神经网络分类器 (2)

neuroph例子

neuroph例子Neuroph是在Java语言中开发的一个神经网络框架,允许开发者创建、训练和部署人工神经网络。

本文将介绍一些使用Neuroph的实例,并解释其核心思想和使用方式。

一、基础概念在使用Neuroph之前,您需要熟悉一些基本的神经网络概念。

以下是一些重要的概念:1. 神经元(Neuron):神经网络中的基本单元,用于接收输入并进行加权计算。

每个神经元都有一个激活函数,用于将输入转换为输出。

2. 层(Layer):神经元可以组成层,这些层可以是输入层、隐藏层或输出层。

每个神经元都会将其输出传递给下一层单元进行处理。

3. 权重(Weights):权重是神经元之间的附加值,用于调整网络的输出。

权重的初始值通常是随机的,并且在训练过程中发生变化。

4. 学习率(Learning Rate):学习率是调整权重的速率。

它决定了在每个训练迭代中应该调整多少权重。

高学习率意味着更快的训练,但可能会导致过拟合。

二、实例接下来我们将介绍一些使用Neuroph的实例,帮助您了解神经网络的训练和使用。

1. 神经网络分类器神经网络可以用于分类器问题,例如对图像或文档进行分类。

以下是一个基本的图像分类器示例:```java// 创建输入层InputLayer inputLayer = new InputLayer(10);// 将层分别添加到网络中NeuralNetwork neuralNetwork = new NeuralNetwork();neuralNetwork.addLayer(inputLayer);neuralNetwork.addLayer(hiddenLayer);neuralNetwork.addLayer(outputLayer);// 创建训练数据和标签DataSet dataSet = new DataSet(10, 3);dataSet.addRow(new double[]{0, 0, 0, 0, 0, 0, 0, 0, 0, 0}, new double[]{1, 0, 0});dataSet.addRow(new double[]{1, 1, 1, 1, 1, 1, 1, 1, 1, 1}, new double[]{0, 1, 0});dataSet.addRow(new double[]{1, 0, 1, 0, 1, 0, 1, 0, 1, 0}, new double[]{0, 0, 1});// 训练神经网络backPropagation.learn(dataSet);// 使用训练数据进行预测neuralNetwork.setInput(new double[]{0, 0, 0, 0, 0, 0, 0, 0, 0, 0});neuralNetwork.calculate();double[] output = neuralNetwork.getOutput();// 打印输出System.out.println(Arrays.toString(output));```以上示例构建了一个包含10个输入、5个隐藏和3个输出神经元的分类器。

第4章 非线性分类器及神经网络

⑶两层感知器模型 • 第一层隐层(hidden layer) 神经元完成第一阶段的计 算,是x到y的映射,即隐 层神经元作用是将输入X 空间映射到二维(因为二 个神经元)Y空间中单位边 长的正方形顶点上(00, 10, 10, 11) 。 • 第二层的一个神经元, 称 为输出层(output layer)完 成第二阶段计算, 输出分 类用判别函数的值。

§2 异或问题(XOR) • 异或布尔函数是非线性可分问题的典型例子。 将布尔函数理解为分类任务,即根据输入 x1、 x2的不同,输出为0(B类)或1(A类)。

• 图中给出了类在空间的位置。 一条直线不能将这两类分开。

• ―与” (AND)和“或” (OR)布尔函数是线性可分 的。

• 用一个感知器可实现“或门”或“与门”。 g 1 由感知器实现的决策面方程

⑴ BP算法推导 • 计算某一层的第j个单元,i和k分别为其前层和 后层的单元,Oj代表本层输出, netj为输入。 • 从前到后对每层各单元计算(正向算法) j 的输入 net j wijOi i j 的输出 O j f (net j ) ˆ j O j 为实际输出,yj为期望值 y • 对输出层而言,

a 称为惯性系数,为学习系数。

⑵反向传播算法步骤: • 初始化:设可调参数(每个权值和阈值)为均匀 分布的较小数,如±0.3 均匀分布随机数。 • 对每个样本作如下计算,直到收敛: ①输入一个样本 x =(x1,x2,..,xd) 即Oi ;输入网络 的期望输出yj,若输出为两个单元则 j =1, 2。 ②从前向后计算各层(正向),各神经元输出Oj

g( x) 3.218x1 0.241x2 1.431

• 对于非线性分类,选择一个合适的非线性判别 函数是很困难的,如图AD, BD, CD。 • 解决方法: ⑴神经网络 (即多层感知器)具有很强的 处理非线性的能力,适合非线性分类。 神经网络中要解决的主要问题: ①学习方法-目的修改权值,如反向传播算法。 ②网络结构-层数,每层神经元数及连接方式。 ③用支持向量机(网络)可得到最优分界面。 ⑵ 用树分类器进行多级决策。在树分类器上用线 性判别函数,就构成了一个分段线性分类器。 ⑶ 对一些特殊的问题可用二次判别函数。

利用证据神经网络的多分类器系统构造

利用证据神经网络的多分类器系统构造和红顺;韩德强;杨艺【摘要】为了充分利用数据信息进而提高分类正确率,提出一种证据神经网络的分类器,并据此构造了多分类器系统.首先将训练数据中的含混数据视为新类别——混合类,将原始的训练数据重组成含有混合类的训练数据,然后使用证据神经网络分类器系统用重组后含混合类的训练数据进行训练,对分类输出进行证据建模,并使用多种不同的证据组合规则实现多分类器融合.采用人工数据集和UCI数据集进行对比实验,结果表明:与其他采用神经网络的多分类器系统相比,采用证据神经网络的多分类器系统能有效提高分类正确率;在数据集Magic 04和Waveform2上,采用提出的多分类器系统比采用投票法的神经网络多分类器系统的分类正确率分别提高了6%和10%左右.【期刊名称】《西安交通大学学报》【年(卷),期】2018(052)011【总页数】8页(P93-99,141)【关键词】神经网络;多分类器系统;证据理论;信度函数【作者】和红顺;韩德强;杨艺【作者单位】西安交通大学电子与信息工程学院,710049,西安;中国电子科技集团公司航天信息应用技术重点实验室,050004,石家庄;西安交通大学电子与信息工程学院,710049,西安;中国电子科技集团公司航天信息应用技术重点实验室,050004,石家庄;西安交通大学机械结构强度与振动国家重点实验室,710049,西安【正文语种】中文【中图分类】TP391复杂环境或场景下,单一分类器的分类效果往往不够理想[1]。

多分类器系统[2]是应对复杂环境下模式分类问题的有效方法,已被广泛应用于图像识别[3]、语音识别[3]、医疗诊断[4]等领域。

学者们基于多分类器系统的多个层面开展了研究。

在成员分类器生成层面,已有研究方法主要有选用不同训练样本获得成员分类器[5]及基于不同的分类算法生成成员分类器[6]等。

由多个相同的分类器构成的多分类器系统,其性能并不会优于单一成员分类器[7]。

人工智能之模式识别_北京理工大学中国大学mooc课后章节答案期末考试题库2023年

人工智能之模式识别_北京理工大学中国大学mooc课后章节答案期末考试题库2023年1.采用非线性激活函数可以实现感知器解决非线性分类问题。

参考答案:错误2.下列关于最大池化的说法中错误的是?参考答案:LeNet采用的是最大池化方法3.填充树法由顶向底的方法和由底向顶填充相反。

参考答案:正确4.语言可以是无限的但是句子必须是有限的。

参考答案:正确5.文法是由下列哪些参数构成的?参考答案:起始符S_终止符V_T_非终止符V_N_产生式P6.感知器算法应用什么方法求解准则函数的最优值?参考答案:梯度下降法7.下列关于对比散度算法的说法中错误的是?参考答案:深度信念网中多层受限玻尔兹曼机同时通过对比散度算法完成预训练8.下列选项中,属于模式识别系统的环节是?参考答案:分类器训练_模式采集_分类决策_预处理与特征生成9.分类器函数的VC维h越大,将使下列选项中的哪些数据发生变化?参考答案:置信风险越大_结构风险越大_分类器泛化能力越差10.利用SVM将低维空间中的非线性问题映射到高维空间,存在哪些问题?参考答案:不确定需要映射到多少维的空间上,非线性问题才会转化为线性问题_如何找到合适的映射函数φ_增加计算量,可能会因为维数灾难无法解决11.本课程中介绍的与句法模式识别相关的基本概念有?参考答案:字母表_句子(链)_文法_语言12.下列选项中属于贝叶斯分类器的特点的是?参考答案:分类决策存在错误率_先验概率已知,以新获得的信息对先验概率进行修正13.贝叶斯分类器的训练,是从样本集数据中估计出____。

参考答案:类条件概率_先验概率14.下列选项中属于特征降维的优点的是?参考答案:降低模式识别任务的复杂度_提升分类决策的正确率_用更少的代价设计出更加优秀的模式识别系统15.下列说法中正确的是?参考答案:聚类结果受特征选取和聚类准则的影响_数据聚类没有预先分好类的样本集_聚类结果受各特征量纲标尺的影响_数据聚类没有已知的分类决策规则16.设计一个组合分类器需要满足什么要求?参考答案:每个基分类器的训练集和训练结果要有差异_组合分类器需要重点考虑方差和偏差_基分类器的分类正确率大于50%17.下列选项中属于决策树分类器的特点的是?参考答案:需选择分支后两个子节点纯度最高的特征作为一个节点的测试特征_速度快,分类决策规则明确_未考虑特征间的相关性_有监督学习方法18.下列选项中属于Adaboost算法的特点的是?参考答案:异常数据(离群点)影响大_不易实现并行化训练_只能解决二分类问题_算法的组合过程能减小偏差19.下列选项中属于反馈型神经网络的是?参考答案:Hopfield网络_受限玻尔兹曼机20.调节以下哪些部分可以对神经网络的性能造成影响?参考答案:权值_激活函数_隐层单元_阈值21.下列选项中关于前馈网络和反馈网络的说法中正确的是?参考答案:前馈网络输出不作用在网络的输入中_前馈网络为静态网络_反馈网络下一时刻的输出与上一时刻的输出有关_反馈网络为动态网络22.下列选项中属于BP网络的不足的是?参考答案:容易陷入局部极小值_全连接网络计算大_隐层神经元数量难以确定_无法做到深度很深,会产生梯度消失23.下列选项中属于深度学习的特点的是?参考答案:需要大量样本进行训练_逐层抽象,发现数据集的特征_是层数较多的大规模神经网络_需要大规模并行计算能力的支持24.利用链式求导法则需要哪些信息?参考答案:损失函数与网络输出向量之间的函数关系_激活函数输出对净激励的导数25.深度信念网不能用于图像识别的原因是?参考答案:深度信念网为一维向量输入,不能直接用于二位图像_需要进行认知-重构的双向计算,学习速度不够快_受限玻尔兹曼机的层间全连接,权值数量太多26.Jp作为类内、类间可分性的概率距离度量时应该满足下列选项中哪些条件?参考答案:当两类完全不可分时,Jp等于0_当两类完全可分时,Jp取得最大值27.特征选择的算法包括以下哪些?参考答案:分支定界法_顺序后退法_穷举法_顺序前进法28.特征降维的方法包括特征选择和特征提取。

监督分析实验报告

一、实验目的本次实验旨在通过监督分析方法,对一组已知标签的数据集进行分类,验证监督学习算法在实际问题中的应用效果,并对比不同算法的性能差异。

二、实验背景监督学习是机器学习中的一种重要方法,通过训练数据集学习得到一个模型,用于对未知数据进行分类或预测。

常见的监督学习方法包括决策树、支持向量机、神经网络等。

本实验选取了三种算法进行对比分析,分别为决策树、支持向量机和神经网络。

三、实验数据实验数据集选用UCI机器学习库中的鸢尾花(Iris)数据集,该数据集包含150个样本,每个样本有4个特征,分别为花萼长度、花萼宽度、花瓣长度和花瓣宽度,以及对应的3个类别标签。

四、实验方法1. 数据预处理(1)数据标准化:将特征值缩放到[0,1]区间内,便于模型计算。

(2)数据划分:将数据集划分为训练集和测试集,其中训练集占80%,测试集占20%。

2. 算法实现(1)决策树:采用Python中的sklearn库实现决策树分类器。

(2)支持向量机:采用Python中的sklearn库实现支持向量机分类器。

(3)神经网络:采用Python中的TensorFlow库实现神经网络分类器。

3. 性能评估采用准确率、召回率、F1值和ROC曲线等指标评估模型性能。

五、实验结果与分析1. 决策树(1)准确率:0.97(2)召回率:0.97(3)F1值:0.97(4)ROC曲线:曲线下面积(AUC)为0.99决策树分类器在本次实验中表现出较好的性能,准确率、召回率和F1值均较高,ROC曲线下面积也较大。

2. 支持向量机(1)准确率:0.95(2)召回率:0.95(3)F1值:0.95(4)ROC曲线:曲线下面积(AUC)为0.98支持向量机分类器在本次实验中表现良好,准确率、召回率和F1值均较高,ROC曲线下面积较大。

3. 神经网络(1)准确率:0.96(2)召回率:0.96(3)F1值:0.96(4)ROC曲线:曲线下面积(AUC)为0.99神经网络分类器在本次实验中表现出较好的性能,准确率、召回率和F1值均较高,ROC曲线下面积较大。

基于 ART2 神经网络的脱机手写吾美藏文基字识别

.

q一 ( n是输入特 征向量 维数 ) 首先输入特征 向量 x= 【 x n ,X ,X ,...,

2识别系统设计

] T ,再计 算 F 1 层各神 经元的值 ,得到上层

模 式 P和 中间模 式 U。P进入 F 2层 ,通 过 竞

2 层 的反馈重 新 的,我们将在后 期进一 步改进 完善该 系统 ,争 本文之所 以提 出基于 AR T 2神经网络的识 争选 出最佳 神经元 。再 依据 F

由此可见藏文结构的 复杂性 ,鉴于时 间所

个新模式类 中。当随机分配新神经元时 ,要

0. 5

T M 系数 ,设置 ( 0 i = ; 0 ,而 限 ,本 文的 识别方 案暂 时只 限于对 藏文的 3 O 初始化 L

个辅音字符识别 , 在保证 一定的识 别率基础上 , 后期将逐渐涉及到藏文音节的识别 。

【 关键词 】吾美藏丈 手写识别 特征提取 神 经 网络

2 ・ 2 A R T 2 神经 网络分类器

2 - 2 ห้องสมุดไป่ตู้ 1 分 类 过 程

1 引言

藏 文结 构和 汉字 不 同,类似 于汉 字的拼 音 ,一 般藏文单音节 的结构顺序为 :前加字 + 上 加 字 +基 字 十下 加字 +元音 +后 加字 +后 后加字 ,一个藏文单音节最多 由一到七个字符 组合。如下图示例 :

对字符进行归一化处理。然后将字符 按 5 x 5规 分 到最 匹配一 类。识别 过程 中,F 1 、F 2之 间

3结论

实验对 吾美 藏文 三十个 辅音 字母进 行测 试 ,采用的样本数据由本人书写。每个 辅音 字 母 测试 1 0 0次 ,识别率 基 本 9 0 % 以上 ,证 明 a r t 2分 类器识别效果较好 。由于 训练样本库是 基于本人笔迹风格建立 , 对其他人 的手写藏文 , 识别率要低一些 ,但经过一些学 习,也可达 到 预期识别效果 。测试结果如下 :

第6讲神经网络精选全文

[0,1]阶梯函数

1 x 0 f (x) 0 x 0

(0,1)S型函数:

1 f (x) 1 ex

+1 ○ 0

f

1 0.5

0

x

x

神经网络的学习

神经网络的学习,主要是指通过一定的学习算法或规则 实现对突触结合强度(权值)的调整。ANN学习规则主要有四 种,即联想式学习、误差传播学习、概率式学习和竞争式学 习。

• M.Minsky和S.Papert进一步发展了感知机的理 论,他们把感知机定义为一种逻辑函数的学习 机。

• B.Widraw在稍后于感知机提出了Adine分类学 习机。它在结构上与感知机相似,但在学习法 则上采用了最小二乘平均误差法。

• 1961年,E.R.Caianiello提出了能实现记忆和识 别的神经网络模型,它由学习方程式和记忆方 程式两部分组成。

• 人工神经网络(简称神经网络)也是由大量的、 功能比较简单的形式神经元互相连接而构成的复 杂网络系统,用它可以模拟大脑的许多基本功能 和简单的思维方式。

神经网络的研究发展史

• 第一次神经网络研究高潮

– 对大脑神经元的研究表明,当其处于兴奋状 态时,输出侧的轴突就会发出脉冲信号,每 个神经元的树状突起与来自其它神经元轴突 的互相结合部(此结合部称为Synapse,即 突触)接收由轴突传来的信号。如果—神经 元所接收到的信号的总和超过了它本身的 “阈值”,则该神经元就会处于兴奋状态, 并向它后续连接的神经元发出脉冲信号。

Hopfield模型的动作原理

• 只要由神经元兴奋的算法和神经元之间的结合 强度所决定的神经网络的状态在适当给定的兴 奋模式下尚未达到稳定,那么该状态就会一直 变化下去,直到预先定义的一个必定减小的能 量函数达到极小值时,状态才达到稳定而不再 变化。

《人工神经网络:模型、算法及应用》习题参考答案

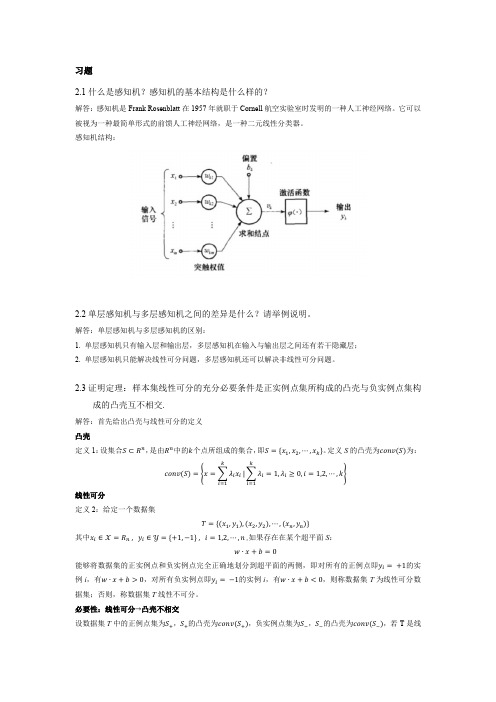

习题2.1什么是感知机?感知机的基本结构是什么样的?解答:感知机是Frank Rosenblatt在1957年就职于Cornell航空实验室时发明的一种人工神经网络。

它可以被视为一种最简单形式的前馈人工神经网络,是一种二元线性分类器。

感知机结构:2.2单层感知机与多层感知机之间的差异是什么?请举例说明。

解答:单层感知机与多层感知机的区别:1. 单层感知机只有输入层和输出层,多层感知机在输入与输出层之间还有若干隐藏层;2. 单层感知机只能解决线性可分问题,多层感知机还可以解决非线性可分问题。

2.3证明定理:样本集线性可分的充分必要条件是正实例点集所构成的凸壳与负实例点集构成的凸壳互不相交.解答:首先给出凸壳与线性可分的定义凸壳定义1:设集合S⊂R n,是由R n中的k个点所组成的集合,即S={x1,x2,⋯,x k}。

定义S的凸壳为conv(S)为:conv(S)={x=∑λi x iki=1|∑λi=1,λi≥0,i=1,2,⋯,k ki=1}线性可分定义2:给定一个数据集T={(x1,y1),(x2,y2),⋯,(x n,y n)}其中x i∈X=R n , y i∈Y={+1,−1} , i=1,2,⋯,n ,如果存在在某个超平面S:w∙x+b=0能够将数据集的正实例点和负实例点完全正确地划分到超平面的两侧,即对所有的正例点即y i=+1的实例i,有w∙x+b>0,对所有负实例点即y i=−1的实例i,有w∙x+b<0,则称数据集T为线性可分数据集;否则,称数据集T线性不可分。

必要性:线性可分→凸壳不相交设数据集T中的正例点集为S+,S+的凸壳为conv(S+),负实例点集为S−,S−的凸壳为conv(S−),若T是线性可分的,则存在一个超平面:w ∙x +b =0能够将S +和S −完全分离。

假设对于所有的正例点x i ,有:w ∙x i +b =εi易知εi >0,i =1,2,⋯,|S +|。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

5.1 感知器算法 5.2 神经网络分类器

5.1 感知器算法 一、引言 模式识别与人工智能是研究如何利用计算机实现人脑的一些 功能。 功能。

人工神经网络研究的发展: 人工神经网络研究的发展: 1943年,提出形式神经元的数学模型,人工神经网络研究的 年 提出形式神经元的数学模型, 开端。 开端。 1949年,提出神经元的学习准则,为神经网络的学习算法奠 年 提出神经元的学习准则, 定了基础。 定了基础。 50年代,研究类似于神经网络的分布系统。 年代,研究类似于神经网络的分布系统。 年代 50年代末提出感知模型,把神经网络的实现付诸工程实践。 年代末提出感知模型,把神经网络的实现付诸工程实践。 年代末提出感知模型 1982年,提出神经网络的数学模型,引入了能力的概念,研 年 提出神经网络的数学模型,引入了能力的概念, 究了网络的动力学特性;设计出用电子线路实现网络的方案, 究了网络的动力学特性;设计出用电子线路实现网络的方案, 大大促进了神经网络的研究。 大大促进了神经网络的研究。 1986年,提出多层感知器的反向传播算法。 年 提出多层感知器的反向传播算法。 现在神经网络的应用已渗透到智能控制、信号处理、 现在神经网络的应用已渗透到智能控制、信号处理、优化计 生物医学工程等领域。 算、生物医学工程等领域。

7、感知器算法推广 、 由感知器算法: 由感知器算法:

w(k ) wT (k ) ⋅ xk > 0 w(k + 1) = w(k ) + c ⋅ xk wT (k ) ⋅ xk ≤ 0

进一步: 变为对分类错误敏感的准则函数J(w, x) 进一步:将cxk变为对分类错误敏感的准则函数 定义: 定义: w(k + 1) = w(k ) − c ⋅ ∇J

初始化: 初始化: 给定一个训练模式集{x 给定一个训练模式集 1, x2,…xN},其中每个类别已知, ,其中每个类别已知, 它们分属于ω 它们分属于 1,ω2。 xi=(xi1, xi2,…xin)T为n维向量,增广为 维向量, 维向量: 维向量 增广为(n+1)维向量:xi= 维向量 (xi1, xi2,…xin,1) ω2类样本乘以-1。 类样本乘以- 。 权向量w为 维向量。 权向量 为(n+1)维向量。 维向量

如果x 如果 k∈ωi和dl(xk) ≥ di(xk) (l≠ i)则: 则 wi(k+1)=wi(k)+ρxk wl(k+1)=wl(k)-ρxk wj(k+1)=wi(k)(任意 ≠ l, i) 任意j 任意 (4)如果 如果k<N,令k=k+1,返至 。如果 返至(2)。如果k=N,则检验判别 如果 令 返至 , 函数w 对 是否都能正确分类。 函数 i’x对x1, x2… xN,是否都能正确分类。若是,结束; 是否都能正确分类 若是,结束; 若不是, 返至(2) 若不是,令k=1,返至 返至

这种神经元没有内部状态的转变,而且函数为阈值型。因此, 这种神经元没有内部状态的转变,而且函数为阈值型。因此, 它实质上是一种线性阈值计算单元。 它实质上是一种线性阈值计算单元。 感知器是一个具有单层计算单元的人工神经网络。 感知器是一个具有单层计算单元的人工神经网络。感知器训 练算法就是由这种神经网络演变来的。 练算法就是由这种神经网络演变来的。 感知器算法能够通过对训练模式样本集的“学习” 感知器算法能够通过对训练模式样本集的“学习”得出判别 函数的系数解。 函数的系数解。

取C=1(不失一般性,可分入样本中) (不失一般性,可分入样本中) xk中k为N个训练样本在多次反复迭代中的累积编号。 个训练样本在多次反复迭代中的累积编号。 为 个训练样本在多次反复迭代中的累积编号

6、感知器算法在多类问题中的应用 、 多类问题分类途径 只考虑第三种情况: 只考虑第三种情况: 如果d 则判x∈ 如果 i(x) >dj(x) 任意 j≠ i ,则判 ∈ωi 算法步骤: 算法步骤: (1)赋初值,分别给 个权矢量 i(1)(i=1,2,…c)赋任意的 赋初值, 个权矢量w ( 赋初值 分别给c个权矢量 ) 初值,选择正常数ρ 置步数k=1. 初值,选择正常数 ,置步数 (2)输入符号未规范化的增广训练模式 k, xk∈{x1, x2… 输入符号未规范化的增广训练模式x ∈{ 输入符号未规范化的增广训练模式 xN} ,计算 个判别函数:di(xk) =wi’(k) xk(i=1,2,…c) 计算c个判别函数 计算 个判别函数: (3)调整增广权矢量,规则是: 调整增广权矢量,规则是: 调整增广权矢量 如果x 任意j 如果 k∈ωi和di(xk)> dj(xk) (任意 ≠ i),则: 任意 , wi(k+1)=wi(k) (i=1,2,…c)

2、人工神经元 、 人工神经元模型: 人工神经元模型: xi:输入,神经元的输入值 输入, ωi:权值,突触的连接强度 权值, f :输出函数,非线性函数 输出函数, y :输出 神经元动作: 神经元动作: = ∑ wi ⋅ xi net

y = f (net )

i =1 n

常用输出函数: 常用输出函数: 阈值函数: 阈值函数: f ( x) = sgn( x)

感知器算法步骤 置步数k=1,令增量C为常数,且C>0,分别赋予初始增广 置步数 ,令增量 为常数, , 为常数 权矢量w(1)的各分量较小的任意值。 的各分量较小的任意值。 权矢量 的各分量较小的任意值 计算判别函数值w 输入训练模式xk,计算判别函数值 T(k)xk 调整增广权矢量,规则是: 调整增广权矢量,规则是: 如果w 如果 T(k)xk≤0, 则w(k+1)=w(k)+ Cxk 如果w 如果 T(k)xk>0, 则w(k+1)=w(k) 如果k<N,令k=k+1,返至第二步。如果 , 如果 ,返至第二步。如果k=N,则检验判别 , 函数wTx对x1, x2,…, xN,是否都能正确分类。若是,结束; 函数 对 是否都能正确分类。若是,结束; 若不是, 若不是,令k=1,返至第二步 ,

属于ω 属于ω 例2:已知训练样本 ,0)’属于 1类,(1,1)’属于 2类,( -1, :已知训练样本(0, 属于 , 属于 , 1)’属于 3类,试求解向量 1*, w2* , w3* 属于ω 试求解向量w 属于

实验四:实验所用样本数据如表给出,编制程序实现ω 实验四:实验所用样本数据如表给出,编制程序实现 1、ω2、 ω3、ω4类的分类。 类的分类。

4、感知器训练算法 、 算法描述 用样本训练时, 不变。 用样本训练时,若x∈ωi,g(x)>0,则w不变。 ∈ , 不变 若g(x)<0,则修改 ,直到所有样本都满足条 ,则修改w, 件为止。 件为止。 通过上面的定义,感知器问题变成wi/wj两类问题。因此,感 通过上面的定义,感知器问题变成 两类问题。因此, 知器的自组织、自学习思想可以用于确定性分类器的训练— 知器的自组织、自学习思想可以用于确定性分类器的训练 —感知器训练方法。 感知器训练方法。 感知器训练方法

1+ e

神经元的学习算法 Hebb学习规则: 学习规则: 学习规则 如果神经元u 接收来自另一神经元u 的输出, 如果神经元 i接收来自另一神经元 j的输出,则当这两个神 经元同时兴奋时, 的权值w 就得到加强,可写成: 经元同时兴奋时,从uj到ui的权值 ij就得到加强,可写成:

阶跃函数: 阶跃函数: f ( x) = step ( x) 双曲正切函数: 双曲正切函数: f ( x) = th( x) =

2 −1 −2 x 1+ e

无限次可微

权值很小时接 近线性函数 权值很大时 接近阈值函 数

非线性, 非线性,单调性

3、感知器模型 、

f 为阈值函数: 为阈值函数:

y = f (∑ wi xi + θ )

神经元的基本工作机制: 神经元的基本工作机制: 神经元的两种工作状态:兴奋和抑制。 神经元的两种工作状态:兴奋和抑制。 动态极化原则:在每一个神经元中, 动态极化原则:在每一个神经元中,信息以预知的确定方 向流动, 向流动,即从神经元的接收信息部分传到轴突的电脉冲起 始部分,再传到轴突终端的突触,以与其它神经元通信。 始部分,再传到轴突终端的突触,以与其它神经元通信。 连接的专一性原则:神经元之间无细胞质的连续, 连接的专一性原则:神经元之间无细胞质的连续,神经元 不构成随机网络, 不构成随机网络,每一个神经元与另一些神经元构成精确 的联接。 的联接。 信号的传递过程: 信号的传递过程: 接受兴奋电位; 接受兴奋电位; 信号的汇集和传导; 信号的汇集和传导; 信号的输出。 信号的输出。

w *T ⋅ xi > 0 i = 1,2,...N

若将式中阈值0改为一非负值 ,则变为更一般的形式: 若将式中阈值 改为一非负值T,则变为更一般的形式: 改为一非负值

w *T ⋅xi > T i = 1,2,...N

感知器算法可写成: 感知器算法可写成:

w(k ) 如果wT ( k ) ⋅ xk > T w(k + 1) = w(k ) + xk 如果wT (k ) ⋅ xk ≤ T

例1:试用感知器算法求出下列两类的判别函数。 :试用感知器算法求出下列两类的判别函数。 ω1:{(0,0)T,(0,1)T}, ω2:{(1,0)T,(1,1)T}, , ,

上机作业三: 上机作业三: ω1=(x1,x2)={(1,0,1),(0,1,1)} ω2=(x3,x4)={(1,1,0),(0,1,0)} 使用感知器算法给出区分两类模式的判别函数。 使用感知器算法给出区分两类模式的判别函数。

5、感知器算法收敛性分析 、 收敛定理:如果训练模式是线性可分的, 收敛定理:如果训练模式是线性可分的,感知器训练算法在 有限次迭代后便可以收敛到正确的解矢量w* 有限次迭代后便可以收敛到正确的解矢量 为权向量的解, 设: w*为权向量的解,则它具有下式的性质: 为权向量的解 则它具有下式的性质: