在MFC对话框的控件中显示Opencv摄像头视频+Camshift跟踪算法实现

MFC通过opencv显示摄像头

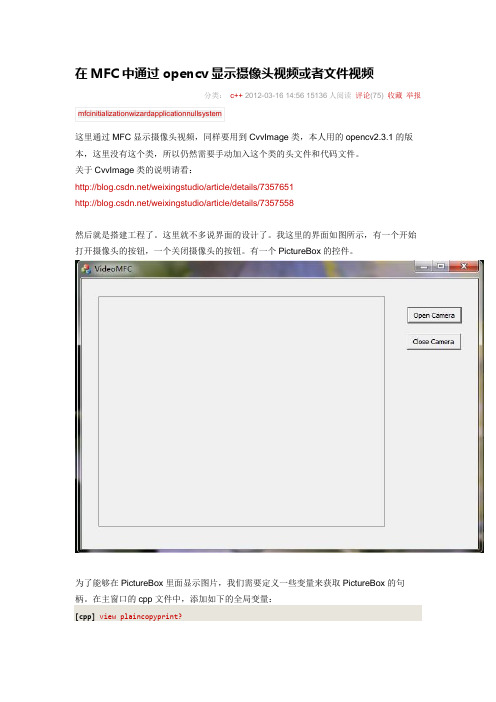

开摄像头的按钮,一个关闭摄像头的按钮。

有一个PictureBox的控件。

1.CvCapture* capture;2.CRect rect;3.CDC *pDC;4.HDC hDC;5.CWnd *pwnd;这里特别注意,这些变量一定要是全局变量。

再来看一下这些变量的添加位置:[cpp]view plaincopyprint?1.#include "stdafx.h"2.#include "VideoMFC.h"3.#include "VideoMFCDlg.h"4.#include "afxdialogex.h"5.6.#ifdef _DEBUG7.#define new DEBUG_NEW8.#endif9.10.11.CvCapture* capture;12.CRect rect;13.CDC *pDC;14.HDC hDC;15.CWnd *pwnd;16.17.// CAboutDlg dialog used for App About18.19.class CAboutDlg : public CDialogEx20.{21.public:然后在窗口的初始化函数中进行句柄的初始化:[cpp]view plaincopyprint?1.OnInitDialog()这个函数,BOOL CVideoMFCDlg::OnInitDialog()初始化代码:[cpp]view plaincopyprint?1.// CVideoMFCDlg message handlers2.3.BOOL CVideoMFCDlg::OnInitDialog()4.{5. CDialogEx::OnInitDialog();6.7. // Add "About..." menu item to system menu.8.9. // IDM_ABOUTBOX must be in the system command range.10. ASSERT((IDM_ABOUTBOX & 0xFFF0) == IDM_ABOUTBOX);11. ASSERT(IDM_ABOUTBOX < 0xF000);12.13. CMenu* pSysMenu = GetSystemMenu(FALSE);14. if (pSysMenu != NULL)15. {16.BOOL bNameValid;17. CString strAboutMenu;18. bNameValid = strAboutMenu.LoadString(IDS_ABOUTBOX);19. ASSERT(bNameValid);20. if (!strAboutMenu.IsEmpty())21. {22. pSysMenu->AppendMenu(MF_SEPARATOR);23. pSysMenu->AppendMenu(MF_STRING, IDM_ABOUTBOX, strAboutMenu);24. }25. }26.27.28. // Set the icon for this dialog. The framework does this automatically29. // when the application's main window is not a dialog30. SetIcon(m_hIcon, TRUE); // Set big icon31. SetIcon(m_hIcon, FALSE); // Set small icon32.33. // TODO: Add extra initialization here34. pwnd = GetDlgItem(IDC_ShowImage);35. //pwnd->MoveWindow(35,30,352,288);36. pDC =pwnd->GetDC();37. //pDC =GetDC();38. hDC= pDC->GetSafeHdc();39. pwnd->GetClientRect(&rect);40.41.42.43. return TRUE; // return TRUE unless you set the focus to a control44.}这里的初始化代码只有Todo后面的是自己添加的,目的是获得图像控件的句柄,将来好在上面显示图像。

基于计算机视觉算法的视频智能监控与跟踪系统研究

图像处理技术

Image Processing Technology

《自动化技术与应用》 2021 年第 40 卷第 6 期

以评估,并触发告警机制。视频图像通过 PC 端呈现,利 用 Visual Studio 编制于人机交互界面,以此 PC 端可实 时观看监控,并观察参数变化状态。硬件则包括计算机、 摄像头、网络设备、储存介质等等。视频智能监控与跟踪 系统框架[2]具体如图 1 所示。

抖动视频图像。

设定视频图像当前帧与前一帧匹配点集为{

;

},(x=1,2,3,∧,n)视频各帧图像综合运动存在

伸缩、旋转、平移等多种变化,其全局运动即:

(4)

z 表示视频图像伸缩变化;θ表示视频图像围绕中心 逆时针旋转角度;(df,dg)U表示视频图像中心位移。

如果图像块匹配结果是在视频某时刻前后两帧图像 匹配点对的集合中,则通过集合随机挑选两对匹配点构 成子集,即:

B 代表蓝色。

灰度化处理基于 OpenCV 提取原始图像,再把三通

道 RGB 彩色图转变为单通道灰度图,利用 OpenCV 所提

供 Cvt Colour 颜色空间转换函数,便可实现图像灰度化。

3.2 滤波处理

视频图像滤波是视频图像去噪处理的重要途径,以

中值滤波法去除噪声,基本原理为于目标像素周围选择

收稿日期:2020-06-30

84 Techniques of Automation & Applications

注意力,遗漏重要数据信息[1]。据此,本文引进了计算机 视觉技术进行视频智能监控,基于视频数据内容自主评 估异常状况,并提示告警。

2 视频智能监控与跟踪系统框架

基于计算机视觉算法的视频智能监控与跟踪系统由 硬件与软件两部分构成,其中软件框架以主机为载体,以 摄像采集监控范围之内的视频图像数据信息,加以预处 理分析,同时以 OpenCV 视觉处理库编制代码,检测所采 集数据信息,在检测发现移动物体之后,于阈值区域内加

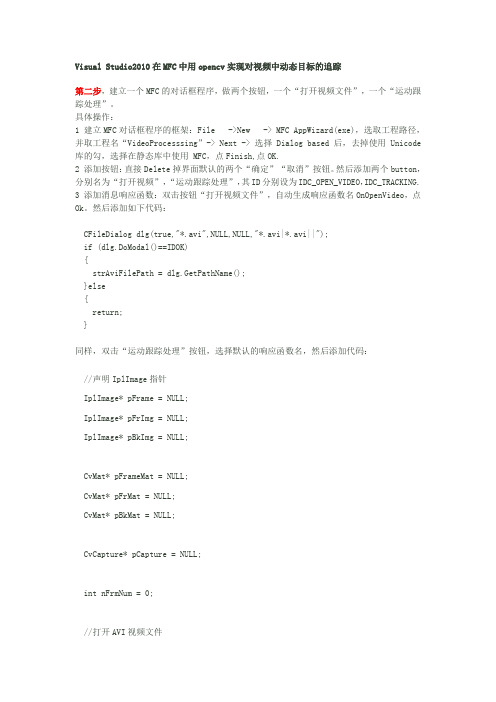

VS 2010在MFC中用opencv实现对视频中动态目标的追踪

Visual Studio2010在MFC中用opencv实现对视频中动态目标的追踪第二步,建立一个MFC的对话框程序,做两个按钮,一个“打开视频文件”,一个“运动跟踪处理”。

具体操作:1 建立MFC对话框程序的框架:File ->New -> MFC AppWizard(exe),选取工程路径,并取工程名“VideoProcesssing”-> Next -> 选择Dialog based后,去掉使用Unicode库的勾,选择在静态库中使用 MFC,点Finish,点OK.2 添加按钮:直接Delete掉界面默认的两个“确定”“取消”按钮。

然后添加两个button,分别名为“打开视频”,“运动跟踪处理”,其ID分别设为IDC_OPEN_VIDEO,IDC_TRACKING.3 添加消息响应函数:双击按钮“打开视频文件”,自动生成响应函数名OnOpenVideo,点Ok。

然后添加如下代码:CFileDialog dlg(true,"*.avi",NULL,NULL,"*.avi|*.avi||");if (dlg.DoModal()==IDOK){strAviFilePath = dlg.GetPathName();}else{return;}同样,双击“运动跟踪处理”按钮,选择默认的响应函数名,然后添加代码://声明IplImage指针IplImage* pFrame = NULL;IplImage* pFrImg = NULL;IplImage* pBkImg = NULL;CvMat* pFrameMat = NULL;CvMat* pFrMat = NULL;CvMat* pBkMat = NULL;CvCapture* pCapture = NULL;int nFrmNum = 0;//打开AVI视频文件if(strAviFilePath=="") //判断文件路径是否为空{MessageBox("请先选择AVI视频文件!");return;}else{if(!(pCapture = cvCaptureFromFile(strAviFilePath))) {MessageBox("打开AVI视频文件失败!");return;}}//创建窗口cvNamedWindow("Video", 1);cvNamedWindow("Background",1);cvNamedWindow("Foreground",1);//使窗口有序排列,窗口宽330cvMoveWindow("Video", 30, 0);cvMoveWindow("Background", 360, 0);cvMoveWindow("Foreground", 690, 0);//逐帧读取视频while(pFrame = cvQueryFrame( pCapture )){nFrmNum++;//如果是第一帧,需要申请内存,并初始化if(nFrmNum == 1){pBkImg = cvCreateImage(cvSize(pFrame->width, pFrame->height), IPL_DEPTH_8U,1); // 存放背景图像(灰度)pFrImg = cvCreateImage(cvSize(pFrame->width, pFrame->height), IPL_DEPTH_8U,1); // 存放中间图像(灰度)pBkMat = cvCreateMat(pFrame->height, pFrame->width, CV_32FC1);pFrMat = cvCreateMat(pFrame->height, pFrame->width, CV_32FC1);pFrameMat = cvCreateMat(pFrame->height, pFrame->width, CV_32FC1);//转化成单通道图像再处理(灰度)cvCvtColor(pFrame, pBkImg, CV_BGR2GRAY);cvCvtColor(pFrame, pFrImg, CV_BGR2GRAY);cvConvert(pFrImg, pFrameMat);cvConvert(pFrImg, pFrMat);cvConvert(pFrImg, pBkMat);}else{cvCvtColor(pFrame, pFrImg, CV_BGR2GRAY); //转化成单通道图像再处理(灰度)cvConvert(pFrImg, pFrameMat);//高斯滤波先,以平滑图像//cvSmooth(pFrameMat, pFrameMat, CV_GAUSSIAN, 3, 0, 0);//当前帧跟背景图相减(求背景差并取绝对值)cvAbsDiff(pFrameMat, pBkMat, pFrMat);//二值化前景图(这里采用特定阈值进行二值化)cvThreshold(pFrMat, pFrImg, 60, 255.0, CV_THRESH_BINARY);//进行形态学滤波,去掉噪音cvErode(pFrImg, pFrImg, 0, 1);cvDilate(pFrImg, pFrImg, 0, 1);//滑动平均更新背景(求平均)cvRunningAvg(pFrameMat, pBkMat, 0.003, 0);//将背景转化为图像格式,用以显示cvConvert(pBkMat, pBkImg);// 保持原图像的旋转方向pBkImg->origin = pFrImg->origin = pFrame->origin;//显示图像cvShowImage("Video", pFrame);cvShowImage("Background", pBkImg);cvShowImage("Foreground", pFrImg);//如果有按键事件,则跳出循环//此等待也为cvShowImage函数提供时间完成显示//等待时间可以根据CPU速度调整if( cvWaitKey(200) >= 0 )break;}}//销毁窗口cvDestroyWindow("Video");cvDestroyWindow("Background");cvDestroyWindow("Foreground");//释放图像和矩阵cvReleaseImage(&pFrImg);cvReleaseImage(&pBkImg);cvReleaseMat(&pFrameMat);cvReleaseMat(&pFrMat);cvReleaseMat(&pBkMat);cvReleaseCapture(&pCapture);4 选fileview选项卡中VideoProcessingDlg.h,在CVideoProcessingDlg类中添加公有类成员:CString strAviFilePath;5 选fileview选项卡中VideoProcessingDlg.cpp,添加opencv头文件#include "cv.h"#include "highgui.h"#include "cxcore.h"6 编译执行,成功!还可以添加一个”录制视频”的按钮,修改ID号为IDC_RECORD,双击“录制视频”按钮,选择默认的响应函数名,然后添加代码:CvCapture* capture=cvCaptureFromCAM(-1); //打开摄像头CvVideoWriter* video=NULL;IplImage* frame=NULL;int n;if(!capture) //如果不能打开摄像头给出警告{cout<<"Can not open the camera."<<endl;return ;}else{frame=cvQueryFrame(capture); //首先取得摄像头中的一帧video=cvCreateVideoWriter("camera.avi", CV_FOURCC('X', 'V', 'I', 'D'), 25,cvSize(frame->width,frame->height)); //创建CvVideoWriter对象并分配空间//保存的文件名为camera.avi,编码要在运行程序时选择,大小就是摄像头视频的大小,帧频率是32if(video) //如果能创建CvVideoWriter对象则表明成功{cout<<"VideoWriter has created."<<endl;}cvNamedWindow("Camera Video",1); //新建一个窗口int i = 0;while(i <= 200) // 让它循环200次自动停止录取{frame=cvQueryFrame(capture); //从CvCapture中获得一帧if(!frame){cout<<"Can not get frame from the capture."<<endl;break;}n=cvWriteFrame(video,frame); //判断是否写入成功,如果返回的是1,表示写入成功cout<<n<<endl;cvShowImage("Camera Video",frame); //显示视频内容的图片i++;if(cvWaitKey(2)>0)break; //有其他键盘响应,则退出}cvReleaseVideoWriter(&video);cvReleaseCapture(&capture);cvDestroyWindow("Camera Video");}return ;第二步,建立一个编程环境,然后加载opencv的库路径等等。

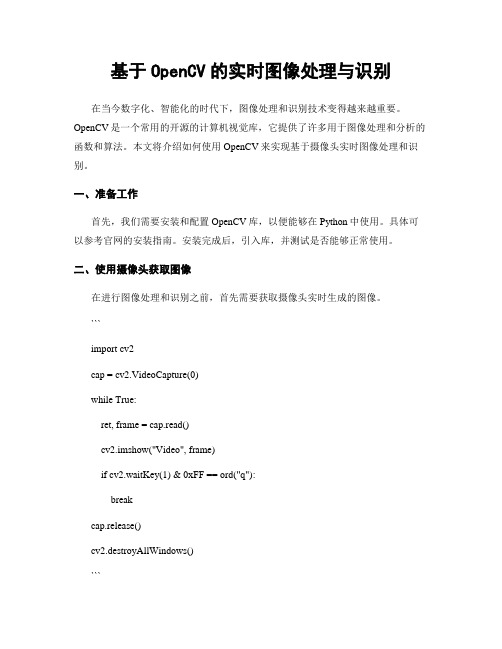

基于OpenCV的实时图像处理与识别

基于OpenCV的实时图像处理与识别在当今数字化、智能化的时代下,图像处理和识别技术变得越来越重要。

OpenCV是一个常用的开源的计算机视觉库,它提供了许多用于图像处理和分析的函数和算法。

本文将介绍如何使用OpenCV来实现基于摄像头实时图像处理和识别。

一、准备工作首先,我们需要安装和配置OpenCV库,以便能够在Python中使用。

具体可以参考官网的安装指南。

安装完成后,引入库,并测试是否能够正常使用。

二、使用摄像头获取图像在进行图像处理和识别之前,首先需要获取摄像头实时生成的图像。

```import cv2cap = cv2.VideoCapture(0)while True:ret, frame = cap.read()cv2.imshow("Video", frame)if cv2.waitKey(1) & 0xFF == ord("q"):breakcap.release()cv2.destroyAllWindows()```在上面的代码中,我们使用`cv2.VideoCapture(0)`函数打开摄像头。

其中参数`0`表示默认使用第一个摄像头,如果有多个摄像头,可以使用不同的数字来切换。

通过`cap.read()`函数读取摄像头返回的视频帧,`ret`表示读取是否成功,`frame`表示读取到的视频帧。

将读取到的视频帧通过`cv2.imshow()`函数显示在窗口中,通过`cv2.waitKey()`函数等待用户键盘输入,输入`q`表示退出程序。

最后,通过`cap.release()`函数释放资源,关闭窗口。

运行程序后,我们可以看到摄像头实时获取到的图像。

三、实现图像处理功能在获取摄像头实时生成的图像后,我们可以对图像进行一些处理,以便后续进行识别。

1. 图像灰度处理将彩色图像转换成灰度图像是进行图像处理的第一步。

通过OpenCV中的`cv2.cvtColor()`函数实现。

mfc中picture control使用

mfc中picture control使用在MFC中,Picture Control是一个用于显示图片的用户界面控件。

它通常用于在应用程序中展示图像内容。

以下是使用MFC中的Picture Control控件的步骤:1、添加Picture Control控件:在Visual Studio的设计视图中,打开你的对话框资源。

在工具箱中,找到Picture Control 控件并将其拖动到对话框上。

2、关联Picture Control控件与变量:选中Picture Control控件,在属性窗口中找到IDC_STATIC对应的ID,然后将其改为一个唯一的ID,比如IDC_PICTURE。

同时,在Class View中为该控件添加一个对应的变量,类型选择为CStatic。

3、加载并显示图片:在代码中找到对应的消息处理函数(例如OnInitDialog),然后使用以下代码加载并显示图片:cpp// 加载图片资源HRSRC hResource = FindResource(AfxGetResourceHandle(),MAKEINTRESOURCE(IDB_PICTURE), RT_RC);HGLOBAL hGlobal = LoadResource(AfxGetResourceHandle(), hResource);// 获取图片数据的指针LPCTSTR lpData = (LPCTSTR)LockResource(hGlobal);// 计算图片大小DWORD dwSize = SizeofResource(AfxGetResourceHandle(), hResource);// 创建位图对象CBitmap bitmap;bitmap.CreateFromBase(lpData, dwSize, NULL, LR_CREATEDIBSECTION);// 获取Picture Control控件的句柄HWND hWndPicture = GetDlgItem(IDC_PICTURE);// 创建兼容的DC(设备上下文)对象CDC compatibleDC;compatibleDC.CreateCompatibleDC(&compatibleDC);// 创建位图对象兼容的位图CBitmap* pOldBitmap = compatibleDC.SelectObject(&bitmap);// 将位图绘制到Picture Control控件上BitBlt(hWndPicture, 0, 0, bitmap.GetWidth(), bitmap.GetHeight(), &compatibleDC, 0, 0, SRCCOPY);// 释放资源compatibleDC.SelectObject(pOldBitmap);FreeResource(hGlobal);上述代码假设你的图片资源已经添加到资源文件中,并且资源的ID为IDB_PICTURE。

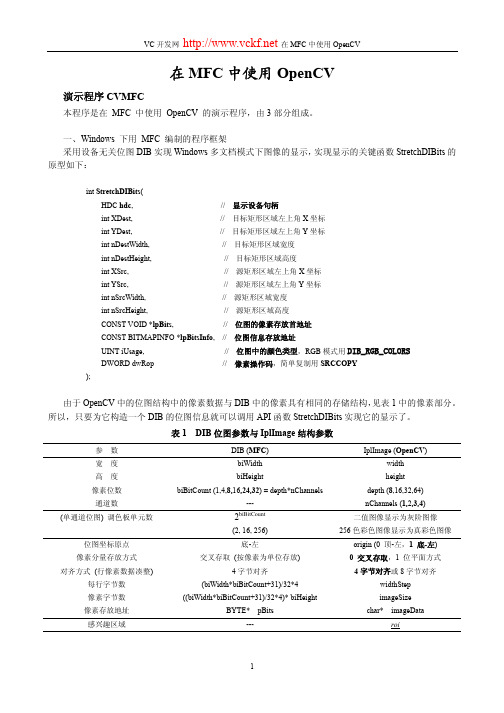

在MFC中使用OpenCV教程

典型例图 ExampleL.bmp、 ExampleQ.bmp

简要说明 仅适用于单连通区域, 不能处理多连通区域与孔边界

ExampleC.bmp、

适用各类二值图像,使用范围较宽

SteelBar.bmp、pic3.png 图像反相后也可进行处理,得到不同结果

ExampleD.bmp

为灰值形态学运算,波谷检测又称黑顶帽变换

三、用 DirectShow 编制的视频采集程序 采用 DirectShow 实现视频采集,其优点是支持高分辨率图像采集,最高分辨率由所用的摄像头决定, 如罗技 130 万像素 USB 摄像头 C300 最高分辨率可达 1280*1024,在 MPEG 模式下采集速度为每秒 15 帧。 使用时 CPU 的时间占用率在 15~30%之间。 通过多图像平均可以采集得到质量不错的图像,经过 4 幅图像平均采集所得图像的信噪比可提高一倍。 由于需要连续采集多帧图像,约需 0.25 秒,故适宜采集静态或缓慢移动对象的图像。 视频采集功能调用 OpenCV China 网站下载的软件 camerads 中的函数实现。

主要内容

下面列出 stdafx.h 尾部集中的几个头文件,程序结构由此可见一斑。

#include "CVMFC.h"

// 窗口管理

#include "cv.h" #include "highgui.h"

// OpenCV 头文件

#include "CameraDS.h" #include "CVDSCap.h"

图像反相后处理与另一方法直接处理等价

lena.jpg、fruits.jpg lena.jpg、fruits.jpg

基于OpenCV的运动目标跟踪及其实现

基于OpenCV的运动目标跟踪及其实现作者:李振伟陈翀赵有来源:《现代电子技术》2008年第20期摘要:CAMSHIFT算法是一种基于颜色直方图的目标跟踪算法。

在视频跟踪过程中,CAMSHIFT算法利用选定目标的颜色直方图模型得到每帧图像的颜色投影图,并根据上一帧跟踪的结果自适应调整搜索窗口的位置和大小,得到当前帧中目标的尺寸和质心位置。

在介绍Intel公司的开源OpenCV计算机视觉库的基础上,采用CAMSHIFT跟踪算法,实现运动目标跟踪,解决了跟踪目标发生存在旋转或部分遮挡等复杂情况下的跟踪难题。

实验结果表明该算法的有效性、优越性和可行性。

关键词:目标跟踪;CAMSHIFT算法;OpenCV;颜色直方图中图分类号:TP391文献标识码:B文章编号:1004373X(2008)2012803Moving Object Tracking Method and Implement Based on OpenCVLI Zhenwei1,2,CHEN Chong1,2,ZHAO You1(1.Changchun Observatory,National Astronomical Observatories,Chinese Academy of Sciences,Changchun,130117,China;2.Graduate School,Chinese Academy of Sciences,Beijing,100049,China)Abstract:CAMSHIFT is an object tracking algorithm based onthe color histogram.In the process of object tracking,CAMSHIFT operates on a color back-projection image produced from object histogram model in current frame and finds the location and size of the current frame by adaptively adjusting the size and the location of the searching windows according to the tracking results of the previous frame in the video.On the basis of introducing OpenCV(an Intel open source computer vision library),through CAMSHIFT algorithm,the paper realizes moving object tracking and resolves some problems including distractor and occlusion by other objects.Experimental results show good perf o rmances,superiority and feasibility of the algorithm.Keywords:object tracking;CAMSHIFT algorithm;OpenCV;color histogram目标跟踪是计算机视觉的一个重要分支,日益广泛应用于科学技术、国防安全、航空、医药卫生以及国民经济等领域。

物体跟踪算法在视频监控中的应用教程

物体跟踪算法在视频监控中的应用教程随着科技的不断发展,视频监控技术的应用越来越广泛。

而为了更好地保障安全,实时的物体跟踪算法变得尤为重要。

本篇文章将为您介绍物体跟踪算法在视频监控中的应用以及相关的教程。

一、物体跟踪算法的概述物体跟踪是指通过对视频序列进行分析和处理,实时地追踪感兴趣的物体。

它涉及到图像处理、计算机视觉和机器学习等领域的技术。

物体跟踪算法在视频监控中的应用非常广泛,包括人脸跟踪、车辆跟踪等。

二、视频监控中的常用物体跟踪算法1. 卡尔曼滤波器(Kalman Filter)算法卡尔曼滤波器算法是一种递归估计算法,常用于预测和估计物体的位置。

它通过不断地更新位置估计值,可以在一定程度上解决物体漂移和遮挡等问题。

卡尔曼滤波器算法在实时视频监控中应用广泛,特别适用于移动目标的跟踪。

2. 均值漂移(Mean Shift)算法均值漂移算法是一种非参数化的密度估计算法,在物体跟踪中有着广泛的应用。

它通过不断地调整搜索窗口的中心,寻找最大密度值所在的位置,从而实现物体的跟踪。

均值漂移算法对物体颜色模型的准确性要求较高,在处理光照变化和背景干扰时比较强大。

3. CamShift 算法CamShift 算法基于均值漂移算法,是一种自适应的物体跟踪算法。

它通过不断地更新搜索窗口的大小和方向来跟踪目标物体。

相比于均值漂移算法,CamShift 算法对于光照变化和尺度变化较为稳健,常用于人脸跟踪和手势识别等应用。

4. Haar 级联检测器Haar 级联检测器是一种基于机器学习的物体检测和跟踪算法。

它使用Haar 特征和 AdaBoost 训练算法来实现目标物体的检测和跟踪。

Haar 级联检测器对于人脸、行人等物体有着较好的效果,并且具有较高的计算效率。

三、物体跟踪算法在视频监控中的应用教程下面将介绍物体跟踪算法在视频监控中的应用教程,涵盖了卡尔曼滤波器、均值漂移和 Haar 级联检测器三种算法的基本原理和实现方法。

opencv videocapture的实现原理 -回复

opencv videocapture的实现原理-回复OpenCV是一个开源的计算机视觉库,提供了许多用于图像和视频处理的功能。

其中,VideoCapture是OpenCV中的一个类,用于从摄像头或视频文件中捕获帧。

本文将介绍VideoCapture的实现原理,并逐步解释其工作流程。

1. 寻找摄像头或打开视频文件在使用VideoCapture之前,我们需要先调用它的构造函数,创建一个VideoCapture对象。

构造函数允许我们指定要捕获的设备索引或视频文件路径。

当指定的设备或文件不存在时,VideoCapture将返回一个空对象。

2. 初始化视频流一旦成功打开摄像头或视频文件,VideoCapture会尝试初始化视频流。

它首先读取视频的头部信息,包括分辨率、帧率和编解码器信息。

这些信息对于后续的视频处理非常重要,因为它们决定了如何解释视频流数据。

3. 循环读取帧一旦视频流被成功初始化,VideoCapture就开始进入一个循环,用于读取视频的每一帧。

它会读取下一帧的图像数据,并将其存储在内存中供后续处理使用。

4. 检查视频流是否结束在读取每一帧之前,VideoCapture会检查视频流是否已经结束。

如果视频流已经结束,它会跳出循环并关闭流。

5. 存储帧数据读取成功的帧数据将被存储在内存中,通常是一个图像矩阵或一个视频帧对象。

这个数据结构允许我们进行进一步的图像处理,例如检测对象、应用滤波器或进行特征提取。

6. 解码帧数据在存储帧数据之后,VideoCapture会将其解码为常用的图像格式,例如BGR或灰度。

这样,我们就可以在处理帧数据之前,先进行图像格式转换或颜色空间转换。

7. 处理帧数据一旦帧数据被解码并存储在内存中,我们可以使用OpenCV的其他功能来对其进行处理。

例如,我们可以在图像上应用滤波器、边缘检测、目标检测等。

8. 显示或保存帧数据处理完帧数据后,我们可以选择将其显示在屏幕上或保存到本地文件中。

目标跟踪算法的分类

主要基于两种思路:a)不依赖于先验知识,直接从图像序列中检测到运动目标,并进行目标识别,最终跟踪感兴趣的运动目标;b)依赖于目标的先验知识,首先为运动目标建模,然后在图像序列中实时找到相匹配的运动目标。

一.运动目标检测对于不依赖先验知识的目标跟踪来讲,运动检测是实现跟踪的第一步。

运动检测即为从序列图像中将变化区域从背景图像中提取出来。

运动目标检测的算法依照目标与摄像机之间的关系可以分为静态背景下运动检测和动态背景下运动检测〔一〕静态背景1.背景差2.帧差3.GMM4.光流背景减算法可以对背景的光照变化、噪声干扰以及周期性运动等进行建模,在各种不同情况下它都可以准确地检测出运动目标。

因此对于固定摄像头的情形,目前大多数的跟踪算法中都采用背景减算法来进行目标检测。

背景减算法的局限性在于它需要一个静态的固定摄像头。

〔二〕运动场通常情况下,摄像机的运动形式可以分为两种:a)摄像机的支架固定,但摄像机可以偏转、俯仰以及缩放; b)将摄像机装在某个移动的载体上。

由于以上两种情况下的背景及前景图像都在做全局运动,要准确检测运动目标的首要任务是进行图像的全局运动估计与补偿。

考虑到图像帧上各点的全局运动矢量虽不尽相同(摄像机做平移运动除外),但它们均是在同一摄像机模型下的运动,因而应遵循相同的运动模型,可以用同一模型参数来表示。

全局运动的估计问题就被归结为全局运动模型参数的估计问题,通常使用块匹配法或光流估计法来进行运动参数的估计。

块匹配基于块的运动估算和补偿可算是最通用的算法。

可以将图像分割成不同的图像块,假定同一图像小块上的运动矢量是相同的,通过像素域搜索得到最正确的运动矢量估算。

块匹配法主要有如下三个关键技术:a)匹配法则,如最大相关、最小误差等b)搜索方法,如三步搜索法、交叉搜索法等。

c) 块大小确实定,如分级、自适应等。

光流法光流估计的方法都是基于以下假设:图像灰度分布的变化完全是目标或者场景的运动引起的,也就是说,目标与场景的灰度不随时间变化。

camera track原理

camera track原理

摄像机跟踪(Camera Tracking)是指利用计算机视觉技术对视频中的摄像机运动进行跟踪和分析的过程。

摄像机跟踪的原理涉及多个方面,包括特征点提取、特征匹配、相机姿态估计等。

首先,摄像机跟踪的原理之一是特征点提取。

在视频序列中,摄像机跟踪算法会首先提取一些关键的特征点,这些特征点可以是角点、边缘点或者纹理点等。

这些特征点在不同帧之间具有较好的稳定性和可区分性,能够用于后续的跟踪和姿态估计。

其次,摄像机跟踪的原理还涉及特征匹配。

在不同帧之间,摄像机的运动会导致特征点的位置发生变化,因此需要进行特征点的匹配,以确定不同帧之间的对应关系。

特征点的匹配可以利用各种计算机视觉算法,如光流法、特征描述子匹配等。

另外,摄像机跟踪的原理还包括相机姿态估计。

通过对特征点的匹配和运动分析,摄像机跟踪算法可以估计出摄像机在不同帧之间的姿态变化,包括平移和旋转等运动参数。

这些参数对于后续的三维重建和虚拟现实应用非常重要。

总的来说,摄像机跟踪的原理涉及特征点提取、特征匹配和相

机姿态估计等多个方面,通过对视频序列进行分析和处理,可以实

现对摄像机运动的跟踪和分析。

这些原理的应用涵盖了计算机视觉、图像处理、三维重建等多个领域,在虚拟现实、增强现实、视频监

控等领域有着广泛的应用前景。

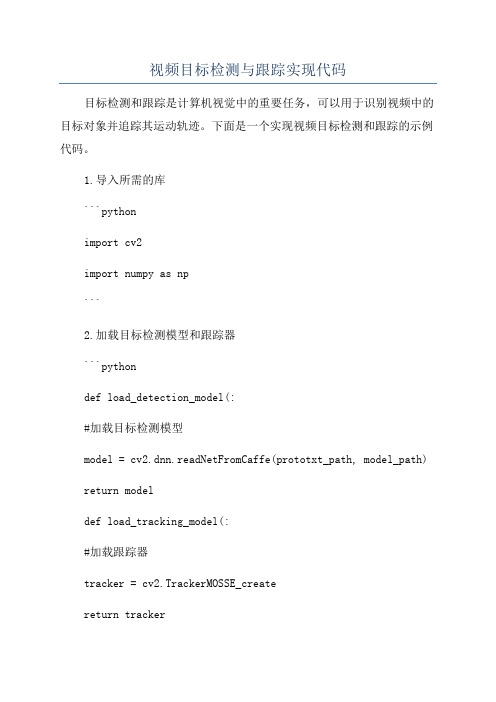

视频目标检测与跟踪实现代码

视频目标检测与跟踪实现代码目标检测和跟踪是计算机视觉中的重要任务,可以用于识别视频中的目标对象并追踪其运动轨迹。

下面是一个实现视频目标检测和跟踪的示例代码。

1.导入所需的库```pythonimport cv2import numpy as np```2.加载目标检测模型和跟踪器```pythondef load_detection_model(:#加载目标检测模型model = cv2.dnn.readNetFromCaffe(prototxt_path, model_path) return modeldef load_tracking_model(:#加载跟踪器tracker = cv2.TrackerMOSSE_createreturn tracker#检测模型的配置文件和权重文件路径prototxt_path = 'detection_model.prototxt'model_path = 'detection_model.caffemodel'```3.定义目标检测函数```pythondef detect_objects(frame, detection_model):# 将帧图像转换为 blob 形式# 将 blob 输入到模型中进行目标检测detection_model.setInput(blob)detections = detection_model.forward#解析检测结果num_detections = detections.shape[2]for i in range(num_detections):confidence = detections[0, 0, i, 2]if confidence > 0.5:class_id = int(detections[0, 0, i, 1])x1 = int(detections[0, 0, i, 3] * frame.shape[1]) y1 = int(detections[0, 0, i, 4] * frame.shape[0])x2 = int(detections[0, 0, i, 5] * frame.shape[1])y2 = int(detections[0, 0, i, 6] * frame.shape[0])cv2.rectangle(frame, (x1, y1), (x2, y2), (0, 255, 0), 2)label = f'Class: {class_id}, Confidence: {int(confidence * 100)}%'cv2.putText(frame, label, (x1, y1 - 10),cv2.FONT_HERSHEY_SIMPLEX, 0.9, (0, 255, 0), 2, cv2.LINE_AA) ```4.定义目标跟踪函数```pythondef track_objects(frame, bbox, tracker):#初始化跟踪器tracker.init(frame, bbox)while True:#读取下一帧图像success, frame = cap.readif not success:break#更新跟踪器success, bbox = tracker.update(frame)if success:#跟踪成功,绘制边界框x, y, w, h = [int(x) for x in bbox]cv2.rectangle(frame, (x, y), (x + w, y + h), (0, 255, 0), 2) else:#跟踪失败,输出失败消息cv2.putText(frame, "Tracking failure detected", (100,80), cv2.FONT_HERSHEY_SIMPLEX, 0.75, (0,0,255),2)#显示图像cv2.imshow("Tracking", frame)if cv2.waitKey(1) == ord('q'):break```5.主函数```pythonif __name__ == '__main__':#打开摄像头或视频文件cap = cv2.VideoCapture(0)#加载目标检测模型和跟踪器detection_model = load_detection_model tracker = load_tracking_modelwhile True:#读取下一帧图像success, frame = cap.readif not success:break#目标检测detect_objects(frame, detection_model) #显示图像cv2.imshow("Object Detection", frame) if cv2.waitKey(1) == ord('t'):#选择一个ROI来跟踪bbox = cv2.selectROI(frame, False)cv2.destroyAllWindows#开始目标跟踪track_objects(frame, bbox, tracker) break#释放资源cap.releasecv2.destroyAllWindows```这是一个简单的视频目标检测和跟踪实现的示例代码。

视频帧快读定位算法

视频帧快读定位算法跟踪就是在连续视频帧中定位物体,通常的跟踪算法包括以下几类:1. Dense Optical Flow 稠密光流2. Sparse Optical Flow 稀疏光流最典型的如KLT算法(Kanade-Lucas-Tomshi)3. Kalman Filter4. Meanshift and Camshift5. Multiple object tracking需要注意跟踪和识别的区别,通常来说跟踪可以比识别快很多,且跟踪失败了可以找回来。

OpenCV 3以后实现了很多追踪算法,都实现在contrib模块中,安装参考。

下面code实现了跟踪笔记本摄像头画面中的固定区域物体,可以选用OpenCV实现的算法#include <opencv2/opencv.hpp>#include <opencv2/tracking.hpp>using namespace std;using namespace cv;int main(int argc, char** argv){// can change to BOOSTING, MIL, KCF (OpenCV 3.1), TLD, MEDIANFLOW, or GOTURN (OpenCV 3.2)Ptr<Tracker> tracker = Tracker::create("MEDIANFLOW");VideoCapture video(0);if(!video.isOpened()){cerr << "cannot read video!" << endl; return -1;}Mat frame;video.read(frame);Rect2d box(270, 120, 180, 260);tracker->init(frame, box);while(video.read(frame)){tracker->update(frame, box);rectangle(frame, box, Scalar(255, 0, 0), 2, 1); imshow("Tracking", frame);int k=waitKey(1);if(k==27) break;}}。

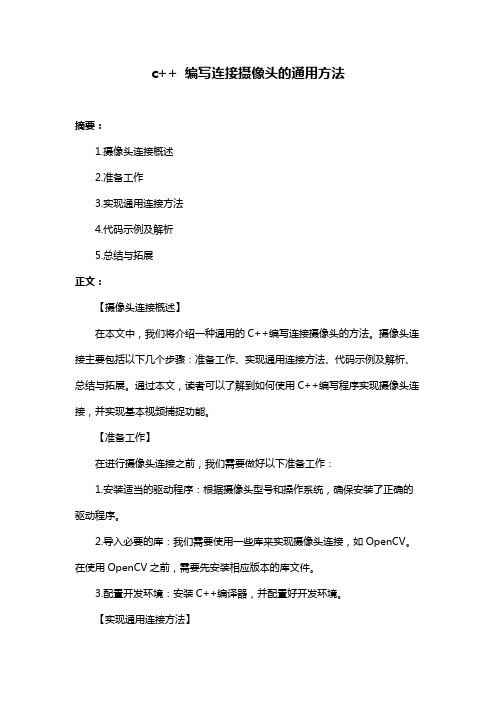

c++ 编写连接摄像头的通用方法

c++ 编写连接摄像头的通用方法摘要:1.摄像头连接概述2.准备工作3.实现通用连接方法4.代码示例及解析5.总结与拓展正文:【摄像头连接概述】在本文中,我们将介绍一种通用的C++编写连接摄像头的方法。

摄像头连接主要包括以下几个步骤:准备工作、实现通用连接方法、代码示例及解析、总结与拓展。

通过本文,读者可以了解到如何使用C++编写程序实现摄像头连接,并实现基本视频捕捉功能。

【准备工作】在进行摄像头连接之前,我们需要做好以下准备工作:1.安装适当的驱动程序:根据摄像头型号和操作系统,确保安装了正确的驱动程序。

2.导入必要的库:我们需要使用一些库来实现摄像头连接,如OpenCV。

在使用OpenCV之前,需要先安装相应版本的库文件。

3.配置开发环境:安装C++编译器,并配置好开发环境。

【实现通用连接方法】在C++中,我们可以使用以下通用方法连接摄像头:1.初始化库:引入OpenCV库,并初始化cv::VideoCapture对象。

2.打开摄像头:使用cv::VideoCapture::open()方法尝试打开摄像头。

3.检查摄像头是否成功打开:通过检查cv::VideoCapture对象的是否为null来判断摄像头是否成功打开。

4.释放资源:在程序结束时,释放摄像头资源,关闭cv::VideoCapture对象。

【代码示例及解析】以下是一个简单的C++代码示例,演示了如何实现摄像头连接:```cpp#include <iostream>#include <opencv2/opencv.hpp>int main() {// 初始化库cv::Mat frame;cv::VideoCapture cap(0); // 0表示默认摄像头// 检查摄像头是否成功打开if (!cap.isOpened()) {std::cout << "摄像头未打开,请检查摄像头是否正确连接。

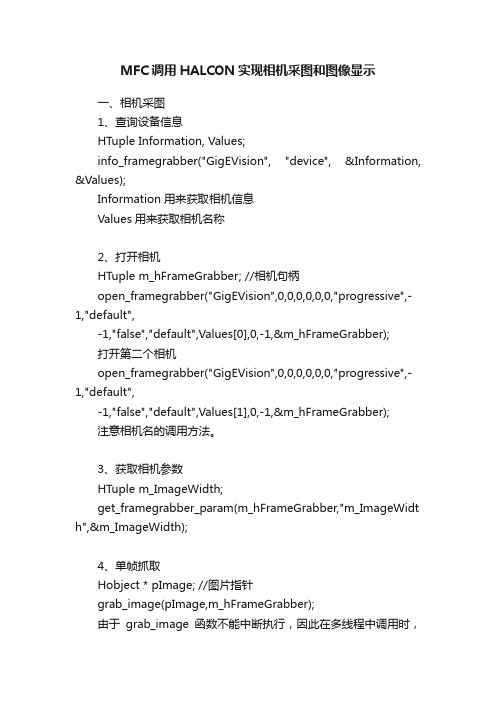

MFC调用HALCON实现相机采图和图像显示

MFC调用HALCON实现相机采图和图像显示一、相机采图1、查询设备信息HTuple Information, Values;info_framegrabber("GigEVision", "device", &Information, &Values);Information用来获取相机信息Values用来获取相机名称2、打开相机HTuple m_hFrameGrabber; //相机句柄open_framegrabber("GigEVision",0,0,0,0,0,0,"progressive",-1,"default",-1,"false","default",Values[0],0,-1,&m_hFrameGrabber);打开第二个相机open_framegrabber("GigEVision",0,0,0,0,0,0,"progressive",-1,"default",-1,"false","default",Values[1],0,-1,&m_hFrameGrabber);注意相机名的调用方法。

3、获取相机参数HTuple m_ImageWidth;get_framegrabber_param(m_hFrameGrabber,"m_ImageWidt h",&m_ImageWidth);4、单帧抓取Hobject * pImage; //图片指针grab_image(pImage,m_hFrameGrabber);由于grab_image函数不能中断执行,因此在多线程中调用时,需要注意对它的原子保护。

基于改进CamShift算法的嵌入式目标跟踪系统设计(方案)

标记运动目标

三、背景差法

当前图像的像素值与背景图像的像素值相减

Dk (x, y) fk (x, y) Bk (x, y)

通过设置一定的阈值,分割运动目标。

1 Tk (x, y) 0

Dk (x, y) T Dk (x, y) T

Page ▪ 9

背景差法检测效果

三、帧差法

帧间差法是将连续的两帧图像或三帧图像像素相减,像素变化大 于一定阈值,认为存在运动物体引起,则为前景,通过对运动物 体标记,确定目标的位置。

KNN学习是一种统计分类器,是经典的机器学习算法之一。 KNN算法又叫K最邻近分类算法,每个样本都可以用它最接近

的k个邻居来代表。 已知一个样本空间里的部分样本分成几个类,待分类的数据通

过找出与自己最接近的K个样本,由这K个样本决定待分类数 据为哪一类。

Page ▪ 15

基于KNN的分类

三、KNN机器学习算法

Page ▪ 5

平台搭建工作

OpenCV3和contrib模块

摄像头

树莓派3B+平台 Raspbian(Linux)操作系统

系统平台搭建

树莓派3B+是基于ARM Cortex-A53的微机主板,1.2GHz的64位四

核处理器,树莓派处理平台可以通过USB摄像头采集图像,实验中采

用测试视频进行实验,安装OpenCV3和Contrib模块,显示器使用

HDMI连接。

Page ▪ 6

三、运动目标检测的相关技术

运动目标的准确分割,对于获取目标的特征信息非常 重要,直接影响到进一步的运动目标跟踪的处理,传统的 运动目标检测算法主要有背景差法,帧间差法,光流法, 这些方法都有各自的缺点和不足,不能准确分割运动目标。 本文选用基于KNN的背景分割器进行运动目标检测。

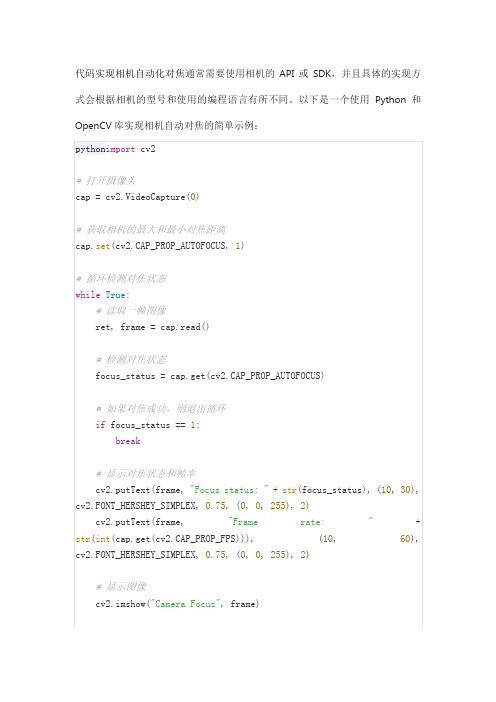

代码实现相机自动化对焦

pythonimportcv2

# 打开摄像头

cap = cv2.VideoCapture(0)

# 获取相机的最大和最小对焦距离

iffocus_status ==1:

break

# 显示对焦状态和帧率

cv2.putText(frame,"Focus status: "+str(focus_status), (10,30), cv2.FONT_HERSHEY_SIMPLEX,0.75, (0,0,255),2)

cv2.putText(frame,"Frame rate: "+str(int(cap.get(cv2.CAP_PROP_FPS))), (10,60), cv2.FONT_HERSHEY_SIMPLEX,0.75, (0,0,255),2)

cap.set(cv2.CAP_PROP_AUTOFOCUS,1)

# 循环检测对焦状态

whileTrue:

# 读取一帧图像

ret, frame = cap.read()

# 检测对焦状态

focus_status = cap.get(cv2.CAP_PROP_AUTOFOCUS)

# 如果对焦成功,则退出循环

# 显示图像

cv2.imshow("Camera Focus", frame)

# 按q键退出循环

ifcv2.waitKey(1) &0xFF==ord('q'):

break

# 释放摄像头并关闭窗口

cap.release()

在MFC中显示视频,图片

OpenCV學習筆記(9)利用MFC的Picture控件顯示圖像+播放視頻和捕獲攝像頭畫面收藏人:彦北2013-06-16 | 阅:2724 转:8 | 来源 | 分享/rocky69/article/details/7726553P.S.:後面又添加了播放視頻和捕獲攝像頭畫面的功能,其中播放視頻的功能只有'Play' 和'Stop',不能實現暫停,《A step-by-step guide to the use of Microsoft Visual C++ and the Intel OpenCV library》中好像有關於多線程防止任務沖突(Mutex)的內容,深入學習和了解那一部分後再嘗試做暫停的功能和其它更復雜的應用。

下面是新增功能後的項目文件(可直接運行):/source/2155367在《OpenCV教程-基礎篇》的2.8節中,所創建的MFC圖像顯示是直接放在對話框面板的左上角的,《A step-by-step 《MFC中快速應用OpenCV》則是介紹用SDI(單文檔界面)來顯示圖像,感覺不大美觀;guide to the use of Microsoft Visual C++ and the Intel OpenCV library》使用VS2005來進行圖像和視頻的讀取和處理,但是其圖像和視頻的顯示界面不是在對話框裡面的,而是新建一個窗口來做。

所以下面我們就來看看怎麼在對話框裡使用Picture控件來顯示和處理圖像。

一、創建MFC首先創建一個MFC對話框應用程序(Dialog-based Application)如下:在VS2005和2008裡,我們可以用一個Solution 來組合幾個Project (每個Project 基本上只包含一個Program),當我們要構建一個多Program的應用時(例如一個客戶端程序加一個服務器應用程序),利用Solution 可以將這些Projects 組合起來、並且共享文件和函數庫。

csrt()函数

csrt()函数`cv::TrackerCSRT` 是OpenCV库中用于目标跟踪的类,它实现了基于颜色和空间信息的稳定可重复(CSR-DCF)目标跟踪算法。

CSR-DCF 是一种视觉目标跟踪算法,具有较高的准确性和鲁棒性,尤其在处理复杂场景和快速目标运动时表现良好。

下面是一个简单的示例,演示了如何使用`cv::TrackerCSRT` 进行目标跟踪:```cpp#include <opencv2/opencv.hpp>int main() {// 打开视频文件或者摄像头cv::VideoCapture cap("path/to/your/video.mp4");if (!cap.isOpened()) {std::cerr << "Error: Couldn't open the video file." << std::endl;return -1;}// 读取第一帧cv::Mat frame;cap >> frame;// 定义感兴趣区域(ROI)cv::Rect2d roi(100, 100, 50, 50);// 创建TrackerCSRT 对象cv::Ptr<cv::TrackerCSRT> tracker = cv::TrackerCSRT::create();// 初始化跟踪器tracker->init(frame, roi);// 开始跟踪while (cap.read(frame)) {// 更新跟踪器if (tracker->update(frame, roi)) {// 跟踪成功,绘制矩形框cv::rectangle(frame, roi, cv::Scalar(0, 255, 0), 2);} else {// 跟踪失败cv::putText(frame, "Tracking failure detected", cv::Point(100, 80),cv::FONT_HERSHEY_SIMPLEX, 0.75, cv::Scalar(0, 0, 255), 2);}// 显示帧cv::imshow("Tracking", frame);// 按'Esc' 键退出if (cv::waitKey(30) == 27) {break;}}// 释放视频捕获和关闭窗口cap.release();cv::destroyAllWindows();return 0;}```这是一个基本的跟踪器应用程序,它从视频中读取帧并使用`TrackerCSRT` 跟踪指定的目标区域。

视频目标跟踪算法与实现

视频目标跟踪算法与实现目标跟踪是计算机视觉领域中的重要任务之一。

它可以用于监控、智能交通、虚拟现实等众多领域。

在视频目标跟踪中,我们的目标是根据输入视频序列找出感兴趣的目标,然后在不同帧之间追踪目标的位置。

为了实现视频目标跟踪,我们需要采用适当的算法。

目前,常用的视频目标跟踪算法可以分为两大类:基于特征的跟踪算法和深度学习算法。

基于特征的跟踪算法主要依靠图像特征来进行目标跟踪。

其中,常见的算法包括:1. 光流法:光流法利用相邻帧之间的像素亮度差异来估计目标的运动。

通过对光流向量的计算和分析,可以推断出目标的位置和速度。

然而,光流法容易受到光照变化和纹理丰富度等因素的影响,导致跟踪结果不准确。

2. 直方图匹配法:直方图匹配法利用目标区域的颜色直方图进行跟踪。

它通过计算帧间颜色直方图的相似度来判断目标的位置。

直方图匹配法简单易懂,但对目标的颜色分布要求较高,不适用于复杂场景。

3. 卡尔曼滤波器:卡尔曼滤波器是一种用于状态估计的优化算法,可以对目标的位置和速度进行预测和修正。

它可以利用先验知识和测量结果来逐步调整估计值。

卡尔曼滤波器具有较好的鲁棒性和实时性,但对目标运动模型的假设较为严格。

与基于特征的算法相比,深度学习算法能够更准确地捕捉目标的特征,从而实现更精确的目标跟踪。

深度学习算法通常采用卷积神经网络(Convolutional Neural Network,CNN)来提取特征,并使用适当的分类器或回归器来预测目标的位置。

常见的深度学习算法包括:1. 基于卷积神经网络的目标跟踪:利用卷积神经网络对输入帧进行特征提取,然后通过分类器或回归器来预测目标的位置。

这种方法能够较好地捕捉目标的纹理和形状特征,实现精确的目标跟踪。

2. 循环神经网络(Recurrent Neural Network,RNN):循环神经网络可以对目标的时序信息进行建模,从而实现更准确的目标跟踪。

它通过学习帧间的时序关系来预测目标的位置。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

在MFC对话框的控件中显示Opencv摄像头视频+Camshift跟踪算法实现

2010-05-07 16:31

一般用opencv显示视频,都用cvNamedWindow新建窗口,并且在while循环中更新每一帧视频,由于窗口是opencv自己创建的,所以在VC中很难对其进行控制,出于这个目的,希望能将视频显示在VC能够控制的部件中。

这里给出一个实例说明如何在MFC对话框的picture控件中显示摄像头视频。

主要步骤为:

1.建立对话框工程并设置对话框布局

注意对话框中间的是picture控件用于显示视频。

2.和console的程序一样,设置opencv库环境,加入opencv头文件,并定义所需要的变量。

3.关键的是这一步,定义CvvImage类型的变量m_CvvImage,这个类型的变量里有函数DrawToHDC能在MFC的控件中显示视频。

还有一个关键的一步是设置定时器timer,MFC中不用while循序来更新每帧视频,取而代之的是在定时器timer的响应函数中实现视频的更新,在本程序中每100毫秒进入一次定时器,定时器响应时间可以更改。

这里给出“打开摄像头”和定时器timer的响应函数。

01void COpencvUIDlgDlg::OnOpencamera() //打开摄像头按钮的响应函数

02{

03// TODO: Add your control notification handler code here

04m_Video=cvCreateCameraCapture-1//打开摄像头

05

06if!m_Video

07return

08

09SetTimer1,100,NULL//设置定时器

10}

11

12void COpencvUIDlgDlg::OnTimer UINT nIDEvent//定时器的响应函数

13{

14// TODO: Add your message handler code here and/or call default 15// KillTimer(nIDEvent);

16m_Frame=cvQueryFrame m_Video//m_Frame是IplImage指针类型17m_CvvImage.CopyOf m_Frame,1//m_CvvImage是CvvImage类型

18m_CvvImage.DrawToHDC hDC,&rect

19//将CvvImage显示在picture控件中,hDC是picture控件的句柄.rect是picture的区域.

20b_flagProcess=1

21

22CDialog::OnTimer nIDEvent

23}

4.加入截图和保存视频功能。

本程序下载地址:/source/1617588

---------------------------------------------------------------------------------------------------------------------------------

可以对本程序进行二次开发,下面实现在上述程序的基础上实现Camshift跟踪算法。

Opencv中自带Camshift跟踪算法的实现(OpenCV\samples\c\camshiftdemo.c),不过是基于console的,在MFC中实现则不能用其本来的鼠标回调函数来定位目标,而要改用MFC的鼠标消息响应函数。

运行结果为:

本程序下载地址:/source/1617559。