开源爬虫软件汇总

爬虫工具汇总

爬虫工具汇总

Heritrix

Heritrix是一个开源,可扩展的web爬虫项目。

Heritrix设计成严格按照robots.txt文件的排除指示和META robots标签。

WebSPHINX

WebSPHINX是一个Java类包和Web爬虫的交互式开发环境。

Web爬虫(也叫作机器人或蜘蛛)是可以自动浏览与处理Web页面的程序。

WebSPHINX由两部分组成:爬虫工作平台和WebSPHINX类包。

~rcm/websphinx/

WebLech

WebLech是一个功能强大的Web站点下载与镜像工具。

它支持按功能需求来下

载web站点并能够尽可能模仿标准Web浏览器的行为。

WebLech有一个功能控制台并采用多线程操作。

Arale

Arale主要为个人使用而设计,而没有像其它爬虫一样是关注于页面索引。

Arale能够下载整个web站点或来自web站点的某些资源。

Arale还能够把动态页面映射成静态页面。

J-Spider

J-Spider:是一个完全可配置和定制的Web Spider引擎.你可以利用它来检查

网站的错误(内在的服务器错误等),网站内外部链接检查,分析网站的结构(可创建一个网站地图),下载整个Web站点,你还可以写一个JSpider插件来扩展你所需要的功能。

spindle。

开源数据库管理工具

开源数据库管理工具开源数据库管理工具是指那些可以免费获取、使用和修改的数据库管理软件。

这些工具提供了一种方便、高效的方法来管理和操作数据库。

本文将介绍一些常见的开源数据库管理工具以及它们的功能和应用场景。

一、MySQL WorkbenchMySQL Workbench是一个功能强大的数据库设计和管理工具,适用于MySQL数据库。

它提供了直观的图形界面,方便用户进行数据库的设计、管理和查询。

MySQL Workbench支持多种操作系统,并且可以连接远程数据库,使得团队协作更加便捷。

此外,MySQL Workbench还提供了性能优化和调试工具,帮助用户提升数据库的运行效率。

二、pgAdminpgAdmin是一个开源的PostgreSQL数据库管理工具,支持Windows、Linux和macOS等操作系统。

它提供了类似于MySQL Workbench的功能,可以进行数据库设计、管理和查询。

pgAdmin还具备备份恢复、性能优化和监控等功能,帮助用户更好地管理PostgreSQL数据库。

三、phpMyAdminphpMyAdmin是一个基于Web的MySQL数据库管理工具,它允许用户通过浏览器来管理MySQL数据库。

phpMyAdmin提供了图形界面,使得用户可以方便地进行数据库的创建、编辑和删除。

此外,phpMyAdmin还支持SQL查询、导入导出数据和用户权限管理等功能,使得数据库管理更加便捷。

四、AdminerAdminer是一个功能齐全的数据库管理工具,支持MySQL、PostgreSQL、SQLite和Oracle等多种数据库。

与其他数据库管理工具相比,Adminer的特点之一是体积小巧,仅有一个PHP文件,便于快速部署和使用。

它提供了图形化界面和SQL编辑器,满足用户进行数据库操作的需要。

五、Sequel ProSequel Pro是一款专为Mac开发者设计的MySQL数据库管理工具。

它提供了直观的用户界面和强大的功能,适用于数据库的设计、管理和查询。

爬虫工具汇总

He ritri x是一个开源,可扩展的web爬虫项目。

H eritr ix设计成严格按照r obots.txt文件的排除指示和MET A rob ots标签。

htt p://c rawle r.arc hive.org/WebS PHINXWebS PHINX是一个Ja va类包和Web爬虫的交互式开发环境。

W eb爬虫(也叫作机器人或蜘蛛)是可以自动浏览与处理Web页面的程序。

W ebSPH INX由两部分组成:爬虫工作平台和Web SPHIN X类包。

http://www.cs.c mu.ed u/~rc m/web sphin x/W ebLec hWeb Lech是一个功能强大的Web站点下载与镜像工具。

它支持按功能需求来下载web站点并能够尽可能模仿标准Web浏览器的行为。

WebL ech有一个功能控制台并采用多线程操作。

http://we blech.sour cefor ge.ne t/A raleArale主要为个人使用而设计,而没有像其它爬虫一样是关注于页面索引。

Arale能够下载整个web站点或来自w eb站点的某些资源。

Arale还能够把动态页面映射成静态页面。

htt p://w eb.ti scali.it/_flat/arale.jsp.htmlJ-Sp iderJ-Spi der:是一个完全可配置和定制的WebSpide r引擎.你可以利用它来检查网站的错误(内在的服务器错误等),网站内外部链接检查,分析网站的结构(可创建一个网站地图),下载整个We b站点,你还可以写一个JSpi der插件来扩展你所需要的功能。

Java 程序员必备的10款开源工具

Java世界中存在许多工具,从Eclipse,NetBeans和IntelliJ IDEA等著名的IDE开始到Java开发人员应该知道的JVM分析和监视工具,如JConsole,VisualVM,Eclipse Memory Analyzer 等。

如果你是一位经验丰富的Java开发人员,你可能对这些工具很熟悉,但如果不是,现在就是是开始学习这些工具的好时机。

在本文中,我将重点介绍适用于各种Java开发人员的通用工具,例如核心Java 开发人员和Web开发人员。

1. JIRAAtlassian的JIRA是当前敏捷开发领域最重要的工具之一。

它用于错误跟踪,问题跟踪和项目管理。

如果你遵循敏捷开发方法,例如Sprint和Scrum,那么你必须了解JIRA。

它允许您创建Spring循环并跟踪软件开发的进度。

JIRA 是目前比较流行的基于Java架构的管理系统,由于Atlassian公司对很多开源项目实行免费提供缺陷跟踪服务,因此在开源领域,其认知度比其他的产品要高得多,而且易用性也好一些。

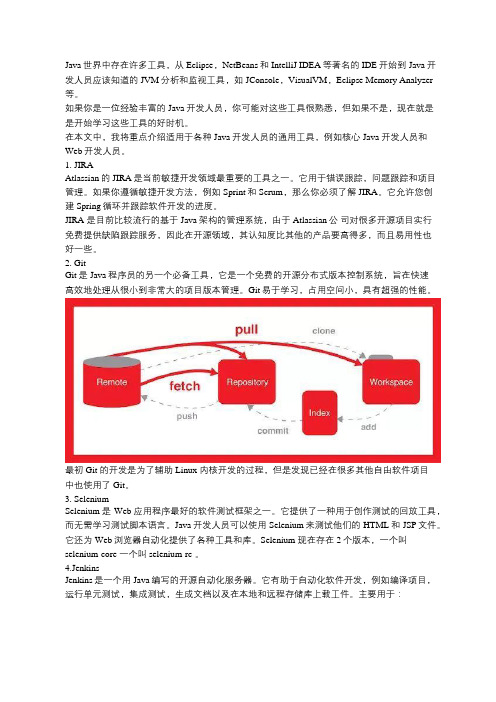

2. GitGit是Java程序员的另一个必备工具,它是一个免费的开源分布式版本控制系统,旨在快速高效地处理从很小到非常大的项目版本管理。

Git易于学习,占用空间小,具有超强的性能。

最初 Git 的开发是为了辅助 Linux 内核开发的过程,但是发现已经在很多其他自由软件项目中也使用了 Git。

3. SeleniumSelenium是Web应用程序最好的软件测试框架之一。

它提供了一种用于创作测试的回放工具,而无需学习测试脚本语言。

Java开发人员可以使用Selenium来测试他们的HTML和JSP文件。

它还为Web浏览器自动化提供了各种工具和库。

Selenium 现在存在2个版本,一个叫selenium-core 一个叫selenium-rc 。

4.JenkinsJenkins是一个用Java编写的开源自动化服务器。

它有助于自动化软件开发,例如编译项目,运行单元测试,集成测试,生成文档以及在本地和远程存储库上载工件。

centos7中配置python爬虫selenium+chromium+chromedri。。。

centos7中配置python爬⾍selenium+chromium+chromedri。

今天为了爬取某异步加载⽹站的数据,开始⾃学了selenium,不得不说selenium还是很⽅便的⼯具,适合⽆脑爬取异步加载的⽹站。

⾸先我在⾃⼰的windows电脑下配置了selenium和chromedriver的chrome浏览器内核,正常调试好程序后准备部署到centos7服务器上,但是遇到了很多问题,不停报错,在踩了很多雷以后终于可以完美部署selenium+chromium+chromedriver环境顺利爬⾍了!接下来我就详细介绍下正确的配置⽅式1. 安装selenium:这⼀步⽐较简单,直接pip安装就⾏:pip install selenium2. 安装chromium:由于⾕歌chrome并不⽀持linux,也就更不⽀持centos了,所以需要安装chromium,不过不⽤担⼼,chromium也是⾕歌的开源项⽬,与chrome并没有太⼤的区别yum install chromium这⼀步也没什么问题,需要注意⼀下chromium安装的版本,因为要与下⼀步需要安装的chromedriver版本相适配,⼆者版本不同都会报错,这⾥我也是踩雷了,chromium默认安装的最新版为“79.0.3945.130-1.el7”,但是chromedriver已经更新到了81.0,第⼀次安装的时候我选择了最⾼版本的chromedriver,但是chromium还是79.0版本,执⾏python脚本的时候就报错版本不适配,所以我重新安装了对应版本的chromedriver。

如何查看安装的chromium版本?yum就可以看到yum list installed3. 安装chromedriver:这⾥我们从taobao镜像站点安装:# 下载对应版本的chromedriverwget https:///mirrors/chromedriver/79.0.3945.16/chromedriver_linux64.zip# 解压unzip chromedriver_linux64.zip# 把chromedriver移动到系统⽬录mv chromedriver /usr/bin⽅法2:直接yum安装,这样其实更省事⼉⼀点yum chromedriver安装完成后确认⼀下版本与chromium保持⼀致:到这⼀步已经配置好selenium+chromium+chromedriver的环境了,接下来我们写⼀个最简单的python脚本试⼀下!from selenium import webdriverfrom selenium.webdriver.chrome.options import Options # 导⼊浏览器内核设置,主要是为了设置⽆头(headless)模式url = ''chrome_options = Options()chrome_options.add_argument('--headless') # 设置Chrome为⽆头模式driver = webdriver.Chrome(options=chrome_options)driver.get(url)driver.close()诶,报错了:The process started from chrome location /usr/lib64/chromium-browser/chromium-browser is no longer running, so ChromeDriver is assuming that Chrome has crashed在脚本上加上两句话:option.add_argument('no-sandbox')option.add_argument('disable-dev-shm-usage')完美解决了!。

数据采集平台软件介绍

数据采集平台软件介绍1. Webhose.io:Webhose.io 是一个提供全球范围内全面的互联网数据收集和分析解决方案的数据提供商。

它使用自动化的网络爬虫技术,从互联网上收集大量的结构化、半结构化和非结构化数据。

Webhose.io 的特点包括高质量的数据源、实时数据获取、自定义数据筛选和分析工具。

它的应用场景包括市场调研、竞争情报、舆情分析等。

2. Import.io:Import.io 是一款强大的 Web 数据提取工具。

它可以将网页上的信息提取为结构化的数据,并可将其导出到 Excel、CSV 或数据库等格式。

Import.io 可以通过简单的点击和拖放来配置网页数据提取任务,而无需编写代码。

它的应用场景包括数据抓取、价格监测、市场分析等。

3. ParseHub:ParseHub 是一款易于使用且功能强大的网络爬虫工具。

它可以从各种网站提取数据,并将其转换为结构化的格式。

ParseHub 的特点包括可视化的配置界面、高度定制的数据选择和转换、自动化和调度功能等。

它适用于市场研究、数据分析、内容聚合等领域。

4. Octoparse:Octoparse 是一款智能的网页数据提取工具,它可以从各种网站抓取数据,并将其转换为结构化的格式。

Octoparse 的特点包括强大的抓取能力、智能的数据识别和处理、可视化的任务配置界面等。

Octoparse 的应用场景包括电子商务竞争情报、新闻聚合、舆情监测等。

5. Scrapy:Scrapy 是一款开源的 Python 框架,用于构建和部署定制化的网络爬虫软件。

它具有高度的可定制性和灵活性,并支持多种数据导出格式。

Scrapy 提供了强大的网络爬取和数据处理功能,适用于各种科研、商业和工程领域。

6. PhantomJS:PhantomJS 是一个基于 WebKit 的"无头"浏览器,它可以模拟浏览器行为,并将网页呈现为图像或 PDF。

基于开源框架的论坛数据爬虫系统设计与关键技术

产业科技创新 Industrial Technology Innovation74Vol.2 No.20基于开源框架的论坛数据爬虫系统设计与关键技术王佳龙,张文兵(神华和利时信息技术有限公司,北京 100001)摘要:在信息快速发展的当今时代,数据分析与采集不可或缺,笔者收集了大量关于论坛数据采集的参考文献,设计了这一款系统,可以快速帮助笔者采集数据并进行分析处理,采集技术为JSP\Servlet,编程语言为Java语言,有登陆、注册、链采集、入库、导出、退出模块。

关键词:数据;采集;网页;Java中图分类号:TP311.52 文献标识码:A 文章编号:2096-6164(2020)20-0074-021 绪论1.1 网页采集系统的研究意义和应用在计算机广泛应用和使用的今天,数据采集在多个领域有着十分重要的应用它是计算机与外部物理世界连接的桥梁利用串行或红外通信方式,实现对移动数据采集器的应用软件升级,该通信协议实现了上位机(PC)与移动数据采集器之间的通信阻塞过程,在工业、工程、生产车间等部门,尤具是在对信息实时性能要求较高或者恶劣的数据采集环境中更突出其应用的必要性。

1.2 网页采集系统简介网页采集系统是基于计算机(或微处理器)测量软件产品,实现灵活的快捷的用户自定义测量系统。

该网页数据采集系统是一种基于开源框架的论坛数据爬虫系统,可以高效采集数据并进行分析处理。

1.3 网页采集系统内容网页采集系统的内容有登陆、注册、采集、入库、导出、退出等,用户访问需要登陆,登陆时候会有默认的帐户名密码并保存到数据库中,当然也可以注册新的帐户名密码,注册成功则保存到数据库,登陆通过比对数据库进行登陆,登陆成功以后进行采集,采集采用链采集的形式,采集一页自动查询是否有其他相关页,有的话一并采集,采集成功后自动入库并按用户要求显示到网页上,根据用户选择导出到word文档供用户查看并操作,最后采集完成后退出登录。

21款开源搜索引擎项目介绍

21款开源搜索引擎项目介绍搜索引擎的主流语言是Java,要研究和开发搜索引擎,最好从Lucene开始,下面介绍一些开源搜索引擎系统,包含开源Web搜索引擎和开源桌面搜索引擎。

Lucene一个全文搜索引擎工具包,但只支持文本文件以及少量语种的索引;通过Lucene提供的接口,我们可以自己开发具体语言的分词器,针对具体文档的文本解析器等;Lucene是索引数据结构事实上的标准;Apache Lucene是一个基于Java全文搜索引擎,利用它可以轻易地为Java软件加入全文搜寻功能。

Lucene的最主要工作是替文件的每一个字作索引,索引让搜寻的效率比传统的逐字比较大大提高,Lucen提供一组解读,过滤,分析文件,编排和使用索引的API,它的强大之处除了高效和简单外,是最重要的是使使用者可以随时应自已需要自订其功能。

Sphider Sphider是一个轻量级,采用PHP开发的web spider和搜索引擎,使用mysql来存储数据。

可以利用它来为自己的网站添加搜索功能。

Sphider非常小,易于安装和修改,已经有数千网站在使用它。

RiSearch PHPRiSearch PHP是一个高效,功能强大的搜索引擎,特别适用于中小型网站。

RiSearch PHP非常快,它能够在不到1秒钟内搜索5000-10000个页面。

RiSearch是一个索引搜索引擎,这就意味着它先将你的网站做索引并建立一个数据库来存储你网站所有页面的关键词以便快速搜索。

Risearch是全文搜索引擎脚本,它把所有的关键词都编成一个文档索引除了配置文件里面的定义排除的关键词。

RiSearch使用经典的反向索引算法(与大型的搜索引擎相同),这就是为什么它会比其它搜索引擎快的原因。

Xapian使用C++编写,提供绑定程序使得其他语言能够方便地使用它;便于进行二次开发PhpDigPhpDig是一个采用PHP开发的Web爬虫和搜索引擎。

通过对动态和静态页面进行索引建立一个词汇表。

大数据分析中的数据采集与清洗自动化工具介绍(Ⅰ)

随着信息技术的不断发展,大数据分析已经成为了企业决策和发展的重要工具。

而在大数据分析的过程中,数据的采集和清洗是至关重要的环节。

本文将介绍几种常用的数据采集与清洗自动化工具,帮助读者更好地理解大数据分析中的关键环节。

一、数据采集工具1. Apache NutchApache Nutch 是一个开源的网络搜索引擎。

它可以帮助用户获取网页信息,并将其转换为结构化的数据,方便后续的分析和处理。

Nutch 支持多种数据存储格式,包括文本、HTML、XML 等,并且可以通过定制插件来扩展其功能。

它的分布式架构和高性能使得它成为了大规模数据采集的首选工具之一。

2. ScrapyScrapy 是一个基于 Python 的开源网络爬虫框架。

它提供了简洁的 API 和强大的选择器功能,可以帮助用户快速高效地获取网页信息。

Scrapy 支持异步网络请求和自定义中间件,同时还提供了丰富的插件和扩展机制。

这使得它成为了一款非常灵活和易用的数据采集工具。

二、数据清洗工具1. OpenRefineOpenRefine(前身为 Google Refine)是一款开源的数据清洗工具。

它支持导入多种数据格式,包括 CSV、JSON、XML 等,同时还提供了强大的数据转换和整合功能。

OpenRefine 还支持实时预览和撤销操作,为用户提供了非常便利的数据清洗环境。

另外,它还支持自定义插件和扩展,使得用户可以根据实际需求定制功能。

2. Trifacta WranglerTrifacta Wrangler 是一款专注于数据清洗和转换的商业工具。

它提供了直观的用户界面和丰富的数据处理操作,可以帮助用户快速高效地清洗数据。

Trifacta Wrangler 还支持数据质量分析和自动化建模,为用户提供了一站式的数据清洗解决方案。

值得一提的是,它还支持与 Hadoop 和 Spark 等大数据处理平台的集成,为用户提供了更加便捷的数据处理流程。

网页内容抓取工具哪个好用

网页内容抓取工具哪个好用互联网上目前包含大约几百亿页的数据,这应该是目前世界上最大的可公开访问数据库。

利用好这些内容,是相当有意思的。

而网页内容抓取工具则是一种可以将网页上内容,按照自己的需要,导出到本地文件或者网络数据库中的软件。

合理有效的利用,将能大大提高自己的竞争力。

网页内容抓取工具有哪些1. 八爪鱼八爪鱼是一款免费且功能强大的网站爬虫,用于从网站上提取你需要的几乎所有类型的数据。

你可以使用八爪鱼来采集市面上几乎所有的网站。

八爪鱼提供两种采集模式 - 简易模式和自定义采集模式,非程序员可以快速习惯使用八爪鱼。

下载免费软件后,其可视化界面允许你从网站上获取所有文本,因此你可以下载几乎所有网站内容并将其保存为结构化格式,如EXCEL,TXT,HTML或你的数据库。

2、ParseHubParsehub是一个很棒的网络爬虫,支持从使用AJAX技术,JavaScript,cookie 等的网站收集数据。

它的机器学习技术可以读取,分析然后将Web文档转换为相关数据。

Parsehub的桌面应用程序支持Windows,Mac OS X和Linux等系统,或者你可以使用浏览器中内置的Web应用程序。

作为免费软件,你可以在Parsehub中设置不超过五个publice项目。

付费版本允许你创建至少20private项目来抓取网站。

3、ScrapinghubScrapinghub是一种基于云的数据提取工具,可帮助数千名开发人员获取有价值的数据。

它的开源视觉抓取工具,允许用户在没有任何编程知识的情况下抓取网站。

Scrapinghub使用Crawlera,一家代理IP第三方平台,支持绕过防采集对策。

它使用户能够从多个IP和位置进行网页抓取,而无需通过简单的HTTP API进行代理管理。

Scrapinghub将整个网页转换为有组织的内容。

如果其爬虫工具无法满足你的要求,其专家团队可以提供帮助。

4、Dexi.io作为基于浏览器的网络爬虫,Dexi.io允许你从任何网站基于浏览器抓取数据,并提供三种类型的爬虫来创建采集任务。

12款开源的低代码开发平台,建议收藏

12款开源的低代码开发平台,建议收藏随着业务系统越来越复杂、高度定制化,IT部门无法满足快速响应并促进企业发展的需求。

低代码开发平台的出现,可以帮助开发人员快速构建和部署功能丰富的应用程序,使企业拥有更具竞争力的软件解决方案。

当前市场上有许多开源的低代码开发平台,如Kintone、Mendix、OutSystems、ThingWorx、Zudy、Chef、AWS QuickSight、Pega、Kissflow、MuleSoft、Lightning Platform和Retool,它们提供了基于Web的可视化工具,可以帮助开发人员在短时间内构建出更复杂、可定制化的应用程序。

Kintone能够让开发人员快速创建出有效的工作流程,它提供了一套完整的应用开发和管理解决方案,可以提高开发效率。

Mendix是一款基于云的企业级应用开发平台,可以帮助开发人员快速创建复杂的应用程序,并节省更多的时间,以实现客户的需求。

OutSystems是一款多平台的低代码开发平台,能够支持跨终端开发,开发人员可以使用该平台快速创建出功能强大的应用程序。

ThingWorx可以让用户快速构建从虚拟工厂到可穿戴设备的设备互联网解决方案,为企业提供了一步到位的服务。

Zudy可以满足企业在技术创新方面的最新需求,可以快速构建出整套应用程序,可以支持复杂的数据结构。

Chef一款灵活易用的低代码开发平台,支持多种不同的开发模式以及开发语言,能够快速构建具有可定制性的应用。

AWS QuickSight提供了强大的数据可视化功能,可以帮助用户实时监测、分析和调整系统,使企业更容易获取和掌握重要信息。

Pega是一款具有可定制性的可视化低代码开发平台,可以帮助企业快速构建出强大的软件解决方案,有助于企业实现业务效率的提高。

Kissflow支持多端使用,可以构建出定制性强的应用,能够满足企业自动化办公和流程管理的需求。

MuleSoft是一款功能全面的开源私有低代码开发平台,可以构建出符合企业要求的应用程序,以及实施API连接和管理。

python爬虫10例经典例子

python爬虫10例经典例子当谈到Python爬虫,经典的例子可能包括以下几种:1. 爬取静态网页数据,使用库如requests或urllib来获取网页内容,然后使用正则表达式或者BeautifulSoup来解析页面,提取所需数据。

2. 爬取动态网页数据,使用Selenium或者PhantomJS等工具模拟浏览器行为,获取JavaScript渲染的页面内容。

3. 爬取图片,通过爬虫下载图片,可以使用requests库发送HTTP请求,获取图片的URL,然后使用openCV或者PIL库来处理图片。

4. 爬取视频,类似图片爬取,但需要考虑视频文件的大小和格式,可能需要使用FFmpeg等工具进行处理。

5. 爬取特定网站,例如爬取新闻网站的新闻内容,或者爬取电商网站的商品信息,需要根据网站的结构和特点编写相应的爬虫程序。

6. 爬取社交媒体数据,可以通过API或者模拟登录的方式爬取Twitter、Facebook等社交媒体平台的数据。

7. 数据存储,将爬取的数据存储到数据库中,可以使用MySQL、MongoDB等数据库,也可以将数据保存为CSV、JSON等格式。

8. 数据清洗和分析,对爬取的数据进行清洗和分析,去除重复数据、处理缺失值,进行数据可视化等操作。

9. 自动化爬虫,编写定时任务或者事件触发的爬虫程序,实现自动化的数据采集和更新。

10. 反爬虫策略,了解和应对网站的反爬虫机制,如设置请求头、使用代理IP、限制访问频率等,以确保爬虫程序的稳定运行。

以上是一些Python爬虫的经典例子,涵盖了静态网页、动态网页、多媒体文件、特定网站、社交媒体等不同类型的数据爬取和处理方法。

希望这些例子能够帮助你更好地理解Python爬虫的应用和实现。

33款可用来抓数据的开源爬虫软件工具

33款可用来抓数据的开源爬虫软件工具要玩大数据,没有数据怎么玩?这里推荐一些33款开源爬虫软件给大家。

爬虫,即网络爬虫,是一种自动获取网页内容的程序。

是搜索引擎的重要组成部分,因此搜索引擎优化很大程度上就是针对爬虫而做出的优化。

网络爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成。

传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。

聚焦爬虫的工作流程较为复杂,需要根据一定的网页分析算法过滤与主题无关的链接,保留有用的链接并将其放入等待抓取的URL队列。

然后,它将根据一定的搜索策略从队列中选择下一步要抓取的网页URL,并重复上述过程,直到达到系统的某一条件时停止。

另外,所有被爬虫抓取的网页将会被系统存贮,进行一定的分析、过滤,并建立索引,以便之后的查询和检索;对于聚焦爬虫来说,这一过程所得到的分析结果还可能对以后的抓取过程给出反馈和指导。

世界上已经成型的爬虫软件多达上百种,本文对较为知名及常见的开源爬虫软件进行梳理,按开发语言进行汇总。

虽然搜索引擎也有爬虫,但本次我汇总的只是爬虫软件,而非大型、复杂的搜索引擎,因为很多兄弟只是想爬取数据,而非运营一个搜索引擎。

Java爬虫1、ArachnidArachnid是一个基于Java的web spider框架.它包含一个简单的HTML剖析器能够分析包含HTML内容的输入流.通过实现Arachnid 的子类就能够开发一个简单的Web spiders并能够在Web站上的每个页面被解析之后增加几行代码调用。

Arachnid的下载包中包含两个spider应用程序例子用于演示如何使用该框架。

特点:微型爬虫框架,含有一个小型HTML解析器许可证:GPL2、crawlzillacrawlzilla 是一个帮你轻松建立搜索引擎的自由软件,有了它,你就不用依靠商业公司的搜索引擎,也不用再烦恼公司內部网站资料索引的问题。

83款网络爬虫开源软件

83款⽹络爬⾍开源软件Nutch 是⼀个开源Java 实现的搜索引擎。

它提供了我们运⾏⾃⼰的搜索引擎所需的全部⼯具。

包括全⽂搜索和Web爬⾍。

尽管Web搜索是漫游Internet的基本要求, 但是现有web搜索引擎的数⽬却在下降. 并且这很有可能进⼀步演变成为⼀个公司垄断了⼏乎所有的web...最近更新:发布于 20天前Grub Next Generation 是⼀个分布式的⽹页爬⾍系统,包含客户端和服务器可以⽤来维护⽹页的索引。

最近更新:发布于 3年前Soukey采摘⽹站数据采集软件是⼀款基于.Net平台的开源软件,也是⽹站数据采集软件类型中唯⼀⼀款开源软件。

尽管Soukey采摘开源,但并不会影响软件功能的提供,甚⾄要⽐⼀些商⽤软件的功能还要丰富。

Soukey采摘当前提供的主要功能如下: 1. 多任务多线... PhpDig是⼀个采⽤PHP开发的Web爬⾍和搜索引擎。

通过对动态和静态页⾯进⾏索引建⽴⼀个词汇表。

当搜索查询时,它将按⼀定的排序规则显⽰包含关键字的搜索结果页⾯。

PhpDig包含⼀个模板系统并能够索引PDF,Word,Excel,和PowerPoint⽂档。

PHPdig适⽤于专业化更...Snoopy是⼀个强⼤的⽹站内容采集器(爬⾍)。

提供获取⽹页内容,提交表单等功能。

NWebCrawler是⼀款开源的C#⽹络爬⾍程序Heritrix是⼀个开源,可扩展的web爬⾍项⽬。

⽤户可以使⽤它来从⽹上抓取想要的资源。

Heritrix设计成严格按照robots.txt⽂件的排除指⽰和META robots标签。

其最出⾊之处在于它良好的可扩展性,⽅便⽤户实现⾃⼰的抓取逻辑。

Heritrix是⼀个爬⾍框架,其组织结... Scrapy 是⼀套基于基于Twisted的异步处理框架,纯python实现的爬⾍框架,⽤户只需要定制开发⼏个模块就可以轻松的实现⼀个爬⾍,⽤来抓取⽹页内容以及各种图⽚,⾮常之⽅便~最近更新:发布于 6个⽉前webmagic的是⼀个⽆须配置、便于⼆次开发的爬⾍框架,它提供简单灵活的API,只需少量代码即可实现⼀个爬⾍。

feapder的使用

feapder的使用

摘要:

1.FEAPDER简介

2.FEAPDER安装与配置

3.FEAPDER功能与应用

4.FEAPDER的优势与不足

5.总结与建议

正文:

FEAPDER是一款功能强大、易于使用的网络爬虫工具,广泛应用于网页数据抓取、数据分析等领域。

本文将为您介绍FEAPDER的使用方法、功能与应用、优势与不足,并提供一些总结与建议。

一、FEAPDER简介

FEAPDER,全称Fast and Easy Web Data Extraction,是一款免费、开源的网络爬虫工具。

它具有简单易用的界面,支持多种编程语言,可以帮助用户快速抓取网页数据,提取所需信息。

二、FEAPDER安装与配置

1.下载与安装:

访问FEAPDER官方网站(https://feapder.github.io/)下载对应操作系统的安装包。

下载完成后,按照提示进行安装。

2.配置:

打开FEAPDER,进入配置界面。

根据实际需求,设置以下参数:

- 请求头:可自定义User-Agent,以避免被目标网站识别为爬虫。

- 请求方式:支持GET、POST等请求方式。

- 请求参数:可根据需要设置请求参数,如URL参数、表单提交等。

- 编码:根据目标网站的编码设置,以确保抓取到的数据正确显示。

三、FEAPDER功能与应用

1.网页抓取:

FEAPDER支持抓取指定URL的网页内容,可自定义请求头、请求参数等。

python爬虫项目100例

python爬虫项目100例随着互联网的快速发展,信息获取变得越来越重要。

而爬虫技术作为一种自动化获取网络信息的技术,受到了广泛的关注和应用。

Python 作为一种简洁、易学、功能强大的编程语言,成为了爬虫技术的首选语言。

下面将介绍100个Python爬虫项目的例子,希望能够给大家提供一些灵感和参考。

1. 爬取网页上的新闻标题和链接。

2. 爬取网页上的图片并保存到本地。

3. 爬取网页上的电影信息,并保存到数据库。

4. 爬取网页上的音乐信息,并保存到本地。

5. 爬取网页上的天气信息,并保存到数据库。

6. 爬取网页上的股票信息,并保存到本地。

7. 爬取网页上的商品信息,并保存到数据库。

8. 爬取网页上的招聘信息,并保存到本地。

9. 爬取网页上的房产信息,并保存到数据库。

10. 爬取网页上的电视剧信息,并保存到本地。

11. 爬取网页上的小说内容,并保存到数据库。

12. 爬取网页上的美食菜谱,并保存到本地。

13. 爬取网页上的旅游景点信息,并保存到数据库。

14. 爬取网页上的体育赛事信息,并保存到本地。

15. 爬取网页上的股票行情,并保存到数据库。

16. 爬取网页上的汽车信息,并保存到本地。

17. 爬取网页上的游戏攻略,并保存到数据库。

18. 爬取网页上的科技新闻,并保存到本地。

19. 爬取网页上的健康知识,并保存到数据库。

20. 爬取网页上的教育资讯,并保存到本地。

21. 爬取网页上的娱乐新闻,并保存到数据库。

22. 爬取网页上的军事新闻,并保存到本地。

23. 爬取网页上的历史资料,并保存到数据库。

24. 爬取网页上的美女图片,并保存到本地。

25. 爬取网页上的搞笑段子,并保存到数据库。

26. 爬取网页上的动漫资讯,并保存到本地。

27. 爬取网页上的游戏下载链接,并保存到数据库。

28. 爬取网页上的电影下载链接,并保存到本地。

29. 爬取网页上的音乐下载链接,并保存到数据库。

31. 爬取网页上的美食菜谱下载链接,并保存到数据库。

常见的爬虫语言

常见的爬虫语言

1. Python:Python是目前最常用的爬虫语言之一。

它有着简洁、易懂的语法,开源的社区提供了强大的第三方库,如Scrapy、Beautiful Soup等,可实现高效地爬取数据。

2. Java:Java在企业级应用中广泛使用,也有不少爬虫框架,如Jsoup、WebMagic等,可实现高效的网络爬虫。

3. JavaScript:JavaScript作为网页编程的核心语言,在浏览器中可实现爬取页面元素。

另外,也有不少Node.js模块可用于爬取数据。

4. PHP:PHP主要应用于Web开发,在爬虫方面主要通过CURL库实现HTTP请求,结合DOM操作可实现数据爬取。

5. Ruby:Ruby的代表框架Ruby on Rails在开发Web应用时极为出色,也有不少支持网络爬虫的库和框架,如Nokogiri和Mechanize等。

搜集行业资料的软件有哪些

搜集行业资料的软件有哪些搜集行业资料的软件有哪些在当今信息时代,行业资料的搜集对于市场调研和商业决策起着至关重要的作用。

为了高效地收集行业资料,许多软件应运而生。

本篇文档将介绍一些常用的搜集行业资料的软件,以帮助您更好地了解和选择适合您需求的工具。

1. 网络爬虫类工具网络爬虫类工具能够自动化地在互联网上搜集数据,对于各种行业资料的搜集具有较大的灵活性和高效性。

以下是几个常用的网络爬虫类工具:Scrapy:Scrapy是一个基于Python的开源网络爬虫框架,支持快速、高效、结构化的数据抓取。

它提供了强大的数据提取和处理能力,并且可以方便地扩展和定制。

Octoparse:Octoparse是一款简单易用的网络数据采集工具,它可以帮助用户将网页上的数据自动提取出来,并且支持将数据导出到Excel、数据库等格式。

import.io:import.io是一款强大的Web数据提取工具,它可以自动化地从各种网页上提取结构化的数据,并且支持导出为CSV、Excel、JSON等格式。

2. 数据库类工具如果您需要收集大量的行业资料并进行整理和存储,数据库类工具将是您的理想选择。

以下是一些常用的数据库类工具:MySQL:MySQL是一个免费的开源关系数据库管理系统,它具有功能强大、性能稳定的特点,在大数据处理和存储方面表现优秀。

MongoDB:MongoDB是一个开源的非关系型数据库,它适用于存储大量的非结构化数据和半结构化数据,具有高可扩展性和灵活性。

Elasticsearch:Elasticsearch是一个分布式、可扩展、实时的全文搜索和分析引擎,它支持近乎实时地存储、检索和分析大量的数据。

3. 信息聚合类工具信息聚合类工具能够从多个渠道收集和整合行业资料,以提供全面和及时的信息。

以下是一些常用的信息聚合类工具:Feedly:Feedly是一个流行的RSS订阅器,它可以帮助用户订阅和整合各种行业资讯源,以便及时获取行业动态。

nohub用法

nohub用法摘要:1.nohub 简介2.nohub 用法3.nohub 的优点4.nohub 的缺点5.nohub 的实际应用正文:【nohub 简介】ohub 是一个开源的网络爬虫框架,它可以帮助用户快速构建网络爬虫,抓取网页数据并进行解析。

nohub 具有简单易用、功能强大的特点,适用于各种网络数据抓取任务。

【nohub 用法】ohub 的用法非常简单,只需按照以下步骤操作即可:1.安装nohub:在命令行中输入“pip install nohub”进行安装。

2.创建爬虫项目:在命令行中输入“nohub create myspider”创建一个名为myspider 的爬虫项目。

3.编辑配置文件:在myspider 文件夹中找到“nohub.yml”文件,编辑项目配置。

配置项包括:start_urls(起始网址)、default_headers(默认请求头)、timeout(超时时间)等。

4.编写爬虫逻辑:在myspider 文件夹中找到“spider.py”文件,编写爬虫逻辑。

nohub 提供了一系列简单的方法,如:“fetch(url, callback)”获取网页内容并调用回调函数处理数据,“click(url, callback)”点击链接并调用回调函数处理数据等。

5.运行爬虫:在命令行中输入“nohub run”启动爬虫。

6.查看结果:在命令行中输入“nohub results”查看爬取结果。

【nohub 的优点】1.简单易用:nohub 的语法简单,易于上手,即使是初学者也能快速掌握。

2.功能强大:nohub 提供了丰富的功能,如模拟登录、处理重定向、识别验证码等,可以应对各种复杂的网络爬虫任务。

3.高效性能:nohub 基于Python 的异步编程机制,具有较高的性能,可以提高爬取效率。

【nohub 的缺点】1.学习成本:虽然nohub 易于上手,但对于有一定难度的网络爬虫任务,用户可能需要深入学习其底层原理。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

开源爬虫软件汇总开发语言

软件名称

软件介绍

许可证

Java

Arachnid

微型爬虫框架,含有一个小型HTML解析器

GPL

crawlzilla

安装简易,拥有中文分词功能

Apache2

Ex-Crawler

由守护进程执行,使用数据库存储网页信息GPLv3

Heritrix

严格遵照robots文件的排除指示和META robots标签LGPL

heyDr

轻量级开源多线程垂直检索爬虫框架

GPLv3

ItSucks

提供swing GUI操作界面

不详

jcrawl

轻量、性能优良,可以从网页抓取各种类型的文件Apache

JSpider

功能强大,容易扩展

LGPL

Leopdo

包括全文和分类垂直搜索,以及分词系统Apache

MetaSeeker

网页抓取、信息提取、数据抽取工具包,操作简单不详

Playfish

通过XML配置文件实现高度可定制性与可扩展性

MIT

Spiderman

灵活、扩展性强,微内核+插件式架构,通过简单的配置就可以完成数据抓取,无需编写一句代码

Apache

webmagic

功能覆盖整个爬虫生命周期,使用Xpath和正则表达式进行链接和内容的提取

Apache

Web-Harvest

运用XSLT、XQuery、正则表达式等技术来实现对Text或XML的操作,具有可视化的界面

BSD

WebSPHINX

由两部分组成:爬虫工作平台和WebSPHINX类包

Apache

YaCy

基于P2P的分布式Web搜索引擎

GPL

Python

QuickRecon

具有查找子域名名称、收集电子邮件地址并寻找人际关系等功能

GPLv3

PyRailgun

简洁、轻量、高效的网页抓取框架

MIT

Scrapy

基于Twisted的异步处理框架,文档齐全BSD

C++

hispider

支持多机分布式下载, 支持网站定向下载

BSD

larbin

高性能的爬虫软件,只负责抓取不负责解析

GPL

Methabot

经过速度优化、可抓取WEB、FTP及本地文件系统

不详

Methanol

模块化、可定制的网页爬虫,速度快不详

C#

NWebCrawler

统计信息、执行过程可视化

GPLv2

Sinawler

国内第一个针对微博数据的爬虫程序,功能强大

GPLv3

spidernet

以递归树为模型的多线程web爬虫程序,支持以GBK (gb2312)和utf8编码的资源,使用sqlite存储数据

MIT

Web Crawler

多线程,支持抓取PDF/DOC/EXCEL等文档来源LGPL

网络矿工

功能丰富,毫不逊色于商业软件

BSD

PHP

OpenWebSpider

开源多线程网络爬虫,有许多有趣的功能

不详

PhpDig

适用于专业化强、层次更深的个性化搜索引擎GPL

Snoopy

具有采集网页内容、提交表单功能

GPL

ThinkUp

采集推特、脸谱等社交网络数据的社会媒体视角引擎,可进行交互分析并将结果以可视化形式展现

GPL

微购

可采集淘宝、京东、当当等300多家电子商务数据

GPL

ErLang

Ebot

可伸缩的分布式网页爬虫

GPLv3

Ruby

Spidr

可将一个或多个网站、某个链接完全抓取到本地

MIT

开发语言软件名称软件介绍许可证Java Arachnid

微型爬虫框架,含有一个小型HTML解析器GPL

crawlzilla

安装简易,拥有中文分词功能

Apache2

Ex-Crawler

由守护进程执行,使用数据库存储网页信息GPLv3

Heritrix

严格遵照robots文件的排除指示和META robots标签LGPL

heyDr

轻量级开源多线程垂直检索爬虫框架

GPLv3

ItSucks

提供swing GUI操作界面

不详

jcrawl

轻量、性能优良,可以从网页抓取各种类型的文件Apache

JSpider

功能强大,容易扩展

LGPL

Leopdo

包括全文和分类垂直搜索,以及分词系统Apache

MetaSeeker

网页抓取、信息提取、数据抽取工具包,操作简单不详

Playfish

通过XML配置文件实现高度可定制性与可扩展性

MIT

Spiderman

灵活、扩展性强,微内核+插件式架构,通过简单的配置就可以完成数据抓取,无需编写一句代码

Apache

webmagic

功能覆盖整个爬虫生命周期,使用Xpath和正则表达式进行

链接和内容的提取

Apache

Web-Harvest

运用XSLT、XQuery、正则表达式等技术来实现对Text或XML的操作,具有可视化的界面

BSD

WebSPHINX

由两部分组成:爬虫工作平台和WebSPHINX类包

YaCy

基于P2P的分布式Web搜索引擎

GPL

Python

QuickRecon

具有查找子域名名称、收集电子邮件地址并寻找人际关系等功能

PyRailgun

简洁、轻量、高效的网页抓取框架

MIT

Scrapy

基于Twisted的异步处理框架,文档齐全BSD

C++

hispider

支持多机分布式下载, 支持网站定向下载BSD

larbin

高性能的爬虫软件,只负责抓取不负责解析GPL

Methabot

经过速度优化、可抓取WEB、FTP及本地文件系统不详

Methanol

模块化、可定制的网页爬虫,速度快

不详

C#

NWebCrawler

统计信息、执行过程可视化

GPLv2

Sinawler

国内第一个针对微博数据的爬虫程序,功能强大GPLv3

spidernet

以递归树为模型的多线程web爬虫程序,支持以GBK (gb2312)和utf8编码的资源,使用sqlite存储数据

MIT

Web Crawler

多线程,支持抓取PDF/DOC/EXCEL等文档来源LGPL

网络矿工

功能丰富,毫不逊色于商业软件

BSD

PHP

OpenWebSpider

开源多线程网络爬虫,有许多有趣的功能

不详

PhpDig

适用于专业化强、层次更深的个性化搜索引擎GPL

Snoopy

具有采集网页内容、提交表单功能

GPL

ThinkUp

采集推特、脸谱等社交网络数据的社会媒体视角引擎,可进行交互分析并将结果以可视化形式展现

GPL

微购

可采集淘宝、京东、当当等300多家电子商务数据

GPL

ErLang

Ebot

可伸缩的分布式网页爬虫GPLv3

Ruby

Spidr

可将一个或多个网站、某个链接完全抓取到本地MIT。