基于python对“中国新一线城市”2017年新建商品房房价数据挖掘

国家统计局:一二线城市新建商品住宅价格环比止涨

国家统计局:一二线城市新建商品住宅价格环比止涨

佚名

【期刊名称】《城市住宅》

【年(卷),期】2017(24)2

【摘要】2月22日,国家统计部网站公布《2017年1月70个大中城市住宅销售价格变动情况》。

【总页数】1页(P93-93)

【关键词】国家统计局;城市住宅;住宅价格;商品;销售价格

【正文语种】中文

【中图分类】TU241

【相关文献】

1.一线城市新建商品住宅销售价格环比下降 [J], ;

2.7月份商品住宅销售价格环比涨幅回落——国家统计局城市司首席统计师孔鹏解读2020年7月份商品住宅销售价格变动情况统计数据 [J],

3.2月份一二线城市新建商品住宅价格同比涨幅继续回落环比较为平稳 [J],

4.3月份一二线城市新建商品住宅价格同比涨幅继续回落 [J],

5.2018年7月份一二线城市新建商品住宅销售价格环比涨幅有所回落 [J],

因版权原因,仅展示原文概要,查看原文内容请购买。

Python爬取二手房源数据,可视化分析二手房市场行情数据

Python爬取⼆⼿房源数据,可视化分析⼆⼿房市场⾏情数据本⽂重点1. 系统分析⽹页性质2. 结构化的数据解析3. csv数据保存环境介绍python 3.8pycharm 专业版 >>> 激活码#模块使⽤requests >>> pip install requestsparsel >>> pip install parselcsv爬⾍代码实现步骤: 发送请求 >>> 获取数据 >>> 解析数据 >>> 保存数据导⼊模块import requests # 数据请求模块第三⽅模块 pip install requestsimport parsel # 数据解析模块import reimport csv发送请求, 对于房源列表页发送请求url = 'https:///ershoufang/pg1/'# 需要携带上请求头: 把python代码伪装成浏览器对于服务器发送请求# User-Agent 浏览器的基本信息headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/94.0.4606.61 Safari/537.36'}response = requests.get(url=url, headers=headers)获取数据print(response.text)解析数据selector_1 = parsel.Selector(response.text)# 把获取到response.text 数据内容转成 selector 对象href = selector_1.css('div.leftContent li div.title a::attr(href)').getall()for link in href:html_data = requests.get(url=link, headers=headers).textselector = parsel.Selector(html_data)# css选择器语法# try:title = selector.css('.title h1::text').get() # 标题area = selector.css('.areaName .info a:nth-child(1)::text').get() # 区域community_name = selector.css('.communityName .info::text').get() # ⼩区room = selector.css('.room .mainInfo::text').get() # 户型room_type = selector.css('.type .mainInfo::text').get() # 朝向height = selector.css('.room .subInfo::text').get().split('/')[-1] # 楼层# 中楼层/共5层 split('/') 进⾏字符串分割 ['中楼层', '共5层'] [-1]# ['中楼层', '共5层'][-1] 列表索引位置取值取列表中最后⼀个元素共5层# re.findall('共(\d+)层', 共5层) >>> [5][0] >>> 5height = re.findall('共(\d+)层', height)[0]sub_info = selector.css('.type .subInfo::text').get().split('/')[-1] # 装修Elevator = selector.css('.content li:nth-child(12)::text').get() # 电梯# if Elevator == '暂⽆数据电梯' or Elevator == None:# Elevator = '⽆电梯'house_area = selector.css('.content li:nth-child(3)::text').get().replace('㎡', '') # ⾯积price = selector.css('.price .total::text').get() # 价格(万元)date = selector.css('.area .subInfo::text').get().replace('年建', '') # 年份dit = {'标题': title,'市区': area,'⼩区': community_name,'户型': room,'朝向': room_type,'楼层': height,'装修情况': sub_info,'电梯': Elevator,'⾯积(㎡)': house_area,'价格(万元)': price,'年份': date,}csv_writer.writerow(dit)print(title, area, community_name, room, room_type, height, sub_info, Elevator, house_area, price, date, sep='|')保存数据f = open('⼆⼿房数据.csv', mode='a', encoding='utf-8', newline='')csv_writer = csv.DictWriter(f, fieldnames=['标题','市区','⼩区','户型','朝向','楼层','装修情况','电梯','⾯积(㎡)','价格(万元)','年份',])csv_writer.writeheader()数据可视化导⼊所需模块import pandas as pdfrom pyecharts.charts import Mapfrom pyecharts.charts import Barfrom pyecharts.charts import Linefrom pyecharts.charts import Gridfrom pyecharts.charts import Piefrom pyecharts.charts import Scatterfrom pyecharts import options as opts读取数据df = pd.read_csv('链家.csv', encoding = 'utf-8')df.head()各城区⼆⼿房数量北京市地图new = [x + '区'for x in region]m = (Map().add('', [list(z) for z in zip(new, count)], '北京').set_global_opts(title_opts=opts.TitleOpts(title='北京市⼆⼿房各区分布'),visualmap_opts=opts.VisualMapOpts(max_=3000),))m.render_notebook()各城区⼆⼿房数量-平均价格柱状图df_price.values.tolist()price = [round(x,2) for x in df_price.values.tolist()]bar = (Bar().add_xaxis(region).add_yaxis('数量', count,label_opts=belOpts(is_show=True)).extend_axis(yaxis=opts.AxisOpts(name="价格(万元)",type_="value",min_=200,max_=900,interval=100,axislabel_opts=belOpts(formatter="{value}"),)).set_global_opts(title_opts=opts.TitleOpts(title='各城区⼆⼿房数量-平均价格柱状图'),tooltip_opts=opts.TooltipOpts(is_show=True, trigger="axis", axis_pointer_type="cross"),xaxis_opts=opts.AxisOpts(type_="category",axispointer_opts=opts.AxisPointerOpts(is_show=True, type_="shadow"),),yaxis_opts=opts.AxisOpts(name='数量',axistick_opts=opts.AxisTickOpts(is_show=True),splitline_opts=opts.SplitLineOpts(is_show=False),)))line2 = (Line().add_xaxis(xaxis_data=region).add_yaxis(series_name="价格",yaxis_index=1,y_axis=price,label_opts=belOpts(is_show=True),z=10))bar.overlap(line2)grid = Grid()grid.add(bar, opts.GridOpts(pos_left="5%", pos_right="20%"), is_control_axis_index=True) grid.render_notebook()area0 = top_price['⼩区'].values.tolist()count = top_price['价格(万元)'].values.tolist()bar = (Bar().add_xaxis(area0).add_yaxis('数量', count,category_gap = '50%').set_global_opts(yaxis_opts=opts.AxisOpts(name='价格(万元)'),xaxis_opts=opts.AxisOpts(name='数量'),))bar.render_notebook()散点图s = (Scatter().add_xaxis(df['⾯积(㎡)'].values.tolist()).add_yaxis('',df['价格(万元)'].values.tolist()).set_global_opts(xaxis_opts=opts.AxisOpts(type_='value')))s.render_notebook()房屋朝向占⽐directions = df_direction.index.tolist()count = df_direction.values.tolist()c1 = (Pie(init_opts=opts.InitOpts(width='800px', height='600px',)).add('',[list(z) for z in zip(directions, count)],radius=['20%', '60%'],center=['40%', '50%'],# rosetype="radius",label_opts=belOpts(is_show=True),).set_global_opts(title_opts=opts.TitleOpts(title='房屋朝向占⽐',pos_left='33%',pos_top="5%"),legend_opts=opts.LegendOpts(type_="scroll", pos_left="80%",pos_top="25%",orient="vertical") ).set_series_opts(label_opts=belOpts(formatter='{b}:{c} ({d}%)'),position="outside"))c1.render_notebook()装修情况/有⽆电梯玫瑰图(组合图)fitment = df_fitment.index.tolist()count1 = df_fitment.values.tolist()directions = df_direction.index.tolist()count2 = df_direction.values.tolist()bar = (Bar().add_xaxis(fitment).add_yaxis('', count1, category_gap = '50%').reversal_axis().set_series_opts(label_opts=belOpts(position='right')).set_global_opts(xaxis_opts=opts.AxisOpts(name='数量'),title_opts=opts.TitleOpts(title='装修情况/有⽆电梯玫瑰图(组合图)',pos_left='33%',pos_top="5%"),legend_opts=opts.LegendOpts(type_="scroll", pos_left="90%",pos_top="58%",orient="vertical")))c2 = (Pie(init_opts=opts.InitOpts(width='800px', height='600px',)).add('',[list(z) for z in zip(directions, count2)],radius=['10%', '30%'],center=['75%', '65%'],rosetype="radius",label_opts=belOpts(is_show=True),).set_global_opts(title_opts=opts.TitleOpts(title='有/⽆电梯',pos_left='33%',pos_top="5%"),legend_opts=opts.LegendOpts(type_="scroll", pos_left="90%",pos_top="15%",orient="vertical") ).set_series_opts(label_opts=belOpts(formatter='{b}:{c} \n ({d}%)'),position="outside"))bar.overlap(c2)bar.render_notebook()⼆⼿房楼层分布柱状缩放图floor = df_floor.index.tolist()count = df_floor.values.tolist()bar = (Bar().add_xaxis(floor).add_yaxis('数量', count).set_global_opts(title_opts=opts.TitleOpts(title='⼆⼿房楼层分布柱状缩放图'), yaxis_opts=opts.AxisOpts(name='数量'),xaxis_opts=opts.AxisOpts(name='楼层'),datazoom_opts=opts.DataZoomOpts(type_='slider')))bar.render_notebook()房屋⾯积分布纵向柱状图area = df_area.index.tolist()count = df_area.values.tolist()bar = (Bar().add_xaxis(area).add_yaxis('数量', count).reversal_axis().set_series_opts(label_opts=belOpts(position="right")) .set_global_opts(title_opts=opts.TitleOpts(title='房屋⾯积分布纵向柱状图'), yaxis_opts=opts.AxisOpts(name='⾯积(㎡)'),xaxis_opts=opts.AxisOpts(name='数量'),))bar.render_notebook()。

如何使用Python爬虫进行房地产数据采集

如何使用Python爬虫进行房地产数据采集在当今数字化的时代,数据成为了宝贵的资源,对于房地产行业来说也不例外。

通过采集房地产相关的数据,我们可以更好地了解市场动态、分析趋势,为决策提供有力的支持。

而 Python 爬虫作为一种强大的数据采集工具,可以帮助我们高效地获取所需的房地产数据。

接下来,我将详细介绍如何使用 Python 爬虫进行房地产数据采集。

一、准备工作在开始编写爬虫代码之前,我们需要做好一些准备工作。

首先,要安装 Python 环境。

可以从 Python 官方网站下载适合您操作系统的安装包,并按照提示进行安装。

其次,我们需要安装一些必要的库,如`requests` 用于发送 HTTP 请求,`BeautifulSoup` 用于解析 HTML 页面,`pandas` 用于数据处理和存储等。

可以使用`pip` 命令进行安装,例如:`pip install requests beautifulsoup4 pandas` 。

另外,还需要了解一些基本的 HTML 和 CSS 知识,以便能够准确地定位和提取所需的数据。

二、选择目标网站选择合适的房地产数据来源网站是非常重要的。

一些常见的房地产网站如贝壳找房、链家、58 同城等都提供了丰富的房地产信息。

但需要注意的是,在采集数据时要遵守网站的使用规则和法律法规,避免不必要的法律风险。

三、分析网站结构在确定了目标网站后,我们需要对其结构进行分析,以便确定如何提取数据。

可以通过浏览器的开发者工具来查看网页的源代码,了解页面的 HTML 结构和数据的组织方式。

例如,如果我们想要采集房屋的售价、面积、户型等信息,就需要找到这些信息在 HTML 代码中的位置和标识。

通常,这些信息会被包含在特定的标签(如`<div>`、`<span>`等)中,并具有特定的类名或属性。

四、编写爬虫代码以下是一个简单的 Python 爬虫示例代码,用于采集某房地产网站上的房屋信息:```pythonimport requestsfrom bs4 import BeautifulSoupimport pandas as pddef crawl_real_estate_data(url):response = requestsget(url)if responsestatus_code == 200:soup = BeautifulSoup(responsetext, 'htmlparser')假设房屋信息都在<div class="houseinfo">标签中house_info_elements = soupfind_all('div', class_='houseinfo')data =for element in house_info_elements:提取房屋售价price = elementfind('span', class_='price')textstrip()提取房屋面积area = elementfind('span', class_='area')textstrip()提取房屋户型layout = elementfind('span', class_='layout')textstrip()dataappend(price, area, layout)将数据存储为 DataFrame 并保存为 CSV 文件df = pdDataFrame(data, columns='Price','Area','Layout')dfto_csv('real_estate_datacsv', index=False)else:print(f"请求失败,状态码: {responsestatus_code}")替换为您要采集的页面 URLurl ="_____"crawl_real_estate_data(url)```在上述代码中,我们首先使用`requests` 库发送 GET 请求获取网页内容,然后使用`BeautifulSoup` 库解析 HTML 。

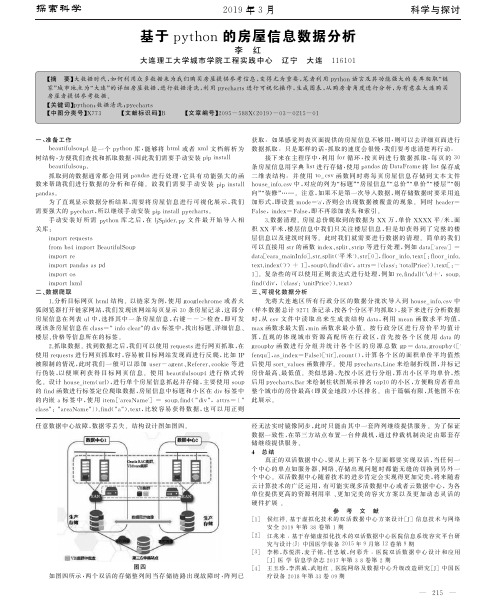

基于python的房屋信息数据分析

beautifulsoup。

条房屋信息用字典 list 进行存储,使用 pandas 的 DataFrame 将 list 保存成

抓取到的数据通常都 会 用 到 pandas 进 行 处 理,它 具 有 功 能 强 大 的 函 二 维 表 结 构。 并 使 用 to _ csv 函 数 同 时 将 每 页 房 屋 信 息 存 储 到 文 本 文 件

二 、数 据 爬 取

三 、可 视 化 数 据 分 析

1 .分析目标网页 html 结 构。以 链 家 为 例,使 用 googlechrome 或 者 火

先将 大 连 地 区 所 有 行 政 分 区 的 数 据 分 批 次 导 入 到 house_ info.csv 中

狐浏览器打开链家网站,我们发现该网站每页显示 3 0 条房屋记录,这 部 分 (样本数据总计 9 2 7 1 条记录,按各个分区平均抓取),接下来进行分析 数 据

3 .数据清理。房屋总价爬取到的数据为 XX 万,单 价 XXXX 平/米,面

关库:

积 XX 平米,楼层信息中我们 只 关 注 楼 层 信 息,但 是 却 获 得 到 了 完 整 的 楼

import requests

层信息以及建筑时间等。此时我们就需要进行数据的清理。简单的我们

from bs4 import BeautifulSoup

数来帮助我们进 行 数 据 的 分 析 和 存 储。 故 我 们 需 要 手 动 安 装 pip install house_info.csv 中,对应的列为“标题”“房屋信息”“总价”“单价”“楼 层”“朝

pandas。

向”“装修”……。注意,如果不是第一次导入数据,则存储数据时要采用 追

为了直观显示数据分析结果,需 要 将 房 屋 信 息 进 行 可 视 化 展 示,我 们 加形式,即设置 mode='a',否则会 出 现 数 据 被 覆 盖 的 现 象。 同 时 header=

2017年主要城市新房房价涨跌幅排行榜(11月)

2017年11月主要城市新房房价涨跌幅排行榜12月18日,国家统计局发布2017年11月份70个大中城市住宅销售价格统计数据,数据显示,11月份,“分类调控、因城施策”房地产市场调控政策效果继续显现,70个大中城市中15个热点城市房地产市场总体继续保持平稳,多数城市已低于去年同期价格水平。

11月新房环比上涨的城市有50个,停涨的有10个,负增长的城市有10个。

其中新房环比涨幅超1%的城市有9个,全部为三四线城市,且多为省会城市,这9城分别为:乌鲁木齐、湛江、西宁、桂林、昆明、呼和浩特、大连、银川、丹东。

其中涨幅最大的是乌鲁木齐,环比上涨1.9%。

湛江环比上涨1.5%。

此外,热点城市重庆和西安房价涨幅回落,11月重庆新房环比上涨0.6%,西安环比上涨0.5%。

合肥、成都热度不再,环比上涨0.1%。

一线城市,北京、上海停涨,广州、深圳负增长,分别环比下跌0.1%和0.2%。

热门城市南京也出现负增长,11月新房环比下跌0.2%,近日,媒体曝光南京地王崩盘,南京房价下跌,南京楼市热度不再。

此外,武汉楼市依旧火爆,日光盘频现,如今新房房价停涨,二手房环比上涨0.1%。

未来国家调控下,武汉楼市将趋冷。

总体来看,7个城市新建商品住宅价格环比下降,降幅在0.1至0.3个百分点之间;北京、上海、郑州和武汉4个城市环比持平。

从同比看,有11个城市新建商品住宅价格下降,降幅在0.2至3.2个百分点之间,也就是说这些城市新建商品住宅价格已低于去年同期水平。

数据来源:统计统计局中商产业研究院整理中商产业研究院简介中商产业研究院是深圳中商情大数据股份有限公司下辖的研究机构,研究范围涵盖智能装备制造、新能源、新材料、新金融、新消费、大健康、“互联网+”等新兴领域。

公司致力于为国内外企业、上市公司、投融资机构、会计师事务所、律师事务所等提供各类数据服务、研究报告及高价值的咨询服务。

中商行业研究服务内容行业研究是中商开展一切咨询业务的基石,我们通过对特定行业长期跟踪监测,分析行业需求、供给、经营特性、盈利能力、产业链和商业模式等多方面的内容,整合行业、市场、企业、用户等多层面数据和信息资源,为客户提供深度的行业市场研究报告,全面客观的剖析当前行业发展的总体市场容量、竞争格局、进出口情况和市场需求特征等,对行业重点企业进行产销运营分析,并根据各行业的发展轨迹及实践经验,对各产业未来的发展趋势做出准确分析与预测。

基于多元线性回归的房价预测模型python

基于多元线性回归的房价预测模型python本文旨在简要介绍基于多元线性回归的房价预测模型在房地产市场中的重要性,并概述本文的目的和结构。

房地产市场中的房价预测对于买卖双方具有重要意义。

了解未来房价的趋势和表现可以帮助买家做出明智的购买决策,同时卖家也可以更准确地定价并制定销售策略。

因此,建立准确可靠的房价预测模型成为了房地产市场中的一个重要课题。

本文的目的是介绍基于多元线性回归的房价预测模型在 Python 中的应用。

通过使用多元线性回归模型,我们可以利用多个自变量(如房屋面积、位置、年龄等)来预测房价。

Python 是一种广泛应用于数据科学领域的编程语言,具有强大的数据处理和分析能力,因此选择 Python 作为实现工具。

本文将按照以下结构进行组织:简介:对基于多元线性回归的房价预测模型进行简要介绍,包括其重要性和应用场景。

数据收集和预处理:介绍如何收集和处理用于构建房价预测模型的数据。

多元线性回归模型:给出多元线性回归模型的理论基础和公式推导。

模型实现:使用 Python 实现多元线性回归模型,并介绍相关的 Python 库和工具。

模型评估和优化:介绍如何对模型进行评估和优化,包括交叉验证和特征选择等方法。

结论:总结本文的主要内容,并对未来的研究方向进行展望。

通过本文的阅读,读者将能够了解基于多元线性回归的房价预测模型在房地产市场中的重要性和应用价值,并学会使用 Python 构建和优化这样的预测模型。

多元线性回归模型是一种用于预测因变量与多个自变量之间关系的统计模型。

该模型基于以下基本原理和公式进行计算:自变量:指影响因变量的多个因素,如房屋面积、房间数量、地理位置等。

因变量:指要预测的变量,即房价。

回归系数:表示自变量对因变量的影响程度,可通过回归分析得到。

通过多元线性回归模型,我们能够利用已有的自变量数据来预测因变量的值,即根据房屋的多个特征来预测其价格。

在Python中,我们可以使用相关的库和函数来实现基于多元线性回归的房价预测模型。

Python网络爬虫在房地产与地产行业数据抓取中的应用

Python网络爬虫在房地产与地产行业数据抓取中的应用Python网络爬虫技术在各行各业都发挥着重要的作用,尤其在房地产与地产行业数据抓取中具有广泛的应用前景。

本文将探讨Python网络爬虫在房地产与地产行业的数据抓取中的应用,并介绍其在实践中的优势和挑战。

一、Python网络爬虫概述Python网络爬虫是一种自动化获取网页上信息的技术,可以通过编写程序自动访问网页并提取所需数据。

Python作为一种简单易学的编程语言,在网络爬虫开发中具备许多优势,包括强大的第三方库、丰富的开发资源、良好的可扩展性等。

二、房地产与地产行业数据抓取需求在房地产与地产行业中,数据对于市场分析、业务决策以及产品优化等方面具有重要意义。

然而,要获取大量、准确、实时的数据并整合分析是一项巨大的挑战。

Python网络爬虫可以针对不同的数据需求,抓取房地产市场、楼盘信息、房价走势、交易数据等相关数据,满足行业内的数据分析与应用需求。

三、Python网络爬虫在房地产与地产行业数据抓取中的应用1. 抓取房地产市场数据Python网络爬虫可通过抓取各大房地产企业官方网站的数据,收集房地产市场的相关信息。

例如,可以抓取新楼盘发布信息、开发商销售动态、房价指数等数据,为市场分析和投资决策提供参考。

2. 抓取楼盘信息通过Python网络爬虫,可以抓取各大房产网站上的楼盘信息。

包括楼盘的基本信息、户型图、楼盘相册等。

这些数据可以用于房地产开发商的竞品分析、产品定位以及市场调研。

3. 抓取房价走势数据房价是房地产市场的核心指标之一,通过Python网络爬虫可以抓取各大房产网站上的二手房交易数据,并结合其他数据进行房价走势分析。

这些数据对于政府部门、开发商、投资机构等具有重要价值。

4. 抓取交易数据Python网络爬虫还可以抓取房地产交易信息,包括成交价格、成交时间、成交户型等。

这些数据对于投资者、开发商和市场分析师来说,是了解市场供求关系和项目市场表现的重要依据。

python数据挖掘案例

python数据挖掘案例Python数据挖掘案例。

数据挖掘是指从大量数据中发现未知的、有效的、潜在有价值的信息的过程。

Python作为一种高效、易学的编程语言,被广泛应用于数据挖掘领域。

本文将介绍几个基于Python的数据挖掘案例,帮助大家更好地理解数据挖掘的应用和Python在其中的作用。

首先,我们来看一个简单的数据挖掘案例,预测房价。

在这个案例中,我们可以利用Python中的pandas库来处理数据,matplotlib库来可视化数据,scikit-learn库来构建预测模型。

首先,我们需要收集房屋的相关数据,比如面积、地段、楼层等。

然后,利用Python中的pandas库对数据进行清洗和整理,去除缺失值和异常值。

接下来,我们可以利用matplotlib库绘制出各个特征与房价之间的关系图,帮助我们更直观地理解数据。

最后,利用scikit-learn库中的机器学习算法,比如线性回归、决策树等,构建预测模型,并对模型进行评估和优化。

通过这个案例,我们可以看到Python在数据挖掘中的强大功能,以及如何利用Python来进行数据处理、可视化和建模。

其次,我们来看一个更复杂的数据挖掘案例,电商网站用户行为分析。

在这个案例中,我们可以利用Python中的numpy库和pandas库来进行数据处理,利用seaborn库和plotly库来进行数据可视化,利用sklearn库和tensorflow库来构建用户行为预测模型。

首先,我们需要收集用户在电商网站上的行为数据,比如浏览记录、购买记录、点击记录等。

然后,利用Python中的numpy库和pandas库对数据进行处理,比如对用户行为进行统计分析、用户行为序列化处理等。

接下来,我们可以利用seaborn库和plotly库来绘制用户行为的热力图、漏斗图等,帮助我们更直观地了解用户行为规律。

最后,利用sklearn库和tensorflow库构建用户行为预测模型,比如用户购买意向预测模型、用户流失预测模型等,帮助电商网站更好地了解用户需求并进行精准营销。

python某地区房屋销售案例

Python某地区房屋销售案例分析一、引言在当今社会,房地产行业一直备受关注。

随着城市化进程的不断加快,房地产市场的波动对经济发展和社会稳定有着重要影响。

对房屋销售案例进行深入分析,可以帮助我们更好地理解房地产市场的运行规律和变化趋势。

二、数据收集与处理我们需要搜集某地区的房屋销售数据,包括房屋面积、售价、地理位置、楼层等信息。

这些数据可以从房地产中介、政府部门或者互联网评台上获取。

我们利用Python的数据分析工具对收集的数据进行清洗和处理,去除异常值和缺失数据,以确保分析的准确性和可靠性。

三、统计分析与可视化接下来,我们可以利用Python的数据分析库进行统计分析和可视化,从而深入挖掘房屋销售数据的内在规律。

通过统计分析,我们可以得到房屋销售的平均价格、面积分布、不同地理位置的销售情况等信息,并借助可视化工具绘制相关图表,直观展现数据的分布和趋势变化。

四、特征工程与建模分析在统计分析的基础上,我们可以进行特征工程和建模分析,以探索房屋销售数据背后的关联和影响因素。

通过建立回归模型或者机器学习模型,我们可以发现房屋面积、地理位置、楼层等特征与售价之间的关系,并预测未来房屋销售的趋势。

五、案例总结与个人观点通过以上的数据分析和建模分析,我们对某地区房屋销售案例有了更深入的理解。

在我看来,房地产市场受到多重因素的影响,包括政策、经济、社会等方面的因素。

对房屋销售案例进行深入分析,能够帮助我们更好地把握市场变化,做出更加准确的决策。

六、结语通过Python对某地区房屋销售案例进行深入分析,我们可以更好地理解房地产市场的运行规律和变化趋势。

希望本文能够为读者提供一些启发和思考,也欢迎大家共享自己的观点和建议。

七、市场趋势分析在房地产市场中,面积和售价是最为重要的两个指标。

我们可以通过Python的数据分析工具对这两个指标进行深入研究,探索市场的变化趋势和规律。

通过对历史销售数据的分析,可以发现不同时间段内,大面积房屋的销售情况如何?不同时间段内,房屋售价的趋势如何?这些信息对于投资者和开发商来说都是极为重要的参考,能够指导他们制定合理的投资策略。

2017年重庆市房价预测基于BP神经网络

2017年重庆市房价预测基于BP神经网络随着中国房地产市场的发展,重庆市房价一直是市场的热点之一。

针对重庆市房价的预测,本文使用了BP神经网络进行了探究和研究,并得出了以下预测结果。

首先,我们需要建立BP神经网络的模型。

BP神经网络是一种多层前向反馈神经网络,具有较强的逼近能力和泛化能力。

在建立模型时,我们需要选择输入层节点、隐藏层节点和输出层节点的数目,同时需要确定学习率、动量系数和最大迭代次数等参数。

在本文中,我们选择了一个输入层节点、两个隐藏层节点和一个输出层节点的模型,学习率为0.2,动量系数为0.3,最大迭代次数为1000次。

接下来,我们需要确定模型的输入变量。

在本文中,我们选择了以下8个因素作为模型的输入变量:1. 城市总人口数:城市总人口数对房价产生影响。

2. 人均可支配收入:人均可支配收入反映了人们的购房能力。

3. 土地面积:土地面积是房价的一个重要因素。

4. 离市中心的距离:离市中心的距离对房价的影响也非常重要。

5. 房屋均价:房屋均价是房价的一个重要指标。

6. 交通情况:交通情况包括公交车路线、地铁站、自行车道等。

7. 商业设施:商业设施是城市配套设施之一,也是影响房价的重要因素。

8. 学区房:学区房是被学校所管辖的范围内的房屋,对家长选择孩子上学有很大的影响。

根据以上8个因素,我们收集了2010年至2016年的相关数据,将其作为BP神经网络的输入数据集和目标数据集进行训练和预测。

这里我们使用了Python语言中的Tensorflow库来搭建BP神经网络模型。

最后,我们进行了对比实验,使用了多元线性回归模型对重庆市房价进行了预测,然后将其与BP神经网络的预测结果进行了对比。

经过比较分析,我们发现,BP神经网络的预测结果明显优于多元线性回归的预测结果,具有更高的预测精度和更强的鲁棒性。

综合以上研究结果,可以得出以下结论:基于BP神经网络的重庆市房价预测方法具有较高的预测精度和较强的鲁棒性,可以为重庆市的房地产市场提供较好的决策参考。

基于数据挖掘的房地产价格预测

基于数据挖掘的房地产价格预测孙珊珊【摘要】针对当前房地产价格预测精度低的难题,提出基于数据挖掘的房地产价格预测模型.首先对当前房地产价格预测研究的现状进行分析,指出房地产价格变化的混沌性和随机性;然后采用混沌理论对数据进行预处理,重建房地产价格预测模型的样本,并采用相关向量机建立房地产价格预测模型;最后采用房地产价格数据进行验证性测试.该模型可以描述房地产价格历史数据中隐藏的变化特点,获得了比其他模型更优的房地产价格预测结果.%Since the prediction accuracy of the current real estate price is low,a real estate price forecasting model based on data mining is proposed. The study situation of the current real estate price prediction is analyzed to point out the chaos characteristics and randomness of the real estate price variation. The chaos theory is used to preprocess the data,and recon-struct the samples of the real estate price prediction model. The relevance vector machine is adopted to set up the real estate price prediction model. The data of the real estate price is employed to conduct the verification test. The model can describe the hidden change characteristics existing in the historical data of the real estate price,and obtain a better prediction result than that of other models.【期刊名称】《现代电子技术》【年(卷),期】2017(040)005【总页数】4页(P126-129)【关键词】房地产市场;价格预测;混沌性变化;非线性拟合【作者】孙珊珊【作者单位】绥化学院信息工程学院,黑龙江绥化 152000【正文语种】中文【中图分类】TN911-34;TP391随着经济不断发展和城市化进程的加快,房地产市场异常活动,房地产价格不断上升,同时房地产价格还受到一个地区的经济、国家政策以及综合影响,房地产价格有时会出现一定的下降,因此房地产价格变化具有一定的规律性和随机性[1]。

基于Python的房价数据爬取及可视化分析

1、导入所需的库和模块

import matplotlib.pyplot as plt

2、定义爬虫函数

2、定义爬虫函数

接下来,定义一个名为get_house_price的函数,该函数用于从指定URL爬取 房价数据。在该函数中,我们使用requests库获取网页内容,并使用 BeautifulSoup库解析网页HTML。然后,我们将解析到的房价数据保存到 DataFrame中并返回。

三、可视化分析

data.plot(kind='hist', y='price', bins=30, alpha=0.5) #绘制 直方图

三、可视化分析

plt.title('House Price Distribution') #设置图表标题

三、可视化分析

plt.xlabel('Price (in thousands)') #设置x轴标签

2、定义爬虫函数

soup = BeautifulSoup(res.text, 'lxml')

2、定义爬虫函数

for row in soup.find_all(class_='price'):

2、定义爬虫函数

price = row.text.strip() df = pd.DataFrame(data, columns=['price'])

一、网页数据爬取

1、爬取的基本步骤首先,需要 了解基本的网络爬虫原理

2、使用Python实现爬取 Python 作为一种流行的高级编程语言

2、使用Python实现爬取 Python作为一种流行的高级编程语言,很 适合用来实现网页爬取

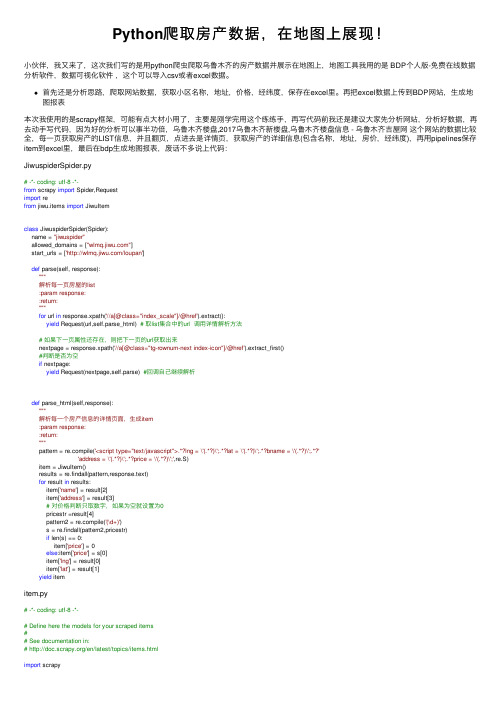

Python爬取房产数据,在地图上展现!

Python爬取房产数据,在地图上展现!⼩伙伴,我⼜来了,这次我们写的是⽤python爬⾍爬取乌鲁⽊齐的房产数据并展⽰在地图上,地图⼯具我⽤的是 BDP个⼈版-免费在线数据分析软件,数据可视化软件,这个可以导⼊csv或者excel数据。

⾸先还是分析思路,爬取⽹站数据,获取⼩区名称,地址,价格,经纬度,保存在excel⾥。

再把excel数据上传到BDP⽹站,⽣成地图报表本次我使⽤的是scrapy框架,可能有点⼤材⼩⽤了,主要是刚学完⽤这个练练⼿,再写代码前我还是建议⼤家先分析⽹站,分析好数据,再去动⼿写代码,因为好的分析可以事半功倍,乌鲁⽊齐楼盘,2017乌鲁⽊齐新楼盘,乌鲁⽊齐楼盘信息 - 乌鲁⽊齐吉屋⽹这个⽹站的数据⽐较全,每⼀页获取房产的LIST信息,并且翻页,点进去是详情页,获取房产的详细信息(包含名称,地址,房价,经纬度),再⽤pipelines保存item到excel⾥,最后在bdp⽣成地图报表,废话不多说上代码:JiwuspiderSpider.py# -*- coding: utf-8 -*-from scrapy import Spider,Requestimport refrom jiwu.items import JiwuItemclass JiwuspiderSpider(Spider):name = "jiwuspider"allowed_domains = [""]start_urls = ['/loupan']def parse(self, response):"""解析每⼀页房屋的list:param response::return:"""for url in response.xpath('//a[@class="index_scale"]/@href').extract():yield Request(url,self.parse_html) # 取list集合中的url 调⽤详情解析⽅法# 如果下⼀页属性还存在,则把下⼀页的url获取出来nextpage = response.xpath('//a[@class="tg-rownum-next index-icon"]/@href').extract_first()#判断是否为空if nextpage:yield Request(nextpage,self.parse) #回调⾃⼰继续解析def parse_html(self,response):"""解析每⼀个房产信息的详情页⾯,⽣成item:param response::return:"""pattern = pile('<script type="text/javascript">.*?lng = \'(.*?)\';.*?lat = \'(.*?)\';.*?bname = \'(.*?)\';.*?''address = \'(.*?)\';.*?price = \'(.*?)\';',re.S)item = JiwuItem()results = re.findall(pattern,response.text)for result in results:item['name'] = result[2]item['address'] = result[3]# 对价格判断只取数字,如果为空就设置为0pricestr =result[4]pattern2 = pile('(\d+)')s = re.findall(pattern2,pricestr)if len(s) == 0:item['price'] = 0else:item['price'] = s[0]item['lng'] = result[0]item['lat'] = result[1]yield itemitem.py# -*- coding: utf-8 -*-# Define here the models for your scraped items## See documentation in:# /en/latest/topics/items.htmlimport scrapyclass JiwuItem(scrapy.Item):# define the fields for your item here like:name = scrapy.Field()price =scrapy.Field()address =scrapy.Field()lng = scrapy.Field()lat = scrapy.Field()passpipelines.py 注意此处是吧mongodb的保存⽅法注释了,可以⾃选选择保存⽅式# -*- coding: utf-8 -*-# Define your item pipelines here## Don't forget to add your pipeline to the ITEM_PIPELINES setting# See: /en/latest/topics/item-pipeline.htmlimport pymongofrom scrapy.conf import settingsfrom openpyxl import workbookclass JiwuPipeline(object):wb = workbook.Workbook()ws = wb.activews.append(['⼩区名称', '地址', '价格', '经度', '纬度'])def__init__(self):# 获取数据库连接信息host = settings['MONGODB_URL']port = settings['MONGODB_PORT']dbname = settings['MONGODB_DBNAME']client = pymongo.MongoClient(host=host, port=port)# 定义数据库db = client[dbname]self.table = db[settings['MONGODB_TABLE']]def process_item(self, item, spider):jiwu = dict(item)#self.table.insert(jiwu)line = [item['name'], item['address'], str(item['price']), item['lng'], item['lat']]self.ws.append(line)self.wb.save('jiwu.xlsx')return item最后报表的数据mongodb数据库。

房地产楼市降温python数据分析

房地产楼市降温python数据分析

房地产楼市降温是一个经济领域的话题,可以通过Python数据分析来探索相关数据。

以下是一些常见的数据分析方法和技术,供参考:

1. 数据采集与清洗:使用Python的网络爬虫工具(如BeautifulSoup、Scrapy等)获取楼市相关数据,并使用Python的数据清洗库(如Pandas)进行数据清洗和预处理。

2. 数据可视化:使用Python的可视化库(如Matplotlib、Seaborn、Plotly等)绘制各种图表,比如线性图、柱状图、散点图等,以观察楼市行情的变化趋势。

3. 统计分析:运用Python的统计库(如Numpy、SciPy、Statsmodels等)进行数据统计分析,比如计算平均价格、价格波动、销售量等指标,并进行相关性分析、趋势预测等。

4. 机器学习预测:借助Python的机器学习库(如Scikit-learn、TensorFlow、PyTorch等),构建楼市价格预测模型,通过历史数据训练模型,然后进行未来价格的预测。

需要注意的是,在进行数据分析时,要确保所使用的数据来源合法、准确,同时遵守相关法律法规和数据隐私保护规定。

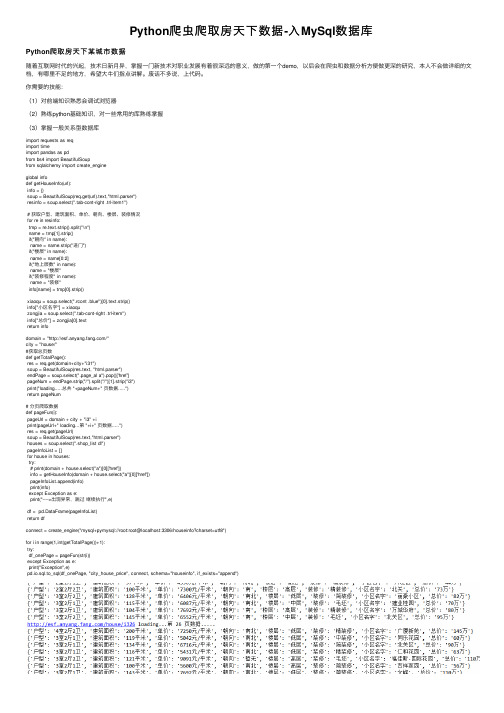

Python爬虫爬取房天下数据-入MySql数据库

Python爬⾍爬取房天下数据-⼊MySql数据库Python爬取房天下某城市数据随着互联⽹时代的兴起,技术⽇新⽉异,掌握⼀门新技术对职业发展有着很深远的意义,做的第⼀个demo,以后会在爬⾍和数据分析⽅便做更深的研究,本⼈不会做详细的⽂档,有哪⾥不⾜的地⽅,希望⼤⽜们指点讲解。

废话不多说,上代码。

你需要的技能:(1)对前端知识熟悉会调试浏览器(2)熟练python基础知识,对⼀些常⽤的库熟练掌握(3)掌握⼀般关系型数据库import requests as reqimport timeimport pandas as pdfrom bs4 import BeautifulSoupfrom sqlalchemy import create_engineglobal infodef getHouseInfo(url):info = {}soup = BeautifulSoup(req.get(url).text,"html.parser")resinfo = soup.select(".tab-cont-right .trl-item1")# 获取户型、建筑⾯积、单价、朝向、楼层、装修情况for re in resinfo:tmp = re.text.strip().split("\n")name = tmp[1].strip()if("朝向" in name):name = name.strip("进门")if("楼层" in name):name = name[0:2]if("地上层数" in name):name = "楼层"if("装修程度" in name):name = "装修"info[name] = tmp[0].strip()xiaoqu = soup.select(".rcont .blue")[0].text.strip()info["⼩区名字"] = xiaoquzongjia = soup.select(".tab-cont-right .trl-item")info["总价"] = zongjia[0].textreturn infodomain = "/"city = "house/"#获取总页数def getTotalPage():res = req.get(domain+city+"i31")soup = BeautifulSoup(res.text, "html.parser")endPage = soup.select(".page_al a").pop()['href']pageNum = endPage.strip("/").split("/")[1].strip("i3")print("loading.....总共 "+pageNum+" 页数据.....")return pageNum# 分页爬取数据def pageFun(i):pageUrl = domain + city + "i3" +iprint(pageUrl+" loading...第 "+i+" 页数据.....")res = req.get(pageUrl)soup = BeautifulSoup(res.text,"html.parser")houses = soup.select(".shop_list dl")pageInfoList = []for house in houses:try:# print(domain + house.select("a")[0]['href'])info = getHouseInfo(domain + house.select("a")[0]['href'])pageInfoList.append(info)print(info)except Exception as e:print("---->出现异常,跳过继续执⾏",e)df = pd.DataFrame(pageInfoList)return dfconnect = create_engine("mysql+pymysql://root:root@localhost:3306/houseinfo?charset=utf8")for i in range(1,int(getTotalPage())+1):try:df_onePage = pageFun(str(i))except Exception as e:print("Exception",e)pd.io.sql.to_sql(df_onePage, "city_house_price", connect, schema="houseinfo", if_exists="append")。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于Python对新建商品房房价数据的挖掘分析

摘要:在大数据的背景下,各行各业的发展对数据的依赖度越来越高。

利用数据分析,为决策者提供决策依据,更是成为当前商业形式的一大趋势。

同时房价信息牵动着,反映着很多经济、民生、就业的信息。

所以房价信息是极有价值的一种数据信息。

在对房价数据分析的难题有二,一是大量数据的获取,二是对数据的分析和挖掘价值。

本文将介绍python抓取数据和分析数据,同时提取出具有商业价值的数据。

本文将分为两大模块,一是利用python 获取数据,二则是利用python分析数据。

关键词:python;数据分析;网络爬虫;python数据分析

Abstract: In the context of big data, the development of all walks of life increasingly depends on data. Using data analysis to provide decision-making basis for decision makers has become a major trend in the current business model. At the same time, the price information reflects, reflecting many economic, livelihood and employment information. So house price information is a very valuable kind of data information. There are two problems in the analysis of house price data. One is the acquisition of large amounts of data, and the other is the analysis and excavation of data. This article will introduce python to grab data and analyze data while extracting commercially valuable data. This article will be divided into two major modules, one is to use python to obtain data, and the other is to use python to analyze data.

Key words: python;data analysis;web crawler; python data analysis;

目录

摘要 (I)

Abstract (I)

目录 (Ⅱ)

1 利用爬虫获取数据 (1)

1.1 爬虫原理 (1)

1.2 爬虫程序编写 (1)

1.2.1 框架还是原生 (1)

1.2.2 创建项目 (2)

1.2.3 定义Item (3)

1.2.4 爬虫编写 (4)

1.3 数据存储 (6)

1.3.1 编写item pipeline (6)

1.3.2 启动item pipeline (6)

1.3.3 开始运行爬虫 (7)

2 数据预处理 (7)

2.1 数据清洗 (8)

2.2 数据集成 (8)

2.3 数据变换 (9)

3 数据可视化 (9)

3.1 各城市新房信息可视化 (10)

3.2 各城市房价信息可视化 (11)

3.3 各城市房价中位数和平均数可视化 (14)

4 数据挖掘 (15)

4.1 可行性分析 (15)

4.2 线性回归 (16)

4.3 训练数据,建立回归方程 (16)

1 利用爬虫获取数据

随着互联网和大数据时代的到来,互联网和大数据的发展相当的迅速和空前,正改变着各行各业的生活和工作方式,这也是为什么在我们身边有这么多互联网+的项目或以此为名号的产品的原因。

而网络数据爆炸性的增长,对数据分析提出了新的挑战。

即使现在的搜索引擎有了很大的进步,但在浩瀚如宇宙的网络数据中提取满足数据需求的数据,仍然是一件困难和费时的事情。

尤其是一些特殊的数据,单单利用搜索引擎是不能满足数据需求的。

而利用网络爬虫自定义的,有目的性的爬取数据,能够将数据批量获取汇总,格式化为满足数据分析需求的数据。

这将极大的提升工作效率。

1.1 爬虫原理

网络爬虫又被叫做网络蜘蛛,网络机器人,简称爬虫,简单的解释就是,一种按照事先指定好的策略,按照一定规则和目的自动浏览互联网,保存互联网信息和数据的程序。

对爬虫程序应用的最为普遍的就是搜索引擎这一类的网站,这一类的网站通常会通过爬虫程序更新自身的网站内容。

并且近年火热的大数据,其中绝大部分的大数据初创公司依然会依靠爬虫程序来获取各种维度的数据集。

这两类的爬虫程序一般比较复杂和高难度,用以达到高可用的爬虫程序,使其能持续性的运行,源源不断的获取数据。

当然本文的爬虫类型和形态还不能达到大型的网络爬虫项目。

但已经足以满足本文需要的数据分析需求。

爬虫的工作流程大致分为五个步骤,发起网络请求,保存网页内容,解析网页内容提取数据,格式化数据内容,保存数据。

1.2 爬虫程序编写

在本节,笔者会完成本文获取数据的爬虫程序的编写,本次获取数据的爬虫会基于著名的爬虫框架scrapy进行开发编写。

1.2.1 框架还是原生

大部分程序可以分为,计算密集型和IO密集型任务程序,爬虫属于IO密集型任务。

也就是说,影响爬虫性能以及速度的因素通常不是CPU的计算能力,相比较计算量巨大的程序来说,爬虫程序更多的时间花费在了I/O操作当中。

所以在解决爬虫效率瓶颈上,需要从如何充分利用I/O等待的时间的角度解决问题。

并且由于python的特性,有全局锁的限制,使用多进程来说往往会是更好的选择。

业界著名的开源爬虫框架scrapy,自身的设计实现拥有一个默认10个线程的twisted线程集,这是一个可以极大提升爬虫抓取效率的解决方案。

而scrapy 是高效率的爬虫框架,就算是单机运行,一个小时也可以处理几十万条数据。

省去了自己编写爬虫的效率问题和线程安全问题。

同时,scrapy对网络请求,网页解析,数据存储,都有很好的封装。

让编写爬虫更简单快捷。

开发网络爬虫的大体思路几乎大小爬虫都是一致的,从而很多开发团队都会有自己的一套爬虫框架,或则是使用开源的python爬虫框架。

如此做可以极大减少“重复造轮子”,将效率提升的同时,还可以使项目更加规范化,大大方便日后对项目的维护和管理。

鉴于以上原因,本文爬虫部分项目将使用python著名的爬虫框架scrapy进行开发。

1.2.2 创建项目

首先进到将要用做项目路径的目录,使用scrapy命令创建一个爬虫项目,用到的命令是scrapy startproject HousePrice,创建完毕后,会在项目目录下发现如下图所示几个文件:

图1-1 项目列表

这些文件分别代表的含义是:

Items.py:项目中的变量文件集合,初始化抓取的数据字段;

Settings: 项目中的配置文件,定义了爬虫程序运行的规则,以及依赖的相应服务和配置参数;

Pipelines: 项目中管理存储数据的文件,管理程序运行最后阶段存取的设置;

Spiders:该目录是存放爬虫文件的地方。

1.2.3 定义Item

编辑Items.py这个文件,添加变量名,确认我们需要爬取的字段有哪些,并且作为爬取到的数据的容器。

在scrapy中将所要提取的字段名全部定义到items文件当中,这个文件需要继承自scrapy.Item这个类,并且需要将字段名定义为scrapy.Field()类型。

编写起来也很简单,只是相对于以往开发爬虫多了对字段的类型定义和类的继承与封装。

接下来去到有房价信息的网站,将需要抓取下来的字段定义好,就可完成Item的定义。

经过对房价信息网站的调研,我们抓取以下字段,楼盘名,地理位置,房型,区域空间,销售情况做数据分析。