人工神经网络作业

人工神经网络原理第8章习题参考答案

1.人工神经网络适合于解决哪些问题?试举例说明。

人工神经网络技术在处理对内部规律不甚了解,也不能用一组规则和方程等数学表达式描述的较为复杂的问题时具有一定的优越性,尤其对容错性有一定要求的任务,例如图形的检测与识别、诊断、特征提取、推论等,人工神经网络都是比较合适的处理手段,对于上述任务,即使输入数据是模糊的或不完善的,人工神经网络仍然能够对其进行处理。

示例略。

2.一个人工神经网络应用的开发要经过哪些阶段?明确需求、选取模型、设计神经网络节点、设计神经网络结构、设计神经网络训练算法、选择训练和测试样本、网络训练与测试、实现神经网络。

3.若要用神经网络实现对0~9十个数字字符的识别,应当如何选取适当的人工神经网络模型?参见表8-1,可以选择BP、Hopfield等神经网络模型。

4.若要实现一个简单的交通标志识别系统,应当如何选取适当的人工神经网络模型?参见表8-1,可以选择BP、Hopfield等神经网络模型。

5.若有一个私人医生,每天可接受10个预约病人的上门服务。

若要为该医生设计一条当天的巡诊路线,以使该医生的巡诊距离最短,应当如何选取适当的人工神经网络模型?这是一个优化问题,可以选择Hopfield神经网络。

6.试述对习题2、3、4中选取的人工神经网络模型进行设计开发的全过程。

略。

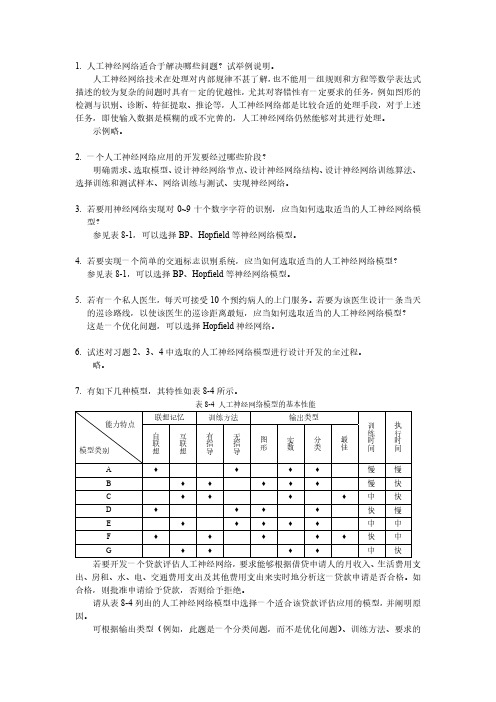

7.有如下几种模型,其特性如表8-4所示。

表8-4 人工神经网络模型的基本性能若要开发一个贷款评估人工神经网络,要求能够根据借贷申请人的月收入、生活费用支出、房租、水、电、交通费用支出及其他费用支出来实时地分析这一贷款申请是否合格。

如合格,则批准申请给予贷款,否则给予拒绝。

请从表8-4列出的人工神经网络模型中选择一个适合该贷款评估应用的模型,并阐明原因。

可根据输出类型(例如,此题是一个分类问题,而不是优化问题)、训练方法、要求的训练时间和执行时间等选取各项指标都符合具体需求的模型。

此题只是一个示例,让读者掌握如何选取适当的人工神经网络模型,具体选取过程略。

智能控制(神经网络)-作业

智能控制作业学生姓名: 学号: 专业班级:(一)7-2 采用BP网路、RBF网路、DRNN网路逼近线性对象, 分别进行matlab 仿真。

(二)采用BP网络仿真网络结构为2-6-1。

采样时间1ms, 输入信号, 权值的初值随机取值, 。

仿真m文件程序为:%BP simulationclear all;clear all;xite=0.5;alfa=0.5;w1=rands(2,6); % value of w1,initially by randomw1_1=w1;w1_2=w1;w2=rands(6,1); % value of w2,initially by randomw2_1=w2;w2_2=w2_1;dw1=0*w1;x=[0,0]';u_1=0;y_1=0;I=[0,0,0,0,0,0]'; % input of yinhanceng cellIout=[0,0,0,0,0,0]'; % output of yinhanceng cellFI=[0,0,0,0,0,0]';ts=0.001;for k=1:1:1000time(k)=k*ts;u(k)=0.5*sin(3*2*pi*k*ts);y(k)=(u_1-0.9*y_1)/(1+y_1^2);for j=1:1:6I(j)=x'*w1(:,j);Iout(j)=1/(1+exp(-I(j)));endyn(k)=w2'*Iout; %output of networke(k)=y(k)-yn(k); % error calculationw2=w2_1+(xite*e(k))*Iout+alfa*(w2_1-w2_2); % rectify of w2for j=1:1:6FI(j)=exp(-I(j))/(1+exp(-I(j))^2);endfor i=1:1:2for j=1:1:6dw1(i,j)=e(k)*xite*FI(j)*w2(j)*x(i); % dw1 calculation endendw1=w1_1+dw1+alfa*(w1_1-w1_2); % rectify of w1% jacobian informationyu=0;for j=1:1:6yu=yu+w2(j)*w1(1,j)*FI(j);enddyu(k)=yu;x(1)=u(k);x(2)=y(k);w1_2=w1_1;w1_1=w1;w2_2=w2_1;w2_1=w2;u_1=u(k);y_1=y(k);endfigure(1);plot(time,y,'r',time,yn,'b');xlabel('times');ylabel('y and yn');figure(2);plot(time,y-yn,'r');xlabel('times');ylabel('error');figure(3);plot(time,dyu);xlabel('times');ylabel('dyu');运行结果为:(三)采用RBF网络仿真网路结构为2-4-1, 采样时间1ms, 输入信号, 权值的初值随机取值, , 高斯基函数初值, 。

人工神经网络大作业

X X X X 大学研究生考查课作业课程名称:智能控制理论与技术研究生姓名:学号:作业成绩:任课教师(签名)交作业日时间:2010 年12 月22 日人工神经网络(artificial neural network,简称ANN)是在对大脑的生理研究的基础上,用模拟生物神经元的某些基本功能元件(即人工神经元),按各种不同的联结方式组成的一个网络。

模拟大脑的某些机制,实现某个方面的功能,可以用在模仿视觉、函数逼近、模式识别、分类和数据压缩等领域,是近年来人工智能计算的一个重要学科分支。

人工神经网络用相互联结的计算单元网络来描述体系。

输人与输出的关系由联结权重和计算单元来反映,每个计算单元综合加权输人,通过激活函数作用产生输出,主要的激活函数是Sigmoid函数。

ANN有中间单元的多层前向和反馈网络。

从一系列给定数据得到模型化结果是ANN的一个重要特点,而模型化是选择网络权重实现的,因此选用合适的学习训练样本、优化网络结构、采用适当的学习训练方法就能得到包含学习训练样本范围的输人和输出的关系。

如果用于学习训练的样本不能充分反映体系的特性,用ANN也不能很好描述与预测体系。

显然,选用合适的学习训练样本、优化网络结构、采用适当的学习训练方法是ANN的重要研究内容之一,而寻求应用合适的激活函数也是ANN研究发展的重要内容。

由于人工神经网络具有很强的非线性多变量数据的能力,已经在多组分非线性标定与预报中展现出诱人的前景。

人工神经网络在工程领域中的应用前景越来越宽广。

1人工神经网络基本理论[1]1. 1神经生物学基础可以简略地认为生物神经系统是以神经元为信号处理单元, 通过广泛的突触联系形成的信息处理集团, 其物质结构基础和功能单元是脑神经细胞即神经元(neu ron)。

(1) 神经元具有信号的输入、整合、输出三种主要功能作用行为。

突触是整个神经系统各单元间信号传递驿站, 它构成各神经元之间广泛的联接。

(3) 大脑皮质的神经元联接模式是生物体的遗传性与突触联接强度可塑性相互作用的产物, 其变化是先天遗传信息确定的总框架下有限的自组织过程。

大工22夏《神经网络》大作业

大工22夏《神经网络》大作业

1. 项目介绍

本次《神经网络》大作业旨在让同学们深入理解神经网络的工作原理,并能够独立实现一个简单的神经网络模型。

通过完成本次作业,同学们将掌握神经网络的基本结构,训练过程以及参数优化方法。

2. 任务要求

1. 独立实现一个具有至少三层神经网络的结构,包括输入层、隐藏层和输出层。

2. 选择一个合适的激活函数,并实现其对应的激活和导数计算方法。

3. 实现神经网络的正向传播和反向传播过程,包括权重更新和偏置更新。

4. 在一个简单的数据集上进行训练,评估并优化所实现的神经网络模型。

3. 评分标准

1. 神经网络结构实现(30分)

2. 激活函数实现(20分)

3. 正向传播和反向传播实现(20分)

4. 模型训练与评估(20分)

5. 代码规范与文档说明(10分)

4. 提交要求

1. 提交代码文件,包括神经网络结构、激活函数、正向传播、反向传播以及训练与评估的实现。

2. 提交一份项目报告,包括项目简介、实现思路、实验结果及分析。

3. 请在提交前确保代码的可运行性,并在报告中附上运行结果截图。

5. 参考资料

1. Goodfellow, I. J., Bengio, Y., & Courville, A. C. (2016). Deep learning. MIT press.

2. Russell, S., & Norvig, P. (2016). Artificial intelligence: a modern approach. Pearson Education Limited.

祝大家作业顺利!。

人工神经网络单选练习题

人工神经网络单选练习题一、基本概念1. 下列关于人工神经网络的描述,正确的是:A. 人工神经网络是一种静态的计算模型B. 人工神经网络可以模拟人脑的神经元连接方式C. 人工神经网络只能处理线性问题D. 人工神经网络的学习过程是监督式的2. 下列哪种算法不属于人工神经网络?A. 感知机算法B. 支持向量机算法C. BP算法D. Hopfield网络3. 人工神经网络的基本组成单元是:A. 神经元B. 节点C. 权重D. 阈值二、前向传播与反向传播4. 在前向传播过程中,下列哪个参数是固定的?A. 输入值B. 权重C. 阈值D. 输出值5. 反向传播算法的主要目的是:A. 更新输入值B. 更新权重和阈值C. 计算输出值D. 初始化网络参数6. 下列关于BP算法的描述,错误的是:A. BP算法是一种监督学习算法B. BP算法可以用于多层前馈神经网络C. BP算法的目标是最小化输出误差D. BP算法只能用于解决分类问题三、激活函数7. 下列哪种激活函数是非线性的?A. 步进函数B. Sigmoid函数C. 线性函数D. 常数函数8. ReLU激活函数的优点不包括:A. 计算简单B. 避免梯度消失C. 提高训练速度D. 减少过拟合9. 下列哪种激活函数会出现梯度饱和现象?A. Sigmoid函数B. ReLU函数C. Tanh函数D. Leaky ReLU函数四、网络结构与优化10. 关于深层神经网络,下列描述正确的是:A. 深层神经网络一定比浅层神经网络效果好B. 深层神经网络更容易过拟合C. 深层神经网络可以减少参数数量D. 深层神经网络训练速度更快11. 下列哪种方法可以降低神经网络的过拟合?A. 增加训练数据B. 减少网络层数C. 增加网络参数D. 使用固定的学习率12. 关于卷积神经网络(CNN),下列描述错误的是:A. CNN具有局部感知能力B. CNN具有参数共享特点C. CNN可以用于图像识别D. CNN无法处理序列数据五、应用场景13. 下列哪种问题不适合使用人工神经网络解决?A. 图像识别B. 自然语言处理C. 股票预测D. 线性规划14. 下列哪个领域不属于人工神经网络的应用范畴?A. 医学诊断B. 金融预测C. 智能家居D. 数值计算15. 关于循环神经网络(RNN),下列描述正确的是:A. RNN无法处理长距离依赖问题B. RNN具有短期记忆能力C. RNN训练过程中容易出现梯度消失D. RNN只能处理序列长度相同的数据六、训练技巧与正则化16. 下列哪种方法可以用来防止神经网络训练过程中的过拟合?A. 提前停止B. 增加更多神经元C. 减少训练数据D. 使用更大的学习率17. 关于Dropout正则化,下列描述错误的是:A. Dropout可以减少神经网络中的参数数量B. Dropout在训练过程中随机丢弃一些神经元C. Dropout可以提高模型的泛化能力D. Dropout在测试阶段不使用18. L1正则化和L2正则化的主要区别是:A. L1正则化倾向于产生稀疏解,L2正则化倾向于产生平滑解B. L1正则化比L2正则化更容易计算C. L2正则化可以防止过拟合,L1正则化不能D. L1正则化适用于大规模数据集,L2正则化适用于小规模数据集七、优化算法19. 关于梯度下降法,下列描述正确的是:A. 梯度下降法一定会找到全局最小值B. 梯度下降法在鞍点处无法继续优化C. 梯度下降法包括批量梯度下降、随机梯度下降和小批量梯度下降D. 梯度下降法的学习率在整个训练过程中保持不变20. 下列哪种优化算法可以自动调整学习率?A. 随机梯度下降(SGD)B. Adam优化算法C. Momentum优化算法D. 牛顿法21. 关于Adam优化算法,下列描述错误的是:A. Adam结合了Momentum和RMSprop算法的优点B. Adam算法可以自动调整学习率C. Adam算法对每个参数都使用相同的学习率D. Adam算法在训练初期可能会不稳定八、损失函数22. 在分类问题中,下列哪种损失函数适用于二分类问题?A. 均方误差(MSE)B. 交叉熵损失函数C. Hinge损失函数D. 对数损失函数23. 关于均方误差(MSE)损失函数,下列描述错误的是:A. MSE适用于回归问题B. MSE对异常值敏感C. MSE的输出范围是[0, +∞)D. MSE损失函数的梯度在接近最小值时趋近于024. 下列哪种损失函数适用于多分类问题?A. 交叉熵损失函数B. Hinge损失函数C. 对数损失函数D. 均方误差(MSE)九、模型评估与超参数调优25. 下列哪种方法可以用来评估神经网络的性能?A. 训练误差B. 测试误差C. 学习率D. 隐层神经元数量26. 关于超参数,下列描述正确的是:A. 超参数是在模型训练过程中自动学习的B. 超参数的值通常由经验丰富的专家设定C. 超参数的调整对模型性能没有影响D. 超参数包括学习率、批量大小和损失函数27. 关于交叉验证,下列描述错误的是:A. 交叉验证可以减少过拟合的风险B. 交叉验证可以提高模型的泛化能力C. 交叉验证会降低模型的训练速度D. 交叉验证适用于小规模数据集十、发展趋势与挑战28. 下列哪种技术是近年来人工神经网络的一个重要发展方向?A. 深度学习B. 线性回归C. 决策树D. K最近邻29. 关于深度学习,下列描述错误的是:A. 深度学习需要大量标注数据B. 深度学习模型通常包含多层神经网络C. 深度学习可以处理复杂的非线性问题D. 深度学习不适用于小规模数据集30. 下列哪种现象是训练深度神经网络时可能遇到的挑战?A. 梯度消失B. 参数过多C. 数据不平衡D. 所有上述选项都是挑战答案一、基本概念1. B2. B二、前向传播与反向传播4. B5. B6. D三、激活函数7. B8. D9. A四、网络结构与优化10. B11. A12. D五、应用场景13. D14. D15. C六、训练技巧与正则化16. A17. A18. A七、优化算法19. C20. B八、损失函数22. B23. D24. A九、模型评估与超参数调优25. B26. B27. D十、发展趋势与挑战28. A29. D30. D。

人工智能与神经网络 第二次作业

2-1 状态空间法、问题归约法、谓词逻辑法和语义网络法的要点是什么?它们有何本质上的联系及异同点? 状态空间法:基于解答空间的问题表示和求解方法,它是以状态和算符为基础来表示和求解问题的。

问题归约法:从目标出发逆向推理,建立子问题以及子问题的子问题,直至最后把初始问题归约为一个平凡的本原问题集合。

这就是问题归约法的实质。

谓词逻辑法:允许表达那些无法用命题逻辑表达的事情,其目的在于把数学中的逻辑论证符号化。

语义网络法:语义网络是知识的一种结构化图解表示,它由节点和弧线或链线组成。

节点用于表示实体、概念和情况等,弧线用于表示节点间的关系。

联系及异同点:状态空间图需要扩展过多的节点,容易出现“组合爆炸”,因而只适用于表示比较简单的问题,它是正向推理,只能表示或的关系。

问题归约法能够比状态空间法更有效地表示问题,状态空间法是问题归约法的特例,是逆向推理,能表示与或关系。

谓词逻辑法是一种形式语言,能够把数学中的逻辑论证符号化,可以表示比较复杂的问题。

语义网络法可用于表示多元关系,扩展后可以表示更复杂的关系。

2-3 利用图2.3,用状态空间法规划一个最短的旅行路程:此旅程从城市A 开始,访问其他城市不多于一次,并返回A 。

选择一个状态表示,表示出所求得的状态空间的节点及弧线,标出适当的代价,并指明图中从起始节点到目标节点的最佳路径。

最佳路径:ACDEBA 或 ABEDCA 总代价:6+5+6+10+7=34如下图所示 ,所有路径(其中红色所标出的为所要找的最佳路径)710 7 101396 6510BEDAC 图 2.32-4试说明怎样把一棵与或解树用来表达图2.28所示的电网络阻抗的计算。

单独的R、L或C可分别用R、jωL或1/jωC来计算,这个事实用作本原问题。

后继算符应以复合并联和串联阻抗的规则为基础。

图 2.28约定,用原来的与后继算法用来表达并联关系,用原来的或后继算法用来表达串联关系2-6 把下列句子变换成子句形式:(1) (∀x){P(x)→P(x)}(2) ∀x∀y(On(x,y)→Above(x,y))(3) ∀x∀y∀z(Above(x,y)∧Above(y,z)→Above(x,z))(4) ~{(∀x){P(x)→{(∀y)[p(y)→p(f(x,y))]∧(∀y)[Q(x,y)→P(y)]}}}(1)(ANY x) { P(x)→P(x) } (ANY x) {~P(x) OR P(x)} ~P(x) OR P(x)最后子句为:~P(x) OR P(x)(2) (ANY x) (ANY y) { On(x,y)→Above(x,y) } (ANY x) (ANY y) { ~On(x,y) OR Above(x,y) }~On(x,y) OR Above(x,y)最后子句为:~On(x,y) OR Above(x,y)(3) (ANY x) (ANY y) (ANY z) { Above(x,y) AND Above(y,z) → Above(x,z) }(命题联结词之优先级如下:否定→合取→析取→蕴涵→等价)(ANY x) (ANY y) (ANY z) { ~ [ Above(x,y) AND Above(y,z) ] OR Above (x,z) }~ [ Above(x,y) AND Above(y,z) ] OR Above (x,z)最后子句为:~[Above(x,y), Above(y,z)] OR Above(x,z)(4) ~{ (ANY x) { P(x)→ { (ANY y) [ p(y)→p(f(x,y)) ] AND (ANY y) [ Q(x,y) → P(y) ] } } }~ { (ANY x) { ~P(x) OR { (ANY y) [ ~p(y) OR p(f(x,y)) ] AND (ANY y) [ ~Q(x,y) OR P(y) ] } } }(EXT x) { P(x) AND { (EXT x) [ p(y) AND ~p(f(x,y)) ] OR (EXT y) [ Q(x,y) AND ~P(y) ] } }(EXT x) { P(x) AND { (EXT w) [ p(y) AND ~p(f(w,y)) ] OR (EXT v) [ Q(x,v) AND ~P(v) ] } }P(A) AND { [ p(y) AND ~p(f(B,y)) ] OR [ Q(A,C) AND ~P(C) ] }P(A) AND { [ p(y) AND ~p(f(B,y)) OR Q(A,C) ] AND [ p(y) AND ~p(f(B,y)) OR ~P(C) ] }P(A) AND { { p(y), ~p(f(B,y)) } OR Q(A,C) } AND { { p(y), ~p(f(B,y)) } OR ~P(C) }最后子句为:P(A){ p(x), ~p(f(B,x)) } OR Q(A,C){ p(y), ~p(f(B,y)) } OR ~P(C)2-7 用谓词演算公式表示下列英文句子(多用而不是省用不同谓词和项。

人工智能概论习题答案第3章 人工神经网络作业 20210307

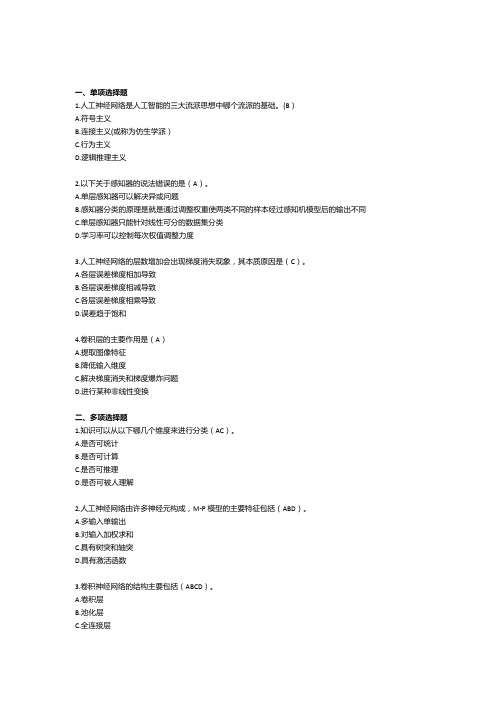

一、单项选择题1.人工神经网络是人工智能的三大流派思想中哪个流派的基础。

(B)A.符号主义B.连接主义(或称为仿生学派)C.行为主义D.逻辑推理主义2.以下关于感知器的说法错误的是(A)。

A.单层感知器可以解决异或问题B.感知器分类的原理是就是通过调整权重使两类不同的样本经过感知机模型后的输出不同C.单层感知器只能针对线性可分的数据集分类D.学习率可以控制每次权值调整力度3.人工神经网络的层数增加会出现梯度消失现象,其本质原因是(C)。

A.各层误差梯度相加导致B.各层误差梯度相减导致C.各层误差梯度相乘导致D.误差趋于饱和4.卷积层的主要作用是(A)A.提取图像特征B.降低输入维度C.解决梯度消失和梯度爆炸问题D.进行某种非线性变换二、多项选择题1.知识可以从以下哪几个维度来进行分类(AC)。

A.是否可统计B.是否可计算C.是否可推理D.是否可被人理解2.人工神经网络由许多神经元构成,M-P模型的主要特征包括(ABD)。

A.多输入单输出B.对输入加权求和C.具有树突和轴突D.具有激活函数3.卷积神经网络的结构主要包括(ABCD)。

A.卷积层B.池化层C.全连接层D.输入层三、判断题1.人工神经网络的层数是固定的,每层的神经元个数是不固定的(错)2.BP神经网络的误差是从前往后传播的(错)3.卷积神经网络的层数一般超过三层(对)四、简答题1.感知机是如何实现从数据中学习的?答:通过训练数据得到误差,再根据误差来调整权值,让再次计算训练数据得到的误差减小,最终达到无误差。

这时候得到的权值就称为学习到关于这些数据的知识。

2.什么是梯度,什么是梯度的方向?答:梯度就是把多元函数关于各个变量的偏导数放在一起构成的向量(也称为矢量)。

梯度方向表示当函数的各个变量都按照各自偏导数的比例进行增加时,各个增加量合起来构成的方向,是函数值变化最快的方向。

3.有A类物体和B类物体,均有两个类似的特征值。

以下有三个属于A类的样本,每个样本的特征值分别为[0.1, 1],[0.2, 0.7],[0.4, 0.8],样本标签用1表示;有三个属于B类的样本,其特征值分别为[0.8, 0.3],[0.9, 0.2],[1.0, 0.5],样本标签用0表示。

人工神经网络试题及答案

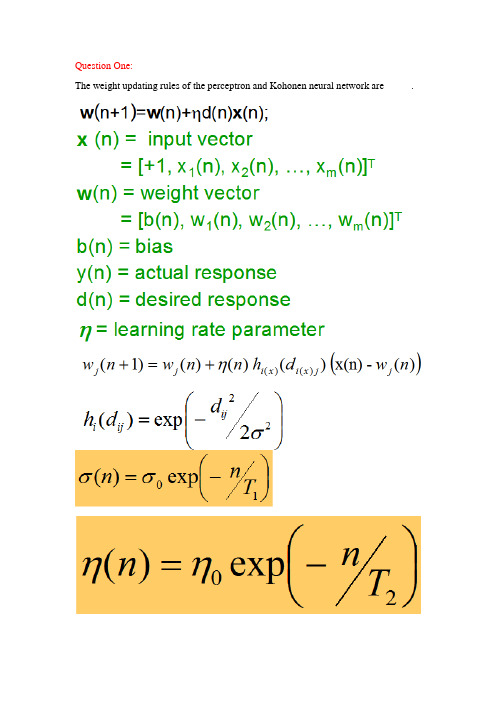

The weight updating rules of the perceptron and Kohonen neural network are _____.The limitation of the perceptron is that it can only model linearly separable classes. The decision boundary of RBF is__________linear______________________whereas the decision boundary of FFNN is __________________non-linear___________________________.Question Three:The activation function of the neuron of the Perceptron, BP network and RBF network are respectively________________; ________________; ______________.Question Four:Please present the idea, objective function of the BP neural networks (FFNN) and the learning rule of the neuron at the output layer of FFNN. You are encouraged to write down the process to produce the learning rule.Question Five:Please describe the similarity and difference between Hopfield NN and Boltzmann machine.相同:Both of them are single-layer inter-connection NNs.They both have symmetric weight matrix whose diagonal elements are zeroes.不同:The number of the neurons of Hopfield NN is the same as the number of the dimension (K) of the vector data. On the other hand, Boltzmann machine will have K+L neurons. There are L hidden neuronsBoltzmann machine has K neurons that serves as both input neurons and output neurons (Auto-association Boltzmann machine).Question Six:Please explain the terms in the above equation in detail. Please describe the weight updating equations of each node in the following FFNN using the BP learning algorithm. (PPT原题y=φ(net)= φ(w0+w1x1+w2x2))W0=w0+W1=w1+W2=w2+Question Seven:Please try your best to present the characteristics of RBF NN.(1)RBF networks have one single hidden layer.(2)In RBF the neuron model of the hidden neurons is different from the one of the output nodes.(3)The hidden layer of RBF is non-linear, the output layer of RBF is linear.(4)The argument of activation function of each hidden neuron in a RBF NN computes the Euclidean distance between input vector and the center of that unit.(5)RBF NN uses Gaussian functions to construct local approximations to non-linear I/O mapping.Question Eight:Generally, the weight vectors of all neurons of SOM is adjusted in terms of the following rule:w j(n+1)=w j(n)+η(n)h i(x)(d i(x)j)(x(n)-w j(n)).Please explain each term in the above formula.: weight value of the j-th neuron at iteration n: neighborhood functiondji: lateral distance of neurons i and j: the learning rate: the winning neuron most adjacent to XX: one input example。

人工神经网络设计作业

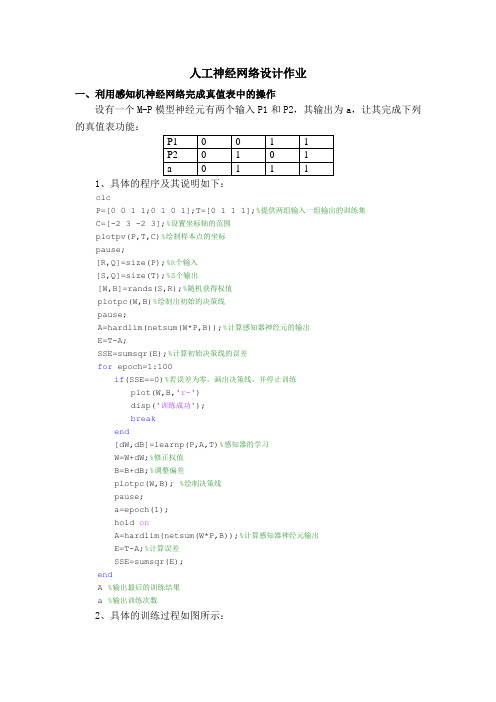

人工神经网络设计作业一、利用感知机神经网络完成真值表中的操作设有一个M-P模型神经元有两个输入P1和P2,其输出为a,让其完成下列的真值表功能:1、具体的程序及其说明如下:clcP=[0 0 1 1;0 1 0 1];T=[0 1 1 1];%提供两组输入一组输出的训练集C=[-2 3 -2 3];%设置坐标轴的范围plotpv(P,T,C)%绘制样本点的坐标pause;[R,Q]=size(P);%R个输入[S,Q]=size(T);%S个输出[W,B]=rands(S,R);%随机获得权值plotpc(W,B)%绘制出初始的决策线pause;A=hardlim(netsum(W*P,B));%计算感知器神经元的输出E=T-A;SSE=sumsqr(E);%计算初始决策线的误差for epoch=1:100if(SSE==0)%若误差为零,画出决策线,并停止训练plot(W,B,'r-')disp('训练成功');breakend[dW,dB]=learnp(P,A,T)%感知器的学习W=W+dW;%修正权值B=B+dB;%调整偏差plotpc(W,B); %绘制决策线pause;a=epoch(1);hold onA=hardlim(netsum(W*P,B));%计算感知器神经元输出E=T-A;%计算误差SSE=sumsqr(E);endA %输出最后的训练结果a %输出训练次数2、具体的训练过程如图所示:样本点P(1)P (2)初始决策线P(1)P (2)训练中的决策线P(1)P (2)训练结束P(1)P (2)3、训练结果:训练结束后我们可知道A=[0 1 1 1],训练次数a=4次。

二、利用BP 网络逼近一个非线性函数1、函数选择为指数衰减函数2*2p te -=*,隐层采用对数正切S 型,输出层采用线性型,具体的程序及其说明如下:clcn=5;%隐层神经元的个数 lr=0.1;%学习率 mc=0.9;%动量因子 p=0:0.05:3; t=2*exp(-2.*p);[r,l]=size(p);%r 输入层的维数 [s,l]=size(t);%s 输出层的维数 w1=0.2*rand(n,r);%隐层的权值 deltaw1=zeros(n,r); B1=0.2*rand(n,1);%隐层的偏移量 deltaB1=zeros(n,1); w2=0.2*rand(s,n);%输出层权值 deltaw2=zeros(s,n);B2=0.2*rand(s,1);%输出层的偏移量 deltaB2=zeros(s,1); A1=tansig(w1*p,B1);A2=purelin(w2*A1,B2);plot(p,t,'r+',p,A2,'b:');xlabel('输入样本p');ylabel('输出样本t');axis([0 3 -1 2])title(['样本点和未经训练的曲线']);legend('样本点');pause;epoch=1;sse=1;for epoch=1:10000 %最大训练圈数为1000w1=w1+deltaw1;%权值及其偏移量的调整B1=B1+deltaB1;w2=w2+deltaw2;B2=B2+deltaB2;[A1,A2]=simuff(p,w1,B1,'tansig',w2,B2,'purelin');E=t-A2;sse(epoch)=sumsqr(E);%计算误差if(sse(epoch)==0.001)%达到期望误差退出逼近breakendD2=deltalin(A2,E);D1=deltatan(A1,D2,w2);[deltaw2,deltaB2]=learnbpm(A1,D2,lr,mc,deltaw2,deltaB2); [deltaw1,deltaB1]=learnbpm(p,D1,lr,mc,deltaw1,deltaB1); if(sse(epoch)<=0.001)breakendend;epochplot(p,t,'r+',p,A2,'b:');xlabel('输入样本p');ylabel('输出样本t');title(['训练',num2str(epoch),'次后的曲线']);legend('样本点');axis([0 3 -1 2])pauseFF=1:epoch;plot(FF,sse(FF),'r-');xlabel('训练次数');ylabel('误差');title(['SSE误差曲线']);pause;%泛化能力测试[A1,A2]=simuff(p,w1,B1,'tansig',w2,B2,'purelin');p=0:0.05:3;t=2*exp(-2.*p);%训练后逼近的曲线plot(p,A2,'-');xlabel('输入样本p');ylabel('输出样本t');legend('逼近的曲线'); axis([0 3 -1 3]) hold on ; pt=0:0.1:3;tt=2*exp(-2.*pt); plot(pt,tt,'ro'); title(['检验泛化能力']); axis([0 3 -1 3]) pause; hold off ; epoch %输出训练次数2、具体的逼近过程如下图形显示:0.511.522.53输入样本p输出样本t样本点和未经训练的曲线0.511.522.53输入样本p输出样本t训练113后的曲线由训练结果显示:完成很好的逼近功能,训练次数为113次,误差曲线如下图,我们可以看到误差是收敛的。

D人工神经网络复习习题

2.2.1 神经元的建摸 (2/6)

上述假定,可用图2.5中的神经元模型示意图进行图解表 示。

i 1

(2 .1 )

式中 τij —— 输入i输出j间的突触延时; Tj —— 神经元j的阈值; wij —— 神经元i到j的突触连接系数值; f( ) —— 神经元转移函数。

2.2.2 神经元的数学模型(2/6)

为简单起见,将上式中的突触延时取为单位时

间,则式(2.1)可写为

n

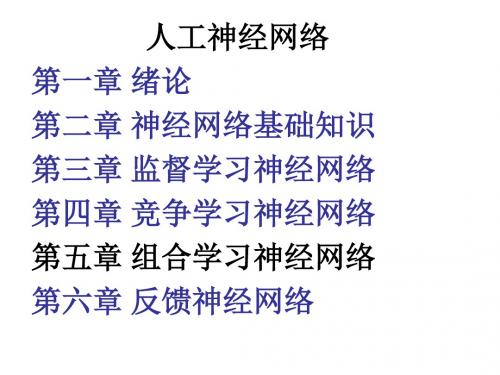

第3章 监督学习神经网络 §3.1 单层感知器

§ 3.1.1 感知器模型 § 3.1.2 单节点感知器的功能分析 § 3.1.3 感知器的学习算法 § 3.1.4 感知器的局限性及解决途径 §3.2 基于误差反传的多层感知器—BP神经网络 § 3.2.1 BP网络模型 § 3.2.2 BP学习算法 § 3.2.3 BP算法的程序实现 § 3.2.4 BP网络的主要能力 § 3.2.5 误差曲面与BP算法的局限性 §3.3 BP算法的改进 §3.4 BP网络设计基础 §3.5 BP网络应用与设计实例 本章小结

§1.2.1 启蒙时期 …低潮时期…复兴时期…高潮时期(新高潮)………

本章小结

第2章 神经网络基础知识 §2.1 人工神经网络的生物学基础 §2.2 人工神经元模型

§ 2.2.1 神经元的建摸 § 2.2.2 神经元的数学模型 § 2.2.3 神经元的转移函数 §2.3 人工神经网络模型 § 2.3.1 网络拓扑结构类型

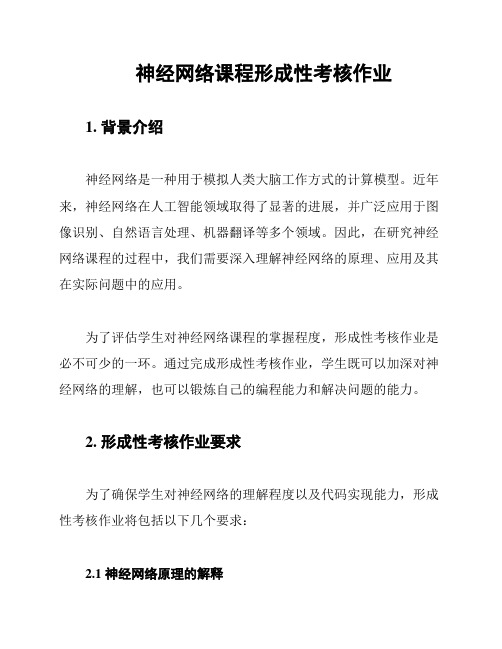

神经网络课程形成性考核作业

神经网络课程形成性考核作业1. 背景介绍神经网络是一种用于模拟人类大脑工作方式的计算模型。

近年来,神经网络在人工智能领域取得了显著的进展,并广泛应用于图像识别、自然语言处理、机器翻译等多个领域。

因此,在研究神经网络课程的过程中,我们需要深入理解神经网络的原理、应用及其在实际问题中的应用。

为了评估学生对神经网络课程的掌握程度,形成性考核作业是必不可少的一环。

通过完成形成性考核作业,学生既可以加深对神经网络的理解,也可以锻炼自己的编程能力和解决问题的能力。

2. 形成性考核作业要求为了确保学生对神经网络的理解程度以及代码实现能力,形成性考核作业将包括以下几个要求:2.1 神经网络原理的解释学生需要写一篇关于神经网络原理的解释文章。

这篇文章应该包括神经网络的基本结构、工作原理和常用算法。

学生需要用自己的语言解释这些概念,并结合实例进行说明。

文章长度至少为500字以上。

2.2 神经网络的编程实现学生需要使用Python或其他编程语言,实现一个简单的神经网络模型。

该模型应该具备基本的前向传播和反向传播功能,并能够在给定的样本数据上进行训练和预测。

学生需要提交完整的代码,并对代码进行简要的注释和说明。

2.3 神经网络应用案例分析学生需要选择一个实际应用场景,如图像识别、情感分析等,采用神经网络方法进行分析和实现。

学生需要解释在该应用场景下神经网络的优势和限制,并给出自己的思考和改进建议。

分析报告的要求为至少300字以上。

3. 提交要求- 神经网络编程实现的Python代码文件4. 评分标准形成性考核作业将根据以下几个方面进行评分:- 神经网络原理解释的清晰度和准确性- 神经网络编程实现的正确性和实用性- 神经网络应用案例分析的深度和思考度各个方面的得分将综合计算出最终的评分。

5. 时间安排- 作业发布:2021年5月1日- 截止日期:2021年5月15日6. 总结通过完成神经网络课程的形成性考核作业,学生可以深入理解神经网络的原理和应用,并提高自己的编程能力和解决问题的能力。

神经网络作业

机器学习,是人工智能的一个子领域,主要关注于开发一些蠩计算机可以自动“学习”的技术。

更堷体说,机器学习是一种用于创建数据順分析分析程序的方法。

机器学习跟统计学有着重要的关系,因为这两个领域都栯研究数据分析,但是又不像统计学,栺器学习关注的是计算实现的算法复杂堦。

很多推论问题属于无程序可循难度,所以部分的机器学习研究是开发容栓处理的近似算法。

机器学习已经有亠十分广泛的应用例如搜索引擎、诊断、检测信用卡欺诈、证券市场分析、DNA序列测序、语音识别和手写识别识别、战略游戏和机器人运用。

第五讲机器学习机器学习就是计算机自动获取知识,它是知识工程的三个分支(使用知识、知识表示、获取知识)之一。

5.1 研究机器学习的必要性和可行性人工智能的概念和方法已经用于很多领域中,主要成果是专家系统、自然语言理解、计算机视觉和听觉、推理系统的研究。

当前人工智能研究的主要障碍和发展方向之一就是机器学习,这包括发展机器学习的计算理论和构造学习系统。

现在的人工智能系统还完全没有或仅有很有限的学习能力。

人工智能系统中的知识由人工编程送入系统,知识库中错误也不能自动改正。

也就是说,现有的AI系统是演绎推理而不是归纳推理,因而不能自动获取和生成知识。

人类有能力获取新知识、学习新技巧,并在实践中改进之。

如果一个人反复犯同样的错误,就不能说他是有智能的。

学习是智能的重要一环,人工智能的研究目标之一应该是理解学习的本质和建立学习系统。

人工智能解决的问题越来越复杂,系统中的知识越来越多,这些知识包括:领域专用的事实和规则,作为常识的启发式和约束,通用的概念和理论,把如此复杂的知识送入系统是复杂的、费时的、容易出错的和需要经验的。

例如:∙建立专家系统需要有关领域的专家和知识工程师的配合。

使用机器学习技术可以简化这一过程;∙计算机视觉中包含各种视觉专用变换、几何概念和对象的物理与功能描述。

把所有这些知识送入系统中是很困难的,系统应该可以由示教实例自动生成知识。

人工神经网络练习题

人工神经网络练习题

1. 什么是人工神经网络?

人工神经网络是一种模仿人类神经系统结构和功能的计算模型。

它由许多人工神经元组成,通过模拟神经元之间的相互连接和信息

传递来研究和处理数据。

2. 人工神经网络的优点是什么?

人工神经网络具有以下优点:

- 能够进行非线性建模,适用于处理复杂的非线性问题。

- 具有自适应研究能力,能够通过反馈机制不断优化性能。

- 对于模式识别、分类和预测等任务表现良好。

- 具有容错性,即使部分神经元损坏,网络仍然可以正常工作。

3. 人工神经网络的主要组成部分有哪些?

人工神经网络主要由以下组成部分构成:

- 输入层:接收外部输入数据。

- 隐藏层:进行数据处理和特征提取。

- 输出层:给出最终的结果。

- 权重:神经元之间的连接强度。

- 激活函数:用于处理神经元的输入和输出。

4. 请解释反向传播算法的工作原理。

反向传播算法是一种用于训练人工神经网络的方法。

它通过将

输入数据传递给网络,并比较输出结果与期望结果之间的差异,然

后根据差异调整网络中的权重和偏置值。

该过程从输出层开始,逐

渐向前传播误差,然后通过梯度下降法更新权重和偏置值,最终使

网络逼近期望输出。

5. 请列举几种常见的用途人工神经网络的应用。

人工神经网络可以应用于许多领域,包括但不限于:

- 机器研究和模式识别

- 金融市场预测

- 医学诊断和预测

- 自动驾驶汽车

- 语音和图像识别

以上是关于人工神经网络的练习题,希望对您的学习有所帮助。

人工智能习题作业神经计算I习题答案

人工智能习题作业神经计算I习题答案第五章神经网络课后习题及答案一、选择题:1. 在BP算法中,设y=f(xi)为xi的平滑函数,想知道xi对y增大变化的情况,我们可求,然后进行下列的哪一项?( B )A 取最小B 取最大C 取积分D 取平均值2. 对于反向传播学习,无论是在识别单个概念的学习或识别两个概念的学习中,都涉及到下列的哪一个操作?( A )A 权值的修正B 调整语义结构C 调整阀值D 重构人工神经元3. 根据Hopfield网络学习的特点,能实现联想记忆和执行线性和非线性规划等求解问题其应用没有涉及到下列的哪一个内容?( D )A 模糊推理模型B 非线性辨认C 自适应控制模型D 图象识别4. 对于神经网络的二级推理产生式规则由三个层次构成,它不含下列的哪一个层次?( C )A 输入层B 输出层C 中间层D 隐层5. 人工神经网络借用了生理神经元功能的一些描述方式,它涉及到下列的哪一些内容?( ABC )A 模拟神经元B 处理单元为节点C 加权有向图D 生理神经元连接而成6. 在应用和研究中采用的神经网络模型有许多种,下列的哪一些是具有代表性的?( ABD )A 反向传递(BP)B Hopfield网C 自适应共振D 双向联想存储器7. 下列的哪一些内容与反向传播学习算法有关?( ABCD )A 选取比率参数B 误差是否满足要求C 计算权值梯度D 权值学习修正8. 构造初始网络后,要用某种学习算法调整它的权值矩阵,使NN在功能上满足样例集给定的输入一输出对应关系,并由此产生推理,该矩阵必须满足下列的哪一个性质? ( A )A 收敛性B 对称性C 满秩性D 稀疏性9. 在人工神经元的功能描述中,往往会用一激发函数来表示输出,常用的一般非线性函数有下列的哪一些项? ( ABD )A 阀值型B 分段线性强饱和型C 离散型D S i gm oid型10. 基于神经网络的推理,其应用中必须涉及到下列的哪一些内容?( ACD )A NN的结构模型B NN的推理规则C NN的学习算法D 从NN到可解释的推理网二、填空题:1. 前馈网络是一种具有很强学习能力的系统,结构简单,易于编程。

神经网络作业总结范文

一、前言随着人工智能技术的飞速发展,神经网络作为人工智能领域的重要技术之一,越来越受到广泛关注。

本次作业以吴恩达机器学习课程中的神经网络部分为基础,通过实际操作,对神经网络的理论知识和实践应用进行了深入学习和总结。

二、理论基础1. 神经网络结构神经网络主要由输入层、隐藏层和输出层组成。

输入层负责接收输入数据,隐藏层负责对输入数据进行特征提取和变换,输出层负责输出最终结果。

2. 激活函数激活函数是神经网络中的关键组成部分,它将线性组合的结果转换为非线性的输出。

常用的激活函数有Sigmoid、ReLU和Tanh等。

3. 权值和偏置权值和偏置是神经网络中重要的参数,它们决定了神经网络的输出。

在训练过程中,通过不断调整权值和偏置,使神经网络能够更好地拟合数据。

4. 前向传播和反向传播前向传播是指将输入数据经过神经网络各个层,最终得到输出结果的过程。

反向传播是指根据输出结果与真实值的误差,反向传播误差信号,并更新权值和偏置,使神经网络能够不断优化。

三、实践操作1. 数据准备本次作业以MNIST手写数字数据集为例,进行神经网络训练。

首先,需要将数据集划分为训练集、验证集和测试集。

2. 网络搭建根据吴恩达机器学习课程的要求,搭建一个简单的神经网络。

输入层为784个神经元,隐藏层为128个神经元,输出层为10个神经元,分别对应0-9的数字。

3. 训练过程使用训练集对神经网络进行训练。

在训练过程中,通过调整学习率、批处理大小等参数,使神经网络能够更好地拟合数据。

4. 验证和测试使用验证集和测试集对神经网络进行验证和测试。

通过计算准确率等指标,评估神经网络的性能。

四、总结1. 理论知识的重要性通过本次作业,深刻体会到理论知识在神经网络实践中的重要性。

只有掌握扎实的理论基础,才能更好地进行实践操作。

2. 神经网络的优化在训练过程中,不断调整学习率、批处理大小等参数,使神经网络能够更好地拟合数据。

这表明,优化神经网络参数对于提高性能至关重要。

神经网络作业-问题及答案

一 简述人工神经网络常用的网络结构和学习方法。

(10分)答:1、人工神经网络常用的网络结构有三种分别是:BP 神经网络、RBF 神经网络、Kohonen 神经网络、ART 神经网络以及Hopfield 神经网络。

人工神经网络模型可以按照网络连接的拓扑结构分类,还可以按照内部信息流向分类。

按照拓扑结构分类:层次型结构和互连型结构。

层次型结构又可分类:单纯型层次网络结构、输入层与输出层之间有连接的层次网络结构和层内有互联的层次网络结构。

互连型结构又可分类:全互联型、局部互联型和稀疏连接性。

按照网络信息流向分类:前馈型网络和反馈型网络。

2、学习方法分类:⑴.Hebb 学习规则:纯前馈网络、无导师学习。

权值初始化为0。

⑵.Perceptron 学习规则:感知器学习规则,它的学习信号等于神经元期望输出与实际输出的差。

单层计算单元的神经网络结构,只适用于二进制神经元。

有导师学习。

⑶.δ学习规则:连续感知学习规则,只适用于有师学习中定义的连续转移函数。

δ规则是由输出值与期望值的最小平方误差条件推导出的。

⑷.LMS 学习规则:最小均放规则。

它是δ学习规则的一个特殊情况。

学习规则与神经元采用的转移函数无关的有师学习。

学习速度较快精度较高。

⑸.Correlation 学习规则:相关学习规则,他是Hebb 学习规则的一种特殊情况,但是相关学习规则是有师学习。

权值初始化为0。

⑹.Winner-Take-All 学习规则:竞争学习规则用于有师学习中定义的连续转移函数。

权值初始化为任意值并进行归一处理。

⑺.Outstar 学习规则:只适用于有师学习中定义的连续转移函数。

权值初始化为0。

2.试推导三层前馈网络BP 算法权值修改公式,并用BP 算法学习如下函数:21212221213532)(x x x x x x x x f -+-+=,其中:551≤≤-x ,552≤≤-x 。

基本步骤如下:(1)在输入空间]5,5[1-∈x 、]5,5[2-∈x 上按照均匀分布选取N 个点(自行定义),计算)(21x x f ,的实际值,并由此组成网络的样本集;(2)构造多层前向网络结构,用BP 算法和样本集训练网络,使网络误差小于某个很小的正数ε;(3)在输入空间上随机选取M 个点(N M >,最好为非样本点),用学习后的网络计算这些点的实际输出值,并与这些点的理想输出值比较,绘制误差曲面;(4)说明不同的N 、ε值对网络学习效果的影响。

人工神经网络作业

人工神经网络在材料领域的应用引言长期以来,对材料研究采纳的是依托大量实验并进行大面积挑选的方式。

这需要消耗大量人力和物理资源及时刻。

由于大量尚未理论化的体会和实验规律的存在,在相当一段时刻内还不能够完全离开体会和实验来进行研究。

于是,人们将目光转向理论付诸的材料研究。

将先进的运算机技术应用于现代材料研究中,通过较少的实验取得较为理想的材料,达到事半功倍的成效。

材料设计的自由度大,阻碍因素多,利用传统的数学建模方式来研究结构。

工艺与性能之间的关系,存在许多困难,而且简化求解问题的数学和力学模型,往往是模型本身存在较大的局限性,难以知足工程技术的需求,人工神经网络的进展,为材料的研究提供了新的有效途径错误!未找到引用源。

人工神经网络(Artifical Neural Networks)是用来模拟人脑结构及智能特点的一个国际前沿研究领域,它具有独特的大规模并行散布处置及学习联想能力,力图模拟生物神经系统。

与其他传统模型相较,它具有以下独特的优势:较强的非线性问题处置能力;对噪声和不完整信息具有低灵敏性,抗噪声能力好;在运行进程中依动态数据库对周围环境具有自适应能力而自我调整、完善、进展使误差达到最小,以提高运行精度;能专门好的完成多变量模式识别;能对进程实此刻线响应,在系统中能够在线利用。

由于他们的综合特点和人类的智能相似,故具有大规模并行、散布式存贮和处置、自组织、自适应的学习能力,适用于处置需要同时考虑许多因素和条件的不精准和模糊的信息问题,能够解决专家系统和统计分析方式不易解决的问题错误!未找到引用源。

正是因为具有上述优势,人工神经网络在信号处置、模式识别、目标跟踪、机械人操纵、专家系统、组合优化、网络治理等众多领域的应用中取得了引人注目的功效。

人工神经网络是一门高度综合的交叉学科,已在生物、微电子、数学、物理、化学化工和材料等学科中取得了普遍的应用。

在材料科学与工程领域中,人工神经网络在处置材料科学的许多问题中发挥了庞大作用,已普遍用于材料设计与成份优化、材料的智能加工与操纵、材料加工工艺的优化、材料相变规律的研究与相变点的预测、材料性能及缺点预测等方面,涉及高分子,金属、合金和无机非金属等多种材料,并取得了良好成效错误!未找到引用源。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

anew = 0.1684 0.1717 0.1857 也就是说三只虫子都是属于 Af 源代码:

%matlab 源程序求解人工神经网络

clc

% 清屏

clear all;

%清除内存以便加快运算速度

close all;

%关闭当前所有 figure 图像

dB1=Delta1*ones(SamNum,1);

%对输出层与隐含层之间的权值和阈值进行修正

W2=W2+lr*dW2;

B2=B2+lr*dB2;

%对输入层与隐含层之间的权值和阈值进行修正

W1=W1+lr*dW1;

B1=B1+lr*dB1;

end

HiddenOut=logsig(W1*SamIn+repmat(B1,1,TestSamNum)); % 隐含层输出最终结果

SamOut=tn + Noise;

%将噪声添加到输出样本上

TestSamIn=SamIn;

%这里取输入样本与测试样本相同因为样本容量偏少

TestSamOut=SamOut;

%也取输出样本与测试样本相同

MaxEpochs=500000;

%最多训练次数为 500000

lr=0.035;

%学习速率为 0.035

W1=0.5*rand(HiddenUnitNum,InDim)-0.1; %初始化输入层与隐含层之间的权值

B1=0.5*rand(HiddenUnitNum,1)-0.1;

%初始化输入层与隐含层之间的阈值

W2=0.5*rand(OutDim,HiddenUnitNum)-0.1; %初始化输出层与隐含层之间的权值

[SamIn,minp,maxp,tn,mint,maxt]=premnmx(p,t); %原始样本对(输入和输出)初始化

rand('state',sum(100*clock)) %依据系统时钟种子产生随机数

NoiseVar=0.01;

%噪声强度为 0.01(添加噪声的目的是为了防止网络过度拟合)

Noise=NoiseVar*randn(1,SamNum); %生成噪声

TestSamIn=SamIn;

%这里取输入样本与测试样本相同因为样本容量偏少

TestSamOut=SamOut;

%也取输出样本与测试样本相同

MaxEpochs=50000;

%最多训练次数为 50000

lr=0.035;

%学习速率为 0.035

误差为 0.65*10^(-5)

B2=0.5*rand(OutDim,1)-0.1;

%初始化输出层与隐含层之间的阈值

ErrHistory=[];

%给中间变量预先占据内存

for i=1:MaxEpochs

HiddenOut=logsig(W1*SamIn+repmat(B1,1,SamNum)); % 隐含层网络输出

NetworkOut=W2*HiddenOut+repmat(B2,1,SamNum); % 输出层网络输出

% 他们是权值(阈值)依据能量函数负梯度下降原理所作的每一步动态调整量

Delta2=Error;

Delta1=W2'*Delta2.*HiddenOut.*(1-HiddenOut);

dW2=Delta2*HiddenOut';

dB2=Delta2*ones(SamNum,1);

dW1=Delta1*SamIn';

0.086 0.071 0.107 0.096 0.065 0.093 0.131];

%样本的相关数据;

pnewn=tramnmx(pnew,minp,maxp);

%利用原始输入数据的归一化参数对新数据进行归一化;

HiddenOut=logsig(W1*pnewn+repmat(B1,1,ForcastSamNum)); % 隐含层输出预测结果

legend('网络输出 UV254 去除率(%)','UV254 去除率(%)');

xlabel('样本');ylabel('UV254 去除率(%)');

% 利用训练好的网络进行预测

% 当用训练好的网络对新数据 pnew 进行预测时,也应作相应的处理

pnew=[1.42 2.51 3.21 4.29 5.24 2.53 3.79

Error=SamOut-NetworkOut;

% 实际输出与网络输出之差

SSE=sumsqr(Error)

%能量函数(误差平方和)

ErrHistory=[ErrHistory SSE];

if SSE<E0,break, end

%如果达到误差要求则跳出学习循环

% 以下六行是 BP 网络最核心的程序

cqulv=[50.2 59.5 58.8 66.2 65.5 64.5 73.6 76.4 78.5 79.2...

81.4 90.3 93.1 98.2 97.3 98.1 97.3 98.8 96.9 98.6];

p=[xiuyang;rukou]; %输入数据矩阵

t=[cqulv];

%目标数据矩阵

1.54 1.56];

%目标值

cqulv=[0.9 0.9 0.9 0.1 0.9 0.9 0.1 0.1 0.1 0.1 0.1 0.1 0.1 0.1 0.1];

p=[xiuyang;rukou]; %输入数据矩阵

t=[cqulv];

%目标数据矩阵

[SamIn,minp,maxp,tn,mint,maxt]=premnmx(p,t); %原始样本对(输入和输出)初始化

Error=SamOut-NetworkOut;

% 实际输出与网络输出之差

SSE=sumsqr(Error)

%能量函数(误差平方和)

ErrHistory=[ErrHistory SSE];

if SSE<E0,break, end

%如果达到误差要求则跳出学习循环

% 以下六行是 BP 网络最核心的程序

SamNum=15;

%输入样本数量为 15

TestSamNum=15;

%测试样本数量也是 15

ForcastSamNum=3;

%预测样本数量为 3

HiddenUnitNum=8;

%中间层隐节点数量取 8,比工具箱程序多了 1 个

InDim=2;

%网络输入维度为 2

OutDim=1;

%网络输出维度为 1

B2=0.5*rand(OutDim,1)-0.1;

%初始化输出层与隐含层之间的阈值

ErrHistory=[];

%给中间变量预先占据内存

for i=1:MaxEpochs

HiddenOut=logsig(W1*SamIn+repmat(B1,1,SamNum)); % 隐含层网络输出

NetworkOut=W2*HiddenOut+repmat(B2,1,SamNum); % 输出层网络输出

anew=postmnmx(anewn,mint,maxt)

k=1

if(anew(k)<0.2&&anew(k+1)<0.2&&anew(k+2)<0.2)

disp('检验通过');

else

disp('检验不通过');

end

人工神经网络作业二:

%matlab 源程序求解人工神经网络

clc

% 清屏

clear all;

legend('网络输出目标值','实际目标值');

xlabel('样本');ylabel('目标值');

% 利用训练好的网络进行预测

% 当用训练好的网络对新数据 pnew 进行预测时,也应作相应的处理

pnew=[1.24 1.28 1.4

1.8 1.84 2.04];

%样本的相关数据;

pnewn=tramnmx(pnew,minp,maxp);

E0=0.65*10^(-9);

%目标误差为 0.65*10^(-8)

W1=0.5*rand(HiddenUnitNum,InDim)-0.1; %初始化输入层与隐含层之间的权值

B1=0.5*rand(HiddenUnitNum,1)-0.1;

%初始化输入层与隐含层之间的阈值

W2=0.5*rand(OutDim,HiddenUnitNum)-0.1; %初始化输出层与隐含层之间的权值

rand('state',sum(100*clock)) %依据系统时钟种子产生随机数

NoiseVar=0.01;

%噪声强度为 0.01(添加噪声的目的是为了防止网络过度拟合)

Noise=NoiseVar*randn(1,SamNum); %生成噪声

SamOut=tn + Noise;

%将噪声添加到输出样本上

%入口 UV254

rukou=[0.116 0.104 0.078 0.107 0.136 0.082 0.125 0.076 0.122...

0.092 0.081 0.068 0.077 0.108 0.128 0.063 0.135 0.07 0.126

0.087];

%UV254 去除率(%)

%清除内存以便加快运算速度

close all;

%关闭当前所有 figure 图像

SamNum=20;

%输入样本数量为 20