人工智能不确定性推理部分参考答案

人工智能不确定性推理部分参考答案

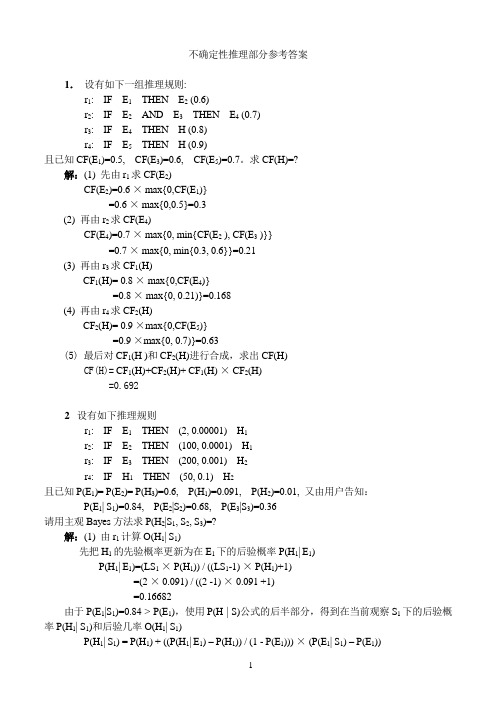

不确定性推理部分参考答案1.设有如下一组推理规则:r1: IF E1THEN E2 (0.6)r2: IF E2AND E3THEN E4 (0.7)r3: IF E4THEN H (0.8)r4: IF E5THEN H (0.9)且已知CF(E1)=0.5, CF(E3)=0.6, CF(E5)=0.7。

求CF(H)=?解:(1) 先由r1求CF(E2)CF(E2)=0.6 × max{0,CF(E1)}=0.6 × max{0,0.5}=0.3(2) 再由r2求CF(E4)CF(E4)=0.7 × max{0, min{CF(E2 ), CF(E3 )}}=0.7 × max{0, min{0.3, 0.6}}=0.21(3) 再由r3求CF1(H)CF1(H)= 0.8 × max{0,CF(E4)}=0.8 × max{0, 0.21)}=0.168(4) 再由r4求CF2(H)CF2(H)= 0.9 ×max{0,CF(E5)}=0.9 ×max{0, 0.7)}=0.63(5) 最后对CF1(H )和CF2(H)进行合成,求出CF(H)CF(H)= CF1(H)+CF2(H)+ CF1(H) × CF2(H)=0.6922 设有如下推理规则r1: IF E1THEN (2, 0.00001) H1r2: IF E2THEN (100, 0.0001) H1r3: IF E3THEN (200, 0.001) H2r4: IF H1THEN (50, 0.1) H2且已知P(E1)= P(E2)= P(H3)=0.6, P(H1)=0.091, P(H2)=0.01, 又由用户告知:P(E1| S1)=0.84, P(E2|S2)=0.68, P(E3|S3)=0.36请用主观Bayes方法求P(H2|S1, S2, S3)=?解:(1) 由r1计算O(H1| S1)先把H1的先验概率更新为在E1下的后验概率P(H1| E1)P(H1| E1)=(LS1× P(H1)) / ((LS1-1) × P(H1)+1)=(2 × 0.091) / ((2 -1) × 0.091 +1)=0.16682由于P(E1|S1)=0.84 > P(E1),使用P(H | S)公式的后半部分,得到在当前观察S1下的后验概率P(H1| S1)和后验几率O(H1| S1)P(H1| S1) = P(H1) + ((P(H1| E1) – P(H1)) / (1 - P(E1))) × (P(E1| S1) – P(E1))= 0.091 + (0.16682 –0.091) / (1 – 0.6)) × (0.84 – 0.6)=0.091 + 0.18955 × 0.24 = 0.136492O(H1| S1) = P(H1| S1) / (1 - P(H1| S1))= 0.15807(2) 由r2计算O(H1| S2)先把H1的先验概率更新为在E2下的后验概率P(H1| E2)P(H1| E2)=(LS2×P(H1)) / ((LS2-1) × P(H1)+1)=(100 × 0.091) / ((100 -1) × 0.091 +1)=0.90918由于P(E2|S2)=0.68 > P(E2),使用P(H | S)公式的后半部分,得到在当前观察S2下的后验概率P(H1| S2)和后验几率O(H1| S2)P(H1| S2) = P(H1) + ((P(H1| E2) – P(H1)) / (1 - P(E2))) × (P(E2| S2) – P(E2))= 0.091 + (0.90918 –0.091) / (1 – 0.6)) × (0.68 – 0.6)=0.25464O(H1| S2) = P(H1| S2) / (1 - P(H1| S2))=0.34163(3) 计算O(H1| S1,S2)和P(H1| S1,S2)先将H1的先验概率转换为先验几率O(H1) = P(H1) / (1 - P(H1)) = 0.091/(1-0.091)=0.10011再根据合成公式计算H1的后验几率O(H1| S1,S2)= (O(H1| S1) / O(H1)) × (O(H1| S2) / O(H1)) × O(H1)= (0.15807 / 0.10011) × (0.34163) / 0.10011) × 0.10011= 0.53942再将该后验几率转换为后验概率P(H1| S1,S2) = O(H1| S1,S2) / (1+ O(H1| S1,S2))= 0.35040(4) 由r3计算O(H2| S3)先把H2的先验概率更新为在E3下的后验概率P(H2| E3)P(H2| E3)=(LS3× P(H2)) / ((LS3-1) × P(H2)+1)=(200 × 0.01) / ((200 -1) × 0.01 +1)=0.09569由于P(E3|S3)=0.36 < P(E3),使用P(H | S)公式的前半部分,得到在当前观察S3下的后验概率P(H2| S3)和后验几率O(H2| S3)P(H2| S3) = P(H2 | ¬ E3) + (P(H2) – P(H2| ¬E3)) / P(E3)) × P(E3| S3)由当E3肯定不存在时有P(H2 | ¬ E3) = LN3× P(H2) / ((LN3-1) × P(H2) +1)= 0.001 × 0.01 / ((0.001 - 1) × 0.01 + 1)= 0.00001因此有P(H2| S3) = P(H2 | ¬ E3) + (P(H2) – P(H2| ¬E3)) / P(E3)) × P(E3| S3)=0.00001+((0.01-0.00001) / 0.6) × 0.36=0.00600O(H2| S3) = P(H2| S3) / (1 - P(H2| S3))=0.00604(5) 由r4计算O(H2| H1)先把H2的先验概率更新为在H1下的后验概率P(H2| H1)P(H2| H1)=(LS4× P(H2)) / ((LS4-1) × P(H2)+1)=(50 × 0.01) / ((50 -1) × 0.01 +1)=0.33557由于P(H1| S1,S2)=0.35040 > P(H1),使用P(H | S)公式的后半部分,得到在当前观察S1,S2下H2的后验概率P(H2| S1,S2)和后验几率O(H2| S1,S2)P(H2| S1,S2) = P(H2) + ((P(H2| H1) – P(H2)) / (1 - P(H1))) × (P(H1| S1,S2) – P(H1))= 0.01 + (0.33557 –0.01) / (1 – 0.091)) × (0.35040 – 0.091)=0.10291O(H2| S1,S2) = P(H2| S1, S2) / (1 - P(H2| S1, S2))=0.10291/ (1 - 0.10291) = 0.11472(6) 计算O(H2| S1,S2,S3)和P(H2| S1,S2,S3)先将H2的先验概率转换为先验几率O(H2) = P(H2) / (1 - P(H2) )= 0.01 / (1-0.01)=0.01010再根据合成公式计算H1的后验几率O(H2| S1,S2,S3)= (O(H2| S1,S2) / O(H2)) × (O(H2| S3) / O(H2)) ×O(H2)= (0.11472 / 0.01010) × (0.00604) / 0.01010) × 0.01010=0.06832再将该后验几率转换为后验概率P(H2| S1,S2,S3) = O(H1| S1,S2,S3) / (1+ O(H1| S1,S2,S3))= 0.06832 / (1+ 0.06832) = 0.06395可见,H2原来的概率是0.01,经过上述推理后得到的后验概率是0.06395,它相当于先验概率的6倍多。

人工智能课件第5章-不确定性推理

在专家系统中,不确定性表现在证据、规则 和推理三个方面,需要对专家系统中的事实 与规则给出不确定性描述,并在此基础上建 立不确定性的传递计算方法。

要实现对不确定性知识的处理,要解决:

不确定知识的表示问题 不确定信息的计算问题 不确定性表示 计算的语义解释问题

1.表示问题

表示问题指的是采用什么方法描述不确定性, 这是解决不确定性推理的关键一步。通常有数 值表示和非数值的语义表示方法。数值表示便 于计算、比较;非数值表示,是一种定性的描 述,以便较好地解决不确定性问题。

3.语义问题

语义问题指上述表示和计算的含义是什么? 即对它们进行解释。如C(H,E)可理解为当 前提E为真时,对结论H为真的一种影响程 度,C(E)可理解为E为真的程度。

目前,在AI中,处理不确定性问题的主要 数学工具:

概率论 模糊数学

概率论与模糊数学所研究和处理的是两种 不同的不确定性。

第5章 不确定性推理

5.1 概述 5.1.1 知识的不确定性 5.1.2 不确定推理要解决的基本问题 5.1.3 不确定性推理方法分类

5.1 概 述

在确定性推理中,一些结论一定是对的,另一 些结论一定是错的。但在不少推理中,有的结论既 不是一定对,也不是一定错。它们“可以这样,也 可以那样”,具有所谓“不确定性”。

课外思考题:

1.什么是不确定性推理 2. 不确定性推理方法如何分类?

第5章 不确定性推理

5.1 概论 √5.2 主观 Bayes方法

2020/7/8

人工智能 丁世飞

25

5.2 主观 Bayes方法

可用概率方法来表示和处理事件A的确定 性程度。如P(A)表示A发生的可能性大小。

主观Bayes方法是由杜达(R.O.Duda)等人 在1976年在概率论的基础上,通过对 Bayes公式的修正而形成的一种不确定性 推理模型,并成功地应用在他们自己开发 的地矿勘探专家系统PROSPECTOR中。

人工智能第十二讲不确定性推理-可信度方法

基本概念 --不确定性推理方法的分类

? 沿着两条路线发展:一是 模型方法 ,与控制策略 无关;二是控制方法,没有统一模型,依赖于控 制策略。我们只讨论模型方法。

? 例如: IF 发热38 °以上 AND 四肢关节疼痛无力 AND 胸闷咳嗽 THEN 患SARS (0.7) 表示病人如有上述症状则有七成把握认为他患 SARS

可信度方法

--C-F模型

? 定义: CF(H,E) = MB(H,E) -MD(H,E), 其中CF(H,E) ∈[-1,1] MB(Measure Belief )--信任增长度 ,表示因 与E匹配的证据的出现,使 H为真的信任增长度。

不确定性推理

--可信度方法

内容简介

一. 不确定性推理的基本概念与原理 二. 可信度方法的基本模型和三个扩展方法

基本概念

--不确定性推理的定义

? 从不确定性的初始证据出发,通过运用不 确定性的知识,最终推出具有一定程度的 不确定性但却是合理或者近乎合理的结论 的思维过程。

? 事实和知识是构成推理的两个基本要素。 已知事实称为证据(E),用以指出推理 的出发点及推理时应该使用的知识;而知 识是推理得以向前推进,并逐步达到最终 目标(H)的依据。

基本概念

-- 一些基本问题

1. 不确定性的表示与量度

a. 知识不确定性的表示

? 制定表示方法时需要考虑:一是要能根据领域 问题的特征把其不确定性比较准确地描述出来, 满足问题求解的需要;另一是要便于推理过程 中对不确定性的推算。

? 一般由领域专家给出,称为知识的 静态强度 。 静态强度可以是相应知识在应用中成功的概率, 也可以是该条知识的可信程度或其他。

智慧树人工智能基础第三章答案2022

智慧树人工智能基础第三章答案20221、问题:推理的不确定性主要表现在()这几个方面选项:A:问题的不确定性B:事实的不确定性C:规则的不确定性D:推理过程的不确定性答案: 【问题的不确定性】2、问题:不确定性推理的计算问题主要表现在()选项:A:合成结论的不确定性B:组合证据的不确定性计算C:不确定性的匹配及阈值设计D:不确定性的传播答案: 【合成结论的不确定性,组合证据的不确定性计算,不确定性的匹配及阈值设计,不确定性的传播】3、问题:在确定性理论中,知识“如果头痛并且流鼻涕,那么感冒(0.7)”,表示()选项:A:很有可能感冒B:感冒的概率比不感冒概率大70%C:不确定D:不可能感冒答案: 【不可能感冒】4、问题:在证据理论中,样本空间D包括红黄白三种颜色,那么下面选项属于D的幂集的是()选项:A:{黄、白}B:{红、黑}C:{红、白}D:{红,黄}E:{红,黄,黑}F:空集答案: 【{黄、白},{红、白},{红,黄},空集】5、问题:概率分配函数就是对样本空间中的所有子集依次进行概率上的分配,并且总和为1选项:A:错B:对答案: 【错】6、问题:在模糊理论中,隶属度的具体数值是根据经验确定下来的,没有一个确定的标准。

选项:A:对答案: 【对】7、问题:在模糊理论中,论域都是离散的,比如“温度很高”、“温度比较高”等等选项:A:对B:错答案: 【错】8、问题:两个隶属度数值的合取式取最小值,而他们的析取式取最大值。

选项:A:对B:错答案: 【对】9、问题:在模糊逻辑里面,规则和知识是用模糊关系R来表达选项:A:对B:错答案: 【对】10、问题:规则前件的不确定性,主要是由证据的组合到底有多大程度符合前提条件而造成。

选项:A:错答案: 【对】。

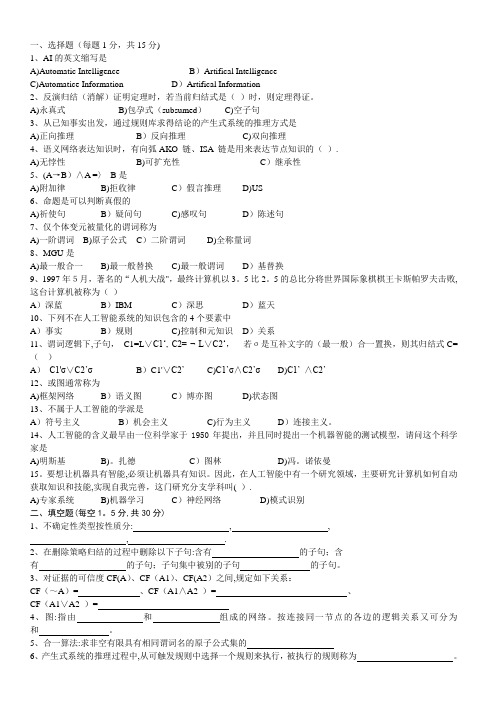

人工智能 经典考试试题及答案

一、选择题(每题1分,共15分)1、AI的英文缩写是A)Automatic Intelligence B)Artifical IntelligenceC)Automatice Information D)Artifical Information2、反演归结(消解)证明定理时,若当前归结式是()时,则定理得证。

A)永真式B)包孕式(subsumed)C)空子句3、从已知事实出发,通过规则库求得结论的产生式系统的推理方式是A)正向推理B)反向推理C)双向推理4、语义网络表达知识时,有向弧AKO 链、ISA 链是用来表达节点知识的().A)无悖性B)可扩充性C)继承性5、(A→B)∧A =〉B是A)附加律B)拒收律C)假言推理D)US6、命题是可以判断真假的A)祈使句B)疑问句C)感叹句D)陈述句7、仅个体变元被量化的谓词称为A)一阶谓词B)原子公式C)二阶谓词D)全称量词8、MGU是A)最一般合一B)最一般替换C)最一般谓词D)基替换9、1997年5月,著名的“人机大战",最终计算机以3。

5比2。

5的总比分将世界国际象棋棋王卡斯帕罗夫击败,这台计算机被称为()A)深蓝B)IBM C)深思D)蓝天10、下列不在人工智能系统的知识包含的4个要素中A)事实B)规则C)控制和元知识D)关系11、谓词逻辑下,子句,C1=L∨C1‘, C2= ¬ L∨C2‘,若σ是互补文字的(最一般)合一置换,则其归结式C=()A)C1'σ∨C2’σB)C1'∨C2’C)C1’σ∧C2’σD)C1’∧C2’12、或图通常称为A)框架网络B)语义图C)博亦图D)状态图13、不属于人工智能的学派是A)符号主义B)机会主义C)行为主义D)连接主义。

14、人工智能的含义最早由一位科学家于1950年提出,并且同时提出一个机器智能的测试模型,请问这个科学家是A)明斯基B)。

扎德C)图林D)冯。

诺依曼15。

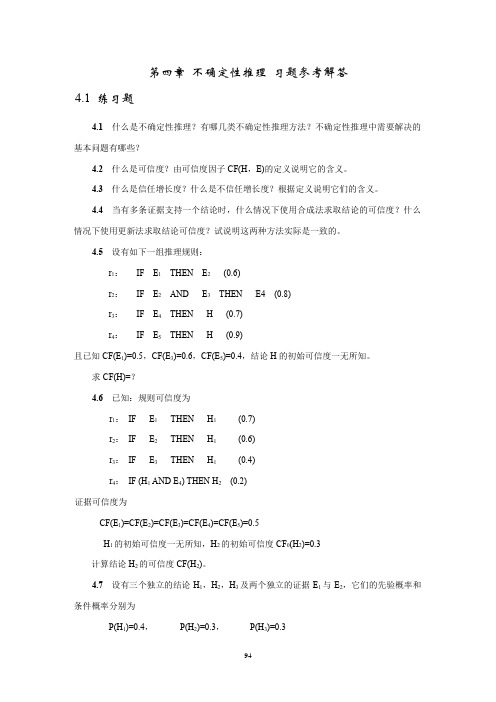

人工智能教程习题及答案第4章习题参考解答

第四章不确定性推理习题参考解答4.1 练习题4.1什么是不确定性推理?有哪几类不确定性推理方法?不确定性推理中需要解决的基本问题有哪些?4.2什么是可信度?由可信度因子CF(H,E)的定义说明它的含义。

4.3什么是信任增长度?什么是不信任增长度?根据定义说明它们的含义。

4.4当有多条证据支持一个结论时,什么情况下使用合成法求取结论的可信度?什么情况下使用更新法求取结论可信度?试说明这两种方法实际是一致的。

4.5设有如下一组推理规则:r1:IF E1THEN E2(0.6)r2:IF E2AND E3THEN E4 (0.8)r3:IF E4THEN H (0.7)r4:IF E5THEN H (0.9)且已知CF(E1)=0.5,CF(E3)=0.6,CF(E5)=0.4,结论H的初始可信度一无所知。

求CF(H)=?4.6已知:规则可信度为r1:IF E1THEN H1(0.7)r2:IF E2THEN H1(0.6)r3:IF E3THEN H1(0.4)r4:IF (H1 AND E4) THEN H2(0.2)证据可信度为CF(E1)=CF(E2)=CF(E3)=CF(E4)=CF(E5)=0.5H1的初始可信度一无所知,H2的初始可信度CF0(H2)=0.3计算结论H2的可信度CF(H2)。

4.7设有三个独立的结论H1,H2,H3及两个独立的证据E1与E2,它们的先验概率和条件概率分别为P(H1)=0.4,P(H2)=0.3,P(H3)=0.3P(E1/H1)=0.5,P(E1/H2)=0.6,P(E1/H3)=0.3P(E2/H1)=0.7,P(E2/H2)=0.9,P(E2/H3)=0.1利用基本Bayes方法分别求出:(1)当只有证据E1出现时,P(H1/E1),P(H2/E1),P(H3/E1)的值各为多少?这说明了什么?(2)当E1和E2同时出现时,P(H1/E1E2),P(H2/E1E2),P(H3/E1E2)的值各是多少?这说明了什么?4.8在主观Bayes方法中,请说明LS与LN的意义。

人工智能导论 第4章 不确定性推理方法(导论) 1-41

CF1(H ) =CF(H , E1)× max{0,CF(E1)} CF2(H ) =CF (H , E2 )× max{0,CF (E2 )}

19

4.2 可信度方法

5. 结论不确定性的合成算法

(2)求出E1与E2对H的综合影响所形成的可信度 CF1,2(H ):

教材:

王万良《人工智能导论》(第4版) 高等教育出版社,2017. 7

第4章 不确定性推理方法

现实世界中由于客观上存在的随机性、模糊性,反 映到知识以及由观察所得到的证据上来,就分别 形 成了不确定性的知识及不确定性的证据。因而 还必 须对不确定性知识的表示及推理进行研究。 这就是 本章将要讨论的不确定性推理。

3

第4章 不确定性推理方法

✓4.1 不确定性推理中的基本问题

4.2 可信度方法 4.3 证据理论 4.4 模糊推理方法

4

4.1 不确定性推理中的基本问题

推理:从已知事实(证据)出发,通过运用相 关 知识逐步推出结论或者证明某个假设成立或 不成 立的思维过程。

不确定性推理:从不确定性的初始证据出发, 通 过运用不确定性的知识,最终推出具有一定 程度 的不确定性但却是合理或者近乎合理的结 论的思 维过程。

r1 : CF1(H ) 0.8 max{0,CF(E1 )}

0.8 max{0,0.35} 0.28

23

4.2 可信度方法

解: 第一步:对每一条规则求出CF(H)。

r2 : CF2 (H ) 0.6 max{0,CF(E2 )}

0.6 max{0,0.8} 0.48

r3 : CF3(H ) 0.5 max{0,CF(E3 )}

4. 不确定性的传递算法

人工智能4不确定性推理

模糊集上的运算主要有:包含、交、并、补等等。

1. 包含运算

定义4.5 设A,B∈F(U),若对任意u∈U,都有

μB(u)≤μA(u) 成立,则称A包含B,记为B A。 2. 交、并、补运算

定义4.6 设A,B∈F(U),以下为扎德算子

A

B : A

B (u)

max{ uU

A

(u

),

B

(u)}

A (u) B (u)

3

模糊集的表示方法(1)

若论域离散且有限,则模糊集A可表示为:

也可写为:

A={μA(u1),μA(u2),…,μA(un)}

或者:

A=μA(u1)/u1+μA(u2)/u2+…+μA(un)/un

n

n

A (u ) / u , 或者A (u ) / u

Ai

i

Ai

i

i 1

i 1

A={μA(u1)/u1,μA(u2)/u2,…,μA(un)/un} A={(μA(u1),u1),(μA(u2),u2),…,(μA(un),un)} 隶属度为0的元素可以不写。

(A, B) 1 [1 (1 0.2)] 0.9 2

即A和B两个模糊集之间的匹配度为0.9。

21

语义距离

如果论域U上两个模糊集A和B的语义距离为d(A,B),则其匹配度为 1-d(A,B)。

曼哈顿距离(Manhattan Distance)或者海明距离(Hamming

Distance)

d (A, B)

A

•

B

{

U

A

(ui

)

B

(ui

)}

A⊙

B

{

人工智能课程习题与部分解答

《人工智能》课程习题与部分解答第1章 绪论什么是人工智能 它的研究目标是什么什么是图灵测试简述图灵测试的基本过程及其重要特征. 在人工智能的发展过程中,有哪些思想和思潮起了重要作用 在人工智能的发展过程中,有哪些思想和思潮起了重要作用人工智能的主要研究和应用领域是什么其中,哪些是新的研究热点第2章 知识表示方法什么是知识分类情况如何什么是知识表示不同的知识表示方法各有什么优缺点 人工智能对知识表示有什么要求 用谓词公式表示下列规则性知识:自然数都是大于零的整数。

任何人都会死的。

[解] 定义谓词如下:N(x): “x 是自然数”, I(x): “x 是整数”, L(x): “x 大于0”, D(x): “x 会死的”, M(x): “x 是人”,则上述知识可用谓词分别表示为: )]()()()[(x I x L x N x ∨→∀ )]()()[(x D x M x →∀用谓词公式表示下列事实性知识:小明是计算机系的学生,但他不喜欢编程。

李晓新比他父亲长得高。

产生式系统由哪几个部分组成 它们各自的作用是什么可以从哪些角度对产生式系统进行分类 阐述各类产生式系统的特点。

简述产生式系统的优缺点。

简述框架表示的基本构成,并给出框架的一般结构 框架表示法有什么特点试构造一个描述你的卧室的框架系统。

试描述一个具体的大学教师的框架系统。

[解] 一个具体大学教师的框架系统为: 框架名:<教师-1> 类属:<大学教师>姓名:张宇 性别:男年龄:32职业:<教师>职称:副教授部门:计算机系研究方向:计算机软件与理论工作:参加时间:2000年7月工龄:当前年份-2000工资:<工资单>把下列命题用一个语义网络表示出来(1)树和草都是植物;(2)树和草都是有根有叶的;(3)水草是草,且生长在水中;(4)果树是树,且会结果;(5)苹果树是果树的一种,它结苹果。

[解]在基于语义网络的推理系统中,一般有几种推理方法,简述它们的推理过程。

《人工智能基础》课后习题及答案

1.什么是智能?智能有什么特征?答:智能可以理解为知识与智力的总和。

其中,知识是一切智能行为的基础,而智力是获取知识并运用知识求解问题的能力,即在任意给定的环境和目标的条件下,正确制订决策和实现目标的能力,它来自于人脑的思维活动。

智能具有下述特征:(1)具有感知能力(系统输入)。

(2)具有记忆与思维的能力。

(3)具有学习及自适应能力。

(4)具有行为能力(系统输出)。

2.人工智能有哪些学派?他们各自核心的观点有哪些?答:根据研究的理论、方法及侧重点的不同,目前人工智能主要有符号主义、联结主义和行为主义三个学派。

符号主义认为知识可用逻辑符号表达,认知过程是符号运算过程。

人和计算机都是物理符号系统,且可以用计算机的符号来模拟人的认知过程。

他们认为人工智能的核心问题是知识表示和知识推理,都可用符号来实现,所有认知活动都基于一个统一的体系结构。

联结主义原理主要是神经网络及神经网络间的连接机制与学习算法。

他们认为人的思维基元是神经元,而不是符号运算。

认为人脑不同于电脑,不能用符号运算来模拟大脑的工作模式。

行为主义原理为控制论及“感知—动作”型控制系统。

该学派认为智能取决于感知和行动,提出智能行为的“感知—动作”模式,他们认为知识不需要表示,不需要推理。

智能研究采用一种可增长的方式,它依赖于通过感知和行动来与外部世界联系和作用。

3.人工智能研究的近期目标和远期目标是什么?它们之间有什么样的关系?答:人工智能的近期目标是实现机器智能,即主要研究如何使现有的计算机更聪明,使它能够运用知识去处理问题,能够模拟人类的智能行为。

人工智能的远期目标是要制造智能机器。

即揭示人类智能的根本机理,用智能机器去模拟、延伸和扩展人类的智能。

人工智能的近期目标与远期目标之间并无严格的界限,二者相辅相成。

远期目标为近期目标指明了方向,近期目标则为远期目标奠定了理论和技术基础。

4.人工智能的研究途径有哪些?答:人工智能的研究途径主要有:(1)心理模拟,符号推演;(2)生理模拟,神经计算;(3)行为模拟,控制进化论。

人工智能导论 第4章 不确定性推理方法(导论)42-76

64

4.4.4 模糊关系与模糊关系的合成

2. 模糊关系的合成

▪ 解:

0.5 0.6 0.3

S

Qo

R

0.7 0

1

0.4 0.8 0.2

1 0

o

0.2 0.8

0.9 0.5

1 0.4 0.3

(0.50.2)(0.6 0.8)(0.30.5)

(0.70.2)(0.4 0.8) (10.5)

AB

ABLeabharlann AB584.4.3 模糊集合的运算

▪ 例4.5 设论域U x1, x2 , x3 , x4 , x5 ,A 及 B 是论域上 的两个模糊集合,已知:

A 0.2 x1 0.4 x 2 0.9 x 3 0.5 x5 B 0.1 x1 0.7 x 3 1.0 x 4 0.3 x5

66

4.4.5 模糊推理

2. 对 IF A THEN B 类型的模糊规则的推理

▪若已知输入为 A,则输出为 B ;若现在已知输入为 A',

则输出 B ' 用合成规则求取 B ' A 'oR

其中模糊关系R: R ( x, y) min[ A ( x), B ( y)]

▪ 控制规则库的N 条规则有N 个模糊关系: R1 , R 2 ,

B B (b1), B (b2

61

4.4.4 模糊关系与模糊关系的合成

1. 模糊关系

▪ 例4.7 已知输入的模糊集合A和输出的模糊集合B:

A 1.0 / a1 0.8 / a2 0.5 / a3 0.2 / a4 0.0 / a5

B 0.7 / b1 1.0 / b2 0.6 / b3 0.0 /b4 ▪ 求A到B的模糊关系R。

人工智能基础(习题卷36)

人工智能基础(习题卷36)第1部分:单项选择题,共50题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]from sklearn import linear_modelreg = linear_sso,其中Lasso 是用来拟合什么样的线性模型的?A)稀疏数据B)稀疏系数C)稀疏标签答案:B解析:2.[单选题]()提供线路重载.过载等运行状态分类查询服务,返回各类运行状态的线路清单。

A)设备状态中心B)电网资源中心C)电网图形中心D)电网拓扑中心答案:A解析:3.[单选题]下列算法中:①K-NN最近邻算法;②线性回归;③逻辑回归,可以用神经网络构建的算法是().A)①②B)②③C)①②③D)以上都不是答案:B解析:KNN是关于距离的学习算法,没有任何参数,所以无法用神经网络构建。

4.[单选题]“检查全部产品合格,则该厂产品合格”。

属于下列哪种推理( )。

A)演绎推理B)归纳推理C)默认推理D)不确定推理答案:B解析:5.[单选题]下列 input() 函数的用法,正确的是?A)a= input(请输入一个整数:,100)B)a= input("请输入一个整数",100)C)a= input(请输入一个整数:)D)a= input("请输入一个整数")答案:D解析:6.[单选题]()模型是一种生成式有向图模型,主要用于处理离散型的数据,在信息检索、自然语言处理等领域有广泛应C)话题模型D)数据模型答案:C解析:7.[单选题]一副灰度分布均匀的图像,灰度范围在[0,255],则该图像像素的存储位数为( )。

A)2B)4C)6D)8答案:D解析:8.[单选题]党中央提出加快数字化发展,推进数字产业化和产业数字化转型,建设()。

A)网络大国B)数字中国C)商品产业链D)电子产品加工链答案:B解析:9.[单选题]RPA 机器人可以执行以下()任务。

A)从文本字段捕获数据B)启动应用程序C)根据预定义规则进行决策D)以上全部答案:D解析:10.[单选题]CNN的基本结构不包括()A)卷积层B)前向池化层C)全连接层D)反向池化层答案:D解析:11.[单选题]以下哪个不属于机器学习主要研究问题()。

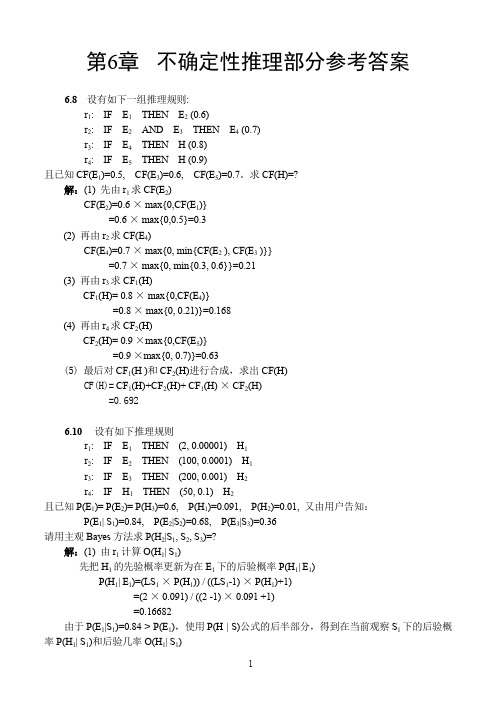

(完整word版)人工智能 第6章 参考答案

第6章不确定性推理部分参考答案6.8 设有如下一组推理规则:r1: IF E1THEN E2 (0.6)r2: IF E2AND E3THEN E4 (0.7)r3: IF E4THEN H (0.8)r4: IF E5THEN H (0.9)且已知CF(E1)=0.5, CF(E3)=0.6, CF(E5)=0.7。

求CF(H)=?解:(1) 先由r1求CF(E2)CF(E2)=0.6 × max{0,CF(E1)}=0.6 × max{0,0.5}=0.3(2) 再由r2求CF(E4)CF(E4)=0.7 × max{0, min{CF(E2 ), CF(E3 )}}=0.7 × max{0, min{0.3, 0.6}}=0.21(3) 再由r3求CF1(H)CF1(H)= 0.8 × max{0,CF(E4)}=0.8 × max{0, 0.21)}=0.168(4) 再由r4求CF2(H)CF2(H)= 0.9 ×max{0,CF(E5)}=0.9 ×max{0, 0.7)}=0.63(5) 最后对CF1(H )和CF2(H)进行合成,求出CF(H)CF(H)= CF1(H)+CF2(H)+ CF1(H) × CF2(H)=0.6926.10 设有如下推理规则r1: IF E1THEN (2, 0.00001) H1r2: IF E2THEN (100, 0.0001) H1r3: IF E3THEN (200, 0.001) H2r4: IF H1THEN (50, 0.1) H2且已知P(E1)= P(E2)= P(H3)=0.6, P(H1)=0.091, P(H2)=0.01, 又由用户告知:P(E1| S1)=0.84, P(E2|S2)=0.68, P(E3|S3)=0.36请用主观Bayes方法求P(H2|S1, S2, S3)=?解:(1) 由r1计算O(H1| S1)先把H1的先验概率更新为在E1下的后验概率P(H1| E1)P(H1| E1)=(LS1× P(H1)) / ((LS1-1) × P(H1)+1)=(2 × 0.091) / ((2 -1) × 0.091 +1)=0.16682由于P(E1|S1)=0.84 > P(E1),使用P(H | S)公式的后半部分,得到在当前观察S1下的后验概率P(H1| S1)和后验几率O(H1| S1)P(H1| S1) = P(H1) + ((P(H1| E1) – P(H1)) / (1 - P(E1))) × (P(E1| S1) – P(E1))= 0.091 + (0.16682 –0.091) / (1 – 0.6)) × (0.84 – 0.6)=0.091 + 0.18955 × 0.24 = 0.136492O(H1| S1) = P(H1| S1) / (1 - P(H1| S1))= 0.15807(2) 由r2计算O(H1| S2)先把H1的先验概率更新为在E2下的后验概率P(H1| E2)P(H1| E2)=(LS2×P(H1)) / ((LS2-1) × P(H1)+1)=(100 × 0.091) / ((100 -1) × 0.091 +1)=0.90918由于P(E2|S2)=0.68 > P(E2),使用P(H | S)公式的后半部分,得到在当前观察S2下的后验概率P(H1| S2)和后验几率O(H1| S2)P(H1| S2) = P(H1) + ((P(H1| E2) – P(H1)) / (1 - P(E2))) × (P(E2| S2) – P(E2))= 0.091 + (0.90918 –0.091) / (1 – 0.6)) × (0.68 – 0.6)=0.25464O(H1| S2) = P(H1| S2) / (1 - P(H1| S2))=0.34163(3) 计算O(H1| S1,S2)和P(H1| S1,S2)先将H1的先验概率转换为先验几率O(H1) = P(H1) / (1 - P(H1)) = 0.091/(1-0.091)=0.10011再根据合成公式计算H1的后验几率O(H1| S1,S2)= (O(H1| S1) / O(H1)) × (O(H1| S2) / O(H1)) × O(H1)= (0.15807 / 0.10011) × (0.34163) / 0.10011) × 0.10011= 0.53942再将该后验几率转换为后验概率P(H1| S1,S2) = O(H1| S1,S2) / (1+ O(H1| S1,S2))= 0.35040(4) 由r3计算O(H2| S3)先把H2的先验概率更新为在E3下的后验概率P(H2| E3)P(H2| E3)=(LS3× P(H2)) / ((LS3-1) × P(H2)+1)=(200 × 0.01) / ((200 -1) × 0.01 +1)=0.09569由于P(E3|S3)=0.36 < P(E3),使用P(H | S)公式的前半部分,得到在当前观察S3下的后验概率P(H2| S3)和后验几率O(H2| S3)P(H2| S3) = P(H2 | ¬ E3) + (P(H2) – P(H2| ¬E3)) / P(E3)) × P(E3| S3)由当E3肯定不存在时有P(H2 | ¬ E3) = LN3× P(H2) / ((LN3-1) × P(H2) +1)= 0.001 × 0.01 / ((0.001 - 1) × 0.01 + 1)= 0.00001因此有P(H2| S3) = P(H2 | ¬ E3) + (P(H2) – P(H2| ¬E3)) / P(E3)) × P(E3| S3)=0.00001+((0.01-0.00001) / 0.6) × 0.36=0.00600O(H2| S3) = P(H2| S3) / (1 - P(H2| S3))=0.00604(5) 由r4计算O(H2| H1)先把H2的先验概率更新为在H1下的后验概率P(H2| H1)P(H2| H1)=(LS4× P(H2)) / ((LS4-1) × P(H2)+1)=(50 × 0.01) / ((50 -1) × 0.01 +1)=0.33557由于P(H1| S1,S2)=0.35040 > P(H1),使用P(H | S)公式的后半部分,得到在当前观察S1,S2下H2的后验概率P(H2| S1,S2)和后验几率O(H2| S1,S2)P(H2| S1,S2) = P(H2) + ((P(H2| H1) – P(H2)) / (1 - P(H1))) × (P(H1| S1,S2) – P(H1))= 0.01 + (0.33557 –0.01) / (1 – 0.091)) × (0.35040 – 0.091)=0.10291O(H2| S1,S2) = P(H2| S1, S2) / (1 - P(H2| S1, S2))=0.10291/ (1 - 0.10291) = 0.11472(6) 计算O(H2| S1,S2,S3)和P(H2| S1,S2,S3)先将H2的先验概率转换为先验几率O(H2) = P(H2) / (1 - P(H2) )= 0.01 / (1-0.01)=0.01010再根据合成公式计算H1的后验几率O(H2| S1,S2,S3)= (O(H2| S1,S2) / O(H2)) × (O(H2| S3) / O(H2)) ×O(H2)= (0.11472 / 0.01010) × (0.00604) / 0.01010) × 0.01010=0.06832再将该后验几率转换为后验概率P(H2| S1,S2,S3) = O(H1| S1,S2,S3) / (1+ O(H1| S1,S2,S3))= 0.06832 / (1+ 0.06832) = 0.06395可见,H2原来的概率是0.01,经过上述推理后得到的后验概率是0.06395,它相当于先验概率的6倍多。

人工智能不确定性推理

1 min{P( H | E ), P( H )} P( H ) MD( H , E ) P( H )

29

规则的不确定性

MB:称为信任增长度,它表示因与前提条件 E 匹 配的证据的出现,使结论H为真的信任增长度. MD:称为不信任增长度,它表示因与前提条件E 匹配的证据的出现,使结论H为真的不信任增长度.

2

不确定性(狭义)

不确定性(uncertainty)就是一个命题(亦即 所表示的事件)的真实性不能完全肯定, 而只能对其为真的可能性给出某种估计。 例 如果乌云密布\电闪雷鸣,则可能要下暴雨。 如果头痛发烧,则大概是患了感冒。

3

不确切性(模糊性) 不确切性(imprecision)就是一个命题中所出现的 某些言词其涵义不够确切,从概念角度讲,也就是其 代表的概念的内涵没有硬性的标准或条件,其外延没 有硬性的边界,即边界是软的或者说是不明确的。 例 小王是个高个子。

30

不确定性的组合

●

在环境E ' 下,若两个证据的合取或析取支持结 论H,则可表示为

证据的不确定性组合定义为 CF(E1∧E2, E ' ) = min[CF(E1, E ' ), CF(E2, E ' )] CF(E1∨E2, E ' ) = max[CF(E1, E ' ), CF(E2, E ' )] 当两条规则支持同一结论H时,可表示为

28

确定因子法

⑴ 知识的不确定性表示 MYCIN系统称规则强度为规则确定性因子(Certainty Factor) CF(H,E),它表示在已知证据的情况下,对假设的确信程度。 CF(H,E)定义如下: CF ( H , E ) MB( H , E ) MD( H , E )

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

不确定性推理部分参考答案1.设有如下一组推理规则:r1: IF E1THEN E2 (0.6)r2: IF E2AND E3THEN E4 (0.7)r3: IF E4THEN H (0.8)r4: IF E5THEN H (0.9)且已知CF(E1)=0.5, CF(E3)=0.6, CF(E5)=0.7。

求CF(H)=?解:(1) 先由r1求CF(E2)CF(E2)=0.6 × max{0,CF(E1)}=0.6 × max{0,0.5}=0.3(2) 再由r2求CF(E4)CF(E4)=0.7 × max{0, min{CF(E2 ), CF(E3 )}}=0.7 × max{0, min{0.3, 0.6}}=0.21(3) 再由r3求CF1(H)CF1(H)= 0.8 × max{0,CF(E4)}=0.8 × max{0, 0.21)}=0.168(4) 再由r4求CF2(H)CF2(H)= 0.9 ×max{0,CF(E5)}=0.9 ×max{0, 0.7)}=0.63(5) 最后对CF1(H )和CF2(H)进行合成,求出CF(H)CF(H)= CF1(H)+CF2(H)+ CF1(H) × CF2(H)=0.6922 设有如下推理规则r1: IF E1THEN (2, 0.00001) H1r2: IF E2THEN (100, 0.0001) H1r3: IF E3THEN (200, 0.001) H2r4: IF H1THEN (50, 0.1) H2且已知P(E1)= P(E2)= P(H3)=0.6, P(H1)=0.091, P(H2)=0.01, 又由用户告知:P(E1| S1)=0.84, P(E2|S2)=0.68, P(E3|S3)=0.36请用主观Bayes方法求P(H2|S1, S2, S3)=?解:(1) 由r1计算O(H1| S1)先把H1的先验概率更新为在E1下的后验概率P(H1| E1)P(H1| E1)=(LS1× P(H1)) / ((LS1-1) × P(H1)+1)=(2 × 0.091) / ((2 -1) × 0.091 +1)=0.16682由于P(E1|S1)=0.84 > P(E1),使用P(H | S)公式的后半部分,得到在当前观察S1下的后验概率P(H1| S1)和后验几率O(H1| S1)P(H1| S1) = P(H1) + ((P(H1| E1) – P(H1)) / (1 - P(E1))) × (P(E1| S1) – P(E1))= 0.091 + (0.16682 –0.091) / (1 – 0.6)) × (0.84 – 0.6)=0.091 + 0.18955 × 0.24 = 0.136492O(H1| S1) = P(H1| S1) / (1 - P(H1| S1))= 0.15807(2) 由r2计算O(H1| S2)先把H1的先验概率更新为在E2下的后验概率P(H1| E2)P(H1| E2)=(LS2×P(H1)) / ((LS2-1) × P(H1)+1)=(100 × 0.091) / ((100 -1) × 0.091 +1)=0.90918由于P(E2|S2)=0.68 > P(E2),使用P(H | S)公式的后半部分,得到在当前观察S2下的后验概率P(H1| S2)和后验几率O(H1| S2)P(H1| S2) = P(H1) + ((P(H1| E2) – P(H1)) / (1 - P(E2))) × (P(E2| S2) – P(E2))= 0.091 + (0.90918 –0.091) / (1 – 0.6)) × (0.68 – 0.6)=0.25464O(H1| S2) = P(H1| S2) / (1 - P(H1| S2))=0.34163(3) 计算O(H1| S1,S2)和P(H1| S1,S2)先将H1的先验概率转换为先验几率O(H1) = P(H1) / (1 - P(H1)) = 0.091/(1-0.091)=0.10011再根据合成公式计算H1的后验几率O(H1| S1,S2)= (O(H1| S1) / O(H1)) × (O(H1| S2) / O(H1)) × O(H1)= (0.15807 / 0.10011) × (0.34163) / 0.10011) × 0.10011= 0.53942再将该后验几率转换为后验概率P(H1| S1,S2) = O(H1| S1,S2) / (1+ O(H1| S1,S2))= 0.35040(4) 由r3计算O(H2| S3)先把H2的先验概率更新为在E3下的后验概率P(H2| E3)P(H2| E3)=(LS3× P(H2)) / ((LS3-1) × P(H2)+1)=(200 × 0.01) / ((200 -1) × 0.01 +1)=0.09569由于P(E3|S3)=0.36 < P(E3),使用P(H | S)公式的前半部分,得到在当前观察S3下的后验概率P(H2| S3)和后验几率O(H2| S3)P(H2| S3) = P(H2 | ¬ E3) + (P(H2) – P(H2| ¬E3)) / P(E3)) × P(E3| S3)由当E3肯定不存在时有P(H2 | ¬ E3) = LN3× P(H2) / ((LN3-1) × P(H2) +1)= 0.001 × 0.01 / ((0.001 - 1) × 0.01 + 1)= 0.00001因此有P(H2| S3) = P(H2 | ¬ E3) + (P(H2) – P(H2| ¬E3)) / P(E3)) × P(E3| S3)=0.00001+((0.01-0.00001) / 0.6) × 0.36=0.00600O(H2| S3) = P(H2| S3) / (1 - P(H2| S3))=0.00604(5) 由r4计算O(H2| H1)先把H2的先验概率更新为在H1下的后验概率P(H2| H1)P(H2| H1)=(LS4× P(H2)) / ((LS4-1) × P(H2)+1)=(50 × 0.01) / ((50 -1) × 0.01 +1)=0.33557由于P(H1| S1,S2)=0.35040 > P(H1),使用P(H | S)公式的后半部分,得到在当前观察S1,S2下H2的后验概率P(H2| S1,S2)和后验几率O(H2| S1,S2)P(H2| S1,S2) = P(H2) + ((P(H2| H1) – P(H2)) / (1 - P(H1))) × (P(H1| S1,S2) – P(H1))= 0.01 + (0.33557 –0.01) / (1 – 0.091)) × (0.35040 – 0.091)=0.10291O(H2| S1,S2) = P(H2| S1, S2) / (1 - P(H2| S1, S2))=0.10291/ (1 - 0.10291) = 0.11472(6) 计算O(H2| S1,S2,S3)和P(H2| S1,S2,S3)先将H2的先验概率转换为先验几率O(H2) = P(H2) / (1 - P(H2) )= 0.01 / (1-0.01)=0.01010再根据合成公式计算H1的后验几率O(H2| S1,S2,S3)= (O(H2| S1,S2) / O(H2)) × (O(H2| S3) / O(H2)) ×O(H2)= (0.11472 / 0.01010) × (0.00604) / 0.01010) × 0.01010=0.06832再将该后验几率转换为后验概率P(H2| S1,S2,S3) = O(H1| S1,S2,S3) / (1+ O(H1| S1,S2,S3))= 0.06832 / (1+ 0.06832) = 0.06395可见,H2原来的概率是0.01,经过上述推理后得到的后验概率是0.06395,它相当于先验概率的6倍多。

3 设有如下推理规则r1:IF E1THEN (100, 0.1) H1r2: IF E2THEN (50, 0.5) H2r3: IF E3THEN (5, 0.05) H3且已知P(H1)=0.02, P(H2)=0.2, P(H3)=0.4,请计算当证据E1,E2,E3存在或不存在时P(H i | E i)或P(H i |﹁E i)的值各是多少(i=1, 2, 3)?解:(1) 当E1、E2、E3肯定存在时,根据r1、r2、r3有P(H1 | E1) = (LS1× P(H1)) / ((LS1-1) × P(H1)+1)= (100 × 0.02) / ((100 -1) × 0.02 +1)=0.671P(H2 | E2) = (LS2× P(H2)) / ((LS2-1) × P(H2)+1)= (50 × 0.2) / ((50 -1) × 0.2 +1)=0.9921P(H3 | E3) = (LS3× P(H3)) / ((LS3-1) × P(H3)+1)= (5 × 0.4) / ((5 -1) × 0.4 +1)=0.769(2) 当E1、E2、E3肯定存在时,根据r1、r2、r3有P(H1 | ¬E1) = (LN1× P(H1)) / ((LN1-1) × P(H1)+1)= (0.1 × 0.02) / ((0.1 -1) × 0.02 +1)=0.002P(H2 | ¬E2) = (LN2× P(H2)) / ((LN2-1) × P(H2)+1)= (0.5 × 0.2) / ((0.5 -1) × 0.2 +1)=0.111P(H3 | ¬E3) = (LN3× P(H3)) / ((LN3-1) × P(H3)+1)= (0.05 × 0.4) / ((0.05 -1) × 0.4 +1)=0.032。