中国科学院大学机器学习——boosting

集成学习Boosting算法综述

集成学习Boosting算法综述一、本文概述本文旨在全面综述集成学习中的Boosting算法,探讨其发展历程、基本原理、主要特点以及在各个领域的应用现状。

Boosting算法作为集成学习中的一类重要方法,通过迭代地调整训练数据的权重或分布,将多个弱学习器集合成一个强学习器,从而提高预测精度和泛化能力。

本文将从Boosting算法的基本概念出发,详细介绍其发展历程中的代表性算法,如AdaBoost、GBDT、GBoost等,并探讨它们在分类、回归等任务中的性能表现。

本文还将对Boosting算法在各个领域的应用进行综述,以期为读者提供全面、深入的Boosting 算法理解和应用参考。

二、Boosting算法概述Boosting算法是一种集成学习技术,其核心思想是将多个弱学习器(weak learner)通过某种策略进行组合,从而形成一个强学习器(strong learner)。

Boosting算法的主要目标是提高学习算法的精度和鲁棒性。

在Boosting过程中,每个弱学习器都针对前一个学习器错误分类的样本进行重点关注,从而逐步改善分类效果。

Boosting算法的基本流程如下:对训练集进行初始化权重分配,使得每个样本的权重相等。

然后,使用带权重的训练集训练一个弱学习器,并根据其分类效果调整样本权重,使得错误分类的样本权重增加,正确分类的样本权重减少。

接下来,使用调整后的权重训练下一个弱学习器,并重复上述过程,直到达到预定的弱学习器数量或满足其他停止条件。

将所有弱学习器进行加权组合,形成一个强学习器,用于对新样本进行分类或预测。

Boosting算法有多种变体,其中最具代表性的是AdaBoost算法。

AdaBoost算法采用指数损失函数作为优化目标,通过迭代地训练弱学习器并更新样本权重,逐步提高分类精度。

还有GBDT(Gradient Boosting Decision Tree)、GBoost、LightGBM等基于决策树的Boosting算法,它们在处理大规模数据集和高维特征时表现出良好的性能。

机器学习基础—集成学习Bagging和Boosting

机器学习基础—集成学习Bagging和Boosting集成学习就是不断的通过数据⼦集形成新的规则,然后将这些规则合并。

bagging和boosting都属于集成学习。

集成学习的核⼼思想是通过训练形成多个分类器,然后将这些分类器进⾏组合。

所以归结为(1)训练样本数据如何选取?(2)分类器如何合并?⼀、baggingbagging 通过将全部数据集中均匀随机有放回的挑选部分数据,然后利⽤挑选出的数据训练模型,然后再随机挑选部分数据训练⼀个新的模型,经过多次选择,形成多个模型,把每⼀个模型的值加权取平均就是bagging。

所以baging (1)样本数据均匀随机有放回的选取。

(2)分类器取均值。

左边这幅图,随机有放回的取5个数据,取五次,⽤三阶多项式拟合出5条曲线,看以看出这五条曲线基本上符合图像上点的⾛势。

右边这幅图红⾊的曲线是⽤bagging实现的,蓝⾊的曲线是⽤四阶多项式实现的。

在训练集上蓝⾊的拟合度优于红⾊,但是在测试集上红⾊要由于蓝⾊。

可以看出baggin⽅法有很强的泛化能⼒。

⼆、boostingboosting 不再均匀随机的挑选数据了,⽽是把重点放在那些不易进⾏分类的数据上或者是分错的数据上,增加分错样本的权值,然后再进⾏训练,经过多次样本数据选择,哪些最难分类的权值会不断增⼤,直到被分类正确。

将形成的多个分类器进⾏投票,分类类别选择票数最多的那个。

boosting (1)调整权值,选择分错的样本。

(2)分类器合并采取投票的⽅式。

要理解boosting中如何增加分错样本的权重必须了解“误差”的概念。

误差:在已知样本分布的情况下,某⼀个样本x上的假设和真实值间不⼀致的概率。

如上⾯这幅图,有四个点,分别出现的频率是1/2,1/20,4/10,1/20,所以由上⾯误差的概念,分错的概率为1/10。

所以样本出现的频率会影响误差,也就是样本的分布会随着权值的变化⽽变化。

相⽐我们已经分对的样本,分错的样本获得正确结果的概率就越⾼。

【机器学习】Jackknife,Bootstraping,bagging,boosting。。。

【机器学习】Jackknife,Bootstraping,bagging,boosting。

Jackknife,Bootstraping, bagging, boosting, AdaBoosting, Rand forest 和 gradient boosting这些术语,我经常搞混淆,现在把它们放在⼀起,以⽰区别。

(部分⽂字来⾃⽹络,由于是之前记的笔记,忘记来源了,特此向作者抱歉)Bootstraping: 名字来⾃成语“pull up by your own bootstraps”,意思是依靠你⾃⼰的资源,称为⾃助法,它是⼀种有放回的抽样⽅法,它是⾮参数统计中⼀种重要的估计统计量⽅差进⽽进⾏区间估计的统计⽅法。

其核⼼思想和基本步骤如下: (1)采⽤重抽样技术从原始样本中抽取⼀定数量(⾃⼰给定)的样本,此过程允许重复抽样。

(2)根据抽出的样本计算给定的统计量T。

(3)重复上述N次(⼀般⼤于1000),得到N个统计量T。

(4)计算上述N个统计量T的样本⽅差,得到统计量的⽅差。

应该说Bootstrap是现代统计学较为流⾏的⼀种统计⽅法,在⼩样本时效果很好。

通过⽅差的估计可以构造置信区间等,其运⽤范围得到进⼀步延伸。

Jackknife:和上⾯要介绍的Bootstrap功能类似,只是有⼀点细节不⼀样,即每次从样本中抽样时候只是去除⼏个样本(⽽不是抽样),就像⼩⼑⼀样割去⼀部分。

(pku, sewm,shinningmonster.)============================================================================================================================下列⽅法都是上述Bootstraping思想的⼀种应⽤。

bagging:bootstrap aggregating的缩写。

第13章-boosting算法--机器学习与应用第二版

1 et exp t et exp t

2

et 1 et

1

4

2 t

在这里利用了错误率 et 以及弱分类器权重 t 的定义。由于在上一轮迭代时权重是归一

化的,因此有

l

l

l

wt1 i

wt 1 i

wt 1 i

1

i1, yi ft xi

i1, yi ft xi

i 1

根据错误率的定义

et

在这里使用了指数损失函数。如果标签值与强分类器的预测值越接近,损失函数的值越 小,反之越大。使用指数损失函数而不用均方误差损失函数的原因是均方误差损失函数对分 类问题的效果并不好。将广义加法模型的预测函数代入上面的损失函数中,得到算法训练时 要优化的目标函数为

l

j , f j arg min ,f exp yi Fj 1 xi f xi i 1

T

T

T

Zt 2 et 1 et

t 1

t 1

t 1

1 4t2

exp

2

T t 1

t2

其中

t

1 2

et

根据错误率和弱分类器权重的计算公式有

l

Zt wit1 exp yit ft xi

i 1

l

l

wit1 exp t

wt 1 i

exp

t

i1, yi ft xi

i1, yi ft xi

表 13.1 随机森林与 AdaBoost 算法的比较

随机森林

AdaBoost

决策树规模

大

小

是否对样本进行随机采样

是

否

是否对特征进行随机采样

是

否

集成学习之Boosting——GradientBoosting原理

集成学习之Boosting——GradientBoosting原理集成学习之Boosting —— Gradient Boosting原理上⼀篇介绍了AdaBoost算法,AdaBoost每⼀轮基学习器训练过后都会更新样本权重,再训练下⼀个学习器,最后将所有的基学习器加权组合。

AdaBoost使⽤的是指数损失,这个损失函数的缺点是对于异常点⾮常敏感,(关于各种损失函数可见之前的⽂章:),因⽽通常在噪⾳⽐较多的数据集上表现不佳。

Gradient Boosting在这⽅⾯进⾏了改进,使得可以使⽤任何损失函数 (只要损失函数是连续可导的),这样⼀些⽐较robust的损失函数就能得以应⽤,使模型抗噪⾳能⼒更强。

Boosting的基本思想是通过某种⽅式使得每⼀轮基学习器在训练过程中更加关注上⼀轮学习错误的样本,区别在于是采⽤何种⽅式?AdaBoost采⽤的是增加上⼀轮学习错误样本的权重的策略,⽽在Gradient Boosting中则将负梯度作为上⼀轮基学习器犯错的衡量指标,在下⼀轮学习中通过拟合负梯度来纠正上⼀轮犯的错误。

这⾥的关键问题是:为什么通过拟合负梯度就能纠正上⼀轮的错误了?Gradient Boosting的发明者给出的答案是:函数空间的梯度下降。

函数空间的的梯度下降这⾥⾸先回顾⼀下梯度下降 (Gradient Descend)。

机器学习的⼀⼤主要步骤是通过优化⽅法最⼩化损失函数L(θ),进⽽求出对应的参数θ。

梯度下降是经典的数值优化⽅法,其参数更新公式:θ=θ−α⋅∂∂θL(θ)Gradient Boosting 采⽤和AdaBoost同样的加法模型,在第m次迭代中,前m-1个基学习器都是固定的,即f m(x)=f m−1(x)+ρm h m(x)因⽽在第m步我们的⽬标是最⼩化损失函数L(f)=N∑i=1L(y i,f m(x i)),进⽽求得相应的基学习器。

若将f(x)当成参数,则同样可以使⽤梯度下降法:f m(x)=f m−1(x)−ρm⋅∂∂f m−1(x)L(y,f m−1(x))对⽐式 (1.2)和 (1.3),可以发现若将h m(x)≈−∂L(y,f m−1(x))∂f m−1(x),即⽤基学习器h m(x)拟合前⼀轮模型损失函数的负梯度,就是通过梯度下降法最⼩化L(f) 。

中科院机器学习题库-new

机器学习题库一、 极大似然1、 ML estimation of exponential model (10)A Gaussian distribution is often used to model data on the real line, but is sometimesinappropriate when the data are often close to zero but constrained to be nonnegative. In such cases one can fit an exponential distribution, whose probability density function is given by()1xb p x e b-=Given N observations x i drawn from such a distribution:(a) Write down the likelihood as a function of the scale parameter b.(b) Write down the derivative of the log likelihood.(c) Give a simple expression for the ML estimate for b.2、换成Poisson 分布:()|,0,1,2,...!x e p x y x θθθ-==()()()()()1111log |log log !log log !N Ni i i i N N i i i i l p x x x x N x θθθθθθ======--⎡⎤=--⎢⎥⎣⎦∑∑∑∑3、二、 贝叶斯假设在考试的多项选择中,考生知道正确答案的概率为p ,猜测答案的概率为1-p ,并且假设考生知道正确答案答对题的概率为1,猜中正确答案的概率为1,其中m 为多选项的数目。

boosting算法原理

boosting算法原理Boosting算法是一种非常常用的机器学习算法,被广泛应用于分类、回归等领域。

它的原理是将若干个弱分类器(weak classifier)通过加权平均的方式组合成一个强分类器(strong classifier),以提高分类的准确率。

下面,我们将介绍Boosting算法的原理和实现方法。

一、原理Boosting算法的核心思想是以一种特殊的方式组合弱分类器,每个弱分类器只能做出比随机猜测稍微好一点的决策。

Boosting将它们组合起来,变成一个强分类器。

具体实现的过程如下:1. 给每个样本赋一个权重值,初始化为1/n,其中n为样本数目。

2. 针对每个样本训练一个弱分类器,例如决策树。

3. 对每个弱分类器计算出它们的误差率,即错误分类样本的权重和。

4. 更新每个样本的权重,在每轮训练中,分类错误的样本会获得更高的权重值。

5. 将所有的弱分类器按照误差率给出权重。

6. 以各个弱分类器的权重作为权重进行加权平均,得到最终的分类器。

二、实现Boosting算法有多种实现方式,其中比较常用的是Adaboost算法,它是一种迭代算法,通过调整样本权重和弱分类器权重实现分类器的训练。

具体实现步骤如下:1. 给每个样本赋一个权重值,初始化为1/n,其中n为样本数目。

2. 针对每个样本训练一个弱分类器,例如决策树。

3. 对每个弱分类器计算出它们的误差率,即错误分类样本的权重和。

4. 计算每个弱分类器的权重,并更新样本的权重,增加分类错误的样本的权重,减少分类正确的样本的权重。

5. 重复上述步骤,直至满足条件为止(例如:弱分类器的数目、误差率等)。

6. 将所有的弱分类器按照误差率给出权重。

7. 以各个弱分类器的权重作为权重进行加权平均,得到最终的分类器。

三、总结在使用Boosting算法时,需要注意选择合适的弱分类器。

这里我们以决策树为例,在实际应用中,我们可以采用其他的算法,如神经网络等。

中科院研究生院机器学习试卷 含答案

中国科学院研究生院课程编号:712008Z 试 题 专 用 纸 课程名称:机器学习任课教师:卿来云———————————————————————————————————————————————姓名学号 成绩1. 判断题(20分,每小题2分)(1)给定n 个数据点,如果其中一半用于训练,另一半用于测试,则训练误差和测试误差之间的差别会随着n 的增加而减小。

(T )(2)当训练数据较少时更容易发生过拟合。

(T ) (3)回归函数A 和B ,如果A 比B 更简单,则A 几乎一定会比B 在测试集上表现更好。

(F ) (4)在核回归中,最影响回归的过拟合性和欠拟合之间平衡的参数为核函数的宽度。

(T ) (5)在AdaBoost 算法中,所有被错分的样本的权重更新比例相同。

(T ) (6)Boosting 的一个优点是不会过拟合。

(F )(7)梯度下降有时会陷于局部极小值,但EM 算法不会。

(F ) (8)SVM 对噪声(如来自其他分布的噪声样本)鲁棒。

(F )(9)Boosting 和Bagging 都是组合多个分类器投票的方法,二者都是根据单个分类器的正确率决定其权重。

(F ) (10)在回归分析中,最佳子集选择可以做特征选择,当特征数目较多时计算量大;岭回归和Lasso 模型计算量小,且Lasso 也可以实现特征选择。

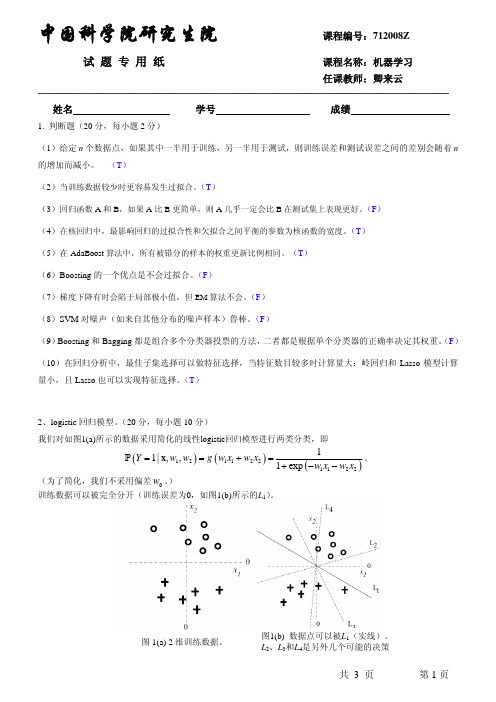

(T )2、logistic 回归模型。

(20分,每小题10分)我们对如图1(a)所示的数据采用简化的线性logistic 回归模型进行两类分类,即()()()121122112211|,,1exp Y w w g w x w x w x w x ==+=+−−x P 。

(为了简化,我们不采用偏差0w 。

) 训练数据可以被完全分开(训练误差为0,如图1(b)所示的L 1)。

共 3 页 第1页图1(a) 2维训练数据。

图1(b) 数据点可以被L 1(实线)。

L 2、L 3和L 4是另外几个可能的决策(1) 考虑一个正则化的方法,即最大化()21221log |,,2Ni i i C y w w w =−∑x P 。

Boosting

有放回抽样

有放回抽样

分类器

VS 统计量

Bootstrapping VS Bagging 等权投票 VS 平均

投票结果 VS 统计量方差

Bagging方法的主要过程

(分类结果)

i) 重复地从一个样本集合中,抽样n* < N 个样本,针对抽样的集合训练分类器Ci

ii) 分类器进行等权投票

Page 7

Page 8

1.1 概述

1989年,Yoav Freund与 Robert Schapire提出了一种可行的将弱分类器 组合为强分类器的方法,即Boosting算法。并由此而获得了2003年的哥德 尔奖(Godel Price) - 颁给理论计算机科学领域中优秀论文的作者。

到了1995年,Freund要框 架可以描述为: i) 循环迭代多次 更新样本分布 寻找当前分布下的最优弱分类器 计算弱分类器误差率 ii) 聚合多次训练的弱分类器

Final rule: Sign[a1 h1 + a2 h2 +

h2 hh3h4h5h6h7h8h9T

+ aThT

]

Page 22

1.1 源起

1.1.5 Boosting

Bagging与Boosting的区别:二者的主要区别是取样方式不同。 Bagging采用均匀取样,而Boosting根据错误率来取样,因此 Boosting的分类精度要优于Bagging。Bagging的训练集的选择是随 机的,各轮训练集之间相互独立,而Boosting的各轮训练集的选择与 前面各轮的学习结果有关;Bagging的各个预测函数没有权重,而 Boosting是有权重的;Bagging的各个预测函数可以并行生成,而 Boosting的各个预测函数只能顺序生成。对于像神经网络这样极为耗 时的学习方法,Bagging可通过并行训练节省大量时间开销。

集成学习Boosting算法综述

集成学习Boosting算法综述集成学习是当前机器学习领域的一个重要研究方向,而Boosting算法则是集成学习中一类重要的方法。

Boosting算法的主要思想是通过多个弱学习器的组合来提高预测精度和稳定性,从而更好地解决分类和回归问题。

在本篇文章中,我们将对Boosting算法进行综述,介绍其基本理论、应用领域、评价与展望,以及未来的发展趋势。

Boosting算法的基本理论可以追溯到1990年代,当时一些学者发现将多个弱学习器组合起来可以显著提高预测精度。

Boosting算法基于这一思想,通过迭代地训练弱学习器和调整其权重,使得整个集成学习器的性能优于单个学习器。

Boosting算法的优化思想主要是通过调整样本数据的权重分布,使得每个弱学习器都能够专注于之前学习器难以处理的样本,从而降低错误率。

在模型建立方面,Boosting 算法通常采用基于决策树的弱学习器,但也可以使用其他类型的弱学习器。

Boosting算法在机器学习、数据挖掘和自然语言处理等领域都有广泛的应用。

在机器学习领域,Boosting算法被广泛应用于图像分类、语音识别、自然语言处理等任务。

例如,AdaBoost算法被用于人脸检测和识别,以及文本分类任务中。

在数据挖掘领域,Boosting算法被应用于关联规则挖掘、聚类分析等任务,如Adaboost.M1算法被用于挖掘频繁项集。

在自然语言处理领域,Boosting算法被应用于词性标注、命名实体识别等任务,如朴素贝叶斯分类器被作为弱学习器,通过Boosting算法提高其性能。

对于Boosting算法的评价,我们可以看到其具有以下优点:提高预测精度:通过多个弱学习器的组合,Boosting算法能够降低错误率,提高预测精度。

稳定性高:Boosting算法对数据集的初始分布和噪声干扰不敏感,具有较好的稳定性。

容易实现:Boosting算法的实现比较简单,可以方便地与其他机器学习算法进行结合。

Boosting算法简介

Boosting算法简介分类:机器学习2012-01-06 10:48 1044人阅读评论(1) 收藏举报算法框架任务测试c网络一、Boosting算法的发展历史Boosting算法是一种把若干个分类器整合为一个分类器的方法,在boosting算法产生之前,还出现过两种比较重要的将多个分类器整合为一个分类器的方法,即boostrapping 方法和bagging方法。

我们先简要介绍一下bootstrapping方法和bagging方法。

1)bootstrapping方法的主要过程主要步骤:i)重复地从一个样本集合D中采样n个样本ii)针对每次采样的子样本集,进行统计学习,获得假设H iiii)将若干个假设进行组合,形成最终的假设H f inaliv)将最终的假设用于具体的分类任务2)bagging方法的主要过程主要思路:i)训练分类器从整体样本集合中,抽样n* < N个样本针对抽样的集合训练分类器C iii)分类器进行投票,最终的结果是分类器投票的优胜结果但是,上述这两种方法,都只是将分类器进行简单的组合,实际上,并没有发挥出分类器组合的威力来。

直到1989年,Yoav Freund与Robert Schapire提出了一种可行的将弱分类器组合为强分类器的方法。

并由此而获得了2003年的哥德尔奖(Godel price)。

Schapire还提出了一种早期的boosting算法,其主要过程如下:i)从样本整体集合D中,不放回的随机抽样n1 < n个样本,得到集合D1训练弱分类器C1ii)从样本整体集合D中,抽取n2 < n个样本,其中合并进一半被C1分类错误的样本。

得到样本集合D2训练弱分类器C2iii)抽取D样本集合中,C1和C2分类不一致样本,组成D3训练弱分类器C3iv)用三个分类器做投票,得到最后分类结果到了1995年,Freund and schapire提出了现在的adaboost算法,其主要框架可以描述为:i)循环迭代多次更新样本分布寻找当前分布下的最优弱分类器计算弱分类器误差率ii)聚合多次训练的弱分类器在下图中可以看到完整的adaboost算法:图1.1 adaboost算法过程现在,boost算法有了很大的发展,出现了很多的其他boost算法,例如:logitboost 算法,gentleboost算法等等。

基于Boosting学习算法的雷达弹道识别

第 30Journal of Projectiles,Rockets,M issiles and Guidance

Boosting算法理论与应用研究

Boosting算法理论与应用研究张文生;于廷照【期刊名称】《中国科学技术大学学报》【年(卷),期】2016(046)003【摘要】作为机器学习领域最经典算法之一,Boosting是一种学习算法,并广泛应用于机器学习与模式识别各领域.Boosting的理论研究分为可学习理论和统计学两个角度.Boosting最初从弱可学习理论角度阐明了由弱到强的提升算法,从理论上证明了一组优于随机猜测的弱学习器通过集成可提升为在训练集上任意精度的强学习器.从统计学的角度看,Boosting是一种叠加模型,理论上二者的等价性已经证明.本文首先从可学习的角度出发,回顾了Boosting算法弱可学习理论,并提出面临的问题及挑战,包括对高维数据的有效性及Margin理论;然后阐述了Boosting算法理论研究分支,并详细回顾了当前最为流行的多种经典Boosting算法及在Boosting 理论框架下的新应用;最后探讨了Boosting算法的未来研究趋势.【总页数】9页(P222-230)【作者】张文生;于廷照【作者单位】中科院自动化所,北京100190;中科院自动化所,北京100190【正文语种】中文【中图分类】TP18【相关文献】1.理论与应用研究浑然融通的一部佳作--读于全有教授《语言理论与应用研究》[J], 曹敏;杨文全2.多分类研究中的boosting算法 [J], 张圆圆;侯艳;李康3.基于boosting算法的中文情感分类研究 [J], 黄彬;4.大数据背景下基本医疗保险公平性评价\r——基于boosting算法的实证研究[J], 李胜会;张子璇;徐贝尔5.基于改进的Boosting算法的仓库监控区域目标跟踪研究 [J], 冯曙明;张佳禹;杨永成;肖爱华;王大淼因版权原因,仅展示原文概要,查看原文内容请购买。

集成学习算法总结----Boosting和Bagging

集成学习算法总结----Boosting和Bagging集成学习基本思想:如果单个分类器表现的很好,那么为什么不适⽤多个分类器呢?通过集成学习可以提⾼整体的泛化能⼒,但是这种提⾼是有条件的:(1)分类器之间应该有差异性;(2)每个分类器的精度必须⼤于0.5;如果使⽤的分类器没有差异,那么集成起来的分类结果是没有变化的。

如下图所⽰,分类器的精度p<0.5,随着集成规模的增加,分类精度不断下降;如果精度⼤于p>0.5,那么最终分类精度可以趋向于1。

接下来需要解决的问题是如何获取多个独⽴的分类器呢?我们⾸先想到的是⽤不同的机器学习算法训练模型,⽐如决策树、k-NN、神经⽹络、梯度下降、贝叶斯等等,但是这些分类器并不是独⽴的,它们会犯相同的错误,因为许多分类器是线性模型,它们最终的投票(voting)不会改进模型的预测结果。

既然不同的分类器不适⽤,那么可以尝试将数据分成⼏部分,每个部分的数据训练⼀个模型。

这样做的优点是不容易出现过拟合,缺点是数据量不⾜导致训练出来的模型泛化能⼒较差。

下⾯介绍两种⽐较实⽤的⽅法Bagging和Boosting。

Bagging(Bootstrap Aggregating)算法Bagging是通过组合随机⽣成的训练集⽽改进分类的集成算法。

Bagging每次训练数据时只使⽤训练集中的某个⼦集作为当前训练集(有放回随机抽样),每⼀个训练样本在某个训练集中可以多次或不出现,经过T次训练后,可得到T个不同的分类器。

对⼀个测试样例进⾏分类时,分别调⽤这T个分类器,得到T个分类结果。

最后把这T个分类结果中出现次数多的类赋予测试样例。

这种抽样的⽅法叫做,就是利⽤有限的样本资料经由多次重复抽样,重新建⽴起⾜以代表原始样本分布之新样本。

Bagging算法基本步骤:因为是随机抽样,那这样的抽样只有63%的样本是原始数据集的。

Bagging的优势在于当原始样本中有噪声数据时,通过bagging抽样,那么就有1/3的噪声样本不会被训练。

集成学习的不二法门bagging、boosting和三大法宝结合策略平均法,投票法和学习法。。。

集成学习的不⼆法门bagging、boosting和三⼤法宝结合策略平均法,投票法和学习法。

单个学习器要么容易⽋拟合要么容易过拟合,为了获得泛化性能优良的学习器,可以训练多个个体学习器,通过⼀定的结合策略,最终形成⼀个强学习器。

这种集成多个个体学习器的⽅法称为集成学习(ensemble learning)。

集成学习通过组合多种模型来改善机器学习的结果,与单⼀的模型相⽐,这种⽅法允许产⽣更好的预测性能。

集成学习属于元算法,即结合数个“好⽽不同”的机器学习技术,形成⼀个预测模型,以此来降⽅差(bagging),减偏差(boosting),提升预测准确性(stacking)。

1. 集成学习之个体学习器个体学习器(⼜称为“基学习器”)的选择有两种⽅式:集成中只包含同种类型的个体学习器,称为同质集成。

集成中包含不同类型的个体学习器,为异质集成。

⽬前同质集成的应⽤最⼴泛,⽽基学习器使⽤最多的模型是CART决策树和神经⽹络。

按照个体学习器之间是否存在依赖关系可以分为两类:个体学习器之间存在强依赖关系,⼀系列个体学习器基本必须串⾏⽣成,代表是boosting系列算法。

个体学习器之间不存在强依赖关系,⼀系列个体学习器可以并⾏⽣成,代表是bagging系列算法。

1.1 boosting算法原理boosting的算法原理如下所⽰:Boosting算法的⼯作机制是:(1)先从初始训练集训练出⼀个基学习器;(2)再根据基学习器的表现对样本权重进⾏调整,增加基学习器误分类样本的权重(⼜称重采样);(3)基于调整后的样本分布来训练下⼀个基学习器;(4)如此重复进⾏,直⾄基学习器数⽬达到事先指定的个数,将这个基学习器通过集合策略进⾏整合,得到最终的强学习器。

Boosting系列算法⾥最著名算法主要有AdaBoost算法和提升树(boosting tree)系列算法。

提升树系列算法⾥⾯应⽤最⼴泛的是梯度提升树(Gradient Boosting Tree)<GDBT>。

如何理解Boosting和Bagging【面试经验】

如何理解Boosting和Bagging?他们有什么异同?【面试经验】Boosting和Bagging是机器学习中的两种集成学习方法,它们通过组合多个弱学习器来创建一个强学习器,从而提高预测性能。

虽然它们的目标相似,但它们在实现方式和策略上有所不同。

1.Boosting:Boosting方法通过迭代地训练弱学习器,并在每次迭代中增加对之前错误分类样本的权重,从而关注那些被错误分类的样本。

每个新的弱学习器都试图纠正前一个学习器的错误。

最终,这些弱学习器的预测结果通过加权的方式进行组合,以产生最终的预测结果。

一个著名的Boosting算法是AdaBoost。

2.Bagging:与Boosting不同,Bagging方法通过从原始数据集中随机抽取多个子集,并在每个子集上独立地训练一个弱学习器。

这些弱学习器的预测结果最后通过投票或平均的方式进行组合,以产生最终的预测结果。

由于每个子集都是随机抽取的,因此Bagging有助于减少模型的方差,并提高模型的稳定性。

随机森林是Bagging的一个著名实现。

异同点:•相似之处:Boosting和Bagging都是集成学习方法,它们通过组合多个弱学习器来提高预测性能。

•不同之处:1.样本选择:Boosting在每次迭代中都会调整样本的权重,关注被错误分类的样本;而Bagging则通过随机抽样来生成不同的训练子集。

2.预测函数:Boosting中的弱学习器通常具有不同的权重,这些权重根据它们在前一轮的表现进行调整;而Bagging中所有弱学习器的权重通常是相等的。

3.并行计算:由于Bagging中的弱学习器是独立训练的,因此它们可以并行生成;而Boosting中的弱学习器是顺序生成的,因为它们依赖于前一个学习器的结果。

4.方差与偏差:从方差-偏差分解的角度看,Bagging主要关注降低模型的方差,因此它在易受样本扰动的学习器上效用更为明显;而Boosting则主要关注降低模型的偏差,通过不断纠正错误来改进预测性能。

中科院研究生院机器学习试卷(含答案)

中国科学院研究生院课程编号:712008Z 试 题 专 用 纸 课程名称:机器学习任课教师:卿来云———————————————————————————————————————————————姓名学号 成绩1. 判断题(20分,每小题2分)(1)给定n 个数据点,如果其中一半用于训练,另一半用于测试,则训练误差和测试误差之间的差别会随着n 的增加而减小。

(T )(2)当训练数据较少时更容易发生过拟合。

(T ) (3)回归函数A 和B ,如果A 比B 更简单,则A 几乎一定会比B 在测试集上表现更好。

(F ) (4)在核回归中,最影响回归的过拟合性和欠拟合之间平衡的参数为核函数的宽度。

(T ) (5)在AdaBoost 算法中,所有被错分的样本的权重更新比例相同。

(T ) (6)Boosting 的一个优点是不会过拟合。

(F )(7)梯度下降有时会陷于局部极小值,但EM 算法不会。

(F ) (8)SVM 对噪声(如来自其他分布的噪声样本)鲁棒。

(F )(9)Boosting 和Bagging 都是组合多个分类器投票的方法,二者都是根据单个分类器的正确率决定其权重。

(F ) (10)在回归分析中,最佳子集选择可以做特征选择,当特征数目较多时计算量大;岭回归和Lasso 模型计算量小,且Lasso 也可以实现特征选择。

(T )2、logistic 回归模型。

(20分,每小题10分)我们对如图1(a)所示的数据采用简化的线性logistic 回归模型进行两类分类,即()()()121122112211|,,1exp Y w w g w x w x w x w x ==+=+−−x P 。

(为了简化,我们不采用偏差0w 。

) 训练数据可以被完全分开(训练误差为0,如图1(b)所示的L 1)。

共 3 页 第1页图1(a) 2维训练数据。

图1(b) 数据点可以被L 1(实线)。

L 2、L 3和L 4是另外几个可能的决策(1) 考虑一个正则化的方法,即最大化()21221log |,,2Ni i i C y w w w =−∑x P 。

一种新的boosting回归树方法

一种新的boosting回归树方法

近年来,随着机器学习、数据挖掘等领域的发展,回归树方法作为数据量级小的机器学习算法,被广泛应用于大规模的复杂数据分析任务中。

拟合和预测准确度高,有效提高了机器学习效率和精度。

然而,由于回归树算法容易过拟合,存在收敛速度慢、估计偏差大等问题,而Boosting算法恰好是一种有效的解决方案,借助于增强的学习机制,加速收敛,提高分类准确率,使Boosting算法在许多计算任务和计算模型中得到成功应用,同时也备受广泛的关注。

基于此,本文提出了一种新的Boosting 回归树方法——改进的Gradient Boost (GB2),其主要特点如下:

1.采用改进后的梯度boost算法来构建弱学习器。

与前一代算法不同,该算法通过损失函数梯度建立了弱学习器,因此能够更精确地进行拟合、收敛和预测,从而提高了结果的准确性。

2.改进的正则化结构。

弱学习器优化策略采用L1、L2正则化,可抑制模型复杂度,减少过拟合现象,提高拟合精度。

3.增加底层算法。

该算法除了采用CART树模型外,还增加了GBDT、Xgboost等底层算法,使得模型能更好地拟合数据,提高了准确率。

本文改进的gradient Boost回归树模型主要针对了拟合准确度、模型复杂度、收敛速度和估计偏差等方面的问题,具有一定的突破性,为回归树在实际应用中提供了新的方法。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Boosting

1. 判断题

(1)Boosting和Bagging都是组合多个分类器投票的方法,二者都是根据单个分类器的正确率决定其权重。

(2)在Boosting中,当训练误差为0时必须停止迭代,否则会发生过拟合。

(3)Boosting和Bagging都可以视为是对训练数据的重采样,但二者的重采样方式不同。

(4)在AdaBoost算法中,所有被错分的样本的权重更新比例相同。

(T)

(5)Boosting的一个优点是不会过拟合。

2. Boosting。

(20分,每小题10分)

考虑如图3所示的训练样本,其中’+’和’O’分别表示正样本和负样本。

图中还给出了采用AdaBoost算法经过若干次迭代后每个样本的权重。

同时图中还给出了3个弱分类器:A、B 和C。

则

图3:训练样本及其权重,A、B和C为3个可能的弱分类器

(1)下次将选择A、B和C等3个弱分类器的哪个弱分类器?为什么?

弱分类器B的加权错误率最小。

(2)图中所示权重最可能是上次采用A、B和C哪个弱分类器得到的?为什么?

上一轮选择的弱分类器在本轮中的加权错误率为0.5,因此上一轮的分类器是弱分类器C.

3.Boosting 与特征选择

考虑一个文本分类问题。

每个文档用一些二值特征表示为()1,...,i i iD x x x =,其中1ij x =表示单

词j 出现在文档i 中,否则的话0ij

x =。

现采用AdaBoost 算法进行分类,其中弱分类器为

(),,j h yx x θ=

(),j y θ=,其中j 为选择的单词索引,{}1,1y ?为对应的文档标签。

即每个弱分类器为每个

单词与类别的关系。

如有单词”足球”,类别有{运动,非运动},则我们有两个弱分类器: ● 如果文档中出现单词”足球”,判定该文档为“运动”; ●

如果文档中不出现单词”足球”,判定该文档为“运动”;

(1) 一共有多少个弱分类器?

每个单词对应两个弱分类器,D 个单词共有2D 个弱分类器。

(2) Boosting 可以实现特征选择,即运行算法,被选择的特征按其被算法选中的顺序加入最

终的模型。

有些弱分类器可能会被选择多次吗? 可能。

Boosting 算法是在假定之前的投票权重不变的情况下优化当前的α,因此不是对所有的系数一起优化。

因此只能通过再重新将弱分类器加入来修正之前的投票权重。

(3) 互信息也可以用来特征选择。

如果我们对每个特征根据其与标签之间的互信息来排序,

那么该排序会比AdaBoost 的排序更有信息量吗? 不会。

AdaBoost 是多个弱分类器(特征)的线性组合,新的弱分类器是在考虑之前已有预测的基础上的。

而单个特征与标签的互信息只考虑该特征本身的信息,不能发现多个特征队线性预测的交互作用。

4. 现采用AdaBoost 算法来集成多个弱分类器。

图2给出了带标签的数据,其中输入特征为2维,同时还给出了第一个弱分类器。

每个弱分类器根据某维特征预测输出1±。

小箭头为决策边界的法线方向。

初始时各样本的权重相同。

图2: 带标签的数据及第一个弱分类器。

箭头方向为决策边界的正方向。

(1) 在图2中标出根据第一个弱分类器权重会增大的样本点。

错分样本的权重会增加。

11111,ln 0.804762t t

e e a e 骣

-÷ç÷===ç÷ç÷桫, 权重更新:()()()()

1exp t t i t i t t

D i y h D i Z α+-=

x ,

错误分类样本的权重:(1个)

()121111

1

11

1

exp 1

262

26

D D D Z a e =

=??

´, 正确分类样本的权重为:(5个)

()()1211111111

exp 521610

26

D D D Z αε=

-=⨯=⨯=-⨯. (2) 在图中画出下一轮选择的弱分类器。

请给出决策边界及其方向。

如图。

(3) 第二轮弱分类器的系数会比第一次的大吗,即21a a >?

是的。

因为被第二个弱分类器分错的样本的权重较小(因为被第一个弱分类器分对了)

5.Boosting

考虑下述分类问题。

我们打算采用boosting 来学习分类器,其中弱分类器为平行两个坐标轴的

线性分类器。

请给出AdaBoost 前3轮迭代的弱分类器、其对应的加权错误率、弱分类器的权重α、样本权重的更新。

为了统一,第一轮弱分类器选择特征x1,即为竖直线。

并请给出每轮结束后的强分类器的训练误差。

6.AdaBoost 的损失函数

(1) AdaBoost 可视为最小化指数损失函数()()exp 1

exp N

i i i J y f x ==

-å

,其中{}1,1y ?

为类别

标签,()()1

T

t t f h x x a ==

å

为弱分类器的权重。

证明指数损失是0-1损失函数

()()011

0N

i

i

i J y f x -==

<åI 的上界。

证明:

(2) 指数损失对outliers 敏感。

请给出一个简单的解决方案。

由于每个被错分的样本的权重会增加,一种忽略outliers 的方法是对样本权重设置一个阈值,当样本的权重超过该阈值时,认为样本是outlier ,去掉该样本。

7.下图给出了8个数据点,其中正负样本各4个。

图中也给出了AdaBoost 第一轮选择的弱分类器h 1 (弱分类器为平行坐标轴的直线)。

(1) AdaBoost 给弱分类器h 1的权重α1为多少? (各样本的初始权重相等,即

1/8.)

11111,ln 0.973082t t

e e a e 骣

-÷ç÷===ç÷ç÷桫 (2) 不管弱分类器是什么类型,AdaBoost 的训练误差最终将趋于0?

错。

只有当训练数据能被某种类型弱分类器的线性组合可分时,AdaBoost 的训练误差才能最终趋于0。

(3)赋予弱分类器的投票权重α总是非负。

对。

AdaBoost 选择的训练误差ε<1/2,因此α=1/2log(ε/(1-ε))>0.。