中文语音识别的方法

AI技术的实时语音翻译方法介绍

AI技术的实时语音翻译方法介绍

实时语音中文翻译是指将一种语言的口头表达转换成另一种语言的口

头表达,且转换过程需要在实时中进行。

以下是一种基本的实时语音中文

翻译方法介绍:

1.语音识别:首先,需要用语音识别技术将原始语音输入转换成文本

形式。

语音识别技术可以根据语音信号的声学特征和语言模型,将语音转

录成对应的文本。

2.文本翻译:接下来,使用机器翻译技术将转录得到的文本进行翻译。

机器翻译技术可以根据预先学习的语言模型和翻译模型,将源语言的文本

转换成目标语言的文本。

3.文本合成语音:将翻译后的文本再次转换成语音输出。

这可以使用

文本到语音合成技术,根据输入的文本生成相应的语音信号,并输出到声

音设备。

需要注意的是,在实时语音中文翻译中,每一步都需要在实时环境下

进行。

因此,在设计中需要考虑时间延迟、处理速度和系统鲁棒性等因素。

除了以上基本的方法,还可以结合其他技术和模型来提高实时语音中

文翻译的效果,例如语音增强技术、情感识别技术等。

同时,基于深度学

习的端到端模型也可以用于实现实时语音中文翻译。

这些方法都在不断地

得到研究和发展,以提升实时语音中文翻译的准确性和自然度。

说话人识别

说话人识别

UBM模型的另一个用途,是可以在只有少量集 内说话人训练语料的条件下,依据UBM模型自适 应得到集内说话人模型。 最大后验准则 (Maximum A Posteriori, MAP) 方 法

nm P(qt i ot , )

t 1 T

1 T Em (O) P(qt i ot , )ot nm t 1

GMM Gaussian model

说话人识别

GMM本质上是一种多维概率密度函数 M 阶GMM的概率密度函数如下:

P(o ) P(o, i ) ci P(o i, )

i 1 i 1 M M

有

c

i 1

M

i

1

1

(o μ i )T Σi1 (o μ i ) P(o i, ) N (o,μ i ,Σi ) exp K 1 2 2 2 (2 ) Σi

t

P( q

i | ot , )

说话人识别

2 ik 2 P ( q i | o , )( o ) t tk tk t 1 T T

P( q

t 1

t

i | ot , )

说话人识别

开始 给定初始模型的阶数 M

初始化模型参数

0

对于每个特征参量

n arg max p(ot | n )

1 n N t

说话人识别

文本提示型的识别方法

非特定说话人 的基元模型

训练

基元模型生成

门限设定

语 音 输 入

端点 检测

特征 提取 指定文本 识别 文本模型生成

匹配计算

门限比较

判 定 输 出

《中文语音识别通用技术标准》

《中文语音识别通用技术标准》中华人民共和国国家标准GB/T ×××××—××××××××-××-××发布××××-××-××实施中文语音识别系统通用技术规范General specification for Chinese speech recognition system 国家质量监督检验检疫总局发布目次前言. III1 范围. 12 规范性引用文件. 13 术语和定义. 14 语音识别系统分类及表述. 34.1 基于用途的分类. 34.2 基于词汇量的分类. 34.3 基于所能识别的说话人群的分类. 34.4 基于系统工作模式的分类. 44.5 语音识别系统的应用环境. 44.6 语音识别系统应用背景环境. 54.7 语音识别系统表述规范. 55 语音识别系统性能指标. 55.1 概述. 55.2 识别性能分类指标. 55.3 响应时间指标. 65.4 系统分类指标要求. 66 语音输入和识别输出. 76.1 语音识别输入准则. 76.2 语音识别输出准则. 77 语音识别系统性能测试方法. 77.1 概述. 77.2 测试语料设计. 87.3 测试语音录制. 87.4 基于语音识别标准库的测试方法. 87.5 基于现场口呼的测试方法. 87.6 测试报告内容. 98 语音识别标准库及规范. 98.1 概述. 98.2 语音识别标准库语音特性的描述. 98.3 语音识别标准库的标注. 98.4 语音识别标准库的来源. 108.5 语音识别标准库的数据转换. 10附录 A (资料性附录)听写系统有关符号读法. 1附录 B (资料性附录)语音识别用无调汉语拼音表. 1参考文献. 2前言请注意本标准的某些内容有可能涉及专利。

Python中如何进行AI语音识别

Python中如何进行AI语音识别随着人工智能技术的发展,语音识别技术已经得到广泛应用,成为人们生活中不可或缺的一部分。

而Python作为一种流行的编程语言,已经在AI领域中扮演着重要的角色。

那么,在Python中如何进行AI语音识别呢?本文将围绕这一问题进行论述。

一、Python语音识别库介绍Python语音识别库包括google speech recognition、sphinx、pocketsphinx、Envelop等几种。

下面将对它们一个个进行介绍。

1. Google Speech RecognitionGoogle Speech Recognition是使用Google的API实现的语音识别库,它可以将音频文件转化为文本。

它可以支持多种语言,如英语、法语、德语、中文等。

它的优点是使用方便、准确度高,但缺点是需要稳定的网络连接,而且需要获取API密钥。

使用方法:(1)安装库。

```pythonpip install SpeechRecognition```(2)使用Google API密钥调用```pythonimport speech_recognition as srdef recognize_speech(audio_file_path):r = sr.Recognizer()with sr.AudioFile(audio_file_path) as source: audio = r.record(source)try:text = r.recognize_google(audio)return textexcept Exception as e:print(e)```2. SphinxSphinx是CMU开发的一种免费语音识别工具包。

由于它可以使用离线识别,因此它是一种非常强大、适用性广泛的语音识别工具。

它能够支持多种操作系统,包括Windows、MacOS、Linux等。

它的优点是支持离线识别,准确度高,但需要一定的学习和训练过程。

语音是如何在线翻译成语音的?方法简单介绍

语音是如何在线翻译成语音的?方法简单介绍

语音是如何在线翻译语音的?我们可以将一些中文的语音翻译

成英文的语音,还可以将不同的语音进行在线翻译,那么我们要是想要将语音在线翻译的快速又准确,我们需要在线进行翻译,接下来小编就给大家简单的介绍一下将语音翻译成语音的简单方法。

1、首先我们需要打开电脑,在浏览器上搜索迅捷PDF在线转换器。

2、在首页面的导航栏中我们可以看到有语音识别,我们点击语音

识别中的语音翻译语音。

3、在上传语音文件之前我们应该先自定义一下我们的文件输出的

格式等,我们可以点击文件进行上传,也可以进行文件的批量

上传。

4、我们点击-开始翻译按钮。

进行开始翻译。

5、在翻译的过程中我们需要等待一段时间,等到语音文件转换完

成,进度条在百分百的时候。

6、我们翻译完成之后就可以进行在线下载或是将翻译好的语音下

载到桌面上了。

以上就是我所了解的语音转文字的方法了,希望会带给大家帮助。

迅捷PDF在线转换器:。

语音识别

语音识别技术概述语音识别技术,也被称为自动语音识别Automatic Speech Recognition,(ASR),其目标是将人类的语音中的词汇内容转换为计算机可读的输入,例如按键、二进制编码或者字符序列。

与说话人识别及说话人确认不同,后者尝试识别或确认发出语音的说话人而非其中所包含的词汇内容。

语音识别技术的应用包括语音拨号、语音导航、室内设备控制、语音文档检索、简单的听写数据录入等。

语音识别技术与其他自然语言处理技术如机器翻译及语音合成技术相结合,可以构建出更加复杂的应用,例如语音到语音的翻译。

语音识别技术所涉及的领域包括:信号处理、模式识别、概率论和信息论、发声机理和听觉机理、人工智能等等。

历史早在计算机发明之前,自动语音识别的设想就已经被提上了议事日程,早期的声码器可被视作语音识别及合成的雏形。

而1920年代生产的"Radio Rex"玩具狗可能是最早的语音识别器,当这只狗的名字被呼唤的时候,它能够从底座上弹出来。

最早的基于电子计算机的语音识别系统是由A T&T贝尔实验室开发的Audrey语音识别系统,它能够识别10个英文数字。

其识别方法是跟踪语音中的共振峰。

该系统得到了98%的正确率。

到1950年代末,伦敦学院(Colledge of London)的Denes已经将语法概率加入语音识别中。

1960年代,人工神经网络被引入了语音识别。

这一时代的两大突破是线性预测编码Linear Predictive Coding (LPC),及动态时间弯折Dynamic Time Warp技术。

语音识别技术的最重大突破是隐含马尔科夫模型Hidden Markov Model的应用。

从Baum提出相关数学推理,经过Labiner等人的研究,卡内基梅隆大学的李开复最终实现了第一个基于隐马尔科夫模型的大词汇量语音识别系统Sphinx。

[1]。

此后严格来说语音识别技术并没有脱离HMM框架。

中文语音识别预训练模型

中文语音识别预训练模型

中文语音识别预训练模型是一种基于大规模中文语音数据进行预训练

的模型,可用于提高中文语音识别系统的性能。

预训练模型的主要作

用是通过大规模语音数据的学习,获取丰富的语音特征并对其进行编码,形成语音特征的表征,为后续的语音识别任务提供更加丰富、准确、鲁棒的特征表示。

与传统的语音识别技术相比,预训练模型具有以下独特的优点:

1. 更快的训练速度:预训练模型的训练过程可以在大规模语音数据上

进行,提供充足的数据支持。

在后续的任务中,只需微调预训练模型

即可,避免了每次都需要从零开始训练的繁琐过程,从而实现更快的

训练速度。

2. 更好的泛化性能:预训练模型可以有效提取语音数据的丰富特征信息,具有很好的泛化性能。

无论是识别普通话、方言还是口音不同的

人的语音,预训练模型都可以进行有效的特征提取,提高识别准确率。

3. 更高的识别准确率:预训练模型可以有效增强语音识别系统的特征

表示能力,从而显著提高识别准确率。

在实验中,使用预训练模型进

行端对端的语音识别任务,其识别准确率可以与传统的深度学习模型

相比,获得更高的结果。

目前,中文语音识别预训练模型已经被广泛应用于自然语言处理、语音识别、机器翻译、情感分析等多个领域。

未来,预训练模型将继续发挥重要的作用,为语音识别系统的发展提供有力的支持。

vivo iQOO哪里可以语音转文字

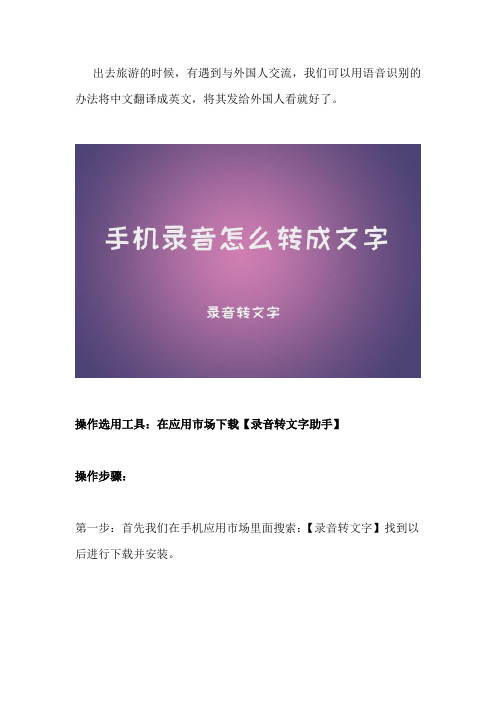

出去旅游的时候,有遇到与外国人交流,我们可以用语音识别的办法将中文翻译成英文,将其发给外国人看就好了。

操作选用工具:在应用市场下载【录音转文字助手】

操作步骤:

第一步:首先我们在手机应用市场里面搜索:【录音转文字】找到以后进行下载并安装。

第二步:安装好以后,我们把软件打开就可以看到录音【录音识别】、【文件识别】和【录音机】,【录音识别】是边录音边转换成文字,【文件识别】则是上传音频文件进行识别,【录音机】仅支持录音,

如果需要转文字和翻译,可以录音结束后在文件库中进行,小编这里就举例说明下【录音识别】。

第三步:点击【录音识别】进入录音的界面,点击下方蓝色按钮就可

以开始说出你想要录制的话,接着你刚说的话就会变成文字显示出来了。

第四步:这里还可以做翻译,点击翻译按钮,等一小会儿就可以把刚识别出来的文字翻译成英文。

第五步:接着可以点击【复制】在弹出的对话框中选择好需要复制的选项,就可以将识别的内容粘贴到你需要的地方。

第五步:如果你还想把识别的内容分享给你的好友,可以点击【导出】,选择好你需要需要导出的选项,然后分享给你的好友就可以了。

第六步:保存到本地;点击右上角的【保存】按钮,在弹出的对话框中点击【确定】就保存好了,点击下面【文件库】选项,就可以看到刚保存的文件了。

录音转文字的具体操作方法就是这样了,感兴趣或者有需要的朋友自己去试试吧。

一种中英文混合语音识别方法[发明专利]

![一种中英文混合语音识别方法[发明专利]](https://img.taocdn.com/s3/m/7f68dfc2cfc789eb162dc854.png)

专利名称:一种中英文混合语音识别方法

专利类型:发明专利

发明人:朱羿孜,许召辉,马翼平,陈年生,范光宇,饶蕾,周圣杰申请号:CN202010948079.6

申请日:20200910

公开号:CN112037762A

公开日:

20201204

专利内容由知识产权出版社提供

摘要:本发明的一种中英文混合语音识别方法,采集中英文混合语音后,将语音按照一定的帧长划分为若干段语音信号,且分段重叠率为40%,对分段后的语音信号进行高通滤波,滤波后进行加窗处理,得到每段语音信号的加窗函数,并计算判断是否为静音段,对非静音段的语音信号进行中文识别判断,当识别成功则输出该段中文且设定语种标识为1,当识别失败设定语种标识为0并进行英文识别,识别成功则输出该段英文且更新语种标识为0,识别失败则设定语种标识为1重新进行中文识别。

通过将语音分成若干段语音信号并判断是否为静音段,可以有效提高识别效率,同时,分别对每段语音信号进行中文识别,识别失败则进行英文失败,可以有效保证中英文识别的准确度。

申请人:中航华东光电(上海)有限公司

地址:201114 上海市闵行区新骏环路115号1号楼3层

国籍:CN

代理机构:上海乐泓专利代理事务所(普通合伙)

代理人:张雪

更多信息请下载全文后查看。

python实现汉语数字语音识别实现方法

python实现汉语数字语音识别实现方法在Python中实现汉语数字语音识别需要用到语音识别和自然语言处理技术。

以下是实现步骤:1. 安装语音识别库首先需要安装语音识别库,比如使用SpeechRecognition库,它支持Python 和以上的版本,支持中文的语音识别。

安装命令如下:```shellpip install SpeechRecognition```2. 导入语音识别库在Python代码中导入SpeechRecognition库:```pythonimport speech_recognition as sr3. 创建语音识别对象使用SpeechRecognition库创建一个语音识别对象:```pythonr = ()```4. 读取音频文件使用SpeechRecognition库的`audio_file`函数读取音频文件,该函数接受一个音频文件的路径作为参数:```pythonwith (path_to_audio_file) as source:audio = (source)```其中`path_to_audio_file`是音频文件的路径。

5. 进行语音识别使用SpeechRecognition库的`recognize_google`函数进行语音识别,该函数接受一个音频对象作为参数,返回识别的文本:```pythontext = _google(audio)```6. 输出识别结果将识别的文本输出到控制台:```pythonprint(text)```7. 处理中文数字识别结果由于中文数字和阿拉伯数字的表示方式不同,需要进行转换。

可以使用`zhconv`库来进行中文数字和阿拉伯数字的转换,安装命令如下:```shellpip install zhconv```在代码中导入zhconv库:```pythonimport zhconv as zc```使用zhconv库的`t2n`函数将中文数字转换为阿拉伯数字:```pythonarabic_num = (text)print(arabic_num)```。

人工智能语音识别系统的使用教程与多语种翻译技术

人工智能语音识别系统的使用教程与多语种翻译技术随着科技的不断发展,人工智能语音识别系统成为了越来越多人们生活中不可或缺的一部分。

不仅能够提供便捷的语音识别功能,还具备多语种翻译技术的能力。

本文将介绍人工智能语音识别系统的使用教程,以及通过该系统进行多语种翻译的技术。

一、人工智能语音识别系统的使用教程人工智能语音识别系统是一种将语音信号转换为文本的技术,广泛应用于语音助手、语音识别软件等领域。

下面是使用人工智能语音识别系统的步骤:1.选择适当的设备:语音识别系统可在各种设备上使用,包括智能手机、平板电脑、电脑等。

根据需求选择合适的设备。

2.安装语音识别应用:在设备上安装语音识别应用程序,如Google语音助手、百度语音识别等。

这些应用程序通常可以免费下载并使用。

3.打开应用程序:在设备上找到已安装的语音识别应用程序,并打开它。

4.设置语言和其他选项:根据个人需求,在应用程序中选择语言和其他选项。

有些应用程序可以识别多种语言,而有些则只能识别特定语言。

5.开始语音识别:点击“开始识别”按钮或使用特定的语音命令开始录音。

准备好后,开始朗读要识别的文本。

6.等待识别结果:语音识别系统将根据点击按钮或语音命令录音并将其转换为文本。

等待片刻后,系统将显示出识别的文本。

7.编辑和纠错:如果识别结果出现错误,可以进行编辑和纠错,以获得更准确的文本结果。

大多数语音识别应用程序提供编辑和纠错功能。

8.保存和分享:完成编辑和纠错后,可以保存识别的文本,并将其分享给他人。

应用程序通常提供识别文本保存和分享的选项。

以上是人工智能语音识别系统的基本使用教程。

通过这样的语音识别系统,我们可以在手机、平板电脑、电脑等设备上实现语音转文字的功能,提高工作效率和生活便利性。

二、多语种翻译技术除了提供语音转文本的功能外,人工智能语音识别系统还具备多语种翻译的能力。

下面是多语种翻译技术的简要介绍:1.系统支持多种语言:多语种翻译技术允许用户使用不同的语言进行交流和翻译。

中文唇语识别技术流程

中文唇语识别技术流程引言:中文唇语识别技术是一种利用人的唇部运动模式来识别和理解语言的技术。

随着人工智能和计算机视觉的快速发展,中文唇语识别技术在多个领域展示了广阔的应用前景。

本文将介绍中文唇语识别技术的流程,包括数据采集、预处理、特征提取、模型训练和识别等环节。

一、数据采集中文唇语识别技术的第一步是采集唇部运动数据。

通常使用高速摄像机或深度相机来捕捉人的唇部运动。

在数据采集过程中,应注意环境的光线和噪声干扰,以确保数据的质量和准确性。

采集到的数据应包括不同人的唇部运动视频。

二、预处理在数据采集完成后,需要对数据进行预处理以提高后续处理的效果。

预处理包括视频去噪、视频稳定和人脸检测等步骤。

去噪可以通过滤波等方法减少视频中的噪声干扰。

视频稳定可以对视频进行运动校正,使唇部运动更加平滑和稳定。

人脸检测可以定位视频中的人脸区域,以便后续的特征提取和识别。

三、特征提取特征提取是中文唇语识别技术的核心环节。

通过对唇部运动视频进行分析,提取出能够表征语音特征的唇部运动特征。

常用的特征提取方法包括时域特征和频域特征。

时域特征可以通过计算唇部运动的速度、加速度等参数来描述唇部的运动模式。

频域特征可以通过傅里叶变换等方法将唇部运动信号转换到频域,提取频谱特征。

四、模型训练在特征提取完成后,需要使用机器学习或深度学习算法对提取到的特征进行训练。

机器学习算法可以包括支持向量机、随机森林等方法,深度学习算法可以包括卷积神经网络、循环神经网络等方法。

在模型训练过程中,需要准备标注好的训练数据,并进行模型的优化和调参,以提高模型的性能和泛化能力。

五、识别在模型训练完成后,可以使用训练好的模型对新的唇部运动数据进行识别。

识别过程包括将新的唇部运动数据进行预处理和特征提取,并使用训练好的模型进行分类或回归预测。

通过比较预测结果和实际标签,可以评估中文唇语识别技术的准确性和性能。

六、应用领域中文唇语识别技术在多个领域都有广泛的应用。

韵律特征分析在中文语音识别中的应用研究

韵律特征分析在中文语音识别中的应用研究中文语言是一种以声调为特征的语言,而其相对应的语音识别技术也必须考虑这一特征。

除了与声调有关的基频、音调等特征,韵律特征也是中文语音识别中的重要研究方向之一。

本文将从韵律特征的概念、韵律特征分析的方法、韵律特征在中文语音识别中的应用以及未来研究方向等方面,全面地探讨韵律特征分析在中文语音识别中的应用研究。

一、韵律特征的概念韵律特征是指语音中词与词之间、句与句之间,在时间和频率上呈现出的变化规律。

在中文语言中,韵律特征主要包括基频、时长、音调等。

其中,基频(fundamental frequency,F0)指的是声音振动的周期,也就是声调的高低;时长则是指声音持续的时间;而音调则是指在一个词语或一个句子中,声调在不同位置上的变化情况。

二、韵律特征分析的方法对于韵律特征的分析,传统的方法是通过手动标注来实现。

但是,这种方法费时费力,而且不够准确。

因此,随着机器学习的发展,越来越多的研究者正在尝试使用自动化的方法来实现韵律特征的分析。

目前比较流行的自动标注方法包括基于模型的方法和基于数据的方法。

前者依赖于事先训练好的语音模型,而后者则主要依赖于大规模的标注语音数据库。

在实际应用中,这两种方法往往会结合在一起,以实现更加准确的韵律特征分析。

三、韵律特征在中文语音识别中的应用韵律特征对中文语音识别的影响非常大。

以音调为例,中文语言中的声调相对来说比较复杂,而且同样的音节在不同句子中的音调可能会有所变化。

因此,对于中文语音识别的研究者来说,如何准确地识别声调就是一个非常重要的问题。

研究表明,通过将韵律特征融合到传统的语音识别系统中,可以显著提高中文语音识别的准确率。

此外,还可以利用韵律特征来优化语音合成和语音转换等方面的应用。

四、未来研究方向虽然韵律特征在中文语音识别中的应用已经取得了不小的成绩,但是在未来的研究中,仍然存在许多挑战和机遇。

例如,在大规模标注语音数据库方面,目前仍然存在一定的局限性;在韵律特征的自动分析方面,如何结合深度学习等先进的技术,进一步提高韵律特征分析的准确性也是一个研究热点。

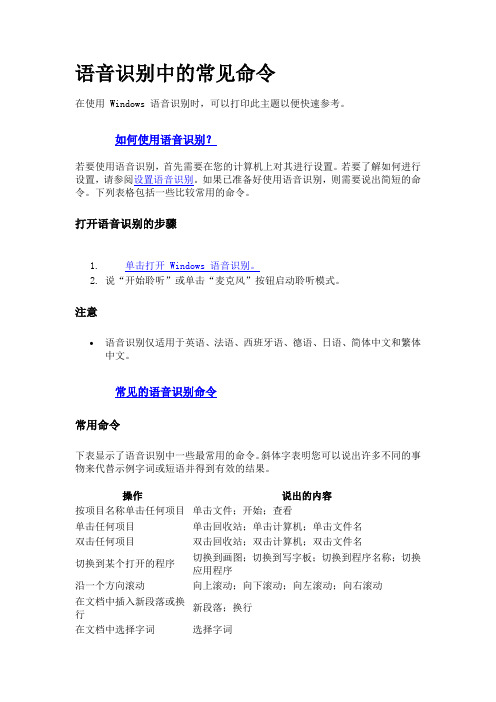

语音识别中的常见命令

语音识别中的常见命令在使用 Windows 语音识别时,可以打印此主题以便快速参考。

如何使用语音识别?若要使用语音识别,首先需要在您的计算机上对其进行设置。

若要了解如何进行设置,请参阅设置语音识别。

如果已准备好使用语音识别,则需要说出简短的命令。

下列表格包括一些比较常用的命令。

打开语音识别的步骤1.单击打开 Windows 语音识别。

2.说“开始聆听”或单击“麦克风”按钮启动聆听模式。

注意语音识别仅适用于英语、法语、西班牙语、德语、日语、简体中文和繁体中文。

常见的语音识别命令常用命令下表显示了语音识别中一些最常用的命令。

斜体字表明您可以说出许多不同的事物来代替示例字词或短语并得到有效的结果。

操作说出的内容按项目名称单击任何项目单击文件;开始;查看单击任何项目单击回收站;单击计算机;单击文件名双击任何项目双击回收站;双击计算机;双击文件名切换到某个打开的程序切换到画图;切换到写字板;切换到程序名称;切换应用程序沿一个方向滚动向上滚动;向下滚动;向左滚动;向右滚动在文档中插入新段落或换行新段落;换行在文档中选择字词选择字词操作说出的内容选择某个字词并开始对其更正更正字词选择并删除特定字词删除字词显示适用命令的列表我可以说什么?更新当前可用的语音命令列表刷新语音命令让计算机听您说话开始聆听让计算机停止聆听停止聆听移动语音识别麦克风栏移动语音识别最小化windows语音识别最小化语音识别查看有关特定任务的Windows 帮助和支持内容如何执行操作?例如,说“如何安装打印机?”,然后会返回帮助主题列表。

请注意,只有使用美国英语语音识别器时,才能使用此命令。

有关详细信息,请参阅设置语音选项。

听写用于处理文本的命令下表显示了使用语音识别处理文本的命令。

斜体字表明您可以说出许多不同的事物来代替示例字词或短语并得到有效的结果。

操作说出的内容在文档中插入换行换行在文档中插入新段落新段落插入选项卡选项卡为下一个命令插入由字母组成的字词(例如,可以插入字词“comma”来代替标点符号)由字母组成的字词插入数字形式的数由数字组成的数将光标放到特定字词之前转到字词将光标放到特定字词之后转到字词后面请勿在下一个字词前插入空格无空格转到光标所在句子开头转到句子开头转到光标所在段落开头转到段落开头操作说出的内容转到文档开头转到文档开头转到光标所在句子的结尾转到句子结尾转到光标所在段落的结束位置转到段落结尾转到当前文档的结尾转到文档结尾选择当前文档中的字词选择字词选择当前文档中的字词范围选择字词到字词选择当前文档中的所有文本选择全部文本选择光标位置之前的多个字词选择前 20 个字词;选择前 10 个字词选择光标位置之后的多个字词选择后 20 个字词;选择后 10 个字词选择最后听写的文本选择它在屏幕上清除选定内容清除选定内容将字词的首字母大写Caps 字词将字词的所有字母大写所有 Caps 字词使字词中的所有字母都小写没有 Caps 字词将下一个编号的字词更改为大写将后 10 个字词更改为大写将下一个编号的字词更改为小写将后 10 个字词更改为小写删除前一个句子删除前一个句子删除下一个句子删除下一个句子删除前一个段落删除前一个段落删除下一个段落删除下一个段落删除选定的文本或最后听写的文本删除这个键盘键键盘键命令下表显示了使用语音识别按键盘键的命令。

中文语音识别 纠正方法

中文语音识别纠正方法我折腾了好久中文语音识别的纠正方法,总算找到点门道。

我一开始弄这个的时候,完全是瞎摸索。

我就觉得要是能像修东西那样,把语音识别的错误部分拆出来,然后换个正确的零件上去就好了,这当然是很天真的想法。

最开始我试过手动纠正,就好比每次识别错一句话,我就一个字一个字地改成正确的。

这可太累人了,就像你在修一条弯弯曲曲的小路,一块石头一块石头地摆正。

而且很容易遗漏一些小错误,效率极低。

后来我发现如果一整篇文章都是这样修正,我眼睛都要花了,脑袋也晕乎乎的。

接着我就想,说不定有自动纠错的工具呢。

我找了好多语音识别软件自带的纠错功能,有些确实有,但是它的纠正不是完全准确的。

有时候识别把一个词刚好识别成了另外一个读音相似但语义完全不同的词,纠错功能可能以为对的,就不给改。

就好比它以为“大米”和“大咪”都是说那个能吃的大米一样,很不靠谱。

我还试过一个办法,就是重新训练语音识别的模型。

这就像教一个小孩重新认字一样,我给它好多正确的语音样本,想让它学习正确的识别方式。

这个方法呢,有点效果,但是很耗时间。

就像你要重新教一个小孩从数手指开始学数学,很漫长。

而且对于一些已经存在的,比较特别的发音习惯很难纠正过来。

后来我就总结了些经验。

在进行语音识别的时候呢,要尽可能在一个安静的地方,这样就像为你的声音铺了一条干净的跑道,让它没那么容易出错。

还有就是说话的速度尽量适中,要是太快就像脱缰的野马,语音识别软件很难跟上。

再一个就是如果识别出来有错误,可以参考相似语境下的正确表述,多试几次重复识别,可能就纠正过来了。

我还不太确定是否有更好的方法,但是目前这些都是我在不断摸索过程中的一些真实尝试,希望对大家有帮助。

另外,在使用语音识别的时候,要对一些专业名词或者生僻字特别留意。

我曾经有一次要识别一篇医学论文的语音内容,好多专业术语识别得乱七八糟。

从那以后,我就先把这些特殊的部分单独列出来,在识别的时候咬字特别清楚,就像要把这个字从嘴里一点一点抠出来一样,然后再识别的时候就相对准确多了。

文心一言中文理解功能

文心一言中文理解功能

文心一言是一款智能语音识别应用,可以识别中文语音并生成相应的文本输出。

它的中文理解功能是基于机器学习技术和自然语言处理算法实现的。

文心一言的中文理解功能可以通过以下方式使用:

1. 发送语音指令:使用语音功能,将想要表达的意思通过麦克风录制并发送给文心一言。

2. 听语音反馈:在发送指令后,文心一言会听取语音反馈,并给出相应的文本输出。

3. 智能理解:文心一言的中文理解功能可以根据语音指令的智能理解技术,自动识别语音指令的含义,并生成相应的文本输出。

使用文心一言的中文理解功能需要注意以下几点:

1. 语音清晰度:语音信号的清晰度对于中文理解功能的准确性和流畅度有着重要的影响。

2. 词语理解:文心一言的中文理解功能在识别语音指令时,会结

合上下文和语法规则对词语进行理解和判断。

3. 语境理解:文心一言的中文理解功能需要考虑语境和说话者的语气等因素,以保证文本输出的准确性和自然度。

维尔汀声线教学

维尔汀声线教学

摘要:

1.维尔汀声线教学简介

2.维尔汀声线的特点

3.维尔汀声线教学的方法

4.维尔汀声线教学的效果

5.维尔汀声线教学的评价与展望

正文:

维尔汀声线教学是一种针对中文语音识别技术的教学方法。

维尔汀声线,即特定说话人的声线,是指一个人在说话时所具有的独特音色。

这种教学方法的目标是通过对特定说话人的声线进行分析和模仿,提高语音识别技术对于不同说话人的识别准确率。

维尔汀声线具有以下特点:

1.每个人的声线都是独特的,因此识别准确率需要针对不同的声线进行训练。

2.声线受到个体生理特征、语言习惯等多方面因素的影响,因此需要对这些因素进行分析和处理。

3.声线具有一定的稳定性,即在较长时间内,一个人的声线变化不会太大。

维尔汀声线教学的方法主要包括以下几个步骤:

1.采集数据:收集不同说话人的语音数据,作为训练和分析的样本。

2.分析数据:对采集到的语音数据进行频谱分析,提取声线特征。

3.模仿训练:根据分析结果,对语音识别模型进行训练,使其能够模仿特定说话人的声线。

4.测试与优化:通过测试集对模型进行测试,根据测试结果对模型进行优化。

维尔汀声线教学的效果主要体现在提高语音识别技术对于不同说话人的识别准确率。

通过这种教学方法,可以使语音识别模型更加适应不同说话人的语音特征,从而提高识别效果。

总体来说,维尔汀声线教学是一种有效的针对中文语音识别技术的教学方法。

然而,由于每个人的声线都是独特的,因此需要大量的数据采集和分析工作。

此外,随着个体生理特征、语言习惯等因素的变化,声线也会发生变化,因此需要定期对模型进行更新和优化。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

}

public static SpRecognition instance()

{

if (_Instance == null)

_Instance = new SpRecognition() ;

return _Instance ;

中文语音识别的方法:

先把该语音识别的类源代码贴在下面,然后再做说明:

public class SpRecognition

{

private static SpRecognition _Instance = null ;

private SpeechLib.ISpeechRecoGrammar isrg ;

private SpeechLib.SpSharedRecoContextClass ssrContex =null;

private System.Windows.Forms.Control cDisplay ;

private SpRecognition()

{

ssrContex = new SpSharedRecoContextClass() ;

{

cDisplay.Text += result.PhraseInfo.GetText(0,-1,true) ;

}

}

我们定义了ssrContex 和isrg为语音识别的上下文和语法,通过设置isrg的DictationSetState方法,我们可以开始或结束识别,在上面的程序中是BeginRec和CloseRec方法。cDisplay 是我们用来输出识别结果的地方,为了能够在大部分控件上都可以显示结果,我用了一个Control 类来定义它。当然,每次语音识别后都会触发ISpeechRecoContextEvents_RecognitionEventHandler 事件,我们定义了一个这样的方法ContexRecognition来响应事件,并且在这个方法里输出识别结果。

ssrContex.Recognition += recHandle ;

}

public void BeginRec(Control tbResult)

{

isrg.DictationSetState(SpeechRuleState.SGDSActive) ;

}

public void CloseRec()

{பைடு நூலகம்

isrg.DictationSetState(SpeechRuleState.SGDSInactive) ;

}

private void ContexRecognition(int iIndex,object obj,SpeechLib.SpeechRecognitionType type,SpeechLib.ISpeechRecoResult result)

isrg = ssrContex.CreateGrammar(1) ;

SpeechLib._ISpeechRecoContextEvents_RecognitionEventHandler recHandle = new _ISpeechRecoContextEvents_RecognitionEventHandler(ContexRecognition) ;