求图像信息熵,基于matlab

matlab计算熵

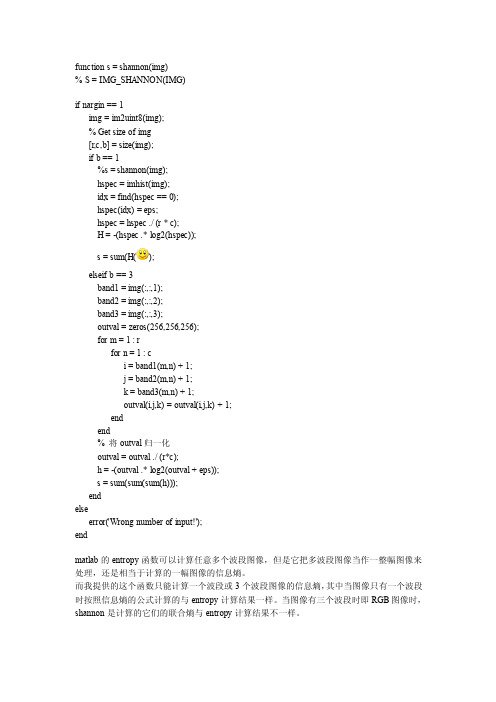

function s = shannon(img)% S = IMG_SHANNON(IMG)if nargin == 1img = im2uint8(img);% Get size of img[r,c,b] = size(img);if b == 1%s = shannon(img);hspec = imhist(img);idx = find(hspec == 0);hspec(idx) = eps;hspec = hspec ./ (r * c);H = -(hspec .* log2(hspec));s = sum(H();elseif b == 3band1 = img(:,:,1);band2 = img(:,:,2);band3 = img(:,:,3);outval = zeros(256,256,256);for m = 1 : rfor n = 1 : ci = band1(m,n) + 1;j = band2(m,n) + 1;k = band3(m,n) + 1;outval(i,j,k) = outval(i,j,k) + 1;endend% 将outval归一化outval = outval ./ (r*c);h = -(outval .* log2(outval + eps));s = sum(sum(sum(h)));endelseerror('Wrong number of input!');endmatlab的entropy函数可以计算任意多个波段图像,但是它把多波段图像当作一整幅图像来处理,还是相当于计算的一幅图像的信息熵。

而我提供的这个函数只能计算一个波段或3个波段图像的信息熵,其中当图像只有一个波段时按照信息熵的公式计算的与entropy计算结果一样。

当图像有三个波段时即RGB图像时,shannon是计算的它们的联合熵与entropy计算结果不一样。

信息熵与图像熵的计算

实验一信息熵与图像熵计算一、实验目的1.复习MATLAB 的基本命令,熟悉MATLAB 下的基本函数。

2.复习信息熵基本定义, 能够自学图像熵定义和基本概念。

二、实验仪器、设备1.计算机-系统最低配置 256M 内存、P4 CPU。

2.Matlab 仿真软件- 7.0 / 7.1 / 2006a 等版本Matlab 软件。

三、实验内容与原理(1)内容:1.能够写出MATLAB 源代码,求信源的信息熵。

2.根据图像熵基本知识,综合设计出MATLAB 程序,求出给定图像的图像熵。

(2)原理1. MATLAB 中数据类型、矩阵运算、图像文件输入与输出知识复习。

2.利用信息论中信息熵概念,求出任意一个离散信源的熵(平均自信息量)。

自信息是一个随机变量,它是指某一信源发出某一消息所含有的信息量。

所发出的消息不同,它们所含有的信息量也就不同。

任何一个消息的自信息量都代表不了信源所包含的平均自信息量。

不能作为整个信源的信息测度,因此定义自信息量的数学期望为信源的平均自信息量:信息熵的意义:信源的信息熵H是从整个信源的统计特性来考虑的。

它是从平均意义上来表征信源的总体特性的。

对于某特定的信源,其信息熵只有一个。

不同的信源因统计特性不同,其熵也不同。

3.学习图像熵基本概念,能够求出图像一维熵和二维熵。

图像熵是一种特征的统计形式,它反映了图像中平均信息量的多少。

图像的一维熵表示图像中灰度分布的聚集特征所包含的信息量,令Pi 表示图像中灰度值为i的像素所占的比例,则定义灰度图像的一元灰度熵为:255log i iip p ==∑H图像的一维熵可以表示图像灰度分布的聚集特征,却不能反映图像灰度分布的空间特征,为了表征这种空间特征,可以在一维熵的基础上引入能够反映灰度分布空间特征的特征量来组成图像的二维熵。

选择图像的邻域灰度均值作为灰度分布的空间特征量,与图像的像素灰度组成特征二元组,记为( i, j ),其中i 表示像素的灰度值(0 <= i <= 255),j 表示邻域灰度(0 <= j <= 255),2(,)/ijP f i j N =上式能反应某像素位置上的灰度值与其周围像素灰度分布的综合特征,其中f(i, j) 为特征二元组(i, j)出现的频数,N 为图像的尺度,定义离散的图像二维熵为:255logij ijip p ==∑H构造的图像二维熵可以在图像所包含信息量的前提下,突出反映图像中像素位置的灰度信息和像素邻域内灰度分布的综合特征.四、实验步骤1.求解信息熵过程:1) 输入一个离散信源,并检查该信源是否是完备集。

图像熵计算

图像熵计算1.信息熵:利用信息论中信息熵概念,求出任意一个离散信源的熵(平均自信息量)。

自信息是一个随机变量,它是指某一信源发出某一消息所含有的信息量。

一条信息的信息量和它的不确定性有着直接的关系。

所发出的消息不同,它们所含有的信息量也就不同。

任何一个消息的自信息量都代表不了信源所包含的平均自信息量。

不能作为整个信源的信息测度,因此定义自信息量的数学期望为信源的平均自信息量:信息熵的意义:信源的信息熵H是从整个信源的统计特性来考虑的。

它是从平均意义上来表征信源的总体特性的。

对于某特定的信源,其信息熵只有一个。

不同的信源因统计特性不同,其熵也不同。

信息熵一般用符号H表示,单位是比特。

变量的不确定性越大,熵也就越大。

2.图像熵:2.1.一元灰度熵图像熵是一种特征的统计形式,它反映了图像中平均信息量的多少。

图像的一维熵表示图像中灰度分布的聚集特征所包含的信息量,令Pi 表示图像中灰度值为i的像素所占的比例,则定义灰度图像的一元灰度熵为:其中Pi是某个灰度在该图像中出现的概率,可由灰度直方图获得。

2.2.二维熵图像的一维熵可以表示图像灰度分布的聚集特征,却不能反映图像灰度分布的空间特征,为了表征这种空间特征,可以在一维熵的基础上引入能够反映灰度分布空间特征的特征量来组成图像的二维熵。

选择图像的邻域灰度均值作为灰度分布的空间特征量,与图像的像素灰度组成特征二元组,记为( i, j ),其中i 表示像素的灰度值(0 <= i <= 255),j 表示邻域灰度均值(0 <= j <= 255):上式能反应某像素位置上的灰度值与其周围像素灰度分布的综合特征,其中f(i, j)为特征二元组(i, j)出现的频数,N 为图像的尺度,定义离散的图像二维熵为:构造的图像二维熵可以在图像所包含信息量的前提下,突出反映图像中像素位置的灰度信息和像素邻域内灰度分布的综合特征。

3.源码[plain] view plaincopy1.1.求一元灰度熵2.%方法一3.[M,N]=size(im);4.temp=zeros(1,256);5.6.%对图像的灰度值在[0,255]上做统计7.for m=1:M;8.for n=1:N;9.if im(m,n)==0;10.i=1;11.else12.i=im(m,n);13.end14.temp(i)=temp(i)+1;15.end16.end17.temp=temp./(M*N);18.19.%由熵的定义做计算20.result=0;21.22.for i=1:length(temp)23.if temp(i)==0;24.result=result;25.else26.result=result-temp(i)*log2(temp(i));27.end28.end29.30.%方法二31.%求熵值entropy32.im=rgb2gray(imread('mubiao.bmp'));33.[count,x]=imhist(im);34.total=sum(count);35.entropy=0;36.for i=1:25637.p(i)=count(i)/total;38.if p(i)~=039.logp(i)=log2(p(i));40.entropele=-p(i)*logp(i);41.entropy=entropy+entropele;42.end43.end44.45. 2.求二维熵46.47.%随机生成图像48.A=floor(rand(8,8).*255);50.[M,N]=size(A);51.temp=zeros(1,256);52.53.%对图像的灰度值在[0,255]上做统计54.for m=1:M;55.for n=1:N;56.if A(m,n)==0;57.i=1;58.else59.i=A(m,n);60.end61.temp(i)=temp(i)+1;62.end63.end64.temp=temp./(M*N);65.66.%由熵的定义做计算67.result=0;68.69.for i=1:length(temp)70.if temp(i)==0;71.result=result;72.else73.result=result-temp(i)*log2(temp(i));74.end75.end76.77.78. 3.计算联合熵80.%随机生成图像81.A=floor(rand(8,8).*255);82.B=floor(rand(8,8).*255);83.84.[M,N]=size(A);85.temp=zeros(256,256);86.87.%对图像的灰度值成对地做统计88.for m=1:M;89.for n=1:N;90.91.if A(m,n)==0;92.i=1;93.else94.i=A(m,n);95.end96.97.if B(m,n)==0;98.j=1;99.else100.j=B(m,n);101.end102.103.temp(i,j)=temp(i,j)+1; 104.end105.end106.temp=temp./(M*N); 107.108.%由熵的定义做计算109.result=0;110.111.for i=1:size(temp,1)112.for j=1:size(temp,2)113.if temp(i,j)==0;114.result=result;115.else116.result=result-temp(i,j)*log2(temp(i,j));117.end118.end119.end4.Matlab的计算熵的函数Matlab中的这2个函数分别是计算熵的,entropy计算全局熵,entropyfilt计算局部熵给定一个灰度图I,entropy(I)的计算方法是,将I直方图化到0-255的bin中,L1规范化,再用–sum(p*log2(p))来计算整理熵,即Curhist = Hist(I, 0:255);Curhist = curhist / sum(curhist);E = -sum(curhist .* log2(curhist));entropyfilt选取以各像素点为中心的的n*n(默认n=9)的区域进行熵计算,计算方法同上。

信息熵在图像处理中的应用 毕业论文

摘要信息论是人们在长期通信实践活动中,由通信技术与概率论、随机过程、数理统计等学科相结合而逐步发展起来的一门新兴交叉学科。

而熵是信息论中事件出现概率的不确定性的量度,能有效反映事件包含的信息。

随着科学技术,特别是信息技术的迅猛发展,信息理论在通信领域中发挥了越来越重要的作用,由于信息理论解决问题的思路和方法独特、新颖和有效,信息论已渗透到其他科学领域。

随着计算机技术和数学理论的不断发展,人工智能、神经网络、遗传算法、模糊理论的不断完善,信息理论的应用越来越广泛。

在图像处理研究中,信息熵也越来越受到关注。

为了寻找快速有效的图像处理方法,信息理论越来越多地渗透到图像处理技术中。

本文通过进一步探讨概论率中熵的概念,分析其在图像处理中的应用,通过概念的分析理解,详细讨论其在图像处理的各个方面:如图像分割、图像配准、人脸识别,特征检测等的应用。

本文介绍了信息熵在图像处理中的应用,总结了一些基于熵的基本概念,互信息的定义。

并给出了信息熵在图像处理特别是图像分割和图像配准中的应用,最后实现了信息熵在图像配准中的方法。

关键词:信息熵,互信息,图像分割,图像配准AbstractInformation theory is a new interdisciplinary subject developed in people long-term communication practice, combining with communication technology, theory of probability, stochastic processes, and mathematical statistics. Entropy is a measure of the uncertainty the probability of the occurrence of the event in the information theory, it can effectively reflect the information event contains. With the development of science and technology, especially the rapid development of information technology, information theory has played a more and more important role in the communication field, because the ideas and methods to solve the problem of information theory is unique, novel and effective, information theory has penetrated into other areas of science. With the development of computer technology and mathematical theory, continuous improvement of artificial intelligence, neural network, genetic algorithm, fuzzy theory, there are more and more extensive applications of information theory. In the research of image processing, the information entropy has attracted more and more attention. In order to find the fast and effective image processing method, information theory is used more and more frequently in the image processing technology. In this paper, through the further discussion on concept of entropy, analyzes its application in image processing, such as image segmentation, image registration, face recognition, feature detection etc.This paper introduces the application of information entropy in image processing, summarizes some basic concepts based on the definition of entropy, mutual information. And the information entropy of image processing especially for image segmentation and image registration. Finally realize the information entropy in image registration.Keywords:I nformation entropy, Mutual information, Image segmentation,Image registration目录摘要 .......................................................................................................................... .. (1)ABSTRACT (2)目录 (3)1 引言 (5)1.1信息熵的概念 (5)1.2信息熵的基本性质及证明 (6)1.2.1 单峰性 (6)1.2.2 对称性 (7)1.2.3 渐化性 (7)1.2.4 展开性 (7)1.2.5 确定性 (8)2基于熵的互信息理论 (9)2.1 互信息的概述 (9)2.2 互信息的定义 (9)2.3 熵与互信息的关系 (9)3 信息熵在图像分割中的应用 (11)3.1图像分割的基本概念 (11)3.1.1图像分割的研究现状 (11)3.1.2 图像分割的方法 (11)3.2 基于改进粒子群优化的模糊熵煤尘图像分割 (12)3.2.1 基本粒子群算法 (12)3.2.2 改进粒子群优化算法 (13)3.2.3 Morlet变异 (13)3.2.4改建粒子群优化的图像分割方法 (14)3.2.5 实验结果及分析 (16)3.3 一种新信息熵的定义及其在图像分割中的应用 (19)3.3.1香农熵的概念及性质 (19)3.3.2一种信息熵的定义及证明 (19)3.3.3信息熵计算复杂性分析 (21)3.3.4二维信息熵阈值法 (22)3.3.5二维信息熵阈值法的复杂性分析 (24)3.3.6 结论及分析 (25)4 信息熵在图像配准中的应用 (27)4.1图像配准的基本概述 (27)4.2基于互信息的图像配准 (27)4.3P OWELL算法 (28)4.4变换 (28)4.4.1平移变换 (29)4.4.2旋转变换 (30)4.5基于互信息的图像配准的设计与实现 (31)4.5.1总体设计思路和图像配准实现 (31)4.5.2直方图 (33)4.5.3联合直方图 (33)4.5.4灰度级差值技术 (34)4.4.5优化搜索办法级结论 (35)5 结语 (37)致谢 (38)参考文献 (39)1 引言1.1. 信息熵的概念1948年,美国科学家香农(C .E .Shannon)发表了一篇著名的论文《通信的数学理论》。

计算图像间互信息的报告

西北工业大学自动化学院信息工程专业信息论实验报告计算图像间的互信息09030702 2007302171 马志强2009/10/20摘要:基于Matlab程序,计算出图像的熵和两幅差异不大的图像之间的互信息,从而加深对互信息和熵值的理解.关键字:Matlab工程应用,信息熵与互信息.一.实验目的:利用Matlab计算两幅差异不大的图片熵值和互信息的值,并通过对图片差异较大区域进行裁剪,增多两个图片相同的区域,从而使得两图片的互信息的值增加,重发以上的操作多次,达到可获得的互信息的最大值,将获得的两个图片进行比较,验证互信息是否会根据图片拥有更多的相似区域而有所增大。

二.实验步骤:1.获取图片:由于rgb图像的像素范围过大,所以实验所用的图片采用像素范围只有0—255的gray图像(灰度图像);可以通过对同一张彩色图片进行灰度处理,也可以直接通过摄像设备获取灰度图像,拍照时应该注意尽量保持两张图片的差异尽可能的小,原因在于人为的摄像中存在不可避免的误差,从而导致最后的结果中的互信息值过于小,即使通过剪裁等手段也无法有效提高互信息的值;将选择好的图片进行剪裁,如果是直接拍摄的两张图片,可以略过此步骤,方法是只减少图片中的极少部分的像素,而且更改的像素希望是条状,然后保存两张图片,供实验中使用。

2.上机操作:将事先准备好的程序输入到Matlab中,利用Matlab的图片处理及转换功能,计算出图像的熵值和两个图像的互信息值,进行比较,以下附图及部分程序:3.记录数据以上程序运行出的结果分列如下:本部分程序用于计算出下面的图片的熵值img=rgb2gray(a);b=imread('2.jpg');[M,N]=size(img);temp=zeros(M,N);figure,imshow(img);%To calculate the statistical character of image¡¯s gray level, which means to calculate the number of each grayfor m=1:M;for n=1:N;if img(m,n)==0;i=1;elsei=img(m,n);endtemp(i)=temp(i)+1;endendtemp=temp./(M*N);%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% Calculate the Entropy according to the defination%%%% %%%%%%%%%%%%%%%%%%%%%%%%%%%%%EntropyResult=0;for i=1:length(temp)if temp(i)==0;EntropyResult=EntropyResult;elseEntropyResult=EntropyResult-temp(i)*log2(temp(i));endend以下程序段用于计算下面两幅图片的互信息:a=rgb2gray(a);b=imread('2.jpg');b=rgb2gray(b);%mi = MI(a,b)%CaculateMI of a and b in the region of the overlap part %To calculate the overlapping regions[Ma,Na] = size(a);[Mb,Nb] = size(b);M=min(Ma,Mb);N=min(Na,Nb);hab= zeros(256,256);ha = zeros(1,256);hb= zeros(1,256);if max(max(a))~=min(min(a))a = (a-min(min(a)))/(max(max(a))-min(min(a)));elsea = zeros(M,N);endif max(max(b))-min(min(b))b = (b-min(min(b)))/(max(max(b))-min(min(b)));elseb = zeros(M,N);enda = double(int16(a*255))+1;b = double(int16(b*255))+1;for i=1:Mfor j=1:Nindexx= a(i,j);indexy= b(i,j) ;hab(indexx,indexy) = hab(indexx,indexy)+1;ha(indexx) = ha(indexx)+1;hb(indexy) = hb(indexy)+1;endendhsum= sum(sum(hab));index = find(hab~=0);p = hab/hsum;Hab= sum(sum(-p(index).*log(p(index))));hsum= sum(sum(ha));index = find(ha~=0);p = ha/hsum;Ha = sum(sum(-p(index).*log(p(index))));hsum= sum(sum(hb));index = find(hb~=0);p = hb/hsum;Hb= sum(sum(-p(index).*log(p(index))));mi = Ha+Hb-HabEntropyResult =1.9475其中EntropyResult为图片的信息熵,mi表示的是两个图片的互信息;以下数据为对图片进行10次修改获得的互信息:mi=0.0512最后获得的两张图片,基本相同,如下图所示:三.实验结论:利用Matlab能够实现对两幅图片互信息的计算,扩展到工程中可为求项目的相似度提供有力的参考,同时,利用互信息能够高效地发现共通之处,就相同的部分采取措施,以获得希望达到的目的,如模拟仿真等,另外通过实验加深了对互信息及信息熵的理解,为以后的工作和学习提供了方便。

波形的信息熵 matlab

波形的信息熵 matlab波形的信息熵是一种在信号处理领域中常用的指标,用来衡量信号的信息量和其难以压缩的程度。

信息熵的大小与信号的复杂性和随机性密切相关,通常被用来分析和处理一些难以直接控制和预测的信号。

在MATLAB中,计算波形的信息熵可以使用熵函数(entropy)来完成。

该函数可以接受一个一维向量作为输入,并返回其信息熵的值,其基本语法如下:entropy(x)其中x表示输入的一维向量,该函数不仅可以计算离散信号的熵,也可以计算连续信号的熵值。

在使用熵函数计算信息熵时,需要注意如下几个问题:1、数据的类型:数据可以是double或single类型的,但不能是int或uint类型的。

2、数据的一维向量的大小:向量长度需要大于1。

3、数据的范围:数据的范围不能超过double类型的最大值。

4、数据的精度:数据的精度至少需要保留到小数点后15位。

下面我们就用一个简单的例子来说明如何使用熵函数计算波形的信息熵。

假设我们有一个包含200个元素的随机信号,其波形如下所示:首先,我们需要将波形数据导入MATLAB工作区中。

我们可以使用以下命令将数据保存在名为data的变量中:data = [ 0.739 0.040 0.786 0.061 0.783 0.998 0.020 0.123 0.679 0.212 0.803 0.804 0.734 0.112 0.007 0.579 0.512 0.433 0.120 0.329 0.5860.725 0.814 0.449 0.119 0.731 0.861 0.632 0.086 0.241 0.073 0.599 0.316 0.390 0.035 0.352 0.966 0.645 0.541 0.317 0.517 0.970 0.7970.732 0.685 0.185 0.550 0.807 0.275 0.864 0.297 0.029 0.546 0.038 0.419 0.072 0.751 0.423 0.925 0.354 0.750 0.679 0.468 0.760 0.3020.271 0.971 0.425 0.145 0.293 0.938 0.215 0.098 0.718 0.081 0.101 0.863 0.162 0.249 0.896 0.757 0.108 0.006 0.268 0.253 0.158 0.3180.142 0.685 0.047 0.864 0.114 0.284 0.489 0.300 0.904 0.684 0.038 0.114 0.838 0.485 0.163 0.857 0.723 0.251 0.978 0.924 0.299 0.0190.032 0.974 0.953 0.737 0.339 0.419 0.196 0.478 0.096 0.613 0.569 0.108 0.461 0.589 0.414 0.308 0.402 0.829 0.205 0.983 0.766 0.1220.082 0.798 0.574 0.369 0.123 0.264 0.199 0.365 0.919 0.618 0.513 0.290 0.414 0.885 0.136 0.336 0.460 0.983 0.020 0.743 0.756 0.7550.411 0.176 0.418 0.766 0.517 0.069 0.581 0.272 0.175 0.552 0.071 0.622 0.621 0.686 0.694 0.222 0.347 0.146 0.004 0.982 0.541 0.0150.496 0.524 0.599 0.021 0.211 0.765 0.270 0.642 0.149 0.291 0.822 0.640 0.919 0.986 0.108 0.967 0.841 0.323 0.076 0.760 0.806 0.4380.026 0.983 0.341 0.885 0.034 0.642 0.563 0.052 0.506 0.506 0.265 0.796 0.028 0.567 0.373 0.690 0.847 0.066 0.591 0.993 0.809 0.6300.565 0.397 0.551 0.932 0.486 0.756 0.076 0.411 0.278 0.665 0.970 0.052 0.807 0.100 0.563 0.766 0.532 0.762 0.017 0.296 0.886 0.1180.759 0.829 0.676 0.431 0.056 0.964 0.868 0.216 0.446 0.963 0.437 0.196 0.184 0.659 0.620 0.784 0.791 0.290 0.514 0.087 0.987 0.6970.401 0.055 0.148 0.421 0.500 0.839 0.148 0.498 0.280 0.737 0.304 0.232 0.749 0.858 0.086 0.908 0.408 0.276 0.689 0.104 0.931 0.6490.817 0.491 0.697 0.287 0.018 0.618 0.9890.754 0.600 0.943 0.947 0.329 0.082 0.787 0.651 0.942 0.228 0.973 0.184 0.383 0.122 0.4960.466 0.066 0.702 0.925 0.811 0.031 0.850 0.047 0.159 0.286 0.161 0.083 0.952 0.144 0.345 0.712 0.260 0.265 0.353 0.726 0.333 0.1770.844 0.657 0.961 0.700 0.912 0.999 0.097 0.217 0.147 0.279 0.408 0.181 0.528 0.294 0.525 0.919 0.684 0.788 0.780 0.684 0.953 0.0050.626 0.387 0.208 0.189 0.015 0.376 0.111 0.884 0.381 0.593 0.122 0.508 0.676 0.929 0.093 0.396 ];接下来,我们可以使用entropy函数计算该信号的信息熵:H = entropy(data)该命令将计算出data向量的信息熵,并将结果赋值给H变量。

熵值法matlab

熵值法matlab

熵值法是一种用于评价多指标决策的方法,可以用于在多个选择方案中找到最佳的解决方案。

在Matlab中,可以使用一些函数和工具箱来实现熵值法。

其中,entropy函数是用于计算熵值的函数,a=[a1,a2,…,an]是一个包含n个元素的向量,entropy(a)将返回a 的熵值。

在计算熵值时,还需要使用归一化函数normalize,该函数将向量归一化为概率分布向量。

例如,a=[1,2,3],normalize(a)将返回[0.1667,0.3333,0.5],表示a中每个元素出现的概率分别为0.1667,0.3333和0.5。

除了这些基本函数外,还可以使用fuzzy工具箱进行模糊多指标决策分析。

该工具箱提供了模糊综合评价方法,将多个指标的模糊信息转化为模糊综合评价值。

使用fuzzy工具箱,可以通过以下步骤进行模糊多指标决策分析:

1. 确定决策问题和决策指标。

2. 对每个指标进行模糊化。

3. 对每个指标进行标准化,并计算每个指标的权重。

4. 对每个指标的指标值进行熵值计算,并计算每个指标的信息熵。

5. 计算每个指标的贡献度和权重。

6. 将每个指标的贡献度和权重相加,得到最终的综合评价值。

总之,熵值法是一种简单有效的多指标决策方法,可以使用Matlab中提供的函数和工具箱来实现。

使用熵值法可以在多个选择

方案中找到最佳的解决方案,为决策提供有力的支持。

matlab样本熵分析

matlab样本熵分析【matlab样本熵分析】1. 引言在实际问题求解中,数据的复杂性和多样性经常导致难以从数据中得出有用的信息。

为了更好地理解和分析数据,在信号处理、图像处理以及模式识别领域中,熵函数被广泛应用。

在这篇文章中,我们将探讨一种基于 MATLAB 的方法,即样本熵分析,用于从数据中提取有关随机性和复杂性的信息。

2. 熵的概念熵是信息论中一个关键的概念,描述了随机变量的不确定性。

熵越大,表示随机变量越不确定,而熵越小,则表示随机变量越确定。

在我们的数据分析中,熵可以被用来衡量数据集的复杂性和不规律性。

3. 样本熵的计算在 MATLAB 中,可以使用以下步骤计算样本熵:3.1 数据准备需要准备一组数据用于计算样本熵。

这可以是任何类型的数据,时间序列数据、图像数据或声音数据。

3.2 确定样本长度样本长度是指用于计算样本熵的数据窗口的大小。

较小的样本长度会导致较短的时间尺度分析,而较大的样本长度则会产生较长的时间尺度分析。

在选择样本长度时,需要根据数据的实际情况和分析目的进行权衡。

3.3 计算样本熵样本熵的计算涉及到两个关键步骤:3.3.1 生成符号序列将数据分成不相交的样本长度窗口。

根据每个样本长度窗口中的数据值,将其映射到一系列符号。

符号的选择可以根据问题的具体要求来确定,可以将数据值离散化到不同的取值范围内,或者使用统计方法将数据映射为不同的符号。

3.3.2 计算样本熵使用生成的符号序列,可以通过应用香农熵的公式来计算样本熵。

香农熵是信息论中常用的一种熵度量方式,用于衡量随机变量的平均信息量。

3.4 统计分析完成样本熵的计算后,可以进行进一步的统计分析,例如绘制样本熵的分布图、计算平均样本熵或计算不同样本长度下的样本熵。

4. 优势和应用4.1 随机性分析样本熵可以用于分析数据中的随机性和不规律性。

通过计算样本熵,我们可以了解数据的复杂程度,并获取有关数据中的随机特征的信息。

4.2 异常检测样本熵可以作为一种异常检测的指标。

信息熵的matlab程序实例讲课稿

信息熵的m a t l a b程序实例求一维序列的信息熵(香浓熵)的matlab程序实例对于一个二维信号,比如灰度图像,灰度值的范围是0-255,因此只要根据像素灰度值(0-255)出现的概率,就可以计算出信息熵。

但是,对于一个一维信号,比如说心电信号,数据值的范围并不是确定的,不会是(0-255)这么确定,如果进行域值变换,使其转换到一个整数范围的话,就会丢失数据,请高手指点,怎么计算。

比如数字信号是x(n),n=1~N(1)先用Hist函数对x(n)的赋值范围进行分块,比如赋值范围在0~10的对应第一块,10~20的第二块,以此类推。

这之前需要对x(n)做一些归一化处理(2)统计每一块的数据个数,并求出相应的概率(3)用信息熵公式求解以上求解方法获得的虽然是近似的信息熵,但是一般认为,这么做是没有问题的求一维序列的信息熵的matlab程序代码如下:(已写成调用的函数形式)测试程序:fs=12000;N=12000;T=1/fs;t=(0:N-1)*T;ff=104;sig=0.5*(1+sin(2*pi*ff*t)).*sin(2*pi*3000*t)+rand(1,length(t));Hx=yyshang(sig,10)%———————求一维离散序列信息熵matlab代码function Hx=yyshang(y,duan)%不以原信号为参考的时间域的信号熵%输入:maxf:原信号的能量谱中能量最大的点%y:待求信息熵的序列%duan:待求信息熵的序列要被分块的块数%Hx:y的信息熵%duan=10;%将序列按duan数等分,如果duan=10,就将序列分为10等份x_min=min(y);x_max=max(y);maxf(1)=abs(x_max-x_min);maxf(2)=x_min;duan_t=1.0/duan;jiange=maxf(1)*duan_t;% for i=1:10% pnum(i)=length(find((y_p>=(i-1)*jiange)&(y_p<i*jiange)));% endpnum(1)=length(find(y<maxf(2)+jiange));for i=2:duan-1pnum(i)=length(find((y>=maxf(2)+(i-1)*jiange)&(y<maxf(2)+i*jiange))); endpnum(duan)=length(find(y>=maxf(2)+(duan-1)*jiange));%sum(pnum)ppnum=pnum/sum(pnum);%每段出现的概率%sum(ppnum)Hx=0;for i=1:duanif ppnum(i)==0Hi=0;elseHi=-ppnum(i)*log2(ppnum(i));endHx=Hx+Hi;endend%----------------扩展阅读:实验一:计算离散信源的熵一、实验设备:1、计算机2、软件:Matlab二、实验目的:1、熟悉离散信源的特点;2、学习仿真离散信源的方法3、学习离散信源平均信息量的计算方法4、熟悉Matlab 编程;三、实验内容:1、写出计算自信息量的Matlab 程序2、写出计算离散信源平均信息量的Matlab 程序。

matlab二值化图像处理让熵为1

matlab二值化图像处理让熵为1 图像二值化是数字图像处理技术中的一项基本技术,二值化图像的显示与打印十分方便,存储与传输也非常容易,在目标识别、图像分析、文本增强、字符识别等领域得到广泛应用。

图像二值化是将灰度图像转化为只有黑白两类像素的图像,大多采用阑值化算法处理。

在不同的应用中,阔值的选取决定着图像特。

征信息的保留。

因此,图像二值化技术的关键在于如何选取阀值。

最大病原理:最大嫡原理是在1957年由提出的,其主要思想是,在只掌握关于未知分布的部分知识时,应该选取符合这些知识但筛值最大的概率分布。

因为在这种情况下,符合已知知识的概率分布可能不止一个,我们知道,烯定义的实际上是一个随机变量的不确定性,烯最大的时候,说明随机变品最不确定,换句话说,也就是随机变量最随机,对其行为做准确预测最困难。

图像分割中最大熵的引入:在图像分割中若假定以灰度级T分割图像,则图像中低于灰度级T的像素点构成目标物体,高于灰度级T的像素点构成背景那么各个灰度级在图像分割后的两区域中的概率如下:O;t iNN(O B:INNN-(t+1其中Ni为图像中灰度级为i的像素点个数,Nt为灰度级从0~t的像素点总和,N为图像总像素点,t为假定灰度阈值T。

图像分割是根据图像的直方图和结构特性或者一些具体的应用需求将图像划分成两个或多个互不相交的子区域的过程,这些子区域是在特定意义下的具有相同属性的像素的连通集合。

例如,一幅图像中不同目标物体所占的图像区域、背景所占的背景区域等都属于这样的连通集合概念。

对图像分割的定义有多种不同的解释,人们普遍接受的是通过集合定义的图像分割。

用集合R表示整个图像区域,那么对整个图像的分割可以等价于将集合R分成n个满足准则的区域。

先将彩色图像转换为灰度图像灰度图(Grayscale)是指只含亮度信息,不含色彩信息的图像,就像我们平时看到亮度由暗到明的黑白服片。

因此,要表示灰度图,就需要把亮度值进行量化。

信息熵与图像熵的计算

实验一信息熵与图像熵计算一、实验目的1.复习MATL AB 的基本命令,熟悉MATL AB 下的基本函数。

2.复习信息熵基本定义, 能够自学图像熵定义和基本概念。

二、实验仪器、设备1.计算机-系统最低配置256M 内存、P4 CPU。

2.Matlab仿真软件- 7.0 / 7.1 / 2006a等版本Mat lab 软件。

三、实验内容与原理(1)内容:1.能够写出MATLAB源代码,求信源的信息熵。

2.根据图像熵基本知识,综合设计出M ATLAB程序,求出给定图像的图像熵。

(2)原理1. MATLAB中数据类型、矩阵运算、图像文件输入与输出知识复习。

2.利用信息论中信息熵概念,求出任意一个离散信源的熵(平均自信息量)。

自信息是一个随机变量,它是指某一信源发出某一消息所含有的信息量。

所发出的消息不同,它们所含有的信息量也就不同。

任何一个消息的自信息量都代表不了信源所包含的平均自信息量。

不能作为整个信源的信息测度,因此定义自信息量的数学期望为信源的平均自信息量:信息熵的意义:信源的信息熵H是从整个信源的统计特性来考虑的。

它是从平均意义上来表征信源的总体特性的。

对于某特定的信源,其信息熵只有一个。

不同的信源因统计特性不同,其熵也不同。

3.学习图像熵基本概念,能够求出图像一维熵和二维熵。

图像熵是一种特征的统计形式,它反映了图像中平均信息量的多少。

图像的一维熵表示图像中灰度分布的聚集特征所包含的信息量,令Pi 表示图像中灰度值为i的像素所占的比例,则定义灰度图像的一元灰度熵为:255log i iip p ==∑H图像的一维熵可以表示图像灰度分布的聚集特征,却不能反映图像灰度分布的空间特征,为了表征这种空间特征,可以在一维熵的基础上引入能够反映灰度分布空间特征的特征量来组成图像的二维熵。

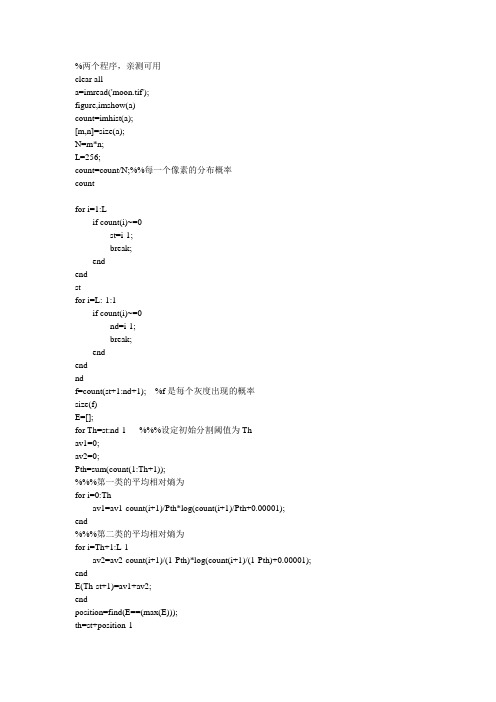

两个matlab实现最大熵法图像分割程序

%两个程序,亲测可用clear alla=imread('moon.tif');figure,imshow(a)count=imhist(a);[m,n]=size(a);N=m*n;L=256;count=count/N;%%每一个像素的分布概率countfor i=1:Lif count(i)~=0st=i-1;break;endendstfor i=L:-1:1if count(i)~=0nd=i-1;break;endendndf=count(st+1:nd+1); %f是每个灰度出现的概率size(f)E=[];for Th=st:nd-1 %%%设定初始分割阈值为Thav1=0;av2=0;Pth=sum(count(1:Th+1));%%%第一类的平均相对熵为for i=0:Thav1=av1-count(i+1)/Pth*log(count(i+1)/Pth+0.00001);end%%%第二类的平均相对熵为for i=Th+1:L-1av2=av2-count(i+1)/(1-Pth)*log(count(i+1)/(1-Pth)+0.00001); endE(Th-st+1)=av1+av2;endposition=find(E==(max(E)));th=st+position-1for i=1:mfor j=1:nif a(i,j)>tha(i,j)=255;elsea(i,j)=0;endendendfigure,imshow(a);%%%%%%%%%%%%%%%%%%%%%2-d 最大熵法(递推方法) %%%%%%%%%%% clear all;clc;tica=imread('trial2_2.tiff');figure,imshow(a);a0=double(a);[m,n]=size(a);h=1;a1=zeros(m,n);% 计算平均领域灰度的一维灰度直方图for i=1:mfor j=1:nfor k=-h:hfor w=-h:h;p=i+k;q=j+w;if (p<=0)|( p>m)p=i;endif (q<=0)|(q>n)q=j;enda1(i,j)=a0(p,q)+a1(i,j);endenda2(i,j)=uint8(1/9*a1(i,j));endendfxy=zeros(256,256);% 计算二维直方图for i=1:mfor j=1:nc1=a0(i,j);d=double(a2(i,j));fxy(c1+1,d+1)=fxy(c1+1,d+1)+1;endendPxy=fxy/m/n;% figure,% mesh(Pxy);% title('二维灰度直方图');%计算HlHl=0;for i=1:256for j=1:256if Pxy(i,j)>0.00001Hl=Hl-Pxy(i,j)*log(Pxy(i,j));elseHl=Hl;endendend%计算PA,HAPA=zeros(256,256);HA=zeros(256,256);PB=zeros(256,256);PA(1,1)=Pxy(1,1);if PA(1,1)<1e-4HA(1,1)=0;elseHA(1,1)=-PA(1,1)*log(PA(1,1));endfor i=2:256PA(i,1)=PA(i-1,1)+Pxy(i,1);if Pxy(i,1)>0.00001HA(i,1)=HA(i-1,1)-Pxy(i,1)*log(Pxy(i,1));elseHA(i,1)=HA(i-1,1);endendfor j=2:256PA(1,j)=PA(1,j-1)+Pxy(1,j);if Pxy(1,j)>0.00001HA(1,j)=HA(1,j-1)-Pxy(1,j)*log(Pxy(1,j));elseHA(1,j)=HA(1,j-1);endendfor i=2:256for j=2:256PA(i,j)=PA(i-1,j)+PA(i,j-1)-PA(i-1,j-1)+Pxy(i,j);if Pxy(i,j)>0.00001HA(i,j)=HA(i-1,j)+HA(i,j-1)-HA(i-1,j-1)-Pxy(i,j)*log(Pxy(i,j));elseHA(i,j)=HA(i-1,j)+HA(i,j-1)-HA(i-1,j-1);endendend%计算最大熵PB=1-PA;h=zeros(256,256);hmax=0;for i=1:256for j=1:256if abs(PA(i,j))>0.00001&abs(PB(i,j))>0.00001h(i,j)=log(PA(i,j)*PB(i,j))+HA(i,j)/PA(i,j)+(Hl-HA(i,j))/PB(i,j);elseh(i,j)=0;endif h(i,j)>hmaxhmax=h(i,j);s=i-1;t=j-1;endendendz=ones(m,n);for i=1:mfor j=1:nif a0(i,j)<=s&a2(i,j)<=t%if double(a(i,j))+double(a2(i,j))+a3(i,j)<=s+t+qz(i,j)=0;elsez(i,j)=255;endendendhmaxstfigure,imshow(z);toc。

熵权法代码matlab

熵权法代码matlab熵权法是一种常用的综合评价方法,它基于信息论原理,用于解决多指标评价问题。

熵权法通过计算各指标的熵值,确定权重,然后结合标准化后的数据进行综合评价。

在MATLAB中,我们可以通过编写代码实现熵权法的计算过程,从而对不同对象进行综合评价。

一、熵权法简介熵权法是一种基于信息论原理的评价方法。

它认为,某个指标的信息熵越小,该指标的权重越大。

因此,在综合评价过程中,需要先计算各指标的熵值,然后根据熵值确定权重。

熵权法具有以下优点:1.能够反映指标之间的差异性。

2.能够避免主观权重的影响。

3.适用于不同类型的数据。

二、熵权法在MATLAB中的实现在MATLAB中,我们可以通过以下步骤实现熵权法的计算:1.导入数据:读取评价对象的数据矩阵。

2.计算绩效矩阵:根据输入数据计算各对象的绩效矩阵。

3.计算权重:根据熵权法计算各指标的权重。

4.计算综合得分:结合权重和标准化数据,计算各对象的综合得分。

5.排名:根据综合得分对各对象进行排名。

三、应用案例及代码解析以下是一个熵权法在MATLAB中的应用案例:【案例】1.导入数据:data2.计算绩效矩阵:```matlabperformance_matrix = zeros(size(data, 1), size(data, 2));for i = 1:size(data, 1)for j = 1:size(data, 2)performance_matrix(i, j) = data(i, j);endend```3.计算权重:```matlabweight = cell(size(performance_matrix, 2), 1);for j = 1:size(performance_matrix, 2)entropy = 0;for i = 1:size(performance_matrix, 1)prob = performance_matrix(i, j) /sum(performance_matrix(:, j));entropy = entropy + prob * log2(prob);endweight{j} = 1 / (1 + entropy);end```4.计算综合得分:```matlabcomprehensive_score = zeros(size(performance_matrix, 1), 1);for i = 1:size(performance_matrix, 1)comprehensive_score(i) = sum(performance_matrix(i, :) .* weight);end```5.排名:```matlab[rank, index] = sort(comprehensive_score, "desc");```四、总结与展望熵权法作为一种常用的综合评价方法,在MATLAB中的实现可以帮助我们有效地解决多指标评价问题。

matlab 熵值法

matlab 熵值法

熵值法是一种可以用来评估多属性决策问题的方法。

它可以帮助我们分析不同属性之间的相对重要性,并根据这些数据进行决策。

在MATLAB中,熵值法是一种非常有用的工具。

要使用熵值法,首先需要确定各个属性的权重。

这可以通过主观评价或客观统计方法来确定。

一旦确定了权重,就可以使用熵值法来进行决策。

在MATLAB中,使用熵值法进行多属性决策的步骤如下:

1. 输入数据。

将属性和每个属性的值输入MATLAB。

2. 计算归一化矩阵。

将每个属性值除以该属性的总和,这样可以将每个属性的值转换为百分比。

3. 计算熵值。

对于每个属性,计算其所有值的熵值。

熵值越高,不确定性就越大。

可以使用MATLAB中的熵函数来计算熵值。

4. 计算权重。

对于每个属性,计算其权重。

这可以通过将其熵值除以所有属性的熵值之和来实现。

5. 计算得分。

将每个属性的值乘以其相应的权重,然后将它们相加。

这将得到每个决策的得分,从而可以选择最佳决策。

总的来说,MATLAB中的熵值法可以帮助人们更好地了解多属性决策问题,从而做出更好的决策。

这是一个非常实用的工具,值得人们深入学习和研究。

熵权法matlab计算过程

熵权法matlab计算过程

熵权法是一种常见的多指标决策方法,用于确定各指标的权重。

Matlab是一种常用的计算机软件,可以方便地进行熵权法的计算过程。

在使用Matlab进行熵权法计算时,需要进行如下步骤:

1. 将指标数据输入Matlab,可以使用Excel等软件导出CSV格式的数据文件,再通过Matlab的读取函数导入数据。

2. 计算各指标的归一化熵值,这可以通过编写函数实现,具体方法是将指标数据进行归一化处理,然后计算每个指标的熵值。

3. 计算各指标的熵权系数,这可以通过编写函数实现,具体方法是将各指标的归一化熵值进行加权平均,得到各指标的熵权系数。

4. 检验所得熵权系数的合理性,可以计算各指标的加权得分,得分越高的指标说明其熵权系数越大,权重越大。

5. 根据熵权系数进行多指标决策,可以将各指标的加权得分相加,得到最终得分,得分越高的方案或选择越优。

以上就是熵权法在Matlab中的计算过程,通过这些步骤可以方便地进行多指标决策,确定各指标的权重和方案的优劣。

- 1 -。