项目7 Flume日志采集系统-任务7.2 Flume采集方案说明与可靠性保证

日志采集原则 与技术措施

日志采集原则与技术措施

日志采集是指通过记录系统、应用程序、网络设备等各种信息的方式,将这些信息集中保存起来,以便后续的分析和监控。

在进行日志采集时,需要遵循一些原则和采取一些技术措施,以确保日志的完整性、可靠性和安全性。

首先,日志采集的原则包括:

1. 完整性原则,确保采集的日志信息能够全面地反映系统、应用程序或网络设备的运行状态,不漏报、不误报。

2. 可靠性原则,保证采集到的日志信息是真实可信的,不受篡改和伪造。

3. 实时性原则,尽可能实时地采集日志信息,以便及时发现和解决问题。

4. 合规性原则,遵循相关法律法规和行业标准,确保日志采集的合规性。

其次,为了实现这些原则,可以采取以下技术措施:

1. 使用专业的日志采集工具,如Logstash、Fluentd、Splunk 等,这些工具能够帮助实现日志的集中采集、存储和分析。

2. 配置日志采集策略,根据系统和应用程序的特点,制定合理

的日志采集策略,包括采集的内容、频率、存储方式等。

3. 加密传输,采用加密的传输协议,如SSL/TLS,确保日志在

传输过程中的安全性。

4. 访问控制,对日志采集系统进行严格的访问控制,只允许授

权人员访问和操作日志信息。

5. 定期审计,定期对采集到的日志信息进行审计和分析,及时

发现异常情况并采取相应的措施。

总之,日志采集是信息安全管理中非常重要的一环,遵循相关

的原则并采取适当的技术措施,能够有效地保障系统和网络的安全。

1+x大数据习题(含答案)

1+x大数据习题(含答案)一、单选题(共93题,每题1分,共93分)1.HDFS 启动成功的标识是()A、jps 显示 NameNodeB、jps 显示 DataNodeC、jps 显示 SecondaryNameNodeD、jps 显示NameNode\DataNode\SecondaryNameNode正确答案:D2.HDFS首先把大数据文件切分成若干个小的数据块,再把这些数据块分别写入不同的节点,这些负责保存文件数据的节点被称为?()A、NameNodeB、DataNodeC、SecondaryNameNodeD、Block正确答案:B3.关于SecondaryNameNode哪项是正确的?A、它对内存没有要求B、SecondaryNameNode应与NameNode部署到一个节点C、它是NameNode的热备D、它的目的是帮助NameNode合并编辑日志,减少NameNode启动时间正确答案:D4.用于检查节点自身的健康状态的进程是()A、ResourceManagerB、NodeManagerC、NameNodeD、DataNode正确答案:B5.关于HDFS回收站描述正确的是?()A、HDFS回收站默认开启B、HDFS回收站中的文件文件像Windows回收站一样,如果不清空回收站,文件会一直保留在回收站。

C、HDFS为每一个用户都创建了回收站,这个类似操作系统的回收站。

位置是/user/用户名/.Trash/D、用户不能手动清空回收站中的内容正确答案:Cnode 在启动时自动进入安全模式,在安全模式阶段,说法错误的是()A、安全模式目的是在系统启动时检查各个 DataNode 上数据块的有效性B、根据策略对数据块进行必要的复制或删除C、当数据块最小百分比数满足的最小副本数条件时,会自动退出安全模式D、文件系统允许有修改正确答案:D7.大数据分析平台的实施流程顺序是()。

A与甲方确定总体计划B组建项目团队C部署环境准备D应用集成及数据集成E 系统安装和调试A、BACEDB、CABEDC、ADCBED、DABCE正确答案:A8.列出mysql数据库中的所有数据库sqoop命令是?A、sqoop import –connectB、sqoop list-tables –connectC、sqoop create-hive-table –connectD、sqoop list-databases –connect正确答案:D9.在确认客户需求,进行确认需求调研的时候,以下说法正确的是()。

flume的安装和使用总结 -回复

flume的安装和使用总结-回复Flume是一个开源的、分布式、可靠和高可用的系统,用于将大量的日志数据从多个服务器收集并将其传输到中心化的数据存储或数据处理平台。

本文将详细介绍Flume的安装和使用过程,以及一些常见的使用方法和场景。

一、Flume的安装1. 准备工作在安装Flume之前,我们需要确保满足以下的准备工作:- JDK的安装:Flume是基于Java开发的,所以我们需要先安装JDK,并配置好环境变量。

- 选择并下载Flume的发布版本:可以从Apache官网上下载合适的Flume发布版本,选择与你服务器的操作系统和架构相匹配的版本。

2. 安装Flume下面是Flume的安装步骤:- 将下载好的Flume发布版本解压到一个合适的目录下,例如:/opt/flume。

- 配置Flume环境变量,在~/.bashrc文件的最后添加以下内容:bashexport FLUME_HOME=/opt/flumeexport PATH=PATH:FLUME_HOME/bin- 使环境变量生效,执行以下命令:bashsource ~/.bashrc- 在Flume的安装目录下创建一个新的目录,用于存放Flume的配置文件:bashmkdir FLUME_HOME/conf- 复制Flume的模板配置文件(位于FLUME_HOME/conf目录下)到新创建的配置目录,并对其进行修改:bashcp FLUME_HOME/conf/flume-conf.properties.template FLUME_HOME/conf/flume-conf.properties- 编辑flume-conf.properties配置文件,并根据自己的需求进行相应的修改。

3. 配置FlumeFlume的配置文件(flume-conf.properties)需要根据实际使用情况进行相应的修改。

下面简要介绍几个常见的配置项:- agent.sources:定义数据源,配置输入数据的来源,例如:日志文件、网络端口等。

网站流量日志分析(数据采集之Flume采集)

⽹站流量⽇志分析(数据采集之Flume采集)⽬录⽹站流量⽇志分析的意义通过分析⽤户的⾏为数据让更多的⽤户沉淀下来变成会员赚取更多的钱。

如何进⾏⽹站分析流量分析- 质量分析在看重数量的同时需要关注流量的质量所谓的质量指的是流量所能带来产⽣的价值。

- 多维度细分维度指的是分析的问题的⾓度在不同的维度下问题所展⽰的特性是不⼀样的内容导航分析从页⾯的⾓度分析⽤户的访问⾏为轨迹转化分析(漏⽃模型分析)从转化⽬标分析分析所谓的流失率转化率漏⽃模型:层层递减逐级流失的形象描述⽹站流量⽇志分析的数据处理流程按照数据的流转流程进⾏通俗概括就是数据从哪⾥来⼀直到数据到哪⼉去数据采集- 数据从⽆到有的过程:通过技术把客观事件量化成为数据(传感器收集服务器⽇志收集)- 数据搬运过程:把数据从⼀个存储介质传递到另⼀个存储介质中(Apache Flume)数据预处理- ⽬的:保证后续正式处理的数据是格式统⼀、⼲净规则的结构化数据- 技术:任何语⾔软件只要能够接受数据处理数据并且最终输出数据都可以⽤于数据预处理**选择MapReduce**- MR本⾝是java程序,语⾔⽐较熟悉可以⽆缝的调⽤java现有的开源库进⾏数据处理- MR是分布式的程序在预处理中如果数据量⽐较⼤可以分布式并⾏计算处理提⾼效率数据⼊库- 库:⾯向分析的数据仓库,也是就会Apache Hive- ⼊库的本质:经过ETL(抽取、转换、加载)把各个不同的数据源集中加载到数仓的分析主题下⾯。

数据分析- 本质:根据业务需求使⽤hive sql计算统计出各种不同的指标分析是⼀个持续的过程数据可视化尽量的使⽤图形表格的形式把分析的结果规律展⽰给别⼈看也称之为数据报表埋点数据采集数据从⽆到有的采集如何把⽤户的访问⾏为记录下来变成⽹站访问⽇志数据采集⽅式及其优缺点### ⽹站⽇志⽂件⽹站的web服务器⾃带⽇志记录的功能简单便捷的收集⼀些基础的属性信息常见的web服务器(Tomcat nginx apache server(httpd))优点:简单便捷⾃带功能不需要配置就可以使⽤缺点:收集的信息确定不利于维护收集的信息不够完整全⾯### 埋点JavaScript收集- ⽬标:不以影响⽤户的正常浏览体验作为标准数据采集分析锦上添花- 何为埋点```在待采集数据的页⾯上,预先置⼊⼀段JavaScript代码,当⽤户的某种⾏为满⾜JavaScript执⾏条件,触发JavaScript的执⾏,在执⾏的过程中进⾏数据的采集⼯作。

日志采集与分析系统

日志采集与分析系统日志采集与分析是一项重要的任务,它可以帮助我们监控系统的运行状况,分析和解决问题,优化系统性能,并且对于安全性管理也有着重要的作用。

下面我将详细介绍日志采集与分析系统的概念、实现方法以及其在实际应用中的意义。

一、日志采集与分析系统的概念日志采集与分析系统是指一种能够自动收集系统、应用程序和网络设备产生的日志信息,并对其进行分析、统计和展示的系统。

它的主要功能包括:收集来自不同系统的日志数据,存储日志数据,处理和分析日志数据以检测异常和问题,以及生成报告和可视化展示。

二、日志采集与分析系统的实现方法1.日志收集日志收集是系统的第一步,可以通过以下几种方式进行:(1)直接调用API:在应用程序中调用API来将日志数据直接发送给日志收集器。

(2)使用日志收集器:安装和配置日志收集器来自动收集日志信息。

(3)使用中间件:对于分布式系统,可以使用消息中间件来收集日志信息。

2.日志存储日志存储是为了方便后续的分析和查询,通常采用以下几种方式:(1)本地文件存储:将日志存储在本地文件中,可以按照时间或大小进行切分和归档。

(2)数据库存储:将日志存储在数据库中,方便查询和分析。

(3)云存储:将日志存储在云平台上,如AWSS3、阿里云OSS等,可以方便地进行可视化展示和分析。

3.日志处理与分析日志处理与分析是对日志数据进行解析、过滤和分析的过程,以检测异常和问题,并获取有价值的信息。

常用的方法包括:(1)日志解析:对日志进行解析,提取关键信息,如事件发生时间、事件类型、事件数据等。

(2)日志过滤:根据预设规则或条件来过滤日志,只保留关键和有价值的日志数据。

(3)日志分析:基于统计、机器学习或规则引擎等方法来进行日志数据的分析,以检测异常和问题。

4.可视化展示与报告生成通过可视化展示和报告生成,可以直观地了解系统的运行状况、异常和性能瓶颈,以及采取相应的措施。

通常有以下几种方式:(1)图表展示:以柱状图、折线图、饼图等形式展示系统的日志数据,如事件发生次数、占比等。

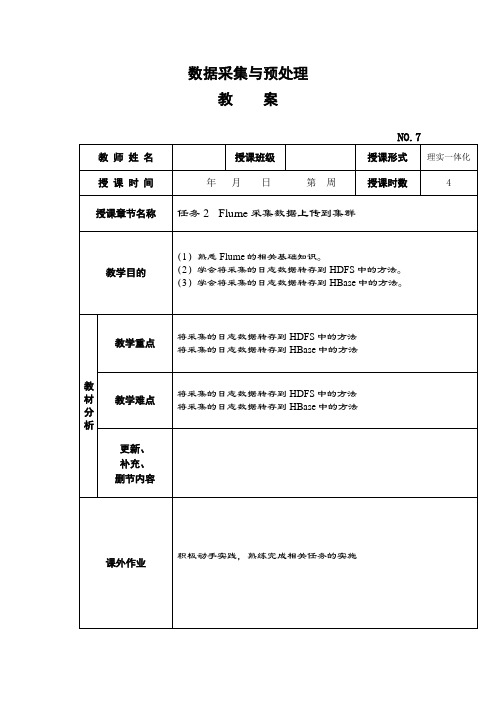

《数据采集与预处理》教学教案—07Flume采集数据上传到集群

启用时间上的“舍弃”,即 hdfs.path 解析时将根据 roundValue 中设置的 时间进行舍弃,时间单位根据 roundUnit 中的设置来确定

a1.Sinks.k1.hdfs.roundValue = 10 设定时间值

a1.Sinks.k1.hdfs.roundUnit minute

= 设定时间单位

;

org. apache. flume. Sink.

hbase.Regex Hbase Ev

entSerializer

设置 serializer 的处理类

—

要传递给序列化程序的属性(如

设置 HBase 的 column)

SimpleHbaseEventSerializer 的配置示例如表 3-11 所示。

示例说明 为 Agent 的 Channel 命名 为 Agent 的 Sink 命名 设置 type 的值 设置 HBase 的 table 的名称 设置 HBase 的 columnFamily

设置 serializer 的处理类

设置相应的正则表达式

\\[(.*?)\\]

agent.Sinks.hbaseSink-2.serializer.colNames = column-1,column-2,column-3,column-4

则。这里由于实例数据量较少,所以采用大小 128MB、时间 60s 作为文件 滚动规则。

2.Flume 采集数据上传到 HBase (1)利用 SimpleHbaseEventSerializer 序列化模式上传数据。 首 先 , 在 HBase 中 创 建 一 个 表 mikeal-hbase-table , 表 中 拥 有 familyclom1 和 familyclom2 两个列。 在 Flume 安 装 目 录 的 conf 目 录 中 创 建 并 配 置 test-flume-into-hbase.conf 文件。 test.log 文件作为实时数据采集源日志文件,选择本地文件目录 /data/flume- hbase-test/data 作为 Channel,选择 HBase 为 Sink(即数据流写 入 HBase)。 在 Flume 安装目录的 bin 目录中启动 Flume。

flume checkpoint原理

flume checkpoint原理Flume Checkpoint原理Flume是Apache基金会下的一个分布式、可靠的、可扩展的日志收集和聚合系统。

它的设计目标是高效地从多个数据源(如Web 服务器、应用程序日志等)收集大量数据,并将数据传输到各种目标(如HDFS、HBase、Kafka等)。

在Flume中,Checkpoint是一个非常重要的概念,它确保了数据的可靠传输和故障恢复。

Checkpoint是Flume用于确保数据传输的可靠性和一致性的机制。

当数据从源头开始流动时,Flume会周期性地将数据写入到一个称为“Channel”的缓冲区。

Channel是一个可靠的、持久化的、有序的队列,它在Flume Agent的两个组件之间传输数据。

为了确保数据的可靠传输,Flume将数据写入到Channel后,会生成一个Checkpoint,用于记录数据的传输状态。

在Flume中,Checkpoint是由一个称为“Transaction”的概念来实现的。

一个Transaction代表了一次数据传输的过程,它包含了一系列的事件(Event)。

当Flume将数据写入到Channel时,它会创建一个新的Transaction,并将数据写入到该Transaction中。

当数据写入完成后,Flume会提交该Transaction,将数据从Channel中删除,并生成一个Checkpoint来记录该Transaction 的状态。

Checkpoint的生成和管理是由Flume Agent的另一个组件称为“Sink”来完成的。

Sink负责将数据从Channel中读取出来,并将数据传输到目标存储系统。

在读取数据之前,Sink会先检查Checkpoint的状态,以确定从哪个位置开始读取数据。

如果发现有未提交的Transaction,Sink会首先将这些未提交的Transaction 提交,并将数据写入到目标存储系统。

日志采集模块设计方案

日志采集模块设计方案

日志采集模块是现代软件系统中非常重要的一部分,它可以帮

助开发人员和系统管理员监控系统运行状况、分析问题和优化性能。

在设计日志采集模块时,需要考虑以下几个方面:

1. 功能需求,日志采集模块需要能够收集系统各个部分的日志

信息,包括应用程序日志、系统日志、安全日志等。

它还需要支持

多种日志格式和协议,以便与不同类型的应用程序和系统集成。

2. 数据收集,日志采集模块需要能够实时、高效地收集日志数据,并能够处理大量的日志信息。

它还需要支持对数据进行过滤、

聚合和转换,以便后续的存储和分析。

3. 数据传输,采集到的日志数据需要能够安全可靠地传输到日

志存储或分析系统。

这可能涉及到使用加密、压缩和其他技术来保

护数据的完整性和隐私性。

4. 可扩展性,日志采集模块需要具有良好的可扩展性,能够适

应系统规模的变化和新的需求。

它还需要支持分布式部署,以便在

需要时能够进行水平扩展。

5. 故障处理,日志采集模块需要能够处理各种故障情况,包括网络故障、存储故障和日志格式错误等。

它需要具有自动重试、容错和告警机制,以便及时发现和解决问题。

6. 安全性,日志采集模块需要能够保护日志数据的安全性,防止数据被篡改或泄露。

它还需要支持身份验证和授权机制,以确保只有授权的用户能够访问和操作日志数据。

综上所述,设计日志采集模块需要综合考虑功能需求、数据收集、数据传输、可扩展性、故障处理和安全性等多个方面,以确保其能够满足现代软件系统对日志管理的需求。

flume知识点

flume知识点Flume知识点一、概述Flume是一个可靠、可扩展且可管理的分布式日志收集系统,用于将日志数据从多个源头(如Web服务器、数据库、应用程序等)收集到中央存储(如Hadoop、HBase、Kafka等)中。

它是Apache软件基金会的开源项目,广泛应用于大数据领域。

二、架构Flume的架构由三个主要组件组成:Source、Channel和Sink。

1. Source:负责收集数据并将其传递给Channel。

Flume提供了多种类型的Source,如Avro Source、Spooling Directory Source 等,可以根据不同的需求选择合适的Source。

2. Channel:用于存储从Source接收到的事件。

Flume提供了多种类型的Channel,如Memory Channel、File Channel等,可以根据数据量和性能需求选择合适的Channel。

3. Sink:负责将从Channel中获取的事件传递给目标存储。

Flume 提供了多种类型的Sink,如HDFS Sink、HBase Sink等,可以根据数据存储的类型选择合适的Sink。

三、工作流程Flume的工作流程可以分为三个阶段:数据采集、数据传输和数据存储。

1. 数据采集:在数据采集阶段,Flume通过Source组件从不同的数据源中收集数据。

Source可以按照配置文件中的规则来监控数据源,并将收集到的数据传递给Channel。

2. 数据传输:在数据传输阶段,Flume将从Source收集到的数据传输到Channel。

Channel可以存储一定量的数据,以便在高负载情况下进行缓冲。

3. 数据存储:在数据存储阶段,Flume通过Sink组件将数据从Channel传输到目标存储。

Sink可以根据配置文件中的规则将数据存储到不同的存储系统中。

四、高可靠性Flume具有高可靠性的特点,可以确保数据的安全传输和存储。

Flume架构原理详解

Flume多agent架构:该场景主要应用于收集FusionInsight集群外节点上的日 志,并经过多个Flume节点最终汇聚到集群内。

Source

Sink

Channel Log

Source

Channel

Sink HDFS

第2页

Flume架构(续)

Interceptor

events

Source

events

Channel Porcessor

Sink Runner

events

Channel Selector

Sink Processor

events

Channel

events

Channel

events

Sink

第3页

目录

1. Flume架构 2. Flume基本概念 3. Flume可靠性 4. Flume安装与配置

第9页

基本概念 - Channel Selector

Channel Selector允许Source基于预设的标准,从所有Channel 中,选择一个或多个Channel,即同一个数据源可以分发到不 同的目的。

内建的Channel Selectors类型:

复制Replicating:event被复制到相关的channel,即数据都放到 同一个目的地

可以根据键值选择发到不同的目的地。 Headers可以在上下文路由中使用扩展。

public interface Event { public Map<String, String> getHeaders(); public void setHeaders(Map<String, String> headers); public byte[] getBody(); public void setBody(byte[] body);

简述flume的主要作用

简述flume的主要作用Flume是一个大数据处理框架,主要用于在分布式环境中高效地收集、聚合和传输大规模数据。

它的主要作用是实现可靠地、高吞吐量地将数据从源头收集到目的地。

Flume的主要作用可以概括为以下几点:1. 数据收集:Flume可以从各种不同的数据源中收集数据,包括日志文件、消息队列、数据库等。

它提供了多种数据源的适配器,可以轻松地配置和管理数据源,实现数据的实时收集。

通过Flume的数据收集功能,用户可以方便地获取分布式环境中的大量数据。

2. 数据聚合:在数据收集的过程中,Flume可以将来自不同数据源的数据进行聚合。

它支持多种不同的聚合策略,如时间窗口、大小窗口等,可以根据用户的需求进行配置。

通过数据聚合功能,用户可以将分散在不同数据源中的数据汇总到一起,方便后续的处理和分析。

3. 数据传输:Flume可以将收集到的数据传输到指定的目的地。

目的地可以是Hadoop集群中的HDFS、HBase等存储系统,也可以是Kafka、Spark等数据处理系统。

Flume提供了多种传输协议和格式,可以灵活地配置和管理数据传输。

通过数据传输功能,用户可以将收集到的数据高效地传输到指定的位置,方便后续的数据处理和分析。

4. 数据可靠性:Flume具有高度的可靠性和容错性。

它可以在数据传输过程中进行数据重试、数据丢弃、数据备份等操作,保证数据的完整性和可靠性。

Flume还支持数据的事务性处理,可以保证数据的一致性和可靠性。

通过数据可靠性功能,用户可以放心地使用Flume进行数据收集和传输,不用担心数据丢失或损坏的问题。

5. 数据扩展性:Flume具有良好的扩展性,可以满足不同规模和需求的数据处理场景。

它采用了分布式架构和可插拔的组件模型,可以方便地进行水平扩展和功能扩展。

Flume的组件之间可以进行灵活的配置和组合,可以根据用户的需求定制和扩展功能。

通过数据扩展性功能,用户可以根据实际情况灵活地调整和扩展Flume的能力。

flume+mongodb流式日志采集技术文档

流式日志采集技术文档背景:由于工作需要,需要搭建一套流式日志采集系统,解决公司目前众多跨项目、跨部门、跨地域日志的问题,每天产生的日志通过flume从源头自动采集并过滤持久化到mongodb中。

前言:由于本人以前从未接触过Liunx,更别说flume和mongodb,加上网上这方面的资料页不是很全,故在这次搭建完成后,进行此次文档的整理技术:flume+mongodb。

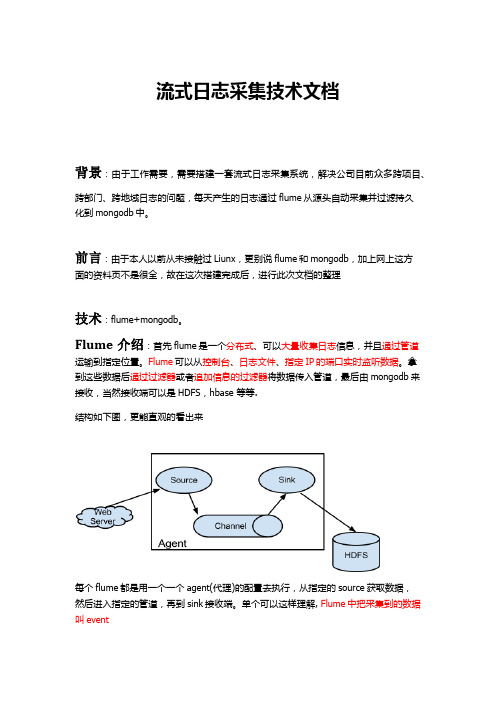

Flume介绍:首先flume是一个分布式、可以大量收集日志信息,并且通过管道运输到指定位置。

Flume可以从控制台、日志文件、指定IP的端口实时监听数据。

拿到这些数据后通过过滤器或者追加信息的过滤器将数据传入管道,最后由mongodb来接收,当然接收端可以是HDFS,hbase 等等.结构如下图,更能直观的看出来每个flume都是用一个一个agent(代理)的配置去执行,从指定的source获取数据,然后进入指定的管道,再到sink接收端。

单个可以这样理解, Flume中把采集到的数据叫event流式的集群的概念如下图配置不同的agent,让很多的flume agent形成一个集群,收集到各式各样的数据,进入持久化数据库。

Mongodb介绍Moggo DB是目前IT行业内比较流行的一种Nosql数据库,也就是所说的非关系型数据库,在mongoDB中存的每一个数据其实都是Document对象,而在mongodb中做增删改查不需要sql语句,提供了方法来执行,比如db.test.save(“test”,”test”),db.test.find(); 等等重点来了如何搭建流式flume+mongodb日志采集系统Flume安装及搭建(1)flume运行的前提是要有java运行环境,jdk下载并安装,配置好环境变量后,运行java,javac,java –version命令有提示,则表示安装成功(注:虚拟机小红帽系统默认有JDK环境,必须卸载默认JDK后,安装自己的即可,被这个默认JDK整了我半天才找到是它的问题,切记)(2)安装flume第一步:先去官网下载flume-ng最新版本(flume 1.0之前的版本都叫flume –og,之后的版本都要flume-ng),下面是传送门/dyn/closer.cgi/flume/1.5.2/apache-flume-1.5.2-bin.tar.gz。

flume的介绍

flume的介绍

Flume是Cloudera提供的一个高可用的,高可靠的,分布式的海量日志采集、聚合和传输的系统。

Flume支持在日志系统中定制各类数据发送方,用于收集数据;同时,Flume提供对数据进行简单处理,并写到各种数据接受方(可定制)的能力。

Flume最早是Cloudera提供的日志收集系统,是Apache下的一个孵化项目。

Flume具有以下特点:

1. 分布式:Flume是一个分布式系统,由多个独立的Agent组成,每个Agent 负责从不同的数据源收集日志数据,并将数据传输到中央存储系统。

2. 高可靠性:Flume具有可靠的可靠性机制以及许多故障转移和恢复机制,具有强大的容错性和容错能力。

3. 可定制化:Flume允许用户自定义数据发送方和数据接收方,以适应不同的日志数据格式和存储需求。

4. 灵活的数据模型:Flume使用一个简单的可扩展数据模型,允许在线分析应用程序。

5. 易于使用:Flume提供了丰富的API和配置选项,使得用户可以轻松地配置和管理Flume系统。

总之,Flume是一个功能强大的分布式日志收集系统,可以帮助用户高效地收集、汇总和移动大量日志数据。

金融行业大数据分析与风险控制方案

金融行业大数据分析与风险控制方案第一章:引言 (3)1.1 项目背景 (3)1.2 项目目标 (3)1.3 项目意义 (3)第二章:大数据技术在金融行业的应用 (4)2.1 大数据概述 (4)2.2 金融行业大数据特点 (4)2.2.1 数据来源丰富 (4)2.2.2 数据类型多样 (4)2.2.3 数据价值密度高 (4)2.2.4 数据处理速度快 (4)2.3 金融行业大数据应用场景 (4)2.3.1 客户关系管理 (4)2.3.2 风险管理 (5)2.3.3 信用评估 (5)2.3.4 资产定价 (5)2.3.5 智能投顾 (5)2.3.6 反洗钱 (5)2.3.7 贷后管理 (5)2.3.8 金融科技创新 (5)第三章:金融行业风险类型与评估 (5)3.1 风险类型概述 (5)3.1.1 信用风险 (5)3.1.2 市场风险 (6)3.1.3 操作风险 (6)3.1.4 法律风险 (6)3.1.5 流动性风险 (6)3.2 风险评估方法 (6)3.2.1 定性评估方法 (6)3.2.2 定量评估方法 (6)3.2.3 综合评估方法 (6)3.3 风险评估流程 (6)3.3.1 风险识别 (6)3.3.2 风险分析 (7)3.3.3 风险评估 (7)3.3.4 风险应对 (7)3.3.5 风险监控 (7)3.3.6 风险报告 (7)第四章:大数据在风险控制中的应用 (7)4.1 大数据在信用风险控制中的应用 (7)4.2 大数据在市场风险控制中的应用 (7)4.3 大数据在操作风险控制中的应用 (8)第五章:金融行业大数据分析模型与方法 (8)5.1 统计分析模型 (8)5.1.1 线性回归模型 (8)5.1.2 逻辑回归模型 (8)5.1.3 时间序列模型 (9)5.2 机器学习模型 (9)5.2.1 决策树 (9)5.2.2 随机森林 (9)5.2.3 支持向量机 (9)5.3 深度学习模型 (9)5.3.1 卷积神经网络 (9)5.3.2 循环神经网络 (9)第六章:大数据分析平台构建 (9)6.1 平台架构设计 (9)6.2 数据采集与存储 (10)6.2.1 数据采集 (10)6.2.2 数据存储 (10)6.3 数据处理与分析 (10)6.3.1 数据清洗 (10)6.3.2 数据整合 (11)6.3.3 数据挖掘与分析 (11)6.3.4 数据可视化 (11)第七章:风险控制策略与实施 (11)7.1 风险预警策略 (11)7.2 风险防范措施 (12)7.3 风险应对策略 (12)第八章:金融行业大数据安全与隐私保护 (13)8.1 数据安全概述 (13)8.1.1 数据安全的重要性 (13)8.1.2 数据安全面临的挑战 (13)8.2 数据隐私保护方法 (13)8.2.1 数据脱敏 (13)8.2.2 数据加密 (13)8.2.3 数据访问控制 (14)8.3 数据安全与隐私保护策略 (14)8.3.1 建立完善的数据安全法律法规体系 (14)8.3.2 加强数据安全技术研究与应用 (14)8.3.3 强化数据安全管理和运维 (14)8.3.4 提高员工数据安全意识 (14)8.3.5 加强数据安全国际合作 (14)第九章:项目实施与推进 (14)9.1 项目实施计划 (14)9.2 项目推进策略 (15)9.3 项目成果评估 (15)第十章:未来展望与挑战 (16)10.1 金融行业大数据发展前景 (16)10.2 面临的挑战与问题 (16)10.3 发展趋势与建议 (17)第一章:引言1.1 项目背景信息技术的飞速发展,大数据技术在各个行业中的应用日益广泛,金融行业作为我国经济体系的重要组成部分,对大数据技术的应用尤为重视。

flume 详解

flume 详解Flume是一个分布式、可靠、高可用的系统,用于有效地收集、聚合和移动大量的日志和事件数据。

它是一个开源项目,由Apache基金会进行管理和维护。

Flume的设计目标是提供一种简单且可扩展的方式来收集数据,无论是静态数据文件还是实时产生的数据流。

它主要用于在大规模数据处理和分析的场景中,将分散在不同来源的数据集中进行收集和整合。

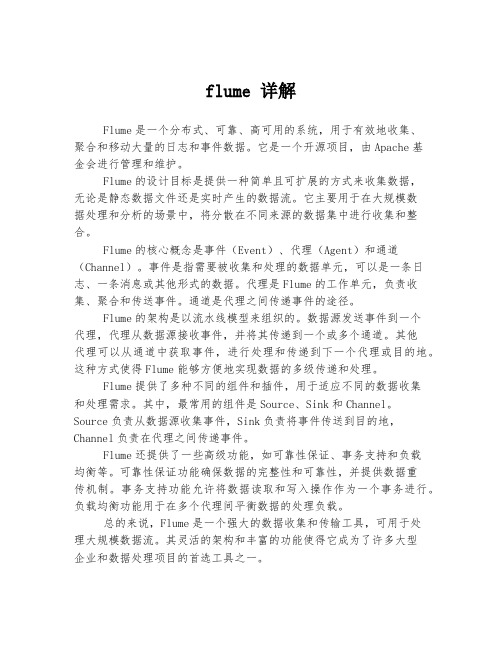

Flume的核心概念是事件(Event)、代理(Agent)和通道(Channel)。

事件是指需要被收集和处理的数据单元,可以是一条日志、一条消息或其他形式的数据。

代理是Flume的工作单元,负责收集、聚合和传送事件。

通道是代理之间传递事件的途径。

Flume的架构是以流水线模型来组织的。

数据源发送事件到一个代理,代理从数据源接收事件,并将其传递到一个或多个通道。

其他代理可以从通道中获取事件,进行处理和传递到下一个代理或目的地。

这种方式使得Flume能够方便地实现数据的多级传递和处理。

Flume提供了多种不同的组件和插件,用于适应不同的数据收集和处理需求。

其中,最常用的组件是Source、Sink和Channel。

Source负责从数据源收集事件,Sink负责将事件传送到目的地,Channel负责在代理之间传递事件。

Flume还提供了一些高级功能,如可靠性保证、事务支持和负载均衡等。

可靠性保证功能确保数据的完整性和可靠性,并提供数据重传机制。

事务支持功能允许将数据读取和写入操作作为一个事务进行。

负载均衡功能用于在多个代理间平衡数据的处理负载。

总的来说,Flume是一个强大的数据收集和传输工具,可用于处理大规模数据流。

其灵活的架构和丰富的功能使得它成为了许多大型企业和数据处理项目的首选工具之一。

flume原理和运用

flume原理和运用Flume是Apache软件基金会下的一个分布式系统,用于将大量的数据从源头(例如服务器日志、社交媒体等)传输到目标(例如Hadoop、HBase等)。

它的主要原理和运用如下:1. 架构:Flume的架构主要包含三个组件:Source、Channel和Sink。

Source用于收集数据,可以是一个日志文件、HTTP接口、JMS队列等;Channel用于存储数据,可以是内存、磁盘或者两者的组合;Sink用于将数据传输到目标系统,可以是HBase、HDFS、Kafka等。

2. 数据流:Flume的数据流通常是以事件(Event)为单位进行传输的。

一个事件可以是一个字节流、一个记录、一个事务等。

在Source收集到数据后,会将其封装为一个或多个事件,然后通过Channel传递给Sink进行处理。

3. 可靠性:Flume提供了多种机制来确保数据的可靠性。

比如,可以通过数据重传来保证数据不会丢失;可以通过事务机制来实现“一次且仅一次”传输;可以通过数据拦截和变换来确保数据的完整性和正确性。

4. 扩展性:Flume支持分布式部署,可以通过增加Source、Channel和Sink来扩展系统的吞吐能力和容量。

此外,Flume还支持灵活的自定义插件,可以根据实际需求实现各种定制化功能。

5. 运用:Flume可以应用于各种数据采集和传输场景。

比如,可以将服务器日志采集到Hadoop进行离线分析;可以将社交媒体数据采集到Kafka进行实时处理;可以将信用卡交易数据传输到HBase进行实时查询等。

总的来说,Flume是一个灵活可靠的数据采集和传输工具,可以帮助用户快速构建大规模的数据处理系统。

数据采集-日志数据采集实践

第三章 日志数据采集实践南京交通职业技术学院授课讲师:XXX目 录Contents01Flume的安装和配置02Flume采集数据上传到集群01学习目标学习目标了解Flume的特点,熟悉Flume的工作原理。

熟悉Flume 运行的核心Agent,识记source、channel、sink的概念。

学会Flume的安装和不同应用场景下的配置。

学会Flume采集数据上传到HDFS。

学会Flume采集数据上传到HBase。

技能目标知识目标02任务3.1: Flume的安装和配置任务描述(1)完成Flume的相关基础知识学习。

(2)完成Flume的安装。

(3)使用Flume采集数据的常用方式,即通过配置Flume的agent信息,定义 Flume的数据源、采集方式和输出目标,完成数据采集的关键参数配置工作任务目标(1)熟悉Flume的相关基础知识;(2)学会Flume的安装和不同应用场景下的配置。

知识准备Flume简介Flume是一个分布式、可靠、和高可用的海量日志采集、聚合和传输的系统。

Flume支持在日志系统中定制各类数据发送方,用于收集数据;同时,Flume提供对数据进行简单处理,并写到各种数据接受方(比如文本、HDFS、Hbase等)的能力。

其设计原理也是基于将数据流,如日志数据从各种网站服务器上汇集起来存储到HDFS,HBase数据采集工作流程,如图所示:等集中存储器中。

FlumeFlume的工作原理Flume的数据流由事件(Event)贯穿始终。

事件是Flume的基本数据单位,它携带日志数据(字节数组形式)并且携带有头信息,这些Event由Agent外部的Source生成,当Source捕获事件后会进行特定的格式化,然后Source会把事件推入(单个或多个)Channel中。

可以把Channel看作是一个缓冲区,它将保存事件直到Sink处理完该事件。

Sink负责持久化日志或者把事件推向另一个Source。

flume-ng 参数

flume-ng 参数Flume-ng是Apache Flume的升级版本,是一个分布式、可靠、可扩展的日志收集系统。

它主要用于将大量的日志数据从各种数据源(如Web服务器、应用服务器、传感器等)收集、汇总、传输到数据存储系统(如Hadoop HDFS)中。

在Flume-ng中,通过使用配置文件来定义数据流的流向和处理过程,而这些配置文件中包含了各种参数。

以下是一些Flume-ng中常用的参数及其说明:1. Agent级参数:1.1 agent.sources:定义Agent中的数据源,可以有多个数据源。

1.2 agent.sinks:定义Agent中的数据目的地,可以有多个数据目的地。

1.3 agent.channels:定义Agent中的数据通道,可以有多个数据通道。

1.4 agent.channels.channel-1.type:指定数据通道的类型,例如,可以是MemoryChannel、FileChannel等。

1.5 agent.channels.channel-1.capacity:指定数据通道的容量,即通道中能够存储的事件数量。

2. Source级参数:2.1 source.type:指定数据源的类型,例如,可以是Avro、Exec、HTTP等。

2.2 source.channels:指定数据源连接的通道。

2.3 source.interceptors:定义用于在事件被传递到通道之前对事件进行预处理的拦截器。

2.4 source.selector.type:指定数据源使用的事件选择器类型,例如,可以是Replicating、Multiplexing等。

3. Sink级参数:3.1 sink.type:指定数据目的地的类型,例如,可以是HDFS、Logger、Avro等。

3.2 sink.channel:指定数据目的地连接的通道。

3.3 sink.batchSize:指定每次事务中处理的事件数量。

简述flume的概念

flume简述什么是flumeFlume是一个可靠、分布式、高可扩展的日志收集和聚合系统。

它被广泛用于将大量日志数据从各种源头(包括Web服务器、数据库、应用程序等)收集到集中式的存储系统中(如Hadoop、HDFS、Kafka等),以便后续的批处理和实时分析。

flume的架构Flume的架构包含了三个核心组件:Agent、Source、Sink。

Agent是一个独立的进程,负责收集、聚合和传输日志数据。

Source负责从各种来源收集数据,如Avro、Thrift、JMS等。

Sink则负责将数据传输到指定的目的地,如HDFS、HBase、Elasticsearch等。

Flume的架构是灵活可扩展的,用户可以根据自己的需求添加或修改Source和Sink组件来满足不同的数据收集和传输需求。

Agent可以部署在不同的节点上来实现数据的并行收集和传输。

flume的工作流程Flume的工作流程可以概括为以下几个步骤:1.Agent启动并监听指定的端口,等待数据源发送数据。

2.数据源发送数据到Agent。

3.Agent根据配置文件中定义的Source组件接收数据,并将数据传输给Channel组件。

4.Channel组件将数据缓存起来,以便后续的处理。

5.Source组件将数据传输给Sink组件,Sink组件负责将数据传输到指定的目的地。

6.目的地接收数据并进行存储或处理。

flume的特性Flume具有以下几个特性,使其成为一个优秀的日志收集和聚合系统:1.高可靠性:Flume使用可靠的日志传输机制,保证数据的可靠传输。

如果传输失败,Flume会自动重试,直到数据成功传输。

2.可扩展性:Flume的架构设计具备高度的可扩展性。

用户可以根据需求添加或修改Source和Sink组件,并且可以部署多个Agent来实现数据的并行收集和传输。

3.容错性:Flume支持数据的备份和故障恢复机制,保证数据在传输过程中不会丢失。

flume技术原理

flume技术原理宝子!今天咱来唠唠Flume这个超有趣的技术。

Flume呀,就像是一个超级快递员,专门负责在数据的世界里搬运东西。

它主要的任务就是把各种各样的数据从产生数据的地方,准确无误地送到该去的地方。

比如说,就像把深山里的新鲜水果(数据),一路好好地运到城市里的超市(数据存储的地方)。

那Flume是怎么做到的呢?它有个很重要的概念叫Agent。

这个Agent就像是一个小机器人,有自己的一套工作流程。

Agent里面包含了三个主要的部分哦。

第一个部分是Source。

Source就像是数据的入口,是小机器人伸出去接数据的手。

它能从好多不同的地方把数据抓过来。

比如说,它可以从文件里把数据读取出来,就像从一本写满了故事(数据)的本子上一个字一个字地抄下来。

它还能从网络端口接收数据呢,就像站在门口等着别人把包裹(数据)递过来。

然后就是Channel啦。

Channel呢,就像是小机器人身上背的小背包。

这个背包是用来暂时存放从Source那里拿到的数据的。

它就像一个临时的小仓库,确保数据在运输过程中有个安全的地方待着。

比如说,要是Source接收到数据的速度很快,但是后面的目的地还没准备好接收,那数据就可以先在这个Channel里歇一歇。

而且这个Channel有不同的类型哦,就像背包有不同的款式。

有的是基于内存的,这种就像是那种轻便的小布包,速度快,但是容量有限,要是数据太多了可能就装不下啦;还有基于文件的,这就像是那种大大的旅行包,可以装好多数据,不过速度可能就没有基于内存的那么快。

最后就是Sink啦。

Sink是数据的出口,就像是小机器人把背包里的数据送到目的地的手。

它可以把数据送到好多不同的地方,像把数据存到HDFS(这就像是把水果送到超级大的水果仓库),或者送到数据库里,就像把货物送到专门存放某种东西的小仓库一样。

Flume还有个很贴心的地方呢,就是它可以有多个Agent一起工作。

就像一群小机器人组成了一个小团队。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

B I T C项目7 Flume日志采集系统任务7.2 Flume采集方案说明与可靠性保证主讲教师:马东波学习目标Title Works About Help章节概要在大数据系统的开发中,数据收集工作无疑是开发者首要解决的一个难题,但由于生产数据的源头丰富多样,其中包含网站日志数据、后台监控数据、用户浏览网页数据等,数据工程师要想将它们分门别类的采集到HDFS系统中,就可以使用Apache Flume(数据采集)系统。

本章将针对Flume系统的基本概念、安装及应用方式详细讲解,让读者掌握Flume系统的原理与应用。

C O N T E N T SFlume采集方案说明PART 01Flume的可靠性保证PART 02Flume Sources在编写Flume采集方案时,首先必须明确采集的数据源类型、出处;接着,根据这些信息与Flume已提供支持的Flume Sources进行匹配,选择对应的数据采集器类型(即sources.type);再根据选择的数据采集器类型,配置必要和非必要的数据采集器属性,Flume提供并支持的Flume Sources种类如下所示。

Avro Source Thrift Source Exec SourceJMS Source Spooling Directory Source Twitter 1% firehose SourceKafka Source NetCat TCP Source NetCat UDP SourceSequence GeneratorSyslog TCP Source Multiport Syslog TCP SourceSourceSyslog UDP Source HTTP Source Stress SourceAvro Legacy Source Thrift Legacy Source Custom SourceScribe Source Taildir SourceTitle Works About HelpFlume Sources监听Avro端口并从外部Avro客户端流中接收event数据,当与另一个Flume Agent 上的Avro Sink配对时,可创建分层集合拓扑,利用Avro Source可以实现多级流动、扇出流、扇入流等效果,Avro Source常用配置属性如下。

属性名称默认值相关说明channels–type–组件类型名需必须是avrobind–要监听的主机名或IP地址port–要监听的服务端口threads–要生成的工作线程的最大数目ssl false 将此设置为true以启用SSL加密,则还必须指定“keystore”和“keystore-password”keystore–SSL所必需的通往Java密钥存储路径keystore-password–SSL所必需的Java密钥存储的密码Title Works About HelpTitle Works AboutHelpFlume Sources使用Avro Source采集器配置一个名称为a1的Agent示例如下:a1.sources=r1a1.channels=c1a1.sources.r1.type=avroa1.sources.r1.channels=c1a1.sources.r1.bind=0.0.0.0a1.sources.r1.port=4141Flume Sources•Spooling Directory Source允许对指定磁盘上的文件目录进行监控来提取数据,它将查看文件的指定目录的新增文件,并将文件中的数据读取出来。

•Spooling Directory Source常用配置属性如下表所示。

属性名称默认值相关说明channels–type–组件类型名需必须是spooldirspoolDir–从中读取文件的目录PLETED附加到完全摄取的文件后缀deletePolicy never 何时删除已完成的文件:never或immediatefileHeader false是否添加存储绝对路径文件名的标头includePattern^.*$正则表达式,指定要包含的文件ignorePattern^$正则表达式,指定要忽略的文件Title Works About HelpFlume Sources使用Spooling Directory Source采集器配置一个名称为a1的Agent示例如下:a1.channels=ch-1a1.sources=src-1a1.sources.src-1.type=spooldira1.sources.src-1.channels=ch-1a1.sources.src-1.spoolDir=/var/log/apache/flumeSpoola1.sources.src-1.fileHeader=trueTitle Works About HelpFlume SourcesTaildir Source用于观察指定的文件,几乎可以实时监测到添加到每个文件的新行。

如果文件正在写入新行,则此采集器将重试采集它们以等待写入完成,Source常用配置属性如下所示。

属性名称默认值相关说明channels–type–组件类型名需必须是TAILDIRfilegroups–以空格分隔的文件组列表filegroups.<filegroupName>–文件组的绝对路径idleTimeout120000关闭非活动文件的时间(毫秒)Flume Sources续表属性名称默认值相关说明writePosInterval3000写入位置文件上每个文件的最后位置的间隔时间batchSize100一次读取和发送到通道的最大行数backoffSleepIncrement1000当最后一次尝试未找到任何新数据时,每次重新尝试轮询新数据之间的最大时间延迟fileHeader false是否添加存储绝对路径文件名的标头fileHeaderKey file 将绝对路径文件名附加到event header时使用的header关键字Flume Sources使用Taildir Sources采集器配置一个名称为a1的Agent示例如下:a1.sources=r1a1.channels=c1a1.sources.r1.type=TAILDIRa1.sources.r1.channels=c1a1.sources.r1.positionFile=/var/log/flume/taildir_position.jsona1.sources.r1.filegroups=f1 f2a1.sources.r1.filegroups.f1=/var/log/test1/example.loga1.sources.r1.headers.f1.headerKey1=value1a1.sources.r1.filegroups.f2=/var/log/test2/.*log.*a1.sources.r1.headers.f2.headerKey1=value2a1.sources.r1.headers.f2.headerKey2=value2-2a1.sources.r1.fileHeader=trueFlume SourcesHTTP Source可以通过HTTP POST和GET请求方式接收event数据,GET通常只能用于测试使用,POST请求发送的所有的events都被认为是一个批次,会在一个事务中插入channel,Taildir Source常用配置属性如下所示。

属性名称默认值相关说明channels–type组件类型名需必须是httpport–采集源要绑定的端口bind0.0.0.0要监听绑定的主机名或IP地址handler org.apache.flume.source.http.JSONHandlerhandler类的全路径名Flume Sources使用HTTP Source采集器配置一个名称为a1的Agent示例如下:a1.sources=r1a1.channels=c1a1.sources.r1.type=httpa1.sources.r1.port=5140a1.sources.r1.channels=c1a1.sources.r1.handler=org.example.rest.RestHandlera1.sources.r1.handler.nickname=random propsFlume ChannelsChannels通道是event在Agent上暂存的存储库,Source向Channel中添加event,Sink在读取完数据后再删除它。

在配置Channels时,需要明确的就是将要传输的sources数据源类型;根据这些信息结合开发中的实际需求,选择Flume已提供的支持的FlumeChannels;再根据选择的Channel类型,配置必要和非必要的Channel属性,Flume提供并支持的Flume Channels种类如下所示。

Memory Channel JDBC Channel Kafka ChannelFile Channel Spillable Memory Channel Pseudo Transaction ChannelCustom ChannelFlume ChannelsMemory Channel会将event存储在具有可配置最大尺寸的内存队列中,适用于需要更高吞吐量的流量,但在Agent发生故障时会丢失部分阶段数据,下表为Memory Channel常用配置属性。

属性名称默认值相关说明type–组件类型名需必须是memorycapacity100存储在channel中的最大event数transactionCapacity100channel从source接收或向sink传递的每个事务中最大event数keep-alive3添加或删除event的超时时间(秒)byteCapacityBuffer Percentage 20定义byteCapacity与channel中所有event所占百分比byteCapacity等于JVM可用的最大允许此channel中所有event的的最大内Flume Channels使用Memory Channel通道配置一个名称为a1的Agent示例如下:a1.channels=c1a1.channels.c1.type=memorya1.channels.c1.capacity=10000a1.channels.c1.transactionCapacity=10000a1.channels.byteCapacityBufferPercentage=20a1.channels.byteCapacity=800000Flume ChannelsFile Channel是Flume的持久通道,它将所有event写入磁盘,因此不会丢失进程或机器关机、崩溃时的数据。