深度网络模型详解

OSI参考模型体系

传输层

传输层负责建立和维护端到端的连接,确保数据的可 靠传输。

输入 标题

详细描述

传输层的主要功能包括建立连接、管理数据流量和控 制数据传输等。它还提供诸如可靠传输和不可靠传输 等传输服务。

总结词

总结词

传输层通过使用诸如TCP和UDP等传输协议来提供可 靠的传输服务。这些协议通过确认机制、重传机制和

表示层的主要任务是处理数 据的表示和转换。

详细描述

表示层通过使用各种表示协 议(如MIME和TLS)来处 理数据的表示和转换。此外, 表示层还负责数据的加密和 解密以及压缩和解压缩等任 务,以确保数据的机密性和 完整性。

应用层

总结词

详细描述

总结词

详细描述

应用层是OSI参考模型的最 顶层,负责处理用户的具体 应用需求。

会话层通过使用各种会话协议 (如RPC和SQL)来管理会话连 接,并确保通信的同步性。此 外,会话层还负责管理对话控 制,以确保通信的正确性和可 靠性。

表示层

总结词

表示层负责数据的表示、编 码和加密等任务。

详细描述

总结词

表示层的主要功能包括数据 的表示、编码和解码、加密 和解密以及压缩和解压缩等。 它还负责转换上层的数据格 式以适应下层的协议要求。

传输效率。

OSI参考模型在网络安全中的应用

安全策略制定

安全风险评估

利用OSI参考模型,可以对网络系统进行全面的安 全风险评估,识别潜在的安全威胁和漏洞。

OSI参考模型提供了多层安全策略制定的框 架,包括物理层、数据链路层、网络层和应 用层的安全策略。

安全事件响应

OSI参考模型有助于安全事件响应团队快速 定位问题所在层,采取相应的措施进行处置 。

深度学习模型的使用教程与实战方法

深度学习模型的使用教程与实战方法深度学习是机器学习领域中的一个重要分支,它以人工神经网络为基础,利用多层的神经网络结构模拟人脑的工作原理,以实现对大规模复杂数据的处理和分析。

深度学习已经在图像识别、自然语言处理、语音识别等领域取得了很大成功,并成为人工智能技术的核心。

本文将介绍深度学习模型的基本概念,分析其应用场景,并详细讲解深度学习模型的使用教程与实战方法,帮助读者快速上手深度学习模型的搭建与使用。

深度学习模型的基本概念深度学习模型是由多层神经网络组成的,每一层都由若干个神经元组成。

神经元接收输入信号,经过激活函数处理后,将输出传递给下一层神经元。

深度学习模型通过多层的网络结构进行信息传递和特征学习,实现对复杂数据的高级抽象和分析。

深度学习模型的应用场景深度学习模型在各个领域都有广泛的应用,特别是在图像识别、自然语言处理、语音识别等领域,取得了巨大的突破。

在图像识别领域,深度学习模型可以实现对图像中物体的自动识别和分类,广泛应用于无人驾驶、安防监控等领域。

在自然语言处理领域,深度学习模型可以实现对文本的自动分类、情感分析等任务,被广泛应用于智能客服、机器翻译等领域。

在语音识别领域,深度学习模型可以实现对语音信号的自动识别和转换,被广泛应用于语音助手、智能音箱等领域。

深度学习模型的使用教程1. 数据准备:收集、清洗和标注数据集是深度学习模型的第一步。

数据集质量和数量对模型性能有重要影响,因此需要注意数据的选择和处理。

可以通过网络爬虫、数据标注工具等方式来获取和处理数据。

2. 模型选择:根据任务的特点和需求,选择适合的深度学习模型。

常用的深度学习模型包括卷积神经网络(CNN)、循环神经网络(RNN)、长短期记忆网络(LSTM)等。

根据任务的特点和需求,选择合适的模型架构。

3. 模型搭建:在选择好模型之后,需要根据具体任务的要求搭建深度学习模型。

使用开源的深度学习框架如TensorFlow、PyTorch等可以简化搭建过程。

深度置信网络模型及应用研究综述

2018,54(1)1引言现今,深度学习在计算机视觉、模式识别、人工智能、图像处理以及数据挖掘等领域掀起的研究热潮引人深思,研究人员提出的自编码器、卷积神经网络、循环神经网络以及深度置信网络等深度学习模型越来越值得深入探索和挖掘。

本文以深度置信网络为例,从理论到实际,由浅入深地分析其应用意义。

深度置信网络(DBN )发展伊始,为解决快速、自动学习特征的研究问题,Hinton 等[1]提出一种应用于DBN的快速学习算法,提供了理解分析DBN 模型的新途径,打开了深度学习模型扩展的大门,并将其应用于实际生活的各个领域。

本文针对目前流行的应用领域——文字检测、人脸及情感识别、遥感图像地物分类,对DBN 进行详细分析。

在上述应用领域中,DBN 改进的相同之处,一是通过预处理方式(特征融合、去噪)提高输入样本的质量;二是利用各种优化策略(提前终止、Dropout )对DBN 模型参数,进行深度改进或选取不同的分类器。

DBN 改进的不同之处在于,文字检测领域中,DBN 结合计算设备架构、文字笔画宽度;人脸及情感领域中,DBN 结合人体识别所需的关键特征(局部纹理特征);遥感图像地物分类领域中,DBN 结合高光谱图像包含的光谱信息和空间信息。

2深度置信网络简介深度置信网络(DBN )是根据生物神经网络的研究及浅层神经网络发展而来的,为概率生成模型,通过联合概率分布推断出数据样本分布。

DBN 生成模型通过训练网络结构中的神经元间的权重使得整个神经网络依据最大概率生成训练数据,形成高层抽象特征,提升深度置信网络模型及应用研究综述刘方园,王水花,张煜东LIU Fangyuan,WANG Shuihua,ZHANG Yudong南京师范大学计算机科学与技术学院,南京210023School of Computer Science and Technology,Nanjing Normal University,Nanjing 210023,ChinaLIU Fangyuan,WANG Shuihua,ZHANG Yudong.Survey on deep belief network model and its puter Engineering and Applications,2018,54(1):11-18.Abstract :This paper firstly introduces the development of Deep Belief Network (DBN )based on theory foundation.Afterwards,the difference between deep network structure and shallow network structure is analyzed.Finally,the literature makes a study and analysis of DBN,in the field of text detection,facial and expression recognition,and remote sensing image classification by quoting multiple representative documents.Through a comprehensive introduction to the deep learning model DBN and deeply understanding the construction and practical application of DBN,it provides researchers with the idea of improving DBN and applying it to a wider emerging field in the future.Key words :Deep Belief Network (DBN );text detection;facial and expression recognition;remote sensing image field 摘要:介绍深度置信网络(DBN )理论基础的发展,对比分析深层结构DBN 与浅层网络结构的差异,最后引用多篇文献分析研究DBN 在文字检测、人脸及表情识别领域和遥感图像领域的应用效果。

主流深度学习框架及神经网络模型汇总

主流深度学习框架及神经网络模型汇总深度学习(Deep Learning)是一种机器学习(Machine Learning)方法,通过人工神经网络(Artificial Neural Networks)模型来模拟人类大脑的工作机制,用于解决复杂的模式识别和数据建模问题。

目前,有许多主流的深度学习框架和神经网络模型被广泛应用于各种领域的研究和应用中。

下面是一些主流的深度学习框架和神经网络模型的汇总:1. TensorFlow:由Google开发的TensorFlow是目前最流行的深度学习框架之一、它提供了丰富的工具和库,支持构建各种类型的神经网络模型,并具有高度的灵活性和可扩展性。

2. PyTorch:由Facebook开发的PyTorch是另一个流行的深度学习框架。

它提供了易于使用的API,允许开发者以动态图的方式进行模型构建和训练。

PyTorch也得到了广泛的应用和研究探索。

3. Keras:Keras是一个高级神经网络API,可以运行于TensorFlow、PyTorch等深度学习框架之上。

Keras具有简单易用的特点,适合初学者和快速原型开发。

4. Caffe:Caffe是一个专门用于卷积神经网络(Convolutional Neural Networks)的深度学习框架。

它以速度和效率为特点,被广泛应用于计算机视觉任务。

5. Theano:Theano是一个开源的数值计算库,特别适用于构建和训练大规模的神经网络模型。

它提供了高效的GPU计算和自动求导功能。

在神经网络模型方面,有以下一些主流的模型:1. 卷积神经网络(Convolutional Neural Networks,CNN):CNN 是一种常用于图像识别和计算机视觉任务的神经网络模型。

它通过局部感知机制和权值共享的方式,有效地处理图像数据。

2. 循环神经网络(Recurrent Neural Networks,RNN):RNN是一种具有记忆性的神经网络模型,适用于处理序列数据。

transformer 模型 详解 简单 明了

题目:Transformer 模型详解1. 前言在当今人工智能领域,Transformer 模型作为一种革命性的深度学习模型,已经被广泛应用于自然语言处理、语音识别、计算机视觉等多个领域。

本文将对 Transformer 模型进行详细讲解,包括其基本原理、网络结构、训练方法和应用场景,希望能够使读者对该模型有一个全面的认识。

2. Transformer 模型的基本原理Transformer 模型是由 Google 于 2017 年提出的一种基于注意力机制的深度神经网络模型。

与传统的循环神经网络(RNN)和卷积神经网络(CNN)相比,Transformer 模型在处理长距离依赖、并行计算和内存消耗等方面具有明显优势。

其基本原理主要包括自注意力机制、位置编码和残差连接等。

3. Transformer 模型的网络结构Transformer 模型主要由编码器和解码器构成,其中编码器用于将输入序列映射成隐藏表示,解码器则用于根据编码器生成的隐藏表示生成输出序列。

在网络结构方面,Transformer 模型采用了多头注意力机制和前馈神经网络等组件,使得模型能够更好地捕捉输入序列中的信息,并生成相应的输出序列。

4. Transformer 模型的训练方法Transformer 模型通常使用端到端的方式进行训练,其中包括数据预处理、模型构建、损失函数定义及优化器选择等步骤。

由于Transformer 模型的参数量较大,因此在训练过程中通常需要采用分布式训练和混合精度训练等技术,以加速模型的收敛。

5. Transformer 模型的应用场景目前,Transformer 模型已经被广泛应用于自然语言处理领域,如机器翻译、文本生成、情感分析等任务。

由于其强大的特征提取能力,Transformer 模型也在语音识别、计算机视觉和强化学习等领域取得了不俗的成绩。

未来,随着深度学习技术的不断发展,相信Transformer 模型将会有更广泛的应用场景。

ddim 原理

DDIM原理详解1. 背景介绍DDIM(Distributed Deep Interest Network)是一种用于推荐系统的深度学习模型,由阿里巴巴集团提出。

在推荐系统中,DDIM能够有效地学习用户的兴趣和行为,从而提供个性化的推荐服务。

DDIM模型的核心原理是利用深度神经网络对用户的兴趣进行建模,同时使用分布式训练方法进行模型训练,以提高推荐的准确性和效率。

2. 基本原理DDIM模型的基本原理可以分为两个部分:深度兴趣网络(DIN)和分布式训练。

2.1 深度兴趣网络(DIN)深度兴趣网络(DIN)是DDIM模型的核心组件,用于建模用户的兴趣。

DIN模型的输入包括用户的历史行为序列和候选推荐物品。

具体而言,输入包括用户的点击序列和候选物品的特征向量。

DIN模型的核心思想是利用注意力机制来对用户的兴趣进行建模。

具体而言,DIN模型通过计算用户历史行为序列中每个物品的注意力权重,来表示用户对不同物品的兴趣程度。

这样,DIN模型能够更好地捕捉用户的兴趣偏好。

在DIN模型中,注意力权重的计算是通过以下步骤完成的:1.Embedding层:将用户的历史行为序列和候选物品的特征向量映射到低维空间中,得到对应的嵌入向量。

2.Local Activation Unit(局部激活单元):通过计算用户的历史行为序列和候选物品的特征向量之间的相似度,得到对应的激活权重。

3.Attention Weight Generation(注意力权重生成):通过对激活权重进行归一化处理,得到最终的注意力权重。

4.Weighted Sum(加权求和):将注意力权重与对应的嵌入向量进行加权求和,得到用户的兴趣表示。

通过这样的过程,DIN模型能够学习到用户的兴趣,并将其用于推荐物品。

2.2 分布式训练分布式训练是DDIM模型的另一个核心组件,用于提高模型训练的效率和准确性。

由于DDIM模型的参数量较大,传统的单机训练方法无法满足需求。

深度学习经典模型RESNET解析

深度学习经典模型RESNET解析深度学习经典模型RESNET解析1. 理论基础1. 残差学习概念深度神经⽹络相当于函数的拟合过程(复合函数)。

如果层数⾜够深,CNN可以拟合任何⼀个函数。

如果当⽹络的层数越来越深的时候,由于⽹络的退化现象(不妨假设拟合的是H(x)),难以训练出来。

那么可以改为训练F(x)=H(x)−x,此在数学上成为残差(Residual)。

则H(x)=F(x)+x,相当于可以变相训练H(x),这就是残差学习。

⽤⽹络实现:将x直接倒⼊到输出,与经过权重层训练出来的F(x)相加。

x的这个通路没有经过⽹络直接跨接过来,称为恒等映射短接(Identity Mapping Shortcut)。

2. RESNET构建形式VGG19:19层,如果要扩展到34层,按设计原则堆积3×3的⼩卷积核,那么这个34层的⽹络称为平凡的⽹络,训练的话会出现退化。

变成残差⽹络:在层与层之间增加恒等映射跨接层即可。

注意跨接层的表⽰,虚线意味着特征的⼤⼩发⽣了变化,跨接层就不再是恒等映射了RESNET可以有不同的层数,虽然层数不同,但其具有类似的⽹络结构,例如它们都是分了五个部分:7×7的卷积,后⾯紧跟⼀个池化层。

第⼆部分为conv2.x(论⽂中称为stage),每⼀个stage⾥有多个block,不同的RESNET⾥每个stage中block的数⽬不⼀样,重复的次数也不⼀样,每个block是由若⼲个卷积层组成。

因此可以实现具有可扩展性的⽹络。

特殊的结构:最⼤平均池化(Global average pooling),在最后把整个通道变成⼀个数字(求平均值,全局平均池化)。

作⽤:替代全连接层,更少的参数(更少的出现过拟合)。

pytorch中:torch.nn.AdaptivAvgPool2d.(output_size)50层以上/以下的RESNET不同之处:50-没有bottle neck(瓶颈)。

深度学习模型的使用方法

深度学习模型的使用方法深度学习模型(Deep Learning Models)是一种基于人工神经网络的机器学习方法,它能够模拟人脑的神经网络结构和特征提取机制,通过对大规模数据的学习和训练,提供了一种强大的数据建模和学习能力。

在各个领域,深度学习模型已经取得了广泛的应用和卓越的成果。

本文将介绍其中一些常见的深度学习模型的使用方法和技巧。

首先,我们将介绍卷积神经网络(Convolutional Neural Network,CNN)。

CNN是一类在计算机视觉领域取得重要突破的深度学习模型。

它能够通过卷积和池化等操作,有效地提取图像的特征,并利用这些特征进行图像分类、目标检测和图像生成等任务。

在使用CNN时,我们首先需要准备好训练数据集和测试数据集。

然后,我们可以使用各种流行的深度学习框架,如TensorFlow和PyTorch,来构建和训练CNN模型。

在构建CNN模型时,我们可以选择不同的网络架构和层次结构,如LeNet-5、AlexNet、VGGNet和ResNet等。

在完成CNN模型的训练后,我们可以使用测试数据集来评估CNN模型的性能,并根据需要进行模型的调优和改进。

其次,我们将介绍循环神经网络(Recurrent Neural Network,RNN)。

RNN是一种具有记忆性的深度学习模型,它能够处理序列数据,并在处理时保留前面的状态信息。

在自然语言处理和语音识别等领域,RNN已经取得了许多重要的成果。

在使用RNN时,我们首先需要将序列数据转换为适当的输入格式,如词向量或音频频谱图。

然后,我们可以使用各种深度学习框架来构建和训练RNN模型,如TensorFlow和PyTorch。

在构建RNN模型时,我们可以选择不同类型的RNN单元,如基本的RNN单元、长短期记忆(Long Short-Term Memory,LSTM)单元和门控循环单元(Gated Recurrent Unit,GRU)。

Transformer是一种基于自注意力机制的深度神经网络模型

Transformer是一种基于自注意力机制的深度神经网络模型,广泛应用于自然语言处理领域。

其主要原理包括以下几个方面:

1. 自注意力机制:Transformer的核心是自注意力机制,它允许模型在处理序列数据时,能够更好地关注输入序列中与当前位置相关的信息。

自注意力机制通过计算每个输入位置与其他所有位置之间的相似度得到一个权重向量,然后将这些权重加权平均作为当前位置的表示向量。

2. 多头注意力机制:为了提高模型的表达能力,Transformer引入了多头注意力机制。

该机制将自注意力机制分为多个头部,每个头部都计算自己的权重向量,然后将它们拼接起来作为最终的表示向量。

这样可以使模型更加灵活地捕捉输入序列中的不同信息。

3. 残差连接和层归一化:为了避免深度神经网络出现梯度消失或梯度爆炸的问题,Transformer使用了残差连接和层归一化技术。

残差连接允许模型跨层直接传递信息,从而增加了网络的深度;层归一化则可以对网络的输出进行标准化,使得网络更容易训练。

4. 前馈神经网络:Transformer的前馈神经网络采用了多层感知机(MLP)结构,用于对自注意力机制的输出进行进一步处理。

MLP可以学习到更复杂的非线性关系,从而提高了模型的表达能力。

总之,Transformer通过自注意力机制、多头注意力机制、残差连接和层归一化、前馈神经网络等技术,实现了对自然语言处理任务的有效建模和解决。

深度学习中的主要网络结构与原理解析

深度学习中的主要网络结构与原理解析深度学习是一种机器学习方法,通过模拟人脑神经网络的结构和功能,实现对大规模数据的学习和处理。

在深度学习中,网络结构起到了至关重要的作用,不同的网络结构决定了模型的性能和学习能力。

本文将对深度学习中的主要网络结构与原理进行解析。

一、卷积神经网络(CNN)卷积神经网络是深度学习中最重要的网络结构之一,它主要用于图像和语音等二维数据的处理。

CNN的核心思想是通过卷积层、池化层和全连接层等组成,实现对图像特征的提取和分类。

其中,卷积层通过卷积操作提取图像的局部特征,池化层通过降采样操作减少参数数量,全连接层通过多层神经元实现分类任务。

CNN的优点在于能够自动学习图像的特征,减少了手动特征提取的工作量,因此被广泛应用于图像识别、目标检测等领域。

二、循环神经网络(RNN)循环神经网络是一种具有记忆功能的神经网络,主要用于序列数据的处理,如语音识别、自然语言处理等。

RNN的特点在于能够处理变长的输入序列,并通过隐藏层的循环连接实现对历史信息的记忆。

然而,传统的RNN在处理长序列时容易出现梯度消失或梯度爆炸的问题,限制了其在实际应用中的效果。

为了解决这个问题,研究者提出了长短期记忆网络(LSTM)和门控循环单元(GRU)等变种结构,有效地解决了梯度问题,提升了RNN在序列数据处理中的表现。

三、生成对抗网络(GAN)生成对抗网络是一种通过对抗训练的方式生成新的数据样本的网络结构。

GAN 由生成器和判别器两个部分组成,生成器通过学习真实数据的分布,生成与之相似的新样本,判别器则通过判断样本的真实性来提供反馈。

通过不断迭代训练,生成器和判别器的性能逐渐提升,最终生成器能够生成逼真的新样本。

GAN的应用非常广泛,如图像生成、图像修复、图像风格转换等。

四、自编码器(Autoencoder)自编码器是一种无监督学习的神经网络结构,主要用于数据的降维和特征提取。

自编码器由编码器和解码器两部分组成,编码器将输入数据映射到低维的隐藏层表示,解码器则将隐藏层表示重构为原始数据。

Xception网络结构详解与模型的搭建

Xception网络结构详解与模型的搭建Xception(Extreme Inception)是一种深度卷积神经网络(CNN)模型,它在2024年由Google提出。

Xception网络结构基于Inception模型,并通过引入深度分离卷积(depthwise separable convolution)操作来改进Inception模型的计算效率和准确性。

Xception模型的核心思想是将传统的卷积操作分解为两个独立的操作:深度卷积和逐点卷积。

深度卷积(depthwise convolution)只关注输入数据的通道维度,而逐点卷积(pointwise convolution)则负责将通道维度的特征映射转换为空间维度的特征映射。

这种分解操作能够减少计算量和参数数量,同时提高模型的准确性。

具体来说,Xception模型由若干个Xception模块(Xception module)组成。

每个Xception模块都由深度分离卷积组成,包含三个步骤:深度卷积、逐点卷积和逐点卷积。

在深度卷积阶段,模型通过使用多个小的卷积核来替代一个大的卷积核,从而减少模型的参数数量。

在逐点卷积阶段,模型使用1x1的卷积核来进行特征融合和维度变换,从而提高模型的准确性。

1.输入层:接收输入数据。

2.初始卷积层:使用标准的卷积操作来提取初始特征。

3. Xception模块:由若干个Xception模块组成,每个模块包含多个深度分离卷积操作。

4.全局平均池化层:对特征图进行平均池化,将其转换为固定大小的特征向量。

5.全连接层:将特征向量映射到类别概率。

6.输出层:输出最终的预测结果。

```pythonfrom keras.applications.xception import Xceptionfrom keras.models import Modelfrom yers import Dense, GlobalAveragePooling2D# 加载预训练的Xception模型,不包括全连接层base_model = Xception(weights='imagenet', include_top=False) #添加全局平均池化层x = base_model.outputx = GlobalAveragePooling2D((x)#添加全连接层x = Dense(1024, activation='relu')(x)predictions = Dense(num_classes, activation='softmax')(x)# 构建完整的Xception模型model = Model(inputs=base_model.input, outputs=predictions) #编译模型```在上述代码中,首先通过`Xception`函数加载预训练的Xception模型,并且设置`include_top=False`,表示不包括全连接层。

resnet模型原理

resnet模型原理ResNet模型原理引言:ResNet(Residual Network)是一种深度残差网络模型,由何凯明等人在2015年提出。

它在ImageNet图像分类任务中取得了优异的成绩,并且在深度学习领域引起了广泛关注。

本文将介绍ResNet模型的原理,并探讨它为什么能够有效解决深度神经网络训练过程中的梯度消失和梯度爆炸问题。

一、深度神经网络中的梯度消失和梯度爆炸问题在深度神经网络中,随着网络层数的增加,梯度在反向传播过程中逐渐减小,导致梯度消失问题。

这使得深度网络的训练变得困难,因为较小的梯度无法有效地更新网络参数。

另一方面,梯度也可能变得非常大,导致梯度爆炸问题。

这种情况下,网络参数的更新可能会非常不稳定,导致训练过程无法收敛。

二、残差学习和ResNet模型的思想ResNet模型通过引入残差学习的概念,有效地解决了深度神经网络中的梯度消失和梯度爆炸问题。

残差学习的思想是,网络的输入和输出之间的差异可以通过添加一个残差块来学习。

残差块是由一个跳跃连接和两个卷积层组成,其中跳跃连接直接将输入连接到输出,绕过了卷积层的计算。

三、ResNet模型的网络结构ResNet模型采用了深度残差网络的结构,其中包含多个残差块。

每个残差块由两个卷积层和一个跳跃连接组成。

在训练过程中,网络通过反向传播来更新参数,使得残差块的输入和输出之间的差异最小化。

这样,网络可以通过学习残差来逐渐逼近真实的函数。

四、ResNet模型的优势相比传统的深度神经网络模型,ResNet模型具有以下优势:1. 解决梯度消失和梯度爆炸问题:通过引入残差学习的概念,ResNet模型能够有效地解决深度网络中的梯度消失和梯度爆炸问题,使得网络的训练更加稳定和有效。

2. 提高网络的收敛速度:由于残差块中的跳跃连接,信息可以更快地传递到后续层,从而加快网络的收敛速度。

3. 减少参数量:相比传统的深度网络模型,ResNet模型通过跳跃连接可以减少网络中的参数量,减少了模型的复杂度,降低了过拟合的风险。

深度学习中几种常用的模型

深度学习中⼏种常⽤的模型 最近再从事深度学习⽅⾯的⼯作,感觉还有很多东西不是很了解,各种⽹络模型的结构的由来还不是很清晰,在我看来所有的⽹络都是⼀层层的卷积像搭积⽊⼀样打起来的,由于还没实际跑所以还没很深刻感受到⼏种⽹络类型的区别,在此我想梳理⼀下⼏种常见的⽹络结构,加深⼀下理解。

本⽂转⾃此⽂,此⽂条理清晰,总结较为到位。

⽬前常见的⽹络结构:AlexNet、ZF、GoogLeNet、VGG、ResNet等等都可谓曾⼀战成名,它们都具有⾃⾝的特性,它们都提出了创新点。

LeNet是由Yann LeCun完成的具有开拓性的卷积神经⽹络,是⼤量⽹络结构的起点。

⽹络给出了卷积⽹络的基本特性:1.局部感知。

⼈对外界的认知是从局部到全局的,相邻局部的像素联系较为紧密。

每个神经元没必要对全局图像进⾏感知,只需要对局部进⾏感知,然后更⾼层将局部的信息综合起来得到全局的信息。

2.多层卷积。

层数越⾼,学到的特征越全局化。

3.参数共享。

每个卷积都是⼀种提取特征的⽅式,⼤⼤降低了参数的数⽬。

4.多卷积核。

提取多类特征,更为丰富。

5.池化。

降低向量维度,并避免过拟合。

特性1⾃然引出了特性2,特性3⾃然引出了特性4。

⽹络⽤于mnist⼿写体识别任务,⽹络结构⽤查看,常见⽹络:AlexNet2012年,深度学习崛起的元年,Alex Krizhevsky 发表了Alexet,它是⽐LeNet更深更宽的版本,并以显著优势赢得了ImageNet竞赛。

贡献有:1.使⽤RELU作为激活单元。

2.使⽤Dropout选择性忽略单个神经元,避免过拟合。

3.选择最⼤池化,避免平均池化的平均化效果。

AlexNet是⽬前应⽤极为⼴泛的⽹络,结构讲解见:。

⽹络整体上给我们带来了三个结构模块:1、单层卷积的结构:conv-relu-LRN-pool。

前⾯的卷积步长⼤,快速降低featureMap的⼤⼩(较少后⾯的计算量),后⾯深层卷积保持featureMap⼤⼩不变。

深度学习模型的训练技巧与步骤详解

深度学习模型的训练技巧与步骤详解深度学习模型的训练技巧与步骤在实际应用中起着至关重要的作用。

深度学习模型的训练过程涉及选择合适的算法、数据预处理、超参数优化等多个方面。

本文将详细介绍深度学习模型的训练技巧与步骤,以帮助读者更好地理解和应用深度学习算法。

一、数据预处理数据预处理是深度学习模型训练的首要步骤。

它的目的是将原始数据转换为可供深度学习模型使用的合适形式。

数据预处理的常见技巧包括数据的归一化、标准化、缺失值填充、特征选择等。

通过数据预处理,可以提升深度学习模型的效果和收敛速度。

首先,数据的归一化和标准化非常重要。

归一化指将数据的取值范围缩放到统一的区间,常见的方法包括将数据缩放到[0,1]或[-1,1]的范围内。

标准化指将数据转化为均值为0,方差为1的标准正态分布。

这两种方法可以使得数据的特征在训练过程中更加平衡,避免某些特征对模型的训练结果产生过大的影响。

其次,对于存在缺失值的数据,需要进行缺失值的填充。

常见的方法包括使用平均值、中位数或众数填充缺失值,或者使用插值法进行填充。

填充缺失值的目的是保证数据集的完整性和一致性,避免缺失值对模型的训练造成干扰。

最后,特征选择是数据预处理的最后一步。

特征选择的目的是从原始数据中选择出对模型训练和预测有用的特征。

常见的特征选择方法包括相关系数分析、主成分分析等。

特征选择可以提高模型的泛化能力和训练速度。

二、模型选择在深度学习中,模型的选择对最终训练结果有着决定性的影响。

模型的选择需要考虑数据集的特点、任务的要求以及计算资源等因素。

常见的深度学习模型包括卷积神经网络(CNN)、循环神经网络(RNN)和生成对抗网络(GAN)等。

卷积神经网络适用于图像和语音等具有空间结构的数据,能够提取出数据的局部特征。

循环神经网络适用于序列数据,能够捕捉数据的时序关系。

生成对抗网络用于生成新的数据样本,能够模拟真实数据的分布特征。

在模型选择的过程中,可以根据任务的需求选择合适的模型架构,并根据实际情况进行调整和优化。

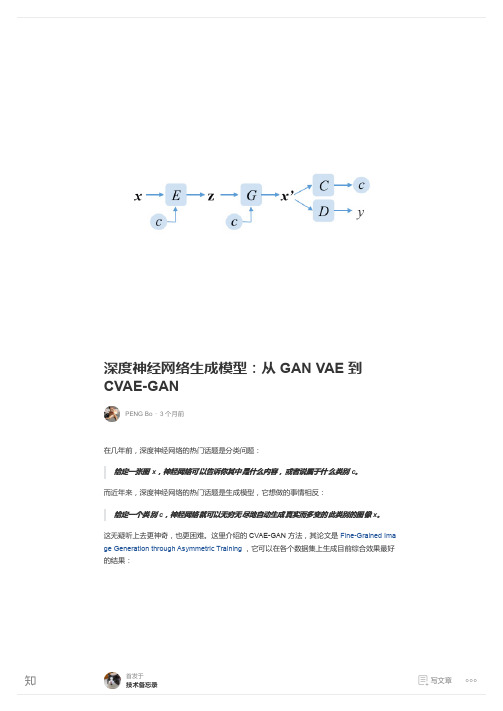

深度神经网络生成模型:从 GAN VAE 到 CVAE-GAN - 知乎专栏

着重看一下画,右边的画都是根据左边的照片完全自动生成的,效果确实相当专业了:

然后是编码改变:

首发于

技术备忘录

写文章

同样是风格转移:

风格转移,从手袋生成匹配的鞋设计,从鞋设计生成匹配的手袋设计:

首发于

技术备忘录

写文章

如需转载本文,请与本人联系,谢谢。 最后,欢迎关注我的专栏: 技术备忘录 - 知乎专栏,其中有更多文章。 欢迎关注本司产品 Blink Sunshine护眼无频闪97显色指数灯泡系列,提升生活品质~

最后,CVAE-GAN 的详细架构如图:

首发于

技术备忘录

写文章

CVAE-GAN 的训练算法如图,其中的每一项都是很直观的。注意里面还用了一个重要 trick, 就是希望 x' 和 x 在 D 和 C 的网络的中间层的特征也相似。这有助于稳定网络:

首发于

技术备忘录

写文章

3. 总结

通过使用 E+G+C+D 四大网络, CVAE-GAN 实现了相当令人满意的生成模型。目前的 GAN 变种非常多,大家都是把 E G C D 到处串起来,不过一般只用到三个,很少有用到四个的。 本来我想试把四个都串起来,然后发现 CVAE-GAN 已经做了,效果也确实好。 最近还有一篇 Triple GAN /pdf/1703.0229... 类似,但它没有用 VAE 作为前端,少了 E 网络,所以效果会不如。而 CycleGAN DualGAN DiscoGAN 等等把网络串起来的方式,无 疑可以与 CVAE-GAN 结合,进一步提升效果。相信 U-NET PatchGAN 等等 trick 也可以进一 步提升效果。 最后图片展示,看看目前的生成模型的发展,尤其是风格转移:

图解3种常见的深度学习网络结构:FC、CNN、RNN

图解3种常见的深度学习网络结构:FC、CNN、RNN导读:深度学习可以应用在各大领域中,根据应用情况的不同,深度神经网络的形态也各不相同。

常见的深度学习模型主要有全连接(Fully Connected,FC)网络结构、卷积神经网络(Convolutional Neural Network,CNN)和循环神经网络(Recurrent NeuralNetwork,RNN)。

它们均有着自身的特点,在不同的场景中发挥着重要作用。

本文将为读者介绍三种模型的基本概念以及它们各自适用的场景。

作者:刘祥龙杨晴虹胡晓光于佃海白浩杰深度学习技术及应用国家工程实验室百度技术学院来源:华章科技01 全连接网络结构全连接(FC)网络结构是最基本的神经网络/深度神经网络层,全连接层的每一个节点都与上一层的所有节点相连。

全连接层在早期主要用于对提取的特征进行分类,然而由于全连接层所有的输出与输入都是相连的,一般全连接层的参数是最多的,这需要相当数量的存储和计算空间。

参数的冗余问题使单纯的FC组成的常规神经网络很少会被应用于较为复杂的场景中。

常规神经网络一般用于依赖所有特征的简单场景,比如说房价预测模型和在线广告推荐模型使用的都是相对标准的全连接神经网络。

FC组成的常规神经网络的具体形式如图2-7所示。

▲图2-7 FC组成的常规神经网络02 卷积神经网络卷积神经网络(CNN)是一种专门用来处理具有类似网格结构的数据的神经网络,如图像数据(可以看作二维的像素网格)。

与FC不同的地方在于,CNN的上下层神经元并不都能直接连接,而是通过“卷积核”作为中介,通过“核”的共享大大减少了隐藏层的参数。

简单的CNN是一系列层,并且每个层都通过一个可微函数将一个量转化为另一个量,这些层主要包括卷积层(Convolutional Layer)、池化层(Pooling Layer)和全连接层(FC Layer)。

卷积网络在诸多应用领域都有很好的应用效果,特别是在大型图像处理的场景中表现得格外出色。

vgg模型结构

vgg模型结构VGG是一种深度卷积神经网络(Convolutional Neural Network,CNN),它在2014年的ImageNet图像识别挑战中大放异彩,取得了当时最好的结果。

VGG的模型结构简单而优雅,它的主要特点是使用非常小的卷积核大小(3x3),以及非常深的网络层数。

以下是VGG模型结构的详细介绍:## VGG模型结构概述VGG模型的核心是卷积层块(convolutional block),卷积层块由若干个卷积层和池化层组成。

VGG模型共有5个卷积层块,每个卷积层块里包含2~3个卷积层和一个池化层。

VGG模型的输出层是全连接层,用于进行分类。

## VGG模型结构详解下面是VGG模型结构的详细介绍:-输入层:输入图像的大小为224x224x3。

-卷积层块1:由两个卷积层和一个池化层组成。

卷积层1的内核大小为3x3,深度为64,卷积层2的内核大小为3x3,深度为64,池化层的大小为2x2,步长为2。

-卷积层块2:由两个卷积层和一个池化层组成。

卷积层1的内核大小为3x3,深度为128,卷积层2的内核大小为3x3,深度为128,池化层的大小为2x2,步长为2。

-卷积层块3:由三个卷积层和一个池化层组成。

卷积层1的内核大小为3x3,深度为256,卷积层2的内核大小为3x3,深度为256,卷积层3的内核大小为3x3,深度为256,池化层的大小为2x2,步长为2。

-卷积层块4:由三个卷积层和一个池化层组成。

卷积层1的内核大小为3x3,深度为512,卷积层2的内核大小为3x3,深度为512,卷积层3的内核大小为3x3,深度为512,池化层的大小为2x2,步长为2。

-卷积层块5:由三个卷积层和一个池化层组成。

卷积层1的内核大小为3x3,深度为512,卷积层2的内核大小为3x3,深度为512,卷积层3的内核大小为3x3,深度为512,池化层的大小为2x2,步长为2。

-全连接层:VGG模型的全连接层共有3个,每个全连接层的神经元数量为4096,最后一个全连接层的神经元数量为1000,用于进行图像分类。

基于多任务学习的深度神经网络模型研究与应用

基于多任务学习的深度神经网络模型研究与应用深度神经网络(Deep Neural Networks,DNNs)是一种逐层抽象、层次化建模的计算模型,被广泛应用于计算机视觉、自然语言处理以及音频分析等领域。

在实际应用中,深度神经网络面临着许多挑战,例如训练时间过长、过拟合等问题。

近年来,多任务学习(Multi-Task Learning,MTL)被引入到深度神经网络中,以解决这些问题。

本文将探讨基于多任务学习的深度神经网络模型的研究与应用。

一、多任务学习介绍多任务学习是机器学习领域中的一种方式,指在一个模型上同时学习多个任务。

在多任务学习中,不同的任务共享相同的特征表示,提高了模型的泛化能力,减少了训练时间和数据需求。

与传统单一任务学习不同的是,多任务学习不仅学习如何解决特定任务,还学习如何将知识转化到其他任务中。

这样,通过对多个任务进行学习,可以提高模型的鲁棒性和迁移能力。

二、基于多任务学习的深度神经网络模型基于多任务学习的深度神经网络模型是指使用深度神经网络模型进行多任务学习的模型。

该模型可以同时学习多个任务,并且通过共享部分或全部层级的参数来提高模型的泛化能力和效率。

在多任务学习中,模型的优化目标通常由多个任务的损失函数构成。

例如,在计算机视觉领域中,可以同时学习图像分类、物体检测和图像分割等多个任务。

对于每个任务,可以计算出相应的损失函数,然后将它们组合为一个多任务损失函数。

在深度神经网络模型中,多个任务通常与不同层级的神经网络相关。

因此,需要考虑如何共享不同层级的参数以提高模型性能。

为了实现参数共享,通常需要考虑多个因素,如任务之间的相关性、任务复杂性和数据集之间的差异等。

三、基于多任务学习的深度神经网络模型应用基于多任务学习的深度神经网络模型已经在许多实际应用中得到了广泛应用,如计算机视觉、自然语言处理和语音识别等领域。

在计算机视觉领域中,基于多任务学习的深度神经网络模型已经用于图像识别、物体检测和图像分割等任务。

基于深度残差网络的DeepFM点击率预测模型

基于深度残差网络的DeepFM点击率预测模型DeepFM点击率预测模型是一种基于深度残差网络的点击率预测模型。

该模型主要通过融合了元素-交互网络和深度残差网络两种方法,来解决CTR(点击率)预测中的特征稠密性和大规模特征组合的问题。

在本文中,我们将介绍DeepFM模型的结构和工作原理,并阐述它的应用。

一、模型结构介绍DeepFM点击率预测模型的主要结构是由两部分组成:FM(因子分解机)网络和深度残差网络。

1. FM网络FM网络是一个基于矩阵分解的线性模型,用于解决CTR预测中的特征稀疏性问题。

它通过利用二次项交互特征来提高模型的预测能力。

在FM网络中,每个特征的特征向量被向量矩阵V表示,并通过矩阵V的点积来计算两个特征向量之间的相似度。

矩阵V的大小为N(特征数)×K(因子数),其中K是需要预定义的超参数。

通过将V乘以输入向量x,可以计算出x与所有特征向量之间的相似度。

相似度的计算公式如下:$$\hat{y}_{FM}=w_{0}+\sum_{i=1}^{n}w_{i}x_{i}+\sum_{i=1}^{n-1}\sum_{j=1}^{n}(V_{ i} \cdot V_{j})x_{i}x_{j}$$其中, $\hat{y}_{FM}$是预测输出, $w_{0}$是偏置项, $w_{i}$是线性权重,$V_{i}$和 $V_{j}$是特征向量, $x_{i}$和 $x_{j}$是特征向量对应的特征值。

2. 残差网络深度残差网络由ResNet提出,利用跨层连接和残差块来解决深度神经网络中的梯度消失问题,可以有效增加模型的深度。

在DeepFM点击率预测模型中,我们将FM网络和残差网络结合起来,提出了一种新的深度残差FM网络,用于解决CTR预测中的特征组合问题。

在残差网络中,模型通过增加残差块,可以将浅层特征传递到深层中,从而保持网络的深度和宽度,提高模型的性能。

残差块由两个卷积层和一个跨层连接组成,其中跨层连接将输入数据添加(element-wise sum)到残差块的输出中,从而使模型学习残差。

wrn_28_2原理

wrn_28_2原理WRN-28-2原理WRN-28-2是一种广泛应用于计算机视觉领域的深度神经网络模型。

该模型的设计灵感来源于ResNet和Wide ResNet,旨在提高模型的深度和宽度,以进一步提升图像分类和目标检测等任务的性能。

WRN-28-2模型的核心原理是通过增加网络的宽度和深度来提升性能。

它通过使用更宽的卷积核和更多的卷积层来增加网络的宽度,同时通过增加残差块的数量来增加网络的深度。

具体来说,WRN-28-2模型包含了28个卷积层和2个残差块,其中每个残差块由多个卷积层和批量归一化层组成。

在网络的顶部,还有一个全连接层用于输出最终的分类结果。

相比于传统的深度神经网络模型,WRN-28-2在性能上有着显著的优势。

首先,通过增加网络的宽度,WRN-28-2可以更好地捕捉图像中的细节和特征,从而提高模型的分类准确率。

其次,通过增加网络的深度,WRN-28-2可以更好地建模复杂的图像场景,并具有更好的泛化能力。

此外,WRN-28-2还可以通过增加网络的宽度和深度来提高模型的鲁棒性和稳定性,使其在面对输入数据的变化和扰动时能够更好地保持性能。

在实际应用中,WRN-28-2可以用于图像分类、目标检测和图像分割等任务。

例如,在图像分类任务中,WRN-28-2可以对输入图像进行分类,并输出每个类别的概率。

在目标检测任务中,WRN-28-2可以检测图像中的目标,并标注出其位置和类别。

在图像分割任务中,WRN-28-2可以将图像分割为不同的区域,并对每个区域进行分类或分析。

总结起来,WRN-28-2是一种基于深度神经网络的图像分类和目标检测模型,通过增加网络的宽度和深度来提高模型的性能。

它在计算机视觉领域具有广泛的应用前景,可以在图像分类、目标检测和图像分割等任务中取得优秀的性能。

未来,随着深度学习技术的不断发展和进步,相信WRN-28-2模型还会有更多的改进和应用。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

两个选择,ACROSS_CHANNELS表示在相邻的 通道间求和归一化。WITHIN_CHANNEL表示在

GoogLeNet

VGGNet

深度网络模型详解

Minsky和Seymour Papert专著Perceptron: 单层感知机不能解决XOR问题

BN Faster R-CNN Residual Net

Clarifai

单层感知机

1969

LeNet

2017-4-27 1998

ReLU

1943

MCP神经元 数学模型

LSTM

1986

万能逼近定

AlexNet

• https:///BVLC/caffe/blob/master/mod els/bvlc_alexnet/deploy.prototxt

LRN:局部响应归一化层

• local_size: 默认为5。如果是跨通道LRN,则表示 求和的通道数;如果是在通道内LRN,则表示求 和的正方形区域长度。

理卷积神经

网络

反向传播算法

2006

Xavier

深度信念网

Dropout AlexNet

GoogLeNet VGGNet R-CNN

主要内容

• 卷积神经网络基础 • 物体分类模型

– LeNet – AlexNet – GoogLeNet – VGGNet – ResNet

• 目标检测模型

– RCNN系列 – SSD – Yolo系列

ResNet

R-CNN

Fast-R-CNN

RoI pooling!

Faster-R-CNN

RPN!

ቤተ መጻሕፍቲ ባይዱ

SSD vs Yolo

Yolo V2

• 类似SSD,使用anchor boxes • 高分辨率输入 • Batch Normalization • 聚类选择boxes • 多尺度训练

卷积神经网络

卷积计算层

卷积计算层

• 深度 • 步长 • 填充值

激励层

• Sigmoid vs ReLU

池化层

• 取区域平均或最大

解释

LeNet

• https:///BVLC/caffe/blob/master/exa mples/mnist/lenet_train_test.prototxt