帧差法代码

opencv运动检测三帧差法

opencv运动检测三帧差法三帧差法优点:实时性高缺点:1、运动物体本身颜色相近时,会出现较大的空洞。

2、无法应对光照骤变的情况理论上:三帧差法比二帧差法更好一些(可在一定程度上消除帧间差分法的“双影”现象),但是也要结合实际情况而用。

1. 帧差法基本原理帧差法的实现非常简单:如图可见,由目标运动引起的运动变化区域,包括运动目标在前后两帧中的共同位置(图中黑色区域)、在当前帧中新显露出的背景区域和新覆盖的背景区域三部分。

数学原理:三帧差法的流程:1 结果1 = (第二幅图像 - 第一幅图像) ∩ (第三幅图像 - 第二幅图像)2结果2 = 滤波(结果1)3 结果3 = 形态学处理(结果2)4结果4 = 二值化(结果3)第一步:第二幅图像减去第一幅图像的值与第三幅图像减去第二幅图像的值作交集运算.对第一步产生的结果做滤波处理.对第二步产生的结果做形态学处理.对第三步产生的结果做二值化处理.直接上代码:1.#include <opencv2/opencv.hpp>ing namespace std;ing namespace cv;4.5.int main()6.{7.//读入视频8.VideoCapture capture("1.avi"); //Laboratory_raw.avi9.//VideoCapture capture(0);10.11.Mat tempframe, currentframe, previousframe, difframe,s3;12.Mat difframe2, difframe3;13.Mat frame;14.int framenum = 0;15.//读取一帧处理16.while (true)17.{18.if (!capture.isOpened())19.{20.cout << "read video failure" << endl;21.return -1;22.}23.//tempframe = capture.read(frame);24.capture >> frame;25.imshow("原视频", frame);26.previousframe = frame.clone(); //第一帧27.28.capture >> frame;29.currentframe = frame.clone(); //第二帧30.31.capture >> frame;32.s3 = frame.clone(); //第三帧33.34.cvtColor(previousframe, previousframe, CV_BGR2GRAY);35.cvtColor(currentframe, currentframe, CV_BGR2GRAY);36.cvtColor(s3,s3, CV_BGR2GRAY);37.38.39.absdiff(currentframe, previousframe, difframe);//做差求绝对值 1-240.absdiff(previousframe, s3, difframe2);//做差求绝对值 2-341.42.43.//准备做与运算,difframe3= difframe2^difframe44.// void bitwise_and(InputArray src1, InputArray src2,OutputArray dst, InputArray mask=noArray());//dst = src1 & src245.bitwise_and(difframe, difframe2, difframe3); //46.47.48.threshold(difframe3, tempframe, 20, 255.0, CV_THRESH_BINARY);49.dilate(tempframe, tempframe, Mat());//膨胀50.erode(tempframe, tempframe, Mat());//腐蚀51.52.imshow("运动目标", tempframe);53.54.waitKey(50);55.}//end while56.}运行结果:希望对你有帮助。

【目标追踪】三帧差法原理及实现

【目标追踪】三帧差法原理及实现三帧差法原理及实现•(一)帧差法原理及实现:•(二)帧差法存在的问题:•(三)三帧差法的原理:•(四)三帧差法的实现代码:•(五)视频中的目标追踪效果:(一)帧差法原理及实现:这里可以看一下我的这篇博客,这里就不赘述了:【目标追踪】python帧差法原理及其实现(二)帧差法存在的问题:运动物体本身颜色相近时,会出现较大的空洞。

位置变化缓慢时,难以检测到目标。

对光线非常敏感。

(三)三帧差法的原理:三帧差法的关键是,不再仅仅采用相邻的两帧图片作差查找运动目标,而是在相邻三帧图片的两张帧差图中取“与”操作,即:(四)三帧差法的实现代码:(具体处理和代码解析还是推荐看一下我的上一篇博客:【目标追踪】python帧差法原理及其实现)代码:import cv2import numpy as npfrom nms import py_cpu_nmsfrom time import sleepclass Detector(object):def __init__(self, name='my_video', frame_num=10, k_size=7, color=(0, 255, 0)): = nameself.color = colorself.nms_threshold = 0.3self.time = 1/frame_num # 频率self.es = cv2.getStructuringElement(cv2.MORPH_ELLIPSE, (k_size, k_size))def catch_video(self, video_index=0, k_size=7,iterations=3, threshold=20, bias_num=1,min_area=360, show_test=True, nms=True,logical='or'):# video_index:摄像头索引(数字)或者视频路径(字符路径)# k_size:中值滤波的滤波器大小# iteration:腐蚀+膨胀的次数,0表示不进行腐蚀和膨胀操作# threshold:二值化阙值# bias_num:计算帧差图时的帧数差# min_area:目标的最小面积# show_test:是否显示二值化图片# nms:是否进行非极大值抑制# logical:三帧差取or或andlogical = logical.lower()if not bias_num > 0:raise Exception('bias_num must > 0')if isinstance(video_index, str):is_camera = False# 如果是视频,则需要调整帧率else:is_camera = Truecap = cv2.VideoCapture(video_index) # 创建摄像头识别类if not cap.isOpened():# 如果没有检测到摄像头,报错raise Exception('Check if the camera is on.')frame_num = 0previous = []while cap.isOpened():catch, frame = cap.read() # 读取每一帧图片if not catch:raise Exception('Unexpected Error.')if frame_num < bias_num:value = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY) previous = [value]*bias_numframe_num += 1raw = frame.copy()gray1 = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)gray1 = cv2.absdiff(gray1, previous[0])gray1 = cv2.medianBlur(gray1, k_size)_, mask1 = cv2.threshold(gray1, threshold, 255, cv2.THRESH_BINARY)gray2 = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)gray2 = cv2.absdiff(gray2, previous[1])gray2 = cv2.medianBlur(gray2, k_size)_, mask2 = cv2.threshold(gray2, threshold, 255, cv2.THRESH_BINARY)if logical == 'or':mask = (np.logical_or(mask1, mask2) + 0)elif logical == 'and':mask = (np.logical_and(mask1, mask2) + 0)else:raise Exception('Logical must be \'OR\' or \'AND\'')mask = (mask * 255).astype(np.uint8)mask = cv2.dilate(mask, self.es, iterations)mask = cv2.erode(mask, self.es, iterations)_, cnts, _ = cv2.findContours(mask.copy(), cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)bounds = self.nms_cnts(cnts, mask, min_area, nms=nms)for b in bounds:x, y, w, h = bthickness = (w*h)//min_areathickness = thickness if thickness <= 3 else 3thickness = thickness if thickness >= 1 else 1cv2.rectangle(frame, (x, y), (x+w, y+h), self.color, thickness) if not is_camera:sleep(self.time)cv2.imshow(, frame) # 在window上显示图片if show_test:cv2.imshow(+'_frame', mask) # 边界value = cv2.cvtColor(raw, cv2.COLOR_BGR2GRAY)previous = self.pop(previous, value)cv2.waitKey(10)if cv2.getWindowProperty(, cv2.WND_PROP_AUTOSIZE) < 1:# 点x退出breakif show_test and cv2.getWindowProperty(+'_frame', cv2.WND_PROP_AUTOSIZE) < 1:# 点x退出break# 释放摄像头cap.release()cv2.destroyAllWindows()def nms_cnts(self, cnts, mask, min_area, nms=True):# 对检测到的边界框使用非极大值抑制bounds = [cv2.boundingRect(c) for c in cnts if cv2.contourArea(c) > min_area]if len(bounds) == 0:return []if not nms:return boundsscores = [self.calculate(b, mask) for b in bounds]bounds = np.array(bounds)scores = np.expand_dims(np.array(scores), axis=-1)keep = py_cpu_nms(np.hstack([bounds, scores]), self.nms_threshold)return bounds[keep]def calculate(self, bound, mask):x, y, w, h = boundarea = mask[y:y+h, x:x+w]pos = area > 0pos = pos.astype(np.float)# 得分应与检测框大小也有关系score = np.sum(pos)/(w*h)return scoredef pop(self, l, value):l.pop(0)l.append(value)return lif __name__ == "__main__":detector = Detector(name='test')detector.catch_video('./test.avi', bias_num=2, iterations=1,k_size=5, show_test=True, min_area=360, nms=False) (五)视频中的目标追踪效果:。

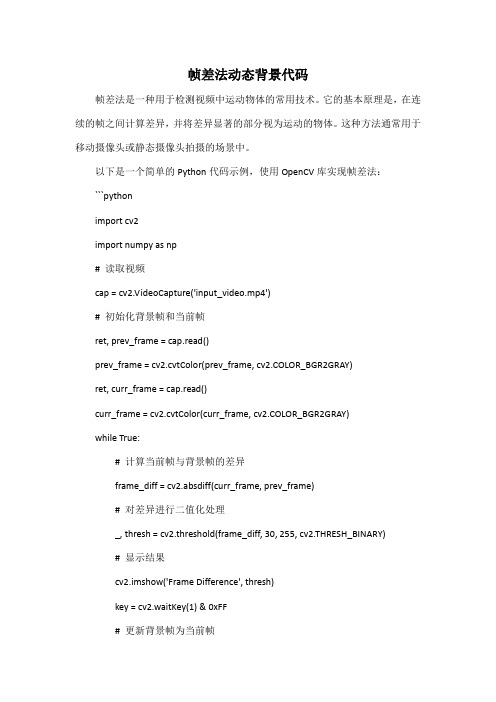

帧差法动态背景代码

帧差法动态背景代码帧差法是一种用于检测视频中运动物体的常用技术。

它的基本原理是,在连续的帧之间计算差异,并将差异显著的部分视为运动的物体。

这种方法通常用于移动摄像头或静态摄像头拍摄的场景中。

以下是一个简单的Python代码示例,使用OpenCV库实现帧差法:```pythonimport cv2import numpy as np# 读取视频cap = cv2.VideoCapture('input_video.mp4')# 初始化背景帧和当前帧ret, prev_frame = cap.read()prev_frame = cv2.cvtColor(prev_frame, cv2.COLOR_BGR2GRAY)ret, curr_frame = cap.read()curr_frame = cv2.cvtColor(curr_frame, cv2.COLOR_BGR2GRAY)while True:# 计算当前帧与背景帧的差异frame_diff = cv2.absdiff(curr_frame, prev_frame)# 对差异进行二值化处理_, thresh = cv2.threshold(frame_diff, 30, 255, cv2.THRESH_BINARY)# 显示结果cv2.imshow('Frame Difference', thresh)key = cv2.waitKey(1) & 0xFF# 更新背景帧为当前帧prev_frame = curr_frame.copy()ret, curr_frame = cap.read()curr_frame = cv2.cvtColor(curr_frame, cv2.COLOR_BGR2GRAY)# 如果按下'q'键,退出循环if key == ord('q'):break# 释放资源并关闭窗口cap.release()cv2.destroyAllWindows()```这个代码读取一个视频文件,然后逐帧计算与上一帧的差异,并对差异进行二值化处理。

帧间差分法 车辆测速 代码

帧间差分法车辆测速代码摘要:一、帧间差分法的简介二、车辆测速的方法及原理三、利用帧间差分法进行车辆测速的代码实现正文:帧间差分法是一种常用的运动目标检测与跟踪技术,通过比较连续两帧或多帧图像之间的差异,检测出运动目标并计算其运动速度。

近年来,帧间差分法已被广泛应用于智能交通、视频监控等领域,特别是在车辆测速方面取得了显著的成果。

车辆测速的方法及原理:车辆测速的基本原理是通过检测车辆在连续帧之间的运动变化,计算其速度。

一般采用的方法有:基于背景减除的测速方法、基于光流法的测速方法和基于帧间差分法的测速方法等。

其中,帧间差分法具有计算简单、实时性好、抗干扰能力强等优点,成为车辆测速领域的研究热点。

利用帧间差分法进行车辆测速的代码实现:为了实现利用帧间差分法进行车辆测速的代码,我们首先需要对视频进行预处理,包括降噪、滤波等操作,提高图像质量。

接着,采用帧间差分法计算车辆的运动变化,并提取出运动车辆的轨迹。

最后,根据轨迹信息计算车辆的速度。

以下是一个简单的Python 代码示例,用于实现帧间差分法进行车辆测速:```pythonimport cv2import numpy as npdef frame_difference(frame1, frame2):diff = cv2.absdiff(frame1, frame2)return diffdef preprocess_image(image):# 降噪、滤波等图像预处理操作return imagedef detect_moving_vehicles(video):# 读取视频cap = cv2.VideoCapture(video)# 循环遍历视频帧while cap.isOpened():ret, frame = cap.read()if not ret:break# 对每一帧进行预处理preprocessed_frame = preprocess_image(frame)# 计算帧间差分diff = frame_difference(preprocessed_frame, frame)# 检测运动车辆vehicles = cv2.inRange(diff, np.array([100, 100, 100]), np.array([255, 255, 255]))# 显示结果cv2.imshow("Vehicles", vehicles)# 按“q”键退出if cv2.waitKey(1) & 0xFF == ord("q"):break# 释放资源cap.release()cv2.destroyAllWindows()if __name__ == "__main__":video = "path/to/your/video.mp4" # 修改为你的视频文件路径detect_moving_vehicles(video)```需要注意的是,此代码仅为示例,实际应用时还需根据具体需求进行优化和调整。

三帧差分

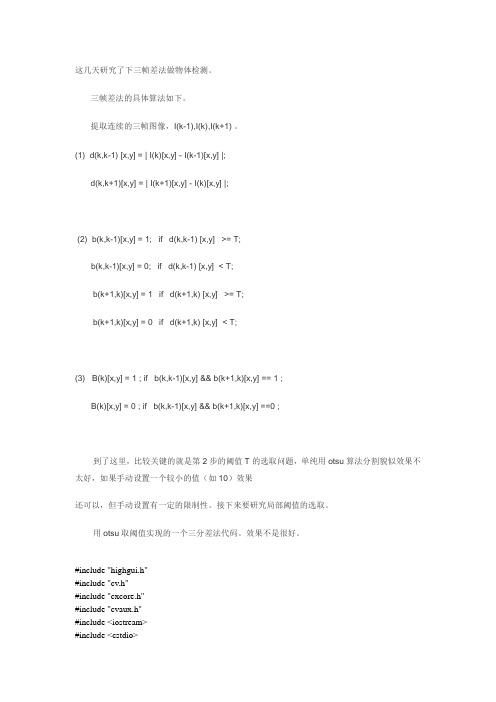

这几天研究了下三帧差法做物体检测。

三帧差法的具体算法如下。

提取连续的三帧图像,I(k-1),I(k),I(k+1) 。

(1) d(k,k-1) [x,y] = | I(k)[x,y] - I(k-1)[x,y] |;d(k,k+1)[x,y] = | I(k+1)[x,y] - I(k)[x,y] |;(2) b(k,k-1)[x,y] = 1; if d(k,k-1) [x,y] >= T;b(k,k-1)[x,y] = 0; if d(k,k-1) [x,y] < T;b(k+1,k)[x,y] = 1 if d(k+1,k) [x,y] >= T;b(k+1,k)[x,y] = 0 if d(k+1,k) [x,y] < T;(3) B(k)[x,y] = 1 ; if b(k,k-1)[x,y] && b(k+1,k)[x,y] == 1 ;B(k)[x,y] = 0 ; if b(k,k-1)[x,y] && b(k+1,k)[x,y] ==0 ;到了这里,比较关键的就是第2步的阈值T的选取问题,单纯用otsu算法分割貌似效果不太好,如果手动设置一个较小的值(如10)效果还可以,但手动设置有一定的限制性。

接下来要研究局部阈值的选取。

用otsu取阈值实现的一个三分差法代码。

效果不是很好。

#include "highgui.h"#include "cv.h"#include "cxcore.h"#include "cvaux.h"#include <iostream>#include <cstdio>#include <cstring>#include <cmath>#include <algorithm>#include <queue>#include <vector>#include <windows.h>using namespace std;//#pragma comment(lib, "highgui200.lib")//#pragma comment(lib, "cv200.lib")//#pragma comment(lib, "cxcore200.lib")//#pragma comment(lib, "cvaux200.lib")#define GET_IMAGE_DATA(img, x, y) ((uchar*)(img->imageData + img->widthStep * (y)))[x]int T = 10;int Num[300];int Sum[300];void InitPixel(IplImage * img, int &_low, int &_top){memset(Num,0,sizeof(Num));memset(Sum,0,sizeof(Sum));_low = 255;_top = 0;for(int i = 0;i < img->height;i++){for(int j = 0;j < img->width;j++){int temp = ((uchar*)(img->imageData + img->widthStep*i))[j];if(temp < _low)_low = temp;if(temp > _top)_top = temp;Num[temp] += 1;}}for(int i = 1 ; i < 256 ; i++){Sum[i] = Sum[i-1]+ i*Num[i];Num[i] += Num[i-1];}}int otsu (IplImage *img){int _low,_top,mbest=0;float mn = img->height*img->width;InitPixel(img,_low,_top);float max_otsu = 0;mbest = 0;if( _low == _top)mbest = _low;else{for(int i = _low; i< _top ; i++){float w0 = (float)((Num[_top]-Num[i]) / mn);float w1 = 1 - w0;float u0 = (float)((Sum[_top]-Sum[i])/(Num[_top]-Num[i]));float u1 = (float)(Sum[i]/Num[i]);float u = w0*u0 + w1*u1;float g = w0*(u0 - u)*(u0 - u) + w1*(u1 - u)*(u1 - u);if( g > max_otsu){mbest = i;max_otsu = g;}}}return mbest;}int main(){int ncount=0;IplImage *image1=NULL;IplImage *image2=NULL;IplImage *image3=NULL;IplImage *Imask =NULL;IplImage *Imask1=NULL;IplImage *Imask2=NULL;IplImage *Imask3=NULL;IplImage *mframe=NULL;CvCapture *capture = cvCreateFileCapture("E:\\Motion\\IndoorGTTest2.avi");//CvCapture *capture = cvCreateCameraCapture(0);cvNamedWindow("src");cvNamedWindow("dst");cvNamedWindow("Imask1");cvNamedWindow("Imask2");cvNamedWindow("Imask3");//cvCreateTrackbar("T","dst",&T,255,0);while(mframe=cvQueryFrame(capture)){DWORD start=GetTickCount();if(ncount>1000000000)ncount=100;ncount+=1;if(ncount==1){image1=cvCreateImage(cvGetSize(mframe),IPL_DEPTH_8U,1);image2=cvCreateImage(cvGetSize(mframe),IPL_DEPTH_8U,1);image3=cvCreateImage(cvGetSize(mframe),IPL_DEPTH_8U,1);Imask =cvCreateImage(cvGetSize(mframe),IPL_DEPTH_8U,1);Imask1=cvCreateImage(cvGetSize(mframe),IPL_DEPTH_8U,1);Imask2=cvCreateImage(cvGetSize(mframe),IPL_DEPTH_8U,1);Imask3=cvCreateImage(cvGetSize(mframe),IPL_DEPTH_8U,1);cvCvtColor(mframe,image1,CV_BGR2GRAY);}if(ncount==2)cvCvtColor(mframe,image2,CV_BGR2GRAY);if(ncount>=3){if(ncount==3)cvCvtColor(mframe,image3,CV_BGR2GRAY);else{cvCopy(image2,image1);cvCopy(image3,image2);cvCvtColor(mframe,image3,CV_BGR2GRAY);}cvAbsDiff(image2,image1,Imask1);cvAbsDiff(image3,image2,Imask2);//cvShowImage("Imask1",Imask1);//cvShowImage("Imask2",Imask2);int mbest1 = otsu(Imask1);cvSmooth(Imask1, Imask1, CV_MEDIAN);cvThreshold(Imask1,Imask1,mbest1, 255, CV_THRESH_BINARY);int mbest2 = otsu(Imask2);cvSmooth(Imask2,Imask2, CV_MEDIAN);cvThreshold(Imask2,Imask2,mbest2, 255, CV_THRESH_BINARY);cout<<mbest1<<" "<<mbest2<<endl;cvAnd(Imask1,Imask2,Imask);/*cvErode(Imask, Imask);cvDilate(Imask,Imask);*/DWORD finish=GetTickCount();// cout<<finish-start<<"ms"<<endl;cvShowImage("src",image2);cvShowImage("dst",Imask);}char c = cvWaitKey(30);if(c==27)break;}return 0;}\#include "stdafx.h"#include "cv.h"#include "cxcore.h"#include "highgui.h"#include "stdio.h"int main(int argc, _TCHAR* argv[]){IplImage* pFrame = NULL;IplImage* pFrImg1 = NULL;IplImage* pFrImg2 = NULL;IplImage* pFrImg3 = NULL;IplImage* result1 = NULL;IplImage* result2 = NULL;IplImage* result = NULL;IplImage* tempImg1 = NULL;CvSize size;CvMat* pFrMat1 = NULL;CvMat* pFrMat2 = NULL;CvMat* pFrMat3 = NULL;CvMat* reMat1 = NULL;CvMat* reMat2 = NULL;CvMat* reMat = NULL;CvMat* tempMat1 = NULL;CvCapture* pCapture = NULL;int nFrmNum = 0;char* reWin = "effect" + nFrmNum;cvNamedWindow("video", 1);cvNamedWindow("effect", 1);cvMoveWindow("video", 0, 0);cvMoveWindow("effect", 400, 400);if( argc != 1 ){fprintf(stderr, "Usage: bkgrd <video_file_name>\n"); return -1;}if( !(pCapture = cvCaptureFromFile("F:\\仿真结果\\B vector.avi"))){fprintf(stderr, "Can not open video file %s\n", "F:\\仿真结果\\B vector.avi");return -2;}while(pFrame = cvQueryFrame( pCapture )){nFrmNum++;if ( nFrmNum > 500){nFrmNum = 0;break;}}printf("视频帧数:%d\n",nFrmNum);cvSetCaptureProperty(pCapture,CV_CAP_PROP_POS_FRAMES,);//第一帧pFrame = cvQueryFrame( pCapture );if(nFrmNum>2){pFrImg1 = cvCreateImage(cvGetSize(pFrame),IPL_DEPTH_8U, 1);pFrImg2 = cvCreateImage(cvGetSize(pFrame), IPL_DEPTH_8U, 1);pFrImg3 = cvCreateImage(cvGetSize(pFrame), IPL_DEPTH_8U, 1);result1 = cvCreateImage(cvGetSize(pFrame), IPL_DEPTH_8U, 1);result2 = cvCreateImage(cvGetSize(pFrame), IPL_DEPTH_8U, 1);result = cvCreateImage(cvGetSize(pFrame), IPL_DEPTH_8U, 1);pFrMat1 = cvCreateMat(pFrame->height, pFrame->width, CV_8UC1);pFrMat2 = cvCreateMat(pFrame->height, pFrame->width, CV_8UC1);pFrMat3 = cvCreateMat(pFrame->height, pFrame->width, CV_8UC1);reMat1 = cvCreateMat(pFrame->height, pFrame->width,CV_8UC1);reMat2 = cvCreateMat(pFrame->height, pFrame->width,CV_8UC1);reMat = cvCreateMat(pFrame->height, pFrame->width,CV_8UC1);size = cvSize(pFrame->width, pFrame->height);tempImg1 = cvCreateImage( cvSize((size.width & -2)/2, (size.height & -2)/2), 8, 1 );}else{printf("帧数小于3!\n");return -1;}//先读取两帧cvCvtColor(pFrame, pFrImg1, CV_BGR2GRAY);cvConvert(pFrImg1, pFrMat1);pFrame = cvQueryFrame( pCapture );cvCvtColor(pFrame, pFrImg2, CV_BGR2GRAY);cvConvert(pFrImg2, pFrMat2);int count = 2;while((pFrame = cvQueryFrame( pCapture ))){count++;cvCvtColor(pFrame, pFrImg3, CV_BGR2GRAY);cvConvert(pFrImg3, pFrMat3);cvSmooth(pFrMat1, pFrMat1, CV_GAUSSIAN , 3, 1);cvSmooth(pFrMat2, pFrMat2, CV_GAUSSIAN , 3, 1);cvSmooth(pFrMat3, pFrMat3, CV_GAUSSIAN , 3, 1);//当前帧跟前一帧相减cvAbsDiff(pFrMat2, pFrMat1, reMat1);cvAbsDiff(pFrMat3, pFrMat2, reMat2);//二值化前景图cvThreshold(reMat1, result1, 60.0, 255.0, CV_THRESH_BINARY); cvThreshold(reMat2, result2, 60.0, 255.0, CV_THRESH_BINARY);///cvAdaptiveThreshold( reMat1, result1, 255,CV_ADAPTIVE_THRESH_MEAN_C, CV_THRESH_BINARY, 5, 5 );//cvAdaptiveThreshold( reMat2, result2, 255,CV_ADAPTIVE_THRESH_MEAN_C, CV_THRESH_BINARY, 5, 5 );//两个帧差值相与cvAnd(result1,result2,result,0);//使用Gaussian金字塔分解对输入图像向下采样,输出图像的高度和宽度应是输入图像的一半cvPyrDown(result, tempImg1, 7 );//对输入图像进行膨胀cvDilate(result, result, 0, 1);//使用Gaussian金字塔分解对输入图像向上采样,输出图像的高度和宽度应是输入图像的2倍cvPyrUp(tempImg1, result, 7 );//cvErode(result, result, 0, 1);//cvDilate(result, result, 0, 1);//cvPyrDown(result, tempImg1, 7 );//cvPyrUp(tempImg1, result, 7 );cvErode(result, result, 0, 3);cvDilate(result, result, 0, 3);//翻转图像,使其正立显示cvFlip(result, NULL, 0);cvShowImage("video", pFrame);cvShowImage("effect", result);cvCopy(pFrMat2, pFrMat1, NULL);cvCopy(pFrMat3, pFrMat2, NULL);if( cvWaitKey( 20 ) >= 0 )break;printf("\nFrame = %d\n", count);}//销毁窗口cvDestroyWindow("video");//cvDestroyWindow(reWin);cvDestroyWindow("effect");//释放图像和矩阵cvReleaseImage(&pFrImg1);cvReleaseImage(&pFrImg2);cvReleaseImage(&result1);cvReleaseImage(&result2);cvReleaseImage(&result);cvReleaseImage(&tempImg1);cvReleaseMat(&pFrMat1);cvReleaseMat(&pFrMat2);cvReleaseMat(&reMat1);cvReleaseMat(&reMat2);cvReleaseMat(&reMat);cvReleaseCapture(&pCapture); return 0;}。

帧差法代码讲课稿

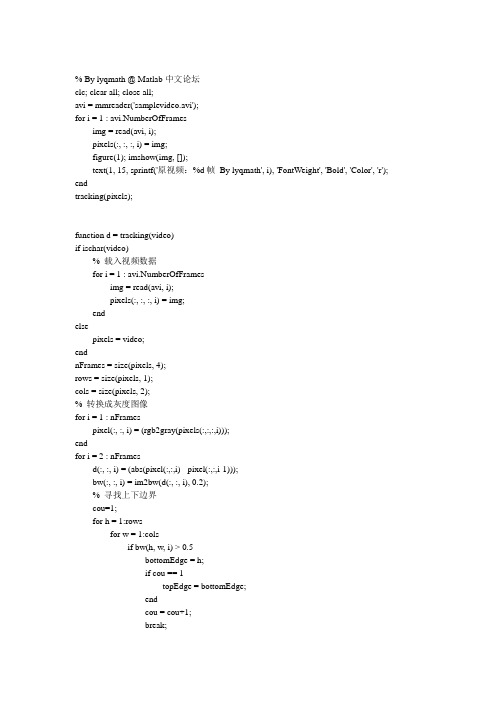

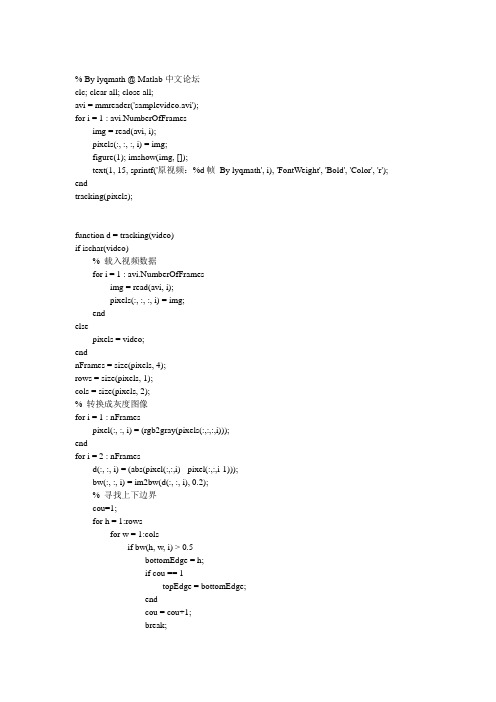

% By lyqmath @ Matlab中文论坛clc; clear all; close all;avi = mmreader('samplevideo.avi');for i = 1 : avi.NumberOfFramesimg = read(avi, i);pixels(:, :, :, i) = img;figure(1); imshow(img, []);text(1, 15, sprintf('原视频:%d帧By lyqmath', i), 'FontWeight', 'Bold', 'Color', 'r'); endtracking(pixels);function d = tracking(video)if ischar(video)% 载入视频数据for i = 1 : avi.NumberOfFramesimg = read(avi, i);pixels(:, :, :, i) = img;endelsepixels = video;endnFrames = size(pixels, 4);rows = size(pixels, 1);cols = size(pixels, 2);% 转换成灰度图像for i = 1 : nFramespixel(:, :, i) = (rgb2gray(pixels(:,:,:,i)));endfor i = 2 : nFramesd(:, :, i) = (abs(pixel(:,:,i) - pixel(:,:,i-1)));bw(:, :, i) = im2bw(d(:, :, i), 0.2);% 寻找上下边界cou=1;for h = 1:rowsfor w = 1:colsif bw(h, w, i) > 0.5bottomEdge = h;if cou == 1topEdge = bottomEdge;endcou = cou+1;break;endendend% 寻找左右边界coun=1;for w = 1:colsfor h = 1:rowsif bw(h, w, i) > 0.5rightEdge = w;if coun == 1leftEdge = rightEdge;coun = coun+1;endbreak;endendend% 矩形框生成wd = rightEdge-leftEdge;hg = bottomEdge-topEdge;widt = wd/2;heit = hg/2;cenx = leftEdge+widt;ceny = topEdge+heit;% 显示并标记figure(1);imshow(pixels(:, :, :, i), []);hold onrectangle('Position',[leftEdge topEdge wd hg], 'EdgeColor', 'r', 'LineWidth', 2);plot(cenx, ceny, 'ko', 'MarkerFaceColor', 'y', 'MarkerSize', 20, 'LineWidth', 2);text(1, 15, sprintf('跟踪视频:%d帧By lyqmath', i), 'FontWeight', 'Bold', 'Color', 'r');hold offEnd另一段代码% By lyqmathclc; clear all; close all;% 原始视频targetavi = 'traffic.avi';% 检测结果视频resultavi = 'c:\\result.avi';%% 读取视频mov = mmreader(targetavi);fnum = mov.NumberOfFrames;%% 建立结果视频aviobj = avifile(resultavi);aviobj.Quality = 100;aviobj.Fps = 25;pression = 'Indeo5';%% 帧间差分法figure(1);for i = 2 : fnumx = read(mov, i-1);y = read(mov, i);subplot(1, 2, 1); imshow(x, []); title(sprintf('第%d帧视频,By lyqmath', i-1), 'FontWeight', 'Bold', 'Color', 'r');% 灰度化if ndims(x) == 3m = rgb2gray(x);elsem = x;endif ndims(y) == 3n = rgb2gray(y);elsen = y;end% 中值滤波m = medfilt2(m);n = medfilt2(n);% 数据类型转换q = im2double(n);w = im2double(m);% 差分c = q-w;% 阈值,此值可以调节t = 40/256;% 阈值分割c(abs(c)>=t)=255;c(abs(c)<t) = 0;c = logical(c);x1 = x(:, :, 1); x2 = x(:, :, 2); x3 = x(:, :, 3);x1(c) = 255; x2(c) = 0; x3(c) = 0;xc = cat(3, x1, x2, x3);subplot(1, 2, 2); imshow(xc, []); title(sprintf('第%d帧视频识别结果,By lyqmath', i-1), 'FontWeight', 'Bold', 'Color', 'r');f = getframe(gcf);f = frame2im(f);% 生成视频aviobj = addframe(aviobj, f);end%% 关闭视频句柄aviobj = close(aviobj);第三段代码mov=aviread('CIMG0003.AVI');temp=size(mov);fnum=temp(2);for i=1:fnum,strtemp=strcat(int2str(i),'.','JPG');imwrite(mov(i).cdata(:,:,:),strtemp);end%% 从视频中提出每一帧图像o=1;e='.jpg';for i=1:15u=o-1;v=o-2;m=int2str(o);n=int2str(u);h=int2str(v);s=strcat(m,e);%%把字符串b与m连接后在连接e得到图像文件存储的位置m=imread(s);%%从S处把图像读取出来m=rgb2gray(m);%%将图像M灰度化m=medfilt2(m,[3,3]);if(o>=3)s=strcat(n,e);n=imread(s);n=rgb2gray(n);s=strcat(h,e);h=imread(s);h=rgb2gray(h);n=medfilt2(n,[3,3]);h=medfilt2(h,[3,3]);q=im2double(m);%%将图像数组转换为double型w=im2double(n); g=im2double(h);c=q-w;j=w-g;th=10/255;k=find(abs(c)>=th);c(k)=1;k=find(abs(c)<th);c(k)=0;c=bwareaopen(c,15);se90=strel ('line',3,90);se0=strel ('line',3,0);c=bwmorph(c,'close'); %对上述图像进行形态学闭运算c=imdilate(c,[se90,se0]);c=bwmorph(c,'close');c=bwareaopen(c,50);k=find(abs(j)>=th);j(k)=1;k=find(abs(j)<th);j(k)=0;j=bwareaopen(j,15);j=bwmorph(j,'close'); %对上述图像进行形态学闭运算j=imdilate(j,[se90,se0]);j=bwmorph(j,'close');c=bwareaopen(c,50);c=c&j;c=imerode(c,[se90,se0]);figure,imshow(c);a=c;b=c; d=c;f=c;[m,n]=size(c);%%行扫描填充for i=1:mfor j=1:n-1if a(i,j)>0a(i,j+1)=1;endendendfor i=1:mfor j=n:-1:2if b(i,j)>0b(i,j-1)=1;endendendth=a&b;%%列扫描填充for i=1:nfor j=1:m-1if d(j,i)>0d(j+1,i)=1;endendendfor i=1:nfor j=m:-1:2if f(j,i)>0f(j-1,i)=1;endendendtd=d&f;c=th&td;endo=o+1;end。

三帧差法 matlab

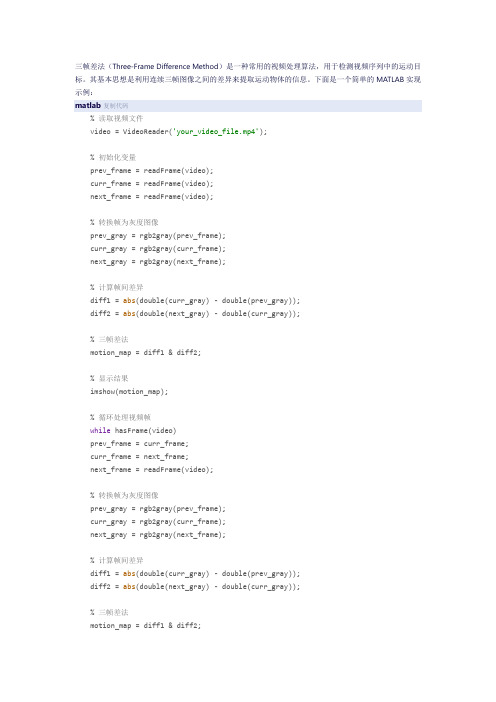

三帧差法(Three-Frame Difference Method)是一种常用的视频处理算法,用于检测视频序列中的运动目标。

其基本思想是利用连续三帧图像之间的差异来提取运动物体的信息。

下面是一个简单的MATLAB实现示例:matlab复制代码% 读取视频文件video = VideoReader('your_video_file.mp4');% 初始化变量prev_frame = readFrame(video);curr_frame = readFrame(video);next_frame = readFrame(video);% 转换帧为灰度图像prev_gray = rgb2gray(prev_frame);curr_gray = rgb2gray(curr_frame);next_gray = rgb2gray(next_frame);% 计算帧间差异diff1 = abs(double(curr_gray) - double(prev_gray));diff2 = abs(double(next_gray) - double(curr_gray));% 三帧差法motion_map = diff1 & diff2;% 显示结果imshow(motion_map);% 循环处理视频帧while hasFrame(video)prev_frame = curr_frame;curr_frame = next_frame;next_frame = readFrame(video);% 转换帧为灰度图像prev_gray = rgb2gray(prev_frame);curr_gray = rgb2gray(curr_frame);next_gray = rgb2gray(next_frame);% 计算帧间差异diff1 = abs(double(curr_gray) - double(prev_gray));diff2 = abs(double(next_gray) - double(curr_gray));% 三帧差法motion_map = diff1 & diff2;% 显示结果imshow(motion_map);% 暂停以便观察结果pause(0.01);end% 释放视频文件release(video);在这个示例中,我们首先使用VideoReader对象读取视频文件,并将连续的三帧转换为灰度图像。

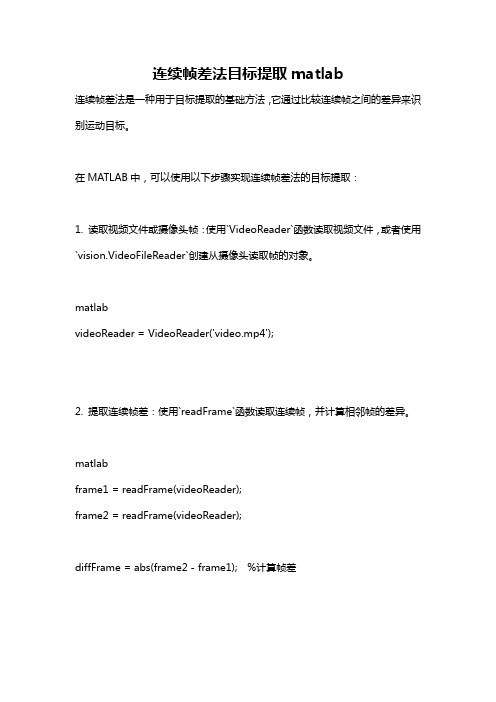

连续帧差法目标提取matlab

连续帧差法目标提取matlab连续帧差法是一种用于目标提取的基础方法,它通过比较连续帧之间的差异来识别运动目标。

在MATLAB中,可以使用以下步骤实现连续帧差法的目标提取:1. 读取视频文件或摄像头帧:使用`VideoReader`函数读取视频文件,或者使用`vision.VideoFileReader`创建从摄像头读取帧的对象。

matlabvideoReader = VideoReader('video.mp4');2. 提取连续帧差:使用`readFrame`函数读取连续帧,并计算相邻帧的差异。

matlabframe1 = readFrame(videoReader);frame2 = readFrame(videoReader);diffFrame = abs(frame2 - frame1); %计算帧差3. 阈值处理:根据差异帧的灰度值进行二值化或阈值处理,得到目标区域。

matlabthreshold = 30; %设置阈值binaryFrame = diffFrame > threshold; %二值化处理4. 目标提取和分析:根据二值化结果,可以使用形态学操作(如膨胀、腐蚀)进一步处理,以提取和分析目标区域。

matlabse = strel('disk', 5); %创建膨胀的结构元素binaryFrameDilated = imdilate(binaryFrame, se); %膨胀操作[target, num] = bwlabel(binaryFrameDilated); %标记连接的目标5. 可视化结果:将提取的目标区域标记在原始帧上,以进行可视化展示。

matlabfigure;imshow(frame2); %显示原始帧hold on;boundaries = bwboundaries(target); %提取目标边界for k = 1:length(boundaries)boundary = boundaries{k};plot(boundary(:,2), boundary(:,1), 'r', 'LineWidth', 2);endhold off;上述步骤可以根据实际应用需要进行适当的修改和优化。

三帧差分法

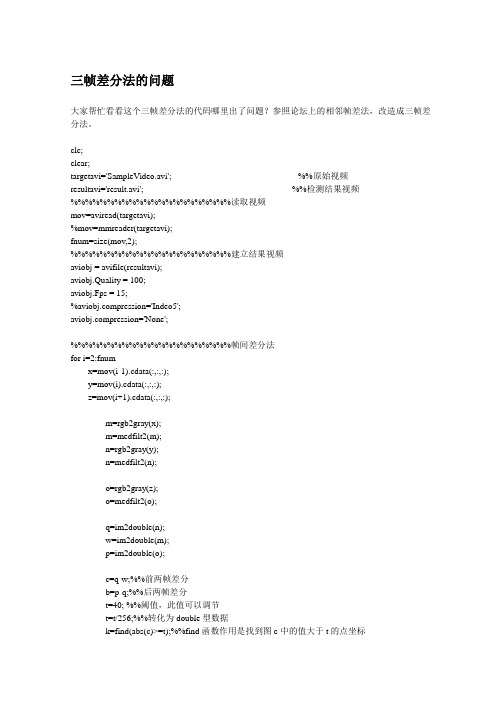

三帧差分法的问题大家帮忙看看这个三帧差分法的代码哪里出了问题?参照论坛上的相邻帧差法,改造成三帧差分法。

clc;clear;targetavi='SampleVideo.avi'; %%原始视频resultavi='result.avi'; %%检测结果视频%%%%%%%%%%%%%%%%%%%%%%读取视频mov=aviread(targetavi);%mov=mmreader(targetavi);fnum=size(mov,2);%%%%%%%%%%%%%%%%%%%%%%建立结果视频aviobj = avifile(resultavi);aviobj.Quality = 100;aviobj.Fps = 15;%pression='Indeo5';pression='None';%%%%%%%%%%%%%%%%%%%%%%帧间差分法for i=2:fnumx=mov(i-1).cdata(:,:,:);y=mov(i).cdata(:,:,:);z=mov(i+1).cdata(:,:,:);m=rgb2gray(x);m=medfilt2(m);n=rgb2gray(y);n=medfilt2(n);o=rgb2gray(z);o=medfilt2(o);q=im2double(n);w=im2double(m);p=im2double(o);c=q-w;%%前两帧差分b=p-q;%%后两帧差分t=40; %%阈值,此值可以调节t=t/256;%%转化为double型数据k=find(abs(c)>=t);%%find函数作用是找到图c中的值大于t的点坐标d=find(abs(b)>=t);%%find函数作用是找到图b中的值大于t的点坐标c(k)=255;%%二值化的一b(d)=255;k=find(abs(c)<t);d=find(abs(b)<t);c(k)=0;%%二值化的零b(d)=0;f=c&b;imshow(f);adata=cat(3,f,f,f);%%灰度图像生成视频必加此句aviobj = addframe(aviobj,adata);%%生成视频hold on;drawnow;hold off;endaviobj=close(aviobj);显示的错误提示:??? Error using ==> avifile.addframe>getInputType at 384Invalid input argument. Each frame must be a numeric matrix, a MA TLAB movie structure, or a handle to a figureor axis.Error in ==> avifile.addframe at 58inputType = getInputType(varargin{i});Error in ==> ThreeFrameDifference at 61aviobj = addframe(aviobj,adata);%%生成视频TOPMatlab中文函数大全上线,欢迎大家完善!点。

三帧差分法

三帧差分法基于OpenCV实现的三帧差分法代码基于帧间差分法进行升级的三帧差分法,不同的测试视频可以设置不同二值化阈值来增强效果。

根据实际情况进行形态学处理。

[cpp] view plain copy1. #include <opencv2/highgui/highgui.hpp>2. #include<opencv2/imgproc/imgproc.hpp> 3. #include <opencv2/core/core.hpp>4.5. #define threshold_diff1 25 //设置简单帧差法阈值6. #define threshold_diff2 25 //设置简单帧差法阈值7.8. using namespace cv;9. using namespace std;10.11. int main(int argc,unsigned char* argv[]) 12. {13. Mat img_src1,img_src2,img_src3;//3帧法需要3帧图片 14. Mat img_dst,gray1,gray2,gray3;15. Mat gray_diff1,gray_diff2;//存储2次相减的图片 16. Matgray_diff11,gray_diff12;17. Mat gray_diff21,gray_diff22;18. Mat gray;//用来显示前景的19. bool pause=false;20.21. VideoCapture vido_file("test3.avi");//在这里改相应的文件名 22. namedWindow("foreground",0);23. for (;;)24. {25. if(!false)26. {27. vido_file >>img_src1; 28. cvtColor(img_src1,gray1,CV_BGR2GRAY);29.30. waitKey(33);31. vido_file >>img_src2; 32. cvtColor(img_src2,gray2,CV_BGR2GRAY);33. imshow("video_src",img_src2);//34.35. waitKey(33);36. vido_file >>img_src3;37. cvtColor(img_src3,gray3,CV_BGR2GRAY);38.39. Sobel(gray1,gray1, CV_8U,1,0,3,0.4,128);40. Sobel(gray2,gray2, CV_8U,1,0,3,0.4,128);41. Sobel(gray3,gray3, CV_8U,1,0,3,0.4,128);42.43. subtract(gray2,gray1,gray_diff11);//第二帧减第一帧44. subtract(gray1,gray2,gray_diff12);45. add(gray_diff11,gray_diff12,gray_diff1); 46.subtract(gray3,gray2,gray_diff21);//第三帧减第二帧47. subtract(gray2,gray3,gray_diff22); 48.add(gray_diff21,gray_diff22,gray_diff2);49.50. for(int i=0;i<gray_diff1.rows;i++)51. for(int j=0;j<gray_diff1.cols;j++) 52. {53. if(abs(gray_diff1.at<unsigned char>(i,j))>=threshold_diff1)//这里模板参数一定要用unsigned char,否则就一直报错54. gray_diff1.at<unsigned char>(i,j)=255; //第一次相减阈值处理 55. else gray_diff1.at<unsigned char>(i,j)=0;56.57. if(abs(gray_diff2.at<unsigned char>(i,j))>=threshold_diff2)//第二次相减阈值处理58. gray_diff2.at<unsigned char>(i,j)=255;59. else gray_diff2.at<unsigned char>(i,j)=0;60. }61. bitwise_and(gray_diff1,gray_diff2,gray);62.63. dilate(gray,gray,Mat());erode(gray,gray,Mat());64.65. imshow("foreground",gray); 66. }67. if( cvWaitKey(33) >= 0 ) 68. break;69. }70. return 0;71. }。

帧间差分法 车辆测速 代码

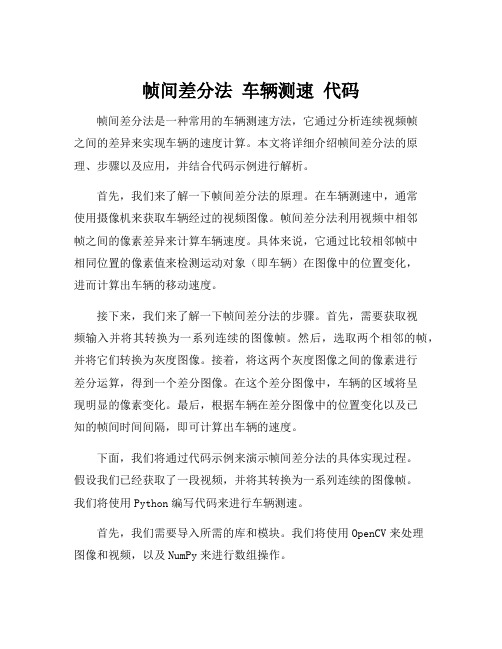

帧间差分法车辆测速代码帧间差分法是一种常用的车辆测速方法,它通过分析连续视频帧之间的差异来实现车辆的速度计算。

本文将详细介绍帧间差分法的原理、步骤以及应用,并结合代码示例进行解析。

首先,我们来了解一下帧间差分法的原理。

在车辆测速中,通常使用摄像机来获取车辆经过的视频图像。

帧间差分法利用视频中相邻帧之间的像素差异来计算车辆速度。

具体来说,它通过比较相邻帧中相同位置的像素值来检测运动对象(即车辆)在图像中的位置变化,进而计算出车辆的移动速度。

接下来,我们来了解一下帧间差分法的步骤。

首先,需要获取视频输入并将其转换为一系列连续的图像帧。

然后,选取两个相邻的帧,并将它们转换为灰度图像。

接着,将这两个灰度图像之间的像素进行差分运算,得到一个差分图像。

在这个差分图像中,车辆的区域将呈现明显的像素变化。

最后,根据车辆在差分图像中的位置变化以及已知的帧间时间间隔,即可计算出车辆的速度。

下面,我们将通过代码示例来演示帧间差分法的具体实现过程。

假设我们已经获取了一段视频,并将其转换为一系列连续的图像帧。

我们将使用Python编写代码来进行车辆测速。

首先,我们需要导入所需的库和模块。

我们将使用OpenCV来处理图像和视频,以及NumPy来进行数组操作。

import cv2import numpy as np```接下来,我们定义一个函数来对相邻两帧之间的像素进行差分运算,并返回差分图像。

```pythondef frame_difference(frame1, frame2):gray1 = cv2.cvtColor(frame1, cv2.COLOR_BGR2GRAY) # 将帧转换为灰度图像gray2 = cv2.cvtColor(frame2, cv2.COLOR_BGR2GRAY)diff = cv2.absdiff(gray1, gray2) # 计算帧差_, diff = cv2.threshold(diff, 30, 255,cv2.THRESH_BINARY) # 二值化图像return diff```然后,我们定义一个函数来计算车辆的速度。

前景检测算法_2(帧差法1)

前景检测算法_2(帧差法1) 帧差法是背景减图法中的⼀种,只不过是帧差法不需要建模,因为它的背景模型就是上⼀帧的图,所以速度⾮常快,另外帧差法对缓慢变换的光照不是很敏感,所以其⽤途还是有的,有不少学者对其做出了出⾊的改进。

其基本原理可以⽤下⾯公式看出: |i(t)-i(t-1)|<T 背景 |i(t)-i(t-1)|>=T 前景 其中i(t),i(t-1)分别为t,t-1时刻对应像素点的像素值,T为阈值。

当然其缺点也不少,容易出现”双影”和”空洞”现象。

⽤opencv2.3.1+vs2010做了个简单的实验,其实验代码如下:1// frame_diff.cpp : 定义控制台应⽤程序的⼊⼝点。

2//34 #include "stdafx.h"5 #include <opencv2/highgui/highgui.hpp>6 #include <opencv2/imgproc/imgproc.hpp>7 #include <opencv2/core/core.hpp>89#define threshold_diff 20 //设置简单帧差法阈值1011using namespace cv;12using namespace std;1314int main(int argc,unsigned char* argv[])15 {16 Mat img_src1,img_src2,img_dst,gray1,gray2,gray_diff;17bool pause=false;1819 VideoCapture vido_file("IndoorGTTest1.avi");//在这⾥改相应的⽂件名20 namedWindow("foreground",0);21for (;;)22 {23if(!pause)24 {25 vido_file >>img_src1; //因为视频⽂件帧数已经固定了,所以每次到这句语句都是读取相邻的帧数,没到时间视频并不向前⾛26 cvtColor(img_src1,gray1,CV_BGR2GRAY);27 imshow("video_src",img_src1);//可以事先不⽤新建⼀个窗⼝28 waitKey(5);2930 vido_file >>img_src2;31 cvtColor(img_src2,gray2,CV_BGR2GRAY);32 imshow("video_src",img_src2);//可以事先不⽤新建⼀个窗⼝3334 waitKey(5);35 subtract(gray1,gray2,gray_diff);36for(int i=0;i<gray_diff.rows;i++)37for(int j=0;j<gray_diff.cols;j++)38if(abs(gray_diff.at<unsigned char>(i,j))>=threshold_diff)//这⾥模板参数⼀定要⽤unsigned char,否则就⼀直报错39 gray_diff.at<unsigned char>(i,j)=255;40else gray_diff.at<unsigned char>(i,j)=0;4142 imshow("foreground",gray_diff);43 }44char c=(char)waitKey(10);45if (c==27)46 {47break;48 }49if(c=='')50 pause=!pause;51 }52return0;53 } 实验结果如下: 可以看出其“双影”和”空洞”⽐较明显。

OpenCV实现帧差法检测运动目标

OpenCV实现帧差法检测运动⽬标今天的⽬标是⽤OpenCV实现对运动⽬标的检测,这⾥选⽤三帧帧差法。

代码如下:#include <opencv2/opencv.hpp>#include <cv.h>#include <highgui.h>#include <stdio.h>#include <ctype.h>double Threshold_index=0;const int CONTOUR_MAX_AERA = 200;void trackbar(int pos){Threshold_index=(double)pos;}int main(int argc, char* argv[]){CvCapture *capture=cvCaptureFromCAM(0);int n_cnt=0;IplImage *img=NULL,*img_gray1=NULL,*img_gray2=NULL,*img_gray3=NULL,*img_diff1=NULL,*img_diff2=NULL,*img_diff_and=NULL,*img_binary=NULL,*img_dilate=NULL;CvMemStorage *stor;CvSeq *cont;stor=cvCreateMemStorage(0);cont=cvCreateSeq(CV_SEQ_ELTYPE_POINT,sizeof(CvSeq),sizeof(CvPoint),stor);cvNamedWindow("test",CV_WINDOW_AUTOSIZE);cvNamedWindow("dilate",CV_WINDOW_AUTOSIZE);img=cvQueryFrame(capture);img_gray1=cvCreateImage(cvGetSize(img),IPL_DEPTH_8U,1);img_gray2=cvCreateImage(cvGetSize(img),IPL_DEPTH_8U,1);img_gray3=cvCreateImage(cvGetSize(img),IPL_DEPTH_8U,1);img_diff1=cvCreateImage(cvGetSize(img),IPL_DEPTH_8U,1);img_diff2=cvCreateImage(cvGetSize(img),IPL_DEPTH_8U,1);img_diff_and=cvCreateImage(cvGetSize(img),IPL_DEPTH_8U,1);img_binary=cvCreateImage(cvGetSize(img),IPL_DEPTH_8U,1);img_dilate=cvCreateImage(cvGetSize(img),IPL_DEPTH_8U,1);int index=1;cvCreateTrackbar("Threshold","test",&index,255,trackbar);while(img=cvQueryFrame(capture)){if(n_cnt%3==0)cvCvtColor(img,img_gray1,CV_BGR2GRAY);else if(n_cnt%3==1)cvCvtColor(img,img_gray2,CV_BGR2GRAY);else if(n_cnt%3==2)cvCvtColor(img,img_gray3,CV_BGR2GRAY);char c=(char)cvWaitKey(25);if(c==27)break;if(n_cnt>3){cvAbsDiff(img_gray1,img_gray2,img_diff1);cvAbsDiff(img_gray2,img_gray3,img_diff2);cvAnd(img_diff1,img_diff2,img_diff_and);cvThreshold(img_diff_and,img_binary,Threshold_index,255,CV_THRESH_BINARY);cvShowImage("test",img_binary);cvDilate(img_binary,img_dilate);//cvShowImage("dilate",img_dilate);cvFindContours(img_dilate,stor,&cont,sizeof(CvContour),CV_RETR_LIST,CV_CHAIN_APPROX_SIMPLE,cvPoint(0,0));for(;cont;cont = cont->h_next){CvRect r = ((CvContour*)cont)->rect;//⼦类转换为⽗类例⼦if(r.height * r.width > CONTOUR_MAX_AERA) // ⾯积⼩的⽅形抛弃掉{cvRectangle(img, cvPoint(r.x,r.y),cvPoint(r.x + r.width, r.y + r.height),CV_RGB(255,0,0), 1, CV_AA,0);}}cvShowImage("dilate",img);}if(c=='s'){cvSaveImage("d:/img.bmp",img);cvSaveImage("d:/img_binary.bmp",img_dilate);}n_cnt++;}cvDestroyAllWindows();cvReleaseCapture(&capture);cvReleaseImage(&img_gray1);cvReleaseImage(&img_gray2);cvReleaseImage(&img_gray3);cvReleaseImage(&img_diff1);cvReleaseImage(&img_diff2);cvReleaseImage(&img_diff_and);cvReleaseImage(&img_binary);cvReleaseImage(&img_dilate);cvReleaseMemStorage(&stor);return 0;}下图是检测的运动⽬标⼆值化图像以及在实际图像中叠加的矩形框效果图。

帧差法动态背景代码 -回复

帧差法动态背景代码-回复帧差法动态背景代码是一种用于识别和提取视频序列中移动物体的计算机视觉技术。

它通过比较连续的视频帧之间的差异来确定移动物体的位置和形状。

在本文中,我将逐步解释帧差法动态背景代码的工作原理和实现步骤,并讨论它的应用和潜在挑战。

第一步:导入所需的库和工具在编写帧差法动态背景代码之前,我们需要导入所需的库和工具。

常用的库包括OpenCV和NumPy,它们提供了用于图像处理和计算的各种功能。

我们还需要一个用于读取视频序列的帧的工具,例如VideoCapture。

第二步:读取视频序列使用VideoCapture工具,我们可以从视频文件中逐帧读取图像。

我们可以将每一帧图像视为时间上的一个快照,通过比较连续的帧图像差异,我们可以找到移动物体的变化。

第三步:转换图像到灰度为了方便比较和计算,我们通常将图像转换为灰度图像。

灰度图像只有一个通道,每个像素的值表示该像素的亮度。

这样,我们可以将图像的每个像素看作是在空间和时间上的一个点。

第四步:计算帧差通过比较连续的帧图像的差异,我们可以得到一个表示移动物体的二进制图像。

这个过程就是帧差法的核心。

我们可以使用差分操作符(如绝对差分或相对差分)计算每个像素的差异。

我们还可以设置一个差异阈值,当帧差超过该阈值时,我们可以确定该像素处的物体发生了移动。

第五步:提取移动物体的轮廓通过对帧差图像进行形态学操作(例如腐蚀和膨胀),我们可以去除图像中的噪声,并填充移动物体的空洞。

然后,我们可以使用轮廓检测算法(如findContours)提取移动物体的轮廓。

第六步:绘制边界框根据提取的移动物体的轮廓,我们可以在原始帧图像上绘制一个边界框,将移动物体标注出来。

这可以帮助我们更直观地理解和观察移动物体的位置和形状。

第七步:可选的后处理步骤根据实际需求,我们还可以进行一些额外的后处理步骤,以进一步优化移动物体的提取结果。

例如,我们可以使用背景建模技术来估计和更新背景图像,从而减少错误的移动物体提取。

python+opencv实现移动侦测(帧差法)

python+opencv实现移动侦测(帧差法)本⽂实例为⼤家分享了python+opencv实现移动侦测的具体代码,供⼤家参考,具体内容如下1.帧差法原理移动侦测即是根据视频每帧或者⼏帧之间像素的差异,对差异值设置阈值,筛选⼤于阈值的像素点,做掩模图即可选出视频中存在变化的桢。

帧差法较为简单的视频中物体移动侦测,帧差法分为:单帧差、两桢差、和三桢差。

随着帧数的增加是防⽌检测结果的重影。

2.算法思路⽂章以截取视频为例进⾏单帧差法移动侦测3.python实现代码def threh(video,save_video,thres1,area_threh):cam = cv2.VideoCapture(video)#打开⼀个视频input_fps = cam.get(cv2.CAP_PROP_FPS)ret_val, input_image = cam.read()index=[]images=[]images.append(input_image)video_length = int(cam.get(cv2.CAP_PROP_FRAME_COUNT))input_image=cv2.resize(input_image,(512,512))ending_frame = video_lengthfourcc = cv2.VideoWriter_fourcc(*'XVID')out = cv2.VideoWriter(save_video,fourcc, input_fps, (512, 512))gray_lwpCV = cv2.cvtColor(input_image, cv2.COLOR_BGR2GRAY)gray_lwpCV = cv2.GaussianBlur(gray_lwpCV, (21, 21), 0)background=gray_lwpCV# es = cv2.getStructuringElement(cv2.MORPH_ELLIPSE, (9, 4))i = 0 # default is 0outt=[]while(cam.isOpened()) and ret_val == True and i <2999:## if i % 2==1:ret_val, input_image = cam.read()input_image=cv2.resize(input_image,(512,512))gray_lwpCV = cv2.cvtColor(input_image, cv2.COLOR_BGR2GRAY)gray_lwpCV = cv2.GaussianBlur(gray_lwpCV, (21, 21), 0)diff = cv2.absdiff(background, gray_lwpCV)outt.append(diff)#跟着图像变换背景tem_diff=diff.flatten()tem_ds=pd.Series(tem_diff)tem_per=1-len(tem_ds[tem_ds==0])/len(tem_ds)if (tem_per <0.2 )| (tem_per>0.75):background=gray_lwpCVelse:diff = cv2.threshold(diff, thres1, 255, cv2.THRESH_BINARY)[1]ret,thresh = cv2.threshold(diff.copy(),150,255,0)contours, hierarchy = cv2.findContours(thresh,cv2.RETR_EXTERNAL,cv2.CHAIN_APPROX_SIMPLE)# contours, hierarchy = cv2.findContours(diff.copy(), cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)for c in contours:if (cv2.contourArea(c) < area_threh) | (cv2.contourArea(c) >int(512*512*0.3) ) : # 对于矩形区域,只显⽰⼤于给定阈值的轮廓(去除微⼩的变化等噪点) continue(x, y, w, h) = cv2.boundingRect(c) # 该函数计算矩形的边界框cv2.rectangle(input_image, (x, y), (x+w, y+h), (0, 255, 0), 2)index.append(i)# cv2.imshow('contours', input_image)# cv2.imshow('dis', diff)out.write(input_image)images.append(input_image)i = i+1out.release()cam.release()return outt,index,images```##调取函数outt=threh('new_video.mp4','test6.mp4',25,3000)以上就是本⽂的全部内容,希望对⼤家的学习有所帮助,也希望⼤家多多⽀持。

verilog帧差法 -回复

verilog帧差法-回复关于Verilog帧差法的实现方法。

Verilog是一种硬件描述语言,用于设计和模拟数字电路。

在数字图像处理中,帧差法(Frame differencing)是一种常用的方法,用于检测和跟踪运动物体。

本文将介绍如何使用Verilog语言实现帧差法。

1. 设计概述:帧差法通过比较当前帧和前一帧之间的差异来检测运动物体。

具体而言,我们将像素点的亮度值相减,并根据差值确定物体是否发生了移动。

在本设计中,我们使用一维数组作为帧存储器,每个存储单元表示图像的一个像素点。

2. 设计步骤:2.1 初始化:首先,我们需要初始化图像帧存储器和其他必要的信号。

我们可以使用Verilog的initial模块来实现初始化。

假设我们的图像宽度为N,高度为M,像素位宽为P,我们可以定义一个二维数组frame[N][M]和一个信号last_frame[N][M],用于存储前一帧和当前帧的图像。

2.2 差值计算:接下来,我们需要计算当前帧和前一帧之间的差异。

为此,我们可以使用一个循环结构,逐个比较每个像素点的亮度值。

假设我们用信号diff[N][M]表示差异值,我们可以使用如下的伪代码来计算差异:for(i=0; i<N; i=i+1) beginfor(j=0; j<M; j=j+1) begindiff[i][j] = abs(frame[i][j] - last_frame[i][j]);endend在这个循环中,我们通过取绝对值函数abs来计算像素点的差值。

这个差值将被用于后续的运动检测。

2.3 运动检测:运动检测是帧差法的关键步骤,它通过阈值判决来确定物体是否发生了移动。

阈值的选择取决于具体的应用场景和图像质量。

我们可以使用Verilog中的if语句来实现阈值判决。

在我们的设计中,假设我们有一个信号motion_detection,用于表示物体是否发生了移动。

我们可以使用如下的伪代码来实现运动检测:for(i=0; i<N; i=i+1) beginfor(j=0; j<M; j=j+1) beginif(diff[i][j] > threshold) beginmotion_detection = 1;endendend在这个循环中,我们将根据差异值和预设的阈值进行判决。

帧差法代码

% By lyqmath @ Matlab中文论坛clc; clear all; close all;avi = mmreader('samplevideo.avi');for i = 1 : avi.NumberOfFramesimg = read(avi, i);pixels(:, :, :, i) = img;figure(1); imshow(img, []);text(1, 15, sprintf('原视频:%d帧By lyqmath', i), 'FontWeight', 'Bold', 'Color', 'r'); endtracking(pixels);function d = tracking(video)if ischar(video)% 载入视频数据for i = 1 : avi.NumberOfFramesimg = read(avi, i);pixels(:, :, :, i) = img;endelsepixels = video;endnFrames = size(pixels, 4);rows = size(pixels, 1);cols = size(pixels, 2);% 转换成灰度图像for i = 1 : nFramespixel(:, :, i) = (rgb2gray(pixels(:,:,:,i)));endfor i = 2 : nFramesd(:, :, i) = (abs(pixel(:,:,i) - pixel(:,:,i-1)));bw(:, :, i) = im2bw(d(:, :, i), 0.2);% 寻找上下边界cou=1;for h = 1:rowsfor w = 1:colsif bw(h, w, i) > 0.5bottomEdge = h;if cou == 1topEdge = bottomEdge;endcou = cou+1;break;endendend% 寻找左右边界coun=1;for w = 1:colsfor h = 1:rowsif bw(h, w, i) > 0.5rightEdge = w;if coun == 1leftEdge = rightEdge;coun = coun+1;endbreak;endendend% 矩形框生成wd = rightEdge-leftEdge;hg = bottomEdge-topEdge;widt = wd/2;heit = hg/2;cenx = leftEdge+widt;ceny = topEdge+heit;% 显示并标记figure(1);imshow(pixels(:, :, :, i), []);hold onrectangle('Position',[leftEdge topEdge wd hg], 'EdgeColor', 'r', 'LineWidth', 2);plot(cenx, ceny, 'ko', 'MarkerFaceColor', 'y', 'MarkerSize', 20, 'LineWidth', 2);text(1, 15, sprintf('跟踪视频:%d帧By lyqmath', i), 'FontWeight', 'Bold', 'Color', 'r');hold offEnd另一段代码% By lyqmathclc; clear all; close all;% 原始视频targetavi = 'traffic.avi';% 检测结果视频resultavi = 'c:\\result.avi';%% 读取视频mov = mmreader(targetavi);fnum = mov.NumberOfFrames;%% 建立结果视频aviobj = avifile(resultavi);aviobj.Quality = 100;aviobj.Fps = 25;pression = 'Indeo5';%% 帧间差分法figure(1);for i = 2 : fnumx = read(mov, i-1);y = read(mov, i);subplot(1, 2, 1); imshow(x, []); title(sprintf('第%d帧视频,By lyqmath', i-1), 'FontWeight', 'Bold', 'Color', 'r');% 灰度化if ndims(x) == 3m = rgb2gray(x);elsem = x;endif ndims(y) == 3n = rgb2gray(y);elsen = y;end% 中值滤波m = medfilt2(m);n = medfilt2(n);% 数据类型转换q = im2double(n);w = im2double(m);% 差分c = q-w;% 阈值,此值可以调节t = 40/256;% 阈值分割c(abs(c)>=t)=255;c(abs(c)<t) = 0;c = logical(c);x1 = x(:, :, 1); x2 = x(:, :, 2); x3 = x(:, :, 3);x1(c) = 255; x2(c) = 0; x3(c) = 0;xc = cat(3, x1, x2, x3);subplot(1, 2, 2); imshow(xc, []); title(sprintf('第%d帧视频识别结果,By lyqmath', i-1), 'FontWeight', 'Bold', 'Color', 'r');f = getframe(gcf);f = frame2im(f);% 生成视频aviobj = addframe(aviobj, f);end%% 关闭视频句柄aviobj = close(aviobj);第三段代码mov=aviread('CIMG0003.AVI');temp=size(mov);fnum=temp(2);for i=1:fnum,strtemp=strcat(int2str(i),'.','JPG');imwrite(mov(i).cdata(:,:,:),strtemp);end%% 从视频中提出每一帧图像o=1;e='.jpg';for i=1:15u=o-1;v=o-2;m=int2str(o);n=int2str(u);h=int2str(v);s=strcat(m,e);%%把字符串b与m连接后在连接e得到图像文件存储的位置m=imread(s);%%从S处把图像读取出来m=rgb2gray(m);%%将图像M灰度化m=medfilt2(m,[3,3]);if(o>=3)s=strcat(n,e);n=imread(s);n=rgb2gray(n);s=strcat(h,e);h=imread(s);h=rgb2gray(h);n=medfilt2(n,[3,3]);h=medfilt2(h,[3,3]);q=im2double(m);%%将图像数组转换为double型w=im2double(n); g=im2double(h);c=q-w;j=w-g;th=10/255;k=find(abs(c)>=th);c(k)=1;k=find(abs(c)<th);c(k)=0;c=bwareaopen(c,15);se90=strel ('line',3,90);se0=strel ('line',3,0);c=bwmorph(c,'close'); %对上述图像进行形态学闭运算c=imdilate(c,[se90,se0]);c=bwmorph(c,'close');c=bwareaopen(c,50);k=find(abs(j)>=th);j(k)=1;k=find(abs(j)<th);j(k)=0;j=bwareaopen(j,15);j=bwmorph(j,'close'); %对上述图像进行形态学闭运算j=imdilate(j,[se90,se0]);j=bwmorph(j,'close');c=bwareaopen(c,50);c=c&j;c=imerode(c,[se90,se0]);figure,imshow(c);a=c;b=c; d=c;f=c;[m,n]=size(c);%%行扫描填充for i=1:mfor j=1:n-1if a(i,j)>0a(i,j+1)=1;endendendfor i=1:mfor j=n:-1:2if b(i,j)>0b(i,j-1)=1;endendendth=a&b;%%列扫描填充for i=1:nfor j=1:m-1if d(j,i)>0d(j+1,i)=1;endendendfor i=1:nfor j=m:-1:2if f(j,i)>0f(j-1,i)=1;endendendtd=d&f;c=th&td;endo=o+1;end。

实践5-视频运动目标检测:帧差法的实现

实践5 视频运动目标检测:帧差法的实现实验任务:根据原理,获取并显示两幅图像的帧差灰度图和帧差二值图,如下图所示。

实现的算法是:(1)分别读取两张图像;(2)将2张图像分别转换为灰度图,转换函数可用:cvCvtColor/cvtColor;(3)将2张灰度图相减(求差值),得到帧差灰度图,相减函数可用:cvAbsDiff/absdiff;(4)利用阈值操作,将帧差灰度图转化为帧差二值图,阈值操作函数可用:cvThreshold/threshold;(如果假设目标设定为白色,背景设定为黑色,则需要使用逻辑“非”操作进行颜色转换,可使用cvNot/bitwise_not函数);(5)显示图像。

请将上述任务改成找茬游戏的自动找茬功能。

请改为三帧差分,并上交源代码。

函数解析:(1)cvCvtColor/cvtColorC: void cvCvtColor( const CvArr* src, CvArr* dst, int code );C++:void cvtColor(InputArray src, OutputArray dst, int code, int dstCn=0)src 输入的8-bit,16-bit或32-bit单倍精度浮点数影像。

dst 输出的8-bit,16-bit或32-bit单倍精度浮点数影像。

code色彩空间转换的模式,该code来实现不同类型的颜色空间转换。

比如CV_BGR2GRAY表示转换为灰度图,CV_BGR2HSV将图片从RGB空间转换为HSV空间。

常见的code模式有:CV_RGB2GRAY(彩色图像-灰度图像)CV_BGR2YCrCbCV_RGB2YCrCbCV_YCrCb2BGRCV_YCrCb2RGBCV_BGR2HSVCV_RGB2HSVCV_HSV2BGRCV_HSV2RGB(2)cvAbsDiff/absdiffOpenCV 中计算两个数组差的绝对值的函数。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

% By lyqmath @ Matlab中文论坛clc; clear all; close all;avi = mmreader('samplevideo.avi');for i = 1 : avi.NumberOfFramesimg = read(avi, i);pixels(:, :, :, i) = img;figure(1); imshow(img, []);text(1, 15, sprintf('原视频:%d帧By lyqmath', i), 'FontWeight', 'Bold', 'Color', 'r'); endtracking(pixels);function d = tracking(video)if ischar(video)% 载入视频数据for i = 1 : avi.NumberOfFramesimg = read(avi, i);pixels(:, :, :, i) = img;endelsepixels = video;endnFrames = size(pixels, 4);rows = size(pixels, 1);cols = size(pixels, 2);% 转换成灰度图像for i = 1 : nFramespixel(:, :, i) = (rgb2gray(pixels(:,:,:,i)));endfor i = 2 : nFramesd(:, :, i) = (abs(pixel(:,:,i) - pixel(:,:,i-1)));bw(:, :, i) = im2bw(d(:, :, i), 0.2);% 寻找上下边界cou=1;for h = 1:rowsfor w = 1:colsif bw(h, w, i) > 0.5bottomEdge = h;if cou == 1topEdge = bottomEdge;endcou = cou+1;break;endendend% 寻找左右边界coun=1;for w = 1:colsfor h = 1:rowsif bw(h, w, i) > 0.5rightEdge = w;if coun == 1leftEdge = rightEdge;coun = coun+1;endbreak;endendend% 矩形框生成wd = rightEdge-leftEdge;hg = bottomEdge-topEdge;widt = wd/2;heit = hg/2;cenx = leftEdge+widt;ceny = topEdge+heit;% 显示并标记figure(1);imshow(pixels(:, :, :, i), []);hold onrectangle('Position',[leftEdge topEdge wd hg], 'EdgeColor', 'r', 'LineWidth', 2);plot(cenx, ceny, 'ko', 'MarkerFaceColor', 'y', 'MarkerSize', 20, 'LineWidth', 2);text(1, 15, sprintf('跟踪视频:%d帧By lyqmath', i), 'FontWeight', 'Bold', 'Color', 'r');hold offEnd另一段代码% By lyqmathclc; clear all; close all;% 原始视频targetavi = 'traffic.avi';% 检测结果视频resultavi = 'c:\\result.avi';%% 读取视频mov = mmreader(targetavi);fnum = mov.NumberOfFrames;%% 建立结果视频aviobj = avifile(resultavi);aviobj.Quality = 100;aviobj.Fps = 25;pression = 'Indeo5';%% 帧间差分法figure(1);for i = 2 : fnumx = read(mov, i-1);y = read(mov, i);subplot(1, 2, 1); imshow(x, []); title(sprintf('第%d帧视频,By lyqmath', i-1), 'FontWeight', 'Bold', 'Color', 'r');% 灰度化if ndims(x) == 3m = rgb2gray(x);elsem = x;endif ndims(y) == 3n = rgb2gray(y);elsen = y;end% 中值滤波m = medfilt2(m);n = medfilt2(n);% 数据类型转换q = im2double(n);w = im2double(m);% 差分c = q-w;% 阈值,此值可以调节t = 40/256;% 阈值分割c(abs(c)>=t)=255;c(abs(c)<t) = 0;c = logical(c);x1 = x(:, :, 1); x2 = x(:, :, 2); x3 = x(:, :, 3);x1(c) = 255; x2(c) = 0; x3(c) = 0;xc = cat(3, x1, x2, x3);subplot(1, 2, 2); imshow(xc, []); title(sprintf('第%d帧视频识别结果,By lyqmath', i-1), 'FontWeight', 'Bold', 'Color', 'r');f = getframe(gcf);f = frame2im(f);% 生成视频aviobj = addframe(aviobj, f);end%% 关闭视频句柄aviobj = close(aviobj);第三段代码mov=aviread('CIMG0003.AVI');temp=size(mov);fnum=temp(2);for i=1:fnum,strtemp=strcat(int2str(i),'.','JPG');imwrite(mov(i).cdata(:,:,:),strtemp);end%% 从视频中提出每一帧图像o=1;e='.jpg';for i=1:15u=o-1;v=o-2;m=int2str(o);n=int2str(u);h=int2str(v);s=strcat(m,e);%%把字符串b与m连接后在连接e得到图像文件存储的位置m=imread(s);%%从S处把图像读取出来m=rgb2gray(m);%%将图像M灰度化m=medfilt2(m,[3,3]);if(o>=3)s=strcat(n,e);n=imread(s);n=rgb2gray(n);s=strcat(h,e);h=imread(s);h=rgb2gray(h);n=medfilt2(n,[3,3]);h=medfilt2(h,[3,3]);q=im2double(m);%%将图像数组转换为double型w=im2double(n); g=im2double(h);c=q-w;j=w-g;th=10/255;k=find(abs(c)>=th);c(k)=1;k=find(abs(c)<th);c(k)=0;c=bwareaopen(c,15);se90=strel ('line',3,90);se0=strel ('line',3,0);c=bwmorph(c,'close'); %对上述图像进行形态学闭运算c=imdilate(c,[se90,se0]);c=bwmorph(c,'close');c=bwareaopen(c,50);k=find(abs(j)>=th);j(k)=1;k=find(abs(j)<th);j(k)=0;j=bwareaopen(j,15);j=bwmorph(j,'close'); %对上述图像进行形态学闭运算j=imdilate(j,[se90,se0]);j=bwmorph(j,'close');c=bwareaopen(c,50);c=c&j;c=imerode(c,[se90,se0]);figure,imshow(c);a=c;b=c; d=c;f=c;[m,n]=size(c);%%行扫描填充for i=1:mfor j=1:n-1if a(i,j)>0a(i,j+1)=1;endendendfor i=1:mfor j=n:-1:2if b(i,j)>0b(i,j-1)=1;endendendth=a&b;%%列扫描填充for i=1:nfor j=1:m-1if d(j,i)>0d(j+1,i)=1;endendendfor i=1:nfor j=m:-1:2if f(j,i)>0f(j-1,i)=1;endendendtd=d&f;c=th&td;endo=o+1;end。