Random Forest

举例说明随机森林的原理和计算流程

举例说明随机森林的原理和计算流程Random forest, as the name suggests, is a collection of decision trees that work together to make predictions. It is a versatile and powerful machine learning algorithm that can be used for both classification and regression tasks. 随机森林,顾名思义,是一组决策树,它们共同工作以进行预测。

这是一种多功能且强大的机器学习算法,既可以用于分类任务,也可以用于回归任务。

The basic principle behind random forest is to build a large numberof decision trees during training and then make predictions based on the majority vote of all the trees. Each decision tree is built using a different subset of the training data, and at each split, a random subset of features is considered. This helps to reduce overfitting and makes the random forest more robust. 随机森林的基本原理是在训练期间构建大量的决策树,然后根据所有树的多数投票进行预测。

每个决策树都是使用训练数据的不同子集构建的,在每次分裂时,都会考虑一组随机特征。

这有助于减少过拟合,使随机森林更加健壮。

The calculation process of the random forest algorithm can be broken down into the following steps. First, a random subset of thetraining data is selected. Then, a decision tree is built using this subset of data, considering only a random subset of features at each split. This process is repeated for a predefined number of trees. Once all the trees are built, the random forest can make predictions by aggregating the predictions of each individual tree. 随机森林算法的计算过程可以分解为以下步骤。

随机森林通俗理解

随机森林通俗理解

随机森林通俗理解:

随机森林(Random Forests)是一种分类和回归的机器学习方法,它是对决策树的扩展,由多个决策树组成,它们具有强大的泛化能力,可以处理非线性问题。

这种方法可以帮助我们更好地理解数据,并有效地预测未来结果。

随机森林最早由Breiman于2001年提出,其核心思想是基于多个决策树的集成方法,即将多个决策树结合起来,以期得到更准确的预测结果。

随机森林的优势在于,它不仅可以提供准确的预测,而且还可以衡量特征的相关性,从而发现数据中的模式。

随机森林的工作原理如下:

1、首先,从原始数据集中抽取N个子数据集,每个子数据集包含M个特征,每个特征都有K个不同的值;

2、然后,使用每个子数据集训练一棵决策树,每棵树都可以根据训练数据生成一组预测结果;

3、最后,将每棵树的预测结果汇总,用来预测新的数据。

因此,随机森林的工作原理就是在训练数据上训练多个决策树,然后将它们的预测结果汇总,从而提高预测精度。

随机森林的优势如下:

1、随机森林的泛化能力很强:它比单个决策树的泛化能力要强,降低了过拟合的风险;

2、随机森林能够处理非线性问题;

3、随机森林可以检测特征之间的相关性,从而发现数据中的隐藏模式;

4、随机森林运行效率较高,可以解决大数据集的问题。

总之,随机森林是一种强大的机器学习方法,它可以有效地处理大型数据集,改善模型的泛化能力,还可以检测特征之间的相关性,从而发现数据中的隐藏模式。

random forest原理

Random Forest原理导言随机森林(Random Forest)是一种基于集成学习(Ensemble Learning)的机器学习方法,它通过构建多个决策树来完成分类或回归任务。

随机森林通过对每个树的结果进行投票或平均来作出最终预测,具有较高的准确性和鲁棒性。

本文将详细介绍随机森林的原理及其关键步骤。

什么是随机森林随机森林是由多个决策树(Decision Tree)组成的集成模型。

决策树是一种树形结构的分类模型,通过一系列的决策规则对数据进行分类。

随机森林通过训练多个决策树,并利用它们的集体智慧来做出预测。

随机森林的优势在于它的鲁棒性、准确性和可解释性。

鲁棒性是指模型对数据异常值和噪声的抗干扰能力;准确性是指模型在预测新数据时的准确程度;可解释性是指模型对结果的解释能力。

随机森林的原理随机森林的原理可分为两个关键步骤:随机特征选择和集成投票。

1. 随机特征选择每个决策树在进行分裂时,并不是在所有特征上进行评估,而是从原始特征集中随机选择一部分特征。

这种随机特征选择的方法称为”特征抽样”(Feature Sampling)或”随机子空间方法”(Random Subspaces)。

通过特征抽样,使得不同的决策树在决策规则上有所差异,增加了随机性,提高了集成模型的泛化能力。

常见特征抽样方法包括随机选择固定数量的特征、随机选择百分比的特征、随机选择与树的深度相关的特征等。

2. 集成投票在随机森林中,每个决策树对于每个样本都会做出一个预测。

对于分类问题,每个决策树的预测结果可能是一个类别;对于回归问题,每个决策树的预测结果是一个数值。

最终的预测结果可以通过投票(classification)或平均(regression)来得到。

在分类问题中,可以采用多数表决的方式,即选择得票最多的类别作为最终预测结果。

在回归问题中,可以采用平均值的方式,即将所有决策树的预测结果求平均。

随机森林的构建过程随机森林的构建过程可以概括为以下几个步骤:1. 随机样本选择从原始数据集中随机选择一部分样本(有放回抽样),构成新的训练集。

R软件实现随机森林算法

R软件实现随机森林算法随机森林算法是一种集成学习方法,它基于决策树构建了多个随机子树,并通过投票方式来确定最终的预测结果。

在R软件中,我们可以使用randomForest包来实现随机森林算法。

下面是详细的代码实现步骤:步骤1:安装并导入randomForest包```Rinstall.packages("randomForest") # 安装randomForest包library(randomForest) # 导入randomForest包```步骤2:准备数据集在这个示例中,我们将使用IRIS数据集作为示例数据。

IRIS数据集是一个经典的分类数据集,包含三个类别的鸢尾花的测量数据。

```Rdata(iris) # 加载IRIS数据集```步骤3:划分数据集将数据集划分为训练集和测试集。

训练集用于构建随机森林模型,测试集用于评估模型的性能。

```Rset.seed(123) # 设置随机种子,保证结果可重复trainIndex <- sample(1:nrow(iris), 0.7*nrow(iris)) # 随机选择70%的样本作为训练集trainData <- iris[trainIndex, ] # 构建训练集testData <- iris[-trainIndex, ] # 构建测试集```步骤4:构建随机森林模型使用randomForest函数来构建随机森林模型。

```RrfModel <- randomForest(Species ~ ., data = trainData, ntree = 100, mtry = 2) # 构建随机森林模型```在这个示例中,我们使用了100颗决策树(ntree参数)和2个随机特征(mtry参数)。

步骤5:查看模型信息可以使用print函数来查看模型的详细信息。

```Rprint(rfModel)```步骤6:模型预测使用predict函数对测试集进行分类预测。

随机森林.ppt

两个重要的代码

randomForest

主要参数是ntree,mtry

Predict

第一步,随机森林的安装

随机森林是基于R语言运行,安装过程分两步: 1.ubuntu系统下首先安装R语言包。

用一行代码。 sudo apt-get install R 然后ubuntu系统就自动的帮你安装完R。 2.安装random forest 意想不到的简单。 打开终端 ,输入R,就算进入到了R语言的编码界面。 在大于号后面入

决策树的定义

Hale Waihona Puke 决策树是这样的一颗树:每个内部节点上选用一个属性进行分割 每个分叉对应一个属性值 每个叶子结点代表一个分类

A1

a11 A2

a12 c1

a21

a22

c1

c2

a13

A3

a31

a32

c2

c1

决策树框架

决策树生成算法分成两个步骤

树的生成

开始,数据都在根节点 递归的进行数据分片

0,mtry=3,proximity=TRUE,importance=TRUE) print(iris.rf) iris.pred<-predict( iris.rf,iris[ind==2,] ) table(observed=iris[ind==2,"Species"],predicted=iris.pred )

随机森林的特点

两个随机性的引入,使得随机森林不容易陷入过 拟合

两个随机性的引入,使得随机森林具有很好的抗 噪声能力

对数据集的适应能力强:既能处理离散型数据, 也能处理连续型数据,数据集无需规范化。

简述随机森林算法的流程及优点

简述随机森林算法的流程及优点随机森林(Random Forest)算法是一种集成学习(Ensembled Learning)方法,它以决策树为基础模型,通过Bagging技术以及随机属性选择的方法集成多个决策树,综合多个模型的预测结果来达到更好的分类或回归性能。

随机森林是一种广泛应用于数据挖掘、机器学习与人工智能领域的算法,因其简单、高效和高准确性而备受研究者的青睐。

流程随机森林包括两个阶段:训练阶段和预测阶段。

训练阶段:1.随机选择样本:从原始数据集中有放回地抽取一部分数据,构造出一个有m个样本的新数据集。

2.随机选择特征:从所有特征中随机选择n个特征,用于建立决策树。

这里的n值是一个超参数,可以在建立模型时调整。

3.建立决策树:对于每个子数据集,采用CART决策树算法建立一棵决策树。

训练过程中使用的特征是在第二步中随机选择的n个特征。

找到的最优特征作为划分样本的依据。

4.重复2~3步,构建k棵决策树。

预测阶段:将待分类的样本,输入到每棵决策树中,每棵决策树将给出一个类别的预测结果。

对于分类任务,采取“投票原则”,即选择出现次数最多的类别作为最终分类结果;对于回归任务,则对每棵决策树的预测结果取均值作为最终预测结果。

随机森林的优点1.可以应用于分类和回归任务:随机森林不仅适用于分类任务,而且可以用于回归任务。

而且在数据集缺失情况下,随机森林的表现也非常优秀。

2.高准确性:随机森林是一种集成算法,通过集成多棵决策树来降低单一模型的过拟合风险,从而提高分类或回归的准确性。

3.不容易过度拟合:随机森林通过Bagging技术和随机属性选择的方式,减少决策树模型的偏好倾向,使得集成模型不易过度拟合。

4.能够反映特征的重要性:在随机森林训练过程中,我们可以通过特定的方法计算每个特征的重要性,从而更好地理解数据集。

5.支持大规模数据集:随机森林算法可以同时处理大量的变量和数据,并且其训练和预测过程具有较高的并行性。

随机森林(RandomForest)和极限森林(ExtraForest)的理解

随机森林(RandomForest)和极限森林(ExtraForest)的理解随机森林(RandomForest)简介: 在机器学习中,随机森林是⼀个包含多个决策树的分类器,并且其输出的类别是由个别树输出的类别的众数⽽定。

Leo Breiman和Adele Cutler发展出推论出随机森林的算法。

⽽ “Random Forests” 是他们的商标。

这个术语是1995年由贝尔实验室的Tin Kam Ho所提出的随机决策森林(random decision forests)⽽来的。

这个⽅法则是结合 Breimans 的 “Bootstrap aggregating” 想法和 Ho 的"random subspace method"以建造决策树的集合。

在Bagging⽅法中,b个学习器之间彼此是相互独⽴的,这样的特点使得Bagging⽅法更容易并⾏。

算法步骤:根据下列算法⽽建造每棵树:1.⽤N来表⽰训练⽤例(样本)的个数,M表⽰特征数⽬。

2.输⼊特征数⽬m,⽤于确定决策树上⼀个节点的决策结果;其中m应远⼩于M。

3.从N个训练⽤例(样本)中以有放回抽样的⽅式,取样N次,形成⼀个训练集(即bootstrap取样),并⽤未抽到的⽤例(样本)作预测,评估其误差。

4.对于每⼀个节点,随机选择m个特征,决策树上每个节点的决定都是基于这些特征确定的。

根据这m个特征,计算其最佳的分裂⽅式。

5.每棵树都会完整成长⽽不会剪枝,这有可能在建完⼀棵正常树状分类器后会被采⽤。

优点:1. 可以⽤来解决分类和回归问题:随机森林可以同时处理分类和数值特征。

2. 抗过拟合能⼒:通过平均决策树,降低过拟合的风险性。

3. 只有在半数以上的基分类器出现差错时才会做出错误的预测:随机森林⾮常稳定,即使数据集中出现了⼀个新的数据点,整个算法也不会受到过多影响,它只会影响到⼀颗决策树,很难对所有决策树产⽣影响。

4. 能够处理很⾼维度(feature很多)的数据,并且不⽤做特征选择(特征列采样)5. 对于不平衡的分类资料集来说,它可以平衡误差。

8、随机森林(RandomForest,RF)算法——监督、分类回归

8、随机森林(RandomForest,RF)算法——监督、分类回归1、随机森林(Random Forest,RF)算法随机森林(Random Forest,RF)算法由Leo Breiman和Adele Cutler提出,可以⽤来解决分类或回归等问题。

基本单元:决策树思想:集成学习(Bagging)优点:具有极好的准确率;能够有效地运⾏在⼤数据集上;能够处理具有⾼维特征的输⼊样本,⽽且不需要降维;能够评估各个特征在分类问题上的重要性;抗过拟合能⼒⽐较强;对于缺省值问题也能够获得很好得结果。

缺点:对于⼩数据或者低维数据(特征较少的数据),可能难以产⽣较好的分类;在解决回归问题时,并没有在分类中表现的那么好。

2、集成学习(Ensemble Learniing)之Bagging算法Bagging算法通过对训练样本有放回地抽取,由此产⽣多个训练数据的⼦集,并在每⼀个训练集的⼦集上训练⼀个分类器,最终分类结果是由多个分类器的分类结果投票⽽产⽣的。

对于 Bagging 思想集成的随机森林,是可以并⾏训练的,正是因为每个弱分类器之间不相互影响。

Bagging算法训练出来的模型在预测新样本分类的时候,会使⽤多数投票或者求均值的⽅式来统计最终的分类结果。

Bagging算法的弱学习器可以是基本的算法模型,⽐如:Linear、Ridge、Lasso、Logistic、Softmax、ID3、C4.5、CART、SVM、KNN 等。

Bagging常⽤模型:随机森林(RF)。

其⽰意图如下:3、随机森林算法基本原理随机森林算法是⼀种重要的基于Bagging的集成学习⽅法,通过对数据集的⾃助法(Bootstrap)重采样⽣成多个不同的数据集,并在每⼀个数据集上训练⼀棵分类树,最终结合每⼀棵分类树的预测结果作为随机森林的预测结果。

即”三个臭⽪匠顶个诸葛亮”。

因此,集成学习⽅法的泛化能⼒⽐单个学习算法的泛化能⼒强很多。

随机算法流程随机森林算法是通过训练多个决策树,⽣成模型,然后综合利⽤多个决策树进⾏分类。

randomforestclassifier 参数

randomforestclassifier 参数随机森林分类器,又称为随机森林(Random Forest),它是一种集成学习(Ensemble Learning)技术,该技术通过并行构建大量的决策树(Decision Tree),然后把它们的结果综合起来进行分类或回归预测。

通过多树的集合,降低了被弱模型及时噪声的影响,使得得到预测更为准确。

随机森林分类器的参数可以分为以下几类:一、树模型参数:1. n_estimators:基分类器(评估器)的数量,也就是决策树数量,默认数量为1002. criterion:分类依据,即决策树的划分标准,默认为gini,也可以设置为entropy3. max_depth:决策树的最大深度,当max_depth=None时,决策树可以延伸到无限深度4. min_samples_split:内部节点再划分所需最小样本数5. min_samples_leaf:叶子节点所需最小样本数二、对偶树参数:1. oob_score:是否测量out-of-bag samples 来估计分类器模型泛化性能2. warm_start:决定下一步训练步是否从上一步训练步开始3. n_jobs:要使用的线程数(个数)三、其他参数:1. random_state:随机种子,设置后做的结果是一样的2. class_weight:是一组指定类别的权重,类别不平衡时可设置该参数3. max_features: 决策树中,每次分割的最大特征个数。

4. min_impurity_split:限制每棵决策树的最大误差比例,这个值越小,决策树最终的精度越高,但模型训练时间越长。

5. max_leaf_nodes:决策树最大叶子节点数,可以将决策树用于回归任务,如果max_leaf_nodes为None时,算法则不对最大叶子节点数设置约束。

6. verbose:输出训练过程信息,默认设置为0,不输出信息。

python randomforest参数

python randomforest参数

随机森林是一种机器学习算法,在许多应用领域都得到了广泛应用。

在使用随机森林时,我们需要对其参数进行一定的调整,以便得到更好的结果。

以下是一些常见的随机森林参数及其含义:

1. n_estimators:森林中树的数量。

该参数越大,模型越复杂,但是过大的值会导致过拟合。

2. criterion:衡量拆分节点的质量。

可以选择“gini”(基尼系数)或“entropy”(信息熵)。

3. max_depth:树的最大深度。

该参数越大,模型越复杂,但是也容易过拟合。

4. min_samples_split:拆分内部节点所需的最小样本数。

该参数越小,模型越复杂,但会导致过拟合。

5. max_features:每个节点评估的特征数。

该参数越小,模型越简单,但也可能导致欠拟合。

6. bootstrap:是否使用自助法创建训练集。

如果为True,则每个树都使用唯一的随机子集进行拟合。

7. oob_score:是否计算out-of-bag误差。

如果为True,则可以在拟合过程中评估模型的性能。

8. n_jobs:用于拟合和预测的并行作业数。

如果为-1,则使用所有可用的CPU核心。

以上是一些常见的随机森林参数。

在实际应用中,我们需要根据具体问题和数据集进行调整,以得到最优的模型性能。

randomforestclassifier参数

randomforestclassifier参数RandomForestClassifier是一种基于随机森林的分类算法,它是用于解决分类问题的一种监督学习算法。

它通过集成多个决策树来进行分类,每个决策树独立训练,最后通过投票或取平均值的方式得到最终的分类结果。

RandomForestClassifier有许多参数可以用来调整和优化模型的性能,下面将详细介绍这些参数。

1. n_estimators(默认值:100):指定随机森林中决策树的数量。

增加这个参数的值可以提高模型的性能,但也会增加计算时间。

2. criterion(默认值:“gini”):用于衡量决策树的质量。

可以选择“gini”或“entropy”。

通常情况下,这两个值的效果差别不大。

3. max_depth(默认值:None):决策树的最大深度。

增加这个值可以提高模型的性能,但也会增加计算时间和过拟合的风险。

4. min_samples_split(默认值:2):决定在进行节点分裂之前,一个节点必须具有的最小样本数。

增加这个值可以防止模型过拟合。

5. min_samples_leaf(默认值:1):决定一个叶子节点必须具有的最小样本数。

增加这个值可以防止模型过拟合。

6. max_features(默认值:“auto”):在决策树节点中考虑的特征数量。

可以选择“auto”、“sqrt”、“log2”或一个整数值。

通常使用默认值即可。

7. bootstrap(默认值:True):指定是否使用自助法(bootstrap)来构建决策树。

自助法通过有放回地抽样样本来构建决策树,可以增加模型的多样性,从而提高模型的性能。

9. random_state(默认值:None):随机数生成器的种子。

设置一个固定的值可以使模型可重复。

10. n_jobs(默认值:None):指定并行计算的数量。

可以选择一个整数值,表示要使用的处理器数量,或者-1表示使用所有可用的处理器。

在r中cforest的用法(一)

在r中cforest的用法(一)在R中使用cforestcforest是一个R中用于建立随机森林(Random Forest)模型的函数。

随机森林是一种机器学习算法,通过集成多个决策树来进行预测和分类。

在本文中,我们将介绍cforest的用法,并提供一些示例代码。

安装与加载在使用cforest函数之前,我们需要安装并加载随机森林相关的包。

# 安装包("party")# 加载包library(party)构建随机森林模型基本语法创建随机森林模型的基本语法如下:model <- cforest(formula, data, controls)其中: - formula:表示因变量和自变量之间的关系,通常使用公式形式表示,例如Y ~ X1 + X2,表示因变量Y与自变量X1和X2之间的关系。

- data:表示使用的数据集。

- controls:表示随机森林模型的控制参数,例如树的数量、节点大小等。

示例代码以下是一个使用cforest函数构建随机森林模型的示例代码:# 创建随机森林模型model <- cforest(Species ~ ., data = iris, controls = cf orest_unbiased(ntree = 100))# 输出模型摘要信息print(model)模型预测基本语法使用训练好的随机森林模型进行预测的基本语法如下:predict(model, newdata)其中: - model:表示使用的随机森林模型。

- newdata:表示待预测的新数据。

示例代码以下是一个使用训练好的随机森林模型进行预测的示例代码:# 预测新数据newdata <- ( = , = , = , = )prediction <- predict(model, newdata)# 输出预测结果print(prediction)模型评估基本语法使用随机森林模型进行评估的基本语法如下:varimp(model)其中: - model:表示使用的随机森林模型。

简述随机森林算法的基本原理

简述随机森林算法的基本原理随机森林(Random Forest)是一种基于集成学习的分类与回归算法,其本质是通过组合多个决策树来改进预测准确性和稳定性。

随机森林算法由瑞典统计学家Tin Kam Ho于1995年提出,是目前最流行的机器学习算法之一,被广泛应用于各种领域,如医疗、金融、农业、计算机视觉、自然语言处理等。

随机森林算法的基本原理如下:1.基础模型——决策树决策树是一种被广泛应用于分类和回归分析的模型,其原理是将数据集分成具有相同特征的不同子集,最终形成树形结构。

在决策树模型中,每个分支代表数据在某个特征上的取值,每个叶子节点代表一个类别或者一个数值。

决策树的优势在于易于理解和实现,并且可以处理各种类型的数据,包括连续变量和离散变量。

2.随机性——引入随机属性选择和样本选择为了提升随机森林的准确性和泛化能力,我们需要在构造决策树时引入随机性。

一种方法是随机选择属性(特征)进行分裂。

具体来说,每次分裂时,从全部属性中随机选择一部分属性进行评估,选择最佳属性进行分裂。

这样,就可以有效避免选择到相似或者相关的属性,提高模型的多样性,从而降低过拟合的风险。

另一种方法是通过随机选择样本来减少过拟合。

在每个决策树结构中,我们从数据集中选择一个子集作为样本集来进行构建。

在随机选择样本过程中,数据可能重复样本也可能在某些样本集中未被选择到,这也有助于提升模型的泛化能力。

3.构造多个决策树——集成学习随机森林是一种基于集成学习的算法,它由若干个决策树构成,每个决策树都是一个弱分类器,其输出被综合考虑在一起得到随机森林的最终预测结果。

在随机森林中,每个决策树都是基于不同的样本集和属性集构建,因此这些树有着较大的差异性,这使得随机森林可以处理高维数据、大规模数据和复杂数据。

由于随机选择属性和样本,随机森林能够抑制噪声和过拟合,提高预测准确性和鲁棒性。

4.组合决策树——随机森林的决策规则在随机森林训练过程中,每个决策树对于相同的样本输入都会给出一个分类结果。

随机森林算法实验报告书

一、实验背景随着大数据时代的到来,机器学习在各个领域得到了广泛的应用。

随机森林(Random Forest)作为一种集成学习方法,因其强大的分类和预测能力,在许多实际问题中得到了应用。

本实验旨在通过Python编程实现随机森林算法,并对其实际应用效果进行评估。

二、实验目的1. 理解随机森林算法的基本原理和实现方法。

2. 掌握随机森林算法在Python编程环境下的实现。

3. 通过实验验证随机森林算法在分类和预测任务中的性能。

三、实验环境1. 操作系统:Windows 102. 编程语言:Python3.83. 库:NumPy、Scikit-learn四、实验步骤1. 数据准备本实验选取了Iris数据集作为分类任务的数据集。

Iris数据集包含150个样本,每个样本包含4个特征(花萼长度、花萼宽度、花瓣长度、花瓣宽度)和1个类别标签(三种不同品种的鸢尾花)。

2. 随机森林算法实现使用Scikit-learn库中的RandomForestClassifier实现随机森林算法。

首先,导入所需的库和模块:```pythonimport numpy as npfrom sklearn.datasets import load_irisfrom sklearn.ensemble import RandomForestClassifierfrom sklearn.model_selection import train_test_splitfrom sklearn.metrics import accuracy_score, confusion_matrix```然后,加载Iris数据集并划分为训练集和测试集:```pythoniris = load_iris()X = iris.datay = iris.targetX_train, X_test, y_train, y_test = train_test_split(X, y,test_size=0.3, random_state=42)```接下来,创建随机森林分类器实例并设置参数:```pythonclf = RandomForestClassifier(n_estimators=100, max_depth=3,random_state=42)```其中,n_estimators表示决策树的数量,max_depth表示决策树的最大深度,random_state用于确保实验的可重复性。

r语言之randomforest随机森林

R语言之Random Forest随机森林什么是随机森林?随机森林就是通过集成学习的思想将多棵树集成的一种算法,它的基本单元是决策树,而它的本质属于机器学习的一大分支——集成学习(Ensemble Learning)方法。

随机森林的名称中有两个关键词,一个是“随机”,一个就是“森林”。

“森林”我们很好理解,一棵叫做树,那么成百上千棵就可以叫做森林了,这样的比喻还是很贴切的,其实这也是随机森林的主要思想--集成思想的体现。

随机森林算法的实质是基于决策树的分类器集成算法,其中每一棵树都依赖于一个随机向量,随机森林的所有向量都是独立同分布的。

随机森林就是对数据集的列变量和行观测进行随机化,生成多个分类数,最终将分类树结果进行汇总。

随机森林相比于神经网络,降低了运算量的同时也提高了预测精度,而且该算法对多元共线性不敏感以及对缺失数据和非平衡数据比较稳健,可以很好地适应多达几千个解释变量数据集。

随机森林的组成随机森林是由多个CART分类决策树构成,在构建决策树过程中,不进行任何剪枝动作,通过随机挑选观测(行)和变量(列)形成每一棵树。

对于分类模型,随机森林将根据投票法为待分类样本进行分类;对于预测模型,随机森林将使用单棵树的简单平均值来预测样本的Y值。

随机森林的估计过程1)指定m值,即随机产生m个变量用于节点上的二叉树,二叉树变量的选择仍然满足节点不纯度最小原则;2)应用Bootstrap自助法在原数据集中有放回地随机抽取k 个样本集,组成k棵决策树,而对于未被抽取的样本用于单棵决策树的预测;3)根据k个决策树组成的随机森林对待分类样本进行分类或预测,分类的原则是投票法,预测的原则是简单平均。

随机森林的两个重要参数:1.树节点预选的变量个数:单棵决策树决策树的情况。

2.随机森林中树的个数:随机森林的总体规模。

随机森林模型评价因素1)每棵树生长越茂盛,组成森林的分类性能越好;2)每棵树之间的相关性越差,或树之间是独立的,则森林的分类性能越好。

随机森林(RandomForest)

随机森林(RandomForest)1.什么是随机森林简述随机森林是⼀个⾼度灵活的机器学习⽅法,拥有⼴泛的应⽤前景,从市场营销到医疗保健保险。

既可以⽤来做市场营销模拟的建模,统计客户来源,保留和流失。

也可⽤来预测疾病的风险和病患者的易感性。

随机森林是⼀个可做能够回归和分类。

它具备处理⼤数据的特性,⽽且它有助于估计或变量是⾮常重要的基础数据建模。

随机森林是⼏乎任何预测问题 (甚⾄⾮直线部分) 的固有选择。

它是⼀个相对较新的机器学习的策略(在90 年代产⽣于贝尔实验室 ) 和它可以⼏乎⽤于任何⽅⾯。

思想随机森林就是通过集成学习的思想将多棵树集成的⼀种算法,它的基本单元是决策树,⽽它的本质属于机器学习的⼀⼤分⽀——集成学习(Ensemble Learning)⽅法。

随机森林的名称中有两个关键词,⼀个是“随机”,⼀个就是“森林”。

“森林”我们很好理解,⼀棵叫做树,那么成百上千棵就可以叫做森林了,这样的⽐喻还是很贴切的,其实这也是随机森林的主要思想--集成思想的体现。

“随机”的含义我们会在下边部分讲到。

其实从直观⾓度来解释,每棵决策树都是⼀个分类器(假设现在针对的是分类问题),那么对于⼀个输⼊样本,N棵树会有N个分类结果。

⽽随机森林集成了所有的分类投票结果,将投票次数最多的类别指定为最终的输出,这就是⼀种最简单的 Bagging 思想。

2.相关知识集成学习集成学习通过建⽴⼏个模型组合的来解决单⼀预测问题。

它的⼯作原理是⽣成多个分类器/模型,各⾃独⽴地学习和作出预测。

这些预测最后结合成单预测,因此优于任何⼀个单分类的做出预测。

随机森林是集成学习的⼀个⼦类,由于它依靠于策率树的合并。

信息、熵以及信息增益的概念这三个基本概念是决策树的根本,是决策树利⽤特征来分类时,确定特征选取顺序的依据。

理解了它们,决策树你也就了解了⼤概。

引⽤⾹农的话来说,信息是⽤来消除随机不确定性的东西。

当然这句话虽然经典,但是还是很难去搞明⽩这种东西到底是个什么样,可能在不同的地⽅来说,指的东西⼜不⼀样。

随机森林回归模型原理

随机森林回归模型原理随机森林回归(RandomForestRegression,RF)是一种集成学习(ensemble learning)技术,它可以应用于分类和回归领域。

它是将多个基学习器(weak learners)有效地组合在一起,从而达到比单个基学习器更好的预测性能。

随机森林是一种强有力的非线性回归模型,可以针对大规模数据集有效处理多维特征。

一、随机森林回归算法流程1.随机森林回归模型的建立需要经历四个步骤:(1)数据集准备:首先用户需要收集数据集,包括:自变量(x1,x2..xn)和响应变量(y),然后对数据进行正确归一化处理。

(2)特征选择:从自变量中选择具有更强预测能力的特征。

(3)模型建立:将特征变量与响应变量进行拟合,建立随机森林回归模型。

(4)模型调参:调整随机森林个体树的参数,使得模型获得最佳性能。

2.随机森林回归模型的预测需要经过两个步骤:(1)模型训练:利用上面步骤(1)中建立的随机森林回归模型来进行训练。

(2)预测:将自变量输入到模型中,根据模型训练结果,获取响应变量的预测值。

二、随机森林回归模型的优势1.随机森林模型可以有效处理大规模数据集,具有计算速度快的优势。

2.随机森林可以有效的处理缺失数据,并且不会对模型的性能产生影响。

3.随机森林模型可以有效处理非线性数据。

4.随机森林模型可以在特征的维度很高的情况下进行训练,而不会损失太多的性能。

5.随机森林模型可以进行特征选择,可以快速和有效的发现有用的特征。

6.随机森林回归模型具有很强的泛化能力。

三、总结随机森林(Random Forest)是一种重要的集成学习技术,它可以应用于分类和回归领域。

它的强大之处在于可以针对大规模数据集,处理多维特征,有效的处理缺失数据,进行特征选择以及具有很强的泛化能力。

随机森林回归模型由四个步骤组成:数据集准备、特征选择、模型建立和模型调参,它的预测需要经过模型训练和预测步骤。

最后,要记住,随机森林回归模型实用性很强,可以用于许多机器学习问题。

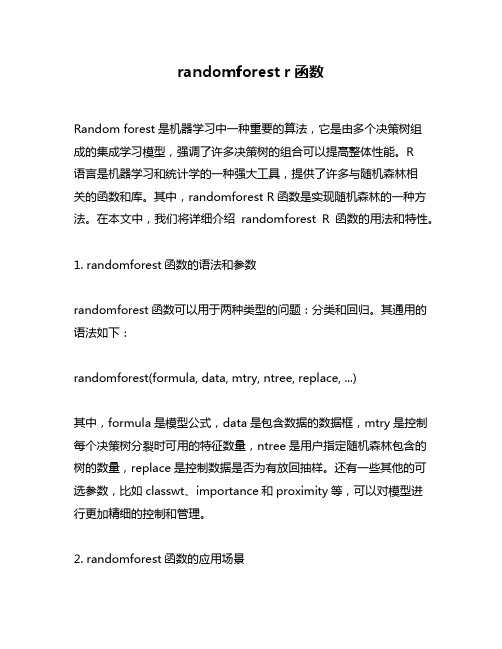

randomforest r函数

5.印模完成后,用生理盐水冲洗龈沟,按需求粘固临时 冠,并在龈沟内放置碘甘油

谢谢!

置,方便临床操作。

排龈技术的优点

1.固定义齿修复排龈的优点 2.其他口腔修复排龈的优点

1.牙体预备前排龈 2.取印模前排龈 3.粘接前排龈

接近龈缘或深达龈下的 牙颈部龋来自和楔状缺损临床常用的排龈方法

1.外科法 2.机械法 3.机械化学法

1.牙龈旋转切割术 2.电刀牙龈切除术 3.激光切除术

排龈术的护理配合

1.调节治疗椅位及灯光,为患者戴好帽子和口围,并向 患者解释可能会出现的不适以消除其恐惧和不适的 心理,从而取得良好的医患配合;

2.护士将患者口腔尽可能打开,给医生足够的操作视野

3.隔湿并干燥牙龈,医生用专用排龈器将排龈线放入龈 沟深处,或使用专用排龈膏注射器将排龈膏推入牙 龈约五至十分钟后, 取出排龈线或冲洗排龈膏。医生 进行牙体预备时,护士应及时用吸唾器吸去患者口 内血液和分泌物,以保持医生的操作视野清晰

1药物排龈线 2 Expasyl排龈膏 3 Merocel条

• 传统的药物排龈线是用缝合线或手工制作 的棉捻蘸取少量的肾上腺素,放入龈沟内。 但由于棉捻粗细不均,肾上腺素的含量有 所差异,排龈效果往往不佳,且残留在龈 沟内的棉絮易引发牙龈炎,目前在应用中 逐渐被淘汰。

• 包括明矾、四氢唑啉,以及 不同浓度的肾上腺素,硫酸 铝溶液,氯化铝溶液,硫酸 亚铁溶液和硫酸铁溶液等。

早上好!

排龈技术在固定义齿修复中的应用

答辩人:张民珍 指导老师:林永盛

排龈技术

排龈技术是指采用药物性或机械性的手段,使 游离的龈缘与牙面分离,去除排龈材料后,牙 龈组织能立即回复到原始位置,不会造成永 久性牙龈萎缩或附着丧失的方法。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

李欣海第五届中国R 语言会议北京2012Random Forest•Random Forest is a n ensemble classifier that consists of many decision trees.•It outputs the class that is the mode of the class's output by individual trees (Breiman 2001).•It deals with “small n large p”-problems, high-order interactions, correlated predictor variables.Breiman, L. 2001. Random forests. Machine Learning 45:5-32. (Being cited 6500 times until 2012)2/25/2011/03/an-introduction-to-data-mining-for-marketing-and-business-intelligence/随机森林简介李欣海第五届中国R 语言会议北京2012HistoryThe algorithm for inducing a random forest was developed by Leo Breiman (2001) and Adele Cutler, and "Random Forests" is their trademark.The term came from random decision forests that was first proposed by Tin Kam Ho of Bell Labs in 1995.The method combines Breiman's "bagging" idea and therandom selection of features, introduced independently by Ho(1995) and Amit and Geman (1997) in order to construct acollection of decision trees with controlled variation.3/25随机森林简介/2011/03/an-introduction-to-data-mining-for-marketing-and-business-intelligence/李欣海第五届中国R 语言会议北京2012Tree modelsRegression tree(Crawley 2007 The R Book p691)Classification tree(Crawley 2007 The R Book p694)ii i i i x x x y εββββ++++=33221104/25随机森林简介李欣海第五届中国R 语言会议北京2012The statistical community uses irrelevant theory,questionable conclusions?David R. CoxBruce Hoadley Brad EfronEmanuel Parzen NOYES5/25随机森林简介李欣海第五届中国R 语言会议北京2012Ensemble classifiersTree models are simple, often produce noisy (bushy) or weak (stunted) classifiers.•Bagging (Breiman, 1996): Fit many large trees to bootstrap-resampled versions of the training data, and classify by majority vote.•Boosting (Freund & Shapire, 1996): Fit many large or small trees to reweighted versions of the training data. Classify by weighted majority vote.•Random Forests (Breiman 1999): Fancier version of bagging .In general Boosting > Random Forests > Bagging > Single Tree (Trevor Hastie)./profiles/Trevor_Hastie/6/25随机森林简介李欣海第五届中国R 语言会议北京2012How Random Forest Works•At each tree split, a random sample of m features (input variables) is drawn, and only those m features are considered for splitting, and the best split is calculated only within this subset. Typically m = sqrt (p) or log (p), where p is the number of features.•For each tree grown on a bootstrap sample, the error rate for observations left out of the bootstrap sample is monitored. This is called the out-of-bag (OOB) error rate.•Random forests tries to improve on bagging by “de-correlating”the trees. Each tree has the same expectation.(Trevor Hastie, p21 in Trees, Bagging, Random Forests and Boosting )/profiles/Trevor_Hastie/7/25随机森林简介•No pruning step is performed so all the trees of the forest are maximal trees.8/25随机森林简介李欣海第五届中国R语言会议北京2012R PackagesrandomForest randomForest()Title: Breiman and Cutler’s random forests for classification and regressionVersion: 4.6-6Date: 2012-01-06Author: Fortran original by Leo Breiman and Adele Cutler, R port by Andy Liaw and Matthew Wiener.•Main parameters: mtry, the number of input variables randomly chosen at each split•Main parameters: ntree, the number of trees in the forest.Implementation based on CART trees for variables of different types.Biased in favor of continuous variables and variables with many categories.party cforest()Based on unbiased conditional inference trees.For variables of different types: unbiased when subsampling.#################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################################四川甘肃陕西湖北重庆山西宁夏河南青海湖南湖南渭河黄河岷江嘉陵江汉江黄河朱鹮的分布12/25随机森林:分类李欣海第五届中国R语言会议北京2012Variance inflation factors (VIF) to detect multicollinearitylibrary(car)vif(lm(pop ~ x+y+elevation+slope+aspect+footprint+GDP+prec_ann+prec_jan+prec_july+t_ann+t_jan+t_july,data=ibis))x 6.86y82.67elevation9.82aspect 1.01footprint 1.38GDP 1.32prec_ann207.97prec_jan 6.24slope 1.50t_ann15170.35prec_july170.89t_jan4309.17t_july5132.72李欣海第五届中国R 语言会议北京2012importance (RF)1MeanDecreaseAccuracyMeanDecreaseGiniy 0.544507 1.39170660.6081245179.819331x 0.455705 1.38664190.594095126.056688slope 0.169391 1.29667970.558778839.304633prec_ann 0.324172 1.21311640.529348655.937209GDP 0.393354 1.18382830.523328242.083964prec_july 0.366197 1.1663940.52123951.248009landcover 0.250204 1.18886270.512518184.391889t_jan 0.406161 1.16513660.509600261.646713elevation 0.380496 1.18950610.505319369.867269t_ann 0.383974 1.1505480.504852963.471821pop 0.423507 1.08749840.498120328.297228aspect -0.0799 1.19879370.480990122.272998t_july 0.352301 1.10585940.479628759.880941footprint -0.053750.92240680.377390215.344756prec_jan0.2289130.80925920.3442248.766087imp <-importance (RF)impvar <-imp [order (imp[, 3], decreasing =TRUE ),]; impvar15/25随机森林:分类李欣海第五届中国R 语言会议北京2012Historical decline of Asian elephantYear !211!212 -500!501 -600!601 -700!701 -800!801 -900!901 -1000!1001 -1100!1101 -1200!1201 -1300!1301 -1400!1401 -1500!1501 -1600!1601 -1700!1701 -1800!1801 -1900!1901 -1940!1941 -1960!1961 -1980!1981 -200020/25随机森林:回归The advantages of Random Forest•For many data sets, it produces a highly accurate classifier•It handles a very large number of input variables•It estimates the importance of variables in determining classification•It generates an internal unbiased estimate of the generalization error as the forest building progresses•It includes a good method for estimating missing data and maintains accuracy when a large proportion of the data are missing•It provides an experimental way to detect variable interactions•It can balance error in class population unbalanced data sets•It computes proximities between cases, useful for clustering, detecting outliers, and (by scaling) visualizing the data•Using the above, it can be extended to unlabeled data, leading to unsupervised clustering, outlier detection and data views•Learning is fastThe disadvantages of Random Forest •Random forests are prone to overfitting for some datasets. This is even more pronounced in noisy classification/regression tasks.•Random forests do not handle large numbers of irrelevant features as well as ensembles of entropy-reducing decision trees.•It is more efficient to select a random decision boundary than an entropy-reducing decision boundary, thus making larger ensembles more feasible.Although this may seem to be an advantage at first, it has the effect of shifting the computation from training time to evaluation time, which is actually adisadvantage for most applications.李欣海第五届中国R语言会议北京2012Try Random Forest!Phone took at Hailuogou, Sichuanprovince in June 2007 by Xinhai Li。