高维线性模型中的经验似然

MA(∞)误差下部分线性模型的经验似然统计推断

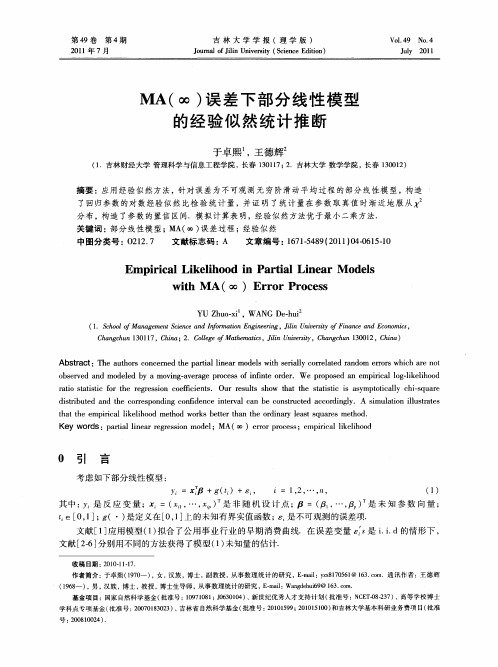

MA(∞)误差下部分线性模型的经验似然统计推断于卓熙;王德辉【摘要】应用经验似然方法,针对误差为不可观测无穷阶滑动平均过程的部分线性模型,构造了回归参数的对数经验似然比检验统计量,并证明了统计量在参数取真值时渐近地服从X2分布,构造了参数的置信区间.模拟计算表明,经验似然方法优于最小二乘方法.【期刊名称】《吉林大学学报(理学版)》【年(卷),期】2011(049)004【总页数】10页(P615-624)【关键词】部分线性模型;MA(∞)误差过程;经验似然【作者】于卓熙;王德辉【作者单位】吉林财经大学管理科学与信息工程学院,长春130117;吉林大学数学学院,长春130012【正文语种】中文【中图分类】O212.70 引言考虑如下部分线性模型:(1)其中: yi是反应变量; xi=(xi1,…,xip)T是非随机设计点; β=(β1,…,βp)T是未知参数向量; ti∈[0,1]; g(·)是定义在[0,1]上的未知有界实值函数; εi是不可观测的误差项. 文献[1]应用模型(1)拟合了公用事业行业的早期消费曲线. 在误差变量是i.i.d的情形下, 文献[2-6]分别用不同的方法获得了模型(1)未知量的估计.在实际问题中, 误差独立同分布的假设并不总合适. 近年来, 具有序列相依误差的部分线性回归模型的研究已引起人们广泛关注. 用于误差建模的一种无穷阶滑动平均过程即为MA(∞)过程, 假设{εi}具有如下形式:(2)这里{ei}是i.i.d.随机变量列, 满足文献[7]应用文献[8]给出的线性过程多项式分解方法获得了参数β的半参数最小二乘估计(SLSE)的重对数律和渐近正态性. 文献[9]应用MA(∞)过程截断方法在更一般的情形下证明了参数β的SLSE的重对数律.经验似然是一类重要的构造非参数置信区间和检验的方法, 文献[10]对此方法的一般性质进行了系统研究. 文献[11-12]研究表明, 经验似然有类似于参数似然法的优良性, 特别是对数形式类似于Wilk’s理论, 趋于χ2分布. 文献[13-14]给出了用分组经验似然方法处理强相依的数据.本文在误差由式(2)定义的MA(∞)过程下应用经验似然方法构造了MA(∞)误差下模型(1)回归系数的经验似然比检验统计量, 并讨论了该统计量的渐近性质.1 方法与主要结果假设随机误差{εi,1≤i≤n}构成由式(2)定义的MA(∞)过程, 且令则假设0<|C(1)|<∞.给定β时g(·)的一个非参数估计量为这里Wni(·)(1≤i≤n)是一些定义在[0,1]上的权函数.令β的对数经验似然比统计量定义为(3)这里λ(β)∈Rp定义如下:(4)假设:(H1) 存在定义在[0,1]上的函数hj(·), 使得xij=hj(ti)+uij, i=1,2,…,n, j=1,2,…,p,(5)这里(ui1,…,uip)T=ui是实值向量, 满足(6)(7)其中: B为正定矩阵; (j1,…, jn)是(1,2,…,n)的任意置换; ‖·‖表示欧氏模;(8)C是不依赖于n的常数.(H2) 函数g(·), hj(·)(j=1,2,…,n)满足一阶Lipschitz条件.(H3) 权函数Wni(·)满足:∀t∈[0,1];这里bn=o(n-2/3(log n)-2);这里dn=O(n-1/3(log n)-1);对s,t∈[0,1]一致成立, 这里c2是一个常数.(H4) 由式(2)所定义的误差过程{εi}满足如下条件:(ii) {εi}的谱密度函数ψ(ω)有界非零, 即0<c3≤ψ(ω)≤c4<∞, ω∈(-π,π],这里c3和c4是常数.定理1 令β0为参数的真值, 假设(H1)~(H4)成立, 则当n→∞时,这里表示依分布收敛.由定理1, 可以建立β的α-水平置信域:这里cα满足2 模拟计算下面通过模拟计算比较经验似然方法和渐近正态方法. 为简单, 只考虑β为标量的情况.应用模型yi=xiβ+g(ti)+εi, εi=θεi-1+ei, 这里g(ti)=sin(2πti), β=1.5, 设计点从固定种子10的U[0,1]分布中产生, 设计点产生于这里vi是i.i.d.的且服从T(3)分布, ei是i.i.d.的且服从N(0,1)分布.由文献[7]中定理1知, β的最小二乘估计渐近服从正态分布, 即这里: 所以, β的水平为1-α的双侧置信区间为这里Zα满足Φ(Zα)=α, Φ(·)是标准正态分布的分布函数. 权函数具有如下形式:其中核函数K(t)是高斯核, 由最小平方交叉核实方法(LSCV)选取带宽hn. 样本容量分别取50,100和200; α=0.10, α=0.05. 基于500次模拟, 计算经验似然(EL)和渐近正态方法(LS)的覆盖率, 结果列于表1. 由表1可见, 两种方法在θ>0时结果较好. 由于由两种方法构造置信区间时都有C(1)=1/(1-θ), 因此在考虑的所有情形下, EL 方法比LS方法结果更好.表1 β的覆盖率Table 1 Coverage probabilities for β样品容量n参数α方法θ-0.5-0.3-0.1500.150.30.5500.10LS0.556 40.668 80.746 00.809 80.86640.925 20.978 0EL0.639 20.734 20.829 40.883 60.922 60.968 00.99220.05LS0.563 80.678 80.767 00.833 80.902 40.958 20.994 4EL0.646 60.774 80.861 20.913 40.959 00.987 40.999 21000.10LS0.564 60.667 60.763 60.826 80.888 80.938 60.983 8EL0.653 00.758 20.842 80.896 40.940 60.971 40.995 40.05LS0.568 40.674 80.773 40.843 20.912 40.957 60.992 6EL0.656 80.770 20.860 60.918 40.958 40.986 80.998 82000.10LS0.580 00.669 00.767 20.828 40.888 00.934 00.983 0EL0.661 80.756 40.841 80.896 20.942 40.970 60.996 80.05LS0.577 60.685 40.779 60.845 00.906 80.952 80.992 6EL0.668 80.778 80.861 20.914 60.958 60.983 00.998 43 定理的证明引理1 1) 假设(H2)和(H3)中(iv)成立, 则当n→∞时,这里G0(·)=g(·), Gj(·)=hj(·)(1≤j≤p);2) 假设(H1)~(H3)成立, 则当n→∞时,这里引理1的证明与文献[7]中引理2的证明类似.引理2 假设(H1)~(H3)成立, 则引理2的证明与文献[7]中引理3(i)的证明类似.引理3 对于式(2)中的线性过程, 假设(H3)中(iii)和(v)、 (H4)中(i)成立, 则证明参见文献[9]中引理2.引理4 对于式(2)中的线性过程, 假设(H4)中(i)成立, 则这里(j1, j2,…, jn)是(1,2,…,n)的任意置换.证明参见文献[9]中引理4.引理5 假设(H1)~(H4)成立, 则证明:这里:下面证明(9)由于故由Chebychev不等式, 得从而, 由Borel-Cantelli引理可得(10)令由和三级数定理, 有而注意到同理可得应用Bernstein’s不等式, 存在c5>0, 使得这里:是一个正的常数. 所以, 正确选择c6, 并应用Borel-Cantelli引理, 可得由以上证明可得(11)结合式(10)和(11), 即可得式(9). 应用引理1中1)、引理2和引理3、 (H1)和(H2), 即可完成引理5的证明.引理6 假设(H1)~(H4)成立, 则有证明: 由Zi的定义, 有对于1≤k≤p, 用表示的第k个元素, 应用假设(H1)和引理1, 有这里类似于以上证明, 应用引理1和引理3, 可得下面证明注意到对于1≤k≤p, (j1, j2,…, jn)是(1,2,…,n)的任意置换, 应用引理4, 有由文献[8], 有这里所以由假设(H1), 有应用Abel不等式, 有由假设(H4), 类似于文献[7]中引理5的证明, 有这里表示依概率收敛.结合以上证明并应用引理2, 即可完成引理6的证明. 引理7 假设(H1)~(H4)成立, 则∀a∈Rp.证明: 由引理6直接可得.引理8 假设(H1)~(H4)成立, 令则证明:应用引理2和引理3, 可得应用引理1, 有‖Rn3‖=O(n-2/3(log n)-2).由引理3和可得同理可证‖Rn5‖=O(n-1/3(log n)-1)O(n1/4log n)=O(n-1/12) a.s., ‖Rn6‖=O(n-1/3log n)O(n-1/3(log n)-1)=O(n-2/3) a.s. 下面证明(12)由文献[8], 有这里:为证明式(12), 只需证(13)(14)注意到这里:从而有故有应用Abel不等式, 可以证明对任意的矩阵A, 用Ahl表示A的第h行、第l列元素(h,l=1,2,…,p).下面证明(15)(16)若则式(15)成立. 而由假设(H4)中(i)可知式(15)成立.式(16)等价于对∀c>0,(17)若则式(17)成立;若则式(16)成立, 从而式(13)成立.由文献[8], 有这里:≜令则由文献[8]中引理3.6(b), 可得由及可知从而有注意到为证明(18)只需证(19)(20)若则式(19)成立. 又由文献[8]中引理5.9知, 若则由假设(H4)中(i)可知式(19)成立.式(20)等价于(21)对∀c>0, 由于从而式(21)成立.而式(18)得证.综上可见, 引理8成立.下面证明定理1. 由引理5~引理8, 类似于文献[10]中定理1的证明, 有结合引理6和引理8, 即可证得定理1.参考文献【相关文献】[1] Shiller R J. Smoothness Priors and Nonlinear Regression [J]. J Amer Statist Assoc, 1984, 79: 605-615.[2] Speckman P. Kernel Smoothing in Partial Linear Models [J]. J Royal Statist Soc B, 1988, 50(3): 413-436.[3] Chen H, Shiau J. A Two-Stage Spline Smoothing Method for Partial Linear Models [J]. J Statist Plann Inference, 1991, 27(2): 187-201.[4] Donald S G, Newey W K. Series Estimation of Semilinear Models [J]. J Multivariate Anal, 1994, 50(1): 30-40.[5] Hamilton S A, Truong Y K. Local Linear Estimation in Partial Linear Models [J]. J Multivariate Anal, 1997, 60(1): 1-19.[6] Härdle W, Liang H, Gao J. Partial Linear Models [M]. Heidelberg: Physica-Verlag, 2000.[7] Gao J T, Anh V V. Semiparametric Regression under Long-Range Dependent Errors [J]. J Statist Plann Inference, 1999, 80(1/2): 37-57.[8] Philips P C B, Solo V. Asymptotics for Linear Processes [J]. Ann Statist, 1992, 20(2): 971-1001.[9] Sun X Q, You J H, Chen G, et al. Convergence Rate of a Class of Estimators in Partially Linear Regression Models with Serially Correlated Errors [J]. Communications Statist: Theory Methods, 2002, 31(12): 2251-2252.[10] Owen A B. Empirical Likelihood Confidence Regions [J]. Ann Statist, 1990, 18(1): 90-120.[11] Owen A B. Empirical Likelihood for Linear Models [J]. Ann Statist, 1991, 19(4): 1725-1747.[12] QIN Jin, Lawless J. Empirical Likelihood and General Estimating Equations [J]. Ann Statist, 1994, 22(1): 300-325.[13] Kitamura Y. Empirical Likelihood Methods with Weakly Dependent Processes [J]. Ann Statist, 1997, 25(5): 2084-2102.[14] ZHANG Jun-jian, WANG Cheng-ming, WANG Wei. Empirical Likelihood Ratio Confidence Regions for Dependent Samples [J]. Appl Math J Chines Univ: Ser A, 1999,14(1): 63-72. (张军舰, 王成名, 王炜. 相依样本情形时的经验似然比置信区间 [J]. 高校应用数学学报: A辑, 1999, 14(1): 63-72.)。

高维线性模型的变量选择

高维线性模型的变量选择年级:2007级专业:概率论与数理统计研究方向:数理统计研究生:李玲玲导师:张军舰摘要高维数据在生物信息学、生物医学、计量经济学和机器学习等领域频繁出现,它使经典的统计方法遭受了较大的冲击,是目前统计学理论和应用研究中面临困难最多、挑战最严峻的研究领域之一。

对高维数据的研究,通常情况需要假定真实模型位于一个低维空间(至少协变量维数要比样本容量低),也就是常说的稀疏性(sparsity)假定。

然后再按照一定的规则选择变量进行降维。

通过选择变量,将对因变量根本没有影响或者影响较小的变量剔除,保留影响较大的变量,从而建立简洁的模型。

本论文在对前人已有研究成果进行综合分析的基础上,主要考察随机误差项分布未知时的高维线性模型的变量选择问题。

所采用的方法和思想主要是Fan和Lv(J.Fan,J.Lv. Sure independence screening for ultra-high dimensional feature space[J].Journal of the Royal Statistical Society Series B.2008,70:849-911.)的安全独立筛选(Sure independent screening,简记为SIS)方法和迭代安全独立筛选(Iterative sure independent screening,简记为ISIS)方法,与Chen,Variyath和Abraham(J.Chen,A.M.Variyath,B.Abraham.Adjusted empirical likelihood and its properties[J].Journal of Computational and Craphical Statistics.2008,17,426-443.)的调整经验似然(AEL)方法的有机结合。

从理论上进一步说明Fan和Lv的SIS方法和ISIS方法在误差项不服从正态分布时也是成立的,并且具有较好的安全筛选渐近性质。

MA(∞)误差下部分线性模型的经验似然统计推断

文献 [ -] 26 分别 用不 同的方 法获 得 了模 型 ( ) 1 未知量 的估 计.

收稿 日期 : 0 01 —7 2 1 —11 .

于卓熙 王德 辉 ,

( .吉林财经 大学 管理科学与信息 工程学院 ,长春 10 1 ; .吉林 大学 数学学 院,长春 10 1 ) 1 3 17 2 30 2

摘 要 :应用 经 验似 然 方法 , 对误 差 为不 可观 测 无 穷 阶滑动 平 均 过 程 的部 分 线 性模 型 ,构造 针

第4 9卷

第 4期

吉 林 大 学 学 报 (理 学 版 )

Jun l f inU i r t Si c dt n ora o l nv sy( c neE io ) Ji ei e i

V 14 No 4 o. 9 .

2 1 年 7月 01

J l 2 1 uy 0 1

MA( ) 差 下 部 分 线 性 模 型 ∞ 误 的经 验 似 然 统 计 推 断

了回归参数 的对数经验似然 比检验统计量,并证明 了统计量在参数取真值 时渐近地服从

分布 ,构造 了参 数 的置信 区间.模 拟 计 算表 明,经 验似 然方 法优 于 最小 二乘 方法.

关键 词 : 分 线 性模 型 ;M ∞ ) 差过 程 ; 验 似然 部 A( 误 经

中 图分 类号 :0 1 . 22 7

Y = +g( , t)+ i7 , … , - 2, n, .1 () 1

其 中 : 是 反 应 变 量 ;X Y =(

… , ) 非 随 机 设 计 点 ; = ( 。 … , 是 未 知 参 数 向 量 ; 是 卢, 卢 )

高维数据分析方法及其应用

高维数据分析方法及其应用随着科技和信息技术的不断发展,数据在我们日常生活和各个领域中的应用愈发广泛。

由于许多数据集包含许多变量,数据的维度呈现高维的趋势。

高维数据比低维数据更加复杂,因此需要更先进的技术来分析和探究。

高维数据分析是一种用于理解高维数据集的方法。

它主要通过统计学和数学方法来抽象和压缩数据,以便能够更好地解释和预测数据。

这种分析方法非常有用,因为它可以揭示数据中的隐含模式和规律,从而提高对数据的理解,进一步推动各个领域的发展。

高维数据的定义高维数据通常是指数据集中包含的变量数比样本点数多得多的数据。

在低维数据分析中,变量数通常低于样本数。

例如,在二维空间中,我们通常只有两个坐标轴,一个横向轴和一个纵向轴,我们可以通过坐标点来描述物体的位置。

而在高维数据集中,我们需要更多的坐标轴来描述同一个物体,这些坐标通常代表数据集中的不同特征。

例如,在三维空间中,我们有x轴,y轴和z轴,可以用三个数值来表示一个点的位置。

而在高维空间中,我们需要更多的坐标,例如在四维空间中,我们有x,y,z,t四个坐标轴。

高维数据的挑战高维数据分析的一个主要挑战是“维数噪声”,这意味着在高维空间中,大量的变量会使得很难找到有效的和重要的特征。

当维度增加时,数据点之间的距离也会增加。

数据点变得稀疏,导致数据的相关性变低,从而增加了分析和预测的困难性。

高维数据还面临着诸多数据存储和计算的问题。

高维数据集通常比低维数据集更大,更复杂,更难以处理。

这些数据缺乏明显的结构和属性,常常需要人工干预分析,导致分析耗时费力。

高维数据分析方法为了解决高维数据问题并提高大数据的分析效率,有许多新兴的高维数据分析方法出现。

这些方法包括统计学、概率论、机器学习以及人工智能等技术。

其中,以下几个方法在高维数据分析中受到广泛关注:1. 主成分分析(PCA)PCA是最常用的高维数据分析方法之一,它可以利用数据的线性组合来提取数据的主要特征。

它降低了数据的维度,并且保留了数据的主要特征。

经验似然方法

第五章 经验似然方法Fisher 提出的 (参数)似然方法是最重要的统计方法之一,应用上要求已知总体的类 型和形式,总体的分布只依赖于若干个未知参数,然后利用所建立的似然函数对这些未知参 数进行统计推断。

在一定的正则条件下,由此方法得到的估计具有良好的统计性质(见文献 [1])。

然而,当我们对问题的背景所知甚少,仅知道部分信息(如总体分布的一阶矩、二阶矩 等),自然希望寻找一定的途径构造和使用某种类似于似然函数的形式,以便有效地加工这些部分信息, 从而进行统计推断, 经验似然法正是在这样的背景下产生的。

Hartley and Rao[2]利用经验似然思想对抽样调查问题进行了研究,Thomas and Grunkemier [3]利用经验似然思想建立了截尾数据下生存概率的区间估计,Owen [45]首次系统地提出了经验似然方法,并用来 处理非参数统计问题。

经验似然有类似于 Bootstrap 的抽样特性,这一方法与经典的或现代的非参数统计方法 比较有很多突出的优点,如:用经验似然方法构造置信区间除有域保持性、变换不变性及置 信域的形状由数据自行决定等诸多优点外, 还有 Bartlett 纠偏性及无需构造枢轴统计量等优 点。

正因为如此,这一方法引起了许多统计学者的兴趣,他们将这一方法应用到各种统计模型和领域,如 Owen [6] 将其应用到线性回归模型的统计推断中,Qin and Lawless [7]将经验似然引入广义估计方程模型, 推广了Owen [45] 的有关结果, Chen [8]给出了密度函数的经验似然置信区间, Chen 和 Qin [9] 发展了非参数回归模型的经验似然,Wang 和 Jing [10] 、Qin [11]以及Shi and Lau [12] 发展了部分线性模型的经验似然,Chen 和 Qin [13] 、 Zhong 和 Rao [14]以及 Chen和 Wu [15] 应用经验似然于抽样数据的研究,Kitamura [16]等应用经验似然到经济模型的研究,Zhang [1718] 证明了利用经验似然可以有效地加工附加信息得到统计泛函的推断等, Owen [19]给出了经验似然当时的研究进展。

【国家自然科学基金】_删失回归_基金支持热词逐年推荐_【万方软件创新助手】_20140802

推荐指数 1 1 1 1 1 1 1 1 1 1 1 1 1

科研热词 高维数据 预测变量 面板数据 药物基因组 联合建模 线性模型 纵向数据 相合性 生存时间 生存分析 潜在变量 比例风险模型 有偏抽样 无偏转换 带信息观察过程 基因表达谱 基因表达数据 回归模型 删失 估计方程 主成分分析

推荐指数 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1

2008年 序号 1 2 3 4 5 6 7 8 9

科研热词 遗传方差分量模型 置信区间 线性回归模型 生存时间 合成数据 加权bootstrap推断 删失性状 weibull回归模型 cox模型

推荐指数 2 1 1 1 1 1 1 1 1

2010年 序号 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16

科研热词 删失数据 非线性模型 非参数估计 调整的经验似然 置信域 最小绝对偏差 局部线性回归 回归残差 变量选择 变系数部分线性模型 变换 删失回归模型 删失 一致相合性 profile最小二乘 lasso

推荐指数 2 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1

2011年 序号 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21

2012年 序号 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20

2013年 科研热词 推荐指数 序号 删失数据 2 1 高维数据 1 2 非线性半参数回归模型 1 3 零膨胀poisson回归 1 4 随机效应 1 5 经验似然估计 1 6 经验似然 1 7 生存预测 1 模拟 1 模型估计 1 有限样本 1 有监督的主成分回归 1 最大边际似然估计 1 回归模型 1 加权矩阵 1 删失回归 1 偏cox回归 1 x~2分布 1 panel data, censored regression, 1 finite sample performance, montecarlo归 数据删失模型 异常点检验 均值漂移模型 变量选择 删失回归模型 oracle性质 推荐指数 1 1 1 1 1 1 1

经验似然介绍及研究状况讲解

李吉妮(2014)研究单指标模型的高维惩罚经验似 然 ,单指标模型是广义回归中一种特 殊的半参数 模型,是处理多元非参数回归问题的有效工具,应用 非常广泛.近二十年,高维数据的变量选择问题已成 为统计及其相关领域中研究的热点之一.在处理高维 数据时,单指标模型的降维特性不仅有效地避免了 “维数灾难(curse of dimensionality)”问题,还抓住了 高维数据的稀疏特性.有关运用单指标模型讨论变量 选择方法的文章层出不穷,但大部分都是针对参数维 数p是 固定时的情况.然而在很多高维的变量选择问 题中,参数维数p一般都会随着样本容量n的增大而同 时增大.因此,在本文中,我们对单指标模型提出了一 种稳健的 变量选择方法:基于SCAD(Smoothly Clipped Absolute Deviation)惩罚函数及经验似然的 惩罚经验似然.在一定正则条件下, 发现参数维数p随 样本量n同时增大的惩罚经验似然估计仍具有Oracle 性质。

关于 数 据 missing时的经验似然推断,这方 面王启华与合作者J.N .K .R ao的做了很多工 作.Wang与Rao(2001),W ang与Rao(2002a,b, c) 分别在线性imputation和非参数核回归 imputation下发展了反映数据misssing时的经 验似然推断.近年祝丽萍(2011)讨论了缺失

下,正态分布一直是最引人注目的,但是对总体的 分布不是随便做出来的,盲目地做出正态分布的假 设有时候是起反作用的。

当数据的分布不是很明确,特别当样本容量不大, 几乎无法对分布作推断的时候,此时使用参数方法 就有一定的风险,我们就可以考虑用非参数的方 法。 但要注意,非参数方法是与总体分布无关,而 不是与所有分布无关!

至于经验似然在测量误差模型中的应用,Wang、Rao(2002) 不假设任何误差模型结构而是在核实数据帮助下,推广经验 似然方法到协变量有测量误差的线性模型,定义了一种渐近 分布是加权卡方的被估计的经验对数似然,由于权未知因而 该结果不能直接应用到统计推断,为了克服这一困难, Wang与Rao使用下面三种方法:

响应变量随机缺失下的变系数部分线性模型的经验似然推断

+E t

( 1 )

其 中 = ( , , ) q … 为 维未知 向量 , ( = (1. … , () . ( , . 为P 未知 向量 函数 。 为 ) ) ) 维

响应变 量 , 为 P 协变 量 , 维 为 q 协变 量 , 维 为 一维协 变 量 。不失 一般 性 ,设 在 区

第2卷 第 期 7 5

2 1 年1 月 00 0

工

程

数

学

学

报

V 12 o 5 o 7 . . N

Oc.2 1 t 00

CHI NES J E OURNAL OF ENGI NEERI NG MATHEMATI CS

文章. 711 0

P 3 , ,, =P 5 ,, ( =1yx ZU) ( =1X ZU) I l

由模型 () 1可知

=

( ) +

+ ,

() 2

其中e i=

为独立 同分 布的 随机变量 ,并 且 E( , , )= 0 el 。模 型 () 2 为基 于完全观 测数据的变系数部分线性模型,因此利用文献 [ 的方法,对给定的 ,最小化 () 9 ] 3式则得 到 Ou 的局部最 小二乘估计 () () 。 ∑

72 7

工

程

数

学

学

报

第2 卷 7

2 参数部分 的调整经验似 然推断

设 ( 五 , , v i 1… , ,为来 自模型 () , , d, = , n 1 的一个不完全随机样本 ,其 中五 , 和

可 以完全观测 ,当 = 1 可 以观测,5 =0 缺失 。本文假定 y为 随机缺 失,即 时, i 时,

分类号: AM S(0 0 2 5 6 G2 2 0 1 G0 ; 2 0 6

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

J.Sys.Sci.&Math.Scis.27(1)(2007,2),124–133∗(100080)MR(2000)62E20,62F051Y=X Tβ+ε,(1.1) X kε0βT(Y1,X1),(Y2,X2),···,(Y n,X n).(1.1),β,βεββ[1,2],[2]Wilks[3],Owen(2001)(1.1)X k n(1.1),Owen[4],kχ2k.k*(10231030,10071090)2006-10-20.11252Owenβ∈R k 1≤i ≤n ,εi (β)=Y i −X T i β.{ε1,ε2,···,εn }β0{ε1(β0),ε2(β0),···,εn (β0)}β∈R k ,Owen[4]L (β)=sup{{p i }n i =1∈F (β)}nj =1p j ,(2.1)F (β)= {p i ≥0}ni =1:n j =1p j =1,n j =1p j X j εj (β)=0 .[4],LagrangeL (β)=n i =1p i (β),p i (β)=(n (1+λT X i εi (β)))−1,λ∈R kn i =1X i εi (β)(1+λT X i εi (β))=0.(2.2)Tn (β)=−2log n i =1(np i (β)).(2.3)β0,T n = T n (β0).k ,[4]T n d →χ2k .knT n p →∞.k ,V n =n i =1X i X T i .V nk ×kV n ≥0.λ1n =min eig (V n )λkn =max eig (V n ),min eig (·)max eig (·)M 2n =max 1≤i ≤n||X i ||2,||·||kλ1n ≤n i =1||X i ||2≤nM 2nλkn ≤n i =1||X i ||2≤nM 2n .||X 1||=0.(A1)r >0,E (|ε1|2+r )<∞.(A2)0≤δ<c (r ),nM 2n kλ1n=O (n δ),c (r )=r(2(2+r )).(A3)k =k (n )→∞(n →∞),k 32=O (n c (r )−δ)r <1;o (n 16−δ)1(A1)–(A3)H 0:β=β0T n −k √2kd →N (0,1).(2.4)12627kβ3E (ε21)=1.(A.2),1≤nM 2n kλ1n≤C 0n δnC 0>0λ1n ≥n 1−δM n(C 0k )≥n 1−δ||X 1||(C 0k ),n 1−δk −1nV nA =(a ij )k ×kk ×k||·||M ||A ||M =max 1≤i,j ≤k|a ij |,AB =A −I k =(b ij )k ×k ,I kk ×k λ1,λ2,···,λkτ1,τ2,···,τk A BAB =A −1−I k =( b ij )k ×k .min 1≤i ≤k|τi +1|=min 1≤i ≤k|λi |>0.1max 1≤i ≤k|λi |≤k ||A ||M .2a,b ∈R k ,||a ||=||b ||=1,|a T Ab |≤max 1≤i ≤k |λi |.3A|| B ||M ≤max 1≤i ≤kτi (1+τi ) =max 1≤i ≤k(λi −1)λi.BC ,B =C Tdiag(τ1,τ2,···,τk )C .A −1=(I k +B )−1=(I k +C T diag(τ1,···,τk )C )−1=C T diag((1+τ1)−1,(1+τ2)−1,···,(1+τk )−1)C=I k −C Tdiagτ1(1+τ1),τ2(1+τ2),···,τk (1+τk )C. B =−C T diag(τ1(1+τ1),τ2(1+τ2),···,τk (1+τk ))C .e iR ki11≤i ≤k .1≤i,j ≤k ,| b ij |=|e T i C T diagτ1(1+τ1),τ2(1+τ2),···,τk (1+τk )Ce j |.2| b ij |≤max 1≤i ≤k|τi(1+τi )|.|| B ||M ≤max 1≤i ≤k|τi (1+τi )|.1k ||B ||M a.s.→0,||B ||M|| B||M k ||B ||M a.s.→0,1max 1≤i ≤k|τi |≤k ||B ||M a.s.→0,3|| B ||M ≤max 1≤i ≤k|τi (1+τi )|.n|| B||M ≤2k ||B ||M (a.s.).B n =V −12n (n i =1X i X T i ε2i )V −12n −I k =n i =1(V −12n X i X T i V −12n )(ε2i −1)=(b ijn )k ×k ,B n 4(A1)–(A3)||B n ||M a.s.=O (kn −(b (r )−δ)log n ),b (r )=min(12,r(2+r )),b (r )>δ.1≤s,l ≤k ,b sln =e T s B n e l=n i =1(e T s V −12n X i )(X T i V −12n e l )(ε2i −1).1127a (sl )ni=(e T s V −12n X i )(X T i V −12n e l ),b sln =n i =1a (sl )ni (ε2i −1).(kn δ)−1b sln=ni =1(kn δ)−1a (sl )ni (ε2i −1)1≤i ≤n ,(kn δ)−1|a (sl )ni |≤(kn δλ1n )−1||X i ||2≤M 2n(kn δλ1n ).(A2)lim sup n →∞max 1≤s,l ≤k(kn δ)−1n i =1|a (sl )ni |≤lim sup n →∞n1−δM 2n(k λ1n)≤C 0<∞.d 1n =max1≤s,l ≤k,1≤i ≤n(kn δ)−1|a (sl )ni |.(A2)d 1n ≤M 2n(kn δλ1n )=O (n −1).(A1)C rE (|ε21−1|(2+r )2)≤C r (1+E (|ε1|2+r )<∞.Ghosh [5]3max 1≤i ≤n|ε2i −1|a.s.=o (n2(2+r )).[6]1,max 1≤s,l ≤k(kn δ)−1|b sln |a.s.=O (max(n22+rd 1n ,d 121n )log n ).||B n ||M =max 1≤s,l ≤k|b sln |a.s.=O (max(n −r 2+r ,n −12)n δk log n )a.s.=O (kn −(b (r )−δ)log n ).2(A3)||B n ||M a.s.=o (1).1≤i ≤n ,Z i =X i εi ,W n =n i =1X i X T i ε2i=n i =1Z i Z T i ,¯Z n =n −1n i =1X i εi .4[6]1,||V −12n n i =1(Z i −¯Z n )(Z i −¯Z n )TV −12n −I k ||M a.s.=O (kn −(b (r )−δ)log n ).λ1n =min eig (W n ).5(A1)–(A3)lim inf n →∞λ1n λn≥12(a.s.).B n =n i =1X i X T i (ε2i −1)=( b ijn )k ×k .4|| Bn ||M a.s.=O (kλ1n n −(b (r )−δ)log n ).a ∈R k ,||a ||=1,a T B n a =a T W n a −a T V n a .1|a T W n a −a T V n a |≤k || B n ||M a T V n a −k || B n ||M ≤a T W n a .λ1n −k || Bn ||M ≤a T W n a , λ1n ≥λ1n −k || B n ||M . λ1n λ1n≥1−O (kn −(b (r )−δ)log n ).(a.s.)UT n =n i =1V −12n X i εi T n i =1V −12n X i εi=n i =1n j =1X T i V −1n X j εi εj1≤i,j ≤n ,a ij =X T i V −1n X j ,A =(a ij )n ×n=(X 1,X 2,···,X n )T V −1n (X 1,X 2,···,X n ),B =diag(a 11,a 22,···,a nn ).12827T n=ni=1nj=1a ijεiεj.T n T nTn=T n−ni=1a iiε2i=1≤i=j≤na ijεiεj.[7] T n(clean)U n6(A1)–(A3)T n −E( T n)V ar( T n)d→N(0,1).[7]Uni=1a ii=ni=1X T i V−1nX i=trni=1V−1nX i X T i=tr(V−1nV n)=k,tr(·)E( T n)=0,E( T2n)=21≤i=j≤n a2ij=21≤i=j≤nX T i V−1nX j X T j V−1nX i=21≤i,j≤n X T i V−1nX j X T j V−1nX i−2ni=1(X T i V−1nX i)2=2ni=1X T i V−1nX i−2ni=1a2ii=2k−2ni=1a2ii.n i=1a2ii≤λ−21nni=1||X i||4≤nM4nλ21n=O(k2n−(1−2δ)),(A1)–(A3)k−1ni=1a2ii=O(kn−(1−2δ))=o(1).E( T2 n )(2k)→1V ar( T n)=2k(1+o(1)).E=A−B,µ1,µ2,···,µn E max1≤i≤n µ2ik→0,de Jong[7] T n CA−B=E=C T diag(µ1,µ2,···,µn)C.A2=A E2=C T diag(µ21,µ22,···,µ2n)C= A2−AB−BA+B2=A+B2−AB−BA.ni=1µ2i=tr(E2)=tr(A+B2−AB−BA)=tr(A)+tr(B2)−2tr(AB)=ni=1a ii+ni=1a2ii−2ni=1a2ii=ni=1a ii−ni=1a2ii=k−ni=1a2ii.1129ni =1µ2ik≤1.max 1≤i ≤nµ4i k 2≤n i =1µ4ik 2≤max1≤i ≤nµ2ik ,max 1≤i ≤n µ2i k →0⇐⇒ni =1µ4ik 2→0.1≤i ≤n ,µi =µik 12.(A −B )k 12=C T diag( µ1, µ1,···, µn )C =Ek 12.n i =1µ4i =tr(E k 12)4=t r (E 4)k 2=tr((A −B )4)k 2.tr((A −B )4)=tr((A +B 2−AB −BA )2)=tr(A −4AB +4AB 2−4AB 3+2ABAB )=n i =1a ii −4n i =1a 2ii +4n i =1a 3ii −4n i =1a 4ii +2ni =1n j =1a ii a jj a 2ij .k−2n i =1a 2ii =O (n−(1−2δ))=o (1)max 1≤i ≤n|a ii |≤M 2n λ1n=O (kn −(1−δ))=o (1).k −2n i =1a 3ii ≤k −2n i =1a 2ii max 1≤i ≤n|a ii |→0,k−2n i =1a 4ii≤k−2n i =1a 2iimax 1≤i ≤na 2ii →0.k−2n i =1a ii =1k=o (1),n i =1n j =1a ii a jj a 2ij≤ni =1a ii n j =1||X i ||2||X j ||4λ31n ≤knM 6nλ31n .k −2n i =1n j =1a ii a jj a 2ij ≤nM 6n kλ31n=O (k 2n −(2−3δ))=o (1).n i =1µ4ik 2=n i =1µ4i =tr ((A −B )4)k 2→0,max 1≤i ≤n µ2ik→0.E ( T 2n )(2k )→1,max 1≤i ≤nµ2iE ( T 2n )=k E ( T2n )·max 1≤i ≤nµ2ik→0.[7]5.2,T n −E ( T n ) E ( T2n )−(E ( T n ))2d →N (0,1).130277(A1)–(A3)T n −k √2kd →N (0,1).T n −k = T n +n i =1a ii (ε2i −1).ni =1a ii (ε2i −1)k 12=o p (1)[6]1,ni =1a ii (ε2i −1)a.s.=O (kn−(b (r )−δ)log n )a.s.=o (1).6T n −k √2k = T n √2k +o p (1)= T n −E ( T n )Var( Tn )·Var( T n )√2k +o p (1)d→N (0,1).1≤i ≤n ,p i =p i (β0)=(n (1+λT X i εi ))−1=(n (1+λT Z i ))−1,Tn = T n (β0)=−2log n i =1(n p i ) =2n i =1log(1+λT Z i ),λni =1Z i (1+λT Z i )−1=0.λ=ρθ,ρ≥0,θ∈R k ,||θ||=1.β=β08(A1)–(A3)||λ||=O p ((kn )12M nλ1n).Z ∗n =max 1≤i ≤n||Z i ||.[5]3,Z ∗n ≤M n max 1≤i ≤n|εi |a.s.=o (M n n 12+r ).ni =1Z i (1+λT Z i )−1=0,0=n i =1λT Z i (1+λT Z i )=λT n i =1Z i −λTn i =1Z i Z T i (1+λT Z i )λ.λTn i =1Z i =λTn i =1Z i Z Ti (1+λT Z i )−1λ,ρθTni =1Z i =ρ2n i =1θT Z i Z T i θ(1+ρθT Z i ).|θT ni =1Z i |≥ λ1n ρ1+ρZ ∗n =⇒ρ≤||ni =1Z i ||( λ1n −Z ∗n||n i =1Z i ||).1131||n i =1Z i ||7,(V −12n n i =1Z i )T(V −12n n i =1Z i )−k√2kd→N (0,1),(ni =1Z i )T V −1n (ni =1Z i )=O p (k ).λ−1kn ||n i =1Z i ||2≤(ni =1Z i )T V −1n (ni =1Z i )λkn ≤nM 2n ,||ni =1Z i ||=O p ((kn )12M n ).Z ∗n ||ni =1Z i ||=o p (k 12n4+r 2(2+r )M 2n ).5(A1)–(A3),λ−11n Z ∗n||n i =1Z i ||=o p (k 32n −(r2(2+r )−δ))=o p (1).ρ=O p ((kn )12M n λ1n ),||λ||=O p ((kn )12M nλ1n).1ni =1Z i (1+λT Z i )−1=0,n i =1Z i =n i =1Z i Z T i (1+λT Z i )λ=W n λ−n i =1(λT Z i )2Z i(1+λT Z i ).R n =ni =1(λT Z i )2Z i (1+λT Z i )−1,λ=W −1nn i =1Z i +W −1n R n .W −1n R nmax 1≤i ≤n|λT Z i |≤||λ||Z ∗n =o p (k 32n −(r2(2+r )−δ))=o p (1),||R n ||≤n i =1 (λT Z i )2Z i (1+λT Z i ) ≤n i =1||λ||2||Z i ||3|(1+λT Z i )|≤||λ||2M 3n (1−||λ||Z ∗n )n i =1|εi |3n[5]3,n i =1|εi |3a.s.=O (n )r ≥1;o (n 3(2+r ))r <1.58,||W −1n R n ||≤ λ−11n ||R n ||≤ λ−11n ||λ||2M 3n(1−||λ||Z ∗n)n i =1|εi |3=O p (k 4n −1+3δ)r ≥1;o p (k 4n −(1+2r2+r−3δ))r <1.(A3)k 32n −(c (r )−δ)=O (1),||W −1n R n ||=o p (1).|log(1+x )−x +x 22|≤|x |3x >−1|log(1+λT Z i )−λT Z i +(λT Z i )22|≤|λT Z i |3132271≤i ≤nmax 1≤i ≤n|λT Z i |=o p (1).Rn =n i =1|λT Z i |3≤||λ||3M 3nn i =1|εi |3=O p (k 92n −(12−3δ))r ≥1;o p (k 92n −(3r2(2+r )−3δ))r <1.Rn =o p (1). T n =2ni =1log(1+λTZ i )=2n i =1λT Z i −λTZ i Z T iλ2+ Rn =n i =1Z i TW −1nn i =1Z i−R T n W −1n R n +o p (1).|R T n W −1n R n |≤λ−11n||R n ||2≤λ−11n||λ||4M 6n n i =1|εi |32=O p (k 7n −(1−5δ))r ≥1;o p (k 7n −(3r2+r −5δ))r <1.k 32n −(c (r )−δ)=O (1)|R T n W −1n R n |=o p (1).T n =(n i =1Z i )T W −1n (n i =1Z i )+o p (1) = T ∗n+o p (1). Tn T ∗nT ∗n = T ∗n −T n +T n = n i =1Z iT(W −1n −V −1n ) ni =1Z i +T n =:R ∗n +T n .7(T n −k )(2k )12d→N (0,1).R ∗nk 12p→0λ∗kV 12n W −1n V 12n −I kR ∗n(2k )12=V −12n n i =1Z iT(V 12n W −1n V 12n−I k ) V −12n n i =1Z i(2k )12,|R ∗n |(2k )12≤λ∗kn i =1Z i T V −1n n i =1Z i (2k )12=λ∗k (T n −k +k )(2k )12≤λ∗k k 212+λ∗k O p (1).λ∗k k 12p→0.1λ∗k ≤k ||V 12W −1n V 12n −I k ||M ,4||V −12n W n V −12n −I k ||Ma.s.=O (kn −(b (r )−δ)log n )a.s.=o (1).n13,||V 12n W −1n V 12n −I k ||M ≤2k ||V −12n W n V −12n−I k ||M a.s.=O (k 2n −(b (r )−δ)log n ).n ,λ∗k k 12≤2k 32||V 12n W −1n V 12n −I k ||M a.s.=O (k 52n−(b (r )−δ)log n )a.s.=o (1).1133R∗n k12=o p(1).7( T∗n−k)(2k)12d→N(0,1),( T n−k)(2k)12d→N(0,1).[1]Owen A.Empirical likelihood ratio confidence intervals for a single functional.Biometrika,1988,75:237–249.[2]Owen A.Empirical likelihood confidence regions.Ann.Statist.,1990,18:90–120.[3]Owen A.Empirical likelihood.Chapman&Hall,New York,2001.[4]Owen A.Empirical likelihood for linear models.Ann.Statist.,1991,19:1725–1747.[5]Ghosh M.A note on bootstrapping the sample median.Ann.Statist.,1984,12:1130–1135.[6]Shi J and Lau T S.Empirical likelihood for partially linear models.J.Multivariate Analysis,2000,72:132–148.[7]de Jong P.A central limit theorem for generalized quadratic forms.Probab.Theory&RelatedFields,75:261–277.EMPIRICAL LIKELIHOOD FOR HIGHER DIMENSIONALLINEAR MODELSShi Jian(Academy of Mathematics and Systems Science,Chinese Academy of Sciences,Beijing100080) Abstract Empirical likelihood for higher dimensional linear model is studied in this paper.When the dimension number of covariates increases with the sample size,conventional empirical likelihood inference becomes invalid.To this end,some mild regularity conditions are imposed and an asymptotic distribution theory is established for modified statistic.Key words Linear models,empirical likelihood,higher dimensional convariates.。