第12章Spark-GraphX

Spark图计算GraphX介绍及实例

Spark图计算GraphX介绍及实例1、GraphX介绍1.1 GraphX应⽤背景Spark GraphX是⼀个分布式图处理框架,它是基于Spark平台提供对图计算和图挖掘简洁易⽤的⽽丰富的接⼝,极⼤的⽅便了对分布式图处理的需求。

众所周知·,社交⽹络中⼈与⼈之间有很多关系链,例如Twitter、Facebook、微博和微信等,这些都是⼤数据产⽣的地⽅都需要图计算,现在的图处理基本都是分布式的图处理,⽽并⾮单机处理。

Spark GraphX由于底层是基于Spark来处理的,所以天然就是⼀个分布式的图处理系统。

图的分布式或者并⾏处理其实是把图拆分成很多的⼦图,然后分别对这些⼦图进⾏计算,计算的时候可以分别迭代进⾏分阶段的计算,即对图进⾏并⾏计算。

下⾯我们看⼀下图计算的简单⽰例:从图中我们可以看出:拿到Wikipedia的⽂档以后,可以变成Link Table形式的视图,然后基于Link Table形式的视图可以分析成Hyperlinks超链接,最后我们可以使⽤PageRank去分析得出Top Communities。

在下⾯路径中的Editor Graph到Community,这个过程可以称之为Triangle Computation,这是计算三⾓形的⼀个算法,基于此会发现⼀个社区。

从上⾯的分析中我们可以发现图计算有很多的做法和算法,同时也发现图和表格可以做互相的转换。

1.2 GraphX的框架设计GraphX时,点分割和GAS都已成熟,在设计和编码中针对它们进⾏了优化,并在功能和性能之间寻找最佳的平衡点。

如同Spark本⾝,每个⼦模块都有⼀个核⼼抽象。

GraphX的核⼼抽象是Resilient Distributed Property Graph,⼀种点和边都带属性的有向多重图。

它扩展了Spark RDD的抽象,有Table和Graph两种视图,⽽只需要⼀份物理存储。

两种视图都有⾃⼰独有的操作符,从⽽获得了灵活操作和执⾏效率。

学Spark需要什么基础?

学Spark需要什么基础?学Spark需要什么基础?作为大数据主流框架之一的Spark,也是大数据开发人员必须要掌握的重要技术框架,在企业招聘当中,掌握Spark框架的大数据人才,也更加具备竞争优势。

那么Spark需要什么基础?今天就来给大家讲讲Spark需要什么基础?首先,学习大数据,不管是Hadoop还是Spark,基本功都少不了Linux和Java。

搭建集群环境,Linux基础是必须的,系统操作命令是基础中的基础。

而Java,主要以JavaSE的知识为重点,包括面向对象、集合、io、多线程以及JDBC操作等,这部分是大数据开发当中常常需要用到的。

其次,是要建立起大数据技术背景,对于大数据处理各个环节,以及对应的解决方案,系统框架要有基本的认识:1、数据采集:Flume、Kafka、Logstash、Filebeat...2、数据存储:Mysql、Redis、Hbase、HDFS...3、数据查询:Hive、Elasticsearch...4、实时数据计算:Storm、Spark-streaming、Flink...5、离线数据计算:Hadoop、Spark...6、其他框架:Zookeeper...有了这样的背景基础之后,开始Spark学习也能够更快地理解很多东西,特点建议在Spark学习之间要先对Hadoop框架有比较全面的认识,包括核心的HDFS、MapReduce、Yarn等,这部分和Spark 联系紧密,对于像Spark为什么计算性能优异,架构设计为什么会这样设计等等这样的问题,也能更快理解和消化。

对于Spark框架的学习,Spark生态圈各组件需要着重掌握,包括Spark-core,Spark-streaming,Spark-mlib,Spark-graphx,刚开始学习的时候主要学习Spark-core和Spark-streaming,Spark-mlib和Spark-graphx可以等后期工作需要或者有时间了在研究即可。

spark基础教程

spark基础教程Spark基础教程介绍了如何使用Spark进行数据处理和分析。

Spark是一个开源的分布式计算框架,旨在通过内存计算以及并行处理来加速大规模数据处理任务。

首先,我们需要安装Spark并配置环境。

Spark支持多种编程语言,包括Scala、Java、Python和R。

可以根据自己的需求选择合适的语言。

一旦环境配置完成,我们可以开始使用Spark的核心概念,如Resilient Distributed Datasets(RDDs)。

RDDs是Spark的灵魂,它代表了分布在集群中的不可变的分区数据集。

我们可以通过RDDs进行数据的转换和操作。

Spark提供了丰富的操作和转换函数,如map、filter、reduce 等,可以对RDDs进行各种运算。

此外,Spark还支持一些高级函数,如join、groupByKey等,用于更复杂的数据处理和分析。

在实际应用中,我们可能需要从外部数据源加载数据,如文本文件、HDFS、数据库等。

Spark提供了用于读取和存储数据的API,可以轻松处理不同格式的数据。

除了RDDs,Spark还引入了DataFrame和Dataset,用于进行结构化数据的处理。

DataFrame是具有命名列的分布式数据集,类似于关系型数据库中的表。

Dataset是DataFrame的扩展,提供了类型安全的API。

Spark还支持常见的机器学习和图计算算法,如分类、回归、聚类、图计算等。

可以使用MLlib进行机器学习任务,使用GraphX进行图计算。

最后,我们需要注意Spark的调优和性能优化。

Spark提供了多种机制来提高作业的性能,如广播变量、累加器、数据分区等。

理解这些机制并进行适当的优化可以显著提升Spark作业的效率。

总结一下,Spark基础教程介绍了Spark的安装和环境配置,RDDs的基本概念和操作,DataFrame和Dataset的使用,以及机器学习和图计算的应用。

云计算与大数据技术知到章节答案智慧树2023年北京联合大学

云计算与大数据技术知到章节测试答案智慧树2023年最新北京联合大学绪论单元测试1.下列哪些应用属于大数据技术的应用()。

参考答案:音视频网站上通过分析注册用户的浏览习惯,为用户推送感兴趣的音视频。

;手机银行或网上银行在用户画像基础上,对用户群进行定位,挖掘潜在金融服务需求。

;政务领域中的智慧城市建设,如智慧交通、智慧医疗、智慧教育等。

;电商网站上对注册用户浏览信息记录、分析、挖掘,为用户推送感兴趣的商品。

2.日常我们用到的云服务器、钉钉办公软件、百度网盘等应用都是云计算服务厂商提供的云计算服务。

()参考答案:对第一章测试1.云计算的服务模式包括()。

参考答案:平台即服务;软件即服务;基础设施即服务2.云计算的劣势有()。

参考答案:风险被集中;数据泄密的环节增多;严重依赖网络3.云计算部署模型有()。

参考答案:公有云;私有云;混合云4.云计算是把有形的产品(网络设备、服务器、存储设备、各种软件等)转化为服务产品(IaaS,PaaS,SaaS),并通过网络让人们远程在线使用。

()参考答案:对5.云计算是一种计算模式,能够提供随时随地、便捷的、随需应变的网络接入,访问可配置的计算资源共享池。

()参考答案:对第二章测试1.虚拟化技术主要用于云计算物理资源的池化,物理资源不包括()。

参考答案:操作系统2.虚拟技术特性有()。

参考答案:隔离;封装;分区;相对于硬件独立3.虚拟化的益处包括()。

参考答案:实现节能减排;实现动态负载均衡;实现资源最优利用;通过系统自愈功能提升可靠性4.个人PC上使用比较多的虚拟化工具有()。

参考答案:Virtual Box;VMware Workstation5.虚拟化是一项技术,而云是一种环境或服务。

()参考答案:对6.虚拟化的主要功能是把单个资源抽象成多个给用户使用,而云计算则是帮助不同部门或公司访问一个自动置备的资源池。

()参考答案:对第三章测试1.开放系统的存储类型分为内置存储和外挂存储,其中外挂存储可分为()。

利用Spark进行实时大数据处理的最佳实践

利用Spark进行实时大数据处理的最佳实践在当今数字化时代,大数据处理已成为企业不可或缺的一环。

为了满足日益增长的数据处理需求,传统的批处理方式已无法满足实时性和性能的要求。

而Apache Spark作为一个快速、通用、容错且易用的大数据处理引擎,成为了处理实时大数据的最佳实践之一。

Spark提供了丰富的API和内置的组件,可以在实时大数据处理过程中实现高效的数据处理和分析。

以下是利用Spark进行实时大数据处理的最佳实践。

1. 选择合适的集群模式:Spark可以在多种集群模式下运行,包括单机模式、本地模式、独立模式和云模式。

根据数据量和需求,选择合适的集群模式可以提高实时大数据处理的效率和性能。

2. 使用Spark Streaming处理流式数据:Spark Streaming是Spark的一部分,支持从各种数据源(如Kafka、Flume和HDFS)实时接收数据并进行处理。

使用Spark Streaming可以实时处理数据流,并支持窗口和滑动窗口操作,以满足不同的实时数据分析需求。

3. 使用Spark SQL进行结构化数据处理:Spark SQL是Spark的SQL查询引擎,可以通过SQL语句处理结构化数据。

通过使用Spark SQL,可以方便地进行实时查询、过滤和转换操作,以满足实时大数据处理的需求。

4. 使用Spark MLlib进行机器学习:Spark MLlib是Spark的机器学习库,提供了各种机器学习算法和工具,可以在实时大数据处理中应用机器学习。

通过使用Spark MLlib,可以进行实时的数据挖掘和模型训练,帮助企业发现隐藏在大数据中的信息和模式。

5. 使用Spark GraphX进行图处理:Spark GraphX是Spark的图处理库,用于处理大规模的图数据。

通过使用Spark GraphX,可以进行实时的图分析和图计算,帮助企业发现图数据中的关联和模式。

6. 使用Spark Streaming和Spark SQL进行流与批处理的无缝集成:Spark提供了将流处理和批处理无缝集成的能力,可以在同一个应用程序中同时处理实时数据流和批处理数据。

spark的面试题

spark的面试题Spark是一种快速、通用的大数据处理引擎,广泛应用于大数据分析和机器学习等领域。

在Spark的面试过程中,面试官通常会考察应聘者对Spark的理解、使用经验以及相关技术的掌握程度。

本文将介绍一些常见的Spark面试题,并给出相应的回答。

1. 请简要介绍一下Spark的核心组件。

Spark的核心组件包括:- Spark Core:提供了Spark的基本功能,包括任务调度、内存管理、容错等。

- Spark SQL:提供了在Spark上进行结构化数据处理和关系型查询的API。

- Spark Streaming:用于实时流数据的处理和分析。

- MLlib:是Spark的机器学习库,提供了许多机器学习算法和工具。

- GraphX:用于图处理和分析的API。

2. 什么是RDD(Resilient Distributed Datasets)?RDD是Spark中的一个核心概念,它代表一个只读的分布式数据集合。

RDD具有以下特点:- 弹性容错:RDD可以在失败的情况下自动恢复。

- 数据分片:RDD将数据划分为多个分片,以便并行处理。

- 惰性计算:RDD进行转换操作时,并不立即执行,而是记录下转换的操作,只有在遇到行动操作时才会真正计算。

- 不可变性:RDD的数据是只读的,当对RDD进行转换时,会生成一个新的RDD,不会修改原有的数据。

3. Spark中的转换操作和行动操作有什么区别?在Spark中,转换操作用于对RDD进行转换,并返回一个新的RDD,但并不触发计算。

常见的转换操作包括map、filter、reduceByKey等。

而行动操作是对RDD进行实际计算并返回结果,触发了Spark的计算过程。

常见的行动操作包括count、collect、save等。

4. 请解释一下Spark的惰性计算。

Spark采用惰性计算的方式来优化计算过程。

当对RDD进行转换操作时,Spark只会记录下转换的操作,而不会立即执行计算。

使用Spark进行实时数据分析的技巧与方法

使用Spark进行实时数据分析的技巧与方法随着大数据时代的到来,实时数据分析变得越来越重要。

作为一个功能强大的开源分析引擎,Spark 提供了一套灵活高效的工具和技巧,使实时数据分析更加便捷和高效。

本文将介绍使用 Spark 进行实时数据分析的技巧与方法。

一、实时数据分析的重要性实时数据分析是指对实时产生的数据进行实时处理和分析,以便及时做出决策或采取行动。

在当今信息化的社会中,实时数据分析能够帮助企业从数据中获取即时的信息和见解,有助于及时发现问题、优化业务和提高效率。

因此,掌握实时数据分析的技巧与方法对于企业来说至关重要。

二、使用 Spark 进行实时数据分析的技巧与方法1. 数据收集与准备在进行实时数据分析之前,首先需要收集和准备好需要分析的数据。

Spark 支持多种数据源,包括文件、数据库、数据流等。

可以根据实际情况选择合适的数据源,并使用 Spark 提供的 API 进行数据的读取和处理。

此外,还可以使用 Spark Streaming 作为实时数据流的源头,实现实时数据的收集和处理。

2. 实时数据流处理Spark Streaming 是 Spark 提供的一个用于处理实时数据流的模块,它能够将实时数据流切分成一系列小批次数据,并实时处理这些小批次数据。

使用 Spark Streaming 可以方便地进行实时数据的处理和转换。

可以使用 Spark Streaming 支持的各种操作,如 map、flatMap、filter、reduceByKey 等,对实时数据流进行处理和转换。

3. 实时数据分析在对实时数据进行处理和转换之后,接下来就是进行实时数据分析。

Spark 提供了一套强大的分析工具和 API,如Spark SQL、Spark MLlib 等,可以用于实时数据的查询、统计、挖掘和机器学习等任务。

可以根据实际需求选择合适的分析工具和 API,进行实时数据分析,并从中获取有价值的信息和见解。

Spark大数据商业实战三部曲:内核解密、商业案例、性能调优

第10章 Spark中Broadcast和Accumulator原理和源码详解

10.1 Spark中Broadcast原理和源码详解 10.2 Spark中Accumulator原理和源码详解

第11章 Spark与大数据其他经典组件整合原理与实战

11.1 Spark组件综合应用 11.2 Spark与Alluxio整合原理与实战 11.3 Spark与Job Server整合原理与实战 11.4 Spark与Redis整合原理与实战

统案例

第17章 Spark在通 信运营商生产环境中 的应用案例

第18章使用Spark GraphX实现婚恋社 交网络多维度分析案 例

第12章 Spark商业案例之大数据电影点评系统应用案例

12.1通过RDD实现分析电影的用户行为信息 12.2通过RDD实现电影流行度分析 12.3通过RDD分析各种类型的最喜爱电影TopN及性能优化技巧 12.4通过RDD分析电影点评系统仿QQ和**等用户群分析及广播背后机制解密 12.5通过RDD分析电影点评系统实现Java和Scala版本的二次排序系统 12.6通过Spark SQL中的SQL语句实现电影点评系统用户行为分析 12.7通过Spark SQL下的两种不同方式实现口碑最佳电影分析 12.8通过Spark SQL下的两种不同方式实现最流行电影分析 12.9通过DataFrame分析最受男性和女性喜爱电影TopN

5.1 Master启动原理和源码详解 5.2 Worker启动原理和源码详解 5.3 ExecutorBackend启动原理和源码详解 5.4 Executor中任务的执行 5.5 Executor执行结果的处理方式 5.6本章总结

第6章 Spark Application提交给集群的原理和源码详解

原创:Spark中GraphX图运算pregel详解

原创:Spark中GraphX图运算pregel详解由于本⼈⽂字表达能⼒不⾜,还是多多以代码形式表述,⾸先展⽰测试代码,然后解释:package com.txq.spark.testimport org.apache.spark.graphx.util.GraphGeneratorsimport org.apache.spark.graphx._import org.apache.spark.rdd.RDDimport org.apache.spark.{SparkConf, SparkContext, SparkException, graphx}import scala.reflect.ClassTag/*** spark GraphX 测试* @authorTongXueQiang*/object test {System.setProperty("hadoop.home.dir","D://hadoop-2.6.2");val conf = new SparkConf().setMaster("local").setAppName("testRDDMethod");val sc = new SparkContext(conf);def main(args: Array[String]): Unit = {/*val rdd = sc.textFile("hdfs://spark:9000/user/spark/data/SogouQ.sample");//搜狗搜索⽇志解析val rdd1 = rdd.map(_.split("\t")).map(line=>line(3)).map(_.split(" "));println("共有"+rdd1.count+"⾏");val rdd2 = rdd1.filter(_(0).toInt == 1).filter(_(1).toInt == 1);println("搜索结果和点击率均排第⼀的共有"+rdd2.count+"⾏");val users:RDD[(VertexId,(String,String))] = sc.parallelize(Array((3L,("rxin","student")),(7L,("jgonzal","postdoc")),(5L,("franklin","prof")),(2L,("istoica","prof"))));val relationships:RDD[Edge[String]] = sc.parallelize(Array(Edge(3L,7L,"collab"),Edge(5L,3L,"advisor"),Edge(2L,5L,"colleague"),Edge(5L,7L,"pi")));val defaultUser = ("jone","Missing");val graph = Graph(users,relationships,defaultUser);val result = graph.vertices.filter{case(id,(name,pos)) => pos == "prof"}.count();println("职位名称为prof的个数有:" + result + "个");println(graph.edges.filter(e => e.srcId > e.dstId).count());graph.triplets.collect().foreach(println)graph.edges.collect().foreach(println)*//*val graph:Graph[Double,Int] = GraphGenerators.logNormalGraph(sc,numVertices = 100).mapVertices((id,_) => id.toDouble)println(graph);println(graph.vertices)*//*val oderFollowers:VertexRDD[(Int,Double)] = graph.mapReduceTriplets[(Int,Double)](triplet =>{if(triplet.srcAttr > triplet.dstAttr){Iterator((triplet.dstId,(1,triplet.srcAttr)));} else {Iterator.empty}},(a,b) =>(a._1 + b._1,a._2 + b._2))val avgAgeOfolderFollower:VertexRDD[Double] = oderFollowers.mapValues((id,value) => {value match{case (count,totalAge) => totalAge / count}})avgAgeOfolderFollower.collect().foreach(println)*/ //收集邻居节点,后⾯有⾃定义⽅法//collectNeighborIds(EdgeDirection.In,graph).foreach(line => {print(line._1+":"); for (elem <- line._2) {print(elem + " ")};println;}); //以Google的⽹页链接⽂件(后⾯由下载地址)为例,演⽰pregel⽅法,找出从v0⽹站出发,得到经过的步数最少的链接⽹站,类似于附近地图最短路径算法val graph:Graph[Double,Double] = GraphLoader.edgeListFile(sc,"hdfs://spark/user/spark/data/web-Google.txt",numEdgePartitions = 4).mapVertices((id,_) => id.toDouble).mapEdges(edge => edge.attr.toDouble); val sourceId:VertexId = 0;//定义源⽹页Idval g:Graph[Double,Double] = graph.mapVertices((id,attr) => if(id == 0) 0.0 else Double.PositiveInfinity)//pregel底层调⽤GraphOps的mapReduceTriplets⽅法,⼀会⼉解释源代码val result = pregel[Double,Double,Double](g,Double.PositiveInfinity)((id,vd,newVd) => math.min(vd,newVd),//这个⽅法的作⽤是更新节点VertexId的属性值为新值,以利于innerJoin操作triplets => {//map函数if(triplets.srcAttr + triplets.attr < triplets.dstAttr){Iterator((triplets.dstId,triplets.srcAttr + triplets.attr))} else {Iterator.empty}},(a,b) => math.min(a,b)//reduce函数) //输出结果,注意pregel返回的是更新VertexId属性的graph,⽽不是VertexRDD[(VertexId,VD)]print("最短节点:"+result.vertices.filter(_._1 != 0).reduce(min));//注意过滤掉源节点} //找出路径最短的点def min(a:(VertexId,Double),b:(VertexId,Double)):(VertexId,Double) = {if(a._2 < b._2) a else b}/*** ⾃定义收集VertexId的neighborIds* @author TongXueQiang*/def collectNeighborIds[T,U](edgeDirection:EdgeDirection,graph:Graph[T,U])(implicit m:scala.reflect.ClassTag[T],n:scala.reflect.ClassTag[U]):VertexRDD[Array[VertexId]] = {val nbrs = graph.mapReduceTriplets[Array[VertexId]](//map函数edgeTriplets => {val msgTosrc = (edgeTriplets.srcId,Array(edgeTriplets.dstId));val msgTodst = (edgeTriplets.dstId,Array(edgeTriplets.srcId));edgeDirection match {case EdgeDirection.Either =>Iterator(msgTosrc,msgTodst)case EdgeDirection.Out => Iterator(msgTosrc)case EdgeDirection.In => Iterator(msgTodst)case EdgeDirection.Both => throw new SparkException("It doesn't make sense to collect neighbors without a " + "direction.(EdgeDirection.Both is not e EdgeDirection.Either instead.)")}},_ ++ _)//reduce函数nbrs}/*** ⾃定义pregel函数* @param graph 图* @param initialMsg 返回的vertexId属性* @param maxInterations 迭代次数* @param activeDirection 边的⽅向* @param vprog 更新节点属性的函数,以利于innerJoin操作* @param sendMsg map函数,返回Iterator[A],⼀般A为Tuple2,其中id为接受消息⽅* @param mergeMsg reduce函数,⼀般为合并,或者取最⼩、最⼤值……操作* @tparam A 想要得到的VertexId属性* @tparam VD graph中vertices的属性* @tparam ED graph中的edge属性* @return 返回更新后的graph*/def pregel[A:ClassTag,VD:ClassTag,ED:ClassTag](graph:Graph[VD,ED],initialMsg:A,maxInterations:Int = Int.MaxValue,activeDirection:EdgeDirection = EdgeDirection.Either)( vprog:(VertexId,VD,A) => VD,sendMsg:EdgeTriplet[VD,ED] =>Iterator[(VertexId,A)],mergeMsg:(A,A) => A): Graph[VD,ED] = {Pregel0(graph,initialMsg,maxInterations,activeDirection)(vprog,sendMsg,mergeMsg)//调⽤apply⽅法} //此为节点内连接函数,返回VertexRDDdef innerJoin[U:ClassTag,VD:ClassTag](table:RDD[(VertexId,U)])(mapFunc:(VertexId,VD,U) => VertexRDD[(VertexId,VD)]) = {val uf = (id: VertexId, data: VD, o: Option[U]) => {o match {case Some(u) => mapFunc(id, data, u)case None => data}}} //测试Option[T] def test():Unit = {val map = Map("a" -> "1","b" -> "2","c" -> "3");def show(value:Option[String]):String = {value match{case Some(x) => xcase None => "no value found!"}}println(show(map.get("a")) == "1");}}下⾯重点研究Pregel,为了⽅便,⾃⼰重新定义了⼀个Pregel0package com.txq.spark.testimport org.apache.spark.Loggingimport org.apache.spark.graphx.{EdgeDirection, EdgeTriplet, Graph, VertexId}import scala.reflect.ClassTag/*** ⾃定义Pregel object,处理思路:*/object Pregel0 extends Logging {def apply[VD:ClassTag,ED:ClassTag,A:ClassTag](graph:Graph[VD,ED],initialMsg:A,maxIterations:Int = Int.MaxValue,activeDirection:EdgeDirection = EdgeDirection.Either)(vprog:(VertexId,VD,A) => VD,sendMsg:EdgeTriplet[VD,ED] => Iterator[(VertexId,A)],mergeMsg:(A,A) => A): Graph[VD,ED] ={ //①对vertices进⾏更新操作var g = graph.mapVertices((vid,vdata) => vprog(vid,vdata,initialMsg)).cache();//②compute the messages,注意调⽤的是mapReduceTriplets⽅法,源代码:def mapReduceTriplets[A](map: EdgeTriplet[VD, ED] => Iterator[(VertexId, A)],reduce: (A, A) => A),activeSetOpt: Option[(VertexRDD[_], EdgeDirection)] = None ): VertexRDD[A]var messages = g.mapReduceTriplets(sendMsg,mergeMsg);print("messages:"+messages.take(10).mkString("\n"))var activeMessages = messages.count();//LOADvar prevG:Graph[VD,ED] = nullvar i = 0;while(activeMessages > 0 && i < maxIterations){//③Receive the messages.Vertices that didn't get any message do not appear in newVerts.//内联操作,返回的结果是VertexRDD,可以参看后⾯的调试信息val newVerts = g.vertices.innerJoin(messages)(vprog).cache();print("newVerts:"+newVerts.take(10).mkString("\n"))//④update the graph with the new vertices.prevG = g;//先把旧的graph备份,以利于后⾯的graph更新和unpersist掉旧的graph //④外联操作,返回整个更新的graphg = g.outerJoinVertices(newVerts){(vid,old,newOpt) => newOpt.getOrElse(old)}//getOrElse⽅法,意味,如果newOpt存在,返回newOpt,不存在返回oldprint(g.vertices.take(10).mkString("\n"))g.cache();//新的graph cache起来,下⼀次迭代使⽤val oldMessages = messages;//备份,同prevG = g操作⼀样//Send new messages.Vertices that didn't get any message do not appear in newVerts.so//don't send messages.We must cache messages.so it can be materialized on the next line.//allowing us to uncache the previous iteration. //⑤下⼀次迭代要发送的新的messages,先cache起来messages = g.mapReduceTriplets(sendMsg,mergeMsg,Some((newVerts,activeDirection))).cache()print("下⼀次迭代要发送的messages:"+messages.take(10).mkString("\n"))activeMessages = messages.count();//⑥print("下⼀次迭代要发送的messages的个数:"+ activeMessages)//如果activeMessages==0,迭代结束logInfo("Pregel finished iteration" + i); //原来,旧的message和graph不可⽤了,unpersist掉oldMessages.unpersist(blocking= false);newVerts.unpersist(blocking=false)//unpersist之后,就不可⽤了prevG.unpersistVertices(blocking=false)prevG.edges.unpersist(blocking=false)i += 1;}g//返回最后的graph}}输出的调试信息:(距离v0节点最近的节点)第⼀次跌代:messages:(11342,1.0)(824020,1.0)(867923,1.0)(891835,1.0)newVerts:(11342,1.0)(824020,1.0)(867923,1.0)(891835,1.0)下⼀次迭代要发送的messages:(302284,2.0)(760842,2.0)(417728,2.0)(322178,2.0)(387543,2.0)(846213,2.0)(857527,2.0)(856657,2.0)(695578,2.0)(27469,2.0)下⼀次迭代要发送的messages的个数:29下⼀次迭代要发送的messages:(754862,3.0)(672426,3.0)(320258,3.0)(143557,3.0)(789355,3.0)(596104,3.0)(118398,3.0)(30115,3.0)下⼀次迭代要发送的messages的个数:141依次不断类推,直到activeMessages = 0跌代结束。

Spark的应用与实现

Spark的应用与实现Spark的应用与实现Spark是一个开源的通用的大数据处理框架,如果用三个词来形容它,那么就是快、强大和灵活。

Spark支持多种语言,包括Java、Scala、Python等。

作为Hadoop生态系统中的一部分,Spark可以与Hadoop、Hive、HBase等其他技术进行整合,实现更加多样化的数据处理解决方案。

Spark的应用Spark在大数据处理中有非常广泛的应用,可以适用于数据分析、机器学习、图形计算等多个领域。

本节中将简单介绍一下Spark在这些领域的主要应用。

1.数据分析Spark可以运行在一个分布式的集群环境中,通过RDD(弹性分布式数据集)来支持数据处理。

用户可以通过Spark SQL进行数据分析,使用Spark底层的计算引擎可以极大地提高处理大数据时的性能和效率。

在数据仓库的构建方面,Spark也有很强的优势,它可以连接各种存储系统,如Hadoop HDFS、Hive、Cassandra等。

2.机器学习Spark支持运行在机器学习算法之上的库,如MLlib(机器学习库)等。

在Spark中,MLlib支持多种机器学习模型,如分类、回归、聚类和协同过滤等。

它还支持从多种数据源(如HDFS、Hive、Cassandra 等)中读取数据,从而便于机器学习的建模和优化。

3.图形计算Spark也可以支持图计算框架GraphX。

通过GraphX,用户可以使用Spark来分析网络数据和图像数据。

图计算特别适合于分布式图分析、推荐算法和社交媒体分析等场景。

Spark可以对图进行并行处理,并发聚合,支持节点、边上的属性计算。

Spark的实现Spark的实现基本上可以分为四个主要模块:Spark Core、Spark SQL、MLlib和GraphX。

下面将对这几个模块进行简要介绍。

1. Spark CoreSpark Core是Spark的核心,提供了分布式任务调度、内存计算等基本的功能。

Spark技术的应用和案例

Spark技术的应用和案例Spark技术是目前最流行的大数据处理技术之一,它能够处理海量的数据,并能在分布式环境下进行多节点计算。

在业界,Spark技术被广泛应用于数据分析、机器学习、推荐算法、图计算、实时处理等领域。

本文将介绍Spark技术的应用和案例。

一、数据分析Spark技术在数据分析方面的应用非常广泛,从传统的数据仓库、ETL、数据挖掘到现在的深度学习、自然语言处理等都有涉及。

Spark SQL是Spark生态系统中的一个可伸缩的SQL查询引擎,它能够将结构化数据集与RDD无缝集成。

Spark SQL能够实现SQL查询、数据汇总、子查询、表连接等操作,并支持复杂的数据类型和JSON数据处理。

Spark SQL支持将数据存储在Hive、Hbase等数据存储中心,同时还支持许多数据库连接器的使用。

二、机器学习Spark技术在机器学习方面的应用也非常广泛。

MLib是Spark生态系统中的机器学习库,它提供了常见的机器学习算法,如分类、回归、聚类、推荐系统等,并且能够在Spark的分布式环境下执行。

同时,MLib还支持模型调优、特征转换、模型持久化、模型运行等功能。

根据欧洲中央银行(ECB)的最新报告,Spark MLlib是市场上最快的大规模机器学习库之一,并且在不能卡住的情况下能处理超过50亿个样本。

三、推荐系统Spark技术在推荐系统方面的应用也非常广泛。

Spark中的推荐系统库MLib中提供了常见的协同过滤算法,如基于用户的协同过滤、基于物品的协同过滤等。

并且,Spark能够并行计算用户和物品之间的相似性,从而获得更好的推荐效果。

在Netflix、Amazon 等云计算巨头的推荐系统中,Spark也被广泛应用。

四、图计算Spark GraphX是Spark生态系统中的图计算库,它支持大规模的图计算和图分析。

Spark GraphX能够处理大规模的图形结构,并提供高效的迭代图计算算法,例如PageRank、SSSP、Triangle Counting等。

spark常见面试题

spark常见面试题Spark是一种快速、分布式计算引擎,被广泛应用于大数据处理和分析中。

在Spark的生态系统中,有许多常见的面试题目,用于评估候选人对Spark的理解和应用能力。

本文将介绍一些常见的Spark面试题,并提供相应的回答。

1. 什么是Spark?它与Hadoop有什么区别?Spark是一种快速、通用、分布式计算系统,可以处理大规模数据和执行复杂的数据处理任务。

与Hadoop相比,Spark的优势在于其内存计算模型,可大大提高计算速度。

此外,Spark提供了丰富的API,支持多种编程语言,并提供了图计算、流式处理和机器学习等扩展库。

2. Spark的核心组件是什么?Spark的核心组件包括Spark Core、Spark SQL、Spark Streaming、Spark MLlib和Spark GraphX。

Spark Core是Spark的基础,提供了任务调度、内存管理和存储系统等功能。

Spark SQL用于处理结构化数据,并提供了SQL查询的功能。

Spark Streaming支持实时数据处理。

Spark MLlib提供了机器学习算法的库。

Spark GraphX用于图计算任务。

3. 什么是RDD?如何创建一个RDD?RDD(弹性分布式数据集)是Spark中的基本数据抽象,是一个可并行操作的不可变分布式集合。

可以通过两种方式创建RDD:并行化已有集合(如列表或数组)或从外部存储系统(如HDFS、HBase)中读取数据。

4. RDD和DataFrame的区别是什么?RDD和DataFrame都是Spark中的数据抽象。

RDD是Spark最早引入的数据结构,它是一个不可变的分布式集合,需要手动指定数据的schema。

而DataFrame是结构化数据的概念,具有自动推断schema 的功能,并且可以基于SQL进行查询和操作。

5. Spark的作业调度器是什么?它的作用是什么?Spark的作业调度器是Spark Cluster Manager,其中包括Standalone、YARN和Mesos等。

spark复习题

spark复习题Spark复习题Apache Spark是一种快速、通用的大数据处理引擎,它提供了高效的数据处理和分析能力,被广泛用于各种大规模数据处理场景。

在使用Spark进行数据处理之前,对于Spark的基本概念和原理的理解是非常重要的。

下面将通过一些复习题来帮助大家回顾和巩固对Spark的知识。

一、Spark基础知识1. 什么是Spark?它与Hadoop的关系是什么?Spark是一种快速、通用的大数据处理引擎,它可以在大规模集群上进行高效的数据处理和分析。

与Hadoop相比,Spark不仅可以利用Hadoop的分布式文件系统HDFS进行数据存储,还可以利用Hadoop的资源管理器YARN进行资源调度。

此外,Spark还提供了比Hadoop更高层次的抽象和更丰富的API,使得用户可以更方便地进行数据处理和分析。

2. Spark的核心组件是什么?请简要介绍一下每个组件的作用。

Spark的核心组件包括Spark Core、Spark SQL、Spark Streaming、Spark MLlib 和Spark GraphX。

- Spark Core是Spark的基础组件,它提供了Spark的基本功能和API,包括分布式任务调度、内存计算和数据存储等。

- Spark SQL是Spark提供的用于处理结构化数据的组件,它支持使用SQL语句进行数据查询和分析,并提供了DataFrame和DataSet等高层次的数据抽象。

- Spark Streaming是Spark提供的用于实时数据处理的组件,它可以实时接收和处理流式数据,并提供了类似于批处理的API来进行数据处理和分析。

- Spark MLlib是Spark提供的机器学习库,它包含了常见的机器学习算法和工具,可以方便地进行机器学习模型的训练和预测。

- Spark GraphX是Spark提供的图计算库,它支持图数据的处理和分析,包括图的构建、遍历和计算等。

南开大学20秋学期《大数据开发技术(二)》在线作业(参考答案)

1.()是AMPLab发布的一个R开发包,使得R摆脱单机运行的命运,可以作为Spark的Job运行在集群上。

A.SparkRB.BlinkDBC.GraphXD.Mllib答案:A2.图的结构通常表示为:G(V,E),其中,V是图G中()。

A.顶点B.顶点的集合C.边D.边的集合答案:B3.Dstream输出操作中()方法将DStream中的内容按对象序列化并且以SequenceFile的格式保存。

A.printB.saveAsTextFilesC.saveAsObjectFilesD.saveAsHadoopFiles答案:D4.()是Spark的核心,提供底层框架及核心支持。

A.Spark CoreB.Spark SQLC.Spark StreamingD.Mllib答案:A5.Spark中的每个RDD一般情况下是由()个分区组成的。

A.0B.1C.多D.无数答案:C6.RDD的()操作通常用来划分单词。

A.filterB.unionC.flatmapD.mapPartitions答案:C7.图结构中如果任意两个顶点之间都存在边,那么称之为()。

A.完全图B.有向完全图C.无向图D.简单图答案:A8.Spark GraphX中类Graph的aggregateMessages方法可以()。

A.收集邻居顶点的顶点Id和顶点属性B.收集邻居顶点的顶点IdC.向指定顶点发送信息并聚合信息D.将顶点信息更新到图中答案:C9.Spark中DataFrame的()方法是进行连接查询。

A.whereB.joinC.limitD.apply答案:B10.以下哪个不是Scala的数据类型?()A.AnyRefB.AnythingC.NULLD.Nothing答案:B11.GraphX中()方法可以释放边缓存。

A.cacheB.presistC.unpersistVerticesD.edges.unpersist答案:D12.()是Spark的数据挖掘算法库。

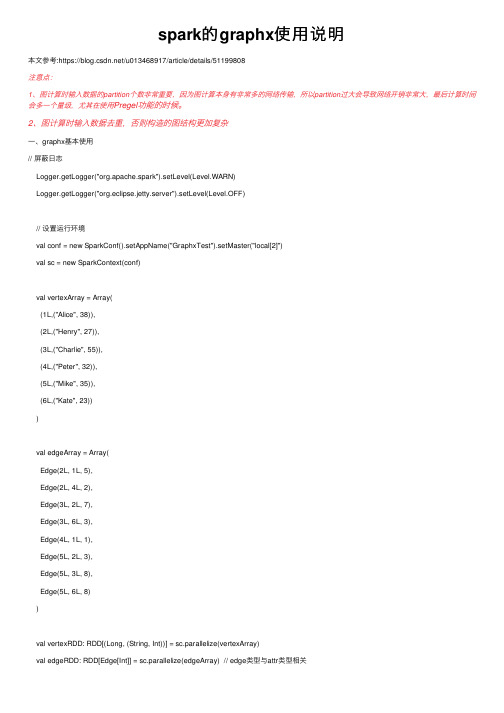

spark的graphx使用说明

spark的graphx使⽤说明本⽂参考:https:///u013468917/article/details/51199808注意点:1、图计算时输⼊数据的partition个数⾮常重要,因为图计算本⾝有⾮常多的⽹络传输,所以partition过⼤会导致⽹络开销⾮常⼤,最后计算时间会多⼀个量级,尤其在使⽤Pregel功能的时候。

2、图计算时输⼊数据去重,否则构造的图结构更加复杂⼀、graphx基本使⽤// 屏蔽⽇志Logger.getLogger("org.apache.spark").setLevel(Level.WARN)Logger.getLogger("org.eclipse.jetty.server").setLevel(Level.OFF)// 设置运⾏环境val conf = new SparkConf().setAppName("GraphxTest").setMaster("local[2]")val sc = new SparkContext(conf)val vertexArray = Array((1L,("Alice", 38)),(2L,("Henry", 27)),(3L,("Charlie", 55)),(4L,("Peter", 32)),(5L,("Mike", 35)),(6L,("Kate", 23)))val edgeArray = Array(Edge(2L, 1L, 5),Edge(2L, 4L, 2),Edge(3L, 2L, 7),Edge(3L, 6L, 3),Edge(4L, 1L, 1),Edge(5L, 2L, 3),Edge(5L, 3L, 8),Edge(5L, 6L, 8))val vertexRDD: RDD[(Long, (String, Int))] = sc.parallelize(vertexArray)val edgeRDD: RDD[Edge[Int]] = sc.parallelize(edgeArray) // edge类型与attr类型相关// 构造图Graph[VD,ED]val graph: Graph[(String, Int), Int] = Graph(vertexRDD, edgeRDD)// (1) Graph.vertices:图中的所有顶点;// (2) Graph.edges:图中所有的边;// (3) Graph.triplets:由三部分组成,源顶点,⽬的顶点,以及两个顶点之间的边;// (4) Graph.degrees:图中所有顶点的度;// (5) Graph.inDegrees:图中所有顶点的⼊度;// (6) Graph.outDegrees:图中所有顶点的出度;println("---找出图中年龄⼤于20的顶点⽅法---\n")graph.vertices.filter{case(id, (name, age)) => age > 20}.collect.foreach{case(id, (name, age)) => println(s"$name is $age")}println("---找出图中属性⼤于3的边---\n")graph.edges.filter(e => e.attr > 3).collect.foreach(e => println(s"${e.srcId} to ${e.dstId} att ${e.attr}"))println("---列出边属性>3的Triples---\n")for(triplet <- graph.triplets.filter(t => t.attr > 3).collect){println(s"${triplet.srcAttr._1} likes ${triplet.dstAttr._1}")}println("---找出图中最⼤的出度,⼊度,度数---\n")def max(a:(VertexId, Int), b: (VertexId, Int)): (VertexId, Int) = {if(a._2 > b._2) a else b}println("Max of OutDegrees:" + graph.outDegrees.reduce(max))println("Max of InDegrees:" + graph.inDegrees.reduce(max))println("Max of Degrees:" + graph.degrees.reduce(max)) // ⼊度 + 出度println("---顶点的转换操作,顶点 age + 10 ---")graph.mapVertices{case(id, (name, age)) => (id, (name, age + 10))}.vertices.collect.foreach(v => println(s"${v._2._1} is ${v._2._2}"))println("---边的转换操作,边的属性*2 ---")graph.mapEdges(e => e.attr * 2).edges.collect.foreach(e => println(s"${e.srcId} to ${e.dstId} att ${e.attr}"))println("---顶点年纪>30 的⼦图---")val subGraph = graph.subgraph(vpred = (id, vd) => vd._2 > 30)println("---⼦图所有顶点---")subGraph.vertices.collect.foreach(v => println(s"${v._2._1} is ${v._2._2}"))println("---⼦图所有边---")subGraph.edges.collect.foreach(e => println(s"${e.srcId} to ${e.dstId} att ${e.attr}"))println("---找出年纪最⼤的follower---")val youngestFollower: VertexRDD[(String, Int)] = graph.aggregateMessages[(String, Int)](triplet => { // map操作triplet.sendToDst(triplet.srcAttr._1, triplet.srcAttr._2)},(a, b) => if(a._2 > b._2) b else a // reduce操作)graph.vertices.leftJoin(youngestFollower) {(id, user, optOldestFollower) =>optOldestFollower match{case None => s"${user._1} does not have any followers"case Some((name, age)) => s"${name} is the youngest follower of ${user._1}"}}.collect.foreach{case(id, str) => println(str)}val graph2 = GraphLoader.edgeListFile(sc, "D:\\tmp\\web-Google.txt")val sourceId: VertexId = 0val initialGraph = graph2.mapVertices((id, _) => if(id == sourceId) 0.0 else Double.PositiveInfinity)sc.stop()⼆、pregel使⽤1、pregel概述Pregel是google提出的⽤于⼤规模分布式图计算框架。

SparkGraphX

Spark GraphX记录Spark GraphX(version 2.1.1)的学习历程。

Graph1. 图的基本概念图是由顶点集合以及顶点间的关系集合组成的一种数据结构。

Graph = (V,E)V是顶点的有穷非空集合;E是顶点之间关系的有穷集合,也叫边(弧)集合。

1). 无向图和有向图对于一个图,若每条边都是没有方向的,则称该图为无向图。

图示如下:因此,(Vi,Vj)和(Vj,Vi)表示的是同一条边。

无向图的顶点集和边集分别表示为:V(G)={V1,V2,V3,V4,V5}E(G)={(V1,V2),(V1,V4),(V2,V3),(V2,V5),(V3,V4),(V3,V5),(V4,V5)} 对于一个图G,若每条边都是有方向的,则称该图为有向图。

图示如下。

因此,<Vi,Vj>和<Vj,Vi>是两条不同的有向边。

有向边又称为弧。

注意,无向图是用小括号,有向图是用尖括号。

有向图的顶点集和边集分别表示为:V(G)={V1,V2,V3}E(G)={<V1,V2>,<V2,V3>,<V3,V1>,<V1,V3>}图上的边和弧上带权则称为网。

图按照边或弧的多少分稀疏图和稠密图。

如果任意两个顶点之间都存在边/弧叫完全图,有向的叫无/有向图完全图。

若无重复的边或顶点到自身的边则叫简单图。

2). 路径、路径长度和回路在无向图G中,存在一个顶点序列V p,V i1,V i2,V i3…,V im,V q,使得(V p,V i1),(V i1,V i2),…,(V im,V q)均属于边集E(G),则称顶点V p到V q存在一条路径。

图中顶点与顶点之间的路径不是唯一的。

路径的长度是路径上的边或弧的数目。

两个顶点间存在路径,则两个顶点是连通的。

当一个顶点通过路径最终回到该顶点,则称该路径为环,若环中没有重复的顶点,则称为简单路径。

若图中任意两个顶点都是连通的,则无向图称为连通图,有向图称为强连通图。

Spark大数据技术介绍

Spark大数据技术介绍大数据时代的到来给企业带来了前所未有的机遇和挑战。

数据量的急剧增加以及数据处理速度的要求,推动了大数据技术的发展。

在众多的大数据技术中,Spark作为一种快速、可扩展、通用的大数据处理框架,受到了广泛的关注和应用。

本文将介绍Spark大数据技术的特点、架构以及应用场景。

Spark是由加州大学伯克利分校AMPLab实验室开发的一种开源的大数据处理框架。

与传统的MapReduce相比,Spark具有更高的性能和更广泛的应用场景。

Spark支持在大规模集群上进行高效的数据处理,其基本理念是将数据存储在内存中,通过内存计算来加速数据处理过程,从而极大地提高了数据处理的速度。

Spark的核心模块是Spark Core,它提供了分布式任务调度、内存数据存储、容错机制和并行计算等基本功能。

Spark的另一个重要特点是其可扩展性。

Spark可以在数千台服务器上运行,而且可以方便地与其他大数据处理工具(如Hadoop和Hive)进行集成。

同时,Spark还提供了丰富的API,支持多种编程语言,包括Scala、Java、Python和R等。

Spark提供了丰富的高级库,用于解决各种大数据处理问题。

其中最著名的是Spark SQL、Spark Streaming、MLlib和GraphX。

Spark SQL是Spark提供的用于处理结构化数据的模块。

它支持将结构化数据导入Spark中,并以类似于SQL的方式进行查询和分析。

Spark SQL可以与其他的数据源进行集成,例如Hive、HBase、JSON和Parquet等。

通过Spark SQL,用户可以直接使用SQL语句来处理和分析大规模的结构化数据。

Spark Streaming是用于处理实时数据流的模块。

它能够将实时数据流分成一系列小批次进行处理,并将结果输出到外部系统中。

Spark Streaming可以集成多种数据源,例如Kafka、Flume和Twitter等。

《Spark应用实践》

《Spark应用实践》Spark应用实践随着大数据时代的到来,数据处理已成为企业信息化中不可避免的部分。

与此同时,大量的数据处理需求也导致了数据处理技术的快速发展,Spark 作为一种分布式计算框架,已经成为了大数据计算框架中不可或缺的一部分。

Spark简介Spark是一种开源的、分布式计算框架,由于其快速、通用、易用、灵活的特点,被广泛应用于数据处理方面。

Spark最初由加州大学伯克利分校AMP实验室开发,已经成为了一种受欢迎的数据处理框架。

Spark主要包括四个组件:Spark Core、Spark SQL、Spark Streaming和Mllib,其中Spark Core是Spark的核心组件,提供了任务调度、内存管理、容错性等机制,Spark SQL则支持带有SQL语句的数据处理,Spark Streaming支持流式数据处理,Mllib则是对机器学习库的支持。

Spark应用实践Spark虽然是一个优秀的分布式计算框架,但是如何在实际应用中使用它进行数据处理呢?下面,我们将从数据预处理、机器学习和图处理三个方面介绍Spark的应用实践。

数据预处理在大多数情况下,数据通常需要进行预处理,以使其适应数据模型,或者在某些情况下对数据进行清洗。

在Spark中,支持在内存中对数据进行操作,因此Spark可以极大地加速数据处理的过程。

Spark提供了丰富的API,可以对数据进行过滤、转换、汇总等操作。

在处理大规模数据的情况下,Spark通过分布式计算能够实现快速的数据处理和高可靠性的计算结果。

机器学习在机器学习领域,Spark的Mllib库提供了成熟的机器学习算法,包括分类、聚类、回归等。

Mllib库中的算法支持分布式计算,可以处理海量的数据,并可用于批处理和流式处理等场景。

一般而言,机器学习过程中需要进行数据预处理、特征选择和模型训练。

在Spark中,数据预处理和特征选择可以通过Spark SQL和Spark DataFrames等工具完成,模型训练可以使用Mllib库中提供的算法进行实现。

spark面试题及答案

spark面试题及答案Spark是一个快速通用的大数据处理框架,被广泛应用于大规模数据处理和分析。

在面试中,对Spark的理解和掌握程度是评估候选人技能水平的重要指标之一。

本文将给出一些常见的Spark面试题及其答案,以帮助读者更好地准备Spark相关的面试。

一、基础概念1. 什么是Spark?答:Spark是一个开源的分布式计算系统,可以快速进行大规模数据处理和分析。

它提供了丰富的API和功能,支持多种编程语言(如Java、Scala和Python)的开发,并具备高速、易用和弹性扩展的特点。

2. Spark和Hadoop的区别是什么?答:Spark和Hadoop都是用于大数据处理的框架,但两者在一些方面有所不同。

首先,在处理批处理任务时,Hadoop使用磁盘存储和复杂的MapReduce模型,而Spark基于内存计算和更高级的数据流模型,因此更快速。

其次,Spark提供了更为全面的功能和API,如Spark SQL、Spark Streaming和MLlib等,而Hadoop主要专注于批处理任务。

此外,Spark还支持交互式分析、机器学习和图形处理等应用。

3. Spark核心组件有哪些?答:Spark核心组件包括:- Spark Core:Spark的基础组件,提供了分布式任务调度、内存管理和容错机制等功能。

- Spark SQL:用于结构化数据处理和分析的模块,支持SQL查询和DataFrame API。

- Spark Streaming:用于实时流处理的模块,支持高吞吐量的实时计算。

- MLlib:Spark的机器学习库,提供了一系列常见的机器学习算法和工具。

- GraphX:用于图计算的模块,支持图形处理和分析。

二、常见问题1. Spark中的RDD是什么?答:RDD(Resilient Distributed Dataset)是Spark的核心数据结构,代表一个可分布式计算的不可变数据集合。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

本 GraphX 简介 章 GraphX实例操作 内 容

GraphX简介

• Spark GraphX是一个分布式图处理框架,它是基于Spark平台提供对图 计算和图挖掘简洁易用的而丰富的接口,极大的方便了对分布式图处理 的需求。 • 众所周知,社交网络中人与人之间有很多关系链,例如Twitter、 Facebook、微博和微信等,这些都是大数据产生的地方都需要图计算, 现在的图处理基本都是分布式的图处理,而并非单机处理。Spark GraphX由于底层是基于Spark来处理的,所以天然就是一个分布式的图 处理系统。 • 图的分布式或者并行处理其实是把图拆分成很多的子图,然后分别对这 些子图进行计算,计算的时候可以分别迭代进行分阶段的计算,即对图 进行并行计算。

GraphX的框架 2

• GraphX发展历程

GraphX实例 1

• 假设有6个人,每个人有名字和年龄,这些人根据社会关系形成8条边,

每条边有其属性。

GraphX实例 2

• 在以下例子演示中将构建顶点、边和图,打印图的属性、转换操作、

结构操作,并结合实际要求进行演示。 • 加入jar包

– <dependency>

总结

• Spark GraphX是一个分布式图处理框架,它是基于Spark

平台提供对图计算和图挖掘简洁易用的而丰富的接口,极 大的方便了对分布式图处理的需求。 • 我们可以通过GraphX方便的构建一个图系统,并随意访 问点和线。

GraphX实例 4

• 设置边(数据类型ED:Int)

• 构建顶点RDD和边RDD

• 构造图

GraphX实例 5

• 点操作:找出年龄大于30的用户

• 边操作:找出属性大于5的边

GraphX实例 6

• 找出5到各顶点的最短距离

val sourceId: VertexId = 5L // 定义源点 val initialGraph = graph.mapVertices((id, _) => if (id == sourceId) 0.0 else Double.PositiveInfinity) val sssp = initialGraph.pregel(Double.PositiveInfinity)( (id, dist, newDist) => math.min(dist, newDist), triplet => { // 计算权重 if (triplet.srcAttr + triplet.attr < triplet.dstAttr) { Iterator((triplet.dstId, triplet.srcAttr + triplet.attr)) } else { Iterator.empty } }, (a,b) => math.min(a,b) // 最短距离 ) println(sssp.vertices.collect.mkString("\n"))

•

从上面的分析中我们可以发现图计算有很多的做法和算法的框架 1

• Spark每个子模块都有一个核心抽象,GraphX的核心抽象是Resilient Distributed Property Graph,一种点和边都带属性的有向多重图。 • 它扩展了Spark RDD的抽象,有Table和Graph两种视图,而只需要一份物理 存储。两种视图都有自己独有的操作符,从而获得了灵活操作和执行效率。

图计算

• 图计算的简单示例

•

拿到Wikipedia的文档以后,可以变成Link Table形式的视图,然后基于Link Table形式的视图可以

分析成Hyperlinks超链接,最后我们可以使用PageRank去分析得出Top Communities。在下面路 径中的Editor Graph到Community,这个过程可以称之为Triangle Computation,这是计算三角 形的一个算法,基于此会发现一个社区。

<groupId>org.apache.spark</groupId> <artifactId>spark-graphx_2.11</artifactId> <version>2.0.2</version> </dependency>

GraphX实例 3

• 构建运行环境

• 设置顶点(数据类型VD:(String,Int))