基于Bagging的选择性聚类集成

机器学习技术中的集成学习方法与应用案例

机器学习技术中的集成学习方法与应用案例机器学习是一种通过让计算机系统自动学习和改进的方法来处理数据和识别模式的技术。

近年来,随着大数据的快速发展,机器学习在各个领域的应用已经变得非常广泛。

而集成学习作为机器学习领域的重要技术方法之一,旨在通过整合多个学习器的预测结果来取得更好的性能。

集成学习中最常见的方法之一是投票法,即利用多个学习器的预测结果进行投票来决定最终的预测结果。

投票法适用于多个学习器的预测结果之间相对独立的情况。

另一种常见的集成学习方法是Bagging。

Bagging通过对训练集进行重采样来生成多个不同的训练集,并通过对这些训练集进行学习,最后将多个学习器的预测结果进行平均或投票来得到最终的预测结果。

相比于投票法,Bagging更适用于多个学习器的预测结果之间存在关联的情况。

此外,还有Boosting、Stacking等其他集成学习方法,它们都有各自的特点和适用场景。

接下来,我们将介绍一些集成学习方法的具体应用案例。

1. 随机森林(Random Forest)随机森林是一种基于决策树的集成学习方法。

它通过随机采样特征和数据来生成多个决策树,并通过对这些决策树的预测结果进行平均来得到最终的预测结果。

随机森林在分类和回归问题上表现出色,并且具有较好的抗过拟合能力。

在金融领域,随机森林可以应用于信用评分、风险预测等任务中。

2. 梯度提升树(Gradient Boosting Machine, GBM)梯度提升树是一种基于决策树的序列化的集成学习方法。

它通过迭代地训练决策树,每次训练都在上一个树的残差上进行,最终将多个决策树的预测结果进行求和来得到最终的预测结果。

梯度提升树在许多机器学习竞赛中表现出色,例如Kaggle等。

在电子商务领域,梯度提升树可以用于用户行为预测、推荐系统等任务。

3. 堆叠泛化(Stacking)堆叠泛化是一种基于模型融合的集成学习方法。

它通过将不同的基本学习模型进行级联,将前一层模型的预测结果作为后一层模型的输入,最终得到最终的预测结果。

机器学习中的集成学习算法

机器学习中的集成学习算法一、集成学习简介集成学习(Ensemble Learning)是机器学习中的一种重要算法。

它的主要思想是将多个弱学习算法集合起来形成一个强学习算法。

二、集成学习分类按照分类器的生成方式可将集成学习分类为Bagging算法、Boosting算法和Stacking算法。

1. Bagging算法Bagging全称为Bootstrap AGGregating,是自举聚合的缩写。

它的基本思想是采用自助法来产生k个新的训练集,在每个训练集上训练出一个基学习器,然后将这k个基学习器的结果进行平均或多数表决等方式来得到最终的结果。

2. Boosting算法Boosting算法基本思想是将一系列弱分类器相互结合,构成一个强分类器的过程。

它的主要特点是每一轮都学习一个新的分类器,并使得之前所有分类器的分类准确率加权相加。

3. Stacking算法Stacking算法是一种用来组合多个学习器的方法。

与传统的集成学习方法不同,Stacking算法通过加入一个“次级学习器”来对多个基学习器进行组合,从而构建出一个强学习器。

三、集成学习的优点1. 集成学习可显著提高机器学习算法的准确率和性能,并且对于许多不同类型的学习算法均有效。

2. 集成学习能够减轻模型过拟合问题,提高模型鲁棒性和泛化能力。

3. 集成学习能够减少各个单个模型产生的误差或者偏差,从而提高模型的精度。

四、集成学习案例1. 随机森林(Random Forest)随机森林是一种集成学习方法,它基于决策树算法创建多个随机子集的基学习器,最终将这些基学习器合并成一个强学习器。

2. AdaBoostAdaBoost是一种常见的Boosting算法,它通过不断调整训练样本的权重来训练机器学习模型,从而提高模型准确率。

3. Gradient Boosting Machines(GBM)GBM也是一种常见的Boosting算法,它采用一种梯度下降算法来学习弱学习器的加权。

bagging原理

bagging原理

Bagging,全称是Bootstrap Aggregating,是一种集成学习方法。

它的基本思想是通过创建多个基模型(通常是决策树)并对它们进行组合,以提高预测的稳定性和准确性。

以下是Bagging的基本原理:

1. 自助采样:

Bagging的核心在于“自助采样”或“有放回采样”的概念。

从原始数据集中随机抽取样本(包括可能重复的选择相同的样本),每个样本被选中的概率相等,且独立于其他样本。

2. 并行生成:

从原始数据集中抽取多个训练子集(这些子集被称为“袋”),每个子集都与原始数据集大小相同。

每个子集都是在原始数据集上独立抽取的,因此不同的子集之间可以有很大的差异。

在每个子集上训练一个基模型,如决策树。

3. 集成预测:

对于一个新的观测值,将其输入到所有已经训练好的基模型中,并获取各自的预测结果。

将所有基模型的预测结果综合起来,通常采用简单投票或者平均数的方式得出最终的预测结果。

4. 多样性:

通过引入随机性(比如在构建决策树时选择特征和划分点的方式),使得基模型之间具有一定的差异性,从而降低整体模型的方差,提高稳定性。

5. 并行计算:

由于各个基模型是在相互独立的子集上训练的,因此可以并行地生成和训练这些模型,大大加快了训练速度。

6. 防止过拟合:

通过对数据的不同采样方式,Bagging有助于减少单个模型的过拟合倾向,因为每一个模型只看到整个数据集的一部分。

通过以上步骤,Bagging能够有效地利用多个弱学习器来形成一个强学习器,提升模型的泛化能力。

集成学习算法在回归问题中的应用研究

集成学习算法在回归问题中的应用研究近年来,数据挖掘与机器学习技术的快速发展使得更多的人开始意识到其在解决实际问题方面的重要性。

而在机器学习算法中,集成学习算法可谓是一种备受关注的算法,其在回归算法中的应用也格外值得探讨。

所谓集成学习算法,指的是将多个基学习器进行组合,从而得到一个具有更好泛化能力的强学习器的过程。

而回归问题则是指寻找输入与输出变量之间的关系,从而预测出未知的输出变量。

下面,我们将从两个角度来探讨集成学习算法在回归问题中的应用。

一、基于Bagging的集成学习算法Bagging算法,即自助采样法,是一种比较简单的集成学习算法。

其主要思路是,通过对原始训练集进行有放回的随机采样,得到多个新的训练集,并利用这些新的训练集来训练不同的基学习器。

其可以有效地减少过拟合现象,提高模型的泛化能力。

在回归问题中,Bagging算法的应用也比较简单。

我们可以通过取各个基学习器的平均值来得到最后的预测结果。

具体来说,对于每个基学习器,我们可以用有放回的方式从训练集中抽取n个样本建立子训练集,并利用这个子训练集来训练基学习器。

当训练完成后,我们可以利用测试样本得到每个基学习器的预测结果。

最后,我们将各个基学习器的预测结果进行平均得到最后的预测值。

二、基于Boosting的集成学习算法上述Bagging算法虽然简单易懂,但其并不能很好的处理噪声数据。

而Boosting算法则可以通过增强易学习样本在最终分类决策中的权重来提高其分类准确率,同时也能够抑制噪声数据的影响,从而达到更好的总体分类效果。

Boosting算法最常用的一种形式是Adaboost算法。

在Adaboost算法中,我们会给错误分类样本增加权重,以便在下一轮迭代中能够更好地识别它们。

同时,对于正确分类样本,我们会减少其权重,以便鼓励算法关注更加困难的样本。

最后,将多个基学习器的输出加权求和,得到最终的预测结果。

总结以上我们介绍了两种常见的集成学习算法在回归问题中的应用。

基于Bagging的聚类集成方法

En e b ecuse i eh db s do g i s m l l trngm t o a e nBa gng

L h n IS a , ZHANG a xa g Hu - in

(co l fnomai c n e n n i e n ,S ad n r a U iesy ia 50 4 hn ) Sh o lfr t nSi c dE g er g h n o g o o e a n i Nom l nvr t,J n20 1 ,C i i n a

t e i u e c u tr g Th x e me t n UCI c i ela n n e c m a k d t e s h w a i me h d b R ri r v e h m p t o n w l se n . s t i ee p r i ns o ma h n r i gb n h r a s t o t t h s t o e e e a s h t mp o et h cu t r gp ro a c . l se n e f r n e i m Ke r s cu trn ; s b s mp e k me s l se n ; c mp n n a n r mu u l n o mai n y wo d : l s i g e u — a l ; — a u tr g n c i o o e te r e; l t a f r t ; i o

Ab t a t A g i g b s d e s mb emeh d s gan w aas mp i gt c n l g e pt e i e s y a dc r eai no b s mp e s r c : Ba gn a e n e l t o s i e d t u n a l h o o y t k e v ri n o r l t f u — a l n e o h d t o s i r p s d a dt e o o e t e r e e e ae yu i ga r v dK- a s l o t m, t e i e e t l s rn s l f a s t s o o e , n nc mp n n a r s n r tdb s i p h l n ig n n mp o e me g r h n a i h f r n u ti gr u t o d t e d c e e s a

集成学习中的Bagging算法优化实现

集成学习中的Bagging算法优化实现集成学习是一种机器学习领域的方法,它通过将多个弱分类器结合起来形成一个强分类器来提高预测准确性和稳定性。

Bagging 算法是集成学习中最受欢迎的方法之一,它通过对数据集进行有放回采样,构建多个子数据集,然后基于每个子数据集构建多个弱分类器,并通过投票的方式集成这些弱分类器的结果来提高分类效果。

本文主要讨论Bagging算法的优化实现方法。

一、Bagging算法的基本实现方法在介绍优化实现方法之前,我们首先来复习一下Bagging算法的基本实现方法。

Bagging算法的主要思路是通过构建多个子数据集和多个弱分类器来提高整体分类准确性和稳定性。

具体实现步骤如下:1. 对原始数据集进行有放回的随机采样,构建多个子数据集。

2. 对于每个子数据集,使用相同的算法来训练一个弱分类器。

3. 对于每个弱分类器,使用不同的随机样本对其进行评估,以降低过拟合的可能性。

4. 对于新的数据集,将每个弱分类器的预测结果进行合并,通过投票的方式来得到最终的分类结果。

这就是Bagging算法的基本实现方法。

然而,这个算法还存在一些问题,需要优化实现才能达到更好的效果。

二、Bagging算法的优化实现方法1. 随机选择特征Bagging算法会对原始数据集进行随机有放回采样,采样得到的数据集和原始数据集的样本数量相同,但是样本可能存在重复。

因此,在训练每一个弱分类器时,我们需要在特征上进行随机选择。

这样可以使得每个弱分类器都能够挖掘到数据集的不同方面,从而提高整体分类准确度和鲁棒性。

2. 加强弱分类器之间的差异化Bagging算法在构造每个弱分类器时采用相同的算法,而且使用了相同的样本。

因此,每个弱分类器之间的差异性可能不够大,这有可能限制了Bagging算法的性能。

为了加强弱分类器之间的差异化,我们可以使用不同的算法或者不同的参数来构建弱分类器,这样可以使得弱分类器之间的差异性更大,提高整体分类效果。

baggin算法

baggin算法Bagging算法是一种常用的集成学习方法,它通过组合多个弱学习器的预测结果来获得更准确的分类或回归结果。

在本文中,我们将详细介绍Bagging算法的原理、应用场景以及优缺点。

一、Bagging算法的原理Bagging算法的全称是Bootstrap aggregating,它的核心思想是通过有放回地从原始训练集中采样得到多个子训练集,然后使用这些子训练集分别训练出多个基学习器。

最后,通过对这些基学习器的预测结果进行投票(分类问题)或求平均(回归问题)来得到最终的预测结果。

具体来说,Bagging算法的步骤如下:1. 从原始训练集中有放回地进行采样,得到多个子训练集;2. 使用这些子训练集分别训练出多个基学习器;3. 对于分类问题,通过投票的方式确定最终的预测结果;对于回归问题,通过求平均的方式确定最终的预测结果。

二、Bagging算法的应用场景Bagging算法可以广泛应用于分类和回归问题。

对于分类问题,Bagging算法可以用于构建一个强大的分类器,从而提高分类的准确率;对于回归问题,Bagging算法可以用于构建一个强大的回归模型,从而提高回归的精度。

在实际应用中,Bagging算法常常与决策树作为基学习器相结合,形成Bagging决策树模型。

因为决策树具有易于理解和解释的特点,并且在处理复杂问题时能够取得不错的效果。

通过Bagging算法,可以进一步提升决策树的性能,使其更加稳定和准确。

三、Bagging算法的优缺点Bagging算法具有以下优点:1. Bagging算法能够降低模型的方差,提高模型的稳定性;2. Bagging算法能够有效地利用原始训练集,提高模型的泛化能力;3. Bagging算法简单易实现,不需要过多的参数调整。

然而,Bagging算法也存在一些缺点:1. Bagging算法无法降低模型的偏差,因此如果基学习器本身存在较大偏差,Bagging算法并不能完全解决这个问题;2. Bagging算法的训练过程需要进行多次采样和模型训练,因此计算复杂度较高。

人工智能基础(习题卷68)

人工智能基础(习题卷68)说明:答案和解析在试卷最后第1部分:单项选择题,共50题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]逻辑回归模型是解决什么问题的模型?A)分类问题B)聚类问题C)回归问题2.[单选题]1997 年5月,闻名的“人机大战”,最终运算机以比的总比分将世界国际象棋棋王卡斯鲍罗夫击败,这台运算机被称为()A)深蓝B)深思C)IBMD)蓝天3.[单选题]下列哪项不属于知识图谱的分布式表示方法()A)word2vecB)TransDC)TransHD)TransE4.[单选题]numpy中向量转成矩阵使用A)reshapeB)revalC)arangeD)random5.[单选题]下列对《国务院关于印发新一代人工智能发展规划的通知》中关于到2030年人工智能发展战略目标,表述错误的是()。

A)人工智能理论、技术与应用达到世界领先水平B)成为世界主要人工智能创新中心C)人工智能产业成为新的重要经济增长点D)智能经济、智能社会取得明显成效6.[单选题]下面关于Jarvis-Patrik(JP)聚类算法的说法不正确的是( )。

A)JP聚类擅长处理噪声和离群点,并且能够处理不同大小、形状和密度的簇。

B)JP算法对高维数据效果良好,尤其擅长发现强相关对象的紧致簇。

C)JP聚类是基于SNN相似度的概念。

D)JP聚类的基本时间复杂度为O(m)。

7.[单选题]编码器的分辨率越高,定位精度( )。

A)越差C)不受影响D)弹性越强8.[单选题]变气隙型位移传感器的自感 L 与气隙厚度的关系是( )。

A)非线性关系B)线性关系C)对称关系D)互补关系9.[单选题]词袋模型是最早的以词语为基本处理单元的文本向量化方法.以下哪个选项不是词袋模型的A)基于分布假设B)存在语义鸿沟C)维度灾难D)无法保留次序信息10.[单选题]如果聚类分割后的点云中存在小于或大于目标点云的点数量,则是因为( )。

R语言聚类集成算法

R语言聚类集成算法R语言是一种广泛应用于数据分析和统计建模的编程语言,而聚类集成算法则是一种将多个聚类算法结果进行整合的方法。

在R语言中,有许多可以用来实现聚类集成的包和函数,本文将介绍其中几个常用的方法。

1. VotingVoting算法是一种简单而有效的聚类集成方法。

它基于多数表决原则,将不同聚类算法得到的结果进行投票,并选择得票最多的结果作为最终答案。

在R语言中,可以使用“majorityVote”函数实现Voting算法:```{r}library(cluster)library(fpc)library(ensembler)data(iris)km <- kmeans(iris[, 1:4], centers = 3)pam <- pam(iris[, 1:4], diss = TRUE, k = 3)diana <- diana(iris[, 1:4])hclust <- hclust(dist(iris[, 1:4]))results <- list(km$cluster, pam$clustering, diana$tree$lower[[3]], cutree(hclust, k = 3))voting_result <- majorityVote(results)```在上述代码中,我们首先使用了四种不同的聚类算法(kmeans、pam、diana、hclust)对鸢尾花数据集进行了聚类,并将其结果存储在一个列表中。

然后,我们调用了“majorityVote”函数,对这些结果进行了投票,并得到了最终的聚类结果。

2. BaggingBagging算法是一种通过随机采样和重复聚类来提高聚类准确度的方法。

它基于不同的采样数据集,使用相同的聚类算法进行多次聚类,并将每次聚类得到的结果进行整合。

在R语言中,可以使用“baggingCluster”函数实现Bagging算法:```{r}library(cluster)library(ensembler)data(iris)bagging_result <- baggingCluster(x = iris[, 1:4], k = 3, B = 10, method = "kmeans")```在上述代码中,我们调用了“baggingCluster”函数,对鸢尾花数据集进行了Bagging聚类。

机器学习中的模型融合方法

机器学习中的模型融合方法机器学习是一门非常重要的学科,涉及到了众多的方法和技术。

其中,模型融合方法是一种常用的技术,用于提高机器学习模型的性能和泛化能力。

本文将介绍几种常见的机器学习中的模型融合方法。

一、集成学习集成学习是一种常用的模型融合方法。

它的基本思想是将多个弱学习器集成在一起,形成一个强学习器,从而提高模型的性能。

常见的集成学习方法包括投票方法、bagging和boosting。

1. 投票方法投票方法是一种简单而有效的集成学习方法。

它的思想是通过结合多个模型的预测结果进行投票,最终选择预测结果最多的类别作为最终的预测结果。

投票方法适用于分类问题,在实际应用中较为常见。

2. BaggingBagging是一种基于自助采样技术的集成学习方法。

它的思想是通过对训练集进行多次有放回的采样,产生多个不同的训练集,然后用这些训练集分别训练出多个模型,再将这些模型的预测结果进行平均或投票,得到最终的预测结果。

Bagging方法可以降低模型的方差,提高模型的泛化能力。

3. BoostingBoosting是一种迭代的集成学习方法。

它的基本思想是通过训练多个弱学习器,每个弱学习器都试图修正前一个弱学习器的错误,最终将这些弱学习器进行加权结合。

Boosting方法可以提高模型的准确率,特别适用于处理复杂的数据集和任务。

二、深度学习中的模型融合方法深度学习是机器学习的一个重要分支,近年来在众多领域取得了重大突破。

在深度学习中,模型融合方法也起到了关键的作用。

下面介绍几种常见的深度学习中的模型融合方法。

1. 神经网络融合神经网络融合是一种常用的深度学习模型融合方法。

它的思想是通过将多个神经网络进行融合,获得更好的预测性能。

常见的神经网络融合方法包括平均融合、投票融合和学习融合等。

2. 迁移学习迁移学习是一种将已经学习好的模型迁移到新的任务上的方法。

它的思想是通过使用已经学习好的模型生成的特征来辅助新任务的学习。

数据挖掘中的Bagging算法原理解析

数据挖掘中的Bagging算法原理解析数据挖掘是一门通过从大量数据中发现隐藏模式、关系和趋势来提取有用信息的领域。

在数据挖掘中,有许多算法被用于处理和分析数据。

其中之一是Bagging算法,它是一种集成学习方法,通过组合多个分类器来提高预测性能。

Bagging算法的全称是Bootstrap Aggregating,它的核心思想是通过对原始数据集进行有放回抽样(bootstrap sampling),生成多个不同的训练集,并在每个训练集上训练一个基分类器。

最后,通过对这些基分类器的预测结果进行投票或取平均来得到最终的预测结果。

Bagging算法的原理可以通过以下步骤来解析:1. 数据集的有放回抽样:首先,从原始数据集中随机抽取一部分样本,抽样过程中每个样本都有可能被重复选择,形成一个新的训练集。

这个过程称为有放回抽样,它可以保证每个样本都有一定的概率被选中,同时保持了原始数据集的规模。

2. 基分类器的训练:对于每个生成的训练集,使用一个基分类器进行训练。

基分类器可以是任何分类算法,如决策树、支持向量机等。

每个基分类器使用不同的训练集进行训练,因此它们之间具有一定的差异性。

3. 集成预测:当所有的基分类器都训练完成后,使用它们对新的样本进行预测。

对于分类问题,可以通过投票的方式来确定最终的预测结果。

对于回归问题,可以取基分类器预测结果的平均值作为最终的预测结果。

Bagging算法的优势在于它能够减少过拟合的风险,提高模型的泛化能力。

通过对原始数据集进行有放回抽样,Bagging算法可以生成多个训练集,每个训练集都是从原始数据集中独立采样得到的。

这样可以使得每个训练集都具有一定的差异性,从而减少了模型对训练集的过度拟合。

此外,Bagging算法还可以通过并行计算来加速模型的训练过程。

由于每个基分类器都是独立训练的,因此可以将它们分配到不同的计算节点上进行并行计算,从而提高训练速度。

然而,Bagging算法也存在一些限制。

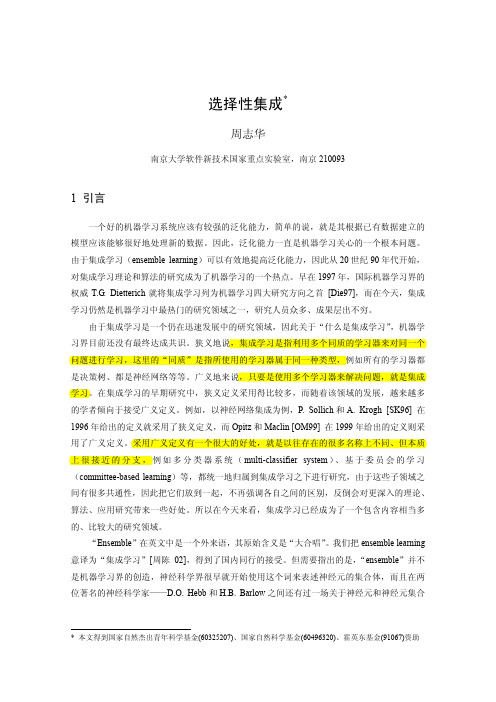

选择性集成—周志华

选择性集成*周志华南京大学软件新技术国家重点实验室,南京2100931 引言一个好的机器学习系统应该有较强的泛化能力,简单的说,就是其根据已有数据建立的模型应该能够很好地处理新的数据。

因此,泛化能力一直是机器学习关心的一个根本问题。

由于集成学习(ensemble learning)可以有效地提高泛化能力,因此从20世纪90年代开始,对集成学习理论和算法的研究成为了机器学习的一个热点。

早在1997年,国际机器学习界的权威T.G. Dietterich就将集成学习列为机器学习四大研究方向之首 [Die97],而在今天,集成学习仍然是机器学习中最热门的研究领域之一,研究人员众多、成果层出不穷。

由于集成学习是一个仍在迅速发展中的研究领域,因此关于“什么是集成学习”,机器学习界目前还没有最终达成共识。

狭义地说,集成学习是指利用多个同质的学习器来对同一个问题进行学习,这里的“同质”是指所使用的学习器属于同一种类型,例如所有的学习器都是决策树、都是神经网络等等。

广义地来说,只要是使用多个学习器来解决问题,就是集成学习。

在集成学习的早期研究中,狭义定义采用得比较多,而随着该领域的发展,越来越多的学者倾向于接受广义定义。

例如,以神经网络集成为例,P. Sollich和A. Krogh [SK96] 在1996年给出的定义就采用了狭义定义,而Opitz和Maclin [OM99] 在1999年给出的定义则采用了广义定义。

采用广义定义有一个很大的好处,就是以往存在的很多名称上不同、但本质上很接近的分支,例如多分类器系统(multi-classifier system)、基于委员会的学习(committee-based learning)等,都统一地归属到集成学习之下进行研究,由于这些子领域之间有很多共通性,因此把它们放到一起,不再强调各自之间的区别,反倒会对更深入的理论、算法、应用研究带来一些好处。

所以在今天来看,集成学习已经成为了一个包含内容相当多的、比较大的研究领域。

bagging算法原理

bagging算法原理Bagging算法,又名自举平均法,是一种集成学习算法,它通过同时训练多个分类器来提高分类准确性。

该算法不仅适用于分类问题,也适用于回归问题。

Bagging算法的基本思想是,通过随机有放回的采样方法,从训练数据集中选取多个子集,训练出多个分类器。

然后,在分类时,分别利用这些分类器对新数据进行分类,并综合多个分类器的结果进行最终分类判定。

为了保证随机性,每个子集的大小都应该与原始数据集的大小相同,即每次采样的时候都应该随机选取原始数据集中的一定比例的数据。

这样,可以避免训练中对某些特定数据的依赖性,提高了算法的泛化能力和鲁棒性。

具体来说,Bagging算法的训练过程如下:1. 从原始数据集中,随机有放回地选取多个大小相同的子集。

2. 对于每个子集,训练一个分类器。

3. 在使用分类器分类新数据时,如果分类器采用的是投票决策规则,则最终的分类结果是多个分类器中选择出现次数最多的类别。

如果采用的是平均决策规则,则最终的分类结果是多个分类器对同一实例分类的结果取平均值。

Bagging算法的优点是可以显著提高分类准确性,特别是对于复杂的分类问题。

同时,由于每个子集的训练过程相对独立,可以并行处理,加快训练速度。

此外,由于采用了随机性,Bagging算法对于数据中的噪声和异常值具有很好的鲁棒性。

然而,Bagging算法也存在一些缺点,例如随机采样有可能导致一些样本没有被选中,从而遗漏了一些重要信息。

此外,在某些情况下,多个分类器的组合并不能提高分类准确率。

总之,Bagging算法是一种简单而有效的集成学习算法,广泛应用于各种分类问题中。

在进行实际应用时,需要根据具体情况选择合适的决策规则,避免过拟合等问题。

机器学习中的集成学习算法

机器学习中的集成学习算法机器学习是目前非常热门的研究领域。

在机器学习中,集成学习算法尤为重要。

集成学习算法是指通过将多个不同的学习算法结合起来,来提高模型的性能和泛化能力。

本文将会介绍集成学习算法的概念、分类以及具体应用等内容。

一、集成学习算法的概念集成学习算法是一种将多个分类器组合起来,以提高学习算法的性能和泛化能力的方法。

其根据不同的机器学习算法,通过实现不同的策略来改进分类器的准确性。

这些算法的主要目的是减少过拟合和提高鲁棒性,它们通过整合来自不同算法的信息,从而提高整体性能。

二、集成学习的分类根据集成学习算法的实现原理,可以将其划分为三类:bagging(套袋法)、boosting(提升法)和stacking(堆叠法)。

1. BaggingBagging是一种并行的集成学习方法。

它的原理是基于不同的训练集对分类器进行训练,并对结果进行平均(以分类问题为例),以提高分类器的准确性。

Bagging依赖于构造大量的分类器并将它们的结果合并,从而使得模型更具鲁棒性和泛化能力。

2. BoostingBoosting是目前应用最广泛的集成学习方法之一。

Boosting的工作原理是一种按序列引入数据的方法。

它的实现方法是生成一系列的基分类器,并将它们按照一定的权重组合来提高模型的准确性。

Boosting技术就是不断得学习如何在错误中提高模型的准确性的过程。

缺点是Boosting几乎总是会导致过度拟合问题,而且对训练数据过于敏感。

3. StackingStacking是一种堆叠的学习方法,它通过堆叠不同分类器的输出来构建一个新的分类器。

Stacking的实现方法是基于不同的学习算法来生成若干个分类器。

这些分类器由不同的特征子集和训练数据子集构成。

最终,在训练数据上生成的分类器组成一个新的分类器来提高分类的准确性。

三、集成学习算法的具体应用集成学习算法可以应用于各种机器学习问题,包括分类和回归。

以下是一些常见的应用:1. 图像识别图像识别是一个受欢迎的研究领域。

介绍常用的集成学习方法及其应用场景

介绍常用的集成学习方法及其应用场景集成学习是机器学习领域的一种重要技术,它通过结合多个基本模型的预测结果来提高整体的准确性和稳定性。

在实际应用中,集成学习方法可以在分类、回归和异常检测等任务中发挥重要作用。

本文将介绍几种常用的集成学习方法及其应用场景。

首先,我们先了解一下集成学习的基本原理。

集成学习将多个弱学习器组合成一个强学习器,其核心思想是“三个臭皮匠,胜过诸葛亮”。

具体来说,集成学习可以分为两种类型:bagging和boosting。

首先,我们来介绍一种被广泛应用的集成学习方法——随机森林(Random Forest)。

随机森林是一种基于决策树的集成学习算法,它通过构建多棵决策树来实现分类和回归任务。

随机森林的核心思想是通过随机抽样和属性随机选择来增加模型的多样性。

在随机森林中,每棵决策树都会基于随机选择的样本和特征进行构建,最终通过多数投票或平均预测结果来做出最终的决策。

随机森林具有良好的鲁棒性和高度的准确性,尤其适用于处理高维数据和噪声数据。

在金融行业中,随机森林被广泛应用于信用评分、风险评估和欺诈检测等任务。

接下来,我们介绍另一种常用的集成学习方法——Adaboost(Adaptive Boosting)。

Adaboost是一种迭代的集成学习算法,它通过调整样本权重来逐步学习和集成弱学习器。

在每一次迭代中,Adaboost会根据上一轮的错误率调整样本权重,使得那些被错误分类的样本在下一轮中具有更高的权重。

这样,Adaboost能够更加关注难以分类的样本。

最终,Adaboost通过对多个弱学习器的线性组合来产生最终的预测结果。

Adaboost具有良好的泛化性能和自适应能力,在人脸识别、目标检测和自然语言处理等领域有很好的应用效果。

此外,还有一种被广泛使用的集成学习方法是梯度提升(Gradient Boosting)。

梯度提升是一种迭代的集成学习算法,它通过拟合前一轮模型的残差来逐步学习和集成弱学习器。

多重扰动因素 集成方法

多重扰动因素集成方法

在处理多重扰动因素时,集成方法(ensemble methods)是一种常用的策略。

集成方法通过组合多个模型(也称为“基础学习器”)的预测结果,来提高整体预测的准确性和鲁棒性。

以下是一些常见的集成方法:

1. 袋装法(Bagging):这种方法通过从原始数据集中进行有放回的随机抽样来创建多个子数据集,然后在每个子数据集上训练基础学习器。

最后,通过取这些基础学习器预测结果的平均值(对于回归问题)或通过投票(对于分类问题)来得到最终预测。

袋装法有助于减少模型的方差,从而提高其稳定性。

2. 提升法(Boosting):这种方法通过顺序地训练基础学习器,并在训练过程中给予之前错误分类的样本更大的权重,来逐步改进模型。

每个新的基础学习器都专注于纠正之前学习器的错误。

最终预测结果是所有基础学习器预测结果的加权和。

提升法有助于减少模型的偏差和方差。

3. 堆叠法(Stacking):这种方法通过训练一个元学习器(meta-learner)来组合多个基础学习器的预测结果。

在每个基础学习器上训练模型,并将它们的预测结果作为输入特征提供给元学习器。

然后,在元学习器上进行训练,以得到最终预测结果。

堆叠法可以灵活地结合不同类型的基础学习器,并利用它们之间的互补性来提高预测性能。

这些集成方法在处理多重扰动因素时具有一定的优势,因为它们可以通过结合多个模型的预测结果来减轻单一模型可能存在的偏差、方差或过度拟合等问题。

选择合适的集成方法取决于具体问题的特点、数据集的规模以及可用的计算资源。

简述随机森林算法的流程及优点

简述随机森林算法的流程及优点随机森林(Random Forest)算法是一种集成学习(Ensembled Learning)方法,它以决策树为基础模型,通过Bagging技术以及随机属性选择的方法集成多个决策树,综合多个模型的预测结果来达到更好的分类或回归性能。

随机森林是一种广泛应用于数据挖掘、机器学习与人工智能领域的算法,因其简单、高效和高准确性而备受研究者的青睐。

流程随机森林包括两个阶段:训练阶段和预测阶段。

训练阶段:1.随机选择样本:从原始数据集中有放回地抽取一部分数据,构造出一个有m个样本的新数据集。

2.随机选择特征:从所有特征中随机选择n个特征,用于建立决策树。

这里的n值是一个超参数,可以在建立模型时调整。

3.建立决策树:对于每个子数据集,采用CART决策树算法建立一棵决策树。

训练过程中使用的特征是在第二步中随机选择的n个特征。

找到的最优特征作为划分样本的依据。

4.重复2~3步,构建k棵决策树。

预测阶段:将待分类的样本,输入到每棵决策树中,每棵决策树将给出一个类别的预测结果。

对于分类任务,采取“投票原则”,即选择出现次数最多的类别作为最终分类结果;对于回归任务,则对每棵决策树的预测结果取均值作为最终预测结果。

随机森林的优点1.可以应用于分类和回归任务:随机森林不仅适用于分类任务,而且可以用于回归任务。

而且在数据集缺失情况下,随机森林的表现也非常优秀。

2.高准确性:随机森林是一种集成算法,通过集成多棵决策树来降低单一模型的过拟合风险,从而提高分类或回归的准确性。

3.不容易过度拟合:随机森林通过Bagging技术和随机属性选择的方式,减少决策树模型的偏好倾向,使得集成模型不易过度拟合。

4.能够反映特征的重要性:在随机森林训练过程中,我们可以通过特定的方法计算每个特征的重要性,从而更好地理解数据集。

5.支持大规模数据集:随机森林算法可以同时处理大量的变量和数据,并且其训练和预测过程具有较高的并行性。

机器学习中的集成学习方法

机器学习中的集成学习方法机器学习是一门关于让计算机通过数据学习和优化算法的领域。

在机器学习的过程中,集成学习方法被广泛应用于提升模型性能和泛化能力。

本文将介绍机器学习中的集成学习方法,并探讨其在不同领域的应用。

一、集成学习方法概述集成学习是一种通过结合多个弱分类器或回归器来构建一个更强大的模型的方法。

它通过将若干个基分类器组合在一起,以达到获得更高性能和鲁棒性的目标。

常见的集成学习方法包括:Bagging、Boosting、Stacking等。

1. BaggingBagging方法通过从原始数据集中进行有放回的采样,生成多个子集,每个子集用于训练一个基分类器。

最后,通过将这些基分类器的结果进行投票或求均值的方式来预测新样本的类别或数值。

其中,随机森林(Random Forest)是Bagging方法的典型代表。

2. BoostingBoosting方法通过顺序训练多个基分类器,每个基分类器的训练数据集是上一个基分类器错误分类的样本集。

Boosting方法通过不断调整基分类器的权重,使得后续分类器对先前分类器错误分类的样本给予更高的重视。

常见的Boosting算法有Adaboost、GBDT(Gradient Boosting Decision Tree)等。

3. StackingStacking方法通过将多个基分类器的预测结果作为输入,训练一个元分类器来进行最终的分类。

与Bagging和Boosting方法不同的是,Stacking方法的基分类器不是独立学习的,而是相互协作,通过将多个基分类器的预测结果作为特征输入到元分类器中进行训练和预测。

二、集成学习方法的应用集成学习方法在机器学习领域得到了广泛的应用,以下是一些常见的应用场景。

1. 图像分类在图像分类任务中,集成学习方法可以通过将多个基分类器的预测结果进行投票或求均值的方式来提高模型的性能。

例如,在人脸识别任务中,可以使用多个基分类器对人脸图像进行分类,并将它们的预测结果进行集成,以提高识别准确率。

CDA-LEVELⅢ模拟题一

CDA-LEVELⅢ模拟题(一)一、单选题1对于分类器的性能,我们需要不同维度来进行综合衡量,以下不属于分类器评价或比较尺度的有?A.预测准确度B.查全率C.模型描述的简洁度D.计算复杂度正确答案:C,解析:模型描述简洁度不属于模型评价指标2下面有关分类算法的准确率,查全率,F1值的描述,错误的是?A.准确率是检索出相关文档数与检索出的文档总数的比率,衡量的是检索系统的查准率B查全率回旨检索出的相关文档数和文档库中所有的相关文档数的瞬,衡量的是检索系统的查全率C.正确率、查全率和F值取值触0和1之间,数值降国,查准率或查全率就越高D.为了解决准确率和查全率冲突问题,引入了fi分数正确答案:C ,解析:无解析3回归树是可以日于回归的决策树模型,一个回归树又寸应着输入空间(即特征空间)的一个划分以及在划分单元上的输出值。

以下哪个指标可用于回归树中的模型上降A.Adjusted R2B.F-measureC.AUCD.Precision & Recall正确答案:A,解析:F-measure. AUC、Precisin & Recall是分类模型的评价指标4 序列模式挖掘(sequence pattern mining )是指挖掘相对时间或其他模式出现频率高的模式典型的应用还是限于离散型的序列。

下列哪个选项不属于序列模式的时限约束?,A.最大跨度约束B.主键约束C.最小间隔和最大间隔约束D.窗口大小约束正确答案:B,解析:序列模式的时限约束包括最壮度约束、最大间隔和最小间隔约束、窗口大小约束5 Apriroi算法中,候选序列的个数比候选项集的个数大得多,产生更多候选的原因有?A.l个项在项集中最多出现一次,但一个事件可以在序列中出现多次B.一个事件在序列中最多出现一次,但一个项在项集中可以出现多次C.次序在序列中和项集中都是重要的D.序列和以合并正确答案:A,解析:无解析6 考虑下面的频繁3-项集的集合:{1, 2. 3}, {1, 2. 4}, {1, 2, 5}, {1, 3, 4}, {1, 3, 5),{1,4,5}, {2, 3, 5}, {3, 4, 5}假定数据集中只有5个项,采用合并策略,由候选产生过程得到4-项集不包含:A.1, 2, 3, 4B.1, 2, 3, 5C.1, 2, 4, 5D.1, 3, 4, 5正确答案:C,解析:无解析7广为流传的“啤酒与尿布”的故事,其背后的模型实际上是哪一类?A.分类(Classification)B.分群(Clustering)C.关联(Assciation)D.预测(Prediction)正确答案:C,解析:"啤酒与尿布”是关联规则的经典故事8 Apriori算法,最有可能可用来解决以下哪个问题?A电子商务网站向顾客推荐商品的广告B.信用卡欺诈识C.电信用户离网预警D预测GDP与工业产值之间的关系正确答案:A,解析:Apriori算法是关联规则挖掘算法,它利用逐层搜索的迭代方法找出数据库中项集的关系,以形成规则9在聚类(Clustering)的问题中,若缄字段属性都是二元属性(Binary Variable),根据下表,下列何者是Jaccard Coefficient计算数据间品巨离的公式?答案:A,10以下哪个选项是分割式聚类算法?A.K-MeansB.Centroid MetohdC.Ward's MethodD.以上皆非正确答案:A,解析:无解析11在机器学习中,非监督学习主要用来分类.其中重要的两种就是聚类分析和主成分分析,下列那个选项不是聚类分析的算法A.Two-StepQ B.FP-GrowthC.Centrid MethodD.Ward's Method正确答案:B,解析:FP-Growth是关联分析算法12、下列哪种集成方法,会重复抽取训练数据集中的数据,且每笔被抽中的概率始终保持一样?A.袋装法(Bagging)B.提升法(Boosting)C.随机森林(Random Forest)D.以上皆是正确答案:A,解析:无解析13 提升法Boosting是一种可以用来减小监督式学习中偏差的机器学习算法。

选择性集成—周志华

选择性集成*周志华南京大学软件新技术国家重点实验室,南京2100931 引言一个好的机器学习系统应该有较强的泛化能力,简单的说,就是其根据已有数据建立的模型应该能够很好地处理新的数据。

因此,泛化能力一直是机器学习关心的一个根本问题。

由于集成学习(ensemble learning)可以有效地提高泛化能力,因此从20世纪90年代开始,对集成学习理论和算法的研究成为了机器学习的一个热点。

早在1997年,国际机器学习界的权威T.G. Dietterich就将集成学习列为机器学习四大研究方向之首 [Die97],而在今天,集成学习仍然是机器学习中最热门的研究领域之一,研究人员众多、成果层出不穷。

由于集成学习是一个仍在迅速发展中的研究领域,因此关于“什么是集成学习”,机器学习界目前还没有最终达成共识。

狭义地说,集成学习是指利用多个同质的学习器来对同一个问题进行学习,这里的“同质”是指所使用的学习器属于同一种类型,例如所有的学习器都是决策树、都是神经网络等等。

广义地来说,只要是使用多个学习器来解决问题,就是集成学习。

在集成学习的早期研究中,狭义定义采用得比较多,而随着该领域的发展,越来越多的学者倾向于接受广义定义。

例如,以神经网络集成为例,P. Sollich和A. Krogh [SK96] 在1996年给出的定义就采用了狭义定义,而Opitz和Maclin [OM99] 在1999年给出的定义则采用了广义定义。

采用广义定义有一个很大的好处,就是以往存在的很多名称上不同、但本质上很接近的分支,例如多分类器系统(multi-classifier system)、基于委员会的学习(committee-based learning)等,都统一地归属到集成学习之下进行研究,由于这些子领域之间有很多共通性,因此把它们放到一起,不再强调各自之间的区别,反倒会对更深入的理论、算法、应用研究带来一些好处。

所以在今天来看,集成学习已经成为了一个包含内容相当多的、比较大的研究领域。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

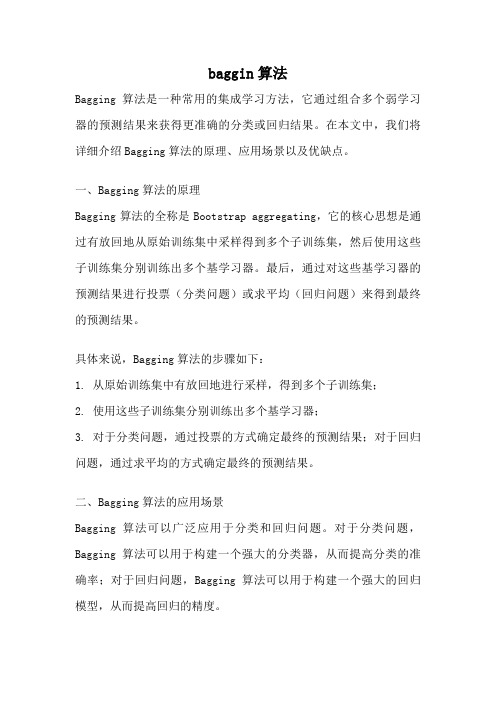

V ol.16, No.4 ©2005 Journal of Software 软 件 学 报 1000-9825/2005/16(04)0496 基于Bagging 的选择性聚类集成∗唐 伟, 周志华+ (南京大学 计算机软件新技术国家重点实验室,江苏 南京 210093)Bagging-Based Selective Clusterer EnsembleTANG Wei, ZHOU Zhi-Hua +(National Laboratory for Novel Software Technology, Nanjing University, Nanjing 210093, China)+ Corresponding author: Phn: +86-25-83686268, E-mail: zhouzh@, /people/zhouzh/Received 2003-11-03; Accepted 2004-07-27Tang W, Zhou ZH. Bagging-Based selective clusterer ensemble. Journal of Software , 2005,16(4):496−502. DOI: 10.1360/jos160496Abstract : This paper uses ensemble learning technique to improve clustering performance. Since the training data used in clustering lacks the expected output, the combination of component learner is more difficult than that under supervised learning. Through aligning different clustering results and selecting component learners with the help of mutual information weight, this paper proposes a Bagging-based selective clusterer ensemble algorithm. Experiments show that this algorithm could effectively improve the clustering results.Key words : machine learning; ensemble learning; clustering; unsupervised learning; selective ensemble摘 要: 使用集成学习技术来提高聚类性能.由于聚类使用的训练样本缺乏期望输出,与监督学习下的集成相比,在对个体学习器进行结合时更加困难.通过对不同的聚类结果进行配准,并基于互信息权进行个体学习器的选择,提出了基于Bagging 的选择性聚类集成算法.实验表明,该算法能够有效地改善聚类结果.关键词: 机器学习;集成学习;聚类;非监督学习;选择性集成中图法分类号: TP181 文献标识码: A聚类分析技术将未标记对象通过其相似度进行分组,使得组内对象的相似度最大而组间对象的相似度最小,从而发现对象中的内在特性.由于聚类分析技术在数据挖掘、模式识别等诸多领域有着广泛的应用前景,一直是机器学习领域的一个研究热点[1].集成学习(ensemble learning)[2]技术利用基学习器的多个版本来解决同一个问题,可以显著地提高学习系统的泛化能力.最近几年,在机器学习、神经网络、统计学等领域的很多研究者都投入到集成学习的研究中,使得该领域成为了一个相当活跃的研究热点,并被认为是当前机器学习领域的4大研究方向之首[2].现在已经有很多集成学习算法,Bagging 算法[3]就是其中比较著名的一个.该算法在训练阶段,各学习器的训练集由原始训练集利用可重复取样(bootstrap sampling)技术获得,训练集的规模通常与原始训练集相当.这样,原始训练集中∗ Supported by the National Outstanding Youth Foundation of China under Grant No.60325207 (国家杰出青年科学基金)作者简介: 唐伟(1978-),男,湖南祁阳人,硕士,主要研究领域为机器学习,数据挖掘;周志华(1973-),男,博士,教授,博士生导师,主要研究领域为机器学习,数据挖掘,模式识别,信息检索,神经计算,进化计算.唐伟等:基于Bagging的选择性聚类集成497某些示例可能在新的训练集中出现多次,而另外一些示例则可能一次也不出现.研究表明[3],Bagging可以显著提高不稳定的基学习器的泛化能力.以往的集成学习算法在生成多个个体学习器之后,通常是对所有的个体都进行结合,因此很多研究者尝试使用大规模的集成来解决问题.Zhou等人[4]提出了“选择性集成 (selective ensemble)”的概念,并证明通过选择部分个体学习器来构建集成可能要优于使用所有个体学习器构建的集成,这就意味着利用中小规模的选择性集成就可以获得很好的性能.需要注意的是,Bagging算法和其他大多数的集成学习算法都是为监督学习而设计的,对聚类这样的非监督学习来说,由于训练样本缺乏类别标记,聚类结果之间没有直接的对应关系,这将使得对个体学习器的结合难以直接进行.因此,用于非监督学习的集成学习算法比一般的用于监督学习的集成学习算法设计起来更加困难.实际上,利用集成学习技术来提高聚类分析的性能已经引起了一些研究者的关注.例如,在Strehl和Ghosh[5]的工作中,他们利用互信息(mutual information)把聚类集成问题定义为一个基于互信息的优化问题,但同时又指出由于该优化问题的计算开销过于庞大,因此难以应用于实际领域.本文对聚类集成进行研究,提出了基于Bagging的选择性聚类集成算法.第1节介绍本文所用到的标记和术语,并简单介绍作为聚类集成个体的k均值(k-means)算法.第2节具体介绍基于Bagging的选择性聚类集成算法.第3节通过实验对该算法进行性能测试并对实验结果进行分析.最后一节是对本文的工作进行总结并展望进一步的工作.1 背景知识1.1 标记和术语为了下文讨论的方便,本节将对有关聚类集成中所涉及的标记和术语进行约定.假设χ={x1,x2,…,x n}⊂ℜd为d维特征空间中一组类别未知的向量集.该向量集中的第i个元素x i为一个d维的特征向量[x i1,x i2,…,x id]T,T表示矩阵的转置.不失一般性,假设特征向量中的每一个分量均为数值属性.对于某个聚类器(clusterer)可以将向量集χ中的元素划分为k个聚类,可用一个标记向量λ(m)=[λ1,λ2,…,λn]T∈Νn表示,其中λi∈{1,2,…,k}为聚类标记.聚类集成算法首先通过M个聚类器对向量集χ进行聚类,然后将所有聚类器产生的标记向量{λ(1),λ(2),…,λ(M)}进行结合,最后得到结果标记向量λ.1.2 k均值算法MacQueen提出的k均值算法[6]是一个著名的聚类学习算法.它根据相似度距离迭代地更新向量集的聚类中心,当聚类中心不再变化或者满足某些停止条件,则停止迭代过程得到最终的聚类结果.k均值算法的具体步骤为:(1) 随机选择k个数据项作为聚类中心;(2) 根据相似度距离公式,将数据集中的每一项数据分配到离它最近的聚类中去;(3) 计算新的聚类中心;(4) 如果聚类中心没有发生改变,算法结束;否则跳转到第(2)步.由于所选择的相似度距离公式的不同,k均值算法所得到的聚类结果将存在较大的差异.为了简化讨论,本文采用欧氏距离作为k均值算法的相似度距离公式.但值得注意的是,本文工作对其他距离公式同样是适用的.2 基于Bagging的选择性聚类集成集成学习一般包含两个阶段,即个体生成阶段和个体学习器的结合阶段.在个体生成阶段,通过不同的个体生成方式产生不同的个体标记向量.在个体学习器的结合阶段,可以采用投票等方式将个体标记向量进行结合.在个体生成阶段,考虑到需要聚类的对象数可能非常庞大,对所有对象进行聚类势必将增加聚类算法的运行开销.因此,可以考虑对整个空间中分布在某个局部的对象进行聚类从而得到结果,但是,由于聚类对象的空间分布可能很不均匀,所得到的聚类结果可能只代表某个局部信息而不是全局的聚类结果.为了解决这个问题,本文采用类似Bagging算法中产生个体训练集的方式产生用于聚类的训练集,即通过可重复取样技术从原向量498 Journal of Software 软件学报 2005,16(4) 集χ中产生若干训练集{S i },i =1,…,T ,对每个训练集S i 用k 均值聚类器进行聚类.由于聚类对象受到某种程度的扰动,将进一步增大聚类结果中个体标记向量之间的差异,这有助于获得更好的集成.另一方面,由于k 均值聚类器只对原向量空间中的某一个局部进行了聚类,从而降低了聚类器的算法开销.需要注意的是,通过可重复取样技术产生的训练集S i 并不代表原向量集χ,故其并不代表全局的聚类结果.本文首先记录下k 均值聚类器对S i 进行聚类后达到稳定状态时的k 个聚类中心,然后用这k 个聚类中心对原向量集χ中的元素进行重新分配,最后得到针对向量集χ的标记向量.然而,通过这种方式得到的标记向量由于缺乏先验的类别信息,并不能直接用于下一阶段的结论合成.例如,对于标记向量[1,2,2,1,1,3,3]T 和[2,3,3,2,2,1,1]T ,虽然它们的表达方式不同,但是却表示着同一个聚类结果.所以为了对聚类结果进行结合,个体标记向量必须经过匹配建立相互之间的对应关系.一般来说,有对应关系的聚类标记所覆盖的相同对象的个数应该是最大的.因此,可以根据这一启发式来对标记向量进行配准.假设存在着两个标记向量λ(a )和λ(b ),每个标记向量分别把原向量集划分为k 个聚类,分别用聚类标记{C 1(a ),C 2(a ),…,C k (a )}和{C 1(b ), C 2(b ),…,C k (b )}表示.首先,将这两个标记向量中每一对聚类标记C i (a )和C j (b )所覆盖的相同对象的个数记录在k ×k 的OVERLAP 矩阵中,然后选择其中覆盖相同对象个数最大的聚类标记建立对应关系,并将其结果从OVERLAP 矩阵中移除.重复以上过程,直到所有聚类标记都建立了对应关系为止.当存在M (M >2)个聚类标记向量时,则随机选取某个标记向量作为匹配基准,将其他标记向量和基准标记向量进行匹配.匹配算法只需要对M -1个标记向量做一次扫描,共需(M -1)×k 2大小的存储空间来保存OVERLAP 矩阵.整个匹配过程是快速和高效的.在个体学习器的结合阶段,本文采用的是一种基于权值的选择性投票策略.在用于投票的个体标记向量的权值计算上,受Strehl 和Ghosh 工作[5]的启发,本文认为聚类标记向量间的互信息在某种程度上能够刻画聚类个体间的紧密程度,因此,利用互信息来表示个体标记向量的权值将有助于得到更好的集成结论.假设通过k 均值聚类器对大小为n 的向量集进行聚类,分别得到具有k 个聚类的标记向量λ(a )和λ(b ),用聚类标记{C 1(a ), C 2(a ),…,C k (a )}和{C 1(b ),C 2(b ),…,C k (b )}来表示.假设聚类标记C i (a )中含有n i 个元素,聚类标记C j (b )中有n j 个元素,其中C i (a )和C j (b )中的相同元素有n ij 个.那么,互信息可定义如下:()()()∑∑==⎟⎟⎠⎞⎜⎜⎝⎛=k i k j j i ij k ij b a NMI n n n n n n 112log 2,λλΦ (1) 对于个体标记向量,其平均互信息可用下式表示:∑≠==−=t ml l l m NMI m t m t ,1)()()1,2,...,( ),(11λλΦβ (2) 当βm 越大时,标记向量λ(m )所包含的其他标记向量所不具备的统计信息也就越少.所以,个体标记向量的权值可定义如下:),...,2,1( 1t m Z w m m ==β (3)其中,Z 用于将权值规范化,使聚类标记的权值满足:1 and ),...,2,1(01∑===>tm m m w t m w (4)本文将前面所定义的个体标记向量的权值作为选择聚类集成个体标记向量的依据.当标记向量的权值低于某个预设阈值如1/T (T 为集成中个体标记向量的个数)时,该个体标记向量将不参加最后的结论合成.最后,将挑选出的个体标记向量再基于权值进行投票.基于Bagging 的选择性聚类集成算法的伪码描述如下.Input: number of cluster centers k , data set S , number of bootstap sampling TOutput: cluster label C *(x ) for data object xFor t =1 to T Do唐伟 等:基于Bagging 的选择性聚类集成499S t = bootstrap sample from S λ(t ) = kmeans(k ,S t )/* λ(t ) is represented as {C 1(t ),C 2(t ),…,C k (t )} *//* for data object x , its cluster label determined by λ(t ) is λ(t )(x )∈{C 1(t ),C 2(t ),…,C k (t )} */End of Forλ(baseline ) = randomly selected from {λ(t )},t =1,…,TDelete λ(baseline ) from {λ(t )}, t =1,…,TFor each λ(t ) in {λ(t )}DoFor i =1 to k , j =1 to k DoOVERLAP(i ,j )=Count(C i (t ),C j (baseline ))End of For/* OVERLAP is a k ×k matrix; Count(A , B ) counts the number of same *//* elements labeled by A and B */Γ=∅While Γ≠{C 1(baseline ), C 2(baseline ),…,C k (baseline )} Do(u ,v )=argmax(OVERLAP(i ,j )) /* OVERLAP(u , v ) is the biggest element */C v (t )=C u (baseline ) /* align C v (t) to C u (baseline ) */Delete OVERLAP(u ,*)Delete OVERLAP(*,v )Γ=Γ∪{C v (t )}End of WhileEnd of ForFor t =1 to T DoCalculate w t for each λ(t )End of For)(max arg )()()/1()1(*x w x C t t T w T t t λ>∧≤≤=3 实验测试本文除对基于Bagging 的选择性聚类集成(sel-b-voting)算法进行了实验测试,还对基于简单投票的聚类集成(即随机初始化聚类中心产生个体标记向量,再进行简单投票)和基于加权投票的聚类集成(即随机初始化聚类中心产生个体标记向量,并根据相互间的互信息计算权值,然后进行基于权值投票)做了实验测试.我们采用UCI 机器学习数据库[7]中的10个数据集对上述聚类集成方法进行了实验.在这10个数据集中,除了类别属性以外,其余属性均为数值属性.其中,Image Segmentation 数据集中由于存在一列常数属性,对以后的聚类过程没有帮助而被删除.这10个数据集的具体信息见表1.当数据有分类信息时,可认为该分类信息在一定程度上表达了数据的一些内部分布特性,如果该分类信息没有被聚类过程所利用,则可以用它来评价聚类效果.在Modha 和Spangler [8]的工作中就是利用数据的分类信息来评价聚类结果的好坏.如果标记向量中某聚类标记和类别属性中某已知类别所覆盖的相同对象个数最多,则将该聚类标记对应为这个已知类别.这样,多个聚类标记可以对应同一个类别,而一个聚类标记则不能对应多个类别.通过这样的匹配,聚类结果就可以利用分类信息来进行评价.500 Journal of Software 软件学报 2005,16(4)Table 1 Data sets used in the experiments表1 实验所用数据集Data set No.attributes No.classes No.instancesImage segmentation 18 7 2 310Ionosphere 34 2 351Iris 4 3 150Liver disorder 6 2 345Page bocks 10 5 5 473Vehicle 18 4 846Waveform-21 21 3 5 000Waveform-40 40 3 5 000Wine 13 3 178Wpbc 33 2 198假设大小为n 的向量集中存在的已知类别标记为C ,可用{C 1,C 2,…,C h }来表示.通过k 均值聚类器对该向量集进行聚类所得到的结果为一个具有k 个聚类标记的标记向量λ,可用{λ1,λ2,…,λk }来表示.通过上述的匹配过程,聚类标记向量中的每一个λi 将对应为类别标记中的某一个C j .假设αi 为λi 中被正确分类为对应类别C i 的示例个数,那么该聚类标记向量的结果可用Micro-precision 进行衡量,具体的定义公式如下:∑==k i i a n 11p -micro (5) Micro-precision 的值越大,则表示聚类的标记向量越好.需要注意的是,这种评价策略只能用于比较能产生固定聚类个数的聚类器性能,而不能用于评价聚类个数产生具有不确定性的聚类器.因此,在本节的实验中,k 均值聚类器的聚类个数固定设置为其已知的类别数.实验中,k 均值聚类器的最大迭代步数设为100,误差停止阈值为1e-5.对于每个数据集,用上述所提到的5种聚类集成算法构造大小为5,8,13,20和30规模的集成.其中对于每一种测试都重复10次实验,然后记录下平均的Micro-precision 和标准偏差.同时,单个k 均值聚类器的结果也记录了下来,以便于和集成结果进行比较.表2给出了在显著程度0.05时的双边t 检验结果,其中voting 表示基于简单投票的聚类集成算法,w-voting 表示基于加权投票的聚类集成,sel-b-voting 表示基于Bagging 的选择性聚类集成.“win”表示聚类集成结果显著地比单个k 均值聚类器的结果“好”,“loss”表示聚类集成结果显著地比单个k 均值聚类器的结果“差”,而“tie”则表示聚类集成结果和单个k 均值聚类器的结果没有显著差异.Table 2 Results of pairwise two-tailed t tests with significance level 0.05表2 显著程度0.05时双边t 检验的结果Ensemble size Voting win/tie/loss W-Voting win/tie/loss Sel-B-Voting win/tie/loss8 0/8/2 3/6/1 4/5/113 2/6/2 2/6/2 6/3/120 1/6/3 3/4/3 5/4/130 1/5/4 3/4/3 5/4/1由表2可以看出,基于简单投票的聚类集成在性能上比单个k 均值聚类器要差;基于加权投票的聚类集成和单个k 均值聚类器所得到的结果相差不大;而基于Bagging 的选择性聚类集成则比单个k 均值聚类器要好.特别是当集成的大小为13的时候,所有10个数据集中,选择性聚类集成所得到的结果仅在1个数据集上比单个k 均值聚类器所得到的结果要差,而在6个数据集上,其结果比单个k 均值聚类器所得到的结果要好.这说明选择性集成方法在非监督学习领域特别是对于聚类问题同样有效.表3给出了不同集成规模下,选择性聚类集成实际使用的个体聚类器数目占所有个体聚类器数目的百分比.由表3可以看出,基于Bagging 的选择性聚类集成仅使用了28%~40%的个体聚类器参与构造最后的集成.从以上的实验数据分析可以看出,选择性聚类集成仅利用了少数个体聚类器就达到了比利用所有个体聚类器更好的效果.同时,实验中对于每一个数据集都构造了规模不等的聚类集成.为了解聚类集成的结果是否会受到集成规模变化的影响,本文也记录了相关的实验结果.图1给出了聚类集成的性能随着集成规模的大小而变化的关系图.其中,voting 表示基于简单投票的聚类集成算法,w-voting 表示基于加权投票的聚类集成,sel-b-voting 表示基唐伟 等:基于Bagging 的选择性聚类集成501于Bagging 的选择性聚类集成.Table 3 The average percentage of component clusterers selected by the proposed algorithm under different ensemble sizes表3 在不同集成规模下,本文方法所选用的个体聚类器的平均百分比Ensemble size Percentage of component clusterers selected (%)5 39.2 (1.96/5)8 38.1 (3.05/8)13 33.7 (4.38/13)20 31.8 (6.36/20)30 28.0 (8.41/30)Fig.1 The influence of ensemble size on the performance of clusterer ensemble图1 集成规模变化对聚类集成的性能的影响从图1可以看出,基于Bagging 的选择性聚类集成随着集成规模的增大,其聚类性能也有所提高.而对基于简单投票的聚类集成,当集成的规模增大时,其性能反而有下降的趋势.产生这种现象的原因可能是由于随着集成规模的增大,将产生更多的个体标记向量覆盖整个向量空间,而并不是所有的标记向量都有助于提高集成的性能,其中某些个体可能存在着严重的误导性.图1也验证了Zhou 等人[9]的结论,即当拥有一组个体学习器时,进行选择性集成比用所有个体集成更好.需要注意的是,图中横轴显示出的是个体聚类器的总数,由于基于Bagging 的选择性聚类集成算法仅对挑选出的个体聚类器进行集成,其实际规模要远小于图1中显示的值. 4 结束语本文提出了基于Bagging 的选择性聚类集成算法.实验结果表明,基于Bagging 的选择性聚类集成算法能有效地利用集成学习技术来提高聚类性能.由于选择性聚类集成只利用到了部分而不是所有聚类个体,这就降低了计算开销和存储开销.另外,由于该算法利用互信息计算权值的过程只对k 均值聚类器的结果标记向量进行分析,这与选择什么样的聚类分析算法无关,所以本文提出的基于Bagging 的选择性聚类集成算法同样也能适用于k 均值外的其他聚类器.本文使用的个体聚类器均采用欧氏距离,由于不同的相似度距离对聚类结果有不同程度的影响,因此也可以尝试使用多种距离度量的个体聚类器进行集成.值得注意的是,在本文工作进行时,将集成学习技术用于聚类的工作还非常少[5,9],但到目前已经出现了很多此类工作[10−12],这说明利用集成学习技术来改善聚类性能是一个新兴的研究热点.事实上,集成学习技术除了被用于监督学习和非监督学习,还被用于多示例学习[13,14].这一方面说明集成学习的效用已经受到了广泛的认可,其适用范围正逐渐扩大;另一方面也说明集成学习的研究空间还很大,尤其是将集成学习技术应用到监督学习之外的场合,还有很多重要的问题需要研究.References :[1] Estivill-Castro V. Why so many clustering algorithms —A position paper. SIGKDD Explorations, 2002,4(1):65−75.[2] Dietterich TG. Machine learning research: Four current directions. AI Magazine, 1997,18(4):97−136.[3] Breiman L. Bagging predicators. Machine Learning, 1996,24(2):123−140.0.640.660.680.700.725 8 13 2030Ensemble size A v e r a g e m i c r o -p Voting W-Voting Sel-B-Voting502 Journal of Software软件学报2005,16(4)[4] Zhou ZH, Wu J, Tang W. Ensembling neural networks: Many could be better than all. Artificial Intelligence, 2002,137(1−2):239−263.[5] Strehl A, Ghosh J. Cluster ensembles—A knowledge reuse framework for combining partitionings. In: Dechter R, Kearns M,Sutton R, eds.Proc. of the 18th National Conf. on Artificial Intelligence. Menlo Park: AAAI Press, 2002. 93−98.[6] MacQueen JB. Some methods for classification and analysis of multivariate observations. In: LeCam LM, Neyman J, eds. Proc. ofthe 5th Berkeley Symp. on Mathematical Statistics and Probability. Berkeley: University of California Press, 1967,1:281−297.[7] Blake C, Keogh E, Merz CJ. UCI Repository of machine learning databases. Irvine: Department of Information and ComputerScience, University of California, 1998. /~mlearn/MLRepository.html[8] Modha DS, Spangler WS. Feature weighting in k-means clustering. Machine Learning, 2003,52(3):217−237.[9] Zhou ZH, Tang W. Clusterer ensemble. Technical Report, Nanjing: AI Lab., Department of Computer Science & Technology,Nanjing University, 2002.[10] Fern XZ, Brodley CE. Random projection for high dimensional data clustering: A cluster ensemble approach. In: Fawcett T, MishraN, eds. Proc. of the 20th Int’l Conf. on Machine Learning. Menlo Park: AAAI Press, 2003. 186−193.[11] Fern XZ, Brodley CE. Solving cluster ensemble problems by bipartite graph partitioning. In: Greiner R, Schuurmans D, eds. Proc.of the 21st Int’l Conf. on Machine Learning. 2004. http://www.aicml.cs.ualberta.ca/ banff04/icml/pages/proceedings.htm[12] Topchy A, Jain AK, Punch W. A mixture model for clustering ensembles. In: Berry MW, Dayal U, Kamath C, Skillicorn DB, eds.Proc. of the 4th SIAM Int’l Conf. on Data Mining. Philadelphia: SIAM, 2004. /meetings/sdm04/proceedings/ index.htm[13] Zhou ZH, Zhang ML. Ensembles of multi-instance learners. In: Lavrač N, Gamberger D, Blockeel H, Todorovski L, eds. LectureNotes in Artificial Intelligence 2837, Berlin: Springer-Verlag, 2003. 492−502.[14] Xu X, Frank E. Logistic regression and boosting for labeled bags of instances. In: Dai H, Srikant R, Zhang C, eds. Lecture Notes inArtificial Intelligence 3056, Berlin: Springer-Verlag, 2004. 272−281.。