一种多视角跟踪系统中的自行标定方法

计算机视觉中的多摄像机标定技术研究

计算机视觉中的多摄像机标定技术研究计算机视觉是一项涉及透过摄像机、算法与硬件处理来自动检测、识别、追踪图像中特定对象并进行分析的技术。

而多摄像机标定技术则是其中重要的一环。

在多个摄像机、多个视角下进行目标识别和跟踪时,需要对不同摄像机之间的相对位置及姿态进行精确的定标,以提供可靠的三维空间信息对目标进行精确追踪。

一、标定技术的概述多摄像机标定技术是计算机视觉中的重要技术之一。

其目的是确定多个单独相机的内部参数(如传感器的像素大小、畸变、内外参数等)以及它们之间的相对位置和姿态关系。

标定技术的质量直接关系到后续视觉处理过程的精度和稳定性。

在摄像机标定中,通常先拍摄已知平面的标定板图像,然后依据标定板的特征点估计摄像机的内部参数。

再利用多个摄像机拍摄特定对象,通过三维变换模型计算不同摄像机观测图像之间的位置、姿态、区域范围,实现多个摄像机图像的建立和转换。

这也是多摄像机标定的主要要素。

二、多摄像机标定技术的种类1.基于姿态变换的多相机标定技术姿态变换的多相机标定技术主要是针对类似于机器人等需要移动观测点的设备,该技术的主要思想是在多个摄像机的观测下计算目标的位置和姿态。

采用这种方法,在每个摄像机中通过已知的目标信息,得到不同的外部摄像机推导矩阵,再利用放缩运算和旋转运算等姿态变换技术,完成多相机标定模型。

2.基于几何约束的多相机标定技术几何约束的多相机标定技术主要侧重于兼容多目标跟踪用途的模型,并着重考虑摄像机的像素级别标定问题。

在此标定方法中,先标定单独的相机,然后通过特定的几何学计算方法,计算它们之间的相对位置和姿态关系,精度高、稳定性较强。

三、多摄像机标定技术的挑战和应用前景多摄像机标定技术中存在准确性和实用性方面的挑战。

准确性方面,主要是影响因素过多,如标定板的位置、姿态、标定点的选取等。

实用性方面,主要是部署难度比较大,且基于视觉实时计算成本较高。

因此,此类技术的应用场景分类比较明显,如移动机器人、VR虚拟现实、视频监视等领域。

多目视觉标定及测量方法

多目视觉标定及测量方法引言:多目视觉标定及测量方法是计算机视觉领域的重要研究方向之一,它在机器人导航、三维重建和虚拟现实等领域中具有广泛的应用前景。

本文将介绍多目视觉标定的基本概念和常用方法,并探讨多目视觉标定在测量中的应用。

一、多目视觉标定的基本概念多目视觉标定是指通过多个相机同时观测同一个场景,在一定条件下,利用已知的参数关系将相机坐标系与世界坐标系之间的转换关系求解出来。

在进行多目视觉标定之前,需要对相机进行内参标定和外参标定。

1. 内参标定相机的内参是指相机的内部参数,包括焦距、畸变系数和主点坐标等。

内参标定的目的是确定相机的内部参数,从而将像素坐标转换为相机坐标。

常见的内参标定方法有棋盘格标定法、球标定法和直线标定法。

2. 外参标定相机的外参是指相机的外部参数,包括相机的位置和朝向。

外参标定的目的是确定相机的外部参数,从而将相机坐标转换为世界坐标。

常见的外参标定方法有标定板法、视觉里程计法和三维重建法。

二、多目视觉标定的常用方法多目视觉标定的常用方法包括基于特征点的方法和基于特征线的方法。

1. 基于特征点的方法基于特征点的方法是指通过提取图像中的特征点,利用这些特征点之间的几何关系求解相机的内外参数。

常用的特征点包括角点、边缘点和尺度不变特征点。

常见的基于特征点的方法有张正友标定法和Tsai标定法。

2. 基于特征线的方法基于特征线的方法是指通过提取图像中的特征线,利用这些特征线之间的几何关系求解相机的内外参数。

常用的特征线包括直线、圆和椭圆。

常见的基于特征线的方法有直线标定法和圆标定法。

三、多目视觉标定在测量中的应用多目视觉标定在测量中具有广泛的应用,主要包括三维重建、立体匹配和虚拟现实等方面。

1. 三维重建多目视觉标定可以用于三维场景重建,通过多个相机同时观测同一个场景,可以获取更多的视角信息,从而提高三维重建的精度和稳定性。

在三维重建中,利用多目视觉标定得到的相机内外参数,可以将多个相机的观测结果进行融合,得到更准确的三维重建结果。

一种自动标定的方法是

一种自动标定的方法是引言在许多应用领域,自动标定都是非常重要的任务。

自动标定是指通过使用计算机算法和技术,从图像或传感器数据中推测,确定目标的位置、大小、形状等特性。

它在计算机视觉、机器人技术、虚拟现实等领域中都有广泛应用。

本文将介绍一种自动标定的方法,旨在提供一种有效且精确的解决方案。

方法- 步骤1: 准备标定目标在自动标定之前,需要准备一个用于标定的目标。

这个目标通常是一个已知大小、形状和特性的物体,例如一张包含棋盘格的标定板。

这个目标应该具有容易检测的特征,比如黑白相间的格子。

- 步骤2: 获取标定图像将相机对准标定目标,获取一系列的标定图像。

这些图像应该包含目标在不同姿态下的表现,例如旋转、平移、放缩等。

- 步骤3: 特征提取与匹配对于每张标定图像,使用特征提取算法提取图像中的关键点和描述符。

常用的特征提取算法包括SIFT、SURF、ORB等。

然后,将这些特征与已知标定目标的特征进行匹配。

- 步骤4: 参数求解通过对匹配的特征进行几何校正和计算,可以得到相机的内外参数。

内参数是关于相机自身特性的参数,例如焦距、主点坐标等;外参数是相机在世界坐标系下的姿态参数,例如旋转矩阵和平移向量。

- 步骤5: 校正和验证通过利用求解得到的相机内外参数,对图像进行校正。

这样可以消除图像中的畸变和眩光等不良因素。

同时,还可以使用一些已知大小和形状的物体进行验证,确保标定结果的精度和准确性。

实验结果与讨论我们对上述提到的自动标定方法进行了实验,并对实验结果进行了评估。

实验结果表明,该方法能够在不同场景下实现相对高精度的自动标定。

与传统手动标定相比,自动标定具有更高的准确性和效率。

然而,该方法仍然存在一些局限性。

首先,标定目标的选择和准备可能会对标定效果产生影响。

如果目标的特征不够明显或者存在噪声,可能会导致标定结果的不准确性。

其次,该方法对图像的质量和场景的光照条件要求较高,如果图像存在过曝或者过暗的情况,可能会影响标定的质量。

双目立体视觉测量系统的标定

双目立体视觉测量系统的标定杨景豪;刘巍;刘阳;王福吉;贾振元【期刊名称】《光学精密工程》【年(卷),期】2016(024)002【摘要】考虑传统的自标定方法虽然无需场景信息即可实现摄像机标定,但是标定精度较低,故本文提出了一种新的大视场双目视觉测量系统自标定方法.该方法无需高精度标定板或者标定物,仅需利用空间中常见的平行线和垂直线建立摄像机参数与特征线间的约束方程,即可实现摄像机的内参数与旋转矩阵标定;同时利用空间中距离已知的3个空间点即可线性标定两摄像机间的平移向量.通过标定实验对本文提出的方法进行了验证.结果表明:该方法标定精度能够达到0.51%,可以较高精度地标定双目测量系统.由于避免了大视场测量系统标定中大型标定物制造困难,以及摄像机自标定过程中算法冗杂,标定精度不高等问题,该方法操作简便,精度较好,适用于大视场双目测量系统的在线标定.【总页数】9页(P300-308)【作者】杨景豪;刘巍;刘阳;王福吉;贾振元【作者单位】大连理工大学教育部精密特种加工实验室,辽宁大连116024;大连理工大学教育部精密特种加工实验室,辽宁大连116024;大连理工大学教育部精密特种加工实验室,辽宁大连116024;大连理工大学教育部精密特种加工实验室,辽宁大连116024;大连理工大学教育部精密特种加工实验室,辽宁大连116024【正文语种】中文【中图分类】TP391;TB92【相关文献】1.基于双目立体视觉的大范围光笔测量系统研究 [J], 肖伟红;王彬;郑光辉;漆振华2.稳定高精度的双目立体视觉测量系统标定方法 [J], 马俊;3.稳定高精度的双目立体视觉测量系统标定方法 [J], 何万涛;梁永波;李景贺4.基于双目立体视觉的小型工件测量系统 [J], 赵琛; 江卫华5.双目立体视觉测量系统的精度分析 [J], 杨洪涛;何海双;李莉;张荣荣;张宇因版权原因,仅展示原文概要,查看原文内容请购买。

visionpro标定方法

VisionPro标定方法引言视觉系统在工业领域扮演着重要的角色,用于自动化生产和质量控制。

在视觉系统中,标定是一个关键的步骤,用于确保图像与实际物理环境之间的一致性。

Vi si on P ro是一种常用的视觉软件,提供了一套强大的标定工具,可以实现高精度的图像处理和测量。

本文将介绍V isi o nP ro标定方法的基本原理和步骤。

基本原理V i si on Pr o标定方法基于相机的内部参数和外部参数进行标定。

相机的内部参数包括焦距、主点坐标和畸变参数等,用于将图像坐标转换为相机坐标。

相机的外部参数包括平移向量和旋转矩阵,用于将相机坐标转换为世界坐标。

通过准确测量已知尺寸的标定板或标定物体,可以计算出相机的内部参数和外部参数,从而实现图像的几何校正和测量。

步骤一:设置标定板在进行标定前,需要准备一个标定板。

标定板可以是一个特制的标定物体,也可以是一个具有规则纹理的平面。

标定板上的特征点用于定位和测量。

V is io nP ro提供了多种标定板的选择,如棋盘格、圆点格、椭圆格等。

步骤二:采集图像在进行标定前,需要采集一系列包含标定板的图像。

图像的采集应覆盖整个工作空间,并且包含不同的姿态和视角。

图像的质量和数量直接影响标定的准确性。

步骤三:设置标定模型在V is io nP ro中,需要设置标定模型来指定标定的方法和参数。

标定模型包括内部参数模型和外部参数模型。

内部参数模型用于校正相机图像,在标定板和图像之间建立映射关系。

外部参数模型用于建立相机坐标和世界坐标之间的转换关系。

步骤四:运行标定工具在V is io nP ro中,可以通过标定工具来执行标定过程。

标定工具会自动识别标定板,并计算相机的内部参数和外部参数。

标定工具还会提供标定结果的评估指标,如重投影误差和标定误差等,用于评估标定的质量。

步骤五:验证标定结果在标定完成后,需要对标定结果进行验证。

可以采用一些已知尺寸的物体进行测量,比较测量结果与实际值的差异。

一种自动标定的方法有两种

一种自动标定的方法有两种自动标定(Automatic calibration)是计算机视觉领域中的重要技术之一,它用于将图像或视频中的物体准确地映射到现实世界的坐标系中。

自动标定技术可以提高计算机视觉系统的准确性和稳定性,广泛应用于机器人导航、虚拟现实和增强现实等领域。

目前,有两种常用的自动标定方法,分别是基于特征点匹配的方法和基于平面标定板的方法。

首先,基于特征点匹配的自动标定方法通过识别和匹配物体上的特征点来确定物体在图像中的位置和姿态。

这种方法首先通过图像处理技术提取物体上的特征点,如角点、边缘等,然后利用特征点之间的几何关系进行匹配。

最常用的特征点匹配算法是SIFT(尺度不变特征变换)和SURF(加速稳健特征),它们能够在图像中提取出具有旋转、尺度和光照不变性的特征点。

通过计算特征点的位置和姿态,可以得到物体在图像中的坐标系和姿态,在此基础上实现自动标定。

然而,基于特征点匹配的自动标定方法存在一些缺点。

首先,特征点提取和匹配的过程比较复杂,需要消耗大量的计算资源和时间。

其次,对于一些没有明显特征点的物体,特征点匹配方法的效果可能不理想。

因此,为了解决这些问题,研究者们提出了基于平面标定板的自动标定方法。

基于平面标定板的自动标定方法利用了平面标定板上的已知几何结构来实现自动标定。

这种方法首先将平面标定板放置在摄像机的视野中,然后利用图像处理技术提取平面标定板上的特征,如角点、边缘等。

接下来,通过计算标定板上特征点之间的几何关系,可以得到摄像机在现实世界的坐标系中的位置和姿态,从而实现自动标定。

相比于基于特征点匹配的方法,基于平面标定板的方法具有计算简单、效果稳定等优点。

然而,基于平面标定板的自动标定方法也存在一些限制。

首先,平面标定板必须放置在摄像机的视野范围内,如果标定板超出了视野范围,就无法实现自动标定。

其次,平面标定板上的特征提取可能受到光照条件的影响,导致标定结果不准确。

因此,在实际应用中,需要根据具体情况选择适合的自动标定方法。

面向多视角摄像头的多目标跟踪算法研究

面向多视角摄像头的多目标跟踪算法研究摘要:随着计算机视觉和人工智能技术的发展,多视角摄像头的应用正在逐渐增加。

多视角摄像头能够提供更全面的视角和更大的覆盖范围,但同时也带来了挑战,如何有效地跟踪多目标成为了一个重要的研究问题。

本文针对面向多视角摄像头的多目标跟踪算法进行研究,详细分析了目前常用的算法,并提出了一种基于深度学习的跟踪算法。

引言:多目标跟踪是计算机视觉中一项重要的任务,广泛应用于视频监控、智能交通系统、无人驾驶等各个领域。

传统的多目标跟踪算法主要包括基于卡尔曼滤波的方法、基于粒子滤波的方法和基于相关滤波的方法等。

然而,当面对多视角摄像头的挑战时,传统的算法可能无法准确跟踪目标。

因此,本文的目标是研究面向多视角摄像头的多目标跟踪算法,提出一种能够解决该问题的新方法。

多目标跟踪算法研究现状:目前,针对多目标跟踪问题已有许多研究。

其中,基于卡尔曼滤波的算法使用物体的运动模型对目标进行预测,并通过观测模型对预测结果进行修正。

然而,在多视角摄像头的场景中,物体的运动模型往往难以建立,使得该算法的效果受限。

另一种常用的算法是基于粒子滤波的方法,该方法通过使用一系列表示目标状态的粒子进行跟踪。

然而,由于多视角摄像头提供的视角不同,粒子滤波算法可能会面临粒子退化和重新采样问题,导致跟踪结果不准确。

基于相关滤波的方法通过将目标与模板进行相关计算,从而实现目标的跟踪。

然而,在多视角摄像头的场景中,物体的外观可能会发生变化,从而导致相关滤波算法难以准确跟踪目标。

基于深度学习的多目标跟踪算法:鉴于传统算法在多视角摄像头下存在的问题,本文提出了一种基于深度学习的多目标跟踪算法。

该算法利用深度神经网络提取多个摄像头的特征表示,并通过多层感知机对目标进行分类和跟踪。

具体而言,本文首先使用卷积神经网络对多个摄像头的图像进行特征提取。

然后,使用循环神经网络对时间序列中的特征进行建模,并预测目标的状态。

最后,使用多层感知机对目标的跟踪结果进行评估和修正。

相机自标定原理

相机自标定原理概述相机自标定是指通过图像数据来估计相机的内部参数和外部参数的过程。

在计算机视觉和计算机图形学领域,相机自标定是非常重要的技术之一。

它可以用于三维重建、姿态估计、虚拟现实等多个应用领域。

传统的相机标定方法需要使用特殊的校准板或者特殊的校准设备来进行,而相机自标定则不需要这些额外的设备,只需要使用普通场景中的图像就可以完成标定过程。

相机自标定方法能够极大地提高标定过程的便利性和实用性。

相机模型在了解相机自标定原理之前,我们首先需要了解相机模型。

常用的相机模型是针孔相机模型。

针孔相机模型假设光线从物体上每一点出发,穿过针孔后形成倒立的影像投射到成像平面上。

这个投影过程可以用一个透视投影矩阵来描述。

透视投影矩阵可以表示为:s * [u] [fx 0 cx 0] [X]= [0 fy cy 0] * [Y]= [0 0 1 0] [Z][1]其中,(u, v) 表示成像平面上的坐标,(X, Y, Z) 表示世界坐标系中的点,(fx, fy) 表示焦距,(cx, cy) 表示光心的坐标。

相机自标定原理相机自标定的目标是估计相机的内部参数(如焦距、光心等)和外部参数(如旋转矩阵、平移向量等)。

常用的相机自标定方法有基于单应性矩阵的方法和基于多视图几何的方法。

基于单应性矩阵的方法基于单应性矩阵的方法是通过图像中平面上不变性质来估计相机参数。

具体步骤如下:1.提取特征点:在图像中提取一些特征点,可以使用角点检测算法(如Harris角点检测)或者特征描述算法(如SIFT、SURF等)来提取。

2.匹配特征点:对于每一对图像之间的特征点,通过匹配算法来寻找它们之间的对应关系。

3.计算单应性矩阵:通过已知对应关系计算出单应性矩阵,单应性矩阵可以通过最小二乘法来估计。

4.分解单应性矩阵:通过对单应性矩阵进行分解,可以得到相机的内部参数和外部参数。

基于单应性矩阵的方法具有简单、快速的特点,但是对于非平面场景或存在畸变的图像可能会导致估计结果不准确。

一种多摄像头车辆实时跟踪系统

第14期2023年7月无线互联科技Wireless Internet TechnologyNo.14July,2023作者简介:崔瑞(1997 ),男,山东德州人,硕士研究生;研究方向:计算机科学技术㊂∗通信作者:贾子彦(1981 ),男,山西太原人,副教授,博士;研究方向:计算机科学,物联网㊂一种多摄像头车辆实时跟踪系统崔㊀瑞,贾子彦∗(江苏理工学院,江苏常州213000)摘要:随着城市人口的增加,越来越多的车辆使得城市的交通状况越来越复杂㊂针对传统的车辆检测中出现的跟踪车辆易丢失㊁跟踪精度低等问题,文章提出一种基于多摄像头的车辆实时跟踪检测方法,从多角度对运动车辆进行跟踪㊂在分析YOLOv5算法的基础结构后,文章针对车辆尺度变化大的特点,充分利用YOLOv5算法检测轻量化㊁速度快㊁实时性强的性质,并在此基础上利用多个摄像头之间的单应性矩阵来确定车辆位置的变化㊂结合颜色特征识别和车辆特征识别对车辆进行重识别,不仅提高了运行速度,而且满足了实时性和准确性的要求,有效解决跟踪车辆易丢失的问题,获得了较为成功的车辆实时跟踪效果㊂关键词:多摄像头;YOLOv5;单应性矩阵;特征识别中图分类号:TP391㊀㊀文献标志码:A0㊀引言㊀㊀随着城市现代化㊁智慧化进程不断加快,城市车辆的使用也越来越普遍,监控摄像随处可见㊂与此同时,车辆的系统管理正在向智能化过渡㊂多摄像头环境下的目标车辆的检测和跟踪已经日益引起高度重视,成为当下的研究热点㊂目前,智能视频监控主要有两大关键技术:一是对运动目标的识别跟踪;二是对目标行为的定义[1-2]㊂多摄像头车辆识别与跟踪是现代智能交通系统中研究的重点内容㊂在多摄像头的切换过程中,可能出现因目标车辆的外形检测发生变化导致错检㊁漏检的情况㊂尤其是在十字路口等事故高发地点,监控视频背景复杂㊁目标车辆遮挡等问题也对识别跟踪的准确度及误检率提出了巨大的挑战[3-4]㊂对于同一车辆在多摄像头重叠监控区域下的定位,不仅是区别于单一摄像头车辆的识别与定位,而且也是多个摄像头车辆的识别与定位的难点所在㊂对于同一车辆的识别既包括对同一车辆在不同摄像头监控区域下的匹配确定[5],同时也包括对车辆出现被遮挡状态时的判断,通过对车辆的行驶状态和被遮挡情况的分析判断,完成同一车辆在不同监控区域下的连续识别与跟踪㊂针对上述问题,本文提出一种多摄像头车辆实时跟踪系统㊂该方法首先采用车辆检测算法进行车辆的识别,同时结合多个摄像头之间的单应性矩阵来确定多个摄像头重叠区域下同一车辆的位置,然后结合HSV 颜色空间和车辆特征来进行车辆的匹配,提高车辆的识别匹配精度,最后将特征识别和全卷积网络的跟踪算法结合起来,实现多角度对车辆的实时跟踪㊂本文的应用场景以十字路口为主㊂本文提出的车辆跟踪流程如图1所示㊂图1㊀车辆跟踪流程1 多摄像头车辆识别与定位1.1㊀车辆检测模型㊀㊀YOLO算法系列在车辆检测方面有着非常显著的识别能力㊂近些年来,随着科技的发展和变迁, YOLO算法系列不断地更新换代,而YOLO系列近几年最新推出的YOLOv5模型则是更加适合当代工程和实际应用的需求㊂目前,YOLOv5算法有4个不同的版本,每个版本之间的网络结构有些许的差别[6]㊂本文采用的YOLOv5s算法是4个版本中网络最小的版本,主要以检测像车辆等之类的大目标为主㊂相对于其他的版本,YOLOv5s的检测速度快,识别准确度比其他算法高,非常适合在嵌入式设备中应用㊂本文对出现在交通视频中的各种交通车辆进行检测,选择YOLOv5s 结构进行研究㊂YOLOv5s网络主要有3个组成部分㊂(1)Backbone:提取特征的主干网络,主要用来提取图片中的信息以供后面的网络使用㊂常用的Backbone有resnet系列(resnet的各种变体)㊁NAS网络系列(RegNet)㊁Mobilenet系列㊁Darknet系列㊁HRNet系列㊁Transformer系列和ConvNeXt㊂主要结构包括focus㊁conv㊁bottle-neckcsp和空间金字塔层㊂(2)Neck(空间金字塔池化):它是通过将图像特征进行糅合并重新组合成一个新的网络结构,将提取到的图像特征传递到预测层㊂(3)Head:主要是针对图像的特征进行预测,然后生成检测框并且预测其类别㊂本文的车辆检测方案使用改进后的YOLOv5s检测算法对车辆数据集进行训练,并引入CA注意力机制,用改进后的检测模型对相关的车辆数据集进行测试,经过实验验证提高了检测精度,更好地完成车辆检测目标㊂1.2㊀多摄像头空间模型的确立㊀㊀单应性矩阵能够将十字路口4个摄像头之间的相互关系形象生动地表达出来,通过将拍摄到的同一车辆不同角度的图片进行像素坐标之间的变换,能够实现车辆在不同监控角度下的像素位置的转换,从而实现同一车辆在不同监控视角下的车辆位置的定位㊂在通常情况下,单应性矩阵一般采用人工标定的方法来进行特征点之间的匹配,但是由于人工标定会产生一定的误差,导致得出的单应性矩阵也存在一定的误差㊂因此,鉴于这一问题,本文采用精确的棋盘格来求取匹配点,结合张正友棋盘标定的方法,求取相对准确的单应性矩阵㊂首先,打印一张8ˑ8的黑白相间的棋盘方格;其次,将打印好的棋盘格放置在十字路口的中间,用4个方向的摄像头对其进行拍摄;然后,对4个视角下的棋盘格图片进行特征点的检测;最后,根据棋盘格中获取的匹配点求取4个摄像头之间的单应性矩阵㊂通过模拟十字路口4个摄像头同时对视野区域内的棋盘格上特征点求取单应性矩阵,对同一标定点在4个摄像头之间的空间位置进行定位㊂本文根据实际十字路口的环境,按照一定的比例搭建了十字路口的实际模型进行研究㊂本文采用UA-detrac车辆检测数据集与自建数据集进行三维空间模型构建,求取单应性矩阵㊂在自建数据库中,在模型上放置标记物进行标记,按照东西南北4个方向分别标定为1㊁2㊁3㊁4号摄像头,同时以第3摄像头为基准,分别求取1㊁2㊁4号摄像头与该摄像头的转换矩阵H13㊁H23㊁H43㊂自建数据库的标定如图2所示,红圈表示选取的特征匹配点㊂图2㊀人工标定图其他视角到该视角的转换矩阵为:H13=0.00020.00140.0025-0.00140.00840.0011-0.00120.00040.0001éëêêêùûúúúH23=0.0015-0.00230.0028-0.00430.00550.0012-0.0020-0.00280.0010éëêêêùûúúúH43=-0.00580.00140.0063-0.00940.00660.0066-0.001000.0010éëêêêùûúúú经过本文实验证明,与人为标定特征点求取单应性矩阵的方法相比,用棋盘标定通过特征点之间的匹配进行单应性矩阵的求取精度会更高,这是由于相对于人工标定,采用棋盘标定的方法,匹配点的数量更多,相互之间匹配点的位置关系会更加准确,减少了人为标定方法产生的误差,同时还提高了求取单应性矩阵的准确性㊂1.3㊀车辆颜色特征匹配㊀㊀车辆的颜色特征能够更加直观地反映车辆的外部整体信息,通常采用RGB颜色空间与HSV颜色空间来提取车辆的颜色特征㊂RGB 颜色空间和HSV 两个颜色空间虽然都是用来表示图像的颜色特性㊂相比而言,RGB 颜色空间获取车辆的颜色特征更加准确㊂HSV 颜色空间更容易被人眼所接受,从而更方便人们观察㊂因此,本文首先通过RGB 颜色空间获取车辆的全局外观颜色特征,之后再转换到HSV 颜色空间进行颜色特征的量化,车辆的颜色特征可以直观地反映车辆的全区信息,由于HSV 颜色空间可以对颜色空间进行量化,降低颜色空间的特征维数,从而减少提取匹配的计算量,提高算法的运算效率㊂HSV 颜色空间具有自然性,与人类的视觉神经感知接近,反映了人类对于色彩的观察,同时有助于查找图像㊂由此分析,本文采用了基于HSV 颜色空间模型对车辆的全局外观进行颜色提取㊂通常来说,拍摄到的车辆图像基本都是以RGB 的方式保存㊂图像从RGB 颜色空间转换到HSV 空间㊂RGB 颜色空间将图片进行R㊁G㊁B 的3种通道的划分,设(r ,g ,b )分别是一个颜色的红㊁绿和蓝颜色的坐标,他们的值是0~1的实数,令max 等于r ㊁g ㊁b 3个分量中的最大值,min 等于r ㊁g ㊁b 3个分量中的最小值,则从RGB 颜色空间到HSV 颜色空间的变换过程可用如下公式来表示:h =00if max =min 600ˑg -b max -min +00,if max =r and g ȡb 600ˑg -b max -min+3600,if max =r and g <b 600ˑg -b max -min +1200,if max =g 600ˑg -b max -min +2400,if max =b ìîíïïïïïïïïïïïïs =0,if max =0max -min max =1-minmax,otherwise{ν=max输入的车辆图片的颜色特征通常用颜色直方图来表示,它的算法简单,速度较快㊂它具有尺度平㊁平移和旋转不变形的特征,在特征提取㊁图像分类方面有着非常好的应用㊂本文通过HSV 颜色空间对多组相同车型不同颜色和相同颜色不同车型的车辆分组图片进行颜色特征的提取和匹配㊂本研究对UA -detrac 车辆检测数据集和自建模型拍摄的多角度下不同颜色的车辆进行颜色特征提取,并计算其颜色相似度㊂对比结果如表1所示㊂表1㊀颜色特征相似程度对比结果测试数据颜色特征相似度第一组红色车辆车辆1-车辆20.975车辆1-车辆30.964车辆1-车辆40.834车辆1-车辆50.435第二组蓝色车辆车辆1-车辆20.954车辆1-车辆30.963车辆1-车辆40.945车辆1-车辆50.364第三组橙色车辆车辆1-车辆20.986车辆1-车辆30.963车辆1-车辆40.895车辆1-车辆50.382通过表1的颜色特征相似度的结果可以看出,颜色特征相似度越大,表示两辆车之间的相似程度越高㊂相同的一辆车在4个方向下的相似度的范围均在0.8以上,颜色相似的两辆车之间的相似度均在0.8以下㊂颜色不同但是车型相同的两辆车之间的相似度均在0.6以下㊂由此可知,颜色特征可以用来区分车型相同或相似但颜色差别大的车辆㊂同一辆车在不同摄像头的监控视野内由于拍摄角度的问题会出现导致同一辆车的颜色特征存在一定的差异的情况发生㊂若是直接将相似度设置为0.8可能会存在在不同的监控角度下,同一车辆被漏检的情况㊂若阈值设置得过低又可能误检一些颜色相近的车辆㊂只是颜色特征识别并不能满足不同角度下车辆的匹配,存在一定的缺陷,因此还需要通过局部特征的匹配来提高匹配的精度㊂1.4㊀SURF 特征匹配㊀㊀鉴于颜色特征能针对局部特征对于颜色信息不区分这一缺点进行补充,而SURF 的特点是具备光线照射㊁角度的调整以及尺寸不变性,速度比较快而且相对比较稳定㊂由于仅是局部特征或者仅是全局特征很容易发生在多摄像头切换角度时出现跟踪错误的信息,从而导致跟踪失败㊂因此,本文将全局特征和局部特征结合起来,从而提高匹配的准确性㊂相对而言,SURF 特征提取的数量虽然比SIFT 特征提取少很多,但还是存在错误匹配的情况㊂因此,本文根据SURF 的算法特性,特征匹配点之间的欧式距离越近,相似度越高,匹配得越准确㊂对匹配点之间的欧氏距离进行筛选,选择合适的阈值,对欧式距离进行排序,从而选出最优的SURF 特征匹配点,减少匹配的误差,降低错误匹配的概率㊂2 融合多特征与全卷积孪生网络的跟踪算法㊀㊀因为在多摄像头切换角度时对同类型的车辆误检㊁漏检的情况时有发生,所以本文对全卷积孪生网络跟踪算法中的图像特征向量相似度与多特征融合进行改进,并引入注意力通道机制网络结构,针对错检㊁漏检的情况进行改进,提升准确度㊂使用上述提到的HSV颜色特征提取和SURF特征作为匹配的特征,与全卷积孪生网络跟踪模型计算的相似度进行结合,即使在发生目标车辆部分遮挡的情况下,在切换到另一角度的摄像头时仍然能对同一车辆继续进行定位跟踪㊂在出现完全遮挡的情况或者在多摄像头角度切换后,目标车辆短时间内未再次出现的情况下仍然继续工作,在等待目标车辆再次出现时,继续对目标车辆进行定位检测与跟踪,以保证目标车辆的持续跟踪㊂跟踪模块首先利用全卷积网络训练的跟踪模型提取目标车辆图片,通过提取检测车辆图像的特征向量,计算目标车辆与待检测车辆之间的相似度,然后通过HSV颜色空间得出车辆的全局特征的相似度,最后对SURF特征进行车辆的局部特征匹配,过滤掉错误的匹配点,提高准确度,因为SURF特征点之间的距离长短表示特征点之间匹配值的高低,所以在所有检测到的车辆中选择特征点之间距离最短的也就是匹配值最小的目标车辆,对目标车辆进行定位,并利用上述计算的3种目标车辆判断的值对初定位的目标车辆进行阈值比较处理,从而最终定位目标车辆㊂目标车辆实验结果如表2所示㊂表2㊀在自建数据库上的实验结果(单位:%)车辆ID Car1Car2Car3Car4Car5定位成功率96.8497.2393.4297.2689.73跟踪成功率94.1593.5889.5694.4588.533 结语㊀㊀本文提出的多摄像头车辆实时跟踪系统,通过多个摄像头之间的单应性矩阵对十字交通路口的车辆进行定位,并结合颜色特征和SURF特征进行匹配,利用多特征和全卷积孪生网络相结合的跟踪模型,得到最终的检测结果,在车辆的检测和跟踪程度上有一定的提高㊂该系统在一定程度上解决了因遮挡问题造成的误检㊁漏检的问题,提高了检测精度和跟踪的准确性㊂根据实践表明,本文提出的方法效果比单一摄像头的检测方法更加可靠㊂参考文献[1]刘建.基于多摄像头的视频跟踪智能算法研究[D].上海:东华大学,2017.[2]罗凡波,王平,梁思源,等.基于深度学习与稀疏光流的人群异常行为识别[J].计算机工程,2020 (4):287-293.[3]李成美,白宏阳,郭宏伟,等.一种改进光流法的运动目标检测及跟踪算法[J].仪器仪表学报,2018 (5):249-256.[4]王朝卿.运动目标检测跟踪算法研究[D].太原:中北大学,2019.[5]张富凯,杨峰,李策.基于改进YOLOv3的快速车辆检测方法[J].计算机工程与应用,2019(2):12-20.[6]鲍金玉.基于视频分析的车辆智能检测技术研究[D].北京:北方工业大学,2019.(编辑㊀王永超)A real time vehicle tracking system with multiple camerasCui Rui Jia Ziyan∗Jiangsu University of Technology Changzhou213000 ChinaAbstract With the increase of urban population year by year more and more vehicles make urban traffic conditions more and more complicated.Aiming at the problems of tracking vehicles easy to lose low tracking rate and poor real-time performance in traditional vehicle detection a multi-camera based vehicle real-time tracking detection method is proposed to track moving vehicles.After analyzing the basic structure of the YOLOv5algorithm and considering the large scale variation of vehicles the YOLOv5algorithm is fully utilized to detect the properties of lightweight fast speed and strong real-time.On this basis the homography matrix between multiple cameras is used to determine the changes of vehicle bining color feature recognition and vehicle feature recognition vehicle rerecognition not only improves the running speed but also meets the requirements of real-time and accuracy effectively solves the problem that tracking vehicles are easy to lose and finally achieves a more successful real-time vehicle tracking effect.Key words multiple cameras YOLOv5 monography matrix feature recognition。

基于机器视觉的无人机目标标定与追踪技术研究

基于机器视觉的无人机目标标定与追踪技术研究随着技术的不断进步,无人机在各个领域的应用越来越广泛。

其中,机器视觉技术作为一种重要的感知和控制手段,为无人机的目标标定和追踪提供了一种有效的解决方案。

本文将就基于机器视觉的无人机目标标定与追踪技术进行深入研究,并介绍其工作原理、关键技术及应用前景。

无人机目标标定与追踪技术是指通过机器视觉系统对地面、空中或水面上的目标进行自动检测、识别和跟踪。

这项技术的应用场景非常广泛,包括监控、搜索与救援、交通管制、农业等领域。

首先,无人机目标标定与追踪技术需要借助机器视觉系统来实现。

机器视觉系统包括图像采集设备(如相机或传感器)、图像处理算法和目标跟踪算法。

图像采集设备负责获取无人机所处环境的图像或视频流,而图像处理算法则负责对图像进行预处理、目标检测和特征提取。

目标跟踪算法则根据预先设定的规则和策略,对目标进行跟踪、预测和控制。

在无人机目标标定与追踪技术中,目标检测是一个非常关键的环节。

传统的目标检测方法主要依靠手工设计的特征来实现,如Haar特征、HOG特征等。

然而,这些方法在复杂环境下往往效果不理想,且对目标位置、尺度以及外观变化比较敏感。

近年来,基于深度学习的目标检测方法(如YOLO、SSD 等)的出现,极大地提高了目标检测的准确率和效率。

这些方法通过构建深度神经网络,可以自动学习和提取图像特征,从而实现更加准确和鲁棒的目标检测。

目标跟踪是无人机目标标定与追踪技术中的另一个重要环节。

目标跟踪的目的是在一系列连续的图像帧中,实时准确地跟踪目标的位置。

常见的目标跟踪方法包括基于特征的方法(如颜色特征、纹理特征等)和基于深度学习的方法。

前者通过提取目标的某些特征,如边缘、颜色或纹理等,然后在后续帧中搜索相似的特征来实现目标的跟踪。

而后者则采用深度学习模型,通过训练大量的图像数据来实现目标的自动跟踪。

无人机目标标定与追踪技术除了在军事领域的侦查与打击中具有重要意义外,还在民用领域有着广泛的应用前景。

不同分辨率相机 标定方法

不同分辨率相机标定方法不同分辨率相机标定方法一、引言相机标定是计算机视觉领域的重要技术之一,其目的是确定相机的内部参数和外部参数,从而提供准确的图像信息用于后续图像处理和分析。

随着相机技术的不断发展,现如今市面上存在着各种不同分辨率的相机,因此需要针对不同分辨率的相机进行相应的标定,本文将介绍几种常见的相机标定方法。

二、基于棋盘格的相机标定方法基于棋盘格的相机标定方法是目前最常用的一种标定方法。

该方法通过在棋盘格上精确地标定一些已知的3D点,然后在相机拍摄到的图像上检测这些3D点对应的2D点,最后通过求解相机的内外参数来实现标定。

该方法具有简单、准确的优点,适用于不同分辨率的相机。

三、基于圆点阵列的相机标定方法基于圆点阵列的相机标定方法是一种相对较新的标定方法。

该方法通过在特定的圆点阵列上标定已知的3D点,然后在相机拍摄到的图像上检测这些3D点对应的2D点,最后通过求解相机的内外参数来实现标定。

与基于棋盘格的相机标定方法相比,基于圆点阵列的方法可以提供更高的标定精度,并且对于不同分辨率的相机同样适用。

四、基于特征点的相机标定方法基于特征点的相机标定方法是一种常见的非标定标定方法。

该方法通过在场景中检测并跟踪一些特征点,然后根据这些特征点的运动轨迹和相机的运动估计相机的内外参数。

该方法适用于实时标定和移动设备标定,对于不同分辨率的相机同样适用。

五、基于多视角几何的相机标定方法基于多视角几何的相机标定方法是一种高级的标定方法。

该方法通过同时使用多个相机进行标定,通过求解多个相机的内外参数来实现标定。

该方法适用于需要高精度标定的场景,对于不同分辨率的相机同样适用。

六、总结本文介绍了几种常见的相机标定方法,包括基于棋盘格的方法、基于圆点阵列的方法、基于特征点的方法以及基于多视角几何的方法。

这些方法都适用于不同分辨率的相机,并且各自都具有一定的优势和适用场景。

在实际应用中,可以根据具体需求选择合适的相机标定方法,以获得最佳的标定效果。

一种多相机视觉检测设备的标定方法[发明专利]

![一种多相机视觉检测设备的标定方法[发明专利]](https://img.taocdn.com/s3/m/ed235d0c6294dd88d1d26bdd.png)

专利名称:一种多相机视觉检测设备的标定方法专利类型:发明专利

发明人:叶琨,曹军旗,冯宇深

申请号:CN201910477867.9

申请日:20190603

公开号:CN110084861A

公开日:

20190802

专利内容由知识产权出版社提供

摘要:本发明公开了一种多相机视觉检测设备的标定方法,包括以下步骤:在检测设备的下方放置标定板,标定板包括普通标志圆和特征标志圆,特征标志圆尺寸明显区别于普通标志圆;与特征标志圆距离最近的普通标志圆为标记圆;检测设备拍摄标定板,选取任意一部相机拍摄的标定板图像记为待处理图像,对待处理图像进行图像处理,获取待处理图像中普通标志圆、特征标志圆的轮廓信息;对轮廓信息进行椭圆拟合,作直线l;对多个普通标志圆的圆心坐标,再次进行椭圆拟合,得出点O;过点O作直线l,直线l、直线l的交点记为O,求得检测设备中心的像素坐标O;本方法能够准确获取检测设备中心的像素坐标以及图像像素当量。

申请人:易思维(杭州)科技有限公司

地址:310051 浙江省杭州市滨江区滨安路1197号3幢495室

国籍:CN

更多信息请下载全文后查看。

高速公路动态环境下的摄像机自标定

高速公路动态环境下的摄像机自标定摄像机自标定技术是一项重要的技术,它可以对高速公路监控系统进行更加准确和高效的监控。

随着科技的发展,自标定技术在高速公路监控系统的应用也越来越广泛。

下面我们将详细讨论一下高速公路动态环境下的摄像机自标定技术。

一、摄像机自标定技术的基本原理摄像机自标定技术可以通过计算机视觉技术和机器学习算法,实现摄像机内部参数和外部位置矩阵的自动标定。

它通过多视角进行角点提取,构建摄像机畸变模型和投影模型,使用RANSAC算法优化提取出的角点,得到摄像机外部位置和内部参数。

摄像机自标定技术是一种相对复杂的技术,需要涉及计算机视觉和机器学习等多个领域。

二、高速公路环境下的挑战高速公路环境下的摄像机自标定技术面临着一些挑战。

首先,高速公路的交通流量大,车辆种类多样,道路宽度也不同。

这就需要摄像机能够准确识别道路上的车辆,找到汽车的轮廓,并且能够自动标定每辆车。

其次高速公路行驶速度快,摄像机的视野范围很大,因此需要高时间和空间的处理能力,并提高精度和速度的平衡。

最后,高速公路环境下摄像机需要具备防抖功能,防止震动对标定结果的干扰。

三、高速公路摄像机自标定的实现为了实现高速公路摄像机自标定,我们应用了一种基于多视角的摄像机自标定技术。

该技术包括以下步骤:1.角点提取:通过图像处理技术,对多层视角的图片进行特征提取和大量筛选,得到局部的角点等特征,也就是标志点。

2.标定参数计算:获得摄影机拍摄图像的内部参数和外部位置矩阵,相应的得出其映射关系,建立采集图像与摄像机坐标系之间的映射模型。

3.误差优化:通过非线性最小二乘法将摄像机重映射矩阵进行构建、分解和优化,使它更加精确地标准。

如果我们想要在更复杂的高速公路环境下使用摄像机自标定技术,需要注意以下几点:1.多角度拍摄:不同视角可以提供不同的信息。

因此,需要多角度拍摄、多角度控制,以提高模型精度和准确性。

2.映射模型构建:摄像机自标定技术需要先建立一个正确的映射模型,然后才能进行姿态估计和标定。

多摄像头视觉定位与跟踪技术研究与实现

多摄像头视觉定位与跟踪技术研究与实现摄像头作为一种常见的传感器,被广泛应用于各个领域,如安防监控、智能交通系统、机器人导航等。

在这些应用场景中,摄像头常常需要进行目标的定位与跟踪。

近年来,随着计算机视觉技术的快速发展,多摄像头视觉定位与跟踪技术也得到了广泛的研究与实现。

多摄像头视觉定位与跟踪技术可以帮助摄像头实现准确的目标定位与跟踪,提高系统的智能性和准确性。

本文将从多摄像头视觉定位与跟踪的基本原理、技术方案以及实现方法等方面进行阐述。

在多摄像头视觉定位与跟踪技术中,常见的基本原理是利用多个摄像头同时拍摄目标,通过图像处理和分析算法,将目标在图像中的位置信息转化为实际世界坐标系下的位置。

首先,需要对每个摄像头进行标定,获取摄像头的内参和外参参数。

然后,通过特征点匹配或者轮廓检测等方法,将目标在不同摄像头图像中的位置进行对应。

最后,根据摄像头的位置和外参参数,利用三角测量等方法计算目标在实际世界坐标系下的位置。

在多摄像头视觉定位与跟踪技术的实现中,常见的技术方案包括基于特征点匹配的方法、基于轮廓检测的方法以及基于深度学习的方法等。

特征点匹配是一种经典的图像处理算法,通过寻找图像中具有明显特征的点,并在不同图像中进行匹配,从而计算目标在不同摄像头图像中的位置。

轮廓检测则是通过检测目标的外形轮廓,并在不同摄像头图像中进行比对,实现目标的跟踪和定位。

而基于深度学习的方法则是通过训练神经网络模型,实现对目标的自动定位与跟踪。

在实际应用中,多摄像头视觉定位与跟踪技术的实现还需要考虑一些问题,如摄像头的布局与位置选择、目标在不同摄像头之间的切换以及光照变化等。

摄像头的布局与位置选择是影响系统性能的重要因素之一。

合理布局摄像头可以提高目标的可见性,及时发现和跟踪目标。

目标在不同摄像头之间的切换需要考虑到目标在不同摄像头之间的连续性,以减少跟踪中的漏检和误检。

光照变化是摄像头视觉定位与跟踪中常见的问题之一,需要通过光照补偿等方法进行处理,提高系统的鲁棒性和稳定性。

一种农机自动驾驶控制系统角度传感器自动标定方法与流程-概述说明以及解释

一种农机自动驾驶控制系统角度传感器自动标定方法与流程-概述说明以及解释1.引言1.1 概述随着农业机械化的发展和现代农田管理的需求增加,农机自动驾驶控制系统在农业生产中扮演着越来越重要的角色。

角度传感器作为农机自动驾驶控制系统中的重要组成部分,在确保农机行驶和作业的准确性和安全性方面起着关键作用。

因此,角度传感器的准确标定是实现农机自动驾驶控制系统的重要前提。

传统的角度传感器标定方法通常需要人工干预,且耗时耗力,无法满足农机自动驾驶控制系统对高效和准确的要求。

因此,本文提出了一种基于自动化技术的角度传感器自动标定方法与流程,旨在实现对角度传感器的快速、精确和可靠的标定。

本文介绍了该自动标定方法的基本原理和实施步骤,并详细描述了角度传感器自动标定的流程。

主要包括数据采集、数据处理和标定参数计算等关键步骤。

通过采集大量的角度传感器数据,利用自动化算法对数据进行处理和分析,并基于标定参数计算公式,可以准确地获得角度传感器的标定结果。

相比传统的人工标定方法,该自动标定方法具有高效、准确和可靠的特点。

本文的研究成果对于提高农机自动驾驶控制系统的精准度、安全性和稳定性具有重要意义。

通过自动化的角度传感器标定方法,可以有效地提高农机的自动驾驶控制精度,降低人工干预的成本和风险。

同时,该方法也为农机自动驾驶控制系统的推广和应用提供了可行的解决方案。

接下来的章节将详细介绍角度传感器自动标定方法和流程,以及实验结果和分析。

通过对该方法的探索和验证,我们希望能为农机自动驾驶控制系统的研究和应用提供有益的参考和借鉴。

文章结构是指文章的整体安排和组织方式,它将帮助读者更好地理解你的论述和逻辑。

本文的结构主要分为引言、正文和结论三个部分。

引言部分旨在引入文章的话题,并对文章的内容进行概述。

在引言的最后一段,可以明确提到文章结构的安排,如下所示:1.2 文章结构本文将从角度传感器自动标定方法和角度传感器自动标定流程两个方面展开论述。

机器视觉——多相机视觉系统的坐标系统标定与统一及其应用

机器视觉——多相机视觉系统的坐标系统标定与统一及其应用来源:运动控制与机器视觉物联网导语:随着机器视觉应用的日益广泛,大幅面多相机视觉系统的需求越来越多,主要应用方向为大幅面高精度的定位与测量和场景拼接等。

多相机视觉系统的难点在于多相机坐标系的统一. 可以分为两类,一是相机视野间无重叠部分,二是相机视野间有重叠部分。

相机间无重叠部分的情况主要用于大幅面多相机高精度的定位和测量,相机间有重叠部分的情况主要用于场景的拼接等。

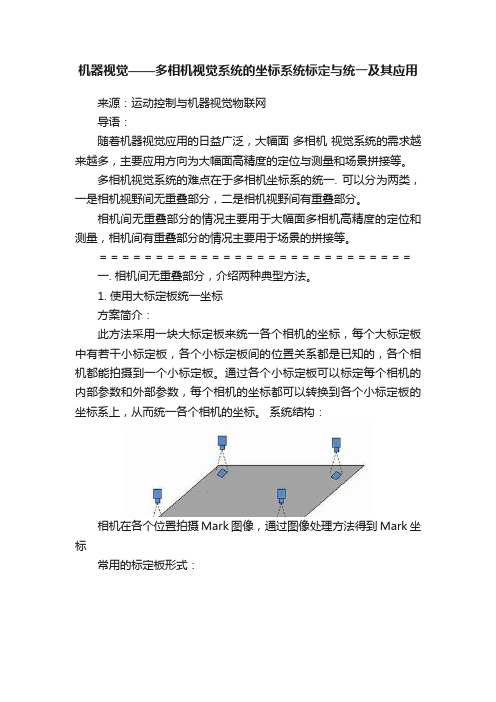

============================一. 相机间无重叠部分,介绍两种典型方法。

1. 使用大标定板统一坐标方案简介:此方法采用一块大标定板来统一各个相机的坐标,每个大标定板中有若干小标定板,各个小标定板间的位置关系都是已知的,各个相机都能拍摄到一个小标定板。

通过各个小标定板可以标定每个相机的内部参数和外部参数,每个相机的坐标都可以转换到各个小标定板的坐标系上,从而统一各个相机的坐标。

系统结构:相机在各个位置拍摄Mark图像,通过图像处理方法得到Mark坐标常用的标定板形式:上图所示为单个标定板图像,大标定板由若干单个标定板组成,标定板的大小和数量根据实际测量情况而定。

多个标定板组合示意图:案例分析:(1) 检测目标分析测量产品需要若干个测量指标。

如下图所示。

(2)图像获取采用4只相机来完成所有项目的测量,分别拍到的照片如下图所示。

(3)检测流程先分别利用每张图的两条垂直边计算出它们的交点,那么得到的4个交点就可以算出L1和L2的值,如下图所示(以右下角相机为例)。

注意事项:此种方法需要将多只相机的坐标统一到一个坐标系中,并且单一相机还要做自己的校准,保证精度。

根据检测要求,设置取多少个点作为参考,但是这影响测试的时间,需酌情考虑。

应用领域:手机和平板电脑面板尺寸的检测。

2. 使用相对运动统一坐标方案简介:此方法采用相机和被测物之间的相对运动来统一相机的坐标,相机和被测物只要一方运动即可,记录各个位置的坐标,然后通过数学运算来统一坐标。

多摄像头系统的物体三维重建算法设计与实现

多摄像头系统的物体三维重建算法设计与实现随着科技的不断发展,多摄像头系统的应用越来越广泛。

多摄像头系统可以通过同时使用多个相机来获取物体的多个视角图像,并通过特定的算法进行处理,从而实现物体的三维重建。

本文将介绍多摄像头系统的物体三维重建算法的设计与实现。

一、多摄像头系统的物体三维重建算法设计1. 视角标定与匹配物体三维重建的第一步是对多个相机的视角进行标定,以确保每个相机的视野范围和角度准确。

这可以通过使用一些标定模型或校准板来实现。

一旦相机的视角被准确标定,接下来的步骤就是对多个视角的图像进行匹配,以识别出物体在不同图像中的特征点。

2. 特征点提取和匹配在每个相机的图像中,使用特征点提取算法(如SIFT、SURF或ORB)来识别出物体的显著特征点。

然后,使用特征点匹配算法(如基于特征描述子的匹配算法)来找到不同视角图像中相对应的特征点。

这些特征点的匹配可以帮助我们在不同视角中准确确定物体的位置和姿势。

3. 三维点云重建通过使用相机的标定信息和匹配的特征点,可以将多个视角的图像转换为三维点云。

三维点云表示物体的三维位置信息,其中每个点都具有其在世界坐标系中的坐标值。

常用的三维点云重建算法包括多视图三角测量和立体匹配。

4. 点云融合和优化在将多个视角的图像转换为三维点云后,我们需要将这些点云进行融合和优化。

融合算法可以使用ICP(Iterative Closest Point)算法或基于图优化的算法,将多个点云合并到一个全局坐标系中。

优化算法可以消除点云中的误差和噪声,使得重建的三维模型更加准确。

二、多摄像头系统的物体三维重建算法实现1. 硬件配置和相机标定在实现多摄像头系统的物体三维重建算法之前,需要将多个相机进行配置并进行准确的标定。

这包括确定摄像头的位置、角度和相机内外参数等。

相机标定可以使用已有的标定工具箱(如OpenCV)来实现。

2. 特征点提取和匹配使用特征点提取算法(如OpenCV中的SIFT、SURF或ORB算法)提取每个相机图像中的特征点,并使用特征描述子对这些特征点进行描述。

基于双目视觉的室内定位标定新方法

基于双目视觉的室内定位标定新方法邢亚斌;王振岭【摘要】随着全球导航卫星系统的发展,位置服务已经逐渐渗透到人们日常生活以及工作之中,并成为必不可少的一部分,越来越多的人开始习惯使用位置服务,并对其产生依赖,并且,室内导航定位应用需求日益增加;目前,基于多目视觉原理的室内定位导航技术已经成为众多技术领域的研究热点,且逐步成熟;室内导航定位中,为获取目标的准确位置,相机的标定过程是重中之重,标定精度对最终定位精度有着决定性作用;然而,当有气液界面存在时,由于不同介质折射率不同,视线在传播过程中将发生偏折,现有的线性标定技术不再适用,并成为制约室内特殊场景定位(如水下机器人作业)的主要技术障碍;针对有气液界面的条件提出了一种新的标定方法,对界面位置进行精确定位,并修正了线性针孔模型,能够有效解决有气液界面存在条件下不能准确标定的难题,克服了封闭体内测量时无法进行现场标定的困难;为验证标定方法的可行性与可靠性,进行了数值模拟,模拟结果显示,此方法误差较小,满足室内定位中的标定精度要求.%With the development of global navigation satellite systems,location based services has increasingly become an indispensable part of our personal and professional lives,as more and more people become accustomed to using positioning technology.With the increasing demand for indoor navigation applications,indoor positioning navigation technology based on multi-visual principles has become the center of many technical research efforts,and has matured throughout the past few years.However,when gas-liquid interface is involved,the linear calibration technique that is currently being used is no longer applicable due to the refraction of the line of sight during the propagation process,and thereforebecomes the major technical harrier restricting indoor positioning under special circumstances (such as underwater robot operations).This paper proposes a new calibration method that accurately locates the interface position and corrects the linear pinhole model,which can effectively ensure the accuracy of calibration under the circumstances of gas-liquid interfaces,and make field calibration possible during closed measurement.To verify the feasibility and reliability of this calibration method,this paper conducted numerical simulation.Results show small margin of error and indicates that this method satisfies the calibration accuracy requirements in indoor positioning.【期刊名称】《计算机测量与控制》【年(卷),期】2017(025)010【总页数】5页(P281-284,309)【关键词】室内定位;双目视觉;气液界面;标定【作者】邢亚斌;王振岭【作者单位】中国电子科技集团公司第五十四研究所,石家庄050081;卫星导航系统与装备技术国家重点实验室,石家庄050081;中国电子科技集团公司第五十四研究所,石家庄050081;卫星导航系统与装备技术国家重点实验室,石家庄050081【正文语种】中文【中图分类】TP3近些年来,信息技术快速发展,各类电子智能设备日渐普及,而卫星定位导航技术性能稳定、成本低廉、定位精度准确,被越来越多的人所熟悉和使用。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

即使跟踪 目标在 其运动 区域 内的投影 误差期 望最小 。

o jcsi p o oe , hc e d op ec l rt npo eso fr t n a dc nc o e aewi xsig be t s rp sd w ihn e sn r—ai ai rc s f nomai n a o p rt t e it b o i o h n

{ } 4 一 标定 计的 优 题 ( , ),N ≥ , 般 估 最 化问 为: pp

呼∑『 p)( p ,t 日 V ( + )s_ i ( 一 一 _= p f

( 3 )

在 本 文 中 , 用 各 个 视 角 中 跟 踪 目标 的 位 置 作 为 控 制 点 进 行 单 应 矩 阵 的 标 定 。 时 控 制 点 的 观 测 误 差 和 系统 使 此

综 述 了各 种线性及 迭代方 法 , 虽然 在降低标 定误差 时取得 了 良好 的结果 , 但却都 在控制点 测量较为 准确并且 分布

合 理 的 前 提 下 。因此 多 视 角 跟 踪 应 用 前 依 然 需 要 额 外 的 标 定 阶 段 , 难 以 做 到 对 单 应 投 影 矩 阵 动 态 的调 整 ,限 制 更 了 系 统 的应 用 场 景 和 功 能 。

t o r s l - a i r t o a s a v r mpo t n o e i o h t e d p o me ta d t e o r to f mu t- i w i n o e f c lb a i n pl y e y i - r a t r l n b t h e l y n n h pe a i n o li v e -

第 1 0卷 第 3期

21 0 2年 6月

信 息 与 电 子 工 程

I NF0RM ATI ON AND ELECTRONI ENGI C NEERI NG

VO .1 NO 1 0. .3

J n. 2 2 u , 01

文 章 编 号 :1 7 — 8 2 2 1 ) 3 0 0 — 7 6 22 9 ( 0 2 0 - 3 5 0

m u t— i w r c i g f a wo k liv e t a k n r me r .By t o e i a n l s s a d s mu a i n e p rm e t h s me h d i r v d he r tc l a a y i n i l to x e i n ,t i t o s p o e t e e fc e t r la l n a y t e d p o e o b fi i n , e i b e a d e s o b e l y d.

视 频 跟 踪 系 统 规 模 已经 越 来 越 大 ,多 视 角 信 息 交 互 协 作 成 为 了 视 频 跟 踪 科 研 及 应 用 的 主 流 发 展 方 向 。 在 一 个 典 型 的 多 视 角 跟 踪 算 法 中 ,如 文 献 [] 1中所 述 , 多 个 视 角 通 过 交 换 跟 踪 物 体 在 各 视 角 的 状 态 得 以 补 充 深 度 信 息 ,从 而 对 复 杂 模 式 进 行 识 别 或 纠 正 ,使 多 视 角 跟 踪 系 统 具 有 更 精 确 的 跟 踪 结 果 、更 高 的 系 统 健 壮 程 度 、

px H (( ) ( 7) p吐1 L : )

题 , 证 明 高 斯 分 布 经 过 投 影 的结 果 可 以使 用 u 并 T变 换 ( se td rn fr 近 似 为 高 斯 分 布 , 此 本 文 中 Uncne a s m) T o 因

( 1 )

( )

式 中 Hj ) 示 了从视 角 到视 角 i (表 的单应投 影变换 。文献【— 0 中解决 了概率分 布 函数经 过单应投影 变换 的 问 9 1] 也 指使用 u T变换对 概率分 布 函数在平 面间进行 投影变 换和近似 。 由文献 [] 7可知 ,一般 从视角 A到视 角 的单应 投影变换 可 以表示 为 :

运动模 式 ,但依 然在很 多应用 场景受到 限制 , 需要 的运算量 大 ,参数 变化后 需要重新 标定等 。同时许 多视角跟 其 踪 系 统 j 应 用 场 景 满 足 平 面 假 设 , 只 需 要 对 目标 运 动 平 面 的 单 应 关 系 (o ga h ) 影 矩 阵 进 行 标 定 , 自标 的 h mo rp y投

t a k ng s s e .I hi a r t o o t c l h o r c i y t ms n t s p pe ,a me h d t a k e t e h mo r p y r l to s i t o a i n ft a k d g a h e a i n h p wih l c to s o r c e

ifr t n e c a g . e etee s i rl so h n w rjcierlt n hp a n iw . air— nomai x h n e N v r ls , t ei nt ek o n poe t eai s i mo gve s C l a o h e v o b

Ke r s ywo d :mu t・ i w ta ki live r c ng; c lb a i n; h mo r p y a i r to o gah

近年来 , 随着计 算机科 学和传 感器技术 的发展 , 智能 图像 处理 , 其是 视频跟踪 技术越来 越受到人们 的重视 。 尤 传统 的基础单 视角视频 跟踪技 术 由于其 在采集 阶段 丢失 了深 度信 息 ,很难对 形变 、遮挡等 问题 做 出有 效的处理 , 也 很 难 在 复 杂 应 用 模 式 中 进 行 有 效 的识 别 。因 此 多 视 角 视 频 跟 踪 系 统 技 术 愈 发 受 到 关 注 并 得 到 发 展 。当前 的 应 用

An Au o-a i r to eh d i hiv e ta k n y t m t - lb a in m t o n Mu - i w r c i gs se c -

DAIFe -i ng ln, FEN G u , YAN G o, HU H i Ta Bo ( p r n f lcrncEn iern ,F d nU iest , S a g a 2 0 3 , C ia De at t e to i gn eig u a nv ri me o E y hnh i 0 4 3 hn ) Ab ta t sr c :A muliv e ta k ng s se c n g i et r p ro ma c h n sn l - i w o e h o g t- iw r c i y t m a an b te ef r n e t a i g e- e n s tr u h - v

的跟 踪误差 处于 同一量级 , 因此只有保 证控制 点在 图像 平面上 的分布均匀合 理 , 能使跟踪 系统在使 用估计得 到 才 的单 应 投 影 矩 阵 时 减 小 投 影 误 差 的影 响 。

本 文 中标 定 估 计 的最 优 化 目标 为 :

miE[ x ) n ( 一x )] H( 、 () 4

对遮挡 和形变更 强 的纠 错能力等 ;同时 尽量避 免信息冗 余带来 的潜在 问题 : 误传染 扩散 、传输 阻塞延 时等 。但 错

以 上 性 能 却 都 依 赖 于 视 角 问 几 何 关 系 已 知 的先 决 条 件 。 此 各 种 摄 像 机 标 定 或 者 自标 定 技 术 成 为 了 计 算 机 视 觉 领 因 域 非 常 重 要 的研 究 课 题 。 自标定 技术L可 以完成 自动特征 点采集 、配对 ,并解 算 出完 整的摄像 机参数 ,可 以不依赖人 为干预或 特定 的 2 】

一

种 多 视 角 跟 踪 系统 中 的 自行 标 定 方 法

戴 凤 麟 ,冯 辉 ,杨 涛 ,胡 波

( 旦 大 学 电 子 工 程 系 ,上 海 2 0 3 ) 复 0 4 3

摘 要 : 多视 角 的 标 定 和 自标 定 是 多视 角 系 统 部 署 和 应 用 中 的 重 要 限 制 环 节 。 文 章 针 对 基 于 单 应 关 系 的 多 视 角 跟 踪 应 用 场 景 ,提 出 了一 种 使 用 跟 踪 结 果 本 身 进 行 视 角 几 何 关 系 前的分 布式 自适应 贝 叶斯 多视角跟踪 系统结 合在一起 ; 以标定误 差为 出发点得 到选取控 制点 的依 据 , 使 控 制点 集在跟 踪过程 中始终 紧凑 ,从而合理 地控制 了标定运算 所需 的运算量 。

1 目标 问 题

在一 个典型 的多视 角跟踪场景 中 , 视 角之 间通过 式() 1 做信 息交互 : 台摄像 机对 目标进行跟 踪 ,t 时刻 跟踪 目标 在 i 角的位置 为 ,其各 视

收 稿 日期 :2 1—30 ;修 回 日期 :2 1-41 0 20 .9 0 20 —5

基金项 目:国家重大专项资助项 目(0 IX00 30 10 ,02 X 3 0 0 70 3;华为合作资助项 目( WL 0 0 9) 2 1Z 30 —0 —22 1Z 0 0 10 —0) YB 2 1 10

=

HAB A = “ ,) (, w x V

() 2

式 中 日 为 3 3矩 阵 ,与 相 对 尺 度 无 关 , 因此 具 有 8 自 由度 。 x 个

实际图像坐标系内R 坐标 (/, w 为非线性变换 = AB 。当已知控制点集{ = =“W /) v H -( - ) ) P, } P

定 技 术 却 需 要 完 成 整 个 标 定 过 程 再 推 算 单 应 投 影 矩 阵 ,代 价 较 高 。 单 应 关 系 的 标 定 方 法 本 身 是 一 个 系 数 确 定 问题 ,分 为 控 制 点 的 选 择 和 如 何 由 控 制 点 得 到 更 精 确 的 结 果 两 部