JAVA插入数据优化

Java框架的性能优化技巧

Java框架的性能优化技巧Java框架在开发过程中,性能优化是一个至关重要的方面。

良好的性能可以提升应用程序的响应速度和并发能力,提高用户的体验。

本文将介绍一些Java框架的性能优化技巧,帮助开发者更好地提高应用程序的运行效率。

一、合理选择Java框架选择适合项目需求的Java框架是性能优化的第一步。

不同的框架在处理性能上可能会有所差异。

在选择框架时,要考虑框架的稳定性、易用性以及其在性能方面的表现。

二、优化数据库访问数据库访问是大多数应用程序的瓶颈之一。

以下是一些优化数据库访问的技巧:1. 使用批处理:将多个数据库操作合并为批处理操作,减少往返数据库的次数。

2. 使用索引:对常用的查询字段创建索引,可以加快查询速度。

3. 优化SQL查询语句:避免使用“select *”来查询所有字段,只查询需要的字段。

避免使用复杂的连接查询和子查询。

三、优化内存管理Java框架的内存管理也是一个关键因素。

以下是一些优化内存管理的技巧:1. 避免内存泄漏:确保在不再需要对象时及时释放资源,避免对象无法释放造成的内存泄漏。

2. 使用合适的缓存策略:合理使用缓存可以减少对数据库的频繁访问,提高性能。

但同时要注意缓存的更新和失效机制。

3. 垃圾回收优化:了解垃圾回收机制,根据项目需求调整垃圾回收的参数。

四、多线程并发控制Java框架常常需要处理大量的并发请求。

以下是一些多线程并发控制的技巧:1. 合理使用线程池:使用线程池可以避免多线程频繁创建与销毁的开销,提高性能。

2. 避免线程安全问题:在多线程环境中,要注意共享资源的线程安全问题,避免出现竞态条件和死锁等问题。

3. 异步处理:对于一些耗时的操作,可以使用异步处理来减少主线程的阻塞,提高并发能力。

五、代码优化优化框架代码本身也是提高性能的关键。

以下是一些代码优化的技巧:1. 减少对象创建:避免频繁创建无用的对象,尽量复用已有的对象,减少垃圾回收的压力。

2. 使用高效的数据结构和算法:选择合适的数据结构和算法可以提高代码的执行效率。

Java千万级别数据处理与优化

Java千万级别数据处理与优化随着互联网的发展,数据规模异常的庞大。

对于Java开发人员来说,面对这种情况,我们需要从性能和优化的角度思考,从而使我们的程序在处理海量数据时更有效率、更加可靠。

一、数据处理1. 数据读取优化数据读取是数据处理的第一步,良好的数据读取优化可以最大限度地提高程序的效率。

在数据读取方面,我们需要注重以下几个方面的优化:(1)缓存读取:对于内存中需要反复读取的数据,我们应该缓存读取,避免多次访问磁盘带来的性能损耗。

(2)文件切割:对于大文件的读取,我们可以将其切割成多个小文件,以便于多线程同时读取,并且有效减少了每个线程读取文件大小的开销。

(3)使用BufferedInputStream和BufferedReader:Java中提供了BufferedInputStream和BufferedReader这两种缓存读取的方式,可以有效地提高文件读取的效率。

2. 数据存储优化在面对千万级别的数据时,数据的存储也是我们需要优化的重要环节。

在数据存储方面,我们需要注重以下几个方面的优化:(1)使用内存存储:对于频繁读写的数据,我们应该尽量使用内存存储,避免频繁的磁盘读写,从而提高程序效率。

(2)使用NoSQL数据库:对于大规模的数据存储,我们可以使用NoSQL数据库来代替传统的关系型数据库,NoSQL数据库对分布式存储的支持更加完善,可以提高数据存储的效率。

(3)批量操作:在实际开发中,我们应该尽量采用批量操作的方式进行数据存储,这样可以有效提高数据处理的效率。

二、数据处理算法1. 分治算法分治算法是一种非常常见的算法,可以用于解决很多常见的数据处理问题。

在数据分析处理过程中,分治算法可以用来将庞大的数据集划分成多个小数据集,然后并行处理每个小数据集,最后合并结果。

通过这种方法,可以有效提高程序的处理效率。

2. MapReduce算法MapReduce算法是一种分布式数据处理算法,可以对千万级别的数据进行优化。

JAVA提高代码效率的方法

JAVA提高代码效率的方法Java是一种高性能语言,但是在编写代码时,我们仍然可以使用一些技巧来提高代码效率。

以下是一些提高Java代码效率的方法:1.使用合适的数据结构:选择正确的数据结构可以显著提高代码效率。

例如,如果需要频繁地进行插入和删除操作,使用链表比使用数组更高效。

如果需要快速访问元素,使用哈希表或树结构。

2.减少循环嵌套:嵌套循环是代码效率低下的一个常见原因。

尽量避免多层嵌套的循环,并考虑使用更高效的算法来处理问题。

3. 使用StringBuilder代替String拼接:在Java中,String对象是不可变的,每次对字符串进行拼接操作都会创建一个新的String对象,这会导致大量的内存分配和垃圾回收。

使用StringBuilder可以避免这个问题,并显著提高字符串拼接的效率。

4.使用局部变量:在循环中,将需要频繁访问的对象保存为局部变量可以减少访问成员变量的开销。

这是因为局部变量存储在栈中,而成员变量存储在堆中。

5. 缓存计算结果:对于一些需要重复计算的结果,可以将其缓存起来以避免重复计算。

这可以通过使用HashMap或其他缓存机制来实现。

6.懒加载:延迟加载是一种在需要时才创建对象的技术。

这可以减少内存的使用和对象的创建时间,并提高代码的效率。

7. 使用并发集合:当多个线程同时访问和修改集合对象时,使用并发集合(如ConcurrentHashMap、CopyOnWriteArrayList等)可以提高代码效率和线程安全性。

8. 使用原生数据类型:原生数据类型(如int、float、long等)在处理大规模数据时比对象类型更高效。

避免将原生类型包装为对象类型,尽量使用原生类型进行计算。

9.避免使用过多的异常处理:异常处理是一种开销较高的操作。

在一些性能要求较高的场景中,尽量避免频繁抛出和捕获异常。

10.减少输入输出:输入输出(IO)是代码效率的一个瓶颈。

可以使用批量读写、缓冲流等技术来减少IO操作的次数。

java写txt文件的大数据方法

一、概述随着信息技术的不断发展和应用,数据处理和管理方面的需求也日益增加。

在大数据处理和管理方面,Java作为一种流行且功能强大的编程语言,为开发人员提供了丰富的工具和库。

本文将介绍如何使用Java编程语言来处理和管理大数据,并重点讨论如何写入txt文件的大数据方法。

二、大数据处理的挑战传统的数据处理方法通常无法满足大数据处理的需求,例如内存的限制、并发处理的问题等。

针对大数据处理的挑战,Java提供了多种机制和工具,例如多线程、文件流、缓冲区等。

这些工具和机制可以帮助开发人员更有效地处理大数据。

三、Java写入txt文件的基本方法在Java中,写入txt文件的基本方法通常涉及到以下几个步骤:1. 创建文件对象:首先需要创建一个文件对象来表示要写入的文件。

可以使用Java中的File类来创建文件对象。

2. 创建文件输出流:接下来需要创建一个文件输出流来将数据写入到文件中。

可以使用Java中的FileOutputStream类来创建文件输出流。

3. 写入数据:一旦创建了文件输出流,就可以调用其write()方法来写入数据。

可以使用缓冲输出流来提高写入效率。

四、Java写入大数据到txt文件的方法在处理大数据时,直接使用FileOutputStream的write()方法来写入数据可能会遇到内存溢出的问题。

为了有效地处理大数据,可以考虑以下几种方法:1. 使用缓冲区:可以通过使用缓冲输出流来提高写入大数据的效率。

缓冲输出流可以将数据暂时存储在缓冲区中,然后一次性写入到文件中,避免频繁的文件I/O操作。

2. 使用多线程:可以考虑使用多线程来并发地写入大数据。

通过将数据分割成多个小块,并分配给不同的线程来处理,可以提高写入数据的速度。

3. 使用内存映射文件:Java提供了内存映射文件的机制,可以将文件映射到内存中,然后直接对内存进行操作,从而避免频繁的文件I/O 操作。

五、示例代码以下是一个使用Java写入大数据到txt文件的示例代码:```javaimport java.io.BufferedWriter;import java.io.File;import java.io.FileWriter;import java.io.IOException;public class WriteBigDataToFile {public static void m本人n(String[] args) {File file = new File("bigdata.txt");try (BufferedWriter writer = new BufferedWriter(new FileWriter(file))){for (int i = 0; i < xxx; i++) {writer.write(String.valueOf(i));writer.newLine();}} catch (IOException e) {e.printStackTrace();}}}```六、总结在处理大数据时,选择合适的方法和工具非常重要。

ava优化知识点总结

ava优化知识点总结一、Java内存优化1. 内存泄漏内存泄漏是指程序在动态分配内存时,由于某种原因(例如程序中有一些指针指向动态分配的内存,但程序没有释放这些内存,这样就会导致内存的浪费)而不能归还内存,使得程序持续占用着内存而无法释放的现象。

解决内存泄漏的方法:- 使用JVM内存分析工具,如jmap、jstat、jconsole等来检测内存泄漏;- 使用代码审查工具检查程序是否存在内存泄漏;- 关注对象的生命周期,及时释放不再使用的对象,避免长时间持有对象的引用。

2. 垃圾回收垃圾回收是Java内存管理的一部分,用于回收不再使用的对象,释放内存空间。

垃圾回收器通过不断扫描堆中的对象,标记哪些对象是活动的,然后释放那些不再被引用的对象。

优化垃圾回收的方法:- 合理设计对象的生命周期,避免对象产生过多的引用;- 使用合适的垃圾回收器,合理的调整堆空间大小,以及调整垃圾回收器的触发机制;- 使用轻量级对象池,重复利用对象,减少垃圾回收的次数。

3. 字符串拼接在Java中,字符串是不可变的,当进行字符串拼接时,会产生很多临时对象,会导致内存的浪费。

可以使用StringBuilder或StringBuffer来提高性能,避免产生大量的临时对象。

优化字符串拼接的方法:- 使用StringBuilder或StringBuffer来进行大量的字符串拼接;- 使用字符串常量池,避免产生重复的字符串对象;- 使用StringJoiner类来进行字符串的拼接。

二、Java性能调优1. 数据结构的选择在实际开发中,选用合适的数据结构对程序性能至关重要。

不同的数据结构适用于不同的场景,可以根据实际情况选择合适的数据结构,提高程序性能。

常用的数据结构优化方法:- 数组:适用于数据量固定、访问频繁的场景;- 链表:适用于频繁插入和删除操作的场景;- 树:适用于有层次关系的场景;- 哈希表:适用于快速查找的场景。

2. 多线程的优化多线程是提高系统性能的一种方法,同时也是一把双刃剑,要想合理利用多线程提高性能,需要考虑线程安全、死锁等问题。

《如何优化JAVA应用》课件

容 ● 性能优化策略

● 代码优化:通过优化代码结构、算法和数据结构来提高应用程序的执行效率

● JVM参数调优:根据应用程序的特点和需求,调整JVM参数以获得更好的性能

PART SEVEN

部署架构:介绍微服务架构、容器化技术、Docker等 容器化技术:介绍Docker的原理、使用方法、优势等 部署架构优化:介绍如何通过容器化技术优化JAVA应用的部署架构 监控优化:介绍如何通过容器化技术对JAVA应用进行监控和优化

监控和告警系统的重要性

监控和告警系统的组成

去除冗余代码:删除不必要的 代码,提高代码质量

优化算法:改进算法,提高程 序运行效率

减少内存占用:优化内存管理, 减少内存占用

代码可读性:提高代码可读性, 方便维护和调试

PART SIX

数据库连接池 的使用

索引的使用和 优化

查询语句的优 化

数据库连接的 关闭和释放

数 据 库 索 引 : 介 绍 索 引 的 概 念 、 作 用 和 应 用 场 景 , 以 及 在 JAVA 应 用 中 如 何 使 用 索 引 进 行 优 化 缓 存 技 术 : 介 绍 缓 存 的 概 念 、 作 用 和 应 用 场 景 , 以 及 在 JAVA 应 用 中 如 何 使 用 缓 存 进 行 优 化

● 多线程优化:合理利用多线程技术,提高应用程序的并发处理能力和响应速度

● 缓存技术:利用缓存技术减少对数据库等外部资源的访问,提高应用程序的响应速度和吞吐量

识别性能瓶颈: 通过分析应用程 序的响应时间、 吞吐量、内存使 用等指标,确定 性能瓶颈所在

Java开发者如何优化代码性能和可扩展性

Java开发者如何优化代码性能和可扩展性在当今的软件开发领域,Java 作为一种广泛使用的编程语言,对于开发者来说,优化代码性能和可扩展性是至关重要的。

这不仅能够提升软件的运行效率,还能为未来的功能扩展和维护打下坚实的基础。

接下来,让我们一起探讨一下 Java 开发者可以采取的一些关键策略和技巧。

首先,理解性能和可扩展性的概念是优化的第一步。

性能主要关注的是代码在执行特定任务时的效率,例如运行速度、内存使用等。

而可扩展性则侧重于系统在面对不断增长的需求和负载时,能够轻松地进行修改和扩展,而不会导致大规模的重构或性能下降。

在优化代码性能方面,选择合适的数据结构是一个重要的起点。

例如,如果需要频繁地进行插入和删除操作,ArrayList 可能就不如LinkedList 合适。

同样,对于快速查找操作,HashSet 或 HashMap 通常比 List 更有效。

另外,要注意避免不必要的数据复制。

在 Java 中,对象的复制可能会消耗大量的资源。

如果可能,尽量通过引用传递对象,而不是复制整个对象。

算法的选择也对性能有着显著的影响。

在解决同一个问题时,不同的算法可能会有截然不同的性能表现。

例如,在排序大量数据时,快速排序在大多数情况下可能比冒泡排序效率更高。

因此,在编写代码之前,对问题进行充分的分析,选择最优的算法是非常关键的。

内存管理是另一个需要重点关注的领域。

及时释放不再使用的对象和资源,避免内存泄漏。

可以使用 Java 的垃圾回收机制,但也要注意不要过度依赖它。

合理地使用缓存可以提高性能,但要注意缓存的大小和更新策略,以防止缓存占用过多的内存。

对于代码的可扩展性,良好的架构设计是基础。

采用分层架构、模块化设计和面向接口编程等原则,可以使代码更容易扩展和维护。

例如,定义清晰的接口,让不同的实现类可以轻松地替换,从而增加了系统的灵活性。

在代码编写过程中,遵循开闭原则(OpenClosed Principle)是很重要的。

java项目中的增删改查方法

java项目中的增删改查方法在Java项目中,增删改查(CRUD)操作是非常常见的需求。

无论是开发Web应用、移动应用还是后台系统,都会涉及到对数据的增加、删除、修改和查询操作。

在Java中,我们通常使用数据库来存储数据,而针对数据库的增删改查操作,我们通常会使用SQL语句来实现。

下面我们来看看在Java项目中,如何实现增删改查方法。

1. 增加(Create),在Java项目中,要实现数据的增加操作,通常需要先连接数据库,然后使用SQL语句向数据库中插入新的数据。

在Java中,我们可以使用JDBC(Java Database Connectivity)来连接数据库,使用PreparedStatement或者Statement来执行插入操作。

另外,如果我们使用了ORM框架(如Hibernate或MyBatis),我们也可以通过框架提供的API来实现数据的插入操作。

2. 删除(Delete),删除数据操作通常是根据某个条件从数据库中删除符合条件的数据。

在Java项目中,我们可以使用SQL的DELETE语句来实现数据的删除操作。

同样地,我们可以使用JDBC或者ORM框架提供的API来执行删除操作。

3. 修改(Update),修改数据操作通常是根据某个条件更新数据库中的数据。

在Java项目中,我们可以使用SQL的UPDATE语句来实现数据的更新操作。

同样地,我们可以使用JDBC或者ORM框架提供的API来执行更新操作。

4. 查询(Retrieve),查询数据操作是从数据库中检索数据。

在Java项目中,我们可以使用SQL的SELECT语句来实现数据的查询操作。

同样地,我们可以使用JDBC或者ORM框架提供的API来执行查询操作,并将查询结果返回给Java应用程序。

总的来说,在Java项目中实现增删改查方法,我们通常会使用JDBC来连接数据库并执行SQL语句,或者使用ORM框架来简化数据库操作。

无论是使用JDBC还是ORM框架,都需要对数据库操作有一定的了解,以便能够编写出高效、安全的增删改查方法。

Java中BigDecimal计算优化方法

Java中BigDecimal计算优化方法在Java中,BigDecimal是一个非常有用的类,用于进行高精度的浮点数计算。

然而,由于其内部实现和算法,使用BigDecimal进行计算可能会比使用 double或 float慢一些。

以下是一些可以提高 BigDecimal计算速度的方法:1.批量运算: 如果你需要对大量BigDecimal对象进行相同的操作(如加、减、乘、除等),可以首先对这些 BigDecimal进行一次排序或重新排列,然后进行批量运算。

2.使用已有的方法: 尽可能使用已经存在的方法,而不是创建新的BigDecimal。

例如,可以使用add、subtract、multiply、divide等方法,而不是手动实现加、减、乘、除等操作。

3.减少小数位数: 如果你的BigDecimal值没有太多小数位数,可以尝试在创建BigDecimal时减少它们。

例如,可以使用setScale(int scale, RoundingMode roundingMode)方法来设置小数位数和舍入模式。

4.使用 MathContext: MathContext类允许你指定舍入模式和精度。

通过设置合适的MathContext,你可以控制BigDecimal的计算精度和舍入方式,从而提高计算速度。

5.避免不必要的转换: 尽量避免将BigDecimal转换为其他数据类型(如double或 float),因为这些转换可能会导致精度损失和性能下降。

6.合理利用缓存: 如果在多个地方进行相同的计算,可以考虑将结果缓存起来,以避免重复计算。

7.并行计算: 如果你的计算任务可以并行处理,那么可以使用 Java 的并发 API(如ExecutorService、ForkJoinPool等)来并行处理任务,以提高计算速度。

记住,这些优化措施通常只有在处理大量数据或在非常苛刻的性能要求下才需要。

在大多数情况下,使用BigDecimal的默认行为应该足够好。

数据库动态增加字段 java程序设计

数据库动态增加字段是指在不修改数据库结构的情况下,通过程序设计的方式向数据库中添加新的字段。

这种方法在开发过程中非常常见,可以提高数据的灵活性和可扩展性,同时也降低了数据库结构的维护成本。

在Java程序设计中,实现数据库动态增加字段通常涉及到以下几个方面的内容:1. 数据库设计与优化2. Java数据库操作3. 动态字段处理下面将分别从这三个方面展开对数据库动态增加字段的Java程序设计进行探讨。

一、数据库设计与优化在进行数据库动态增加字段之前,首先需要进行数据库设计与优化。

在设计数据库时,需要考虑到可能需要动态增加字段的情况,并为此留下相应的扩展空间。

要合理地设计表结构,将相似或相关的字段放在一起,以方便后续的动态增加操作。

在优化数据库时,可以考虑采用分布式数据库、集裙数据库等技术,以提高数据库的扩展性和性能。

二、Java数据库操作在Java程序设计中,常见的数据库操作方式包括JDBC、Hibernate、MyBatis等。

这些技术都可以用来实现数据库的动态增加字段。

以JDBC为例,可以通过编写SQL语句来向数据库中添加新的字段,然后通过Java程序进行调用和执行。

而使用Hibernate和MyBatis时,可以通过相应的映射配置文件或注解来实现动态字段的增加。

三、动态字段处理在实际的Java程序设计中,动态字段处理通常涉及到实体类的动态更新、数据库表结构的动态修改等内容。

在实体类的动态更新中,可以使用反射技术来动态改变实体类的字段结构。

而数据库表结构的动态修改则需要通过相应的SQL语句来实现。

需要注意的是,动态字段处理涉及到数据库的安全性和稳定性问题,因此在实现过程中需要格外谨慎。

总结:数据库动态增加字段在Java程序设计中是一个复杂而又重要的问题。

通过合理的数据库设计与优化、灵活的Java数据库操作以及严谨的动态字段处理,可以实现数据库结构的灵活性和可扩展性,为系统的持续发展提供了良好的支持。

java项目中的增删改查方法

java项目中的增删改查方法在Java项目中,增删改查(CRUD)方法是非常常见和重要的。

这些方法用于对数据库中的数据进行操作,是任何应用程序的核心功能之一。

在本文中,我们将讨论Java项目中的增删改查方法的实现和最佳实践。

1. 增加(Create)数据。

在Java项目中,创建数据通常涉及将用户输入或其他来源的数据插入到数据库中。

为了实现这一点,我们通常会使用SQL INSERT语句或ORM(对象关系映射)框架(如Hibernate)来执行插入操作。

在使用ORM框架的情况下,我们可以通过创建实体对象并将其持久化到数据库中来实现数据的创建操作。

2. 删除(Delete)数据。

删除数据是指从数据库中移除特定记录或数据集。

在Java项目中,我们可以使用SQL DELETE语句或ORM框架提供的方法来执行删除操作。

在使用ORM框架时,通常会调用实体对象的删除方法来删除数据库中的记录。

3. 修改(Update)数据。

修改数据是指更新数据库中现有记录的内容。

在Java项目中,我们可以使用SQL UPDATE语句或ORM框架提供的方法来执行更新操作。

如果使用ORM框架,我们可以通过修改实体对象的属性并将其持久化到数据库中来实现数据的修改操作。

4. 查询(Retrieve)数据。

查询数据是指从数据库中检索特定记录或数据集。

在Java项目中,我们可以使用SQL SELECT语句或ORM框架提供的方法来执行查询操作。

如果使用ORM框架,我们通常会调用相应的查询方法来检索数据库中的数据。

在实现增删改查方法时,我们应该注意以下最佳实践:使用预编译语句或参数化查询来防止SQL注入攻击。

对数据库操作进行事务管理,以确保数据的一致性和完整性。

使用适当的索引和优化数据库查询,以提高性能。

对于ORM框架,应该了解并遵循框架的最佳实践和性能优化建议。

总之,增删改查方法是任何Java项目中不可或缺的部分。

通过遵循最佳实践和使用合适的工具和技术,我们可以有效地实现这些方法并确保应用程序的数据操作功能的稳健性和性能。

Java编程技巧:提高代码效率的方法

Java编程技巧:提高代码效率的方法Java编程技巧是提高代码效率的关键。

在软件开发中,编写高效的代码对于提升程序性能和用户体验非常重要。

本文将详细介绍一些能够提高Java代码效率的方法和步骤。

一、优化算法和数据结构:1. 算法选择:选择合适的算法可以大大提高代码效率。

在解决问题的过程中,需要仔细评估不同算法的时间复杂度和空间复杂度,选择最优的算法。

2. 数据结构:选择合适的数据结构可以提高代码效率。

例如,使用哈希表进行快速查找和插入操作,使用链表进行频繁的插入和删除操作。

二、避免重复计算:1. 缓存结果:如果某个计算过程需要重复执行,可以将结果缓存起来,在需要的时候直接使用缓存结果,避免重复计算。

2. 使用动态规划:动态规划是一种自底向上的计算方式,可以保存已经计算过的中间结果,避免重复计算。

三、合理使用循环和迭代:1. 减少循环次数:合理设计循环条件,避免不必要的循环。

例如,当循环次数已知时,可以使用for循环代替while循环,减少循环次数。

2. 防止死循环:在编写循环代码时,一定要确保循环条件能够终止,避免进入死循环。

四、适当使用并发处理:1. 多线程处理:适当使用多线程可以提高代码效率。

在程序中使用多线程处理独立的任务,可以有效利用多核处理器的计算能力。

2. 线程池管理:合理使用线程池可以避免线程创建和销毁的开销,减少资源占用。

线程池可以复用线程,提高程序性能。

五、避免频繁的IO操作:1. 缓存IO结果:如果某个IO操作需要频繁执行,可以将结果缓存起来,减少IO操作的次数。

2. 批量IO操作:如果可能的话,将多个IO操作合并成批量操作。

例如,将多次文件读写操作合并为一次,减少IO操作的次数。

六、使用合适的Java类库和框架:1. Java标准库:合理使用Java标准库提供的类和方法,可以大大提高代码效率。

例如,使用Collections类进行集合操作,使用StringBuilder类进行字符串拼接等。

JAVA项目性能优化

JAVA项目性能优化在开发JAVA项目时,我们经常会遇到性能问题,这会导致系统运行缓慢、响应时间长以及资源占用过多等问题。

针对这些问题,我们需要对项目进行性能优化,以提高系统的响应速度和效率。

下面将介绍一些常见的JAVA项目性能优化方法。

1. 合理使用String类在JAVA中,String类是不可变的,每次对字符串的操作都会生成新的字符串对象。

因此,在频繁操作字符串时,不要使用"+"号拼接字符串,而更好的方式是使用StringBuilder或StringBuffer类,因为它们在操作字符串时不会生成新的对象,从而提高了性能。

2.避免过多的数据库操作数据库操作往往是系统性能的瓶颈,因此,需要尽量减少对数据库的访问次数。

可以通过以下几种方式来实现:-使用批量操作替代多次单条数据操作,减少连接数据库的次数。

-使用缓存,将常用的查询结果缓存在内存中,减少对数据库的访问次数。

-使用数据库连接池,减少连接数据库的开销。

3.使用合适的数据结构和算法选择合适的数据结构和算法对于提高性能非常重要。

例如,对于频繁的查找操作,可以使用哈希表或二叉树等数据结构,而不是线性表;对于大规模的数据排序,应使用快速排序或归并排序等效率更高的算法。

4.减少内存开销JAVA使用垃圾回收机制来释放无用对象的内存,但是频繁的垃圾回收会导致系统性能下降。

因此,需要注意以下几点:-及时释放资源,如数据库连接、文件流等,避免造成内存泄漏。

-慎用静态对象,因为静态对象会一直存在于内存中,占用较多的内存空间。

-使用轻量级对象,避免创建过多的大对象,可以使用基本数据类型替代大对象。

5.使用多线程和异步处理对于需要频繁处理的任务,可以使用多线程和异步处理来提高性能。

使用多线程可以充分利用CPU资源,提高系统的并发处理能力;使用异步处理可以减少等待时间,提高系统的响应速度。

6.使用缓存技术缓存技术是提高系统性能的有效手段。

可以将热点数据缓存在内存中,减少对数据库的访问次数;可以使用分布式缓存,将缓存数据分布在多台服务器上,提高系统的并发处理能力。

如何通过代码优化提高数据库写入速度

如何通过代码优化提高数据库写入速度数据库的写入操作对系统的性能有着很大的影响,尤其在高负载的情况下,写入操作可能成为瓶颈,导致整个系统性能下降。

为了提高数据库的写入速度,可以通过对代码进行优化来实现。

1.批量插入数据:将多个插入操作合并成一个批量插入操作,减少与数据库的交互次数。

这种方式可以大大减少网络延迟和数据库连接开销,提高写入速度。

2.使用事务:将多个插入操作放在一个事务中,使用事务可以减少磁盘IO次数,提高写入速度。

同时,事务还具有ACID特性,可以保证数据的一致性和完整性。

3.使用预编译语句:预编译语句可以将SQL语句提前编译,并缓存起来,减少重复编译的开销,提高写入速度。

4.合理使用索引:索引可以大大提高查询速度,但是对于写操作来说,索引的维护可能会降低写入速度。

因此,在写入操作频繁的表中,需要谨慎选择索引,避免过多或不必要的索引。

5.优化数据库结构:合理设计数据库的结构可以提高写入速度。

例如,拆分大表可以减少锁的竞争,采用分区表可以减少IO操作等。

6.避免触发器和触发器中的逻辑:触发器会在数据变动时执行相应的逻辑,但是触发器的执行会增加数据库的负载,降低写入速度。

因此,如果触发器不是必要的,可以考虑避免使用。

7.使用连接池:连接数据库是一种资源密集型的操作,频繁连接数据库会增加系统开销。

使用连接池可以提前创建好连接,在需要时从连接池中获取连接,减少连接的创建和销毁开销,提高写入速度。

8.优化SQL语句:合理编写SQL语句可以减少不必要的查询和计算,提高写入速度。

例如,避免使用SELECT *,只选择需要的字段;避免使用子查询和嵌套查询等。

9.数据库分片:对于大规模的系统来说,可以将数据按照一定的规则进行分片存储,每个分片独立运行,可以提高并发度和写入速度。

10.增加缓存层:对于频繁读取的数据,可以加入缓存层,减少对数据库的访问次数,提高读写速度。

通过以上的优化措施,可以大大提高数据库的写入速度,增强系统的性能和稳定性。

JDBC优化与批量处理技巧

JDBC优化与批量处理技巧JDBC(Java Database Connectivity)是Java语言中用于访问关系型数据库的接口,也是Java EE中常用的数据访问方式之一。

在Java EE应用开发中,JDBC是必备的技能之一。

在使用JDBC时,需要注意代码的执行效率和效果。

本文主要介绍JDBC的优化和批量处理技巧,以提高代码的执行效率和效果。

一、JDBC优化技巧1.1 使用PreparedStatement代替Statement在使用JDBC时,有两种方式用于执行SQL语句,即Statement和PreparedStatement。

在执行单条语句时,两者的效果差不多。

但是在执行大量语句时,PreparedStatement的效率比Statement更高。

这是因为PreparedStatement能够预编译SQL语句,而Statement无法预编译。

预编译SQL语句可以减少数据库的负担,提高代码执行效率。

下面是一个使用PreparedStatement的例子:```javaPreparedStatement ps = conn.prepareStatement("SELECT * FROM users WHERE name = ?");ps.setString(1, "John");ResultSet rs = ps.executeQuery();```1.2 使用连接池连接池是一种基于数据库连接池技术的优化方式,可以避免在每次执行数据库操作时都要重新连接数据库的问题。

使用连接池可以有效地减少数据库的负荷和资源消耗。

Java EE中提供了多种连接池技术,例如Apache DBCP、C3P0等。

下面是一个使用C3P0连接池的例子:```javaComboPooledDataSource ds = new ComboPooledDataSource();ds.setDriverClass("com.mysql.jdbc.Driver");ds.setJdbcUrl("jdbc:mysql://localhost:3306/mydb");ds.setUser("user");ds.setPassword("pwd");Connection conn = ds.getConnection();```1.3 批量操作在Java EE应用中,经常需要执行批量操作,例如批量插入数据、批量删除数据等。

java excel表格导入的异常数据处理方案

尊敬的读者:在日常工作中,我们经常会遇到需要使用Java语言进行Excel表格导入的情况。

然而,由于Excel表格的复杂性,我们很可能会遇到各种异常数据。

如何处理这些异常数据是我们在工作中需要思考并解决的问题之一。

我们需要了解什么是异常数据,以及它们可能的形式。

异常数据指的是那些不符合预期格式或内容的数据,例如数据类型不匹配、缺失数值、不合法的数值等。

这些异常数据可能会导致我们的程序无法正常运行,甚至导致系统崩溃。

针对Java语言中Excel表格导入的异常数据处理方案,我将从以下几个方面展开讨论:1. 异常数据的识别和定位2. 异常数据的清洗和转换3. 异常数据的存储和报告4. 个人观点和经验共享1. 异常数据的识别和定位在Excel表格导入过程中,我们首先需要对异常数据进行识别和定位。

这一步通常需要借助Java语言中的Excel处理库,如Apache POI或JExcel等。

通过这些库,我们可以逐行读取Excel表格中的数据,并对每一列进行类型和内容的校验。

一旦发现异常数据,我们可以将其标记并记录下来,以便后续处理。

2. 异常数据的清洗和转换在识别和定位到异常数据后,我们需要对其进行清洗和转换。

清洗包括删除不合法的数据、填充缺失的数据等操作;而转换则是将异常数据按照一定规则进行转换,使其符合我们的预期格式和内容。

在Java语言中,我们可以借助正则表达式、数据结构和算法来实现这些操作。

3. 异常数据的存储和报告处理完异常数据后,我们需要将其存储并生成相应的报告。

存储可以选择将清洗后的数据重新写入Excel表格,或者将异常数据以特定格式存储在数据库中;而报告则是对异常数据处理的结果进行总结和回顾,以便后续跟踪和分析。

个人观点和经验共享在实际工作中,我发现处理Java语言中Excel表格导入的异常数据并不是一件容易的事情。

需要我们对Excel表格的结构和内容有深入的了解,对Java语言的数据处理和算法有扎实的掌握,以及对业务需求和用户期望有敏锐的洞察力。

java处理重复插入数据的方法

一、背景介绍在实际的软件开发过程中,经常会遇到需要向数据库中插入数据的情况。

然而,在进行数据插入时,有时候会遇到重复插入数据的问题。

针对这一问题,本文将介绍在Java中处理重复插入数据的方法。

二、使用IGNORE关键字处理重复数据插入1. 在MySQL数据库中,可以通过使用IGNORE关键字来处理重复数据插入的问题。

当使用INSERT IGNORE INTO语句插入数据时,如果发生主键重复或者唯一键重复的情况,数据库会忽略掉这些重复的数据,而不会报错。

2. 在Java中,可以使用JDBC来执行带有IGNORE关键字的SQL语句,从而处理重复数据插入的情况。

以下是使用JDBC处理重复数据插入的示例代码:```javatry {Connection conn = DriverManager.getConnection(url, user, password);Statement stmt = conn.createStatement();String sql = "INSERT IGNORE INTO table_name (column1, column2) VALUES (value1, value2)";stmt.executeUpdate(sql);} catch (SQLException e) {e.printStackTrace();}```三、使用REPLACE关键字处理重复数据插入1. 除了使用IGNORE关键字外,还可以使用REPLACE关键字来处理重复数据插入的情况。

当使用REPLACE INTO语句插入数据时,如果发生主键重复或者唯一键重复的情况,数据库会先删除原有的数据,然后再插入新的数据。

2. 在Java中,同样可以使用JDBC来执行带有REPLACE关键字的SQL语句,从而处理重复数据插入的情况。

以下是使用JDBC处理重复数据插入的示例代码:```javatry {Connection conn = DriverManager.getConnection(url, user, password);Statement stmt = conn.createStatement();String sql = "REPLACE INTO table_name (column1, column2) VALUES (value1, value2)";stmt.executeUpdate(sql);} catch (SQLException e) {e.printStackTrace();```四、使用ON DUPLICATE KEY UPDATE子句处理重复数据插入1. 在MySQL数据库中,还可以通过使用ON DUPLICATE KEY UPDATE子句来处理重复数据插入的问题。

Java中的机器学习模型部署与优化

Java中的机器学习模型部署与优化在当今信息时代,机器学习在各个领域中发挥着越来越重要的作用。

而在机器学习的应用中,模型的部署与优化是不可或缺的环节。

本文将介绍Java中的机器学习模型部署与优化的方法与技巧。

一、模型部署1. 导入所需的库在Java中,我们可以使用各种开源的机器学习库来进行模型的构建与部署。

常用的库包括Apache Mahout、Weka和DL4J等。

在使用之前,我们需要首先导入相应的库,并进行必要的配置。

2. 数据准备与预处理在进行机器学习模型的部署之前,我们需要准备好相应的数据,并对数据进行预处理。

这包括数据的清洗、特征工程和数据归一化等步骤。

Java中的机器学习库通常提供了丰富的函数和方法来支持数据的处理和转换。

3. 模型选择与训练在进行机器学习模型部署之前,我们需要选择适合我们数据集和任务的模型。

选择模型时需要考虑模型的准确度、训练速度和内存占用等指标。

在选择好模型之后,我们需要使用训练数据对模型进行训练。

这包括模型参数的初始化和迭代优化等步骤。

4. 模型保存与加载在模型训练完成后,我们需要将模型保存到硬盘中,以便之后的部署和使用。

Java中的机器学习库通常提供了保存和加载模型的函数和方法。

这样,在之后的应用中,我们可以直接加载模型,而无需重新训练。

二、模型优化1. 模型性能评估在部署之前,我们需要对模型的性能进行评估。

常用的评估指标包括准确度、精确度、召回率和F1值等。

通过评估模型的性能,我们可以了解模型的优劣,并据此做出相应的优化策略。

2. 特征选择与降维在模型部署之前,我们可以通过特征选择和降维等方法来减少特征的维度,从而提高模型的性能和效率。

Java中的机器学习库通常提供了各种特征选择和降维的函数和方法,如相关系数、主成分分析和线性判别分析等。

3. 模型调参与优化在将模型部署到实际应用中时,我们经常需要对模型的参数进行调优。

这需要通过实验和交叉验证等方法来确定最佳的参数设置。

java执行10000数据量计算优化

java执行10000数据量计算优化

1.尽量使用单例。

2.合理使用静态变量,常用才使用,减少使用。

3.多使用final,如setter。

4.尽量不要在循环中创建对象(使用基本数据类型或者数组来代替),不要过多创建对象,不要在循环中使用try/catch。

5.尽量使用局部变量,局部变量存在栈中,比存在堆中的变量实例等速度都要快(但是规范要求尽量不要有局部变量,适当就行)。

6.操作局部变量要比读取全局变量要更快。

7.基本类型和包装类型一样,基本数据类型在栈中,包装类型在堆中,合理使用吧,能用基本类型就用基本类型,不行就用包装类型。

8.synchronized尽量不用,用的话范围尽量小。

9.尽量不要使用finalize。

10.合理使用给出最佳大小,尽量避免扩容,其他类似

11.尽量减少重复计算,如list.size在循环中可以提前算好,然后再在循环中使用13.尽量减少不必要的对象创建。

12.资源要及时关闭。

13.尽量使用位运算来代替逻辑运算,在条件判断中尽量用boolean。

14.尽早释放无用对象引用。

15.用一维数组代替二维数组。

16.尽量避免使用split,如果要用,可以使用的split(string,char),频繁的split可以缓存结果。

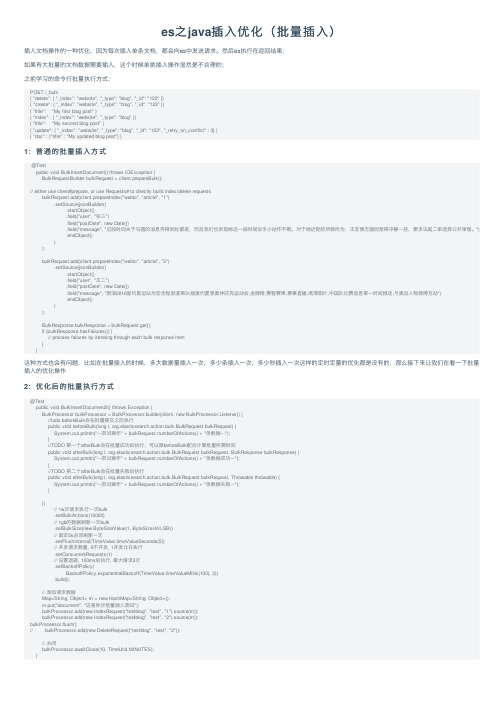

es之java插入优化(批量插入)

es之java插⼊优化(批量插⼊)插⼊⽂档操作的⼀种优化,因为每次插⼊单条⽂档,都会向es中发送请求。

然后es执⾏在返回结果;如果有⼤批量的⽂档数据需要插⼊,这个时候单挑插⼊操作显然是不合理的;之前学习的命令⾏批量执⾏⽅式:POST /_bulk{ "delete": { "_index": "website", "_type": "blog", "_id": "123" }}{ "create": { "_index": "website", "_type": "blog", "_id": "123" }}{ "title": "My first blog post" }{ "index": { "_index": "website", "_type": "blog" }}{ "title": "My second blog post" }{ "update": { "_index": "website", "_type": "blog", "_id": "123", "_retry_on_conflict" : 3} }{ "doc" : {"title" : "My updated blog post"} }1:普通的批量插⼊⽅式@Testpublic void BulkInsertDocument() throws IOException {BulkRequestBuilder bulkRequest = client.prepareBulk();// either use client#prepare, or use Requests# to directly build index/delete requestsbulkRequest.add(client.prepareIndex("weibo", "article", "1").setSource(jsonBuilder().startObject().field("user", "张三").field("postDate", new Date()).field("message", "近段时间关于马蓉的消息传得到处都是,⽽且我们也发现她这⼀段时间似乎⼩动作不断。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

我的数据库MySQLAssembly codeCREATE TABLE `users` (`id` int(11) NOT NULL auto_increment,`firstname` varchar(50) NOT NULL,`lastname` varchar(50) NOT NULL,`age` int(11) NOT NULL,PRIMARY KEY (`id`)) ENGINE=InnoDB DEFAULT CHARSET=utf8我的数据库辅助类Java codepackage com.jdbc.batch;import java.sql.Connection;import java.sql.DriverManager;import java.sql.PreparedStatement;import java.sql.ResultSet;import java.sql.SQLException;public final class DBUtils {private static String mysqlurl ="jdbc:mysql://localhost:3306/mytest";private static String accessurl ="jdbc:mysql://localhost:3306/mytest";private static String user = "root";private static String password = "root";// 获得连接public static Connection getAccessConn() throws SQLException {return DriverManager.getConnection(accessurl, user, password);}public static Connection getMySqlConn() throws SQLException { return DriverManager.getConnection(mysqlurl, user, password);}// 释放连接public static void free(ResultSet rs, PreparedStatement ps, Connection conn) {try {if (rs != null) {rs.close();}} catch (SQLException e) {e.printStackTrace();} finally {try {if (ps != null) {ps.close();}} catch (SQLException e) {e.printStackTrace();} finally {try {if (conn != null) {conn.close();}} catch (SQLException e) {e.printStackTrace();}}}}// 加载驱动static {try {Class.forName("com.mysql.jdbc.Driver");} catch (ClassNotFoundException e) {System.out.println("驱动加载出错");}}}我的测试类Java codepackage com.jdbc.batch;import java.sql.Connection;import java.sql.PreparedStatement;import java.sql.ResultSet;import java.sql.SQLException;public class BatchExample {private static Connection mysqlConn = null;private static ResultSet rs = null;// 总条数private static int allCount = 10000;// 分批条数private static int preCount = 1000;// 计数器private static int count = 0;private static String insertSQL = "insert into users(firstname, lastname, age) values(?, ?, ?)";private static PreparedStatement mysqlPs = null;public static void main(String[] args) throws SQLException { try {mysqlConn = DBUtils.getMySqlConn();mysqlPs = mysqlConn.prepareStatement(insertSQL);mysqlConn.setAutoCommit(false);long start = System.currentTimeMillis();for (int i = 1; i <= allCount; i++) {mysqlPs.setString(1, "firstname" + i);mysqlPs.setString(2, "lastname" + i);mysqlPs.setInt(3, 23);mysqlPs.addBatch();if ((i % preCount) == 0){mysqlPs.executeBatch();System.out.println("当前进行完毕===>" +(++count) * preCount + "条");}}long end = System.currentTimeMillis();System.out.println("数据导入完毕,所用时间为: " +(end - start) + " ms");} catch (Exception e) {mysqlConn.rollback();System.out.println("数据出错,已进行回滚");throw new RuntimeException();} finally {mit();DBUtils.free(rs, mysqlPs, mysqlConn);}}}我用的批处理.最后执行10000条的记录是Assembly code当前进行完毕===>1000条当前进行完毕===>2000条当前进行完毕===>3000条当前进行完毕===>4000条当前进行完毕===>5000条当前进行完毕===>6000条当前进行完毕===>7000条当前进行完毕===>8000条当前进行完毕===>9000条当前进行完毕===>10000条数据导入完毕,所用时间为: 8140 msJava code主要看下我的测试类BatchExample 我用的批处理 addBatch每1000条打包发送一次.但结果还是不尽人意8140ms.而我换了一种方案用executeUpdate一次提交.SQL用StringBuilder串接效率提升很快.代码Java codepackage com.jdbc.batch;import java.sql.Connection;import java.sql.PreparedStatement;import java.sql.ResultSet;import java.sql.SQLException;public class BufferQuery {private static Connection mysqlConn = null;private static ResultSet rs = null;// 总条数private static int allCount = 10000;// 分批条数private static int preCount = 1000;// 计数器private static int count = 0;private static String insertSQL = "insert into users(firstname, lastname, age) values(?, ?, ?)";private static PreparedStatement mysqlPs = null;public static void main(String[] args) throws SQLException { try {StringBuilder sb = new StringBuilder();sb.append("insert into users(firstname, lastname, age) values");mysqlConn = DBUtils.getMySqlConn();mysqlPs = mysqlConn.prepareStatement(insertSQL);mysqlConn.setAutoCommit(false);long start = System.currentTimeMillis();for (int i = 1; i <= allCount; i++) {if(i > 1) sb.append(",");sb.append("('aa"+ i +"','bb',23)");if(i % preCount == 0){System.out.println("导入进行===>" + (++count * preCount) + "条");}}mysqlPs.executeUpdate(sb.toString());long end = System.currentTimeMillis();System.out.println("数据导入完毕,所用时间为: " +(end - start) + " ms");} catch (Exception e) {mysqlConn.rollback();System.out.println("数据出错,已进行回滚");throw new RuntimeException();} finally {mit();DBUtils.free(rs, mysqlPs, mysqlConn);}}}Java code// 用的StringBuilder串接long start = System.currentTimeMillis();for (int i = 1; i <= allCount; i++) {if(i > 1) sb.append(",");sb.append("('aa"+ i +"','bb',23)");if(i % preCount == 0){System.out.println("导入进行===>" + (++count * preCount) + "条");}}mysqlPs.executeUpdate(sb.toString());运行结果为:Assembly code导入进行===>1000条导入进行===>2000条导入进行===>3000条导入进行===>4000条导入进行===>5000条导入进行===>6000条导入进行===>7000条导入进行===>8000条导入进行===>9000条导入进行===>10000条数据导入完毕,所用时间为:219 ms。