MSExample1_-_Three_ways_to_model_a_chine_hull

pytorch面试知识点

PyTorch面试知识点PyTorch是一个基于Torch的开源机器学习库,它提供了一个灵活的深度学习开发框架,因此在面试中对于PyTorch的了解是非常重要的。

下面是一些PyTorch面试中可能会涉及到的知识点。

1. 张量(Tensor)张量是PyTorch中最基本的数据结构,它类似于NumPy中的多维数组。

面试官可能会问你张量的创建方法、操作和索引等相关知识点。

以下是一些常见的张量操作:•创建一个张量:可以使用torch.tensor()函数创建一个新的张量。

还可以使用其他函数如torch.zeros(), torch.ones(), torch.randn()等来创建特定类型的张量。

•张量的操作:PyTorch提供了一系列的张量操作函数,如torch.add(), torch.matmul(), torch.transpose()等。

你应该熟悉这些函数的用法。

•张量的索引:与NumPy类似,你可以使用索引和切片来访问张量的元素。

同时,你还可以使用torch.masked_select()函数根据条件选择张量中的元素。

2. 自动求导(Autograd)PyTorch中的自动求导是其最重要的特性之一,它允许你在模型训练过程中自动计算梯度。

在面试中,你可能会被问到什么是自动求导、如何计算梯度以及如何使用PyTorch的自动求导功能。

以下是一些与自动求导相关的知识点:•自动求导机制:PyTorch使用动态图来实现自动求导。

你可以通过将requires_grad属性设置为True来追踪张量的操作,并使用backward()函数计算梯度。

•梯度计算:PyTorch使用反向传播算法来计算梯度。

你可以通过调用backward()函数在计算图上的某个节点上计算梯度。

•torch.no_grad()上下文管理器:有时候你可能需要在不计算梯度的情况下对张量进行操作。

在这种情况下,你可以使用torch.no_grad()上下文管理器来关闭自动求导功能。

torch里model()用法

torch里model()用法PyTorch是一个流行的深度学习框架,它提供了许多方便的功能和工具,使开发人员能够更轻松地构建和训练神经网络。

在PyTorch 中,model()函数是一个重要的工具,用于创建和加载模型。

本文将介绍torch中model()的用法,包括其基本概念、创建模型、加载模型等。

一、model()的基本概念在PyTorch中,model()函数用于创建和加载模型。

它接受一个模型类或一个已经定义好的模型实例作为参数,并返回一个模型对象。

通过使用model()函数,开发人员可以轻松地创建和加载各种类型的神经网络模型,包括卷积神经网络(CNN)、循环神经网络(RNN)等。

二、创建模型要使用model()函数创建模型,需要先定义模型类。

模型类通常继承自torch.nn.Module,并实现其子类中的方法。

这些方法包括前向传播(forward())和其他必要的操作。

下面是一个简单的示例,展示如何使用model()函数创建一个简单的全连接神经网络:```pythonimport torch.nn as nnclass SimpleModel(nn.Module):def __init__(self, input_size, hidden_size,output_size):super(SimpleModel, self).__init__()self.fc1 = nn.Linear(input_size, hidden_size)self.relu = nn.ReLU()self.fc2 = nn.Linear(hidden_size, output_size)def forward(self, x):x = self.fc1(x)x = self.relu(x)x = self.fc2(x)return x```要使用上述模型类创建一个模型对象,可以使用model()函数:```pythonmodel = torch.nn.model(SimpleModel, input_size=784, hidden_size=500, output_size=10)```这将创建一个SimpleModel类的实例,并将其传递给model()函数。

predictmodel的例子(一)

predictmodel的例子(一)Predict Model 示例1. Linear Regression Model•简介:线性回归模型是一种用于建立连续型目标变量与自变量之间线性关系的预测模型。

通过最小化残差平方和,找到最佳拟合直线,使预测值与实际观测值的差距最小化。

•应用场景:适用于自变量与目标变量之间存在线性关系的问题,如销售额随广告投入的增加而增加的情况。

•优势:简单易懂,计算速度快。

•缺点:不能解决非线性问题。

2. Logistic Regression Model•简介:逻辑回归模型是一种用于建立二分类目标变量与自变量之间关系的预测模型。

通过利用S型函数将线性回归结果映射到概率预测结果,从而进行分类预测。

•应用场景:广泛应用于二分类问题,如判断邮件是否为垃圾邮件。

•优势:实现简单,预测结果可解释性强。

•缺点:不能解决多分类问题,对特征间存在高度相关性时容易产生过拟合。

3. Decision Tree Model•简介:决策树模型是一种通过对数据进行分割,构建树形结构来进行预测的模型。

通过将数据集分成多个子集,根据特征条件选择最佳分割点进行预测。

•应用场景:适用于离散型和连续型特征的分类和回归问题。

•优势:易于理解和解释,能够处理缺失值和异常值。

•缺点:容易过拟合,对数据的变化较敏感。

4. Random Forest Model•简介:随机森林模型是一种整合多个决策树模型的集成预测模型。

通过随机选择特征子集和数据子集,构建多棵决策树进行预测,并通过投票或平均预测结果得到最终结果。

•应用场景:适用于分类和回归问题,特别是特征较多的复杂问题。

•优势:准确性高,能够处理高维度数据,对特征选择不敏感。

•缺点:模型复杂度较高,训练时间较长。

5. Support Vector Machine Model•简介:支持向量机模型是一种用于分类和回归问题的监督学习模型。

通过将数据映射到高维空间,寻找超平面将不同类别的数据分开。

text-to-3d_with_classifier_score_distillation_概述说明

text-to-3d with classifier score distillation 概述说明1. 引言1.1 概述本文旨在介绍"text-to-3d with classifier score distillation"的概念和应用。

"text-to-3d"是一种技术,可以将文本信息转换为三维场景或模型,通过深度学习算法实现。

而"classifier score distillation"则是一种方法,用于提取分类器的得分信息并进行蒸馏处理。

本文将详细介绍这两个技术及其原理、应用领域和实现方法。

1.2 文章结构本文共分为五个部分:引言、正文、text-to-3d、classifier score distillation 和结论。

在正文部分,将详细介绍"text-to-3d"技术的原理、应用领域和实现方法;而在"classifier score distillation"部分,则会针对分类器得分蒸馏的相关内容进行阐述。

最后,在结论中总结主要发现,并探讨研究意义及未来展望。

1.3 目的本文的目的是通过对"text-to-3d with classifier score distillation"这一技术的全面介绍,使读者对这一领域有一个清晰的认识和了解。

同时,希望能够展示该技术在不同领域中的潜在应用价值,并为相关研究提供启示和指导。

通过本文的阐述,读者将能够掌握"text-to-3d"技术的原理、实现以及与"classifier score distillation"相结合的应用方法,为进一步研究和开展相关工作提供基础和支持。

这样便清晰地描述了“1. 引言”部分的内容。

2. 正文在本文中,我们将介绍text-to-3d技术和classifier score distillation方法,并探讨它们的原理、应用领域以及实现方法。

斑马技术公司DS8108数字扫描仪产品参考指南说明书

python英文情感三分类方法

python英文情感三分类方法英文情感三分类方法通常指的是将英文文本的情感分为三类:正面、负面和中性。

下面是一个使用Python实现英文情感三分类的示例代码:```pythonimport pandas as pdfrom _ import CountVectorizerfrom _bayes import MultinomialNBfrom _selection import train_test_splitfrom import accuracy_score读取数据集df = _csv('')提取特征和标签X = df['text'].valuesy = df['sentiment'].values划分训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=, random_state=42)将文本转换为词频矩阵vectorizer = CountVectorizer()X_train_vectorized = _transform(X_train)X_test_vectorized = (X_test)使用朴素贝叶斯分类器进行训练和预测clf = MultinomialNB()(X_train_vectorized, y_train)y_pred = (X_test_vectorized)计算准确率accuracy = accuracy_score(y_test, y_pred)print('Accuracy:', accuracy)```在这个示例代码中,我们使用了Pandas库读取数据集,然后使用CountVectorizer将文本转换为词频矩阵,并使用MultinomialNB分类器进行训练和预测。

最后,我们计算了模型的准确率。

深度学习试题500问

深度学习试题500问1.1标量、向量、张量之间的联系 1 [填空题]_________________________________1.2张量与矩阵的区别? 1 [填空题]_________________________________1.3矩阵和向量相乘结果 1 [填空题]_________________________________1.4向量和矩阵的范数归纳 1 [填空题]_________________________________1.5如何判断一个矩阵为正定? 2 [填空题]_________________________________1.6导数偏导计算 3 [填空题]_________________________________1.7导数和偏导数有什么区别? 3 [填空题]_________________________________1.8特征值分解与特征向量 3 [填空题]_________________________________1.9奇异值与特征值有什么关系? 4 [填空题]_________________________________1.10机器学习为什么要使用概率? 4 [填空题]_________________________________1.11变量与随机变量有什么区别? 4 [填空题]_________________________________1.12常见概率分布? 5 [填空题]_________________________________1.13举例理解条件概率 9 [填空题]_________________________________1.14联合概率与边缘概率联系区别? 10 [填空题]_________________________________1.15条件概率的链式法则 10 [填空题]_________________________________1.16独立性和条件独立性 11 [填空题]_________________________________1.17期望、方差、协方差、相关系数总结 11 [填空题] *_________________________________2.1 各种常见算法图示 14 [填空题]_________________________________2.2监督学习、非监督学习、半监督学习、弱监督学习? 15 [填空题] _________________________________2.3 监督学习有哪些步骤 16 [填空题]_________________________________2.4 多实例学习? 17 [填空题]_________________________________2.5 分类网络和回归的区别? 17 [填空题]_________________________________2.6 什么是神经网络? 17 [填空题]_________________________________2.7 常用分类算法的优缺点? 18 [填空题]_________________________________2.8 正确率能很好的评估分类算法吗? 20 [填空题]_________________________________2.9 分类算法的评估方法? 20 [填空题]_________________________________2.10 什么样的分类器是最好的? 22 [填空题]_________________________________2.11大数据与深度学习的关系 22 [填空题]_________________________________2.12 理解局部最优与全局最优 23 [填空题]_________________________________2.13 理解逻辑回归 24 [填空题]_________________________________2.14 逻辑回归与朴素贝叶斯有什么区别? 24 [填空题] _________________________________2.15 为什么需要代价函数? 25 [填空题]_________________________________2.16 代价函数作用原理 25 [填空题]_________________________________2.17 为什么代价函数要非负? 26 [填空题]_________________________________2.18 常见代价函数? 26 [填空题]_________________________________2.19为什么用交叉熵代替二次代价函数 28 [填空题]_________________________________2.20 什么是损失函数? 28 [填空题]_________________________________2.21 常见的损失函数 28 [填空题]_________________________________2.22 逻辑回归为什么使用对数损失函数? 30 [填空题] _________________________________0.00 对数损失函数是如何度量损失的? 31 [填空题] _________________________________2.23 机器学习中为什么需要梯度下降? 32 [填空题] _________________________________2.24 梯度下降法缺点? 32 [填空题]_________________________________2.25 梯度下降法直观理解? 32 [填空题]_________________________________2.23 梯度下降法算法描述? 33 [填空题]_________________________________2.24 如何对梯度下降法进行调优? 35 [填空题]_________________________________2.25 随机梯度和批量梯度区别? 35 [填空题]_________________________________2.26 各种梯度下降法性能比较 37 [填空题]_________________________________2.27计算图的导数计算图解? 37 [填空题]_________________________________2.28 线性判别分析(LDA)思想总结 39 [填空题] _________________________________2.29 图解LDA核心思想 39 [填空题]_________________________________2.30 二类LDA算法原理? 40 [填空题]_________________________________2.30 LDA算法流程总结? 41 [填空题]_________________________________2.31 LDA和PCA区别? 41 [填空题]_________________________________2.32 LDA优缺点? 41 [填空题]_________________________________2.33 主成分分析(PCA)思想总结 42 [填空题] _________________________________2.34 图解PCA核心思想 42 [填空题]_________________________________2.35 PCA算法推理 43 [填空题]_________________________________2.36 PCA算法流程总结 44 [填空题]_________________________________2.37 PCA算法主要优缺点 45 [填空题]_________________________________2.38 降维的必要性及目的 45 [填空题]_________________________________2.39 KPCA与PCA的区别? 46 [填空题]_________________________________2.40模型评估 47 [填空题]_________________________________2.40.1模型评估常用方法? 47 [填空题]_________________________________2.40.2 经验误差与泛化误差 47 [填空题]_________________________________2.40.3 图解欠拟合、过拟合 48 [填空题]_________________________________2.40.4 如何解决过拟合与欠拟合? 49 [填空题] _________________________________2.40.5 交叉验证的主要作用? 50 [填空题]_________________________________2.40.6 k折交叉验证? 50 [填空题]_________________________________2.40.7 混淆矩阵 50 [填空题]_________________________________2.40.8 错误率及精度 51 [填空题]_________________________________2.40.9 查准率与查全率 51 [填空题]_________________________________2.40.10 ROC与AUC 52 [填空题]_________________________________2.40.11如何画ROC曲线? 53 [填空题]_________________________________2.40.12如何计算TPR,FPR? 54 [填空题]_________________________________2.40.13如何计算Auc? 56 [填空题]_________________________________2.40.14为什么使用Roc和Auc评价分类器? 56 [填空题]_________________________________2.40.15 直观理解AUC 56 [填空题]_________________________________2.40.16 代价敏感错误率与代价曲线 57 [填空题]_________________________________2.40.17 模型有哪些比较检验方法 59 [填空题]_________________________________2.40.18 偏差与方差 59 [填空题]_________________________________2.40.19为什么使用标准差? 60 [填空题]_________________________________2.40.20 点估计思想 61 [填空题]_________________________________2.40.21 点估计优良性原则? 61 [填空题]_________________________________2.40.22点估计、区间估计、中心极限定理之间的联系? 62 [填空题] _________________________________2.40.23 类别不平衡产生原因? 62 [填空题]_________________________________2.40.24 常见的类别不平衡问题解决方法 62 [填空题] _________________________________2.41 决策树 64 [填空题]_________________________________2.41.1 决策树的基本原理 64 [填空题]_________________________________2.41.2 决策树的三要素? 64 [填空题]_________________________________2.41.3 决策树学习基本算法 65 [填空题]_________________________________2.41.4 决策树算法优缺点 65 [填空题]_________________________________2.40.5熵的概念以及理解 66 [填空题]_________________________________2.40.6 信息增益的理解 66 [填空题]_________________________________2.40.7 剪枝处理的作用及策略? 67 [填空题]_________________________________2.41 支持向量机 67 [填空题]_________________________________2.41.1 什么是支持向量机 67 [填空题]_________________________________2.25.2 支持向量机解决的问题? 68 [填空题]_________________________________2.25.2 核函数作用? 69 [填空题]_________________________________2.25.3 对偶问题 69 [填空题]_________________________________2.25.4 理解支持向量回归 69 [填空题]_________________________________2.25.5 理解SVM(核函数) 69 [填空题]_________________________________2.25.6 常见的核函数有哪些? 69 [填空题]_________________________________2.25.6 软间隔与正则化 73 [填空题]_________________________________2.25.7 SVM主要特点及缺点? 73 [填空题]_________________________________2.26 贝叶斯 74 [填空题]_________________________________2.26.1 图解极大似然估计 74 [填空题]_________________________________2.26.2 朴素贝叶斯分类器和一般的贝叶斯分类器有什么区别? 76 [填空题] _________________________________2.26.4 朴素与半朴素贝叶斯分类器 76 [填空题]_________________________________2.26.5 贝叶斯网三种典型结构 76 [填空题]_________________________________2.26.6 什么是贝叶斯错误率 76 [填空题]_________________________________2.26.7 什么是贝叶斯最优错误率 76 [填空题]_________________________________2.27 EM算法解决问题及实现流程 76 [填空题] _________________________________2.28 为什么会产生维数灾难? 78 [填空题]_________________________________2.29怎样避免维数灾难 82 [填空题]_________________________________2.30聚类和降维有什么区别与联系? 82 [填空题] _________________________________2.31 GBDT和随机森林的区别 83 [填空题]_________________________________2.32 四种聚类方法之比较 84 [填空题] *_________________________________3.1基本概念 88 [填空题]_________________________________3.1.1神经网络组成? 88 [填空题]_________________________________3.1.2神经网络有哪些常用模型结构? 90 [填空题] _________________________________3.1.3如何选择深度学习开发平台? 92 [填空题] _________________________________3.1.4为什么使用深层表示 92 [填空题]_________________________________3.1.5为什么深层神经网络难以训练? 93 [填空题]_________________________________3.1.6深度学习和机器学习有什么不同 94 [填空题]_________________________________3.2 网络操作与计算 95 [填空题]_________________________________3.2.1前向传播与反向传播? 95 [填空题]_________________________________3.2.2如何计算神经网络的输出? 97 [填空题]_________________________________3.2.3如何计算卷积神经网络输出值? 98 [填空题]_________________________________3.2.4如何计算Pooling层输出值输出值? 101 [填空题] _________________________________3.2.5实例理解反向传播 102 [填空题]_________________________________3.3超参数 105 [填空题]_________________________________3.3.1什么是超参数? 105 [填空题]_________________________________3.3.2如何寻找超参数的最优值? 105 [填空题]_________________________________3.3.3超参数搜索一般过程? 106 [填空题]_________________________________3.4激活函数 106 [填空题]_________________________________3.4.1为什么需要非线性激活函数? 106 [填空题]_________________________________3.4.2常见的激活函数及图像 107 [填空题]_________________________________3.4.3 常见激活函数的导数计算? 109 [填空题]_________________________________3.4.4激活函数有哪些性质? 110 [填空题]_________________________________3.4.5 如何选择激活函数? 110 [填空题]_________________________________3.4.6使用ReLu激活函数的优点? 111 [填空题]_________________________________3.4.7什么时候可以用线性激活函数? 111 [填空题]_________________________________3.4.8怎样理解Relu(<0时)是非线性激活函数? 111 [填空题] _________________________________3.4.9 Softmax函数如何应用于多分类? 112 [填空题]_________________________________3.5 Batch_Size 113 [填空题]_________________________________3.5.1为什么需要Batch_Size? 113 [填空题]_________________________________3.5.2 Batch_Size值的选择 114 [填空题]_________________________________3.5.3在合理范围内,增大 Batch_Size 有何好处? 114 [填空题] _________________________________3.5.4盲目增大 Batch_Size 有何坏处? 114 [填空题]_________________________________3.5.5调节 Batch_Size 对训练效果影响到底如何? 114 [填空题] _________________________________3.6 归一化 115 [填空题]_________________________________3.6.1归一化含义? 115 [填空题]_________________________________3.6.2为什么要归一化 115 [填空题]_________________________________3.6.3为什么归一化能提高求解最优解速度? 115 [填空题]_________________________________3.6.4 3D图解未归一化 116 [填空题]_________________________________3.6.5归一化有哪些类型? 117 [填空题]_________________________________3.6.6局部响应归一化作用 117 [填空题]_________________________________3.6.7理解局部响应归一化公式 117 [填空题]_________________________________3.6.8什么是批归一化(Batch Normalization) 118 [填空题] _________________________________3.6.9批归一化(BN)算法的优点 119 [填空题]_________________________________3.6.10批归一化(BN)算法流程 119 [填空题]_________________________________3.6.11批归一化和群组归一化 120 [填空题]_________________________________3.6.12 Weight Normalization和Batch Normalization 120 [填空题] _________________________________3.7 预训练与微调(fine tuning) 121 [填空题]_________________________________3.7.1为什么无监督预训练可以帮助深度学习? 121 [填空题]_________________________________3.7.2什么是模型微调fine tuning 121 [填空题]_________________________________3.7.3微调时候网络参数是否更新? 122 [填空题]_________________________________3.7.4 fine-tuning模型的三种状态 122 [填空题]_________________________________3.8权重偏差初始化 122 [填空题]_________________________________3.8.1 全都初始化为0 122 [填空题]_________________________________3.8.2 全都初始化为同样的值 123 [填空题]_________________________________3.8.3 初始化为小的随机数 124 [填空题]_________________________________3.8.4用1/sqrt(n)校准方差 125 [填空题]_________________________________3.8.5稀疏初始化(Sparse Initialazation) 125 [填空题]_________________________________3.8.6初始化偏差 125 [填空题]_________________________________3.9 Softmax 126 [填空题]_________________________________3.9.1 Softmax定义及作用 126 [填空题]_________________________________3.9.2 Softmax推导 126 [填空题]_________________________________3.10 理解One Hot Encodeing原理及作用? 126 [填空题] _________________________________3.11 常用的优化器有哪些 127 [填空题]_________________________________3.12 Dropout 系列问题 128 [填空题]_________________________________3.12.1 dropout率的选择 128 [填空题]_________________________________3.27 Padding 系列问题 128 [填空题] *_________________________________4.1LetNet5 129 [填空题]_________________________________ 4.1.1模型结构 129 [填空题]_________________________________ 4.1.2模型结构 129 [填空题]_________________________________ 4.1.3 模型特性 131 [填空题]_________________________________ 4.2 AlexNet 131 [填空题]_________________________________ 4.2.1 模型结构 131 [填空题]_________________________________ 4.2.2模型解读 131 [填空题]_________________________________ 4.2.3模型特性 135 [填空题]_________________________________ 4.3 可视化ZFNet-解卷积 135 [填空题] _________________________________ 4.3.1 基本的思想及其过程 135 [填空题] _________________________________ 4.3.2 卷积与解卷积 136 [填空题]_________________________________ 4.3.3卷积可视化 137 [填空题]_________________________________ 4.3.4 ZFNe和AlexNet比较 139 [填空题] _________________________________4.4 VGG 140 [填空题]_________________________________ 4.1.1 模型结构 140 [填空题]_________________________________ 4.1.2 模型特点 140 [填空题]_________________________________ 4.5 Network in Network 141 [填空题] _________________________________ 4.5.1 模型结构 141 [填空题]_________________________________ 4.5.2 模型创新点 141 [填空题]_________________________________ 4.6 GoogleNet 143 [填空题]_________________________________ 4.6.1 模型结构 143 [填空题]_________________________________ 4.6.2 Inception 结构 145 [填空题]_________________________________ 4.6.3 模型层次关系 146 [填空题]_________________________________ 4.7 Inception 系列 148 [填空题]_________________________________ 4.7.1 Inception v1 148 [填空题]_________________________________4.7.2 Inception v2 150 [填空题]_________________________________4.7.3 Inception v3 153 [填空题]_________________________________4.7.4 Inception V4 155 [填空题]_________________________________4.7.5 Inception-ResNet-v2 157 [填空题]_________________________________4.8 ResNet及其变体 158 [填空题]_________________________________4.8.1重新审视ResNet 159 [填空题]_________________________________4.8.2残差块 160 [填空题]_________________________________4.8.3 ResNet架构 162 [填空题]_________________________________4.8.4残差块的变体 162 [填空题]_________________________________4.8.5 ResNeXt 162 [填空题]_________________________________4.8.6 Densely Connected CNN 164 [填空题]_________________________________4.8.7 ResNet作为小型网络的组合 165 [填空题] _________________________________4.8.8 ResNet中路径的特点 166 [填空题]4.9为什么现在的CNN模型都是在GoogleNet、VGGNet或者AlexNet上调整的? 167 [填空题] *_________________________________5.1 卷积神经网络的组成层 170 [填空题]_________________________________5.2 卷积如何检测边缘信息? 171 [填空题]_________________________________5.2 卷积的几个基本定义? 174 [填空题]_________________________________5.2.1卷积核大小 174 [填空题]_________________________________5.2.2卷积核的步长 174 [填空题]_________________________________5.2.3边缘填充 174 [填空题]_________________________________5.2.4输入和输出通道 174 [填空题]_________________________________5.3 卷积网络类型分类? 174 [填空题]_________________________________5.3.1普通卷积 174 [填空题]_________________________________5.3.2扩张卷积 175 [填空题]_________________________________5.3.3转置卷积 176 [填空题]5.3.4可分离卷积 177 [填空题]_________________________________5.3 图解12种不同类型的2D卷积? 178 [填空题]_________________________________5.4 2D卷积与3D卷积有什么区别? 181 [填空题]_________________________________5.4.1 2D 卷积 181 [填空题]_________________________________5.4.2 3D卷积 182 [填空题]_________________________________5.5 有哪些池化方法? 183 [填空题]_________________________________5.5.1一般池化(General Pooling) 183 [填空题]_________________________________5.5.2重叠池化(OverlappingPooling) 184 [填空题]_________________________________5.5.3空金字塔池化(Spatial Pyramid Pooling) 184 [填空题] _________________________________5.6 1x1卷积作用? 186 [填空题]_________________________________5.7卷积层和池化层有什么区别? 187 [填空题]_________________________________5.8卷积核一定越大越好? 189 [填空题]_________________________________5.9每层卷积只能用一种尺寸的卷积核? 189 [填空题]_________________________________5.10怎样才能减少卷积层参数量? 190 [填空题]_________________________________5.11卷积操作时必须同时考虑通道和区域吗? 191 [填空题]_________________________________5.12采用宽卷积的好处有什么? 192 [填空题]_________________________________5.12.1窄卷积和宽卷积 192 [填空题]_________________________________5.12.2 为什么采用宽卷积? 192 [填空题]_________________________________5.13卷积层输出的深度与哪个部件的个数相同? 192 [填空题]_________________________________5.14 如何得到卷积层输出的深度? 193 [填空题]_________________________________5.15激活函数通常放在卷积神经网络的那个操作之后? 194 [填空题] _________________________________5.16 如何理解最大池化层有几分缩小? 194 [填空题]_________________________________5.17理解图像卷积与反卷积 194 [填空题]_________________________________5.17.1图像卷积 194 [填空题]_________________________________5.17.2图像反卷积 196 [填空题]_________________________________5.18不同卷积后图像大小计算? 198 [填空题]_________________________________5.18.1 类型划分 198 [填空题]_________________________________5.18.2 计算公式 199 [填空题]_________________________________5.19 步长、填充大小与输入输出关系总结? 199 [填空题] _________________________________5.19.1没有0填充,单位步长 200 [填空题]_________________________________5.19.2零填充,单位步长 200 [填空题]_________________________________5.19.3不填充,非单位步长 202 [填空题]_________________________________5.19.4零填充,非单位步长 202 [填空题]_________________________________5.20 理解反卷积和棋盘效应 204 [填空题]_________________________________5.20.1为什么出现棋盘现象? 204 [填空题]_________________________________5.20.2 有哪些方法可以避免棋盘效应? 205 [填空题]_________________________________5.21 CNN主要的计算瓶颈? 207 [填空题]_________________________________5.22 CNN的参数经验设置 207 [填空题]_________________________________5.23 提高泛化能力的方法总结 208 [填空题]_________________________________5.23.1 主要方法 208 [填空题]_________________________________5.23.2 实验证明 208 [填空题]_________________________________5.24 CNN在CV与NLP领域运用的联系与区别? 213 [填空题] _________________________________5.24.1联系 213 [填空题]_________________________________5.24.2区别 213 [填空题]_________________________________5.25 CNN凸显共性的手段? 213 [填空题]_________________________________5.25.1 局部连接 213 [填空题]_________________________________5.25.2 权值共享 214 [填空题]_________________________________5.25.3 池化操作 215 [填空题]_________________________________5.26 全卷积与Local-Conv的异同点 215 [填空题]_________________________________5.27 举例理解Local-Conv的作用 215 [填空题]_________________________________5.28 简述卷积神经网络进化史 216 [填空题] *_________________________________6.1 RNNs和FNNs有什么区别? 218 [填空题]_________________________________6.2 RNNs典型特点? 218 [填空题]_________________________________6.3 RNNs能干什么? 219 [填空题]_________________________________6.4 RNNs在NLP中典型应用? 220 [填空题]_________________________________6.5 RNNs训练和传统ANN训练异同点? 220 [填空题] _________________________________6.6常见的RNNs扩展和改进模型 221 [填空题]_________________________________6.6.1 Simple RNNs(SRNs) 221 [填空题]_________________________________6.6.2 Bidirectional RNNs 221 [填空题]_________________________________6.6.3 Deep(Bidirectional) RNNs 222 [填空题]_________________________________6.6.4 Echo State Networks(ESNs) 222 [填空题]_________________________________6.6.5 Gated Recurrent Unit Recurrent Neural Networks 224 [填空题] _________________________________6.6.6 LSTM Netwoorks 224 [填空题]_________________________________6.6.7 Clockwork RNNs(CW-RNNs) 225 [填空题] *_________________________________7.1基于候选区域的目标检测器 228 [填空题]_________________________________7.1.1滑动窗口检测器 228 [填空题]_________________________________7.1.2选择性搜索 229 [填空题]_________________________________7.1.3 R-CNN 230 [填空题]_________________________________7.1.4边界框回归器 230 [填空题]_________________________________7.1.5 Fast R-CNN 231 [填空题]_________________________________7.1.6 ROI 池化 233 [填空题]_________________________________7.1.7 Faster R-CNN 233 [填空题]_________________________________7.1.8候选区域网络 234 [填空题]_________________________________7.1.9 R-CNN 方法的性能 236 [填空题]_________________________________7.2 基于区域的全卷积神经网络(R-FCN) 237 [填空题] _________________________________7.3 单次目标检测器 240 [填空题]_________________________________7.3.1单次检测器 241 [填空题]_________________________________7.3.2滑动窗口进行预测 241 [填空题]_________________________________7.3.3 SSD 243 [填空题]_________________________________7.4 YOLO系列 244 [填空题]_________________________________7.4.1 YOLOv1介绍 244 [填空题]_________________________________7.4.2 YOLOv1模型优缺点? 252 [填空题]_________________________________7.4.3 YOLOv2 253 [填空题]_________________________________7.4.4 YOLOv2改进策略 254 [填空题]_________________________________7.4.5 YOLOv2的训练 261 [填空题]_________________________________7.4.6 YOLO9000 261 [填空题]_________________________________7.4.7 YOLOv3 263 [填空题]_________________________________8.1 传统的基于CNN的分割方法缺点? 269 [填空题]_________________________________8.1 FCN 269 [填空题]_________________________________8.1.1 FCN改变了什么? 269 [填空题]_________________________________8.1.2 FCN网络结构? 270 [填空题]_________________________________8.1.3全卷积网络举例? 271 [填空题]_________________________________8.1.4为什么CNN对像素级别的分类很难? 271 [填空题]_________________________________8.1.5全连接层和卷积层如何相互转化? 272 [填空题]_________________________________8.1.6 FCN的输入图片为什么可以是任意大小? 272 [填空题]_________________________________8.1.7把全连接层的权重W重塑成卷积层的滤波器有什么好处? 273 [填空题] _________________________________8.1.8反卷积层理解 275 [填空题]_________________________________8.1.9跳级(skip)结构 276 [填空题]_________________________________8.1.10模型训练 277 [填空题]_________________________________8.1.11 FCN缺点 280 [填空题]_________________________________8.2 U-Net 280 [填空题]_________________________________8.3 SegNet 282 [填空题]_________________________________8.4空洞卷积(Dilated Convolutions) 283 [填空题] _________________________________8.4 RefineNet 285 [填空题]_________________________________8.5 PSPNet 286 [填空题]_________________________________8.6 DeepLab系列 288 [填空题]_________________________________8.6.1 DeepLabv1 288 [填空题]_________________________________8.6.2 DeepLabv2 289 [填空题]_________________________________8.6.3 DeepLabv3 289 [填空题]_________________________________8.6.4 DeepLabv3+ 290 [填空题]_________________________________8.7 Mask-R-CNN 293 [填空题]_________________________________8.7.1 Mask-RCNN 的网络结构示意图 293 [填空题]_________________________________8.7.2 RCNN行人检测框架 293 [填空题]_________________________________8.7.3 Mask-RCNN 技术要点 294 [填空题]_________________________________8.8 CNN在基于弱监督学习的图像分割中的应用 295 [填空题] _________________________________8.8.1 Scribble标记 295 [填空题]_________________________________8.8.2 图像级别标记 297 [填空题]_________________________________8.8.3 DeepLab+bounding box+image-level labels 298 [填空题]_________________________________8.8.4统一的框架 299 [填空题] *_________________________________9.1强化学习的主要特点? 301 [填空题]_________________________________9.2强化学习应用实例 302 [填空题]_________________________________9.3强化学习和监督式学习、非监督式学习的区别 303 [填空题] _________________________________9.4 强化学习主要有哪些算法? 305 [填空题]_________________________________9.5深度迁移强化学习算法 305 [填空题]_________________________________9.6分层深度强化学习算法 306 [填空题]_________________________________9.7深度记忆强化学习算法 306 [填空题]_________________________________9.8 多智能体深度强化学习算法 307 [填空题]_________________________________9.9深度强化学习算法小结 307 [填空题] *_________________________________10.1 什么是迁移学习? 309 [填空题]_________________________________10.2 什么是多任务学习? 309 [填空题]_________________________________10.3 多任务学习有什么意义? 309 [填空题]_________________________________10.4 什么是端到端的深度学习? 311 [填空题]_________________________________10.5 端到端的深度学习举例? 311 [填空题]_________________________________10.6 端到端的深度学习有什么挑战? 311 [填空题] _________________________________10.7 端到端的深度学习优缺点? 312 [填空题] *_________________________________13.1 CPU和GPU 的区别? 314 [填空题]_________________________________13.2如何解决训练样本少的问题 315 [填空题]_________________________________13.3 什么样的样本集不适合用深度学习? 315 [填空题]_________________________________13.4 有没有可能找到比已知算法更好的算法? 316 [填空题]_________________________________13.5 何为共线性, 跟过拟合有啥关联? 316 [填空题]_________________________________13.6 广义线性模型是怎被应用在深度学习中? 316 [填空题]_________________________________13.7 造成梯度消失的原因? 317 [填空题]_________________________________13.8 权值初始化方法有哪些 317 [填空题]_________________________________13.9 启发式优化算法中,如何避免陷入局部最优解? 318 [填空题]_________________________________13.10 凸优化中如何改进GD方法以防止陷入局部最优解 319 [填空题] _________________________________13.11 常见的损失函数? 319 [填空题]_________________________________13.14 如何进行特征选择(feature selection)? 321 [填空题]_________________________________13.14.1 如何考虑特征选择 321 [填空题]_________________________________13.14.2 特征选择方法分类 321 [填空题]_________________________________13.14.3 特征选择目的 322 [填空题]_________________________________13.15 梯度消失/梯度爆炸原因,以及解决方法 322 [填空题]_________________________________13.15.1 为什么要使用梯度更新规则? 322 [填空题]_________________________________13.15.2 梯度消失、爆炸原因? 323 [填空题]_________________________________13.15.3 梯度消失、爆炸的解决方案 324 [填空题]_________________________________13.16 深度学习为什么不用二阶优化 325 [填空题]_________________________________13.17 怎样优化你的深度学习系统? 326 [填空题]_________________________________13.18为什么要设置单一数字评估指标? 326 [填空题]_________________________________13.19满足和优化指标(Satisficing and optimizing metrics) 327 [填空题] _________________________________13.20 怎样划分训练/开发/测试集 328 [填空题]_________________________________13.21如何划分开发/测试集大小 329 [填空题]_________________________________13.22什么时候该改变开发/测试集和指标? 329 [填空题]_________________________________13.23 设置评估指标的意义? 330 [填空题]_________________________________13.24 什么是可避免偏差? 331 [填空题]_________________________________13.25 什么是TOP5错误率? 331 [填空题]_________________________________13.26 什么是人类水平错误率? 332 [填空题]_________________________________13.27 可避免偏差、几大错误率之间的关系? 332 [填空题] _________________________________13.28 怎样选取可避免偏差及贝叶斯错误率? 332 [填空题] _________________________________13.29 怎样减少方差? 333 [填空题]_________________________________13.30贝叶斯错误率的最佳估计 333 [填空题]_________________________________13.31举机器学习超过单个人类表现几个例子? 334 [填空题] _________________________________13.32如何改善你的模型? 334 [填空题]_________________________________13.33 理解误差分析 335 [填空题]_________________________________13.34 为什么值得花时间查看错误标记数据? 336 [填空题] _________________________________13.35 快速搭建初始系统的意义? 336 [填空题]_________________________________13.36 为什么要在不同的划分上训练及测试? 337 [填空题] _________________________________13.37 如何解决数据不匹配问题? 338 [填空题]_________________________________13.38 梯度检验注意事项? 340 [填空题]_________________________________13.39什么是随机梯度下降? 341 [填空题]_________________________________13.40什么是批量梯度下降? 341 [填空题]_________________________________13.41什么是小批量梯度下降? 341 [填空题]_________________________________13.42怎么配置mini-batch梯度下降 342 [填空题]_________________________________13.43 局部最优的问题 343 [填空题]_________________________________13.44提升算法性能思路 346 [填空题] *_________________________________14.1 调试处理 358 [填空题]_________________________________14.2 有哪些超参数 359 [填空题]_________________________________14.3 如何选择调试值? 359 [填空题]_________________________________14.4 为超参数选择合适的范围 359 [填空题]_________________________________14.5 如何搜索超参数? 359 [填空题] *_________________________________15.1 什么是正则化? 361 [填空题]_________________________________15.2 正则化原理? 361 [填空题]_________________________________15.3 为什么要正则化? 361 [填空题]_________________________________15.4 为什么正则化有利于预防过拟合? 361 [填空题] _________________________________15.5 为什么正则化可以减少方差? 362 [填空题]_________________________________15.6 L2正则化的理解? 362 [填空题]_________________________________15.7 理解dropout 正则化 362 [填空题]_________________________________15.8 有哪些dropout 正则化方法? 362 [填空题]_________________________________15.8 如何实施dropout 正则化 363 [填空题]_________________________________。

SequencetoSequenceLearningwithNeuralNetworks(。。。

SequencetoSequenceLearningwithNeuralNetworks(。

1. Introduction本⽂提出了⼀种端到端的序列学习⽅法,并将其⽤于英语到法语的机器翻译任务中。

使⽤多层LSTM将输⼊序列映射为固定维数的表⽰向量,然后使⽤另⼀个多层LSTM从该向量解码得到⽬标序列。

作者还提出,颠倒输⼊序列的单词序列可以提⾼LSTM的性能,因为这在源和⽬标序列之间引⼊了许多短期依赖性。

之前的DNN只能将源序列和⽬标序列编码为固定维数的向量,⽽许多问题需⽤长度不是先验已知的序列表⽰,例如语⾳识别、机器翻译。

本⽂的想法是,使⽤⼀个LSTM读取源序列逐步得到固定维数的表⽰向量,然后⽤另⼀个LSTM从该表⽰向量中得到⽬标序列,第⼆个LSTM本质上是⼀个RNN语⾔模型,只是它以输⼊序列为条件。

由于输⼊与输出之间有很⼤的时间延迟,所以使⽤具有学习长时间依赖关系的数据能⼒的LSTM(如下图)。

测试结果表明,该模型在机器翻译任务中可以得到不错的BLEU score,显著地优于统计机器翻译基线(SMT baseline)。

令⼈惊讶的是,LSTM在长句⼦的训练上也没有什么问题,原因是颠倒了输⼊序列单词的顺序。

另外,编码的LSTM将变长序列映射为维数固定的向量,传统的SMT⽅法倾向于逐字翻译,⽽LSTM能够学习句⼦的含义,具有相似含义的句⼦在表⽰向量中距离近,不同含义的句⼦则距离远。

⼀项评估表明,该模型可以学习到单词的顺序,并且对主动和被动语态具有不变性。

2. The modelRNN是前馈神经⽹络的⼀种⾃然泛化。

给定⼀个输⼊序列{ \left( x\mathop{{}}\nolimits_{{1}},...,x\mathop{{}}\nolimits_{{T}} \right) },RNN通过以下公式迭代计算出输出:{\begin{array}{*{20}{l}} {h\mathop{{}}\nolimits_{{t}}= \sigma \left(W\mathop{{}}\nolimits^{{hx}}x\mathop{{}}\nolimits_{{t}}+W\mathop{{}}\nolimits^{{hh}}h\mathop{{}}\nolimits_{{t-1}} \right) }\\{y\mathop{{}}\nolimits_{{t}}=W\mathop{{}}\nolimits^{{yh}}h\mathop{{}}\nolimits_{{t}}} \end{array}}只要事先知道输⼊与输出之间的对齐⽅式,RNN就可以将序列映射到序列。

多标签分类,汉明loss原理与公式

多标签分类,汉明loss原理与公式

汉明损失(Hamming Loss)在多标签分类问题中是一种常用的评价指标,其原理和公式如下:

汉明损失的原理是衡量所有标签中错误样本的比例,该值越小则网络的分类能力越强。

具体来说,对于一个样本,如果其真实标签为y,预测标签为h(x),那么汉明损失就是预测标签与真实标签之间不一致的比率。

其计算公式为:

$h\_{hamming\_{loss}}(h) = \frac{1}{N} \sum_{i=1}^{N} \frac{1}{C}

h(x_{i}) \oplus y_{i}$

其中,$N$ 是样本总数,$C$ 是标签总数,$x_{i}$ 和 $y_{i}$ 分别表示第$i$ 个样本的预测结果和真实标签,$h(x_{i})$ 表示第 $i$ 个样本的预测标签,$\oplus$ 表示异或运算。

汉明损失的计算过程是,对于每个样本,将预测标签与真实标签进行异或运算,然后计算不一致的比率。

由于每个样本可能有多个标签,因此需要将每个标签的不一致比率相加后再除以总的标签数。

最后将所有样本的汉明损失求和并除以样本总数,得到整体的汉明损失。

希望以上信息对你有帮助,如需更多信息,建议查阅机器学习相关书籍或咨询专业人士。

nn.multiheadattention使用示例

nn.multiheadattention使用示例nn.MultiheadAttention使用示例深度学习领域中,自然语言处理(Natural Language Processing,NLP)是一个热门的研究方向。

在NLP任务中,机器需要具备对文本的理解和处理能力,其中包括序列到序列任务(Sequence-to-Sequence,Seq2Seq)和文本分类任务。

为了更好地处理这类任务,谷歌的深度学习框架PyTorch 提供了nn.MultiheadAttention模块。

本文将从基本概念出发,介绍如何使用nn.MultiheadAttention模块,并结合一个具体的示例来展示它的用法。

1. 模块介绍nn.MultiheadAttention是PyTorch中用于实现多头注意力机制的模块。

注意力机制是一种机器学习的技术,用于给予模型对不同输入的不同关注程度。

MultiheadAttention可以将一个输入序列映射到另一个序列,通过计算输入和输出序列之间的注意力分布。

该模块将输入序列划分为多个头,并为每个头计算注意力权重,最后将所有头的注意力结果相加。

这种方式可以增强模型对输入序列的表示能力,提高模型的性能。

2. 使用示例为了更好地理解nn.MultiheadAttention的使用方法,我们以文本分类任务为例来进行说明。

假设我们有一个文本分类问题,需要将一段文本划分到不同的类别中。

首先,我们需要将文本编码成词嵌入向量,然后使用nn.MultiheadAttention模块对其进行处理。

2.1 载入数据集首先,我们需要载入文本数据集,将其转换成PyTorch可以处理的形式。

在这个示例中,我们使用的是IMDB情感分类数据集,其中包含50,000个带标签的电影评论,共分为正面和负面两类。

我们可以使用torchtext 库来进行数据预处理和加载。

pythonimport torchfrom torchtext.legacy import datafrom torchtext.legacy import datasets# 定义使用的文本字段text_field = data.Field(tokenize='spacy', lower=True)# 下载IMDB数据集train_data, test_data = datasets.IMDB.splits(text_field)# 构建词汇表text_field.build_vocab(train_data, max_size=10000,vectors="glove.6B.100d")# 创建数据迭代器train_iterator, test_iterator = data.BucketIterator.splits( (train_data, test_data), batch_size=32,device=torch.device("cuda:0" if torch.cuda.is_available() else "cpu"))2.2 定义模型然后,我们需要定义一个包含nn.MultiheadAttention模块的文本分类模型。

nn.multiheadattention使用示例 -回复

nn.multiheadattention使用示例-回复NN.MultiheadAttention是PyTorch中的一个模块,它可以用于实现多头注意力机制。

在自然语言处理和计算机视觉等领域,多头注意力机制已经被广泛应用。

本文将围绕着nn.MultiheadAttention的用法展开,并通过一个示例来详细介绍它的使用。

1. 什么是多头注意力机制?在介绍nn.MultiheadAttention之前,我们先简单介绍一下多头注意力机制。

多头注意力机制是一种机器学习中常用的基本操作,用于在给定一组查询(Q)、键(K)和值(V)的情况下,通过计算相似度得分来对值进行加权求和。

具体而言,给定一个查询向量q、一组键向量k以及一组值向量v,多头注意力机制会计算每个查询向量对每个键向量的相似度得分,然后将这些得分作为权重来加权求和对应的值向量,得到最终的加权求和结果。

多头注意力机制通常会通过并行计算多个注意力头,并将它们的输出进行拼接或加权求和。

这样做可以使模型更有效地捕捉输入中的不同关注点。

2. nn.MultiheadAttention的基本用法PyTorch提供了内置的nn.MultiheadAttention模块,用于实现多头注意力机制。

我们可以通过以下代码示例来演示nn.MultiheadAttention的基本用法:import torchimport torch.nn as nn# 定义输入的维度embed_dim = 256# 创建一个MultiheadAttention实例multihead_attn = nn.MultiheadAttention(embed_dim,num_heads=8)# 构造输入数据,假设有batch_size个样本,每个样本的序列长度为seq_len,特征维度为embed_dimbatch_size = 32seq_len = 10input_tensor = torch.randn(seq_len, batch_size, embed_dim)# 将输入传入MultiheadAttention,并获取输出output_tensor, _ = multihead_attn(input_tensor, input_tensor, input_tensor)# 查看输出的形状print(output_tensor.shape)在这个示例中,我们首先创建了一个nn.MultiheadAttention的实例,指定了输入数据的维度embed_dim和注意力头的数量num_heads。

poly_features.transform的用法

poly_features.transform的用法简介在机器学习领域中,特征工程是非常重要的一步,可以帮助我们将原始数据转化为适合机器学习算法处理的形式。

在特征工程中,多项式特征转换是一个常见且有效的方法。

而`p ol y_f ea tu re s.tr an sfo r m`是S c ik it-l ea rn库中用于进行多项式特征转换的一个工具。

什么是多项式特征转换多项式特征转换是指将原始特征的幂次组合作为新特征的过程。

它通过添加原始特征的高次项以及特征间的交互项,从而可以更好地捕捉特征之间的非线性关系。

例如,对于一元线性回归问题,我们可以使用2次多项式特征转换将数据拟合成一个二次曲线。

多项式特征转换的公式如下:$$\t ex t{tr an sf or m}(X)=[1,X,X^2,\ldo t s,X^d]$$其中,$X$是原始特征,$d$是转换的阶数。

使用poly_f eatures.tr ansform进行多项式特征转换在S ci ki t-le ar n库中,我们可以使用`p ol y_fe at ur es.tr a ns fo rm`方法来进行多项式特征转换。

下面将介绍其使用方法。

首先,需要导入相应的库和模块:f r om sk le ar n.pr epr o ce ss in gi mp or tPo l yn om ia lF ea tu res接下来,我们需要创建一个`Po ly no mi al F ea tu re s`对象,指定转换的阶数:p o ly=P ol yn om ia lFe a tu re s(de gr ee=d)其中,`d`表示转换的阶数。

然后,我们可以使用`f it_t ra ns fo rm`方法将原始特征进行转换:X_tr an sf or m e d=pol y.f it_t ra ns fo rm(X)其中,`X`是原始特征的数据。

最后,我们可以得到转换后的特征数据`X_tr an sf or me d`,即多项式特征转换后的结果。

poly_reg.fit_transform(x)原理

poly_reg.fit_transform(x)原理全文共四篇示例,供读者参考第一篇示例:在机器学习中,多项式回归是一种用于拟合非线性数据的方法。

通常情况下,线性模型无法很好地拟合非线性数据,因此我们需要引入多项式回归来增加模型的灵活性。

在Python中,我们可以使用sklearn库中的PolynomialFeatures类来进行多项式特征转换,其中的poly_reg.fit_transform(x)方法就是其中之一。

当我们调用poly_reg.fit_transform(x)方法时,它的主要作用是将原始特征矩阵x转换为包含多项式特征的矩阵。

简单来说,它将原始特征矩阵中的每一个特征进行多项式化,生成新的特征矩阵,从而为模型提供更多的信息。

这样做的主要目的是为了增加模型的复杂度,使得模型可以更好地捕捉数据中的非线性关系。

具体来说,poly_reg.fit_transform(x)方法会将原始特征矩阵x中的每个特征进行多项式化,生成包含所有可能组合的新特征矩阵。

如果原始特征矩阵x只包含一个特征x1,且我们将多项式的次数设置为2,那么poly_reg.fit_transform(x)方法将生成包含x1和x1^2两个特征的新特征矩阵。

在实际应用中,我们可以将多项式的次数设置为任意值,从而生成不同阶数的多项式特征。

除了将特征进行多项式化外,poly_reg.fit_transform(x)方法还会添加一个截距项,即常数项。

这个常数项通常用于拟合数据中的偏差,从而提高模型的拟合度。

通过这种方式,我们可以获得一个更加灵活的模型,可以更好地拟合非线性数据。

需要注意的是,多项式回归虽然可以很好地拟合非线性数据,但也存在过拟合的风险。

在使用多项式回归时,我们需要谨慎选择多项式的次数,以防止模型过度复杂化。

一般来说,可以通过交叉验证等方法来选择合适的多项式次数,从而获得一个既能很好地拟合数据又不会过度拟合的模型。

poly_reg.fit_transform(x)方法是多项式回归中一个非常重要的步骤,它可以帮助我们将原始特征矩阵转换为包含多项式特征的矩阵,从而提高模型的拟合能力。

transformers trainer 参数

Transformers Trainer 是Hugging Face Transformers 库中的一个类,用于训练模型。

其参数包括:1. model: 预训练模型。

可以是任何Hugging Face Transformers 模型。

2. train_dataset: 训练数据集。

可以是列表,列表的元素可以是任何类型的输入数据,例如Pandas DataFrame, Numpy array, 等等。

也可以是直接的数据文件,例如JSON, CSV, 或者直接是包含数据的文件路径。

3. eval_dataset: 验证数据集。

和train_dataset 类似,也可以是列表,列表的元素可以是任何类型的输入数据,例如Pandas DataFrame, Numpy array, 等等。

也可以是直接的数据文件,例如JSON, CSV, 或者直接是包含数据的文件路径。

4. output_dir: 输出目录。

模型训练和评估的结果将保存在这个目录下。

5. num_train_epochs: 训练轮数。

6. per_device_train_batch_size: 每个设备的训练批次大小。

7. per_device_eval_batch_size: 每个设备的评估批次大小。

8. warmup_steps: 学习率的预热步数。

9. weight_decay: 权重衰减值。

10. logging_dir: 日志目录。

模型的训练和评估日志将保存在这个目录下。

11. logging_steps: 每隔多少步打印日志。

12. learning_rate: 学习率。

13. adam_beta1 和adam_beta2: Adam优化器的参数。

14. adam_epsilon: Adam优化器的epsilon 值。

15. max_grad_norm: 梯度的最大范数。

如果大于0,会进行梯度裁剪。

16. use_fast_tokenizer: 是否使用快速的tokenizer。

transformer模型用法

transformer模型用法英文回答:Transformers are a type of neural network that has become increasingly popular in natural language processing (NLP) tasks. They are particularly well-suited for tasksthat involve understanding the meaning of text, such as machine translation, text summarization, and question answering.Transformers work by attending to different parts ofthe input sequence. This allows them to capture long-range dependencies between words and phrases, which is essential for understanding the meaning of text. Transformers alsouse self-attention, which allows them to learnrelationships between different parts of the input sequence.There are many different types of transformers, eachwith its own strengths and weaknesses. Some of the most popular transformer models include:BERT: BERT (Bidirectional Encoder Representations from Transformers) is a transformer model that was developed by Google. BERT is a large transformer model that has been trained on a massive dataset of text. BERT has achieved state-of-the-art results on a wide range of NLP tasks.GPT-3: GPT-3 (Generative Pre-trained Transformer 3) is a transformer model that was developed by OpenAI. GPT-3 is a very large transformer model that has been trained on a massive dataset of text and code. GPT-3 can generate text, translate languages, and answer questions.T5: T5 (Text-To-Text Transfer Transformer) is a transformer model that was developed by Google. T5 is a general-purpose transformer model that can be used for a wide range of NLP tasks. T5 has achieved state-of-the-art results on a variety of NLP tasks, including machine translation, text summarization, and question answering.Transformers are a powerful tool for NLP tasks. They have achieved state-of-the-art results on a wide range oftasks, and they are likely to continue to play an important role in NLP research and development in the years to come.中文回答:Transformer模型是一种神经网络,在自然语言处理(NLP)任务中变得越来越流行。

transformer模型 的例子

transformer模型的例子Transformer模型是一种深度学习模型,由Google在2017年提出,广泛应用于自然语言处理任务。

Transformer模型的核心思想是使用自注意力机制(self-attention)来建立全局上下文关系,避免了传统循环神经网络(RNN)的局限性,能够并行计算,提升了训练和推断的效率。

Transformer模型的一个经典示例是用于机器翻译任务的模型,即将一种语言的句子翻译成另一种语言。

以下将对Transformer模型在机器翻译任务中的应用进行详细介绍。

在Transformer中,输入的句子首先经过词嵌入层(Embedding Layer),将每个词转换为一个向量表示。

这些向量表示被传递给Encoder层进行处理。

Encoder层主要由多个编码器堆叠而成,每个编码器由两个子层组成:多头自注意力层(Multi-head Self-Attention Layer)和前馈神经网络层(Feed-forward Neural Network Layer)。

多头自注意力层能够根据输入的词序列,计算每个词与其他词的关联程度,从而捕捉到句子的上下文信息。

它通过将输入的词序列分别映射到多个子空间,然后在每个子空间上计算注意力权重,并融合这些权重来得到最终的输出。

这种多头机制可以提取更丰富的特征表示。

前馈神经网络层则用于对自注意力层输出的特征进行进一步处理。

它通过使用全连接层和激活函数对每个位置上的特征向量进行非线性变换,从而增强特征的表达能力。

编码器层的输出被传递给解码器层,解码器也是由多个解码器堆叠而成。

每个解码器与编码器类似,由两个子层组成:自注意力层和编码器-解码器注意力层。

自注意力层用于计算解码器的上下文信息,而编码器-解码器注意力层则用于对编码器层输出进行注意力计算,以捕捉源语言句子和目标语言句子之间的对应关系。

解码器的最后一层输出经过一个线性变换和Softmax函数,得到目标语言句子的概率分布,根据概率分布进行翻译的选择。

simcse 在few-shot中的公式

simCSE 在few-shot中的公式

SimCSE是一种基于对比学习的无监督文本表示学习方法,它在few-shot learning(少样本学习)中的公式如下:

设两个句子分别为句子1和句子2,句子1的表示为z1,句子2的表示

为z2,句子1和句子2之间的相似性为s12。

SimCSE的目标是最大化所有相似句子对的相似性,同时最小化所有不相似句子对的相似性。

具体来说,SimCSE的损失函数为:

L=−N1∑i=1N log∑j=1Nesijesi1

其中,N是训练样本的数量,si1是第i个样本与第1个样本之间的相似性,sij是第i个样本与第j个样本之间的相似性。

在few-shot learning中,SimCSE通常与迁移学习和微调技术结合使用。

具体来说,在训练阶段,SimCSE可以在大规模无标注语料库上训练出高质量的文本表示模型;在测试阶段,将训练好的模型用于少量的标注样本中,通过微调技术使模型适应新的任务。

这样可以在没有大量标注样本的情况下实现有效的文本分类和检索等任务。

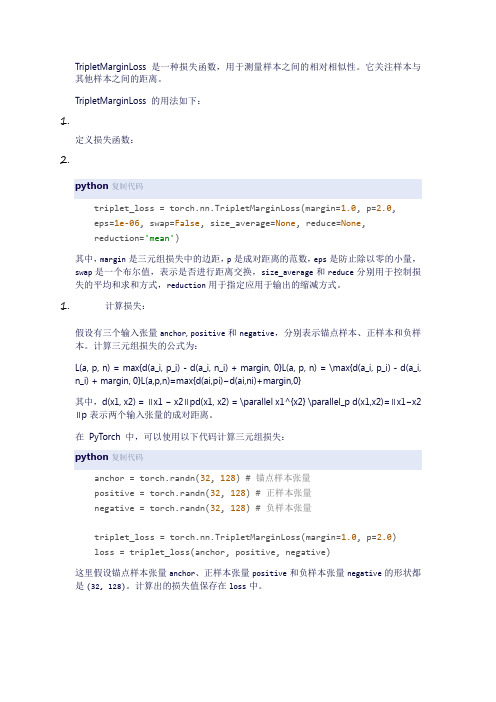

tripletmarginloss用法

TripletMarginLoss 是一种损失函数,用于测量样本之间的相对相似性。

它关注样本与其他样本之间的距离。

TripletMarginLoss 的用法如下:1.定义损失函数:2.python复制代码triplet_loss = torch.nn.TripletMarginLoss(margin=1.0, p=2.0,eps=1e-06, swap=False, size_average=None, reduce=None,reduction='mean')其中,margin是三元组损失中的边距,p是成对距离的范数,eps是防止除以零的小量,swap是一个布尔值,表示是否进行距离交换,size_average和reduce分别用于控制损失的平均和求和方式,reduction用于指定应用于输出的缩减方式。

1.计算损失:假设有三个输入张量anchor, positive和negative,分别表示锚点样本、正样本和负样本。

计算三元组损失的公式为:L(a, p, n) = max{d(a_i, p_i) - d(a_i, n_i) + margin, 0}L(a, p, n) = \max{d(a_i, p_i) - d(a_i, n_i) + margin, 0}L(a,p,n)=max{d(ai,pi)−d(ai,ni)+margin,0}其中,d(x1, x2) = ∥x1 − x2∥pd(x1, x2) = \parallel x1^{x2} \parallel_p d(x1,x2)=∥x1−x2∥p表示两个输入张量的成对距离。

在PyTorch 中,可以使用以下代码计算三元组损失:python复制代码anchor = torch.randn(32, 128) # 锚点样本张量positive = torch.randn(32, 128) # 正样本张量negative = torch.randn(32, 128) # 负样本张量triplet_loss = torch.nn.TripletMarginLoss(margin=1.0, p=2.0)loss = triplet_loss(anchor, positive, negative)这里假设锚点样本张量anchor、正样本张量positive和负样本张量negative的形状都是(32, 128)。

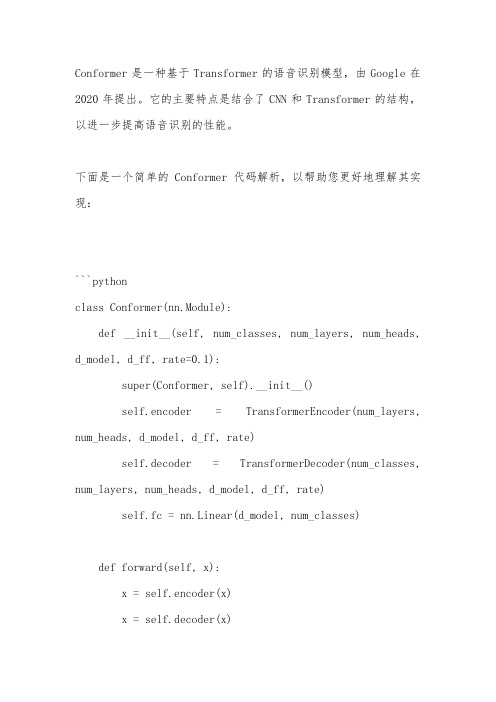

conformer 代码解析

Conformer是一种基于Transformer的语音识别模型,由Google在2020年提出。

它的主要特点是结合了CNN和Transformer的结构,以进一步提高语音识别的性能。

下面是一个简单的Conformer代码解析,以帮助您更好地理解其实现:```pythonclass Conformer(nn.Module):def __init__(self, num_classes, num_layers, num_heads, d_model, d_ff, rate=0.1):super(Conformer, self).__init__()self.encoder = TransformerEncoder(num_layers, num_heads, d_model, d_ff, rate)self.decoder = TransformerDecoder(num_classes, num_layers, num_heads, d_model, d_ff, rate)self.fc = nn.Linear(d_model, num_classes)def forward(self, x):x = self.encoder(x)x = self.decoder(x)x = self.fc(x)return x```在上面的代码中,`Conformer`类继承了PyTorch中的`nn.Module`类,表示它是一个自定义的神经网络模型。

该模型包含三个主要部分:`encoder`、`decoder`和`fc`。

1. `encoder`:该部分使用Transformer结构对输入数据进行编码。

它接受一个输入张量`x`,并返回一个编码后的张量。

2. `decoder`:该部分使用Transformer结构对编码后的数据进行解码,并输出最终的识别结果。

它接受编码后的张量作为输入,并使用分类器将其转换为最终的识别结果。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

12 Three ways to model a chine hullThere are three ways of producing surface discontinuities (or chines) in a hull:1) Compacted control pointsOnly a single surface, useful for blending a chine into a round bilge. More complicated fairing, more difficult to adjust spline stiffness. Non-optimum control point distribution for different areas of surface.2) Using Bonded EdgesSurfaces move together can be advantage or disadvantage3) Trimmed surfacesSurfaces independent, each can be faired independently. Cannot blend to round bilge.For a complete list of steps to produce a chined hull using any of the above three methods, see Tutorial 5.12.1. Step-by-step: Chine hull using linear surfacesPerhaps the simplest way to make a chine hull is to make the transverse flexibility of the surface linear (order 2). This will make the surface piecewise linear, with straight lines joining the control points. You can still maintain a smooth hull in the longitudinal direction by using a flexibility of 3 or more in the longitudinal direction.12.1.1. Create a new design and add a default surfaceSelect New from the File menu. If you have an existing design open, you will have to close it first.To add a surface select Surfaces | Add Surface | Default. This will add the default surface, which will be fine for this example.In the Perspective window, you should have something like this (turn on the Net to show all the control points, and turn on the Half display so that you see just one side – use the commands in the Display menu):12.1.2. Change the surface flexibilityNote that the ends of the default surface you have just added are curved. We will now change the surface's transverse flexibility so that it is linear.Select Surfaces | Properties | Default:you can then set the transverse flexibility to 2 (linear):click OK and notice that the ends of the surface have now changed so that they are straight lines:12.1.3. Fairing the ProfileThe next stage is to fair the profile. To do this change to the Profile view:We will add some shear to the hull by lifting the forward control point a little. Remember that there is only one control point here, so it can be selected just by clicking the mouse on it and dragging it to its final position:Now move the forefoot up a bit. Remember, there are two points here so select them both by dragging a box over them:Then click on the selected control points to move them:12.1.4. Fairing the planWe will now fair the plan shape, so switch to the Plan window:First we will close the bow, by dragging all the forward control points onto the centreline: If you hold the shift key down whilst dragging them, they will only move in the vertical or horizontal direction. This helps to just move them into the centreline without moving them longitudinally:Now close the transom a little. Remember that there are two points here so drag a box over the control points to select them both and move them into the centreline a little:Review the design in the Perspective window, try turning on the rendering to get a better idea of the shape (Display | Render | Smooth Shading). Note, to get the best shading, ensure that the outside arrow is pointing outwards. Turn on the outside arrows in the Display menu, and click on the arrow's tip to flip its direction:12.1.5. Fairing the sectionIn the Body Plan window you can fair the sections more accurately. Change to the Body plan view and don’t forget to turn off the Net so that you can only see the control points for the current column. Also turn off the rendering to speed up the program:To better visualise the shape, we shall add some sections. This is done in the Data | Grid Spacing dialog:Click the Add button and type 11 stations. Then click on the Space button and select "Evenly along the length of the model". When you click OK, the station positions will have been automatically calculated:Click OK to close the window.In the Body Plan Window, when you click on one of the control point column indicators in the inset window, the current control point column will change and the closest section to this column will be displayed. Click on the indicator for the middle control point columnIf you wish to have a single chine hull, simply move the chine control point to the desired location.Then do the same thing for the aft control point row. First click on the left hand control point column indicator to get the aft control point column, then move the middle control point to get the desired deadrise:You can then turn on all the sections (Display | Contours dialog, or use the Toolbar button ) It is also a good idea to turn on the "Feature Lines" in the Display | Contours dialog as this will highlight the chine:Also review the design in the Perspective window (you can turn off the Grid from the Display menu to see the shape more clearly):12.1.6. Adding more chinesYou may want to add more chines to the design. To do this go back to the Body Plan view and select the middle control point column by using the control point indicator in the inset window:To add a chine, we must add extra control point rows. To do this, select Controls | Add Row, or use the Toolbar button . Then click at the location where you want to insert the extra row. Add two rows as shown below:Then fair the control point positions for each of the columns to get the desired shape. You may also want to refine the design in the Profile view, especially to get the forefoot correct. Here is the final design in the Perspective view:12.1.7. Controlling the longitudinal shapeThe longitudinal shape can be manipulated in the Plan and Profile views. You can also add more control point rows so that you have more control over the shape.。