基于无人机图像的密集匹配方法研究_蔡龙洲

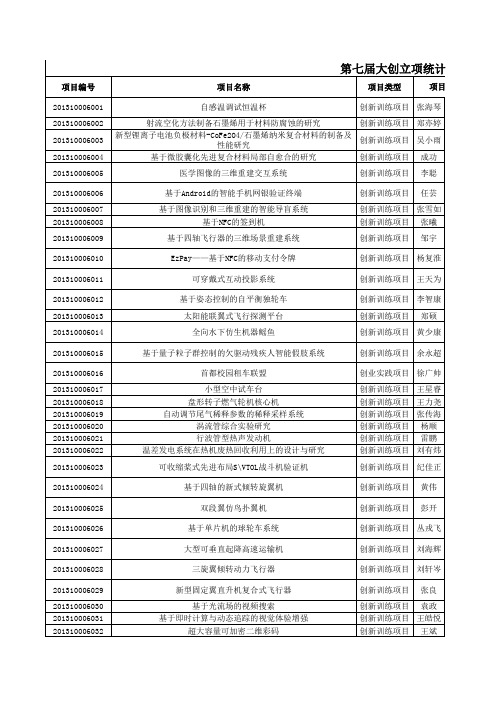

第七届大创立项统计表-公布版

201310006100 201310006101 201310006102 201310006103 201310006104 201310006105 201310006106

从“缺失的井盖”看井盖的管理问题--以北京市昌平区为研究对 创新训练项目 刘琼 象 具有RFID功能的RC车模计时系统设计与制作 创新训练项目 刘家曦 自行车娱乐平台(BikeTraveller) 创新训练项目 郑嘉雷 远程监控机器人 创新训练项目 朱晨 创业实践 “佼脚者”计划 潘琛 项目 基于无人机技术的农用飞防应用项目 基于三轴云台的直升机航拍系统 创业实践 项目 创业实践 项目 宋贺腾 王亚龙

自适应像素填充应用技术 地理围栏概念下的LBS系统 个性化聊天表情生成软件 大学生旧书旧物出售网络平台 全功能勘探车结构及控制研究 便携式插头 新型油阻式离合器 基于VR虚拟现实的图景导航应用 民航起降阶段防鸟撞装置 应用机器视觉的SLAM小车设计 全局视觉导航的特种飞行机器人 北京高校校园手机充电机布局的最优规划与仿真模拟 我国城市经济发展二元驱动模式的比较研究

创立项统计表

项目负责人 11011137 项目其他成员信息(姓名和学号) 指导教师姓 财政拨款 学院 名 李岩 沈志刚 李松梅 游文彬11011125 李雪缘10021079李胜曦10021214祝贺 10101026 张曦11021173 彦晓宇10021222 白璐 10021088 李雁雯11021143 王启濛11021180;冯柏源11021191 南丁11021069 王子钰12021181 朱晨 11021072 曹竞超11021052 王越11021152 冯采 11021053 杨韧12021063 陈玉莹12021114 杨宝翔 12021109 杨重阳12031139 樊峻崧12031146 赵力 12031149 王辰元 12031140 吴易霖(12031230) 唐哲文12031199、张益鑫39032517、王 梦莹12291160 苏翔博(11031140)、李锁兰 (11031132)、马仲海11031149) 袁野11081118、李梦奇11031127、李垚 11081105、李赟11081127 秦建(10051068) 龚雨晋10041177 刘有炜12041034 庞岩(10041007) 任鹏 10041051 李德政 10041011 刘贵艺11041045 纪国圣11041039 龚雨晋10041177 刘佳思12041036 孙思昊(10051128)邓颖 (10051053)罗天航(10051037) 乔冬冬10051024朱少雄10051006王龙 10051025张莉雯11291121 涂章杰(10051245)胡达达 (10031040)丁伟(10051264) 张鑫(10051001) 纪佳正(10051008) 陈爽爽(10051014) 王乾威10051107秦玉培10051129 李晓敏10051096曹顺翔10051110 陈杰10051142,陈拓10051138, 王照瑞10051105 张啸迟10051168、章异嬴10051043、石 明轩10051077、黄帅10151117 10131064夏正林;11061065冮一江 11061017夏天晗;11061025李鲲 顾轶卓 刁为民 金天 赵巍 张波 王俊 金天 黄勤 袁梅 王少萍 王少萍 段海滨 袁梅 丁水汀 张弛 陈龙飞 方祥军 孙纪宁 董金钟 王维军 黄俊 王延奎 孙明磊 王维军 陈铭 万志强 荣文戈 胡春明 许兴 10000 9000 15000 15000 15000 8000 9600 9000 12000 8000 9200 18000 15000 14000 12000 9000 15000 18000 10000 15000 8000 8000 10000 6000 9000 5000 9000 9000 15000 8000 8000 4000 1 1 1 1 2 2 2 2 2 2 2 3 3 3 3 3 4 4 4 4 4 4 5 5 5 5 5 5 5 6 6 6 王煜坤 11011043 谢敏灵 11011034 丁 文宇11011130 11011083 井京 11011085 10011097 11011135 10021079 11021116 11021150 11021173 11021234 11024002 12021138 12031144 11031105 11031115 11031138 11031187 10041173 11041028 10041021 10041003 11041057 12041034 10051008 10051018 10051252 10051002 100513 10051140 11051194 10131061 11061028 11061125

2020年第43卷总目次

Ⅲ

船用锅炉汽包水位内模滑模控制………………………………………………… 段蒙蒙ꎬ甘辉兵 ( 3. 83 )

三峡升船机变频器 IGBT 路故障诊断 ……………………… 孟令琦ꎬ高 岚ꎬ李 然ꎬ朱汉华 ( 3. 89 )

定航线下考虑 ECA 的船舶航速多目标优化模型 …………… 甘浪雄ꎬ卢天赋ꎬ郑元洲ꎬ束亚清 ( 3. 15 )

改进二阶灰色极限学习机在船舶运动预报中的应用………… 孙 珽ꎬ徐东星ꎬ苌占星ꎬ叶 进 ( 3. 20 )

Ⅱ

规则约束下基于深度强化学习的船舶避碰方法

………………………………… 周双林ꎬ杨 星ꎬ刘克中ꎬ熊 勇ꎬ吴晓烈ꎬ刘炯炯ꎬ王伟强 ( 3. 27 )

船用起重机吊索张力建模与计算机数值仿真 ………………………… 郑民民ꎬ张秀风ꎬ王任大 ( 4. 94 )

约束规划求解自动化集装箱码头轨道吊调度 ………………………… 丁 一ꎬ田 亮ꎬ林国龙 ( 4. 99 )

航海气象与环保

162 kW 柴油机排气海水脱硫性能

基于模糊 ̄粒子群算法的舰船主锅炉燃烧控制 ……… 毛世聪ꎬ汤旭晶ꎬ汪 恬ꎬ李 军ꎬ袁成清 ( 1. 88 )

多能源集成控制的船舶用微电网系统频率优化……………… 张智华ꎬ李胜永ꎬ季本山ꎬ赵 建 ( 1. 95 )

基于特征模型的疏浚过程中泥浆浓度控制系统设计………… 朱师伦ꎬ高 岚ꎬ徐合力ꎬ潘成广 ( 2. 74 )

基于卷积神经网络的航标图像同态滤波去雾 …………………………………………… 陈遵科 ( 4. 84 )

船用北斗导航系统终端定位性能的检测验证 …………………………………………… 吴晓明 ( 4. 89 )

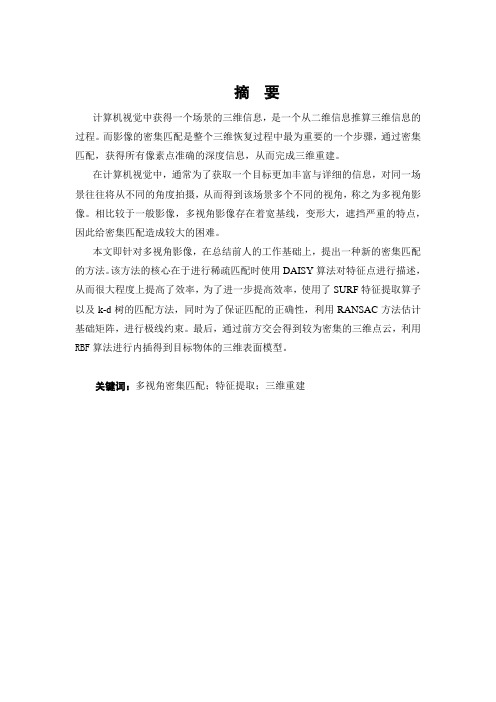

密集匹配

摘要计算机视觉中获得一个场景的三维信息,是一个从二维信息推算三维信息的过程。

而影像的密集匹配是整个三维恢复过程中最为重要的一个步骤,通过密集匹配,获得所有像素点准确的深度信息,从而完成三维重建。

在计算机视觉中,通常为了获取一个目标更加丰富与详细的信息,对同一场景往往将从不同的角度拍摄,从而得到该场景多个不同的视角,称之为多视角影像。

相比较于一般影像,多视角影像存在着宽基线,变形大,遮挡严重的特点,因此给密集匹配造成较大的困难。

本文即针对多视角影像,在总结前人的工作基础上,提出一种新的密集匹配的方法。

该方法的核心在于进行稀疏匹配时使用DAISY算法对特征点进行描述,从而很大程度上提高了效率,为了进一步提高效率,使用了SURF特征提取算子以及k-d树的匹配方法,同时为了保证匹配的正确性,利用RANSAC方法估计基础矩阵,进行极线约束。

最后,通过前方交会得到较为密集的三维点云,利用RBF算法进行内插得到目标物体的三维表面模型。

关键词:多视角密集匹配;特征提取;三维重建ABSTRACTThe process of obtaining three dimensional information from a scene in Computer Vision is also a process of calculating three dimensional information from two dimensional information. Dense Matching of images is the most important step in the process of 3D Recovery. Through Dense Matching, we could get accurate depth information of all pixels and achieve the purpose of rebuilding.In Computer Vision, we usually shoot the same scene from different perspectives in order to get more abundant and detailed information of the object. And then, we can obtain several different perspectives of the scene, which we call it multi-view image. Compared with general images, multi-view image has wide baseline, large deformation and is always seriously sheltered, which creates great difficulties for Dense Matching.Based on summarizing predecessors’ work, I put forward a new method for Dense Matching, and aiming at better handling the multi-view images. The heart of the method is using DAISY algorithm to describe the feature points during Sparse Matching. This greatly improve the efficiency of matching. In order to further raise the efficiency, I also add SURF feature extraction operator and the matching method of kd-tree. At the same time, I adopt RANSAC method to estimate basic matrix and complete polar constraint to ensure the correctness of the matching. Finally, I get dense 3D point cloud through forward intersection, and establish the object’s 3D surface model through the RBF algorithm for interpolation.Key words: Multi-view Dense Matching; Pattern Extraction; 3D Reconstruction目录第1章绪论1.1 研究背景及意义 (1)1.2 国内外研究现状 (2)1.3 本文研究思路 (4)第2章密集匹配相关理论和算法基础2.1 特征匹配算法基础 (6)2.1.1 SURF特征点提取原理 (6)2.1.2 DAISY描述符算法原理 (10)2.1.3 kd树匹配原理 (13)2.3 误匹配剔除算法基础 (15)2.3.1 极几何以及基本矩阵介绍 (15)2.3.2 RANSAC算法原理 (19)2.4 三维重建原理 (20)2.4.1 三角原理 (20)2.4.2 RBF内插算法介绍 (21)第3章基于DAISY的多视角密集匹配算法3.1 特征提取和描述 (24)3.1.1 特征提取 (24)3.1.2 DAISY算法进行描述 (26)3.2 影像匹配 (28)3.2.1 立体像对匹配实现 (28)3.2.2 多视角影像匹配实现 (31)3.3 三维恢复 (31)第4章实验结果与分析4.1 实验数据 (34)4.2 密集匹配实验结果 (36)4.2.1 立体像对密集匹配实验 (36)4.2.2 多视角密集匹配结果...................................................错误!未定义书签。

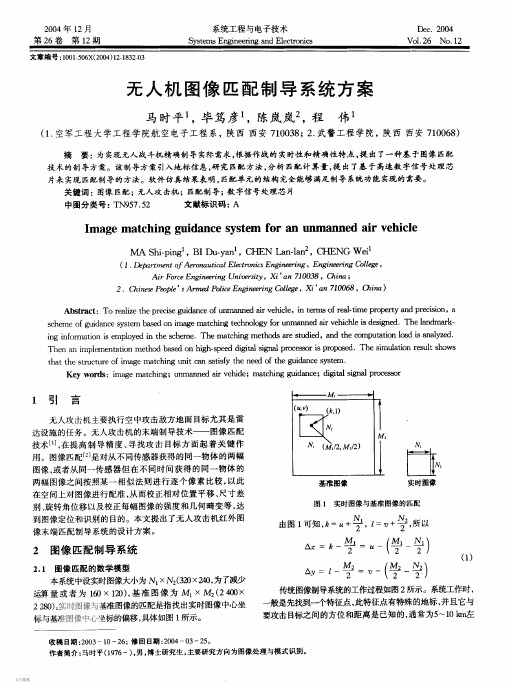

无人机图像匹配制导系统方案

1 引

言

(v u)

无人攻击机主要执行空中攻击敌方地面目 标尤其是雷 达设施的任务。无人攻击机的末端制导技术— 图像匹配

(, ki )

技 ‘在提高制导精度、 术〔, 〕 寻找攻击目 标方面起着关键作 用。图 像匹配[是对从不同 [ 2 1 传感器获得的同 一物体的两幅

图像, 或者从同一传感器但在不同时间获得的同一物体的 两幅图像之间按照某一相似法则进行逐个像素比较, 以此 在空间上对图像进行配准, 从而校正相对位置平移、 尺寸差 别、 旋转角位移以及校正每幅图像的强度和几何畸变等, 达 到图像定位和识别的目的。本文提出了无人攻击机红外图 像末端匹配制导系统的设计方案。

2 8) 20。 实时图像与基准图像的匹配是指找出实时图像中心坐 标与基准图像中 心坐标的 偏移, 具体如图1 所示。

A = Y

-2

-一

刀

-

-2

一

() 1

传统图像制导系统的工作过程如图2 所示。系统工作时, 一般是先找到一个特征点, 此特征点有特殊的地标, 并且它与 要攻击目 标之间的方位和距离是已知的, 通常为5 1 k 左 - 0 m

x 2 10 = . mx . m. (6 /2 ) 22 22 2

. 一 .一

匡匡 } 厅「

一 回

口

航行参数

红外摄像头方向 参数设置与 调试接 口 校正 ( x A ) A , y

压 1 5

口

图3 无人攻击机图像匹配系统制导方案

图4 无人机匹配制导系统的组成框图

23 系统组成 . 图4 为无人攻击机匹配制导系统的组成框图, 共分为 A大模块。即图像数据转换单元, 5B 1 3 接口, 5 图像匹配单 元, 主控单元, 基准图像与目 标特征库, 图像压缩模块, 数据 传输单元和电源模块。其中图像数据格式转换单元接收来 自红外摄像头的图像数据, 并将其转换为 30 4 点阵或 2 x 20 10 0 6 x 点阵的图像格式。15B 单元接收来自 1 2 53 接口 导航 与控制系统的启动匹配命令, 并接收导航控制系统提供的 高度、 姿态、 速度信号, 负责将图像匹配后所测目 可拍摄的景物大小为( 00 x 410 m 5 x 飞机方位、 5 x 31/8) ( 00 0 4 . x 0 4 x 410 * / m = 4 m 6 m 31/8) 34 39 22 . x 。当像素数为30 2x 20 像素分辨率为(4/2 ) 2220 =11 4 时, 3930 x /4 ) . mx (6 11 当像素数为 10 2 . m。 6 x 10时, 像素分辨率为(4/6) 3910

无人机影像的同名点匹配

基 金项 目:“ 十一 五” 国家科 技支 撑计 划重大 项 目(06 AJ5 3 2 0B 0 A1)

作 者简 介 :) (96)  ̄ 18-,男( 族) 汉 ,安 徽南陵 县 人 。 博 士研 究生 ,主 要研 究工作 是 3 s集成 及应 用 。Em i ag n 53 ia o - al nmi05 @s . m。 :t nt

h t :/ tp /www g g cc d ca n

2 0

光 电 工程

的算法 来完 成 。

目前 ,部分 学者 进行 着这 方面 的研 究 。杨 晓敏 等¨采 用 基于 置信 度的算 法 对影像 同名点进 行 匹配 ;张 登 荣 等 通 过 构 建 仿 射 变 换 方 程 ,使 用 距 离 约 束 对 匹配特 征 点 对 进 行校 正 和 消 除错 误 匹配 ;Z ego hn yu Z ag 1 用极 线约 束消除 不 良匹配 点。这些 研究 取得 了一定 的成 果 ,但 也都 存在 问题 ,特 别是 应 用到 无人 hn 1采 3 机影像 的 同名 点 匹配上 来 , 由于其 影像 几何 变形大 且复 杂等特 点 ,若直 接应用 这些 方法 很难 取得 满意 的效 果 。本文针 对上述 问题 ,主 要通过 改进 剔除误 匹配同名 点的算 法上 来解 决无 人机影 像 同名 点 匹配 可靠性 不

无人机影像 的同名点 匹配

唐 敏 ,李永树 ,鲁 恒

(西南交通大学 地理信息工程中心 ,成都 6 0 3 ) 10 1 摘要 :与传统航 空摄 影测量相 比,无人机所获取 的影像存在更 大、更复杂的几何 变形 问题 ,而且 由于摄影比例尺

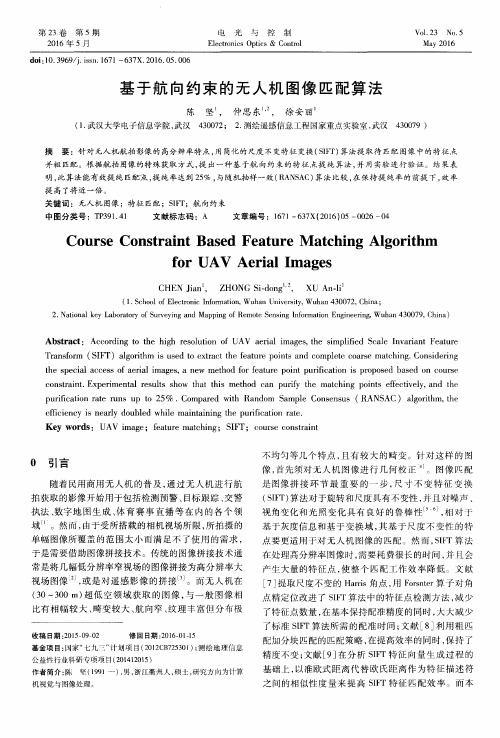

基于航向约束的无人机图像匹配算法

第 23卷 第 5期 2016年 5月

电 光 与 控 制

Electronics Optics& Control

doi:10.3969/j.issn.1671—637X.201基 于航 向约 束 的 无 人机 图像 匹 配算 法

Abstract: According to the high resolution of UAV aerial images,the simplified Scale Invariant Feature

Transform (SIFT)algorithm is used to extract the feature points and complete coarse matching.Considering

收稿 日期 :2015—09—02

修 回 日期 :2016-O1-15

基金项 目:困家“七九三”计划 项 目(2012CB725301);测绘 地理信 息

公益性行业科研专项项 目(201412015)

作 者 简 介 :陈 - (1991一 ),男 ,浙 江衢 州 人 ,硕 士 ,研 究 方 向为 计 算

the special access of aerial images,a new method for feature point purification is proposed based on course constraint.Experimental results show that this method can purify the matching points effectively,and the

陈 坚 , 仲 思 东 , 徐 安丽 ’ (1.武汉大学电子信息学院 ,武汉 430072; 2.测绘遥感信息工程 国家重点实验室 ,武汉 430079)

一种基于边缘结构信息的无人机图像与SAR卫星图像的匹配方法[发明专利]

![一种基于边缘结构信息的无人机图像与SAR卫星图像的匹配方法[发明专利]](https://img.taocdn.com/s3/m/fc672bb7ad02de80d5d84010.png)

专利名称:一种基于边缘结构信息的无人机图像与SAR卫星图像的匹配方法

专利类型:发明专利

发明人:杨文,张瑞祥,徐芳,夏桂松

申请号:CN202010686373.4

申请日:20200716

公开号:CN111899269A

公开日:

20201106

专利内容由知识产权出版社提供

摘要:本发明公开了一种基于边缘结构信息的无人机图像与SAR卫星图像的匹配方法,该方法首先利用传统的Ratio算子对SAR卫星图像的边缘进行初步的粗提取,再叠加到SAR原图上对SAR图像进行增强,利用卷积神经网络提取无人机光学/红外图像以及增强后的SAR卫星图像的边缘图像,然后再利用新的卷积神经网络提取边缘图像的深层语义特征,然后对边缘图的深度特征进行相似度匹配,获取无人机图像和SAR卫星图像的匹配热力图,最终根据热力图中值最高的区域,找到无人机图像在SAR卫星图像中的位置。

本发明采用的基于图像边缘结构的匹配方法,能够利用图像的边缘特性,弥补不同成像机制带来的域差异,有效地对三种异源图像之间进行匹配。

申请人:武汉大学

地址:430072 湖北省武汉市武昌区珞珈山

国籍:CN

代理机构:武汉科皓知识产权代理事务所(特殊普通合伙)

代理人:罗飞

更多信息请下载全文后查看。

基于多测度半全局优化的无人机影像密集匹配算法

基于多测度半全局优化的无人机影像密集匹配算法文章针对无人机影像的特点,采用互信息和Census两种相似性测度相结合的方式进行模型密集匹配。

由于组合Census 和互信息两种相似性测度的优点,多测度半全局匹配算法可以得到稳健可靠、高效、精细且保边缘的密集匹配结果。

标签:无人机影像;互信息;Census1 概述来源于计算机视觉领域的半全局优化密集匹配算法是当前国内外最先进的密集匹配算法之一,在DSM提取、三维建模等领域得到了广泛应用,该算法的逐像素密度以及子像素精度可以大大提高获取DSM的精度和可靠性。

半全局优化密集匹配算法采用多个方向的一维平滑约束来近似二维平面上的平滑约束,其基本思想如图1所示,首先在一维视差范围内计算每个候选匹配位置的能量代价,得到三维代价矩阵,然后采用多个方向动态规划对代价矩阵累加,得到累加后的三维代价矩阵,最后根据累加后的代价矩阵计算最优视差曲面。

在无人机影像提取DSM信息过程中,经典的半全局匹配算法采用互信息作为相似性测度,并以此计算匹配代价,但是计算互信息需要先验的视差初值,通常策略是随机生成每个像素的视差作为初值,但这种方式会对最终的匹配结果造成一定的影响。

针对此问题,本文采用互信息和Census两种相似性测度相结合的方式来改善模型匹配的结果。

本文第二部分主要介绍半全局优化算法的基本原理,第三部分采用实际数据验证本文方法的有效性,第四部分为本文的结论。

2 半全局优化密集匹配算法半全局優化密集匹配算法来源于文献[2,3],包括三维代价矩阵计算、代价矩阵累加、最优视差面获取三个部分,具体如下:2.1 三维代价矩阵计算匹配代价由相似性测度计算,相似性测度是衡量立体像对中左右影像上任意两个像素间的相似程度。

常用的相似性测度有灰度绝对差、互信息、Census等,本文首先在金字塔顶层采用Census相似性测度获得稳定可靠的视差初值,然后将此初值传至下一层,后面的每一层都以互信息作为相似性测度。

基于改进ORB和RANSAC算法的无人机影像特征匹配方法

文章编号:1006-7949(2021)04-0066-04

UAV image feature matching method based on improved ORB and RANSAC algorithm

DING Jinxuan ,WANG Lixin2,MIAO Xinglei

(1. Shenzhen Investigation & Research Institute Co. , Ltd,Shenzhen 518003,China; 2. Heilongjiang Provincial Society of Surveying and Mapping Geographic Information,Harbin 150081, China; 3. Harbin North Defence Equipment Co.,Ltd, Harbin 150050 China)

检测性能进行实验,然后进行匹配实 页组

影像对

检测

图2和图3;基于改进算

法的 匹配 匹配

图 4 图 5;

对

数和匹配

表1改进算法尺 变性实

图6所示。

图2研究区1特征点检测结果

图3研究区2特征点检测结果

图4基于改进算法的粗匹配结果

第4期

丁进选,等:基于改进ORB和RANSAC算法的无人机影像特征匹配方法

基于改进ORB和RANSAC算法的

无人机影像特征匹配方法

丁进选r王丽欣2,苗星雷3

(1.深圳市长勘勘察设计有限公司,广东深圳518003$.黑龙江省测绘地理信息学会,黑龙江哈尔滨150080$.哈尔滨北方 防务装备股份有限公司,黑龙江哈尔滨150050)

摘 要:针对ORB和RANSAC算法存在的不足,文中提出通过对Harns角点函数的改进和将空间一致性原理思想

基于预测的无人机视频快速匹配算法研究

基于预测的无人机视频快速匹配算法研究杨德龙;吴云东;蔡国榕;陈水利【摘要】This paper proposes a fast matching algorithm for UAV�s video. Firstly, the algorithm use computer to sign some points which are uniform distribution on the image. Secondly, the algorithm take ad⁃vantage of the adjacent frame�s characteristics to find the correspond points. At last, we introducing the inter⁃polation theory to establish the prediction model to reduce the size of the searching window and matching win⁃dow, make the time complexity lower than before.%针对无人机视频数据,提出一种快速逐帧匹配算法。

该算法首先使用计算机在每一帧中均匀标记一定数量的点,接着利用视频相邻帧之间的特点使用绝对差值法完成同名点的寻找,之后引入内插理论建立预测模型,缩小了搜索窗口和匹配窗口大小,降低了算法时间复杂度。

实验结果表明,该算法可以高效地完成相邻帧之间的匹配。

【期刊名称】《集美大学学报(自然科学版)》【年(卷),期】2016(021)005【总页数】9页(P370-378)【关键词】相邻帧;模板匹配;PID;预测;内插【作者】杨德龙;吴云东;蔡国榕;陈水利【作者单位】集美大学理学院,福建厦门361021;集美大学计算机工程学院,福建厦门361021;集美大学计算机工程学院,福建厦门361021;集美大学诚毅学院,福建厦门361021【正文语种】中文【中图分类】N941.5利用无人机视频制作大场景静态图像,有利于在军事侦察、抢险救灾等应用中掌握全局信息,是无人机应用的关键技术之一[1]。

基于ZigBee的无人机航拍影像快速特征匹配算法

基于ZigBee的无人机航拍影像快速特征匹配算法邓雯静【期刊名称】《《电子设计工程》》【年(卷),期】2019(027)022【总页数】5页(P147-151)【关键词】ZigBee; 无人机; 航拍影像; 快速特征匹配【作者】邓雯静【作者单位】重庆科技发展战略研究院有限责任公司重庆401123; 《自动化与仪器仪表》编辑部重庆401123【正文语种】中文【中图分类】TP391随着无人机技术的发展,采用无人机进行航拍成像,结合图像处理算法,进行无人机航拍影像的特征分析和检测,实现对无人机航拍影像的优化识别,提高无人机航拍影像的自动检测能力,研究无人机航拍影像的识别方法是建立在对图像的特征快速匹配基础上,构建无人机航拍影像的快速特征匹配模型,根据对无人机航拍影像的特征匹配结果进行目标检测和高清成像处理,研究无人机航拍影像的特征快速匹配方法在提高无人机航拍影像的检测和识别能力方面具有重要意义[1]。

传统方法中,对无人机航拍影像快速特征匹配方法采用多层螺旋尺度分割的快速特征匹配方法,结合LVEDV、LVESV等点扫描技术,实现对无人机航拍影像快速特征匹配[2],采用多元特征分解方法,实现无人机航拍影像快速特征匹配[3],对无人机航拍影像三维测量和特征匹配的设计采用低分辨成像技术,上述方法在进行无人机航拍影像快速特征匹配的模糊度较大,特征分辨能力不好。

针对上述问题,本文提出基于ZigBee的无人机航拍影像快速特征匹配算法,采用ZigBee协议进行无人机航拍影像采集的无线传感组网设计,采集无人机航拍的图像,对图像采用局部加权融合特征分离方法进行无人机航拍影像快速特征检测,构建像素分维像模型进行无人机航拍影像快速特征匹配,使用图像的熵特征量作为特征匹配的基准分量,计算图像每个像素的局部信息熵,结合图像背景过滤机制和小目标增强方法实现对无人机航拍影像的目标细节定位和快速特征匹配。

最后进行仿真实验分析,展示了本文方法在提高无人机航拍影像快速特征匹配能力方面的优越性能。

无人机影像密集匹配方法

无人机影像密集匹配方法

冯飞;冯建辉;赵艳艳

【期刊名称】《遥感信息》

【年(卷),期】2016(031)005

【摘要】针对无人机航摄影像存在的像幅小、影像倾角过大且倾斜方向没有规律等特点研究了一种基于尺度不变特征变换算法(Scale Invariant Feature Transform,SIFT)特征点匹配结果的无人机航摄影像密集匹配方法.在SIFT特征点匹配结果的基础上,根据立体像对的同名影像相似性原理,结合Moravec特征点提取算法、灰度相关匹配算法和最小二乘匹配算法来获取无人机影像的密集匹配结果,再利用影像密集点匹配结果生成影像覆盖区域的DSM进行精度分析.实验结果表明,基于SIFT特征匹配算法的无人机影像密集匹配方法能够获取可靠的密集匹配结果.

【总页数】4页(P122-125)

【作者】冯飞;冯建辉;赵艳艳

【作者单位】河北省第一测绘院,石家庄050031;河北省制图院,石家庄050031;河北省制图院,石家庄050031

【正文语种】中文

【中图分类】P231

【相关文献】

1.基于多测度半全局优化的无人机影像密集匹配算法 [J], 左志奇;卢坤;黄良

2.多匹配基元集成的多视影像密集匹配方法 [J], 王竞雪;朱庆;王伟玺

3.基于半全局优化的无人机影像密集匹配策略 [J], 袁红选;左志奇;胡裕军;

4.基于改进ORB和RANSAC算法的无人机影像特征匹配方法 [J], 丁进选;王丽欣;苗星雷

5.改进SIFT的倾斜无人机影像匹配方法 [J], 张占平;武风英;包鹏章

因版权原因,仅展示原文概要,查看原文内容请购买。

基于无人机的大场景序列图像自动采集和三维建模

基于无人机的大场景序列图像自动采集和三维建模李康;周泩朴;邹林波;邓鹏;耿国华【期刊名称】《西北大学学报(自然科学版)》【年(卷),期】2017(047)001【摘要】提出并实现了一种基于无人机的大场景序列图像自动采集和三维重建方法,实现了大范围场景全自动图像数据采集和三维建模.首先设计实现无人机自动控制地面站和基于Codex-A17的无人机控制模块,其次在地面站人工点选设计航线和拍摄位置,并自动控制飞行和拍摄过程,实时将序列图像回传地面站,最后地面站应用SFM方法实时自动重建大场景三维模型.实验结果表明,相对于人工控制方法,文中方法能够实现无人机飞行和拍摄过程自动控制,同时提高拍摄稳定性,降低基于无人机的大场景三维建模难度,提高建模效果.【总页数】8页(P30-37)【作者】李康;周泩朴;邹林波;邓鹏;耿国华【作者单位】西北大学信息科学与技术学院,陕西西安710127;西北大学文化遗产数字化国家地方联合工程研究中心,陕西西安710127;西北大学信息科学与技术学院,陕西西安710127;西北大学文化遗产数字化国家地方联合工程研究中心,陕西西安710127;西北大学信息科学与技术学院,陕西西安710127;西北大学文化遗产数字化国家地方联合工程研究中心,陕西西安710127;西北大学信息科学与技术学院,陕西西安710127;西北大学信息科学与技术学院,陕西西安710127;西北大学文化遗产数字化国家地方联合工程研究中心,陕西西安710127【正文语种】中文【中图分类】TP391.7【相关文献】1.基于无人机的影像数据采集与三维建模 [J], 曹明兰;桂维振;周浩恩2.基于无人机航测的区域场景快速三维建模实现 [J], 黄文锋;余振强3.基于无人机序列图像的三维场景重建 [J], 林思;左小清;张建柱;李勇发;李海强4.基于无人机技术的大场景三维建模——以云冈石窟景区为例 [J], 李丽红5.基于无人机航测的区域场景快速三维建模实现 [J], 邓强;张号因版权原因,仅展示原文概要,查看原文内容请购买。

无人机、无人船航道测绘成果融合拼接处理研究

无人机、无人船航道测绘成果融合拼接处理研究摘要:目前,相对于传统测量,无人机、无人船效率高的优势在航道测绘中的应用越来越普及,本文研究无人机、无人船的实时采集的测绘成果数据,经过融合拼接、点云滤波处理、点云抽稀,实现测绘成果的在线显示,为快速测量、应急测量提供支撑。

关键词:无人船、无人机、航道测绘、融合拼接前言广东省航道资源丰富,辖区内航道里程16050公里,近年来,随着电子航道图全面推广应用及数字航道加快建设,航道测绘的需求和工作量大幅增长、要求不断提高,快速测量、应急测量及航道监测的重要性日益突显,而基于传统测量技术(全站仪观测、RTK观测等)的陆域测量、地质灾害调查效率和效果上难以满足航道测绘工作发展的需要,迫切需引入更加先进的测量技术和设备以改善这种情况。

随着无人船、无人机在航道测绘中的应用,实现无人机艇联合航道测绘成果数据实时可视化,即实现:应用Lidar、多波束两种手段同步开展航道地表地形以及水底地形之时,实时完成两种数据融合与集成,并且提供点云数据成果三维可视化展示,达到快速掌握测区水上水下地形三维空间形态,为满足高时效性的现场三维测绘监控分析提供技术支撑。

1.无人机、无人船航道测绘成果融合拼接处理流程(1)数据接收。

根据无人机无人艇的规划路线数据生成均匀网格,作为实时采集数据接收基础单元,确保实时数据的处理效率;(2)一体化数据融合。

实现多波束、激光点云数据实时融合,为同平台实时展示奠定基础;(3)数据除燥滤波。

通过建立数据空间索引、剔除误差数据、以及实施点云滤波等预处理环节,实现点云数据清洗,方便快速检索与后续处理。

(4)数据成果发布。

建立点云数据抽稀处理策略,建立数据发布服务,实现高效数据后台抽取与前向数据传输。

(5)三维可视化展示。

前端接收三维数据流,完成数据融合渲染展示,提供相应前端交互操作功能,实现无人机艇联测成果三维场景实时监控。

2.无人机、无人船航道测绘成果融合拼接研究2.1基于约束边Delaunay三角网的地形数据整合方法该方法的思想是在一个已存在的Delaunay三角网的基础上,以迭代算法为核心,对预先嵌入的约束线段进行预处理,使约束线段的两端点与三角网中三角形顶点重合且影响区域内不包含其他点和约束边,并且使影响多边形转为凸四边形,通过交换对角线,直至约束线嵌入,完成三角网重构。

基于orb算法和改进knn-ransac算法的无人机遥感影像拼接

方向的质心。这样可以把从特征点 O到强度质心 C 若一个样本在特征空间 K个最相邻的样本中的大

两点之 间 的 距 离 组 成 一 个 向 量 OC,该 向 量 的 方 向

便可作为 FAST特征点的方向:

多数样本都属于某一个类别,那么该样本也将同样

α =arctan2(m01/m10), 即得到 FAST检测算法 oFAST。

大学学报,2020,40(1):131-137.

132

桂 林 理 工 大 学 学 报 2020年

FAST检测算法由于高效的检测效率而被广泛

Sα =Rα·S。

(8)

使用,但是 FAST算法检测出来的特征点没有方 最终得到了改进的 BRIEF特征描述符 rBRIEF

向。这时引进强度质心算法,其基本思想是:假设

gn(p,α):=fn(p)|(xi,yi)∈ Sα。 (9)

某个角点的强度偏离其质心,把这个偏离的距离

综上,ORB算法是将有方向的 FAST检测算

用一个向量表示为

法 oFAST和 rBRIEF特征描述符结合而成的一种新

∑ mpq = xpyqI(x,y),

Ni′(u,v),那么投影变换前后的误差指标函数为

当误差指标函数与最小值接近时,此时的算法计

算速度也最快,同时该时刻的单应性矩阵的精度

也最高。

224 改进后的 RANSAC算法 ①从初始匹配点

对集合 U中,按照图 3、图 4的分块方法及公式随

机选取 4个点对作为一 个 内 点 集 合,并 将 其 记 为

Ui;②用线性方程组的方法解算出初始单应性矩阵

图 2 KNN算法简化图 Fig2 SimplifiedsketchofKNNalgorithm

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1 引 言

从二维图像中提取物体的空间位置信息,相对于影像采集其实是一个逆反的病态过程。 物体在成像过程中,失去了其三维信息,而三维重建,则从图像中恢复被摄物体的表面三维 特征。 利用二维图像进行被摄物体三维重建过程中, 涉及的主要技术有影像密集匹配和三维 [1] 建模 。在遥感数据融合、对象识别、图像拼接、影像校正、三维建模等应用中,图像匹配 是这些应用的基础。 图像密集匹配的精度直接影响着视差图的精度, 进而影响三维重建结果 的精度。所以,图像密集匹配是三维重建的基石和出发点。 [2] 对于密集匹配,已有了大量的研究。杨化超等 提出了 SIFT 特征及对极几何和单应矩 阵双重约束基于宽基线多阶段密集匹配,他首先提取最优 SIFT 特征进行匹配,然后对于剩 余的 SIFT 特征基于双重约束匹配,最后对于未匹配点使用宽基线和滤波加速计算并使用最 [3] 小二乘拟合完成密集匹配。 侯文广等 则基于 SURF 算子与薄板样条(TPS)建立影像之间连续 和光滑形变变换,其使用极线和 TPS 变化约束选择可靠同名点,建立 TPS 变换矩阵,然后基 [4] 于影像灰度进行匹配。孔晓东等 对极线进行了校正,使得两幅图像对应极线处在同一扫描 [5][6] 线上,然后分线段进行密集匹配。针对图像密集匹配,本文提出了一种基于 FAST 算法 [7] 的图像密集匹配方法。FAST 算法原理直观运算简单 。该方法首先使用 FAST 算法检测两图 像的角点,并对两角点集进行匹配。根据粗匹配的两点点集采用 RANSAC 算法鲁棒的估算出 基本矩阵和单应矩阵。 然后根据极线约束和单应约束估算出匹配点的对应位置范围, 根据互 相关系数进行两点之间匹配, 从而实现两图像之间点点对应的密集匹配。 使用该算法实现了 两幅未标定无人机图像的密集匹配。

454003, China; ②Remote Sensing Calibration and Authenticity Inspection Laboratory, Institute of Remote Sensing Applications of Chinese Academy of Sciences, Beijing 100101, China)

C '

P

图5 对极几何关系

设 C 和 C ′分别为同一摄影基线上的两次曝光时光心位置,p 和 p′是地面点 P 在两张图 像上的投影点,则 p 与 p′是两幅图像中的一对匹配点。连接两光心 C 和 C ′与左右两幅图分 别交于点 e 和 e′,e 和 e′称之为一对极点。空间点 P 和两个光心 C 和 C ′共面,其组成的平 面称之为对极平面。对极平面与两图像平面 I、I′分别相交于直线线 l 和 1′,l 和 l′称为对 极线。因为 p、p′点同时处在对极平面和像平面上的交线上,即对极线上。我们可以得出, 寻找像平面 I 上的一点 x 在像平面 I′上的对应点 x′时,只需在 x′所对应的极线上寻找。这为 匹配点搜索缩小了范围。所有的极线都穿过对极点 e 或者 e′。从上面的对极几何约束中,我 们可以推出对极几何约束的性质,对于图像平面 I 上的一点 p,存在像平面 I′上的一直线 l′ [15] 与之相对于,在 l′上存在一点 p′与 p 相匹配。基本矩阵是对极几何的数学描述 。如图 5, ' ' ' 我们可设对极点 e,e′的齐次坐标为 e ex , e y ,1 ,e ex , e y ,1 。为此,这一对极几何关系 可以表示为基本矩阵 F 进行描述, 位于图像 I′中的一点 p′通过基本矩阵映射到图像 I 中的对 极线 l 中,用数学表示为

l ' Fp l F T p'

T

(2)

(2)式中,l、l′为一对对应的极线,p、p′为一对对应点,F 为基本矩阵,F 为基本矩 阵的转置矩阵。在对极几何中,我们已经能够判定位于图像 I′上的一点 p′对应于图像 I 上的 点 p 的线性位置,但是不能判定 p 点位于图像 I 中的具体位置。为此,我们引进单应矩阵进 行描述两个对应点之间的一一对应关系矩阵。如图 6 所示

3 对极几何约束与单应约束

对极几何表示了同一场景中两幅图像之间的几何关系, 它独立于场景结构, 仅依赖于摄 [14,1] 像机的参数,所以,对极几何是两幅图像间固有的射影性质 。无人机在飞行过程中,对 地面的同一地物进行拍摄,其对极几何关系如图 5 所示。

C

e l p I

e' l' p' I ′ '

图 2 噪声敏感性测试

从图 2 我们很容易看出,FAST 算子对加入一定噪声后,其检测到的角点数增加的速度 比 Harris 算子快得多, 所以 FAST 对噪声比较敏感, 很容易受到噪声的影响而提取了错误的 角点。同时,我们对 FAST 和 Harris 提取角点的运算速度进行了测试,同样针对上述图像条 件进行 30 组的运算取其平均时间作为运算时间,其结果如图 3 所示。

图 3 检测角点速度测试

从图 3 我们可以看出 FAST 和 Harris 进行角点检测耗费的时间有一定的差距, 但是他们 都随着噪声密度值的增加而呈逐渐上升趋势。考虑检测一万个角点耗费的时间则可以看出, Harris 所耗时间要远远大于 FAST。 考虑在无人机应急中, 图像的噪声密度有限性, 使用 FAST 提取角点缩短运算时间是可取的。为此,本文选择 FAST 算子检测角点,提取的特征点如图 4 所示,特征点使用红色十字标出。

w1 xi , yi u1

i

2

w2 xi , yi u 2

i

2

(1)

(1)式中,w1 和 w2 分别为特征点集 I1、I2 中特征点 P1、P2 为中心在相对应图像中两个大

小一致的窗口。u1、u2 为相关匹配窗口内像素灰度的平均值。匹配时,在特征点集 I1 中选取 任意角点,查找在特征点集 I2 中与其相关性最大的角点进行配对。然后对于特征点集 I2 中 的任一角点,查找在特征点集 I1 中与其相关性最大的角点配对。当双向搜索查找的最大相 关性角点相互匹配时,则判定其配对成功,否则配对失败。

Abstract: A method of UAV image-dense matching based on FAST algorithm was proposed in this paper. Firstly, it is to extract image feature points using the FAST algorithm, and use the normalized cross-correlation relationship algorithm to match two feature point sets ,then the fundamental and homographic matrixes were estimated by the robustness of the RANSAC algorithm according to the early matching results. All the points could be matched stably by the Epipolar constraint and Homography constraint through normalized cross-correlation relationship. The experiments showed that the matched results with the method were satisfactory. Key words: FAST algorithm; dense matching; epipolar constraint; homography constraint

[8]

图 1 FAST 角点检测

考虑图 1 中,以检测点 P 为圆心半径为 3 的圆环上有 16 个点,设定某一阈值 T,检测 圆环上的点与点 P 的灰度值之差。若连续有超过 12 个点的灰度值之差大于阈值 T。则判定 点 P 为角点。 若对一任意点 P 都将其与邻域的 16 个像素点进行比对,则需要大量的计算量。考虑图 1 我们知道,如果圆环上像素点 1 和 9 的灰度值与点 P 的灰度值小余阈值 T 的话,那么我们 不再需要检测 12 个像素点来判定 P 点是否为角点。为此,我们可以采取加速的检测方法。 根据以上原则,我们先检测像素点 1、9,然后检测像素点 5 和 13。通过实验统计,经过优

A study of dense matching method based on UAV image

CAI Long-zhou①②, YU Tao②, XIE Dong-hai , WU Yu , ZHENG Feng-jie , MENG Xiu-jun①

② ② ②

(①

School of Surveying and Land Information Engineering, Henan Polytechnic University, Henan Jiaozuo

2 FAST 角点检测与初匹配

对于角点检测算法, 人们提出了各种算法, 并进行加以改进, 如 Harris 算子及对 Harris [9] 算子的改进 。本文中对图像进行特征点的提取采用 FAST(Features from Accelerated Segment Test)角点检测算法。FAST 算法是由 Edward Rosten 和 Tom Drummond 提出了一种 简单快速的角点探测算法, 该算法检测的角点定义为在像素点的周围邻域内有足够多的像素 [10] 点与该点处于不同的区域 。 应用到灰度图像中, 即有足够多的像素点的灰度值大于该点的 灰度值或者小于该点的灰度值。 考虑图像中任意一个像素点和以它为中心的一个区域, 该区 域为一个半径等于 3 的离散化的 Bresenham 圆,如图 1 所示。

C

e p I H1 P H