MongoDB-Middle-Level--大数据量下MapReduce取代GroupBy

mapreduce在大数据处理中的作用

mapreduce在大数据处理中的作用一、引言随着大数据时代的到来,数据量越来越庞大,传统的数据处理方法已经无法胜任。

为了解决这个问题,谷歌公司在2004年提出了一种分布式计算框架——MapReduce,该框架可以对大规模数据进行高效处理,并且具有可扩展性和容错性等优点。

本文将详细介绍MapReduce在大数据处理中的作用。

二、MapReduce框架概述1. MapReduce框架基本原理MapReduce框架是一种分布式计算模型,它将一个大规模的任务分成若干个小任务,并行地执行这些小任务。

具体来说,MapReduce 框架包含两个阶段:映射(map)阶段和归约(reduce)阶段。

在映射阶段中,每个节点都会对输入数据进行处理,并将处理结果输出为键值对;在归约阶段中,所有节点将相同键值对的结果进行合并并输出最终结果。

2. MapReduce框架主要组件MapReduce框架主要由以下三个组件构成:(1)JobTracker:负责管理整个作业的执行过程,在其中分配任务给各个节点,并监控各个节点的状态。

(2)TaskTracker:负责执行具体的任务,在其中执行Map和Reduce操作,并将处理结果输出到HDFS中。

(3)HDFS:分布式文件系统,用于存储大规模数据。

三、MapReduce框架在大数据处理中的作用1. 高效的数据处理能力MapReduce框架采用分布式计算的方式,可以将一个大规模的任务分成若干个小任务,在多个节点上并行地执行这些小任务。

这种方式可以充分利用集群中的计算资源,提高数据处理速度。

同时,MapReduce框架还支持本地化计算,即将计算任务尽可能地分配到离数据源较近的节点上,减少网络传输带来的开销。

2. 可扩展性MapReduce框架具有良好的可扩展性。

由于它采用了分布式计算的方式,可以通过增加节点数量来扩展集群规模,以应对不断增长的数据量。

同时,MapReduce框架还支持动态添加和删除节点等操作,使得集群规模更加灵活。

hadoop填空题

hadoop填空题以下是一些关于Hadoop的填空题:1. Hadoop是一个用于大数据处理的分布式计算框架,它允许在大量计算机上分布式存储和处理大规模数据集。

2. Hadoop的核心组件包括____________和____________。

3. Hadoop的数据存储系统是____________,它是一个分布式文件系统,可以存储和处理大规模数据集。

4. Hadoop的数据处理引擎是____________,它基于MapReduce模型,可以将大数据处理任务分解为多个子任务,并在多个计算机上并行执行。

5. Hadoop的MapReduce模型包括两个主要阶段:____________和____________。

6. 在Hadoop中,数据可以通过____________和____________两种方式进行分片。

7. Hadoop的可扩展性非常好,可以轻松地处理大规模数据集,并且可以在____________上运行。

8. Hadoop的一个主要优点是它可以有效地处理大规模数据集,并且可以在____________上运行。

9. Hadoop的另一个优点是它可以很好地处理失败的节点,因为它具有____________的特性。

10. Hadoop的____________功能可以方便地与其他数据处理工具集成。

答案:1. Hadoop是一个用于大数据处理的分布式计算框架,它允许在大量计算机上分布式存储和处理大规模数据集。

2. Hadoop的核心组件包括HDFS和MapReduce。

3. Hadoop的数据存储系统是HDFS,它是一个分布式文件系统,可以存储和处理大规模数据集。

4. Hadoop的数据处理引擎是MapReduce,它基于MapReduce模型,可以将大数据处理任务分解为多个子任务,并在多个计算机上并行执行。

5. Hadoop的MapReduce模型包括两个主要阶段:Map阶段和Reduce 阶段。

mongodb 高可用方案

mongodb 高可用方案MongoDB是一种流行的开源文档数据库,提供了高可用性和灵活性的解决方案。

为了实现高可用性,我们可以采用以下几种MongoDB的高可用方案:1. 副本集(Replica Set):副本集是MongoDB用于提供数据冗余和故障恢复的基本方式。

一个副本集由多个MongoDB实例组成,其中一个是主节点(Primary),其余是副本节点(Secondary)。

主节点处理所有的读写请求,副本节点复制主节点的数据,并提供读操作的能力。

如果主节点发生故障,副本集会自动进行主节点选举,选择一个新的主节点来接管服务。

2. 故障转移(Failover):故障转移是指当主节点不可用时,副本集能够自动选择一个新的主节点来保证服务的可用性。

副本集通过心跳机制来检测主节点的可用性,如果主节点不可用,副本集会自动进行选举以选择一个新的主节点。

这种自动故障转移可以在毫秒级别完成,不会对应用程序的正常运行产生明显的影响。

3. 分片集群(Sharded Cluster):分片集群是一种横向扩展的解决方案,用于处理大规模数据集。

在分片集群中,数据被分散存储在多个分片(Shard)上。

每个分片只存储部分数据,因此能够扩展到更大的存储容量和处理吞吐量。

分片集群还提供了故障恢复和自动扩容的功能,当某个分片发生故障或存储不足时,系统可以自动将数据迁移或重新分片来保证服务的可用性。

4. 心跳和延迟检测:为了进一步增加可用性和冗余性,可以在不同的地理位置部署MongoDB节点。

通过在多个地理位置部署节点,可以提供数据的快速复制和故障转移,以保证服务的高可用性。

此外,还可以通过定期发送心跳信号和检测延迟来实时监测节点的健康状况,以便及时发现并处理故障。

总结起来,MongoDB提供了多种高可用方案,包括副本集、故障转移、分片集群以及心跳和延迟检测等。

这些方案能够有效地提供数据冗余、故障恢复和灵活的扩展能力,以确保MongoDB系统的高可用性和可靠性。

2022-3 大数据分析师(初级)考前冲刺题A3卷

信息素养培训平台2022.3 大数据分析师(初级)考前冲刺题A3卷1.【单选题】下列不属于分布式计算技术的是()。

A:MapReduceB:SparkC:FlinkD:TensorFlow正确答案:D答案解析:分布式计算技术包括MapReduce、Spark和Flink。

2.【单选题】在Flume日志采集过程中,目的地对应的组件为()。

A:sourceB:sinkC:channelD:selector正确答案:B答案解析:Flume日志采集中,source对应源,sink对应目的3.【单选题】下列关于HBase特性描述不正确的是()。

A:Google的Bigtable的开源实现B:是典型的分布式数据库系统C:采用行式存储D:支持数据的随机读取正确答案:C答案解析:HBase是一个开源的、分布式NoSQL数据库系统,是Google的Bigtable的开源实现,是Apache基金会的顶级项目。

作为一个典型的分布式数据库系统,HBase具有高可靠性、高性能、可伸缩等分布式架构特性。

虽然HBase底层采用了H DFS的存储,但与HDFS支持顺序存取不同,HBase采用列式存储结构,支持数据的随机存取功能。

因此,HBase 是一个可以进行随机存取和检索数据的存储平台。

HBase的目标是存储并处理由成千上万的行和列所组成的大型数据。

具体来说,HBase可以通过水平扩展的方式,利用廉价计算机集群处理由超过10亿行数据和数百万列元素组成的数据表 。

4.【单选题】大数据在哪个领域的应用是最为成熟的()。

A:教育领域B:商业领域C:医疗领域D:智能城市领域正确答案:B答案解析:目前,大数据在商业领域的应用是最为成熟的。

这主要有两个原因。

第一个原因是商业领域变现更快,大数据能够快速、直接地体现出来价值。

另外一个原因是商业领域产生的数据量非常庞大,消费者的行为都会成为对企业非常有价值的数据来源,这也让大数据能够在商业领域落地有了非常扎实的基础。

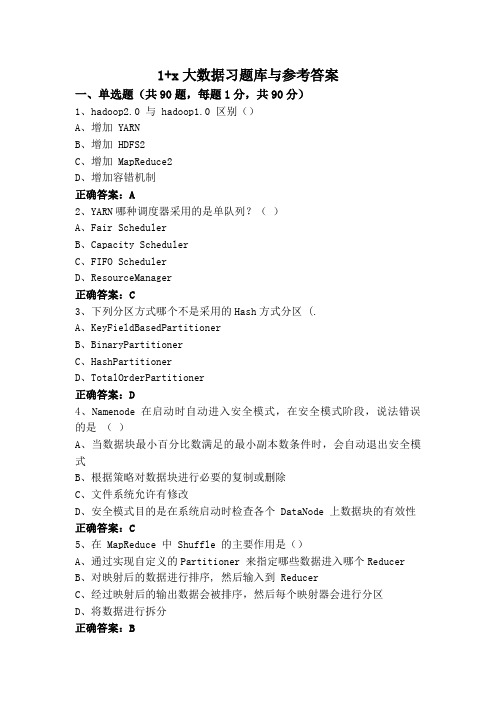

1+x大数据习题库与参考答案

1+x大数据习题库与参考答案一、单选题(共90题,每题1分,共90分)1、hadoop2.0 与 hadoop1.0 区别()A、增加 YARNB、增加 HDFS2C、增加 MapReduce2D、增加容错机制正确答案:A2、YARN哪种调度器采用的是单队列?()A、Fair SchedulerB、Capacity SchedulerC、FIFO SchedulerD、ResourceManager正确答案:C3、下列分区方式哪个不是采用的Hash方式分区 (.A、KeyFieldBasedPartitionerB、BinaryPartitionerC、HashPartitionerD、TotalOrderPartitioner正确答案:D4、Namenode 在启动时自动进入安全模式,在安全模式阶段,说法错误的是()A、当数据块最小百分比数满足的最小副本数条件时,会自动退出安全模式B、根据策略对数据块进行必要的复制或删除C、文件系统允许有修改D、安全模式目的是在系统启动时检查各个 DataNode 上数据块的有效性正确答案:C5、在 MapReduce 中 Shuffle 的主要作用是()A、通过实现自定义的Partitioner 来指定哪些数据进入哪个ReducerB、对映射后的数据进行排序, 然后输入到 ReducerC、经过映射后的输出数据会被排序,然后每个映射器会进行分区D、将数据进行拆分正确答案:B6、MapReduce编程模型,键值对<key, value>的key必须实现哪个接口?()A、WritableComparableB、ComparableC、WritableD、LongWritable正确答案:A7、ZooKeeper 的特点不包括()A、顺序一致性B、可靠性C、复合系统映像D、原子性正确答案:C8、关于ZooKeeper的说法错误的是?()A、ZooKeeper服务端有两种重要的角色是Leader和FollowerB、ZooKeeper不存在单点故障的情况C、客户端可以连接到ZooKeeper集群中任一台机器D、ZooKeeper Leader挂掉之后会自动在其他机器选出新的Leader正确答案:B9、显示当前所在目录的命令是()A、lsB、cdC、mkdirD、pwd正确答案:D10、2004年,Google公司发表了主要讲解海量数据的高效计算方法的论文是?()A、“Bigtable: A Distributed Storage System for Structured Data”B、“MapReduce: Simplified Data Processing on Large Clusters”C、“The Google File System”D、“The Hadoop File System”正确答案:B11、在 HDFS 文件操作中,上传文件的命令是()A、getC、inputD、up正确答案:B12、大数据平台项目实施计划不包括()A、完成大数据平台的安装调试B、基础平台部署C、用户环境准备D、完成大数据平台操作开发正确答案:D13、在hive 中已知表t est(name)的记录如下, tomTom_green tomlyLily代码 select * from test where name rlike 'tom.*'的结果有()条记录A、2B、3C、1D、0正确答案:B14、HDFS有一个gzip文件大小75MB,客户端设置Block大小为64MB。

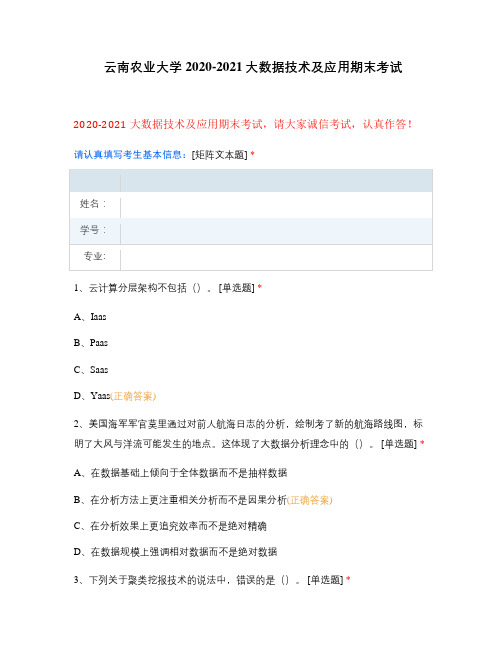

云南农业大学2020-2021大数据技术及应用期末考试

云南农业大学2020-2021大数据技术及应用期末考试2020-2021大数据技术及应用期末考试,请大家诚信考试,认真作答!请认真填写考生基本信息:[矩阵文本题] *1、云计算分层架构不包括()。

[单选题] *A、IaasB、PaasC、SaasD、Yaas(正确答案)2、美国海军军官莫里通过对前人航海日志的分析,绘制考了新的航海路线图,标明了大风与洋流可能发生的地点。

这体现了大数据分析理念中的()。

[单选题] *A、在数据基础上倾向于全体数据而不是抽样数据B、在分析方法上更注重相关分析而不是因果分析(正确答案)C、在分析效果上更追究效率而不是绝对精确D、在数据规模上强调相对数据而不是绝对数据3、下列关于聚类挖报技术的说法中,错误的是()。

[单选题] *A、不预先设定数据归类类目,完全根据数据本身性质将数据聚合成不同类别B、要求同类数据的内容相似度尽可能小(正确答案)C、要求不同类数据的内容相仪度尽可能小D、与分类挖据技术相似的是,都是要对数据进行分类处理4、大数据的利用过程是() [单选题] *A、果集-挖提-清洗-统计B、果集一统计-清洗一挖据C、采集-清洗一挖据-统计D、采集一清洗--统计-挖据(正确答案)5、大数据的本质是() [单选题] *A、洞察(正确答案)B、采集C、统计D、联系6、下面哪个()程序通常与 Namenode A在ー个节点启动。

[单选题] *A、TasktrackerB、DatanodeC、Jobtracker(正确答案)D、secondarynamenode7、HDFS默认 Block Size()。

[单选题] *A、16MB、32MC、64M(正确答案)D、128M8、云计算是对()技术的发展与运用。

[单选题] *A、并行计算B、分布式计算C、网格计算D、以上都是(正确答案)9、()是用于处理海量数据的并行编程模式和大规模数据集的并行运算的软件架构。

[单选题] *A、GFSB、Mapreduce(正确答案)C、BittableD、Chubby10、在 Bigtable中,()主要用来存储子表数据以及一些日志文件。

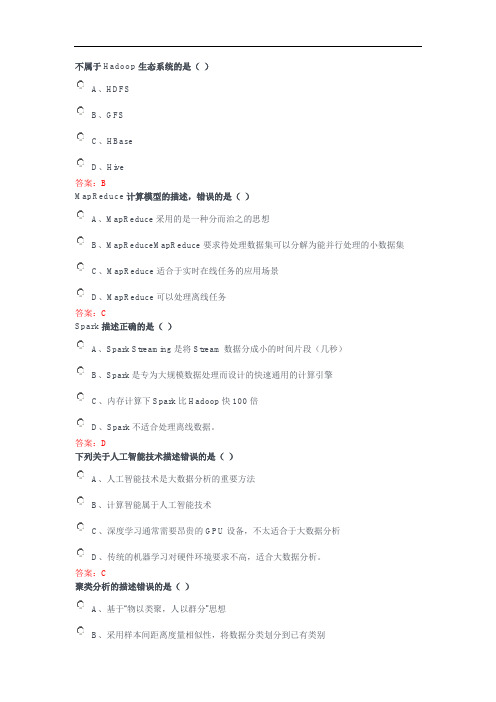

成电求实专技网2020年度公需科目-大数据及其应用答案-非图片版

不属于Hadoop生态系统的是()A、HDFSB、GFSC、HBaseD、Hive答案:BMapReduce计算模型的描述,错误的是()A、MapReduce采用的是一种分而治之的思想B、MapReduceMapReduce要求待处理数据集可以分解为能并行处理的小数据集C、MapReduce适合于实时在线任务的应用场景D、MapReduce可以处理离线任务答案:CSpark描述正确的是()A、Spark Streaming是将Stream数据分成小的时间片段(几秒)B、Spark是专为大规模数据处理而设计的快速通用的计算引擎C、内存计算下Spark比Hadoop快100倍D、Spark不适合处理离线数据。

答案:D下列关于人工智能技术描述错误的是()A、人工智能技术是大数据分析的重要方法B、计算智能属于人工智能技术C、深度学习通常需要昂贵的GPU设备,不太适合于大数据分析D、传统的机器学习对硬件环境要求不高,适合大数据分析。

答案:C聚类分析的描述错误的是()A、基于“物以类聚,人以群分”思想B、采用样本间距离度量相似性,将数据分类划分到已有类别C、k-means算法适合于非此即彼的聚类分析方法D、对于有层级关系的样本,可以采用自底向上的凝聚式层次聚类分析方法答案:B关于深度学习算法的描述,错误的是()A、深度学习通过组合低层特征形成更加抽象的高层特征或类别。

B、深度学习算法适合于语音识别、文字识别、智能客服等应用场景C、深度学习应用于人脸识别时,首先根据每个像素的亮度来识别边缘,然后根据边缘再识别出轮廓,最后根据轮廓识别出特定图像。

D、KNN、SVM等算法属于深度学习算法。

答案:D计算智能描述错误的是()A、计算智能是在生物遗传、变异、生长以及外部环境的自然选择中产生的B、计算智能包括遗传算法、粒子群算法、蚁群算法等C、粒子群算法是模拟鸟随机搜索食物的算法D、计算智能是局部最优算法答案:D深度学习开源软件框架描述,错误的是()A、TensorFlow支持多种操作系统和终端设备B、Caffe支持命令行、Python和MATLAB接口C、PyTorch内嵌自动求导系统,使其成为最流行的动态图像处理框架D、2018年PyTorch项目并入Caffe2项目。

19秋学期(1709、1803、1809、1903、1909)大数据开发技术(一)1组

第一组1优点是性能好(高并发),灵活性高,复杂性低,数据结构灵活提供嵌入式文档功能的数据库是(A.列族数据库B.键值数据库C.图数据库D.文档数据库标准答案:D2以下哪种属于图数据库(A MongoDBB RedisC HbaseD Neo4j标准答案:D3Storm中如果要让每一个Task都会收到所有的Tuple,应该采用哪种StreamGroupings o。

A. ShufflegroupingB. AllGroupingC. GlobalgroupingD. FiedlsGrouping标准答案:B4以下哪个是HDFS的局限性()。

A.吞吐率B.数据集C.兼容性D.延迟标准答案:D5.Storm中如果要随机分发Stream中的Tuple,保证每个Bolt的Task接收Tuple数量大致一致,应该采用哪种Streamgroupings(。

A. ShufflegroupingB. AllGroupingC Global groupingD. Fiedlsgrouping标准答案:A6.以下说法不正确的是A. Zookeeper提供分布式锁之类的基本服务B. Mahout提供了分布式存储服务C. Flume提供了日志管理服务D.Sqop主要被用于数据交互操作7.MapReduce将输入文件切分成M个分片,Master将其中个分片分给处于空闲状态的N个Worker来处理。

A MB. NC.M-1D.N-1标准答案:A8.Hbase中Zookeeper文件记录了(的位置A..MTA.表B.-R00T-表C RegionD Master标准答案:B9.Amazon SimpleDB属于A.关系数据库B.键值数据库C. NOSQL数据库D.数据仓库标准答案:B10.UMP系统的哪个功能实现了负载均衡OA.读写分离B.资源隔离C.资源调度D.可扩展标准答案:A在Storm的工作流程中,对于Supervisor说法错误的是A. Supervisor会去Zookeeper集群上认领自己的TaskB. Supervisor节点首先将提交的Topology进行分片,分成一个个Task,分配给相应的NimbusC. Supervisor会将Task和相关的信息提交到Zookeeper集群上D. Supervisor会通知自己的Worker进程进行Task的处理标准答案:BHDFS中FSDataInputStream封装了OA. HDFSInputStreamB. DFSInputStreamC DataInputStreamD. FSInputStreamStorm中如果要保证相同字段的Tuple分配到同一个Task中,应该采用哪种StreamGroupings oA. ShufflegroupingB AllGroutingC. GlobalgroupingD. FiedlsGrouping标准答案:D关于Hadoop集群网络拓扑,以下说法错误的是O。

mongodb单表数据量级

MongoDB是一种流行的NoSQL数据库,它提供了高效的数据存储和处理能力。

在MongoDB 中,单个表的数据量级是一个重要的话题,因为它会影响数据库的性能和可扩展性。

当数据量级达到一定程度时,MongoDB的性能和可扩展性会受到挑战。

具体来说,当表中的数据量达到GB或TB级别时,MongoDB的性能和可扩展性可能会受到影响。

这是因为MongoDB是一个内存中的数据存储,它依赖于内存来快速检索数据。

当数据量级过大时,内存消耗也会随之增加,导致性能下降和系统资源占用过多的问题。

为了应对大表的数据量级,MongoDB提供了以下几种策略:1. 分片(Sharding):MongoDB的分片功能可以将数据分布在多个节点上,以提高性能和可扩展性。

通过将数据按照一定的规则分布在不同的节点上,MongoDB可以在需要时动态地将查询分配到不同的节点上,从而优化性能。

2. 索引优化:合理的索引可以大大提高查询效率。

在大型表中,适当的索引可以帮助减少查询的时间复杂度,从而提高性能。

然而,过多的索引可能会导致查询效率下降,因此需要根据实际情况进行权衡。

3. 压缩(Compression):MongoDB支持数据压缩,可以减少存储空间的使用,从而提高存储效率。

对于大型表来说,压缩可以显著降低存储成本。

4. 备份和恢复策略:对于大型表,备份和恢复策略也是非常重要的。

使用适当的备份和恢复工具和方法,可以确保数据的安全性和完整性。

总之,对于大型表的数据量级,MongoDB提供了多种策略来应对性能和可扩展性的挑战。

通过合理地使用分片、索引优化、压缩和备份和恢复策略,可以确保在处理大量数据时保持高效和可靠的性能。

然而,需要注意的是,对于非常大的数据量级,可能需要考虑使用其他类型的数据库系统,如分布式数据库或数据仓库。

2022-3 大数据分析师(初级)考前冲刺题A1卷

信息素养培训平台2022.3 大数据分析师(初级)考前冲刺题A1卷1.【单选题】下面关于MapReduce任务描述不正确的是()。

A:不同的Map任务之间不会进行通信B:不同的Reduce任务之间也不会发生任何信息交换C:Map需要考虑数据全局性D:用户不能显式地从一台机器向另一台机器发送消息正确答案:C答案解析:在MapReduce工作工作中: 不同的Map任务之间不会进行通信。

不同的Reduce任务之间也不会发生任何信息交换。

Map需要考虑数据局部性,Reduce无需考虑数据局部性。

用户不能显式地从一台机器向另一台机器发送消息。

所有的数据交换都是通过MapReduce框架自身去实现的。

2.【单选题】下列不适用于大数据图计算的产品是()。

A:GraphXB:PregelC:FlumeD:PowerGraph正确答案:C答案解析:Flume是实时采集工具。

3.【单选题】利用Sqoop进行数据同步描述错误的是()。

A:将关系数据库数据导入HDFSB:将关系数据库数据导入HiveC:将关系数据库数据导入HBaseD:将HDFS数据导入Hive正确答案:D答案解析:Sqoop是一款开源的工具,主要用于在Hadoop与传统的关系数据库间进行数据的传递4.【单选题】散点图用于展示数据的相关性和分布关系,由X轴和Y轴两个变量组成。

通过因变量(Y轴数值)随自变量(X轴数值)变化的呈现数据的大致趋势,同时支持从类别和颜色两个维度观察数据的分布情况。

散点图支持()坐标系。

A:一维B:二维C:三维D:四维正确答案:B答案解析:散点图用于描述二维数据之间的关系。

5.【单选题】下列属于图形数据库的是()。

A:HBaseB:MongoDBC:Neo4JD:Oracle正确答案:C答案解析:图数据库的相关产品包括:Neo4J、OrientDB、InfoGrid、GraphDB等。

6.【单选题】哪种图形用于表示三维数据()。

1+X大数据平台运维初级题库与参考答案

1+X大数据平台运维初级题库与参考答案一、单选题(共60题,每题1分,共60分)1、HDFS 默认 Block Size 的大小是()。

A、32MBB、64MBC、128MBD、256M正确答案:C2、在 HDFS 分布式文件系统中,一般采用冗余存储,冗余因子通常设置为()A、1B、2C、3D、4正确答案:C3、ZooKeeper 的特点不包括()A、复合系统映像B、可靠性C、原子性D、顺序一致性正确答案:A4、以下选项哪个是 HDFS 的名称节点()A、DataNodeB、SecondaryNodeC、NodeD、NameNode正确答案:D5、在HBase Shell操作中,可以使用下面哪个命令对数据表进行行数统计( )。

A、select count(0) from ‘users’B、sum ‘users’C、count ‘users’D、truncate ‘users’正确答案:C6、HBase依赖( )提供消息通信机制。

A、ZookeeperB、ChubbyC、RPCD、Socket正确答案:A7、Client在HDFS上进行文件写入时,namenode根据文件大小和配置情况,返回部分datanode信息,谁负责将文件划分为多个Block,根据DataNode的地址信息,按顺序写入到每一个DataNode块A、ClientB、NamenodeC、DatanodeD、Secondary namenode正确答案:A8、在 HBase 的组件中,哪一个负责日志记录A、HregionB、HfileC、MemStoreD、WAL正确答案:D9、HBase 依赖_( )存储底层数据A、HDFSB、HadoopC、MemoryD、MapReduce正确答案:A10、整个大数据平台按其职能划分为五个模块层次,运行环境层是( )A、运行环境层为基础设施层提供运行时环境,它由 2 部分构成,即操作系统和运行时环境。

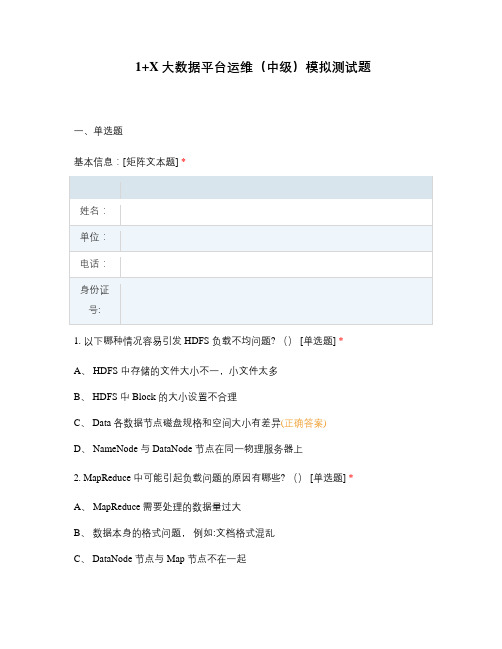

1+X大数据平台运维(中级)模拟测试题

1+X大数据平台运维(中级)模拟测试题一、单选题基本信息:[矩阵文本题] *1. 以下哪种情况容易引发 HDFS 负载不均问题? () [单选题] *A、 HDFS 中存储的文件大小不一,小文件太多B、 HDFS 中 Block 的大小设置不合理C、 Data 各数据节点磁盘规格和空间大小有差异(正确答案)D、 NameNode 与 DataNode 节点在同一物理服务器上2. MapReduce 中可能引起负载问题的原因有哪些? () [单选题] *A、 MapReduce 需要处理的数据量过大B、数据本身的格式问题,例如:文档格式混乱C、 DataNode 节点与 Map 节点不在一起D、 Map 中 Key 值选取和设定问题,导致 Key 值过于集中(正确答案)3. 下面哪些不是引起 Spark 负载不均的原因?() [单选题] *A、 Spark 读入的数据源是倾斜的B、 Shuffle 阶段 Key 值过于集中C、在数据过滤阶段需要处理的数据量差异D、 Spark 的运行方式差异(正确答案)4. 哪些不是引起 Hive 数据倾斜的原因?() [单选题] *A、数据在节点存储上分布不均B、运算中 Key 值分布不均C、业务数据本身存在分布不均D、 Hive 中表数量的多少(正确答案)5. Hive 数据倾斜的表现? () [单选题] *A、 Hive 建表后数据无法导入B、 Hive 无法启动C、 Hive sql 语句运行异常直接退出D、 Hive 运算任务为报错单长期卡在 99%(正确答案)6. 下列大数据特点中错误的是()。

[单选题] *A、数据体量大B、数据种类多C、处理速度快D、价值密度高(正确答案)7. 下列不属于数据存储技术的是()。

[单选题] *A、 MySQLB、 Storm(正确答案)C、 HDFSD、 HBase8. 企业使用大数据平台基于()做分析报表。

[单选题] *A、 MongoDBB、 BIC、 Hive(正确答案)D、 SQL9. 大数据存储是指用存储器,以()的形式,存储采集到数据的过程。

mongodb 面试题

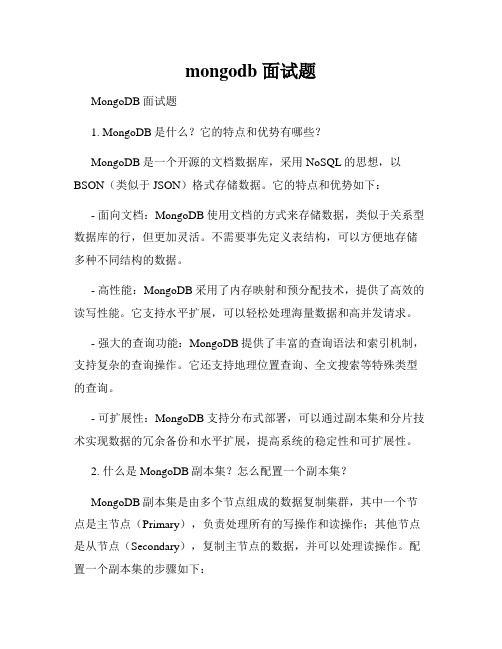

mongodb 面试题MongoDB面试题1. MongoDB是什么?它的特点和优势有哪些?MongoDB是一个开源的文档数据库,采用NoSQL的思想,以BSON(类似于JSON)格式存储数据。

它的特点和优势如下:- 面向文档:MongoDB使用文档的方式来存储数据,类似于关系型数据库的行,但更加灵活。

不需要事先定义表结构,可以方便地存储多种不同结构的数据。

- 高性能:MongoDB采用了内存映射和预分配技术,提供了高效的读写性能。

它支持水平扩展,可以轻松处理海量数据和高并发请求。

- 强大的查询功能:MongoDB提供了丰富的查询语法和索引机制,支持复杂的查询操作。

它还支持地理位置查询、全文搜索等特殊类型的查询。

- 可扩展性:MongoDB支持分布式部署,可以通过副本集和分片技术实现数据的冗余备份和水平扩展,提高系统的稳定性和可扩展性。

2. 什么是MongoDB副本集?怎么配置一个副本集?MongoDB副本集是由多个节点组成的数据复制集群,其中一个节点是主节点(Primary),负责处理所有的写操作和读操作;其他节点是从节点(Secondary),复制主节点的数据,并可以处理读操作。

配置一个副本集的步骤如下:- 启动多个MongoDB实例,每个实例配置不同的端口和数据目录。

- 在其中一个实例上进行初始化,成为主节点。

- 将其他实例设置为从节点,指定主节点的地址。

- 启动从节点,它们会自动从主节点同步数据。

3. MongoDB的索引有哪些类型?如何创建和使用索引?MongoDB支持多种类型的索引,包括单字段索引、复合索引、文本索引、地理空间索引等。

创建索引可以提高查询性能,加快数据检索的速度。

创建索引的基本步骤如下:- 使用`db.collection.createIndex()`方法创建索引,指定要创建索引的字段和索引类型。

- 可以使用`db.collection.getIndexes()`方法查看已创建的索引。

mongodb 集群空间不足删除数据

引言在进行MongoDB集群管理的过程中,经常会遇到集群空间不足的情况。

当这种情况发生时,我们需要采取一些措施来删除数据以释放空间。

本文将深入探讨MongoDB集群空间不足的原因、数据删除的方法以及我个人对这个话题的观点和理解。

一、MongoDB集群空间不足的原因1. 数据量持续增长:随着业务的发展和数据的积累,MongoDB集群中存储的数据量会逐渐增加,导致空间不足的问题。

2. 索引占用空间过大:集群中的各种索引也会占用大量空间,如果索引设计不合理或者存在大量冗余索引,就会加剧空间不足的问题。

3. 慢查询导致数据增长过快:如果集群中存在大量慢查询,可能导致数据增长速度过快,间接导致空间不足的问题。

二、数据删除的方法1. 删除历史数据:对于一些历史数据或者过期数据,可以通过定期清理的方式来删除,释放空间。

2. 压缩数据:对已有的数据进行压缩,可以减小数据占用的空间。

3. 精简索引:对不必要的或者冗余的索引进行删除或者优化,释放空间。

4. 分片存储:将数据按照一定的规则进行分片存储,可以有效减少单个节点的数据量,缓解空间不足的问题。

三、个人观点和理解在面对MongoDB集群空间不足的情况时,我认为需要综合考虑数据删除、索引优化和存储规划等多个方面的因素。

除了及时清理历史数据和优化索引外,还需要考虑集群的整体架构和未来的业务发展规划,以更全面地解决空间不足的问题。

对于数据库管理人员来说,需要保持对数据增长情况的监控,并及时调整存储策略,以避免空间不足给业务带来不必要的影响。

结论通过对MongoDB集群空间不足的原因、数据删除的方法以及个人观点和理解的探讨,我们可以更全面地理解并解决这一问题。

在实际操作中,需要根据具体情况综合考虑数据删除、索引优化和存储规划等多个方面的因素,以有效释放空间并保证集群的可用性和稳定性。

希望本文能对您在MongoDB集群管理中遇到空间不足的问题有所帮助。

扩写新内容:四、综合考虑解决方案针对MongoDB集群空间不足的问题,我们可以采取综合的解决方案来应对。

数据迁移与ETL工作中的MongoDB应用

数据迁移与ETL工作中的MongoDB应用在当今数字化时代,数据的重要性变得越来越不言而喻。

许多企业和组织需要将数据从一个系统迁移到另一个系统,或者对现有数据进行提取、转换和加载(ETL)以满足不同的需求。

本文将重点讨论数据迁移与ETL工作中MongoDB的应用。

一、MongoDB简介MongoDB是一个开源的、面向文档的NoSQL数据库管理系统,采用了分布式文件存储的方式,适合在云计算和大数据环境中应用。

MongoDB在处理非结构化和半结构化数据方面具有出色的性能和灵活性。

二、数据迁移的必要性数据迁移是将数据从一个存储系统迁移到另一个存储系统的过程。

常见的数据迁移场景包括将数据从关系型数据库迁移到MongoDB、从传统数据仓库迁移到云数据平台等。

数据迁移的主要原因包括业务扩展、系统升级、平台迁移、数据合并等。

三、ETL工作的概念与流程ETL(Extract-Transform-Load)是指从源系统中提取数据、进行一系列的转换操作,然后加载到目标系统中的过程。

ETL工作通常包括数据的清洗、过滤、合并、格式转换等步骤,以确保数据的完整性和一致性。

四、MongoDB在数据迁移中的应用4.1 数据提取阶段在数据迁移的数据提取阶段,MongoDB可以通过其丰富的查询语言和灵活的数据模型实现高效的数据提取。

借助MongoDB的聚合管道功能,可以对数据进行复杂的聚合操作和数据转换。

此外,MongoDB 支持分片集群和副本集群,可以更好地应对数据规模和高可用性的需求。

4.2 数据转换阶段数据转换是ETL工作中至关重要的一步,MongoDB提供了强大的操作符和函数,以支持复杂的数据转换和格式化需求。

例如,使用$project操作符可以对数据进行字段投影,只提取所需字段;使用$group操作符可以对数据进行分组,进行汇总计算;使用$lookup操作符可以进行数据的关联查询等。

4.3 数据加载阶段数据加载阶段是将转换后的数据加载到目标系统中的步骤。

mangodb替代方案

mangodb替代方案Mongodb替代方案近年来,随着数据量的快速增长和数据处理的需求不断提升,传统关系型数据库面临着越来越多的挑战。

在这个背景下,非关系型数据库逐渐崭露头角,并且成为了数据库领域的新宠。

在众多非关系型数据库中,Mongodb凭借其灵活性、易用性和出色的性能而备受关注。

然而,正如任何技术一样,Mongodb并非适用于所有场景。

本文将介绍一些Mongodb的替代方案,以帮助您在选择数据库时做出明智的决策。

1. CassandraCassandra是一个高度可伸缩的非关系型数据库,旨在处理大规模的分布式数据。

与Mongodb相比,Cassandra具有更好的水平扩展能力和数据冗余机制。

Cassandra采用了去中心化的架构,可以轻松实现跨多个数据中心的数据复制和故障恢复。

此外,Cassandra具有出色的写入性能和良好的读取性能,在需要处理海量数据的场景下表现出色。

2. Redis如果您的应用程序需要快速读取和写入的能力,并且对数据的一致性要求不高,那么Redis是一个理想的替代方案。

Redis是一个内存存储数据库,它将数据存储在内存中,以实现快速的读写操作。

与Mongodb相比,Redis具有更低的延迟和更高的吞吐量。

Redis还提供了丰富的数据结构支持,如字符串、哈希表、列表、集合和有序集合,使得它成为构建缓存、消息队列和实时统计等应用的理想选择。

3. Elasticsearch如果您的应用程序需要进行复杂的全文搜索和分析,那么Elasticsearch是一个不错的选择。

Elasticsearch是一个基于Lucene的搜索引擎,可以轻松地处理海量数据的索引和查询。

与Mongodb相比,Elasticsearch具有更强大的搜索能力和更高效的分布式架构。

它还提供了强大的聚合功能,可以用于实时分析和可视化数据。

4. MySQL虽然Mongodb是一个非关系型数据库,但在某些场景下,关系型数据库仍然是不可或缺的。

大数据处理期末考试题库

大数据期末考试题库Spark选择题Spark 的四大组件下面哪个不是 ( D )A.Spark Streaming B MlibC GraphxD Spark R下面哪个端口不是 spark 自带服务的端口 ( C )A.8080B.4040C.8090D.18080spark 1.4 版本的最大变化 ( B )A spark sql Release 版本B 引入 Spark RC DataFrameD 支持动态资源分配Spark Job 默认的调度模式 ( A )A FIFOB FAIRC 无D 运行时指定哪个不是本地模式运行的个条件 ( D )A spark.localExecution.enabled=trueB 显式指定本地运行C finalStage 无父 StageD partition 默认值下面哪个不是 RDD 的特点 ( C )A. 可分区 B 可序列化 C 可修改 D 可持久化关于广播变量,下面哪个是错误的 ( D )A 任何函数调用B 是只读的C 存储在各个节点D 存储在磁盘或 HDFS关于累加器,下面哪个是错误的 ( D )A 支持加法B 支持数值类型C 可并行D 不支持自定义类型Spark 支持的分布式部署方式中哪个是错误的 ( D )A standaloneB spark on mesosC spark on YARND Spark on localStage 的 Task 的数量由什么决定 ( A )A PartitionB JobC StageD TaskScheduler下面哪个操作是窄依赖 ( B )A joinB filterC groupD sort下面哪个操作肯定是宽依赖 ( C )A mapB flatMapC reduceByKeyD samplespark 的 master 和 worker 通过什么方式进行通信的? ( D ) A http B nio C netty D Akka默认的存储级别 ( A )A MEMORY_ONLYB MEMORY_ONLY_SERC MEMORY_AND_DISKD MEMORY_AND_DISK_SERspark.deploy.recoveryMode 不支持那种 ( D )A.ZooKeeperB. FileSystemD NONE D Hadoop下列哪个不是 RDD 的缓存方法 ( C )A persist()B Cache()C Memory()Task 运行在下来哪里个选项中 Executor 上的工作单元 ( C ) A Driver program B. spark masterC.worker node D Cluster managerhive 的元数据存储在 derby 和 MySQL 中有什么区别 ( B ) A. 没区别 B. 多会话 C. 支持网络环境 D 数据库的区别DataFrame 和 RDD 最大的区别 ( B )A. 科学统计支持B. 多了 schemaC. 存储方式不一样D. 外部数据源支持Master 的 ElectedLeader 事件后做了哪些操作 ( D )A. 通知 driverB. 通知 workerC. 注册 applicationD. 直接 ALIVE(Spark)Spark 是什么 () ?正确答案:A,C,DA.Spark 是基于内存计算的框架B.Spark 是基于磁盘计算的框架C.Spark 是一种基于 RDD 计算框架D.Spark 是一种并行计算框架spark 的数据,可以存储在哪些地方?正确答案:A,B,C,DB.CassandraC.HbaseD.S3大数据处理主要的三种场景为()正确答案:A,B,CA. 批处理B. 交互处理C. 流式计算D. 事务处理以下对 Spark Core 描述正确的有?正确答案:A,B,C,DA. 引入了 RDDB. 移动计算而非移动数据C. 使用线程池来减少 task 启动开销D. 使用 akka 作为通讯框架以下对 Spark SQL 的描述正确的有?正确答案:A,B,CA.Spark SQL 运行开发人员之间处理 RDDB.Spark SQL 可以直接查询 hive 中的数据C.Spark SQL 运行开发人员之间使用 SQL 进行复制的数据分析D.Spark SQL 的性能上,和 Hive 类似。

nosql练习题

NoSQL练习题一、选择题A) 文档型数据库B) 关系型数据库C) 图形数据库D) 键值对数据库2. MongoDB是一种什么类型的NoSQL数据库?A) 文档型数据库B) 关系型数据库C) 列存储数据库D) 对象存储数据库A) 缓存B) 消息队列C) 数据库A) FacebookB) TwitterC) LinkedInD) Google5. 在NoSQL数据库中,CAP定理指的是什么?A) 一致性、可用性、分区容错性B) 一致性、可用性、性能C) 可用性、性能、分区容错性D) 一致性、性能、分区容错性A) MongoDBB) RedisC) CouchDBD) Cassandra7. 在NoSQL数据库中,哪个概念与“文档”相对应?A) 表B) 记录C) 行D) 文档A) MongoDBB) HBaseC) RedisD) CouchDB9. 在NoSQL数据库中,哪个特性通常用于实现高可用性?A) 复制B) 分片C) 负载均衡A) MongoDBB) CassandraC) RedisD) Elasticsearch二、填空题11. 在MongoDB中,_________ 用于存储数据。

12. Redis是一种_________ 数据库。

13. 在Cassandra中,_________ 用于处理数据分区。

14. NoSQL数据库通常不保证_________。

15. 在NoSQL数据库中,_________ 用于实现数据的水平扩展。

三、判断题16. 在NoSQL数据库中,数据模型通常比关系型数据库更加灵活。

(对/错)17. Redis支持数据持久化。

(对/错)18. MongoDB中的文档相当于关系型数据库中的表。

(对/错)19. 在Cassandra中,分区键用于确定数据存储在哪个节点上。

(对/错)20. NoSQL数据库通常不支持SQL查询语言。

(对/错)四、简答题21. 简述NoSQL数据库的主要特点。

mongodb替换方法

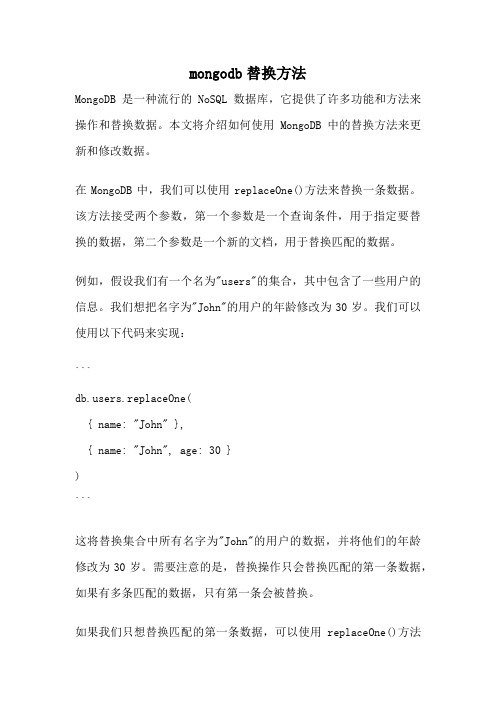

mongodb替换方法MongoDB是一种流行的NoSQL数据库,它提供了许多功能和方法来操作和替换数据。

本文将介绍如何使用MongoDB中的替换方法来更新和修改数据。

在MongoDB中,我们可以使用replaceOne()方法来替换一条数据。

该方法接受两个参数,第一个参数是一个查询条件,用于指定要替换的数据,第二个参数是一个新的文档,用于替换匹配的数据。

例如,假设我们有一个名为"users"的集合,其中包含了一些用户的信息。

我们想把名字为"John"的用户的年龄修改为30岁。

我们可以使用以下代码来实现:```ers.replaceOne({ name: "John" },{ name: "John", age: 30 })```这将替换集合中所有名字为"John"的用户的数据,并将他们的年龄修改为30岁。

需要注意的是,替换操作只会替换匹配的第一条数据,如果有多条匹配的数据,只有第一条会被替换。

如果我们只想替换匹配的第一条数据,可以使用replaceOne()方法的第三个参数。

该参数是一个选项对象,可以用来指定替换的行为。

例如,我们可以使用以下代码来替换匹配的第一条数据:```ers.replaceOne({ name: "John" },{ name: "John", age: 30 },{ upsert: false })```在这个例子中,我们将upsert选项设置为false,表示如果没有匹配的数据,不会插入新的数据。

除了replaceOne()方法,MongoDB还提供了其他一些替换方法,例如replaceMany()和update()。

这些方法可以根据具体的需求选择使用。

replaceMany()方法可以用来替换多条匹配的数据,它接受两个参数,第一个参数是一个查询条件,用于指定要替换的数据,第二个参数是一个新的文档,用于替换匹配的数据。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

MongoDB Middle Level (大数据量下MapReduce取代GroupBy)

MongoDB中的MapReduce其实更类似关系型数据库中的GroupBy 。

刚做了下这样试验,对于大数据量的GroupBy(MapReduce)还是比较理想的,生成100W条3

位随机字符串

for (var i=0; i<1000000; i++)

{

var x = "0123456789";

var tmp="";

for (var j=0; j<3; j++)

{

tmp += x.charAt(Math.ceil(Math.random()*100000000)%x.length);|

}

var u = {_id:i,v1:tmp};

db.RandomNum.insert(u);

}

然后进行对相同的随机数取Count数所以必须GroupBy

var m = function(){emit(this.v1,{count:1}); }; //map key类似关系型数据的group by 第二个是value 就var r = function (key,values) { var total = 0;for (var i=0; i<values.length; i++) { total += var res = db.RandomNum.mapReduce(m, r, {out:{replace:'Result'}});

db[res.result].find()

测试了下时间:

var startTime = new Date();

var m = function(){emit(this.v1,{count:1}); };

var r = function (key,values) { var total = 0;for (var i=0; i<values.length; i++) { total += var res = db.RandomNum.mapReduce(m, r, {out:{replace:'Result'}});

db[res.result].find()

(new Date().getTime()-startTime.getTime())/1000

结果如下:

> db[res.result].find()

{ "_id" : "000", "value" : { "count" : 1075 } }

{ "_id" : "001", "value" : { "count" : 1045 } }

{ "_id" : "002", "value" : { "count" : 1022 } }

{ "_id" : "003", "value" : { "count" : 968 } } { "_id" : "004", "value" : { "count" : 994 } } { "_id" : "005", "value" : { "count" : 1009 } } { "_id" : "006", "value" : { "count" : 948 } } { "_id" : "007", "value" : { "count" : 1003 } } { "_id" : "008", "value" : { "count" : 983 } } { "_id" : "009", "value" : { "count" : 993 } } { "_id" : "010", "value" : { "count" : 987 } } { "_id" : "011", "value" : { "count" : 982 } } { "_id" : "012", "value" : { "count" : 957 } } { "_id" : "013", "value" : { "count" : 1031 } } { "_id" : "014", "value" : { "count" : 971 } } { "_id" : "015", "value" : { "count" : 1053 } } { "_id" : "016", "value" : { "count" : 974 } } { "_id" : "017", "value" : { "count" : 975 } } { "_id" : "018", "value" : { "count" : 978 } } { "_id" : "019", "value" : { "count" : 1010 } } has more

>

> (new Date().getTime()-startTime.getTime())/1000 63.335s

> bye

测试机的性能:。