HLDA学习笔记

HALCON20.11:深度学习笔记(5)

HALCON20.11:深度学习笔记(5)HALCON 20.11.0.0中,实现了深度学习方法。

关于超参数的有关设置内容如下:不同的DL方法被设计用于不同的任务,它们的构建方式也会有所不同。

它们都有一个共同点,即在模型的训练过程中都面临着一个最小化问题。

训练网络或子网络,一个目标是努力使适当的损失函数最小化,参见“网络和训练过程”一节。

为此,有一组进一步的参数,这些参数是在开始训练之前设置的,在训练期间未进行优化。

我们将这些参数称为超参数。

对于DL模型,您可以设置更改策略,指定您希望在培训期间何时以及如何更改这些超参数。

在本节中,我们将解释不同超参数的概念。

注意,某些方法有额外的超参数,你可以在它们各自的章节中找到更多的信息。

如前所述,损失比较来自网络的预测与图像内容的给定信息。

损失决定惩罚偏差。

训练网络以这样的方式更新滤波器权值,使损失受到的惩罚更少,从而使损失结果得到优化。

为此,需要从训练数据集中获取一定数量的数据。

对于这个子集,计算损失的梯度,并修改网络以更新其相应的滤波权重。

现在,对下一个数据子集重复这一过程,直到整个训练数据被处理。

这些训练数据的子集被称为批,这些子集的大小,即“batch_size”,决定了一个批处理的数据数量,并作为结果一起处理。

对整个训练数据的完整迭代称为epoch。

对训练数据进行多次迭代是有益的。

迭代次数由“epochs”定义。

因此,“epochs”决定了算法在训练集上循环多少次。

一些模型(如异常检测)一次训练使用整个数据集。

对于其他模型,数据集按批处理,为了做到这一点,使用了随机梯度下降算法SGD (Stochastic Gradient Descent)。

这涉及到更多的参数,将在下面解释。

在每次计算损失梯度后,滤波器权值被更新。

对于这个更新,有两个重要的超参数:'learning_rate',它决定更新的损失函数参数(过滤器权重)上的梯度的权重,以及间隔内的'momentum',它指定以前更新的影响。

华尔街学堂python笔记

华尔街学堂python笔记

华尔街学堂的Python笔记可能包括以下内容:

1.Python基础语法:包括变量、数据类型、控制流、函数等。

2.文件操作:介绍如何打开文件、读取文件、写入文件和关闭文件等操作。

3.数据处理:介绍如何使用Pandas库处理数据,包括数据导入、数据清洗、数据转换等

操作。

4.数据可视化:介绍如何使用Matplotlib和Seaborn库进行数据可视化,包括绘制折线图、

柱状图、散点图等。

5.机器学习:介绍如何使用Scikit-learn库进行机器学习,包括分类、回归、聚类等算法的

使用和评估。

6.金融数据获取和预处理:介绍如何获取金融数据并对其进行预处理,包括数据清洗、缺

失值处理、异常值处理等操作。

7.量化交易:介绍如何使用Python进行量化交易,包括策略编写、回测、优化等操作。

这些只是可能包含的部分内容,具体内容可能会因课程不同而有所差异。

《Oracle J D Edwards技术与应用 基础篇》读书笔记思维导图

2.3.3 工具栏 2.3.4 网格

2.3.5 UBE、报表 及计划作业

2.3.6 用户自定义码 UDC

2.3.7 地址簿

2.3.8 自动会计指令 AAI & DM...

第3章 JDE中几个子系统的原理 与功能

3.1 财务管理子系统 3.2 固定资产子系统

3.3 采购管理子系统 3.4 库存管理子系统

《Oracle J D Edwards技术与应用

基础篇》

最新版读书笔记,下载可以直接修改

思维导图PPT模板

本书关键字分析思维导图

第章

信息

系统

概述

使用

应用

技术

管理

企业

功能 生产

作业

项目

子系统

会计

计划

报表

采购

基础

目录

01 免责声明

03 第2章 JDE E1概述

02

第1章 企业信息化概 述

04 第3章 JDE中几个子 系统的原理与功能

1

3.6.1 产品数 据管理

2

3.6.2 车间管 理

3

3.6.3 需求计 划

4

3.6.4 质量管 理

5 3.6.5 产品成

本核算和制造 会计

3.7.2 财务管理及 法规遵守控制台

3.7.1 工厂管理者 信息显示板(Pla...

3.7.3 BI Publisher 报...

第4章 JDE实施

1

5.3.1 权限管理 5.3.2 添加角色

5.3.3 添加用户 5.3.4 权限控制

附录A JDE资源

参考文献

感谢观看

读

书

笔

记

目录

05 第4章 JDE实施

《编程卓越之道(卷3):软件工程化》读书笔记模板

9系统文档 10需求文档

11软件设计描述文档 12软件测试文档

9.1系统文档类型 9.2可追溯性 9.3确认、验证和审查 9.4通过文档降低开发成本 9.5获取更多信息

10.1需求的来源和可追溯性 10.2设计目标 10.3系统需求规范文档 10.4软件需求规范文档 10.5创建需求 10.6用例 10.7根据用例创建DAQ软件需求 10.8 (从SRS中选择的)DAQ软件需求 10.9用需求信息更新可追溯性矩阵

11.1 IEEE Std 1016-1998和IEEE Std 1016-2009 11.2 IEEE 1016-2009的概念模型 11.3 SDD所需内容 11.4 SDD的可追溯性和标签 11.5建议的SDD大纲 11.6 SDD文档示例 11.7用设计信息更新可追溯性矩阵 11.8创建软件设计 11.9获取更多信息

12.1 Std 829中的软件测试文档 12.2测试计划 12.3软件审查列表文档 12.4软件测试用例文档 12.5软件测试过程文档 12.6级别测试日志 12.7异常报告 12.8测试报告 12.9你真的需要这些吗

读书笔记

这是《编程卓越之道(卷3):软件工程化》的读书笔记模板,可以替换为自己的心得。

5.1 UML活动状态符号 5.2扩展UML活动图 5.3获取更多信息

6.1 UML中的面向对象分析与设计 6.2类图中的可见性 6.3类属性 6.4类操作 6.5 UML的类关系 6.6对象 6.7获取更多信息

7.1时序图 7.2协作图 7.3获取更多信息

8.1组件图 8.2包图 8.3部署图 8.4合成结构图 8.5状态图 8.6关于UML的更多信息 8.7获取更多信息

3.1软件开发生命周期 3.2软件开发模型 3.3软件开发方法论 3.4卓越程序员的模型和方法论 3.5获取更多信息

NAT9914学习笔记

1.发送GPIB数据消息的基本流程(from nat9914_rm):(1)确认T1 delay已经被正确设置;(2)等待NA T9914被编程(向auxcr寄存器写入0x09\89\0A\8A指令)或寻址(CIC发送MTA(My Talker Address)指令)作为活动讲者;(3)等待BO位(ISR0[4])被设置;(4)将数据字节写到CDOR寄存器中;(5)等待BO位(ISR0[4])或ERR位(ISR1[6])被设置;BO=1表明系统中的所有设备都已经接收了这个数据或指令;ERR=1表明系统中有设备没有正常工作。

主端口(host interface)可以通过对BO与ERR位进行查询,也可以通过设置BOIE与ERR IE位使得这些事件自动产生中断。

(两种方式:查询、中断)2.如何发送EOI或EOS?方法一:将字节写入CDOR之前,写入Send EOI指令(向auxcr寄存器写入0x08);这一指令的作用:使得下一个数据字节传输完成后EOI信号线自动变高;方法二:设置XEOS(ACCRA[3])=1,当CDOR中的字节值与EOSR中设置的值相同时,EOI线将自动置高;方法三:直接向CDOR中写入EOS码。

3.与T1 Delay有关的问题:T1 Delay的定义:在GPIB端口数据传输的过程中,NA T9914作为讲者驱动数据字节到DIO[8-1]信号线上,经过一定的延迟(称为T1 Delay),NA T9914置DA V为低向听者表明数据字节已经被放置到DIO[8-1]信号线上。

关于T1 Delay的设置,目前先不设ustd, vstdl和stdl,先设为缺省值2000ns,等系统功能初步实现后,再琢磨如何提高传输速度。

4.nbaf: auxiliary command(0x05),New Byte A vailable Falsenbaf强制将本地消息nba(new byte available)置为false,这个动作将禁止NA T9914发送CDOR中最后写入的字节。

哈工大操作系统读书笔记

哈工大操作系统读书笔记在哈尔滨工业大学的计算机科学与技术专业的学习中,操作系统是我们学科的核心课程之一。

为了更好地掌握操作系统的基本原理和技术,我认真阅读了相关教材,并做了一些笔记。

一、操作系统的基本概念1. 操作系统定义:操作系统是控制计算机硬件和软件资源,管理用户程序运行,提供用户界面和应用程序开发环境的一种系统软件。

2. 操作系统功能:主要功能包括处理机管理、存储管理、文件管理、设备管理以及用户界面。

二、处理机管理1. 进程的定义:进程是程序的一次执行,是系统进行资源分配和调度的基本单位。

2. 进程的状态:包括新建、就绪、运行和阻塞四种状态。

3. 进程控制块PCB:用于描述进程的基本信息和运行状态。

4. 进程调度算法:包括先来先服务、最短作业优先、最短剩余时间优先等。

三、存储管理1. 内存分配方式:包括固定分区、可变分区、分页和分段。

2. 内存置换算法:包括先进先出、最近最少使用、最佳置换算法等。

3. 虚拟内存的概念:通过将内存和外存统一管理,为用户提供一个比实际内存大得多的虚拟内存空间。

四、文件管理1. 文件系统的概念:文件系统是操作系统中负责管理和存储文件信息的软件部分。

2. 文件的分类:按性质分为系统文件和用户文件;按内容分为文本文件和二进制文件;按存储方式分为顺序文件和随机文件。

3. 文件的访问方式:包括顺序访问和随机访问。

五、设备管理1. 设备驱动程序的概念:设备驱动程序是操作系统与硬件设备交互的接口,负责设备的初始化和释放、设备的读写操作以及设备的状态查询等。

2. 缓冲技术的概念:缓冲技术是解决I/O设备速度与CPU速度不匹配问题的一种方法,通过在内存中开辟一块缓冲区,暂时存放输入输出数据,以实现数据的同步传输。

3. 设备分配与回收:设备分配的主要任务是确定哪些进程可以使用哪些设备,并满足设备的互斥使用和独立性等约束条件;设备回收的任务是在进程终止时,将设备的使用权收回并重新分配给其他进程使用。

HALCON20.11:深度学习笔记(9)

HALCON20.11:深度学习笔记(9)HALCON 20.11.0.0中,实现了深度学习方法。

本章解释了如何使用基于深度学习的异常检测。

通过异常检测,我们想要检测图像是否包含异常。

异常指的是偏离常规的、未知的东西。

异常检测的例子:输入图像的每个像素都被分配了一个值,该值表明该像素是异常的可能性有多大。

蠕虫不是模型在训练中看到的无虫苹果的一部分,因此它的像素得到了更高的分数。

一个异常检测模型学习没有异常的图像的共同特征。

训练后的模型将推断出输入图像只包含学习过的特征的可能性有多大,还是该图像包含不同的东西。

后一个被解释为异常。

此推理结果作为灰度图像返回。

其中的像素值表示输入图像像素中相应像素显示异常的可能性有多大。

一般工作流程在本节中,我们描述了基于深度学习的异常检测任务的一般流程。

预处理数据这一部分是关于如何预处理数据的。

1. 需要转换数据集的信息内容。

这是通过函数read_dl_dataset_anomaly来完成的。

它创建了一个字典DLDataset,它充当一个数据库,存储关于您的数据的所有必要信息。

要了解更多关于数据及其传输方式的信息,请参阅下面的“数据”一节和深度学习/模型一章。

2. 拆分字典DLDataset表示的数据集。

这可以使用函数split_dl_dataset来完成。

3. 网络对图像有几个要求。

可以使用函数get_dl_model_param检索这些需求(例如图像大小和灰度值范围)。

为此,您需要首先通过函数read_dl_model读取模型。

4. 现在可以对数据集进行预处理了。

为此,您可以使用该函数preprocess_dl_dataset。

对于自定义预处理,本函数提供了实现的指导。

要使用这个函数,请指定预处理参数,例如,图像的大小。

将所有参数及其值存储在DLPreprocessParam字典中,您可以使用该函数create_dl_preprocess_param。

我们建议保存这个字典DLPreprocessParam,以便稍后在推理阶段访问预处理参数值。

交互设计概论李四达读书笔记

交互设计概论李四达读书笔记《交互设计概论》是李四达教授的一部关于交互设计的专著,全书共分为五个部分,分别是交互设计的基本概念、交互设计的方法与过程、交互设计的原则与策略、交互设计的实践案例以及交互设计的未来发展趋势。

在阅读这本书的过程中,我对交互设计有了更深入的了解,以下是我在阅读过程中的一些读书笔记。

1. 交互设计的基本概念交互设计是一门研究人与计算机系统之间相互作用的学科,它关注的核心问题是如何在用户与产品之间建立一种有效的沟通方式,使用户能够更好地理解和使用产品。

交互设计的目标是提高产品的易用性、可用性和愉悦性,从而提高用户的满意度和忠诚度。

2. 交互设计的方法与过程交互设计的过程可以分为需求分析、概念设计、详细设计和评估四个阶段。

在需求分析阶段,设计师需要深入了解用户的需求和期望,以便为他们提供合适的解决方案。

在概念设计阶段,设计师需要根据需求分析的结果,提出一系列可能的设计方案。

在详细设计阶段,设计师需要对选定的方案进行详细的设计,包括界面布局、导航结构、交互模式等方面。

在评估阶段,设计师需要对设计方案进行测试和评估,以便不断优化和完善。

3. 交互设计的原则与策略交互设计的原则包括一致性、反馈、可控性、简洁性等。

一致性是指产品的各个部分应该具有一致的风格和操作方式,以便用户能够快速地熟悉和使用产品。

反馈是指产品应该及时地向用户提供操作结果的信息,以便用户了解当前的状态和下一步的操作。

可控性是指用户应该能够自由地控制产品的操作过程,以便根据自己的需求和习惯进行调整。

简洁性是指产品的界面和操作方式应该尽量简单明了,以便用户能够轻松地理解和使用。

4. 交互设计的实践案例书中通过多个实践案例,详细介绍了交互设计的方法和技巧。

这些案例涵盖了不同类型的产品,如软件、硬件、网站等,以及不同的设计问题,如导航、搜索、输入等。

通过学习这些案例,我了解到了如何将理论知识应用到实际的设计过程中,以及如何解决实际的设计问题。

23课的课堂笔记

23课的课堂笔记

23课堂笔记:

本次课程主要讲解了大数据处理中的一些基本概念和技术,以下是我所记录的一些重点内容:

1. 大数据指的是数据量过大、类型繁多、处理速度要求高的数

据集合。

其特点包括三个V:Volume(数据规模大)、Variety(数据类型多样)和Velocity(数据处理速度快)。

2. 大数据处理的技术包括分布式存储和计算、MapReduce编程

模型、Hadoop生态系统等。

其中,Hadoop是一个开源的大数据处理

框架,包含了HDFS分布式文件系统和MapReduce计算模型。

3. 在大数据处理中,常用的数据存储格式包括文本格式、序列

化格式和列式存储格式。

其中,列式存储格式在处理大规模数据时具有较好的性能表现。

4. 数据清洗和预处理在大数据处理中也非常重要。

常用的数据

清洗工具包括OpenRefine、DataWrangler等。

5. 大数据可视化是将大数据处理结果以图形化界面展现出来的

过程。

常用的大数据可视化工具包括Tableau、D3.js等。

总的来说,本次课程让我了解到了大数据处理的基本概念和技术,对我今后的工作和学习都有很大的启发作用。

深度学习的数学读书笔记

《深度学习的数学》读书笔记一、超参数调整与优化方法概述超参数调整是深度学习模型训练过程中的重要步骤,直接影响模型的性能。

通过对超参数的调整,我们可以优化模型的性能,提高模型的精度和泛化能力。

书中详细介绍了多种超参数调整策略,包括网格搜索、随机搜索和贝叶斯优化等。

网格搜索是一种简单但计算成本较高的方法,通过在指定的超参数范围内进行网格划分,然后分别尝试不同的超参数组合来找到最优配置。

随机搜索则通过随机采样超参数组合来避免陷入局部最优解,有助于在更大范围内寻找最佳超参数配置。

贝叶斯优化方法则是一种基于贝叶斯定理的优化策略,通过对已知数据进行建模,预测新的超参数配置的性能,从而有效地提高超参数调整的效率。

除了超参数调整策略,书中还涉及多种优化方法的应用场景和特点。

常见的优化方法包括梯度下降、动量法、自适应学习率调整等。

梯度下降是深度学习中应用最广泛的优化算法之一,通过不断计算损失函数的梯度并更新权重来最小化损失函数。

动量法则是一种改进的梯度下降算法,通过引入动量项来加速收敛并减少震荡。

自适应学习率调整方法则根据模型的训练过程动态调整学习率,有助于在不同阶段选择适当的学习率以适应模型的学习速度。

书中还介绍了一些先进的优化技术,如Adam和RMSProp等自适应优化算法,它们在深度学习模型的训练中发挥着重要作用。

在实际应用中,我们需要根据具体问题选择合适的超参数调整策略和优化方法。

还需要注意超参数的选取范围、模型的复杂度以及数据的特性等因素对模型性能的影响。

通过对这些因素的全面考虑,我们可以更有效地训练深度学习模型,提高模型的性能和应用效果。

二、正则化与损失函数选择策略分析深度学习模型的训练过程中,正则化和损失函数的选择都是至关重要的环节,这两者不仅直接影响到模型的性能,还关系到模型的稳定性和泛化能力。

在阅读《深度学习的数学》我对这两部分内容有了更深入的理解。

正则化是一种控制模型复杂度的技术,通过添加额外的信息或者约束条件来防止模型过度拟合训练数据。

Python从入门到精通:光环大数据学员笔记全整理

Python从入门到精通:光环大数据学员笔记全整理光环大数据Python培训了解到,Python被称为胶水语言,受到了很多编程初学者和其他需要职业提升的编程者的热捧,为了方便小伙伴们的学习,光环大数据Python开发团队特别整理了《Python开发从入门到精通》的学习路径资料,囊括了整个学习过程的重点与精华,内容全部由光环大数据Python开发团队采编撰写而成,欢迎大家支持!!!详情请看:一、Python入门准备1.为什么Python这么火?2.Python如何快速入门?3.Python入门之学习资料推荐4.Python必备的19个编程资源5.Python入门知识点总结6.Python学不好怎么办?7.Python学习有哪些阶段?8.参加Python培训会有前景吗?9.Python培训班真的有效吗?10.参加Python培训前应该做哪些准备?二、Python入门知识1.Python安装教程2.Pyenv在centos6.9安装教程3.linux下多版本python环境配置教程4.python语法基础总结5.python基础语法之if,else,for,while,continue,break6.Python循环三、Python中级进阶1.Python基础之重定向和管道2.Python函数式编程指南:函数3.Python函数式编程指南:迭代器4.Python函数式编程指南:生成器5.python装饰器详解四、Python高级技巧1.装饰器深度解析2.深入Python字典3.Python线程技术4.Python的异步IO:Asyncio简介5.Python实现线程安全队列五、Python常用工具1.2017最受欢迎的15大Python库2.5个高效Python库3.Django官方教程4.PythonDjango的正确学习方法5.Python自然语言处理工具小结7.数据科学常用Python工具六、Python实战练习1.Python破解斗地主残局2.python实现爬虫功能3.Python脚本完成登入新浪微博并批量下载4.使用Python–PCA分析进行金融数据分析5.用python制作游戏外挂吗?6.运用爬虫抓取网易云音乐评论生成词云7.使用Scrapy爬起点网的完本小说8.TensorFlow计算加速七、其他1.11道Python基本面试题|深入解答2.Python求职怎么拿到Offer以上为光环大数据Linux云计算学员精华笔记,希望对大家有所帮助,谢谢!为什么大家选择光环大数据!大数据培训、人工智能培训、Python培训、大数据培训机构、大数据培训班、数据分析培训、大数据可视化培训,就选光环大数据!光环大数据,聘请专业的大数据领域知名讲师,确保教学的整体质量与教学水准。

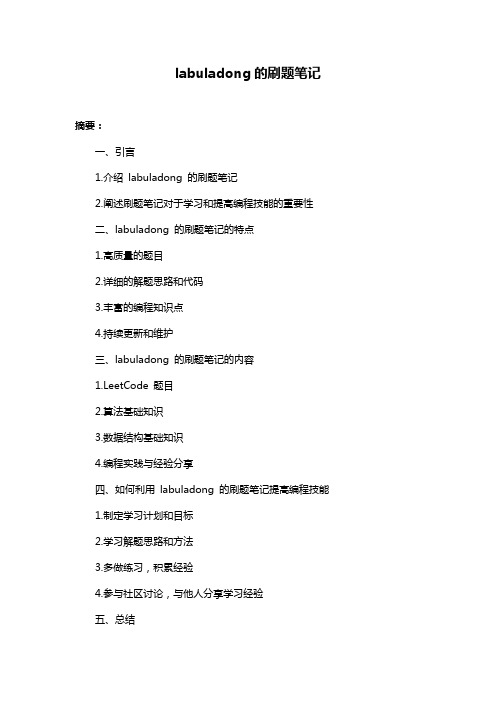

labuladong的刷题笔记

Labuladong的刷题笔记1. Labuladong简介Labuladong,是一名来自我国的程序员,以其在LeetCode等在线编程评台上的刷题笔记而闻名。

他擅长使用简洁而高效的算法解决问题,常常能够以更快的速度和更优雅的解决方案解决问题,因此受到广大程序员的尊敬和追随。

2. 算法和数据结构的深度探讨Labuladong的刷题笔记不仅仅是对问题的解答,更多的是对算法和数据结构的深度探讨。

他会从简单的问题出发,逐步延伸至更为复杂的情景,并解释其中的原理和逻辑。

他会以图表和实例来辅助讲解,帮助读者更加直观地理解各种算法和数据结构的应用场景。

3. 深度和广度的兼具Labuladong的刷题笔记不仅覆盖了各种类型的题目,如数组、链表、树、动态规划等等,而且在解答问题的过程中,他会深入挖掘各种算法和数据结构的内在联系,帮助读者建立起更为全面和深刻的知识体系。

这种深度和广度兼具的风格,使得他的笔记不仅是解题的工具,更是一本深入学习算法和数据结构的宝典。

4. 共享个人观点和理解通过阅读Labuladong的刷题笔记,人们不仅能够了解到各种算法和数据结构的应用,更能够感受到作者对于编程世界的独特见解。

他善于从实际问题出发,总结出一些通用的解决方法和技巧,这些经验可以帮助读者更好地应用在自己的编程实践中,提高工作和竞赛中的效率。

5. 总结和回顾Labuladong的刷题笔记不仅是一些零散的题解,更像是一本丰富而完整的编程经验之谷。

在文章的结尾,他会对所涉及的主题进行总结和回顾,帮助读者系统地理解全部内容,从而更好地应用到实际情境中。

Labuladong的刷题笔记是一份高质量、深度和广度兼具的学习资料。

通过阅读他的笔记,人们不仅能够学习到解题的方法,更会深刻理解到算法和数据结构的奥妙之处,从而提升自己的编程水平。

Labuladong的刷题笔记不仅仅是一份具有指导作用的学习资料,更是一种对编程世界的探索和实践。

labuladong 的刷题笔记

Labuladong的刷题笔记一、Labuladong简介Labuladong,是力扣(LeetCode)全球信息湾的一名知名博主,因其在算法和数据结构方面的独特见解和深入讲解而备受广大程序员的推崇。

他以其真实尊称“Hua Dong”自称,曾就读于清华大学计算机专业,并在硅谷拥有多年工作经验。

由于他在算法、数据结构和编程方面的独到见解和丰富经验,因此备受众多程序员的追捧,他的博客和算法讲解被广泛传播和引用。

二、刷题笔记的意义1.刷题的意义刷题一直是程序员和计算机专业学生的必修课程,它能够帮助大家更好地掌握编程思维和算法解题能力。

而Labuladong的刷题笔记更是将这一过程推向了高峰,他总结的刷题方法、技巧和经验成为了很多人学习和进步的重要参考。

2.刷题笔记的重要性Labuladong的刷题笔记对于广大程序员来说具有非常大的指导作用。

在学习刷题的过程中,很多人都会遇到一些棘手的问题,比如题目理解不清晰、解法思路不清晰等。

而Labuladong在自己的刷题笔记中总结了许多这样的情况,并给出了详细的解题方法和思路,帮助读者更快地理解和掌握。

三、从简到繁的讲解方式Labuladong的刷题笔记以从简到繁、由浅入深的方式探讨了许多算法和数据结构的题目。

在他的博客或视频中,通常会从最基础的算法知识开始,然后逐渐深入,直至探讨一些非常深奥和复杂的题目。

这样的讲解方式让读者更容易理解,也更容易接受。

四、对刷题笔记内容的回顾与总结Labuladong的刷题笔记内容非常丰富,几乎囊括了所有常见的算法和数据结构题目。

通过他的刷题笔记,可以系统地学习和掌握各种算法思想和解题技巧。

值得一提的是,他在刷题笔记中还共享了自己的面试经验和技巧,这对于正在准备面试的程序员来说非常有帮助。

五、个人观点和理解在学习Labuladong的刷题笔记的过程中,我深切感受到了他对算法和编程的热爱和专注。

他的共享不仅帮助了很多人提高了解题能力,同时也激发了广大程序员对编程的热情。

哈工大博士的pytorch笔记

哈工大博士的pytorch笔记摘要:1.引言:介绍哈工大博士的PyTorch 笔记2.内容概述:概括哈工大博士的PyTorch 笔记的主要内容3.笔记的实用性:分析哈工大博士的PyTorch 笔记对学习和理解PyTorch 的实用性4.笔记的优点:介绍哈工大博士的PyTorch 笔记的优点5.结论:总结哈工大博士的PyTorch 笔记的价值和意义正文:1.引言本文要介绍的是哈工大博士的PyTorch 笔记。

这是一份由哈尔滨工业大学一名博士生整理的关于深度学习框架PyTorch 的详细笔记,旨在帮助更多的人学习和理解PyTorch。

2.内容概述哈工大博士的PyTorch 笔记主要涵盖了PyTorch 的基本概念、安装和使用,以及各种常用算法的实现和应用。

内容包括但不限于以下几个方面:- PyTorch 的基本概念:张量、变量、数据加载和预处理等;- PyTorch 的安装与使用:各种版本的安装方法,以及使用Python 进行开发的方法;- 常用算法的实现和应用:包括卷积神经网络(CNN)、循环神经网络(RNN)、长短时记忆网络(LSTM)等。

3.笔记的实用性哈工大博士的PyTorch 笔记非常实用,因为它详细介绍了PyTorch 的各种功能和用法,以及如何使用PyTorch 实现各种深度学习算法。

这些内容对于初学者来说非常有帮助,可以让他们更快地上手PyTorch,同时也为进阶者提供了很多实用的技巧和方法。

4.笔记的优点哈工大博士的PyTorch 笔记具有以下几个优点:- 系统性强:笔记内容涵盖了PyTorch 的方方面面,从基本概念到高级应用,体系完整,条理清晰;- 实例丰富:笔记中提供了大量的代码实例,方便读者理解和学习;- 更新及时:哈工大博士会根据PyTorch 的新版本和最新研究成果更新笔记内容,保证笔记的时效性。

5.结论哈工大博士的PyTorch 笔记是一份非常实用的深度学习学习资料,对于广大深度学习爱好者和研究者来说,具有很高的学习和参考价值。

code笔记法,para分类法

code笔记法,即以代码形式记录笔记的方法,一般用于记录技术、编程方面的知识和经验。

而para分类法则是以段落形式将相关内容分类组织,便于阅读和理解。

一、code笔记法1. 代码风格统一在使用code笔记法时,需要注意代码风格的统一,包括缩进、命名规范、注释规范等,这样能够提高代码的可读性和可维护性。

2. 记录问题和解决方案在实际编程中,经常会遇到各种问题,使用code笔记法能够将问题和解决方案记录下来,以便日后参考和复用。

3. 学习总结在学习新的编程语言或框架时,通过code笔记法记录下重要的知识点和实践经验,能够帮助加深理解和记忆。

4. 版本管理代码是不断迭代和更新的,使用code笔记法能够帮助记录每一个版本的变化和更新内容,为后续的版本管理提供参考。

5. 工作日志在实际工作中,使用code笔记法能够记录工作日志、进度和遇到的问题,方便团队协作和交流。

二、para分类法1. 知识点整理使用para分类法能够将不同的知识点进行分类整理,便于自己理解和记忆,也方便他人阅读和学习。

2. 逻辑清晰通过将相关内容按照特定的分类进行组织,能够帮助文章或笔记的逻辑更加清晰,便于读者理解和接受。

3. 内容精炼para分类法能够将内容进行精炼和提炼,去除冗余和无关的内容,使得文章更加简洁和有吸引力。

4. 结构合理通过分类法进行内容组织,能够让文章的结构更加合理,使得整个文章看起来更加整洁和有条理。

5. 阅读体验对于读者来说,通过分类法组织的文章更容易阅读和理解,能够提升阅读体验和学习效果。

结语以上是关于code笔记法和para分类法的一些介绍和应用场景。

无论是在学习、工作还是实际项目中,良好的笔记方法都能够帮助我们更好地记录和整理知识,提高工作效率和学习效果。

希望大家在实际应用中能够加以尝试和总结,找到适合自己的笔记方法,提升个人能力和团队协作效率。

code笔记法与para分类法是在个人知识管理和学习过程中非常有用的工具。

labuladong的刷题笔记

labuladong的刷题笔记摘要:一、引言1.介绍labuladong 的刷题笔记2.阐述刷题笔记对于学习和提高编程技能的重要性二、labuladong 的刷题笔记的特点1.高质量的题目2.详细的解题思路和代码3.丰富的编程知识点4.持续更新和维护三、labuladong 的刷题笔记的内容1.LeetCode 题目2.算法基础知识3.数据结构基础知识4.编程实践与经验分享四、如何利用labuladong 的刷题笔记提高编程技能1.制定学习计划和目标2.学习解题思路和方法3.多做练习,积累经验4.参与社区讨论,与他人分享学习经验五、总结1.强调刷题笔记对于编程学习的重要性2.呼吁大家积极学习和使用labuladong 的刷题笔记,提高编程技能正文:一、引言在当今信息时代,编程技能已经成为一项非常重要的技能。

无论是从事软件开发、数据分析,还是其他相关领域,掌握编程技能都将为你的职业生涯带来极大的帮助。

而labuladong 的刷题笔记,正是一个可以帮助你提高编程技能的优质资源。

本文将介绍labuladong 的刷题笔记,并探讨如何利用它来提高我们的编程技能。

二、labuladong 的刷题笔记的特点labuladong 的刷题笔记以其独特的特点,受到了许多编程爱好者的喜爱。

首先,它提供了高质量的题目。

这些题目涵盖了各种编程知识点,从基础的数据结构和算法,到进阶的编程技巧和优化方法。

通过解决这些题目,你将能够全面地提高自己的编程能力。

其次,labuladong 的刷题笔记提供了详细的解题思路和代码。

这使得学习者能够更好地理解题目的解法,从而提高自己的编程水平。

同时,这些代码也为我们提供了一个很好的参考,让我们可以学习到优秀的编程实践和技巧。

此外,labuladong 的刷题笔记还涵盖了丰富的编程知识点。

无论是初学者还是有一定基础的编程爱好者,都可以在这里找到适合自己的学习内容。

这使得刷题笔记成为了一个非常实用的编程学习工具。

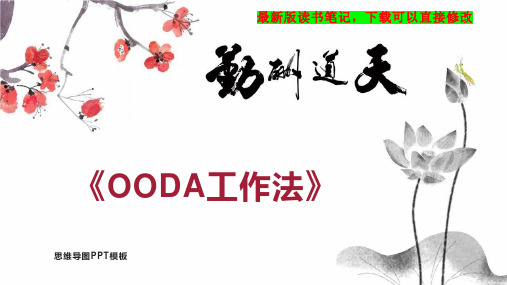

《OODA工作法》读书笔记思维导图

04

任何人通过 锻炼都能掌 握直觉力

06

V〔梦想愿 景 (Vision )〕——自 己和...

05

“世界观 (VSA)” 是人类一切 思考与行 动...

01

与“梦想愿 景”无关的 工作都是无 用功

02

S〔战略 (Strateg y)〕—— 根据“...

03

A〔行动方 针 (Activit ies Di...

03

利用“销售 漏斗管理” 与时间分配 将工作 “可...

04

消除无用功 可以使附加 价值的比率 提高12%

06

“劳动方法 改革”也应 该导入 PMQIR和 G...

05

通过导入 PMQIR使 “无用功” 一目了然

第五章 组织的12个问题以及利 用OODA...

OODA循环能够 让拥有以下问

题的组织转 变...

组织存在的问 题全都可以通 过OODA循环 解...

结语 利用OODA循环转变为“持 续思考型...

谢谢观看

03

让组织崩溃 的CIA间谍 手册

04

实践OODA 循环与VSA 的“自主思 考型组...

06

让员工自己 利用“行动 方针”和 KPI设定 目...

05

通过设定目 标和共享 VSA来实现 “放权”

能够切实取得成果的 “1对1会议”

与“能力和技术”相 比更重视对“梦想愿

景”...

彻底实现公平人事考 核的“圆桌考核”

将OODA循环与PDCA 循环并用就是“如...

为什么都说“日本的 企业没有战略”?

“精益创业”与“设 计思考”都源自 OODA...

第二章 通过共享“世界观 (VSA)”使组...

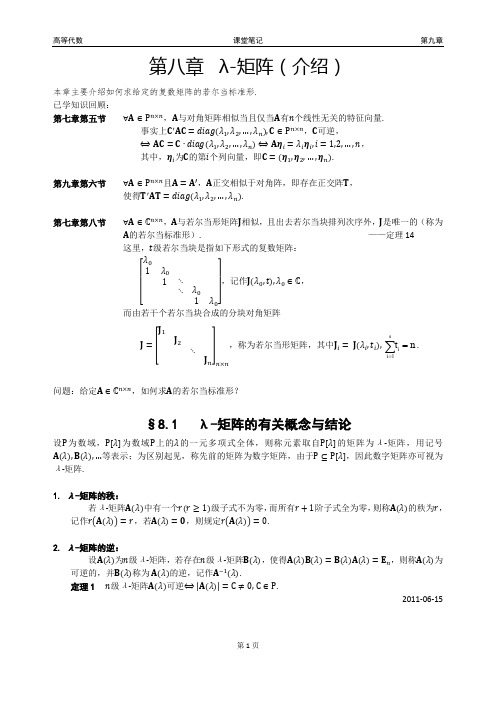

高等代数.第八章.λ-矩阵(介绍).课堂笔记

课堂笔记

第九章

第八章 λ-矩阵(介绍)

本章主要介绍如何求给定的复数矩阵的若尔当标准形. 已学知识回顾: 第七章第五节 ∀������ ∈ P ������×������ ,������与对角矩阵相似当且仅当������有������个线性无关的特征向量. 事实上������ ′ ������������ = ������������������������(������1 , ������2 , … , ������������ ), ������ ∈ P ������×������ ,������可逆, ⟺ ������������ = ������ ∙ ������������������������(������1 , ������2 , … , ������������ ) ⟺ ������������������ = ������������ ������������ , ������ = 1,2, … , ������, 其中,������������ 为������的第������ 个列向量,即������ = (������1, ������2 , … , ������������ ). 第九章第六节 ∀������ ∈ P ������×������ 且������ = ������′,������正交相似于对角阵,即存在正交阵������, 使得������ ′ ������������ = ������������������������(������1 , ������2 , … , ������������ ). ∀������ ∈ ℂ������×������ ,������与若尔当形矩阵������相似,且出去若尔当块排列次序外,������是唯一的(称为 ������的若尔当标准形). ——定理 14 这里,������级若尔当块是指如下形式的复数矩阵: ������0 1 ������0 ,记作������(������0 , ������), ������0 ∈ ℂ, 1 ⋱ ⋱ ������0 [ 1 ������0 ] 而由若干个若尔当块合成的分块对角矩阵 ������1 ������ = [ ������2 ,称为若尔当形矩阵,其中������������ = ������(������������ , ������������ ),

格式塔咨询与治疗技术第三版笔记

格式塔咨询与治疗技术第三版笔记下载提示:该文档是本店铺精心编制而成的,希望大家下载后,能够帮助大家解决实际问题。

文档下载后可定制修改,请根据实际需要进行调整和使用,谢谢!本店铺为大家提供各种类型的实用资料,如教育随笔、日记赏析、句子摘抄、古诗大全、经典美文、话题作文、工作总结、词语解析、文案摘录、其他资料等等,想了解不同资料格式和写法,敬请关注!Download tips: This document is carefully compiled by this editor. I hope that after you download it, it can help you solve practical problems. The document can be customized and modified after downloading, please adjust and use it according to actual needs, thank you! In addition, this shop provides you with various types of practical materials, such as educational essays, diary appreciation, sentence excerpts, ancient poems, classic articles, topic composition, work summary, word parsing, copy excerpts, other materials and so on, want to know different data formats and writing methods, please pay attention!格式塔咨询与治疗技术第三版笔记第一章:引言在《格式塔咨询与治疗技术第三版笔记》的第一章中,我们将介绍格式塔治疗的基本概念和历史背景。

HLSL学习笔记(一):基础

HLSL学习笔记(一):基础前言五一在家无事,于是学习了一下HLSL,基于XAN4.0的。

学习完了也就总结一下,纯粹是新手学习的经验之谈,纰漏之处还望见谅,不喜勿喷。

HLSL是一种使用GPU渲染出图像的技术,不仅可以改变最终呈现的颜色,还可以物体的大小、胖瘦和位置等。

例如物体的碎裂效果就可以使用HLSL来渲染得到。

数据类型数据类型有值类型、向量、矩阵、采样器、和结构体。

1.值类型bool 布尔变量half 16为整形int 32位整形float 单精度浮点数double 双精度浮点数声明方式:float f;赋值方式:f = 1;2.向量声明方式:float4 f;赋值方式:f = {1,2,3,4};取值方式:float3 ff = f.rgb;说明:向可以通过xyzw或者rgba访问向量中的指定字段,x或者r就是代表0号字段。

不仅可以单独操作一个字段,还可以对多个字段同时操作,例如3*f.xyz,就是将f中的xyz都乘以个3。

3.矩阵声明方式:float2x4 f; 先行后列。

赋值方式:f = {1,1,2,2,3,3,4,4};取值方式:float ff = f[0][0];说明:如果要对矩阵做乘法运算,请使用mul函数,另外,mul(ff,f)与mul(f,ff)的结果是不一样的。

4.采样器声明方式:texture Texture; //纹理变量sampler TextureSampler = sampler_state //纹理采样器{Texture = <Texture>; //纹理采样器使用的纹理对象MinFilter = Linear; //缩小图形使用线性滤波MagFilter = Linear; //放大图形使用线性滤波MipFilter = Linear; //Mipmap使用线性滤波AddressU = Wrap; //U方向上的纹理寻址模式采用Wrap方式AddressV = Wrap; //V方向上的纹理寻址模式采用Wrap方式};赋值方式:在C#中对Texture赋值,effect.Parameters["Texture"].SetValue(Game.Content.Load<Texture2D>("*"));取值方式:tex2D(TextureSampler, TEXCOORD0);说明:MinFilter、MagFilter、MipFilter、AddressU、AddressV是可选项,如果不写将会使用默认值,也就是上面赋予的值。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

HLDA学习笔记题目:The Nested Chinese Restaurant Process and Bayesian Nonparametric Inference of Topic HierarchiesDavid M.BLEI 这个LDA领域的大牛,对LDA有诸多变形,这一片是将随机过程(stochastic process)用于无参贝叶斯推断上,构造主题层次树。

2012.9.17刚刚开始学习,掌握了大概内容。

文中采用的方法:在贝叶斯无参推断(BNP)中,先验和后验分布不再受限于参数的分布,而是一般的随机过程。

贝叶斯推断过程也不再受限于优先维空间,可以扩展到一般的无限维空间。

构造主题层次结构树(以JACM1987-2004年间536个摘要——abstract为例)图中可以看到第一层是5个大的计算机的方向,每个方向中列出了前5个主题词,然后每个主题又有若干子主题。

该方法能够发现不同领域中基于唯一的输入数据中的有用的主题层次。

通过为文档定义概率模型,不需要定义主题的层次,而是定义统计过程。

文章的结构:首先回顾随机过程和贝叶斯无参统计的必要背景;第3部分:nested Chinese restaurant procee;第4部分:在层次主题模型中使用的拓扑;第5部分:近似后验推断算法;第6部分:样本和经验评估;第7部分:相关工作和讨论。

第2部分:Aldous 1985(Chinese restaurant process),Antoniak 1974(Dirichlet processmixture).这部分有一系列的公式,暂时没有看懂,先跳过。

第3部分:The Nested Chinese Restaurant Process (nCRP)nCRP过程和相关的分布被广泛地使用在Bayesian nonparametric statistics 中,因为,它使得被假设从位置类数量中获取统计模型成为可能。

nCRP的过程大致如下:假设在一个城市中有无限多个餐馆,每个餐馆中有无限多张table。

一个餐馆被定义为树的root,它的无限多张table上都有一张card,上面写着其它餐馆的名字。

在其它餐馆的每张table上也都有一张card,涉及到其它餐馆的名字,这个结构重复无限多次。

每个餐馆确切地被提交一次;这样这个城市中的餐馆被组织成一个具有无限分支、无限深度的树。

注意每个餐馆在树中与一层相关联。

树根的餐馆在第1层,根餐馆的table的card上涉及到的餐馆在第2层,如此下去。

如下图。

这张图中涉及到3层,每个box表示一个餐馆,有无限多table。

如图第1层有5张桌子,每张桌子引用下一层的唯一的table。

在这种结构中,5个游客沿着4条唯一的路径visit餐馆。

在hLDA模型中,每个餐馆具有topic分布Beta.每个文档被假设假设沿着一个随机选择的路径,从topic分布中选择它的word。

一个游客到这个城市度假,第一天晚上,他进入根上的中观餐馆并且选择了一张table,采用CRP分布选择table。

第二天晚上,他去第一天晚上的餐馆table 上标识得餐馆,这样一直重复下去。

M个游客餐馆这个城市后,路径的集合就描述了无限树的随机子树;子树中一个分支因子,在所有节点上有至多为M。

(图中每个Beta表示1个餐馆,根上表示1个餐馆(有1,2,3,4,5游客来),这个餐馆的table指向了3个餐馆,1,2游客去了第二层最左边的餐馆,3,5游客去了第二层中间的餐馆,4游客去了第二层最右边的餐馆)有许多方法在树上设置先验分布,我们的特殊选择是基于几个考虑。

首要的是,一个先验分布与似然结合以产生后验分布。

4.Hierarchical Latent Dirichlet AllocationnCRP提供了在树拓扑上定义先验的方法,不受分支因子(数目)或深度的限制。

我们采用这种分布作为概率topic模型的一个组成部分。

topic模型的目标是识别Document中word的子集。

早期的topic建模起源于潜在语义分析,随后的工作将topic看做word上的概率分布,使用基于似然的方法从词库中估计这些分布。

在LDA中概率topic模型被作为全Bayesian对待。

像LDA这样的topic模型,将topics对待为“flat”概率集合,在一个topic 和另外topics之间没有直接的联系。

这些模型可以从词库中发现topics,不能说明topic之间抽象的层次或者各种主题之间的联系。

我们提出的这个模型,建立在nCRP上,敌营了hierarchical topic model。

这个模型将topics安排在tree中,具有一般性的主题应该出现在接近于root的位置,更具体的topics应该在叶子附近。

定义这样的模型,我们使用概率推断同时识别topics和他们之间的关系。

我们的方法定义层次topic model,基于识别由nCRP差生的带有路径的文档。

将ncRP增加到两个方式去获取文档的产生模式,首先对树中的每个节点,赋予一个主题(也就是word上的概率分布);第二,给定一个路径选择,使用GEM分布定义沿着这个路径的topic的概率分布。

给定一个draw,从GEM分布,document被产生,通过重复地选择topic,根据draw定义的概率,然后从它选定的topic中选择word。

一般过程:这里,无限树由nCRP定义,并且设置Cd表示第d个customer通过的路径(例如document)。

在hierarchical LDA(hLDA)中词库中的documents是假设从上面的过程中产生的。

这里Z~Discrete(theta)分布,表示Z=i具有概率thetaI集合的离散分布.找到摘要(abstraction)的topic主题曾是是不同于层次聚类的。

层次聚类是从下到上将每个节点看成叶子,结合产生根节点。

内部节点反映的是下层节点的概括。

而此方法:内部节点不是他们孩子节点的概括,而是反映了一种“共享”,第1张图中,一个节点的高概率词与其下层节点高概率词是不同的。

很重要的一点事,我们的方法是无监督学习方法,在我们已经定义的概率成分是潜在变量。

也就是我们不需要假设topics是预先定义,也不需要建设document 的嵌套分区或者主题在预定义的哪一层上。

我们从Baysian计算中推断实体,计算所有的潜在变量。

注意,即使这个方法很灵活,模型仍然做了关于tree的假设。

tree的大小、形状和特征将由设置的hyerparameters集合来反映。

影响最大的hyperparameter 是Dirichlet参数——主题yita和stick-breaking(分块,)参数,用作topic比例{m,pi}。

yita控制topics的稀疏性;{m,pi}控制文档中多少个词可能来自于各种摘要的主题。

小的yita将导致在小的words集合上产生topic,topics就多。

如果设m大,例如m=0.5那么将可能从每个document中分配更多的words在抽象的更高层次上。

设pi是大的,例如pi=100,意味着word分布将不可能脱离这样的设置。

最后,我们注意到,hLDA是展示nCRP的最简单的模型,在更复杂的模型中,可以看率变体hLDA,每个文档展示多条树上的路径。

这可以使用两层分布对word 产生建模:首先选择树的路径,然后为word选择词。

最近对topic模型的扩展也可以考虑使用灵活的topic层次。

在dynamic topic model中,文档time stamped和隐藏的主题随时间变化等。

我们提出了另外的方法在text分析中使用层次概念。

首先,我们学习topics 层次而不是术语层次,这里topics是术语的分布,描述了数据中word发生的有意义的模式。

此外,当关注text时,topics是简化的word产生的分布,不依赖于词的类型等其他信息,例如词库或语法。

最后,我们的方法可以适应将来的数据。

在我们的无参集合中,必须找到给定documents集合的层次、路径分配和words层次分布对象的后验分布。

更进一步,我们需要能够使用计算机的有限资源去做,hLDA不能再闭集上获得,需要估计。

5.Probabilistic Inference使用Markov chain Monte Carlo(MCMC)算法估计hLDA的后验概率。

在本文中采用了Gibbs采样,使用collapsed Gibbs Simpling[Liu 1994]。

在hLDA中,我们采样每个document的路径Cd和每个词对主题的层次分布,在路径Zd,n上。

我们边缘化(marginalize out)参数BetaI和每个document的topc比例Thetad。

对于单个文档的Markov chain的演示如下:这是"A new approach to the maximum-flow problem"文章的摘要,摘要中的每个词都被Wd,n都被在路径上分配一个层次Zd,n,0表示最高层,2表示最底层。

Gibbs采样迭代取得文档中所有word的Cd和Zd,n。

随后又一系列的参数推断,还没有完全看懂。

6.Examples和Empirical Results一般来讲,我们不能期望总是获得正确的tree。

这要依赖于数据集的大小,topics是多么的一致。

在那些一词多以或者topics之间比较相似的数据集中tree 是不容易被识别的。

hLDA与LDA的比较:首先在LDA中topic的数目是固定的参数,模式选择过程需要选择topics的数目。

在层次Dirichlet process中可以解决这个问题。

第二,给定topics集合,LDA没有在词库中document使用的topics加以约束;而在hLDA中,document只能访问在树中存在于单一路径上的topics。

这样来讲LDA比hLDA更灵活。

所以,可以扩展hLDA,先用LDA找到topics,然后再用hLDA建立topics的层次。

进一步的工作,找到结合LDA和hLDA模型特征的合理的模型,可以考虑一个类hLDA层次模型,允许每个document沿着tree展开多条路径。

这样的方法将更适用于full-text文章,而不是abstract。