Faster-RCNN

图像识别技术的对比:YOLO和Faster R-CNN

图像识别技术的对比:YOLO和Faster R-CNN 近年来,图像识别技术受到越来越广泛的关注和应用,其中的YOLO和Faster R-CNN是两种常用的目标检测算法。

本文将从算法原理、检测速度、精确度等方面对这两种算法进行对比。

一、算法原理YOLO(You Only Look Once)算法是一种基于卷积神经网络的实时目标检测算法。

它将图像分成若干个网格,每个网格预测一个边界框和类别。

YOLO通过一个卷积神经网络将整张图片映射到一个特征向量,然后采用3x3卷积层和全连接层将特征向量转化为边界框和置信度,最后对所有的边界框进行非极大值抑制,输出检测结果。

Faster R-CNN算法则是一种两阶段的目标检测算法。

它首先使用一个卷积神经网络提取出特征图,然后使用一个RPN(RegionProposal Network)网络预测可能存在目标的候选框,并对这些候选框进行回归。

接着对候选框与特征图进行ROI(Region of Interest)池化操作,得到固定大小的特征向量,最后通过全连接层进行分类和回归。

两种算法的原理不同,YOLO采用单阶段的检测模式,Faster R-CNN则是双阶段的检测模式。

这也决定了它们各自的优缺点。

二、检测速度考虑到实时性的要求,YOLO算法在检测速度上具有优势。

在相同的硬件设备上,YOLO的检测速度可以达到每秒45帧,而Faster R-CNN只能达到每秒5帧左右,即使在改进后优化模型,速度也难以大幅提升。

原因在于,Faster R-CNN算法需要先生成候选框,再对候选框进行分类和回归,而YOLO直接预测目标的类别和边界框,无需生成候选框,大大节省时间。

三、精确度在精度方面,Faster R-CNN更优秀。

虽然YOLO算法能够实现实时检测,但它对于小目标和密集目标的检测效果较差。

相比之下,Faster R-CNN算法采用了RPN网络,可以生成大量候选框,增加了目标的搜索空间,可以更好地适应各种目标尺度,因而在精度上表现更好。

Faster RCNN的交通场景下行人检测方法

Faster RCNN的交通场景下行人检测方法Faster RCNN是一种流行的目标检测算法,它在目标检测领域取得了很大的成功。

在交通场景下,行人检测是一项非常重要的任务,它可以帮助交通管理部门监测人员流动情况、改善交通安全等方面都具有重要的意义。

本文将从交通场景下的行人检测需求出发,介绍Faster RCNN在此场景下的应用方法。

一、交通场景下的行人检测需求在交通场景下,行人检测是非常重要的,它具有以下几个方面的重要意义:1. 交通安全:行人在交通场景中往往容易受到车辆的威胁,行人检测可以帮助交通管理部门对行人的行为和分布进行监测,从而及时发现危险情况并应对。

2. 交通流量管理:交通流量管理部门需要掌握道路上行人的流动情况,以便做出合理的交通管理决策。

3. 前沿科技应用:在智慧城市建设、自动驾驶等领域,行人检测技术也是非常重要的。

Faster RCNN是一种端到端的目标检测方法,它由两个网络构成:一个用于提取特征的卷积神经网络(CNN),和一个用于目标检测的区域提议网络(RPN)。

Faster RCNN能够实现端到端的目标检测,在准确性和速度上取得了很大的突破,因此在交通场景下的行人检测中具有很大的潜力。

1. 数据准备:首先需要收集交通场景下的行人图片数据,并标记出行人的位置信息。

2. 模型训练:利用已标记的数据,对Faster RCNN模型进行训练,通过大量数据的学习,模型可以逐步提高准确率和鲁棒性。

3. 模型调优:在交通场景下,由于行人可能会出现在各种复杂的环境中,因此需要针对具体场景对模型进行调优,以提高检测效果。

4. 模型应用:经过训练和调优后的Faster RCNN模型可以应用于实际的交通场景中,对行人进行准确的检测和定位。

1. 准确性高:Faster RCNN基于深度学习,在大量数据的学习下,能够实现较高的准确性。

2. 适应性强:Faster RCNN能够适应各种复杂的交通场景,对光照、天气等因素具有一定的鲁棒性。

基于深度学习的Faster R-CNN小目标检测方法

基于深度学习的Faster R-CNN小目标检测方法基于深度学习的Faster R-CNN小目标检测方法随着计算机视觉技术的快速发展,目标检测一直是一个备受关注的课题。

在传统的目标检测方法中,由于小目标的特点与挑战,检测精度常常不高。

然而,随着深度学习的兴起,基于卷积神经网络的目标检测方法在解决小目标检测问题上取得了较好的效果。

本文将介绍一种基于深度学习的Faster R-CNN小目标检测方法。

Faster R-CNN(Region Convolutional Neural Network)是目标检测领域中一种非常重要的算法。

它的核心思想是将目标检测任务分解为两个子任务,即生成候选框和分类定位。

生成候选框的算法又称为区域提议(Region Proposal)算法,在Faster R-CNN中,作者采用了一种名为RPN(Region Proposal Network)的网络结构来实现。

RPN主要通过滑动窗口的方式,以一定的步长在输入特征图上生成多个不同尺寸的候选框,并对每个候选框进行是否包含目标的二分类预测和候选框的精确位置回归。

与传统的区域提议方法相比,RPN在召回率和速度上都取得了较好的平衡。

在生成候选框的基础上,Faster R-CNN还需要对每个候选框进行分类和位置回归。

为了解决小目标检测的问题,Faster R-CNN引入了RoI(Region of Interest)Pooling层。

RoI Pooling层的作用是将不同尺寸的候选框转化为固定尺寸的特征图,以便输入到后续的全连接层进行分类和位置回归。

通过RoI Pooling层,Faster R-CNN可以对不同尺寸的目标进行统一处理,提高了小目标检测的精度。

为了进一步提高小目标检测的性能,Faster R-CNN还采用了多尺度融合(Multi-Scale Fusion)的策略。

传统的目标检测方法通常只关注单一尺度的特征图,而小目标的尺寸普遍较小,因此很容易被忽略。

目标检测参考文献

目标检测是计算机视觉领域中的一个重要任务,旨在识别和定位图像中的目标物体。

近年来,随着深度学习方法的发展,目标检测取得了显著的进展。

以下是一些经典的目标检测参考文献及其相关内容。

1.R-CNN: Rich feature hierarchies for accurate object detection 这是目标检测中的经典方法之一,引入了区域提议网络(Region Proposal Network)的概念,通过生成候选目标区域来提高检测的效果。

该方法通过使用卷积神经网络提取图像特征,并使用支持向量机对提取的特征进行分类和定位。

2.Faster R-CNN: Towards real-time object detection with regionproposal networks Faster R-CNN是R-CNN的改进版本,引入了一种称为Region Proposal Network(RPN)的网络模块,用于生成候选目标区域。

相比于R-CNN,Faster R-CNN在保持准确性的同时大幅提升了检测速度。

3.You Only Look Once: Unified, Real-Time Object Detection YOLO是一种实时目标检测方法,通过将目标检测问题转化为回归问题,并在单个神经网络中同时进行目标分类和定位,实现了快速准确的物体检测。

该方法在速度上具有显著优势,但在检测小物体和密集目标方面仍有改进空间。

4.Single Shot MultiBox Detector SSD是另一种实时目标检测方法,采用了特征金字塔网络(Feature Pyramid Network)和多尺度预测的策略,能够在不同尺度下同时检测目标。

SSD在准确性和速度方面取得了良好的平衡,成为目标检测领域的重要方法之一。

5.Mask R-CNN Mask R-CNN是在Faster R-CNN的基础上进行改进的方法,不仅可以检测和定位目标,还可以生成目标的语义分割掩码。

令我“细思极恐”的Faster-R-CNN

令我“细思极恐”的Faster-R-CNN作者简介CW,⼴东深圳⼈,毕业于中⼭⼤学(SYSU)数据科学与计算机学院,毕业后就业于腾讯计算机系统有限公司技术⼯程与事业群(TEG)从事Devops⼯作,期间在AI LAB实习过,实操过道路交通元素与医疗病例图像分割、视频实时⼈脸检测与表情识别、OCR等项⽬。

⽬前也有在⼀些⾃媒体平台上参与外包项⽬的研发⼯作,项⽬专注于CV领域(传统图像处理与深度学习⽅向均有)。

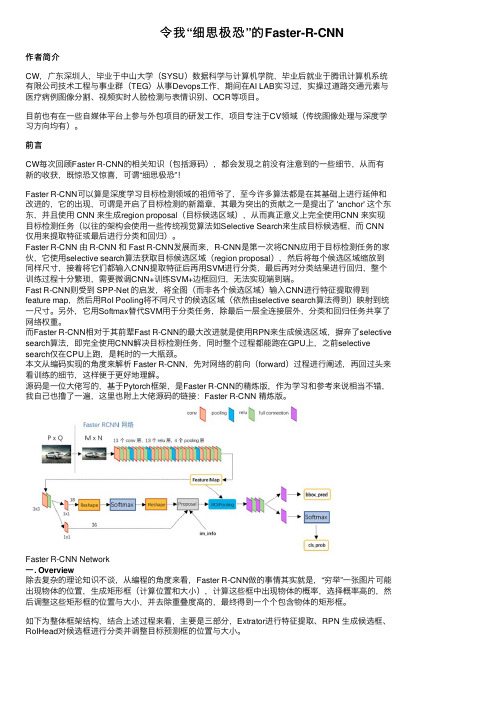

前⾔CW每次回顾Faster R-CNN的相关知识(包括源码),都会发现之前没有注意到的⼀些细节,从⽽有新的收获,既惊恐⼜惊喜,可谓“细思极恐”!Faster R-CNN可以算是深度学习⽬标检测领域的祖师爷了,⾄今许多算法都是在其基础上进⾏延伸和改进的,它的出现,可谓是开启了⽬标检测的新篇章,其最为突出的贡献之⼀是提出了 'anchor' 这个东东,并且使⽤ CNN 来⽣成region proposal(⽬标候选区域),从⽽真正意义上完全使⽤CNN 来实现⽬标检测任务(以往的架构会使⽤⼀些传统视觉算法如Selective Search来⽣成⽬标候选框,⽽ CNN 仅⽤来提取特征或最后进⾏分类和回归)。

Faster R-CNN 由 R-CNN 和 Fast R-CNN发展⽽来,R-CNN是第⼀次将CNN应⽤于⽬标检测任务的家伙,它使⽤selective search算法获取⽬标候选区域(region proposal),然后将每个候选区域缩放到同样尺⼨,接着将它们都输⼊CNN提取特征后再⽤SVM进⾏分类,最后再对分类结果进⾏回归,整个训练过程⼗分繁琐,需要微调CNN+训练SVM+边框回归,⽆法实现端到端。

Fast R-CNN则受到 SPP-Net 的启发,将全图(⽽⾮各个候选区域)输⼊CNN进⾏特征提取得到feature map,然后⽤RoI Pooling将不同尺⼨的候选区域(依然由selective search算法得到)映射到统⼀尺⼨。

二阶段目标检测算法

二阶段目标检测算法一、区域提取阶段:区域提取阶段的主要功能是对输入图像进行初步处理,提取出可能含有目标的区域。

这个阶段的主要任务是减少计算量,降低后续处理的复杂度。

常用的区域提取算法有以下几种:1. Selective Search:Selective Search是一种基于图像分割的区域提取算法。

它将图像分割成多个不同的区域,并根据这些区域的相似性进行合并,从而得到候选区域。

Selective Search具有较好的召回率和准确率,适用于检测尺度变化较大的目标。

2. Edge Boxes:Edge Boxes是一种基于边缘信息的区域提取算法。

它使用了候选区域的边缘响应作为指标,从而提取出可能的目标区域。

Edge Boxes算法的特点是简单高效,适用于处理大规模的图像数据。

3. Region Proposal Network (RPN):RPN是一种通过深度学习网络自动学习生成候选区域的方法。

它将图像输入到一个神经网络中,通过网络的输出得到候选区域。

RPN算法的优点是能够自动学习提取特征,并具有较好的准确率和召回率。

二、目标分类与定位阶段:目标分类与定位阶段主要是对提取出的候选区域进行进一步的处理和分类,确定每个区域是否含有目标,并对目标进行定位。

常用的目标分类与定位算法有以下几种:1.卷积神经网络(CNN):CNN是一种用于图像分类和定位的深度学习算法。

它通过多层卷积和池化操作,从输入图像中提取特征,并通过全连接层进行目标分类和定位。

CNN算法的优点是能够自动学习提取特征,并具有较好的准确率。

2. Faster R-CNN:Faster R-CNN是一种基于深度学习的目标检测算法。

它使用RPN网络生成候选区域,并利用ROI Pooling和全连接层进行目标分类和定位。

Faster R-CNN算法具有较快的处理速度和较好的准确率,是目标检测领域的主流算法之一3. Mask R-CNN:Mask R-CNN是一种在Faster R-CNN的基础上进一步发展的算法。

基于多尺度的Faster R-CNN算法的PCB板缺陷识别

基于多尺度的Faster R-CNN算法的PCB板缺陷识别基于多尺度的Faster R-CNN算法的PCB板缺陷识别随着电子工业的快速发展,印制电路板(PrintedCircuit Board,PCB)在各个领域中广泛应用。

然而,由于PCB制造过程中的不可避免的缺陷,如焊接不良、线路断裂等,这些缺陷可能导致电路板的性能和可靠性下降。

因此,对于PCB板缺陷的快速识别和检测显得尤为重要。

传统的PCB板缺陷识别方法通常采用基于规则或特征提取的方式,需要人工设定一些规则或特征来判定缺陷。

然而,由于PCB板上的缺陷形状和大小各不相同,并且存在一定的复杂性,这些传统方法往往难以准确地检测和识别缺陷。

近年来,深度学习技术的发展使得使用卷积神经网络(Convolutional Neural Network,CNN)进行缺陷识别成为可能。

Faster R-CNN是一种基于深度学习的目标检测算法,具有高效、准确、可扩展等优点,并且可以通过多尺度的方式识别不同大小的缺陷。

针对PCB板缺陷识别问题,本文提出了一种基于多尺度的Faster R-CNN算法。

该算法首先对PCB板进行预处理,包括灰度化、二值化、边缘检测等操作,以便更好地提取缺陷的特征。

然后,利用CNN网络对图像进行特征提取,获取图像的高层抽象表达。

接下来,利用Faster R-CNN算法进行目标检测,对图像中的缺陷进行定位和分类。

为了适应不同大小的缺陷,我们提出了一种多尺度的策略,通过设置不同的感受野和卷积核大小来适应不同尺寸的缺陷。

实验结果表明,我们的算法在PCB板缺陷识别方面取得了良好的效果。

与传统的基于规则或特征提取的方法相比,该算法具有更高的准确性和鲁棒性。

同时,多尺度的策略使得算法对于不同大小的缺陷具有较好的识别能力。

总之,本文提出的基于多尺度的Faster R-CNN算法能够有效地识别PCB板上的缺陷。

这种算法不仅具有较高的准确性和鲁棒性,而且能够适应不同大小的缺陷,具有较好的可扩展性。

详细解读Faster RCNN

bounding box regression原理

如图所示绿色框为飞机的Ground Truth(GT),红色为提取的foreground anchors,那么即便红色 的框被分类器识别为飞机,但是由于红色的框定位不准,这张图相当于没有正确的检测出飞机。所 以我们希望采用一种方法对红色的框进行微调,使得foreground anchors和GT更加接近。

进Proposal Layer forward(caffe layer的前传函数)按照以下顺序依次处理: 1、生成anchors,利用[dx(A),dy(A),dw(A),dh(A)]对所有的anchors做bbox regression 回归(这里的anchors生成和训练时完全一致) 2、按照输入的foreground softmax scores由大到小排序anchors,提取前pre_nms_topN(e.g. 6000)个anchors,即提取修正位置后的foreground anchors。 3、利用im_info将fg anchors从MxN尺度映射回PxQ原图,判断fg anchors是否大范围超过边界, 剔除严重超出边界fg anchors。 4、进行nms(nonmaximum suppression,非极大值抑制) 5、再次按照nms后的foreground softmax scores由大到小排序fg anchors,提取 post_nms_topN(e.g. 300)结果作为proposal输出。

RoI Pooling layer forward过程:在之前有明确提到:proposal=[x1, y1, x2, y2]是对应MxN尺度 的,所以首先使用spatial_scale参数将其映射回(M/16)x(N/16)大小的feature maps尺度;之后将 每个proposal水平和竖直都分为7份,对每一份都进行max pooling处理。这样处理后,即使大小不 同的proposal,输出结果都是7x7大小,实现了fixed-length output(固定长度输出)。

图像识别技术的对比:YOLO和Faster R-CNN

图像识别技术的对比:YOLO和Faster R-CNN 图像识别技术是计算机视觉领域的一个重要研究方向,它的发展对于智能自动驾驶、安防监控、商品识别等多个领域具有重要意义。

在图像识别技术中,YOLO和Faster R-CNN是两种常用的目标检测算法,它们在精度、速度、复杂度等方面有着不同的特点。

本文将对这两种算法进行比较分析,从理论基础、算法原理、应用场景等多个角度详细探讨它们的优缺点和适用范围。

一、理论基础YOLO(You Only Look Once)是由Joseph Redmon等人在2016年提出的一种实时目标检测算法。

YOLO算法将目标检测问题视作一个回归问题,通过将图像划分为网格,每个网格负责检测图像中的目标,并预测目标的边界框和类别信息。

由于YOLO算法采用单个神经网络进行端到端的训练和预测,因此能够在保持较高精度的同时达到较快的检测速度。

YOLO算法在物体检测领域取得了较为显著的成果,被广泛应用于自动驾驶、人脸检测、安防监控等领域。

相比之下,Faster R-CNN是由Shaoqing Ren等人于2015年提出的一种目标检测算法。

Faster R-CNN算法主要由两部分组成:Region Proposal Network(RPN)和Fast R-CNN。

RPN负责生成候选区域,而Fast R-CNN则负责对候选区域进行分类和回归。

Faster R-CNN算法之所以称之为“更快”的R-CNN,是因为它采用共享卷积特征提取,使得在目标检测任务中能够达到较快的检测速度。

Faster R-CNN算法在准确度上具有一定的优势,特别是在小目标检测和复杂场景中表现更为突出。

二、算法原理YOLO算法的核心思想是将对象检测问题转化为回归问题,通过生成候选框并进行类别判别来完成对象检测任务。

在具体实现中,YOLO 算法将输入图像划分为S X S个网格,每个网格负责检测图像中的目标,同时预测目标的边界框和类别信息。

aFaster_RCNN:一种基于平扫CT的多疾病阶段胰腺病灶检测模型

胰腺癌(PC )是恶性程度最高的肿瘤之一,预后差,全球死亡率高达94.00%[1],中国高达97.64%[2],美国为84.41%[3],且发病率和死亡率都仍呈逐年上升趋势。

手术是PC 患者可能治愈和长期生存的唯一有效方法,尽可能早的诊断可以使患者得到及时的手术治疗,从而改善预后,降低死亡率,提高生存期[4,5]。

然而,当癌症尚处于局部状态时,PC 患者通常会因缺乏症状表现或症状模糊而被忽略,发现时通常已是中晚期[6],从而错过最佳治疗时间。

因此,在目前还没有有效的PC 早期检测技术和早期诊断方法的情况下,开发一项基于医学检查(比如医学影像)的早期检测技术是实现PC 早期诊断的关键。

医学影像已成疾病检查、诊断和治疗不可或缺的常规检查和辅助手段;而且临床对医学人工智能(AI )的需求也在蓬勃发展[7-12]。

PC 相关的AI 方法研究虽然仍处Advanced Faster RCNN:a non-contrast CT-based algorithm for detecting pancreatic lesions in multiple disease stagesLIANG Lidu 1,ZHANG Haojie 2,LU Qian 3,ZHOU Chenjie 2,LI Shulong 11School of Biomedical Engineering,Guangdong Provincial Key Laboratory of Medical Image Processing,Southern Medical University,Guangzhou 510515,China;2General Surgery Center,Second Department of Hepatobiliary Surgery,Guangdong Provincial Research Center for Artificial Organ and Tissue Engineering,Zhujiang Hospital,Southern Medical University,Guangzhou 510280,China;3Department of Ultrasound,Yancheng Third People's Hospital,Yancheng 224008,China摘要:目的研究基于平扫CT 的胰腺病灶检测算法,实现低成本和精准的胰腺病灶自动检测。

FasterRCNN理解(精简版总结)

FasterRCNN理解(精简版总结)Faster R-CNN(Faster Region-based Convolutional Neural Networks)是一种用于目标检测的深度学习模型,它能够准确、快速地检测图像中的物体并对其进行分类。

本文将对Faster R-CNN进行精简版总结。

目标分类与边界框回归:在生成的候选区域之后,每个候选区域都需要进行分类和位置回归。

为了解决这个问题,Faster R-CNN引入了一个用于分类和位置回归的全连接层网络,在区域特征图上进行目标分类和边界框回归操作。

此外,从RPN得到的候选区域与这个全连接层网络之间共享卷积特征,以减少计算量。

具体来说,Faster R-CNN采用了RoI (Region of Interest)池化层来从特征图上提取固定大小的特征向量,然后输入到全连接层网络进行分类和回归。

Faster R-CNN的训练过程包括两个阶段:预训练阶段和微调阶段。

在预训练阶段,使用一个大规模数据集(如ImageNet)对整个网络进行训练,以提取通用特征。

在微调阶段,使用目标检测数据集对RPN和全连接层网络进行微调。

为了加快训练速度,Faster R-CNN采用了两阶段的训练策略,即首先训练RPN网络,然后使用RPN生成的候选区域进行目标分类和边界框回归的训练。

Faster R-CNN的优势在于其准确性和速度。

相比于传统的目标检测方法,Faster R-CNN在准确率上有显著的提升,并且其检测速度更快。

这是因为RPN网络可以一次性生成大量候选区域,在这些候选区域上进行分类和回归操作,从而减少了计算量。

总而言之,Faster R-CNN是一种用于目标检测的深度学习模型,通过引入Region Proposal Network生成候选区域,并使用全连接层网络进行目标分类和边界框回归。

它在准确性和速度上都有很好的表现,成为目标检测领域的重要模型之一。

fasterrcnn损失函数

fasterrcnn损失函数Faster R-CNN是一种流行的目标检测算法,其损失函数主要由两部分组成:分类损失和回归损失。

1.分类损失:在Faster R-CNN中,分类任务的损失函数采用交叉熵损失函数。

分类损失的目标是根据物体的特征将其正确地分类为不同的类别。

具体而言,对于每个RoI(Region of Interest,感兴趣区域),将其特征向量输入全连接层进行线性变换,然后通过Softmax函数进行归一化,得到各个类别的概率分布。

分类损失函数如下所示:L_cls = - ∑ (y_i * log(p_i))2.回归损失:另一方面,Faster R-CNN中还设计了一种回归损失函数,用于根据候选框的位置信息来精确定位物体。

回归损失是通过计算预测的候选框和真实候选框之间的差异来定义的。

具体而言,对于每个候选框,首先通过回归层对其位置进行线性变换,得到预测的候选框位置。

然后,计算预测候选框与真实候选框之间的差异。

回归损失函数如下所示:L_reg = ∑ (smooth_L1(t_i - t*_i))其中,t_i表示真实候选框的位置,t*_i表示预测候选框的位置,smooth_L1表示平滑L1损失函数。

该损失函数可以使得预测候选框的位置和真实候选框的位置之间的平均绝对误差最小化。

综合以上两个损失函数,Faster R-CNN的总损失函数可以定义为:L_total = L_cls + λ * L_reg其中,L_cls代表分类损失,L_reg代表回归损失,λ是一个可调参数用于平衡两个损失的权重。

通过最小化总损失函数,可以同时优化分类和定位的性能。

需要注意的是,Faster R-CNN还引入了一个辅助损失函数用于训练候选框的生成网络(Region Proposal Network,RPN)。

RPN的损失函数与回归损失函数类似,有助于更好地生成候选框。

整体而言,Faster R-CNN的损失函数是通过多任务学习来同时优化分类、定位和候选框生成的性能。

常用目标检测算法比较

常用目标检测算法比较目标检测是计算机视觉领域中的一个重要任务,它可以在图片或视频中检测出物体的位置和类别。

目标检测算法可以分为两类:基于区域提取的方法和基于全卷积网络的方法。

下面将介绍常用的目标检测算法及其优缺点。

基于区域提取的方法1. R-CNN系列算法R-CNN是基于区域提取的方法的代表作之一,它通过候选区域提取算法得到候选区域,并使用卷积神经网络提取特征。

R-CNN的缺点是速度慢,需要逐个处理每个候选区域。

2. Fast R-CNNFast R-CNN在R-CNN的基础上做了改进,它将卷积神经网络应用于整张图片,得到一张特征图,然后对候选区域进行池化操作,得到固定大小的特征向量。

Fast R-CNN的速度比R-CNN提高了数十倍,但仍然比较慢。

3. Faster R-CNNFaster R-CNN是在Fast R-CNN的基础上引入了区域生成网络(Region Proposal Network,简称RPN),用于生成候选框。

Faster R-CNN比Fast R-CNN更快,精度也更高。

基于全卷积网络的方法1. YOLO系列算法YOLO(You Only Look Once)是一种基于全卷积网络的目标检测算法,它能够在一次前向传播中检测出图片中的所有物体,并且速度非常快。

但它的缺点是定位精度不高,对小物体的检测效果不好。

2. SSD系列算法SSD(Single Shot MultiBox Detector)也是一种基于全卷积网络的目标检测算法,它通过在网络不同层次上预测不同尺度的物体,并采用了多个不同尺度的先验框来检测不同大小的物体。

SSD比YOLO 的检测精度更高,但速度稍慢。

综上所述,目标检测算法因其不同的特点和应用场景而各有优劣,选择适合自己应用场景的算法是非常重要的。

计算机视觉领域目标检测算法性能对比分析

计算机视觉领域目标检测算法性能对比分析摘要:目标检测是计算机视觉领域中的一项重要任务,广泛应用于图像处理、视频监控、自动驾驶等领域。

随着深度学习的迅猛发展,目标检测算法在精度和速度上取得了巨大的进步。

本文将以YOLOv3、Faster R-CNN和SSD三种经典目标检测算法为例,分析它们在性能上的对比。

第一节:引言目标检测是指通过计算机视觉算法识别图像或视频中是否存在特定物体,并在图像中准确地标记出物体的位置和边界。

目标检测算法的性能直接影响计算机视觉应用的效果。

本文将对当前计算机视觉领域三种主流的目标检测算法进行全面对比分析,以探讨它们的特点和优劣之处。

第二节:YOLOv3算法YOLOv3(You Only Look Once)是一种基于深度学习的实时目标检测算法。

它的特点是通过一个单一的神经网络同时预测物体的类别和位置,速度快且精确度较高。

YOLOv3采用了Darknet-53网络作为基础网络,并引入了多尺度特征图,能够有效地检测小目标和远距目标。

第三节:Faster R-CNN算法Faster R-CNN(Region-based Convolutional Neural Networks)是一种经典目标检测算法,也是第一个将深度学习与区域提案相结合的方法。

Faster R-CNN的核心是RPN(Region Proposal Network),它通过生成候选目标框来提高目标定位的准确性。

在目标检测过程中,Faster R-CNN采用两个独立的网络进行目标分类和目标定位。

第四节:SSD算法SSD(Single Shot MultiBox Detector)是一种用于实时目标检测的算法,它不需要额外的候选框生成模块,可以直接在特征图上进行目标检测。

SSD算法通过引入多尺度特征图和多个不同尺度的卷积层,在提高检测速度的同时保持较高的检测精度。

第五节:算法性能对比在性能对比方面,我们主要从以下几个方面进行分析:1. 精确度:根据PASCAL VOC数据集的mAP(mean Average Precision)指标评测,YOLOv3和Faster R-CNN的精确度较高,SSD相对略低。

FasterRCNN详解

FasterRCNN详解摘⾃: 这篇是我看过讲faster-RCNN最清楚的,很多地⽅茅塞顿开,特转。

⼀、 faster-RCNN的背景 Faster R-CNN 发表于 NIPS 2015,其后出现了很多改进版本,后⾯会进⾏介绍. R-CNN - Rich feature hierarchies for accurate object detection and semantic segmentation 是 Faster R-CNN 的启发版本. R-CNN 是采⽤ Selective Search 算法来提取(propose)可能的 RoIs(regions of interest) 区域,然后对每个提取区域采⽤标准 CNN 进⾏分类. 出现于 2015 年早期的 Fast R-CNN 是 R-CNN 的改进,其采⽤兴趣区域池化(Region of Interest Pooling,RoI Pooling) 来共享计算量较⼤的部分,提⾼模型的效率. Faster R-CNN 随后被提出,其是第⼀个完全可微分的模型. Faster R-CNN 是 R-CNN 论⽂的第三个版本.R-CNN、Fast R-CNN 和Faster R-CNN 作者都有 Ross Girshick.⼆、faster-RCNN的⽹络结构 Faster R-CNN 的结构是复杂的,因为其有⼏个移动部件. 这⾥先对整体框架宏观介绍,然后再对每个部分的细节分析.问题描述:针对⼀张图⽚,需要获得的输出有:边界框(bounding boxes) 列表,即⼀幅图像有多少个候选框(region proposal),⽐如有2000个;每个边界框的类别标签,⽐如候选框⾥⾯是猫?狗?等等;每个边界框和类别标签的概率。

2.1 faster-RCNN的基本结构 除此之外,下⾯的⼏幅图也能够较好的描述发图尔-RCNN的⼀般结构:2.2 faster-RCNN的⼤致实现过程 整个⽹络的⼤致过程如下: (1)⾸先,输⼊图⽚表⽰为 Height × Width × Depth 的张量(多维数组)形式,经过预训练 CNN 模型的处理,得到卷积特征图(conv feature map)。

faster-rcnn原理讲解

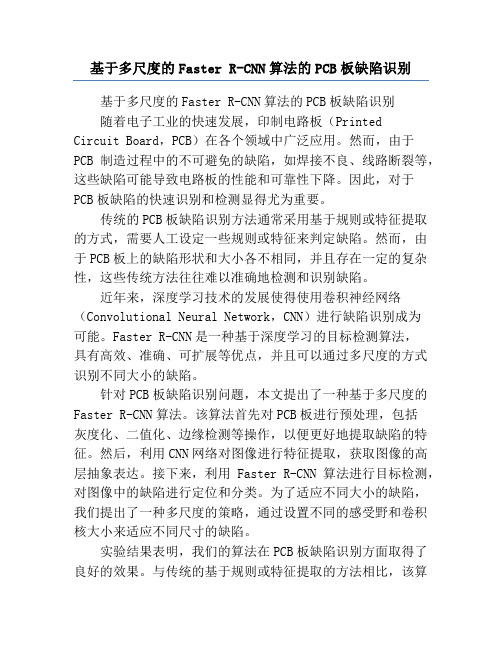

faster-rcnn原理讲解⽂章转⾃:经过R-CNN和Fast RCNN的积淀,Ross B. Girshick在2016年提出了新的Faster RCNN,在结构上,Faster RCNN已经将特征抽取(feature extraction),proposal提取,bounding box regression(rect refine),classification都整合在了⼀个⽹络中,使得综合性能有较⼤提⾼,在检测速度⽅⾯尤为明显。

图1 Faster RCNN基本结构(来⾃原论⽂)依作者看来,如图1,Faster RCNN其实可以分为4个主要内容:1. Conv layers。

作为⼀种CNN⽹络⽬标检测⽅法,Faster RCNN⾸先使⽤⼀组基础的conv+relu+pooling层提取image的feature maps。

该feature maps被共享⽤于后续RPN层和全连接层。

2. Region Proposal Networks。

RPN⽹络⽤于⽣成region proposals。

该层通过softmax判断anchors属于foreground或者background,再利⽤bounding boxregression修正anchors获得精确的proposals。

3. Roi Pooling。

该层收集输⼊的feature maps和proposals,综合这些信息后提取proposal feature maps,送⼊后续全连接层判定⽬标类别。

4. Classification。

利⽤proposal feature maps计算proposal的类别,同时再次bounding box regression获得检测框最终的精确位置。

所以本⽂以上述4个内容作为切⼊点介绍Faster R-CNN⽹络。

图2展⽰了python版本中的VGG16模型中的faster_rcnn_test.pt的⽹络结构,可以清晰的看到该⽹络对于⼀副任意⼤⼩PxQ的图像,⾸先缩放⾄固定⼤⼩MxN,然后将MxN图像送⼊⽹络;⽽Conv layers中包含了13个conv层+13个relu层+4个pooling层;RPN⽹络⾸先经过3x3卷积,再分别⽣成foreground anchors与bounding box regression偏移量,然后计算出proposals;⽽Roi Pooling层则利⽤proposals从feature maps中提取proposal feature送⼊后续全连接和softmax⽹络作classification(即分类proposal到底是什么object)。

详细解读Faster RCNN

一副MxN大小的矩阵送入Faster RCNN网络后,到RPN网络变为(M/16)x(N/16),不妨设W=M/16, H=N/16。在进入reshape与softmax之前,先做了1x1卷积,可以看到其num_output=18,也就是经 过该卷积的输出图像为WxHx18大小。这也就刚好对应了feature maps每一个点都有9个anchors,同时 每个anchors又有可能是foreground和background,所有这些信息都保存WxHx(9x2)大小的矩阵。后 面接softmax分类获得foreground anchors,也就相当于初步提取了检测目标候选区域box(一般认为 目标在foreground anchors中)。那么为何要在softmax前后都接一个reshape layer?其实只是为了便 于softmax分类,至于具体原因这就要从caffe的实现形式说起了在caffe基本数据结构blob中以如下形式 保存数据: blob=[batch_size, channel,height,width]对应至上面的保存bg/fg anchors的矩阵,其在caffe blob中的存储形式为[1, 2*9, H, W]。而在softmax分类时需要进行fg/bg二分类,所以reshape layer会 将其变为[1, 2, 9*H, W]大小,即单独“腾空”出来一个维度以便softmax分类,之后再reshape回复原状。

论文作者看来FasterRCNN可以分为4个部分

1、Conv layers。作为一种CNN网络目标检测方法,Faster RCNN首先使用一组基础的 conv+relu+pooling层提取image的feature maps。该feature maps被共享用于后续RPN层和全 连接层。 2、Region Proposal Networks。RPN网络用于生成region proposals。该层通过softmax判断 anchors属于foreground或者background,再利用bounding box regression修正anchors获得 精确的proposals。 3、Roi Pooling。该层收集输入的feature maps和proposals,综合这些信息后提取 proposal feature maps,送入后续全连接层判定目标类别。 4、Classification。利用proposal feature maps计算proposal的类别,同时再次bounding box regression获得检测框最终的精确位置。

图像识别技术的对比:YOLO和Faster R-CNN

图像识别技术的对比:YOLO和Faster R-CNN 图像识别技术是计算机视觉领域的一个重要研究方向,旨在通过算法和模型识别以及理解图像中的对象和内容。

在图像识别技术中,YOLO(You Only Look Once)和Faster R-CNN(Region-based Convolutional Neural Networks)是两种常用的目标检测算法,它们在实际应用中具有广泛的应用。

本文将对YOLO和Faster R-CNN进行对比,从算法原理、性能指标、优缺点等方面进行综合分析。

1.算法原理YOLO算法是一种基于卷积神经网络(CNN)的目标检测算法,它将目标检测任务视为一个回归问题,通过单个CNN模型直接在图像上进行检测和定位。

YOLO算法将图像划分为网格,并在每个网格单元中预测目标的类别和边界框,因此其算法速度较快。

而Faster R-CNN算法则采用两阶段检测框架,首先通过区域建议网络(RPN)生成候选区域,然后再对候选区域进行分类和定位。

Faster R-CNN算法通过引入RPN网络,使得检测精度和效率得到了显著提升。

2.性能指标在目标检测任务中,常用的性能指标包括准确率(Precision)、召回率(Recall)和平均精度(Average Precision)。

通过比较不同算法在这些指标上的表现,可以客观评估算法的性能。

研究表明,YOLO算法在检测速度上具有一定优势,但在目标定位和小目标检测上表现较弱;而Faster R-CNN算法在目标定位和小目标检测上有着较好的表现,但相对较慢。

3.算法优缺点YOLO算法的优点在于检测速度快,实时性好,在对大型目标进行检测时具有一定优势。

然而,YOLO算法在小物体检测和目标定位方面表现较差,容易出现目标漏检和定位偏差的情况。

而Faster R-CNN算法的优点在于检测精度高,可以有效识别小物体和进行精确的目标定位;但其缺点是算法速度较慢,对实时性要求较高的应用场景不太适用。

R-CNN,FastR-CNN,FasterR-CNN原理及区别

R-CNN,FastR-CNN,FasterR-CNN原理及区别RCNN1、⽣成候选区域使⽤Selective Search(选择性搜索)⽅法对⼀张图像⽣成约2000-3000个候选区域,基本思路如下:(1)使⽤⼀种过分割⼿段,将图像分割成⼩区域(2)查看现有⼩区域,合并可能性最⾼的两个区域,重复直到整张图像合并成⼀个区域位置。

优先合并以下区域:颜⾊(颜⾊直⽅图)相近的纹理(梯度直⽅图)相近的合并后总⾯积⼩的合并后,总⾯积在其BBOX中所占⽐例⼤的在合并时须保证合并操作的尺度较为均匀,避免⼀个⼤区域陆续“吃掉”其它⼩区域,保证合并后形状规则。

(3)输出所有曾经存在过的区域,即所谓候选区域2、特征提取使⽤深度⽹络提取特征之前,⾸先把候选区域归⼀化成同⼀尺⼨227×227。

使⽤CNN模型进⾏训练,例如AlexNet,⼀般会略作简化。

3、类别判断对每⼀类⽬标,使⽤⼀个线性SVM⼆类分类器进⾏判别。

输⼊为深度⽹络(如上图的AlexNet)输出的4096维特征,输出是否属于此类。

4、位置精修⽬标检测的衡量标准是重叠⾯积:许多看似准确的检测结果,往往因为候选框不够准确,重叠⾯积很⼩,故需要⼀个位置精修步骤,对于每⼀个类,训练⼀个线性回归模型去判定这个框是否框得完美。

Fast R-CNNFast R-CNN主要解决R-CNN的以下问题:1、训练、测试时速度慢R-CNN的⼀张图像内候选框之间存在⼤量重叠,提取特征操作冗余。

⽽Fast R-CNN将整张图像归⼀化后直接送⼊深度⽹络,紧接着送⼊从这幅图像上提取出的候选区域。

这些候选区域的前⼏层特征不需要再重复计算。

2、训练所需空间⼤R-CNN中独⽴的分类器和回归器需要⼤量特征作为训练样本。

Fast R-CNN把类别判断和位置精调统⼀⽤深度⽹络实现,不再需要额外存储。

下⾯进⾏详细介绍1. 在特征提取阶段,通过CNN(如AlexNet)中的conv、pooling、relu等操作都不需要固定⼤⼩尺⼨的输⼊,因此,在原始图⽚上执⾏这些操作后,输⼊图⽚尺⼨不同将会导致得到的feature map(特征图)尺⼨也不同,这样就不能直接接到⼀个全连接层进⾏分类。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

目标检测框架Faster-RCNN

框架中用到的一些技术介绍 Faster-RCNN整体框架 训练时采用的一些策略与参数设置

RCNN系列检测算法介绍

RCNN、fast-rcnn、faster-rcnn

此系列算法采用策略:

1、提取建议区域,R代表region proposal。2、利用CNN对建议区域进行

分类

提取建议区域方法的发展:

滑动窗口、select search/edge box、rpn 其它深度学习检测策略,利用CNN强大的表述能力直接对目标位置进行回归, 例如YOLO。

SPP Net

1.结合空间金字塔方法实现CNNs的多尺度 输入

一般CNNs后接full-connect layer或者classifier,它们都需要固定的输入 尺寸。因此不得不对输入数据进行crop或warp,这些预处理会造成数据 的丢失或几何学上的失真。 SPP Net 的第一个贡献是将空间金字塔的思想 加入到CNNs中,实现了数据的多尺度输入。

3、训练样本选择方法与其参数设置

训练时采用的一些策略与参数设置

3、训练样本选择方法与其参数设置

RPN中参数的设置 按照Image-centric sampling,每个batch中的图片数。ims_per_batch 1或2 每个batch中的正负样本数。 batch_size 256 每个batch中正样本占得比率。 fg_fraction 0.5

训练时采用的一些策略与参数设置

1、使用ImageNet分类模型初始化。

使模型具有一定的提取图像通用特征的能力,是目前在训练数 据较少和检测任务中的常用做法。

2、solver配置文件中的参数

初始学习率0.001,学习率衰减系数0.1,SGD方法,权重衰减 项0.0005。在RPN和Fast-RCNN中都是这样。

Multi-task loss

FR-CNN的有两个网络输出 层,将原来与网络分开的 bbox regression的操作整 合在了网络中。并设计了一 个同时优化两个输出层的 loss函数。

RoI-centric sampling与Imagecentric sampling

RoI-centric sampling:从所有图片的所有RoI中随机均匀取样, 这样每个SGD的mini-batch中包含了不同图像中的样本(SPP Net采用)。SPP Net的反向传播没有到SPP pooling之前的层, 因为反向传播需要计算每一个RoI感受野的卷基层,通常会覆盖整 幅图像,又慢又耗内存。FR-CNN想要解决这个限制。 Image-centric sampling:mini-batch采用分层采样,先对图 像采样,再对RoI采样。将采样的RoI限定在个别图像内,这样同 一图像的RoI共享计算和内存。通过这种策略,实现了端到端的反 向传播,可以fine-tuning整个网络。

RPN整体结构

RPN的网络结构类似于FR-CNN,连接与最后卷基层输出的feature map, 有一个RoI层,两个输出层,一个输出滑窗为建议区域的概率,另一个输出 bbox回归的offset。其训练方式也类似于FR-CNN。注意:RPN与FR-CNN 共用卷积层。

RPN

RPN通过一个滑动窗口(图中红色框)连接在最后一个卷积层输出的 feature map上,然后通过全连接层调整到256-d的向量,作为输出 层的输入。同时每个滑动窗对应k个anchor boxes,在论文中使用3个 尺寸和3个比例的3*3=9个anchor。每个anchor对应原图上一个感受 野,通过这种方法提高scale-invariant。

与GT的IOU在阈值0.1到0.5之间的ROI作为负样本。bg_th.1

Fast R-CNN整体结构

如图,Fast R-CNN的网络有两个输出层,一个softmax,一个bbox regressor(相对的R-CNN,SPP Net中分类和回归是两个部分,这里集 成在了同一个网络中)。而且加入了一个RoI pooling layer(类似于一 个尺度的SPP layer)。注意:Fast R-CNN提取建议区域的方法依然是 select search。

与Ground Truth的IOU大于阈值0.75的ROI作为正样本。 fg_thresh=0.75

与Ground Truth的IOU在阈值0到0.35之间的ROI作为负样本。 bg_thresh_hi=0.35、bg_thresh_lo=0 feature map到原图映射的变化率为16,这个数值主要是由池化降维算出, 与其步长选择有关。 feat_stride=16

Spatial Pyramid Pooling Layer(SPP)

如图,在卷基层和全连接层之间加入SPP layer。此时网络的输入 可以是任意尺寸,在SPP layer中每一个pooling的filter会根据输入 调整大小,而SPP的输出尺寸始终是固定的。

2.只对原图提取一次卷积特征

在R-CNN中,每个proposed region先rescale成统一大小, 然后分别作为CNNs的输入,这样是很低效的。

在SPP Net中,只对原图进行一次卷积得到整张图的feature map,然后找到每个proposed region在feature map上的 映射patch,将此patch作为每个proposed region的卷积特 征输入到SPP layer和之后的层。节省了大量的计算时间,比RCNN有一百倍左右的加速。

训练时采用的一些策略与参数设置

3、训练样本选择方法与其参数设置 ims_per_batch 1或2 batch_size 128 每个batch中正样本占得比率。 fg_fraction 0.25 与GT的IOU大于阈值0.6的ROI作为正样本。 fg_thresh=0.6

Fast-RCNN中参数的设置

RoI pooling layer

这是SPP pooling的一个简化版本,可以看做是只有一个尺度 filter的 ‘金字塔’。输入是N个整幅图的feature map和一组R个RoI (proposed region)。每个特征映射都是H*W*C,每个RoI是一个 元组(n,r,c,h,w),n是特征映射的索引,r,c,h,w分别是 RoI的左上角坐标和高与宽。输出是max-pooling过得特征映射 H’xW’xC,如上图中红色框线。

RPN与FR-CNN共享卷基层

为了使共用的卷积层在训练RPN和FR-CNN时都会收敛,论文里设计 了一个四步训练的策略: (1):对RPN进行end-to-end的训练,这里网络使用ImageNet pre-trained model进行初始化。 (2):使用第一步RPN生成的建议区域训练FR-CNN,这里也使用 ImageNet pre-trained model进行初始化。 (3):使用上一步FR-CNN的参数初始化RPN,固定卷基层,只 fine-tune RPN独有的层。(在此步已共享卷积层) (4):固定卷基层,只fine-tune FR-CNN独有的层。

Faster-RCNN整体框架

Faster R-CNN

Faster R-CNN的主要贡献是设计了提取建议区域的网络Region Proposal Network(RPN)。代替了费时的select search,使检测 速度大为提高。下图为Faster R-CNN的结构图,黄色部分为RPN, 可以看出除了RPN,其它部分继承了FR-CNN的结构。