一个基于K_means的聚类算法的实现

K-means++聚类算法研究与实现

K-means++聚类算法研究与实现作者:崔健徐健来源:《电脑知识与技术》2024年第17期摘要:聚类分析作为数据挖掘领域的一个关键研究热点,主要涉及数据分组技术。

K-means算法作为一种经典的聚类方法,由于其简洁性和高效率而被广泛应用。

然而,该算法存在一些明显的缺陷,如聚类中心的随机选择和较慢的收敛速度。

文章在分析传统聚类算法的基础上,对K-means++算法进行了深入探讨。

K-means++算法的核心思想是在选定后续聚类中心时,综合考虑当前已有聚类中心的分布,从而减少中心点的重叠。

实验结果表明,K-means++通过选择更为分散的聚类中心,有效提高了聚类的准确性和算法的收敛速度,在改善聚类效率和精度方面具有显著优势。

关键词:聚类算法;K-means;K-means++;数据挖掘中图分类号:TP311 文献标识码:A文章编号:1009-3044(2024)17-0078-04 开放科学(资源服务)标识码(OSID):0 引言聚类是一种关键的无监督学习方法,用于将相似数据点分类并探索数据的内在结构[1]。

通过揭示数据集中的密集和稀疏区域,聚类分析帮助研究人员识别全局分布模式和复杂数据属性关联,这不仅有助于理解数据的基本结构,还能在市场细分、社会网络和生物信息学等领域中发挥重要作用。

作为数据预处理步骤,聚类通过特征提取和分类操作,提高了数据分析的精确度和效率。

在处理大规模数据集时,这种方法可简化数据结构并明确研究方向。

聚类算法在统计学、模式识别、计算几何、生物信息学、优化及图像处理等多个领域得到广泛应用,并在过去十年中取得了显著进展。

K-means聚类算法是数据挖掘领域中极受欢迎的一种算法。

尽管由于其简单和高效而广泛应用,但该算法存在一些明显的局限性,如聚类中心的随机选择和较慢的收敛速度。

为应对这些问题,改进版的K-means++算法应运而生,并成为本研究的焦点。

Kmeans++通过更精细的初始聚类中心选择方法优化了标准K-means 算法,减少了算法收敛所需的迭代次数,并提高了聚类的最终质量。

kmeans算法简单例题代码实现

K-means算法是一种用于数据聚类的经典算法,它通过迭代将数据分成K个类别。

在本文中,我们将对K-means算法进行简单介绍,然后用一个例题来演示如何实现K-means算法的代码。

1. K-means算法简介K-means算法是一种无监督学习算法,它的基本原理是通过迭代将数据分成K个类别,使得每个数据点都属于与其最近的均值点所代表的类别。

K-means算法的过程可以简单分为以下几步:(1)随机选择K个初始均值点作为聚类中心;(2)对于每个数据点,计算其与K个均值点的距离,并将其归类到距离最近的均值点所代表的类别中;(3)更新每个类别的均值点为该类别中所有数据点的平均值;(4)重复步骤(2)和步骤(3),直到达到停止条件为止。

2. K-means算法例题代码实现下面我们用一个简单的例题来演示如何实现K-means算法的代码。

假设我们有如下的数据集:```X = [[1, 2], [1, 4], [1, 0], [4, 2], [4, 4], [4, 0]]我们的目标是将这个数据集分成两个类别。

我们可以用以下的Python 代码来实现K-means算法:```pythonimport numpy as npfrom sklearn.cluster import KMeansX = np.array([[1, 2], [1, 4], [1, 0], [4, 2], [4, 4], [4, 0]])kmeans = KMeans(n_clusters=2, random_state=0).fit(X)print(bels_)print(kmeans.cluster_centers_)```在这段代码中,我们首先导入了numpy库和sklearn库,并将我们的数据集X转换为numpy数组。

然后我们使用KMeans类来创建一个K-means模型,并指定聚类的数量为2。

接着我们使用fit方法来对数据进行聚类,并打印出每个数据点的类别和每个类别的均值点的位置。

基于k-means聚类算法的研究

第 7期

计 算 机 技Biblioteka 术 与 发 展 C0MP ER ECHNOL UT T OGY AND DEVE LOP MEN1 ’

V0. 1 No 7 12 .

2 1 年 7月 01

J l 2 1 uy 0 1

基 于 k me n — a s聚 类算 法 的研 究

黄 韬, 刘胜 辉 , 艳 娜 谭

HUANG o, U h n Ta LI S e g-h i TAN n-n u, Ya a

( c . f o u c.n eh - ri U i.fSiadT c . H bn108 。 hn ) Sh o mp ̄r iadT c .Ha n nv o c. eh , a i 5 0 0 C ia C S b n r

( 尔滨理 工大 学 计 算机 科 学与技 术 学院 , 哈 黑龙 江 哈 尔滨 10 8 ) 5 00

摘 要 : 析研 究聚 类分 析方法 , 多种 聚类分 析算 法进 行 分析 比较 , 分 对 讨论 各 自的优 点 和 不 足 , 同时 针 对原 k m as 法 - en 算

的 聚类结 果受 随机选 取初 始聚 类 中心的影 响较 大 的缺 点 , 出一 种 改进 算 法 。通过 将 对 数据 集 的 多次 采 样 , 提 选取 最 终较

中图分 类号 :P0 . T 316 文献 标识 码 : A 文章 编号 : 7 —2 X(0 10 — 04 0 1 3 69 2 1 )7 05 — 4 6

Re e r h o u trn g rt m s d o - a s s a c f Cl se i g Al o i h Ba e n K me n

Ab t a t An l z n e e r h t e me o fcu t ra a y i - a y e a d c mp r n i d fa g rt ms o l se n y i 。 i u s s r c : ay e a d r s a c h t d o l se l ss a l z n o a e ma y k n so o i h n n l h fcu t ra a ss d s s l c merr s e t e s e g s a d we k e s s Att e s me t i e p c v t n t n a n s . a i i r h e h me。 c o d n o t e we kn s s o e c u tr r s l fo g n a c r i g t a e s f t l se e u to r i a k-me s ag - h e h i l n a lo r h a i ini c ti fu n e b lc i g t e i i a l t r c n e s r d ml a mo i e g rt m s p o o e T o g k n a p e i r s sg f a n e c y s e t n t cus e t r a o y。 d f d a o i t in l e n h i l e n i l h i r p s d. hr u h t i g s a m l ma y t st aa s t c o s n u e o l se e t r br g d wn t e i a t fi i a l se e t r o i r e g rt m r a l . n me d t e , h o e f a s p r rcu t rc n e - i o mp c tl cu trc n e st mp ov d a o h g e t i o il i n h o ni l i y S mu tn o sy-t e ii a t ssa d d z d o e t ei i a l se e tr i s lc e i l e u l h n t da i tn a ie nc t cu t r n e s ee t d,ma e l se fe t mp o e t e mo . t — a i l a h ni l c k scu t re c r v d f h r r Dee i ur e c i w o t m r g ue a g r h Hk- a s t r u h t e d t f UCId t t t e r s l s o a n l i me h o g h a e o n aa s 。 u t h wst tHk- a s ag rt m s mo r mi e ti r v e h e h me o i n l h i r p o n n mp e o o d h n n tl k t a i i a —me sa g rt m i l se fe t a d i S u f l o o f r n e t e a v ie d i n a l o h i n cu t re f , c n t s u f rc n e c o r lt ef l . e e i Ke r s d t n n cus r g a g rt m ; me s ag r h y wo d : aa m i g; l t i o i i en l h k— a o i m n l t

kmeans算法java实现

kmeans算法java实现K-means算法是一种常用的聚类算法,在机器学习和数据挖掘领域得到广泛应用。

本文将介绍K-means算法的原理以及如何用Java实现。

文章将按照以下五个主题逐步展开:K-means算法概述、算法步骤、Java实现准备、Java实现步骤和结果分析。

1. K-means算法概述K-means算法是一种非监督学习算法,用于将具有相似特征的数据点划分为不同的簇。

它以欧氏距离作为相似度度量,并希望簇内的数据点尽可能接近彼此,而不同簇之间的样本点则尽可能远离彼此。

算法的核心思想是通过迭代优化来找到使目标函数最小化的质心位置。

2. 算法步骤2.1 初始化:设定簇的数量K和数据集,随机选择K个数据点作为初始质心。

2.2 聚类:计算每个数据点到各个质心的距离,并将其归类到离其最近的质心所在的簇中。

2.3 更新质心:计算每个簇内所有数据点的均值,作为新的质心位置。

2.4 重复2.2和2.3步骤,直到质心位置不再改变或达到迭代次数的上限。

3. Java实现准备在开始编写代码之前,我们需要引入Java相关的机器学习库。

ApacheMahout和Weka是两个常用的选项,它们提供了各种机器学习算法的实现。

在本文中,我们将使用Weka库。

4. Java实现步骤4.1 导入必要的库:首先,导入Weka库,以及用于读取数据和处理数据的其他必要库。

4.2 读取数据:从外部文件读取数据,并将其转换为需要的格式。

例如,将输入的CSV文件转换为Weka库中的Instances对象。

4.3 初始化质心:随机选择K个数据点作为初始质心。

4.4 聚类和更新质心:根据质心计算每个数据点到各个质心的距离,并将其归类到最近的质心所在的簇中。

然后,计算每个簇内所有数据点的均值,作为新的质心位置。

4.5 重复聚类和更新质心步骤,直到质心位置不再改变或达到迭代次数的上限。

4.6 结果输出:将聚类的结果输出到外部文件,以便进一步分析和可视化。

kmeans聚类算法简单例题

kmeans聚类算法简单例题一、引言K-means聚类算法是一种非常常用的无监督学习算法,它能够将数据划分为多个簇,每个簇的样本具有相似的特征。

本例题将介绍K-means聚类算法的基本原理,并通过Python实现一个简单的例子。

二、K-means聚类算法原理K-means算法是一种基于迭代的方法,它将数据划分为K个簇,每个簇的样本通过迭代重新分配到最近的均值(即质心)所代表的簇中。

算法的核心步骤包括:初始化、计算距离、重新分配样本、迭代优化。

三、Python实现1. 数据准备:首先,我们需要准备一组数据,可以使用Python内置的随机数生成器生成一些随机数据。

2. 导入库:使用Python的库导入必要的库,如numpy和matplotlib。

3. 计算距离:使用numpy库中的dist函数计算样本之间的距离。

4. 初始化质心:使用numpy库中的random.rand函数随机初始化质心。

5. 迭代优化:使用循环进行迭代,每次迭代中,将样本分配到最近的质心所代表的簇中,并更新质心。

6. 可视化结果:使用matplotlib库绘制聚类结果。

四、代码示例以下是一个简单的K-means聚类算法实现示例:```pythonimport numpy as npimport matplotlib.pyplot as plt# 生成随机数据data = np.random.rand(100, 2)# 设置簇的数量k = 3# 初始化质心centers = data[np.random.choice(np.arange(len(data)), k, False)]for i in range(10): # 迭代次数# 计算距离并分配样本到最近的簇中labels = np.argmin(np.linalg.norm(data[:, None] - centers, axis=-1), axis=-1)# 更新质心new_centers = np.array([data[labels==j].mean(axis=0) for j in range(k)])# 检查是否收敛(质心不再变化)if np.all(centers == new_centers):breakcenters = new_centers# 可视化结果plt.scatter(data[:, 0], data[:, 1], c=labels)plt.scatter(centers[:, 0], centers[:, 1], marker='x', s=200, linewidths=3, color='r')plt.show()```五、总结本例题通过Python实现了一个简单的K-means聚类算法,并通过可视化展示了聚类结果。

kmeans的聚类算法

kmeans的聚类算法K-means是一种常见的聚类算法,它可以将数据集划分为K个簇,每个簇包含相似的数据点。

在本文中,我们将详细介绍K-means算法的原理、步骤和应用。

一、K-means算法原理K-means算法基于以下两个假设:1. 每个簇的中心是该簇内所有点的平均值。

2. 每个点都属于距离其最近的中心所在的簇。

基于这两个假设,K-means算法通过迭代寻找最佳中心来实现聚类。

具体来说,该算法包括以下步骤:二、K-means算法步骤1. 随机选择k个数据点作为初始质心。

2. 将每个数据点分配到距离其最近的质心所在的簇。

3. 计算每个簇内所有数据点的平均值,并将其作为新质心。

4. 重复步骤2和3直到质心不再变化或达到预定迭代次数。

三、K-means算法应用1. 数据挖掘:将大量数据分成几组可以帮助我们发现其中隐含的规律2. 图像分割:将图像分成几个部分,每个部分可以看做是一个簇,从而实现图像的分割。

3. 生物学:通过对生物数据进行聚类可以帮助我们理解生物之间的相似性和差异性。

四、K-means算法优缺点1. 优点:(1)简单易懂,易于实现。

(2)计算效率高,适用于大规模数据集。

(3)结果可解释性强。

2. 缺点:(1)需要预先设定簇数K。

(2)对初始质心的选择敏感,可能会陷入局部最优解。

(3)无法处理非球形簇和噪声数据。

五、K-means算法改进1. K-means++:改进了初始质心的选择方法,能够更好地避免陷入局部最优解。

2. Mini-batch K-means:通过随机抽样来加快计算速度,在保证精度的同时降低了计算复杂度。

K-means算法是一种常见的聚类算法,它通过迭代寻找最佳中心来实现聚类。

该算法应用广泛,但也存在一些缺点。

针对这些缺点,我们可以采用改进方法来提高其效果。

一种基于遗传算法的Kmeans聚类算法

一种基于遗传算法的K-means聚类算法一种基于遗传算法的K-means聚类算法摘要:传统K-means算法对初始聚类中心的选取和样本的输入顺序非常敏感,容易陷入局部最优。

针对上述问题,提出了一种基于遗传算法的K-means聚类算法GKA,将K-means算法的局部寻优能力与遗传算法的全局寻优能力相结合,通过多次选择、交叉、变异的遗传操作,最终得到最优的聚类数和初始质心集,克服了传统K-means 算法的局部性和对初始聚类中心的敏感性。

关键词:遗传算法;K-means;聚类聚类分析是一个无监督的学习过程,是指按照事物的某些属性将其聚集成类,使得簇间相似性尽量小,簇内相似性尽量大,实现对数据的分类[1]。

聚类分析是数据挖掘技术的重要组成部分,它既可以作为独立的数据挖掘工具来获取数据库中数据的分布情况,也可以作为其他数据挖掘算法的预处理步骤。

聚类分析已成为数据挖掘主要的研究领域,目前已被广泛应用于模式识别、图像处理、数据分析和客户关系管理等领域中。

K-means算法是聚类分析中一种基本的划分方法,因其算法简单、理论可靠、收敛速度快、能有效处理较大数据而被广泛应用,但传统的K-means算法对初始聚类中心敏感,容易受初始选定的聚类中心的影响而过早地收敛于局部最优解,因此亟需一种能克服上述缺点的全局优化算法。

遗传算法是模拟生物在自然环境中的遗传和进化过程而形成的一种自适应全局优化搜索算法。

在进化过程中进行的遗传操作包括编码、选择、交叉、变异和适者生存选择。

它以适应度函数为依据,通过对种群个体不断进行遗传操作实现种群个体一代代地优化并逐渐逼近最优解。

鉴于遗传算法的全局优化性,本文针对应用最为广泛的K-means方法的缺点,提出了一种基于遗传算法的K-means聚类算法GKA(Genetic K-means Algorithm),以克服传统K-means算法的局部性和对初始聚类中心的敏感性。

用遗传算法求解聚类问题,首先要解决三个问题:(1)如何将聚类问题的解编码到个体中;(2)如何构造适应度函数来度量每个个体对聚类问题的适应程度,即如果某个个体的编码代表良好的聚类结果,则其适应度就高;反之,其适应度就低。

matlab kmeans聚类算法代码

一、引言在机器学习和数据分析中,聚类是一种常用的数据分析技术,它可以帮助我们发现数据中的潜在模式和结构。

而k均值(k-means)聚类算法作为一种经典的聚类方法,被广泛应用于各种领域的数据分析和模式识别中。

本文将介绍matlab中k均值聚类算法的实现和代码编写。

二、k均值(k-means)聚类算法简介k均值聚类算法是一种基于距离的聚类算法,它通过迭代的方式将数据集划分为k个簇,每个簇内的数据点与该簇的中心点的距离之和最小。

其基本思想是通过不断调整簇的中心点,使得簇内的数据点与中心点的距离最小化,从而实现数据的聚类分布。

三、matlab实现k均值聚类算法步骤在matlab中,实现k均值聚类算法的步骤如下:1. 初始化k个簇的中心点,可以随机选择数据集中的k个点作为初始中心点。

2. 根据每个数据点与各个簇中心点的距离,将数据点分配给距离最近的簇。

3. 根据每个簇的数据点重新计算该簇的中心点。

4. 重复步骤2和步骤3,直到簇的中心点不再发生变化或者达到预定的迭代次数。

在matlab中,可以通过以下代码实现k均值聚类算法:```matlab设置参数k = 3; 设置簇的个数max_iter = 100; 最大迭代次数初始化k个簇的中心点centroids = datasample(data, k, 'Replace', false);for iter = 1:max_iterStep 1: 计算每个数据点与簇中心点的距离distances = pdist2(data, centroids);Step 2: 分配数据点给距离最近的簇[~, cluster_idx] = min(distances, [], 2);Step 3: 重新计算每个簇的中心点for i = 1:kcentroids(i, :) = mean(data(cluster_idx == i, :)); endend得到最终的聚类结果cluster_result = cluster_idx;```四、代码解释上述代码实现了k均值聚类算法的基本步骤,其中包括了参数设置、簇中心点的初始化、迭代过程中的数据点分配和中心点更新。

kmeans聚类算法的算法流程

K-means聚类算法是一种经典的基于距离的聚类算法,它被广泛应用于数据挖掘、模式识别、图像分割等领域。

K-means算法通过不断迭代更新簇中心来实现数据点的聚类,其算法流程如下:1. 初始化:首先需要确定要将数据分成的簇的个数K,然后随机初始化K个簇中心,可以从数据集中随机选择K个样本作为初始簇中心。

2. 分配数据:对于每个数据点,计算它与各个簇中心的距离,将该数据点分配给距离最近的簇,并更新该数据点所属簇的信息。

3. 更新簇中心:计算每个簇中所有数据点的均值,将该均值作为新的簇中心,更新所有簇中心的位置。

4. 重复迭代:重复步骤2和步骤3,直到簇中心不再发生变化或者达到预定的迭代次数。

5. 输出结果:最终得到K个簇,每个簇包含一组数据点,形成了聚类结果。

K-means算法的优点在于简单易实现,时间复杂度低,适用于大规模数据;但也存在一些缺点,如对初始聚类中心敏感,对噪声和离裙点敏感,需要事先确定聚类个数K等。

K-means聚类算法是一种常用的聚类方法,通过迭代更新簇中心的方式逐步将数据点划分为不同的簇,实现数据的聚类分析。

通过对算法流程的详细了解,可以更好地应用K-means算法解决实际问题。

K-means算法是一种非常经典的聚类算法,它在数据挖掘和机器学习领域有着广泛的应用。

在实际问题中,K-means算法可以帮助我们对数据进行分组和分类,从而更好地理解数据的内在规律,为我们提供更准确的数据分析和预测。

接下来,我们将对K-means聚类算法的一些关键要点进行探讨,包括算法的优化、应用场景、以及与其他聚类算法的比较等方面。

1. 算法的优化:在实际应用中,K-means算法可能会受到初始簇中心的选择和迭代次数的影响,容易收敛到局部最优解。

有一些改进的方法可以用来优化K-means算法,例如K-means++算法通过改进初始簇中心的选择方式,来减少算法收敛到局部最优解的可能性;另外,Batch K-means算法通过批量更新簇中心的方式来加快算法的收敛速度;而Distributed K-means算法则是针对大规模数据集,通过并行计算的方式来提高算法的效率。

K-means聚类算法实现及应用

K-means聚类算法的实现及应用内容摘要本文在分析和实现经典k-means算法的基础上,针对初始类中心选择问题,结合已有的工作,基于对象距离和密度对算法进行了改进。

在算法实现部分使用vc6.0作为开发环境、sql sever2005作为后台数据库对算法进行了验证,实验表明,改进后的算法可以提高算法稳定性,并减少迭代次数。

关键字 k-means;随机聚类;优化聚类;记录的密度1 引言1.1聚类相关知识介绍聚类分析是直接比较各事物之间性质,将性质相近的归为一类,将性质不同的归为一类,在医学实践中也经常需要做一些分类工作。

如根据病人一系列症状、体征和生化检查的结果,将其划分成某几种方法适合用于甲类病的检查,另几种方法适合用于乙类病的检查,等等。

聚类分析被广泛研究了许多年。

基于聚类分析的工具已经被加入到许多统计分析软件或系统中,入s-plus,spss,以及sas。

大体上,聚类算法可以划分为如下几类:1) 划分方法。

2) 层次方法。

3) 基于密度的算法。

4) 基于网格的方法。

5) 基于模型的方法。

1.2 研究聚类算法的意义在很多情况下,研究的目标之间很难找到直接的联系,很难用理论的途径去解决。

在各目标之间找不到明显的关联,所能得到的只是些模糊的认识,由长期的经验所形成的感知和由测量所积累的数据。

因此,若能用计算机技术对以往的经验、观察、数据进行总结,寻找个目标间的各种联系或目标的优化区域、优化方向,则是对实际问题的解决具有指导意义和应用价值的。

在无监督情况下,我们可以尝试多种方式描述问题,其中之一是将问题陈述为对数分组或聚类的处理。

尽管得到的聚类算法没有明显的理论性,但它确实是模式识别研究中非常有用的一类技术。

聚类是一个将数据集划分为若干聚类的过程,是同一聚类具有较高相似性,不同聚类不具相似性,相似或不相似根据数据的属性值来度量,通常使用基于距离的方法。

通过聚类,可以发现数据密集和稀疏的区域,从而发现数据整体的分布模式,以及数据属性间有意义的关联。

简述k均值聚类的实现步骤

k均值聚类的实现步骤1. 简介k均值聚类(k-means clustering)是一种常用的无监督学习算法,用于将数据集划分为k个不重叠的类别。

该算法通过寻找数据集中各个样本之间的相似性,将相似的样本归为一类,从而实现聚类分析。

2. 算法步骤k均值聚类算法主要包含以下几个步骤:步骤1:初始化首先需要确定要划分的类别数k,并随机选择k个样本作为初始聚类中心。

这些聚类中心可以是随机选择的,也可以根据领域知识或经验来确定。

步骤2:分配样本到最近的聚类中心对于每个样本,计算它与各个聚类中心之间的距离,并将其分配到距离最近的聚类中心所代表的类别。

步骤3:更新聚类中心对于每个聚类,计算该类别内所有样本的平均值,作为新的聚类中心。

步骤4:重复步骤2和步骤3重复执行步骤2和步骤3,直到满足停止条件。

停止条件可以是达到最大迭代次数、聚类中心不再发生变化等。

步骤5:输出聚类结果k均值聚类算法输出每个样本所属的类别,即完成了对数据集的聚类分析。

3. 距离度量在k均值聚类算法中,需要选择合适的距离度量方法来计算样本之间的相似性。

常用的距离度量方法包括欧氏距离、曼哈顿距离和余弦相似度等。

欧氏距离欧氏距离是最常用的距离度量方法之一,它表示两个点在n维空间中的直线距离。

假设有两个点A(x1, y1)和B(x2, y2),则它们之间的欧氏距离为:d(A, B) = sqrt((x2 - x1)^2 + (y2 - y1)^2)曼哈顿距离曼哈顿距离是另一种常用的距离度量方法,它表示两个点在n维空间中沿坐标轴方向的绝对差值之和。

假设有两个点A(x1, y1)和B(x2, y2),则它们之间的曼哈顿距离为:d(A, B) = |x2 - x1| + |y2 - y1|余弦相似度余弦相似度是用于衡量两个向量之间的相似性的度量方法,它通过计算两个向量的夹角余弦值来确定它们的相似程度。

假设有两个向量A和B,则它们之间的余弦相似度为:sim(A, B) = (A·B) / (||A|| * ||B||)其中,A·B表示向量A和向量B的内积,||A||和||B||分别表示向量A和向量B 的模长。

kmeans聚类算法实例

kmeans聚类算法实例Kmeans聚类算法是一种无监督学习算法,可用于将数据集划分成多个不同的簇。

本文将介绍一些Kmeans聚类算法的基本概念和一个实例。

Kmeans聚类算法基本概念Kmeans聚类算法主要包含以下基本概念:簇:Kmeans聚类算法的目标是将数据集划分成多个簇,其中每个簇包含相似的数据项。

质心:每个簇的质心是该簇内所有数据项的平均值。

距离度量:Kmeans聚类算法基于距离度量来衡量数据项之间的相似度。

聚类中心:Kmeans聚类算法一开始需要随机初始化一些聚类中心。

在Kmeans聚类算法的每个迭代中,聚类中心将根据当前分配给它们的数据项而重新计算。

Kmeans聚类算法实例下面我们将使用sklearn库中的Kmeans聚类算法来演示一个实例。

我们将使用Iris数据集来执行聚类。

首先,我们需要导入所需的库:from sklearn.cluster import KMeansimport matplotlib.pyplot as pltimport pandas as pdimport numpy as npfrom sklearn.datasets import load_iris接下来,我们将加载Iris数据集:iris = load_iris()df = pd.DataFrame(iris.data, columns=iris.feature_names)我们可以使用Kmeans聚类算法来将Iris数据集划分成3个簇:model = KMeans(n_clusters=3)model.fit(df.values)现在我们可以创建一个图来显示每个数据点所属的簇以及质心的位置:colors = np.array(['red', 'green', 'blue'])plt.scatter(df.values[:, 0], df.values[:, 1], c=colors[bels_]) plt.scatter(model.cluster_centers_[:, 0], model.cluster_centers_[:, 1], marker='x', s=100, linewidths=3, color='black', zorder=10) plt.show()该图显示了所有数据点以及它们所属的簇(红色、绿色和蓝色)。

k-means聚类算法实验总结 -回复

k-means聚类算法实验总结-回复K-means聚类算法是一种常用的无监督学习算法,广泛应用于数据挖掘、图像分割、文本分类等领域。

本文将基于我对K-means聚类算法的实验总结,分步详细介绍这一算法的原理、实验设置、实验结果及其分析。

希望通过本文的总结,读者能够对K-means算法有一个更全面的了解。

一、算法原理K-means聚类算法的原理比较简单,其基本步骤如下:1. 初始化k个聚类中心,可以是随机选择样本或根据经验预设;2. 对于每个样本,计算其与各个聚类中心的距离,并将其划分到距离最近的聚类中心所属的类别;3. 调整聚类中心的位置,将各个类别内的样本点的均值作为新的聚类中心,重复步骤2,直到聚类中心的位置不再变化或达到预设的最大迭代次数。

二、实验设置为了验证K-means聚类算法的性能,我选择了UCI机器学习库中的Iris 数据集作为实验数据集。

该数据集包含150个样本,每个样本有4个属性。

为了方便可视化,将数据集中的前两个属性作为横纵坐标,将样本点分布在二维平面上。

在实验中,我使用Python编程语言实现了K-means聚类算法,并使用matplotlib库绘制了聚类结果的散点图。

实验中设置聚类的类别数k为3,迭代次数上限为100。

三、实验结果及分析执行K-means聚类算法后,得到了如下图所示的聚类结果:[图1 聚类结果图]根据聚类结果可以看出,三个类别的样本点被分别用不同的颜色表示,并且通过散点图可以很直观地看到各个样本点与聚类中心的距离。

为了更客观地评估K-means的聚类性能,我采用了两项指标:聚类准确率和轮廓系数。

聚类准确率是将聚类结果与原始类别进行对比,计算分类正确的样本数量占总样本数量的比例。

通过计算实验结果,我得到了聚类准确率为85.33。

轮廓系数是一种评价聚类结果的衡量指标,其数值范围在-1到1之间,越接近于1表示聚类越紧密、样本点越相似,越接近于-1表示聚类越分散、样本点越不相似。

基于KMeans聚类算法的智能化站点设计与实现

河南科技大学硕士学位论文基于K-Means聚类算法的智能化站点设计与实现姓名:高利军申请学位级别:硕士专业:计算机应用技术指导教师:王辉@摘要论文题目:基于K-Means聚类算法的智能化站点设计与实现专业:计算机应用技术研究生:高利军指导教师:王辉摘要Internet和电子商务的发展带动了面向Web的数据挖掘技术的研究。

在个性化推荐系统中,运用数据挖掘技术对服务器上的日志文件等数据进行用户访问信息的Web数据挖掘,根据对用户的访问行为、访问时间的分析,得到群体用户行为和方式的普遍知识,动态地调整页面结构,改进服务,给用户个性化的界面,从而更好地服务于用户,提升网站的整体质量。

Web挖掘技术使得人们能够充分了解Web页面之间,以及Web站点的组织形式与用户的访问模式之间的关联。

其中,面向服务器日志的Web日志挖掘技术尤其得到众多研究人员的关注。

利用Web日志挖掘,可以了解用户对网站的浏览模式、浏览习惯以及浏览行为,进而发现行为相似的用户群,同时根据Web页面被用户访问的情况将具有相同特征的页面进行分组。

本文在充分分析国内外研究现状的基础上,提出了通过挖掘Web日志,根据当前用户的访问行为实时地为用户进行个性化推荐的智能化网站基本架构,特别是对其中的关键技术做了深入细致的研究,主要内容如下:(1) 提出了通过Web日志对用户兴趣进行隐式获取的方法。

(2)对k-Means聚类算法做出了改进,使得管理员无需背景知识也能很好地对网站用户进行聚类。

在关键技术研究的基础上,提出了一个提高Web服务质量的解决方案,并实现了一个基于用户访问模式进行实时推荐的智能化站点原型系统,同时将其关键技术应用到河南科技大学洛浦清风校园文化网站,取得了良好的效果。

本文对智能化站点原型系统的研究和实验结果分析,将对智能化站点从理论研究向现实网站中应用,起到一定的指导和推动作用。

关键词:聚类,Web日志挖掘,关联规则,数据挖掘,协同过滤.论文类型:应用研究河南科技大学硕士学位论文Subject: Design and Realization of Intelligent Website Based on K-Means ClusteringSpecialty: Computer Applications TechnologyName:Gao Li-junSupervisor:Wang HuiABSTRACTAt present, the development of Internet and e-commerce drives the research for data mining technology facing web. In personalized recommendation system, the user’s browsing behavior can be discovered by applying data mining technology on web data such as server logs, and the general knowledge of the group user’s behaviors and patterns can be obtained by analyzing the user’s accessing behavior and accessing time. In addition, the page structure, the service and marketing strategies can be modified and improved dynamically according to the discovered knowledge to serve the user well and promote the overall quality of the website.Web mining technology makes people can fully find out the relation between the web pages, and the connection between the web organizational forms of website and the access mode of the customer. Among them, the web log mining technology gets the concern of numerous researchers especially. By utilizing the web log mining, we can know the browsing pattern、browsing custom as well as browsing behavior of the customer, find the similar user group according to browser behaviors and divide the pages with the same characteristic into groups by the web pages visited by the user.This paper proposed the basic construction of the intellectualized website which can offer the personalized recommendation to the user in real time by mining the Web log and according to the current user's visit behavior on the basis of fully analyzing the research of present situation in the domestic and foreign. This paper has done the thorough careful research to key technologies specially; the primary content is as follows:(1) Proposed a method of obtaining user’s interests by mining web log implicitly.(2) Improved the K-Means clustering algorithm, the new algorithm realizes automatically cluster, which improves cluster validity without background knowledge and can be implemented to cluster users.摘要On the basis of the research of the key technologies, this paper proposed the solution to improve the web quality of service, and realized the intellectualized prototype system to provide real-time recommendation based on the user’s visit pattern, simultaneously applied the key technologies to the LPQF campus culture website, and obtained good effect.This paper researched the intellectualized prototype system and analyzed the experimental result, which has important instruction and significant impetus to drive the intellectualized website from fundamental theory research to reality application.KEY WORDS:Data Mining, Intelligent Website, Data Preprocessing, Web Mining, Web Log Mining, Clustering, Collaborative Filtering.Dissertation Type: Application research第1章绪论第1章绪论1.1 课题背景当今人类已经处于一个信息极度丰富的时代,人们可以从各种各样的传播媒体中获得信息,如报纸、电视、杂志、万维网等。

(完整版)matlab实现Kmeans聚类算法

题目:matlab实现Kmeans聚类算法姓名学号背景知识1.简介:Kmeans算法是一种经典的聚类算法,在模式识别中得到了广泛的应用,基于Kmeans的变种算法也有很多,模糊Kmeans、分层Kmeans 等。

Kmeans和应用于混合高斯模型的受限EM算法是一致的。

高斯混合模型广泛用于数据挖掘、模式识别、机器学习、统计分析。

Kmeans 的迭代步骤可以看成E步和M步,E:固定参数类别中心向量重新标记样本,M:固定标记样本调整类别中心向量。

K均值只考虑(估计)了均值,而没有估计类别的方差,所以聚类的结构比较适合于特征协方差相等的类别。

Kmeans在某种程度也可以看成Meanshitf的特殊版本,Meanshift 是一种概率密度梯度估计方法(优点:无需求解出具体的概率密度,直接求解概率密度梯度。

),所以Meanshift可以用于寻找数据的多个模态(类别),利用的是梯度上升法。

在06年的一篇CVPR文章上,证明了Meanshift方法是牛顿拉夫逊算法的变种。

Kmeans 和EM算法相似是指混合密度的形式已知(参数形式已知)情况下,利用迭代方法,在参数空间中搜索解。

而Kmeans和Meanshift相似是指都是一种概率密度梯度估计的方法,不过是Kmean选用的是特殊的核函数(uniform kernel),而与混合概率密度形式是否已知无关,是一种梯度求解方式。

k-means是一种聚类算法,这种算法是依赖于点的邻域来决定哪些点应该分在一个组中。

当一堆点都靠的比较近,那这堆点应该是分到同一组。

使用k-means,可以找到每一组的中心点。

当然,聚类算法并不局限于2维的点,也可以对高维的空间(3维,4维,等等)的点进行聚类,任意高维的空间都可以。

上图中的彩色部分是一些二维空间点。

上图中已经把这些点分组了,并使用了不同的颜色对各组进行了标记。

这就是聚类算法要做的事情。

这个算法的输入是:1:点的数据(这里并不一定指的是坐标,其实可以说是向量)2:K,聚类中心的个数(即要把这一堆数据分成几组)所以,在处理之前,你先要决定将要把这一堆数据分成几组,即聚成几类。

基于k-means算法改进的短文本聚类研究与实现

文章编号:1009 - 2552(2019)12 - 0076 - 05 DOI:10 13274 / j cnki hdzj 2019 12 016

基于 K ̄means 算法改进的短文本聚类研究与实现

利用Python如何实现K-means聚类算法

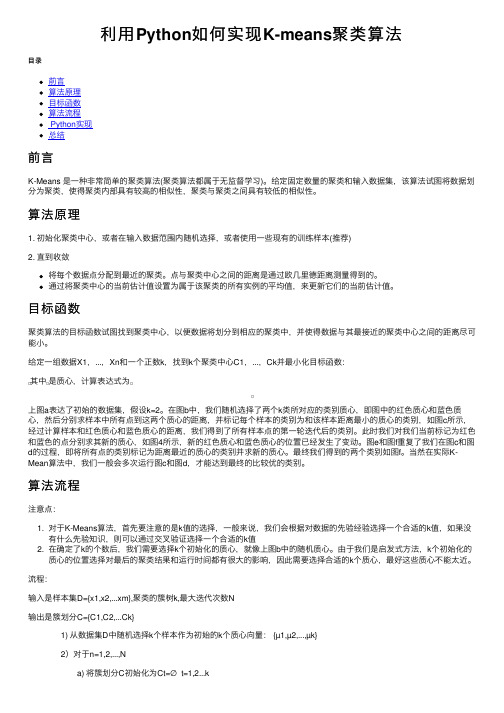

利⽤Python如何实现K-means聚类算法⽬录前⾔算法原理⽬标函数算法流程Python实现总结前⾔K-Means 是⼀种⾮常简单的聚类算法(聚类算法都属于⽆监督学习)。

给定固定数量的聚类和输⼊数据集,该算法试图将数据划分为聚类,使得聚类内部具有较⾼的相似性,聚类与聚类之间具有较低的相似性。

算法原理1. 初始化聚类中⼼,或者在输⼊数据范围内随机选择,或者使⽤⼀些现有的训练样本(推荐)2. 直到收敛将每个数据点分配到最近的聚类。

点与聚类中⼼之间的距离是通过欧⼏⾥德距离测量得到的。

通过将聚类中⼼的当前估计值设置为属于该聚类的所有实例的平均值,来更新它们的当前估计值。

⽬标函数聚类算法的⽬标函数试图找到聚类中⼼,以便数据将划分到相应的聚类中,并使得数据与其最接近的聚类中⼼之间的距离尽可能⼩。

给定⼀组数据X1,...,Xn和⼀个正数k,找到k个聚类中⼼C1,...,Ck并最⼩化⽬标函数:其中是质⼼,计算表达式为上图a表达了初始的数据集,假设k=2。

在图b中,我们随机选择了两个k类所对应的类别质⼼,即图中的红⾊质⼼和蓝⾊质⼼,然后分别求样本中所有点到这两个质⼼的距离,并标记每个样本的类别为和该样本距离最⼩的质⼼的类别,如图c所⽰,经过计算样本和红⾊质⼼和蓝⾊质⼼的距离,我们得到了所有样本点的第⼀轮迭代后的类别。

此时我们对我们当前标记为红⾊和蓝⾊的点分别求其新的质⼼,如图4所⽰,新的红⾊质⼼和蓝⾊质⼼的位置已经发⽣了变动。

图e和图f重复了我们在图c和图d的过程,即将所有点的类别标记为距离最近的质⼼的类别并求新的质⼼。

最终我们得到的两个类别如图f。

当然在实际K-Mean算法中,我们⼀般会多次运⾏图c和图d,才能达到最终的⽐较优的类别。

算法流程注意点:1. 对于K-Means算法,⾸先要注意的是k值的选择,⼀般来说,我们会根据对数据的先验经验选择⼀个合适的k值,如果没有什么先验知识,则可以通过交叉验证选择⼀个合适的k值2. 在确定了k的个数后,我们需要选择k个初始化的质⼼,就像上图b中的随机质⼼。

k-means算法的设计与实现

k-means算法的设计与实现1. 算法思想K-means算法是一种基于聚类思想的数据分析算法,通过将数据集中的点划分为K个类,使得各个数据点与所属类的质心的距离最小化。

2. 算法流程(1)初始化:选取K个质心,可以是随机选取或根据数据特征选取。

(2)分类:对数据集中的每个点,计算其与K个质心的距离,将其划分到距离最近的质心的类别中。

(3)更新质心:对于每个类别,计算属于该类别的所有点的平均值,并将其作为该类别的新质心。

(4)计算误差:计算所有点与其所属质心的距离的和,作为误差。

(5)重复分类、更新质心、计算误差的过程,直到误差不再变化或达到预设的最大迭代次数为止。

3. 算法实现在Python中,可以使用sklearn.cluster.KMeans模块实现K-means算法。

(1)初始化:pythonfrom sklearn.cluster import KMeanskmeans = KMeans(n_clusters=K, init='random', n_init=10, max_iter=300, tol=1e-4)其中,n_clusters表示聚类的个数,init表示质心的初始化方式,n_init表示多次聚类的次数,max_iter表示最大迭代次数,tol表示距离变化阈值。

(2)分类:pythonkmeans.fit(X)labels = bels_其中,X为数据集,labels为分类结果。

(3)更新质心:pythoncentroids = kmeans.cluster_centers_(4)计算误差:pythoninertia = kmeans.inertia_其中,inertia为SSE(Sum of Squared Errors),表示所有点到所属质心的距离平方和。

完整代码示例:pythonfrom sklearn.datasets import make_blobsfrom sklearn.cluster import KMeans# 生成数据集X, y = make_blobs(n_samples=1000, centers=3, random_state=42)# 初始化K = 3kmeans = KMeans(n_clusters=K, init='random', n_init=10, max_iter=300, tol=1e-4)# 分类kmeans.fit(X)labels = bels_# 更新质心centroids = kmeans.cluster_centers_# 计算误差inertia = kmeans.inertia_# 可视化import matplotlib.pyplot as pltplt.scatter(X[:, 0], X[:, 1], c=labels)plt.scatter(centroids[:, 0], centroids[:, 1], marker='*', s=300, c='r') plt.show()。

kmeans算法实现原理

kmeans算法实现原理K-Means算法是一种聚类算法,旨在将一组数据对象分为多个不同的簇,使得同一簇内的对象之间相似度较高,簇间的不相似度较大。

该算法由J. MacQueen于1967年提出,其基本思想是把已有的n个数据对象分成k个簇,使得簇内对象的相似性较高,而簇间对象的相似性较低。

K-Means属于无监督学习算法,没有给定训练数据集的输出,只有输入数据。

一、算法原理KMeans算法采用的是迭代优化的方法,其步骤如下:1. 初始化: 从n个数据对象中随机选择k个作为初始的聚类中心。

2. 计算每个样本到每个簇中心的距离,并将其分配到与其距离最近的那个簇中。

3. 定义新的簇中心: 对于每个簇内的所有数据对象,求其平均值并作为新的簇中心。

4. 重复2和3直到簇中心不再发生变化,或者是达到最大迭代次数。

步骤2和步骤3是迭代的核心部分,直至算法收敛即可停止迭代。

二、算法实现KMeans算法的实现有多种方式,其中一种比较常用的实现方法是传统的坐标下降法。

坐标下降法在每个迭代步骤中只更新一个维度,对整个集合进行更新的时间较长。

通常采用Lloyd算法来改进这种方法。

Lloyd算法和坐标下降法思想类似,不过每次更新是对所有维度同时进行更新,而不是对单个维度进行更新,从而使算法收敛速度加快。

三、算法应用KMeans算法广泛应用于数据挖掘、模式识别、图像分割等领域,较为常见的应用有:1. 市场营销: KMeans算法可用于进行客户聚类分析,从而根据不同聚类的客户需求和行为,制定相应的市场策略。

2. 模式识别: KMeans算法可用于文本分类,根据文本的内容,进行分类和归纳,进而分析文本的分布规律。

3. 图像分割: KMeans算法可用于图像分割,对图像中的不同区域进行划分,达到分离目标物体的目的。

四、算法局限性虽然KMeans算法具有较好的聚类效果,但是其也存在一些局限性。

1. 聚类数目k的确定: 聚类数目k是算法的参数,其有时需要通过经验调整合适的数值。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第22卷第1期 湖北民族学院学报(自然科学版) V ol.22 N o.1 2004年3月 Journal of Hubei Institute for Nationalities(Natural S cience Edition) Mar.2004一个基于K-means的聚类算法的实现谭 勇1,荣秋生2(1.湖北民族学院信息工程学院,湖北恩施445000;2.湖南文理学院计算机科学与技术系,湖南常德415000)摘要:聚类算法作为数据挖掘中的一种分析方法,它能找到样本比较密集的部分,并且概括出样本相对比较集中的区域.分析了传统的聚类算法及局限性,讨论了一个基于K-means算法的实现过程,使得算法可处理存在孤立点的大文档集,得到最佳的聚类结果.关键词:数据挖掘;聚类;K-Means中图分类号:TP311文献标识码:A文章编号:1008-8423(2004)01-0069-03随着数据挖掘研究领域技术的发展,作为数据挖掘主要方法之一的聚类算法,也越来越受到人们的关注.数据挖掘(Data Mining)[1],也称知识发现(K DD),是从数据库中便捷地抽取出以前未知的、隐含的、有用的信息,所挖掘出来的知识可应用于信息管理、决策支持、过程控制和其它许多方面.所谓聚类(Cluster),就是把大量的d维数据样本聚集成k个类,使同一类中样本的相似性最大,而不同类中样本的相似性最小.本文中提出的K-means算法属于聚类方法中一种基本的划分方法,该算法具有较好的可伸缩性和很高的效率,适合处理大文档集.1 传统的聚类算法及其局限性聚类分析作为数据挖掘中的一种分析方法,可以作为一个单独的工具以发现数据库中数据分布的一些深入的信息,并且概括出每一类的特点,或者把注意力放在某一个特定的类上以作进一步的分析;聚类分析也可以作为数据挖掘算法中其他分析算法的一个预处理.目前,已经提出的聚类算法有很多[2,3].(1)分裂法:给定一个有n个元组或者记录的数据集,构造k个分组,每一个分组代表一个聚类(k<n).对于给定的k,可以给出一个初始的分组方法,以后通过反复迭代来改变分组,使得每一次改进之后的分组方案都较前一次好.(2)层次法:对给定的数据集进行层次似的分解,直到某种条件满足为止.初始时每一个数据纪录都组成一个单独的组,在接下来的迭代中,把那些相互邻近的组合并成一个组,直到所有的记录组成一个分组或者某个条件满足为止.(3)基于网格的方法:首先将数据空间划分成为有限个单元(cell)的网格结构,所有的处理都是以单个的单元为对象的,从而使得处理速度加快.(4)基于模型的方法:给每一个聚类假定一个模型,然后去寻找能够很好的满足这个模型的数据集.这样一个模型可能是数据点在空间中的密度分布函数或者其它.它的一个潜在的假定就是:目标数据集是由一系列的概率分布所决定的.通常有两种尝试方向:统计的方案和神经网络的方案.上述这些算法的缺点在于对样本数据的分布进行了一定的假设,处理大数据集和高维数据集,尤其是对处理存在孤立点的大文档集时不够有效;另一方面它能发现的聚类个数常常依赖于用户参数的指定,而这对用户来说是很困难的.收稿日期:2003-10-201作者简介:谭勇(1968-),男(土家族),讲师,主要从事计算机网络、数据库、数据挖掘研究工作12 聚类算法描述聚类算法是在预先不知道目标数据库到底有多少类的情况下,希望将所有的纪录组成不同的类或者说聚类,并且使得在这种分类情况下,以某种度量为标准的相似性,在同一聚类之间最小化,而在不同聚类之间最大化.2.1 聚类分析中的数据类型聚类分析中数据结构为数据矩阵和差异度矩阵,聚类分析中的数据类型包括区间标度变量(Interval -scaled variables )、二元变量(Binary variables )、标称型,序数型和比例型变量(Nominal ,ordinal ,and ratio vari 2ables )以及混合类型变量(Variables of mixed types )4种.x 11...x 1f (x)1p ……………x i 1…x if …x ip ……………x n 1…x nf …x np , 0d (2,1)0d (3,1)d (3,2)0………d (n ,1)d (n ,2) 0 基于划分的聚类算法形式描述为:已知d 维空间R d ,在R d 中定义一个评价函数c :{X :X ΑS} R +,给每个聚类一个量化的评价,输入R d 中的对象集合S 和一个整数k ,要求输出的S 一个划分:S 1,S 2,…,S k ,这个划分使得6ki =1(cS i )最小化.不同的评价函数将产生不同的聚类结果,最常用的评价函数定义如下:c (s i )=6|S i |r =16|S i |s =1(d (x i r ,x i s ))2其中S i 为划分形成的簇,x i r 、x i s 分别为S i 的第r 个和第s 个元素,|S i |表示元素个数,d (x i r ,x i s )为x i r 和x i s 之间的距离.2.2 K-means 算法的计算步骤K-means 聚类算法的步骤为(如图1所示):(1)按一定原则选择n 个对象作为初始的聚类种子;(2)重复执行3、4两步,直到各个簇不再发生变化;(3)根据聚类种子的值,将每个对象重新赋给最相似的簇;(4)更新聚类种子,即重新计算每个簇中对象的平均值,用对象均值点作为新的聚类种子.图1 算法的具体过程Fig.1The procedure of alg orithm7 湖北民族学院学报(自然科学版) 第22卷2.3 K-means 算法的实现输入n 个数据对象集合X i ;输出k 个聚类中心Z j 及K 个聚类数据对象集合Cj.Procedure K-means (s ,k )S ={x 1,x 2,…,x n };m =1;for j =1to k 初始化聚类中心Z j ;do {for i =1to n for j =1to k {D (X i ,Z j )=|X i -Z j|;if D (X i ,Z j )=Min{D (X i ,Z j )}then X i ∈Cj ;}//归类 if m =1then Jc (m )=∑kj =1∑|X i -Z j|2 m =m +1;for j =1to k Z j =(∑ni =1(X i )j )/n ;//重置聚类中心 }while |J c (m )-J c (m -1)|>ξ2.4 K-means 算法性能分析实验表明,如果各簇之间区别明显且数据分布稠密,则误差平方和准则函数比较有效;但是如果各簇的形状和大小差别很大,为使误差平方和Jc 值达到最小,有可能出现将大的聚类簇分割的现象.此外在运用误差平方和准则函数测度聚类效果时,最佳聚类结果对应于目标函数的极值点,由于目标函数存在着许多局部极小点,而算法的每一步都是沿着目标函数减小的方向进行,若初始化落在了一个局部极小点附近,就会造成算法在局部极小处收敛.因此初始聚类中心的随机选取可能会陷入局部最优解,而难以获得全局最优解.采用了基于代表点的处理方法并取得了较优的聚类效果,而对于初值选取影响聚类效果的情况,最简单的措施就是随机选取不同的初始值多次执行该算法,然后选取最好的结果.K-means 算法对于文档集中孤立点很敏感,少量的这类K-means 文档将对聚类结果产生较大的影响.基于划分的聚类算法对存在孤立点的文档集能得到较好的聚类结果.3 总结本文针对K-means 算法在文档聚类过程中对孤立点敏感的问题提出了一种算法,实验表明了该算法的有效性.参考文献:[1]Jiawei Han ,M icheline K amber.Data M ining :C oncepts and T echniques[M].S im on Fraser University ,2000.[2]Alsabti K,Ranka S ,S ingh V.An efficient k -means clustering alg orithm ,IPPS -98[A].Proceedings of the First W orkshop on H igh Performance Date M ining[C].Orlando ,Florida ,US A ,1998.[3]Ester M ,K riegel H P ,Sander J ,et al.A Density -Based Alg orithm for Discovering Clusters in Large S patial Databases with N oise[J ].Proc.2nd Int.C on f.on K nowledge Discovery and Data M ining.P ortland ,1996,20:226~231.An Implementation of Clustering Algorithm B ased on K -meansT AN Y ong 1,RONG Qiu -sheng 2(1.Hubei Institue for Nationalities ,Enshi 445000,China ;2.Hunan University of Arts &Sciences ,Changde 415000,China )Abstract :As one analyzed method in data mining ,clustering alg orithm can find relatively dense regions ,and generalize the regions of swatch.The article analyses localization of the traditional clustering alg orithm ,discusses an im plementation of K-means.The alg orithm can deal with documentation with is olated point.The high accuracy and efficiency of K -means clustering alg orithm are shown in our experiments.K ey w ords :data mining ;clustering ;K-means17第1期 谭 勇等:一个基于K —means 的聚类算法的实现 。