聚类算法在R中的实现

r语言+arcgis自组织映射划分生态系统服务簇代码_概述说明

r语言+arcgis自组织映射划分生态系统服务簇代码概述说明1. 引言1.1 概述本文介绍了使用R语言和ArcGIS进行自组织映射来划分生态系统服务簇的方法和代码示例。

自组织映射(SOM)是一种基于神经网络的机器学习算法,可以以无监督的方式对数据进行聚类分析。

生态系统服务簇划分是指将地理空间上的不同区域归类为属于相似生态系统服务类型的群体,这对于环境保护和资源管理至关重要。

1.2 文章结构本文共分为六个部分。

引言中给出了本文的概述、目的以及文章结构。

第二部分介绍了R语言和ArcGIS的简介,其中包括两者的概述和基本功能。

第三部分详细阐述了自组织映射算法的原理和步骤。

第四部分介绍了生态系统服务簇划分方法,并提供了相关代码示例。

第五部分通过实验数据集介绍了结果与讨论,包括对划分结果的分析和讨论。

最后一部分总结全文,提出进一步研究方向建议。

1.3 目的本文旨在介绍利用R语言和ArcGIS进行自组织映射划分生态系统服务簇的方法和代码示例。

通过本文的阐述,读者可以了解R语言、ArcGIS以及自组织映射算法的基本原理和功能,并学会使用这些工具进行生态系统服务簇划分。

此外,文章还将提供实验数据集和划分结果的分析,帮助读者更好地理解该方法的应用与效果。

以上就是“1. 引言”部分的详细内容,介绍了文章概述、结构以及目的。

2. R语言与ArcGIS简介2.1 R语言概述R语言是一种强大的统计分析编程语言,广泛应用于数据处理、数据可视化、机器学习等领域。

它具有丰富的函数库和包,可以进行各种统计方法的实施和数据模型建立。

由于其开源、免费以及可移植的特性,R语言成为了许多研究者和数据科学家的首选工具。

2.2 ArcGIS概述ArcGIS是一个基于地理信息系统(GIS)的软件平台,集成了地图制作、数据管理、空间分析等功能,被广泛运用于环境科学、城市规划、自然资源管理等领域。

通过ArcGIS,用户可以处理和分析各种空间数据,并生成专业水准的地图和图表。

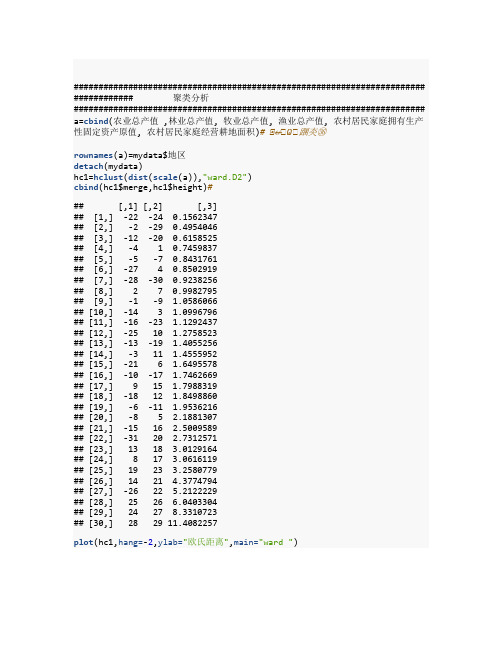

【原创】r语言层次聚类案例附代码数据

####################################################################### ############ 聚类分析####################################################################### a=cbind(农业总产值 ,林业总产值, 牧业总产值, 渔业总产值, 农村居民家庭拥有生产性固定资产原值, 农村居民家庭经营耕地面积)# ⭞↚⭞Ѡ⭞䠅㚐㊱rownames(a)=mydata$地区detach(mydata)hc1=hclust(dist(scale(a)),"ward.D2")cbind(hc1$merge,hc1$height)### [,1] [,2] [,3]## [1,] -22 -24 0.1562347## [2,] -2 -29 0.4954046## [3,] -12 -20 0.6158525## [4,] -4 1 0.7459837## [5,] -5 -7 0.8431761## [6,] -27 4 0.8502919## [7,] -28 -30 0.9238256## [8,] 2 7 0.9982795## [9,] -1 -9 1.0586066## [10,] -14 3 1.0996796## [11,] -16 -23 1.1292437## [12,] -25 10 1.2758523## [13,] -13 -19 1.4055256## [14,] -3 11 1.4555952## [15,] -21 6 1.6495578## [16,] -10 -17 1.7462669## [17,] 9 15 1.7988319## [18,] -18 12 1.8498860## [19,] -6 -11 1.9536216## [20,] -8 5 2.1881307## [21,] -15 16 2.5009589## [22,] -31 20 2.7312571## [23,] 13 18 3.0129164## [24,] 8 17 3.0616119## [25,] 19 23 3.2580779## [26,] 14 21 4.3774794## [27,] -26 22 5.2122229## [28,] 25 26 6.0403304## [29,] 24 27 8.3310723## [30,] 28 29 11.4082257plot(hc1,hang=-2,ylab="欧氏距离",main="ward ")cutree(hc1,3)## 北京天津河北山西内蒙辽宁吉林黑龙江上海江苏## 1 1 2 1 3 2 3 3 1 2## 浙江安徽福建江西山东河南湖北湖南广东广西## 2 2 2 2 2 2 2 2 2 2## 海南重庆四川贵州云南西藏陕西甘肃青海宁夏## 1 1 2 1 2 3 1 1 1 1## 新疆## 3library(NbClust)# 加载包res<-NbClust(a, distance ="euclidean", min.nc=2, max.nc=8,method ="complete", index ="ch")res$All.index## 2 3 4 5 6 7 8## 22.4859 64.2952 95.0505 91.2070 112.2167 126.6607 125.0580res$Best.nc## Number_clusters Value_Index## 7.0000 126.6607res$Best.partition## 北京天津河北山西内蒙辽宁吉林黑龙江上海江苏## 1 2 2 3 4 5 5 4 6 1## 浙江安徽福建江西山东河南湖北湖南广东广西## 5 1 1 3 2 1 3 3 3 1## 海南重庆四川贵州云南西藏陕西甘肃青海宁夏## 1 1 1 1 2 7 1 2 5 5## 新疆## 4####################################################################### ############ 因子分析####################################################################### x=ascale(x,center=T,scale=T)## 农业总产值林业总产值牧业总产值渔业总产值## 北京 -1.22777296 -0.68966546 -1.0576108 -0.717868590## 天津 -1.20072019 -1.32628581 -1.1287831 -0.587405030## 河北 1.44015787 -0.40768816 1.2735925 -0.276307864## 山西 -0.60736290 -0.39313054 -0.8459665 -0.730089499## 内蒙 -0.31173176 -0.16449038 0.3536925 -0.682760278## 辽宁 0.02317599 0.21376291 1.0886323 0.905582647## 吉林 -0.31664133 -0.16033106 0.3705164 -0.661159286## 黑龙江 0.73000004 0.28496065 0.6928325 -0.543827843## 上海 -1.22304555 -1.24358878 -1.1769433 -0.598687930## 江苏 1.32304764 -0.14014613 0.5106958 2.558246143## 浙江 -0.25945707 0.37842297 -0.4799669 1.088655075## 安徽 0.32193142 1.20245730 0.3549653 0.277626262## 福建 -0.22816878 1.77681021 -0.5790521 1.668371030## 江西 -0.46544975 1.43990544 -0.1820088 0.139953438## 山东 2.22835882 -0.05133246 2.0610374 2.643122498## 河南 2.22683767 0.36264203 2.0166955 -0.521101240## 湖北 0.88705181 -0.13647615 0.6684891 0.925656025## 湖南 1.03609706 1.81987138 0.8945726 -0.002409428## 广东 0.65132842 1.36442604 0.3760463 1.697020485## 广西 0.19109441 1.64358969 0.2862654 0.136415807## 海南 -0.95958625 0.32594217 -0.9698633 -0.119446069## 重庆 -0.61246376 -0.82851329 -0.6191076 -0.632081027## 四川 1.13921636 0.49292656 2.0375425 -0.313747797## 贵州 -0.59146827 -0.69749477 -0.6664339 -0.677051827## 云南 -0.10569354 1.40222691 0.0524867 -0.583545796## 西藏 -1.33060989 -1.32909946 -1.1967954 -0.752065694## 陕西 0.01099770 -0.64550329 -0.4072439 -0.713500151## 甘肃 -0.48272891 -1.11489458 -0.9441448 -0.747831257## 青海 -1.27264229 -1.30451055 -1.0825979 -0.751154486## 宁夏 -1.16021392 -1.24089745 -1.1284759 -0.716850181## 新疆 0.14646191 -0.83389594 -0.5730687 -0.711758136## 农村居民家庭拥有生产性固定资产原值农村居民家庭经营耕地面积## 北京 -0.521919855 -0.69519658 ## 天津 -0.036498322 -0.33578982 ## 河北 0.004069841 -0.23262677 ## 山西 -0.824825602 -0.02962851 ## 内蒙 1.179852466 2.59936535## 辽宁 0.730243656 0.39633505## 吉林 0.724094855 1.89053536## 黑龙江 1.396721068 3.65096289## 上海 -1.404513394 -0.77506475 ## 江苏 -0.340308064 -0.44560856 ## 浙江 0.499884752 -0.68188522 ## 安徽 -0.279565363 -0.23262677 ## 福建 -0.618739413 -0.61865625 ## 江西 -0.805278639 -0.33911766 ## 山东 0.133404538 -0.31582278 ## 河南 -0.500048919 -0.32247846 ## 湖北 -0.721961668 -0.29252790 ## 湖南 -0.917381131 -0.45559208 ## 广东 -0.957062704 -0.68521306 ## 广西 -0.615649655 -0.40567447 ## 海南 -0.663204069 -0.58537785 ## 重庆 -0.570175555 -0.43229719 ## 四川 -0.420353046 -0.48221480 ## 贵州 -0.604823220 -0.46890344 ## 云南 0.118332502 -0.32913414 ## 西藏 3.590383141 -0.23262677 ## 陕西 -0.572497480 -0.35575687 ## 甘肃 0.165991341 0.04358397## 青海 0.415065901 -0.25259382 ## 宁夏 0.655330865 0.36638449## 新疆 1.761431173 1.05524743 ## attr(,"scaled:center")## 农业总产值林业总产值## 1514.206129 111.20612 9## 牧业总产值渔业总产值## 877.092581 280.83903 2## 农村居民家庭拥有生产性固定资产原值农村居民家庭经营耕地面积## 17865.076774 2.58903 2## attr(,"scaled:scale")## 农业总产值林业总产值## 1097.854553 81.74416 7## 牧业总产值渔业总产值## 683.552567 373.13101 0## 农村居民家庭拥有生产性固定资产原值农村居民家庭经营耕地面积## 9767.757883 3.00495 2cor(x)### 农业总产值林业总产值牧业总产值## 农业总产值 1.00000000 0.4304367 0.9148545 ## 林业总产值 0.43043666 1.0000000 0.4593615 ## 牧业总产值 0.91485445 0.4593615 1.0000000 ## 渔业总产值 0.51598365 0.4351225 0.4103977 ## 农村居民家庭拥有生产性固定资产原值 -0.16652881 -0.3495913 -0.1017802## 农村居民家庭经营耕地面积 0.04040478 -0.0961515 0.1426829## 渔业总产值## 农业总产值 0.5159836## 林业总产值 0.4351225## 牧业总产值 0.4103977## 渔业总产值 1.0000000## 农村居民家庭拥有生产性固定资产原值 -0.2131248## 农村居民家庭经营耕地面积 -0.2669966## 农村居民家庭拥有生产性固定资产原值## 农业总产值 -0.1665288 ## 林业总产值 -0.3495913 ## 牧业总产值 -0.1017802 ## 渔业总产值 -0.2131248 ## 农村居民家庭拥有生产性固定资产原值 1.0000000 ## 农村居民家庭经营耕地面积 0.5316341 ## 农村居民家庭经营耕地面积## 农业总产值 0.04040478## 林业总产值 -0.09615150## 牧业总产值 0.14268286## 渔业总产值 -0.26699659## 农村居民家庭拥有生产性固定资产原值 0.53163410## 农村居民家庭经营耕地面积 1.00000000FA=factanal(x,3,scores="regression")FA#### Call:## factanal(x = x, factors = 3, scores = "regression")#### Uniquenesses:## 农业总产值林业总产值## 0.134 0.64 9## 牧业总产值渔业总产值## 0.005 0.00 5## 农村居民家庭拥有生产性固定资产原值农村居民家庭经营耕地面积## 0.005 0.61 0#### Loadings:## Factor1 Factor2 Factor3## 农业总产值 0.902 0.231## 林业总产值 0.460 -0.274 0.253## 牧业总产值 0.989 0.100## 渔业总产值 0.335 -0.172 0.924## 农村居民家庭拥有生产性固定资产原值 -0.185 0.980## 农村居民家庭经营耕地面积 0.120 0.569 -0.227#### Factor1 Factor2 Factor3## SS loadings 2.164 1.396 1.032## Proportion Var 0.361 0.233 0.172## Cumulative Var 0.361 0.593 0.765#### The degrees of freedom for the model is 0 and the fit was 0.0338A=FA$loadings#D=diag(FA$uniquenesses)#cancha=cor(x)-A%*%t(A)-Dsum(cancha^2)## [1] 0.01188033FA$scores## Factor1 Factor2 Factor3## 北京 -0.9595745 -0.700059511 -0.55760316## 天津 -1.0947804 -0.236528598 -0.28377148## 河北 1.3398849 0.269241913 -0.72734450## 山西 -0.6949304 -0.952525400 -0.71168863## 内蒙 0.3022926 1.274620864 -0.61477840## 辽宁 0.9086974 0.898645857 0.80686141## 吉林 0.3617131 0.823049845 -0.69568729## 黑龙江 0.6377695 1.558056539 -0.53064438## 上海 -1.0020542 -1.600313046 -0.58279912## 江苏 0.2978404 -0.338175607 2.58332275## 浙江 -0.6586307 0.351125849 1.47562686## 安徽 0.3633716 -0.220261996 0.12915299## 福建 -0.7017677 -0.799773443 1.90201088## 江西 -0.1252221 -0.843258690 0.03964935## 山东 1.8098550 0.433178408 2.27098864## 河南 2.1841524 -0.072629248 -1.35570609## 湖北 0.6625677 -0.618906179 0.64211420## 湖南 1.0200226 -0.733225411 -0.50075826## 广东 0.3057090 -0.945233885 1.54225085## 广西 0.3420343 -0.562216144 -0.07785160## 海南 -0.9131785 -0.847172077 0.04381513## 重庆 -0.5087268 -0.661768675 -0.62025496## 四川 2.1397385 -0.003827953 -1.11031362## 贵州 -0.5463126 -0.703696201 -0.66210885## 云南 0.1044516 0.146947680 -0.63418799## 西藏 -1.5214222 3.342858193 0.36144124## 陕西 -0.2687306 -0.616728372 -0.78286620## 甘肃 -0.8904189 0.010720625 -0.48059064## 青海 -1.0791206 0.225711752 -0.37974261## 宁夏 -1.1481591 0.456190239 -0.27546552## 新疆 -0.6670714 1.665952673 -0.21307102FA=factanal(x,3,scores="regression")#FA#### Call:## factanal(x = x, factors = 3, scores = "regression")#### Uniquenesses:## 农业总产值林业总产值## 0.134 0.64 9## 牧业总产值渔业总产值## 0.005 0.00 5## 农村居民家庭拥有生产性固定资产原值农村居民家庭经营耕地面积## 0.005 0.61 0#### Loadings:## Factor1 Factor2 Factor3## 农业总产值 0.902 0.231## 林业总产值 0.460 -0.274 0.253## 牧业总产值 0.989 0.100## 渔业总产值 0.335 -0.172 0.924## 农村居民家庭拥有生产性固定资产原值 -0.185 0.980## 农村居民家庭经营耕地面积 0.120 0.569 -0.227#### Factor1 Factor2 Factor3## SS loadings 2.164 1.396 1.032## Proportion Var 0.361 0.233 0.172## Cumulative Var 0.361 0.593 0.765#### The degrees of freedom for the model is 0 and the fit was 0.0338 biplot(FA$scores,FA$loadings)######################################################################## ########## 主成分分析####################################################################### # mydata<-read.csv("cosume.csv",header=TRUE)x=aPCA=princomp(x)# 分分析summary(PCA)## Importance of components:## Comp.1 Comp.2 Comp.3 Comp.4## Standard deviation 9611.2440729 1.248877e+03 3.201426e+02 2.211289e+02## Proportion of Variance 0.9817713 1.657641e-02 1.089277e-03 5.1968 75e-04## Cumulative Proportion 0.9817713 9.983477e-01 9.994370e-01 9.9995 67e-01## Comp.5 Comp.6## Standard deviation 6.377898e+01 2.299907e+00## Proportion of Variance 4.323210e-05 5.621753e-08## Cumulative Proportion 9.999999e-01 1.000000e+00plot(PCA)screeplot(PCA,type="lines")# ⻄⭞ഴPCA$loadings##### Loadings:## Comp.1 Comp.2 Comp.3 Comp.4 Comp. 5## 农业总产值 0.847 0.529 ## 林业总产值 -0.994 ## 牧业总产值 0.510 0.340 -0.786 ## 渔业总产值 0.147 -0.939 -0.304 ## 农村居民家庭拥有生产性固定资产原值 1.000 ## 农村居民家庭经营耕地面积## Comp.6## 农业总产值## 林业总产值## 牧业总产值## 渔业总产值## 农村居民家庭拥有生产性固定资产原值## 农村居民家庭经营耕地面积 1.000#### Comp.1 Comp.2 Comp.3 Comp.4 Comp.5 Comp.6## SS loadings 1.000 1.000 1.000 1.000 1.000 1.000## Proportion Var 0.167 0.167 0.167 0.167 0.167 0.167## Cumulative Var 0.167 0.333 0.500 0.667 0.833 1.000diag(1/sqrt(diag(cor(x))))%*%eigen(cor(x))$vectors%*%diag(sqrt(eigen(co r(x))$values))# ⭞⭞䠅фѱᡆ分的⭞ީ⭞䱫## [,1] [,2] [,3] [,4] [,5]## [1,] 0.8748914 0.33002393 -0.05962134 -0.2919961 0.03333473## [2,] 0.7199843 -0.09695761 0.39747812 0.5280225 0.18691501## [3,] 0.8358325 0.42778470 0.06215717 -0.2657004 0.10009450## [4,] 0.7239860 -0.13749802 -0.54651176 0.3113087 -0.24595467## [5,] -0.4283184 0.72257821 -0.37626680 0.2240839 0.32017966## [6,] -0.1942551 0.86197649 0.26492953 0.1648656 -0.34904716## [,6]## [1,] 0.189001599## [2,] 0.022088666## [3,] -0.184133750## [4,] -0.029268951## [5,] 0.010900009## [6,] 0.007698218print(-loadings(PCA),cutoff=0.001)#### Loadings:## Comp.1 Comp.2 Comp.3 Comp.4 Comp. 5## 农业总产值 0.019 -0.847 0.041 -0.529 0.027 ## 林业总产值 0.003 -0.026 0.036 0.096 0.994 ## 牧业总产值 0.007 -0.510 -0.340 0.786 -0.077 ## 渔业总产值 0.008 -0.147 0.939 0.304 -0.068 ## 农村居民家庭拥有生产性固定资产原值 -1.000 -0.021 0.006 -0.002 0.002 ## 农村居民家庭经营耕地面积 -0.003 0.003 ## Comp.6## 农业总产值## 林业总产值 0.003## 牧业总产值 0.001## 渔业总产值 -0.002## 农村居民家庭拥有生产性固定资产原值## 农村居民家庭经营耕地面积 -1.000#### Comp.1 Comp.2 Comp.3 Comp.4 Comp.5 Comp.6## SS loadings 1.000 1.000 1.000 1.000 1.000 1.000## Proportion Var 0.167 0.167 0.167 0.167 0.167 0.167## Cumulative Var 0.167 0.333 0.500 0.667 0.833 1.000####################################################################### ##### 条形图####################################################################### country<-mydata$地区percent<-mydata$农业总产值d<-data.frame(country,percent)# png("d:\\test2.png",width=2048,height=2048)f<-function(name,value) {xsize=200plot(0, 0,xlab="",ylab="",axes=FALSE,xlim=c(-xsize,xsize),ylim=c(-xsize,xsize))for(i in 1:length(name)){info =name[i]percent =value[i]k =(1:(360*percent/100)*10)/10r=xsize*(length(name)-i+1)/length(name)#print(r)x=r*sin(k/180*pi)y=r*cos(k/180*pi)text(-18,r,info,pos=2,cex=0.7)text(-9,r,paste(percent,"%"),cex=0.7)lines(x,y,col="red")}}f(country,percent)####################################################################### ###### 柱状图####################################################################### library(RColorBrewer)pv<-percentid<-countrycol<-c(brewer.pal(9, "YlOrRd")[1:9],brewer.pal(9, "Blues")[1:9]) barplot(pv,col=col,horiz =TRUE,xlim=c(-8000.00,5000))title(main=list("农业总产值",cex=2),sub="",ylab="地区")text(y=seq(from=0.7,length.out=31,by=1.2),x=-450.00,labels=id)legend("topleft",legend=rev(id),pch=10,col=rev(col),ncol=2)。

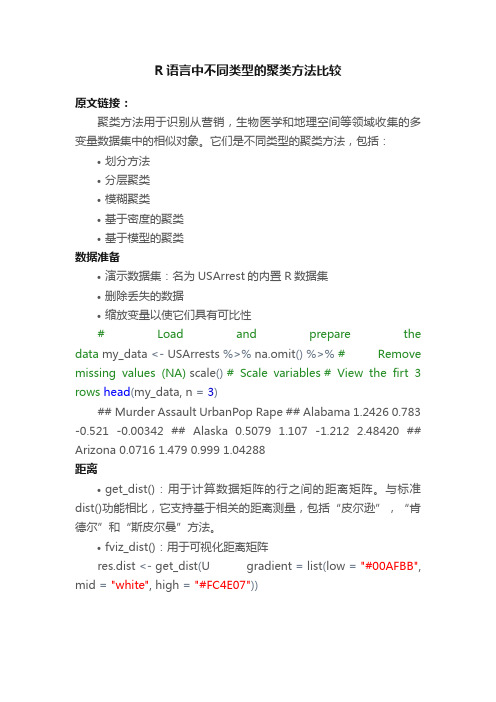

R语言中不同类型的聚类方法比较

R语言中不同类型的聚类方法比较原文链接:聚类方法用于识别从营销,生物医学和地理空间等领域收集的多变量数据集中的相似对象。

它们是不同类型的聚类方法,包括:•划分方法•分层聚类•模糊聚类•基于密度的聚类•基于模型的聚类数据准备•演示数据集:名为USArrest的内置R数据集•删除丢失的数据•缩放变量以使它们具有可比性# Load and prepare the data my_data <- USArrests %>% na.omit()%>%# Remove missing values (NA) scale()# Scale variables# View the firt 3 rows head(my_data, n =3)## Murder Assault UrbanPop Rape ## Alabama 1.2426 0.783 -0.521 -0.00342 ## Alaska 0.5079 1.107 -1.212 2.48420 ## Arizona 0.0716 1.479 0.999 1.04288距离•get_dist():用于计算数据矩阵的行之间的距离矩阵。

与标准dist()功能相比,它支持基于相关的距离测量,包括“皮尔逊”,“肯德尔”和“斯皮尔曼”方法。

•fviz_dist():用于可视化距离矩阵res.dist <- get_dist(U gradient = list(low ="#00AFBB", mid ="white", high ="#FC4E07"))划分聚类、算法是将数据集细分为一组k个组的聚类技术,其中k是分析人员预先指定的组的数量。

k-means聚类的替代方案是K-medoids聚类或PAM (Partitioning Around Medoids,Kaufman和Rousseeuw,1990),与k-means相比,它对异常值不太敏感。

动态K-均值聚类算法在RBF神经网络中心选取中的应用

确定隐含层各节点的变换 函数的 中心C和半径 P ;二是 j j

采用误差校正学习算法 ,调节输 出层的权w 。其 目的就

内 ,从而不能分配到该类别 中去。此时 ,应该 以x‘ 为

中心,分配—个新的聚类中心 ,算法流程图如图2 所示。

8 4

信 息 系统 工程 I2 1..0 0 16 2

等于其与属于该类 的训练样本之间的平均距离 ,即:

p =1∑( 一 , (‘ C) , ‘ C) 一

1 x… E

() 5

[ Ko Go isM i n aR. ua NewokL a igT er 4 yA, vl , r d A Ne r t r er n h oy ] a l n a d a oy o a Ti n P ln mil meRBFAlo i m[ . E a sOlNe rl g r h J I E Trn .i t 】E ua

i1 =

() 3

其 中M是输 入 向量 的 维数 。

设输入 向量X ( P)和所有 已分配 的模式类别之间 的距 离 已知 ,且 和该输入矢 量最 近 的中心为c ,应 有 k d=lx - kl l 一 j ,j l o l C <l l x C I = ,… ,T J k l , ≠ 其 中T 是已分配类别 的数 目。 在确定 了与输人矢量最 近的 中心后 ,k 已经确定 就 了 ,从 而d 也就确定 了。先把它和距离 门限值 p 0 进行 比 较 ,会有如下两种情况 : () 。 1当d<P时 ,输入矢 量X I’ 允许 的误差 范 围 在 p 内 ,该 输入矢量属 于第k 个类别 。也就 是说 ,如果用S 表示第K 中心所对应 的全部输入矢量的集合 ,则x【 个 p

《数据挖掘实验》---K-means聚类及决策树算法实现预测分析实验报告

实验设计过程及分析:1、通过通信企业数据(USER_INFO_M.csv),使用K-means算法实现运营商客户价值分析,并制定相应的营销策略。

(预处理,构建5个特征后确定K 值,构建模型并评价)代码:setwd("D:\\Mi\\数据挖掘\\")datafile<-read.csv("USER_INFO_M.csv")zscoredFile<- na.omit(datafile)set.seed(123) # 设置随机种子result <- kmeans(zscoredFile[,c(9,10,14,19,20)], 4) # 建立模型,找聚类中心为4round(result$centers, 3) # 查看聚类中心table(result$cluster) # 统计不同类别样本的数目# 画出分析雷达图par(cex=0.8)library(fmsb)max <- apply(result$centers, 2, max)min <- apply(result$centers, 2, min)df <- data.frame(rbind(max, min, result$centers))radarchart(df = df, seg =5, plty = c(1:4), vlcex = 1, plwd = 2)# 给雷达图加图例L <- 1for(i in 1:4){legend(1.3, L, legend = paste("VIP_LVL", i), lty = i, lwd = 3, col = i, bty = "n")L <- L - 0.2}运行结果:2、根据企业在2016.01-2016.03客户的短信、流量、通话、消费的使用情况及客户基本信息的数据,构建决策树模型,实现对流失客户的预测,F1值。

基于RFM模型对客户价值分析研究

基于 RFM模型对客户价值分析研究摘要:为了给客户提供差异化服务和有针对性的营销,电商们会把客户分成不同的群体。

RRFM模型是对客户价值评估所应用的模型中最广泛的一种。

首先介绍了RMF模型和k-means聚类的相关概念,然后通过一些算法计算出RFM各项指标,运用k-means聚类算法实现按客户价值分类,最后对每个客户群进行特征分析,分析其价值。

关键词:RFM模型;聚类分析;k-means算法;客户分类1引言随着网络信息技术迅速发展,跟我们日常生活息息相关的各种数据都在不断增长,这些数据中隐藏着巨大商机,仅靠人工处理这些数据已经远远不够,所以需要通过计算机来进行数据的分析和处理。

随着人工智能、大数据以及5G时代的到来,对数据的处理方面带来了便利。

通过对数据进行有效的分析,找到对管理者判断、决策有价值的分析结果,决定着是否在发展中占得先机。

尤其在竞争日益激烈的电商中,面向客户需要制定运个性化营销策略,实现精准化运营,以期获取最大的转化率。

精准化运营的前提是客户关系管理,而客户关系管理的核心是客户分类。

孙瑛等人基于RFM模型以及聚类分析方法,提供了一种以忠诚度为基础对客户进行划分的方法[1]。

RFM模型在客户分类中是一个经典的分类模型,是衡量客户价值和客户潜在价值的重要工具和手段。

主要由R(最近消费时间间隔Recency)、F(消费频率Frequency)和M(消费金额Monetary)3个指标构成[2]。

R表示最近消费时间间隔,主要判断客户对店铺的记忆强度。

R越大表示客户越久没有进行交易,有流失的可能性;R越小表示客户越近进行交易。

F表示一段时间内的客户消费次数,主要判断客户品牌的忠诚度、对店铺的熟悉度、购买习惯等。

F越大表示客户交易越频繁,对店铺商品的认同度越高。

F越小表示客户不够活跃。

M表示客户每次的消费金额。

根据帕累托规则,一个公司的80%的收入都是由20%的客户贡献的,所以每次消费金额较大的客户是较为优质的客户。

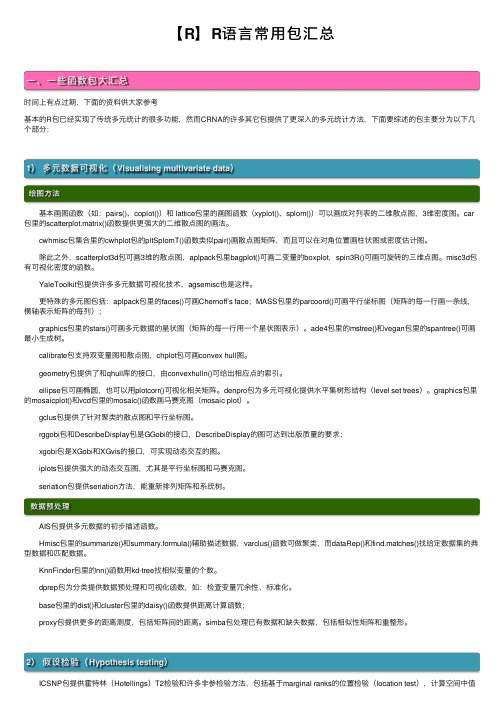

【R】R语言常用包汇总

【R】R语⾔常⽤包汇总⼀、⼀些函数包⼤汇总时间上有点过期,下⾯的资料供⼤家参考基本的R包已经实现了传统多元统计的很多功能,然⽽CRNA的许多其它包提供了更深⼊的多元统计⽅法,下⾯要综述的包主要分为以下⼏个部分:1)多元数据可视化(Visualising multivariate data)绘图⽅法 基本画图函数(如:pairs()、coplot())和 lattice包⾥的画图函数(xyplot()、splom())可以画成对列表的⼆维散点图,3维密度图。

car 包⾥的scatterplot.matrix()函数提供更强⼤的⼆维散点图的画法。

cwhmisc包集合⾥的cwhplot包的pltSplomT()函数类似pair()画散点图矩阵,⽽且可以在对⾓位置画柱状图或密度估计图。

除此之外,scatterplot3d包可画3维的散点图,aplpack包⾥bagplot()可画⼆变量的boxplot,spin3R()可画可旋转的三维点图。

misc3d包有可视化密度的函数。

YaleToolkit包提供许多多元数据可视化技术,agsemisc也是这样。

更特殊的多元图包括:aplpack包⾥的faces()可画Chernoff’s face;MASS包⾥的parcoord()可画平⾏坐标图(矩阵的每⼀⾏画⼀条线,横轴表⽰矩阵的每列); graphics包⾥的stars()可画多元数据的星状图(矩阵的每⼀⾏⽤⼀个星状图表⽰)。

ade4包⾥的mstree()和vegan包⾥的spantree()可画最⼩⽣成树。

calibrate包⽀持双变量图和散点图,chplot包可画convex hull图。

geometry包提供了和qhull库的接⼝,由convexhulln()可给出相应点的索引。

ellipse包可画椭圆,也可以⽤plotcorr()可视化相关矩阵。

denpro包为多元可视化提供⽔平集树形结构(level set trees)。

用R语言实现对不平衡数据的四种处理方法

用R语言实现对不平衡数据的四种处理方法在对不平衡的分类数据集进行建模时,机器学习算法可能并不稳定,其预测结果甚至可能是有偏的,而预测精度此时也变得带有误导性。

那么,这种结果是为何发生的呢?到底是什么因素影响了这些算法的表现?在不平衡的数据中,任一算法都没法从样本量少的类中获取足够的信息来进行精确预测。

因此,机器学习算法常常被要求应用在平衡数据集上。

那我们该如何处理不平衡数据集?本文会介绍一些相关方法,它们并不复杂只是技巧性比较强。

本文会介绍处理非平衡分类数据集的一些要点,并主要集中于非平衡二分类问题的处理。

一如既往,我会尽量精简地叙述,在文末我会演示如何用R中的ROSE包来解决实际问题。

什么是不平衡分类不平衡分类是一种有监督学习,但它处理的对象中有一个类所占的比例远远大于其余类。

比起多分类,这一问题在二分类中更为常见。

(注:下文中占比较大的类称为大类,占比较小的类称为小类)不平衡一词指代数据中响应变量(被解释变量)的分布不均衡,如果一个数据集的响应变量在不同类上的分布差别较大我们就认为它不平衡。

举个例子,假设我们有一个观测数为100000的数据集,它包含了哈佛大学申请人的信息。

众所周知,哈佛大学以极低的录取比例而闻名,那么这个数据集的响应变量(即:该申请人是否被录取,是为1,否为0)就很不平衡,大致98%的观测响应变量为0,只有2%的幸运儿被录取。

在现实生活中,这类例子更是不胜枚举,我在下面列举了一些实例,请注意他们的不平衡度是不一样的。

1.一个自动产品质量检测机每天会检测工厂生产的产品,你会发现次品率是远远低于合格率的。

2.某地区进行了居民癌症普查,结果患有癌症的居民人数也是远远少于健康人群。

3.在信用卡欺诈数据中,违规交易数比合规交易少不少。

4.一个遵循6δ原则的生产车间每生产100万个产品才会产出10个次品。

生活中的例子还有太多,现在你可以发现获取这些非平衡数据的可能性有多大,所以掌握这些数据集的处理方法也是每个数据分析师的必修课。

r语言中pam函数

r语言中pam函数

pam函数是R语言中用于执行基于

partioningaroundmedoids(PAM)算法的函数。

PAM算法是一种基于贪心策略的聚类算法,它通过选择一组代表性对象(即medoids)来划分数据集。

PAM算法的核心思想是在给定数据集上寻找一组对象,使得这些对象与其他对象的平均距离最小。

在R语言中,pam函数可以用于执行PAM算法并生成聚类结果。

该函数接受多个参数,包括数据集、聚类数和距离度量等。

pam函数返回一个类别列表,其中每个元素表示一个聚类,并包含该聚类的代表性对象列表。

除了聚类结果外,pam函数还可以返回一些有关聚类质量的统计信息,例如每个类别的平均距离和总误差平方和等。

这些信息可以用于评估聚类的质量,并确定最佳聚类数。

总之,pam函数是R语言中一种有效的聚类算法实现方式,它可以帮助用户快速准确地执行PAM算法,并生成高质量的聚类结果。

- 1 -。

多元统计分析——基于R 语言 PPT课件-聚类分析

(1)把样品粗略分成K个初始类。

(2)进行修改,逐个分派样品到其最近均值类中(通常用标准化数据或非标准化数据计算欧氏距

离)。重新计算接受新样品的类和失去样品的类的形心(均值)。

(3)重复第2步,直到各类无元素进出。

注意:

样品的最终聚类在某种程度上依赖于最初的划分或种子点的选择。

为了检验聚类的稳定性,可用一个新的初始分类重新检验整个聚类算法。如果最终分类与原来

✓有序样品的聚类:n个样品按某种原因(时间、地层深度等)排成次序,必须是

次序相邻的样品才能聚成一类。

✓分解法:首先所有的样品均在一类,然后用某种最优准则将它分为两类,再试

图用同种准则将这两类各自分裂为两类,从中选一个使目标函数较好者,这样

由两类变成三类,如此下去,一直分裂到每类只有一个样品为止(或采用其他停

1. 可能的分类数目

′

对于有序样品,n个样品分成k类的一切可能的分法有: , =

−

−

2. 最优分割法(又称Fisher算法)

(1)定义类的直径

设某一类 是{ , +1 , … , }( > ),均值为ഥ

,ഥ

=

σ= 。

−+

(2)定义目标函数

= ≤≤ { − , − + , }

当我们要分k类时,首先找 使上式达到最小,即

(2)最长距离法: , = max{ | ∈ , ∈ },表示类 与类 最邻近的两个样本距

离。

定义

(3)类平均法: , =

σ∈ σ∈

,表示类 与类 任两个样品距离的平均。

(4)重心法: , = ഥpഥ ,表示两个重心ഥ

r软件聚类分析课程设计

r软件聚类分析课程设计一、课程目标知识目标:1. 理解聚类分析的基本概念、原理及在R软件中的实现方法;2. 学会使用R软件进行数据预处理、聚类分析及结果解读;3. 掌握不同聚类算法(如K-means、层次聚类等)的优缺点及适用场景。

技能目标:1. 能够独立操作R软件进行聚类分析,并对结果进行可视化展示;2. 能够根据实际数据特点选择合适的聚类算法,调整相关参数,优化分析结果;3. 能够运用聚类分析结果对实际问题进行解释和阐述。

情感态度价值观目标:1. 培养学生对数据科学和R软件的兴趣,激发主动学习的热情;2. 培养学生的团队合作意识,学会在团队中分享、交流、协作;3. 培养学生严谨的科学态度,注重数据分析的客观性和准确性。

课程性质:本课程为高年级数据分析相关课程,旨在通过R软件聚类分析的学习,提高学生的数据分析能力,培养学生解决实际问题的能力。

学生特点:学生具备一定的统计学和R软件基础,对数据分析有一定了解,具备独立思考和解决问题的能力。

教学要求:结合学生特点和课程性质,注重理论与实践相结合,强调学生在实际操作中掌握聚类分析方法,并能应用于实际问题。

在教学过程中,关注学生的学习反馈,及时调整教学策略,确保课程目标的实现。

通过课程学习,使学生具备独立进行聚类分析的能力,为后续学习和工作打下坚实基础。

二、教学内容1. 聚类分析基本概念与原理- 聚类分析的分类及各自特点- 聚类分析的数学原理及算法流程2. R软件基础操作与数据预处理- R软件的基本操作与数据导入- 数据清洗、整理与转换3. 常用聚类算法及其R实现- K-means算法及其R实现- 层次聚类算法及其R实现- DBSCAN算法及其R实现4. 聚类结果可视化与评估- 聚类结果的可视化方法- 聚类效果的评估指标与优化方法5. 聚类分析在实际案例中的应用- 选择合适的数据集进行聚类分析- 根据实际需求调整聚类算法与参数- 案例分析与结果解读教学内容安排与进度:1. 第1周:聚类分析基本概念与原理2. 第2周:R软件基础操作与数据预处理3. 第3-4周:常用聚类算法及其R实现4. 第5周:聚类结果可视化与评估5. 第6周:聚类分析在实际案例中的应用教材章节关联:1. 《统计学》第十章:聚类分析2. 《R语言实战》第四章:数据处理与可视化3. 《数据挖掘与机器学习》第六章:聚类分析方法三、教学方法本课程将采用以下教学方法,旨在激发学生的学习兴趣,提高学生的主动参与度和实践能力:1. 讲授法:通过系统的讲解,使学生掌握聚类分析的基本概念、原理和算法流程。

层次聚类算法r语言

层次聚类算法r语言在R语言中,层次聚类可以使用hclust函数来实现,该函数在stats包中。

以下是一个基本的层次聚类算法的实现示例:r复制代码# 加载必要的库library(stats)# 创建一些数据set.seed(123) # 为了可重复的结果data <- rbind(matrix(rnorm(2 * 50), nc = 2),matrix(rnorm(2 * 50, mean = 3), nc = 2))# 计算数据之间的距离dist_matrix <- dist(data)# 使用完全链接法进行层次聚类hc <- hclust(dist_matrix, method = "complete")# 绘制树状图plot(hc)# 切割树状图以获取聚类结果clusters <- cutree(hc, k = 2) # k是你想要的聚类数量# 打印聚类结果print(clusters)在这个示例中,我们首先创建了一个包含两个类别的数据集。

然后,我们使用dist函数计算数据点之间的距离。

接下来,我们使用hclust函数和完全链接法(也称为最远邻居法)进行层次聚类。

最后,我们使用plot函数绘制出树状图,并使用cutree函数将树状图切割为两个聚类。

注意,method参数在hclust函数中用于指定链接方法。

除了"complete"(完全链接法)之外,还可以使用"single"(单链接法)、"average"(平均链接法)、"centroid"(质心链接法)和"ward"(Ward方差最小化法)等方法。

cutree函数中的k参数用于指定你想要的聚类数量。

你可以根据需要调整这个参数。

以上就是在R语言中实现层次聚类的一个基本示例。

具体的实现可能会根据你的数据和需求有所不同。

使用R进行数据挖掘和机器学习实战案例

使用R进行数据挖掘和机器学习实战案例引言在当今信息时代,大量的数据被生成和存储,这些数据蕴含了丰富的信息和价值。

然而,如何从这些海量数据中提取有用的信息仍然是一个具有挑战性的问题。

数据挖掘和机器学习技术的出现,为我们解决这个问题提供了一条可行的道路。

本文将使用R 语言为工具,介绍数据挖掘和机器学习的实战案例,并分为三个章节:数据预处理、数据挖掘和机器学习。

第一章:数据预处理在数据挖掘和机器学习之前,必须进行数据预处理,以清洗和准备数据,使其适合后续的分析和建模。

数据预处理步骤通常包括数据清洗、特征选择、特征缩放和数据转换等。

在R中,我们可以使用各种包和函数来处理数据。

例如,使用dplyr包可以对数据进行清洗和整理,使用tidyverse包可以进行特征选择,使用caret包可以进行特征缩放,使用reshape2包可以进行数据转换等。

通过这些功能强大的工具,我们可以在数据挖掘和机器学习之前对数据进行必要的预处理。

第二章:数据挖掘在数据预处理完成之后,接下来是数据挖掘的过程。

数据挖掘旨在发现数据背后的隐藏模式和关联规则,并提取有用的信息。

在R中,我们可以使用多种算法进行数据挖掘,如聚类分析、关联规则挖掘、时间序列分析等。

对于聚类分析,我们可以使用k-means算法、层次聚类算法等,在R中可以通过cluster包和stats包来实现。

关联规则挖掘可以使用Apriori算法和FP-Growth算法,在R中可以通过arules包和arulesSequences包来实现。

时间序列分析可以使用ARIMA模型和自回归平均滑动模型,在R中可以通过forecast包和stats包来实现。

通过这些算法和相应的R包,我们可以在数据中发现有用的模式和规律。

第三章:机器学习数据挖掘的结果往往是为了解决实际的问题或做出预测。

而机器学习就是通过利用数据的模式和规律来训练模型,并使用这些模型来做出预测或分类。

在R中,有许多机器学习算法和相应的包可以供我们选择。

r语言k均值聚类代码

r语言k均值聚类代码1.引言1.1 概述在数据分析和机器学习领域中,聚类是一种常用的数据分析方法。

K 均值聚类算法是一种常见的聚类算法,它能够将数据集中的样本划分为K 个不同的类别,每个类别中的样本互相之间的相似度较高,而不同类别之间的相似度较低。

K均值聚类算法的原理比较简单,它通过迭代的方式将所有样本点划分为K个类别。

在每一次迭代中,算法通过计算每个样本点与K个聚类中心的距离,将样本点划分到与其距离最近的类别中。

然后,更新每个类别的聚类中心,再次进行下一轮的样本点划分。

迭代过程会不断进行,直到聚类中心不再发生变化或达到设定的迭代次数。

R语言是一款广泛使用的数据分析和统计建模工具,它提供了丰富的聚类算法库和函数。

在R语言中,使用K均值聚类算法进行数据的聚类十分方便。

本文将介绍如何使用R语言中的K均值聚类代码进行数据聚类操作,包括数据准备和具体的K均值聚类代码示例。

本文的目的是为读者提供使用R语言进行K均值聚类的基本知识和实践操作指导,帮助读者快速上手使用K均值聚类算法进行数据的聚类分析。

通过本文的学习,读者将能够理解K均值聚类算法的原理、掌握使用R语言进行K均值聚类的步骤和技巧,进而能够将此算法应用于自己的数据分析和研究工作中。

在接下来的章节中,我们将首先介绍K均值聚类算法的原理和步骤。

然后,我们会详细讲解R语言中的K均值聚类代码,包括数据准备和聚类代码示例。

最后,我们将总结本文的内容并探讨K均值聚类算法的研究意义。

让我们一起开始学习使用R语言进行K均值聚类吧!1.2 文章结构文章结构部分的内容可以包括以下方面:文章的结构是为了清晰地展示和组织内容,使读者能够更好地理解和消化所阐述的主题。

本文将按照以下结构进行展开:首先,在引言部分,会给出本文的概述,简单介绍文章的主要内容和要解决的问题。

随后,会说明文章的结构,介绍各个章节的主要内容。

接着,在正文部分,主要分为两个章节。

第一个章节是对K均值聚类算法的介绍,包括其原理和步骤。

三种常见的聚类算法的python实现kmeans、Hierarchicalclusteri。。。

三种常见的聚类算法的python实现kmeans、Hierarchicalclusteri。

聚类是机器学习、数据挖掘相关的⼀类很常见的问题。

关于聚类算法的介绍这⾥就不多写了,因为⽆论是教科书还是⽹络上都有太多的资料了。

这⾥,⽤⼀个《Programming Collective Intelligence》中的聚类例⼦,写⼏个经典聚类算法的实现,分别是hierachiclaCluster、kmeans、kmedoids。

另外,最近⼀直在看数据挖掘、⾃然语⾔处理相关的东西,通过看资料发现有些东西很好理解,但是长时间不⽤的话,过⼀段时间就忘记得差不多了。

其实换个⾓度想,也是⾃⼰对这些东西理解得不深刻。

我觉得踏踏实实的实现这些算法是必要的,因为在实现过程中,我们可以发现哪些地⽅是算法的核⼼思想,哪些地⽅是性能瓶颈,这也为进⼀步优化提供了基础。

问题背景及数据集:blog的聚类。

如何判断两个blog是相似的呢?由于相关的博客的主题内容应该是相同的,即会出现很多相同的词。

于是我们为每个blog定义⼀个向量,该向量的维度为数据集中所有出现的不同词的个数,向量的值为对应词出现的次数。

判断两个向量间的相似性,我们使⽤算法。

测试数据集描述:数据集,该数据集第⼀⾏包含所有数据集中出现的不同词,共有m个,剩下所有⾏,每⼀⾏对应⼀篇blog,共m+1列,⽤tab分开。

第⼀列为博客名,接下来m列为⼀个向量,代码每个词出现的次数。

接下来就聚类吧~Hierachical clustering :维基百科:kmeans clustering :维基百科:kmedoids clustering :维基百科:虽然上⾯三种算法都很好理解,但是这都是基础算法,要想深⼊,还有很多很多相关问题需要解决,⽐如k如何设置;随机选取初始点的问题等等,⽽且如何选取好⽤的聚类算法也值得商榷。

github代码位置:clusterBase.py ⽤来导⼊数据from math import sqrtdef importData(FIFE = 'blogdata.txt') :blogwords = []blognames = []f = open(FIFE, 'r')words = f.readline().split()#//remove '\r\n'for line in f:blog = line[:-2].split('\t')blognames.append(blog[0])blogwords.append([int(word_c) for word_c in blog[1:]] )return blogwords,blognamesdef pearson_distance(vector1, vector2) :"""Calculate distance between two vectors using pearson methodSee more : /wiki/Pearson_product-moment_correlation_coefficient"""sum1 = sum(vector1)sum2 = sum(vector2)sum1Sq = sum([pow(v,2) for v in vector1])sum2Sq = sum([pow(v,2) for v in vector2])pSum = sum([vector1[i] * vector2[i] for i in range(len(vector1))])num = pSum - (sum1*sum2/len(vector1))den = sqrt((sum1Sq - pow(sum1,2)/len(vector1)) * (sum2Sq - pow(sum2,2)/len(vector1)))if den == 0 : return 0.0return 1.0 - num/denhierachiclaCluster.py注意distances字典的使⽤,可以减少⼤量重复的计算另外这个聚类算法,最终⽣成的是⼀颗树形结构。

基于最小聚类单元的聚类算法研究及其在CRM中的应用

化Ⅲ。

2 MC C算 法及 数据 结构描 述

2 1 M0 . C算 法 中的 几 个 定 义

定义 1 设 G为数据 对象的集合 , 共有 m 个元 素 , 给定 阈

值T >O 对 G 中任一个元素 g ,:12 … , 它到 中心 点的 , , , m,

欧 几 里 得距 离 d T, 称 G 为 网格 。一 个 网 格 也 可 用 一 个 ≤ 则

( o g ig I tt t fTehn lg Ch n qn nsiu eo c oo y,Cho gqn 0 0 0) n ig4 0 5

Ab ta t Th l se i e h i u fd t n n a src ec u t r g n t c nq eo a a mi ig c n i r v h ea i n h p b t e n e p iea d c s o r ,f r — mp o e t er lt s i e we n e t r rs n u t me s o e o c s h r n n e a ir O s p o t e p e Sd cso a t e te d a d b h v o st u p r o l ’ e i in,o t i r e i l y t p p i z ma k t m e g o c n p i .Th d a tg sa d d s d a t g s ea v n a e n ia v n a e o me n n rd c u t rn lo i m r i e is ,t e e c u t rn lo i m a e n M i i u l s e i g fK- a sa d g i l s e ig a g rt h a eg v n fr t h n a n w l se ig a g rt h b s d o n m m C u trn C l M CC) i p ee tda d a ay e el( s r sn e n n lz d,whc spo e Ob o rc ,efce ta d fs ho g p la in i ihi r v d t ec re t fiin n a tt ru ha pi to nCRM . c Ke wo d Da a mi i ,Cl s e i ,k me n l se i ,Grd y rs t n n g u t rn g - a sc u t rn g i ,CRM

dbscan聚类算法matlab代码

dbscan聚类算法matlab代码这是一个dbscan聚类算法的matlab代码,运行环境为matlabR2010a:% dbscan聚类算法% 输入:% X 简单点周围扩展点的数据集% eps 点之间的最小距离% minpts 简单点的最小个数% 输出:% C 类别索引% 功能:% 使用的dbscan聚类算法function C = dbscan(X, eps, minpts)% 初始化C = zeros(size(X,1),1);% 计算圆形区域内的数据点k = 0;for i = 1:size(X,1)if ~any(C == i)D = dist(X(i,:),X);% 搜索圆形区域内的数据点Id = find(D <= eps);if length(Id) < minptsC(i) = 0;elsek = k+1;G = regiongrow(X,Id,i);C(G) = k;endendendend% 计算点之间的欧式距离function D = dist(a,b)D = sqrt(sum((a-b).^2));end% regiongrow函数function G = regiongrow(X,Id,i) G = Id;% 搜索邻域并将新点加入while trueL = length(G);for j = 1:L% 搜索G中点的邻域D = dist(X(G(j),:),X);% 找出G中点的邻域内未被选中的点 Id2 = find(D <= eps);% 把未被选中的点加入到G中for k = 1:length(Id2)if ~any(G == Id2(k))G = [G Id2(k)];endendend% 如果G的长度没有变化,则退出循环 if L == length(G)breakendendend。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

• Most of the packages listed in this CRAN Task View, but not all are distributed under the GPL. Please have a look at the DESCRIPTION file of each package to check under which license it is distributed.

• • • • • • • • • • •

Partitioning Clustering: Function kmeans() from package stats provides several algorithms for computing partitions with respect to Euclidean distance. Function pam() from package cluster implements partitioning around medoids and can work with arbitrary distances. Function clara() is a wrapper to pam() for larger data sets. Silhouette plots and spanning ellipses can be used for visualization. Package apcluster implements Frey's and Dueck's Affinity Propagation clustering. The algorithms in the package are analogous to the Matlab code published by Frey and Dueck. Package clusterSim allows to search for the optimal clustering procedure for a given dataset. Package evclust implements various clustering algorithms that produce a credal partition, i.e., a set of DempsterShafer mass functions representing the membership of objects to clusters. Package flexclust provides k-centroid cluster algorithms for arbitrary distance measures, hard competitive learning, neural gas and QT clustering. Neighborhood graphs and image plots of partitions are available for visualization. Some of this functionality is also provided by package cclust. Package kernlab provides a weighted kernel version of the k-means algorithm by kkmeans and spectral clustering by specc. Package kml provides k-means clustering specifically for longitudinal (joint) data. Package skmeans allows spherical k-Means Clustering, i.e. k-means clustering with cosine similarity. It features several methods, including a genetic and a simple fixed-point algorithm and an interface to the CLUTO vcluster program for clustering high-dimensional datasets. Package trimcluster provides trimmed k-means clustering. Package tclust also allows for trimmed k-means clustering. In addition using this package other covariance structures can also be specified for the clusters.

• • • • • • • •

•

• •

Hierarchical Clustering: Functions hclust() from package stats and agnes() from cluster are the primary functions for agglomerative hierarchical clustering, function diana() can be used for divisive hierarchical clustering. Faster alternatives to hclust() are provided by the packages fastcluster and flashClust. Function dendrogram() from stats and associated methods can be used for improved visualization for cluster dendrograms. The dendextend package provides functions for easy visualization (coloring labels and branches, etc.), manipulation (rotating, pruning, etc.) and comparison of dendrograms (tangelgrams with heuristics for optimal branch rotations, and tree correlation measures with bootstrap and permutation tests for significance). Package dynamicTreeCut contains methods for detection of clusters in hierarchical clustering dendrograms. Package genie implements a fast hierarchical clustering algorithm with a linkage criterion which is a variant of the single linkage method combining it with the Gini inequality measure to robustify the linkage method while retaining computational efficiency to allow for the use of larger data sets. hybridHclust implements hybrid hierarchical clustering via mutual clusters. Package isopam uses an algorithm which is based on the classification of ordination scores from isometric feature mapping. The classification is performed either as a hierarchical, divisive method or as non-hierarchical partitioning. The package protoclust implements a form of hierarchical clustering that associates a prototypical element with each interior node of the dendrogram. Using the package's plot() function, one can produce dendrograms that are prototype-labeled and are therefore easier to interpret. pvclust is a package for assessing the uncertainty in hierarchical cluster analysis. It provides approximately unbiased p-values as well as bootstrap p-values. Package sparcl provides clustering for a set of n observations when p variables are available, where p >> n . It adaptively chooses a set of variables to use in clustering the observations. Sparse K-means clustering and sparse hierarchical clustering are implemented.

聚类算法在R中的实现

• • • • •

CRAN Task View: Cluster Analysis & Finite Mixture Models Maintainer: Friedrich Leisch and Bettina Gruen Contact: Bettina.Gruen at jku.at Version: 2016-05-29 This CRAN Task View contains a list of packages that can be used for finding groups in data and modeling unobserved cross-sectional heterogeneity. Many packages provide functionality for more than one of the topics listed below, the section headings are mainly meant as quick starting points rather than an ultimate categorization. Except for packages stats and cluster (which ship with base R and hence are part of every R installation), each package is listed only once.