BWFS文件系统与Qstar兼容性测试环境搭建步骤

Veritas_cluster_安装说明

Veritas HA/cluster软件安装说明目录一.简介1.V eritas Cluster Server(或quickstart)二.使用说明1.软件安装前的准备和说明2.软件的安装3.初步配置VCS一.简介1.Veritas Cluster ServerV eritas Cluster Server是一个高可用管理软件,它应用于一组服务器中为用户应用提供安全保障。

具体的讲,VCS保证应用在一台服务器上故障时,可以快速地切换到另一台服务器上,从而,提供应用和数据的高可用性。

V eritas Cluster Server具有如下特点:●可实现32节点系统的应用切换。

●切换速度快( <10秒)●完全GUI图形界面,简单易用●完全实现多应用多级切换(应用级切换 ),适用多种应用并存的系统。

某一应用的切换可以不对其它应用产生影响●远程PC监控界面和管理界面,便于无人值守的应用需求●与 Veritas file system 结合,提供高速的切换●与 Veritas Netbackup结合,提供备份系统的热备份●拥有多种应用的agent(web server、IP、数据库、多网卡、NFS、文件系统、disk、进程、SNMP、Netbackup、HSM、文件),适用领域相当广泛。

●用户可以自由定制agent,适应特殊应用。

●故障报警机制,全局网络管理。

●应用故障后,可以在本地重试,确保排除偶然因素。

二. 使用说明1.软件安装前的准备和说明●安装cluster server的操作系统平台是solaris8,RAM至少是128M。

在根目录下必须有/opt文件夹。

●必须在两主机的根目录下有.rhosts文件,此文件的内容是+即可。

●两主机的心跳线必须安装接通。

两主机的外网口保持互连相同。

●在两主机的/etc/hosts文件上必须有对方主机名的解析。

●在两主机上的/etc/hosts文件中配置四块网卡的IP地址,类似如下:#s1127.0.0.1 localhost192.168.2.31 s1 loghost192.168.3.31 s11172.16.2.31 heartbeats1-0172.16.3.31 heartbeats1-1#r1192.168.2.32 r1192.168.3.32 r11172.16.2.32 heartbeatr1-0172.16.3.32 heartbeatr1-1●在/etc/netmasks中加入四个网段的掩码, 类似如下:192.168.2.0 255.255.255.0192.168.3.0 255.255.255.0172.16.2.0 255.255.255.0172.16.3.0 255.255.255.0●在/etc下创建下列四个文件:hostname.eri0 (其内容是:s1)hostname.hme2hostname.hme0hostname.hme1●一般安装的顺序是先安装操作系统,然后是volume manager,然后是cluster,然后是sybase和其他的应用程序。

北斗-全球卫星导航系统(GNSS)测量型天线性能要求及测试方法

linux lvfs 开发流程

LVFS(Linux Vendor Firmware Service)是一个用于分发固件更新给Linux 发行版的开源服务。

它的开发流程并不直接涉及创建或管理逻辑卷(Logical Volume,简称LV),后者是LVM(Logical Volume Manager)的功能。

但这里假设你提到的是在Linux环境下通过LVFS进行固件更新的开发和发布流程,以下是简化的步骤:1. 注册贡献者账号:开发商首先需要在LVFS网站上注册一个账号并验证身份,以便提交固件。

2. 打包固件:根据LVFS的指导原则,将固件打包成.cab格式,并提供相应的元数据文件(如manifest.json),描述固件适用的设备、版本信息、供应商信息等。

3. 上传固件:使用注册的账号登录LVFS后,按照页面提示上传已经准备好的固件包及元数据。

4. 审核过程:LVFS团队会对提交的固件进行审核,确认其安全性、合规性以及与硬件的匹配程度。

5. 公开发布:审核通过后,固件会被添加到LVFS仓库中,然后Linux发行版可以通过集成LVFS的客户端工具自动检测并下载这些固件更新。

6. 用户端更新:在用户端,系统通常会定期检查固件更新(例如使用fwupdmgr工具),发现有新固件时会通知用户安装。

对于LVFS本身的开发流程,它作为一项服务,开发者可能涉及到的内容包括但不限于:编写和维护LVFS服务器端的代码,处理固件的上传、存储、验证和分发逻辑。

开发和优化客户端工具,比如fwupd,以更好地支持固件升级功能。

设计和改进API接口、安全机制、数据库结构等方面的工作。

跟踪上游Linux内核和固件供应商的新特性需求,持续迭代和更新服务功能。

以上流程涵盖了从固件供应商的角度如何向LVFS提交固件,以及从LVFS 项目自身的开发与维护角度的一些要点。

Seaweed-FS综合使用测试(转)

Seaweed-FS综合使⽤测试(转)Seaweed-FS综合使⽤测试参考信息使⽤Go语⾔编写Weed fs 是⼀个简单/⾼可⽤密集型⼩⽂件存储的集群⽂件系统Weed-FS is a simple and highly scalable distributed file system. There are two objectives:官⽅说to store billions of files! 可以存储亿级的⼩⽂件to serve the files fast! 存取⽂件快速Instead of supporting full POSIX file system semantics, Weed-FS choose to implement only a key~file mapping. Similar to the word “NoSQL”, you can call it as “NoFS”.完整的符合POSIX⽂件系统规范和nosql⼀样使⽤key-file的结构。

⼀,架构设计1,架构拓扑DataCenter相当于数据中⼼Rack相当于机柜DataNode相当于服务器测试topo如下(注意由于副本设置原因110,1个数据中⼼⾄少要有2个rack):2,模拟现有环境测试:数据中⼼1:dc1 Rack:dc1rack1 DataNode:dc1node1、dc1node2、dc1node3、dc1node4数据中⼼2:dc2 Rack:dc2rack1 DataNode:dc2node1、dc2node2、dc2node3weed master:dc1node1、dc1node2、dc2node1weed volume:dc1node3、dc1node4、dc2node2、dc2node3weed filter:dc1node1、dc1node2(⽬录⽀持,mout不⽀持)3,备份策略⽤100:replicate once on a different data center其他备份策略如下:000 no replication, just one copy001 replicate once on the same rack010 replicate once on a different rack in the same data center100 replicate once on a different data center200 replicate twice on two other different data center110 replicate once on a different rack, and once on a different data center4,hosts⽂件:192.168.88.213 dc1node1192.168.88.214 dc1node2192.168.88.215 dc1node3192.168.88.216 dc1node4192.168.188.58 dc2node1192.168.188.133 dc2node2192.168.188.172 dc2node3⼆,部署设置1,安装weed1),Go(Golang)tar zxvf go1.6.linux-amd64.tar.gz -C /usr/local在/etc/profile设置gorootexport GOROOT=/usr/local/goexport PATH=$PATH:$GOROOT/bin:/usr/local/seaweedfs/sbinsource /etc/profice2),Mercurial(版本控制)rpm -ivh mercurial-3.4.2-0.x86_64.rpm3),Seaweed-FS推荐⼆进制包,go install需要FQweed_0.70beta_linux_amd64.tar.gztar zxvf weed_0.70beta_linux_amd64.tar.gz -C /usr/local/cd /usr/localmv weed_0.70beta_linux_amd64/ seaweedfsmkdir seaweedfs/sbinmv seaweedfs/weed seaweedfs/sbin2,部署weed1),启动weed master分别在dc1node1、dc1node1、dc2node1上执⾏weed master -mdir="/data/dc1node1" -ip="192.168.88.213" -ip.bind="192.168.88.213" -port=9333 -peers="dc1node1:9333,dc1node2:9333,dc2node1:9333" -defaultReplication="110" &weed master -mdir="/data/dc1node2" -ip="192.168.88.214" -ip.bind="192.168.88.214" -port=9333 -peers="dc1node1:9333,dc1node2:9333,dc2node1:9333" -defaultReplication="110" &weed master -mdir="/data/dc2node1" -ip="192.168.188.58" -ip.bind="192.168.188.58" -port=9333 -peers="dc1node1:9333,dc1node2:9333,dc2node1:9333" -defaultReplication="110" &使⽤介绍:weed help masterUsage: weed master -port=9333start a master server to provide volume=>location mapping serviceand sequence number of file idsDefault Parameters:-conf="/etc/weedfs/weedfs.conf": Deprecating! xml configuration file-defaultReplication="000": Default replication type if not specified.-garbageThreshold="0.3": threshold to vacuum and reclaim spaces-idleTimeout=10: connection idle seconds-ip="localhost": master <ip>|<server> address-ip.bind="0.0.0.0": ip address to bind to-maxCpu=0: maximum number of CPUs. 0 means all available CPUs-mdir="/tmp": data directory to store meta data-peers="": other master nodes in comma separated ip:port list, example: 127.0.0.1:9093,127.0.0.1:9094-port=9333: http listen port-pulseSeconds=5: number of seconds between heartbeats-secure.secret="": secret to encrypt Json Web Token(JWT)-volumeSizeLimitMB=30000: Master stops directing writes to oversized volumes.-whiteList="": comma separated Ip addresses having write permission. No limit if empty.启动⽇志:[root@dc1node1 ~]# weed master -mdir="/data/dc1node1" -ip="192.168.88.213" -ip.bind="192.168.88.213" -port=9333 -peers="dc1node1:9333,dc1node2:9333,dc2node1:9333" -defaultReplication="110" &[1] 7186[root@datanode01 ~]# I0314 14:13:59 07186 file_util.go:20] Folder /data/dc1node1 Permission: -rwxr-xr-xI0314 14:13:59 07186 topology.go:86] Using default configurations.I0314 14:13:59 07186 master_server.go:59] Volume Size Limit is 30000 MBI0314 14:13:59 07186 master.go:69] Start Seaweed Master 0.70 beta at 192.168.88.213:9333I0314 14:13:59 07186 raft_server.go:74] Joining cluster: dc1node1:9333,dc1node2:9333,dc2node1:9333I0314 14:13:59 07186 raft_server_handlers.go:16] Processing incoming join. Current Leader Self 192.168.88.213:9333 Peers map[]I0314 14:13:59 07186 raft_server_handlers.go:20] Command:{"name":"192.168.88.213:9333","connectionString":"http://192.168.88.213:9333"}I0314 14:13:59 07186 raft_server.go:179] Post returned status: 200I0314 14:13:59 07186 master_server.go:93] [ 192.168.88.213:9333 ] I am the leader!I0314 14:14:24 07186 raft_server_handlers.go:16] Processing incoming join. Current Leader 192.168.88.213:9333 Self 192.168.88.213:9333 Peers map[]I0314 14:14:24 07186 raft_server_handlers.go:20] Command:{"name":"192.168.88.214:9333","connectionString":"http://192.168.88.214:9333"}I0314 14:14:52 07186 raft_server_handlers.go:16] Processing incoming join. Current Leader 192.168.88.213:9333 Self 192.168.88.213:9333 Peersmap[192.168.88.214:9333:0xc20822dc00]I0314 14:14:52 07186 raft_server_handlers.go:20] Command:{"name":"192.168.188.58:9333","connectionString":"http://192.168.188.58:9333"}[root@dc1node2 ~]# weed master -mdir="/data/dc1node2" -ip="192.168.88.214" -ip.bind="192.168.88.214" -port=9333 -peers="dc1node1:9333,dc1node2:9333,dc2node1:9333" -defaultReplication="110" &[1] 47745[root@datanode02 ~]# I0314 14:14:23 47745 file_util.go:20] Folder /data/dc1node2 Permission: -rwxr-xr-xI0314 14:14:23 47745 topology.go:86] Using default configurations.I0314 14:14:23 47745 master_server.go:59] Volume Size Limit is 30000 MBI0314 14:14:23 47745 master.go:69] Start Seaweed Master 0.70 beta at 192.168.88.214:9333I0314 14:14:23 47745 raft_server.go:74] Joining cluster: dc1node1:9333,dc1node2:9333,dc2node1:9333I0314 14:14:23 47745 raft_server.go:179] Post returned status: 200[root@dc2node1 ~]#weed master -mdir="/data/dc2node1" -ip="192.168.188.58" -ip.bind="192.168.188.58" -port=9333 -peers="dc1node1:9333,dc1node2:9333,dc2node1:9333" -defaultReplication="110" &[1] 4490[root@localhost ~]# I0314 14:14:50 04490 file_util.go:20] Folder /data/dc2node1 Permission: -rwxr-xr-xI0314 14:14:50 04490 topology.go:86] Using default configurations.I0314 14:14:50 04490 master_server.go:59] Volume Size Limit is 30000 MBI0314 14:14:50 04490 master.go:69] Start Seaweed Master 0.70 beta at 192.168.188.58:9333I0314 14:14:50 04490 raft_server.go:74] Joining cluster: dc1node1:9333,dc1node2:9333,dc2node1:9333I0314 14:14:52 04490 raft_server.go:179] Post returned status: 2002),启动volume分别在dc1node3、dc1node4、dc2node2、dc2node3上执⾏weed volume -dataCenter="m5dc" -rack="m5rack1" -ip="192.168.88.215" -ip.bind="192.168.88.215" -max="10" -dir="/data/dc1node3" -mserver="dc1node1:9333" -port=8081 &weed volume -dataCenter="m5dc" -rack="m5rack1" -ip="192.168.88.216" -ip.bind="192.168.88.216" -max="10" -dir="/data/dc1node4" -mserver="dc1node1:9333" -port=8081 &weed volume -dataCenter="shddc" -rack="shdrack1" -ip="192.168.188.133" -ip.bind="192.168.188.133" -max="10" -dir="/data/dc2node2" -mserver="dc2node1:9333" -port=8081 &weed volume -dataCenter="shddc" -rack="shdrack1" -ip="192.168.188.172" -ip.bind="192.168.188.172" -max="10" -dir="/data/dc2node3" -mserver="dc2node1:9333" -port=8081 &启动⽇志:[root@dc1node3 ~] # weed volume -dataCenter="m5dc" -rack="m5rack1" -ip="192.168.88.215" -ip.bind="192.168.88.215" -max="10" -dir="/data/dc1node3" -mserver="dc1node1:9333" -port=8081 &[1] 21117[root@m ~]# I0314 14:12:12 21117 file_util.go:20] Folder /data/dc1node3 Permission: -rwxr-xr-xI0314 14:12:12 21117 store.go:225] Store started on dir: /data/dc1node3 with 0 volumes max 10I0314 14:12:12 21117 volume.go:136] Start Seaweed volume server 0.70 beta at 192.168.88.215:8081I0314 14:12:12 21117 volume_server.go:70] Volume server bootstraps with master dc1node1:9333[root@dc1node4 ~] # weed volume -dataCenter="m5dc" -rack="m5rack1" -ip="192.168.88.216" -ip.bind="192.168.88.216" -max="10" -dir="/data/dc1node4" -mserver="dc1node1:9333" -port=8081 &[1] 6284[root@master ~]# I0314 14:19:50 06284 file_util.go:20] Folder /data/dc1node4 Permission: -rwxr-xr-xI0314 14:19:50 06284 store.go:225] Store started on dir: /data/dc1node4 with 0 volumes max 10I0314 14:19:50 06284 volume.go:136] Start Seaweed volume server 0.70 beta at 192.168.88.216:8081I0314 14:19:50 06284 volume_server.go:70] Volume server bootstraps with master dc1node1:9333[root@dc2node2] # weed volume -dataCenter="shddc" -rack="shdrack1" -ip="192.168.188.133" -ip.bind="192.168.188.133" -max="10" -dir="/data/dc2node2" -mserver="dc2node1:9333" -port=8081 &[1] 15590[root@datanode03 ~]# I0314 14:20:05 15590 file_util.go:20] Folder /data/dc2node2 Permission: -rwxr-xr-xI0314 14:20:05 15590 store.go:225] Store started on dir: /data/dc2node2 with 0 volumes max 10I0314 14:20:05 15590 volume.go:136] Start Seaweed volume server 0.70 beta at 192.168.188.133:8081I0314 14:20:05 15590 volume_server.go:70] Volume server bootstraps with master dc2node1:9333[root@dc2node3 ~] # weed volume -dataCenter="shddc" -rack="shdrack1" -ip="192.168.188.172" -ip.bind="192.168.188.172" -max="10" -dir="/data/dc2node3" -mserver="dc2node1:9333" -port=8081 &[1] 33466[root@datanode04 ~]# I0314 14:20:26 33466 file_util.go:20] Folder /data/dc2node3 Permission: -rwxr-xr-xI0314 14:20:26 33466 store.go:225] Store started on dir: /data/dc2node3 with 0 volumes max 10I0314 14:20:26 33466 volume.go:136] Start Seaweed volume server 0.70 beta at 192.168.188.172:8081I0314 14:20:26 33466 volume_server.go:70] Volume server bootstraps with master dc2node1:9333[root@dc1node1 ~]#I0314 14:19:29 07186 node.go:208] topo adds child m5dcI0314 14:19:29 07186 node.go:208] topo:m5dc adds child m5rack1I0314 14:19:29 07186 node.go:208] topo:m5dc:m5rack1 adds child 192.168.88.215:8081I0314 14:19:50 07186 node.go:208] topo:m5dc:m5rack1 adds child 192.168.88.216:8081I0314 14:20:06 07186 node.go:208] topo adds child shddcI0314 14:20:06 07186 node.go:208] topo:shddc adds child shdrack1I0314 14:20:06 07186 node.go:208] topo:shddc:shdrack1 adds child 192.168.188.133:8081I0314 14:20:27 07186 node.go:208] topo:shddc:shdrack1 adds child 192.168.188.172:8081使⽤介绍:weed help volumeUsage: weed volume -port=8080 -dir=/tmp -max=5 -ip=server_name -mserver=localhost:9333start a volume server to provide storage spacesDefault Parameters:-dataCenter="": current volume server's data center name-dir="/tmp": directories to store data files. dir[,dir]...-idleTimeout=10: connection idle seconds-images.fix.orientation=true: Adjust jpg orientation when uploading.-index="memory": Choose [memory|leveldb|boltdb] mode for memory~performance balance.-ip="": ip or server name-ip.bind="0.0.0.0": ip address to bind to-max="7": maximum numbers of volumes, count[,count]...-maxCpu=0: maximum number of CPUs. 0 means all available CPUs-mserver="localhost:9333": master server location-port=8080: http listen port-port.public=0: port opened to public-publicUrl="": Publicly accessible address-pulseSeconds=5: number of seconds between heartbeats, must be smaller than or equal to the master's setting-rack="": current volume server's rack name-whiteList="": comma separated Ip addresses having write permission. No limit if empty.3,安装后结构UI三,基本操作:存储、获取和删除⽂件1,http rest api接⼝1),存储⽂件I0314 15:14:05 33466 store.go:192] In dir /data/dc2node3 adds volume:1 collection: replicaPlacement:110 ttl:I0314 15:14:05 33466 volume.go:110] loading index file /data/dc2node3/1.idx readonly falseI0314 15:14:05 33466 store.go:192] In dir /data/dc2node3 adds volume:3 collection: replicaPlacement:110 ttl:I0314 15:14:05 33466 volume.go:110] loading index file /data/dc2node3/3.idx readonly false{"fid":"3,01255df9c4","fileName":"helloseaweedfs","fileUrl":"192.168.88.213:8081/3,01255df9c4","size":17}我们看到master给我们返回了⼀⾏json数据,其中:fid是⼀个逗号分隔的字符串,按照repository中⽂档的说明,这个字符串应该由volume id, key uint64和cookie code构成。

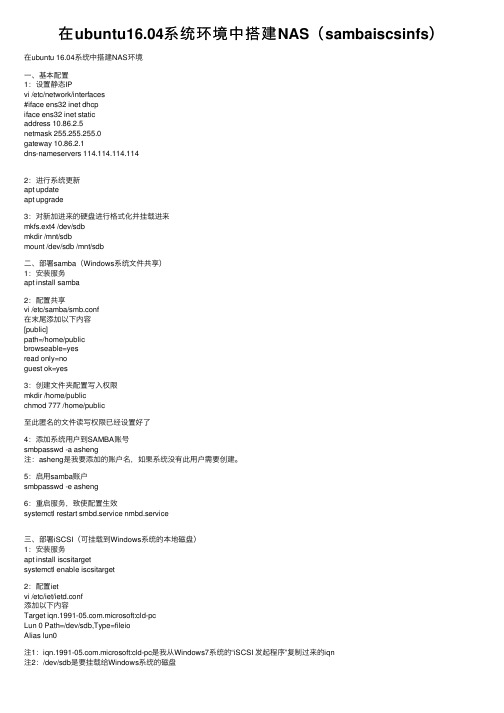

在ubuntu16.04系统环境中搭建NAS(sambaiscsinfs)

在ubuntu16.04系统环境中搭建NAS(sambaiscsinfs)在ubuntu 16.04系统中搭建NAS环境⼀、基本配置1:设置静态IPvi /etc/network/interfaces#iface ens32 inet dhcpiface ens32 inet staticaddress 10.86.2.5netmask 255.255.255.0gateway 10.86.2.1dns-nameservers 114.114.114.1142:进⾏系统更新apt updateapt upgrade3:对新加进来的硬盘进⾏格式化并挂载进来mkfs.ext4 /dev/sdbmkdir /mnt/sdbmount /dev/sdb /mnt/sdb⼆、部署samba(Windows系统⽂件共享)1:安装服务apt install samba2:配置共享vi /etc/samba/smb.conf在末尾添加以下内容[public]path=/home/publicbrowseable=yesread only=noguest ok=yes3:创建⽂件夹配置写⼊权限mkdir /home/publicchmod 777 /home/public⾄此匿名的⽂件读写权限已经设置好了4:添加系统⽤户到SAMBA账号smbpasswd -a asheng注:asheng是我要添加的账户名,如果系统没有此⽤户需要创建。

5:启⽤samba账户smbpasswd -e asheng6:重启服务,致使配置⽣效systemctl restart smbd.service nmbd.service三、部署iSCSI(可挂载到Windows系统的本地磁盘)1:安装服务apt install iscsitargetsystemctl enable iscsitarget2:配置ietvi /etc/iet/ietd.conf添加以下内容Target .microsoft:cld-pcLun 0 Path=/dev/sdb,Type=fileioAlias lun0注1:.microsoft:cld-pc是我从Windows7系统的“iSCSI 发起程序”复制过来的iqn注2:/dev/sdb是要挂载给Windows系统的磁盘3:配置为启⽤vi /etc/default/iscsitarget将第⼀⾏的ISCSITARGET_ENABLE=false改为ISCSITARGET_ENABLE=true4:重启服务使之⽣效service iscsitarget restart四、部署NFS(可挂到linux系统、给ESXI提供存储)1:安装服务apt install nfs-kernel-serversystemctl enable nfs-kernel-server2:配置NFSmkdir -p /mnt/sdb/nfs/datavi /etc/exports添加内容/mnt/sdb/nfs/data 10.86.2.0/24(rw,sync,no_root_squash)3:重启NFS服务service nfs-kernel-server restart========以上3种共享存储的安装与配置⽅法到此结束==========。

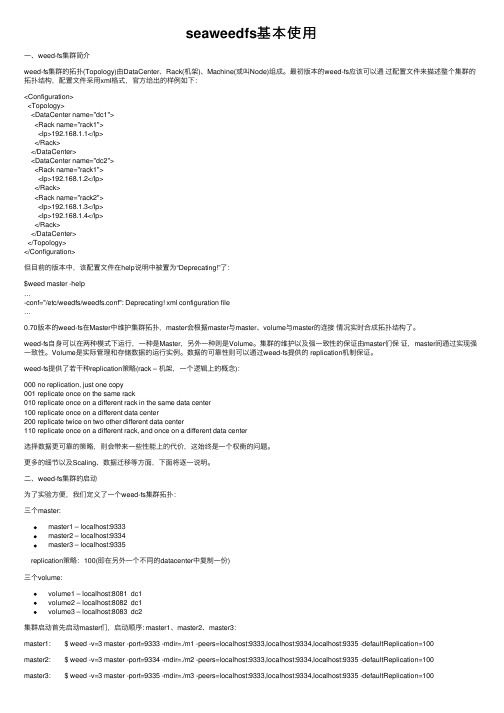

seaweedfs基本使用

seaweedfs基本使⽤⼀、weed-fs集群简介weed-fs集群的拓扑(Topology)由DataCenter、Rack(机架)、Machine(或叫Node)组成。

最初版本的weed-fs应该可以通过配置⽂件来描述整个集群的拓扑结构,配置⽂件采⽤xml格式,官⽅给出的样例如下:<Configuration><Topology><DataCenter name="dc1"><Rack name="rack1"><Ip>192.168.1.1</Ip></Rack></DataCenter><DataCenter name="dc2"><Rack name="rack1"><Ip>192.168.1.2</Ip></Rack><Rack name="rack2"><Ip>192.168.1.3</Ip><Ip>192.168.1.4</Ip></Rack></DataCenter></Topology></Configuration>但⽬前的版本中,该配置⽂件在help说明中被置为“Deprecating!”了:$weed master -help…-conf="/etc/weedfs/weedfs.conf": Deprecating! xml configuration file…0.70版本的weed-fs在Master中维护集群拓扑,master会根据master与master、volume与master的连接情况实时合成拓扑结构了。

北斗-全球卫星导航系统(GNSS)测量型天线性能要求及测试方法

BD 420003—2015

北斗/全球卫星导航系统(GNSS) 测量型天线性能要求及测试方法

Performance requirements and test methods for BeiDou/Global Navigation Satellite Systems (GNSS) geodetic antenna

3.1 术语和定义....................................................................................................................................... 1 3.2 缩略语............................................................................................................................................... 4 4 性能要求.

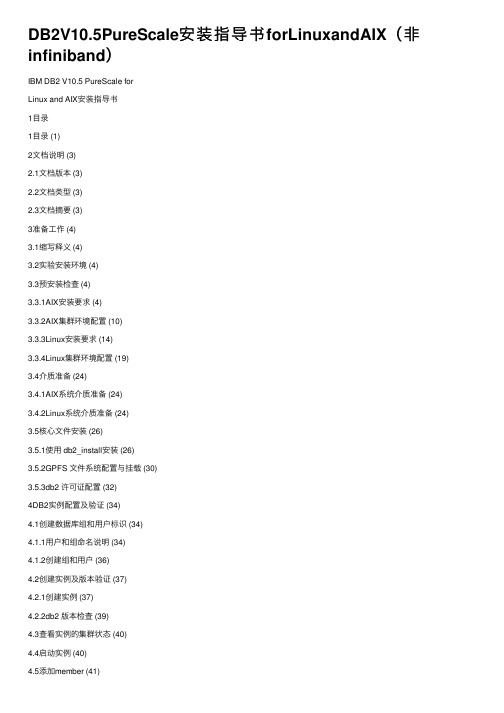

DB2V10.5PureScale安装指导书forLinuxandAIX(非infiniband)

DB2V10.5PureScale安装指导书forLinuxandAIX(⾮infiniband)IBM DB2 V10.5 PureScale forLinux and AIX安装指导书1⽬录1⽬录 (1)2⽂档说明 (3)2.1⽂档版本 (3)2.2⽂档类型 (3)2.3⽂档摘要 (3)3准备⼯作 (4)3.1缩写释义 (4)3.2实验安装环境 (4)3.3预安装检查 (4)3.3.1AIX安装要求 (4)3.3.2AIX集群环境配置 (10)3.3.3Linux安装要求 (14)3.3.4Linux集群环境配置 (19)3.4介质准备 (24)3.4.1AIX系统介质准备 (24)3.4.2Linux系统介质准备 (24)3.5核⼼⽂件安装 (26)3.5.1使⽤ db2_install安装 (26)3.5.2GPFS ⽂件系统配置与挂载 (30)3.5.3db2 许可证配置 (32)4DB2实例配置及验证 (34)4.1创建数据库组和⽤户标识 (34)4.1.1⽤户和组命名说明 (34)4.1.2创建组和⽤户 (36)4.2创建实例及版本验证 (37)4.2.1创建实例 (37)4.2.2db2 版本检查 (39)4.3查看实例的集群状态 (40)4.4启动实例 (40)4.5添加member (41)4.6添加CF (42)4.7为实例配置 TCP/IP 通信 (43)4.7.1更新 services ⽂件 (43)4.7.2更新数据库管理器配置 (44)4.8配置 DB2 服务器通信 (44)5数据库创建 (44)5.1实例注册变量设置 (44)5.1.1注册变量设置 (44)5.1.2注册变量检查 (45)5.2创建SAMPLE数据库 (45)2⽂档说明2.1⽂档版本⽂档历史2.2⽂档类型2.3⽂档摘要本⽂档描述数据库产品 DB2 V10.5.0.4 PureScale在Linux 和 Unix平台的安装、配置等内容。

浪潮通软 myGS pSeries 安装手册

如何在Oracle平台上安装浪潮通软myGS pSeries?

数据库平台

Oracle 7.3及以上

操作步骤

1、在客户端安装Oracle客户端软件(参见附录一1.1小节)。

2、在服务器端安装Oracle服务器端软件(参见附录一1.2小节)。

Custom Installation:Oracle定制安装方式,在安装过程中要进行多种选项的设置,相对比较麻烦。

4、点击【确定】按钮,屏幕显示窗口如图1.4所示。

图1.4

在该窗口中要求确定你所履行的主要职责:是一般应用者(Application User)还是数据库管理员(Database Administrator),采用默认值即可。

2、在图2.1所示窗口中,选择不同数据库,将弹出不同的窗口。

(1)、如果选中Sybase或MSS SQL Server,点击【确认】按钮,屏幕显示窗口如图2.2。

图2.2

在此窗口中输入Sybase服务器名和管理员口令。

(2)如果选中Oracle,弹出窗口如图2.3:

图2.3

系统管理员:Oracle的系统管理员为system。

口令:帐套主管的口令,口令的个数不少于六个,并且第一个字符必须为字母。帐套主管一定要记住编号和口令,最好做一下记录。在进《维护工具》子系统时,就要用到帐套主管编号和口令。

确认口令:应和口令一致。

7、点击【下一步】,弹出窗口如图2.9。

图2.9

选择子系统:确定本次安装需要装那些系统。

执行结果:执行结果分为三种:日志文件,安装时的错误记录在日志文件Cwlog.txt中,建议使用此种方式;即时显示,在安装的过程中,出现错误时立即显示;忽略错误,在安装过程中,出现错误时,不显示错误信息。

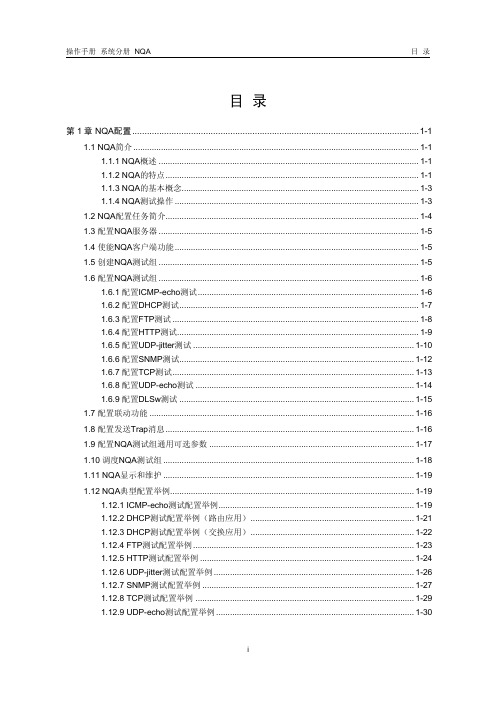

H3C NQA配置

本文中标有“请以实际情况为准”的特性描述,表示各型号对于此特性的支持情况 可能不同,本节将对此进行说明。

说明:

z H3C MSR 系列路由器对相关命令参数支持情况、缺省值及取值范围的差异内容 请参见本模块的命令手册。

z H3C MSR 系列各型号路由器均为集中式设备。

第1章 NQA 配置

1.1 NQA 简介

1.1.2 NQA 的特点

1. 支持多种测试类型 以往的 Ping 功能是使用 ICMP(Internet Control Message Protocol,互联网控制报 文协议)测试数据包在本端和指定目的端之间的往返时间。NQA 是对 Ping 功能的 扩展和增强,它增加了多种测试类型,提供了更多的功能。 目前 NQA 支持九种测试类型:ICMP-echo、DHCP、FTP、HTTP、UDP-jitter、SNMP、 TCP、UDP-echo 和 DLSw 测试。客户端向对端发送不同类型的测试报文,统计对 端是否回应报文以及报文的往返时间等参数,以便用户根据统计结果判断协议的可 用性和网络的性能。

h3c nqa配置 s6nqau <s6 nqa server enable nqau<g!5b, nqaserver ip-addressport-number g!5b,xip s6nqa v0s6 s6 s6nqa v0s6 e924?system-view s6nqav0s6 nqa agent enable nqav0s6b(1.5 e924?system-view nqa#a4je nqa#a4?nqa entry admin-name operation-tag nqaentry 1.6g!5b nqa#a4 1.6 cmp-echo bh1(y[cyc?,,x,xe'icmp-echo uwpw operation interface interface-type interface-number nqajvn"dhcp-r nqav0n,xftp ,h,xg!5bftp g!5bftp 1-7g!5b ftp p@0ro@><wp%*u`kp0f0h?ppif'0f0n"0#<c system-view nqa#a4?nqa entry admin-name operation-tag g!5b#a2o_http je9 #a2o typehttp destinationip ip-address sourceip ip-address g!5b02o_operation g!5bhttp ,x5%url url http-versionv1.0 typesnmp destinationip ip-address [,x$d0source port port-number sourceip ip-address data-sizesize 00+8v +0data-fill string y[,x$d0source port port-number sourceip ip-address e924?system-view nqa#a4?nqa entry admin-name operation-tag g!5b#a2o_dl sw je 9#a2o_? type dlsw destinationip ip-address nqasystem-view nqa#a4?nqa entry admin-name operation-tag reactiontrap probe-failurecons

blissQTP之文件系统操作

bliss-QTP之文件系统操作目录1.文件系统对象FSO(FileSystemObject)51.1FSO对象的属性61.2FSO对象的方法:61.2.1BulidPath(path,name):把文件路径信息添加到现有的文件路径上61.2.2CopyFile(source,destination,overwrite):复制文件 (6)1.2.3CopyFolder(source,destination,overwrite):复制文件夹 (7)1.2.4CreateFolder(foldername):创建文件夹并返回一个folder对象 (7)1.2.5CreateTextFile(filename,overwrite,unicode):创建文本并返回一个TextStream对象filename:必选项。

指定创建文本文件的名称 (8)1.2.6DeleteFile(filespec,force):删除文件 (8)1.2.7DeleteFolder(folderspec,force):删除文件夹及其中所有内容 (9)1.2.8DriveExits(drivespec):确定驱动器是否存在返回true或false 9 1.2.9FileExits(filespec):确定一个文件是否存在 (10)1.2.10FolderExists(folderspec):确定某文件夹是否存在 (10)1.2.11........ GetAbsolutePathName (pathspec):从提供的路径说明中返回一个完整、明确的路径。

(10)1.2.12GetBaseName(filespec):返回一个文件或文件夹的基本路径 (11)1.2.13GetDrive(drivespec):返回一个dreve对象 (11)1.2.14GetDriveName(drivespec):返回一个驱动器的名字 (11)1.2.15GetExtensionName(filespec):返回扩展名 (11)1.2.16GetFile(filespec):返回一个file 对象 (12)1.2.17GetFileName(pathspec):返回文件夹中文件名称 (12)1.2.18GetFolder(Folderspec):返回一个folder对象 (12)1.2.19........ GetParentFolderName(pathspec):返回一个文件夹的父文件夹 (13)1.2.20GetSpecialFolder(Folderspec):返回指定的特殊文件夹 (13)1.2.21GetTempName():返回随机产生的文件名,用于进行需要临时文件或临时文件夹的操作 (13)1.2.22MoveFile(source,destination):移动文件 (14)1.2.23MoveFolder(source,destination):移动文件夹 (14)1.2.24OpenTextFile(filename,iomode,create,format):打开一个存在的文件并返回一个TextStream对象 (14)2. 通过FSO对象访问的几个常用对象 (16)2.1Drives集合:只读所有可用驱动器的集合 (16)2.2Folders集合:提供文件夹中子文件夹的列表 (20)2.3Textstream对象:读写文本文件261.文件系统对象FSO(FileSystemObject)对文件系统中的驱动器、文件夹和文件进行处理,比如收集驱动器的相关信息;创建、添加、移动或删除文件夹和文件等。

gpfs安装配置说明

GPFS系统配置(1)

▪ 支持1 to 8,192 个节点(V3.2 & V3.3) V3.1可达4096个节点 可多达 3794 个Linux节点和1530个AIX节点 有些用户实际环境已安装了超过500个节点GPFS

▪ 能mount多个文件系统 V3.2以上支持256个 V3.1.0.5开始支持64个 V3.1开始支持32个

Configuration data Servers角色

– 注: 对GPFS集群做变更配置必需这些节点

mmcrcluster命令

▪ Usage:

▪ mmcrcluster -N {NodeDesc[,NodeDesc...] | NodeFile

▪

-p PrimaryServer

▪

[-s SecondaryServer]

– Installp命令安装如下安装包(前面已经介绍了dsh,我们可以dsh对 多个节点进行同步安装,在节点数非常多时,可以节省很多工作量) ▪ gpfs.base ▪ gpfs.docs.data ▪ gpfs.msg.en_US ▪ gpfs.gui

安装GPFS介质—LINUX节点(Power 服务器)

安装前准备— 存储配置

▪ 将存储LUN/disk 配置映射到GPFS集群节点

– 依据系统需求的不同,disk连接拓扑可能会有差异 ▪ SAN存储模式是将所有节点直接映射到所有节点 ▪ NSD模式只需由作为NSD Server的节点链接disk ▪ 混合模式可以是部分节点直接连接存储,部分做为NSD Client,它们通过NSD Server,通过IP网络进行IO访问 (Network Block IO)

▪

tracedev

▪

dumpconv

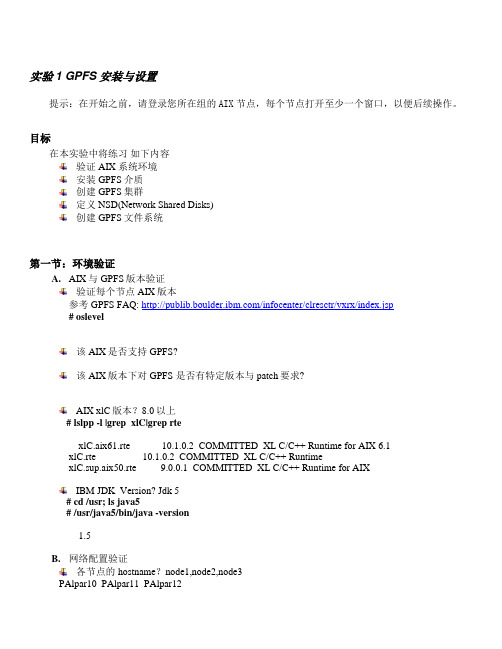

GPFS安装与设置

实验1 GPFS安装与设置提示:在开始之前,请登录您所在组的AIX节点,每个节点打开至少一个窗口,以便后续操作。

目标在本实验中将练习如下内容验证AIX 系统环境安装GPFS介质创建GPFS集群定义NSD(Network Shared Disks)创建GPFS文件系统第一节:环境验证A.AIX与GPFS版本验证验证每个节点AIX版本参考GPFS FAQ: /infocenter/clresctr/vxrx/index.jsp # oslevel_______________________________________________________该AIX是否支持GPFS?该AIX版本下对GPFS 是否有特定版本与patch要求?________________________________________________________AIX xlC版本?8.0以上# lslpp -l |grep xlC|grep rte___xlC.aix61.rte 10.1.0.2 COMMITTED XL C/C++ Runtime for AIX 6.1xlC.rte 10.1.0.2 COMMITTED XL C/C++ RuntimexlC.sup.aix50.rte 9.0.0.1 COMMITTED XL C/C++ Runtime for AIX_____________________________________________________IBM JDK Version? Jdk 5# cd /usr; ls java5# /usr/java5/bin/java -version__1.5_____________________________________________________B.网络配置验证各节点的hostname?node1,node2,node3PAlpar10 PAlpar11 PAlpar12________________________________________________________ 各节点是否能相互ping 通?# ping node1# ping node2# ping node3C.验证/etc/hosts文件,应包含组内给节点IP和hostname,如192.168.1.11node1192.168.1.12node2192.168.1.13node3D.ssh安装、配置与通讯验证#cd /home/soft/ssh; installp -agYXpd . all先预览是否能正常安装,输出如下表示通过:SUCCESSES---------Filesets listed in this section passed pre-installation verificationand will be installed.Selected Filesets-----------------openssh.base.client 5.0.0.5302 # Open Secure Shell Commandsopenssh.base.server 5.0.0.5302 # Open Secure Shell Serveropenssh.license 5.0.0.5302 # Open Secure Shell Licenseopenssh.man.en_US 5.0.0.5302 # Open Secure Shell Documentat... openssl.base 0.9.8.840 # Open Secure Socket Layeropenssl.license 0.9.8.840 # Open Secure Socket Licenseopenssl.man.en_US 0.9.8.840 # Open Secure Socket Layer # installp -agYXd . all安装后,如下表示正常:openssl.man.en_US 0.9.8.840 USR APPLY SUCCESS openssl.license 0.9.8.840 USR APPLY SUCCESS openssl.base 0.9.8.840 USR APPLY SUCCESS openssl.base 0.9.8.840 ROOT APPLY SUCCESS openssh.license 5.0.0.5302 USR APPLY SUCCESS openssh.base.client 5.0.0.5302 USR APPLY SUCCESS openssh.base.server 5.0.0.5302 USR APPLY SUCCESS openssh.base.client 5.0.0.5302 ROOT APPLY SUCCESS openssh.base.server 5.0.0.5302 ROOT APPLY SUCCESS openssh.man.en_US 5.0.0.5302 USR APPLY SUCCESS # ssh-keygen -t rsa在每个AIX节点生成ssh-key如下:Generating public/private rsa key pair.Enter file in which to save the key (//.ssh/id_rsa): 回车Created directory '//.ssh'.Enter passphrase (empty for no passphrase): 回车Enter same passphrase again: 回车Your identification has been saved in //.ssh/id_rsa.Your public key has been saved in //.ssh/id_rsa.pub.The key fingerprint is:db:0b:23:aa:81:a9:b2:41:33:97:8b:6b:b7:24:fc:2c root@node1在节点 node1 copy如下文件# cp /.ssh/id_rsa.pub /.ssh/authorized_keys从节点node2 copy /.ssh/id_rsa.pub 到节点1/tmp/id_rsa.pub2,需要输入节点2的root密码从节点node3 copy /.ssh/id_rsa.pub 到节点1/tmp/id_rsa.pub3,需要输入节点3的root密码# scp node2:/.ssh/id_rsa.pub /tmp/id_rsa.pub2root@node2's password:id_rsa.pub 100% 393 0.4KB/s 00:00 # scp node3:/.ssh/id_rsa.pub /tmp/id_rsa.pub3在node1将/tmp/id_rsa.pub2; /tmp/id_rsa.pub3追加到/.ssh/authorized_keys中#cat /tmp/id_rsa.pub2 >> /.ssh/authorized_keys#cat /tmp/id_rsa.pub3 >> /.ssh/authorized_keys将node1上/.ssh/authorized_keys copy到node2,node3#scp /.ssh/authorized_keys node2:/.ssh/authorized_keys#scp /.ssh/authorized_keys node3:/.ssh/authorized_keys在node1,node2,node3节点touch 一个/.hushlogin文件,以屏蔽登录回显信息# touch /.hushlogin验证node1,node2,node3节点的ssh通讯,如能显示日期验证通过on node1# ssh node2 date; ssh node3 dateon node2# ssh node1 date; ssh node3 dateon node3# ssh node1 date; ssh node2 dateE.rsh, dsh 配置创建并编辑/.rhosts文件,node1 rootnode2 rootnode3 root验证rsh通讯,如能显示日期验证通过on node1# rsh node2 date; rsh node3 dateon node2# rsh node1 date; rsh node3 dateon node3# rsh node1 date; rsh node2 date验证dsh通讯,如能显示日期验证通过on node1# dsh -n node2 date; dsh -n node3 dateon node2# dsh -n node1 date; dsh -n node3 dateon node3# dsh -n node1 date; dsh -n node2 dateF.检查各AIX系统共享disks#lsdev –Cc disk#lspv第二节:安装GPFS软件A. 在node1,node2,node3上分别预览与安装GPFS软件及其PTF(Program Temporary Fix)# dsh -n node1,node2,node3 "cd /home/soft/gpfs3.2.1/3.2.1.0; inutoc .; installp -agYXpd . all"# dsh -n node1,node2,node3 "cd /home/soft/gpfs3.2.1/3.2.1.0; installp -agYXd . all"# dsh -n node1,node2,node3 "cd /home/soft/gpfs3.2.1/ptf; inutoc .; installp -agYXpd . all"# dsh -n node1,node2,node3 "cd /home/soft/gpfs3.2.1/ptf; installp -agYXd . all"B. 在node1,node2,node3上分别验证GPFS软件# dsh -n node1,node2,node3 "lslpp -L gpfs.*"Fileset Level State Type Description (Uninstaller)----------------------------------------------------------------------------gpfs.base 3.2.1.13 A F GPFS File Managergpfs.docs.data 3.2.1.1 A F GPFS Server Manpages andDocumentationgpfs.gui 3.2.1.0 C F GPFS GUIgpfs.msg.en_US 3.2.1.11 A F GPFS Server Messages - U.S.EnglishState codes:A -- Applied.B -- Broken.C -- Committed.E -- EFIX Locked.O -- Obsolete. (partially migrated to newer version)? -- Inconsistent State...Run lppchk -v.Type codes:F -- Installp FilesetP -- ProductC -- ComponentT -- FeatureR -- RPM PackageC. 在node1,node2,node3上,将gpfs执行命令路径加入PATH环境变量# echo export PATH=$PATH:/usr/lpp/mmfs/bin >>/etc/profile# . /etc/profileD. 在node1,node2,node3上,确认gpfs PATH环境变量是否已正确# env|grep PATH# mmlsclustermmlscluster: 6027-1382 This node does not belong to a GPFS cluster.mmlscluster: 6027-1639 Command failed. Examine previous error messages to determine cause.第三节:创建一个双节点的GPFS集群在本练习中,我们首先建一个单节点的GPFS CLUSTER。

btrfs手册

btrfs手册

Btrfs是一种先进的Linux文件系统,提供了许多高级特性,包括数据完整性、快照和克隆、空间利用率、文件系统可扩展性等。

以下是Btrfs手册的主要内容:

1. 简介:介绍Btrfs的历史和发展,以及它的主要特点和用途。

2. 安装和配置:指导用户如何安装和配置Btrfs文件系统。

3. 使用和操作:介绍如何创建和挂载文件系统,以及如何进行文件和目录操作。

4. 高级功能:介绍Btrfs的高级特性,如存储池和子卷、文件系统快照、数据压缩等。

5. 常见问题和故障排除:提供常见错误信息和解决方案,帮助用户解决使用过程中遇到的问题。

6. 总结:总结Btrfs的主要特性和优点,以及它在Linux操作系统中的重要地位。

通过阅读这本手册,用户可以了解Btrfs的基本概念和特点,以及如何使用它来提高数据的安全性和可靠性。

同时,用户也可以解决使用过程中遇到的问题,确保系统的稳定性和可靠性。

嵌入式实验二(嵌入式Linux主机调试环境搭建)

实验二嵌入式Linux主机调试环境搭建一、实验目的:1.熟悉Linux TFTP配置,为后续Linux底层开发做准备。

2.熟悉Linux NFS文件系统的配置过程,为后续Linux底层开发实验做准备。

3.熟悉嵌入式Linux交叉开发环境的搭建与使用。

二、实验内容:1.利用安装好的虚拟机系统,测试TFTP服务是否正常。

2.重新配置NFS文件系统。

3.使用TFTP的方式下载内核,运行到开发板上;使用nfs方式挂载文件系统,为后续的开发做准备。

三、实验原理:TFTP协议是简单文件传输协议,基于UDP协议,没有文件管理、用户控制功能。

TFTP分为服务器端程序和客户端程序,在主机上通常同时配置有TFTP服务端和客户端。

NFS方式是开发板通过NFS挂载放在主机(PC)上的根文件系统。

此时在主机上文件系统中进行的操作同步反映在开发板上;反之,在开发板上进行的操作同步反映在主机中的根文件系统上。

实际工作中,我们经常使用NFS方式挂载系统,这种方式对于系统的调试非常方便。

四、实验步骤及过程:1. 打开虚拟机,运行Ubuntu 12.04系统,打开命令行终端。

回到home目录。

如上图所示,没有出现错误代码,且在家目录(/home/linux)下出现test文件,内容相同,则证明tftp服务建立成功。

2. 配置/etc/exports(sudo获取权限。

输入密码,默认为1;如不会使用vim,命令行vim字段用gedit代替,下面省略此说明。

):NFS允许挂载的目录及权限在文件/etc/exports中进行了定义。

例如,我们要将/source/rootfs目录共享出来,那么我们需要在/etc/exports文件末尾添加如下一行:其中:/source/rootfs是要共享的目录,*代表允许所有的网络段访问,rw是可读写权限,sync是资料同步写入内存和硬盘,no_root_squash是NFS客户端分享目录使用者的权限,如果客户端使用的是root用户,那么对于该共享目录而言,该客户端就具有root 权限。

ES DS系列主要配置步骤--CRT版

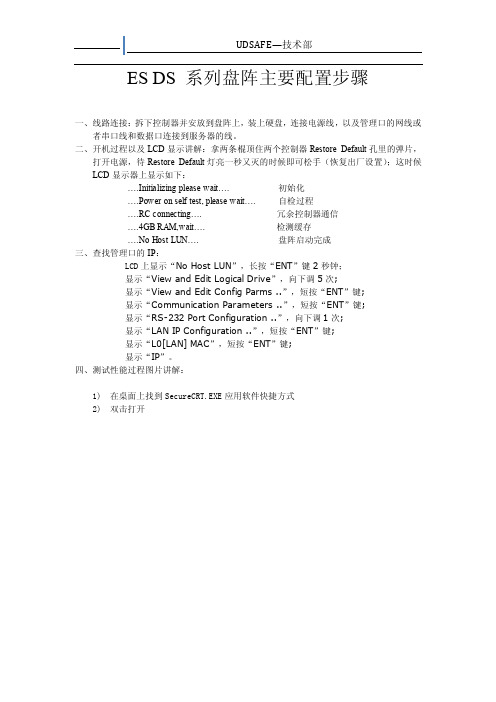

ES DS 系列盘阵主要配置步骤一、线路连接:拆下控制器并安放到盘阵上,装上硬盘,连接电源线,以及管理口的网线或者串口线和数据口连接到服务器的线。

二、开机过程以及LCD显示讲解:拿两条棍顶住两个控制器Restore Default孔里的弹片,打开电源,待Restore Default灯亮一秒又灭的时候即可松手(恢复出厂设置);这时候LCD显示器上显示如下:….Initializing please wait…. 初始化….Power on self test, please wait…. 自检过程….RC connecting…. 冗余控制器通信….4GB RAM,wait…. 检测缓存….No Host LUN…. 盘阵启动完成三、查找管理口的IP:LCD上显示“No Host LUN”,长按“ENT”键2秒钟;显示“View and Edit Logical Drive”,向下调5次;显示“View and Edit Config Parms ..”,短按“ENT”键;显示“Communication Parameters ..”,短按“ENT”键;显示“RS-232 Port Configuration ..”,向下调1次;显示“LAN IP Configuration ..”,短按“ENT”键;显示“L0[LAN] MAC”,短按“ENT”键;显示“IP”。

四、测试性能过程图片讲解:1)在桌面上找到SecureCRT.EXE应用软件快捷方式2)双击打开3)点击选项栏中第二个图标4)选择Protcol为Telnet5)在Hostname中输入刚才所查的IP地址6)单击Connect进入7)密码为空,直接按ENT键进入管理界面,此界面出现很多乱码8)按Ctrl+C,ESC,向下键,消除乱码看到(VT100 mode)9)按ENT键进入盘阵的管理界面10)建立LD的过程:选择wiew and edit Logical drives,按ENT键进入再按ENT键选择Yes 确认创建此时,选着RAID级别,选到这项按ENT键选择好要创建RAID 的硬盘,把下面的硬盘都选上(按ENT键选择)选择完硬盘按ESC返回设置写入模式,选择Write Policy : Default(Wrie-Back),按ENT键进入一般我们使用Write-Back,根据实际情况而定,选择它按ENT键按ESC键返回出现提示问你是否确认创建RAID选择Yes确认创建出现告示开始创建按ESC键消去告示,又出现新的告示创建过程中继续按ESC消去告示,又有新的告示是正在初始化继续按ESC消去告示,出现初始化进度条我们不用等待它完成在线初始化,按ESC键返回查看RAID的状态创建RAID 完成了,按ESC键返回到主界面11)创建LV的过程选择view and edit Host Volumes,按ENT键进入按ENT键开始创建选择Yes确认创建,出现告示(在LD基础上建立LV的大小必须大于16G)还是按ESC消去告示(下文凡是遇到告示需要消去的我直接说消去告示)按ENT键选择刚才创建的LD,看见其序号及容量等信息。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

一、QNM页面配置:

1、登录QNM管理界面

https://QNM_engine服务器IP地址:7777/

https://QNM_engine服务器IP地址:6666/

如果通过QNM服务器本地登录则无需用户名和密码

如果通过其它服务器远程web登录,则需输入用户名和密码。

用户名:admin 密码:qstarp@ssw0rd

2、导入License

Engine Setting-License,点击“load”,导入正确的License

3、设置Network Destination(Network Migrator->Network Destination)

Path为策略执行目的地网络路径,并且填写有权限访问网络路径的用户名及密码(若是启用了guest用户,需要为guest用户设置密码),点击“test”进行测试。

可以看到以下截图:

即说明该Network Storage Destination可用。

4、设置Policy(Network Migrator->Policy Bulider)

可选择的策略有Copy、Migrate、Move、Delete

二、MDC端的配置:

1、在文件系统页面上创建文件系统,比如fs1

2、登录到MDC端,配置DMAPI,方法请参考文档“HyperFS Support for

QNM.doc”

注:其中“mtpt=/path/to/mountpoint”其值应为文件系统的挂载点,比如“/fsmnt/fs1”

3、在MDC端用“mount –t cifs –o username=xx,password=xx //IP/xx /xx”将

Network Destination挂载到本地目录。

4、重启qnm-bwfs-server服务

注:每次修改qnm-bwfs-server.ini或者在MDC端挂载Network Destination 后都需要重启该服务。

qnm-bwfs-server.ini可以设置回迁的方式,即增加“RestoreMethod = xx”可选择的值为agent或者local。

三、挂载蓝鲸盘

1、Linux Client挂载蓝鲸盘

2、Windows Client挂载蓝鲸盘

四、策略执行

设置Agent (Network migratory->Agent Source Managemet->Agent

Configuration)

1、选中相应的Agent,Agent Managent->Modify

2、在“Managed directory path”右侧点击“Browse”,选中相应的源目

录

3、在“Policy”下选择策略

4、根据agent类型不同,Network Destination设置不同。

(1)若该agent属于Windows平台,在“Network Destination Targets”

中选择targets;

(2)若该agent属于Linux平台,在“Local Destination Target”中选择Network Destination在Linux端挂载相应的目录,且选中“Local

Mount Check”。

5、在页面最下方,点击“Add”,之后点击“Back”,返回至上一页面。

五、执行策略

1、点击“Check Configuration”。

当Agent的“Status”恢复为“Idle”时

执行下一步。

2、点击“Scan”。

当Agent的“Status”恢复为“Idle”时执行下一步。

3、点击“Execute”,此时策略开始执行。

六、策略执行完成后,通过QNM页面的“File System Brower”查看数据状态,

有两种方法:

1.选择“Client Storage Brower”,查看相应目录下文件的“Status”

注:若文件的“Status”为“Not migrated”说明文件并没有迁移,资源

没有释放,需要查看MDC端的DMAPI是否配置正确。

2.选择“Archive Brower”,通过“By Storage”,可以查看目标目录中文件

的情况,并对文件进行操作,如回迁等,请看截图:

通过“By Agent”,可以查看经由相应agent操作过的文件情况,并对这

些文件进行回迁等操作,请看以下截图:。