newff神经网络

matlab newff参数

matlab newff参数

newff函数是Matlab中用于创建前馈神经网络的函数,其参数如下:

1.第一个参数为一个长度为n的行向量,表示每层神经元的个数,n表示网络的层数,如[5 3 1]表示输入层有5个神经元,隐层有3个神经元,输出层有1个神经元。

2.第二个参数为一个长度为2的行向量,表示可接受的误差范围和最大训练轮数,如[0.01 1000]表示误差小于0.01时停止训练,最多训练1000轮。

3.第三个参数为一个长度为n-1的行向量,表示每一层使用的激活函数,如['logsig' 'tansig']表示隐层使用logistic激活函数,输出层使用tansig激活函数。

4.第四个参数为一个字符串,表示训练算法,如'trainlm'表示使用Levenberg-Marquardt算法进行训练。

5.第五个参数为布尔值,表示是否对输入进行归一化处理,如true表示进行归一化处理。

6.第六个参数为布尔值,表示是否显示训练进度,如true表示显示训练进度。

例如:net=newff([2 3 1],[1e-3

1000],{'tansig','logsig'},'trainlm',true,false) 表示创建了一个有输入层2个神经元、1个隐层3个神经元、输出层1个神经元,使用tansig和logsig函数作为隐层和输出层激活函数,使用Levenberg-Marquardt算法进行训练,进行归一化处理,不显示训练进度的神经网络。

Matlab工具箱中地BP与RBF函数

Matlab工具箱中的BP与RBF函数Matlab神经网络工具箱中的函数非常丰富,给网络设置适宜的属性,可以加快网络的学习速度,缩短网络的学习进程。

限于篇幅,仅对本章所用到的函数进展介绍,其它的函数与其用法请读者参考联机文档和帮助。

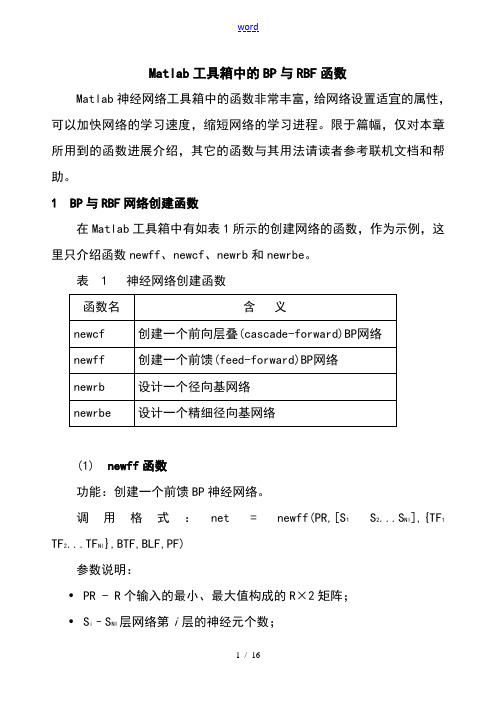

1 BP与RBF网络创建函数在Matlab工具箱中有如表1所示的创建网络的函数,作为示例,这里只介绍函数newff、newcf、newrb和newrbe。

表 1 神经网络创建函数(1) newff函数功能:创建一个前馈BP神经网络。

调用格式:net = newff(PR,[S1S2...S Nl],{TF1 TF2...TF Nl},BTF,BLF,PF)参数说明:•PR - R个输入的最小、最大值构成的R×2矩阵;•S i–S NI层网络第i层的神经元个数;•TF i - 第i层的传递函数,可以是任意可导函数,默认为 'tansig',可设置为logsig,purelin等;•BTF -反向传播网络训练函数,默认为 'trainlm',可设置为trainbfg,trainrp,traingd等;•BLF -反向传播权值、阈值学习函数,默认为 'learngdm';•PF -功能函数,默认为'mse';(2) newcf函数功能:创建一个N层的层叠(cascade)BP网络调用格式:net = newcf(Pr,[S1 S2...SNl],{TF1 TF2...TFNl},BTF,BLF,PF)参数同函数newff。

(3) newrb函数功能:创建一个径向基神经网络。

径向基网络可以用来对一个函数进展逼近。

newrb函数用来创建一个径向基网络,它可以是两参数网络,也可以是四参数网络。

在网络的隐层添加神经元,直到网络满足指定的均方误差要求。

调用格式:net = newrb(P,T,GOAL,SPREAD)参数说明:•P:Q个输入向量构成的R×Q矩阵;•T:Q个期望输出向量构成的S×Q矩阵;•GOAL:均方误差要求,默认为0。

matlab神经网络工具箱简介和函数及示例

目前,神经网络工具箱中提供的神经网络模型主 要应用于:

函数逼近和模型拟合 信息处理和预测 神经网络控制 故障诊断

神经网络实现的具体操作过程:

• 确定信息表达方式; • 网络模型的确定; • 网络参数的选择; • 训练模式的确定; • 网络测试

• 确定信息表达方式:

将领域问题抽象为适合于网络求解所能接受的 某种数据形式。

函数类型 输入函数

其它

函数名 称

netsum netprcd concur dotprod

函数用途

输入求和函数 输入求积函数 使权值向量和阈值向量的结构一致 权值求积函数

BP网络的神经网络工具箱函数

函数类型

函数名称 函数用途

前向网络创建 函数

传递函数

学习函数

函数类型 性能函数 显示函数

函数名 函数用途 称

三、BP网络学习函数

learngd 该函数为梯度下降权值/阈值学习函数,通过神经 元的输入和误差,以及权值和阈值的学习速率, 来计算权值或阈值的变化率。

调用格式; [dW,ls]=learngd(W,P,Z,N,A,T,E,gW,gA,D,LP,LS)

二、神经元上的传递函数

传递函数是BP网络的重要组成部分,必须是连续可 微的,BP网络常采用S型的对数或正切函数和线性函数。

• Logsig 传递函数为S型的对数函数。 调用格式为: • A=logsig(N)

N:Q个S维的输入列向量; A:函数返回值,位于区间(0,1) 中

② info=logsig(code)

问题形式的种类:

数据样本已知; 数据样本之间相互关系不明确; 输入/输出模式为连续的或者离散的; 输入数据按照模式进行分类,模式可能会 具有平移、旋转或者伸缩等变化形式; 数据样本的预处理; 将数据样本分为训练样本和测试样本

matlab newff损失函数

matlab newff损失函数在使用 MATLAB 中的 newff 函数进行神经网络训练时,损失函数是一个非常重要的概念。

损失函数是在神经网络模型中评估训练的好坏的指标,它通常是通过计算预测输出和真实输出之间的差异来计算的。

在 newff 函数中,可以选择不同的损失函数来适应不同的问题类型。

在 MATLAB 中使用 newff 函数进行神经网络训练时,可以通过指定损失函数的类型来控制模型的训练过程。

在 newff 函数中,损失函数的类型参数被称为'trainFcn',它决定了神经网络模型的训练算法和损失函数类型。

下面介绍几种常用的损失函数类型和适用的问题类型:1. 均方误差损失函数 (mse):均方误差是最常用的损失函数之一,常用于回归问题。

它计算预测输出与真实输出的平方差,并且在训练过程中尽量将这个差异减小。

均方误差损失函数可以通过设置 'trainFcn' 参数为 'trainlm' 实现。

2. 均方根误差损失函数 (rmse):均方根误差是均方误差的平方根,更直观地衡量了预测值和真实值之间的差异程度。

均方根误差损失函数也常用于回归问题,并且可以通过设置 'trainFcn' 参数为 'trainlm' 来使用。

3. 交叉熵损失函数 (crossentropy):交叉熵损失函数是用于分类问题的一种常见损失函数。

它通过计算预测概率分布与真实概率分布之间的差异来评估模型的训练效果。

交叉熵损失函数可以通过设置 'trainFcn' 参数为 'trainrp'、'trainbfg' 或者'traincgf' 来使用。

4. 对数似然损失函数 (logsig):对数似然损失函数也是用于分类问题的一种常见损失函数。

它基于逻辑斯蒂回归模型,通过计算预测概率和真实概率的对数差异来评估模型的训练效果。

matlab神经网络

Matlab神经网络工具箱2010-7-21今天学的是BP神经网络,首先看的是一个关于非线性函数逼近的例子,最后得出一个心得:在使用newff函数生成一个新的网络时,神经元的层数和每一层的神经元数会对结果造成不小的影响,一般都采用[n,1]的建立方法,其中n为隐层的神经元数,1为输出层的神经元数。

然后是做了一个识别系统,算是一个较大的神经网络,具体的代码解释和分析如下:[alphabet,targets]=prprob;[R,Q]=size(alphabet);[S2,Q]=size(targets);S1=10;[R,Q]=size(alphabet);[S2,Q]=size(targets);P=alphabet;net=newff(minmax(P),[S1,S2],{'logsig','logsig'},'traingdx');net.LW{2,1}=net.LW{2,1}*0.01;net.b{2}=net.b{2}+0.01;其中的proprob是matlab自带的一个生成字母表布尔值的函数。

可以具体查看。

T=targets;net.performFcn='sse';net.trainParam.goal=0.1;net.trainParam.show=20;net.trainParam.epochs=5000;net.trainParam.mc=0.95;[net,tr]=train(net,P,T)接下来首先进行无噪声训练。

netn.trainParam.goal=0.6;netn.trainParam.epochs=300;T=[targets targets targets targets];for pass=1:10P=[alphabet,alphabet,(alphabet+randn(R,Q)*0.1),(alphabet+randn(R,Q)*0.2) ];[netn,tr]=train(net,P,T);end接下来是有噪声训练,采用随机数生成影响输入矩阵的方式。

神经网络预测法

Step2 • 利用样本计算网络输出,得到误差

Step3

• 利用误差反向计算每一层旳sensitivty, 更新权值和阈值。直到误差满足精度 要求。

BP网络学习算法旳改善

▪ BP算法缺陷小结

➢ 易形成局部极小而得不到全局最优; ➢ 训练次数多使得学习效率低,收敛速度慢; ➢ 隐节点旳选用缺乏理论指导; ➢ 训练时学习新样本有遗忘旧样本旳趋势。

w eight

af(W,p)

期望输出 t=1---苹果 t=0---香蕉

有导师旳学习

期望输出(向量)

训练样本:{ p 1 ,t 1 } { p 2 ,t 2 } { p Q , t Q }

输入(向量)

基本思想:

对样本对(输入和期望输出)进行学习;将样本旳输 入送至神经网络,计算得到实际输出;若实际输出与 期望输出之间旳误差不满足精度要求,则调整权值W

2、创建/训练BP神经网络: newff, train 创建前需要拟定网络旳构造:

隐层数

含一种隐层旳MLP网络能够以任意精度逼近任何有理函数。 在设计BP网络时,应优先考虑3层BP网络(即有1个隐层), 靠增长隐层节点数来取得较低旳误差。

隐层节点数 拟定隐层节点数旳最基本原则:在满足精度要求旳前提

BP神经网络旳Matlab工具箱函数

2、BP神经网络训练函数:

函数train用于训练已经创建好旳BP神经网络,其调 用格式为:

[net, tr, Y, E] = train(net, P, T)

训练前旳网络,

newff产生旳BP

网络

P:输入矩阵,每行相应于一种样本旳输入向量

T:输出矩阵,每行相应于该样本旳期望输出

下取尽量少旳隐层节点数。最佳隐层神经元个数可参照如下 公式:

神经网络实学习 例子

神经网络实学习例子1通过神经网络滤波和信号处理,传统的sigmoid函数具有全局逼近能力,而径向基rbf函数则具有更好的局部逼近能力,采用完全正交的rbf径向基函数作为激励函数,具有更大的优越性,这就是小波神经网络,对细节逼近能力更强。

BP网络的特点①网络实质上实现了一个从输入到输出的映射功能,而数学理论已证明它具有实现任何复杂非线性映射的功能。

这使得它特别适合于求解内部机制复杂的问题。

我们无需建立模型,或了解其内部过程,只需输入,获得输出。

只要BPNN结构优秀,一般20个输入函数以下的问题都能在50000次的学习以内收敛到最低误差附近。

而且理论上,一个三层的神经网络,能够以任意精度逼近给定的函数,这是非常诱人的期望;②网络能通过学习带正确答案的实例集自动提取"合理的"求解规则,即具有自学习能力;③网络具有一定的推广、概括能力。

bp主要应用回归预测(可以进行拟合,数据处理分析,事物预测,控制等)、分类识别(进行类型划分,模式识别等),在后面的学习中,都将给出实例程序。

但无论那种网络,什么方法,解决问题的精确度都无法打到100%的,但并不影响其使用,因为现实中很多复杂的问题,精确的解释是毫无意义的,有意义的解析必定会损失精度。

BP注意问题1、BP算法的学习速度很慢,其原因主要有:a由于BP算法本质上为梯度下降法,而它所要优化的目标函数又非常复杂,因此,必然会出现"锯齿形现象",这使得BP算法低效;结论4:由上表可以看出,后者的初始权值比较合适些,因此训练的时间变短,误差收敛速度明显快些。

因此初始权值的选取对于一个网络的训练是很重要的。

1.4,用最基本的BP算法来训练BP神经网络时,学习率、均方误差、权值、阈值的设置都对网络的训练均有影响。

综合选取合理的值,将有利于网络的训练。

在最基本的BP算法中,学习率在整个训练过程是保持不变的,学习率过大,算法可能振荡而不稳定;学习率过小,则收敛速度慢,训练时间长。

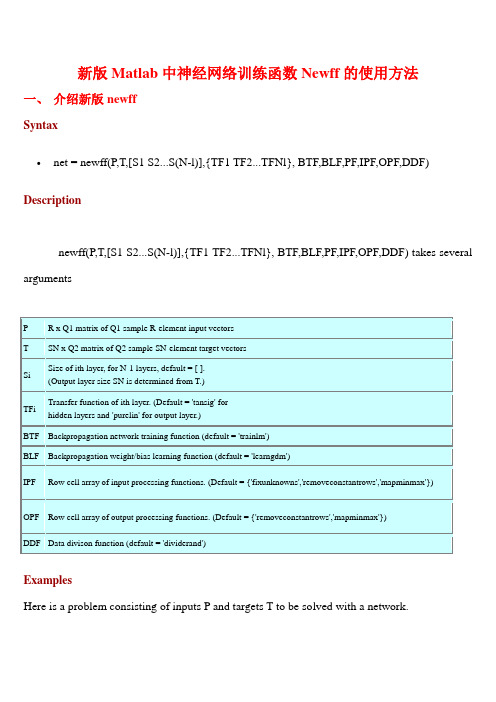

新版Matlab中神经网络训练函数Newff的使用方法资料

新版Matlab中神经网络训练函数Newff的使用方法一、介绍新版newffSyntaxnet = newff(P,T,[S1 S2...S(N-l)],{TF1 TF2...TFNl}, BTF,BLF,PF,IPF,OPF,DDF) Descriptionnewff(P,T,[S1 S2...S(N-l)],{TF1 TF2...TFNl}, BTF,BLF,PF,IPF,OPF,DDF) takes several argumentsExamplesHere is a problem consisting of inputs P and targets T to be solved with a network.∙P = [0 1 2 3 4 5 6 7 8 9 10];T = [0 1 2 3 4 3 2 1 2 3 4];Here a network is created with one hidden layer of five neurons.∙net = newff(P,T,5);The network is simulated and its output plotted against the targets.∙Y = sim(net,P);plot(P,T,P,Y,'o')The network is trained for 50 epochs. Again the network's output is plotted.∙net.trainParam.epochs = 50;net = train(net,P,T);Y = sim(net,P);plot(P,T,P,Y,'o') 二、新版newff与旧版newff调用语法对比Example1比如输入input(6*1000),输出output为(4*1000),那么旧版定义:net=newff(minmax(input),[14,4],{'tansig','purelin'},'trainlm');新版定义:net=newff(input,output,14,{'tansig','purelin'},'trainlm'); Example2比如输入input(6*1000),输出output为(4*1000),那么旧版定义:net=newff(minmax(input),[49,14,4],{'tansig','tansig','tansig'},'traingdx');新版定义:net=newff(input,output, [49,14], {'tansig','tansig','tansig'},'traingdx');三、旧版newff使用方法在新版本中使用提示:旧版本定义的newff虽也能在新版本中使用,但会有警告,警告如下:Warning: NEWFF used in an obsolete way.> In obs_use at 18In newff>create_network at 127In newff at 102See help for NEWFF to update calls to the new argument list.四、新版newff与旧版newff使用的训练效果对比旧版本:旧用法训练次数多,但精度高新版本:新用法训练次数少,但精度可能达不到要求造成上述原因是:程序里面的权值、阈值的初始值是随机赋值的,所以每次运行的结果都会不一样,有好有坏。

数学建模之神经预测ANN方法

生物神经元,也称神经细胞,它是由细胞体、 树突、轴突和突触等生物组织构成的,并通过细胞 膜电位来实现生物神经元的兴奋与抑制、学习与联 想等基本功能,因此,它是构成人脑神经系统的基 本功能单元。其结构如下图所示。

根据生物神经元的结构与基本功能,可以将其 简化为下图的形式,并建立神经网络模型的基础—— 人工神经元数学模型:

n

y j f ( wij xi a j ) i1

其中,y j 表示神经元 j 的输出;xi 表示神经元i 的输入; wij 表示神经元 i 与神经元 j 之间的连接权值;a j 表示神 经元 j 的阈值;f (•) 是输入到输出传递函数(也称激活 函数).

下表给出了一些常用的传递函数。除线性传递 函数外,其它的均是非线性的,因此,神经网络特 别适合于解决非线性问题。

化各层神经元之间的连接权值 vij , wjk ,初始化隐含层阈值 a ,输出

层阈值 b ,给定学习速率和神经元传递函数.

步骤 2:隐含层输出计算。根据输入向量 X ,输入层和隐含层间连

接权值vij 以及隐含层阈值 a ,计算隐含层输出.

n

n

yi f ( vij xi a j ) f ( vij xi )

取 NAN) 最大训练时间(秒)

net.trainParam.max_fail=5 确认失败的最大次数

net.trainParam.min_grad=1e-6 最小性能梯度

net.trainParam.lr=0.2

学习速率

(3)sim——BP 神经网络预测/仿真函数 函数功能:用训练好的 BP 神经网络预测/仿真函数输出. 函数形式:Y=sim(net,x)

神经网络训练函数 训练函数的意义 梯度下降法 动量反传的梯度下降法 动态自适应学习率(lr)的梯度下降法 带动量动态自适应学习率(lr)的梯度下降法 弹性梯度下降法 量化共轭梯度法 Levenberg_Marquardt 法 Fletcgera-Reeves 共轭梯度法 Polak-Ribiere 共轭梯度法 Powell-Beale 共轭梯度法

神经网络模拟试题

神经网络模拟试题叶伟、朱宇涛、双银锋一.填空:1.神经元(即神经细胞)是由细胞体、树突、轴突和突触四部分构成。

2.按网络结构分,人工神经元细胞可分为前馈型和反馈型,按照学习方式分可分为:有导师和无导师学习。

3.前馈型网络可分为可见层和隐含层,节点有输入结点、输出节点、计算单元。

4.反馈网络历经状态转移,直到它可能找到一个平衡状态,这个平衡状态称为吸引子。

5.神经网络工作过程主要由工作期和学习期两个阶段组成。

6.在ANN中HEBB算法最简单可描述为:如果一个处理单元从另一处理单元接收输入激励信号,而且两者都处于高激励电平,那么处理单元间的加权就应当增强。

HEBB网络代表了一种纯前向式无导师学习。

7.δ学习规则又称最小均方规则,它利用目标激活值与所得激活值之差进行学习。

其方法是:调整联系强度,使其差最小。

8.常见的七种学习规则中,无导师学习的规则是指HEB学习和胜者为王学习规则。

9.误差反传训练算法的主要思想是学习过程分为两个阶段:正向传播过程和反向过程。

10.网络吸引子分为稳定和非稳定两种,非稳定吸引子又有两种情况:有限状态指网络状态有规律地在某些状态之间振荡;而混沌状态是指网络无规律地某些状态之间振荡。

二、判断题:1.对反馈网络而言,稳定点越多,网络的联想与识别能力越强,因此,稳定点的数据目越多联想功能越好。

(╳)2.简单感知器仅能解决一阶谓词逻辑和线性分类问题,不能解决高阶谓词和非线分类问题。

(∨)3.BP算法是在无导师作用下,适用于多层神经元的一种学习,它是建立在相关规则的基础上的。

(╳)(╳)4.在误差反传训练算法中,周期性函数已被证明收敛速度比S型函数慢。

5.基于BP算法的网络的误差曲面有且仅有一个全局最优解。

(╳)6.对于前馈网络而言,一旦网络的用途确定了,那么隐含层的数目也就确定了。

(╳)7.对离散型HOPFIELD网络而言,如权矩阵为对称阵,而且对角线元素非负,那么网络在异步方式下必收敛于下一个稳定状态。

matlab神经网络newff函数的使用

matlab神经网络newff函数的使用设[P,T]是训练样本,[X,Y]是测试样本;net=newrb(P,T,err_goal,spread); %建立网络q=sim(net,p);e=q-T;plot(p,q); %画训练误差曲线q=sim(net,X);e=q-Y;plot(X,q); %画测试误差曲线训练前馈网络的第一步是建立网络对象。

函数newff建立一个可训练的前馈网络。

这需要4个输入参数。

第一个参数是一个Rx2的矩阵以定义R个输入向量的最小值和最大值。

第二个参数是一个设定每层神经元个数的数组。

第三个参数是包含每层用到的传递函数名称的细胞数组。

最后一个参数是用到的训练函数的名称。

举个例子,下面命令将创建一个二层网络。

它的输入是两个元素的向量,第一层有三个神经元(3),第二层有一个神经元(1)。

第一层的传递函数是tan-sigmoid,输出层的传递函数是linear。

输入向量的第一个元素的范围是-1到2[-1 2],输入向量的第二个元素的范围是0到5[0 5],训练函数是traingd。

net=newff([-1 2; 0 5],[3,1],{'tansig','purelin'},'traingd');这个命令建立了网络对象并且初始化了网络权重和偏置,因此网络就可以进行训练了。

我们可能要多次重新初始化权重或者进行自定义的初始化。

下面就是初始化的详细步骤。

在训练前馈网络之前,权重和偏置必须被初始化。

初始化权重和偏置的工作用命令init 来实现。

这个函数接收网络对象并初始化权重和偏置后返回网络对象。

下面就是网络如何初始化的:net = init(net);我们可以通过设定网络参数net.initFcn和yer{i}.initFcn这一技巧来初始化一个给定的网络。

net.initFcn用来决定整个网络的初始化函数。

前馈网络的缺省值为initlay,它允许每一层用单独的初始化函数。

Matlab工具箱中的BP与RBF函数要点

Matlab工具箱中的BP与RBF函数Matlab神经网络工具箱中的函数非常丰富,给网络设置合适的属性,可以加快网络的学习速度,缩短网络的学习进程。

限于篇幅,仅对本章所用到的函数进行介绍,其它的函数及其用法请读者参考联机文档和帮助。

1 BP与RBF网络创建函数在Matlab工具箱中有如表1所示的创建网络的函数,作为示例,这里只介绍函数newff、newcf、newrb和newrbe。

表 1 神经网络创建函数(1) newff函数功能:创建一个前馈BP神经网络。

调用格式:net = newff(PR,[S1 S2...S Nl],{TF1 TF2...TF Nl},BTF,BLF,PF) 参数说明:•PR - R个输入的最小、最大值构成的R×2矩阵;•S i–S NI层网络第i层的神经元个数;•TF i - 第i层的传递函数,可以是任意可导函数,默认为'tansig',可设置为logsig,purelin等;•BTF -反向传播网络训练函数,默认为'trainlm',可设置为trainbfg,trainrp,traingd等;•BLF -反向传播权值、阈值学习函数,默认为'learngdm';•PF -功能函数,默认为'mse';(2) newcf函数功能:创建一个N层的层叠(cascade)BP网络调用格式:net = newcf(Pr,[S1 S2...SNl],{TF1 TF2...TFNl},BTF,BLF,PF) 参数同函数newff。

(3) newrb函数功能:创建一个径向基神经网络。

径向基网络可以用来对一个函数进行逼近。

newrb函数用来创建一个径向基网络,它可以是两参数网络,也可以是四参数网络。

在网络的隐层添加神经元,直到网络满足指定的均方误差要求。

调用格式:net = newrb(P,T,GOAL,SPREAD)参数说明:•P:Q个输入向量构成的R×Q矩阵;•T:Q个期望输出向量构成的S×Q矩阵;•GOAL:均方误差要求,默认为0。

基于神经网络的水产养殖水质预测模型研究

基于神经网络的水产养殖水质预测模型研究袁琦;黄建清;符新;翁绍捷【摘要】Since the aquaculture pond is a multi-variables,nonlinearity and long-time lag system,the traditional water quality prediction method could not easily establish an accurate model.Neural network has the advantageof approximating the nonlinear function,it is an ideal method for dealing with the complex problems such as prediction of water quality.A prediction model of pH based on BP neural network was established by applying a dynamic self-adaptive learning method and model optimization.This model was completed by programming with neural network toolbox of MATLAB.The results showed that the average relative error was less than 1%between the value of prediction and the measured value when the trained network was applied in prediction.It was indicated that the prediction model of aquaculture water quality based on selfadaptive BP algorithmhad good accuracy and precision,and it could effectively predict the fishery water quality.%水产养殖池塘是一个多变量、非线性和大时延系统,很难用传统方法建立水质预测的精确模型.神经网络具有良好的非线性函数逼近能力,非常适合处理水质预测等复杂问题.利用BP神经网络模型,通过自适应的动态学习方法和模型优化,采用MATLAB神经网络工具箱建立了水产养殖水环境因子pH值预测模型.在预测模型中输入测试样本,将预测结果与实测值进行比较,平均相对误差小于1%.结果表明,所构建的基于自适应BP算法的水产养殖水质预测模型具有良好的精确性和准确性,能有效地预测养殖池塘的水质状况.【期刊名称】《湖北农业科学》【年(卷),期】2013(052)001【总页数】4页(P143-146)【关键词】神经网络;自适应BP算法;预测模型;pH;水产养殖;水质【作者】袁琦;黄建清;符新;翁绍捷【作者单位】海南大学机电工程学院,海口 570228;华南农业大学工程学院,广州510642;海南大学机电工程学院,海口 570228;海南大学机电工程学院,海口570228【正文语种】中文【中图分类】TP183随着水产养殖业的迅速发展,温度、pH值、溶解氧等水质参数作为养殖水域必控的水环境因子越来越受到重视[1]。

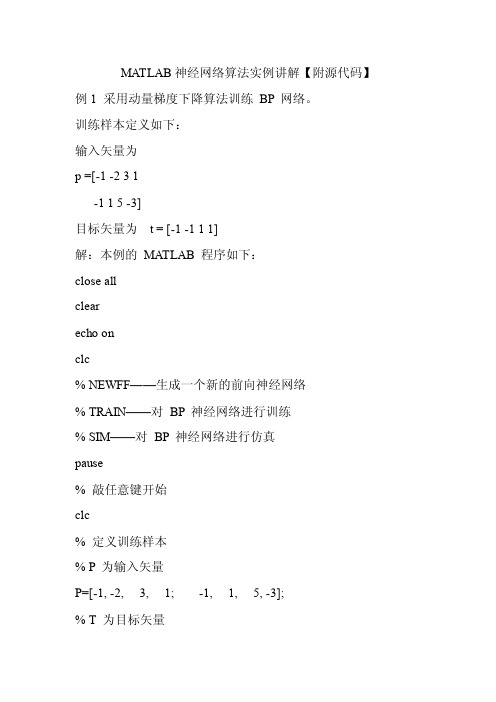

MATLAB神经网络算法实例讲解【附源代码】

MA TLAB神经网络算法实例讲解【附源代码】例1 采用动量梯度下降算法训练BP 网络。

训练样本定义如下:输入矢量为p =[-1 -2 3 1-1 1 5 -3]目标矢量为t = [-1 -1 1 1]解:本例的MA TLAB 程序如下:close allclearecho onclc% NEWFF——生成一个新的前向神经网络% TRAIN——对BP 神经网络进行训练% SIM——对BP 神经网络进行仿真pause% 敲任意键开始clc% 定义训练样本% P 为输入矢量P=[-1, -2, 3, 1; -1, 1, 5, -3];% T 为目标矢量T=[-1, -1, 1, 1];pause;clc% 创建一个新的前向神经网络net=newff(minmax(P),[3,1],{'tansig','purelin'},'traingdm') % 当前输入层权值和阈值inputW eights=net.IW{1,1}inputbias=net.b{1}% 当前网络层权值和阈值layerW eights=net.LW{2,1}layerbias=net.b{2}pauseclc% 设置训练参数net.trainParam.show = 50;net.trainParam.lr = 0.05;net.trainParam.mc = 0.9;net.trainParam.epochs = 1000;net.trainParam.goal = 1e-3;pauseclc% 调用TRAINGDM 算法训练BP 网络[net,tr]=train(net,P,T);pauseclc% 对BP 网络进行仿真A = sim(net,P)% 计算仿真误差E = T - AMSE=mse(E)pauseclcecho off例2 采用贝叶斯正则化算法提高BP 网络的推广能力。

人工神经网络与神经网络优化算法

其中P为样本数,t j, p 为第p个样本的第j个输

出分量。

感知器网络

1、感知器模型 2、学习训练算法 3、学习算法的收敛性 4.例题

感知器神经元模型

感知器模型如图Fig2.2.1 I/O关系

n

y wipi bi

i 1

y {10

y0 y0

图2.2.1

单层感知器模型如图2.2.2

定义加权系数

10.1 人工神经网络与神经网络优化算法

③第 l 1层第 i个单元到第个单元的权值表为

; l1,l ij

④第 l 层(l >0)第 j 个(j >0)神经元的

输入定义为 , 输出定义 Nl1

x

l j

y l 1,l ij

l 1 i

为

yLeabharlann l jf (xlj )

, 其中 i0 f (•)为隐单元激励函数,

人工神经网络与神经网络优化算法

自20世纪80年代中期以来, 世界上许多国 家掀起了神经网络的研究热潮, 可以说神 经网络已成为国际上的一个研究热点。

1.构成

生物神经网

枝蔓(Dendrite)

胞体(Soma)

轴突(Axon) 胞体(Soma)

2.工作过程

突触(Synapse)

生物神经网

3.六个基本特征: 1)神经元及其联接; 2)神经元之间的联接强度决定信号传递的强

函数的饱和值为0和1。

4.S形函数

o

a+b

c=a+b/2

(0,c)

net

a

2.2.3 M-P模型

McCulloch—Pitts(M—P)模型, 也称为处理单元(PE)

x1 w1

人工神经网络是一个非线性的有向图.

xn wn

∑

x1 w1

x2 w2

net=XW

…

人工神经元模拟生物神经元的一阶特性。 输入:X=(x1,x2,…,xn) 联接权:W=(w1,w2,…,wn)T 网络输入: net=∑xiwi 向量形式: net=XW

*

*

a+b

o

(0,c)

net

a

c=a+b/2

1、BP算法的出现 非循环多级网络的训练算法 UCSD PDP小组的Rumelhart、Hinton和Williams1986年独立地给出了BP算法清楚而简单的描述 1982年,Paker就完成了相似的工作 1974年,Werbos已提出了该方法 2、弱点:训练速度非常慢、局部极小点的逃离问题、算法不一定收敛。 3、优点:广泛的适应性和有效性。

interval=0.1; [x1, x2]=meshgrid(-1.5:interval:1.5); F = 20+x1.^2-10*cos(2*pi*x1)+x2.^2-10*cos(2*pi*x2); mesh(x1,x2,F); Surf(x1,x2,F);

interval=0.1; [i, j]=meshgrid(-1.5:interval:1.5); row=size(i); tx1=i(:); tx1=tx1'; tx2=j(:); tx2=tx2'; tx=[tx1;tx2]; %testing ty=sim(net,tx); v=reshape(ty,row); figure subplot(1,3,2) mesh(i,j,v);

应该将net的值尽量控制在收敛比较快的范围内 可以用其它的函数作为激活函数,只要该函数是处处可导的

神经网络的训练(问题集锦)

神经⽹络的训练(问题集锦)问:rbf神经⽹络的训练样本要多⼤?答:因课题⽽异。

1、样本最关键在于正确性和准确性。

你所选择的样本⾸先要能正确反映该系统过程的内在规律。

我们从⽣产现场采得的样本数据中有不少可能是坏样本,例如由于测量仪器故障导致测量数据误差较⼤等,这样的样本会⼲扰你的神经⽹络训练。

通常我们认为坏样本只是个别现象,所以我们希望通过尽可能⼤的样本规模来抵抗坏样本造成的负⾯影响。

2、其次是样本数据分布的均衡性。

你所选择的样本最好能涉及到该系统过程可能发⽣的各种情况。

例如某化⼯⽣产中某反应炉的温度主要分布在350度—400度,且出现在380度的情况较多,那么你的样本数据最好也是在350-400度各种情况都有,并且也是在380度左右的样本较多些,这样可以极⼤可能的照顾到系统在各个情况下的规律特征。

通常我们对系统的内在规律不是很了解,所以我们希望通过尽可能⼤的样本规模来“地毯式”覆盖对象系统的⽅⽅⾯⾯。

3、再次就是样本数据的规模,也就是你要问的问题。

在确保样本数据质量和分布均衡的情况下,样本数据的规模决定你神经⽹络训练结果的精度。

样本数据量越⼤,精度越⾼。

还⽤刚才的例⼦,假如反应炉的温度主要均匀分布在375-385度之间,那么你⽤100个均衡分布在375-385度的训练样本去训练,经过⽆限次或者说是⾜够多次迭代之后,理论上你的神经⽹络的精度就是0.1度。

如果你觉得0.1度⾜够细腻了,那么样本规模为100也就可以接受了。

由于样本规模直接影响计算机的运算时间,所以在精度符合要求的情况下,我们不需要过多的样本数据,否则我们要等待很久的训练时间。

补充说明⼀下,不论是径向基(rbf)神经⽹络还是经典的bp神经⽹络,都只是具体的训练⽅法,对于⾜够多次的迭代,训练结果的准确度是趋于⼀致的,⽅法只影响计算的收敛速度(运算时间),和样本规模没有直接关系。

问:BP神经⽹络如何确定神经元个数?答:现在还没有什么成熟的定理能确定各层神经元的神经元个数和含有⼏层⽹络,⼤多数还是靠经验,不过3层⽹络可以逼近任意⼀个⾮线性⽹络,神经元个数越多逼近的效果越好。

[转载]MATLAB中神经网络的函数

![[转载]MATLAB中神经网络的函数](https://img.taocdn.com/s3/m/a8864264f56527d3240c844769eae009581ba22d.png)

[转载]MATLAB中神经⽹络的函数1.设计函数solvein 设计线性⽹络; solverb 设计径向基⽹络; solverbe 设计精确的径向基⽹络;solvehop 设计Hopfield⽹络。

2.传递函数hardlim 硬限幅传递函数; hardlims 对称硬限幅传递函数; purelin 线性传递函数;tansig 正切S型传递函数; logsig 对数S型传递函数; satlin 饱和线性传递函数;satlins 对称饱和线性传递函数; radbas 径向基传递函数; dist 计算⽮量间的距离;compet ⾃组织映射传递函数; dpurelin 线性传递函数的导数; dtansig 正切S型传递函数的导数;dlogsig 对数S型传递函数的导数。

3.学习规则learnp 感知层学习规则; learnpn 规范感知层学习规则; learnbp BP学习规则;learnbpm 带动量项的BP学习规则; learnlm Levenberg-Marquardt学习规则;learnwh Widrow-Hoff学习规则; learnk Kohonen学习规则; learncon Conscience阈值学习函数;learnsom ⾃组织映射权学习函数; learnh Hebb学习规则; learnhd 退化的Hebb学习规则;learnis 内星学习规则; learnos 外星学习规则;4.⽹络创建函数newp 创建感知器⽹络; newlind 设计⼀线性层; newlin 创建⼀线性层;newff 创建⼀前馈BP⽹络; newcf 创建⼀多层前馈BP⽹络; newfftd 创建⼀前馈输⼊延迟BP⽹络;newrb 设计⼀径向基⽹络; newrbe 设计⼀严格的径向基⽹络; newgrnn 设计⼀⼴义回归神经⽹络;newpnn 设计⼀概率神经⽹络; newc创建⼀竞争层; newsom 创建⼀⾃组织特征映射;newhop 创建⼀Hopfield递归⽹络; newelm 创建⼀Elman递归⽹络;5.⽹络应⽤函数sim 仿真⼀个神经⽹络; init 初始化⼀个神经⽹络; adapt 神经⽹络的⾃适应化;train 训练⼀个神经⽹络。

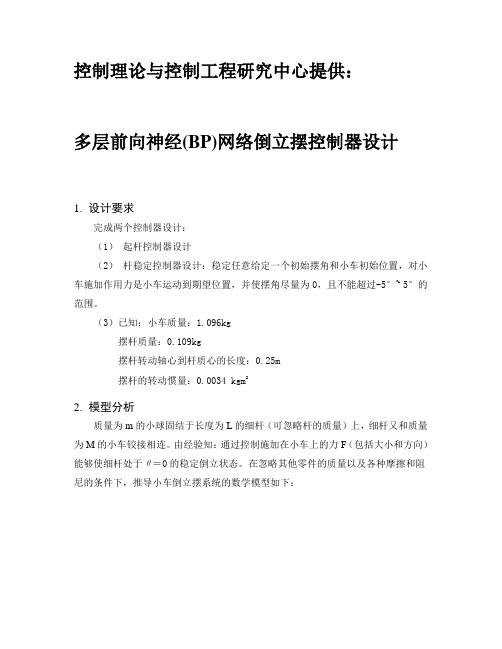

多层前向(BP)神经网络倒立摆控制器设计

控制理论与控制工程研究中心提供:多层前向神经(BP)网络倒立摆控制器设计1.设计要求完成两个控制器设计:(1)起杆控制器设计(2)杆稳定控制器设计:稳定任意给定一个初始摆角和小车初始位置,对小车施加作用力是小车运动到期望位置,并使摆角尽量为0,且不能超过-5°~ 5°的范围。

(3)已知:小车质量:1.096kg摆杆质量:0.109kg摆杆转动轴心到杆质心的长度:0.25m摆杆的转动惯量:0.0034 kgm22.模型分析质量为m的小球固结于长度为L的细杆(可忽略杆的质量)上,细杆又和质量为M的小车铰接相连。

由经验知:通过控制施加在小车上的力F(包括大小和方向)能够使细杆处于θ=0的稳定倒立状态。

在忽略其他零件的质量以及各种摩擦和阻尼的条件下,推导小车倒立摆系统的数学模型如下:图1 倒立摆模型在不考虑摩擦时倒立摆的运动方程可以由如下非线性微风方程描述:当状态变量在小的范围内变动时,可将其局部线性化,因为32sin ,cos 13!2!θθθθθ≈-≈-所以当θ很小时,由cos θ、sin θ的幂级数展开式可知,忽略高次项后, 可得cos θ≈1,sin θ≈θ,θ’’≈0。

故线性化后运动方程组简化为: x1’=θ’=x2 x2’=''θ=()Ml g m M +x1-Ml1 FX3’ =x ’=x4 x4’=x ’’=-Mmg x1+M1 F化为状态空间表达式:X ’=⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡'4'3'2'1x x x x =()⎥⎥⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎢⎢⎣⎡-+0010000000010Mmg Ml gm M ⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡4321x x x x + ⎥⎥⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎢⎢⎣⎡-MMl 1010 FY= ⎥⎦⎤⎢⎣⎡31x x =⎥⎦⎤⎢⎣⎡010001⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡4321x x x x + 0⨯F 综上所属,可将倒立摆进行动力学建模,写出动力学方程,并当状态变量在小范围内变化时,可局部线性化,写出该模型的状态空间方程。