数据库安全产品选型

数据库技术选型的原则与技巧

数据库技术选型的原则与技巧在现代信息技术的高速发展中,数据库技术成为了企业信息化建设不可缺少的一部分。

而在选型过程中,负责技术选型的人员需要考虑到各种不同的因素,如性能、安全性、可用性、成本等因素。

本文将从数据库技术选型的基本原则、常见的数据库架构以及不同类型数据库的适用场景等方面进行探讨,希望能够帮助读者更好地理解数据库技术选型并能够更加准确地选择适合企业的数据库技术。

一、数据库技术选型的基本原则在数据库技术选型的过程中,需要考虑多个方面的因素。

以下是一些基本原则:1.数据库技术必须符合企业的业务需求技术与业务的关系不可忽视。

如果技术选型不符合企业的业务需求,则数据库无论如何优秀,也无法带来更多的价值。

因此,首要的任务是了解企业的业务需求,以便选择适合的数据库技术。

例如,如果企业需要处理复杂的数据分析任务,则需要选择支持复杂查询和分析的数据库。

2.数据库技术必须具有高可用性和可靠性在企业的信息系统中,数据库往往是最重要的一环,也是最容易出现问题的一环。

因此,数据库技术必须具有高可用性和可靠性,能够保证数据的安全和稳定运行。

当数据库故障时,必须能够快速恢复数据,并且能适应数据增长。

3.数据库技术必须具有良好的性能企业的生产系统需要在高速运行的同时保证高质量的服务。

因此,数据库技术必须具有良好的性能,以确保数据的快速访问和高效处理。

4.数据库技术选型必须合理经济虽然数据库技术在企业的信息化建设中扮演着重要的角色,但不应过分消耗企业的经济和资源。

因此,在选择数据库技术时,需要根据企业的实际情况考虑成本和收益,并选择适合的技术和版本。

二、数据库架构的常见类型及其选择在数据库选型中,架构是一个非常重要的因素。

不同的架构可提供不同的功能和特性,但也存在一些限制和约束。

以下是几种常见的数据库架构类型:1.单机数据库单机数据库是指运行在单个计算机上的数据库管理系统。

这种架构的最大优点是管理和维护比较简单。

但是,在数据量较大的情况下,单台服务器可能会无法满足业务需求,同时,并发操作容易导致数据库性能下降。

数据库选型:MySQL、Oracle和MongoDB

数据库选型:MySQL、Oracle和MongoDB随着互联网及大数据时代的到来,数据的规模和复杂度不断增大,如何实现高效、稳定、安全的数据存储和处理成为了企业数据管理中的重要问题。

在数据库中,MySQL、Oracle和MongoDB等数据库成为了各个领域最为常用的数据库系统。

本文将分别从MySQL、Oracle和MongoDB三个方面来探讨它们的优缺点以及适用场景,以期为企业数据库选型提供一些参考意见。

MySQL:开源数据库MySQL是一种开源数据库,根据MySQL官方网站统计,全球用户数量已超过1亿。

MySQL是一款基于SQL语言的关系型数据库管理系统,适用于大型企业、中小企业以及各种互联网应用程序等领域。

MySQL作为一种开源产品,具有以下优点:1.免费、开源。

MySQL以GPL(通用公共许可证)的方式发布,用户可以根据自己的需求,自由地获取、拷贝、修改和分发MySQL源代码,这使得用户可以在没有额外软件费用的情况下使用MySQL,为企业降低了成本。

2.易于学习,支持SQL语言。

MySQL采用标准化的SQL语言,操作简单、易学易用,使得用户快速掌握MySQL的使用技巧。

3.安全、可靠、稳定。

MySQL的安全性得到了广泛的认可,在短短几年内,已成为众多项目和应用程序的首选数据库系统,实时性高、支持高并发、可靠性高,受到了各种规模的企业用户及互联网应用、网站的广泛使用。

4.支持多个平台。

开源免费的MySQL支持多个平台,包括Linux、Unix、Windows等主流操作系统,兼容性强,易于部署。

但是,MySQL也存在一些缺点:1.对于高负载、高并发的应用,MySQL的性能和稳定性没有Oracle好,需要进行优化。

2. MySQL在处理大数据时,容易因为表锁定、索引失效等问题而卡住,导致系统的响应能力降低。

3. MySQL不支持XML和JSON数据类型,不适用于需要处理复杂数据结构的应用。

适用场景:MySQL适用于中小企业及互联网应用领域,如网站、博客、论坛等。

数据库解决方案

第1篇

数据库解决方案

一、背景分析

随着信息化建设的不断深入,数据已成为企业核心竞争力的关键要素。为充分发挥数据价值,提高企业运营效率,需构建一套稳定、高效、可扩展的数据库系统。本方案旨在解决企业在数据库建设过程中面临的性能、安全、管理等方面的问题,为企业提供全方位的数据库解决方案。

二、需求分析

(2)建立完善的数据库监控体系,实时掌握数据库运行状态。

(3)制定数据库管理规范,规范数据库开发、使用、维护等环节。

6.数据库扩展性设计

(1)采用分布式数据库技术,如MyCat、ShardingSphere等,满足大数据量存储需求。

(2)预留足够的硬件资源,便于后期扩展。

四、实施方案

1.项目筹备

成立项目组,明确项目目标、范围、时间表等。

(4)部署数据库防火墙,防止SQL注入等攻击。

4.数据库性能优化

(1)优化数据库参数,提高系统性能。

(2)定期进行数据库维护,如索引重建、碎片整理等。

(3)利用数据库性能监控工具,实时监控数据库性能,发现并解决问题。

5.数据库管理

(1)采用自动化运维工具,如Ansible、Puppet等,简化数据库部署、升级等操作。

三、目标设定

1.提升数据库性能,满足高并发、大数据量的处理需求。

2.加强数据库安全性,保障数据不被非法访问和篡改。

3.简化数据库管理流程,降低运维成本。

4.增强数据库系统的可扩展性,适应未来业务发展。

四、解决方案

1.数据库选型与架构设计

-根据业务特性和数据存储需求,选择适合的数据库类型,如关系型根据业务需求,选择合适的数据库产品及架构。

3.系统设计

完成数据库架构设计、安全方案设计、性能优化方案设计等。

数据库选型与架构设计的原则与方法

数据库选型与架构设计的原则与方法导言:在当今信息化时代,数据的重要性无可忽视。

对于大多数企业来说,数据库是管理和存储数据的核心工具。

选择合适的数据库以及设计良好的架构是确保数据安全、高效运行以及满足未来发展需求的关键决策。

本文将介绍数据库选型与架构设计的原则与方法,帮助您在面对众多选项时能够做出明智的决策。

一、数据库选型的原则1. 数据需求分析:在选择数据库之前,首先需进行全面的数据需求分析。

具体而言,需要了解数据的类型(结构化、半结构化或非结构化)、容量、访问模式、数据完整性以及处理速度等方面的要求。

只有全面了解数据需求,才能选择合适的数据库。

2. 产品评估:在选择数据库时,可以从开源数据库和商业数据库两个方面考虑。

开源数据库具有可裁剪、高拓展性的优点,而商业数据库在事务处理和数据敏感性方面的安全性更高。

在评估数据库时,需考虑其可扩展性、性能、稳定性、安全性以及社区支持等方面的因素。

3. 性价比评估:除了功能和性能,还需综合考虑数据库的许可费用、维护成本以及人员培训成本等因素。

有时候,免费开源的数据库可能比付费商业数据库更适合特定的项目。

要进行综合评估,确定哪款数据库在长期运营中具有良好的性价比。

4. 技术支持与服务:数据库的选型不仅仅在于产品本身的功能,还需考虑供应商提供的技术支持和服务。

了解数据库供应商的可靠性、响应时间、问题解决能力以及扩展服务等,对于长期运营来说至关重要。

5. 跨平台兼容性:随着云计算和移动互联网的普及,跨平台兼容性变得越来越重要。

选择支持多种操作系统和编程语言的数据库,可以保证系统能够灵活地在不同环境下运行,提高开发效率和协作能力。

二、架构设计的原则与方法1. 数据库范式设计:设计数据库时,应尽量符合数据库范式设计的原则,以达到有效的数据组织和查询性能。

首先,需设计适当的数据表结构,将数据按照属性分解为不可再分的子元素;其次,设计外键关联建立关系;还需避免冗余数据以及多值数据等不符合范式的设计。

数据库服务器选型原则及实例解说.doc

数据库服务器选型原则及实例解说数据库服务器作为业务系统的核心.具有业务虽大、存储数据址大等特点。

它承担着业务数据的存储和处理任务,因此关键数据库服务器的选择就显得尤为重要。

服务器的可靠性和可用性是首嬰的需求.其次是数据处理能力和安全性.然后是可扩展性和可管理性。

根据应用类型和规模的不同,数据库对于服务器的性能要求也不一样。

如对于大型数据库(ERP, OLTP, data mart)说.服务器往往仅用來运行数据库,或仅运行紙一的应用。

数据库的容虽在1TB以上.需耍有较商的CPU 处理能力.大容虽内存为数据缓存服务,并需要很好的10性能.使用这类应用时.通常需要有较高的CPU主频。

那么,具体到某个行业甚至某个项目,数据库服务器该如何选择呢?数据库服务器选型五个原则首先.数据库服务器选型应该遵循以下几个原则:D高性能原则保证所选购的服务器.不仅能够满足运营系统的运行和业务处理的需婆,而且能够满足一定时期的业务虽増长的需要。

一般可以根据经验公式计算出所需的服务器TpmC值.然后比较备服务器厂商和TPC组织公布的TpmC值.选择相应的机型。

同时•用服务器的市场价/报价除去计算出來的TpmC值得出爪位TpmC 值的价格.进而选择高性能价格比的服务器c2)可靠性原则可靠性原则是所有选择设备和系统中首要考虑的,尤其是在大型的、有大虽处理要求的、需要长期运行的系统。

考唐服务器系统的可靠性,不仅要考虑服务器单个节点的可靠性或稳定性.而且翌考世服务器与相关辅助系统之间连接的整体可靠性,如:网络系统、安全系统、远程打印系统等°在必耍时.还应考虑对关键服务器采用集群技术,如:双机热备份或集群并行访问技术.甚至采用可能的完全容错机。

比如,要保证系统潑件和操作系统)在99. 98$的时间内都能够正常运作(包括维修时间)•则故障停机时间六个丿]不得超过0・5个小时。

服务器需7X24小时连续运行•因而要求其具有很成的安全可靠性。

分布式数据库选型

分布式数据库选型随着数据规模的不断增长,传统的集中式数据库已经不能满足日益增长的数据处理需求。

而分布式数据库的出现为解决大规模数据的存储和处理提供了一种有效的解决方案。

在选择合适的分布式数据库时,我们需要考虑多个因素,包括数据库的功能、性能、可靠性、扩展性、安全性等。

本文将重点介绍几种常见的分布式数据库,并对其特点和适用场景进行分析,以帮助读者在选择时做出明智的决策。

一、分布式关系型数据库1. MySQL ClusterMySQL Cluster是MySQL官方推出的一款分布式数据库解决方案。

它使用基于共享存储的架构,通过数据分区和数据复制来实现高可用性和可扩展性。

MySQL Cluster具有数据一致性、数据冗余和自动故障切换等特性,适用于对事务支持要求较高的应用场景,如金融交易系统和电子商务平台。

2. PostgreSQLPostgreSQL是一款开源的关系型分布式数据库系统,具备良好的可扩展性和高可用性。

它支持水平扩展和数据分区,可以根据需求自由调整数据库的存储和计算能力。

PostgreSQL提供了丰富的功能和强大的查询优化能力,适用于复杂的数据模型和需要大规模数据存储的场景。

二、分布式列式数据库1. HBaseHBase是Apache Hadoop生态系统中的一部分,是一款基于列式存储的分布式数据库。

它具备高可伸缩性、高可用性和高性能的特点。

HBase适用于需要实时读写大规模结构化数据的场景,如实时分析、日志处理和用户行为分析等。

2. CassandraCassandra是一款高度可扩展的分布式列式数据库,广泛应用于大数据领域。

它支持跨数据中心的数据复制和多节点写入,并具备自动数据分片和负载均衡的特性。

Cassandra适用于需要高性能、大规模数据存储和快速读写的场景,如社交网络、物联网和实时分析。

三、分布式键值数据库1. Redis ClusterRedis Cluster是Redis官方提供的一种分布式数据库解决方案,支持数据分片和数据复制。

数据库选型评估报告

数据库选型评估报告一、引言随着信息时代的到来,数据量日益庞大,数据库成为管理和存储这些数据的基础设施。

而不同的应用场景对数据库的要求也不尽相同,因此数据库选型成为了一个重要的决策。

本评估报告旨在通过对不同数据库的比较和评估,为公司选择合适的数据库提供参考。

二、评估指标在进行数据库选型评估时,我们主要考虑以下几个指标:1.数据规模:即数据库需要管理和存储的数据量大小,包括数据表的数量和数据记录的条数。

2.数据模型:根据应用需求,选择符合数据模型的数据库,如关系型数据库、文档数据库、图数据库等。

3.数据库性能:包括读写性能、并发能力和吞吐量等,取决于数据库的架构和技术实现。

4.数据库安全性:包括用户认证、数据加密、访问控制等,以保护数据的安全和隐私。

5.数据库可靠性:包括数据备份和恢复、故障切换和容灾等,以保证数据库的连续可用性。

6.数据库扩展性:即在数据规模增加的情况下,数据库的性能和可用性是否能够随之扩展。

三、候选数据库比较根据上述评估指标,我们选取了以下三个数据库进行比较:1.MySQL:MySQL是一种常用的关系型数据库管理系统,具有较高的性能和稳定性,适合中小型数据量的应用。

2. MongoDB:MongoDB是一种基于文档存储的非关系型数据库,具有良好的扩展性和灵活的数据模型,适合大数据量和需要高可用性的应用。

3. Neo4j:Neo4j是一种图数据库,适用于处理复杂的关系和网络数据,具有强大的图查询能力。

四、评估结果根据对以上三个数据库的评估,得出如下结果:1. 数据规模:如果数据量相对较小,MySQL是一个经济实惠且稳定的选择;如果数据量较大,MongoDB和Neo4j能够提供分布式处理和扩展能力。

2. 数据模型:如果应用场景采用了复杂的关系和网络数据模型,Neo4j是最合适的选择;如果数据结构相对较简单,MySQL和MongoDB都能够满足需求。

3. 数据库性能:对于大部分应用场景,MySQL和MongoDB的性能已经足够;如果需要处理复杂的图查询,Neo4j可能更为适合。

数据库建设方案

数据库建设方案第1篇数据库建设方案一、背景随着信息化建设的不断深入,数据已成为企业核心资产之一。

构建稳定、高效、安全的数据库系统,对提高企业运营效率、优化决策过程具有重要意义。

本方案旨在结合现有技术,为企业提供一套合法合规的数据库建设方案,确保数据资产的有效管理和利用。

二、目标1. 满足业务需求:确保数据库系统满足企业各项业务的数据存储、查询和管理需求。

2. 高效稳定:提高数据库性能,降低故障发生率,确保系统稳定运行。

3. 安全合规:遵循相关法律法规,确保数据安全,防止数据泄露。

4. 易于维护:降低运维成本,提高数据库管理效率。

三、数据库选型根据企业业务需求和数据特点,选择合适的数据库类型和版本。

本方案推荐以下数据库选型:1. 关系型数据库:如MySQL、Oracle、SQL Server等,适用于结构化数据存储和管理。

2. 非关系型数据库:如MongoDB、Redis、Cassandra等,适用于半结构化和非结构化数据存储和管理。

3. 大数据数据库:如Hadoop、Spark等,适用于大规模数据存储和分析。

四、数据库设计1. 数据库架构:采用分层设计,分为数据源层、数据存储层、数据服务层、数据应用层。

2. 数据库表设计:遵循第三范式,确保数据一致性和完整性。

3. 索引优化:合理创建索引,提高查询性能。

4. 存储过程和函数:编写存储过程和函数,实现业务逻辑的封装,提高数据处理效率。

五、数据库安全1. 访问控制:采用角色授权机制,实现对数据库用户的权限控制。

2. 加密存储:对敏感数据进行加密存储,防止数据泄露。

3. 数据备份与恢复:定期进行数据备份,确保数据安全,提高灾难恢复能力。

4. 安全审计:开启数据库审计功能,记录用户操作行为,便于追踪和审计。

六、数据库性能优化1. 服务器硬件优化:提高服务器硬件配置,如CPU、内存、存储等。

2. 数据库参数调优:根据实际业务需求,调整数据库参数,提高性能。

安全产品选型与部署优化

安全产品选型与部署优化在当今数字化时代,企业和组织面临着日益复杂和多样化的安全威胁。

为了有效保护信息资产、维护业务连续性和满足合规要求,选择合适的安全产品并进行优化部署至关重要。

这不仅需要对各类安全产品有深入的了解,还需要结合组织的实际需求和环境进行综合考量。

安全产品的选型是构建强大安全防线的第一步。

首先,要明确组织的安全目标和需求。

是侧重于防范外部攻击、内部数据泄露,还是合规性遵循?不同的目标和需求将引导我们选择不同类型的安全产品。

防火墙是常见的基础安全产品之一。

在选型时,需要考虑其性能、功能和可扩展性。

例如,对于大型企业,需要具备高吞吐量和处理能力的防火墙,以应对大量的网络流量。

同时,防火墙的访问控制策略配置是否灵活、是否支持深度包检测等功能也是重要的考量因素。

入侵检测与防御系统(IDS/IPS)能够实时监测和阻止网络中的恶意活动。

在选择 IDS/IPS 产品时,检测准确率和响应速度是关键指标。

此外,其对新型攻击的识别能力以及与其他安全设备的集成性也需要关注。

加密技术在保护数据机密性方面起着重要作用。

无论是文件加密、磁盘加密还是通信加密,都需要根据数据的敏感性和使用场景选择合适的加密算法和产品。

例如,对于存储重要客户信息的数据库,可能需要采用高强度的加密算法和集中管理的加密系统。

防病毒和恶意软件防护产品也是必不可少的。

除了对常见病毒和恶意软件的检测能力外,其对零日攻击的防范能力、更新频率以及对终端设备的资源占用情况都需要评估。

在安全产品选型过程中,还需要考虑产品的易用性和管理成本。

过于复杂的产品可能导致配置错误和维护困难,增加运营成本。

同时,供应商的信誉和技术支持能力也是重要的因素。

一个可靠的供应商能够及时提供产品更新和技术支持,确保安全产品的持续有效性。

选好了安全产品,接下来就是优化部署。

合理的部署能够充分发挥安全产品的效能,最大程度地保护组织的网络和信息系统。

在网络架构方面,要根据组织的网络拓扑结构和业务流程,确定安全产品的部署位置。

数据中心的安全设备有哪几种类型

数据中心的安全设备有哪几种类型来源:机房360 作者:林小村更新时间:2010/11/17 16:56:07摘要:数据中心常用的网络及信息安全产品主要有防火墙、人侵检测、入侵防护、安全审计、漏洞扫描及桌面安全防护等软件和硬件,安全技术比较成熟,市场上产品种类也较多,为此,对数据中心安全设备的选型要求提出参考建议。

数据中心常用的网络及信息安全产品主要有防火墙、人侵检测、入侵防护、安全审计、漏洞扫描及桌面安全防护等软件和硬件,安全技术比较成熟,市场上产品种类也较多,为此,对数据中心安全设备的选型要求提出参考建议。

(1)产品应为国内自主研发,并拥有软件著作权登记证书。

(2)应具备国内权威机构的相关认证:公安部、国家信息安全测评认证中心、中国人民解放军信息安全测评认证中心、国家保密局,并提供相关证书编号。

(3)应具备标准千兆网络光接口,10/100/100兆网络电接口,10/100/1000兆网络接口。

(4)平均无故障时间(MTBF)不小于9万小时。

(5)应支持透明、路由、NAT、透明路由的混合模式的工作模式,支持多种网络地址转换,包括支持源网络地址转换,支持目的网络地址转换,支持双向地址转换,支持端口映射。

(6)应当可以通过图形配置界面,方便对网口的工作模式进行设定,如半双工/全双工、MTU等。

(7)应支持H。

323,UPNP等多媒体协议,应当支持在NAT工作方式下的多媒体协议穿透,应支持TNS、RTSP等动态协议。

(8)应支持基于时间的访问控制,应当可以手工配置时间,应当支持NTP服务器.(9)防火墙应具有局域网IP/MAC地址绑定功能,且必须具备MAC的自动学习功能。

(l0)提供应用代理功能,包括";HTTP、FTP、TELNET、SMTP、POP3、DNS、ICMP、SOCKS代理及自定义代理,并可实现透明代理。

(l1)产品应当支持DHCP服务器、DHCPRelay、DHCP客户端.(12)支持Radius和防火墙本地数据库认证。

国产数据库选型评估标准

国产数据库选型评估标准在选择国产数据库时,我们需要考虑一系列评估标准。

以下是一些主要的评估标准:1.性能指标评估数据库的性能指标是非常重要的。

这包括对数据库的读写速度、数据处理能力、并发处理能力、响应时间等方面进行评估。

这些性能指标可以直接影响应用系统的运行效率和用户体验。

2.功能完善度评估数据库的功能完善度,包括对数据库的查询功能、索引功能、数据存储和组织方式、事务处理能力等方面进行评估。

功能完善的数据库可以更好地满足业务需求,提高应用系统的效率和稳定性。

3.安全性评估数据库的安全性是至关重要的。

这包括对数据库的账号和权限管理、数据加密和隐私保护、安全审计和日志等方面的评估。

安全性高的数据库可以更好地保护用户的数据安全和隐私。

4.兼容性评估数据库的兼容性,包括对数据库与其他系统、应用软件和操作系统的互操作能力进行评估。

兼容性好的数据库可以更好地与其他系统进行集成,提高系统的整体效率和稳定性。

5.可维护性评估数据库的可维护性,包括对数据库的安装和升级、故障排除和恢复、备份和恢复策略等方面的评估。

可维护性好的数据库可以更好地降低运维成本,提高系统的可用性和稳定性。

6.可靠性评估数据库的可靠性,包括对数据库的容错能力和稳定性进行评估。

可靠性高的数据库可以更好地保证数据的一致性和完整性,提高系统的可用性和稳定性。

7.成本效益评估数据库的成本效益,包括对数据库的购买成本、运营成本、维护成本和升级成本等方面的评估。

成本效益好的数据库可以更好地降低企业的IT投入成本,提高企业的经济效益。

8.技术支持能力评估数据库的技术支持能力,包括对厂商的技术实力、客户支持和服务能力等方面的评估。

技术支持能力强的厂商可以更好地提供及时有效的技术支持和服务,解决用户遇到的问题和困难。

关系型数据库选型指南

关系型数据库选型指南在当今数据驱动的时代,企业对于存储、管理和处理大规模数据的需求变得越来越重要。

而关系型数据库作为持久性数据存储的核心工具之一,扮演着至关重要的角色。

关系型数据库的选型决策对一个企业的数据管理和业务发展至关重要,本文将为您介绍关系型数据库选型的指导原则和注意事项。

1. 数据规模和性能在选择关系型数据库时,首先要考虑的是企业的数据规模和性能要求。

根据数据量的大小、读写频率和部署场景的不同,选择适合的关系型数据库是至关重要的。

若数据量巨大且需要高性能,则一些高可扩展的关系型数据库如Oracle、SQL Server、MySQL Cluster等可能是较好的选择;而对于中小型企业或数据量较小的应用,则一些开源的关系型数据库如MySQL、PostgreSQL、SQLite等都是不错的选择。

2. 功能和功能扩展当选择关系型数据库时,了解其所提供的功能特性非常重要。

根据企业应用的需求,确定数据库需要支持的功能,例如事务处理、数据完整性、索引优化、备份和恢复等。

此外,还要考虑数据库的功能扩展性,即支持是否容易插件化、有无成熟的第三方扩展等。

一些商业数据库如Oracle、DB2等在功能和功能扩展方面较为强大,而开源数据库如MySQL和PostgreSQL也提供了广泛的功能特性和扩展机制。

3. 支持和生态系统选择一个有良好支持和庞大生态系统的关系型数据库也非常重要。

官方文档的完善、社区的活跃程度、开发者资源的丰富度都能够为企业在遇到问题时提供重要的支持。

此外,关系型数据库庞大的生态系统可以为企业提供多种多样的工具和框架,更好地满足不同的需求。

一些开源数据库如MySQL和PostgreSQL拥有庞大而活跃的社区,具有广泛的生态系统,而商业数据库如Oracle和SQL Server则有完善的技术支持和丰富的生态系统。

4. 安全性和数据一致性对于企业的关键数据,安全性和数据一致性非常重要。

因此,在选择关系型数据库时,要考虑其在安全性和数据完整性方面的功能和特性。

数据处理中的数据存储和数据管理技术选型指南(一)

数据处理中的数据存储和数据管理技术选型指南随着信息时代的到来,数据处理已经成为我们日常生活和工作中不可或缺的一部分。

而在数据处理过程中,数据存储和数据管理是两个至关重要的环节。

本文将介绍数据处理中的数据存储和数据管理技术选型指南,帮助读者选择合适的技术以满足其具体需求。

一、数据存储技术选型数据存储是指将数据保存在某个介质中,以便于后续的读取和处理。

在选择数据存储技术时,我们应考虑以下几个方面:1. 数据量和规模:如果你的数据量较小,可以选择使用传统的文件系统进行数据存储。

而如果数据量很大,可能需要考虑使用分布式文件系统或对象存储系统。

2. 读写性能要求:不同的数据存储技术在读写性能上有所差异。

如果你的应用对读写性能有较高要求,可以选择使用高性能的存储介质,如固态硬盘(SSD)或者分布式存储系统。

3. 数据安全性:对于一些敏感数据,数据安全性是一个非常重要的考虑因素。

在选择数据存储技术时,应考虑选择支持数据加密和访问控制等安全功能的存储方案。

4. 数据可靠性和容错性:数据存储中的数据丢失是一个很常见的问题,所以在选择数据存储技术时应考虑选择具备数据冗余和容错机制的方案,以保证数据的可靠性。

术,如传统的文件系统、分布式文件系统(如HDFS)、对象存储系统(如Amazon S3)等。

二、数据管理技术选型数据管理是指对数据进行组织、存储和访问的过程。

在选择数据管理技术时,我们应考虑以下几个方面:1. 数据库类型:根据数据的结构和应用场景,可以选择不同类型的数据库,如关系型数据库、非关系型数据库、图数据库等。

关系型数据库适用于结构化数据的存储和查询,非关系型数据库适用于半结构化和非结构化数据的存储和查询,而图数据库适用于复杂的关系数据的存储和查询。

2. 数据一致性和并发性:对于一些需要保持数据一致性和支持高并发读写的应用,可以选择使用分布式数据库或者新兴的NewSQL数据库。

3. 数据查询和分析功能:如果你的应用需要频繁的数据查询和分析,可以选择使用支持复杂查询和分析的数据库技术,如列存储数据库或者搜索引擎。

干货分布式关系型数据库选型原则和POC测试方法

干货分布式关系型数据库选型原则和POC测试方法分布式关系型数据库是当前云计算、大数据、物联网等领域中的重要技术之一、在选择合适的分布式关系型数据库之前,我们需要了解一些选型原则和进行相关的POC(Proof of Concept,概念验证)测试。

下面是关于分布式关系型数据库选型原则和POC测试方法的一些干货。

一、分布式关系型数据库选型原则在进行分布式关系型数据库的选型时,我们需要考虑以下几个原则:1.数据模型的需求:首先要明确应用的数据模型,包括数据结构、数据关系、数据访问频率等。

不同的数据模型可能适合不同的数据库系统。

例如,如果数据具有复杂的关系和层次结构,那么选择支持多关系模型的数据库可能更合适。

2.数据规模和可伸缩性:考虑应用中的数据规模以及数据的增长速度,选择具备良好可伸缩性的分布式数据库。

可伸缩性包括读写性能、存储容量等方面。

3.数据一致性和可靠性:对于需要保证严格一致性和高可靠性的应用,选择具备分布式事务、多副本机制以及容错能力的分布式数据库。

4.数据安全和权限控制:保证数据的安全性是重要的考虑因素之一、选择具备强大的权限控制和数据加密机制的数据库系统。

5.开发和维护成本:考虑数据库的开发和维护成本,包括学习成本、部署成本、运维成本等。

选择具备开发和管理工具完善的数据库系统。

进行POC测试是为了验证选定的分布式关系型数据库是否符合应用需求和预期性能。

以下是POC测试的一般步骤和测试方法:1.设计测试用例:根据实际业务需求,设计一系列的测试用例,包括数据读写性能测试、并发访问测试、故障恢复测试等。

测试用例要尽可能符合实际应用场景。

2.构建测试环境:搭建符合数据库系统要求的测试环境,包括数据库节点、网络连接等。

确保测试环境的稳定和可靠。

3.进行基准测试:首先进行基准测试,记录数据库的基本性能指标,如读写延迟、吞吐量、并发访问能力等。

基准测试是评估数据库性能的重要手段。

4.进行负载测试:根据设计的测试用例,模拟实际业务场景,对数据库进行负载测试。

数据库的选型

数据库的选型⽬录影响数据库选择的因素数据量:是否海量数据,单表数据量太⼤会考验数据库的性能数据结构:结构化 (每条记录的结构都⼀样) 还是⾮结构化的 (不同记录的结构可以不⼀样)是否宽表:⼀条记录是 10 个域,还是成百上千个域数据属性:是基本数据 (⽐如⽤户信息)、业务数据 (⽐如⽤户⾏为)、辅助数据 (⽐如⽇志)、缓存数据是否要求事务性:⼀个事务由多个操作组成,必须全部成功或全部回滚,不允许部分成功实时性:对写延迟,或读延迟有没有要求,⽐如有的业务允许写延迟⾼但要求读延迟低查询量:⽐如有的业务要求查询⼤量记录的少数列,有的要求查询少数记录的所有列排序要求:⽐如有的业务是针对时间序列操作的可靠性要求:对数据丢失的容忍度⼀致性要求:是否要求读到的⼀定是最新写⼊的数据对增删查改的要求:有的业务要能快速的对单条数据做增删查改 (⽐如⽤户信息),有的要求批量导⼊,有的不需要修改删除单条记录(⽐如⽇志、⽤户⾏为),有的要求检索少量数据 (⽐如⽇志),有的要求快速读取⼤量数据 (⽐如展⽰报表),有的要求⼤量读取并计算数据 (⽐如分析⽤户⾏为)是否需要⽀持多表操作不同的业务对数据库有不同的要求SQL 数据库 & NoSQL 数据库SQL 数据库就是传统的关系型数据库⾏列式表存储结构化数据需要预定义数据类型数据量和查询量都不⼤,如果数据量⼤要做分表对数据⼀致性、完整性约束、事务性、可靠性要求⽐较⾼⽀持多表 Join 操作⽀持多表间的完整性,要删除 A 表的某条数据,可能需要先删除 B 表的某些数据SQL 的增删改查功能强较为通⽤,技术⽐较成熟⼤数据量性能不⾜⾼并发性能不⾜⽆法应⽤于⾮结构化数据扩展困难常⽤的 SQL 数据库⽐如 Oracle、MySQL、PostgreSQL、SQLiteNoSQL 泛指⾮关系型数据库表结构较灵活,⽐如列存储,键值对存储,⽂档存储,图形存储⽀持⾮结构化数据有的不需要预定义数据类型,有的甚⾄不需要预定义表⽀持⼤数据量多数都⽀持分布式扩展性好基本查询能⼒,⾼并发能⼒⽐较强 (因为采⽤⾮结构化、分布式,并牺牲⼀致性、完整性、事务性等功能)对数据⼀致性要求⽐较低通常不⽀持事务性,或是有限⽀持通常不⽀持完整性,复杂业务场景⽀持较差通常不⽀持多表 Join,或是有限⽀持⾮ SQL 查询语⾔,或类 SQL 查询语⾔,但功能都⽐较弱,有的甚⾄不⽀持修改删除数据不是很通⽤,技术多样,市场变化⽐较⼤常⽤的 NoSQL 数据库⽐如列式:HBase、Cassandra、ClickHouse键值:Redis、Memcached⽂档:MongoDB时序:InfluxDB、Prometheus搜索:ElasticsearchSQL 和 NoSQL 是⼀个互补的关系,应⽤在不同的场景中OLTP & OLAPOLTP (On-Line Transaction Processing)主要做实时事务处理⽐如处理⽤户基本信息、处理订单合同、处理银⾏转账业务、企业的 ERP 系统和 OA 系统,等等频繁地,对少量数据,甚⾄是单条数据,做实时的增删改查数据库经常更新通常对规范化、实时性、稳定性、事务性、⼀致性、完整性等有要求操作较为固定,⽐如订单业务,可能永远就那⼏个固定的操作数据库主要模型是 3NF 或 BCNF 模型OLAP (On-Line Analytical Processing)数据仓库,主要做历史数据分析,为商业决策提供⽀持⽐如对⼤量的⽤户⾏为做分析,对设备的状态、使⽤率、性能做分析频率较低地,对⼤量数据,做读取、聚合、计算、分析,实时性要求不⾼,对吞吐能⼒要求较⾼通常列的数量⽐较多,但每次分析的时候只取少部分列的数据通常是批量导⼊数据通常数据导⼊后不会修改,主要是读取操作,写少读多通常对规范化、事务性、⼀致性、完整性等要求较低,甚⾄⼀个查询操作失败了也不会有什么影响操作较为灵活,⽐如⼀个海量⽤户⾏为数据表,可以想出许多不同的⽅法,从不同的⾓度对⽤户做分析数据库主要是星型、雪花模型不使⽤⾼性能的 OLAP 之前,更传统的做法是通过离线业务构建 T+1 的离线数据,⽐较滞后OLTP 通常⽤传统的关系数据库,如果数据量⼤要分表,对事务性、⼀致性、完整性等要求不⾼的话也可以⽤ NoSQLOLAP 通常⽤ NoSQL,数据量不⼤的话也可以⽤传统的关系数据库关系型数据库 Oracle、SQL Server、MySQL、PostgreSQL、SQLiteOracle:甲⾻⽂开发的商业数据库,不开源,⽀持所有主流平台,性能好,功能强,稳定性好,安全性好,⽀持⼤数据量,⽐较复杂,收费昂贵SQL Server:微软开发的商业数据库,只能在 Windows 运⾏MySQL:甲⾻⽂拥有的开源数据库,⽀持多种操作系统,体积⼩,功能弱些,简单的操作性能好,复杂的操作性能差些PostgreSQL:使⽤ BSD 协议的完全开源免费的项⽬,⽀持多种操作系统,功能更强⼤,可以和多种开源⼯具配合SQLite:开源、轻型、⽆服务器、零配置,⼀个数据库就只是⼀个⽂件,在应⽤程序内执⾏操作,占⽤资源⼩,可⽤于嵌⼊式或⼩型应⽤Oracle 多⽤于银⾏等⾼要求的领域,要求不⾼的⽐如互联⽹⾏业多⽤ MySQL 和 PostgreSQL,⽽ SQLite ⽤于嵌⼊式或作为应⽤程序内的数据库使⽤,SQL Server ⽤于 Window 服务器HBase (宽表、列式存储、键值对存储、NoSQL、OLTP)基于 Hadoop 的 HDFS 分布式⽂件系统分布式数据库,需要 ZooKeeper 作为节点间的协调器⽀持宽表,⽀持⾮结构化数据,不需要预定义列和数据类型列式存储,每个 HFile ⽂件只存储⼀个列族的数据,⼀个列族可以有多个 HFile,⽽ HFile 内部按 Key-Value 格式存储,其中 Key 是rowkey, column family, column, timestamp 的组合并且按 rowkey 在 HFile 中按序存储,⽽ value 就是 Column Cell 的值⽀持海量数据 (千亿级数据表)数据先写⼊内存,达到阀值再写⼊磁盘,性能好,占⽤内存⼤不⽀持 SQL,不⽀持 Join,有⾃⼰专⽤的语句,⽀持增删改查⾃动分区、负载均衡、可线性扩展⾃动故障迁移强⼀致性 (每个分区 Region 只由⼀个 Region Server 负责,容易实现强⼀致性)CP 模型 (不保证可⽤性,每个 Region 只由⼀个 Region Server 负责,Server 挂了得做迁移导致暂时不可⽤)不⽀持事务、⼆级索引组件⽐较多,⽐较重,适⽤于已有的 Hadoop 平台,适⽤于海量宽表数据、需要增删改查、OLTP 的场景Phoenix (基于 HBase 的数据库引擎、关系型、OLTP)嵌⼊到 HBase 的 Region Server 的数据库引擎⽀持 SQL⽀持 Join⽀持事务 (需要在定义表的时候配置)⽀持⼆级索引⽀持撒盐⽀持 JDBC⽤于强化 HBase,主要作为 OLTP,查询性能要求不⾼的话也可作为 OLAP,多⽤于 HDP (HDP 有集成 Phoenix)Cassandra (宽表、键值对存储、NoSQL、OLTP)⽆单点故障:Cassandra 节点按环形排列,没有中⼼节点,每个节点独⽴互联地扮演相同⾓⾊,每个节点都可以接受读写请求,数据可以有多个副本存储在多个节点,节点之间通过 Gossip (P2P) 协议交换状态信息,集群中有若⼲节点配为种⼦节点,⽤于新加⼊的节点获取集群拓扑结构并启动 Gossip 协议提供类 SQL 语⾔ CQL适合结构化、⾮结构化数据Table 需要定义 Partition Key、Clustering Key、以及普通列,其中 Partition Key ⽤于分区和排序,即按照 Partition Key 的 Hash Token 决定了数据被分配到哪个节点,并且在节点内也是按该 Hash Token 按序存储的,有相同 Partition Key 的数据会存在⼀起,并且按照 Clustering Key 排序存储,有点类似于 HBase 的 RowKey、ColumnFamily、Column,不过 HBase 是相同 CF 存⼀起,内部再按 RowKey 排序存储,再取 Column 值 (Column 值不排序),⽽ Cassandra 是先按 Partition Key 的 Token 排序存储,内部再按Clustering 排序存储,再取普通 Column 的值 (Column 值不排序)⾼度可扩展,允许添加硬件、节点以提⾼数据容量,同时保持快速的响应时间通过 Consistency 命令可以配置⼀致性级别,主要是通知客户端操作前,必须确保的 replica 的成功数量Cassandra 采⽤的是最终⼀致性,是 CAP 理论⾥的 APCassandra 不⽀持 Join 和⼦查询主要⽤于 OLTP,要求不⾼的话也可以作为 OLAP 使⽤,和 HBase ⽐需要的组件⽐较少,维护⽐较容易Redis (基于内存的 Key-Value 的 NoSQL 数据库,OLTP)由 C 语⾔编写⽀持多种数据类型如 strings,hashes,lists,sets,sorted sets,bitmaps,hyperloglogs,geospatial 等操作原⼦性,保证了两个客户端同时访问服务器将获得更新后的值数据存储在内存中可以配置持久化,周期性的把更新数据写⼊磁盘,或周期性地把修改操作写⼊追加记录⽂件,也可以关闭持久化功能,将 Redis 作为⼀个⾼效的⽹络缓存数据功能使⽤⽀持主从同步,数据可以从主服务器向任意数量的从服务器同步,从服务器可以是关联其他从服务器的主服务器,这使得 Redis 可执⾏单层树复制,存盘可以有意⽆意的对数据进⾏写操作,由于完全实现了发布/订阅机制,使得从数据库在任何地⽅同步树时,可订阅⼀个频道并接收主服务器完整的消息发布记录,同步对读取操作的可扩展性和数据冗余很有帮助⽀持消息的发布/订阅(Pub/Sub)模式单线程模式,即⽹络 IO、数据读写,都由⼀个线程完成,正因为如此保证了原⼦性、稳定性、代码容易维护,之所以单线程不影响性能,是因为数据都在内存,操作本来就⾼效,当然这⾥的单线程指⽹络 IO、数据读写这个主功能,实际上还有其他线程,⽐如周期性写⼊硬盘的线程⾼版本在⽹络 IO 这块使⽤了多线程 (因为在⾼并发操作时,⽹络 IO 成为了瓶颈),但读写操作还是单线程 (操作内存数据性能还是⾮常⾼的,能应付⾼并发场景)通常作为⾼性能内存数据库、缓存、消息中间件等使⽤memcached (基于内存的 Key-Value 的 NoSQL 数据库,OLTP)开源、⾼性能、分布式的基于内存的 Key-Value 数据存储,作⽤类似于 Redis存储 String/RawData,不定义数据结构 (Redis 有 hash、list、set 等多种结构)数据通常由 key,flags,expire time,bytes,value 组成服务端基本上只能简单的读写数据,服务端能⽀持的操作⽐较少包含 Server 组件和 Client 组件,可以有多个 server 但 server 之间是独⽴的,没有同步⼴播等机制,需要选择哪个 server 由 client 的API 决定的数据只在内存,不会落到硬盘没有安全机制协议简单性能⾼效memcached ⽐较简单,作为纯粹的 Key-Value 缓存性能会⽐ Redis 好些,但功能没有 Redis 强⼤MongoDB (⽂档数据库,NoSQL,OLTP)之所以说是⽂档数据库,是因为它的数据是以 JSON ⽂档的形式存储MongoDB 的概念和很多数据库不⼀样,它的 collection 相当于表,document 相当于⾏,field 相当于列⽐如er.insert({"name": "Lin","age": 30"address": {"street": "Zhongshan Road","city": "Guangzhou","zip": 510000},"hobbies": ["surfing", "coding"]})这是⼀条插⼊语句,这⾥的 db 是指当前数据库,user 就是 collection 相当于表,insert 语句⾥⾯的 JSON 就是 document 相当于其他数据库的⾏,name,age,street 这些就是 field 相当于列相同的⽂档可以插⼊多次⽽不会被覆盖,实际上 mongodb 会⾃动创建 _id 字段作为 primary key,并分配不同的数值,所以不会重复,也可以 insert 的时候指定 _id,但如果 _id 已经存在则会报错可以看到,mongodb 是⾮结构化数据,不需要预定义 collection,也不需要预定义数据结构提供丰富的查询表达式⽀持⼆级索引,⾃动负载平衡,读效率⽐写⾼⽀持分布式、⽀持故障恢复、数据冗余、分⽚、⽔平扩展可以配置存储引擎,WiredTiger Storage Engine (默认) 会做内存到⽂件的映射以提⾼性能,但内存消耗⼤,In-Memory Storage Engine (企业版⽀持) 只存在内存,不会落盘⾼版本⽀持 Join,⽀持事务⽀持安全认证功能提供扩展,⽐如实现可视化的⼯具,实现 BI 集成的⼯具mongodb 更适⽤于⾼度⾮结构化,或者源数据就是 JSON,每条数据⽐较⼤,以 OLTP 为主的场景,不适合于事务要求⽐较⾼,或⽐较复杂的⼤数据量的查询的场景,另外由于 mongodb 的语法和其他数据库差异⽐较⼤,需要⼀定的学习成本Hive (基于 HDFS 的数据库引擎、关系型、OLAP)Hive 是基于 Hadoop 的⼀个数据仓库⼯具数据存储在 HDFS,创建表的时候要通过 STORED AS 命令指定存储格式⽐如 TEXTFILE、ORCFILE、PARQUET,也可以通过STORED BY 命令指定为 HBase,可以创建新表也可以创建已有 HBase 表的映射查询通过 MapReduce、Spark 等作业完成提供了类 SQL 查询语⾔ HQL (HiveQL),⽀持⽤户定义函数 (UDF)⾼版本⽀持事务 (需要创建表时指定)⽀持海量数据结构化数据⽀持增删改查不适合于 OLTP,主要作为 OLAP ⽤于⼤数据批量查询使⽤,需要有 Hadoop 平台Impala (基于 HDFS、HBase、Kudu 存储,并⾏计算,关系型,OLAP)Cloudera 开发的基于内存的分布式并⾏计算的数据库查询引擎主要由 C++ 实现,和 Hadoop 的交互使⽤ JNIImpala 使⽤和 Hive ⼀样的 metadata、SQL、ODBC driver、UI,这样在提⾼了 HDFS 的 SQL 查询性能的同时,⼜提供了相似的⽤户使⽤体验和 Hive ⼀样可以通过 STORED AS 指定 HDFS 的存储格式⽐如 TEXTFILE、ORCFILE、PARQUET通过 Hive 操作的表,需要⼿动同步到 ImpalaImpala 不仅 SQL 和 Hive ⼀样,实际上元数据也存在 Hive 中表数据除了 HDFS,也可以存储到 HBase,但需要在 HBase 建表,然后在 Hive 通过 STORED BY 建⽴映射表,由于 Impala 和 Hive 使⽤⼀样的 metadata,在 Hive 建好表后,只要在 Impala 执⾏刷新命令 INVALIDATE METADATA,就可以看到对应的 HBase 表⽀持 Join、Aggregate 等功能⽀持 JDBC、ODBC和 Hive 不同,Impala 不依赖于 MapReduce,⽽是在每个 HDFS DataNode 上运⾏⾃⼰的引擎实现并⾏处理Impala 的并⾏处理引擎主要由 state store、catalog service、多个 impala daemon 组成每个 impala daemon 都可以接收 client 的请求,impala daemon 由 query planner、query coordinator、query executor 组成,planner 接收 client 的 SQL 查询,然后分解为多个⼦查询,由 coordinator 将⼦查询分发到各个 daemon 的 executor 执⾏,daemon 获取HDFS、HBase 数据、计算、然后返回给 coordinator,然后由 coordinator 聚合后将最终结果返回给 clientImpala 是⽆中⼼结构,每个 daemon 都可以接受连接查询,可以通过 HA Proxy 实现多个 daemon 的负载均衡state store ⽤于收集监控各个 daemon 的状态catalog service 将 SQL 做出的元数据变化通知给集群中所有的 impala daemonImpala 的计算都在内存进⾏,对内存要求⽐较⾼Impala 在 2.8 以后才⽀持 update 操作,但是只限于 Kudu 存储,需要安装 Kudu,并通过 STORED AS 指定 Kudu 作为数据库的存储,Kudu 是 Cloudera 开发的列式存储管理器,⽬的是做 OLAP,并且平衡 HDFS 和 HBase 的性能,Kude 的随机读写性能⽐HDFS(⽐如 Parquet)好,但是⽐ HBase 差,⽽⼤数据量查询性能⽐ HDFS(⽐如 Parquet)差,但⽐ HBase 好,Kude 和 Impala ⾼度集成,也可以和 MapReduce/Spark 集成,⽤ Kudu 替换 HDFS/HBase 这样 Impala 就可以做 update,兼顾 OLAP 和改数据的需求,适合于以 OLAP 为主⼜有⼀定的 Update 需求的场景,Kudu 可以配置⼀致性,采⽤结构化表数据模型,需要定义主键,不使⽤HDFS ⽽是有⾃⼰的组件存储和管理数据, 采⽤ c++ 没有 full gc 风险Impala 不适合于 OLTP,主要作为 OLAP ⽤于⼤数据批量查询使⽤需要有 Hadoop 平台和 Hive性能⽐ Hive 好很多作为 OLAP 的性能⽐ Phoenix 之类的好主要是 CDH 在推,CDH 有集成 ImpalaPresto (基于多种数据源,并⾏计算,关系型,OLAP)Facebook 推出的基于内存的分布式并⾏计算的数据库查询引擎由 coordinator server、discovery server (通常集成在 coordinator ⾥,也可以独⽴)、多个 worker server 组成coordinator 负责与 client 交互,负责管理 worker,负责解析 statement、规划 query、创建⼀系列的 stage、再转换成⼀系列的 task 分发到不同 worker 并发执⾏worker 负责执⾏ task 和处理数据,会通过 connector 获取数据,和其他 worker 交互中间数据,最终结果会由 coordinator 返回给clientconnector 是适配器,使得 Presto 可以访问不同的数据库内建的 connector 主要是 Hive,此外有很多三⽅开发的 connector ⽐如 cassandra、es、kafka、kudu、redis、mysql、postgresql 等等需要在配置⽂件配置 catalog,这⾥ catalog 维护 schema 并通过 connector 指向⼀个数据源,定位 presto 表都是从 catalog 开始的,⽐如 hive.test_data.test 指的是 hive catalog 下的 test_data schema 下⾯的 test 表,⽽ schema 的概念则依赖于具体的 connector,⽐如对于 mysql ⽽⾔,presto 的 schema 就是 mysql 的 schema,⽽对于 cassandra ⽽⾔,presto 的 schema 就是 cassandra 的keyspace,可以建⽴多个 catalog 关联同⼀个 connector ⽐如环境⾥有多个 kafka 集群那可以有 kafka1 和 kafka2 两个 catalog statement 可以认为就是 presto 收到的 sql 语句,然后会解析成 query plan,然后 query ⼜被分为多个 stages,这些 stages 组成⼀个树的结构,每个 stage 会聚合计算它下⾯的其他 stages 的结果,每个 stage ⼜分为⼀个或多个 tasks,这些 task 会分发到不同的worker 并⾏执⾏,每个 task 处理不同的数据分⽚,每个 task ⼜有⼀个或多个 driver 并发处理数据Presto ⽀持 JDBC 接⼝,JDBC 的 URL 格式为 jdbc:presto://host:port/catalog/schema 或 jdbc:presto://host:port/catalog 或jdbc:presto://host:port⽀持 Join 查询,并且⽀持多数据源的 join 查询 (多张⼤表的 join 可能会影响性能),跨数据源查询的时候需要指定完整的表名即[catalog].[schema].[table],并且使⽤ presto://host:port 连接 JDBC,不指定 catalog 和 schema有限⽀持⼦查询不⽀持 update 操作⽀持安全机制⽀持标准的 ANSI SQL扩展性好可以和 Tableau 集成⽀持 Spark适合有多种数据源的⼤数据量的 OLAP 查询性能和 Impala 可能差不多,但⽀持多种数据源,不依赖 HadoopGreenplum (基于多个 PostgreSQL,并⾏计算,关系型,OLAP)基于多个 PostgreSQL 的分布式并⾏计算的数据库查询引擎内部的 PostgreSQL 有做改动以适应并⾏分布式计算主要由⼀个 master、多个 segments、⼀个 interconnect 组成master 维护元数据,接收并认证 client 的链接,接收 SQL 请求,解析 SQL,⽣成 query plan,并将任务分发到 segments,协调聚合segments 的返回结果,并将最终结果返回给 client,可以设置 master 为主从配置每个 segment 有个独⽴的 PostgreSQL 数据库,每个 segment 负责存储部分数据,并执⾏相应的查询计算,segment 也可以配置备份机制Interconnect 是 Greenplum 的⽹络层,负责 master 和 segment 的链接,以及各个 segment 之间的链接链接和 SQL 语法都和 PostgreSQL 兼容,⽀持 JDBC、ODBC创建表时可以指定是⽤列存储、⾏存储、外部表 (数据在其他系统⽐如 HDFS ⽽ GP 只存储元数据)操作外部数据,需要安装 PXF (Platform Extension Framework),有了 PXF 可以⽀持 Hive、HBase、Parquet、S3、MySQL、ORACLE 等等⽀持安全、权限配置⽀持分布式事务,⽀持 ACID,保证数据的强⼀致性,不是使⽤锁,⽽是使⽤ MVCC (Multi-Version Concurrency Control) 来保证数据⼀致性shared-nothing 架构和 Impala、Presto 类似都是并⾏内存计算,但 Greenplum 性能可能稍差⼀点点,并且 Greenplum 还分开源版和商业版,有的功能只有商业版才⽀持Kylin (基于 Hive、HBase,并⾏计算,关系型,多维度、预计算 OLAP)传统 OLAP 根据数据存储⽅式的不同分为 ROLAP(Relational OLAP)以及 MOLAP(Multi-Dimension OLAP),ROLAP 以关系模型的⽅式存储数据,优点在于体积⼩,查询⽅式灵活,缺点是每次查询都需要对数据进⾏聚合计算,⽽ Kylin 属于 MOLAPKylin 将数据按维度的不同组合,提前计算好结果,形成 Cube (⽴⽅体) 结构,这样查询速度快,缺点是数据量不容易控制,N 个维度可以有 2**N 种组合,可能会出现维度爆炸的问题,⽽且数据有改动的话需要重新计算⽐如有 Phone 和 Country 两张维度表,以及 Sale 事实表 (明细表),取⼿机品牌、国家、⽇期作为三个维度,有 (null)、(品牌)、(国家)、(⽇期)、(品牌、国家)、(品牌、⽇期)、(国家、⽇期)、(品牌、国家、⽇期) 共 8 种组合,可以提前计算好这 8 种 group by 组合的 sale 的各种汇总信息 (sum、count 等),⼀个维度组合的⼀个汇总信息称为⼀个 cuboid,所有的 cuboid 合起来就被称为⼀个 CubeKylin 的数据源可以是 Hive 或 Kafka (Json 格式消息,key 就是列名)Kylin 的预计算结果存到 HBase,RowKey 就是各种维度的组合,相应的明细汇总存在 Column 中,这样 SQL 就变成对 RowKey 的扫描,并进⼀步的对 Column 计算 (如果需要的话),这样查询性能⾃然就提升了,可以⽀持亚秒级查询Kylin ⽀持 ODBC,JDBC,RESTful API 等接⼝Kylin 可以和 Tableau、PowerBI 等 BI ⼯具集成使⽤步骤如下创建 Project同步 Hive 表或 Kafka 表创建 Data Model创建并命名 Model选择 Fact Table (事实表) 和 Lookup Table (查找表,主要是维度信息),以及 Join 字段从 Fact Table 和 Lookup Table 中挑选维度列 (可以被 Cube 做 group by)从 Fact Table 选择指标列 (可以被 Cube 做 aggregation)从 Fact Table 选择⽤于⽇期分区的列,不需要就留空添加 Filter (可以被 Cube ⽤来做 Where 操作)创建 Cube创建并命名 Cube,并选择要关联的 Data Model添加维度列 (必须从 Data Model 配置的维度列中选择)添加指标列 (必须从 Data Model 配置的指标列中选择)共有 8 种 aggregation 操作可以配置给指标列:SUM, MAX, MIN, COUNT, COUNT_DISTINCT, TOP_N,EXTENDED_COLUMN and PERCENTILE (如果要查 avg 实际上就是⽤ sum 除以 count 得出,所以这⾥不需要配置 avg 等可以通过预计算结果进⼀步计算出的操作)build Cube,实际是通过 MapReduce/Spark 计算,任务完成后结果会写⼊ HBasebuild 成功后即可直接⽤ SQL 查询了,实际是根据维度查 RowKey,然后把 Column 存的聚合结果取出,如果必要的话再做进⼀步计算如果数据源有改动,需要重新 build Cube可以看到 Kylin 是⼀个纯粹的 OLAP ⼯具,通过预计算提升查询性能,但⽆法及时反应出数据源的改变,预计算可能很耗时并且可能会占⽤⼤量空间,且需要和 Hadoop 集成基于预计算的 OLAP 数据查询引擎还有 DruidClickHouse (列存储,向量化计算,并⾏计算,OLAP)俄罗斯企业 Yandex 开发的 OLAP 数据库列存储对于 OLAP 的好处由于 OLAP 经常是在⼤量数据列中检索少量列,如果采⽤⾏存储,意味着要逐⾏扫描,并且每⾏都很⼤,⽽采⽤列存储只需要扫描要检索的列,能减少 IO假设有的记录并没有存储要检索的列,⾏存储依然要扫描该记录才知道,⽽对于列存储则不存在这样的问题,因为没存储,⾃热⽽然就不会扫描到因为同⼀列的数据类型、⼤⼩⽐较⼀致,列存储更容易压缩,效率更⾼,进⼀步减少 IOIO 的减少还意味着有更多数据可以被缓存到内存向量化计算SIMD (Single Instruction,Multiple Data,单指令流多数据流),现在的 CPU ⽀持这样的功能,通过⼀条指令即可利⽤多核对⼀组数据 (也就是向量) 进⾏ CPU 层⾯的并发计算,适⽤于纯基础计算的场景,如果有判断、跳转、分⽀的场景则不合适ClickHouse 有⼀个向量计算引擎,尽可能地使⽤ SMID 指令,批量并⾏地处理数据,⼤⼤提升了处理能⼒主要由 C++ 实现⽆中⼼化结构,由⼀个集群的 server 组成,并且每个 server 都可以接受客户端的链接查询,server 收到请求后会和其他 server 协调做并⾏计算,每个 server 都是多线程的,server 之间通过 ZooKeeper 协调同步⽀持分⽚(shard),数据可以跨节点存储在不同分⽚中,⼀个分⽚就是⼀个节点,或者多个节点组成⼀个有副本备份的分⽚,由配置⽂件配置⽀持分区,通过 Partition By 命令创建表分⽚和分区有时候不好区分,分⽚更多指的是表的数据分布在不同节点,⽽且⼀个节点可以存储多个数据库、多个表的数据,⽽分区更多指的是按某列数据将⼀个⼤表分成多个⼩表,⽐如按⽇期列分区,每天⼀个分区表,既可以查分区表,也可以查⼤表⽀持副本备份、⽀持数据完整性表引擎(Table Engine)创建表的时候要通过 Engine 命令指定要⽤的表引擎,决定如何存储数据最常⽤的是 MergeTree 系列引擎,⽐如ENGINE = MergeTree()ENGINE = AggregatingMergeTree()⽐较轻量级的 Log 系列引擎ENGINE = Log;ENGINE = TinyLog;允许从其他数据源查询,⽐如ENGINE = ODBC(connection_settings, external_database, external_table)ENGINE = JDBC(dbms_uri, external_database, external_table)ENGINE = MySQL('host:port', 'database', 'table', 'user', 'password')ENGINE = PostgreSQL('host:port', 'database', 'table', 'user', 'password')ENGINE = MongoDB(host:port, database, collection, user, password)ENGINE = HDFS(URI, format)ENGINE = Kafka() SETTINGS kafka_broker_list = 'host:port', kafka_topic_list = 'topic1'特殊类型,⽐如ENGINE = Memory 数据存在内存分布式在某个 server 创建的表只是该 server 的本地表,不是分布式的,如果要创建分布式表,需要在每个 server 创建相同名字的表,再在其中⼀台 server 上创建分布式表(会⾃动在所有 server 上都创建),这个分布式表是个逻辑表,不真正存储数据,⽽是映射到各个 server 的本地表,会⾃动做并⾏计算ENGINE = Distributed(cluster_name, database, table, [sharding_key])cluster_name 是在配置⽂件⾥配置的通常使⽤ MergeTree 存储,数据可以快速地按序 append 到⼀颗 MergeTree 的后⾯,后台会做合并和压缩操作,这样提升了数据插⼊的性能主索引,数据按 Primary Key 排序也可以在创建表时通过 Order By 指定排序的字段⽀持⼆级索引,也叫跳数索引 data skipping index,⽐如 minmax 索引,会统计每⼀段数据内某列数据(或是某个表达式)的最⼤值和最⼩值,检索的时候可以依据 minmax 决定是否跳过这段数据(感觉⽐较怪,性能应该⽐重建⼀张索引表的做法要差吧)⽀持 TTL,包括列级别、⾏级别、分区级别的 TTL⽀持 HTTP、TCP 接⼝⽀持 JDBC、ODBC有三⽅⼯具⽀持将其他数据库如 PG 的数据导⼊ ClickHouse有三⽅⼯具⽀持和⼀些可视化⼯具如 Grafana、DBeaver、Tabix 集成有三⽅⼯具⽀持 Kafka、Flink、Spark 等⽀持 SQL,⽀持 group by、order by、join、部分⼦查询等功能⽀持 array、json、tuple、set 等复杂数据类型⽀持近似计算,⽐如计算平均值,可以取部分数据计算,这样提升了性能,但降低了准度⾃适应 Join 算法,⽐如优先使⽤ Hash-Join,如果有多张⼤表则⾃动改⽤ Merge-Join安全机制、基于 Role 的权限控制⽀持错误恢复、扩展性好不⾜的地⽅对⾼并发的⽀持不⾜没有成熟的事务功能修改、删除数据的性能⽐较差,并且仅提供有限⽀持Primary Key 是采⽤稀疏索引,即索引只能指向⼀段数据,具体的数据还得⼀条条查,所以如果是查少量数据,或者查询单条数据,性能会⽐较差不依赖 Hadoop、列存储、向量化、并⾏、多线程、多存储引擎单表查询性能极好,⽐ Impala、Presto 之类的要好很多多表查询性能差些,⽐ Impala、Presto 之类的要差Elasticsearch (倒索引、分词、搜索引擎)Elastic Stack 是⼀组组件包括 Elasticsearch、Logstash、Filebeat、Kibana 等Elasticsearch 是基于 Apache Lucene 开发的搜索引擎,主要由 Java 开发Elasticsearch 集群主要由 master、data、ingest、coordinating 节点组成每个节点可以同时配置多种⾓⾊,⽐如即是 master ⼜是 data,但在⼤型集群中,通常每个节点只负担⼀种功能coordinating 是每个节点都会有的功能,不需要配置,即⽆论 master 还是 data 都会有 coordinating 功能,⽤于接收 client 的读写请求,然后将请求转发给相应节点处理,然后将处理结果合并后返回给 client,在⼤型集群中为了不对 master/data 等节点造成太⼤压⼒,可以配置多个专门的 coordinating,通过将 role 配置为空或是将 master、data、ingest 设置为 false (取决于不同版本) 即可,这样这些 coordinating 节点就只负责接收响应 client 请求不做其他⼯作,就像是⼀个反向代理的负载均衡⼀样,能提⾼并发性能master 负责管理整个集群,负责对 index 的创建删除等管理操作,决定数据要分⽚到哪个节点,管理其他节点的状态等等,可以配置多个 master 做 HA,需要单数个,⾄少要 3 个,系统实际上⾃动选举其中⼀个做 master,如果该 master 挂了,会从其他配置为master 的节点中重新选举⼀个,master 的配置可以低⼀些data 负责存储、计算、处理数据,对资源要求⽐较⾼,data 还可以进⼀步配置,指定节点⽤于存储 hot data、warm data、cold data 等等。

数据库选型评估报告

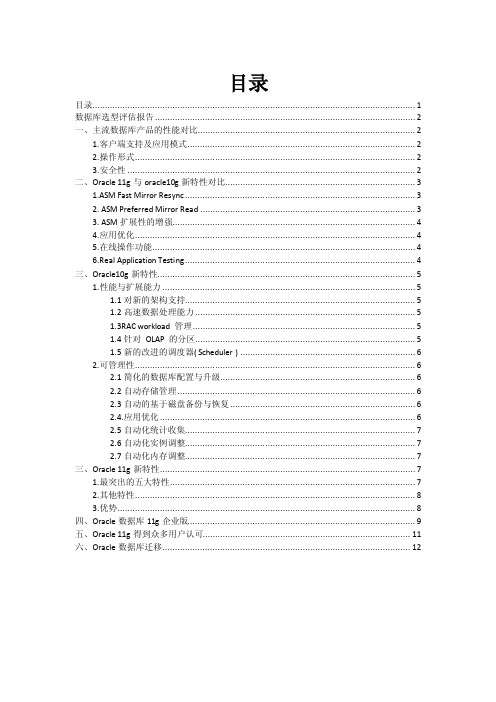

目录目录 (1)数据库选型评估报告 (2)一、主流数据库产品的性能对比 (2)1.客户端支持及应用模式 (2)2.操作形式 (2)3.安全性 (2)二、Oracle 11g与oracle10g新特性对比 (3)1.ASM Fast Mirror Resync (3)2. ASM Preferred Mirror Read (3)3. ASM扩展性的增强 (4)4.应用优化 (4)5.在线操作功能 (4)6.Real Application Testing (4)三、Oracle10g新特性 (5)1.性能与扩展能力 (5)1.1对新的架构支持 (5)1.2高速数据处理能力 (5)1.3RAC workload 管理 (5)1.4针对OLAP 的分区 (5)1.5新的改进的调度器( Scheduler ) (6)2.可管理性 (6)2.1简化的数据库配置与升级 (6)2.2自动存储管理 (6)2.3自动的基于磁盘备份与恢复 (6)2.4.应用优化 (6)2.5自动化统计收集 (7)2.6自动化实例调整 (7)2.7自动化内存调整 (7)三、Oracle 11g新特性 (7)1.最突出的五大特性 (7)2.其他特性 (8)3.优势 (8)四、Oracle数据库11g企业版 (9)五、Oracle 11g得到众多用户认可 (11)六、Oracle数据库迁移 (12)数据库选型评估报告企业该如何去选择适合自己的数据库产品,客观上说,目前市场上大部分的数据库产品都能满足数据存储与处理的要求,但是要挑选一款合适的产品,还必须从企业实际出发,必须着重考虑产品的安全性、易用性以及性价比等方面。

一、主流数据库产品的性能对比目前的数据库市场的竞争格局,Oracle、IBM和微软厂商三足鼎立,几款主流产品Oracle11g、SQL Server2005和DB2,它们在各自的领域,都具有一定的优势。

以下是关于它们的性能比较。

数据库选型流程

数据库选型流程

在进行数据库选型时,需要考虑多个因素,包括数据量、数据类型、数据结构、性能要求、安全性要求、可扩展性、成本等。

下面是一个基本的数据库选型流程:

1.需求分析

首先需要明确业务需求,包括数据类型、数据量、数据结构、性能要求、安全性要求、可扩展性等。

这些需求将直接影响数据库的选型。

2.技术评估

在明确需求后,需要对各种数据库技术进行评估,包括关系型数据库、非关系型数据库、内存数据库、分布式数据库等。

需要考虑数据库的特点、优缺点、适用场景等。

3.性能测试

在评估数据库技术后,需要进行性能测试,包括读写性能、并发性能、扩展性能等。

这些测试将直接影响数据库的选型。

4.安全性评估

在性能测试后,需要进行安全性评估,包括数据加密、访问控制、备份恢复等。

这些评估将直接影响数据库的选型。

5.成本评估

在安全性评估后,需要进行成本评估,包括数据库软件、硬件、维护等成本。

这些评估将直接影响数据库的选型。

6.选型决策

在完成以上评估后,需要进行选型决策,选择最适合业务需求的数据库。

需要考虑数据库的性能、安全性、可扩展性、成本等因素。

7.实施和维护

在选型决策后,需要进行数据库的实施和维护。

需要考虑数据库的安装、配置、优化、备份恢复等工作。

数据库选型是一个复杂的过程,需要考虑多个因素。

只有根据业务需求,进行全面的评估和决策,才能选择最适合的数据库,为业务提供高效、安全、可靠的数据支持。

指标归因数据库选型

指标归因数据库选型

如今互联网行业正在不断发展,它提升了所有行业的效率,并且成就越来越高。

伴随着大数据以及技术的发展,经常为了提升企业的运营效率,公司便会寻求合适的指标归因数据库选型的解决方案。

指标归因数据库的设计是想要提升企业的运营效果的必要手段,数据库的选择类型也非常重要。

指标归因数据库选型,首先要考虑的是它的存储结构及容量。

指标归因数据库

存储结构注重它的访问速度与稳定性,应该以响应请求速度最快为优先考虑。

且存储容量要能满足公司按时处理大量数据,并提高系统质量和吞吐量。

其次是分析存储工具和细节。

合理的分析存储工具,如MySQL、Oracle、Hadoop等针对大量数据在高效安全的前提下完成指标的归因分析,这也是考量数

据库选型的重要标准。

此外,对建设指标归因数据库的细节也要仔细考虑,只有将细节进行充分地分析,才能构建出科学完整的指标归因数据库系统。

最后是服务水平。

不能缺少的是稳定的服务水准,当客户使用数据库时,只有

稳定的服务水平才能满足客户的服务需求,否则会给企业的运营带来不可估量的影响。

总而言之,指标归因数据库选型要从它的容量、存储结构分析工具以及服务水

平几个方面来考量。

只有在掌握了工具的基本操作,以及熟记数据库的细节以及充分分析数据库服务水平之后,才能科学、合理地选择适用性强且符合公司需求的指标归因数据库,从而提升公司运营水平。

知识数据库选型

选择适合的知识数据库选型需要考虑以下几个因素:

1. 数据类型和结构:确定你需要存储和管理的数据类型和结构,例如文本、数字、图像、 音频等。不同的知识数据库可能对不同类型的数据有不同的支持。

2. 数据量和性能要求:评估你的数据量大小和对性能的要求,包括数据的读写速度、并发 访问能力、数据存储和检索效率等。一些知识数据库可能更适合大规模数据存储和高性能需 求,而另一些可能适用于小规模数据存储和较低性能要求。

5. 安全性和权限控制:确保知识数据库提供适当的安全性和权限控制机制,以保护敏感数 据免受未经授权的访问和篡改。

知识数据库选型

6. 支持和社区:考虑知识数据库的支持和社区资源,包括文档、教程、示例代码、社区论 坛等。这些资源可以帮助你更好地理解和使用知识数据库。

常见的知识数据库选型包括关系型数据库(如MySQL、PostgreSQL)、文档数据库(如 MongoDB)、图数据库(如Neo4j)、搜索引擎(如Elasticsearch)等。根据上述因素, 你可以对比不同的选项,选择最适合你需求的知识数据库。

Hale Waihona Puke 知识数据库选型3. 查询和检索功能:考虑你需要的查询和检索功能,例如全文搜索、模糊搜索、过滤、排 序等。不同的知识数据库提供的查询语言和功能可能会有所不同。

4. 可扩展性和灵活性:评估知识数据库的可扩展性,即能否轻松地扩展存储容量和处理能 力。此外,考虑数据库的灵活性,即能否适应不断变化的需求和数据结构。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

数据库安全加固产品选型系列之二

上次写了数据库安全加固产品选型系列文章的第一篇后,据说反响还不错。

但是在部门内部就“资深”售前的称号问题产生了争执,大家一致认为本人虽然“长的着急”了点,但是心理年龄似乎还是比较年轻的,是啊,就像那首歌里唱不是:“革命人永远是年轻……” (坏了,这首老歌又暴露了问题……)

言归正传,上回从客户面临的数据库安全“核心痛点”,以及中安威士针对客户“痛点”开发的几款产品的实现原理,两个方面介绍了在数据库安全加固产品选型时的一些参考依据。

今天我们来聊聊造成数据库风险存在的最大,最直接,最重要的因素:人!您别笑,我也没和您开玩笑。

您仔细想想看,围绕数据库安全的诸多维度,例如,数据库的权限配置、数据库的备份与恢复、数据库的误操作,甚至是数据库本身存在的各种漏洞和针对数据库发起攻击的黑客们,都离不开我说的这个一撇一捺的“人”字。

举个例子,如果我们只从数据库泄露途径这个相对单纯的维度来分析“人”带来的威胁。

不难看出,数据泄露的途径主要来自外部和内部两个方面。

第一个方面:外部威胁一般大家都明白,各种黑客攻击,SQL注入,恶意后门等等方法来企图窃取数据。

另一方面,内部人员的蓄意越权访问、误操作、或是介质窃取等,都是数据泄露和数据遭到破坏的途径。

值得一提的是,内部人员通常权限较高,可以轻而易举的导出整库整表的数据,和黑客们的外部攻击相比,看似缺乏技术含量的来自内部的威胁却逐渐成为了数据泄露风险的主流因素。

根据权威咨询公司的调查结果显示,来自于内部的数据泄漏事件占70%以上。

随着企业在边界防护上的不断强化,越来越多的数据安全防线,被从内部攻破。

特别是具有敏感数据访问权限的人员成为数据泄密的主要途径。

如何针对现实工作中的多种人员角色来选择中安威士的数据库安全加固产品,以覆盖数据泄露的多个风险点呢?我们已经总结好了,为了让您看得清清楚楚、明明白白、真真切切……当然还是上表格啦!

以上表格,结合企业中围绕数据库应用的各种角色,分别以“必选”,“推荐”等两种级别,标识了在环境中应用和部署四款数据库安全产品的迫切程度。

从表格中不难看出,数据库审计产品可以说是一款数据库安全的“标配”产品。

无论企业中围绕数据库的角色多还是少,都应该部署数据库审计产品。

数据库审计系统能够对数据的访问和活动情况进行全方位的监控和记录,便于事后审计和追查。

可以及时发现数据的异常活动情况和风险,产生报警并且输出可视化的报表,便于统计分析及相关汇报。

数据库防火墙则通过实时分析用户对数据库的访问行为,自动建立访问数据库的合法特征模型。

对于越权的访问或非法操作实现即时阻断,在业务系统自身的角色权限基础上,在数据库层面实现了深度的数据安全防护。

数据库加密产品,在防范外部攻击窃取数据的同时,更重要的是针对来自内部的数据泄露风险点,增强了对加密敏感数据的权限管理,防止越权权限的滥用、权限盗用、合法权限滥用导致的数据泄漏。

针对很多公司将自己业务系统的开发和测试工作外包给第三方公司的情况,数据库脱敏产品成为了保护企业敏感数据不被一并“外包”的有效工具。

如何选择适合的数据库安全产品,通过今天的分析,您是不是又多了一点决策的信心呢?

更多数据安全解决方案点击:中安威士/#page4。