正则化度修正随机块模型的演化网络社团发现

正则化方法

正则化方法正则化方法是一种有效的优化技术,它是用来减少模型的复杂性,避免过拟合,促进模型的泛化性能。

它把模型参数空间中不重要的变量设置为空并移除,以提高模型的效果。

正则化方法可以有效控制过拟合,有助于提高模型的性能和运行效率,在机器学习和深度学习领域得到广泛应用。

正则化方法有多种形式。

常用的正则化方法有L2正则化,L1正则化,Max-norm正则化,Dropout正则化等。

例如,L2正则化(也称为权重衰减)是一种数学技术,它引入了一个系数来改变参数的取值范围。

一般来说,改变参数的系数越大,则缩小参数的范围越多,也就是模型越不复杂,所以参数就越不容易过拟合。

L1正则化也可以减少模型参数的复杂性,它使模型的参数值更接近于0,从而达到降维的效果,有助于改善模型的泛化能力。

Max-norm正则化主要用于约束参数的W矩阵中元素的大小,通过控制模型参数中单个参数值的大小,来减少模型参数的复杂性,从而降低过拟合风险,增加模型的泛化性能。

Dropout正则化是一种常用的深度学习正则化方法,它通过跳过一些神经网络激活函数来简化神经网络结构,从而避免过拟合,增强模型的泛化能力。

正则化可以有效地降低模型的复杂度,让模型在训练集和测试集上的表现更加一致,从而促进模型的有效运用。

正则化方法在实际应用中也存在一定的问题,例如,由于L1正则化会使参数的范围变得非常小,它会使模型的训练变得很慢,并且影响模型的精度。

对于一些复杂的模型,Max-norm正则化可能会限制模型的学习能力,从而影响模型的性能。

正则化方法在实践中表现出很强的耐受性,它可以解决过拟合问题,提高模型的泛化性能。

不同的正则化方法都有各自的优势和劣势,在实际应用中,根据具体情况选择合适的正则化方法,才能最大程度地发挥正则化方法的优势,提高模型的性能。

总之,正则化方法是一种有效的优化技术,它通过减少模型的复杂性,解决过拟合问题,从而提高模型的泛化性能,在机器学习和深度学习领域得到广泛应用。

正则化原理总结

正则化原理总结正则化理论(Regularization Theory)是 Tikhonov于1963年提出的⼀种⽤以解决逆问题的不适定性的⽅法。

不适定性通常由⼀组线性代数⽅程定义,这组⽅程组由于具有很⼤的系数⽽使得它的反问题(已知系统输出求输⼊)存在多解。

正则化理论就是⽤来对原始问题的最⼩化经验误差函数(损失函数)加上某种约束,这种约束可以看成是⼈为引⼊的某种先验知识(正则化参数等价于对参数引⼊先验分布),从⽽对原问题中参数的选择起到引导作⽤,因此缩⼩了解空间,也减⼩了噪声对结果的影响和求出错误解的可能,使得模型由多解变为更倾向其中⼀个解。

也就是说,正则化项本质上是⼀种先验信息,整个最优化问题从贝叶斯观点来看是⼀种贝叶斯最⼤后验估计,其中正则化项对应后验估计中的先验信息(不同的正则化项具有不同先验分布),损失函数对应后验估计中的似然函数,两者的乘积则对应贝叶斯最⼤后验估计的形式。

附加的先验信息强⾏地让系统学习到的模型具有⼈们想要的特性,例如稀疏、低秩、平滑等等,约束了梯度下降反向迫使最终解倾向于符合先验知识。

接下来的问题是我们应该引⼊什么样正则项作为先验知识,才能准确⾼效地缩⼩解空间?⼀切⽅法的动机来源于⼈们⼀直以来对科学的“简洁性”、“朴素性”和“美”的深刻认同,这⼀经典理念可以⽤14世纪逻辑学家Occam提出的“奥克姆剃⼑”原理表述,它长久以来被⼴泛运⽤在⼈们对⾃然科学、社会科学的探索和假设之中:Entities should not be multiplied unnecessarily,译作“若⽆必要,勿增实体”,即“简单有效原理”。

说到这⾥还想多说⼏句题外话。

其实⾄少从亚⾥⼠多德以来,在哲学界、科学界陆续有很多⼈针对不同的场景、以种种⽅式提出了类似的观点。

科学家们⽤这种⽅式,作为建⽴基本假设的原则、作为想象⼒的出发点和思考的⼤⽅向、作为模型选择和建⽴的依据,最终得到了被实验事实所验证的理论学说,⽐如:⽜顿经典⼒学、麦克斯韦⽅程中位移电流的假设、进化论中进化机制的构想、狭义相对论两个基本假设的建⽴、⼴义相对论场⽅程的推导等等,当然它在如今的管理学、经济学等领域同样被⼴泛运⽤。

神经网络中的正则化方法

神经网络中的正则化方法神经网络在机器学习领域具有广泛的应用价值,在语音识别、图像分类、自然语言处理等方面都发挥了很好的作用。

即使得到了很好的训练结果,但仍然需要在正则化方面进行优化,以避免过拟合的问题,进而提升网络的泛化性能。

本文主要探讨神经网络中的正则化方法。

1. 正则化的概念在机器学习中,过拟合是指模型过于复杂,导致仅适用于训练集,而不能很好地适用于新的数据集。

因此,正则化的目的就是减少模型的复杂性,优化模型的拟合效果,提高其泛化性能。

2. 常用的正则化方法2.1 L1正则化L1正则化的主要思想是增加权值向量中非零元素的数量,使得它们更加稀疏。

这个想法的出发点是为了减少模型中冗余的特征,提高模型的效率和泛化性能。

L1正则化的损失函数为:L1(w) = ||w||1 = Σ|wi|其中,||w||1是权重向量的绝对值和,wi是权值向量中的第i个元素。

2.2 L2正则化L2正则化与L1正则化的主要区别在于,它增加了权值向量中各个元素的平方和,并使较大的元素权重下降,将较小的权重值向零收缩。

它在一定程度上防止了过拟合,提高了泛化性能。

L2正则化的损失函数为:L2(w) = ||w||2^2 = Σwi^2其中,||w||2是向量w的模长。

2.3 Dropout正则化Dropout是一种基于神经网络中的正则化方法,可以有效降低过拟合的风险。

它随机删除模型中一些神经元,并且随机选择一些神经元进行训练,使得每个神经元都会在多个模型中进行学习,从而防止过拟合。

通过Dropout,网络的每次迭代都基于不同的子集进行计算。

该方法已经被广泛地应用于深度学习中。

3. 正则化方法的参数在进行神经网络中的正则化方法的时候,需要设置一些参数。

对于L1和L2正则化,需要设置对应的惩罚系数λ,对于Dropout,需要设置丢失率p。

惩罚系数λ通常通过交叉验证进行设置。

通常情况下,λ越大,则惩罚越大,这会导致有界约束。

然而,在选择Dropout的参数时,并没有明显的标准方式。

机器学习知识:机器学习中的正则化

机器学习知识:机器学习中的正则化正则化是机器学习中常用的一种技术,它旨在减少模型过度拟合或复杂化的风险,进而提高模型泛化能力和预测精度。

本文将从正则化的基本概念、种类及应用方面进行阐述,以便读者对正则化有更加深入的理解和应用。

一、正则化的基本概念正则化是指向模型中添加额外的信息(约束)以防止过度拟合或复杂化。

通常以限制权重(weights)或特征(features)的方式进行。

其优点在于:可以使得模型的泛化误差尽可能小,增加模型的稳健性,适用于训练数据较少或噪音较多的情况下。

在机器学习中,正则化技术分为L1正则化、L2正则化和Elastic Net正则化。

下面分别介绍一下。

1、L1正则化(L1 regularization)L1正则化是指在损失函数后加上模型权重的绝对值之和的惩罚项。

它的目的是使得一些无用的特征被消除,进而减少权重和特征的个数,提高模型的泛化性能和可解释性。

L1正则化的优点是可以自动地进行特征选择(feature selection)和稀疏性(sparse)处理,即将无用的特征对应的权重直接设置为0,以达到降维和优化模型的效果。

但缺点是损失函数非凸,不易优化。

2、L2正则化(L2 regularization)L2正则化是指在损失函数后加上模型权重的平方和的惩罚项。

它的目的是让权重更加平稳,减少模型复杂度,增强模型的泛化能力和稳定性。

L2正则化的优点是能够有效地减少过拟合现象,使模型更加通用和泛化能力更强。

缺点是有时可能无法识别到不重要的特征,因为L2正则化只能让权值趋于0但不能绝对为0。

3、Elastic Net正则化Elastic Net正则化是L1和L2的组合,也就是将L1正则化和L2正则化的惩罚项结合在一起,可以同时拥有它们的优点。

Elastic Net正则化的优点是能够处理相关性高的特征,用于分类问题效果比单独使用L1或L2更好。

但缺点是需要调节两个超参数(alpha和lambda),比较麻烦和耗时。

基于约束非负矩阵分解的符号网络社团发现方法

在分析复杂网络时,通常将网络建模为无符号网络,节点表示

实体,边表示个体之间的关系,边的属性都是正的。 但是随着社交

网络的发展,在某些网络中,节点之间的关系产生了积极和消极的

区别,例如在微博中的好友关系是积极的关系,黑名单、屏蔽是消

极关系。 网络节点间的这种两面性关系蕴涵了丰富的信息,传统

2

根据上述表述,本文将符号网络中的社团发现问题建模为一

个多目标问题:给定一个符号网络 G,将其划分成 k 个社团 C =

{C1 ,C2 ,…,C k }并满足社团内部的边尽量为正边且社团内的节点

联系紧密,社团之间的边尽量为负边且社团之间的节点联系稀疏

两个条件。

在上述目 标 的 基 础 上, 本 文 提 出 了 一 种 基 于 约 束 的 Semi⁃

据结构平衡和地位理论,社团划分的目标是使网络分割尽可能接

近网络平衡状态,主要方法是将社团发现问题转换为目标优化问

题 [5 ~ 10] 。 另一种常见的研究思路是充分利用现有的研究成果,根

据符号网络的特点改进算法 [11 ~ 15] 。 基于这个研究思路,符号模块

度 [11,12] 、符号相似度 [13] 、符号拉普拉斯矩阵 [14] 、符号比 例 割 集 准

min‖X - WSH‖2F s. t. W≥0,H≥0

(5)

针对 NMF 算法要求分解矩阵都为非负的特点,Ding 等人 对

NMF 进行扩展,提出 Semi⁃NMF 算法。 Semi⁃NMF 算法继承了 NMF

算法的思想, 但 是 不 限 制 矩 阵 元 素 的 符 号, 扩 展 了 NMF 的 应 用

的具体需求提出了多种改进方法。 对于对称矩阵,研究人员提出

改进的随机分块模型

2 . 合 成 网络

而对于参数 m 的选择 , 则相对复杂. 理论上来说 , 任何满足 s m k 的

剖 析 网 络 的 特 征 , 为 其 应 用 于 算 法 测 试 I 3 】 奠 定 基 础 。 e

非负 o J 值都可 以然 而 , 考虑到我们要用于实验的网络并非具有 同样的

【 参考文献1 1 ] 汪小帆 复杂 网络理论及其应用【 M ] . 北京 : 清华 大学 出版社 , 2 0 0 6 . 社 团结构 . 而是千变万化 的. 为 了便于更便捷 的生成社团结 构不 同的网 [ [ 2 ] 胡守信. MA T L A B基础及其应用教程[ M ] . 北京 : 科学 出版社 , 2 0 0 6 . 络. 我们引人参数 A . 来调节下面线性表达式的系数 :

与更新对 于适应各种新算法的测试具有重要 意义. 笔者主要介 绍一种 对度进行 改进 的随机分块模型 , 浅析其性质 , 对比模糊程度不 同的 网络 , 以便于更好 的将其运用于算法的测试。

【 关键词】 社 团结构 ; 随机 分块模型 ; 模糊程度

O . 引 言

在复杂 网络中 .随机分块模型既可以用来发现 网络社 团结构 , 还 可用于产生合成网络 . 以此作 为测试社 团发现等算法 的表现 . 然而 , 传 统 的分块模 型忽略了节点度的变化性 , 与真实 网络 中度的分布特征不

2 . 1 合 成 网络 特 性分 析

= 1 l o 0 0 k k 0 I ) j 【

运用 M A L A B软件 . 编写 以上随机分块模 型的生成程序 , 并对相 应的 网络特性进行分 析. 以5 0 0 个节点 的网络为例 , 设 置其社 团数 目 1 . 模 型 介 绍 为5 个, 参数 A 设为O . 8 。 本文所探讨 的随机分块模型为对度进行改进的模型 . 其相 比与传 实验结果表明 . 网络 中节点 度大致 服从 普瓦松分布 。 并且该生 成 统的模型 . 度的变化范围更为宽泛 , 更接近真实网络的特性. 在模 型的 网络节点 的度 主要 集中在 O 一 5 O 之间. 度大于 5 O的节点非常少. 对 生 理论分析过程 中. 我们允许 节点 自连边以及多连边 , 这 主要 体现在生 成网络中节点度 的分布有大致了解 . 有助于我们对网络特性的掌握 . 成模型的连边概率 中. 对 网络的产生没有影响日 在连边预测以及社 团分析时 . 能帮助我们分析实验结果 。 该模型 中网络节点的度服从普瓦松分布 . 社 团大小服从均匀分 2 . 2 合成网络 的对 比分析 布. 网络的生成过程主要分为两 步 : 首先 , 要确定 网络的群分 配 , 即社 我们运用该模型 , 分 别生成社团结构模糊程度不 同的网络 , 预先 团结 : 其次 . 要确定 网络 中每两条边之间连边的概率. 社团结构的划分 设置社 团数 为 2 . 随着参数 A的不 断增 大 , 网络的社团结构越来 越清 是预先设置的 , 而群 g与群 岛内节点连边 的概率如下式所示 : 晰, 当A = 0 . 5时 。 从表达式( 3 ) 可知, 随机 图与构造社团结构各 占一半的 P s i  ̄ = 0 i 0 i  ̄ o ( 1 ) 权重 . 此 时生成 网络 的社 团结构 比较模糊 。 两个社团的分界并不明显. 在上式 中, 表示节 点 i 所 属的社 团 。 参数 0 和0 3 的最大似然值 而随着 A增大到 0 . 9时 . 网络的社团结构 已经非常清晰。 分别 如下 : 。 。 一 ( 2 )

人工智能基础(习题卷9)

人工智能基础(习题卷9)第1部分:单项选择题,共53题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]由心理学途径产生,认为人工智能起源于数理逻辑的研究学派是( )A)连接主义学派B)行为主义学派C)符号主义学派答案:C解析:2.[单选题]一条规则形如:,其中“←"右边的部分称为(___)A)规则长度B)规则头C)布尔表达式D)规则体答案:D解析:3.[单选题]下列对人工智能芯片的表述,不正确的是()。

A)一种专门用于处理人工智能应用中大量计算任务的芯片B)能够更好地适应人工智能中大量矩阵运算C)目前处于成熟高速发展阶段D)相对于传统的CPU处理器,智能芯片具有很好的并行计算性能答案:C解析:4.[单选题]以下图像分割方法中,不属于基于图像灰度分布的阈值方法的是( )。

A)类间最大距离法B)最大类间、内方差比法C)p-参数法D)区域生长法答案:B解析:5.[单选题]下列关于不精确推理过程的叙述错误的是( )。

A)不精确推理过程是从不确定的事实出发B)不精确推理过程最终能够推出确定的结论C)不精确推理过程是运用不确定的知识D)不精确推理过程最终推出不确定性的结论答案:B解析:6.[单选题]假定你现在训练了一个线性SVM并推断出这个模型出现了欠拟合现象,在下一次训练时,应该采取的措施是()0A)增加数据点D)减少特征答案:C解析:欠拟合是指模型拟合程度不高,数据距离拟合曲线较远,或指模型没有很好地捕 捉到数据特征,不能够很好地拟合数据。

可通过增加特征解决。

7.[单选题]以下哪一个概念是用来计算复合函数的导数?A)微积分中的链式结构B)硬双曲正切函数C)softplus函数D)劲向基函数答案:A解析:8.[单选题]相互关联的数据资产标准,应确保()。

数据资产标准存在冲突或衔接中断时,后序环节应遵循和适应前序环节的要求,变更相应数据资产标准。

A)连接B)配合C)衔接和匹配D)连接和配合答案:C解析:9.[单选题]固体半导体摄像机所使用的固体摄像元件为( )。

正则化详解——精选推荐

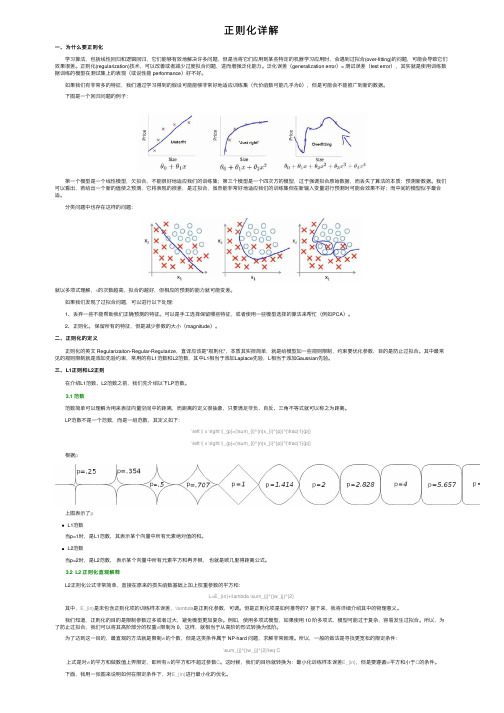

正则化详解⼀、为什么要正则化 学习算法,包括线性回归和逻辑回归,它们能够有效地解决许多问题,但是当将它们应⽤到某些特定的机器学习应⽤时,会遇到过拟合(over-fitting)的问题,可能会导致它们效果很差。

正则化(regularization)技术,可以改善或者减少过度拟合问题,进⽽增强泛化能⼒。

泛化误差(generalization error)= 测试误差(test error),其实就是使⽤训练数据训练的模型在测试集上的表现(或说性能 performance)好不好。

如果我们有⾮常多的特征,我们通过学习得到的假设可能能够⾮常好地适应训练集(代价函数可能⼏乎为0),但是可能会不能推⼴到新的数据。

下图是⼀个回归问题的例⼦: 第⼀个模型是⼀个线性模型,⽋拟合,不能很好地适应我们的训练集;第三个模型是⼀个四次⽅的模型,过于强调拟合原始数据,⽽丢失了算法的本质:预测新数据。

我们可以看出,若给出⼀个新的值使之预测,它将表现的很差,是过拟合,虽然能⾮常好地适应我们的训练集但在新输⼊变量进⾏预测时可能会效果不好;⽽中间的模型似乎最合适。

分类问题中也存在这样的问题:就以多项式理解,x的次数越⾼,拟合的越好,但相应的预测的能⼒就可能变差。

如果我们发现了过拟合问题,可以进⾏以下处理: 1、丢弃⼀些不能帮助我们正确预测的特征。

可以是⼿⼯选择保留哪些特征,或者使⽤⼀些模型选择的算法来帮忙(例如PCA)。

2、正则化。

保留所有的特征,但是减少参数的⼤⼩(magnitude)。

⼆、正则化的定义 正则化的英⽂ Regularizaiton-Regular-Regularize,直译应该是"规则化",本质其实很简单,就是给模型加⼀些规则限制,约束要优化参数,⽬的是防⽌过拟合。

其中最常见的规则限制就是添加先验约束,常⽤的有L1范数和L2范数,其中L1相当于添加Laplace先验,L相当于添加Gaussian先验。

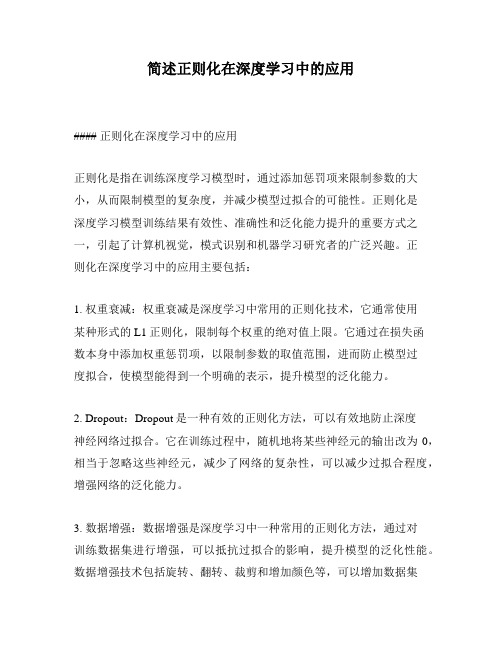

简述正则化在深度学习中的应用

简述正则化在深度学习中的应用#### 正则化在深度学习中的应用正则化是指在训练深度学习模型时,通过添加惩罚项来限制参数的大小,从而限制模型的复杂度,并减少模型过拟合的可能性。

正则化是深度学习模型训练结果有效性、准确性和泛化能力提升的重要方式之一,引起了计算机视觉,模式识别和机器学习研究者的广泛兴趣。

正则化在深度学习中的应用主要包括:1. 权重衰减:权重衰减是深度学习中常用的正则化技术,它通常使用某种形式的L1正则化,限制每个权重的绝对值上限。

它通过在损失函数本身中添加权重惩罚项,以限制参数的取值范围,进而防止模型过度拟合,使模型能得到一个明确的表示,提升模型的泛化能力。

2. Dropout:Dropout是一种有效的正则化方法,可以有效地防止深度神经网络过拟合。

它在训练过程中,随机地将某些神经元的输出改为0,相当于忽略这些神经元,减少了网络的复杂性,可以减少过拟合程度,增强网络的泛化能力。

3. 数据增强:数据增强是深度学习中一种常用的正则化方法,通过对训练数据集进行增强,可以抵抗过拟合的影响,提升模型的泛化性能。

数据增强技术包括旋转、翻转、裁剪和增加颜色等,可以增加数据集里面的图片数量,充分扩充数据集,有助于模型泛化性能的提升。

4. 惩罚性回归:惩罚性回归是深度学习中常用的正则化技术,通过添加L1范数的正则化项,可以减少模型的过拟合程度,简化参数,提高模型的训练效果和泛化能力。

5. 权重共享:权重共享是一种有效的正则化技术,它可以使网络权值参数减少,同时保持模型准确性和鲁棒性。

权重共享可以使模型权值参数更加紧密,从而简化神经网络参数,有效地抑制过拟合,提高模型效果和泛化能力。

总之,正则化技术在深度学习中有广泛的应用,可以有效降低模型复杂程序,抑制过拟合,降低参数和噪声的敏感度,提升模型在测试集上的准确率,提高深度学习模型的训练结果有效性、准确性和泛化能力。

社团检测算法

社团检测算法

社团检测算法是网络分析中的一种方法,用于发现网络中的社团结构。

社团结构是指

网络中由密切关联的节点组成的分组。

社团检测算法可以帮助我们理解网络中的关系,发

现网络的模式,识别关键节点和集群等。

模块度最大化算法是一种基于网络密度和社团内部连接强度的方法。

它通过比较网络

中实际连接和随机连接的差异,来确定社团结构。

该算法优化目标是最大化网络中社团的

密度和社团之间的差异性。

模块度最大化算法在处理大规模网络时效果较好,但容易受到

网络噪音的影响。

谱聚类算法是一种基于网络谱矩阵的方法。

该算法将网络转换为谱矩阵,并通过特征

值分解和聚类来确定社团结构。

谱聚类算法适用于处理稀疏网络和高维数据,但需要计算

网络谱矩阵,计算复杂度较高。

层次聚类算法是一种基于网络节点相似度的方法。

该算法通过计算节点之间的相似度,将节点逐层聚类成社团。

层次聚类算法适用于处理带权网络和不规则网络,但对噪音和异

常值比较敏感。

K-means算法是一种基于距离的方法。

该算法将网络节点按照距离划分为若干个簇,

并对簇内节点进行聚类。

K-means算法适用于处理纯数字数据和高维数据,但对离群点比

较敏感。

总之,社团检测算法是一种重要的网络分析方法,可以帮助我们理解网络中的关系和

结构,为社会科学、生物学、计算机科学等领域提供有用的研究工具。

在应用社团检测算

法时,需要根据网络的特点和需求选择合适的算法,并结合实际领域的专业知识进行解释

和分析。

网络分析中的社团发现算法研究

网络分析中的社团发现算法研究随着互联网的快速发展和普及,网络分析成为了一门重要的研究领域。

在大数据时代,社团发现算法是网络分析中一项核心任务,用于发现网络中的社团结构,揭示网络中的隐藏信息,对于理解网络结构和社交关系具有重要意义。

本文将探讨网络分析中的社团发现算法的研究进展和应用。

首先,我们来介绍社团发现算法的定义和基本原理。

社团发现算法旨在将网络中具有相似连接和交互模式的节点划分为一个社团,即将网络划分为若干个相对独立的子网络结构。

这些子网络结构通常被称为社团。

社团发现算法基于节点之间的连接强度和相似性,通过计算节点之间的距离或相似度来找到社团结构。

常用的社团发现算法有基于模块性的方法、谱聚类方法、基于模型的方法等。

基于模块性的社团发现算法是最常用的一类算法。

它通过计算网络中节点之间的模块性来评估社团划分的质量。

模块性是一种表示社团结构紧密程度的度量指标,它衡量了实际社团内部连接与预期连接之间的差异。

常见的基于模块性的算法有Louvain算法、GN算法、CNM 算法等。

这些算法通过不断优化社团划分的模块性来寻找最优的社团结构。

谱聚类方法是一种基于图论和代数方法的社团发现算法。

它通过将网络表示为一个拉普拉斯矩阵,然后利用拉普拉斯矩阵的特征向量进行聚类。

谱聚类方法在处理大规模网络时具有较好的性能和效果,广泛应用于社团发现和聚类分析。

常见的谱聚类算法有标准谱聚类、归一化谱聚类等。

除了基于模块性和谱聚类的方法,还有一些基于模型的社团发现算法。

这些算法通过建立概率模型来描述网络中的社团结构,并使用贝叶斯推断或最大似然估计等方法来学习模型参数。

基于模型的算法可以更好地处理复杂网络中存在的噪声和不确定性,提高社团发现的准确性和鲁棒性。

常见的基于模型的算法有概率潜在社团模型(PLP)、狄利克雷过程混合模型(DPMM)等。

在实际应用中,社团发现算法被广泛应用于社交网络分析、推荐系统、生物网络分析等领域。

例如,在社交网络分析中,社团发现算法可以用于识别用户群体、分析信息传播和影响力传播。

正则化的基本概念和原理(一)

正则化的基本概念和原理(一)正则化的基本概念什么是正则化正则化是机器学习中常用的一种方法,它可以用来解决模型过拟合的问题。

在统计学中,正则化指的是通过限制模型参数的大小或分布,来避免模型过拟合的现象。

在机器学习中,正则化一般是通过添加一个正则化项来实现的,这个正则化项可以是模型参数的L1范数或L2范数等。

为什么需要正则化在机器学习中,我们一般将数据分为训练集和测试集。

我们使用训练集来训练模型,然后使用测试集来测试模型的泛化能力。

当我们使用较复杂的模型时,比如神经网络,模型的参数很多,很容易出现过拟合的问题。

过拟合指的是模型在训练集上表现非常好,但在测试集上表现较差的现象。

这是因为模型在训练集上过分拟合了训练数据的噪声,而忽略了真正的数据分布。

这时候,我们可以通过正则化来控制模型的过拟合。

正则化的实现方式L1正则化L1正则化是通过添加L1范数来实现的,它的公式如下:loss(y,ŷ)=MSE(y,ŷ)+λ∥w∥1其中,MSE是均方误差,y是真实标签,ŷ是模型预测的标签,w是模型的参数,λ是超参数,用来控制L1范数的权重。

L1范数是指参数的绝对值之和,它可以使部分参数变为0,从而实现特征的选择和稀疏化的效果。

L1正则化在特征选择和模型稀疏化方面有较好的效果。

L2正则化L2正则化是通过添加L2范数来实现的,它的公式如下:loss(y,ŷ)=MSE(y,ŷ)+λ∥w∥22其中,MSE、y、ŷ、w和λ的意义同上。

L2范数是指参数的平方和,它可以使参数变得比较平滑,从而减少模型的波动,提高模型的泛化能力。

L2正则化在防止过拟合方面有较好的效果。

L1和L2混合正则化L1和L2混合正则化是将L1范数和L2范数一起使用,它可以同时实现特征选择、稀疏化和参数平滑化等多种效果。

它的公式如下:loss(y,ŷ)=MSE(y,ŷ)+λ1∥w∥1+λ2∥w∥22其中,MSE、y、ŷ、w、λ1和λ2的意义同上。

改进的随机分块模型-文档

改进的随机分块模型0.引言在复杂网络中,随机分块模型既可以用来发现网络社团结构,还可用于产生合成网络,以此作为测试社团发现等算法的表现.然而,传统的分块模型忽略了节点度的变化性,与真实网络中度的分布特征不太相符.因此,在真实网络的社团发现过程中,传统模型的合成网络对于测试算法准确性并不十分适用.Brian Karrer和M.E.J.Newman对传统的随机分块模型做了改进,使得改进后的模型生成的网络度的分布更为宽泛,这样就更加接近于真实网络的特性[1]。

1.模型介绍本文所探讨的随机分块模型为对度进行改进的模型,其相比与传统的模型,度的变化范围更为宽泛,更接近真实网络的特性.在模型的理论分析过程中,我们允许节点自连边以及多连边,这主要体现在生成模型的连边概率中,对网络的产生没有影响[2]。

该模型中网络节点的度服从普瓦松分布,社团大小服从均匀分布.网络的生成过程主要分为两步:首先,要确定网络的群分配,即社团结;其次,要确定网络中每两条边之间连边的概率.社团结构的划分是预先设置的,而群gi与群gj内节点连边的概率如下式所示:Pgigj=θiθjωgi,gj (1)在上式中,gi表示节点i所属的社团,参数θi和ωrs的最大似然值分别如下:= rs=mrs (2)2.合成网络在运用随机分块模型生成网络时,涉及到参数的选择.对于网络的群分配参数g和节点的期望度值,我们可以根据实验需要进行预设值,而对于参数ωrs的选择,则相对复杂.理论上来说,任何满足sωrs=kr的非负ωrs值都可以.然而,考虑到我们要用于实验的网络并非具有同样的社团结构,而是千变万化的.为了便于更便捷的生成社团结构不同的网络,我们引入参数λ,来调节下面线性表达式的系数:ω=λωplanted+(1-λ)ωrandom (3)这里,ωrsandom=krks/2m对应于随机图中ωrs的期望值,而ωrsplanted对应于构造社团结构.例如,我们想要将网络划分为4个社团,那么就有:ω= (4)2.1合成网络特性分析运用MALAB软件,编写以上随机分块模型的生成程序,并对相应的网络特性进行分析.以500个节点的网络为例,设置其社团数目为5个,参数λ设为0.8。

社会网络中社团发现及网络演化分析

社会网络中社团发现及网络演化分析一、本文概述随着信息技术的快速发展,网络科学已经成为研究复杂系统的重要工具。

社会网络作为复杂网络的一种,广泛存在于我们的日常生活之中,如社交网络、科研合作网络、生物网络等。

这些网络中的社团结构,即一组内部节点连接紧密而与其他组节点连接稀疏的节点集合,是理解和分析网络性质和功能的关键。

社团发现不仅能够揭示网络中的结构和功能模块,还能为预测网络行为、优化网络结构提供重要依据。

同时,网络演化分析则能够揭示网络随时间变化的动力学特性,对理解网络的发展和演化机制具有重要意义。

本文旨在探讨社会网络中社团发现及网络演化分析的理论和方法。

我们将介绍社团发现的基本概念和常用算法,包括基于模块度优化的方法、基于链接相似性的方法以及基于动态模型的方法等。

我们将分析这些方法在真实社会网络中的应用案例,展示其在揭示网络结构和功能方面的有效性。

接着,我们将探讨网络演化的基本模型和演化机制,包括网络增长、节点和链接的演化等。

我们将介绍网络演化分析的方法和技术,包括时间序列网络分析、网络动态可视化等,并展示其在理解网络发展和演化机制方面的应用。

二、社团发现的基本理论和方法社团发现是社会网络分析中的一项重要任务,它旨在揭示网络中的紧密连接群体,这些群体通常具有共同的特征或属性。

社团结构反映了网络中节点间的关联性和社区内部的相似性,对于理解网络的功能和动态演化具有重要意义。

社团发现的基本理论基于图论和统计学的原理。

图论提供了描述和分析网络结构的数学工具,如节点、边、度、路径等概念,以及更复杂的网络度量指标,如聚类系数、平均路径长度等。

这些概念和指标为社团发现提供了基础数据和分析框架。

在社团发现的方法上,研究者们提出了多种算法和技术。

其中最常用的是基于模块度优化的方法。

模块度是一个衡量社团结构的指标,它衡量了社团内部节点连接的紧密程度相对于随机情况下的期望连接程度。

通过最大化模块度,可以找到最佳的社团划分方式。

如何调整机器学习模型的正则化方法

如何调整机器学习模型的正则化方法在机器学习中,正则化是一种用于防止模型过拟合的重要技术。

正则化方法通过在损失函数中引入惩罚项,限制模型的复杂度,从而提高其泛化能力。

调整机器学习模型的正则化方法是优化模型性能和准确性的关键步骤。

本文将介绍几种常见的机器学习模型的正则化方法,并提供调整方法的建议。

1. L1正则化(Lasso):L1正则化是一种常见的正则化方法,通过在损失函数中引入权重向量的L1范数,使得部分权重变为零,从而实现特征选择和模型简化。

L1正则化有助于减少模型中不重要特征的权重,并提高模型的泛化能力。

如果你的模型受到噪声和冗余特征的干扰,可以考虑增加L1正则化的强度。

您可以通过调整正则化参数来控制L1正则化的程度,建议从小范围内的值开始,逐渐增加以找到最佳值。

2. L2正则化(Ridge):L2正则化是另一种常见的正则化方法,通过在损失函数中引入权重向量的L2范数,限制模型的权重大小。

L2正则化有助于防止模型过拟合和对异常值的敏感性。

如果您的模型在训练数据上的表现良好,但在测试数据上过拟合,可以尝试增加L2正则化的强度。

您可以通过调整正则化参数来控制L2正则化的程度,建议从小范围内的值开始,逐渐增加以找到最佳值。

3. Elastic Net正则化:Elastic Net正则化是L1和L2正则化的结合,通过引入L1和L2范数的组合来平衡特征选择和权重约束的效果。

Elastic Net正则化既可以减少不重要特征的权重,又可以控制模型的复杂度。

如果您的模型需要同时进行特征选择和权重约束,可以考虑使用Elastic Net正则化。

您可以通过调整正则化参数来控制L1和L2正则化的权重比例,建议从均衡的比例开始,根据需求进行调整。

4. Dropout正则化:Dropout正则化是一种基于随机失活的正则化方法,通过在训练过程中随机将一部分神经元的输出置零,减少神经元之间的依赖关系,使得模型更加健壮。

Dropout正则化有助于减少神经网络的过拟合和提高模型的泛化能力。

机器学习知识:机器学习中的正则化方法

机器学习知识:机器学习中的正则化方法机器学习中的正则化方法正则化方法是一种常用的机器学习技术,用于控制模型的复杂度并防止过拟合。

在许多应用中,过拟合是一个常见的问题,这使模型在训练数据上表现得相当好,但在测试数据上表现不佳。

为了解决这个问题,正则化方法被引入到机器学习中。

正则化方法的基本思想是将模型的复杂度限制在一定范围内,以防止模型过度拟合训练数据。

这可以通过在模型的损失函数中添加一个正则化项来实现。

正则化项通常是模型权重的范数,它可以限制权重的大小,从而使模型变得更加简单和可解释。

常见的正则化方法有L1正则化和L2正则化。

L1正则化将权重向量中的绝对值之和添加到损失函数中,L2正则化将权重向量中的平方和添加到损失函数中。

这样做可以防止权重的值变得太大,从而限制模型的复杂度。

实践中通常使用L2正则化,因为它比L1更易于处理和计算。

除了L1和L2正则化,还有其他的正则化方法。

例如,弹性网络正则化是L1和L2正则化的一种组合。

这种方法的优点是可以平衡L1和L2正则化的影响,并在处理高维数据时表现出色。

另一个常见的正则化方法是Dropout。

Dropout是一种随机正则化技术,用于随机地从神经网络中删除一些神经元。

这有助于防止神经网络过拟合,并提高模型的泛化能力。

除了正则化方法,还有一些其他技术可以用于控制模型的复杂度。

例如,特征选择是一种减少输入特征数量的方法,它可以减少模型的复杂度和训练时间。

另一个技术是集合方法,它使用多个模型来减少模型的方差并提高模型的准确性。

在实际应用中,正则化方法是一种非常有用的技术,可以帮助我们控制模型的复杂度,防止过拟合,并提高模型的泛化能力。

无论是在传统的机器学习中还是在深度学习中,都可以使用正则化方法来提高模型的性能和稳定性。

解读神经网络中的正则化方法

解读神经网络中的正则化方法神经网络在计算机科学领域中扮演着重要的角色,但是当网络规模变大时,容易出现过拟合的问题。

为了解决这个问题,正则化方法被引入到神经网络中。

本文将对神经网络中的正则化方法进行解读。

一、过拟合问题在神经网络中,过拟合是指模型在训练集上表现良好,但在测试集上表现较差的现象。

过拟合的原因是模型过于复杂,学习到了训练集中的噪声和细节,导致对新数据的泛化能力较差。

二、正则化方法的基本原理正则化方法通过在损失函数中引入正则化项,对模型的复杂度进行约束,从而减少过拟合的风险。

常见的正则化方法包括L1正则化和L2正则化。

1. L1正则化L1正则化通过在损失函数中添加权重的绝对值之和,使得模型倾向于选择稀疏的权重。

这样做的好处是可以减少不重要特征的影响,提高模型的泛化能力。

2. L2正则化L2正则化通过在损失函数中添加权重的平方和,使得模型倾向于选择较小的权重。

这样做的好处是可以防止权重过大,减少模型对训练集中噪声的敏感性。

三、正则化方法的应用正则化方法可以应用于神经网络的不同层,包括输入层、隐藏层和输出层。

1. 输入层正则化输入层正则化可以通过对输入数据进行归一化或标准化来实现。

这样做的好处是可以使得输入数据的分布更加均匀,减少模型对某些特征的过度依赖。

2. 隐藏层正则化隐藏层正则化可以通过在隐藏层的激活函数中引入正则化项来实现。

这样做的好处是可以控制隐藏层神经元的激活程度,防止某些神经元过度激活。

3. 输出层正则化输出层正则化可以通过在输出层的损失函数中引入正则化项来实现。

这样做的好处是可以减少输出层权重的过拟合风险,提高模型的泛化能力。

四、正则化方法的优化正则化方法可以通过调整正则化项的权重来优化模型的性能。

通常情况下,正则化项的权重越大,模型的复杂度越低,但过大的正则化项权重也可能导致模型欠拟合。

为了找到合适的正则化项权重,可以使用交叉验证的方法。

通过在训练集中划分出一部分数据作为验证集,可以在不同的正则化项权重下训练模型,并选择在验证集上表现最好的模型。

模型正则化的概念

模型正则化的概念随着深度学习技术的发展,人工神经网络已经被广泛应用于各种任务,包括图像分类、文本处理和语音识别等。

为了提高模型的泛化性能,减少过拟合,常见的技术是模型正则化。

本文将介绍模型正则化的概念及其常见的实现方法。

概念在机器学习中,模型正则化是通过添加惩罚项来约束模型的复杂程度,从而防止过拟合。

正则化的目标是在保持模型的预测精度的同时,使模型更简单。

本质上,正则化是在最小化损失函数的同时,加入一个对模型参数的限制。

正则化项通常被加入到线性回归、逻辑回归和神经网络等模型中。

最常用的正则化项是L1正则化和L2正则化,它们基于不同的想法来约束模型。

以L2正则化为例,其惩罚项被定义为模型权重的平方和。

因此,模型的训练过程将同时优化模型预测和权重的规模。

实现方法L1正则化和L2正则化是两种最常见的正则化方法。

L1正则化通过把权重向量的L1范数加入到损失函数中来完成。

L1正则化得到的模型往往能够产生稀疏的特征选择,这意味着规则化后的模型会使一些特征的权重为零,从而简化模型并降低其复杂度。

L2正则化是另一种广泛使用的正则化方法,它通过将权重向量的平方和乘以一个小常数加入到损失函数中来实现。

L2正则化被称为权重衰减方法,因为它可将权重向量沿着同样的方向缩小一个常数。

除了L1和L2正则化,还有其他正则化方法,如弹性网络正则化、投影梯度法和Dropout等。

下面简要介绍一下弹性网络正则化和Dropout方法。

弹性网络正则化是一种结合了L1正则化和L2正则化的技术。

它的优点在于,它能够产生更加稀疏的模型,并且仅具有L1正则项的模型在存在高度相关特征时通常会分配相似的权重。

Dropout是一种在神经网络中广泛使用的正则化技术,在训练期间,它随机地关闭一些神经元,以减少神经网络的复杂度。

Dropout对于网络内存消耗的减少可以显著提高速度,并可以或多或少地提高网络的泛化性能。

总结与其他应用程序类似,机器学习的应用离不开数据。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

V O1.42 No.8

· 人 工 智 能 及 识 别 技 术 ·

计 算 机 工 程

Com puter Engineering

文章编号:1000-3428(2016)08-0134-05

文献标志码:A

2016年 8月

August 2016

中图分类号 :TP18

【Key words】evolving network;evolutionary analysis;community detection;model selection;stochastic block model;

【Abstract】Nowadays,many models for community detection are designed only for static networks,which ignore the

temporal inform ation and are always not ideal to model the real world data.In order to solve this problem ,an evolving comm unity detection m odel based on the degree—corrected block m odel is proposed.According to the theory of the fram ework of evolutionary clustering,the m odel introduces a regularization term based on the com munity membership

Regularized Degree-corrected Stochastic Block M odel for Evolving Network Com m unity Detection

W ANG Tingting ,D AI W eidi 一 ,JIAO Pengfei ,LI X iaom ing’

正 则 化 度修 正 随 机块 模 型 的演 化 网络 社 团发 现

王 亭 机 科 学 与技 术学 院 ,天 津 300072;2.天 津 市认 知计 算 与应 用 重 点 实 验 室 ,天 津 300072)

摘 要 :目前 大 多数 用 于社 团发 现 问题 的模 型 只适 用 于 静 态 网络 而 忽 视 了时 序 信 息 ,因 此 ,无 法 较好 地 建模 真 实 世 界数 据 。针 对 该 问题 ,提 出一 种 基 于 度 修 正 随 机 块 模 型 的 演 化 社 团 发 现 模 型 。根 据 演 化 聚 类 框 架 的原 理 ,基 于 社 团隶 属矩 阵将 一 个 正则 项 引入 到 度 修 正 随机 块 模 型 的 目标 函数 中 。利 用 网络 交 叉 验 证 方 法 进 行 模 型 选 择 ,处 理 社 团 个 数 随 时 间 变化 的 演化 网 络 ,从 而 克 服 由 于假 定 社 团个 数 为 常量 而 导 致 的 与 真 实 世 界 数 据 不 相 符 合 的 问 题 。 实 验 结 果 表 明 ,与经 典 的动 态 随机 块 模 型 和 FacetNet相 比 ,该 模 型 具 有 较 高 的 准 确 性 和 较 低 的 误 差 率 。 关 键 词 :演 化 网 络 ;演 化 分 析 ;社 团 发 现 ;模 型选 择 ;随机 块 模 型 ;节 点特 性

matrix into the objective function of the degree—corected stochastic block mode1.The network cross—validation approach is

utilized for m odel selection,so the proposed m ethod is able to deal with evolving netw orks with variational numbers of com munities.In this way.it overcomes the problem of assum ing the num ber of com munities as a constant,which is not consistent with real world data.Experim ental results show that the m odel has a better perform ance with higher accuracy and lower error rate com pared with the classica1 dynam ic stochastic block m odel and the FacetNet.

(1.School of Computer Science and Technology,Tianjin University,Tianjin 300072,China; 2.Tianjin Key Laboratory of Cognitive Computing and Application,Tianjin 300072,China)

中文 引 用 格 式 :王 亭 亭 ,戴 维 迪 ,焦鹏 飞 ,等 .正 则 化 度 修 正 随机 块 模 型 的演 化 网 络 社 团发 现 [J].计 算 机 工 程 ,2016, 42(8):134—138. 英 文 引 用 格 式 :W ang Tingting,Dai W eidi,Jiao Pengfei,et a1.Regularized Degree—corrected Stochastic Block M odel for Evolving Network Community Detection[J].Computer Engineering,2016,42(8):134—138.