大数据实验报告

信息技术的实验报告

信息技术的实验报告一、实验目的本次实验旨在深入探究信息技术在不同领域的应用和影响,通过实际操作和数据分析,了解信息技术的工作原理、优势以及可能存在的局限性,为今后在相关领域的研究和实践提供有力的参考依据。

二、实验设备与环境本次实验使用了以下设备和软件:1、计算机:配置了英特尔酷睿 i7 处理器、16GB 内存、512GB 固态硬盘,操作系统为 Windows 10。

2、网络连接:稳定的高速宽带网络。

3、实验软件:Python 38、Matlab R2020a、Microsoft Office 2019 等。

三、实验内容(一)大数据分析实验1、数据收集从互联网上收集了大量的公开数据,包括社交媒体数据、电商交易数据以及气象数据等。

2、数据预处理对收集到的数据进行清洗和预处理,去除重复、错误和不完整的数据。

3、数据分析运用 Python 中的数据分析库,如 Pandas 和 NumPy,对数据进行统计分析、相关性分析和聚类分析。

4、结果展示通过图表和报告的形式展示数据分析的结果,以便直观地理解数据中的规律和趋势。

(二)人工智能图像识别实验1、数据集准备选择了常见的图像数据集,如 MNIST 手写数字数据集和 CIFAR-10 图像数据集。

2、模型训练使用深度学习框架 TensorFlow 和 Keras,搭建卷积神经网络(CNN)模型,并对数据集进行训练。

3、模型评估通过准确率、召回率等指标评估模型的性能,并对模型进行优化和改进。

(三)网络通信实验1、网络拓扑搭建使用网络模拟软件构建了一个简单的局域网拓扑结构,包括服务器、客户端和路由器等设备。

2、协议配置配置了 TCP/IP 协议栈,包括 IP 地址、子网掩码、网关和 DNS 等参数。

3、网络性能测试使用网络测试工具,如 Ping 和 Traceroute,测试网络的延迟、丢包率和带宽等性能指标。

四、实验过程与步骤(一)大数据分析实验1、首先,使用 Python 的爬虫工具从指定的网站抓取数据,并将数据保存为 CSV 格式。

实验4:大数据的分析与挖掘

3.数据的预处理:在理解数据之后,需要对数据进行预处理,例如数据清洗、数据归一化、特征提取等,以确保数据质量和可用性。如果数据集较大,可能需要使用分布式计算平台进行处理。

五、实训体会

最终,通过数据挖掘方法得到的结果可以帮助我们更好地理解和解决实际问题,例如优化产品推荐、预测市场需求、检测欺诈、识别风险等等。

4.模型的训练:接下来,需要确定哪种数据挖掘算法才能解决我们的问题,并训练相应的模型。例如,我们可以使用决策树算法、神经网络算法或者基于规则的算法等。

5.模型的预测与评价:训练好模型之后,需要对新的数据进行预测,并根据实际结果对模型进行评价。这个过程需要注意模型的可解释性、预测的准确性和稳定性等指标。

“大数据技术概论”课程实验报告

实验名称:

教师评语

教师签字日期

成绩

学生姓名

学号

一、实验目标

展示数据挖掘方法如何解决实际问题

二、实验环境

Python

三、实验内容

1. 数据的读入与理解

2. 数据的预处理

3. 模型的训练

4. 模型的预测与评价

四、实验成果

1.确定问题和目的:首先要明确需要解决的问题,以及期望得到什么样的结果。例某个产品优化推荐算法等。

基于大数据分析的智慧交通规划实验报告

基于大数据分析的智慧交通规划实验报告一、引言随着城市化进程的加速和人口的增长,交通拥堵成为了困扰城市发展的重要问题。

为了提高交通效率、改善出行体验,智慧交通规划应运而生。

本实验旨在通过大数据分析,深入挖掘交通数据中的潜在规律和趋势,为智慧交通规划提供科学依据和决策支持。

二、实验目的1、探索大数据在智慧交通规划中的应用方法和效果。

2、分析交通流量、出行模式等数据,为交通设施规划和交通管理策略制定提供参考。

3、评估不同交通规划方案对交通运行状况的影响,优化交通资源配置。

三、实验数据来源1、交通流量监测数据:包括城市道路卡口、高速公路收费站等采集的车辆通行数据。

2、公交地铁刷卡数据:记录了市民乘坐公共交通工具的出行轨迹。

3、出租车 GPS 数据:反映出租车的行驶路线和载客情况。

4、手机信令数据:通过分析手机用户在不同基站之间的切换,获取人员的移动信息。

四、实验方法与步骤1、数据预处理对原始数据进行清洗,去除重复、错误和异常值。

将不同来源的数据进行整合和关联,建立统一的数据格式。

2、数据分析运用统计分析方法,计算交通流量的均值、峰值、分布等特征。

利用聚类分析,对出行模式进行分类,如通勤出行、休闲出行等。

通过关联分析,挖掘交通流量与时间、空间、天气等因素的关系。

3、交通模型构建基于历史数据,构建交通仿真模型,预测未来交通流量和拥堵情况。

采用多智能体模型,模拟交通参与者的行为和决策过程。

4、交通规划方案制定与评估根据数据分析结果和模型预测,提出多种交通规划方案,如新增道路、优化公交线路、设置智能交通信号等。

利用交通仿真模型对各方案进行评估,比较不同方案下的交通运行指标,如平均车速、拥堵时长等。

五、实验结果与分析1、交通流量特征分析交通流量呈现明显的时空分布规律,工作日早晚高峰时段道路拥堵严重,城市中心区域流量较大。

节假日期间,旅游景点周边道路流量显著增加。

2、出行模式分析通勤出行主要集中在特定的时间段和路线上,形成明显的潮汐现象。

数据分析及优化实验报告(3篇)

第1篇一、实验背景随着大数据时代的到来,数据分析已成为各个行业提高效率、优化决策的重要手段。

本实验旨在通过实际案例分析,运用数据分析方法对某一特定数据集进行深入挖掘,并提出相应的优化策略。

本实验选取了一个典型的电商数据集,通过对用户行为数据的分析,旨在提高用户满意度、提升销售业绩。

二、实验目的1. 熟练掌握数据分析的基本流程和方法。

2. 深入挖掘用户行为数据,发现潜在问题和机会。

3. 提出针对性的优化策略,提升用户满意度和销售业绩。

三、实验内容1. 数据收集与预处理实验数据来源于某电商平台,包含用户购买行为、浏览记录、产品信息等数据。

首先,对数据进行清洗,去除缺失值、异常值,确保数据质量。

2. 数据探索与分析(1)用户画像分析通过对用户性别、年龄、地域、职业等人口统计学特征的统计分析,绘制用户画像,了解目标用户群体特征。

(2)用户行为分析分析用户浏览、购买、退货等行为,探究用户行为模式,挖掘用户需求。

(3)产品分析分析产品销量、评价、评分等数据,了解产品受欢迎程度,识别潜力产品。

3. 数据可视化运用图表、地图等可视化工具,将数据分析结果直观展示,便于理解。

四、实验结果与分析1. 用户画像分析通过分析,发现目标用户群体以年轻女性为主,集中在二线城市,职业以学生和白领为主。

2. 用户行为分析(1)浏览行为分析用户浏览产品主要集中在首页、分类页和搜索页,其中搜索页占比最高。

(2)购买行为分析用户购买产品主要集中在促销期间,购买产品类型以服饰、化妆品为主。

(3)退货行为分析退货率较高的产品主要集中在服饰类,主要原因是尺码不合适。

3. 产品分析(1)销量分析销量较高的产品主要集中在服饰、化妆品、家居用品等类别。

(2)评价分析用户对产品质量、服务、物流等方面的评价较好。

五、优化策略1. 提升用户体验(1)优化搜索功能,提高搜索准确度。

(2)针对用户浏览行为,推荐个性化产品。

(3)加强客服团队建设,提高用户满意度。

大数据技术基础实验报告-HDFS常用操作命令

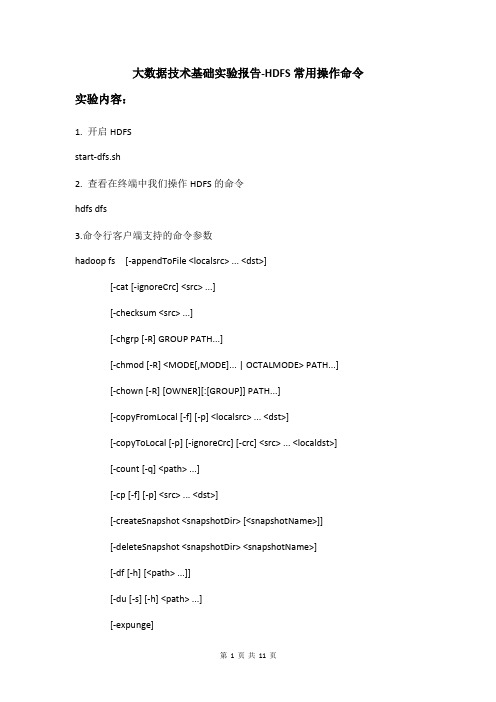

大数据技术基础实验报告-HDFS常用操作命令实验内容:1. 开启HDFSstart-dfs.sh2. 查看在终端中我们操作HDFS的命令hdfs dfs3.命令行客户端支持的命令参数hadoop fs [-appendToFile <localsrc> ... <dst>][-cat [-ignoreCrc] <src> ...][-checksum <src> ...][-chgrp [-R] GROUP PATH...][-chmod [-R] <MODE[,MODE]... | OCTALMODE> PATH...][-chown [-R] [OWNER][:[GROUP]] PATH...][-copyFromLocal [-f] [-p] <localsrc> ... <dst>][-copyToLocal [-p] [-ignoreCrc] [-crc] <src> ... <localdst>][-count [-q] <path> ...][-cp [-f] [-p] <src> ... <dst>][-createSnapshot <snapshotDir> [<snapshotName>]][-deleteSnapshot <snapshotDir> <snapshotName>][-df [-h] [<path> ...]][-du [-s] [-h] <path> ...][-expunge][-get [-p] [-ignoreCrc] [-crc] <src> ... <localdst>][-getfacl [-R] <path>][-getmerge [-nl] <src> <localdst>][-help [cmd ...]][-ls [-d] [-h] [-R] [<path> ...]][-mkdir [-p] <path> ...][-moveFromLocal <localsrc> ... <dst>][-moveToLocal <src> <localdst>][-mv <src> ... <dst>][-put [-f] [-p] <localsrc> ... <dst>][-renameSnapshot <snapshotDir> <oldName> <newName>][-rm [-f] [-r|-R] [-skipTrash] <src> ...][-rmdir [--ignore-fail-on-non-empty] <dir> ...][-setfacl [-R] [{-b|-k} {-m|-x <acl_spec>} <path>]|[--set <acl_spec> <path>]] [-setrep [-R] [-w] <rep> <path> ...][-stat [format] <path> ...][-tail [-f] <file>][-test -[defsz] <path>][-text [-ignoreCrc] <src> ...][-touchz <path> ...][-usage [cmd ...]]图中显示很多命令选项信息,以上截图补全,下面的表格能够完整的列出了支持的命令选项。

大数据处理实验报告

大数据处理实验报告随着信息时代的到来,大数据处理逐渐成为了各行业的重要课题。

本次实验旨在通过对大数据处理技术的探究,提高我们对大数据处理的理解和应用能力。

一、实验背景在日常生活中,我们经常会碰到各种大数据,比如网络上的海量数据、传感器采集的实时数据等。

如何高效地处理这些大数据,成为了当前亟需解决的问题。

因此,本次实验旨在研究大数据处理技术,包括数据收集、处理与分析等方面。

二、实验内容1. 数据采集:首先,我们需要选择一个合适的数据源,比如文本文件、数据库等,以便进行后续的数据处理。

2. 数据预处理:在数据采集后,我们需要对数据进行清洗、筛选、去重等处理,以确保数据的质量和完整性。

3. 数据分析:通过对数据进行统计、分析等操作,我们可以获取数据中隐藏的规律和信息,帮助我们做出决策和预测。

4. 结果展示:最后,我们需要将数据处理的结果进行可视化展示,让别人更直观地理解我们的数据分析成果。

三、实验步骤1. 选择数据源:本次实验我们选择了一份包含用户购物记录的文本文件作为数据源。

2. 数据预处理:首先,我们对数据进行了清洗,去除了其中的脏数据和异常值。

3. 数据分析:接着,我们利用Python编程语言进行了数据分析,包括用户购买偏好分析、销售额统计等。

4. 结果展示:最后,我们使用Matplotlib库将数据分析结果绘制成图表,方便其他人理解和借鉴。

四、实验结果通过本次实验,我们成功地完成了对大数据的处理与分析,获取了有关用户购物行为的一些有价值的信息。

这些信息可以帮助商家更好地了解用户需求,制定更科学有效的营销策略。

五、实验总结大数据处理是一个复杂而又重要的领域,需要我们不断地学习和实践。

通过本次实验,我们对大数据处理技术有了更深入的了解,也掌握了一些实用的数据处理方法和工具。

希望在今后的学习和工作中能够更好地运用大数据处理技术,实现更多有意义的成果。

以上就是本次大数据处理实验的报告内容,谢谢!。

大数据实践课程 实验报告

大数据实践课程实验报告一、引言大数据技术在当今社会中扮演着越来越重要的角色。

为了更好地应对和利用大数据,大数据实践课程成为了许多学校和企业培养人才的重要一环。

本实验报告旨在总结和分析大数据实践课程的相关实验内容,以及实验过程中所遇到的问题和解决方案。

二、实验内容在大数据实践课程中,学生通常会接触到大数据处理框架、数据分析和可视化、机器学习等方面的内容。

这些实验旨在让学生通过实际操作和项目实践,深入了解大数据的处理和应用。

1. 大数据处理框架实验在大数据处理框架实验中,学生会学习和使用一些主流的大数据处理框架,如Hadoop、Spark等。

通过搭建和配置这些框架,学生可以学习到大数据的分布式存储和计算的原理和方法。

2. 数据分析和可视化实验数据分析和可视化是大数据处理中非常重要的一环。

在这个实验中,学生将学习如何使用Python或R等编程语言进行数据分析,并通过绘制图表和可视化工具展示分析结果。

这些实验将帮助学生掌握数据清洗、特征提取、数据可视化等技能。

3. 机器学习实验机器学习是大数据中的关键技术之一。

在机器学习实验中,学生将学习和实践常见的机器学习算法,如线性回归、逻辑回归、决策树等。

通过使用真实的数据集进行训练和测试,学生可以了解机器学习的原理和应用。

三、实验问题和解决方案在进行大数据实践过程中,学生可能会遇到一些问题。

下面列举了一些常见的问题和相应的解决方案。

1. 数据清洗问题在进行数据分析和机器学习实验时,往往需要对原始数据进行清洗和预处理。

这个过程中可能会遇到缺失值、异常值等问题。

解决方案可以包括删除缺失值或异常值、使用插补方法填充缺失值等。

2. 算法选择问题在进行机器学习实验时,选择合适的算法对于结果的准确性和效率都非常重要。

解决方案可以包括对比不同算法的优缺点,根据数据特点选择最合适的算法。

3. 模型评估问题在机器学习实验中,模型的评估是判断模型好坏的重要指标。

解决方案可以包括使用交叉验证、绘制学习曲线等方法来评估模型的性能。

大数据结构实验报告材料一元多项式

一元多项式一、需求分析实现实系数一元多项式的创建,打印以及两个一元多项式的加、减、乘运算。

(1)程序所能达到的功能:a. 实现一元多项式的输入;b. 实现一元多项式的输出;c. 计算两个一元多项式的和并输出结果;d. 计算两个一元多项式的差并输出结果;e. 计算两个一元多项式的积并输出结果。

(2)输入的形式和输入值的范围:输入要求:分行输入,每行输入一项,先输入多项式的指数,再输入多项式的系数,以0 0为结束标志,结束一个多项式的输入。

输入形式:2 3-1 23 01 20 0输入值的范围:系数为int型,指数为float型。

(3)输出的形式:要求:第一行输出多项式1;第二行输出多项式2;第三行输出多项式1与多项式2相加的结果多项式;第四行输出多项式1与多项式2相减的结果多项式;第五行输出多项式1与多项式2相乘的结果多项式注:多项式的每一项形如:2.0x^3,注意指数应保留一位小数;多项式按照升幂次序排列;系数为1的非零次项应略去系数,系数为0的项不能出现在结果中;指数为0的项应只输出系数;多项式的第一项系数符号为正时,不要输出“+”,其他项要输出“+”,“-”符号。

-3.0x^-1-6.0x-2.0x^2-9.0x^3-4.0x^4-6.0x^6二、概要设计(1):程序实现a. 功能:将要进行运算的二项式输入输出;b. 数据流入:要输入的二项式的系数与指数;c. 数据流出:合并同类项后的二项式;d. 程序流程图:二项式输入流程图;e. 测试要点:输入的二项式是否正确,若输入错误则重新输入。

(2):数据类型ADT Polynomial{数据对象:D={ai| ai ∈TermSet,i=1,2,…,m,m≥0TermSet 中的每个元素包含一个表示系数的实数和表示指数的整数}数据关系:R1={< ai-1,ai >| ai-1 , ai ∈D,且ai-1 中的指数值<ai 中的指数值,i=2,…,n}基本操作:sort(Polyn & h); //对多项式进行排序print(Polyn h); //输出多项式delZeroCoef(Polyn & h); //判断系数为零的情况merge(Polyn & h); //合并指数相同的项createList(); //创建多项式addPoly(Polyn h1,Polyn h2); //多项式相加subPoly(Polyn h1,Polyn h2); //多项式相减multPoly(Polyn h1,Polyn h2); //多项式相乘} ADT Polynomial三、详细设计(1):存储结构一元多项式的表示在计算机内可以用链表来表示,为了节省存储空间,只存储多项式中系数非零的项。

《大数据技术导论》实验报告实验

大数据技术导论实验报告实验目的本实验主要旨在通过实际操作了解大数据技术的基本概念、应用场景以及一些常用的大数据处理技术。

实验环境•操作系统:Ubuntu 18.04•编程语言:Python 3.7•大数据框架:Apache Hadoop 3.2.0、Apache Spark2.4.1实验内容1. 大数据技术简介在进行实验前,我们首先了解了大数据技术的基本概念和发展背景。

大数据技术是一种用于处理大规模数据的技术,它包括了数据采集、存储、处理和分析等方面。

随着互联网的快速发展,各种应用场景下产生的海量数据给传统的数据处理方式带来了很大的挑战,大数据技术应运而生。

2. 大数据应用场景介绍我们对大数据的应用场景进行了一些介绍,包括金融领域的风险控制、电商领域的用户画像、物流领域的路线规划等。

这些场景都需要采集和处理大量的数据,然后通过分析得出一些有价值的信息和结论。

通过了解这些应用场景,我们对大数据技术在不同领域中的应用有了更深入的理解。

3. 大数据处理技术实验在实验过程中,我们选择了两个常用的大数据处理技术:Hadoop和Spark。

3.1 Hadoop实验我们在实验中使用Hadoop进行批量数据处理。

首先,我们安装和配置了Hadoop集群。

然后,我们编写了一个简单的MapReduce程序,用于统计文本文件中单词的出现频率。

通过Hadoop的分布式计算能力,我们可以高效地处理大规模的文本数据。

实验结果显示,Hadoop可以有效地加速数据处理过程。

3.2 Spark实验Spark是另一个非常流行的大数据处理框架。

我们在实验中使用Spark进行实时数据处理。

我们首先安装和配置了Spark集群。

然后,我们编写了一个简单的Spark Streaming 程序,用于实时处理网络日志数据。

通过Spark的快速计算能力,我们可以实时地对大规模的数据进行处理和分析。

实验结果表明,Spark在实时处理方面具有显著的优势。

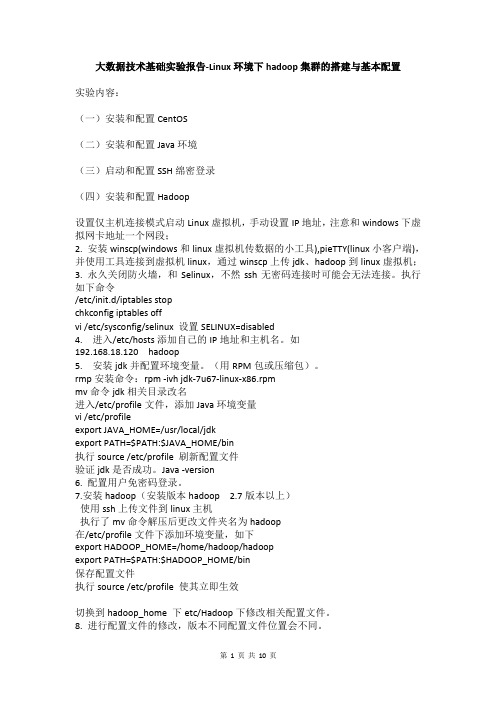

大数据技术基础实验报告-Linux环境下hadoop集群的搭建与基本配置

大数据技术基础实验报告-Linux环境下hadoop集群的搭建与基本配置实验内容:(一)安装和配置CentOS(二)安装和配置Java环境(三)启动和配置SSH绵密登录(四)安装和配置Hadoop设置仅主机连接模式启动Linux虚拟机,手动设置IP地址,注意和windows下虚拟网卡地址一个网段;2. 安装winscp(windows和linux虚拟机传数据的小工具),pieTTY(linux小客户端),并使用工具连接到虚拟机linux,通过winscp上传jdk、hadoop到linux虚拟机;3. 永久关闭防火墙,和Selinux,不然ssh无密码连接时可能会无法连接。

执行如下命令/etc/init.d/iptables stopchkconfig iptables offvi /etc/sysconfig/selinux 设置SELINUX=disabled4. 进入/etc/hosts添加自己的IP地址和主机名。

如192.168.18.120 hadoop5. 安装jdk并配置环境变量。

(用RPM包或压缩包)。

rmp安装命令:rpm -ivh jdk-7u67-linux-x86.rpmmv命令jdk相关目录改名进入/etc/profile文件,添加Java环境变量vi /etc/profileexport JAVA_HOME=/usr/local/jdkexport PATH=$PATH:$JAVA_HOME/bin执行source /etc/profile 刷新配置文件验证jdk是否成功。

Java -version6. 配置用户免密码登录。

7.安装hadoop(安装版本hadoop 2.7版本以上)使用ssh上传文件到linux主机执行了mv命令解压后更改文件夹名为hadoop在/etc/profile文件下添加环境变量,如下export HADOOP_HOME=/home/hadoop/hadoopexport PATH=$PATH:$HADOOP_HOME/bin保存配置文件执行source /etc/profile 使其立即生效切换到hadoop_home 下etc/Hadoop下修改相关配置文件。

大数据实验——精选推荐

⼤数据实验实验⼀:熟悉常⽤的Linux操作和Hadoop操作⼀、实验⽬的Hadoop运⾏在Linux系统上,因此,需要学习实践⼀些常⽤的Linux命令。

本实验旨在熟悉常⽤的Linux操作和Hadoop操作,为顺利开展后续其他实验奠定基础。

⼆、实验平台l 操作系统:Linux;l Hadoop版本:2.7.1。

三、实验步骤(⼀)熟悉常⽤的Linux操作l cd命令:切换⽬录(1)切换到⽬录“/usr/local”(2)切换到当前⽬录的上⼀级⽬录(3)切换到当前登录Linux系统的⽤户的⾃⼰的主⽂件夹l ls命令:查看⽂件与⽬录(4)查看⽬录“/usr”下的所有⽂件和⽬录l mkdir命令:新建⽬录(5)进⼊“/tmp”⽬录,创建⼀个名为“a”的⽬录,并查看“/tmp”⽬录下已经存在哪些⽬录(6)进⼊“/tmp”⽬录,创建⽬录“a1/a2/a3/a4”l rmdir命令:删除空的⽬录(7)将上⾯创建的⽬录a(在“/tmp”⽬录下⾯)删除(8)删除上⾯创建的⽬录“a1/a2/a3/a4” (在“/tmp”⽬录下⾯),然后查看“/tmp”⽬录下⾯存在哪些⽬录l cp命令:复制⽂件或⽬录(9)将当前⽤户的主⽂件夹下的⽂件.bashrc复制到⽬录“/usr”下,并重命名为bashrc1(10)在⽬录“/tmp”下新建⽬录test,再把这个⽬录复制到“/usr”⽬录下l mv命令:移动⽂件与⽬录,或更名(11)将“/usr”⽬录下的⽂件bashrc1移动到“/usr/test”⽬录下(12)将“/usr”⽬录下的test⽬录重命名为test2l rm命令:移除⽂件或⽬录(13)将“/usr/test2”⽬录下的bashrc1⽂件删除(14)将“/usr”⽬录下的test2⽬录删除l cat命令:查看⽂件内容(15)查看当前⽤户主⽂件夹下的.bashrc⽂件内容 xQWl tac命令:反向查看⽂件内容(16)反向查看当前⽤户主⽂件夹下的.bashrc⽂件的内容l more命令:⼀页⼀页翻动查看(17)翻页查看当前⽤户主⽂件夹下的.bashrc⽂件的内容l head命令:取出前⾯⼏⾏(18)查看当前⽤户主⽂件夹下.bashrc⽂件内容前20⾏(19)查看当前⽤户主⽂件夹下.bashrc⽂件内容,后⾯50⾏不显⽰,只显⽰前⾯⼏⾏l tail命令:取出后⾯⼏⾏(20)查看当前⽤户主⽂件夹下.bashrc⽂件内容最后20⾏(21)查看当前⽤户主⽂件夹下.bashrc⽂件内容,并且只列出50⾏以后的数据l touch命令:修改⽂件时间或创建新⽂件(22)在“/tmp”⽬录下创建⼀个空⽂件hello,并查看⽂件时间(23)修改hello⽂件,将⽂件时间整为5天前l chown命令:修改⽂件所有者权限(24)将hello⽂件所有者改为root帐号,并查看属性l find命令:⽂件查找(25)找出主⽂件夹下⽂件名为.bashrc的⽂件l tar命令:压缩命令(26)在根⽬录“/”下新建⽂件夹test,然后在根⽬录“/”下打包成test.tar.gz(27)把上⾯的test.tar.gz压缩包,解压缩到“/tmp”⽬录l grep命令:查找字符串(28)从“~/.bashrc”⽂件中查找字符串'examples'l 配置环境变量(29)请在“~/.bashrc”中设置,配置Java环境变量(30)查看JAVA_HOME变量的值(⼆)熟悉常⽤的Hadoop操作(31)使⽤hadoop⽤户登录Linux系统,启动Hadoop(Hadoop的安装⽬录为“/usr/local/hadoop”),为hadoop⽤户在HDFS中创建⽤户⽬录“/user/hadoop”./sbin/start -all.sh(32)接着在HDFS的⽬录“/user/hadoop”下,创建test⽂件夹,并查看⽂件列表Hadoop fs -mkdir /test(33)将Linux系统本地的“~/.bashrc”⽂件上传到HDFS的test⽂件夹中,并查看testHadoop fs -put ~/.bashrc /testHadoop fs -ls /test(34)将HDFS⽂件夹test复制到Linux系统本地⽂件系统的“/usr/local/hadoop”⽬录下Hadoop fs -get test /usr/local四、实验报告实验报告题⽬:实验⼀姓名郭⼦鹏⽇期:2020年6⽉实验环境:l 操作系统:Linux;l Hadoop版本:2.7.1。

大数据基础实验报告 -回复

大数据基础实验报告-回复一、实验目的本实验旨在通过探索大数据基础知识,并在实际操作中理解和应用这些知识,提高对大数据的理解和应用能力。

二、实验背景随着信息时代的到来,大数据成为一个热门的话题。

大数据是指规模巨大、高速流动且多样的数据集合,对于传统的数据处理方法和工具来说,无法处理和分析这些数据。

因此,为了能够更好地利用大数据,我们需要掌握大数据的基础知识。

三、实验过程及结果1. 了解大数据的概念首先,我们需要了解什么是大数据。

大数据通常具备以下特点:数据量大、数据速度快、数据类型多样。

了解了大数据的概念后,我们可以进一步探索大数据的发展和应用领域。

2. 学习大数据的基础技术在学习大数据的基础技术之前,我们需要了解大数据处理的挑战和难点。

由于大数据的规模巨大和数据类型多样,传统的数据处理方法和工具无法快速高效地处理这些数据。

因此,我们需要学习一些适用于大数据处理的技术,如分布式计算、并行计算、数据挖掘等。

3. 掌握大数据处理工具为了能够处理大数据,我们需要掌握一些大数据处理工具。

常见的大数据处理工具包括Hadoop、Spark、Flink等。

通过学习和实践,我们可以理解这些工具的原理和使用方法,并在实际操作中应用这些工具进行大数据处理和分析。

4. 进行大数据实验为了更好地理解和应用大数据知识,我们需要进行一些实验。

可以选择一些实际的大数据场景,如电商数据分析、社交媒体数据分析等,并使用所学的大数据处理工具进行数据处理和分析。

通过实验,我们可以进一步加深对大数据的理解和应用能力。

五、实验总结通过这次实验,我掌握了大数据的基础知识,并学习了大数据处理的基础技术和工具。

在实际的操作中,我运用所学的知识进行了大数据处理和分析,并解决了实际问题。

通过这个实验,我深刻理解了大数据对于传统的数据处理方法和工具的挑战,也认识到了大数据的巨大潜力和应用前景。

希望在未来的学习和工作中,我能够进一步深入研究和应用大数据,为社会和经济发展做出更大的贡献。

大数据实验报告

大数据实验报告一、实验背景随着信息技术的飞速发展,数据量呈现爆炸式增长,大数据已经成为当今社会各个领域关注的焦点。

大数据的处理和分析对于企业决策、科学研究、社会管理等方面都具有重要意义。

本次实验旨在深入了解大数据的处理技术和应用,通过实际操作和数据分析,探索大数据的价值和潜力。

二、实验目的1、熟悉大数据处理的基本流程和技术。

2、掌握数据采集、存储、清洗、分析和可视化的方法。

3、运用大数据技术解决实际问题,提高数据分析能力。

4、了解大数据在不同领域的应用场景和效果。

三、实验环境1、硬件环境:服务器配置为_____,内存_____,硬盘_____。

2、软件环境:操作系统为_____,使用的大数据处理框架包括_____,数据分析工具为_____,可视化工具为_____。

四、实验数据本次实验使用了公开数据集_____,该数据集包含了_____等信息,数据量约为_____。

五、实验步骤1、数据采集通过网络爬虫从相关网站获取数据。

利用数据接口获取第三方数据。

2、数据存储将采集到的数据存储到分布式文件系统 HDFS 中。

建立数据库表,使用关系型数据库 MySQL 存储结构化数据。

3、数据清洗处理缺失值,采用均值填充或删除缺失值较多的记录。

去除重复数据,保证数据的唯一性。

纠正数据中的错误和异常值。

4、数据分析使用 MapReduce 编程模型对数据进行统计分析,计算各项指标的平均值、最大值、最小值等。

运用数据挖掘算法,如聚类分析、分类算法,挖掘数据中的潜在模式和规律。

5、数据可视化使用 Echarts 等可视化工具将分析结果以图表的形式展示,如柱状图、折线图、饼图等,使数据更加直观易懂。

六、实验结果与分析1、数据分析结果通过统计分析,发现_____。

聚类分析结果表明,数据可以分为_____类,每类的特征为_____。

2、结果分析结合实际业务背景,对数据分析结果进行解释和说明。

分析结果对决策的支持和指导作用,例如_____。

大数据导论实验报告

大数据导论实验报告1. 实验目的本次实验旨在通过使用大数据处理框架,掌握大数据处理的基本概念和技术。

2. 实验环境- 操作系统:Ubuntu 18.04- 处理器:Intel Core i5 2GHz- 内存:8GB- 大数据处理框架:Apache Hadoop3. 实验过程3.1 数据准备我们选择了一个包含一百万条学生信息的数据集,数据集中包含学生的姓名、年龄、性别和成绩等信息。

这个数据集被存储在一个文本文件中,文件大小约为200MB。

3.2 Hadoop集群搭建为了进行大数据处理,我们需要先搭建一个Hadoop集群。

在我们的实验环境中,我们使用了3台虚拟机来搭建一个Hadoop集群。

其中一台作为主节点,另外两台作为从节点。

在搭建集群之前,我们需要确保每台虚拟机之间可以互相访问,并且已经正确配置了SSH免密登录。

开始搭建Hadoop集群之前,我们需要先下载并解压Hadoop的安装包,并进行配置。

我们修改了Hadoop的配置文件,设置了主节点和从节点的IP地址,并指定了数据存储的路径。

之后,我们在主节点上启动Hadoop集群,通过命令行输入以下命令:start-dfs.sh 启动分布式文件系统start-yarn.sh 启动资源管理器3.3 数据处理在搭建好Hadoop集群之后,我们可以开始进行数据处理了。

我们的目标是统计学生的平均成绩。

首先,我们需要将数据文件上传到Hadoop集群的文件系统中。

我们使用以下命令将文件复制到Hadoop集群中:hdfs dfs -copyFromLocal /path/to/students.txt /input/students.txt接下来,我们使用Hadoop提供的MapReduce框架来进行数据处理。

我们编写了两个Java类,分别是`StudentMapper`和`AverageReducer`。

`StudentMapper`用于将学生信息进行映射,而`AverageReducer`用于计算平均成绩。

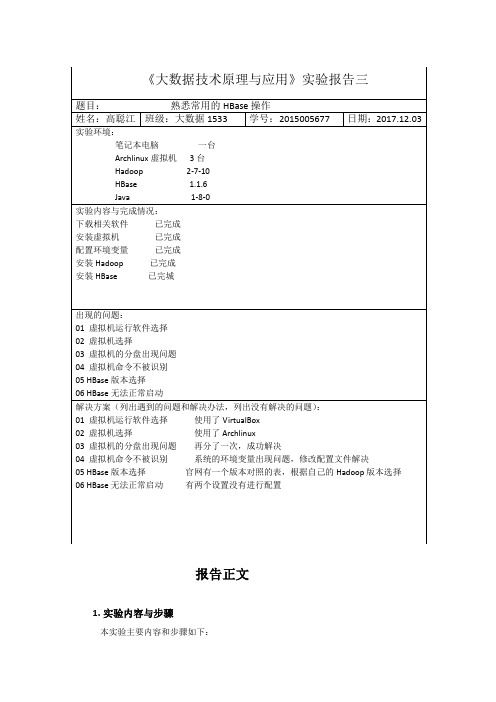

大数据技术实验三

报告正文

1.实验内容与步骤

本实验主要内容和步骤如下:

1.1.实验内容

1.编程实现以下指定功能,并利用Hadoop提供的HBase Shell命令完成相同的任务.

<1>.列出HBase所有表的相关信息,如表名,创建时间等.

<2>.在终端打印出指定表的所有记录数据.

<3>.向已经创建好的表添加和删除指定的列族或列.

<4>.清空指定表的所有记录数据.

<5>.统计表的行数.

1.2.实验步骤及实验结果

1.

<1>.列出HBase所有表的相关信息,如表名,创建时间等.

<2>.在终端打印出指定表的所有记录数据.

<3>.向已经创建好的表添加和删除指定的列族或列.

A>.添加列

B>.删除列

<4>.清空指定表的所有记录数据.

<5>.统计表的行数.

2.对指定表进行操作,完成以下功能

1>.创建表

表Student

表course

表SC

2>插入数据Student表第一行

Student表第二行

Student表第三行

Course表第一行

Course表第二行:

Course表第三行:

说明:第一页做封面,简要概述报告,正文部分详述实验内容,标题上的X 代表实验编号(实验几)。

大数据实验报告

大数据实验报告大数据实验报告引言在当今信息时代,大数据已经成为了一种重要的资源。

大数据的应用已经渗透到各个领域,从商业到医疗,从交通到教育,无处不在。

本实验旨在探索大数据的应用,并分析其对我们生活的影响。

一、大数据的概念和特点大数据是指规模巨大、种类繁多且快速增长的数据集合。

与传统的小数据相比,大数据具有三个特点:V3(Volume、Variety、Velocity)。

Volume指的是大数据的规模庞大,Variety指的是大数据的种类繁多,Velocity指的是大数据的处理速度快。

二、大数据在商业中的应用1. 市场营销:通过大数据分析,企业可以了解消费者的购买行为和偏好,从而精准地进行市场定位和推广活动。

2. 客户服务:大数据可以帮助企业了解客户需求,提供个性化的服务和产品,提高客户满意度和忠诚度。

3. 风险管理:通过对大数据的分析,企业可以预测和规避风险,减少损失。

三、大数据在医疗中的应用1. 疾病预测:通过对大数据的分析,可以发现疾病的早期迹象,提前进行预防和治疗,减少疾病的发生和传播。

2. 医疗资源优化:通过对大数据的分析,可以了解医疗资源的分布和利用情况,优化医疗资源的配置,提高医疗服务的效率。

3. 个性化医疗:通过对大数据的分析,可以根据患者的个体特征和病情,提供个性化的医疗方案,提高治疗效果。

四、大数据在交通中的应用1. 智能交通管理:通过对大数据的分析,可以实现交通信号的智能控制,减少交通拥堵和事故发生。

2. 路线优化:通过对大数据的分析,可以了解交通流量和道路状况,优化路线规划,提高交通效率。

3. 共享交通服务:通过对大数据的分析,可以实现共享交通服务的优化,提高出行效率,减少资源浪费。

五、大数据在教育中的应用1. 个性化教育:通过对大数据的分析,可以了解学生的学习特点和需求,提供个性化的教育方案,提高学习效果。

2. 教育评估:通过对大数据的分析,可以评估教育政策和教育质量,提出改进建议,提高教育水平。

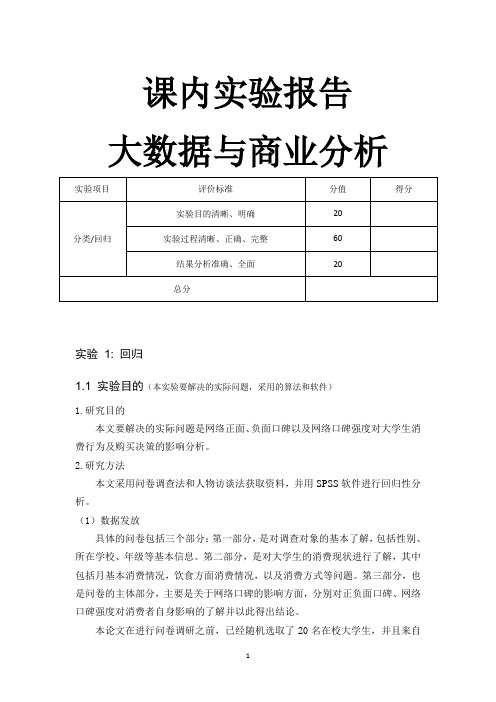

MBA作业——课内实验报告大数据与商业分析

课内实验报告大数据与商业分析实验1: 回归1.1 实验目的(本实验要解决的实际问题,采用的算法和软件)1.研究目的本文要解决的实际问题是网络正面、负面口碑以及网络口碑强度对大学生消费行为及购买决策的影响分析。

2.研究方法本文采用问卷调查法和人物访谈法获取资料,并用SPSS软件进行回归性分析。

(1)数据发放具体的问卷包括三个部分:第一部分,是对调查对象的基本了解,包括性别、所在学校、年级等基本信息。

第二部分,是对大学生的消费现状进行了解,其中包括月基本消费情况,饮食方面消费情况,以及消费方式等问题。

第三部分,也是问卷的主体部分,主要是关于网络口碑的影响方面,分别对正负面口碑、网络口碑强度对消费者自身影响的了解并以此得出结论。

本论文在进行问卷调研之前,已经随机选取了20名在校大学生,并且来自不同的年级,采取了小规模访谈的方法优化并且对问卷进行完善,对出现的不当之处进行了修改。

(2)数据搜集本论文主要是研究餐饮类网络口碑对大学生消费行为的影响,因此样本也全都是在校大学生,并且在一定条件下会进行网上订餐,把调查范围定在大学城,所以对天津大学生具有一定的代表性。

鉴于手机已经成为大学生生活的一部分,所以此次问卷调研全都采取问卷星查在线调查,通过微信、QQ软件的协助进行转载,共收到有效问卷140份。

有效回收率为100%。

1.2 实验过程(数据描述,实验主要步骤介绍,可以借助重要的图表帮助介绍过程,数量不超过5张)1.正负面网络口碑对大学生消费行为的影响分析2.网络口碑强度对大学生消费行为的影响分析3.实证分析(1)描述性统计分析方法这一研究使用了描述性统计方法,对样本数据中目标变量、Cronbach' s a、测量的目标载荷因素、相关系数等做了统计。

目标变量为正负面口碑、网络口碑强度,并分别研究了它们。

(2)相关性统计分析方法由于本文采用的是截面数据作为样本,利用截面数据建模时,很多变量的变化可能与发展规模相关,它们一起增强导致了解释变量对于被解释变量的解释程度。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

课程实验报告

专业年级14级软件工程

课程名称大数据技术原理与应用指导教师李均涛

学生姓名吴勇

学号20142205042026

实验日期2017.05.04

实验地点笃行楼B栋301

实验成绩

教务处制

2017年03月09日

实验项目

名称

Liunx基本操作

实验

目的及要求1.了解Liunx操作系统发展历史。

2.学习Liunx操作系统基本概念及操作。

3.学习Liunx操作系统用户及文件权限管理。

4.Linux 目录结构及文件基本操作。

实验内容1.实验楼环境介绍,常用Shell 命令及快捷键,Linux 使用小技巧。

2.Linux 中创建、删除用户,及用户组等操作。

Linux 中的文件权限设置。

3.Linux 的文件组织目录结构,相对路径和绝对路径,对文件的移动、复制、重命名、编辑等操作。

实验步骤

1.Liunx输入输出命令。

2.使用touch命令创建文件夹,后缀都为txt。

3.学会在命令行中获取帮助。

4.输出图形字符。

5.查看用户。

6.创建新用户。

7.删除用户。

8.查看文件权限。

9.用ls –A/Al/dl/AsSh查看文件。

10.变更文件所有者。

11.修改文件权限。

12.目录路径。

13.新建空白文件。

14.文件的复制、删除、移动、重命名。

实验环境

Liunx 操作系统

实验结果与

分析通过学习Liunx操作系统的发展历史、基本操作、用户及文件权限管理以及Linux 目录结构及文件基本操作。

是得我大致了解Liunx操作系统的使用,并且能够完成相应的练习。

教师评语

课程实验报告

专业年级14级软件工程

课程名称大数据技术原理与应用指导教师李均涛

学生姓名吴勇

学号20142205042026

实验日期2017.05.04

实验地点笃行楼B栋301

实验成绩

教务处制

2017年03月09日

实验项目

名称

Hadoop的基本操作

实验

目的及要求1.Hadoop单机模式安装.

2.Hadoop伪分布模式配置部署.

3.Hadoop介绍及1.X伪分布式安装.

4.adoop2.X 64位编译.

5.Hadoop2.X 64位环境搭建.

实验内容1.hadoop三种安装模式介绍,hadoop单机模式安装,测试安装

2.hadoop配置文件介绍及修改,hdfs格式化,启动hadoop进程,验证安装.

3.Hadoop1.X伪分布安装,Hadoop介绍,Hadoop变量配置.

4.Hadoop2.X 64位编译,编译Hadoop2.X 64位,编译Hadoop.

5.搭建环境,部署Hadooop2.X,启动Hadoop.

实验步骤1.用户及用户组,添加用户及用户组,添加sudo权限.

2.安装及配置依赖的软件包,安装openssh-server、java、rsync等,配置ssh

免密码登录.

3.下载并安装Hadoop, 下载Hadoop 2.6.0,解压并安装, 配置Hadoop.

4.测试验证.

5.相关配置文件修改:修改core-site.xml:

6.格式化HDFS文件系统.

7.Hadoop集群启动.

8.测试验证.

9.设置Host映射文件.

10.下载并解压hadoop安装包

11.在Hadoop-1.1.2目录下创建子目录.

12.启动hadoop.

13. 编译Hadoop2.X 64位.

14.使用yum安装sun.

15. 部署Hadooop2.X.与Hadoop1.X类似。

实验环境hadoopXfce终端

实验结果与

分析通过本次实验,让我对Hadoop有所了解,但是在实验过程中出现许多问题。

例如,不知道该如何下载java jdk,甚至如何创建文件夹目录下的文件,以及Hadoop的环境配置原理以及编译原理和方法。

这些都是实验中出现的问题,但是通过自己查询,问同学,部分问题已经得到解决,但是还存在一部分就只能通过课后自学进行解决!!!通过上述的学习,让我对Hadoop的基本操作有了基础的掌握,包括Hadoop介绍及1.X伪分布式安装,adoop2.X 64位编译,Hadoop2.X 64位环境搭建等。

教师评语

注:可根据实际情况加页

课程实验报告

专业年级14级软件工程

课程名称大数据技术原理与应用指导教师李均涛

学生姓名吴勇

学号20142205042026

实验日期2017.06.01

实验地点笃行楼B栋301

实验成绩

教务处制

2017年03月09日

客户端通过调用DistributedFileSystem的create()方法创建新文件。

1.6测试例子1。

1.创建代码目录

2. 建立例子文件上传到HDFS中

3.配置本地环境

4.编写代码

5.编译代码

6.使用编译代码读取HDFS文件

2. MapReduce原理及操作。

2.1环境说明。

性控制,表示用作此用途的堆空间的百分比),如果数据量超过了该缓冲区大小的一定比例(由mapred.job.shuffle.merge.percent决定),则对数据合并后溢写到磁盘中。

2.5测试例子。

1.编写代码。

2.编译代码。

3.打包编译文件。

4.解压气象数据并上传到HDFS中。

5. 运行程序。

6. 查看结果。