jmeter性能测试报告.doc

jmeter性能测试实验报告

jmeter性能测试实验报告JMeter 性能测试实验报告一、实验背景随着业务的不断发展,系统的性能成为了关键的关注点。

为了确保系统在高并发、大数据量等情况下能够稳定运行,满足用户的需求,我们使用 JMeter 工具对系统进行了性能测试。

二、实验目的本次性能测试的主要目的是评估系统的性能表现,包括但不限于以下方面:1、确定系统能够承受的最大并发用户数。

2、评估系统在不同并发用户数下的响应时间和吞吐量。

3、检测系统在高负载下是否存在性能瓶颈,如内存泄漏、CPU 利用率过高等。

4、为系统的优化和改进提供依据。

三、实验环境1、硬件环境服务器:_____客户端:_____2、软件环境操作系统:_____应用服务器:_____数据库:_____JMeter 版本:_____四、实验设计1、测试场景设计登录场景:模拟用户登录系统的操作。

搜索场景:模拟用户进行搜索的操作。

数据提交场景:模拟用户提交数据的操作。

2、并发用户数设置逐步增加并发用户数,从 100 开始,每次增加 100,直到系统出现性能瓶颈或达到预期的最大并发用户数。

3、测试数据准备准备足够的测试数据,包括用户账号、搜索关键词、提交的数据等,以确保测试的真实性和有效性。

4、性能指标监控监控服务器的 CPU 利用率、内存利用率、磁盘 I/O 等性能指标。

监控系统的响应时间、吞吐量、错误率等性能指标。

五、实验步骤1、启动 JMeter 工具,创建测试计划。

2、添加线程组,设置并发用户数和循环次数。

3、添加 HTTP 请求,配置请求的方法、路径、参数等。

4、添加监听器,用于收集性能指标数据,如聚合报告、查看结果树等。

5、配置服务器监控插件,监控服务器的性能指标。

6、运行测试计划,观察性能指标的变化。

7、根据测试结果,分析系统的性能表现,找出性能瓶颈。

六、实验结果及分析1、登录场景并发用户数为 100 时,平均响应时间为 2 秒,吞吐量为 50 次/秒,错误率为 0%。

jmeter性能测试报告

jmeter性能测试报告目录1. 概述1.1 定义1.2 目的2. JMeter性能测试报告的重要性2.1 为决策提供依据2.2 发现系统问题3. JMeter性能测试报告的内容3.1 性能摘要3.2 性能趋势分析3.3 错误分析4. 性能测试报告的编写注意事项4.1 清晰易懂4.2 结果可靠性概述定义JMeter性能测试报告是在对系统进行性能测试后所生成的详细报告,用于反映系统的性能表现和性能指标。

目的JMeter性能测试报告的主要目的是帮助团队成员了解系统在不同负载下的性能表现,从而为决策提供依据和推动性能优化。

同时,也可以帮助发现系统中存在的性能问题,及时进行调整和改进。

JMeter性能测试报告的重要性为决策提供依据JMeter性能测试报告可以为决策者提供系统在不同负载情况下的性能数据,帮助他们做出合理的决策,如是否需要升级硬件、优化代码或调整系统配置。

发现系统问题通过分析JMeter性能测试报告中的数据,可以帮助团队发现系统中存在的性能问题,如性能瓶颈、内存泄漏等,有针对性地进行优化,提高系统的性能和稳定性。

JMeter性能测试报告的内容性能摘要性能摘要部分通常包括系统在不同负载下的吞吐量、响应时间、错误率等核心指标,为读者提供一个整体的性能概况。

性能趋势分析性能趋势分析会展示系统在一段时间内的性能变化情况,帮助团队了解系统的性能趋势,预测未来可能出现的性能问题。

错误分析错误分析部分会详细列出在性能测试中出现的错误类型和次数,帮助团队找出系统中存在的问题,及时进行修复和优化。

性能测试报告的编写注意事项清晰易懂性能测试报告应该使用清晰简洁的语言,避免使用过多的技术词汇,让读者容易理解报告内容,做出正确的决策。

结果可靠性在编写性能测试报告时,应确保测试结果的可靠性和准确性,避免因为数据错误或解释模糊导致做出错误的决策。

jmeter性能测试报告

jmeter性能测试报告一、测试环境。

本次性能测试是在一个典型的生产环境中进行的,测试服务器配置为,CPU 8核、内存 16GB、硬盘 500GB,操作系统为CentOS 7.0,Java版本为1.8。

测试使用的工具为Apache JMeter 5.1.1。

二、测试目标。

本次性能测试的主要目标是评估系统在高负载下的性能表现,包括并发用户数、响应时间、吞吐量等指标。

通过对系统的压力测试,发现系统的性能瓶颈,并对系统进行优化,以提高系统的稳定性和可靠性。

三、测试方案。

1. 测试场景设计,根据实际业务场景,设计了多个测试场景,包括用户登录、数据查询、提交订单等操作。

2. 测试数据准备,准备了符合实际业务的测试数据,以模拟真实用户行为。

3. 测试脚本编写,使用JMeter编写了测试脚本,模拟了不同的用户行为,并设置了不同的并发用户数。

4. 测试执行,在测试环境下执行测试脚本,记录测试过程中的性能数据。

四、测试结果。

1. 响应时间,在100个并发用户的情况下,系统的平均响应时间为2.5秒,最大响应时间为5秒。

2. 吞吐量,系统在高峰期的吞吐量为每秒处理100个请求,系统能够较好地支撑业务高峰期的访问量。

3. 错误率,系统在高负载下的错误率较低,仅为0.5%,表明系统具有较好的稳定性和可靠性。

4. 资源利用率,系统在测试过程中,CPU利用率在80%左右,内存利用率在60%左右,硬盘IO在正常范围内,系统资源利用率较为稳定。

五、测试分析。

通过对测试结果的分析,发现系统在当前的配置下,能够较好地支撑业务的高负载访问。

然而,随着用户量的增加,系统的响应时间有可能会进一步增加,因此建议在后续的优化中,对系统进行进一步的扩展和调优,以提高系统的性能和稳定性。

六、优化建议。

1. 系统性能优化,建议对系统的关键模块进行性能优化,包括数据库查询、接口调用等,以提高系统的响应速度。

2. 硬件资源扩展,可以考虑对服务器的硬件资源进行扩展,包括CPU、内存等,以提高系统的并发处理能力。

jmeter自动化测试报告模板

JMeter自动化测试报告模板一、测试计划制定在开始测试之前,根据需求文档和设计文档,我们制定了详细的测试计划。

测试计划明确了测试目标、范围、方法、资源、时间安排等关键信息,以确保测试的顺利进行。

二、测试数据准备为了确保测试的有效性,我们根据测试计划准备了充足和合适的测试数据。

这包括模拟用户请求的数据、响应数据的生成等。

三、测试执行过程1.根据测试计划,我们设置了JMeter并进行预测试,以确保一切正常。

2.执行测试,记录结果并进行分析。

四、测试覆盖率在本次测试中,我们成功地对80%的软件功能进行了覆盖,达到了预期的覆盖率目标。

具体覆盖情况如下:功能模块覆盖情况备注A模块95% 全部关键操作均已覆盖B模块80% 部分高级功能未被覆盖C模块2% 由于资源限制,未进行此模块的测试五、性能指标分析通过测试,我们获取了系统的性能数据。

以下是部分关键性能指标的分析:●响应时间:平均响应时间为100ms,最大响应时间为150ms。

●并发用户:在500并发用户的情况下,系统表现稳定。

●吞吐量:系统每秒处理请求数为XX,满足预期标准。

六、错误分析在测试过程中,我们发现了5个错误,其中3个已修复,2个待修复。

以下是具体的错误描述和修复情况:序号错误描述修复情况1 A模块出现数据异常已修复2 B模块登录功能异常待修复3 C模块数据处理错误已修复4 D模块接口调用失败待修复5 E模块响应超时已修复七、日志与图表分析1.测试日志:在执行过程中,我们记录了详细的测试日志,包括每次请求的时间戳、响应数据等信息。

这些日志对于问题定位和后续分析至关重要。

2.性能图表:通过图表的形式,直观地展示了系统的性能变化趋势。

例如,使用折线图表示响应时间的变化,柱状图展示不同负载下的吞吐量等。

八、问题列表及解决方案针对上述错误,我们制定了相应的解决方案,并计划在下一个迭代中修复这些问题。

具体解决方案如下:●对于错误1和错误3,计划进行代码审查并进行相应的修复。

jmeter测试报告

jmeter测试报告

JMeter测试报告是使用Apache JMeter进行性能测试后生成的结果的汇总。

它提供了关于测试执行结果的详细信息,包括各个请求的响应时间、吞吐量、错误率等指标。

JMeter测试报告通常包括以下内容:

1. 汇总信息:显示测试执行的总体结果,包括总请求数、成功请求数、失败请求数、平均响应时间等。

2. 响应时间分布图表:显示各个请求的响应时间分布情况,可以帮助分析性能瓶颈。

3. 成功率和错误率图表:显示成功请求和失败请求的比例,以及错误请求的类型和数量。

4. 吞吐量图表:显示每秒钟处理的请求数量,可以帮助评估系统的可承载能力。

5. 响应时间趋势图表:显示测试过程中响应时间的变化趋势,有助于观察系统性能的稳定性。

6. 并发用户数图表:显示测试过程中并发用户数的变化情况。

JMeter测试报告可以以HTML、XML、CSV等格式导出,在性能测试完成后可以方便地与团队成员、管理者进行共享和讨

论。

它提供了丰富的测试结果信息,帮助用户全面评估系统的性能并进行性能优化。

JMeter性能测试:JMeter多用户并发模拟及压测结果分析

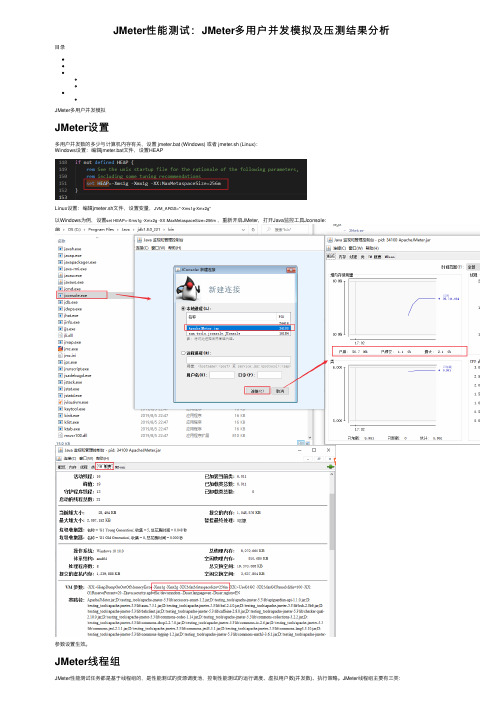

JMeter性能测试:JMeter多⽤户并发模拟及压测结果分析⽬录JMeter多⽤户并发模拟JMeter设置多⽤户并发数的多少与计算机内存有关,设置 jmeter.bat (Windows) 或者 jmeter.sh (Linux):Windows设置:编辑jmeter.bat⽂件,设置HEAPLinux设置:编辑jmeter.sh⽂件,设置变量,JVM_ARGS="-Xms1g-Xmx2g"以Windows为例,设置set HEAP=-Xms1g -Xmx2g -XX:MaxMetaspaceSize=256m,重新开启JMeter,打开Java监控⼯具Jconsole:参数设置⽣效。

JMeter线程组JMeter性能测试任务都是基于线程组的,是性能测试的资源调度池,控制性能测试的运⾏调度、虚拟⽤户数(并发数)、执⾏策略。

JMeter线程组主要有三类:setUp Thread Group:普通线程组执⾏之前执⾏,相当于pytest测试框架的setup⽅法。

Thread Group:普通线程tearDown Thread Group:普通线程组之后执⾏。

JMeter压测实例⾸先使⽤python开启⼀个http服务:(base) C:\Users\10287>python -m http.server 80Serving HTTP on 0.0.0.0 port 80 (http://0.0.0.0:80/) ...新建线程组,设置线程数,点击运⾏View Results TreeThread Group -> Add -> Listenter -> View Results Tree⽀持各种测试器:正则表达式、CSS选择器、XPath测试、JSON Tester等Aggregate Report查看Aggregate Report,聚合报告Thread Group -> Add -> Listenter -> Aggregate Report参数:Average:平均响应时间,所有请求的平均响应时间。

JMeter测试报告

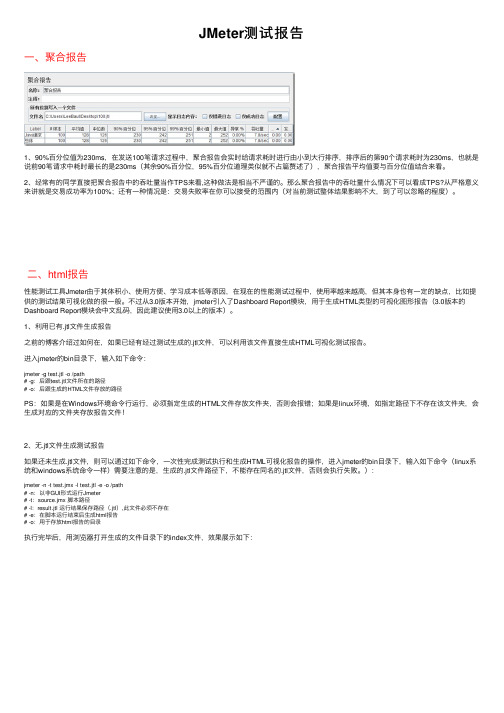

JMeter测试报告⼀、聚合报告1、90%百分位值为230ms,在发送100笔请求过程中,聚合报告会实时给请求耗时进⾏由⼩到⼤⾏排序,排序后的第90个请求耗时为230ms,也就是说前90笔请求中耗时最长的是230ms(其余90%百分位,95%百分位道理类似就不占篇赘述了),聚合报告平均值要与百分位值结合来看。

2、经常有的同学直接把聚合报告中的吞吐量当作TPS来看,这种做法是相当不严谨的。

那么聚合报告中的吞吐量什么情况下可以看成TPS?从严格意义来讲就是交易成功率为100%;还有⼀种情况是:交易失败率在你可以接受的范围内(对当前测试整体结果影响不⼤,到了可以忽略的程度)。

⼆、html报告性能测试⼯具Jmeter由于其体积⼩、使⽤⽅便、学习成本低等原因,在现在的性能测试过程中,使⽤率越来越⾼,但其本⾝也有⼀定的缺点,⽐如提供的测试结果可视化做的很⼀般。

不过从3.0版本开始,jmeter引⼊了Dashboard Report模块,⽤于⽣成HTML类型的可视化图形报告(3.0版本的Dashboard Report模块会中⽂乱码,因此建议使⽤3.0以上的版本)。

1、利⽤已有.jtl⽂件⽣成报告之前的博客介绍过如何在,如果已经有经过测试⽣成的.jtl⽂件,可以利⽤该⽂件直接⽣成HTML可视化测试报告。

进⼊jmeter的bin⽬录下,输⼊如下命令:jmeter -g test.jtl -o /path# -g:后跟test.jtl⽂件所在的路径# -o:后跟⽣成的HTML⽂件存放的路径PS:如果是在Windows环境命令⾏运⾏,必须指定⽣成的HTML⽂件存放⽂件夹,否则会报错;如果是linux环境,如指定路径下不存在该⽂件夹,会⽣成对应的⽂件夹存放报告⽂件!2、⽆.jtl⽂件⽣成测试报告如果还未⽣成.jtl⽂件,则可以通过如下命令,⼀次性完成测试执⾏和⽣成HTML可视化报告的操作,进⼊jmeter的bin⽬录下,输⼊如下命令(linux系统和windows系统命令⼀样)需要注意的是,⽣成的.jtl⽂件路径下,不能存在同名的.jtl⽂件,否则会执⾏失败。

性能测试分析报告

性能测试分析报告1. 引言在软件开发过程中,性能测试是一项重要的任务,它旨在评估系统在不同负载条件下的性能表现。

本文将分析一次性能测试的结果,以了解系统在各种负载条件下的表现,并提供改进建议。

2. 测试环境本次性能测试在以下环境中进行: - 操作系统:Windows Server 2016 - 处理器:Intel Core i7-8700K - 内存:16GB - 软件版本:应用版本1.0.03. 测试目标本次性能测试的主要目标是评估系统的响应时间和吞吐量。

我们将通过模拟不同负载条件来测试系统的性能,并记录下相关数据以进行分析。

4. 测试方案我们将使用JMeter进行性能测试。

测试方案包括以下步骤: 1. 设置测试计划:定义测试目标、线程组和相关参数。

2. 创建HTTP请求:模拟用户请求,包括登录、浏览和提交表单等操作。

3. 添加断言:验证系统返回的数据是否符合预期。

4. 配置监听器:收集系统的响应时间和吞吐量等性能指标。

5. 运行测试:使用不同负载条件运行测试,并记录测试结果。

5. 测试结果分析在测试过程中,我们模拟了100个并发用户在30分钟内对系统进行操作。

以下是我们得到的一些关键结果:5.1 响应时间系统在不同操作下的平均响应时间如下:- 登录操作:平均响应时间为1.5秒。

- 浏览操作:平均响应时间为2.2秒。

- 表单提交操作:平均响应时间为3.8秒。

从结果中可以看出,表单提交操作的响应时间相对较长,可能是由于数据处理量较大导致的。

5.2 吞吐量系统在不同操作下的吞吐量如下: - 登录操作:平均吞吐量为50个请求/秒。

- 浏览操作:平均吞吐量为40个请求/秒。

- 表单提交操作:平均吞吐量为30个请求/秒。

根据吞吐量结果可以看出,在并发用户较多的情况下,系统的吞吐量会下降,可能会影响用户的体验。

6. 结果分析根据测试结果,我们可以得出以下结论: 1. 系统在处理表单提交操作时的响应时间较长,可能需要优化数据处理逻辑。

jmeter性能报告

JMeter性能报告介绍JMeter是一个开源的性能测试工具,可以用于测试各种应用程序和服务器的性能。

它具有强大的功能和灵活的配置选项,可以模拟大量用户同时访问应用程序,从而测试系统在负载下的性能表现。

在本文中,将介绍如何使用JMeter进行性能测试,并生成性能报告。

步骤一:安装JMeter首先,我们需要安装JMeter。

在JMeter官方网站上下载适用于您的操作系统的安装程序,然后按照安装向导完成安装过程。

步骤二:创建测试计划打开JMeter,我们需要创建一个新的测试计划。

在左侧导航栏上右键单击“测试计划”,然后选择“添加”>“Threads (Users)”>“线程组”。

线程组是模拟用户的集合,可以设置用户数量和并发访问量。

步骤三:添加Sampler现在,在线程组下添加一个Sampler。

Sampler定义了要发送给服务器的请求。

右键单击线程组,选择“添加”>“Sampler”>“HTTP请求”。

在HTTP请求中,我们可以设置请求的URL、请求方法和参数等。

步骤四:设置断言断言用于验证服务器返回的响应。

添加一个响应断言,以确保服务器返回了正确的响应。

右键单击HTTP请求,选择“添加”>“断言”>“响应断言”。

在断言配置中,可以设置期望的响应代码或响应内容。

步骤五:配置监听器监听器用于收集和显示测试结果。

右键单击线程组,选择“添加”>“监听器”>“聚合报告”。

在聚合报告中,我们可以查看每个请求的响应时间、吞吐量和错误率等信息。

步骤六:运行测试完成配置后,点击工具栏上的“运行”按钮开始测试。

JMeter将模拟用户并发送请求到服务器。

请确保服务器可以处理所模拟的负载。

步骤七:生成性能报告测试运行完成后,我们可以生成性能报告以帮助分析测试结果。

在左侧导航栏上右键单击线程组,选择“添加”>“监听器”>“生成报告”。

选择适当的报告类型和输出目录,然后点击“运行”按钮生成报告。

【转】Jmeter性能测试报告解析

【转】Jmeter性能测试报告解析报告解析1、Aggregate Report 解析 Aggregate Report 是 JMeter 常⽤的⼀个 Listener,中⽂被翻译为“聚合报告”。

今天再次有同⾏问到这个报告中的各项数据表⽰什么意思,顺便在这⾥公布⼀下,以备⼤家查阅。

如果⼤家都是做Web应⽤的,例如只有⼀个登录的请求,那么在Aggregate Report中,会显⽰⼀⾏数据,共有10个字段,含义分别如下。

Label:每个 JMeter 的 element(例如 HTTP Request)都有⼀个 Name 属性,这⾥显⽰的就是 Name 属性的值 #Samples:表⽰你这次测试中⼀共发出了多少个请求,如果模拟10个⽤户,每个⽤户迭代10次,那么这⾥显⽰100 Average:平均响应时间——默认情况下是单个 Request 的平均响应时间,当使⽤了 Transaction Controller 时,也可以以Transaction 为单位显⽰平均响应时间 Median:中位数,也就是 50%⽤户的响应时间 90% Line:90%⽤户的响应时间 Note:关于 50%和 90%并发⽤户数的含义,请参考下⽂ /jackei/archive/2006/11/11/557972.html Min:最⼩响应时间 Max:最⼤响应时间 Error%:本次测试中出现错误的请求的数量/请求的总数 Throughput:吞吐量——默认情况下表⽰每秒完成的请求数(Request per Second),当使⽤了 Transaction Controller 时,也可以表⽰类似的 Transaction per Second 数 KB/Sec:每秒从服务器端接收到的数据量,相当于LoadRunner中的Throughput/Sec 基本知识: 1、吞吐量:是指在没有帧丢失的情况下,设备能够接受的最⼤速率。

jemeter性能测试

jemeter性能测试1:性能测试关键指标 衡量性能测试的参数 ⼀:响应时间 ⼆:并发⽤户数 三:吞吐量 四:系统性能计数器(资源使⽤率) 五:思考时间 功能性测试:pass和fail 性能测试指标:多维度的指标衡量:快不快,强不强,好不好 多(⽀持最⼤的⽤户访问量) 快(响应时间多快) 好(持久运⾏) 省(资源节省) 多:并发量 快:延时,响应时间 好:稳定性,长时间运⾏ 省:资源使⽤率 +⼀个思考时间 ⼀个好的系统就是多快好省的⼀个系统2:响应时间 对请求做出响应所需要的时间,是⽤户感知软件性能的主要指标 如上典形的三层模型:客户端(浏览器),应⽤服务器,数据库服务器 所有的应⽤服务器和数据库都是基于操作系统的 客户端在桌⾯上打开⼀个电脑,输⼊⽹址,通过http请求先发送到web服务器,web服务器根据链接查找⽂件,有⽹络接收时间 有处理时间A1,之后如果要查数据(⽐如登录验证⽤户名密码)需要访问数据服务器,有个N2⽹络时间发过去, 如果数据服务器和web服务器是同⼀台,那么N2和N3基本认为可以没有了,变成了程序时间的进程通信,本机交互 如果web就在web服务器打开⽹页请求,那么N1和N4就没有了,三合⼀就没有⽹络时间了 响应时间包括上⾯的全部:N1,A1,N2,N3,A3,N4 ⽤户不知道经过多少服务,只看打开页⾯和接受的时间(两者时间差),客户感知的感应时间:是端到端的(不管中间经过多少请求,多少处理不管) 发出请求多久能受到 测试⼯程师需要关注:N1到N4所有的请求的时间 web服务器和数据库服务器的⽹络响应时间N2和N3:linux ping命令查看两台系统的响应时间,简单 这是⽹络时间,不是处理时间 响应时间多少合理: 对于⼀个web系统,普遍接受的时间标准为2/5/8秒 2秒钟之内响应客户是⾮常好的 5秒钟之内响应客户是可以接受的 8秒钟是客户能够接受响应的上限 响应时间包括: 1:⽤户客户端呈现时间 2:请求/响应数据⽹⾥传输时间 3:应⽤服务器处理时间 4:数据库处理时间3:并发⽤户数 ⽤户三种类型: 系统⽤户数:1w个⼈注册了,下载了app并且注册了,保存在数据库⾥⾯真正的⼀条条数据(app热不热门看app的注册量,不是下载量) 注册⽤户数对系统影响不会太⼤,主要影响磁盘空间,存储上⾯,内存也会受到影响,cpu也会受到影响 响磁盘空间满和空对于系统查询来说是有很⼤影响的,系统性能测试的时候⼀定记得初始化环境 装的东西多了,找东西更花时间,捞数据更慢 性能测试需要部署这部分系统⽤户数,存量⽤户,系统的环境 系统性能测试需要构造出跟现场差不多的环境,数据库空的,和数据库有⼀亿数据的是有很⼤差别的 存储区域满的的需要寻址去写⼊数据,空⽩的写和塞满了找空格去写,写的速度⼀样,找地址的速度相差很⼤ 没有经过初始化的性能环境==没有作⽤的环境(现场的配置,现场的⽤户量,还有⽹络环境,测试的时候数据a机器,服务器b机器,两个机器背靠背⽹线⼀连接 交换机都不过,这样进⾏系统测试也是没有什么意义的,现场a机器上海,b服务器北京,⼀测就是gg 测试时候:a-b可能就是0.0001s,现场:a-b可能就需要2s了,这时候找运维:注⼊延时,两台电脑的防⽕墙上⾯注⼊延时 linux系统注⼊⽹络延时的⽅法,windwos注⼊⽹络延时(命令⼯具注⼊都可以)规定必须2s才能牵⼿) 在线⽤户数: 登录了,但是没有⾏为,什么都不⼲,对系统就没什么压⼒ 12306:在线被踢了,登录不上系统 在线⽤户数影响: 内存(web的session会话需要保持,会话放在内存⾥的,同时在线需要保持登录状态,内存消耗很⼤) cpu:在线⽤户数和cpu有关系但是关系不⼤, cpu:时间⽚,cpu基于时间戳的,每个进⾏任务分个固定时间,看状态好不好执⾏,执⾏好了执⾏下⼀个,保持业务任务公平执⾏ 每⼀个进⾏都有个时间⽚,⽤完了下⼀个,排队,全部塞在内存⾥⾯的进程,在线⽤户就是⼀个session,cpu 会看⾥⾯有没有动作 ⼀个个过掉了,因为⽤户没有操作,没有⾏为,会花时间,基本上很少,切换的很快的,和cpu关联不⼤ 磁盘:⼀丁点关系 ⽹络:⼀丁点关系 对什么要求最⾼,什么就容易产⽣瓶颈,系统测试就是在⽊板⾥挑选⼀个短板, 并发⽤户数:秒杀了,同时在线做操作, 1:严格并发 所有的⼈再同⼀个时间做同⼀件事,同⼀时间点⼀个按钮 2:⼴义并发 不严格并发,你点你的按钮,我点我的按钮,你打开页⾯,我登录,你查询,我下单这也是并发 性能测试需要两个都在,极端情况下做⼀个最敏感的,秒杀双11抢购,平时有秒杀的,查询的,改订单的,等做成⼀个不同的场景出来 ⽤不同的jemert去洪他,所以性能测试只有⼀个jemeter是不合格的,只有⼀种场景不得⾏,(性能测试需要⼏个jemert,脚本需要⼏套) 极端的可能就⼀种情况,但是⼀般需要规划的:100个⽤户,25个登录,25注册,25查询,25评价 ⼀般严格并发和⼴义并发都要测试---这就是性能的规划了 并发⽤户数的计算公式 知道平均的每天多少访问量,⼀天内登录导退出的平均响应时间,总共观察多少时间得到⼀个这样的公式 每天多少访问量,每个⼈访问的时间,考察的时间长度(⼀天或者半天)来进⾏计算,就是平均并发⽤户量 3000⽤户,平均每天400个系统访问系统,典形⽤户⼀天只在8⼩时内使⽤改系统,从系统登录到退出系统的平均时间4⼩时 C=nL/T=400*4/8=200 得出并发⽤户数200 估算 C^=200+3*根号C 如果系统不熟悉,并发⽤户数怎么计算 并发⽤户数量的统计的⽅法⽬前没有准确的公式 不同系统会有不同的并发特点 假如QA系统统计并发⽤户数量的经验公式为:使⽤系统⽤户数量*(5%~20%) (系统注册⽤户数量的百分之5-20) 1w⼈注册,固安⼀下500⼈的并发量 前⾯⽤户量从0-500,系统还好的响应时间基本不变,后⾯⽤户量达到500了时候,突然升到很⾼,这⾥就是性能拐点, 到了这个临界点性能就很糟糕了,500⽤户量达到性能瓶颈了,⽤户响应时间超长,⽤户还可能没有响应了,500这个并发量就是 性能拐点,jemter有监听和统计报表4:吞吐量 吞吐量:单位时间内系统处理⽤户的请求数,单位时间,⽐如1个⼩时,系统让1w个⼈正常访问 吞吐率:单位时间变成1s,每秒钟多少,⼀般关注吞吐率,⼀秒钟能处理多少,这时候TPS出来,每秒钟处理的事务数 ⼀个事务可能包含⼏个消息,TPS吞吐率,js有这种空间计算的 吞吐率吞吐量有不同的⽅式,每秒钟多少字节,多少请求,⼀般使⽤请求数的⽐较多 吞吐量的估算计算公式 100个并发,每个VU间隔1s法出⼀个请求 吞吐量=100*1/1=100 图形分析 随着⽤户量的上升,吞吐量上升,再上升的时候就平了,并发⽤户再多的时候,不变了,瓶颈了,上不去了,饱和了,性能瓶颈了 这时候需要加⼀套服务器或者看⼀下内存满了还是cpu满了,还是磁盘满了,资源监控和分析 这⾥⾯出现饱和的基本上都是⽹络原因⽐较多,cpu和内存的问题不会⼀条线那么绝对会不变动,会有波浪 这时候可能是⽹络臃塞了,需要加带宽了,⽹络丢包了,很⽆情,满了就丢 内存满了会和磁盘进⾏交换,⽤交换空间,会震动⼀下 cpu满了有时候会下来⼀些,,空闲时间突然可能好了⼀点,会波浪线上上下下,⼀条线这么绝对可能就是⽹络 后⾯可以⽹络命令监控⼀下5:性能计数器(资源使⽤率) 性能计数器:描述服务器或操作系统性能的⼀些数据指标 ⽐如: 内存 cpu 磁盘等资源使⽤率6:思考时间 消息和消息之间留⼀个等待时间,发⼀条消息,然后等1s再发⼀条信息,更加真实模拟⽤户的⾏为, Think Time:业务⾓度来看,这个时间指⽤户进⾏操作时每个请求之间的间隔时间 在做性能测试时候,为了模拟这样的时间间隔,引⼊了思考时间这个概念,更加真实的模拟⽤户操作7:系统环境初始化:重点 ⽹络⽅⾯:注⼊延时 对于数据库:不是很敏感的数据,把数据库dump过来,导出来,备份还原进去、数据很敏感,根据数据的表格格式 姓名,密码,电话号码,邮箱,等,知道格式后使⽤数据库脚本创建就⾏了,模拟出来,构造出来 知道结构和量就⾏了,1千万的数据脚本刷进去就⾏了 对于在线⽤户数:warm up热机,热⾝,让⽤户跑进去,把内存填起来,不要为空,让系统接近于正在运⾏的系统,让系统查询速度更快 ,数据从磁盘进⼊内存的⼀个过程,正常跑的系统,⾥⾯⼤部分⽤户数据在内存⾥⾯的,速度更快, ⼀开始跑,特别是查询的时候,速度很慢,长时间跑的数据⽚和数据区在内存⾥都存在,直接从内存⾥调导cpu去 什么都没跑过的,什么都要从磁盘⾥⾯去拉,内存和磁盘速度相差⼏千⼏万倍的差别,性能之前需要热机 1:磁盘⽤户调⼊内存 2:让内存接近现实场景,更加精准 热机:jemeter先洪⼀洪,洪⼀段时间然后再开始算响应的时间,jemeter跑⼀跑再算时间,前⾯热机的时间不要算时间 尽量让⽤户都进去,跑半个⼩时之后再计算性能的响应时间,tps,资源使⽤率,系统进⼊稳定期才开始计算8:测试下这个web系统的性能,看能⽀持多少并发 在确定并发⽤户数之前,必须先对⽤户的业务进⾏分析,分析出其中的典形业务场景(⽤户最常见的,最关注的业务操作),然后基于场景获得其并发⽤户数 常见场景:访问⽹站⾸页,登录功能,核⼼业务功能,个⼈中⼼9:jemeter性能测试⼯具简介 多线程框架, 进程:启动jemeter是⼀个java进程 线程:java并发去创建⽤户数,这个⽤户数就是java进程⾥⾯的线程 多线程框架:jemeter⾥⾯可以创建很多线程数(⽤户数) 对服务器的模拟负载: 性能测试两个级别,⽤户线程级别的,⽤户进程级别的,⾏业⽤的⽐较多的都是线程级别的 jemeter可以模拟很多线程,⼀个线程就是⼀个⽤户数,然后去压测服务器,对服务器进⾏模拟负载的测试 模拟⼀千个⽤户在线:通过jemeter可以实现 ⽀持各种服务器的性能测试: web的,数据库,FTP的各式各样的都可以,可以专门测试某些接⼝,也可以测试对应的这个数据库都可以 开源,存java,可⼆次定制化开发 jemeter发tcp协议的时候,发现⾃带的tcp取样器有时候结尾是uf结尾的,有时候协议不太⽀持,这时候需要进⾏⼆次开发 10:jemeter运⾏环境搭建 jemeter下载好电脑有java环境就ok了 ⼯具⼀般不⽤最新的,除⾮需求新⼯具的新需求, jdk:⼀般是带开发⼩组件的,可以开发程序的⼯具包 jre:java运⾏时环境,如果只运⾏java程序要jre就⾏,不需要jdk jvm:java虚拟机 jmeter.bat windows批处理⽂件,jmeter在windows环境运⾏的按钮,双击就可以启动 jmeter.log jemeter⽇志⽂件,跑的东西都在这⾥⾯记录下来 jmeter.properties jemeter属性⽂件,很多属性在⾥⾯设置 jmeter.sh .sh表⽰linux服务器启动的执⾏⽂件 jmeter-server 启动单台jmeter在windows⾥⾯jmeter.ba这个就可以启动单台,如果通过分布式去做的话需要jmeter-server使⽤这个 分布式:⼀台电脑能承受多少⽤户数 每⼀条机器能创建多少个⽤户数: 内存(物理内存32g) jmeter本⾝是⼀个java进程,进程需要消耗⼀定的内存资源(堆内存) 所以⼀台机器能虚拟多少⽤户数,⼀个是本机物理内存多⼤,另⼀个是给jmeter这个进程多⼤的堆内存 端⼝号:端⼝号分配不均,不合理也达不到很好的发挥 所以很多时候虚拟5000个⽤户机器⽜逼就⾏了,还需要多台机器做分布式, 主机下⾯很多从机 如果需要虚拟4000个⽤户,找四台机器,主机下⾯四台从机,每个从机都是1000,主从的⽅式实现分布式 正常性能测试⼀台机器搞不定的, 分布式:负载均衡,⽤户负载,找⼏个哥们分担⽤户数 jmeter是java进程,每个进程会消耗⼀定的内存,所以打开jmeter的时候有个默认的堆内存,堆内存是提供java进⾏使⽤的内存空间 jmeter环境设置: jmeter home和path路径 dos运⾏命令:⾥⾯有个path路径,输⼊jmeter的时候会到每个path路径去找,有没有这个命令,有就能运⾏,没有就会提⽰不内部或者外部指令 找环境变量 ⽤户变量:a⽤户设置的变量b⽤户使⽤不了了,⼀般设置系统变量 系统变量: gui:带窗⼝的界⾯化模式,gui模式,jmeter⼀般不使⽤gui模式去做负载测试,因为gui会消耗⼀定的资源 windows和linux系统的差别:gui模式会有很多资源处理页⾯的⼀些操作,会消耗很多性能资源的,性能下降 这就是为什么设设置path路径使⽤命令⾏模式 HEAP:堆, jmeter配置了堆之后cmd显⽰得还是不会改,显⽰得时候写死了,设置8g显⽰还是256m,正常设置是⽣效得 这个只是个提⽰11:jmeter⼯具的使⽤ ⽂件 新建 模板:其他请求的模板(不太知道的接⼝不知道怎么写,⾥⾯对着写就⾏) 编辑 启⽤:某些原件本次测试不需要,右键禁⽤就可以,禁⽤后选项不起作⽤了 禁⽤: 运⾏: 远程启动:远程启动两台机器,多台机器,其他机器来跑也是可以的,脚本⾃⼰会同步的,不需要传,只要⾃⼰关联好 主机控制从机去运⾏(分布式) 参数化:怎么做,⽂件怎么放,放到那⾥去,复制⼏份,内容怎么分盘,放哪个⽬录,不同版本⽬录要求不⼀样 选项 ⼀些⽪肤外观或者语⾔的设置,放⼤缩⼩ 语⾔设置⽬前是临时设置,如果想永久⽣效需要修改jmeter.properties的37⾏,保持重启jmeter 下⾯还有⼀些分布式的设置也在jmeter.properties⾥,如下 Tools⼯具 创建html_report报告: 聚合报告的查看:聚合报告汇总的⼀个窗⼝信息 libei:请求的名称 样本:请求个数 平均值——最⼤值:响应时间,单位ms 异常:错误率 吞吐量TPS:单位时间内系统处理⽤户的请求数,单位时间,⽐如1个⼩时,系统让1w个⼈正常访问 接收: 发送: 12:jmeter⽣成html报告 ⼀:点击html_report ⼆:通过下⾯的页⾯使⽤csv⽂件⽣成报告 1:Results file:结果⽂件,两种格式,csv,grl都是数据⽂件,选择浏览,选中桌⾯的csv⽂件即可 2:user.preperfiles file:⽤户的属性⽂件,很多设置都在属性⽂件设置的,不同的属性⽂件代表jmeter配置不⼀样的 找到jmeter⽂件——>bin——>jmeter.properties 3:output directory:导出的html报告放在哪⾥,可以放在⼀个html_report的空⽬录去 4:generate report:点击⽣成报告,⽣成html页⾯,多少错误率,多少数据都能记录13:线程组,setup和teardown的区别 线程组:普通的线程组,正常运⾏的,初始化 setup:⽆论怎么放都是第⼀个运⾏的,与位置⽆关 teardown:⽆论怎么放都是最后与⼀个运⾏的,退出恢复的,环境清除14:jmeter性能测试脚本开发 ⼀:什么是jmeter脚本 俗称:⽤户操作被测软件系统某场景的动作流程 jmeter:⽤户操作被测软件系统某场景的请求 性能前功能肯定ok的,功能测试和性能测试最⼤的差别:功能⼀个⽤户就可以了,功能实现就ok了 性能测试需要n个⽤户,n个⽤户取决场景的需求,需要多少⽤户 ⽤户从1到n的区别 被测项⽬的性能测试,模拟⽤户量,并发数,不⽌⼀个⽤户,n个⽤户操作需要⼀个剧本, 脚本就是⽤户操作被测系统某些场景的动作流程,让⽤户⼲什么 jmeter操作的流程翻译成jmeter能识别执⾏的对应的脚本 性能测试脚本流程: 1:找到测试哪个场景, 2:场景如何去做,步骤 3:开发对应的脚本 脚本开发⼀开始都是⽤⼀个⽤户去跑,⼀个⽤户没有问题根据需求去并发n个⽤户去做性能测试,通了再说 ⼆:快速开发漂亮的脚本 准确:最基本要求,脚本可以正常运⾏,只是能通 快速:借助技术⼿动快速⾼效完成脚本开发 漂亮:脚本逻辑,维护性⾼ 整个性能测试重点是性能的监控分析调优 三:开发脚本⽅案 1:"代理"剑 最合适的脚本⽅案:⽂档+fiddler抓包,最快速靠谱的, 通过jmeter代理录制的,这个脚本的录制脚本很乱,都是需要调试的,⼯作量也很⼤ jmeter有个代理服务器的原件,抓包⼯具和⼯具⾃带的录制都是代理的 代理在pc和server中间加个中转站,通过代理转发http请求,请求和响应都会在代理服务器全部捕获到 fiddler和jmeter的代理录制的⽅式都是⼀模⼀样的,所有录制都是辅助脚本开发的,15:jmeter脚本的保存 保存之后就有对应的⼯程了, 2:创建线程组,脚本在线程组使⽤,录制的地⽅放在这个⾥⾯去的 3:设置⼀个代理,jmeter本⾝有代理的,点击⼀下右键增加⾮测试元件,选择http代理服务器 如下: ⽬标控制器就是脚本放在什么地⽅的:选择测试计划>线程组 global settings:代理服务器的端⼝号,浏览器访问的时候就需要经过这个代理了,pc浏览器也需要设置包经过代理 pc浏览器设置⼿动代理,让他去访问这个代理服务器,抓取对应数据,保存到脚本 浏览器设置代理服务器如下 127.0.0.1 8888 然后点击保存 浏览器设置了代理我们的web端现在是访问不了服务器的,因为jmeter的代理没开,需要点击启动打开⼀下 然后启动jmeter的代理服务器,代理就是jemert本⾝,点击⼀下上⾯图⽚的启动按钮,现在就可以进⾏抓包了 现在jmeter录制的脚本很粗糙,⾥⾯很多静态资源,图⽚的,js的,增加⼀个排除模模式 先过滤掉这四个,都是常⽤的,还有js也可以过滤 现在过滤⼀部分请求了可以少抓很多请求了,过滤,不过滤太⿇烦了 上⾯就是代理服务器的录制⽅法:两⼤步 1:浏览器代理的设置 2:jmeter代理的设置16:badboy录制脚本 现在很少⽤了,已经不更新了,也能录制脚本17:fiddler进⾏脚本录制(把抓包的会话转成jmx⽂件) fiddler原理:正向代理,打开fiddler⾃⼰打开代理,关闭的时候⾃⼰关闭代理 fiddler抓包后——>file——>export sessions——>all Sessions——>导出⼀个jmx⽂件 jmx⽂件直接拖到jmeter⾥⾯就⾏19:⽂档+fiddler开发脚本是最快的,实在不会写还可以借助录制的脚本对⽐⼀下,看录制本⾝怎么构建请求的 ⽂档为主还是必须的20:token脚本实战 任何脚本⾥⾯都需要创建⼀个线程组,线程组⾥有⽤户数, ⼀百个客户,五百个客户都是在线程数⾥⾯设置的,开发前期都选择⼀,搞通了再往下 ⼀:线程⾥⾯增加⼀个什么协议的,⽐如取样器选择对应的哪个就⾏了 如下 选择http请求,然后在页⾯修改⼀下接⼝名称,添加注释 然后⼀下基本信息按照接⼝⽂档填写:ip地址,端⼝号,请求⽅式,路径,编码(看请求,如果有中⽂加utf-8就可以了,没有就不要写)如下 接⼝名称,协议,ip、地址,端⼝号,⽅式,路径必须填写 参数:⼀般表单形式⽐较多,变量等于值这种类型 消息体数据:⼀般放json格式的,或者xml格式的,也可以放表单(a=1&c=2) ⽂件上传:⽂件上传的接⼝⾥⾯需要放到,⽐如⽂件路径,⽂件名称,⽂件格式 ⼆最后记得写⼀下请求头,很多时候默认版本不⼀样的,写⼀下: 名称:Content-Type 值:application/json 写在请求头⾥⾯ http请求头的添加需要配置原件:如下线 程组右击⿏标 找到http信息头管理器,整个jmeter有个很关键的东西:作⽤域: 消息头管理器放在整个线程组⾥⾯表⽰整个线程组所有请求都是共享它的, 所有如果不想在整个线程组⽣效,只是单个接⼝⽣效,把针对这个请求的请求头拖拽到get_token这个请求⾥⾯就⾏了 现在消息头管理器就到接⼝⾥⾯去了,作⽤域变了,只对这个请求有作⽤ 重点 操作如下: 基本请求和头写好了后,还需要⼀个监听的 如下: 三:增加监听器 添加查看结果树后点run⼀下,请求就成功了,很简单 现在就能成功看到响应结果,这个接⼝就完成了,单个接⼝ok 还可以切换格式查看请求结果 如果想把参数提取出来:输⼊ $.token test⼀下就可以了 把这个值复制给⼀个变量,以后所有的接⼝都可以使⽤这个变量了,token共享了,关联接⼝,其他接⼝都需要这个令牌直接使⽤这个变量,参数化来做, ⽤的时候把变量放到头⾥⾯,这样就⾏了 后续响应数据是json的不要⽤正则,$.token 这个更简单,错不了,很清晰(json提取器) 后续接⼝需要⽤到这个接⼝的token的,关联技术,获取token复制给变量就可以使⽤了, 增加⼀个后置处理器,json提取器21:性能测试规范流程 场景提取 脚本开发 场景设计 场景执⾏ 监控分析 调优 回归 22:jmeter主要元件的讲解 配置元件 监听器元件 其他常⽤元件 什么场景需要什么元件get到23:配置元件 config http请求默认值: http消息头管理器: http cookies管理器: http cache管理器:缓存 ⼀:请求默认值 1:保存⼀个测试计划:类似⼯程⼀样的东西,计划不要放在bin⾥⾯,千万谨记:如下保存,这是⼀个⼯程,保存完成之后是⼀个测试计划 2:有了测试计划后增加⼀个线程组,本⾝性能测试就是多组账户和⽤户的,并发数,线程数就代表⽤户数 本⾝jmeter是多线程的,Ld有个多线程模式 3:线程组增加好了之后增加⼀个请求叫 取样器,增加http请求 80:http默认端⼝ 8080:tomcat默认端⼝ 8888:⼀般是代理服务器⽤的端⼝号 443:https的默认端⼝ 4:填写http接⼝请求信息:参数和消息体数据和⽂件上传三个是互锁的,只能填写⼀个 参数填写表单,消息体数据写json,xml,表单都可以 5:使⽤查看结果树查看结果是否成功 监听器就是查看结果的,通过查看结果树的响应查看结果 前期调试使⽤⼀个线程组,脚本正确再考虑并发,脚本通了才⾏ 返回绿⾊的不代表成功,只是说明有返回,需要看请求和响应数据是不是正常 6:需要增加⼀个http——>配置元件——>http信息头管理器 这个元件是有作⽤域的,如果放在线程组下⾯会对线程组所有的请求都是共享的 如果只是单个接⼝是有拖到登录接⼝⾥⾯去,改变作⽤域 填写消息头是个表单形式 7:请求头还需添加cookie cookie是通过⼀个请求获取的, 登录接⼝第⼀次直接访问不得⾏的,需要前⾯加⼀个访问⾸页获取cookie的请求 访问⾸页接⼝可以获取cookie值。

jmeter:测试报告解析

jmeter:测试报告解析html报告主要分为两个部分:baseboard与charts⼀、Baseboard(基本报告情况)1、Test and Report information(测试报告与信息)2、(应⽤性能信息)3、Statistics(统计)4、Error(请求异常)⼆、Charts(详细报告)Over time(每时运⾏时信息):1、response time over time(响应时长):2、Response Time Percentiles Over Time (successful responses)(90%、95%、99%线程在各个时间段的响应时间):跟聚合报告⾥⾯的90、95、99%差不多3、Active threads over time(各个线程每时运⾏情况):线程多的时候看⽐较有意义4、bytes throughout over time(每时接收与发送字节的情况)5、latencies over time(每时请求的延迟时长):如图⼀开始延迟很⾼,后⾯有所下降6、connect time over time(每时连接需要的时长):如图⼀开始请求并发⾼,连接需要的时间很⾼1、hits per second(每时发起的请求数)2、codes per second(各个code每时响应数量)3、teansactions per second(每时事物响应数⽬)4、total transations per second(总每时事务请求曲线)5、response time vs request(每时各个请求响应类型的平均响应时间)6、latency vs request(各个请求类型的每时延迟时间)Response time(响应时间)1、Response time percentiles(响应时间百分⽐分布)2、response time overview(响应时间条状对⽐图)3、time vs threads(各个线程平均响应时间,实际中看运⾏拐点来定为性能瓶颈的参考值)4、response time distribution(测试过程中多少线程数占响应时间⽐例图)三、设定取样间隔时间:在上⾯的测试中,采⽤的是默认取样时长“⼀分钟”,总共运⾏了5分钟;设置取样间隔时间在jmeter/bin/user.properties⽂件中,搜索字段:granularity,修改后⾯的值:⼀秒的设置为:jmeter.reportgenerator.overall_granularity=1000如图:需要拉⼤才看得到。

Jmeter性能测试报告导出

Jmeter性能测试报告导出⼀、环境搭建1、Java JDK (版本最好在1.6或者1.6以上)2、ANT 安装下载地址:3、JMeter 安装下载地址:4、JMeter ⽂件配置1>、JMeter 下的extras ⽬录下的ant-jmeter-1.1.1.jar ⽂件拷贝到 ANT 安装⽬录下的lib ⽬录中2>、修改 JMeter 下 bin ⽬录中的jmeter.properties 配置⽂件jmeter.save.saveservice.output_format=csv 保持不变⼆、创建Jmeter 脚本三、jtl 性能测试报告转换直接⼀⾏命令将 jmx ⽂件转换为 jtl ⽂件,然后再转换为图⽂报告,如图:最终会⽣成如下图表报告命令⾏模式将 jtl 转成测试图表-注意此⽅法只使⽤jmeter3.0以后版本第⼀种:在测试过程中将jtl转成测试报告(在jmeter的bin⽬录下执⾏)命令:./jmeter -n -t baidu_requests_results.jmx -r -l baidu_requests_results.jtl -e -o /home/tester/apache-jmeter-3.0/resultReport 参数说明:-n : ⾮GUI 模式执⾏JMeter-t : 执⾏测试⽂件所在的位置及⽂件名-r : 远程将所有agent启动⽤在分布式测试场景下,不是分布式测试只是单点就不需要-r-l : 指定⽣成测试结果的保存⽂件, jtl ⽂件格式-e : 测试结束后,⽣成测试报告-o : 指定测试报告的存放位置-o 指定的⽂件及⽂件夹,必须不存在,否则执⾏会失败,对应上⾯的命令就是resultReport⽂件夹必须不存在否则报错。

JMeter测试结果图分析

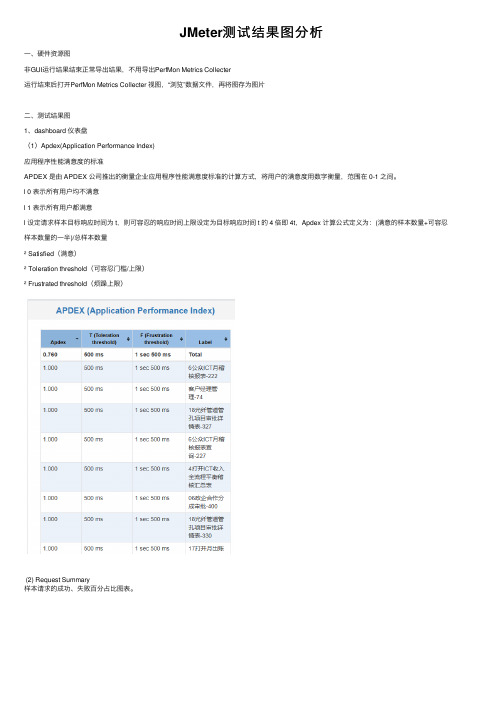

JMeter测试结果图分析⼀、硬件资源图⾮GUI运⾏结果结束正常导出结果,不⽤导出PerfMon Metrics Collecter运⾏结束后打开PerfMon Metrics Collecter 视图,“浏览”数据⽂件,再将图存为图⽚⼆、测试结果图1、dashboard 仪表盘(1)Apdex(Application Performance Index)应⽤程序性能满意度的标准APDEX 是由 APDEX 公司推出的衡量企业应⽤程序性能满意度标准的计算⽅式,将⽤户的满意度⽤数字衡量,范围在 0-1 之间。

l 0 表⽰所有⽤户均不满意l 1 表⽰所有⽤户都满意l 设定请求样本⽬标响应时间为 t,则可容忍的响应时间上限设定为⽬标响应时间 t 的 4 倍即 4t,Apdex 计算公式定义为:(满意的样本数量+可容忍样本数量的⼀半)/总样本数量² Satisfied(满意)² Toleration threshold(可容忍门槛/上限)² Frustrated threshold(烦躁上限)(2) Request Summary样本请求的成功、失败百分占⽐图表。

(3)Statistics此部分结果展⽰的是每个样本事务的⼀些常见的性能测试指标,跟我们通常看到的聚合报告的表格展⽰⾮常相近,多了成功与失败的占⽐。

(4)Errors执⾏结果的错误情况,根据不同的错误类型进⾏展⽰。

四列分别对应:发⽣错误的类型、错误数量、类型错误占⽐(相对于错误总数)、类型错误样本占⽐(相对于所有的请求样本数量)。

2、Charts(1)Over Time² Response Times Over Time随时间推移,样本请求响应时间的变化。

² Bytes Throughput Over Time随时间推移,⽹络数据传输(发送、接收,单位:字节)速率的变化。

² Latencies Over Time随时间推移,请求样本延迟响应的变化。

jemeter性能测试报告

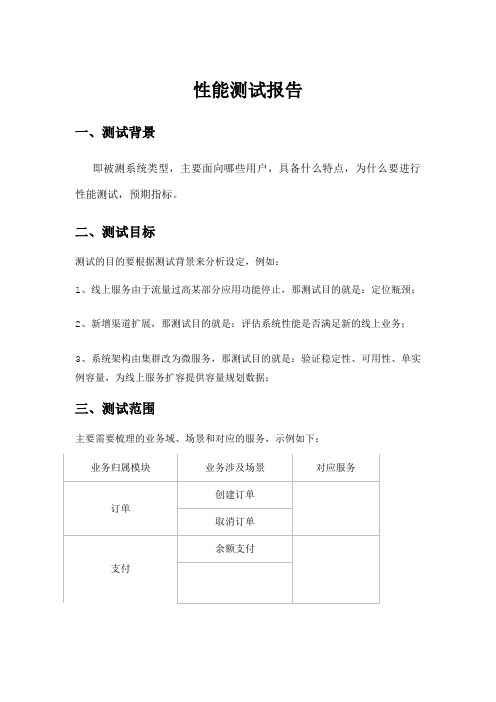

性能测试报告一、测试背景即被测系统类型,主要面向哪些用户,具备什么特点,为什么要进行性能测试,预期指标。

二、测试目标测试的目的要根据测试背景来分析设定,例如:1、线上服务由于流量过高某部分应用功能停止,那测试目的就是:定位瓶颈;2、新增渠道扩展,那测试目的就是:评估系统性能是否满足新的线上业务;3、系统架构由集群改为微服务,那测试目的就是:验证稳定性、可用性、单实例容量,为线上服务扩容提供容量规划数据;三、测试范围主要需要梳理的业务域、场景和对应的服务,示例如下:四、预期指标预期指标主要包含如下:应用系统方面性能指标:主要有TPS、RT、请求成功率(一般默认请求成功率≥99.99%);硬件系统方面性能指标:主要有CPU使用率、Memory使用率、系统IO、网络IO等。

五、测试准备压测工具:jmeter网络:内网测试服务器资源监控:nmon六、测试安排及人员岗位安排七、测试过程一、linux压测1、服务及测试数据准备。

2、启动nmon监控服务。

3、在windows上调试好测试脚本通过FTP传到linux压测机上。

4、安装配置好JAVA、jmeter环境5、启用命令jmeter -n -t test.jmx -l res.jtl -e -o /result6、脚本运行结束后,使用命令结束nmon监控,并把result和nmon的监控文件传到windows电脑。

用于分析测试结果。

二、分布式压测如果并发量过大,必须要用分布式压测。

压测机设置:第一步:禁用ssl到slave Jmeter的jmeter.properties文件中修改server.rmi.ssl.disable=true第二步:修改slave Jmeter的远程连接端口server_port=8899 表示master机器要远程连接的端口第三步:启动slave Jmeter./jmeter-server./jmeter-server -Djava.rmi.server.hostname=192.168.179.128第四步:关闭防火墙service iptables stop控制机设置:关闭防火墙service iptables stop到slave Jmeter的jmeter.properties文件中修改server.rmi.ssl.disable=true修改remote_hosts=127.0.0.1为remote_hosts=192.168.179.128:9999八、结果分析在windows打开result文件内的html测试结果,使用nonm的专用工具打开监测服务器的文件,两者结合分析。

jmeter测试报告

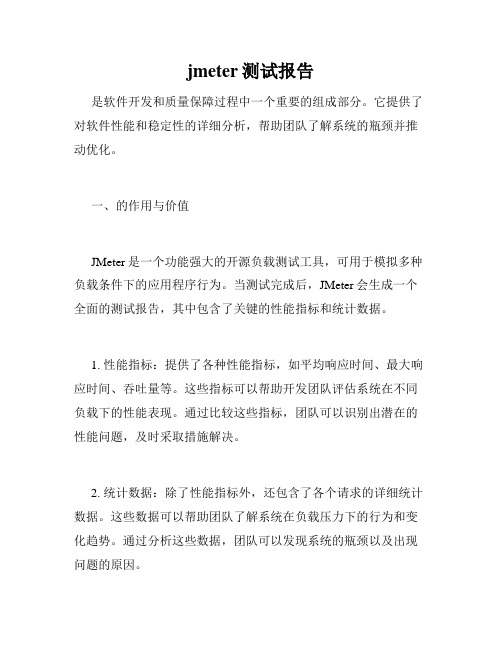

jmeter测试报告是软件开发和质量保障过程中一个重要的组成部分。

它提供了对软件性能和稳定性的详细分析,帮助团队了解系统的瓶颈并推动优化。

一、的作用与价值JMeter是一个功能强大的开源负载测试工具,可用于模拟多种负载条件下的应用程序行为。

当测试完成后,JMeter会生成一个全面的测试报告,其中包含了关键的性能指标和统计数据。

1. 性能指标:提供了各种性能指标,如平均响应时间、最大响应时间、吞吐量等。

这些指标可以帮助开发团队评估系统在不同负载下的性能表现。

通过比较这些指标,团队可以识别出潜在的性能问题,及时采取措施解决。

2. 统计数据:除了性能指标外,还包含了各个请求的详细统计数据。

这些数据可以帮助团队了解系统在负载压力下的行为和变化趋势。

通过分析这些数据,团队可以发现系统的瓶颈以及出现问题的原因。

3. 报表和图表:以直观的方式展示了测试结果,通常采用图表和表格的形式呈现。

这使得团队可以更加直观地理解测试结果,快速发现系统存在的问题。

报表和图表也有助于与利益相关者共享测试结果,促进沟通和决策。

二、的关键内容包含了丰富的内容,但以下几个关键部分尤为重要。

1. 概览信息:测试报告的概览信息提供了对整个测试过程的总体了解。

它可以包括测试日期、持续时间、总请求数、错误率等。

通过概览信息,团队可以快速了解系统的整体性能。

2. 性能指标和趋势图:测试报告中的性能指标和趋势图展示了系统在负载压力下的性能表现与趋势。

这些指标可以帮助团队识别系统的瓶颈,并跟踪性能问题的变化。

常见的图表包括响应时间分布图、吞吐量趋势图、错误率趋势图等。

3. 请求详情和分析:提供了对每个请求的详细分析。

对于每个请求,报告会给出其相关的统计数据、响应时间分布、错误信息等。

这使得团队可以深入了解各个请求的性能特征和问题点,进一步优化系统性能。

4. 错误分析:测试报告中的错误分析部分列出了出现错误的请求及其相关信息。

对于每个错误,报告会给出错误类型、错误数量、错误率等。

jmeter测试报告

jmeter测试报告JMeter是一个用于性能测试和负载测试的开源工具。

它可以模拟多种不同类型的测试场景,帮助开发人员和测试人员识别和解决性能问题。

在进行JMeter测试后,会生成一个测试报告,该报告包含了测试中收集到的数据和指标。

这些数据和指标可以帮助我们评估系统在不同负载下的性能,并找出潜在的瓶颈。

Jmeter测试报告通常包括以下几个关键部分:1. 概述:报告的第一部分通常是一个概述,它提供了整体测试结果的摘要。

概述包括测试日期和时间,测试运行的持续时间,以及执行的线程数。

通过这些信息,我们可以得出对测试结果的初步了解。

2. 性能指标:报告中的性能指标部分显示了在不同负载下的系统性能。

这些指标包括响应时间、吞吐量和并发用户数等。

通过分析这些指标,我们可以了解系统在不同负载下的行为,并找出潜在的性能问题。

3. 错误和异常:这部分报告显示了在测试过程中发生的错误和异常。

这些错误可以是HTTP错误代码(如404、500等),也可以是由于资源不足或超时引起的错误。

通过分析这些错误,我们可以找出系统中存在的问题,并采取相应的措施加以解决。

4. 图表和图形:报告中的图表和图形可视化了测试结果。

这些图表可以帮助我们更直观地了解系统在不同负载下的性能,并发现系统中可能存在的性能瓶颈。

5. 结论和建议:最后部分的报告通常是一个结论和建议的总结。

根据测试结果,我们可以得出对系统性能的评估,并提出相应的建议。

这些建议可以是优化系统配置、增加硬件资源、重新编写代码等。

总而言之,JMeter测试报告为我们提供了一个全面的性能测试结果和分析。

通过仔细分析报告,我们可以找出系统中的性能问题,并采取相应的措施加以解决,从而提高系统的性能和稳定性。

jmeter测试报告

jmeter测试报告JMeter(Java应用程序性能测试工具)是一款功能强大且广泛使用的自动化测试工具,用于在应用程序生命周期中测量和评估软件质量以及性能。

由于它的灵活性和可扩展性,它是许多软件开发人员和测试人员首选的自动化性能测试工具。

一般来说,JMeter使用者需要使用JMeter测试报告来分析测试结果和进行性能测试。

JMeter测试报告是一份完整的报告,详细描述了测试方案,包括性能和负载测试的结果。

在这篇文章中,我们将深入探讨JMeter测试报告的各个方面,以帮助您提高您的软件测试技能。

首先,JMeter测试报告主要分为两部分:图表和表格。

图表可以用来比较性能数据和易读性,表格可以提供有关测试运行的更详细的信息。

其中,你会看到JMeter测试报告中最常见的图表为折线图、柱状图、双Y轴图和饼图。

而表格方面则按照请求和线程组的名称显示了所有的测试结果,包括平均响应时间、标准偏差、通过率、错误率及其它数据和统计信息。

表格数据适合在整个测试过程中跟踪单个请求或线程组的行为,并提供可读性较强和非常详细的信息。

此外,JMeter测试报告还可以通过配置缩放表和自定义报告来满足不同用户的需求。

其次,在任何测试分析中,对性能数据的解释和评估是非常重要的。

测试人员需要深入了解性能数据的各方面,并确定需要进行更深入的分析和解决方案。

首先,测试人员需要识别JMeter测试结果报告中性能数据的错误率。

如果错误率非常低,而性能数据正常,则测试人员可以探索进一步测试来确保测试结果的正确性。

如果发现错误率比较高,则可能需要对测试方案进行更改,或者进行更深入的分析。

其次,在评估性能数据时,测试人员需要考虑总体平均响应时间。

一般来说,平均响应时间越短,性能越高,反之则越低。

然而,如果平均响应时间太短,则可能表示测试数据量太小或者系统处理能力太高。

因此,性能测试专家需要深入分析平均响应时间的具体数据,包括响应时间分布、响应时间曲线和其他相关性能数据,以更好地了解系统的运行状态。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

快乐农家网站压力测试报告

一、测试简介

1、测试环境:

测试人:***

测试时间:2010年9月13日

服务器 IP :客户端内存:(R)4

测试工具:测试内容:

二、测试说明

1、名词定义(时间的单位均为ms):

Samples -- 本次场景中一共完成了多少个线程

Average -- 平均响应时间

Median -- 统计意义上面的响应时间的中值

90% Line -- 所有线程中 90%的线程的响应时间都小于 xx

Min -- 最小响应时间

Max -- 最大响应时间

Error -- 出错率

Troughput -- 吞吐量

KB/sec -- 以流量做衡量的吞吐量

2、安装启动JMeter ,分别对以上页面进行压力测试

分别测试10、100、500、1000 个线程,即模拟这些数目的用户并发;每个用户循环发送请求 1; Ramp-up period ( inseconds )的值设为0,即并发请求。

三、测试结果及分析

1、首页测试结果及分析:

Label#Samples Average Median90%Line Min Max Error% Throughput KB/sec

首页10 53 52 73 39 73 % sec

首页100 31 26 66 10 83 % sec

首页500 76 32 196 9 661 % sec

首页1000 36 22 69 9 345 % sec

分析: #Samples: 模拟 1000 个用户时的压力测试,Average :平均响应时间为秒,90%Line:

百分之90 的用户相应时间为秒,Error% : 没有无法相应的请求。

2、社区论坛测试结果及分析:

Label#Samples Average Median90%Line Min Max Error% Throughput KB/sec

社区论坛10 53 52 73 39 73 % sec

社区论坛100 10279 9748 14997 528 15505 % sec

社区论坛500 28048 22277 79473 9 82674 % sec

社区论坛1000 17988 2509 71178 9 86822 % sec 分析:#Samples: 模拟 500 个用户时的压力测试,tomcat 已经明显看到响应慢了,Average :

平均响应时间为秒,90%Line:百分之90 的用户相应时间为秒,Error% :百分之40的请求无法响应。

模拟1000 个用户时,出现的无法响应的概率:%。

3、专家与咨询测试结果及分析

Label#Samples Average Median90%Line Min Max Error% Throughp KB/sec

ut

专家与10 6252 7213 8227 1590 8227 %

sec

咨询

专家与38 20298 20104 21247 1986 2157 % sec

咨询8 4

分析:#Samples: 模拟100 个用户时的压力测试,tomcat 无法响应,不能完成。

模拟38 个

用户时Average :平均响应时间为秒,90%Line:百分之90 的用户相应时间为秒,Error% :

百分之90 的请求无法响应。

4、知识培训测试结果及分析

Label #Samples Average Median 90%Line Min Max Error% ThroughpKB/sec

ut

知识培10 590 612 789 278 789 % sec

训

知识培100 6440 6127 10078 1077 11684 % sec

训

知识培500 13116 14453 30437 13 34437 % sec

训

知识培1000 9360 142 32116 16 40311 % sec

训

分析:#Samples: 模拟 500 个用户时的压力测试,tomcat 已经明显看到响应慢了,Average :平均响应时间为秒,90%Line:百分之90 的用户相应时间为秒,Error% : 百分之40 的请

求无法响应。

模拟1000 个用户时,出现的无法响应的概率:%。