Ch5-Linear Regression

python linearregression参数

python linearregression参数Python Linear Regression参数Linear Regression(线性回归)是一种常用的机器学习算法,用于建立自变量和因变量之间的线性关系模型。

在Python中,有多种方法可以实现线性回归,比如使用NumPy库的linalg方法或使用Scikit-learn库的LinearRegression类。

本文将介绍Python中线性回归的参数及其相关用法。

1. 线性回归参数在进行线性回归时,有几个重要的参数需要考虑:1.1 自变量与因变量自变量是用于建立模型的特征或属性,通常用矩阵X表示。

因变量是要预测或估计的目标,通常用向量y表示。

在进行线性回归时,需要明确自变量和因变量的关系。

1.2 截距(intercept)截距是线性回归模型的常数项,表示在自变量取值为零时的因变量值。

截距可以用参数b0表示,用于调整直线的位置。

1.3 斜率(slope)斜率是线性回归模型的系数项,表示自变量与因变量之间的变化率。

斜率可以用参数b1表示,用于调整直线的斜率。

1.4 残差(residual)残差是指实际观测值与回归模型预测值之间的差异。

残差可以用来评估模型的拟合程度,通常使用最小二乘法来最小化残差的平方和。

2. 使用NumPy进行线性回归NumPy是Python中常用的科学计算库,其中的linalg模块提供了线性代数运算功能。

可以使用该模块中的函数来进行线性回归。

2.1 数据准备首先,需要准备自变量X和因变量y的数据,通常可以使用NumPy的数组或矩阵来表示。

假设我们有以下样本数据:```pythonimport numpy as npX = np.array([1, 2, 3, 4, 5])y = np.array([2, 4, 6, 8, 10])```2.2 构建模型使用linalg模块中的函数进行线性回归模型的构建。

下面是构建模型的代码:```pythonfrom numpy.linalg import lstsq# 添加截距项X_with_intercept = np.vstack([X, np.ones(len(X))]).T# 使用最小二乘法进行线性回归params, residuals, rank, singular_values = lstsq(X_with_intercept, y)```2.3 参数解释上述代码中,通过添加截距项将自变量矩阵X变为X_with_intercept。

python logistic regression参数

逻辑回归(Logistic Regression)是一种用于分类问题的线性模型。

在Python 中,我们可以使用scikit-learn 库实现逻辑回归。

以下是逻辑回归的一些关键参数:1. `penalty`:惩罚系数,用于控制权重矩阵的规模。

惩罚系数为正时,称为L1 正则化(Lasso),会压缩权重向量;惩罚系数为负时,称为L2 正则化(Ridge),会放大权重向量。

默认值为`'l2'`。

2. `C`:正则化参数,用于控制惩罚力度。

较大的C 值会导致更严格的正则化,权重更新的幅度较小;较小的C 值会导致较宽松的正则化,权重更新的幅度较大。

默认值为1.0。

3. `tol`:梯度下降的收敛阈值。

当梯度下降的收敛速度低于此阈值时,算法停止迭代。

默认值为1e-4。

4. `max_iter`:最大迭代次数。

达到最大迭代次数后,算法停止迭代。

默认值为1000。

5. `solver`:指定优化算法。

可选值包括:- 'liblinear':当数据量较大时,使用高效的大规模线性分类器。

- 'sag':随机梯度下降算法,适用于大规模数据。

- 'lbfgs':有限记忆拟牛顿法,适用于小规模数据。

- 'newton-cg':牛顿法,适用于中小规模数据。

默认值为'liblinear'。

6. `intercept`:是否在特征向量前加上截距项。

默认值为`True`。

7. `random_state`:随机种子,用于控制训练过程中的随机性。

默认值为None。

8. `verbose`:控制输出的详细程度。

默认值为`False`。

9. `warm_start`:是否使用预热启动。

当设置为`True`时,算法会从上次训练的权重出发进行迭代。

默认值为`False`。

10. `input_shape`:输入特征的形状。

默认值为(None, 1)。

linearregression 参数

在Python的Scikit-learn库中,LinearRegression模型的参数主要包括:1. `fit_intercept`:一个布尔值,决定是否拟合截距。

默认值为True。

2. `normalize`:一个布尔值,决定是否对输入数据进行标准化处理。

默认值为False。

3. `copy_X`:一个布尔值,决定是否在训练过程中复制数据。

默认值为True。

4. `n_jobs`:一个整数,表示用于拟合的并行处理器数。

默认值为None,这意味着使用CPU的数量。

5. `positive`:一个布尔值,如果为True,则强制权重为正。

默认值为False。

6. `precompute`:'auto', True or False, 数组或 callable. 如果为 'auto',那么在前向-后向双扩散(动量)和/或随机梯度下降(随机)时使用适合的计算方法。

如果为True,那么使用前向-后向双扩散(动量)。

如果为 False,那么不使用预计算,并且只能使用随机梯度下降(随机)。

如果是一个可调用的对象,那么该对象应该接收参数 X,y 并返回一个形状 (n_features, n_features) 的矩阵,用于计算矩阵的乘积。

7. `solver`:'newton-cg', 'lbfgs', 'sag', 'saga' or 'trust-krylov'. 用于优化线性回归模型的损失函数的优化算法。

8. `penalty`:'l2' or 'none'. 在优化线性回归模型的损失函数时应用的惩罚项的类型。

9. `max_iter`:int, the maximum number of iterations. 最大迭代次数。

10. `tol`:float, tolerance for the stopping criterion. 容忍度,用于判断是否满足停止条件。

introduction to linear algebra 5th edition 中译 -回复

introduction to linear algebra 5th edition 中译-回复"Introduction to Linear Algebra 5th Edition 中译"主题文章第一步:介绍《Linear Algebra 5th Edition 中译》及其重要性《Linear Algebra 5th Edition 中译》是一本介绍线性代数的教材。

线性代数是数学中的一个重要分支,涉及向量空间、线性方程组、特征值和特征向量等概念。

这些概念在数学、物理学、计算机科学、经济学和工程学等领域都有广泛应用。

本书旨在为读者提供系统、全面且易于理解的线性代数基础知识,帮助读者建立起与今后的学习和研究相结合的数学基础。

此次中文翻译对于那些使用中文学习的学生和研究者,特别是那些需要掌握线性代数以支持他们的学术和职业发展的人来说,具有重要意义。

第二步:介绍线性代数的基本概念和应用线性代数是一门研究线性映射和向量空间的学科。

它涉及将线性方程组转化为矩阵,解决线性方程组的问题,以及在现实世界中描述和解决各种问题的能力。

线性代数也是许多其他学科的基础,例如机器学习、图像处理和优化问题。

通过学习线性代数,读者可以理解向量、矩阵、空间、线性变换、特征值和特征向量等概念,培养抽象思维、推理能力和解决实际问题的能力。

第三步:介绍《Linear Algebra 5th Edition》的特点和优势《Linear Algebra 5th Edition 中译》具有以下特点和优势:1.系统全面:本书从基本概念开始介绍线性代数,逐步展开。

读者可以完整地掌握线性代数的核心概念和理论。

2.易于理解:作者使用简洁明了的语言和示例,帮助读者深入理解抽象的线性代数概念。

此外,作者还提供了大量的习题和解答,以巩固和测试理解。

3.应用广泛:本书覆盖了线性代数的许多应用领域,如物理学、计算机科学和经济学。

读者可以从实际问题出发,将所学的线性代数知识应用到实际中。

Python机器学习LinearRegression(线性回归模型)(附源码)

Python 机器学习LinearRegression (线性回归模型)(附源码)LinearRegression (线性回归)1.线性回归简介线性回归定义:我个⼈的理解就是:线性回归算法就是⼀个使⽤线性函数作为模型框架(y =w ∗x +b )、并通过优化算法对训练数据进⾏训练、最终得出最优(全局最优解或局部最优)参数的过程。

y :我们需要预测的数值;w :模型的参数(即我们需要通过训练调整的的值)x :已知的特征值b :模型的偏移量我们的⽬的是通过已知的x 和y ,通过训练找出合适的参数w 和b 来模拟x 与y 之间的关系,并最终通过x 来预测y 。

分类: 线性回归属于监督学习中的回归算法; 线性回归作为机器学习的⼊门级算法,很适合刚接触机器学习的新⼿。

虽然线性回归本⾝⽐较简单,但是⿇雀虽⼩,五脏俱全,其中涉及到的“线性模型”、“⽬标函数”、“梯度下降”、“迭代”、“评价准则”等思想与其他复杂的机器学习算法是相通的,深⼊理解线性回归后可以帮助你更加轻松的学习其他机器学习算法。

2.线性回归模型解析2.1线性回归模型⽰意图2.2模型的组成部件 2.2.1 假设函数(Hypothesis function ) h w (x )=b +w 0x 0+w 1x 1+···+w n x n 使⽤向量⽅式表⽰:X = x 0x 1⋮x n ,W =w 0w 1⋮w n 则有:h w (x )=W T X +b [][] 2.2.2 损失函数:(Cost function) 这⾥使⽤平⽅差作为模型的代价函数 J(w)=12m∑mi=1(h w(x(i))−y(i))2 2.2.3 ⽬标函数:(Goal function) minimize(J(w)) 2.2.4 优化算法:(optimization algorithm) 梯度下降法(Gradient descent) 关于梯度下降法这⾥不详细介绍;3.使⽤python实现线性回归算法1#-*- coding: utf-8 -*-2import numpy as np3from matplotlib import pyplot as plt456#⽣成训练使⽤数据;这⾥线性函数为 y = 1.5*x + 1.37def data_generate():8#随机⽣成100个数据9 x = np.random.randn(100)10 theta = 0.5 #误差系数11#为数据添加⼲扰12 y = 1.5*x + 1.3 + theta*np.random.randn(100)13return x,y1415class LinearRegression():16'''17线性回归类18参数:19 alpha:迭代步长20 n_iter:迭代次数21使⽤⽰例:22 lr = LinearRegression() #实例化类23 lr.fit(X_train,y_train) #训练模型24 y_predict = lr.predict(X_test) #预测训练数据25 lr.plotFigure()⽤于画出样本散点图与预测模型26'''27def__init__(self,alpha=0.02,n_iter=1000):28 self._alpha = alpha #步长29 self._n_iter = n_iter #最⼤迭代次数3031#初始化模型参数32def initialPara(self):33#初始化w,b均为034return 0,03536#训练模型37def fit(self,X_train,y_train):38#保存原始数据39 self.X_source = X_train.copy()40 self.y_source = y_train.copy()4142#获取训练样本个数43 sample_num = X_train.shape[0]44# 初始化w,w045 self._w, self._b = self.initialPara()4647#创建列表存放每次每次迭代后的损失值48 self.cost = []4950#开始训练迭代51for _ in range(self._n_iter):52 y_predict = self.predict(X_train)53 y_bias = y_train - y_predict54 self.cost.append(np.dot(y_bias,y_bias)/(2 * sample_num))55 self._w += self._alpha * np.dot(X_train.T,y_bias)/sample_num56 self._b += self._alpha * np.sum(y_bias)/sample_num5758def predict(self,X_test):59return self._w * X_test + self._b6061#画出样本散点图以及使⽤模型预测的线条62def plotFigure(self):63#样本散点图64 plt.scatter(self.X_source,self.y_source,c='r',label="samples",linewidths=0.4) 6566#模型预测图67 x1_min = self.X_source.min()68 x1_max = self.X_source.max()69 X_predict = np.arange(x1_min,x1_max,step=0.01)70 plt.legend(loc='upper left')7172 plt.plot(X_predict,self._w*X_predict+self._b)73 plt.show()7475if__name__ == '__main__':76#创建训练数据77 x_data,y_data = data_generate()7879#使⽤线性回归类⽣成模型80 lr = LinearRegression()81 lr.fit(x_data,y_data)8283#打印出参数84print(lr._w,lr._b)85#画出损失值随迭代次数的变化图86 plt.plot(lr.cost)87 plt.show()88#画出样本散点图以及模型的预测图89 lr.plotFigure()9091#预测x92 x = np.array([3])93print("The input x is{0},then the predict of y is:{1}".format(x,lr.predict(x)))线性回归代码更多线性回归的代码参考github:Processing math: 100%。

introduction to linear algebra 5th edition 中译 -回复

introduction to linear algebra 5th edition 中译-回复[introduction to linear algebra 5th edition 中译]的主题:线性代数入门文章长度:1500-2000字第一步:了解线性代数的定义和重要性在数学中,线性代数是研究向量空间和线性映射的分支。

它研究线性方程组、向量空间的结构和变换,是数学中一个重要的分支领域。

线性代数在许多数学和科学领域的应用非常广泛,如工程学、物理学、经济学等。

[introduction to linear algebra 5th edition中译]提供了深入了解线性代数的基础。

第二步:概述[introduction to linear algebra 5th edition 中译] 的内容[introduction to linear algebra 5th edition 中译]主要介绍了线性代数中的基本概念和理论,以及其在实际问题中的应用。

书中包含了向量、矩阵、线性变换、特征值与特征向量等重要内容。

第三步:深入探讨书中主要概念和理论1. 向量:向量是线性代数中的基本对象,它可以用来表示在空间中的方向和大小。

向量可以进行加法和数乘操作,同时还有一些特殊的向量,如零向量和单位向量。

2. 矩阵:矩阵是线性代数中的另一个重要概念,它是由一个或多个向量组成的矩形数组。

矩阵可以用来表示线性变换、解线性方程组等问题。

矩阵的乘法和转置操作是线性代数中常用的操作。

3. 线性变换:线性变换是将一个向量空间映射为另一个向量空间的变换。

线性变换具有保持加法和数乘运算的特性,可以用矩阵来表示。

线性变换在图像处理、信号处理等领域有广泛应用。

4. 特征值与特征向量:特征值与特征向量是描述线性变换的重要概念。

特征值代表了线性变换对应的变换方向,而特征向量代表了这个方向上的变换量。

特征值与特征向量在物理学和计算机图形学中有广泛应用。

introduction to linear algebra 5th edition 中译 -回复

introduction to linear algebra 5th edition 中译-回复题目: 《[线性代数引论第五版中译]》:理解线性代数的步骤和关键概念引言:线性代数作为数学的一个重要分支,研究了向量空间和线性映射的性质与结构,是解决各种数学和工程问题的基础。

而在学习线性代数的过程中,作为一本经典教材,《线性代数引论第五版中译》提供了详尽和深入的内容,对于初学者来说,理解其中的步骤和关键概念是非常重要的。

本文将一步一步回答关于该教材的一些常见问题,帮助读者更好地掌握线性代数。

第一步:了解线性代数的基本定义和概念(Introduction)在学习《线性代数引论第五版中译》之前,首先需要了解线性代数的基本定义和概念。

线性代数主要研究向量、矩阵和线性变换等概念。

向量是线性代数中的基本元素,它可以表示方向和大小。

矩阵是由数构成的矩形阵列,用于表示线性映射和线性方程组等。

线性变换是指一个向量空间到另一个向量空间的映射,保持向量间的线性关系。

第二步:掌握向量空间的概念和性质(Chapter 1)向量空间是线性代数中最重要的概念之一,它是由一组满足一定条件的向量所构成的集合。

在学习第一章时,需要掌握向量空间的定义、线性组合、线性相关性和线性无关性等重要概念。

了解这些基本概念,可以帮助我们理解向量空间的性质和操作。

第三步:理解线性变换和矩阵的关系(Chapter 2)线性变换和矩阵是线性代数中核心的概念。

一个线性变换可以由一个矩阵来表示,而一个矩阵也可以表示一个线性变换。

在第二章,我们需要理解线性变换和矩阵之间的关系,掌握线性变换的定义、线性变换的运算和性质,以及矩阵的乘法和逆矩阵等重要概念。

第四步:解析线性方程组和矩阵的特征值和特征向量(Chapter 3)线性方程组是线性代数中的一个重要应用。

在第三章,我们需要学习如何解析线性方程组,理解矩阵的秩、行列式和逆矩阵的相关概念。

此外,还需要掌握矩阵的特征值和特征向量的概念,这对于分析和处理线性变换的性质和行为非常重要。

scipy linearoperator例子-概述说明以及解释

scipy linearoperator例子-概述说明以及解释1.引言1.1 概述LinearOperator是Scipy库中的一个重要模块,它提供了一种简洁而灵活的处理线性算子的方法。

线性算子是指具有线性性质的运算,可以将向量映射到另一个向量空间中。

LinearOperator模块通过定义一种抽象的线性算子类,使得用户能够以一种统一的方式去处理不同类型的线性算子。

与传统的线性代数计算相比,LinearOperator提供了更高效、更灵活的方式来处理大规模的线性问题。

它通过将线性算子抽象为一个矩阵-向量乘法操作,使得在处理大规模数据时能够节省存储空间和计算时间。

LinearOperator的一个重要特点是它支持延迟计算,即只在需要的时候才进行实际的计算操作。

这种延迟计算的特性使得在处理大规模数据时能够节省计算资源,并且能够轻松地与其他Scipy模块进行集成。

此外,LinearOperator还提供了一系列常见的线性算子变换和组合操作,如共轭、转置、相乘等。

这些操作使得用户能够方便地构建复杂的线性算子,并能够灵活地适应不同的应用场景。

在本文中,我们将介绍LinearOperator的基本概念和作用,以及它在科学计算、信号处理、优化等领域中的常见应用。

我们将通过一些具体的例子来展示LinearOperator的用法,并讨论它的优势和局限性。

最后,我们将展望LinearOperator的未来发展,探讨它在大数据时代的应用前景。

通过阅读本文,读者将能够全面了解LinearOperator的概念、用法和意义,并能够灵活地运用它来解决实际问题。

1.2 文章结构本文将围绕Scipy的LinearOperator模块展开讨论,旨在介绍LinearOperator的基本概念、作用以及常见的用法和应用场景。

文章结构主要分为引言、正文和结论三个部分。

引言部分将概述本文的主题内容,即介绍Scipy的LinearOperator 模块,并说明本文的目的。

五点线性拟合去差值五点线性平滑算法原理

五点线性拟合去差值五点线性平滑算法原理具体实现步骤如下:1.首先选择五个离散数据点,这五个点应该包含需要进行平滑的数据点以及其邻近的四个数据点。

2.将这五个数据点中间的数据点视为待拟合的数据点,而其它四个数据点为拟合的支持点。

3.使用线性拟合的方法,通过在支持点中构造一条最小二乘拟合直线来估算待拟合数据点的值。

最小二乘法线性拟合的目标是使得待拟合数据点到拟合直线的距离的平方和最小。

4.将估算得到的值作为平滑后的数据点,并逐步向后滑动,以平滑整个数据序列。

五点线性平滑算法原理:五点线性平滑算法是一种对离散数据进行平滑处理的方法。

它通过对相邻的五个数据点进行线性加权平均,来得到平滑后的数据点。

具体实现步骤如下:1.首先选择五个离散数据点,这五个点应该包含需要进行平滑的数据点以及其邻近的四个数据点。

2.对这五个数据点进行线性加权平均处理,即将每个数据点乘以对应的权重,并将结果相加。

这里的权重通常是按照一个预定义的模式进行分配的,例如1-2-3-2-1或1-4-6-4-1等。

3.将加权平均后得到的结果作为平滑后的数据点,并逐步向后滑动,以平滑整个数据序列。

五点线性平滑算法的优势是简单易懂,计算量较小,能够有效地去除噪声和异常值,同时保留原始数据的整体趋势;但其缺点是对较快变化的数据可能会造成滞后效应,因为加权平均的方法使得算法对数据的响应较为缓慢。

总结起来,五点线性拟合去差值和五点线性平滑算法都是常用的数据平滑方法。

它们通过对离散数据点进行拟合或加权平均处理,来去除噪声和异常值,使得数据更加平滑。

但是需要根据具体应用需求选择合适的算法,并进行参数调整以获得最佳的平滑效果。

五因子模型回归法

五因子模型回归法The five-factor model regression method is a statistical approach widely used in various research fields, particularly in social and behavioral sciences. It is based on the assumption that the observed variables can be explained by five underlying latent factors. These factors are typically identified through an iterative process of factor analysis and regression modeling, aiming to capture the maximum amount of variance in the data while maintaining interpretability.五因子模型回归法是一种广泛应用于各个研究领域的统计方法,尤其在社会科学和行为科学中。

该方法基于这样一个假设:观察到的变量可以由五个潜在的因子来解释。

这些因子通常是通过因子分析和回归建模的迭代过程来确定的,目的是在保持可解释性的同时,捕捉数据中最大的方差。

The implementation of the five-factor model regression involves several steps. First, the researcher needs to collect and preprocess the data, ensuring its quality and suitability for analysis. Then, factor analysis is conducted to identify the underlying latent factors and estimate their loadings on the observed variables. These loadings represent the strength of the relationship between each factor and the variables.实施五因子模型回归涉及多个步骤。

python linearregression参数

Python线性回归参数线性回归是一种常见的机器学习算法,用于建立自变量和因变量之间的线性关系模型。

在Python中,我们可以使用多种库和工具来实现线性回归,并调整相关参数以优化模型的性能。

本文将介绍Python中线性回归的参数及其使用方法,包括以下内容:1.线性回归简介2.相关库和工具3.参数说明与使用方法–fit_intercept(截距)–normalize(标准化)–copy_X(复制X)–n_jobs(并行计算)4.参数调优技巧5.示例代码与实战应用6.总结与展望1. 线性回归简介线性回归是一种监督学习算法,用于建立自变量X和因变量y之间的线性关系模型。

它的基本假设是自变量和因变量之间存在一个线性关系,通过最小化残差平方和来拟合这个关系。

在数学上,线性回归模型可以表示为:y = β0 + β1x1 + β2x2 + … + βnxn + ε,其中y是因变量,x1, x2, …, xn是自变量,β0, β1, …, βn是模型的参数(斜率),ε是误差项。

线性回归模型的目标是找到最佳的参数估计,使得模型拟合数据最好。

参数估计可以使用最小二乘法来求解,即通过最小化残差平方和来确定参数的取值。

2. 相关库和工具在Python中,有多个库和工具可用于实现线性回归,包括:•scikit-learn:一个功能强大的机器学习库,提供了丰富的线性回归模型和相关函数。

•numpy:一个用于科学计算的常用库,提供了向量、矩阵等数据结构以及相关运算。

•pandas:一个数据处理和分析库,提供了灵活且高效的数据结构和数据操作功能。

•matplotlib:一个用于绘图和可视化的库,可以绘制线性回归模型的拟合结果。

我们将在本文中使用scikit-learn作为主要工具来实现线性回归,并借助其他库完成数据处理和结果可视化。

3. 参数说明与使用方法在scikit-learn中,线性回归模型(LinearRegression)有几个重要的参数可以调整。

数理统计CH回归分析课件

2024/10/4

21

回归最小二乘估计

(2)最小二乘思想

n

n

| i |

2 i

i 1

i 1

残差计算:

yi a bxi i

i yi a bxi

➢用残差(误差)平 方和代表试验点与 回归直线旳总距离

2024/10/4

➢回归方程旳最小二乘

估计可归结为求解下

面旳优化模型:

n

Min a,b

n i 1

yi

a

bxi

2

n i 1

b

yi a bxi

2

n

2 yi a bxi xi i 1

2024/10/4

24

回归最小二乘估计

(3)回归最小二乘估计

x

1 n

n i 1

xi

y

1 n

n i 1

yi

Q 0 a aˆ,b bˆ a

n

即 2 yi aˆ bˆxi 0 i 1

2024/10/4

40

回归明显性检验

(3)模型和假设

线性回归模型 线性有关假设

➢由线性回归模型可推论:

E yi E a bxi i a bxi

Var yi Var a bxi i Var i 2

2024/10/4

10

7.2 一元线性回归

(1)案例和问题

x称作自变量 y称作响应变量

案例:某特种钢抗拉强度试 抗拉强度试验成果 验,控制某稀有金属含量x

x(%) y(MPa) 测得不同抗拉强度y,试验

2.07 128 成果如表所示。

3.10 194 4.14 273 5.17 372 6.20 454

yi

linearregression() 方程参数

linearregression() 方程参数Linear regression是一种非常常见的机器学习算法,它是用来处理数据集中一个或多个变量对结果变量之间相互关系的线性回归。

这个方程由许多参数组成,那么我们可以看看这些参数分别表示什么,以及它们在什么时候使用。

一般地,我们用下面这个方程来描述线性回归的关系:y=mx+b其中y表示结果变量,x表示自变量,m和b分别表示斜率和截距。

斜率是自变量增加一单位时y增加的单位量,而截距则是当自变量为0时y值的量.在多元线性回归中,有多个自变量,因此,公式将变成:y=b0+b1*x1+b2*x2+....+bn*xn这里,每个自变量都有一个对应的系数。

我们的目标是通过回归分析找到最佳的参数集合,这个参数集合是在训练数据集上的,它可以用于对未知的数据进行预测。

对于线性回归,参数估计是通过最小化误差平方和计算出来的。

具体来说,我们可以使用普通最小二乘法找到最佳参数。

这就是所谓的最小二乘法线性回归模型。

然而,这个模型不一定是最好的,有时我们需要采用更加灵活的模型来处理数据。

其中包括岭回归(Ridge Regression)和Lasso回归(Least Absolute Shrinkage and Selection Operator)。

它们也可以用来找到线性回归模型的最佳参数,但是它们还可以对模型进行正则化以防止过拟合。

在实际应用中,线性回归可应用于很多不同的领域,如金融、制造业、医疗保健等。

它是一个最基本的机器学习算法之一,也是一个非常有用的预测工具。

总的来说,在建立线性回归模型时,我们需要了解每个参数的含义和作用,选择适合的数据集,建立恰当的模型来处理数据,以获得最佳的结果。

分类自变量回归

分类自变量回归

分类自变量回归是一种统计方法,用于研究分类自变量对因变量的影响。

在回归分析中,自变量可以是连续的,也可以是分类的。

当自变量是分类变量时,通常需要进行一些额外的处理来进行回归分析。

一种常见的方法是使用哑变量(dummy variables)来处理分类自变量。

哑变量是一种将分类变量转换为数值变量的方法,以便在回归模型中使用。

对于每个分类级别,可以创建一个哑变量,其中一个级别通常被选作参考级别,并且其哑变量的值为0。

其他级别的哑变量值则为1。

这样,每个分类级别都可以通过其对应的哑变量在回归模型中进行表示。

在进行分类自变量回归时,还需要考虑其他因素,如样本选择偏差等。

例如,Heckman两阶段模型就是一种解决由样本选择偏差造成的内生性问题的方法。

这种方法在第一阶段估计出一个用于修正样本选择偏差的值,然后在第二阶段的回归方程中加入这个修正值,以得到更准确的回归系数估计。

总的来说,分类自变量回归需要一些特殊的处理来适应分类自变量的特性。

通过使用哑变量和其他统计方法,可以有效地研究分类自变量对因变量的影响。

以直角坐标表示的牛顿拉夫逊修正方程中雅可比矩阵

第一部分:引言1. 牛顿拉夫逊方法是一种数值优化算法,用于求解无约束优化问题和非线性方程组的根。

2. 通过牛顿拉夫逊方法求解优化问题或非线性方程组时,需要计算雅可比矩阵。

3. 雅可比矩阵在牛顿拉夫逊方法中起到了至关重要的作用,它反映了目标函数的局部斜率和曲率信息。

第二部分:牛顿拉夫逊方法的基本原理1. 牛顿拉夫逊方法是一种迭代算法,通过不断求解线性方程组来逼近优化问题的最优解或非线性方程组的根。

2. 在每次迭代过程中,牛顿拉夫逊方法利用目标函数的局部斜率和曲率信息来更新当前的估计值。

3. 牛顿拉夫逊方法的收敛速度通常较快,尤其对于光滑的目标函数而言。

第三部分:牛顿拉夫逊方法中雅可比矩阵的作用1. 雅可比矩阵是目标函数的一阶导数矩阵,在牛顿拉夫逊方法中扮演了关键的角色。

2. 通过雅可比矩阵,我们可以计算目标函数的斜率信息,在每次迭代中指导算法朝着最优解的方向更新估计值。

3. 牛顿拉夫逊方法中的修正方程就是利用雅可比矩阵来逼近目标函数的根或最优解。

第四部分:以直角坐标表示的牛顿拉夫逊修正方程中雅可比矩阵1. 在以直角坐标表示的牛顿拉夫逊修正方程中,雅可比矩阵通常以矩阵形式出现。

2. 假设目标函数为n维度的向量函数,则雅可比矩阵的维度为n×n。

3. 雅可比矩阵的每个元素代表了目标函数在每个自变量方向上的变化率,正是这些信息指导着牛顿拉夫逊方法的迭代更新。

第五部分:在数值计算中的应用1. 在数值计算中,雅可比矩阵常常通过数值方法进行计算,特别是对于复杂的目标函数而言。

2. 通过数值方法计算雅可比矩阵可以使牛顿拉夫逊方法应用于更广泛的优化问题和非线性方程组求解。

3. 在数值计算中,为了提高计算效率和精度,我们通常会使用一些特殊的算法来计算雅可比矩阵的近似值。

第六部分:结论1. 雅可比矩阵在牛顿拉夫逊方法中扮演了极其重要的角色,它反映了目标函数的局部斜率和曲率信息,指导着算法的迭代更新。

2. 通过数值计算方法求解雅可比矩阵,可以使牛顿拉夫逊方法应用于各种复杂的优化问题和非线性方程组求解。

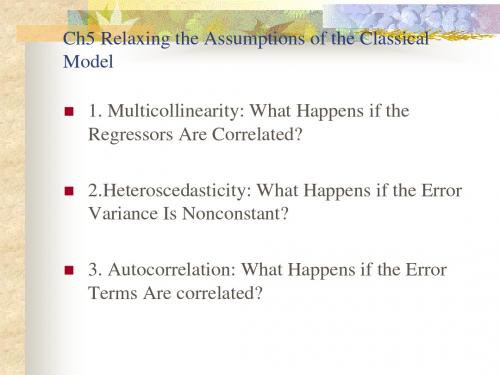

Ch5 Relaxing assumptioms_(金融经济学-英文版)

Often occurs when dealing with cross-sectional

data.

2.Correction of Heteroscedasticity

Known Variance Unknown Variance (Error Variance Varies Directly

2?????????????????iiixyminimizei??iiiiiiiiiiiiiiiiiiiiyyxxxyxxyxxy2x2222?????knownvariancemultiplelinearregressionmodel

Ch5 Relaxing the Assumptions of the Classical Model

2.Heteroscedasticity: E ( i2 ) i2

Impact of heteroscedasticity on parameter

estimators;

Corrections for heteroscedasticity;

Tests for Corrections for heteroscedasticity.

with an Independent Variable)

Known Variance

Two-variable regression model:

Yi X i Minimize i

2

xi yi / i2

x /

Yi 1 X X 1 2 3 3i k ki i X 2i X 2i X 2i X 2i X 2i

Because:

i 1 Var( ) Var X X 2 Var( i ) C 2i 2i

linearregression().fit原理

`linearregression().fit`是scikit-learn库中线性回归模型的一个方法,用于拟合线性回归模型。

其原理如下:1. 首先,该方法会接收一个特征矩阵X和一个目标向量y作为输入。

2. 然后,它会计算特征矩阵的转置和目标向量的外积,得到一个系数矩阵。

3. 接着,使用最小二乘法求解该系数矩阵,得到线性回归模型的参数(即截距和斜率)。

4. 最后,将得到的参数赋值给线性回归模型对象,完成拟合过程。

具体来说,`linearregression().fit`方法的代码实现如下:```pythondef fit(self, X, y, sample_weight=None):"""Fit linear regression model.Parameters----------X : array-like, shape (n_samples, n_features)Training vector, where n_samples is the number of samples andn_features is the number of features.y : array-like, shape (n_samples,)Target values.sample_weight : array-like, shape (n_samples,), default=NoneOptional sample weights.Returns-------self : objectReturns self."""# ...省略部分代码...self.coef_ = np.linalg.inv(X.T @ X + self.penalty * self.identity_matrix(X.shape[1])) @ X.T @ y self.intercept_ = y -***********_return self```。

stata初级入门5线性回归模型估计

2模型预测

计量经济学软件应用

16

2021/10/31

3参数检验

计量经济学软件应用

17

2021/10/31

4对虚拟变量的处理

计量经济学软件应用

18

2021/10/31

5变量的边际效应或弹性

计量经济学软件应用

19

2021/10/31

6对模型估计的相关操作

计量经济学软件应用

20

2021/10/31

.5991101 -574.8645

.7361998 1984.512

计量经济学软件应用

32

2021/10/31

3Breusch-Pagan,Cook-Weisberg 异方差检验

命令:estat hettest [varlist] [,rhs [normal|iid|fstat] mtest [(spec)]]

chi2(1)

=

2.76

Prob > chi2 = 0.0968

计量经济学软件应用

37

2021/10/31

5Ramsey回归设定误差检验

命令:estat ovtest [,rhs]

计量经济学软件应用

38

2021/10/31

回归设定误差检验:农村

范例:estat ovtest

Ramsey RESET test using powers of the fitted values of rconsum

在一元线性回归中,设定varlist或rhs,或都不设定的结果是 一样的。

normal表示误差项独立正态分布,iid表示误差项独立同分布 ,计算卡方统计量,fstat表示误差项为独立同分布,计算F统 计量,mtest表示同时进行上述各种检验。