西电数据挖掘大作业k-means和k-medoids

聚类算法 KNN 、K-mean ,K-center FCM

聚类算法分类

划分方法(partitioning method)k-means 层次方法(hierarchical methods) 基于密度的方法(density-based methods) 基于网格的方法(grid-based methods) 基于模型的方法(model-based methods)

Eg:样本点A –>E1=10 样本点B –>E2=11 样本点C –>E3=12 原质点O–>E4=13, 那我们选举A作为类簇的新质点。与K-means算法一样, K-medoids也是采用欧几里得距离来衡量某个样本点 到底是属于哪个类簇。终止条件是,当所有的类簇的 质点都不在发生变化时,即认为聚类结束。

K-MEANS

算法流程:

首先从聚类对象中随机选出K个对象作为类簇 的质心(当然了,初始参数的K代表聚类结果 的类簇数),对剩余的每个对象,根据它们分 别到这个K个质心的距离,将它们指定到最相 似的簇(因为K-means是利用距离来量化相似 度的,所以我们这里可以理解为是“将它们指 定到离最近最近距离的质心所属类簇”)。然 后重新计算质心位置。以上过程不断反复,直 到准则函数收敛为止。

K-MEANS

算法流程:

通常采用平方误差准则,定义如下:

其中,E代表的意思是所有类簇中各对象到其所属类簇 质点平方误差和. K:聚类结果类簇个数 Ci:第i个类簇 P:类簇中聚类对象mi:第i个类簇的质心

K-MEANS

K-MEANS

优点与不足:

优点: 能处理大型数据集,结果簇相当紧凑,并且簇和 簇之间明显分离。 不足: 1)该算法必须事先给定类簇数和质点,簇数和 质点的初始值设定往往会对聚类的算法影响较 大。 2 ) 通常会在获得一个局部最优值时停止。

k-medoids 聚类公式字母公式

k-medoids 聚类算法是一种常用的基于距离的聚类方法,它主要用于将数据集中的数据点划分为若干个类别,使得同一类别内的数据点之间的相似度较高,不同类别之间的相似度较低。

与k-means 算法不同的是,k-medoids 算法使用代表性的数据点(medoids)来代表每个类别,从而使得对噪声和异常值更加稳健。

在k-medoids 聚类算法中,我们首先需要确定聚类的数量k,然后从数据集中随机选择k个数据点作为初始的medoids。

接下来的步骤是不断地迭代,直至收敛为止。

具体的迭代过程如下:1. 初始化:随机选择k个数据点作为初始的medoids。

2. 分配数据点:对于每个数据点,计算它与各个medoids 的距离,并将其分配到距离最近的medoids 所代表的类别中。

3. 更新medoids:对于每个类别,选择一个新的medoids 来代表该类别,使得该类别内所有数据点到新medoids 的距离之和最小。

4. 判断收敛:检查新的medoids 是否与旧的medoids 相同,若相同则停止迭代,否则继续进行迭代。

在k-medoids 聚类算法中,距离的计算可以使用各种不同的距离度量方式,例如欧氏距离、曼哈顿距离等。

对于大规模的数据集,k-medoids 算法可能会比k-means 算法更具有优势,因为它在每次迭代时只需要计算medoids 之间的距离,而不需要计算所有数据点之间的距离,从而可以减少计算量。

k-medoids 聚类算法是一种有效且稳健的聚类方法,它在处理一些特定情况下可以取得比k-means 更好的聚类效果。

通过对数据进行有效的分组和分类,k-medoids 聚类算法在数据挖掘和模式识别领域具有广泛的应用前景。

K-medoids clustering algorithm is a widely used distance-based clustering method for partitioning the data points in a dataset into several categories, in which the similarity of data points within the same category is relatively high, while the similarity between different categories is relatively low. Unlike the k-means algorithm, the k-medoids algorithm uses representative data points (medoids) to represent each category, making it more robust to noise and outliers.In the k-medoids clustering algorithm, the first step is to determine the number of clusters, denoted as k, and then randomly select k data points from the dataset as the initial medoids. The following steps involve iterative processes until the algorithm converges.The specific iterative process is as follows:1. Initialization: randomly select k data points as the initial medoids.2. Data point assignment: for each data point, calculate its distance to each medoid and assign it to the category represented by the nearest medoid.3. Update medoids: for each category, select a new medoid to represent the category, so that the sum of the distances from all data points in the category to the new medoid is minimized.4. Convergence check: check whether the new medoids are the same as the old medoids. If they are the same, stop the iteration; otherwise, continue the iteration.In the k-medoids clustering algorithm, various distance metrics can be used for distance calculation, such as Euclidean distance, Manhattan distance, etc. For large-scale datasets, the k-medoids algorithm may have advantages over the k-means algorithm because it only needs to calculate the distance betweenmedoids at each iteration, rather than calculating the distance between all data points, which can reduce theputational workload.In conclusion, the k-medoids clustering algorithm is an effective and robust clustering method that can achieve better clustering results than the k-means algorithm in certain situations. By effectively grouping and classifying data, the k-medoids clustering algorithm has wide application prospects in the fields of data mining and pattern recognition.Moreover, the k-medoids algorithm can be further extended and applied in various domains, such as customer segmentation in marketing, anomaly detection in cybersecurity, and image segmentation inputer vision. In marketing, k-medoids clustering can be used to identify customer segments based on their purchasing behavior, allowingpanies to tailor their marketing strategies to different customer groups. In cybersecurity, k-medoids can help detect anomalies by identifying patterns that deviate from the norm in network traffic or user behavior. Inputer vision, k-medoids can be used for image segmentation to partition an image into different regions based on similarity, which is useful for object recognition and scene understanding.Furthermore, the k-medoids algorithm can also bebined with other machine learning techniques, such as dimensionality reduction, feature selection, and ensemble learning, to improve its performance and scalability. For example, using dimensionality reduction techniques like principalponent analysis (PCA) can help reduce theputational burden of calculating distances in high-dimensional data, while ensemble learning methods like boosting or bagging can enhance the robustness and accuracy of k-medoids clustering.In addition, research and development efforts can focus on optimizing the k-medoids algorithm for specific applications and datasets, such as developing parallel and distributed versions of the algorithm to handle big data, exploring adaptive and dynamic approaches to adjust the number of clusters based on the data characteristics, and integrating domain-specific knowledge or constraints into the clustering process to improve the interpretability and usefulness of the results.Overall, the k-medoids clustering algorithm is a powerful tool for data analysis and pattern recognition, with a wide range of applications and potential for further advancements andinnovations. Its ability to handle noise and outliers, its flexibility in distance metrics, and its scalability to large-scale datasets make it a valuable technique for addressing real-world challenges in various domains. As the field of data science and machine learning continues to evolve, the k-medoids algorithm will likely remain an important method for uncovering meaningful insights fromplex data.。

k-medoids算法

k-medoids算法K-medoids算法(基于中心对象算法)是一种属于聚类分析的非常流行的算法,它不像K-means算法那样基于质心。

相反,它使用最近的中心对象作为聚类的一部分。

聚类分析是一种数据挖掘技术,它搜索数据集中隐藏的关联。

它将测量对象组合到许多不同的分组中,每个组都具有相同或相似的属性。

K-medoids算法通过使用相似度度量,将对象分组到不同的类别中。

K-medoids算法是一种基于中心点聚类算法,它使用迭代计算来重复地优化聚类结果。

K-medoids算法从数据集中选择一组中心对象,然后将剩余的对象与最接近的中心对象分配。

然后,算法将中心对象更新以更接近这些对象,这可以通过调整中心对象来完成。

中心对象的改变引起的影响可能会影响聚类的结果。

K-medoids算法继续重复这个过程,直到找到聚类的最优解。

K-medoids算法在许多应用中使用,包括簇分析、序列模式探索和可视化聚类。

在簇分析中,该算法可以用来发现数据中的簇结构,以改善商业活动和市场分析。

它也可以用于发现序列模式,例如揭示隐藏在大型数据集中的共同行为。

在可视化聚类中,它可以用于将对象聚类到空间中的不同区域,以便使用空间可视化来观察簇的相似性和差异性。

K-medoids算法的优势在于其灵活性。

它可以用于不同类型的数据,而且可以应用于大型数据集。

它还可以适应非凸形数据结构,可以应用于低维空间,并且在具有多类噪声的情况下也能良好工作。

尽管K-medoids算法的算法复杂性较大,但它的稳定性非常好,对发现有用的数据结构非常有效。

k-medoids聚类算法

k-medoids聚类算法k-medoids聚类算法是一种常用的非监督机器学习算法,用于将一组对象分成不同的群组。

与k-means算法类似,k-medoids也是一种基于距离的聚类算法,但它相比于k-means算法更加鲁棒,具有更好的稳定性。

在这篇文章中,我们将介绍k-medoids聚类算法的工作原理、算法流程以及其应用。

首先,让我们来了解一下k-medoids算法是如何工作的。

k-medoids算法通过计算每个数据点与聚类中心之间的距离,将数据点分配到最近的聚类中心。

与k-means算法不同的是,k-medoids算法选择的聚类中心是实际数据点,而不是数据的均值。

这些实际数据点被称为“medoids”,因为它们代表着每个聚类的代表性样本。

接下来,我们将介绍k-medoids算法的具体流程。

首先,我们需要选择k个初始聚类中心。

这些初始聚类中心可以根据一些预定义的规则选择,例如随机选择或者根据一些先验知识选择。

然后,我们计算每个数据点与这些初始聚类中心之间的距离,将每个数据点分配到距离最近的聚类中心。

在数据点分配完毕后,我们需要重新计算每个聚类中心的位置。

对于每个聚类,我们计算该聚类中的每个数据点到其他数据点的总距离,并将其中距离最小的点作为新的聚类中心。

这个过程不断迭代直到聚类中心不再变化或达到预定的迭代次数。

最后,我们将得到k个聚类中心以及它们对应的聚类。

每个聚类都由一组数据点组成,这些数据点与自己所属的聚类中心之间的距离最小。

这些聚类可以用于分析数据集,发现隐藏在数据中的模式和关系。

k-medoids算法具有一些优点。

首先,与k-means算法相比,k-medoids算法对异常值更加鲁棒,因为它选择的聚类中心是实际的数据点。

其次,k-medoids算法适用于任意距离度量,而k-means算法只适用于欧氏距离。

此外,k-medoids算法相对简单,易于实现和理解。

k-medoids算法在许多领域都有广泛的应用。

聚类算法比较

聚类算法:1. 划分法:K-MEANS算法、K-M EDOIDS算法、CLARANS算法;1)K-means 算法:基本思想是初始随机给定K个簇中心,按照最邻近原则把待分类样本点分到各个簇。

然后按平均法重新计算各个簇的质心,从而确定新的簇心。

一直迭代,直到簇心的移动距离小于某个给定的值。

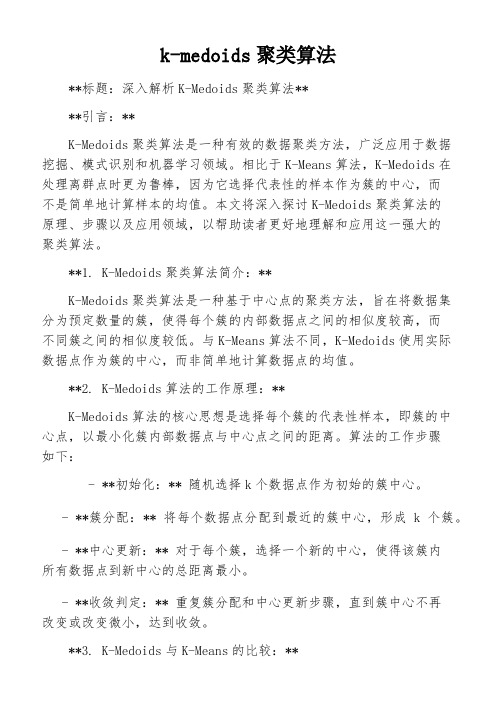

K-Means聚类算法主要分为三个步骤:(1)第一步是为待聚类的点寻找聚类中心(2)第二步是计算每个点到聚类中心的距离,将每个点聚类到离该点最近的聚类中去(3)第三步是计算每个聚类中所有点的坐标平均值,并将这个平均值作为新的聚类中心反复执行(2)、(3),直到聚类中心不再进行大范围移动或者聚类次数达到要求为止下图展示了对n个样本点进行K-means聚类的效果,这里k取2:(a)未聚类的初始点集(b)随机选取两个点作为聚类中心(c)计算每个点到聚类中心的距离,并聚类到离该点最近的聚类中去(d)计算每个聚类中所有点的坐标平均值,并将这个平均值作为新的聚类中心(e)重复(c),计算每个点到聚类中心的距离,并聚类到离该点最近的聚类中去(f)重复(d),计算每个聚类中所有点的坐标平均值,并将这个平均值作为新的聚类中心优点:1.算法快速、简单;2.对大数据集有较高的效率并且是可伸缩性的;3.时间复杂度近于线性,而且适合挖掘大规模数据集。

缺点:1. 在 K-means 算法中 K 是事先给定的,这个 K 值的选定是非常难以估计的。

2. 在 K-means 算法中,首先需要根据初始聚类中心来确定一个初始划分,然后对初始划分进行优化。

这个初始聚类中心的选择对聚类结果有较大的影响。

3. 从 K-means 算法框架可以看出,该算法需要不断地进行样本分类调整,不断地计算调整后的新的聚类中心,因此当数据量非常大时,算法的时间开销是非常大的。

4. 产生类的大小相差不会很大,对于脏数据很敏感。

2)K-M EDOIDS(k-medoids)算法与k-means很像,不一样的地方在于中心点的选取,在K-means中,我们将中心点取为当前cluster中所有数据点的平均值,在 K-medoids算法中,我们将从当前cluster 中选取这样一个点——它到其他所有(当前cluster中的)点的距离之和最小——作为中心点。

聚类分析—K-means and K-medoids聚类34页PPT

5、虽然权力是一头固执的熊,可是金 子可以 拉着它 的鼻子 走。— —莎士 比

ห้องสมุดไป่ตู้

6、最大的骄傲于最大的自卑都表示心灵的最软弱无力。——斯宾诺莎 7、自知之明是最难得的知识。——西班牙 8、勇气通往天堂,怯懦通往地狱。——塞内加 9、有时候读书是一种巧妙地避开思考的方法。——赫尔普斯 10、阅读一切好书如同和过去最杰出的人谈话。——笛卡儿

聚类分析—K-means and K-medoids聚 类

1、合法而稳定的权力在使用得当时很 少遇到 抵抗。 ——塞 ·约翰 逊 2、权力会使人渐渐失去温厚善良的美 德。— —伯克

3、最大限度地行使权力总是令人反感 ;权力 不易确 定之处 始终存 在着危 险。— —塞·约翰逊 4、权力会奴化一切。——塔西佗

k-medoids聚类算法

k-medoids聚类算法**标题:深入解析K-Medoids聚类算法****引言:**K-Medoids聚类算法是一种有效的数据聚类方法,广泛应用于数据挖掘、模式识别和机器学习领域。

相比于K-Means算法,K-Medoids在处理离群点时更为鲁棒,因为它选择代表性的样本作为簇的中心,而不是简单地计算样本的均值。

本文将深入探讨K-Medoids聚类算法的原理、步骤以及应用领域,以帮助读者更好地理解和应用这一强大的聚类算法。

**1. K-Medoids聚类算法简介:**K-Medoids聚类算法是一种基于中心点的聚类方法,旨在将数据集分为预定数量的簇,使得每个簇的内部数据点之间的相似度较高,而不同簇之间的相似度较低。

与K-Means算法不同,K-Medoids使用实际数据点作为簇的中心,而非简单地计算数据点的均值。

**2. K-Medoids算法的工作原理:**K-Medoids算法的核心思想是选择每个簇的代表性样本,即簇的中心点,以最小化簇内部数据点与中心点之间的距离。

算法的工作步骤如下:- **初始化:** 随机选择k个数据点作为初始的簇中心。

- **簇分配:** 将每个数据点分配到最近的簇中心,形成k个簇。

- **中心更新:** 对于每个簇,选择一个新的中心,使得该簇内所有数据点到新中心的总距离最小。

- **收敛判定:** 重复簇分配和中心更新步骤,直到簇中心不再改变或改变微小,达到收敛。

**3. K-Medoids与K-Means的比较:**- **鲁棒性:** K-Medoids相比K-Means对离群点更为鲁棒,因为中心点是实际数据点,不受异常值的影响。

- **复杂度:** 由于K-Medoids需要计算中心点到所有其他数据点的距离,算法的复杂度相对较高,但在小规模数据集上表现良好。

- **收敛性:** K-Medoids的收敛性较差,且初始中心点的选择对结果影响较大。

**4. K-Medoids算法的改进和优化:**- **PAM算法:** Partitioning Around Medoids(PAM)是K-Medoids的经典算法,通过交换中心点与非中心点来优化簇的内部距离。

k-medoids算法

k-medoids算法k-medoids算法是一种用于聚类分析的算法。

它与k-means算法相似,但有一些不同之处。

在k-means算法中,每个聚类的中心点是所属聚类中的所有样本的均值。

而在k-medoids算法中,每个聚类的中心点是聚类中的一个实际样本点,也称为medoid。

1. 随机选择k个样本作为初始medoids。

2. 对于每个样本,计算其与每个medoid的距离,并将其分配到距离最近的medoid所属的聚类中。

3. 对于每个聚类,计算其中所有样本与其medoid的总距离。

选取总距离最小的样本作为新的medoid。

4. 重复步骤2和步骤3,直到medoid不再改变或达到最大迭代次数。

5.得到最终的聚类结果。

1. 对于离群点更加鲁棒:由于medoid是聚类中的实际样本点,而不是均值点,因此k-medoids算法对于存在离群点的数据集更加鲁棒。

2. 可以应用于非欧几里德距离度量:k-means算法基于欧几里德距离,而k-medoids算法可以灵活地使用非欧几里德距离度量,例如曼哈顿距离或闵可夫斯基距离。

3. 可解释性更强:由于medoid是具体的样本点,而不是均值点,这意味着聚类结果更容易理解和解释。

k-medoids算法的应用广泛。

例如,在医学领域,它可以用于将患者分为不同的疾病类别,从而有助于疾病的诊断和治疗。

在市场营销中,它可以用于消费者分组,以便制定个性化的推广策略。

在图像处理领域,它可以用于图像分割,将相似的像素聚类在一起。

然而,k-medoids算法也存在一些局限性。

首先,由于需要计算样本之间的距离,如果数据集非常大,计算成本会很高。

其次,k-medoids算法对于数据集中选择medoids的敏感度较高,不同的初始medoids可能会导致不同的聚类结果。

此外,k-medoids算法无法直接处理高维数据,需要使用降维方法来减少维度。

为了克服这些局限性,研究人员提出了一些改进的k-medoids算法,如PAM算法和CLARA算法。

常规聚类算法

常规聚类算法常规聚类算法是一种重要的数据分析方法,可以帮助我们对大规模数据进行有效的分类和归纳。

通过对数据进行聚类,我们可以发现数据中的隐藏模式、规律和关系,从而为后续的数据挖掘、预测和决策提供有力支持。

常规聚类算法主要分为基于划分的聚类算法、基于层次的聚类算法和基于密度的聚类算法。

每种算法都有其独特的特点和适用场景,下面就分别进行介绍。

基于划分的聚类算法主要包括K-means算法和K-medoids算法。

K-means算法是一种常用且广泛应用的聚类算法,它将数据分成K个簇,每个簇的中心点代表了该簇的平均值。

该算法通过迭代的方式,将数据点不断归类到离其最近的簇中,直到达到稳定状态。

K-medoids算法是一种改进的K-means算法,它将簇的中心点定义为簇中所有数据点中与其他点的平均距离最小的点,从而可以更准确地划分簇。

基于层次的聚类算法主要包括凝聚层次聚类算法和分裂层次聚类算法。

凝聚层次聚类算法从每个数据点作为一个簇开始,然后通过计算两个最相似簇之间的距离来合并簇,直到形成一个大的簇。

分裂层次聚类算法则相反,从一个大的簇开始,然后通过计算簇中数据点之间的距离来分裂簇,直到形成多个小的簇。

这种算法的优点是可以在不同的层次上进行聚类,从而可以灵活地控制聚类的粒度。

基于密度的聚类算法主要包括DBSCAN算法和OPTICS算法。

DBSCAN算法是一种基于密度的聚类算法,它通过确定数据点的密度来划分簇,具有自动确定簇数和可处理噪声的优点。

OPTICS算法是DBSCAN算法的扩展,它通过将数据点的密度和可达距离进行排序,形成一个密度可达图,并根据该图来划分簇。

这种算法可以更好地处理数据中的离群点和噪声。

在使用常规聚类算法时,我们需要注意数据的选择和预处理。

合适的数据选择和预处理可以提高聚类算法的效果和准确性。

同时,我们还需要关注聚类结果的解释和评估。

解释聚类结果可以帮助我们理解数据中的模式和关系,评估聚类结果可以帮助我们判断算法的优劣和稳定性。

k-medoids聚类算法

k-medoids聚类算法

k-medoids聚类算法又叫做PAM算法,是一种基于中心点的分组聚类算法,和k-means算法相似,其目的也是将样本划分为k个簇,每个簇都包含距离簇中心最近的样本点。

与k-means不同的是,k-medoids使用的是样本点而非均值点来作为簇的中心点,因此不受离群点的影响,在一定程度上提高了聚类的准确性。

k-medoids算法的步骤如下:

1. 随机选择k个样本作为初始中心点。

2. 将每个样本点分配到与其最近的中心点所在的簇中。

3. 计算每个簇中所有样本之间的距离和作为该簇的代价函数。

4. 针对每个簇中的每个样本,计算将该样本作为中心点后,该簇的代价函数。

5. 如果将当前簇的某个样本作为中心点可以降低该簇的代价函数,则将该样本作为新的中心点。

6. 重复执行步骤2至5,直到簇的中心点不再改变。

最终,k-medoids算法会得到k个簇,每个簇包含距离中心点最近的一些样本点。

通过对数据的分析,可以发现不同的簇之间具有明显的差异性,对于簇内相似性高、簇间相似性低的数据集,k-medoids 算法在实际应用中有着广泛的应用。

kmedoids算法简单例题

Kmedoids算法简单例题在数据挖掘领域,Kmedoids算法是一种常用的聚类算法。

它是Kmeans算法的改进版本,与Kmeans算法相比,Kmedoids算法更加鲁棒,能够更好地处理噪声数据,并且在簇的个数K确定的情况下,其聚类结果不受初始聚类中心的选择影响。

接下来,我们将通过一个简单的例题来讲解Kmedoids算法的原理和应用。

假设我们有一个数据集,包含如下10个数据点:1. (2, 6)2. (3, 4)3. (3, 8)4. (4, 7)5. (6, 2)6. (6, 4)7. (7, 3)8. (7, 4)9. (8, 5)10. (7, 6)现在,我们希望利用Kmedoids算法将这些数据点聚类成两个簇。

为了简化计算,我们假设初始的簇中心为数据点3和数据点8。

接下来,按照Kmedoids算法的步骤来进行计算。

计算每个数据点到两个初始簇中心的距离。

根据最近的簇中心将每个数据点分配到相应的簇中。

经过计算和分配后,我们得到了两个簇:簇1:(2, 6), (3, 4), (3, 8), (4, 7), (6, 4)簇2:(6, 2), (7, 3), (7, 4), (8, 5), (7, 6)接下来,我们需要计算每个簇中所有数据点对簇中心的距离之和,并选择一个新的簇中心使得这个距离之和最小。

经过计算,我们发现数据点3和数据点8并不是最佳的簇中心。

事实上,数据点3和数据点7更适合作为新的簇中心。

我们将簇中心更新为数据点3和数据点7,然后重新进行数据点的分配和簇中心的更新。

经过若干轮迭代后,我们最终得到了两个簇:簇1:(2, 6), (3, 4), (3, 8), (4, 7), (6, 4)簇2:(6, 2), (7, 3), (7, 4), (8, 5), (7, 6)在这个例题中,我们简单介绍了Kmedoids算法的原理和应用。

通过不断计算和更新簇中心,Kmedoids算法能够有效地将数据点聚类成符合我们期望的簇。

聚类分析—K-means and K-medoids聚类要点

2018/10/5

在图像分割上的简单应用(续)

分割后的效果

注:最大迭代次数为20次,需运行多次才有可能得到较好的效果。

2018/10/5

在图像分割上的简单应用(续)

例 2:

注:聚类中心个数为5,最大迭代次数为10。

2018/1Байду номын сангаас/5

k-平均聚类算法(续)

优点: 相对有效性: O(tkn),

其中 n 是对象数目, k 是簇数目, t 是迭代次数; 通常, k, t << n.

2018/10/5

PAM

PAM (Partitioning Around Medoids) (Kaufman and Rousseeuw, 1987)

是最早提出的k-中心点聚类算法 基本思想:

随机选择k个代表对象

反复地试图找出更好的代表对象: 分析所有可能的对象对,每个对 中的一个对象被看作是代表对象, 而另一个不是. 对可能的各种组合, 估算聚类结果的质量

2018/10/5

k-中心点聚类方法(续)

找聚类中的代表对象(中心点)

PAM (Partitioning Around Medoids, 1987)

首先为每个簇随意选择选择一个代表对象, 剩余的对象根 据其与代表对象的距离分配给最近的一个簇; 然后反复地 用非代表对象来替代代表对象,以改进聚类的质量 PAM 对于较小的数据集非常有效, 但不能很好地扩展到大 型数据集

k-平均值(MacQueen’67): 每个簇用该簇中对象的平均值来表示

k-中心点或 PAM (Partition around medoids) (Kaufman & Rousseeuw’87): 每个簇用接近聚类中心的一个对象来表示

k-medoids聚类算法

k-medoids聚类算法K-medoids聚类算法是一种常用的基于对象间相似性的聚类方法。

与传统的K-means算法不同,K-medoids算法不是通过计算数据对象之间的欧氏距离来评估聚类质量,而是利用一种称为Medoid的代表样本来度量样本间的相似性。

K-medoids算法的基本思想是在给定数据集和指定的聚类数k的条件下,将数据集划分为k个不相交的聚类簇,使得簇内的数据对象之间的相似性最大化且簇间的相似性最小化。

与K-means算法一样,K-medoids算法也是一个迭代的过程,包括选择初始聚类中心、计算聚类成本、更新聚类簇等步骤。

K-medoids算法的第一步是选择初始聚类中心。

初始聚类中心是通过从数据集中选择k个对象作为代表样本来确定的。

这些代表样本被称为Medoids,它们是数据集中最具代表性的样本。

接下来是计算聚类成本。

聚类成本是指所有数据对象与其所属聚类簇的Medoid之间的距离之和。

在K-medoids算法中,采用曼哈顿距离作为聚类成本的度量标准。

曼哈顿距离是指两个二维向量之间的绝对值差之和。

计算完聚类成本之后,需要更新聚类簇。

首先,对于每个对象,计算其与当前Medoids的曼哈顿距离,并将对象分配给离其最近的Medoid所在的簇。

然后,对于每个簇,选择该簇中所有对象到该簇内其他对象的距离和最小的对象作为新的Medoid。

更新聚类簇完成后,需要重新计算聚类成本。

如果聚类成本没有发生变化或变化非常小,则停止迭代,算法结束。

否则,继续迭代更新聚类簇。

K-medoids算法的优点是对异常值更加鲁棒。

与K-means算法相比,K-medoids算法通过选择最具代表性的样本作为Medoids,从而减少了异常值的影响。

此外,K-medoids算法还可以用于处理非数值型数据,比如文本数据。

因为K-medoids算法使用曼哈顿距离作为度量标准,所以可以计算非数值型数据之间的相似性。

然而,K-medoids算法也有一些缺点。

聚类算法之划分方法(k-means)

聚类算法之划分⽅法(k-means)聚类划分⽅法给定n个数据点的数据集合,构建数据集合的出K个划分,每个划分代表⼀个类别,2<k<sqrt(n)。

算法思想,划分法需要预先指定聚类数⽬和聚类中⼼,计算每个点与其他点的距离,对于每个数据点都有n-1个距离值,对这些距离值进⾏排序,找出最接近的数据点,算出这些距离的和值。

并进⾏下次迭代,这时数据中兴点位置改变,继续按照上⽅的步骤,逐步降低⽬标函数的误差值,直到⽬标函数值收敛时,得到最终聚类的结果。

逐步对聚类结果进⾏优化、不断将⽬标数据集向各个聚类中⼼进⾏重新分配以获最优解。

代表算K-means,K-medoids.(公式乱码,⽤⽂字代替)setp1:指定K个聚类中⼼setp2:(每⼀个数据点与初始聚类中⼼的距离)setp3:(对每⼀个数据点x,找到最近的C(聚类中⼼),x分配到新的类C中)setp4:(更新聚类中⼼点)setp5:(计算每⼀类的偏差)setp6:判断偏差是否⼩于阈值(⾃⼰设定),不⼩于则返回setp2当聚类是密集的,⽽聚类之间区别明显时,K—Means算法的效果较好。

另外,对处理⼤数据集,该算法是⾼效率的,因为它的复杂度是,其中,n是所有对象的数⽬,K是聚类的数⽬,t是迭代的次数。

通常且。

但是,K—Means算法只有在聚类的平均值被定义的情况下才能使⽤。

如果处理符号属性的数据并不适⽤。

K—Means算法对初始聚类中⼼和样本的输⼊顺序敏感,对于不同的初始聚类中⼼和样本输⼊顺序,聚类结果会有很⼤差别。

由于采⽤迭代更新的⽅法,所以当初始聚类中⼼落在局部值最⼩附近时,算法容易⽣成局部最优解。

另外,算法的效果受孤⽴点的影响很⼤。

优点:1简单,易于理解和实现;2,时间复杂度低3.聚类中⼼⽤各类别中所有数据的平均值表⽰k-means⽅法的缺陷1,需要对均值给出定义,2,需要指定要聚类的数⽬;3,⼀些过⼤的异常值会带来很⼤影响;4,算法对初始选值敏感;5,适合球形聚类6.结果好坏依赖于对初始聚类中⼼的选择、容易陷⼊局部最优解、对K值的选择没有准则可依循、只能处理数值属性的数据、聚类结构可能不平衡。

K-median算法(2020)

K-median算法(2020)聚类算法之k-medoids算法上一次我们了解了一个最基本的 clustering 办法 k-means ,这次要说的k-medoids 算法,其实从名字上就可以看出来,和k-means 肯定是非常相似的。

事实也确实如此,k-medoids 可以算是 k-means 的一个变种。

k-medoids 和k-means 不一样的地方在于中心点的选取,在k-means 中,我们将中心点取为当前cluster 中所有数据点的平均值:并且我们已经证明在固定了各个数据点的assignment 的情况下,这样选取的中心点能够把目标函数最小化。

然而在 k-medoids 中,我们将中心点的选取限制在当前 cluster 所包含的数据点的集合中。

换句话说,在 k-medoids 算法中,我们将从当前cluster 中选取这样一个点——它到其他所有(当前cluster 中的)点的距离之和最小——作为中心点。

k-means 和k-medoids 之间的差异就类似于一个数据样本的均值 (mean) 和中位数 (median) 之间的差异:前者的取值范围可以是连续空间中的任意值,而后者只能在给样本给定的那些点里面选。

那么,这样做的好处是什么呢?一个最直接的理由就是 k-means 对数据的要求太高了,它使用欧氏距离描述数据点之间的差异(dissimilarity) ,从而可以直接通过求均值来计算中心点。

这要求数据点处在一个欧氏空间之中。

然而并不是所有的数据都能满足这样的要求,对于数值类型的特征,比如身高,可以很自然地用这样的方式来处理,但是类别(categorical)类型的特征就不行了。

举一个简单的例子,如果我现在要对犬进行聚类,并且希望直接在所有犬组成的空间中进行,k-means 就无能为力了,因为欧氏距离在这里不能用了:一只Samoyed 减去一只Rough Collie 然后在平方一下?天知道那是什么!再加上一只German Shepherd Dog 然后求一下平均值?根本没法算,k-means 在这里寸步难行!在 k-medoids 中,我们把原来的目标函数中的欧氏距离改为一个任意的 dissimilarity measure 函数最常见的方式是构造一个 dissimilarity matrix 来代表,其中的元素只狗和第只狗之间的差异程度,例如,两只Samoyed 之间的差异可以设为 0 ,一只German Shepherd Dog 和一只Rough Collie 之间的差异是 0.7,和一只Miniature Schnauzer 之间的差异是 1 ,等等。

kmedoids的轮廓系数__解释说明

kmedoids的轮廓系数解释说明1. 引言1.1 概述在聚类算法中,K-means是一种常用的方法,其通过将数据点划分为K个簇来实现聚类分析。

然而,当数据集包含离群点或者噪声数据时,传统的K-means 算法可能无法获取准确的聚类结果。

为了克服这一问题,K-medoids算法被提出并广泛应用于各种领域。

与K-means不同的是,K-medoids将簇中心选择为该簇内具有最小平均距离的对象,从而提高了对异常值和噪声数据的鲁棒性。

1.2 文章结构本文将详细介绍K-medoids算法及其在聚类分析中的应用。

首先,在第2节中我们将总览该算法,并解释其原理和流程;接着,在第3节中我们将介绍轮廓系数的概念和意义,并阐述轮廓系数在K-medoids中的作用;然后,在第4节中我们将给出研究方法与结果分析部分,包括数据集选择与预处理方法描述、实验设置与评估指标介绍以及实验结果分析与讨论;最后,在第5节中我们将对整篇文章进行总结,并展望未来关于K-medoids算法的研究方向。

1.3 目的本文的目的在于介绍K-medoids算法,并重点解释其应用中的一个重要指标——轮廓系数。

通过对该指标的全面分析,我们希望读者能够理解K-medoids算法及其在聚类分析中的优势,以及如何使用轮廓系数来评估聚类效果。

此外,通过实验结果分析与讨论部分,我们也将展示K-medoids算法在不同数据集上的性能表现,以验证其有效性和可靠性。

最后,我们还将探讨未来关于K-medoids 算法的研究方向,并给出相应建议和展望。

这样组织文章可以确保读者对文章结构有清晰的了解,并且能够准确把握每一节主题内容。

同时,在引言部分明确阐述了文章的概述、结构和目的,使得读者能够对整篇文章有一个整体认识并明白作者要传达的信息。

2. K-medoids算法2.1 总览K-medoids算法是一种用于聚类分析的方法,它是基于中心点(medoid)的概念进行计算的。

数据挖掘常用聚类算法分析与研究

数据挖掘常用聚类算法分析与研究数据挖掘是从大量的数据集中发现有用信息和模式的过程。

聚类算法是数据挖掘中常用的一种方法,它的目标是把数据集划分为若干个组,使组内的数据点相似度较高,组间的数据点相似度较低。

聚类算法在实际应用中具有广泛的研究和应用价值。

聚类算法常用于数据分析、图像处理、信号处理、生物信息学、社交网络和自然语言处理等领域。

在这些领域中,聚类算法可以帮助我们发现隐藏在数据中的模式,提取出有用的信息,辅助决策和预测。

常见的聚类算法包括K-means、DBSCAN、层次聚类和密度聚类等。

K-means算法是最常用的聚类算法之一、它通过迭代的方式将数据集划分为K个簇,使簇内的数据点尽可能接近簇的质心。

K-means算法的优点是简单易实现,收敛速度快,适用于处理大规模数据集。

缺点是需要预先设定聚类数目K,并且对初始质心的选择较为敏感。

DBSCAN算法是一种基于密度的聚类算法。

它通过选择一个适当的半径ε和邻居数目MinPts来划分数据集。

对于密度较高的区域,DBSCAN 算法会将其划分为一个簇;对于边界上的数据点,DBSCAN算法会将其划分为噪音点。

DBSCAN算法的优点是能够处理任意形状的簇,不需要预先指定簇的数目。

缺点是对于不同密度的簇效果可能不佳。

层次聚类算法是一种自底向上或自顶向下的聚类方法。

它通过计算数据点之间的距离或相似度,根据一定的凝聚或分裂规则逐步合并或划分数据点,直到得到所需的聚类结果。

层次聚类算法的优点是能够得到层次化的聚类结果,可视化效果好。

缺点是计算复杂度高,在处理大规模数据集时效率低下。

密度聚类算法是一种基于数据点密度的聚类方法。

它通过检测数据集中的密度高点和低点,将密度较高的数据点划分为簇,将密度较低的数据点划分为噪音点。

密度聚类算法的优点是能够发现任意形状的簇,对噪音和离群点有较好的鲁棒性。

缺点是对参数的选择较为敏感,对于数据集密度不均匀的情况,效果可能不佳。

聚类算法的选择取决于数据集的特征和要达到的分析目标。

数据挖掘教学大纲

西北师范大学计算机科学与技术专业课程教学大纲数据挖掘一、说明(一)课程性质数据挖掘是计算机科学与技术专业的选修课程,本课程以数据挖掘为主要内容,讲述实现数据挖掘的各主要功能、挖掘算法和应用,并通过对实际数据的分析更加深入地理解常用的数据挖掘模型。

先修课程:《数据库原理》、《概率论与数理统计》、《高级程序设计语言》、《数据结构》等。

(二)教学目的数据挖掘是20世纪末刚刚兴起的数据智能分析技术,由于有广阔的应用前景而备受重视。

数据挖掘作为一门新兴的学科,在它的形成和发展过程中表现出了强大的生命力,广大从事数据库应用与决策支持,以及数据分析等学科的科研工作者和工程技术人员迫切需要了解和掌握它。

数据挖掘涉及的内容较为广泛,已成为迅速发展并在信息社会中广泛应用的一门综合性学科。

数据挖掘已成为统计学专业的一门重要课程。

通过数据挖掘课程的教学,使学生理解数据挖掘的基本概念和方法,为进入更深入的智能数据分析研究打好基础。

(三)教学内容本课程主要学习的内容包括数据预处理、分类与预测、聚类分析等内容(四)教学时数本课程的教学时数为课堂36学时,上机18学时,2.5学分。

(五)教学方式本课程将采用课堂讲授、上机实验相结合的方法。

二、本文第一章数据挖掘概述教学要点:1.理解和掌握数据挖掘的基本概念、数据挖掘过程以及数据挖掘功能。

2.了解数据挖掘的应用和面临的问题。

3.对数据挖掘能够解决的问题和解决问题思路有清晰的认识。

教学时数:3学时。

教学内容:第一节什么是数据挖掘(0.5学时)数据挖掘(Data Mining)就是从大量的、不完全的、模糊的、随机的实际应用数据中,提取隐含在其中的、事先不知道的但又是潜在有用的信息和知识的过程。

第二节数据挖掘——在何种数据上进行?(0.5学时)关系数据库、数据仓库、事务数据库第三节数据挖掘功能——可以挖掘什么类型的模式(1学时)关联分析、分类和预测、聚类分析第四节数据挖掘系统的分类(1学时)数据挖掘系统可以根据所挖掘的知识类型分类。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

题 目: 数据挖掘学 院: 电子工程学院专 业: 智能科学和技术学生姓名: **学 号: 02115***k -means 实验报告一、 waveform 数据1、 算法描述1. 从数据集{X n }n−1N 中任意选取k 个赋给初始的聚类中心c 1, c 2, …,c k;2.对数据集中的每个样本点x i,计算其和各个聚类中心c j的欧氏距离并获取其类别标号:label(i)=arg min ||x i−c j||2,i=1,…,N,j=1,…,k3.按下式重新计算k个聚类中心;c j=∑x js:label(s)=jj,j=1,2,…k重复步骤2和步骤3,直到达到最大迭代次数为止2、实验结果二、图像处理1、算法描述同上;2、实验结果代码:k_means:%%%%%%%%%K_means%%%%%%%%%%%%%%%%%函数说明%%%%%%%%%输入:% sample——样本集;% k ——聚类数目;%输出:% y ——类标(从0开始)% cnew ——聚类中心% n ——迭代次数function [y cnew n]=k_means(sample,k)[N V]=size(sample); %N为样本的个数 K为样本的维数y=zeros(N,1); %记录样本类标dist=zeros(1,k);rand_num=randperm(N);cnew=(sample(rand_num(1,1:k),:));%随机初始化聚类中心cold=zeros(k,V);n=0;while(cold~=cnew)cold=cnew;n=n+1; %记录迭代次数%对样本进行重新分类for i=1:Nfor j=1:kif(V==1)dist(1,j)=abs(sample(i,:)-cold(j,:));elsedist(1,j)=norm(sample(i,:)-cold(j,:));endendfor s=1:kif(dist(1,s)==min(dist))y(i,1)=s-1;endendend%更新聚类中心cnew=zeros(k,V);flag=zeros(k,1);for i=1:Nfor j=1:kif (y(I,1)==j-1)flag(j,1)=flag(j,1)+1;cnew(j,☺=cnew(j,☺+sample(I,☺;endendendfor j=1:kcnew(j,☺=cnew(j,☺/flag(j,1);endendk_means_waveform:clear;clc;%%%%%%%%%数据读入%%%%%%%data=load('G:\西电\2014大三下\大作业\Data Mining\k_means\waveform.data');[N K]=size(data); %数据集的数目data0=zeros(1,K);data1=zeros(1,K);data2=zeros(1,K);for i=1:Nif(data(i,K)==0)data0=cat(1,data(i,:),data0);elseif(data(i,K)==1)data1=cat(1,data(i,:),data1);elsedata2=cat(1,data(i,:),data2);endendsample=cat(1,data0(1:100,:),data1(1:100,:),data2(1:100,:));label=sample(:,K); %样本的正确类标sample=sample(:,1:K-1); %样本集k=3; %聚类中心的数目%%%%%%%%%K_means%%%%%%%%[y cnew n]=k_means(sample,k);%%%%%%%%%%正确率统计%%%%%%%sum=zeros(1,6);[N V]=size(sample);for i=1:Nif(y(i,1)==label(i,1))sum(1,1)=sum(1,1)+1;endendfor i=1:Nif((y(i,1)+label(i,1))==2)sum(1,2)=sum(1,2)+1;endendfor i=1:Nif(((y(i,1)==0)&&(label(i,1)==0))||((y(i,1)==1)&&label(i,1)==2)||((y( i,1)==2)&&label(i,1)==1))sum(1,3)=sum(1,3)+1;endendfor i=1:Nif(((y(i,1)==0)&&(label(i,1)==1))||((y(i,1)==1)&&label(i,1)==0)||((y( i,1)==2)&&label(i,1)==2))sum(1,4)=sum(1,4)+1;endendfor i=1:Nif(((y(i,1)==0)&&(label(i,1)==1))||((y(i,1)==1)&&label(i,1)==2)||((y( i,1)==2)&&label(i,1)==0))sum(1,5)=sum(1,5)+1;endendfor i=1:Nif(((y(i,1)==0)&&(label(i,1)==2))||((y(i,1)==1)&&label(i,1)==0)||((y( i,1)==2)&&label(i,1)==1))sum(1,6)=sum(1,6)+1;endendsum=sum/N;creatrate=max(sum);disp('循环次数:');disp(n);disp('聚类中心为:');disp(cnew);disp('正确率为:');disp(creatrate);k_means_picture:clear;clc;%%%%%%%%%数据读入%%%%%%%I1=imread('G:\西电\2014大三下\大作业\Data Mining\ k_means\lena.jpg');I2=rgb2gray(I1);%转化为灰度图像I=im2double(I2);[num v]=size(I);sample=reshape(I,v*num,1);%样本集k=2; %聚类中心的数目%%%%%%%%%K_means%%%%%%%%[y cnew n]=k_means(sample,k);%%%%%%%%v%%%%%%%%I3=sample;if(cnew(1,1)>=cnew(2,1))F0=255;F1=0;elseF0=0;F1=255;endfor i=1:num*vif(y(i,1)==0)I3(i,1)=F0;elseI3(i,1)=F1;endendI3=reshape(I3,num,v);figure(1)subplot(1,3,1);imshow(I1);title('原图像');subplot(1,3,2);imshow(I2);title('灰度图像');subplot(1,3,3);imshow(I3);title('二值化图像');k_medoids实验报告一、 waveform数据1、算法描述(1)随机选择k个对象作为初始的代表对象;(2) repeat(3) 指派每个剩余的对象给离它最近的代表对象所代表的簇;(4) 随意地选择一个非代表对象Orandom;(5) 计算用Orandom代替Oj的总代价S;(6) 如果S<0,则用Orandom替换Oj,形成新的k个代表对象的集合;(7) until 不发生变化2、实验结果二、图像处理1、算法描述同上;2、实验结果代码:k_medoids:%%%%%%%%k_medoids%%%%%%%%%%%%%%%%%º函数说明%%%%%%%%%%输入:% sample——数据集% k——聚类数目;%输出:% y——类标;% med ——聚类中心点function [y med]=k_medoids(sample,k)[N V]=size(sample); %N为样本数目 V为样本为数%聚类中心的随机初始化rbowl=randperm(N);med=sample(rbowl(1,1:k),:);temp=zeros(N,2);dist=zeros(1,k);index=rbowl(1,k);Eold=0;Enew=1000;while(abs(Enew-Eold)>0.001)%将所有样本分配到最近的代表点for i=1:Nfor j=1:kdist(1,j)=norm(sample(i,:)-med(j,:));endtemp(i,1)=min(dist);for s=1:kif(dist(1,s)==temp(i,1))temp(i,2)=s;endendendy=temp(:,2);Eold=sum(temp(:,1));%随机的选择一个非代表点,生成新的代表点集合index=index+1;med_temp=med;E=zeros(1,k);for j=1:kmed_temp(j,:)=sample(index,:);%将所有样本分配到最近的代表点for i=1:Nfor t=1:kdist(1,t)=norm(sample(i,:)-med_temp(t,:));endtemp(i,1)=min(dist);for s=1:kif(dist(1,s)==temp(i,1))temp(i,2)=s;endendendE(1,j)=sum(temp(:,1));endEnew=min(E);for t=1:kif(E(1,t)==Enew)obest=t;endendif(Enew<Eold)med(obest,:)=sample(index,:);elseEnew=Eold;endendk_medoids_waveform:clear;clc;%%%%%%%%%Êý¾Ý¶ÁÈë%%%%%%%data=load(' G:\西电\2014大三下\大作业\Data Mining\k_medoids\waveform-+noise.data');[N K]=size(data); %数据集的数目data0=zeros(1,K);data1=zeros(1,K);data2=zeros(1,K);for i=1:Nif(data(i,K)==0)data0=cat(1,data(i,:),data0);elseif(data(i,K)==1)data1=cat(1,data(i,:),data1);elsedata2=cat(1,data(i,:),data2);endendsample=cat(1,data0(1:100,:),data1(1:100,:),data2(1:100,:)); label=sample(:,K); %Ñù±¾µÄÕýÈ·Àà±êsample=sample(:,1:K-1); %Ñù±¾¼¯k=3; %聚类中心的数目%%%%%%%%%%k_medoids%%%%%%%[y med]=k_medoids(sample,k);%%%%%%%%%%正确率统计Æ%%%%%%%sum=zeros(1,6);[N V]=size(sample);for i=1:Ny(i,1)=y(i,1)-1;endfor i=1:Nif(y(i,1)==label(i,1))sum(1,1)=sum(1,1)+1;endendfor i=1:Nif((y(i,1)+label(i,1))==2)sum(1,2)=sum(1,2)+1;endendfor i=1:Nif(((y(i,1)==0)&&(label(i,1)==0))||((y(i,1)==1)&&label(i,1)==2)||((y( i,1)==2)&&label(i,1)==1))sum(1,3)=sum(1,3)+1;endendfor i=1:Nif(((y(i,1)==0)&&(label(i,1)==1))||((y(i,1)==1)&&label(i,1)==0)||((y( i,1)==2)&&label(i,1)==2))sum(1,4)=sum(1,4)+1;endendfor i=1:Nif(((y(i,1)==0)&&(label(i,1)==1))||((y(i,1)==1)&&label(i,1)==2)||((y( i,1)==2)&&label(i,1)==0))sum(1,5)=sum(1,5)+1;endendfor i=1:Nif(((y(i,1)==0)&&(label(i,1)==2))||((y(i,1)==1)&&label(i,1)==0)||((y( i,1)==2)&&label(i,1)==1))sum(1,6)=sum(1,6)+1;endendsum=sum/N;creatrate=max(sum);disp('¾ÛÀàÖÐÐÄΪ£º');disp(med);disp('ÕýÈ·ÂÊΪ£º');disp(creatrate);k_medoids_picture:clear;clc;%%%%%%%%%Êý¾Ý¶ÁÈë%%%%%%%I0=imread(' G:\西电\2014大三下\大作业\Data Mining\ k_medoids\lena.jpg'); D=0.001;I1=imnoise(I0,'gaussian',0,D);%加噪声I2=rgb2gray(I1);%转化为灰度图像I=im2double(I2);[num v]=size(I);sample=reshape(I,v*num,1);%Ñù±¾¼¯k=2; %¾ÛÀàÖÐÐĵÄÊýÄ¿%%%%%%%%%K_means%%%%%%%%[y med]=k_medoids(sample,k); %%%%%%%%图像显示¾%%%%%%%%I3=sample;if(med(1,1)>=med(2,1))F0=255;F1=0;elseF0=0;F1=255;endfor i=1:num*vif(y(i,1)==1)I3(i,1)=F0;elseI3(i,1)=F1;endendI3=reshape(I3,num,v);figure(1)subplot(1,4,1);imshow(I0);title('原图像');subplot(1,4,2);imshow(I1);title('加噪声后的图像');subplot(1,4,3);imshow(I2);title('灰度图像');subplot(1,4,4);imshow(I3);title('二值化图像');。