应用于P2P流分类的一种改进Bagging学习算法

集成学习中的Bagging算法概述

集成学习中的Bagging算法概述集成学习是一种机器学习的方法,它通过将多个分类器的预测结果进行整合,从而得到更准确的分类结果。

Bagging(Bootstrap aggregating)算法是集成学习中最常用的一种方法之一。

本文将对Bagging算法进行概述,介绍其原理和应用,并探讨其优势和局限性。

Bagging算法的原理很简单。

首先,从原始数据集中使用自助采样方法,随机地有放回地抽取样本,生成若干个训练子集。

然后,每个训练子集都用于独立地训练一个基分类器。

最后,对于分类任务,通过投票的方式来整合每个基分类器的预测结果;对于回归任务,通过平均每个基分类器的回归结果来得到最终的预测结果。

Bagging算法的优势在于可以降低模型的方差,提高模型的稳定性和泛化能力。

通过自助采样的方式,每个基分类器所使用的训练数据集之间具有较大的差异性,从而减小了模型的过拟合风险。

通过对多个基分类器的整合,Bagging算法可以减少噪声的影响,提高分类器的鲁棒性。

此外,Bagging算法还可以并行化,有效地提高了模型训练速度。

Bagging算法的应用非常广泛,特别是在分类和回归任务中。

在分类任务中,Bagging算法可以应用于各种分类算法,例如决策树、支持向量机、神经网络等。

在回归任务中,Bagging算法可以应用于各种回归算法,例如线性回归、岭回归、随机森林等。

根据实际问题的不同,可以选择合适的基分类器和整合方法。

此外,Bagging算法还可以用于特征选择、异常检测和集成模型的构建等领域。

尽管Bagging算法在许多应用场景下具有良好的性能,但也存在一些局限性。

首先,Bagging算法无法减少模型的偏差,因此在某些情况下可能无法显著提高模型的预测准确率。

其次,Bagging算法的训练子集之间存在重叠样本,这可能导致基分类器之间存在较高的相关性,从而降低整体性能。

此外,Bagging算法的模型结构相对简单,对于复杂的非线性问题可能不够灵活。

集成学习中的Bagging算法概述

集成学习中的Bagging算法概述Bagging算法是集成学习中一种常用的方法,旨在通过集合多个基础分类器的预测结果来提高整体的分类准确性。

本文将对Bagging算法进行概述,介绍其原理、优点和应用领域。

Bagging(Bootstrap aggregating)算法的核心思想是通过自助采样(bootstrap sampling)和多个基学习器的集成来减小模型的方差,提高模型的鲁棒性。

具体步骤如下:1. 数据集采样:从原始训练集中使用有放回的随机采样(bootstrap sampling)方法生成多个采样集合。

每个采样集合的大小与原始训练集一样,但样本中可能有重复。

2. 基学习器训练:对于每个采样集合,使用基础学习算法(如决策树、SVM 等)来训练一个基学习器。

由于采样集合中可能出现冗余和噪声,每个基学习器可能会学到略微不同的知识。

3. 集成预测:对于新的未知样本,通过将所有基学习器的预测结果进行投票或取平均,来进行最终的集成预测。

这样可以抵消单个基学习器的错误,提高整体的分类准确度。

Bagging算法的优点在于能有效降低过拟合风险,并提高模型的鲁棒性和稳定性。

具体而言,有以下几个方面:1. 方差减小:通过集成多个基学习器的预测结果,Bagging算法能够减小模型的方差,降低模型对训练数据的过拟合程度。

2. 鲁棒性提升:多个基学习器的集成可以减小训练数据中的随机噪声和异常样本对模型的影响,提高模型的鲁棒性。

3. 算法简单:Bagging算法本身的实现相对简单,只需要采样数据集和训练多个基学习器,不需要大量的调参和优化。

Bagging算法在实践中被广泛应用于各种机器学习任务中,特别是在分类和回归问题上。

以下是一些典型的应用领域:1. 基于决策树的Bagging算法(Random Forest)在图像识别、物体检测和推荐系统等领域取得了很好的效果。

由于决策树具有良好的可解释性和抗噪能力,与Bagging算法结合能够更进一步提高模型的分类准确性和鲁棒性。

集成学习中的Bagging算法优化实现

集成学习中的Bagging算法优化实现集成学习是一种机器学习领域的方法,它通过将多个弱分类器结合起来形成一个强分类器来提高预测准确性和稳定性。

Bagging 算法是集成学习中最受欢迎的方法之一,它通过对数据集进行有放回采样,构建多个子数据集,然后基于每个子数据集构建多个弱分类器,并通过投票的方式集成这些弱分类器的结果来提高分类效果。

本文主要讨论Bagging算法的优化实现方法。

一、Bagging算法的基本实现方法在介绍优化实现方法之前,我们首先来复习一下Bagging算法的基本实现方法。

Bagging算法的主要思路是通过构建多个子数据集和多个弱分类器来提高整体分类准确性和稳定性。

具体实现步骤如下:1. 对原始数据集进行有放回的随机采样,构建多个子数据集。

2. 对于每个子数据集,使用相同的算法来训练一个弱分类器。

3. 对于每个弱分类器,使用不同的随机样本对其进行评估,以降低过拟合的可能性。

4. 对于新的数据集,将每个弱分类器的预测结果进行合并,通过投票的方式来得到最终的分类结果。

这就是Bagging算法的基本实现方法。

然而,这个算法还存在一些问题,需要优化实现才能达到更好的效果。

二、Bagging算法的优化实现方法1. 随机选择特征Bagging算法会对原始数据集进行随机有放回采样,采样得到的数据集和原始数据集的样本数量相同,但是样本可能存在重复。

因此,在训练每一个弱分类器时,我们需要在特征上进行随机选择。

这样可以使得每个弱分类器都能够挖掘到数据集的不同方面,从而提高整体分类准确度和鲁棒性。

2. 加强弱分类器之间的差异化Bagging算法在构造每个弱分类器时采用相同的算法,而且使用了相同的样本。

因此,每个弱分类器之间的差异性可能不够大,这有可能限制了Bagging算法的性能。

为了加强弱分类器之间的差异化,我们可以使用不同的算法或者不同的参数来构建弱分类器,这样可以使得弱分类器之间的差异性更大,提高整体分类效果。

baggin算法

baggin算法Bagging算法是一种常用的集成学习方法,它通过组合多个弱学习器的预测结果来获得更准确的分类或回归结果。

在本文中,我们将详细介绍Bagging算法的原理、应用场景以及优缺点。

一、Bagging算法的原理Bagging算法的全称是Bootstrap aggregating,它的核心思想是通过有放回地从原始训练集中采样得到多个子训练集,然后使用这些子训练集分别训练出多个基学习器。

最后,通过对这些基学习器的预测结果进行投票(分类问题)或求平均(回归问题)来得到最终的预测结果。

具体来说,Bagging算法的步骤如下:1. 从原始训练集中有放回地进行采样,得到多个子训练集;2. 使用这些子训练集分别训练出多个基学习器;3. 对于分类问题,通过投票的方式确定最终的预测结果;对于回归问题,通过求平均的方式确定最终的预测结果。

二、Bagging算法的应用场景Bagging算法可以广泛应用于分类和回归问题。

对于分类问题,Bagging算法可以用于构建一个强大的分类器,从而提高分类的准确率;对于回归问题,Bagging算法可以用于构建一个强大的回归模型,从而提高回归的精度。

在实际应用中,Bagging算法常常与决策树作为基学习器相结合,形成Bagging决策树模型。

因为决策树具有易于理解和解释的特点,并且在处理复杂问题时能够取得不错的效果。

通过Bagging算法,可以进一步提升决策树的性能,使其更加稳定和准确。

三、Bagging算法的优缺点Bagging算法具有以下优点:1. Bagging算法能够降低模型的方差,提高模型的稳定性;2. Bagging算法能够有效地利用原始训练集,提高模型的泛化能力;3. Bagging算法简单易实现,不需要过多的参数调整。

然而,Bagging算法也存在一些缺点:1. Bagging算法无法降低模型的偏差,因此如果基学习器本身存在较大偏差,Bagging算法并不能完全解决这个问题;2. Bagging算法的训练过程需要进行多次采样和模型训练,因此计算复杂度较高。

P2P网络上的优化搜索算法研究

P2P网络上的优化搜索算法研究随着互联网的普及和发展,P2P(点对点)网络已经成为一种重要的资源共享和传输方式。

P2P网络是一种去中心化的网络模型,它通过连接各种节点,使得用户可以共享和传输信息、文件和资源。

然而,在P2P网络中进行有效的搜索依然是一个挑战,因为网络拓扑的分布性和节点自身的动态性。

因此,对P2P网络上的搜索算法进行优化研究是至关重要的。

优化搜索算法可以提高搜索性能,减少搜索时间,并提供更准确和全面的搜索结果。

本文将讨论P2P网络上的优化搜索算法的研究现状、挑战和解决方案。

首先,P2P网络中的搜索算法需要克服网络拓扑的分布性。

P2P网络由许多对等节点组成,这些节点可能分布在整个网络中。

搜索算法需要确定哪些节点具有所需资源并与之进行通信。

传统的搜索算法如随机搜索和基于邻居的搜索无法有效地解决这个问题。

因此,研究人员提出了许多基于索引和超节点的搜索算法。

这些算法通过建立索引和维护超节点列表来提高搜索效率。

索引可以帮助节点快速确定哪些节点具有所需资源,而超节点列表可以提供更高效的路由选择。

这些优化算法在实际应用中取得了显著的效果。

其次,P2P网络中的搜索算法还需要应对节点自身的动态性。

在P2P网络中,节点的加入和离开是常见的情况。

传统的搜索算法无法有效地处理节点动态变化所引起的问题。

为了解决这个问题,研究人员提出了许多动态扩展的搜索算法。

这些算法通过动态维护邻居列表和路由表来适应节点的动态变化。

一些算法还利用节点之间的信任关系来提高搜索效率。

这些动态扩展的搜索算法能够有效地适应节点的动态变化,提高搜索的准确性和效率。

此外,隐私和安全性也是P2P网络上的搜索算法需要考虑的重要问题。

在搜索过程中,用户需要将自己的搜索请求传递给其他节点,以寻找所需的资源。

然而,这种信息传递可能会引起隐私泄露和数据安全问题。

为了解决这个问题,研究人员提出了许多隐私保护和安全搜索的算法。

这些算法通过加密和匿名化技术来保护用户的隐私和搜索数据的安全。

详解Bagging算法的原理及Python实现

详解Bagging算法的原理及Python实现⽬录⼀、什么是集成学习⼆、Bagging算法三、Bagging⽤于分类四、Bagging⽤于回归⼀、什么是集成学习集成学习是⼀种技术框架,它本⾝不是⼀个单独的机器学习算法,⽽是通过构建并结合多个机器学习器来完成学习任务,⼀般结构是:先产⽣⼀组“个体学习器”,再⽤某种策略将它们结合起来,⽬前,有三种常见的集成学习框架(策略):bagging,boosting和stacking也就是说,集成学习有两个主要的问题需要解决,第⼀是如何得到若⼲个个体学习器,第⼆是如何选择⼀种结合策略,将这些个体学习器集合成⼀个强学习器集成学习是指将若⼲弱分类器组合之后产⽣⼀个强分类器。

弱分类器(weak learner)指那些分类准确率只稍好于随机猜测的分类器(error rate < 50%)。

如今集成学习有两个流派,⼀种是bagging流派,它的特点是各个弱学习器之间没有依赖关系,可以并⾏拟合,随机森林算法就属于bagging派系;另⼀个是boosting派系,它的特点是各个弱学习器之间有依赖关系,Adaboost算法就属于boosting派系。

在实现集成学习算法时,很重要的⼀个核⼼就是如何实现数据的多样性,从⽽实现弱分类器的多样性集成学习有如下的特点:(1)将多个分类⽅法聚集在⼀起,以提⾼分类的准确率(这些算法可以是不同的算法,也可以是相同的算法。

);(2)集成学习法由训练数据构建⼀组基分类器,然后通过对每个基分类器的预测进⾏投票来进⾏分类;(3)严格来说,集成学习并不算是⼀种分类器,⽽是⼀种分类器结合的⽅法;(4)通常⼀个集成分类器的分类性能会好于单个分类器;(5)如果把单个分类器⽐作⼀个决策者的话,集成学习的⽅法就相当于多个决策者共同进⾏⼀项决策。

Bagging和Boosting的使⽤区别如下:1)样本选择:Bagging:训练集是在原始集中有放回选取的,从原始集中选出的各轮训练集之间是独⽴的。

bagging分类法

bagging分类法

Bagging分类法是一种集成学习的方法,它通过结合多个分类

器的预测结果来提高整体分类的准确性和稳定性。

Bagging的全称

是Bootstrap Aggregating,它的基本思想是通过对训练数据进行

自助采样(bootstrap sampling),生成多个不同的训练数据子集,然后在每个子集上训练一个基分类器,最后通过投票或取平均值的

方式来整合这些基分类器的预测结果。

Bagging分类法的优势在于它可以降低模型的方差,提高模型

的泛化能力。

通过对训练数据进行自助采样,每个基分类器都是在

不同的数据子集上进行训练,这样可以使得每个基分类器都有一定

的差异性,从而提高整体分类器的多样性。

同时,由于每个基分类

器都是在不同的数据子集上进行训练,因此它们对训练数据的敏感

性较低,可以降低模型的方差,提高模型的稳定性和泛化能力。

在实际应用中,Bagging分类法通常与决策树等基分类器结合

使用,形成Bagging决策树(Bagging Decision Trees)或随机森

林(Random Forest)等集成学习模型。

这些模型在实际应用中取得

了很好的效果,被广泛应用于分类、回归等领域。

总之,Bagging分类法是一种有效的集成学习方法,通过结合

多个基分类器的预测结果,可以提高整体分类器的准确性和稳定性,是机器学习领域中的重要技术之一。

bagging的流程

bagging的流程Bagging是一种常用的集成学习方法,可以提高模型的预测准确度和稳定性。

下面将介绍Bagging的流程。

Bagging是Bootstrap Aggregating的缩写,即自助聚合。

它通过对原始数据集进行有放回的随机抽样,生成多个子数据集。

这些子数据集的大小与原始数据集相同,但是每个子数据集都是独立的。

接下来,针对每个子数据集,我们使用相同的学习算法构建一个基分类器(或回归器)。

这里的学习算法可以是决策树、神经网络、支持向量机等等。

通过对每个子数据集进行训练,我们得到了多个基分类器。

然后,将这些基分类器进行整合。

在分类问题中,我们可以通过投票的方式来决定最终的分类结果。

即对于一个新的样本,每个基分类器都对其进行预测,然后根据投票结果来确定最终的分类标签。

在回归问题中,我们可以将多个基回归器的预测结果取平均值作为最终的预测结果。

在整合基分类器的过程中,Bagging还可以通过引入随机性来增加模型的多样性。

例如,每个基分类器在训练时只能看到部分特征,或者只能看到部分样本。

这样可以减少基分类器之间的相关性,提高集成模型的泛化能力。

我们可以通过交叉验证等方法来评估Bagging模型的性能,并进行调参优化。

常见的评估指标包括准确率、精确率、召回率、F1值等。

总结起来,Bagging的流程可以概括为以下几个步骤:1. 从原始数据集中有放回地随机抽样,生成多个子数据集;2. 针对每个子数据集,使用相同的学习算法构建一个基分类器(或回归器);3. 将多个基分类器进行整合,得到最终的集成模型;4. 通过评估指标对集成模型进行性能评估和调参优化。

Bagging的优点在于可以降低模型的方差,提高模型的稳定性和泛化能力。

它适用于各种类型的机器学习问题,并且相对容易实现。

然而,Bagging也有一些限制,例如对于处理高维稀疏数据和处理类别不平衡的问题效果可能不佳。

除了Bagging,还有一些其他的集成学习方法,如Boosting和随机森林。

数据挖掘中的Bagging算法原理解析

数据挖掘中的Bagging算法原理解析数据挖掘是一门通过从大量数据中发现隐藏模式、关系和趋势来提取有用信息的领域。

在数据挖掘中,有许多算法被用于处理和分析数据。

其中之一是Bagging算法,它是一种集成学习方法,通过组合多个分类器来提高预测性能。

Bagging算法的全称是Bootstrap Aggregating,它的核心思想是通过对原始数据集进行有放回抽样(bootstrap sampling),生成多个不同的训练集,并在每个训练集上训练一个基分类器。

最后,通过对这些基分类器的预测结果进行投票或取平均来得到最终的预测结果。

Bagging算法的原理可以通过以下步骤来解析:1. 数据集的有放回抽样:首先,从原始数据集中随机抽取一部分样本,抽样过程中每个样本都有可能被重复选择,形成一个新的训练集。

这个过程称为有放回抽样,它可以保证每个样本都有一定的概率被选中,同时保持了原始数据集的规模。

2. 基分类器的训练:对于每个生成的训练集,使用一个基分类器进行训练。

基分类器可以是任何分类算法,如决策树、支持向量机等。

每个基分类器使用不同的训练集进行训练,因此它们之间具有一定的差异性。

3. 集成预测:当所有的基分类器都训练完成后,使用它们对新的样本进行预测。

对于分类问题,可以通过投票的方式来确定最终的预测结果。

对于回归问题,可以取基分类器预测结果的平均值作为最终的预测结果。

Bagging算法的优势在于它能够减少过拟合的风险,提高模型的泛化能力。

通过对原始数据集进行有放回抽样,Bagging算法可以生成多个训练集,每个训练集都是从原始数据集中独立采样得到的。

这样可以使得每个训练集都具有一定的差异性,从而减少了模型对训练集的过度拟合。

此外,Bagging算法还可以通过并行计算来加速模型的训练过程。

由于每个基分类器都是独立训练的,因此可以将它们分配到不同的计算节点上进行并行计算,从而提高训练速度。

然而,Bagging算法也存在一些限制。

bagging算法原理

bagging算法原理Bagging算法,又名自举平均法,是一种集成学习算法,它通过同时训练多个分类器来提高分类准确性。

该算法不仅适用于分类问题,也适用于回归问题。

Bagging算法的基本思想是,通过随机有放回的采样方法,从训练数据集中选取多个子集,训练出多个分类器。

然后,在分类时,分别利用这些分类器对新数据进行分类,并综合多个分类器的结果进行最终分类判定。

为了保证随机性,每个子集的大小都应该与原始数据集的大小相同,即每次采样的时候都应该随机选取原始数据集中的一定比例的数据。

这样,可以避免训练中对某些特定数据的依赖性,提高了算法的泛化能力和鲁棒性。

具体来说,Bagging算法的训练过程如下:1. 从原始数据集中,随机有放回地选取多个大小相同的子集。

2. 对于每个子集,训练一个分类器。

3. 在使用分类器分类新数据时,如果分类器采用的是投票决策规则,则最终的分类结果是多个分类器中选择出现次数最多的类别。

如果采用的是平均决策规则,则最终的分类结果是多个分类器对同一实例分类的结果取平均值。

Bagging算法的优点是可以显著提高分类准确性,特别是对于复杂的分类问题。

同时,由于每个子集的训练过程相对独立,可以并行处理,加快训练速度。

此外,由于采用了随机性,Bagging算法对于数据中的噪声和异常值具有很好的鲁棒性。

然而,Bagging算法也存在一些缺点,例如随机采样有可能导致一些样本没有被选中,从而遗漏了一些重要信息。

此外,在某些情况下,多个分类器的组合并不能提高分类准确率。

总之,Bagging算法是一种简单而有效的集成学习算法,广泛应用于各种分类问题中。

在进行实际应用时,需要根据具体情况选择合适的决策规则,避免过拟合等问题。

bagging法和boosting法

bagging法和boosting法

Bagging(Bootstrap Aggregating)和Boosting是两种常用的集成学习方法,它们都旨在通过结合多个模型的预测来提高性能。

Bagging是一种随机化集成学习方法,通过在每次训练过程中使用有放回的抽样(bootstrap抽样)来创建多个模型,并对每个模型进行独立的训练。

Bagging通过结合这些模型的预测来降低模型的方差,从而提高模型的稳定性和准确性。

在Bagging中,通常使用基学习器(base learner)作为单个模型,例如决策树、随机森林等。

Boosting是一种迭代的方法,它通过逐步构建一系列弱模型来逐步改进预测结果。

在每次迭代中,Boosting会根据当前模型的预测结果来调整下一次迭代的训练数据和权重,使得模型能够更好地学习到数据中的特征和模式。

Boosting通常使用加权和的方法来组合多个模型,其中每个模型的权重可以根据其性能进行动态调整。

在Boosting中,常用的基学习器包括AdaBoost算法和Gradient Boosting算法等。

这两种方法各有优缺点。

Bagging通常更加稳定,能够更好地处理高维数据和复杂的数据分布,但可能无法充分利用弱模型的潜力。

Boosting则可以更好地利用弱模型的优点,逐步改进预测结果,但可能对数据分布的敏感性较高,需要更多的调参工作。

在实际应用中,可以根据具体的问题和数据特点选择适合的方法。

机器学习中的集成学习算法

机器学习中的集成学习算法机器学习是目前非常热门的研究领域。

在机器学习中,集成学习算法尤为重要。

集成学习算法是指通过将多个不同的学习算法结合起来,来提高模型的性能和泛化能力。

本文将会介绍集成学习算法的概念、分类以及具体应用等内容。

一、集成学习算法的概念集成学习算法是一种将多个分类器组合起来,以提高学习算法的性能和泛化能力的方法。

其根据不同的机器学习算法,通过实现不同的策略来改进分类器的准确性。

这些算法的主要目的是减少过拟合和提高鲁棒性,它们通过整合来自不同算法的信息,从而提高整体性能。

二、集成学习的分类根据集成学习算法的实现原理,可以将其划分为三类:bagging(套袋法)、boosting(提升法)和stacking(堆叠法)。

1. BaggingBagging是一种并行的集成学习方法。

它的原理是基于不同的训练集对分类器进行训练,并对结果进行平均(以分类问题为例),以提高分类器的准确性。

Bagging依赖于构造大量的分类器并将它们的结果合并,从而使得模型更具鲁棒性和泛化能力。

2. BoostingBoosting是目前应用最广泛的集成学习方法之一。

Boosting的工作原理是一种按序列引入数据的方法。

它的实现方法是生成一系列的基分类器,并将它们按照一定的权重组合来提高模型的准确性。

Boosting技术就是不断得学习如何在错误中提高模型的准确性的过程。

缺点是Boosting几乎总是会导致过度拟合问题,而且对训练数据过于敏感。

3. StackingStacking是一种堆叠的学习方法,它通过堆叠不同分类器的输出来构建一个新的分类器。

Stacking的实现方法是基于不同的学习算法来生成若干个分类器。

这些分类器由不同的特征子集和训练数据子集构成。

最终,在训练数据上生成的分类器组成一个新的分类器来提高分类的准确性。

三、集成学习算法的具体应用集成学习算法可以应用于各种机器学习问题,包括分类和回归。

以下是一些常见的应用:1. 图像识别图像识别是一个受欢迎的研究领域。

集成学习算法总结----Boosting和Bagging

集成学习算法总结----Boosting和Bagging集成学习基本思想:如果单个分类器表现的很好,那么为什么不适⽤多个分类器呢?通过集成学习可以提⾼整体的泛化能⼒,但是这种提⾼是有条件的:(1)分类器之间应该有差异性;(2)每个分类器的精度必须⼤于0.5;如果使⽤的分类器没有差异,那么集成起来的分类结果是没有变化的。

如下图所⽰,分类器的精度p<0.5,随着集成规模的增加,分类精度不断下降;如果精度⼤于p>0.5,那么最终分类精度可以趋向于1。

接下来需要解决的问题是如何获取多个独⽴的分类器呢?我们⾸先想到的是⽤不同的机器学习算法训练模型,⽐如决策树、k-NN、神经⽹络、梯度下降、贝叶斯等等,但是这些分类器并不是独⽴的,它们会犯相同的错误,因为许多分类器是线性模型,它们最终的投票(voting)不会改进模型的预测结果。

既然不同的分类器不适⽤,那么可以尝试将数据分成⼏部分,每个部分的数据训练⼀个模型。

这样做的优点是不容易出现过拟合,缺点是数据量不⾜导致训练出来的模型泛化能⼒较差。

下⾯介绍两种⽐较实⽤的⽅法Bagging和Boosting。

Bagging(Bootstrap Aggregating)算法Bagging是通过组合随机⽣成的训练集⽽改进分类的集成算法。

Bagging每次训练数据时只使⽤训练集中的某个⼦集作为当前训练集(有放回随机抽样),每⼀个训练样本在某个训练集中可以多次或不出现,经过T次训练后,可得到T个不同的分类器。

对⼀个测试样例进⾏分类时,分别调⽤这T个分类器,得到T个分类结果。

最后把这T个分类结果中出现次数多的类赋予测试样例。

这种抽样的⽅法叫做,就是利⽤有限的样本资料经由多次重复抽样,重新建⽴起⾜以代表原始样本分布之新样本。

Bagging算法基本步骤:因为是随机抽样,那这样的抽样只有63%的样本是原始数据集的。

Bagging的优势在于当原始样本中有噪声数据时,通过bagging抽样,那么就有1/3的噪声样本不会被训练。

非结构化P2P网络的一种改进搜索算法

关键词 : 非结构化 P 2 P网络 ;洪泛法 ;冗余 查询 包;搜 索算法 ; 模 拟

中图分 类号 : T P 3 9 3 文献标识码 : A d o i : 1 0 . 3 9 6 9 / j . i s5 . 2 0 1 3 . 1 2 . 0 1 2

主要的搜索算法 _ 6 。洪泛法 的优点是 算法思想简 单, 但是一个致命 的缺陷是会产生冗余的查询数据包 ( 下文中简称查 询包 ) , 大量 的冗余查询信 息可能成 为网络瓶颈而限制 网络的性能 , 比如网络中资料利用 率的下降和搜索效率的降低 [ 8 。 。 。

2 0 1 3年第 1 2期 文章编号 : 1 0 0 6 - 2 4 7 5 ( 2 0 1 3 ) 1 2 - 0 0 4 4 - 0 4

计 算 机 与 现 代 化 J I S U A N J I Y U X I A N D A I H U A

总第 2 2 0期

非结构化 P 2 P网络 的一 种 改 进 搜 索算 法

叶 培顺

( 榆 林学院信 息工程学院 , 陕西 榆林 7 1 9 0 0 0 ) 摘要 : 分析非结构化 P 2 P网络 中利 用原始 的洪泛法进行 资源搜 索时产生冗余查询 包的原 因, 提 出整 改的措 施和优化 的机

制, 在此基础上给 出改进 的搜 索策略 , 同时设计 出一种更好的分段搜 索算法 , 并对其进行 实验仿 真, 通过 和洪泛 法的模 拟

I m pr o v e d S e a r c h Al g o r i t h m f o r Uns t r uc t ur e d P2 P Ne t wo r k

YE Pe i . s h u n

关于bagging算法的描述

关于bagging算法的描述摘要:一、Bagging算法简介1.背景介绍2.算法原理二、Bagging算法的应用1.数据预处理2.特征选择3.模型训练与评估三、Bagging算法的优缺点1.优点2.缺点四、Bagging算法在实际项目中的应用案例1.案例介绍2.案例分析正文:【一、Bagging算法简介】1.背景介绍Bagging(Bootstrap Aggregating,引导聚合)算法是一种基于决策树的可扩展集成学习方法。

它通过有放回抽样生成多个子数据集,并对每个子数据集进行独立训练得到基学习器。

再对基学习器的预测结果进行平均或投票,得到最终的预测结果。

2.算法原理Bagging算法主要包含以下几个步骤:(1)有放回抽样:从原始数据集中抽取一定比例的样本,组成子数据集。

(2)特征选择:在每个子数据集上进行特征选择,选取与目标变量相关的特征。

(3)决策树生成:在每个子数据集上利用选取的特征构建决策树。

(4)基学习器训练与预测:对每个子数据集生成的决策树进行训练,并用训练好的基学习器对测试集进行预测。

(5)预测结果整合:对基学习器的预测结果进行平均或投票,得到最终的预测结果。

【二、Bagging算法的应用】1.数据预处理在实际应用中,Bagging算法可以用于数据预处理,如缺失值填充、异常值处理等。

通过有放回抽样生成多个子数据集,可以降低原始数据集中异常值对模型训练的影响,提高模型的泛化能力。

2.特征选择Bagging算法可以在每个子数据集上进行特征选择,选取与目标变量相关的特征。

这有助于降低特征维度,提高模型训练效率。

3.模型训练与评估Bagging算法可以用于构建集成学习模型,如随机森林、梯度提升树等。

通过对多个子数据集进行独立训练,可以提高基学习器的多样性,从而提高集成学习模型的泛化能力。

同时,对基学习器的预测结果进行平均或投票,可以降低单个基学习器过拟合的风险。

【三、Bagging算法的优缺点】1.优点(1)降低过拟合:Bagging算法通过对原始数据进行有放回抽样,降低基学习器过拟合的风险。

如何理解Boosting和Bagging【面试经验】

如何理解Boosting和Bagging?他们有什么异同?【面试经验】Boosting和Bagging是机器学习中的两种集成学习方法,它们通过组合多个弱学习器来创建一个强学习器,从而提高预测性能。

虽然它们的目标相似,但它们在实现方式和策略上有所不同。

1.Boosting:Boosting方法通过迭代地训练弱学习器,并在每次迭代中增加对之前错误分类样本的权重,从而关注那些被错误分类的样本。

每个新的弱学习器都试图纠正前一个学习器的错误。

最终,这些弱学习器的预测结果通过加权的方式进行组合,以产生最终的预测结果。

一个著名的Boosting算法是AdaBoost。

2.Bagging:与Boosting不同,Bagging方法通过从原始数据集中随机抽取多个子集,并在每个子集上独立地训练一个弱学习器。

这些弱学习器的预测结果最后通过投票或平均的方式进行组合,以产生最终的预测结果。

由于每个子集都是随机抽取的,因此Bagging有助于减少模型的方差,并提高模型的稳定性。

随机森林是Bagging的一个著名实现。

异同点:•相似之处:Boosting和Bagging都是集成学习方法,它们通过组合多个弱学习器来提高预测性能。

•不同之处:1.样本选择:Boosting在每次迭代中都会调整样本的权重,关注被错误分类的样本;而Bagging则通过随机抽样来生成不同的训练子集。

2.预测函数:Boosting中的弱学习器通常具有不同的权重,这些权重根据它们在前一轮的表现进行调整;而Bagging中所有弱学习器的权重通常是相等的。

3.并行计算:由于Bagging中的弱学习器是独立训练的,因此它们可以并行生成;而Boosting中的弱学习器是顺序生成的,因为它们依赖于前一个学习器的结果。

4.方差与偏差:从方差-偏差分解的角度看,Bagging主要关注降低模型的方差,因此它在易受样本扰动的学习器上效用更为明显;而Boosting则主要关注降低模型的偏差,通过不断纠正错误来改进预测性能。

bagging,boosting,stacking基本流程

bagging,boosting,stacking基本流程

以下是bagging、boosting、stacking三种集成学习方法的流程:

1. Bagging:

从原始样本集中使用Bootstraping方法随机抽取n个训练样本,共进行k 轮抽取,得到k个训练集(k个训练集之间相互独立,元素可以有重复)。

对于抽取的k个训练集,可以训练出k个模型。

对于分类问题,由投票表决产生的分类结果。

2. Boosting:

对训练集中的每个样本建立权值wi,表示每个样本的权重。

在随后的运算中,对于被错误分类的样本,权重会在下一轮的分类中获得

更大的权重。

对于误差率较小的弱学习器,加大权值,使其在表决中起到更大的作用。

对于误差率较大的弱学习器,减小权值,使其在表决中起到较小的作用。

Boosting算法基于错误提升模型性能,根据前面分类器分类错误的样本,调整训练集中各个样本的权重,构建新的分类器。

其训练过程是呈阶梯状的,后一个基模型会在前一个基模型的基础上进行学习,最终以某种综合方式,比如加权法,对所有模型的预测结果进行加权来产生最终的结果。

3. Stacking:

将训练数据D划分为两个不相交的子集D1,D2。

用训练集的第一部分D1训练多个不同的基模型。

将多个基模型用于预测训练集的第二部分D2。

将基模型的预测结果当作输入,D2的样本标签当作学习目标,训练一个高层的模型。

以上是三种集成学习方法的基本流程,请注意这些方法各有特点,适用于不同的情况和问题类型。

在实际应用中需要根据具体需求和数据特点来选择合适的方法。

用于P2P流媒体识别的类增量学习算法

用于P2P 流媒体识别的类增量学习算法李 进,张 鑫,王 晖(国防科学技术大学信息系统与管理学院,长沙 410073)摘 要:针对P2P 流媒体流量识别中的类增量学习问题,提出一种基于“一对一”支持向量机多分类器的类增量学习算法CIOOL 。

充分利用原有多分类器知识,在不打破原有分类器体系的前提下加入新增类样本知识,以构造出新的多分类器。

实验结果表明,CIOOL 算法能在保证识别精度的同时减少训练时间和内存消耗,是一种解决P2P 流媒体流量识别中类增量问题的有效方法。

关键词关键词::P2P 流媒体识别;类增量学习;一对一;支持向量机;CIOOL 算法Class Incremental Learning Algorithmfor P2P Streaming Media IdentificationLI Jin, ZHANG Xin, W ANG Hui(College of Information System & Management, National University of Defense Technology, Changsha 410073, China)【Abstract 】This paper studies class incremental learning of P2P streaming traffic identification by using one-against-one Support Vector Machine(SVM) multi-classification. A new SVM class incremental learning algorithm ——Class Incremental One-against-One Learning(CIOOL) is presented. CIOOL can adequately use former knowledge to construct a new multi-classifier without training over again. Experimental results indicate that CIOOL can decrease the time of training and memory consuming, and it is an effective algorithm to solve the problem of class incremental learning in P2P streaming traffic identification.【Key words 】P2P streaming media identification; class incremental learning; one-against-one; Support Vector Machine(SVM); CIOOL algorithm DOI: 10.3969/j.issn.1000-3428.2011.20.053计 算 机 工 程 Computer Engineering 第37卷 第20期V ol.37 No.20 2011年10月October 2011·人工智能及识别技术人工智能及识别技术·· 文章编号文章编号::1000—3428(2011)20—0154—03 文献标识码文献标识码::A中图分类号中图分类号::TN919.851 概述近年来,P2P 流媒体应用在互联网上迅速流行,很快聚集了庞大的用户群;但是这些基于P2P 架构的应用平台占用了大量的网络带宽,并且带来了版权侵犯、非法内容传播等一系列的问题,给网络管理提出了巨大的挑战。

非结构化P2P网络的一种改进搜索算法

非结构化P2P网络的一种改进搜索算法叶培顺【期刊名称】《计算机与现代化》【年(卷),期】2013(0)12【摘要】分析非结构化P2 P网络中利用原始的洪泛法进行资源搜索时产生冗余查询包的原因,提出整改的措施和优化的机制,在此基础上给出改进的搜索策略,同时设计出一种更好的分段搜索算法,并对其进行实验仿真,通过和洪泛法的模拟分析比较,表明改进后算法的高效性和可行性。

%This paper analyzes the reasons for that generating redundant query packet in unstructured P 2P network by using the o-riginal flooding search mechanism to search resources , puts forward improvement measures and optimization mechanisms .Based on above, this paper gives some improved search strategies to design a better segment search algorithm , and the experimental sim-ulation is implemented for the simulationanalysis .Comparison between the flooding search algorithm and the segment search algo -rithm is made, and it shows the feasibility and efficiency of the improved algorithm .【总页数】4页(P44-47)【作者】叶培顺【作者单位】榆林学院信息工程学院,陕西榆林 719000【正文语种】中文【中图分类】TP393【相关文献】1.非结构化P2P网络搜索算法的研究与改进 [J], 袁静波;石鸿伟;丁顺利2.改进的非结构化P2P网络搜索算法 [J], 戴建勇;蔡勇3.一种非结构化P2P网络的资源搜索算法 [J], 李林校;王芳;郑明春4.一种基于反馈的非结构化P2P网络搜索算法 [J], 冯明星;5.一种基于反馈的非结构化P2P网络搜索算法 [J], 冯明星因版权原因,仅展示原文概要,查看原文内容请购买。

用于P2P流媒体识别的类增量学习算法

用于P2P流媒体识别的类增量学习算法李进;张鑫;王晖【期刊名称】《计算机工程》【年(卷),期】2011(037)020【摘要】针对P2P流媒体流量识别中的类增量学习问题,提出一种基于“一对一”支持向量机多分类器的类增量学习算法CIOOL.充分利用原有多分类器知识,在不打破原有分类器体系的前提下加入新增类样本知识,以构造出新的多分类器.实验结果表明,CIOOL算法能在保证识别精度的同时减少训练时间和内存消耗,是一种解决P2P流媒体流量识别中类增量问题的有效方法.%This paper studies class incremental learning of P2P streaming traffic identification by using one-against-one Support VectorMachine(SVM) multi-classification. A new SVM class incremental learning algorithm--Class Incremental One-against-One Learning(CIOOL) ispresented. CIOOL can adequately use former knowledge to construct a new multi-classifier without training over again. Experimental results indicate that CIOOL can decrease the time of training and memory consuming, and it is an effective algorithm to solve the problem of class incremental learning in P2P streaming traffic identification.【总页数】3页(P154-156)【作者】李进;张鑫;王晖【作者单位】国防科学技术大学信息系统与管理学院,长沙410073;国防科学技术大学信息系统与管理学院,长沙410073;国防科学技术大学信息系统与管理学院,长沙410073【正文语种】中文【中图分类】TN919.85【相关文献】1.基于SVM增量学习算法的煤矿高压断路器故障模式识别方法 [J], 耿蒲龙;宋建成;赵钰;高云广;郑丽君;呼守信2.基于SVM增量学习的P2P流媒体流量识别策略分析 [J], 滕翠;梁川;邓秀娟3.浅谈增量学习支持向量机图像识别算法的设计 [J], 廖隽婷;施荣华4.增量学习算法对文本情感识别模型的改进 [J], 庞娜5.基于增量学习的合成孔径雷达目标识别算法 [J], 郭晨龙;仇振安;孙瑞彬因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

应用于P2P流分类的一种改进Bagging学习算法摘要:集成学习算法的效果取决于各个基分类器,如何构造有效的基分类器是关键。

对集成学习算法中的Bagging算法进行了研究,提出了一种基于层次抽样构造SVM基分类器的方法进行P2P流分类,并通过实验验证了该方法的有效性。

关键词关键词:集成学习算法;层次抽样;Bagging;P2P 流中图分类号:TP312文献标识码:A文章编号文章编号:16727800(2014)005007103作者简介作者简介:丁里(1989-),男,江南大学物联网工程学院硕士研究生,研究方向为基于机器学习的网络流分类。

0引言网络流的分类是分析网络用户行为、检测网络异常行为和提高服务质量等行为的前提和基础。

P2P流量爆发式的增长和不加限制的宽带使用已经使其成为Internet流量的主体,其丰富的应用吞噬网络带宽,使网络拥塞现象日益严重[1]。

由此,如何识别和控制P2P流量,已经成为运营和管理者面临的挑战性问题。

作为机器学习算法中的重要一员,利用集成学习算法来进行网络流分类已经越来越受到重视。

集成学习算法主要分为Boosting[2]算法和Bagging[3]算法。

Boosting算法(以AdaBoosting算法为例)的基本原理是按样本权重抽样,不断迭代训练基分类器,改变训练样本权重分布,来得到一系列弱分类器,并赋予每个基分类器权重组合提升成一个强分类器。

文献[5]使用AdaBoostSVM对Moore[6]数据集分类,整体准确率达到95%。

文献[7]提出AdaBoost+C4.5算法结合一种特征选择策略,在Moore网络流数据集上的整体分类正确率达到了99%。

Bagging算法主要通过有放回重复抽样(bootstrap sampling),训练足够多的基分类器,进行投票选择。

文献[4]研究表明,Bagging可以显著提高不稳定的基学习器的泛化能力。

这要求基分类器的学习算法必须是不稳定的,即算法对训练数据敏感。

因此,本文采用支持向量机中(SVM)的CSVM作为Bagging的基分类器学习算法。

Bagging学习算法采用简单随机抽样,具有较大的随机猜测性,然而根据大数定律,当基分类器足够多时,Bagging 算法可以达到任意精度[8]。

由于随机抽样的盲目性,训练过程中不可避免出现一些分类效果很弱的分类器,减缓了强分类器的集成效率,为此需要对分类器组合问题进行研究。

文献[8]总结了分类器组合的两个研究思路:其一,对已训练好的多个基分类器,通过某种组合策略达到最佳;其二,改善训练各个基分类器的过程来提升分类器效果。

文献[9]对第一个思路进行研究,提出了删除最差基学习器来层次化修剪Bagging组合分类器,通过删除基分类器,用较少的分类器个数就能达到甚至超过原来分类器规模所能达到的效果。

依据思路二,本文提出用一种层次抽样的抽样策略来优化训练过程,使得每次训练的基分类器都具有较高的分类正确率,并且依据分层进行了减噪式抽样,从一定程度上提高了Bagging集成效率。

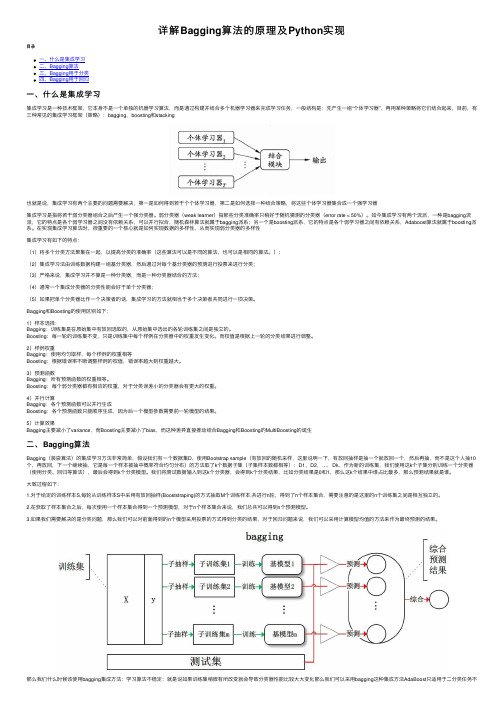

1Bagging学习算法流程Bagging学习流程如图1所示,包括网络流数据集、特征选择、训练基分类器和投票选择分类。

(1)网络流数据集。

网络流数据集中包含大量P2P流和非P2P流,将P2P流和非P2P流按一定比例提取出来构成初始样本。

(2)特征选择。

以特征选择算法对网络流数据集进行降维。

(3)训练基分类器。

采用某种的抽样策略抽取一定数量的训练样本训练一个单分类器,重复训练得到足够多的基分类器。

(4)投票选择。

每个基分类器对测试样本进行投票得到其分类标签。

2特征选择本文采用基于CFS评估函数的贪婪逐步搜索特征选择算法对数据集进行降维。

为了不依赖端口号,事先去掉端口号特征(序号1,2特征)。

CFS(Correlationbased Feature Subset)[12]是一种常用的特征子集评估函数,其对特征子集的评估函数的计算公式为:Rs=k*cf/k+k*(k-1)*ff(1)其中,s表示含有k个特征的特征子集,Rs是对特征子集s相关度的一个评估结果;cf是类与特征之间的平均相关度;ff 是特征与特征之间的平均相关度。

基于CFS的贪婪逐步搜索算法选择的特征编号如下:{3,63,65,79,90,94,102,121,163,209},其中每个特征的含义参考文献[6]。

3BaggingSVM分类器模型支持向量机(SVM)[10]由Cortes和Vapnik于1995年首先提出,它建立在统计学习理论的VC 维理论和结构风险最小原理基础上,根据有限的样本信息在模型的复杂性(即对特定训练样本的学习精度,Accuracy)和学习能力(即无错误地识别任意样本的能力)之间寻求最佳折衷,以期获得最好的泛化能力。

3.1基于SVM的Bagging集成算法Bagging算法主要采用Bootstrap方法进行有放回随机采样,Bootstrap抽样是Efron在1979、1981和1982年的工作中引入和发展起来的方法,其通过再抽样对总体分布进行估计,再抽样方法将观测到的样本视为一个有限总体,从中进行随机有放回抽样来估计总体的特征并对抽样总体作出统计推断。

BaggingSVM算法流程如下:输入:S={(Xi,yi)|Xi∈Rn,yi∈Y={1,-1},i=1,2,...,N},T,//S是训练样本集,T是基分类器个数输出:强分类器l(xi)Do for t=1,2,…,T步骤1:从训练样本中等概率有放回抽样(bootstrap sampling)取得M个样本。

步骤2:根据M个样本训练得到弱分类器ht。

步骤3:计算ht的训练误差εt=∑M1i=1ptiδ(lt(xi)≠lt-1(xi)),lt(xi)为第t步中样本点xi的类别标签。

步骤4:if εt>0.5 then 置ht投票权重为kt=-1,else 置ht投票权重为kt=1。

end if返回步骤1。

步骤5:得出最终强分类器l(xi)=arg[∑T1t=1ktht(xi)]3.2GSBaggingSVMBagging的简单随机抽样不但没有考虑基分类器的训练效果,也没有进行噪声处理,本文提出一种改进的抽样方法,即在Bagging之前先进行分层抽样(Group Sampling),分层抽样使得每个训练集具有一定的代表性,既能训练出效果较好的基分类器,同时在每个层的抽样过程中维持bootstrap sampling,保持了分类器的泛化性能。

并且根据每一层的特点,定义了含噪声层,通过减少在该层的抽样比重来减小噪声的影响。

把所有样本放到欧式空间中,计算两类样本的中心向量C1、C2:Ci=11|Ci|∑|Ci|1j=1Xj,i=1,2(2)计算每个类中各样本到中心向量的欧式距离:dij=||Xj-Ci||(i=1,2;j=1,2,...,|Ci|)(3)按照距离对训练集等量分层(保持每层样本总量相等),认为越靠后的层,包含噪声的可能性越大,故通过减少靠后层抽样比重来达到减噪的目的,在减噪过程中,为了保持类的平衡性,仅对大类进行减噪。

算法流程如下:输入:S={(Xi,yi)|Xi∈Rn,yi∈Y={1,-1},i=1,2,...,N},T,//S是训练样本集,T是基分类器个数输出:强分类器l(xi)步骤1:分布计算C1类(大类)、C2类向量c1、c2。

对于C1类中的样本X1i计算其到c1的距离d1i,按照距离从小到大排序得到{d1n},将{d1n}分成K层(以K=5为例,前4层每层抽取该层样本数量100%,最后一层抽取该层样本数的50%,每层抽样仍然保持bootstrap抽样);对于C2类中的样本S2i计算其到c2的距离d2i,按照距离大小排序的得到{d2n},将{d2n}分成K层(每层采用bootstrap抽样该层总数的100%)。

Do for t=1,2,…,T步骤2:按比重进行层次抽样得到M个样本。

步骤3-6与3.1节步骤2-5相同。

4实验验证与分析4.1实验数据本文采用Moore[12]等人为流分类专门制作的数据,如表1所示。

该数据集采自3个生物学研究所共享的网络出口,包含377 526个网络流,被分成10种类型;每条网络流由249个特征组成,其中最后一个特征表示流的类别。

从Moore 数据集中抽取一定数量的P2P流和一定数量的非P2P流构成训练集和测试集。

表1数据集数据集1P2P流1Other流1总流数训练样本集11 86715 64817 515测试样本集1305142217274.2评估策略在基于机器学习的流量分类研究中,模型评估是指在测试数据集上运行流量分类模型,并根据运行结果预估分类模型在未知数据集上处理流量分类问题的能力。

对任意类型i定义如下概念:(1)真正TP(true positive):实际类型为i的样本中被分类模型正确预测的样本数,TPi=nii。

(2)假负FN(false negative):实际类型为i的样本中被分类模型误判为其它类型的样本数,FNi=∑j≠inij。

(3)假正FP(false positive):实际类型为非i的样本中被分类模型误判为类型i的样本数量FPi=∑j≠inji。

基于以上概念,给出衡量分类模型准确性的3个常用指标:类准确率(accuracy)和整体准确率(overall accuracy)的形式化描述。

类i的准确率:Ai=TPi1TPi+FNi(4)整体准确率:OA=∑m1i=1TPi1∑m1i=1(TPi+FNi)(5)在上述评估指标中,类的准确率为在类的所有样本中被分类模型正确预测的样本所占比例。

分类模型的整体准确率代表了分类模型正确预测样本数在预测总数中的比例。

4.3实验结果在不同分类器个数下分类整体准确率比较如表2所示。

表2整体正确率比较分类器数目(个)1BaggingSVM(%)1GSBaggingSVM(%)1AdaboostSVM(%)M=5192.59194.55193.74M=11194.53196.22195.03M=17195.9 2197.43196.34M=23196.97197.88197.38混入10%噪声(约500条ATTACK流)后分类准确率比较如表3所示。

表3混入噪声后整体准确率比较分类器数目(个)1BaggingSVM(%)1GSBaggingSVM(%)1AdaboostSVM(%)M=5190.15192.24190.42M=11192.43194.35193.47M=17193.3 9195.76194.61M=23194.06196.55195.79通过表3可以看到,随着分类器个数的增加,Bagging算法的效果不断提升,但是在相同分类器数目下,GSBagging要比Bagging平均高出1%~2%,而AdaBoost算法的效果与Bagging算法接近,说明层次抽样提升了Bagging的集成效率。