LVS keepalived负载均衡高可用 配置安装大全

负载均衡--LVS+Keepalived

利用LVS+Keepalived 实现高性能高可用负载均衡作者:NetSeek 网站: 背景:随着你的网站业务量的增长你网站的服务器压力越来越大?需要负载均衡方案!商业的硬件如F5又太贵,你们又是创业型互联公司如何有效节约成本,节省不必要的浪费?同时实现商业硬件一样的高性能高可用的功能?有什么好的负载均衡可伸张可扩展的方案吗?答案是肯定的!有!我们利用LVS+Keepalived基于完整开源软件的架构可以为你提供一个负载均衡及高可用的服务器。

一.L VS+Keepalived 介绍1.LVSLVS是Linux Virtual Server的简写,意即Linux虚拟服务器,是一个虚拟的服务器集群系统。

本项目在1998年5月由章文嵩博士成立,是中国国内最早出现的自由软件项目之一。

目前有三种IP负载均衡技术(VS/NA T、VS/TUN和VS/DR);八种调度算法(rr,wrr,lc,wlc,lblc,lblcr,dh,sh)。

2.KeepalviedKeepalived在这里主要用作RealServer的健康状态检查以及LoadBalance主机和BackUP主机之间failover的实现二. 网站负载均衡拓朴图.IP信息列表:名称IPLVS-DR-Master 61.164.122.6LVS-DR-BACKUP 61.164.122.7LVS-DR-VIP 61.164.122.8WEB1-Realserver 61.164.122.9WEB2-Realserver 61.164.122.10GateWay 61.164.122.1三. 安装LVS和Keepalvied软件包1. 下载相关软件包#mkdir /usr/local/src/lvs#cd /usr/local/src/lvs#wget /software/kernel-2.6/ipvsadm-1.24.tar.gz #wget /software/keepalived-1.1.15.tar.gz2. 安装LVS和Keepalived#lsmod |grep ip_vs#uname -r2.6.18-53.el5PAE#ln -s /usr/src/kernels/2.6.18-53.el5PAE-i686/ /usr/src/linux#tar zxvf ipvsadm-1.24.tar.gz#cd ipvsadm-1.24#make && make install#find / -name ipvsadm # 查看ipvsadm的位置#tar zxvf keepalived-1.1.15.tar.gz#cd keepalived-1.1.15#./configure && make && make install#find / -name keepalived # 查看keepalived位置#cp /usr/local/etc/rc.d/init.d/keepalived /etc/rc.d/init.d/#cp /usr/local/etc/sysconfig/keepalived /etc/sysconfig/#mkdir /etc/keepalived#cp /usr/local/etc/keepalived/keepalived.conf /etc/keepalived/#cp /usr/local/sbin/keepalived /usr/sbin/#service keepalived start|stop #做成系统启动服务方便管理.四. 配置LVS实现负载均衡1.LVS-DR,配置LVS脚本实现负载均衡#vi /usr/local/sbin/lvs-dr.sh#!/bin/bash# description: start LVS of DirectorServer#Written by :NetSeek GW=61.164.122.1# website director vip.SNS_VIP=61.164.122.8SNS_RIP1=61.164.122.9SNS_RIP2=61.164.122.10./etc/rc.d/init.d/functionslogger $0 called with $1case "$1" instart)# set squid vip/sbin/ipvsadm --set 30 5 60/sbin/ifconfig eth0:0 $SNS_VIP broadcast $SNS_VIP netmask 255.255.255.255 broadcast $SNS_VIP up/sbin/route add -host $SNS_VIP dev eth0:0/sbin/ipvsadm -A -t $SNS_VIP:80 -s wrr -p 3/sbin/ipvsadm -a -t $SNS_VIP:80 -r $SNS_RIP1:80 -g -w 1/sbin/ipvsadm -a -t $SNS_VIP:80 -r $SNS_RIP2:80 -g -w 1touch /var/lock/subsys/ipvsadm >/dev/null 2>&1;;stop)/sbin/ipvsadm -C/sbin/ipvsadm -Zifconfig eth0:0 downifconfig eth0:1 downroute del $SNS_VIProute del $SS_VIPrm -rf /var/lock/subsys/ipvsadm >/dev/null 2>&1echo "ipvsadm stoped";;status)if [ ! -e /var/lock/subsys/ipvsadm ];thenecho "ipvsadm stoped"exit 1elseecho "ipvsadm OK"fi;;*)echo "Usage: $0 {start|stop|status}"exit 1esacexit 02.配置Realserver脚本.#vi /usr/local/sbin/realserver.sh#!/bin/bash# description: Config realserver lo and apply noarp#Written by :NetSeek SNS_VIP=61.164.122.8. /etc/rc.d/init.d/functionscase "$1" instart)ifconfig lo:0 $SNS_VIP netmask 255.255.255.255 broadcast $SNS_VIP/sbin/route add -host $SNS_VIP dev lo:0echo "1" >/proc/sys/net/ipv4/conf/lo/arp_ignoreecho "2" >/proc/sys/net/ipv4/conf/lo/arp_announceecho "1" >/proc/sys/net/ipv4/conf/all/arp_ignoreecho "2" >/proc/sys/net/ipv4/conf/all/arp_announcesysctl -p >/dev/null 2>&1echo "RealServer Start OK";;stop)ifconfig lo:0 downroute del $SNS_VIP >/dev/null 2>&1echo "0" >/proc/sys/net/ipv4/conf/lo/arp_ignoreecho "0" >/proc/sys/net/ipv4/conf/lo/arp_announceecho "0" >/proc/sys/net/ipv4/conf/all/arp_ignoreecho "0" >/proc/sys/net/ipv4/conf/all/arp_announceecho "RealServer Stoped";;*)echo "Usage: $0 {start|stop}"exit 1esacexit 0或者采用secondary ip address方式配置# vi /etc/sysctl.confnet.ipv4.conf.lo.arp_ignore = 1net.ipv4.conf.lo.arp_announce = 2net.ipv4.conf.all.arp_ignore = 1net.ipv4.conf.all.arp_announce = 2#sysctl –p#ip addr add 61.164.122.8/32 dev lo#ip add list 查看是否绑定3. 启动lvs-dr脚本和realserver启本,在DR上可以查看LVS当前状态:#watch ipvsadm –ln五.利用Keepalvied实现负载均衡和和高可用性1.配置在主负载均衡服务器上配置keepalived.conf#vi /etc/keepalived/keepalived.conf! Configuration File for keepalivedglobal_defs {notification_email {cnseek@# failover@firewall.loc# sysadmin@firewall.loc}notification_email_from sns-lvs@smtp_server 127.0.0.1# smtp_connect_timeout 30router_id LVS_DEVEL}# 20081013 written by :netseek# VIP1vrrp_instance VI_1 {state MASTER #备份服务器上将MASTER改为BACKUP interface eth0virtual_router_id 51priority 100 # 备份服务上将100改为99advert_int 1authentication {auth_type PASSauth_pass 1111}virtual_ipaddress {61.164.122.8#(如果有多个VIP,继续换行填写.)}}virtual_server 61.164.122.8 80 {delay_loop 6 #(每隔10秒查询realserver状态)lb_algo wrr #(lvs 算法)lb_kind DR #(Direct Route)persistence_timeout 60 #(同一IP的连接60秒内被分配到同一台realserver) protocol TCP #(用TCP协议检查realserver状态)real_server 61.164.122.9 80 {weight 3 #(权重)TCP_CHECK {connect_timeout 10 #(10秒无响应超时)nb_get_retry 3delay_before_retry 3connect_port 80}}real_server 61.164.122.10 80 {weight 3TCP_CHECK {connect_timeout 10nb_get_retry 3delay_before_retry 3connect_port 80}}}2. BACKUP服务器同上配置,先安装lvs再按装keepalived,仍后配置/etc/keepalived/keepalived.conf,只需将红色标示的部分改一下即可.3. vi /etc/rc.local#/usr/local/sbin/lvs-dr.sh 将lvs-dr.sh这个脚本注释掉。

keepalived 原理

keepalived 原理

Keepalived是一个用于管理虚拟IP地址,负载均衡和故障转移的软件。

它使用VRRP协

议(虚拟路由冗余协议)来实现高可用性,并且可以与LVS(Linux虚拟服务器)结合使用,以实现负载均衡。

Keepalived的工作原理是,它在两台服务器之间建立一个虚拟路由器,其中一台服务器被设置为主服务器,另一台服务器被设置为备用服务器。

主服务器拥有虚拟IP地址,并且

可以接收和处理客户端的请求。

如果主服务器出现故障,备用服务器将接管虚拟IP地址,并继续处理客户端的请求。

Keepalived还可以与LVS结合使用,以实现负载均衡。

LVS是一种负载均衡技术,它可以将客户端的请求分发到多台服务器上,以提高服务器的性能。

Keepalived可以将LVS集群中的服务器分为主服务器和备用服务器,并且可以根据服务器的负载情况来动态调整负载

均衡策略。

总之,Keepalived是一款非常强大的高可用性和负载均衡软件,它可以帮助系统管理员实现高可用性和负载均衡,从而提高系统的可靠性和性能。

双机热备+负载均衡线上方案(Heartbeat+DRBD+NFS+Keepalived+Lnmp)

/thread-3689681-1-1.html我们下面来实现一个架构,heartbeat+drbd+nfs实现mysql和网站数据的同步,keepalived 实现nginx的高可用,而用nginx和dns轮询实现负载均衡。

架构说明目录规划/usr/local/src/lnmp:用来存放源码工具等等/data:用来存放所有数据和NFS以及DRBD的挂载/data/shell:用来存放所有管理脚本/data/mysql:用来挂载DRBD的mysql资源,以供mysql存放数据库/data/wwwnfs:用来挂载DRBD生成的www资源,以供两个节点挂载到各个节点的/data/www 目录,以供论坛等程序数据使用/data/www:用来挂载NFS资源,用来存放论坛(网站)等程序数据拓扑工作原理内网:1,DRBD网络存储创建出两个资源,一个mysql给mysql数据库同步用,一个www给web(论坛)数据NFS共享挂载用,虚拟出两个虚拟IP,一个是 192.168.1.100,用来连接数据库,一个是192.168.1.200,用来给节点挂载NFS注意:NFS底下挂载了三次:DRBD挂载一次,文件系统挂载一次,客户端挂载一次2,Heartbeat来实现DRBD的HA,同时虚拟出两个内网IP,并管理NFS,MySQL的启动和关闭外网:1,两个节点都用Nginx做均衡器,通过内网调度负载两个节点,实现内部均衡2,DNS配置双IP对应一个域名的方式来实现DNS轮询,实现外网均衡3,Keepalived使用双主(master)配置虚拟出两个虚拟IP:节点一 12.12.12.100和节点二12.12.12.200,同时共外网访问,两个节点互为主从关系,当某个节点挂掉的时候,另外一个节点将同时是两个资源的master,同时拥有两个虚拟IP,实现资源转移。

我们知道DNS的缺点就是生效慢,分配资源不合理,理论上有可能把所有的请求都发送给同一节点,导致均衡不合理导致所有资源不可用,这里我们由于有了NGINX内部负载,就不怕DNS轮询不均衡了,因为NGINX内部有严谨的调度方式,不管那台请求有多少,在内部都能实现理想的调度,这样就能把 DNS负载均衡和NGINX完美结合,是硬件资源得到合理的利用,然后利用keepalive保证了每个节点的可靠性,几乎完美!拓扑图如下:架构实现LNMP架构配置配置LNMp架构需要注意两点:注意一:这里MYSQL都不要初始化,不要启动!后面有专门的配置的注意二:nginx所有端口都改成 8080,因为一会还要安装nginx来做均衡器并对外提供服务,所以不要用默认的80注意三、nginx和php-fpm运行的用户都是www。

keepalived工作原理和作用

keepalived工作原理和作用keepalived是一个用于实现高可用性和负载均衡的软件,它基于VRRP协议,通过监测系统的状态来实现故障转移和负载均衡。

本文将从keepalived的工作原理和作用两个方面来介绍该软件。

一、keepalived的工作原理keepalived主要通过两个核心组件来实现高可用性和负载均衡的功能,分别是VRRP和健康检查。

1. VRRP(Virtual Router Redundancy Protocol)VRRP是一种用于实现路由器冗余的协议,它能够将多个路由器组成一个虚拟路由器,对外提供一个统一的IP地址。

这个虚拟路由器由一个Master和多个Backup组成,Master负责处理数据包的转发,而Backup则处于备份状态。

当Master发生故障时,Backup 中的一个会自动切换为Master,保证系统的可用性。

keepalived基于VRRP协议来实现高可用性。

在keepalived中,一个Master节点和多个Backup节点通过VRRP协议组成一个虚拟的服务IP地址,对外提供服务。

Master节点负责接收并处理客户端的请求,Backup节点则处于备份状态,当Master节点发生故障时,Backup节点会自动接管服务,保证服务的连续性。

这种方式避免了单点故障,提高了系统的可用性。

2. 健康检查健康检查是keepalived实现负载均衡的关键,它通过定期检测服务器的状态来判断服务器是否正常工作。

keepalived支持多种健康检查方式,包括ping检查、TCP连接检查、HTTP检查等。

通过不同的方式来检查服务器的状态,确保只有正常工作的服务器会接收到客户端的请求。

当keepalived检测到某个服务器发生故障或不可用时,会将该服务器从负载均衡的服务器池中移除,同时将请求转发到其他正常工作的服务器上。

这样可以避免故障服务器对系统性能的影响,提高整体的负载均衡效果。

nginx和keeplive实现负载均衡高可用

nginx和keeplive实现负载均衡⾼可⽤⼀、 Keeplive服务介绍Keeplive期初是专门为LVS设计的,专门⽤来监控LVS集群系统中各个服务节点的状态,后来⼜加⼊VRRP的功能,因此除了配合LVS服务以外,也可以作为其他服务(nginx,haroxy)的⾼可⽤软件,VRRP是Virtual Router Redundancy Protocol(虚拟路由冗余协议)的缩写,VRRP出现的⽬的就是为了解决静态路由出现的单点故障问题,它能够保证⽹络的不间断,稳定的运⾏。

所以keepalive⼀⽅⾯具有LVS cluster nodes healthchecks功能,另⼀⽅⾯也具有LVS directors failover1.1 Keepalived的⽤途Keepalive服务的两⼤⽤途:healthcheck和failoverha failover功能:实现LB Master主机和Backup主机之间故障转移和⾃动切换这是针对有两个负载均衡器Direator同时⼯作⽽采取的故障转移措施,当主负载均衡器失效或者出现故障时,备份的负载均衡器(BACKUP)将⾃动接管主负载均衡器的所有⼯作(vip资源以及相关服务):⼀旦主负载均衡器故障恢复,MASTER⼜会接管回它原来的⼯作,⼆备份复杂均衡器(BACKUP)会释放master是⼩事它接管的⼯作,此时两者将恢复到最初各⾃的⾓⾊1.2 LVS cluster nodes healthchecks功能在keeplive.conf配置记忆可以实现LVS的功能keeplive可以对LVS下⾯的集群节点进⾏健康检查rs healthcheck功能:负载均衡定期检查RS的可⽤性决定是否给其分发请求当虚拟的服务器中的某⼀个甚⾄是⼏个真实的服务器同时出现故障⽆法提供服务时,负载均衡器会⾃动将失效的RS服务器从转发队列中清除出去,从⽽保证⽤户的访问不收影响;当故障的RS服务器被修复后,系统⼜⾃动的将他们加⼊转发队列,分发请求提供正常服务。

keepalived原理

keepalived原理Keepalived,即“Keeper of Alive Daemon”,是一个高可用性负载均衡和虚拟IP管理系统,可以有效地实现服务高可用性和路由节点快速转移。

它是基于VRRP协议的服务可用性解决方案,利用信息交换协议可以快速路由和实现可用性高负载均衡。

Keepalived的主要作用是实现高可用性和负载均衡,一个主机可以容纳一定数量的流量,而另一台主机可以容纳剩下的流量,从而实现高性能解决方案。

Keepalived的原理主要基于VRRP协议实现服务可用性,VRRP协议是路由器间进行信息交换协议,VRRP协议是网关可用性的主要方法。

VRRP在当前网络中使用多台路由器实现高可用性,而备用路由器运行在低优先级模式下。

如果活动路由器失效,则备用路由器将以同样的优先级和路由数据替代活动路由器,达到高可用性的目的。

Keepalived的结构主要由两个部分组成,一个是VRRP组件,一个是服务器组件。

VRRP组件是Keepalived的核心部分,它包含了一系列的状态机逻辑,用于监控VRRP组的当前状态,进行状态变更,以及维护VRRP协议的必要数据。

VRRP组件也负责发送和接收定时的VRRP报文,以便保持可用性,并向其他成员发布必要的VRRP信息。

服务器组件是存储VRRP信息,以及负责心跳检测主机状态的部分。

Keepalived可以实现实时响应、负载均衡和状态可用性等功能,可以应用于Web服务器、数据库服务器、邮件服务器等服务情况,并且它是可移植的,可以运行在多种不同的操作系统上,能够应对各种复杂的网络结构,用于实现高可用性服务。

总之,Keepalived是一种有效的服务可用性解决方案,它主要以VRRP协议为基础,利用信息交换协议和状态机机制实现可靠性和实时性,并且可以部署在多种不同操作系统上,实现高可用性和负载均衡的解决方案。

三.keepalived介绍及工作原理

三.keepalived介绍及⼯作原理⼀、keepalived的介绍Keepalived软件起初是专为LVS负载均衡软件设计的,⽤来管理并监控LVS集群系统中各个服务节点的状态,后来⼜加⼊了可以实现⾼可⽤的VRRP功能。

因此,Keepalived除了能够管理LVS软件外,还可以作为其他服务(例如:Nginx、Haproxy、MySQL等)的⾼可⽤解决⽅案软件。

Keepalived软件主要是通过VRRP协议实现⾼可⽤功能的。

VRRP是Virtual Router Redundancy Protocol(虚拟路由器冗余协议)的缩写,VRRP出现的⽬的就是为了解决静态路由单点故障问题的,它能够保证当个别节点宕机时,整个⽹络可以不间断地运⾏。

所以,Keepalived⼀⽅⾯具有配置管理LVS的功能,同时还具有对LVS下⾯节点进⾏健康检查的功能,另⼀⽅⾯也可实现系统⽹络服务的⾼可⽤功能。

keepalived:vrrp协议:Virtual Router Redundancy Protocol术语:虚拟路由器:Virtual Router虚拟路由器标识:VRID(0-255),唯⼀标识虚拟路由器物理路由器:master:主设备backup:备⽤设备priority:优先级VIP:Virtual IPVMAC:Virutal MAC (00-00-5e-00-01-VRID)通告:⼼跳,优先级等;周期性⼯作⽅式:抢占式,⾮抢占式安全⼯作:认证:⽆认证简单字符认证:预共享密钥MD5⼯作模式:主/备:单虚拟路径器主/主:主/备(虚拟路径器1),备/主(虚拟路径器2)⼆、Keepalived服务的重要功能1、管理LVS负载均衡软件早期的LVS软件,需要通过命令⾏或脚本实现管理,并且没有针对LVS节点的健康检查功能。

为了解决LVS的这些使⽤不便的问题,Keepalived就诞⽣了,可以说,Keepalived软件起初是专为解决LVS的问题⽽诞⽣的。

简述keepalived工作原理

简述keepalived工作原理

keepalived是一种高可用性软件,可以实现网络服务的故障转移。

其主要工作原理如下:

1. keepalived通过心跳机制来检测系统的运行状态,如果主服务器出现故障,备份服务器将立即接管其功能。

2. keepalived的心跳机制可以使用两种方式:一种是VRRP协议,另一种是LVS+HAProxy,其中VRRP协议是更常用的方式。

VRRP 协议是一种基于互联网协议的协议,可以实现网络设备之间的故障转移。

3. keepalived的另一个重要功能是负载均衡。

通过LVS+HAProxy 技术,keepalived可以将负载分配到多个服务器上,从而避免单一服务器的过载问题。

4. keepalived还可以通过邮件、短信等方式来通知管理员系统出现故障,以便及时处理。

总之,keepalived是一种非常实用的高可用性软件,可以在网络服务出现故障时实现自动故障转移,从而保证系统的稳定性和可靠性。

- 1 -。

keepalived编译

Keepalived编译什么是Keepalived?Keepalived是一个用于实现高可用性和负载均衡的开源软件。

它基于VRRP(Virtual Router Redundancy Protocol)协议,可以在多个服务器之间实现故障切换和负载均衡。

通过配置Keepalived,可以将多个服务器组成一个虚拟路由器,并将请求分发到这些服务器上,从而提高系统的可用性和性能。

编译Keepalived的步骤编译Keepalived需要一些准备工作和步骤,下面将详细介绍如何编译Keepalived。

步骤一:安装必要的依赖项在开始编译之前,我们需要安装一些必要的依赖项。

这些依赖项包括:•gcc:C语言编译器•make:构建工具•libssl-dev:OpenSSL库开发包•libpopt-dev:popt库开发包可以使用以下命令来安装这些依赖项:sudo apt-get updatesudo apt-get install gcc make libssl-dev libpopt-dev -y步骤二:下载Keepalived源代码在开始编译之前,我们需要下载Keepalived的源代码。

可以从官方网站或者GitHub上获取最新版本的源代码。

wgettar -zxvf keepalived-2.3.0.tar.gzcd keepalived-2.3.0步骤三:配置编译选项在编译之前,我们需要配置一些选项,例如安装路径、启用的功能等。

可以使用以下命令来配置编译选项:./configure --prefix=/usr/local/keepalived \--sysconf=/etc/keepalived \--enable-libiptc \--enable-snmp \--enable-dynamic-linking这里我们将Keepalived安装到/usr/local/keepalived目录下,并指定了一些启用的功能,例如libiptc、snmp和动态链接。

LVS的配置

(2)、选中要编辑的虚拟服务器,单击"EDIT"编辑其属性;编辑完成后单击"ACCEPT"保存 信息,如下图所示。

(3)在弹出的界面中填入以下信息 Name:定义虚拟服务器的名称。 Application port :指定此目标应用服务的端口。 Protocol:目标应用服务的网络协议,TCP 或 UDP。 Virtual IP Address:定义目标应用所使用的虚拟 IP。

RHEL 5 LVS 的配置

在企业的 IT 集群应用中,最常用的架构除了高可用集群外,还有负载均衡集群 (Load Balancing)。 负载均衡集群可实现多台服务器或应用的流量均衡分配。 服务器集群对外部应 用及客户表现为一个虚拟的服务器, 集群内部各服务器平均地处理由外部应用及客户端所提 交的业务,实现服务器之间的负载均衡处理并提供灵活的可扩展性,当业务压力增大时,可 随时加入新的服务器以提高集群的整体性能。负载均衡集群特别适用于高并发的网络应用, 如网站、文件服务器、各种要求高并发的 Socket 处理等。通常负载均衡集群方案大多通过 专用的硬件--"负载均衡器"来实现, 但此类硬件产品往往价格昂贵。 目前在服务器领域千兆 网络已经非常普及,但是当前中档的百兆负载均衡器依然以动辄近十万元的高价, 使得不少 企业望而却步。 LVS(负载均衡软件,Linux Virtual Server) 项目的创始人是我国国防科技大学的章文 嵩博士,此项目也是当前已经加入到 Linux 内核中为数不多的由国人维护的开源项目之一。 随着此项目的不断发展, 功能的逐渐完善及性能的不断提高, 当前不少硬件负载均衡器就是 通过 Linux 内核结合 LVS 来实现的。 在网上有很多 LVS 方面的配置教程, 如果 LVS 负载均衡器只是单台的只需安装 LVS 服务 即可, 如果 LVS 服务器是多台一般需要 LVS+keepalived 或 heartbeat+ldirectord+lvs 来实 现 LVS 负载均衡器的热备和监控应用服务器的状态。 在 RHEL 5 系列的 RHCS 中所带的 LVS 能通过图形界面的配置来实现比 LVS+keepalived 或 heartbeat+ldirectord+lvs 更强大的功能,下面我们就以 RHEL 5 LVS 为例来讲解 LVS 的基 本配置。 实验拓扑图

LVS原理详解配置文件参数详解

LVS原理详解配置⽂件参数详解LVS原理详解LVS简介 Internet的快速增长使多媒体⽹络服务器⾯对的访问数量快速增加,服务器需要具备提供⼤量并发访问服务的能⼒,因此对于⼤负载的服务器来讲, CPU、I/O处理能⼒很快会成为瓶颈。

由于单台服务器的性能总是有限的,简单的提⾼硬件性能并不能真正解决这个问题。

为此,必须采⽤多服务器和负载均衡技术才能满⾜⼤量并发访问的需要。

Linux 虚拟服务器(Linux Virtual Servers,LVS) 使⽤负载均衡技术将多台服务器组成⼀个虚拟服务器。

它为适应快速增长的⽹络访问需求提供了⼀个负载能⼒易于扩展,⽽价格低廉的解决⽅案。

LVS结构与⼯作原理⼀.LVS的结构 LVS由前端的负载均衡器(Load Balancer,LB)和后端的真实服务器(Real Server,RS)群组成。

RS间可通过局域⽹或⼴域⽹连接。

LVS的这种结构对⽤户是透明的,⽤户只能看见⼀台作为LB的虚拟服务器(Virtual Server),⽽看不到提供服务的RS群。

当⽤户的请求发往虚拟服务器,LB根据设定的包转发策略和负载均衡调度算法将⽤户请求转发给RS。

RS再将⽤户请求结果返回给⽤户。

⼆.LVS内核模型1.当客户端的请求到达负载均衡器的内核空间时,⾸先会到达PREROUTING链。

2.当内核发现请求数据包的⽬的地址是本机时,将数据包送往INPUT链。

3.LVS由⽤户空间的ipvsadm和内核空间的IPVS组成,ipvsadm⽤来定义规则,IPVS利⽤ipvsadm定义的规则⼯作,IPVS⼯作在INPUT链上,当数据包到达INPUT链时,⾸先会被IPVS检查,如果数据包⾥⾯的⽬的地址及端⼝没有在规则⾥⾯,那么这条数据包将被放⾏⾄⽤户空间。

4.如果数据包⾥⾯的⽬的地址及端⼝在规则⾥⾯,那么这条数据报⽂将被修改⽬的地址为事先定义好的后端服务器,并送往POSTROUTING链。

5.最后经由POSTROUTING链发往后端服务器。

LVS安装配置验证说明

与IPTunneling类似,负载均衡器仅处理一半的连接,避免了新的性能瓶颈,同样增加了系统的可伸缩性。Direct Routing与IPTunneling相比,没有IP封装的开销,但由于采用物理层(修改MAC地址)技术,所有服务器都必须在一个物理网段

1.3

LVS已实现了以下八种调度算法:

1.轮叫调度(Round-Robin Scheduling)

2.加权轮叫调度(Weighted Round-Robin Scheduling)

3.最小连接调度(Least-Connection Scheduling)

4.加权最小连接调度(Weighted Least-Connection Scheduling)

3.工作电脑访问http://192.168.3.40,即VIP(虚拟地址)

知识点:

可见VIP(虚拟地址)的http服务也可以正常访问

4.通过抓包深入分析工作电脑到VIP(虚拟地址)的访问

第1次

第2次

分析两次请求抓包的结果。可见工作电脑192.168.3.205到VIP的请求,首先实际都发到了52:54:00:8E:AB:8C(centos6.5-lvs-master),而后实际响应的分别是52:54:00:06:53:AD(centos6.5-app-02)和52:54:00:6F:FF:FD(centos6.5-app-01)。说明LVS DR方式下的负载均衡,首先都由LVS进行请求的分发,然后realserver处理后直接响应给访问者,而不用通过LVS转发。此种方式是LVS比其它负载均衡软件性能更高的本质原因。

其中lb_kind指定为DR,使用直接路由方式。

每个real_server指定实际提供服务的机器地址和端口,这里陪着两个,分别是centos6.5-app-01及centos6.5-app-02上的80端口。其中weight表示每个real_server的权重,TCP_CHECK设置服务状态检查的策略。

Linux开源集群架构之keepalived应用详解

第03章集群利器Keepalived本章主要了解开源高可用负载均衡集群利器Keepalived,掌握Keepalived的安装,运用Keepalived配置高可用集群,并能够实现Keepalived与负均衡集群LVS的完美组合。

一、Keepalived概述1、什么是Keepalived?keepalived是一个类似于layer3, 4 & 5交换机制的软件,也就是我们平时说的第3层、第4层和第5层交换。

Keepalived的作用是检测web服务器的状态,如果有一台web服务器死机,或工作出现故障,Keepalived将检测到,并将有故障的web服务器从系统中剔除,当web服务器工作正常后Keepalived自动将web服务器加入到服务器群中,这些工作全部自动完成,不需要人工干涉,需要人工做的只是修复故障的web服务器2、keepalived理论工作原理Layer3,4&5工作在IP/TCP协议栈的IP层,TCP层,及应用层,原理分别如下:Layer3:Keepalived使用Layer3的方式工作式时,Keepalived会定期向服务器群中的服务器发送一个ICMP的数据包(既我们平时用的Ping程序),如果发现某台服务的IP地址没有激活,Keepalived便报告这台服务器失效,并将它从服务器群中剔除,这种情况的典型例子是某台服务器被非法关机。

Layer3的方式是以服务器的IP地址是否有效作为服务器工作正常与否的标准。

Layer4:主要以TCP端口的状态来决定服务器工作正常与否。

如web server的服务端口一般是80,如果Keepalived检测到80端口没有启动,则Keepalived将把这台服务器从服务器群中删除。

Layer5:Layer5就是工作在具体的应用层了,比Layer3,Layer4要复杂一点,在网络上占用的带宽也要大一些。

Keepalived将根据用户的设定检查服务器程序的运行是否正常,如果与用户的设定不相符,则Keepalived将把服务器从服务器群中剔除。

REDIS+KEEPALIVED+HAPROXY 集群,负载均衡,主备自动切换安装手册

REDIS集群,KEEPALIVED+HAPROXY负载均衡,主备自动切换安装手册服务器环境:centos6.3机器1:redis主节点(172.16.8.21:6379)从节点(172.16.8.21:63791)从节点(172.16.8.21:63792)机器2:从节点172.16.8.22:63793从节点172.16.8.23:63794一、REDIS集群安装进入机器1:mkdir /usr/local/redismkdir /usr/local/redis/data1 下载redis,进入/usr/local/src目录2 wget http://download.redis.io/releases/redis-2.8.9.tar.gz3 tar xvf redis-2.8.9.tar.gz4 cd redis-2.8.95 make && make install6 cp redis.conf /usr/local/bin7 cd /usr/local/bin8 cp redis.conf redis-slave19 cp redis.conf redis-slave210 vi redis.conf11 搜索dind设为172.16.8.21dir 设为/usr/local/redis/datadaemonize 设为yes12 vi redis-slave113 搜索bind 设为172.16.8.21pidfile 设为/var/run/redis-slave1.piddbfilename设为dump-slave1.rdbdir设为/usr/local/redis/dataport 设为63791将slaveof前面的#号去掉,改为slaveof 172.16.8.21 6379 daemonize 设为yes14 vi redis-slave215 搜索bind 设为172.16.8.21pidfile 设为/var/run/redis-slave2.piddbfilename设为dump-slave2.rdbdir设为/usr/local/redis/dataport 设为63792将slaveof前面的#号去掉,改为slaveof 172.16.8.21 6379 daemonize 设为yes16redis-server redis.confredis-server redis-slave1redis-server redis-slave2进入机器2mkdir /usr/local/redismkdir /usr/local/redis/data1 下载redis,进入/usr/local/src目录2 wget http://download.redis.io/releases/redis-2.8.9.tar.gz3 tar xvf redis-2.8.9.tar.gz4 cd redis-2.8.95 make && make install6 cp redis.conf /usr/local/bin7 cd /usr/local/bin8 cp redis.conf redis-slave39 cp redis.conf redis-slave410 vi redis-slave311 搜索bind 设为172.16.8.22pidfile 设为/var/run/redis-slave3.piddbfilename设为dump-slave3.rdbdir设为/usr/local/redis/dataport 设为63793将slaveof前面的#号去掉,改为slaveof 172.16.8.21 6379daemonize 设为yes12 vi redis-slave413 搜索bind 设为172.16.8.22pidfile 设为/var/run/redis-slave4.piddbfilename设为dump-slave4.rdbdir设为/usr/local/redis/dataport 设为63794将slaveof前面的#号去掉,改为slaveof 172.16.8.21 6379daemonize 设为yes14 redis-server redis-slave315 redis-server redis-slave4到现在已完成redis集群配置,且只有172.16.8.21 6379可写数据,其余slave机器只能读数据redis-cli -h 172.16.8.21 -p 6379info可以看到这样子就是成功了二、安装haproxy进入机器1cd /usr/loca/srcwget http://haproxy.1wt.eu/download/1.4/src/haproxy-1.4.25.tar.gztar xvf http://haproxy.1wt.eu/download/1.4/src/haproxy-1.4.25.tar.gzcd haproxy-1.4.25make TARGET=linux26 PREFIX=/usr/local/haproxymake install PREFIX=/usr/local/haproxycd /usr/local/haproxyvi haproxy.cfg添加下面内容# this config needs haproxy-1.1.28 or haproxy-1.2.1globallog 172.16.8.21 local0#log 172.16.8.21 local1 notice#log loghost local0 infomaxconn 4096chroot /usr/local/haproxyuid 99gid 99daemon#debugquietnbproc 2pidfile /usr/local/haproxy/haproxy.piddefaultslog globalmode httpoption httplogoption dontlognulllog 172.16.8.21 local3 inforetries 3redispatchmaxconn 3000contimeout 5000clitimeout 50000srvtimeout 50000listen cluster 0.0.0.0:63790mode tcpbalance roundrobinoption forwardforserver redis-slave1 172.16.8.21:63791 weight 100 check inter 2000 rise 2 fall 3 server redis-slave2 172.16.8.21:63792 weight 100 check inter 2000 rise 2 fall 3 server redis-slave3 172.16.8.22:63793 weight 100 check inter 2000 rise 2 fall 3 server redis-slave4 172.16.8.22:63794 weight 100 check inter 2000 rise 2 fall 3listen 172.16.8.21 *:8888mode http#transparentstats refresh 10sstats uri /haproxyadminstats realm Haproxy \ statisticstats auth admin:adminstats hide-version保存加上日志支持 vi /etc/rsyslog.conf在最下边增加local3.* /var/log/haproxy.loglocal0.* /var/log/haproxy.logvi /etc/sysconfig/rsyslog修改: SYSLOGD_OPTIONS="-r -m 0"重启日志服务service rsyslog restart进入机器2cd /usr/loca/srcwget http://haproxy.1wt.eu/download/1.4/src/haproxy-1.4.25.tar.gz tar xvf http://haproxy.1wt.eu/download/1.4/src/haproxy-1.4.25.tar.gz cd haproxy-1.4.25make TARGET=linux26 PREFIX=/usr/local/haproxymake install PREFIX=/usr/local/haproxycd /usr/local/haproxyvi haproxy.cfg添加下面内容# this config needs haproxy-1.1.28 or haproxy-1.2.1globallog 172.16.8.22 local0#log 172.16.8.22 local1 notice#log loghost local0 infomaxconn 4096chroot /usr/local/haproxyuid 99gid 99daemon#debugquietnbproc 2pidfile /usr/local/haproxy/haproxy.piddefaultslog globalmode httpoption httplogoption dontlognulllog 172.16.8.22 local3 inforetries 3redispatchmaxconn 3000contimeout 5000clitimeout 50000srvtimeout 50000listen cluster 0.0.0.0:63790mode tcpbalance roundrobinoption forwardforserver redis-slave1 172.16.8.21:63791 weight 100 check inter 2000 rise 2 fall 3 server redis-slave2 172.16.8.21:63792 weight 100 check inter 2000 rise 2 fall 3 server redis-slave3 172.16.8.22:63793 weight 100 check inter 2000 rise 2 fall 3 server redis-slave4 172.16.8.22:63794 weight 100 check inter 2000 rise 2 fall 3 listen 172.16.8.22*:8888mode http#transparentstats refresh 10sstats uri /haproxyadminstats realm Haproxy \ statisticstats auth admin:adminstats hide-version保存加上日志支持 vi /etc/rsyslog.conf在最下边增加local3.* /var/log/haproxy.loglocal0.* /var/log/haproxy.logvi /etc/sysconfig/rsyslog修改: SYSLOGD_OPTIONS="-r -m 0"重启日志服务service rsyslog restart三、安装keepalived进入机器1cd /usr/local/srcwget /software/keepalived-1.2.12.tar.gztar xvf keepalived-1.2.12.tar.gzcd keepalived-1.2.12./configuremake&&make install注:若这里报错提示没有装openssl,则执行yum –y install openssl-devel安装,若还有其他的包没装,则执行yum命令进行安装cp /usr/local/etc/rc.d/init.d/keepalived /etc/rc.d/init.d/cp /usr/local/etc/sysconfig/keepalived /etc/sysconfig/mkdir /etc/keepalivedcp /usr/local/etc/keepalived/keepalived.conf /etc/keepalived/ln -s /usr/local/sbin/keepalived /usr/sbin/vi /etc/keepalived/keepalived.conf将内容改为如下! Configuration File for keepalivedvrrp_script chk_haproxy {script "/etc/keepalived/check_haproxy.sh"interval 2global_defs {router_id LVS_DEVEL}vrrp_instance VI_1 {state MASTERinterface eth0virtual_router_id 51priority 150advert_int 1authentication {auth_type PASSauth_pass 1111}track_script {chk_haproxy}virtual_ipaddress {172.16.8.20}}}保存vi /etc/keepalived/check_haproxy.sh添加内容#!/bin/bash#A = `ps -C haproxy --no-header |wc -l`if [[ `ps -C haproxy --no-header |wc -l` -eq 0 ]];thenecho "haproxy not runing,attempt to start up."/usr/local/haproxy/sbin/haproxy -f /usr/local/haproxy/haproxy.cfgsleep 3if [[ `ps -C haproxy --no-header |wc -l` -eq 0 ]];then/etc/init.d/keepalived stopecho "haproxy start failure,stop keepalived"elseecho "haproxy started success"fifi注意`这个符号不是单引号,是esc下面那个键进入机器2cd /usr/local/srcwget /software/keepalived-1.2.12.tar.gztar xvf keepalived-1.2.12.tar.gzcd keepalived-1.2.12./configuremake&&make install注:若这里报错提示没有装openssl,则执行yum –y install openssl-devel安装,若还有其他的包没装,则执行yum命令进行安装cp /usr/local/etc/rc.d/init.d/keepalived /etc/rc.d/init.d/cp /usr/local/etc/sysconfig/keepalived /etc/sysconfig/ mkdir /etc/keepalivedcp /usr/local/etc/keepalived/keepalived.conf /etc/keepalived/ ln -s /usr/local/sbin/keepalived /usr/sbin/vi /etc/keepalived/keepalived.conf将内容改为如下! Configuration File for keepalivedvrrp_script chk_haproxy {script "/etc/keepalived/check_haproxy.sh"interval 2global_defs {router_id LVS_DEVEL}vrrp_instance VI_1 {state BACKUPinterface eth0virtual_router_id 51priority 120advert_int 1authentication {auth_type PASSauth_pass 1111}track_script {chk_haproxy}virtual_ipaddress {172.16.8.20}}}保存vi /etc/keepalived/check_haproxy.sh添加内容#!/bin/bash#A = `ps -C haproxy --no-header |wc -l`if [[ `ps -C haproxy --no-header |wc -l` -eq 0 ]];thenecho "haproxy not runing,attempt to start up."/usr/local/haproxy/sbin/haproxy -f /usr/local/haproxy/haproxy.cfgsleep 3if [[ `ps -C haproxy --no-header |wc -l` -eq 0 ]];then/etc/init.d/keepalived stopecho "haproxy start failure,stop keepalived"elseecho "haproxy started success"fifi注意`这个符号不是单引号,是esc下面那个键保存在机器1机器2中分别执行service keepalived start然后在浏览器上打开http://172.16.8.20:8888/haproxyadmin用户名和密码是admin只要机器1和机器2中keepalived服务没有同时挂掉,一台机器挂掉后,另一台机器就会绑定172.16.8.20地址,实现主备切换,因此都可以通过172.16.8.20:63790访问该redis 集群Vip压力测试redis-benchmark -h 172.16.8.20 -p 63790 -t get -q -r 1000 -n 100000 -c 800主机器压力测试redis-benchmark -h 172.16.8.21 -p 6379 -t get -q -r 1000 -n 100000 -c 800从节点压力测试redis-benchmark -h 172.16.8.22 -p 63793 -t get -q -r 1000 -n 100000 -c 800本文参考于百度文库地址/link?url=Wd0Z2arJ4wdspy7jw9O1mGZCy2e5GiO4hCIv36 QxoOtNGcFOMG8rPpegmRH_z72Ejc-KAP9Ld2Aieo7DPgmC_b1bXB2BZVSKPTXsoz BNNYi。

Keepalived配置详解

Keepalived配置详解Keepalived 配置⽂件解释Keepalived的所有配置都在⼀个配置⽂件⾥⾯,主要分为三类:全局配置VRRPD配置LVS 配置配置⽂件是以配置块的形式存在,每个配置块都在⼀个闭合的{}范围内,所以编辑的时候需要注意⼤括号的闭合问题。

#和!开头都是注释。

全局配置全局配置是对整个 Keepalived ⽣效的配置,⼀个典型的配置如下:global_defs {notification_email { #设置 keepalived 在发⽣事件(⽐如切换)的时候,需要发送到的email地址,可以设置多个,每⾏⼀个。

acassen@firewall.locfailover@firewall.locsysadmin@firewall.loc}notification_email_from Alexandre.Cassen@firewall.loc #设置通知邮件发送来⾃于哪⾥,如果本地开启了sendmail的话,可以使⽤上⾯的默认值。

smtp_server 192.168.200.1 #指定发送邮件的smtp服务器。

smtp_connect_timeout 30 #设置smtp连接超时时间,单位为秒。

router_id LVS_DEVEL #是运⾏keepalived的⼀个表⽰,多个集群设置不同。

}VRRPD配置VRRPD 的配置是 Keepalived ⽐较重要的配置,主要分为两个部分 VRRP 同步组和 VRRP实例,也就是想要使⽤ VRRP 进⾏⾼可⽤选举,那么就⼀定需要配置⼀个VRRP实例,在实例中来定义 VIP、服务器⾓⾊等。

VRRP Sync Groups不使⽤Sync Group的话,如果机器(或者说router)有两个⽹段,⼀个内⽹⼀个外⽹,每个⽹段开启⼀个VRRP实例,假设VRRP配置为检查内⽹,那么当外⽹出现问题时,VRRPD认为⾃⼰仍然健康,那么不会发⽣Master和Backup的切换,从⽽导致了问题。

keepalived iptables规则

keepalived iptables规则Keepalived是一个用于实现高可用性(LVS)的软件,而Iptables是一个用于配置Linux防火墙规则的工具。

在使用Keepalived来实现负载均衡和故障转移时,我们可以通过Iptables来增强网络安全性,以保护服务器免受恶意攻击。

为了确保Keepalived正常运行,我们需要在服务器上设置一些Iptables规则。

这些规则主要包括:1. 开启必要的端口:Keepalived使用一些特定的端口进行通信,因此我们需要在防火墙上开放这些端口。

一般来说,这些端口包括VIP(Virtual IP)、VRRP (Virtual Router Redundancy Protocol)和其他用于监控和通信的端口。

举例来说,如果Keepalived使用VIP 192.168.0.1和VRRP端口号112,我们可以使用以下命令将它们添加到Iptables规则中:```iptables -A INPUT -p vrrp -j ACCEPTiptables -A INPUT -d 192.168.0.1 -j ACCEPT```2. 禁止非授权的访问:为了防止未授权的访问,我们需要限制对Keepalived服务的访问。

只有特定IP地址的请求才应该被允许通过,而其他请求应该被丢弃。

举例来说,假设我们只允许IP地址为192.168.0.2和192.168.0.3的主机进行访问,其他IP地址的请求应该被拒绝。

我们可以使用以下命令设置相应的规则:```iptables -A INPUT -p tcp -s 192.168.0.2 -j ACCEPTiptables -A INPUT -p tcp -s 192.168.0.3 -j ACCEPTiptables -A INPUT -p tcp -j DROP```3. Log记录:为了方便排查问题和监控网络活动,我们可以对Keepalived的网络流量进行日志记录。

使用LVS实现负载均衡原理及安装配置详解

如上图。FULLNAT模式对入报文做了DNAT+SNAT,即将报文的目的地址改为RS的地址,源地址改为LVS设备地址;RS上不需要配置路由策略,出报文到了LVS设备上后做 SNAT+DNAT,即将报文的源地址改为LVS设备上的地址,目的地址改为真实的用户地址。

LVS FULLNAT类型特性

ipvsadm:用户空间的命令行工具,规则管理器,用于管理集群服务及RealServer ipvs:工作于内核空间的netfilter的INPUT钩子之上的框架

LVS集群类型中的术语

Director:负载均衡器,也称VS(Virtual Server) RS:真实服务器(RealServer) CIP:客户端IP(Client IP) VIP: Client所请求的,提供虚拟服务的IP,可以用Keepalive做高可用 DIP:在Director实现与RS通信的IP RIP:RealServer IP

1.VIP是公网地址,RIP和DIP是私网地址,且通常不在同一IP网络,因此,RIP的网关一般不会指向DIP 2.RS收到的请求报文源地址是DIP,因此只需响应给DIP, Dirctor收到RS的回复报文后将其发往Client 3.请求和响应报文都经由Dirctor 4.支持端口映射

三、LVS调度方法(Scheduler)

2.2 LVS/DR(Direct Routing直接路由) 通过为请求报文重新封装一个MAC首部进行转发,源MAC是DIP所在的接口的MAC,目标MAC是挑选出的RS的RIP所在接口的MAC地址;源IP/PORT,以及目标IP/PORT均保持不变, 请求报文经过Dirctor但响应报文不再经过Dirctor

二、LVS集群的类型

LVS转发模式有四种: lvs-nat: 修改请求报文的目标IP lvs-dr: 操纵封闭新的MAC地址 lvs-tun: 在原请求IP报文之外新加一个IP首部 lvs-fullnat: 修改请求报文的源和目标IP

LINUX集群LVS负载均衡配置

作者:潜小生 open.source.niche@LINUX 集群LVS 负载均衡配置基础基础原理篇原理篇原理篇::LVS 是Linux Virtual Server 的缩写,意思是Linux 虚拟服务器。

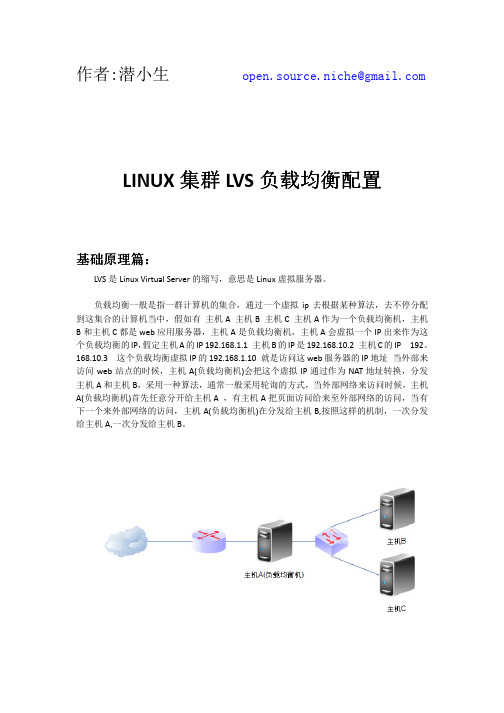

负载均衡一般是指一群计算机的集合,通过一个虚拟ip 去根据某种算法,去不停分配到这集合的计算机当中,假如有 主机A 主机B 主机C 主机A 作为一个负载均衡机,主机B 和主机C 都是web 应用服务器,主机A 是负载均衡机,主机A 会虚拟一个IP 出来作为这个负载均衡的IP ,假定主机A 的IP 192.168.1.1 主机B 的IP 是192.168.10.2 主机C 的IP 192。

168.10.3 这个负载均衡虚拟IP 的192.168.1.10 就是访问这web 服务器的IP 地址 当外部来访问web 站点的时候,主机A(负载均衡机)会把这个虚拟IP 通过作为NAT 地址转换,分发主机A 和主机B ,采用一种算法,通常一般采用轮询的方式,当外部网络来访问时候,主机A(负载均衡机)首先任意分开给主机A ,有主机A 把页面访问给来至外部网络的访问,当有下一个来外部网络的访问,主机A(负载均衡机)在分发给主机B,按照这样的机制,一次分发给主机A,一次分发给主机B 。

LVS有三种负载均衡的模式,分别是VS/NAT(nat模式)VS/DR(路由模式) VS/TUN(隧道模式)介绍模式介绍VS/NAT模式这种模式当来访问这个网络的时候,负载均衡机会会通过NAT的转换分别分发给应用服务器A或应用服务器B。

应用服务器返回给来至外部的访问,要在次通过负载机访问给来至外部的访问。

这种模式通常是应用服务器是IP是私有IP地址,需要通过NAT地址来转换成公网IP地址。

返回给外部网络的不在通过这个负载均衡机出去,而且自己通过路由返回给外部网络,自己去查路由,去返回。

vs/tun模式介绍隧道模式,负载均衡机和集群集合的服务器和负载均衡虚拟出来IP不属于同一个网段,分别分布在不同网段,这时候我需要隧道模式,好比这个负载均衡机和这个集群集合的服务器建议一条用来专门用来负载均衡隧道,隧道模式首先外部网络访问时候,经负载均衡机来分发到应用服务器,应用服务器也是和路由模式一样的方式,自己路由出去返回结果给来至外部的访问,也不经在过负载均衡机出返回给来至外部网络的访问。

keepalived vrrp原理

keepalived vrrp原理keepalived是一种用于高可用性的软件,它使用VRRP(Virtual Router Redundancy Protocol)协议来实现路由器的冗余和负载均衡。

本文将详细讨论keepalived VRRP的工作原理,并解释其在构建高可用性网络环境中的应用。

首先,我们需要了解什么是VRRP。

VRRP是一种网络协议,用于在多个路由器之间实现冗余,即一个主路由器和一个或多个备份路由器。

它通过将IP地址分配给一个虚拟路由器来创建冗余。

这样,如果主路由器出现故障,备份路由器可以立即接管虚拟路由器的功能,以确保网络的持续运行。

keepalived是一个用户空间进程,用于监控网络中的服务器,并确保它们的可用性。

它通过VRRP协议与其他keepalived进程通信,实现路由器的冗余和负载均衡。

keepalived的工作原理如下:1. 配置Virtual IP(VIP)和Virtual Router ID(VRID):在keepalived配置文件中,我们需要指定一个VIP和VRID。

VIP 是一个虚拟的IP地址,用于识别虚拟路由器。

VRID用于标识逻辑上相同的虚拟路由器的虚拟路由器组。

2. 发送VRRP通告:一旦keepalived进程启动,它会发送VRRP通告(Advertisement)消息,以通知其他keepalived进程它是活动路由器。

3. 确定Master路由器:当其他keepalived进程接收到VRRP通告消息时,他们将判断消息中的优先级和VRID。

如果接收到的消息中的VRID与本地配置的相同,并且发送消息的优先级较高,那么本地路由器将判断接收到的消息中的优先级,并决定是否切换到备份状态。

4. 选举Master路由器:如果当前的路由器被切换到备份状态,它将参与Master路由器的选举过程。

该过程基于优先级。

优先级越高的路由器将被选举为Master路由器。

如果多个路由器具有相同的优先级,则MAC地址较高的路由器将成为Master。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

LVS+Keepalived实现高可用集群一、基础介绍 (2)二、搭建配置LVS-NA T模式 (2)三、搭建配置LVS-DR模式 (4)四、另外一种脚本方式实现上面LVS-DR模式 (6)五、keepalived + LVS(DR模式) 高可用 (8)六、Keepalived 配置文件详细介绍 (11)一、基础介绍(一)根据业务目标分成三类:High Availability 高可用Load Balancing 负载均衡High Performance 高性能(二)实现集群产品:HA类:rhcs、heartbeat、keepalivedLB类:haproxy、lvs、nginx、f5、piranhaHPC类:/index/downfile/infor_id/42(三)LVS 负载均衡有三种模式:LVS-DR模式(direct router)直接路由模式进必须经过分发器,出就直接出LVS-NAT模式(network address translation)进出必须都经过分发器LVS-TUN模式(ip tunneling)IP隧道模式服务器可以放到全国各地二、搭建配置LVS-NAT模式1 、服务器IP规划:DR服务器添加一张网卡eth1,一个网卡做DIP,一个网口做VIP。

设置DIP、VIP IP地址:DIP的eth1和所有RIP相连同一个网段CIP和DIP的eth0(Vip)相连同一个网段Vip eth0 192.168.50.200Dip eth1 192.168.58.4客户机IP:Cip 192.168.50.32台真实服务器IP:Rip1 192.168.58.2Rip2 192.168.58.32 、R ealServer1配置:mount /dev/xvdd /media/vi /var/www/html/index.html写入:this is realserver1启动httpdvi /etc/sysconfig/network-scripts/ifcfg-eth0设置RIP,子网掩码必须设置成DIPIPADDR=192.168.58.2NETMASK=255.255.255.0GA TEWAY=192.168.58.43 、R ealServer2 配置:vi /var/www/html/index.html写入:this is realserver2启动httpdvi /etc/sysconfig/network-scripts/ifcfg-eth0设置RIP,子网掩码必须设置成DIPIPADDR=192.168.58.3NETMASK=255.255.255.0GA TEWAY=192.168.58.44 、在DR服务器上做以下设置:开启IP数据包转发vi /etc/sysctl.confnet.ipv4.ip_forward = 0 ##0改成1 ,此步很重要查看是否开启:sysctl -p5 、安装LVS服务:ipvsadmyum -y install ipvsadmlsmod |grep ip_vsTurbolinux系统没有带rpm包,必须下载源码安装:#ln -s /usr/src/kernels/2.6.18-164.el5-x86_64/ /usr/src/linux##如果不做连接,编译时会包错#tar zxvf ipvsadm-1.24.tar.gz#cd ipvsadm-1.24#make && make install运行下ipvsadm ,就加到ip_vs模块到内核了lsmod | grep ip 可以看到有ip_vs模块了6 、配置DR服务器,添加虚拟服务ipvsadm -L -n 查询信息ipvsadm -A -t 192.168.50.200:80 -s rr #添加集群服务、调度算法,rr为调度算法ipvsadm -a -t 192.168.50.200:80 -r 192.168.58.2 -m -w 1 # -m代表net模式,-w代表权重ipvsadm -a -t 192.168.50.200:80 -r 192.168.58.3 -m -w 2ipvsadm -L -n 再次查看是就有了realserverservice ipvsadm save 保存配置iptables -L 关闭或者清空防火墙watch -n 1 'ipvsadm -L -n' 查看访问记录的数显示如下:-> RemoteAddress:Port Forward Weight ActiveConn InActConnTCP 192.168.50.200:80 rr-> 192.168.58.2:80 Masq 1 0 13-> 192.168.58.3:80 Masq 2 0 12ActiveConn是活动连接数,也就是tcp连接状态的ESTABLISHED;InActConn是指除了ESTABLISHED以外的,所有的其它状态的tcp连接.7 、测试:http://192.168.58.200配完后若想修改算法:ipvsadm -E -t 192.168.58.200:80 -s wlc修改Rip的权重:ipvsadm -e -t 192.168.58.200:80 -r 192.168.58.2 -m -w 1ipvsadm -e -t 192.168.58.200:80 -r 192.168.58.3 -m -w 5三、搭建配置LVS-DR模式lo:1 回应客户端,lo:1上的IP跟机器有关,跟网卡没有关系arp_announce 对网络接口上本地IP地址发出的ARP回应作出相应级别的限制arp_ignore 定义对目标地址为本地IP的ARP询问不同的请求一、3台服务器IP配置规划:DIP:eth0:1 192.168.58.200/32 (VIP)eth0 192.168.58.3/24 (DIP)RIP1 lo:1 192.168.58.200/32 (VIP)eth0 192.168.58.4/24RIP2 lo:1 192.168.58.200/32 (VIP)eth0 192.168.58.5/24 .................................................................RIP n lo:1 192.168.58.200/32 (VIP)eth0 192.168.58.N/24二、每台realserver都加上下面四个步骤配置:1 、配置每台rip的IP、http,web页面2 、关闭每台rip服务器的ARP广播:echo 1 > /proc/sys/net/ipv4/conf/lo/arp_ignoreecho 2 > /proc/sys/net/ipv4/conf/lo/arp_announceecho 1 > /proc/sys/net/ipv4/conf/all/arp_ignoreecho 2 > /proc/sys/net/ipv4/conf/all/arp_announce3 、配置VIPifconfig lo:1 192.168.58.200 netmask 255.255.255.255 broadcast 192.168.58.200 up4 、配置网关route add -host 192.168.58.200 dev lo:1三、DR上的配置(DR模式下Dip不用开启转发):1 、配置DIP,在eth0上添加一个子VIP接口:添加VIP:ifconfig eth0:1 192.168.58.200 broadcast 192.168.58.200 netmask 255.255.255.255 up2 、配置网关:route add -host 192.168.58.200 dev eth0:1route -n3 、安装ipvsadm(方法见文档上面)yum -y install ipvsadmlsmod |grep ip_vs4 、配置LVS集群:ipvsadm -A -t 192.168.58.200:80 -s rr #添加集群服务、调度算法,rr为调度算法ipvsadm -a -t 192.168.58.200:80 -r 192.168.58.3 -g -w 1 # -g代表DR模式,-w代表权重ipvsadm -a -t 192.168.58.200:80 -r 192.168.58.2 -g -w 2service ipvsadm saveipvsadm -L -n 查看信息四、测试:http://192.168.58.200四、另外一种脚本方式实现上面LVS-DR模式IP规划:Dip eth0 192.168.58.139VIP:192.168.58.200RIP1:192.168.58.2RIP2:192.168.58.31 、D R服务器上安装ipvsadm#yum -y install ipvsadm#lsmod | grep ip_vs 查看没有输出#modprobe ip_vs 安装即可2 、配置DIP服务器、LVS这里也是个写脚本为了方便vim /etc/init.d/lvsdr#!/bin/bash#lvs of DRVIP=192.168.58.200RIP1=192.168.58.2RIP2=192.168.58.3case "$1" instart)echo "start lvs of DR"/sbin/ifconfig eth0:0 $VIP broadcast $VIP netmask 255.255.255.0 up echo "1" > /proc/sys/net/ipv4/ip_forward/sbin/iptables -C/sbin/ipvsadm -A -t $VIP:80 -s rr/sbin/ipvsadm -a -t $VIP:80 -r $RIP1:80 -g/sbin/ipvsadm -a -t $VIP:80 -r $RIP2:80 -g/sbin/ipvsadm;;stop)echo "stop lvs of DR"echo "0" > /proc/sys/net/ipv4/ip_forward/sbin/ipvsadm -C/sbin/ifconfig eth0:0 down;;*)echo "Usage :$0 {start|stop}"exit1esacexit 0#chmod o+x /etc/init.d/lvsdr启动脚本:#service lvsdr start3 、2台RIP服务器都配置这里我们也都可以写成脚本开启2台RIP的httpd服务。