nutch介绍

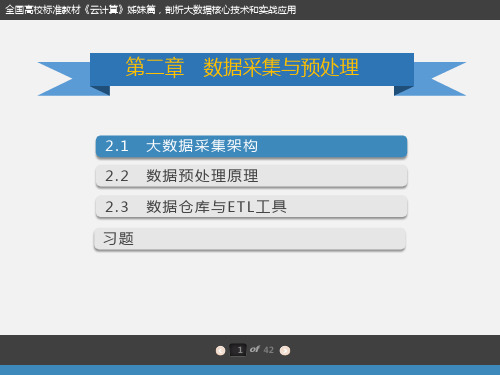

第二章 数据采集与预处理 (教案与习题)

2 of 42

2.1大数据采集架构

第二章 数据采集与预处理

2.1.2 常用大数据采集工具

数据采集最传统的方式是企业自己的生产系统产生的数据,除上述生产系统中的数据外, 企业的信息系统还充斥着大量的用户行为数据、日志式的活动数据、事件信息等,越来越 多的企业通过架设日志采集系统来保存这些数据,希望通过这些数据获取其商业或社会价 值。

$sudo apt-get update

Apache Kafka需要Java运行环境,这里使用apt-get命令安装default-jre包,然后安装Java运行环境:

$sudo apt-get install default-jre

通过下面的命令测试一下Java运行环境是否安装成功,并查看Java的版本信息:

Nutch搜索引擎(第1期)_Nutch简介及安装

细细品味Nutch——Nutch搜索引擎(第1期)精华集锦csAxp虾皮工作室/xia520pi/2014年3月18日Nutch搜索引擎(第1期)——Nutch简介及安装1、Nutch简介Nutch是一个由Java实现的,开放源代码(open-source)的web搜索引擎。

主要用于收集网页数据,然后对其进行分析,建立索引,以提供相应的接口来对其网页数据进行查询的一套工具。

其底层使用了Hadoop来做分布式计算与存储,索引使用了Solr分布式索引框架来做,Solr是一个开源的全文索引框架,从Nutch 1.3开始,其集成了这个索引架构。

Nutch目前最新的版本为version1.4。

1.1 Nutch的目标Nutch致力于让每个人能很容易,同时花费很少就可以配置世界一流的Web搜索引擎。

为了完成这一宏伟的目标,Nutch必须能够做到:●每个月取几十亿网页●为这些网页维护一个索引●对索引文件进行每秒上千次的搜索●提供高质量的搜索结果●以最小的成本运作1.2 Nutch的优点●透明度Nutch是开放源代码的,因此任何人都可以查看他的排序算法是如何工作的。

商业的搜索引擎排序算法都是保密的,我们无法知道为什么搜索出来的排序结果是如何算出来的。

更进一步,一些搜索引擎允许竞价排名,比如百度,这样的索引结果并不是和站点内容相关的。

因此Nutch对学术搜索和政府类站点的搜索来说,是个好选择。

因为一个公平的排序结果是非常重要的。

●扩展性你是不是不喜欢其他的搜索引擎展现结果的方式呢?那就用 Nutch 写你自己的搜索引擎吧。

Nutch 是非常灵活的,他可以被很好的客户订制并集成到你的应用程序中。

使用Nutch 的插件机制,Nutch 可以作为一个搜索不同信息载体的搜索平台。

当然,最简单的就是集成Nutch到你的站点,为你的用户提供搜索服务。

●对搜索引擎的理解我们并没有google的源代码,因此学习搜索引擎Nutch是个不错的选择。

推荐-全文搜索引擎的设计与实现 精品

作者声明本人郑重声明:所呈交的学位是本人在导师的指导下独立进行研究所取得的研究成果。

除了文中特别加以标注引用的内容外,本不包含任何其他个人或集体已经发表或撰写的成果作品。

本人完全了解有关保障、使用学位的规定,同意学校保留并向有关学位管理机构送交的复印件和电子版。

同意省级优秀学位评选机构将本学位通过影印、缩印、扫描等方式进行保存、摘编或汇编;同意本被编入有关数据库进行检索和查阅。

本学位内容不涉及国家机密。

题目:全文搜索引擎的设计与实现作者单位:江汉大学数学与计算机科学学院作者签名:XXX20XX年 5 月 20 日学士学位题目全文搜索引擎的设计与实现(英文) Full-text search engine design andImplementation学院数学与计算机科学学院专业计算机科学与技术班级 B09082021姓名 XXX学号 20XX08202137指导老师 YYY20XX 年5月20日摘要目前定制和维护搜索引擎的需求越来越大,对于处理庞大的网络数据,如何有效的去存储它并访问到我们需要的信息,变得尤为重要。

Web搜索引擎能有很好的帮助我们解决这一问题。

本文阐述了一个全文搜索引擎的原理及其设计和实现过程。

该系统采用B/S模式的Java Web平台架构实现,采用Nutch相关框架,包括Nutch,Solr,Hadoop,以及Nutch 的基础框架Lucene对全网信息的采集和检索。

文中阐述了Nutch相关框架的背景,基础原理和应用。

Nutch相关框架的出现,使得在java平台上构建个性化搜索引擎成为一件简单又可靠的事情。

Nutch 致力于让每个人能很容易, 同时花费很少就可以配置世界一流的Web 搜索引擎。

目前国内有很多大公司,比如百度、雅虎,都在使用Nutch相关框架。

由于Nutch是开源的,阅读其源代码,可以让我们对搜索引擎实现有更加深刻的感受,并且能够更加深度的定制需要的搜索引擎实现细节。

Nutch 的配置文件

Nutch 的配置Nutch的配置文件主要有三类:1.Hadoop的配置文件,Hadoop-default.xml和Hadoop-site.xml。

2.Nutch的配置文件,Nutch-default.xml和Nutch-site.xml。

3.Nutch的插件的配置文件,这些插件的配置文件在加载插件的时候由插件自行加载,如filter的配置文件。

配置文件的加载顺序决定了配置文件的优先级,先加载的配置文件优先级低,后加载的配置文件优先级高,优先级低的配置会被优先级高的配置覆盖。

因此,了解Nutch配置文件加载的顺序对学习使用Nutch是非常必要的。

下面我们通过对Nutch源代码的分析来看看Nutch加载配置文件的过程。

Nutch1.0使用入门(一)介绍了Nutch主要命令--crawl的使用,下面我们就从crawl的main类(org.apache.nutch.crawl.Crawl)的main方法开始分析:Crawl类main方法中加载配置文件的源码如下:Configuration conf = NutchConfiguration.create();conf.addResource("crawl-tool.xml");JobConf job = new NutchJob(conf);上面代码中,生成了一个NutchConfiguration类的对象,NutchConfiguration 是Nutch管理自己配置文件的类,Configuration是Hadoop管理自己配置文件的类。

下面我们进入NutchConfiguration类的create()方法。

/** Create a {@link Configuration} for Nutch. */public static Configuration create() {Configuration conf = new Configuration();addNutchResources(conf);return conf;}create()方法中,先生成了一个Configuration类的对象。

数据库调查报告

(范文)数据搜索系统调查研究报告一、选题意义1.随着搜索经济的崛起,人们开始越加关注全球各大搜索引擎的性能、技术和日流量。

作为企业,会根据搜索引擎的知名度以及日流量来选择是否要投放广告等;作为普通网民,会根据搜索引擎的性能和技术来选择自己喜欢的引擎查找资料;作为技术人员,会把有代表性的搜索引擎作为研究对象。

搜索引擎经济的崛起,又一次向人们证明了网络所蕴藏的巨大商机。

网络离开了搜索将只剩下空洞杂乱的数据,以及大量等待去费力挖掘的金矿。

2.随着信息科学的进步与互联网络的发展,网络上的信息资源越来越多,公用数据库的飞速发展为用户查询各种信息提供了可能。

我国有数以百万计的网络用户并且用户人数仍然在急剧的增加。

随着计算机技术、网络技术及通信技术的发展,各种相关信息愈来愈多地通过网络为人们所利用。

而用户深感困惑的是很难在浩瀚如海的信息网络空间里快速、准确的查找到所需要的信息。

当用户面对成千上万的超级链接时便难以检索到合适的信息。

于是,借助搜索引擎进行搜索就是一个非常重要的手段。

随着因特网的迅猛发展、web信息的增加,用户要在信息海洋里查找信息,就象大海捞针一样,搜索引擎技术恰好解决了这一难题(它可以为用户提供信息检索服务)。

目前搜索引擎技术正成为计算机工业界和学术界争相研究、开发的对象。

搜索引擎(search engine)是随着web信息的迅速增加,从1995年开始逐渐发展起来的技术。

据发表在《科学》杂志1999年7月的文章《web信息的可访问性》估计,全球目前的网页超过8亿,有效数据超过9t,并且仍以每4个月翻一番的速度增长。

用户要在如此浩瀚的信息海洋里寻找信息,必然会大海捞针无功而返。

搜索引擎正是为了解决这个迷航问题而出现的技术。

搜索引擎以一定的策略在互联网中搜集、发现信息,对信息进行理解、提取、组织和处理,并为用户提供检索服务,从而起到信息导航的目的。

搜索引擎提供的导航服务已经成为互联网上非常重要的网络服务,搜索引擎站点也被美誉为网络门户。

Nutch-0.8.1中二分法中文分词的实现

在 Nuc一 . 1中的具体 实现 。 t 0. h 8

准确度 , 因此好的搜索引擎必须处理好 中文分词 。现有 的中文

Nt uc h是搜索 引擎 的研 究热 点 , 它的 出现使 得抓 取 、 引 、 索 检索一体化 , 并且开放源 码 , 以让研究者通过配置 , 可 逐步 完善 各个模块 , 从而实现所需 的搜索 引擎。中文 分词是搜 索引擎的

关键 词 :N t 一..;二 分 法 ; 索 引 ;检 索 uc 081 h

0 引 言

随着互联 网的飞速发 展 , 海量的信息 出现在 网络 上 , 了 为 减少 人们 搜索 信 息所 用 的时 间 ,搜索 网站应 运上 。例如 , a i Lin b

维普资讯

计算机 时代 2 0 年 第 7 07 期

・ 9・

N th 081中二分 法 中文分 词 的实现 c 一 .. u

屈 培 。葛 蓁 ( 武汉科技 学 院电信 学 院,湖北 武 汉 407) 303

摘 要 :海量 信 息在 网络上 的 出现 , 搜 索 网站应 运 而 生 , 来越 多的搜 索 工具 受 到 关 注。 t 使 越 Nuc 一个 开 源 介 绍

11 uc . N th介绍

Nt uc h是一个开源 Jv 实现的搜索 引擎。Nuc aa t h的开 源使 得任何人 都可 以了解 它的工作 机制 ; t Nuc h的插件机 制使得它

nutch介绍

搜索过程 Nutch提供了一个Fascade的NutchBean类供我 们使用,一段典型的代码如下

nutch的目标 nutch致力于让每个人能很容易, 同时花费很少 就可以配置世界一流的Web搜索引擎. 为了完成这 一宏伟的目标, nutch必须能够做到: • 每个月取几十亿网页 • 为这些网页维护一个索引 • 对索引文件进行每秒上千次的搜索 • 提供高质量的搜索结果 • 以最小的成本运作 这将是一个巨大的挑战。

Crawler工作流程 1. 创建一个新的WebDb (admin db -create). 2. 将抓取起始URLs写入WebDB中 (inject). 3. 根据WebDB生成fetchlist并写入相应的 segment(generate). 4. 根据fetchlist中的URL抓取网页 (fetch). 5. 根据抓取网页更新WebDb (updatedb).

爬虫,Crawler Index是Crawler抓取的所有网页的索引,它 是通过对所有单个segment中的索引进行合并处 理所得的。Nutch利用Lucene技术进行索引,所 以Lucene中对索引进行操作的接口对Nutch中的 index同样有效。但是需要注意的是,Lucene中 的segment和Nutch中的不同,Lucene中的 segment是索引index的一部分,但是Nutch中的 segment只是WebDB中各个部分网页的内容和索 引,最后通过其生成的index跟这些segment已经 毫无关系了。

爬虫,Crawler Crawler的重点在两个方面,Crawler的工作流 程和涉及的数据文件的格式和含义。数据文件主要 包括三类,分别是web database,一系列的 segment加上index,三者的物理文件分别存储在 爬行结果目录下的db目录下webdb子文件夹内, segments文件夹和index文件夹。那么三者分别 存储的信息是什么目录: 1.crawdb,linkdb 是web link目录,存放url 及url的互联关 系,作为爬行与重新爬行的依据,页面默认30天过期。 2.segments 是主目录,存放抓回来的网页。页面内容有 bytes[]的raw content 和 parsed text的形式。nutch 以广度优先的原则来爬行,因此每爬完一轮会生成一个 segment目录。 3.index 是lucene的索引目录,是indexs里所有index合并 后的完整索引,注意索引文件只对页面内容进行索引,没 有进行存储,因此查询时要去访问segments目录才能获 得页面内容。

大数据分析中的数据采集与清洗自动化工具介绍(Ⅰ)

随着信息技术的不断发展,大数据分析已经成为了企业决策和发展的重要工具。

而在大数据分析的过程中,数据的采集和清洗是至关重要的环节。

本文将介绍几种常用的数据采集与清洗自动化工具,帮助读者更好地理解大数据分析中的关键环节。

一、数据采集工具1. Apache NutchApache Nutch 是一个开源的网络搜索引擎。

它可以帮助用户获取网页信息,并将其转换为结构化的数据,方便后续的分析和处理。

Nutch 支持多种数据存储格式,包括文本、HTML、XML 等,并且可以通过定制插件来扩展其功能。

它的分布式架构和高性能使得它成为了大规模数据采集的首选工具之一。

2. ScrapyScrapy 是一个基于 Python 的开源网络爬虫框架。

它提供了简洁的 API 和强大的选择器功能,可以帮助用户快速高效地获取网页信息。

Scrapy 支持异步网络请求和自定义中间件,同时还提供了丰富的插件和扩展机制。

这使得它成为了一款非常灵活和易用的数据采集工具。

二、数据清洗工具1. OpenRefineOpenRefine(前身为 Google Refine)是一款开源的数据清洗工具。

它支持导入多种数据格式,包括 CSV、JSON、XML 等,同时还提供了强大的数据转换和整合功能。

OpenRefine 还支持实时预览和撤销操作,为用户提供了非常便利的数据清洗环境。

另外,它还支持自定义插件和扩展,使得用户可以根据实际需求定制功能。

2. Trifacta WranglerTrifacta Wrangler 是一款专注于数据清洗和转换的商业工具。

它提供了直观的用户界面和丰富的数据处理操作,可以帮助用户快速高效地清洗数据。

Trifacta Wrangler 还支持数据质量分析和自动化建模,为用户提供了一站式的数据清洗解决方案。

值得一提的是,它还支持与 Hadoop 和 Spark 等大数据处理平台的集成,为用户提供了更加便捷的数据处理流程。

爬虫工具汇总

Arachnid

Arachnid:是一个基于Java的web spider框架.它包含一个简单的HTML剖析器能够分析包含HTML内容的输入流.通过实现Arachnid的子类就能够开发一个简单的Web spiders并能够在Web站上的每个页面被解析之后增加几行代码调用。 Arachnid的下载包中包含两个spider应用程序例子用于演示如何使用该框架。

snoics-reptile

snoics -reptile是用纯Java开发的,用来进行网站镜像抓取的工具,可以使用配制文件中提供的URL入口,把这个网站所有的能用浏览器通过GET的方式获取到的资源全部抓取到本地,包括网页和各种类型的文件,如:图片、flash、mp3、zip、rar、exe等文件。可以将整个网站完整地下传至硬盘内,并能保持原有的网站结构精确不变。只需要把抓取下来的网站放到web服务器(如:Apache)中,就可以实现完整的网站镜像。

3、iSearch

The iSearch PHP search engine allows you to build a searchable database for your web site. Visitors can search for key words and a list of any pages that match is returned to them.

Web-Harvest

Web-Harvest是一个Java开源Web数据抽取工具。它能够收集指定的Web页面并从这些页面中提取有用的数据。Web-Harvest主。

php开源网络爬虫

1、PHPdig是国外非常流行的垂直搜索引擎产品(与其说是产品,不如说是一项区别于传统搜索引擎的搜索技术),采用PHP语言编写,利用了PHP程序运行的高效性,极大地提高除了普通的网页外还包括txt, doc, xls, pdf等各式的文件,具有强大的内容搜索和文件解析功能。

Nutch 使用总结

Nutch 是一个开源Java 实现的搜索引擎。

它提供了我们运行自己的搜索引擎所需的全部工具。

包括全文搜索和Web爬虫。

Nutch使用方法简介:/pengpengfly/archive/2008/09/29/2994664.aspx nutch1.2 eclipse tomcat6.0 配置:/oliverwinner/blog/item/4be3f1370284b32f5ab5f565.htmlNutch 实战:介绍了开源搜索引擎Nutch 的基本信息,详细说明了在Eclispe 下运行Nutch 的步骤和需要注意的问题,还分析了部分源代码。

很好的文章Nutch 目录结构bin:用于命令行运行的文件;conf:Nutch的配置文件lib:一些运行所需要的jar文件;plugins:存放相应的插件;src:Nutch的所有源文件;webapps:web运行相关文件;nutch-0.9.war是Nutch所提供的基于Tomcat的应用程序包。

Nutch工作流程1. 将起始URL 集合注入到Nutch 系统之中。

2. 生成片段文件,其中包含了将要抓取的URL 地址。

3. 根据URL地址在互联网上抓取相应的内容。

4. 解析所抓取到的网页,并分析其中的文本和数据。

5. 根据新抓取的网页中的URL集合来更新起始URL集合,并再次进行抓取。

6. 同时,对抓取到的网页内容建立索引,生成索引文件存放在系统之中。

(1)准备需要的软件列表Cygwin (下载地址:/setup.exe)Jdk(1.4.2以上版本,下载地址/technetwork/java/javase/downloads/jdk-6u29-download-513648.html)Nutch(推荐使用0.9版本,下载地址/dyn/closer.cgi/lucene/nutch/)Tomcat(下载地址/)(2)安装软件1) Cygwin 打开安装程序Cygwin.exe后,在"Choose Installation Type"页选择"Install from Internet"(如果你已经把全部安装包下载到本地,就可以选择"Install from local directory"选项)。

Hadoop论文

Hadoop论文内容摘要:Hadoop是一个由Apache基金会所开发的分布式系统基础架构。

用户可以在不了解分布式底层细节的情况下,开发分布式程序。

充分利用集群的威力进行高速运算和存储。

Hadoop实现了一个分布式文件系统(Hadoop Distributed File System),简称HDFS。

HDFS有高容错性的特点,并且设计用来部署在低廉的(low-cost)硬件上;而且它提供高吞吐量(high throughput)来访问应用程序的数据,适合那些有着超大数据集(large data set)的应用程序。

HDFS放宽了(relax)POSIX的要求,可以以流的形式访问(streaming access)文件系统中的数据。

Hadoop的框架最核心的设计就是:HDFS和MapReduce。

HDFS为海量的数据提供了存储,则MapReduce为海量的数据提供了计算。

正文:在课堂上,老师通过教我们使用虚拟机安装Linux系统ubuntu桌面系统,来使用这款软件,由于在非Windows下使用,对于操作命令不是很熟悉,以及Linux的使用不熟练,遇到了很多问题。

例如网络问题,在VM下,网络可以自行连接也可以和本机共享,在windows自带的Hyper-v上使用时,就需要注意到网络的配置问题,这款虚拟机不会共享网络,而VirualBox却可以直接共享。

安装好虚拟机和ubuntu系统后,接下来就是通过终端使用命令进行安装,这个终端和windows下的cmd类似,但是由于很少使用命令行,所以不熟悉。

然后完成Hadoop的安装。

为hadoop应用添加一个单独的用户,这样可以把安装过程和同一台机器上的其他软件分离开来,使得逻辑更加清晰。

无论是在单机环境还是多机环境中,Hadoop均采用SSH来访问各个节点的信息。

在单机环境中,需要配置SSH来使用户能访问localhost的信息。

首先需要安装openssh-server。

纽太特成分

纽太特成分(最新版)目录1.纽太特的定义与简介2.纽太特的主要成分3.纽太特成分的作用4.纽太特成分的来源与摄取方式5.纽太特成分的益处与注意事项正文纽太特,又称为“纽崔特”或“纽崔莱”,是一种源自美国的营养补充品品牌,以其高品质和科学配方而受到广泛关注。

纽太特产品中包含多种营养成分,那么它们究竟是什么呢?本文将为您详细介绍纽太特的主要成分、作用、来源与摄取方式,以及它们的益处和注意事项。

1.纽太特的定义与简介纽太特作为一家全球领先的健康食品公司,自 1934 年成立以来,始终致力于为消费者提供高品质的营养补充品。

纽太特的产品涵盖了维生素、矿物质、植物营养素等多个领域,为消费者提供全方位的健康保障。

2.纽太特的主要成分纽太特的产品中包含了许多营养成分,其中最主要的成分包括:维生素、矿物质、植物营养素和蛋白质。

这些成分在人体健康中扮演着举足轻重的角色。

3.纽太特成分的作用纽太特的成分在人体健康中发挥着重要作用,例如:- 维生素:维持生命活动所需的有机物质,参与人体新陈代谢过程,帮助身体吸收和利用其他营养物质。

- 矿物质:构成人体组织和骨骼,参与酶反应,维持酸碱平衡和神经肌肉功能。

- 植物营养素:具有抗氧化、抗炎、降低胆固醇等多种生理功能,有益于人体健康。

- 蛋白质:构成人体组织和细胞,参与生长发育、修复损伤、免疫应答等多种生理过程。

4.纽太特成分的来源与摄取方式纽太特成分的来源丰富多样,包括水果、蔬菜、谷物、豆类、肉类等。

为了确保摄取到足够的营养成分,建议大家在日常生活中保持合理的膳食结构,同时可以适当补充纽太特等营养补充品。

5.纽太特成分的益处与注意事项纽太特成分的摄入有助于维持人体健康、预防疾病、提高免疫力等。

然而,在摄取纽太特成分时,还需注意以下几点:- 根据个人需求和实际情况选择适当的营养成分和补充品。

- 注意补充品的剂量,避免过量摄入。

- 保持良好的生活习惯,合理膳食与运动相结合。

- 如有特殊疾病或健康状况,请在医生指导下使用。

大数据分析中的数据采集与清洗自动化工具介绍(四)

大数据分析中的数据采集与清洗自动化工具介绍随着互联网的快速发展,大数据分析已经成为企业决策和发展的重要工具。

然而,大数据分析的第一步是数据的采集和清洗,这是一个耗时且繁琐的过程。

为了解决这个问题,许多公司和组织开发了各种数据采集与清洗自动化工具,以提高效率和准确性。

一、数据采集自动化工具数据采集是大数据分析的第一步,它涉及从各种来源收集数据并将其存储在一个统一的数据库中。

为了简化这一过程,许多公司开发了各种数据采集自动化工具。

这些工具可以从互联网上抓取数据,或者从各种数据库和文件中提取数据。

其中一个常用的数据采集自动化工具是Apache Nutch。

这是一个开源的网络爬虫工具,可以用于从互联网上抓取数据。

它支持分布式部署,可以快速地抓取大规模的网页数据,并将其存储在Hadoop分布式文件系统中。

另一个常用的工具是,它可以从网页上提取数据,并将其转换成结构化的数据。

这个工具可以帮助用户从网页上抽取各种类型的数据,例如商品价格、新闻文章等。

二、数据清洗自动化工具一旦数据被采集到统一的数据库中,就需要进行清洗以确保数据的质量和准确性。

数据清洗涉及删除重复记录、填补缺失值、纠正错误值等操作。

为了简化这一过程,许多公司开发了各种数据清洗自动化工具。

其中一个常用的数据清洗自动化工具是OpenRefine。

它是一个开源的数据清洗工具,可以帮助用户快速地对数据进行清洗和转换。

OpenRefine支持导入各种类型的数据,包括CSV、Excel、JSON等格式。

它提供了丰富的数据清洗操作,例如拼写检查、分割列、合并列等。

另一个常用的工具是Trifacta Wrangler,它是一个基于云的数据清洗工具,可以帮助用户快速地进行数据清洗和转换。

Trifacta Wrangler提供了直观的用户界面,可以帮助用户快速地理解数据的结构和质量,并进行相应的清洗操作。

三、数据采集与清洗自动化工具的优势数据采集与清洗自动化工具的出现,为大数据分析提供了便利。

数据处理中的数据采集和数据清洗工具推荐

数据处理中的数据采集和数据清洗工具推荐随着信息技术的飞速发展和互联网的普及,数据成为了当今社会的重要资源。

然而,海量的数据对于人工处理来说是一项巨大的挑战。

为了更好地处理和利用这些数据,数据采集和清洗工具成为了必不可少的工具。

在本文中,我将向大家介绍几种值得推荐的数据采集和数据清洗工具。

一、数据采集工具1. Apache NutchApache Nutch是一个开源的网络爬虫工具,它可以帮助用户从互联网上采集数据。

它支持多种数据源,包括网页、新闻、论坛等。

Apache Nutch具有高度的可扩展性和定制性,用户可以根据自己的需求定制采集规则和过滤条件。

同时,它还提供了强大的分布式处理能力,能够处理大规模数据采集任务。

2. OctoparseOctoparse是一款简单易用的网络爬虫软件,它可以帮助用户从各种网站上采集数据。

Octoparse提供了友好的界面和丰富的功能,用户无需编写代码即可完成复杂的数据采集任务。

它支持多种数据输出格式,如Excel、CSV等,方便用户进行后续的数据处理和分析。

3. SeleniumSelenium是一个流行的自动化测试工具,但它也可以用于数据采集。

Selenium可以模拟用户在浏览器上的操作,导航到需要采集数据的网页,然后提取所需的数据。

Selenium支持多种浏览器和编程语言,用户可以根据自己的喜好选择合适的环境。

二、数据清洗工具1. OpenRefineOpenRefine是一款强大的数据清洗工具,它可以帮助用户处理各种数据质量问题。

OpenRefine支持数据导入、转换、清洗和导出等功能,用户可以通过它进行数据去重、格式转换、缺失值处理等操作。

OpenRefine还提供了丰富的文本处理和数据操作函数,方便用户进行复杂的数据清洗任务。

2. Trifacta WranglerTrifacta Wrangler是一款基于人工智能的数据清洗工具,它可以自动识别和推荐数据清洗操作。

nutch的基本工作流程理解

今天研究了Nutch,差不多已经好几个小时了,到现在还没有搞定,也这么晚了,先记录下来,明天继续吧。

一开始很多时间都浪费在了cygwin的安装上了,bs这个软件的开发者了,一个不伦不类的软件安装程序,安装的时候还要从网上下载东东。

不过最后终于装成功了,先下载到本地后,再安装的(建议下载站点中选 TW 的比较块)。

下面是我安装CYGWIN和NUTCH的过程,都块成功了,但最后卡在了用户查询界面,输入东西什么都查不出来,不知怎么回事。

NUTCH的大致原理如下:安装步骤参考了该文章一、环境:1.操作系统:windowsXp,windows2000+2.javaVM:java1.5.x,设置JAVA_HOME到环境变量3.cygwin,当然这个不是必需的,只是nutch提供的脚本只能在shell环境下使用,所以使用cygwin来虚拟shell命令。

4.nutch版本:0.85.tomcat:5.0二、cygwin的安装:cygwin的安装在Nutch在Windows中安装之细解一文中有较为详细的介绍,此处不再介绍安装步骤,只介绍安装后需要如何判断是否能够使用:在cygwin 的安装目录下,查找x:\cygwin\cygwin\bin\sh.exe,存在此命令即可使用。

cygwin在删除后会发现无法再次成功安装的问题,可以通过注册表内的查找功能,删除所有包含cygwin内容的键值即可。

三、nutch的安装和配置:1。

从/nutch/release/下载0.8或更高的版本,解压缩后,放置到cygwin的根目录下,如图:图中可以看到nutch目录在cygwin的根目录下。

2。

在nutch/bin下,建立urls目录,然后建立一个url.txt文件,在url.txt 文件内写入一个希望爬行的url,例如:,目录结构如图:3。

打开nutch\conf\crawl-urlfilter.txt文件,把字符替换为url.txt内的url的域名,其实更简单点,直接删除 这几个字就可以了,也就是说,只保存+^http://([a-z0-9]*\.)*这几个字就可以了,表示所有http的网站都同意爬行。

nutch2+Hbase+Slor4浅谈--Nutch-2.2.1+Hbase-0.90.4+Slor-4.4.0+Hadoop-1.1.2

浅谈--Nutch-2.2.1+Hbase-0.90.4+Slor-4.4.0+Hadoop-1.1.2组合分布式搜索引擎集群搭建指南介绍Nutch 网络爬虫Hbase 分布式存储系统Solr 搜索服务器版本说明由于Nutch\Hbase\Solr他们都各自做在自己的版本修改,所以配置他们三者有不同的方法.这里也是参考网络文档做了他们最新版本的配置 Nutch版本(2.2.1) apache-nutch-2.2.1-src.tar.gz;由于改版本的Nutch默认的Hbase版本是0.90.4 所以这里就使用的hbase-0.90.4.tar.gz ;同时Nutch默认的Solr版本是3.4.0版本,但由于Solr4与三的版本变化比较大,所以这里我使用的是当前最新的4版本solr-4.4.0.tgz。

apache-nutch-2.2.1-src.tar.gzhbase-0.90.4.tar.gzsolr-4.4.0.tgz下载Nutch 首页/下载地址apache-nutch-2.2.1-src.tar.gzHbase 首页/下载地址hbase-0.90.4.tar.gzSolr 首页/solr/下载地址solr-4.4.0.tgz安装JDK参考:Linux安装JDK安装Hbase单机版的HBase由于Hbase是一个分布式的数据库,所以我们经常与Hadoop联系起来一起用。

可以参考(Hbase入门——安装),但我们在开放中其实未必有条件使用。

使用这里就可以不于hadoop一起使用,使用这里就直接安装单击版的Hbase。

来在官方的安装和使用/book/quickstart.html。

解压hbase-0.90.4.tar.gz先拷贝文件到/usr/local/目录下$ tar xfzhbase-0.90.4.tar.gz$ chmod -R777 hbase-0.90.4编辑 conf/hbase-site.xml在中添加如下内容。

施磊磊的双周汇报书面版5

双周汇报最近一直在研究nutch,版本是0.9 的,各项功能都是很齐全的,最后也是成功的实现了搜索引擎的一般功能,现在感觉在此基础之上要研究一下排序算法。

Nutch现在的发展的版本已经是蛮高的了,0.9的版本也是一个分界线,懂了最基本的功能以后就能实现更多的功能,现在界面能自己修改,和百度相比最重要的差别在于排序的算法方面的东西,这个nutch本身的算法并不是很好,只是类似于google的pagerank算法,看了很多的这方面的论文,改进的都是pagerank的算法,然后进行相关的实验就说是改进了该算法,我感觉这个很搞笑,只是和pagerank本身对比,我认为这个是没有什么可比性的,可以分析很多的论文,看看其他人用的的是什么样的排序算法,做了哪些方面的改进,然后效率提高了多少,也只有这样的实验或是对比才是让人感觉比较合乎逻辑的。

接下来我的重点就放在了排序算法的研究上,当然在其他的方面也是有很多值得我去改进的地方,每个搜索引擎的整体架构方面的算法很多,有很多值得我去完善的地方,下面先简要的介绍一下nutch的整体架构方面的知识点。

1、Apache NutchApache Nutch是一个用于网络搜索的开源框架,它提供了我们运行自己的搜索引擎所需的全部工具,包括全文搜索和Web爬虫。

Nutch=lucene+hadoop+爬虫1.1、Nutch的组件结构WebDB:存储网页数据和连接信息Fetch lists:将WebDB所存储的连接分成多个组,来用于分布式检索Fetchers:检索Fetch list中的内容并下载到本地,共有两项输出:分别是连接的update信息和内容contentUpdates:更新WebDB的页面检索状态WebDB、updates、fetch lists和fetchers组成循环结构,不断运行下去,来确保所得到的Web镜像是最新的Content:界面内容,获取内容之后,Nutch便可以根据它来创建索引并执行查询操作Indexers:对目标Content创建索引,当索引内容较大时,可把索引划分成多个索引片段,然后分配给不同的seracher实现并行检索Searchers:实现查询功能的同时也会缓存contentWebservers:有两种角色:1处理用户的交互请求(Nutch Search Client)2从searchers中获取查询结果(HTTP Server)注:fetchers和searchers两个节点所对应的操作可放到分布式环境(hadoop)中去完成,这个方面的实践部分可以试一试,也就是这个分布式的环节使得这个nutch能够应用到我们现在的大数据时代。

Nutch中文分词的研究和改进

Nutch中文分词的研究和改进摘要:介绍了在Nutch1.0中加入Paoding's Knives中文分词的原因及实现方法。

通过实例测试,对结果进行分析和比较,说明了Paoding's Knives中文分词能够较好地满足实际的中文搜索需求。

关键词:Nutch;搜索引擎;中文分词;Paoding's Knives1 中文分词和Nutch中文分词的缺点中文分词是构建检索类系统需要重点考虑的一个因素,它直接影响着搜索结果的相关度排序和搜索的效率及准确程度。

分词的准确性对搜索引擎来说十分重要,但如果分词速度太慢,即使准确性再高,对于搜索引擎来说也是不可用的,因为搜索引擎需要处理数以亿计的网页,如果分词耗用的时间过长,会严重影响搜索引擎内容更新的速度。

因此对于搜索引擎来说,分词的准确性和速度,二者都需要达到很高的要求。

Nutch的分词对英文的切分比较完善,在中文分词上使用的是默认的单字切分,即每个字被认为是一个词。

这种以单个汉字索引方式来分词的方法效果不是很理想,不能满足中文搜索的实际需求。

因此我们需要新的分词器,来实现对中文搜索的良好支持。

目前的中文分词组件有Paoding's Knives、CJKAnalyzer、JE、ICTCLAS等,其中Paoding's Knives是一个开源的,使用Java开发的分词组件。

它具有高效和高扩展性等特点,采用基于不限制个数的词典文件对文章进行有效切分,能够对词汇分类定义,能够对未知的词汇进行合理解析,成为首选的中文分词开源组件。

2 Nutch中文分词的实现2.1 Nutch分词架构Nutch分词的最底层使用的是lucene的Analyzer抽象类,它位于org.apache.lucene.analysis包。

NutchAnalyzer继承了Analyzer类,是Nutch中扩展分析文本的扩展点,所有用于解析文本的插件都得实现这个扩展点。

大数据时代下智慧物流发展策略探究——以“京东物流青龙系统”为例

收稿日期:2020-10-09作者简介:孙婷姝(1994-),女,辽宁沈阳人,硕士研究生,从事现代服务业与商品流通研究。

对于大数据最早的引用来源于Apache 的开源项目Nutch,意指需要同时进行分布式处理分析的数据集[1]。

云时代的来临标志着新一代信息技术愈加深入地渗透到各行各业的发展。

物流企业逐步实现信息化、大数据技术在物流产业的应用推进了其智能转型与产业调整的进程,智能化、自动化、可视化、网络化、可控化的智慧物流将极大赋能经济高质量发展。

一、智慧物流概念的提出与国内外发展现状(一)智慧物流概念及其提出物流活动是国民经济的重要组成部分。

物流是指物质资料等在时间空间两个层次上的状态变化的过程;智慧物流是在此基础上,利用先进的大数据信息收集、处理、流通等技术,把人员和系统更好结合起来,使物质资料的移动实现网络化、自动化、智能化、可视化、可控化的整个过程。

智慧物流的概念最早来源于2008年11月IBM 在外国关系理事会上首次提出的“智慧地球”。

2009年美国总统奥巴马公开肯定“智慧地球”思路,并将“智慧的地球”作为美国国家战略。

奥巴马总统认为,IT 产业应通过“物联网”与互联网的整合使人类的生产生活达到“智慧”状态,从而提高整个社会的生产效率,使资源配置更趋合理,资源利用更趋高效。

同年,IBM 公司提出建立一个面向未来的具有先进、互联和智能三大特征的供应链,通过感应器、RFID 标签、制动器、GPS 和其他设备及系统生成实时信息的“智慧供应链”概念,紧接着“智慧物流”的概念由此延伸而出。

智慧物流的理念顺应信息时代发展,标志着物流业未来发展趋势主要以大数据、云计算以及人工智能为技术支撑,全面优化物流的各个环节,提高各方效益,优化资源利用,通过建立智能化的管控系统,使得物流配送面向各主体,实现更加高效的深度协同,从而打造智慧化物流体系。

(二)智慧物流国内外发展现状1.国外发展状况近年来,智慧物流在美国、日本等发达国家发展较快。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第三 nutch介绍

软件学院 刘高原

L/O/G/O

什么是nutch Nutch 是一个开源的、Java 实现的搜索引擎。 它提供了我们运行自己的搜索引擎所需的全部工具。

nutch的目标 nutch致力于让每个人能很容易, 同时花费很少 就可以配置世界一流的Web搜索引擎. 为了完成这 一宏伟的目标, nutch必须能够做到: • 每个月取几十亿网页 • 为这些网页维护一个索引 • 对索引文件进行每秒上千次的搜索 • 提供高质量的搜索结果 • 以最小的成本运作 这将是一个巨大的挑战。

爬虫,Crawler

Web database,也叫WebDB,其中存储的是爬虫所 抓取网页之间的链接结构信息,它只在爬虫Crawler工作 中使用而和Searcher的工作没有任何关系。WebDB内存 储了两种实体的信息:page和link。Page实体通过描述网 络上一个网页的特征信息来表征一个实际的网页,因为网 页有很多个需要描述,WebDB中通过网页的URL和网页内 容的MD5两种索引方法对这些网页实体进行了索引。Page 实体描述的网页特征主要包括网页内的link数目,抓取此 网页的时间等相关抓取信息,对此网页的重要度评分等。 同样的,Link实体描述的是两个page实体之间的链接关系。 WebDB构成了一个所抓取网页的链接结构图,这个图中 Page实体是图的结点,而Link实体则代表图的边。

爬虫,Crawler Index是Crawler抓取的所有网页的索引,它 是通过对所有单个segment中的索引进行合并处 理所得的。Nutch利用Lucene技术进行索引,所 以Lucene中对索引进行操作的接口对Nutch中的 index同样有效。但是需要注意的是,Lucene中 的segment和Nutch中的不同,Lucene中的 segment是索引index的一部分,但是Nutch中的 segment只是WebDB中各个部分网页的内容和索 引,最后通过其生成的index跟这些segment已经 毫无关系了。

爬虫,Crawler

爬虫,Crawler Crawler的重点在两个方面,Crawler的工作流 程和涉及的数据文件的格式和含义。数据文件主要 包括三类,分别是web database,一系列的 segment加上index,三者的物理文件分别存储在 爬行结果目录下的db目录下webdb子文件夹内, segments文件夹和index文件夹。那么三者分别 存储的信息是什么呢?

谢谢!

L/O/G/O

爬虫,Crawler 一次爬行会产生很多个segment,每个 segment内存储的是爬虫Crawler在单独一次抓 取循环中抓到的网页以及这些网页的索引。 Crawler爬行时会根据WebDB中的link关系按照 一定的爬行策略生成每次抓取循环所需的fetchlist, 然后Fetcher通过fetchlist中的URLs抓取这些网 页并索引,然后将其存入segment。Segment是 有时限的,当这些网页被Crawler重新抓取后,先 前抓取产生的segment就作废了。在存储中。 Segment文件夹是以产生时间命名的,方便我们 删除作废的segments以节省存储空间。

Crawler工作流程 1. 创建一个新的WebDb (admin db -create). 2. 将抓取起始URLs写入WebDB中 (inject). 3. 根据WebDB生成fetchlist并写入相应的 segment(generate). 4. 根据fetchlist中的URL抓取网页 (fetch). 5. 根据抓取网页更新WebDb (updatedb).

Crawler工作流程 6. 循环进行3-5步直至预先设定的抓取深度。 7. 根据WebDB得到的网页评分和links更新 segments (updatesegs). 8. 对所抓取的网页进行索引(index). 9. 在索引中丢弃有重复内容的网页和重复的URLs (dedup). 10. 将segments中的索引进行合并生成用于检索 的最终index(merge).

Nutch主要分为两个部分 爬虫crawler和查询searcher。Crawler主要 用于从网络上抓取网页并为这些网页建立索引。 Searcher主要利用这些索引检索用户的查找关键 词来产生查找结果。两者之间的接口是索引,所以 除去索引部分,两者之间的耦合度很低。 Crawler和Searcher两部分尽量分开的目的 主要是为了使两部分可以分布式配置在硬件平台上, 例如将Crawler和Searcher分别放在两个主机上, 这样可以提升性能。

在创建一个WebDB之后(步骤1), “产生/抓取/ 更新”循环(步骤3-6)根据一些种子URLs开始启 动。当这个循环彻底结束,Crawler根据抓取中生 成的segments创建索引(步骤7-10)。在进行 重复URLs清除(步骤9)之前,每个segment的 索引都是独立的(步骤8)。最终,各个独立的 segment索引被合并为一个最终的索引index(步 骤10)。

Crawler工作流程 首先Crawler根据WebDB生成一个待抓取网 页的URL集合叫做Fetchlist,接着下载线程 Fetcher根据Fetchlist将网页抓取回来,如果下载 线程有很多个,那么就生成很多个Fetchlist,也 就是一个Fetcher对应一个Fetchlist。然后 Crawler用抓取回来的网页更新WebDB,根据更 新后的WebDB生成新的Fetchlist,里面是未抓取 的或者新发现的URLs,然后下一轮抓取循环重新 开始。这个循环过程可以叫做“产生/抓取/更新” 循环。