Nutch 使用总结

网络数据采集框架Nutch及其应用研究

网络数据采集框架Nutch及其应用研究一、Nutch框架简介Nutch是一个开源的网络数据采集框架,最早由Doug Cutting创建于2002年,它使用Java语言编写,可以在大规模的网络环境中进行数据的采集和处理。

Nutch的核心组件包括了一个网络爬虫和一个索引器,它们可以协同工作来对互联网上的各种信息进行抓取、存储、索引和搜索。

Nutch框架的设计理念是模块化和可扩展的,使得用户可以根据自己的需求来定制和扩展不同的功能,从而实现个性化的数据采集和处理。

二、Nutch的工作原理Nutch框架的工作原理可以简单概括为以下几个步骤:1. 网络爬取:Nutch通过网络爬虫来遍历互联网上的网页,并对这些网页进行数据的抓取和提取。

2. 数据存储:Nutch使用分布式文件系统来存储抓取到的数据,这样可以有效地管理和存储大量的网络数据。

3. 数据索引:Nutch使用索引器来对抓取到的数据进行索引,从而可以更快速地进行搜索和检索。

通过这些步骤,Nutch可以实现对互联网上的大量数据进行高效的采集和处理,为用户提供了一个方便和强大的工具来进行网络数据的分析和利用。

三、Nutch的应用研究1. 企业信息采集:在企业信息化建设中,Nutch可以用来对竞争对手的产品信息、市场动态和客户需求等进行采集和分析,从而帮助企业制定更加科学和有效的决策。

2. 社交网络分析:社交网络中的信息是非常丰富和多样的,Nutch可以用来对这些信息进行采集和整理,从而为研究人员和分析师提供有力的支持。

3. 互联网舆情监测:Nutch可以实现对互联网上的舆情信息进行自动化的采集和分析,帮助政府和企业在第一时间掌握舆情动向,及时做出相应的处理。

4. 学术研究和信息检索:研究人员可以使用Nutch来对学术网站和数据库中的文献信息进行采集和整理,从而帮助他们进行更加有效的文献检索和资料分析。

以上仅是Nutch在一些典型领域的应用情况,实际上Nutch在网络数据采集和分析方面还有很多其他的应用场景,如金融行业的信息监测、政府部门的数据整合等。

网络数据采集框架Nutch及其应用研究

网络数据采集框架Nutch及其应用研究一、Nutch框架概述Nutch是一种全文搜索引擎和网络爬虫框架,是由Apache Lucene和Hadoop等开源软件组成的平台。

它包括爬虫、索引器和搜索器等模块,可以对互联网上的文本、图像、视频等数据进行采集、存储、处理和检索。

Nutch的设计目标是实现一个高度可扩展的网络爬虫系统,支持定制化开发和快速性能优化。

Nutch的架构基于分布式计算,由多个节点协同工作完成大规模数据采集和处理任务。

它使用Hadoop作为底层的分布式计算框架,可以支持海量数据的并行处理和计算。

同时,Nutch也提供了灵活的配置选项和丰富的插件机制,可以根据不同的需求和场景进行自定义开发和扩展功能。

1. 开源:Nutch是一种开源软件,可以自由获取和使用,具有较低的开发和维护成本。

2. 可扩展性强:Nutch采用分布式计算和插件机制,可以方便地增加和扩展新的功能模块和算法。

3. 支持多语言:Nutch可以支持多种语言的分词和搜索,包括英语、中文、日语等。

4. 支持自定义:Nutch可以根据用户的需求和场景进行自定义开发和优化,例如自定义爬虫策略、页面过滤规则、索引器等。

5. 数据可视化:Nutch可以将采集的数据进行可视化处理,例如生成统计图表、地理信息图等。

1. 信息检索Nutch可以通过网络爬虫批量采集互联网上的文本、图像、视频等信息,再通过索引器建立数据索引,最终通过搜索器实现信息检索。

在这一过程中,Nutch可以支持多种搜索算法和检索模式,并提供定制化开发选项。

2. 情感分析通过采集互联网上的社交媒体、博客、新闻等数据,Nutch可以支持情感分析的研究。

情感分析是指通过自然语言处理和机器学习技术,对文本内容进行情绪分类和评价的过程。

Nutch可以支持多语言的分词和情感分析,例如中文、英语等。

3. 数据挖掘通过采集互联网上的数据,Nutch可以为用户提供数据挖掘的服务。

数据挖掘是指通过计算机技术分析、提取、过滤和预测数据的过程,可以应用于商业分析、科研、市场调研等领域。

Nutch爬虫与搜索引擎开发实践

Nutch爬虫与搜索引擎开发实践随着大数据时代的到来,信息爆炸的情况越来越严重,需要开发出高效的搜索引擎来应对这个挑战。

目前,较为流行的搜索引擎开发框架有Nutch、Solr、Elasticsearch等。

其中,Nutch作为一款基于Java语言开发的搜索引擎框架,已经在大量的搜索引擎开发实践中被广泛应用。

Nutch是什么?Nutch是基于网络爬虫技术的搜索引擎框架,在爬取网页的基础上利用索引和搜索等技术来实现网页的搜索和处理。

与其他搜索引擎框架比较,Nutch的优势在于它的高度可配置性和开放性。

用户可以自由地根据自己的需要来修改、扩展Nutch的功能,实现个性化的搜索引擎开发。

Nutch的使用方法Nutch的使用方法主要包括以下几个步骤:1. 安装配置首先,需要从官网下载Nutch安装包并解压缩到本地目录。

然后将其配置成本地的web搜索引擎。

2. 编写配置文件Nutch的配置文件包括nutch-site.xml、gora.properties、conf\/nutch-default.xml等。

其中,nutch-site.xml文件是Nutch的核心配置文件,用于配置Nutch的相关参数、属性和插件。

gora.properties 文件是Gora数据存储库的配置文件,在使用Nutch的过程中需要配置Gora 库的相关参数。

3. 编写爬虫插件Nutch的核心功能是爬虫,而爬虫插件就是爬虫执行的操作。

Nutch提供了多种不同类型的插件,包括解析器、抓取器、链接程序等,用户可以根据自己的需求编写自己的插件。

4. 配置爬虫FilterNutch提供了多种不同类型的Filter,可以选择合适的Filter来爬取网页。

Filter的作用是对爬取到的网页进行过滤和处理,以保证能够爬取到最符合需求的网页。

5. 运行爬虫根据配置文件和爬虫插件的要求,可以运行Nutch的爬虫程序。

在爬取过程中,Nutch会自动爬取符合规则的网页,并进行解析、处理和存储等操作。

nutch+hadoop集群总结磊磊版

1.下载Nutch-1.6-src.tar.gz /apache/nutch/1.6/将Nutch-1.6-src.tar.gz复制到usr/目录下sudo cp /home/franklin/Documents/apache-nutch-1.6-src.tar.gz /usr/并解压sudo tar -zxf apache-nutch-1.6-src.tar.gz改变apache-nutch-1.6的权限sudo chown hadoop:hadoop apache-nutch-1.62.使用ant对nutch进行编译ant的安装:下载ant-1.9.0 /bindownload.cgi将apache-ant-1.9.0-bin.tar.gz复制到usr下sudo cp /home/franklin/Documents/apache-ant-1.9.0-bin.tar.gz /usr/ 解压之sudo tar -zxf apache-ant-1.9.0-bin.tar.gz配置ant的环境变量sudo gedit /etc/profile加入如下内容export ANT_HOME=/usr/apache-ant-1.9.0在PATH后添加:$ANT_HOME/bin验证ant是否配置成功ant -version出现如下提示即配置成功使用ant对nutch进行编译进入apache-nutch-1.6.0目录下,运行ant命令,就会根据build.xml对nutch进行编译(需要等一段时间,因为要通过网络下载)编译成功总共花了15分钟编译完后会在apache-nutch-1.6.0目录下看到一个runtime目录进入该目录会发现一个local目录和一个deploy目录,一个是本地模式,一个是分布式模式。

很重要的是每次修改配置文件都需要重新ant编译一下3.本地模式下运行nutch的爬虫进行爬取进入runtime/local/conf下配置nutch-site.xmlsudo gedit nutch-site.xml在configuration中加入如下内容:<property><name></name><value>My Nutch Spider</value></property>创建爬虫爬取的Url新建urls目录sudo mkdir urls在urls目录下新建seed.txtsudo touch seed.txt改变seed.txt的读写权限chmod 777 seed.txt写入爬取Urlsudo echo / > seed.txt设置爬取的规则进入apache-nutch-1.6.0/runtime/local/conf目录下sudo gedit regex-urlfilter.txt将这两行内容# accept anything else+.替换为 +^http://([a-z0-9]*\.)*/运行ant重新编译一下开始爬取进入apache-nutch-1.6.0/runtime/local 运行bin/nutch crawl /data/urls/seed.txt -dir crawl -depth 3 -topN 5爬取的过程中出现错误:这是由于上一次运行爬取命令生成了一个不完整的segments/20130434113019造成的,到相应目录下将该文件夹删除即可爬取完毕:在输出结果的文件夹中可以看见:crawldb/ linkdb/ segments/4.分布式模式下运行nutch爬虫进行爬取启动hadoop的所有节点bin/start-all.sh进入apache-nutch-1.6.0/conf下配置nutch-site.xmlsudo gedit nutch-site.xml在configuration中加入如下内容:<property><name></name><value>My Nutch Spider</value></property>将爬取的url复制到hadoop分布式文件系统中设置爬取规则:进入apache-nutch-1.6.0/conf目录下sudo gedit regex-urlfilter.txt将这两行内容# accept anything else+.替换为 +^http://([a-z0-9]*\.)*/运行ant重新编译一下开始爬取进入apache-nutch-1.6.0/runtime/deploy 运行bin/nutch crawl /data/urls/seed.txt -dir crawl -depth 3 -topN 5可以看到爬取任务被提交给hadoop的mapping和reducing通过50030端口可以看到jobtracker运行的状态运行完毕:爬取完毕后可以通过50070查看hadoop的分布式文件系统点击Browse the filesystem:可以看到分布式文件系统下的文件进入该目录下可以看到爬取输出的内容至此所有配置测试完毕。

网络数据采集框架Nutch及其应用研究

网络数据采集框架Nutch及其应用研究Nutch是一个开源的网络数据采集框架,最初由Doug Cutting开发,并于2003年开源。

它是一个基于Java的框架,用于从互联网上采集和索引大规模数据,支持分布式环境并具有高度可扩展性。

Nutch基于Apache Hadoop构建,使用了分布式文件系统HDFS和分布式计算框架MapReduce。

Nutch的主要目标是从互联网中获取低成本、可扩展和高可靠性的大规模数据,并为用户提供强大的搜索和分析功能。

Nutch提供了丰富的功能和工具,包括网络爬虫、数据提取、网页解析、数据清洗和索引等,使用户能够灵活地定制和扩展自己的数据采集系统。

Nutch的应用研究主要集中在以下几个方面:1. 网络爬虫技术:Nutch实现了高度可配置和可扩展的网络爬虫,能够从互联网上快速、智能地抓取和下载网页。

研究者可以基于Nutch提供的框架进行网络爬虫性能的优化、爬取策略的设计和算法的改进等。

2. 数据提取和网页解析:Nutch提供了丰富的数据提取和网页解析功能,可以自动从网页中提取结构化的数据。

研究者可以基于Nutch进行数据提取算法的研究和改进,使其能够更加准确和高效地从网页中提取有用的信息。

3. 数据清洗和去重:Nutch提供了强大的数据清洗和去重功能,可以对采集到的数据进行过滤、去噪和重复数据的删除。

研究者可以基于Nutch开发各种数据清洗和去重算法,以提高数据的质量和准确性。

4. 数据索引和搜索:Nutch使用Apache Solr作为搜索引擎,可以对采集到的数据进行索引和搜索。

研究者可以基于Nutch进行搜索引擎的性能优化、搜索算法的改进和用户体验的提升等研究工作。

5. 分布式计算和大数据处理:Nutch基于Apache Hadoop构建,可以运行在分布式环境下,并利用HDFS和MapReduce进行大规模数据的处理和分析。

研究者可以基于Nutch进行分布式计算和大数据处理算法的研究和开发。

网络数据采集框架Nutch及其应用研究

网络数据采集框架Nutch及其应用研究1. 引言1.1 Nutch框架简介Nutch框架是一个开源的网络数据采集框架,它可以帮助用户从互联网上获取大量的数据并进行处理。

该框架由Apache软件基金会开发和维护,采用Java语言编写,具有良好的跨平台性和扩展性。

Nutch框架的设计初衷是为了解决互联网上海量数据的采集和处理问题,为用户提供一个高效、可靠的数据采集解决方案。

Nutch框架的核心功能包括网络爬虫、数据存储、数据索引和搜索等,通过这些功能可以实现对互联网上各种类型数据的采集、存储和检索。

用户可以基于Nutch框架构建自己的定制化数据采集系统,根据自己的需求和规模进行扩展和优化。

Nutch框架是一个强大的数据采集工具,可以帮助用户快速高效地获取网络上的各种数据资源。

通过学习和使用Nutch框架,用户可以更好地理解网络数据采集的原理和方法,为自己的研究和应用提供更有力的支持。

1.2 研究背景在当今信息爆炸的时代,如何高效地获取和处理海量的网络数据成为了各行各业都面临的挑战之一。

随着互联网的迅猛发展,网络数据的规模和复杂度不断增加,传统的数据采集方法已经无法满足现代大数据的需求。

人们急需一种高效、可扩展、可定制的网络数据采集框架来帮助他们解决这一难题。

本研究将重点关注Nutch框架的原理与特点、应用领域、功能模块、在数据采集中的作用以及优缺点等方面展开探讨,旨在深入分析Nutch框架的特点和价值,为进一步应用和推广Nutch框架提供理论支持和实践指导。

1.3 研究意义研究Nutch框架的意义主要体现在以下几个方面:Nutch框架可以帮助研究人员快速、高效地收集网络上的数据,为相关研究提供数据支持;Nutch框架的应用广泛,涉及到搜索引擎、网络爬虫、舆情分析等领域,可以满足不同领域的需求;通过研究Nutch框架的原理和特点,可以促进网络数据采集技术的进步和发展,推动整个领域的发展;针对Nutch框架的优缺点,可以有针对性地改进和优化框架,提高数据采集的效率和质量。

HadoopNutch学习整理(持续更新) 电脑资料

HadoopNutch学习整理(持续更新)电脑资料Nutch学习第一部分单机尝试1、安装部署Nutch的部署和其他Hadoop生态产品的部署流程根本相似:下载软件,上传到效劳器,解压文件,修改配置文件,domain-urlfilter.txt 是用来配置所爬取网站的范围,域名和它的子网页的正那么表达式,类似于爬取规那么。

一般配置为: # aept hosts in +^([a-z0-9]*\.)*/ nutch-site.xml 这类似于对我要爬取的网站进展一下声明,不声明的话,会导致爬取失败。

2、单机主要爬取命令简单命令格式,不赘述。

bin/nutch crawl [-dir d] [-threads n] [-depth i] [-topN]3、爬取结果解析nutch爬取下来的网页信息,保存路径格式如下:主要爬取信息保存在路径segments下:vcD4KPHVsPgo8bGk+Q3Jhd2xkYsrHy/nT0NDo0qrXpcihtcSzrMGsvdxc+i KLTmt8XPwtTYtcRVUkyjrLywz8LU2LXEyNXG2qOs08PAtNKzw+a4/NDCvOy y6cqxvOSjrNK7sOPU2sXAyKHE2sjdveLO9sq9sru74dPDtb2jqTxsaT5MaW 5rZGLW0LTmt8W1xMrHy/nT0LOsway907ywxuTDv7j2way907XEwazI67XY1 re6zcOqzsSxvqGjPGxpPlNlZ21lbnRztOa3xdelyKG1xNKzw+ajrNPryc/D 5sG0vdPJ7rbIIGRlcHRoIM/gudijrGRlcHRoyejOqry41PLU2iBzZWdtZW5 0c8/Cyfqzyby4uPbS1MqxvOTD/MP7tcTX087EvP680KGjz8LA/b3YzbzKxw ogLWRlcHRoPTMKCjxpbWcgc3Jj==".2cto./uploadfile/Collfiles/xx 1127/xx112709151123.jpg" alt="\">Segments下的文件夹含义:crawlgenerate :names a set of urls to be fetched crawlfetch : contains the status of fetching each urlcrawlparse : contains the outlink urls, used to update the crawldbcontent : contains the content of each urlparsetext : contains the parsed text of each url parsedata : contains outlinks and metadata parsed from each url<--未完待续-->。

网络数据采集框架Nutch及其应用研究

网络数据采集框架Nutch及其应用研究Nutch是一个开源的网络数据采集框架,在大数据时代发挥了重要作用。

本文介绍Nutch的相关知识以及它的应用研究。

一、Nutch的基本概念Nutch的核心是一个网页抓取器。

这个抓取器能够从互联网上抓取网页文本内容、链接和图片等信息,并将这些信息存储在分布式文件系统中。

Nutch可以抓取数千万甚至数亿个网页,并对这些数据做索引,帮助用户快速地找到所需的信息。

二、Nutch的工作原理Nutch主要有三个模块:爬虫模块、解析模块和索引模块。

爬虫模块是Nutch的核心模块。

它负责从网络上下载网页,并处理这些网页中的链接,获取新的网页地址。

Nutch的爬虫模块采用了分布式架构和多线程技术,能够在极短的时间内抓取大量的网页数据。

解析模块是将爬虫模块下载的网页进行解析,提取网页中的文本内容、URL链接、图片等信息。

这些信息将会被存储在数据库中,以备后续的处理和索引。

索引模块是将解析模块提取的信息根据不同的分类,以一个统一的格式存储在文件系统中。

这一步可以使用任意的搜索引擎来对数据进行索引和搜索,以帮助用户更加快速地获取所需的信息。

三、Nutch的应用研究1、搜索引擎优化搜索引擎优化是如何让网站在搜索引擎中排名更高,以达到吸引更多用户的目的。

Nutch为用户提供了抓取网页数据的工具,能够有效地优化各类网站,并提高网站的搜索引擎排名。

使用Nutch的用户首先需要建立一个网站地图,将其提交给搜索引擎,并设定好一个定时抓取的周期,这样搜索引擎会在定期的时间内发现网站的变化。

2、企业网站数据采集企业站点一般比较庞大,需要从多个地方获取数据,比如产品信息、销售情况、客户反馈等内容。

使用Nutch进行数据采集,可以将这些信息快速地存储在数据库中,便于后续的分析和决策,更好地提升企业管理效率。

3、网络价值的挖掘互联网上存在大量的信息和数据,Nutch的数据采集功能能够帮助用户获取宝贵的市场数据,进行数据分析,以更好地进行商业决策。

Nutch调试报告

Nutch调试报告一.所需软件:1.Java:Nutch 是Java开发在Java平台上运行的,所以需要下载JDK(调试用的是jdk6)2.Tomcat:用于演示搜索界面3.cygwin:用于在windows下模拟Linux环境4.nutch 1.2二.软件安装1.JA V A安装。

打开安装软件进行安装,我用的是jdk-6u43-windows-i586,直接点击exe文件进行安装,目录选择的是C:/java。

环境变量配置设置好之后,打开命令管理窗口cmd,输入java或者javac、java –version判断是否安装好。

二.Tomcat安装从官网上下载的7.0版本的,直接安装。

安装目录为C:/Tomcat-7.0。

安装好后设置了TOMCAT_HOME环境变量,并且在前面设置的CLASSPATH变量值后面加上了“;%TOMCAT_HOME%\lib”。

安装后可以在浏览器中输入http://localhost:8080/,出现表示安装成功。

三.Cygwin安装安装过程和上面差不多,就不再赘述了。

四.NUTCH的安装从官网上下载的nutch 1.2版本的zip包,解压缩后放在了d 盘,目录为D:/cod/nutch-1.2。

继续配置环境变量。

设置了NUTCH _JA V A_HOME环境变量,变量值为java的安装地址。

安装后进行检验是否安装正确。

打开cygwin,输入cd /cygdrive/d/cod/nutch-1.2(cd是命令符,后面应有空格,自己当时没注意,耽误了好久)转入到当前目录下,然后再输入bin/nutch,出现下面结果,安装成功。

五.配置在nutch-1.2目录下建立了一个urls文件夹,里面建立了url 的文本,输入搜索站点的起始位置。

我输入的是/,我们学校主页。

在nutch目录下找到conf/crawl-urlfilter.txt,进行编辑,设置过滤规则,即要抓取什么样的网站。

网络数据采集框架Nutch及其应用研究

网络数据采集框架Nutch及其应用研究

Nutch是一个开源的网络数据采集框架,可以用于抓取和分析互联网上的海量数据。

它由Apache软件基金会开发,采用Java语言开发,具有可扩展性、高效性、数据抽取能

力和灵活性的特点,被广泛应用于搜索技术、舆情分析、数据挖掘等领域。

Nutch的主要特点包括:

1.可扩展性:可以在不影响原有代码的情况下,通过插件机制增加新的模块,如网页

解析器、URL生成器、数据存储器等。

2.高效性:采用分布式架构,支持多个节点并行抓取和处理数据,同时还能有效地去重、排重等处理。

3.数据抽取能力:支持多种格式的数据抽取,如HTML、XML、JSON等,还支持自定义

的数据抽取规则。

4.灵活性:可根据需求进行配置,支持多种数据存储方式,如数据库、文件系统、HDFS等。

1.搜索引擎:Nutch可用作搜索引擎的爬虫和索引器,并可以与Lucene等搜索引擎库结合使用,为搜索结果提供更优质的数据。

2.舆情分析:Nutch可以帮助企业对社会舆情进行抓取和分析,及时了解公众对企业

的看法,帮助企业制定应对策略。

3.数据挖掘:Nutch可以用于从互联网上抓取数据,并进行提取、转换、加载等数据

挖掘操作,用于市场调研、热点分析等领域。

由于Nutch具有可扩展性和灵活性的特点,因此可以根据实际需求来进行定制化开发,满足不同场景下的应用需求。

同时,Nutch的开放源代码和强大的社区支持,为用户提供

了更多的定制化和优化的机会。

nutch的基本工作流程理解

今天研究了Nutch,差不多已经好几个小时了,到现在还没有搞定,也这么晚了,先记录下来,明天继续吧。

一开始很多时间都浪费在了cygwin的安装上了,bs这个软件的开发者了,一个不伦不类的软件安装程序,安装的时候还要从网上下载东东。

不过最后终于装成功了,先下载到本地后,再安装的(建议下载站点中选 TW 的比较块)。

下面是我安装CYGWIN和NUTCH的过程,都块成功了,但最后卡在了用户查询界面,输入东西什么都查不出来,不知怎么回事。

NUTCH的大致原理如下:安装步骤参考了该文章一、环境:1.操作系统:windowsXp,windows2000+2.javaVM:java1.5.x,设置JAVA_HOME到环境变量3.cygwin,当然这个不是必需的,只是nutch提供的脚本只能在shell环境下使用,所以使用cygwin来虚拟shell命令。

4.nutch版本:0.85.tomcat:5.0二、cygwin的安装:cygwin的安装在Nutch在Windows中安装之细解一文中有较为详细的介绍,此处不再介绍安装步骤,只介绍安装后需要如何判断是否能够使用:在cygwin 的安装目录下,查找x:\cygwin\cygwin\bin\sh.exe,存在此命令即可使用。

cygwin在删除后会发现无法再次成功安装的问题,可以通过注册表内的查找功能,删除所有包含cygwin内容的键值即可。

三、nutch的安装和配置:1。

从/nutch/release/下载0.8或更高的版本,解压缩后,放置到cygwin的根目录下,如图:图中可以看到nutch目录在cygwin的根目录下。

2。

在nutch/bin下,建立urls目录,然后建立一个url.txt文件,在url.txt 文件内写入一个希望爬行的url,例如:,目录结构如图:3。

打开nutch\conf\crawl-urlfilter.txt文件,把字符替换为url.txt内的url的域名,其实更简单点,直接删除 这几个字就可以了,也就是说,只保存+^http://([a-z0-9]*\.)*这几个字就可以了,表示所有http的网站都同意爬行。

Nutch全文搜索学习笔记

1.Nutch1.1.安装配置1.1.1.Linux一、安装JDK如果你已经安装了JDK,并且已经设置了JAVA_HOME,那么跳过这一步安装jdk 代码sudo apt-get install sun-java5-jdk或者从sun公司网站下载bin文件执行安装设置了JAVA_HOME代码sudo vi ~/.bashrc在最后面增加代码export JAVA_HOME=/usr/lib/jvm/java-1.5.0-sunexport PATH=$PATH:$JAVA_HOME/bin二、下载nutch的最新版本nutch0.8.1代码wget /lucene/nutch/nutch-0.8.1.tar.gz释放下来即可代码tar zxvf nutch-0.8.1.tar.gz三、抓取页面增加url代码cd nutch-0.8.1mkdir urlsecho >>urls/xici编辑conf/crawl-urlfilter.txt,修改为代码+^http://([a-z0-9]*\.)*/修改conf/nutch-site.xml,增加值代码<property><name></name><value>test/unique</value></property>执行bin/nutch crawl开始抓取页面代码sudo bin/nutch crawl urls -dir crawl -depth 5 -topN 50&这个过程需要等待一些时间四、检索安装tomcat,我们使用apache网站上的包代码cd ..wget/apache/tomcat/tomcat-5/v5.5.20/bin/apache-tomcat -5.5.20.tar.gztar zxvf apache-tomcat-5.5.20.tar.gz将nutch自带的war文件拷贝到webapps下面代码rm -rf apache-tomcat-5.5.20/webapps/ROOT*cp nutch-0.8.1/nutch*.war apache-tomcat-5.5.20/webapps/ROOT.war运行tomcat,如果不设定nutch-site.xml的searcher.dir的值,则需要在crawl目录下面执行代码sudo ${TOMCAT的目录}/bin/startup.sh我们也可以设定nutch-site.xml的searcher.dir的值代码sudo vi ${TOMCAT的目录}/webapps/ROOT/WEB-INF/classes/nutch-site.xml 增加代码<property><name>searcher.dir</name><value>/home/martin/doc/nutch-0.8.1/crawl</value></property>五、中文乱码修改tomcat的server.xml,在Connector的tag最后增加代码URIEncoding="UTF-8"1.2.FetcherFetcher:根据URL爬取网页内容;CrawlDatum:爬取URL时相应的爬取状态;1.3.ParserHtmlParser:解析以Content格式表示的Html文件;Content:ParseData:存储解析好的Html数据,包括title,outlinks,contentMeta,parseMeta,status;可以修改ParseData,增加Html页面中的关键字;Outlink:存储网页上面的链接;HtmlMetaTags:存储Html标签;ParseUtil:工具类,该类包含一些可以简化不同解析类的执行,如可以根据输入内容的不同类型,选择不同的解析类;1.4.Indexer1、NutchDocumentAnalyzer:该类指定了切词的方式;如果使用自己的切词类,可以修改NutchDocumentAnalyzer.tokenStream(…)方法;2、Indexer3、BasicIndexingFilter:此类指定了创建索引时所使用的Field,默认有url,anchor,content,title,host;如果想添加新的Field,如tag,就在该类中添加,其中新添加的Field的值从ParseData中取得;1.5.Searcher1、BasicSummarizer:该类实现了读取指定搜索词前后的字符的功能;在改用其它分词方式创建索引时,注意修改该类,把getSummary方法中的text参数用该分词进行切词,然后对切词以后的字符串进行操作;2、BasicQueryFilter:该类指定查询时搜索的Field;如果增加新的查询Field,可以修改此类;也可以修改此类,把该类中的Field改为指定的Field,配合QueryFilters类达到在指定Field进行查询的目的;3、NutchAnalysis:主要负责根据请求表达式生成相应的Query,是search的关键;4、解析Query的过程:Query.parse(…)→ NutchAnalysis.fixup(…) ,返回解析好的Query;其中NutchAnalysis.fixup(…)中要运行NutchAnalysis.parseQuery(…)→NutchAnalysis.parse(…),把返回的Query作为fixup的参数;5、QueryFilters:该类负责依次运行所有的Query Filter,如BasicQueryFilter、SiteQueryFilter等;可以通过修改QueryFilters.filter(…)方法中的参数来达到查询指定Field的目的;1.6.Pluginnutch的plugin系统是基于Eclipse 2.x中对插件的使用。

nutch分析

一般来说同一域名下的 url 链接会被合成到同一个 fetchlist。这样做的考虑是:当同时使用多个工具抓取的时候,不会产生重复抓取的现象。Nutch 遵循 Robots Exclusion Protocol, 可以用robots.txt 定义保护私有网页数据不被抓去。

抓取部分:

抓取程序是被Nutch的抓取工具驱动的。这是一组工具,用来建立和维护几个不同的数据结构: web database, a set of segments, and the index。下面逐个解释这三个不同的数据结构:

1、The web database, 或者WebDB。这是一个特殊存储数据结构,用来映像被抓取网站数据的结构和属性的集合。WebDB 用来存储从抓取开始(包括重新抓取)的所有网站结构数据和属性。WebDB 只是被 抓取程序使用,搜索程序并不使用它。WebDB 存储2种实体:页面 和 链接。页面 表示 网络上的一个网页,这个网页的Url作为标示被索引,同时建立一个对网页内容的MD5 哈希签名。跟网页相关的其它内容也被存储,包括:页面中的链接数量(外链接),页面抓取信息(在页面被重复抓取的情况下),还有表示页面级别的分数 score 。链接 表示从一个网页的链接到其它网页的链接。因此 WebDB 可以说是一个网络图,节点是页面,链接是边。

从上面的介绍可以看出,一般情况下我们只要从头执行的程序就可以了,不需要接触底层的工具。但是搜索引擎有很多“意外”,很多的时间需要花费在维护上,所以底层的工具也是需要掌握的。

2、把开始抓取的跟Url 放入WebDb (inject)。

3、从WebDb的新 segment 中生成 fetchlist (generate)。

4、根据 fetchlist 列表抓取网页的内容 (fetch)。

Apache Nutch 1.3 学习笔记十(Ntuch 插件机制简单介绍)

Apache Nutch 1.3 学习笔记十(Ntuch 插件机制简单介绍)在Nutch中,大量的可扩展的部分都使用了插件来做,如网页下载时所用的协议选择,解析不同类型的网页,url的过滤和规范化都使用了Nutch的插件机制。

Nutch中插件的主要目标是:1.可扩展性:用户可以通过实现相应的接口来生成自己的扩展插件2. 灵活性:任务人都可以参与插件的编写。

3. 可维护性:插件的开发者只要实现相应的扩展接口,而不需要关注插件的内部原理。

下面对其原理和代码做一个简单的分析。

1. 一些概念1.1 插件仓库(PluginRepository)插件仓库是一个所有插件的注册器,在系统启动时,这个仓库是通过分析插件目录中所有插件的mainfest文件来生成。

对于每一个插件都会生成一个插件描述实例,它包含了每一个插件的元数据,所以插件的真正的实例会在用的时候再来创建,也就是所谓的延迟插件载入机制(lazy plugin loading)。

1.2 插件(Plugin)Nutch中的插件实际上是一系列自定义逻辑的容器,而这些自定义逻辑为Nutch的核心功能提供扩展和为其它插件提供扩展API。

一个插件要提供一个或者一组扩展。

而对于扩展点来说(ExtensionPoints)来说,这些扩展都可以被看做是一组可以被动态加载的监听器。

每一个具体的插件都扩展自基类Plugin,而这些实例又被用于去管理相关功能的生命周期。

插件打开与关闭都由Nutch的插件管理系统来操作。

1.3 扩展(Extension)扩展相当于一种被安装在具体的扩展点(ExtensionPoint)上的监听描述符,这里的扩展点扮演了一个发布者的角色。

1.4 扩展点(ExtensionPoint)扩展点提供了一类具体功能扩展的元信息,它包含了具体的扩展。

1.5 插件描述符(PluginDescriptor)插件描述符提供了一种对于Nutch所插件元数据的一种描述,它包含了国际化资源和插件本自的classloader。

nutch应用

nutchNutch 是一个刚刚诞生开放源代码(open-source)的web搜索引擎。

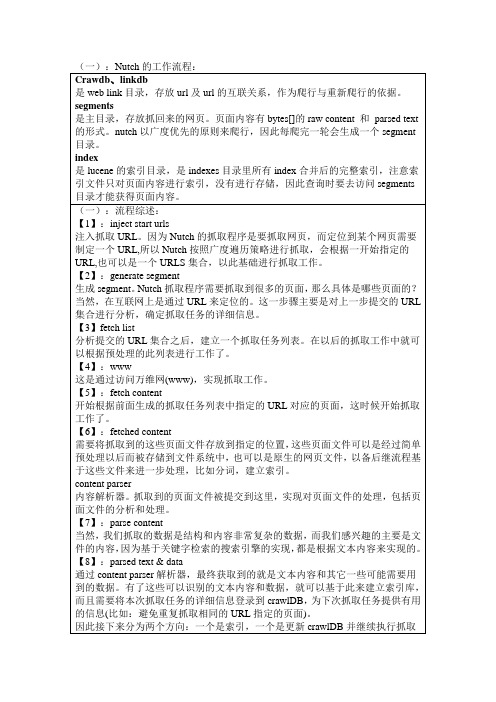

尽管Web搜索是漫游Internet的基本要求, 但是现有web搜索引擎的数目却在下降. 并且这很有可能进一步演变成为一个公司垄断了几乎所有的web搜索为其谋取商业利益.这显然不利于广大Internet用户.Nutch为我们提供了这样一个不同的选择. 相对于那些商用的搜索引擎, Nutch作为开放源代码搜索引擎将会更加透明, 从而更值得大家信赖. 现在所有主要的搜索引擎都采用私有的排序算法, 而不会解释为什么一个网页会排在一个特定的位置. 除此之外, 有的搜索引擎依照网站所付的费用, 而不是根据它们本身的价值进行排序. 与它们不同, Nucth没有什么需要隐瞒, 也没有动机去扭曲搜索的结果. Nutch将尽自己最大的努力为用户提供最好的搜索结果.Nutch 致力于让每个人能很容易, 同时花费很少就可以配置世界一流的Web搜索引擎. 为了完成这一宏伟的目标, Nutch必须能够做到:* 每个月取几十亿网页* 为这些网页维护一个索引* 对索引文件进行每秒上千次的搜索* 提供高质量的搜索结果* 以最小的成本运作Nutch主要分为两个部分:爬虫crawler和查询searcher。

Crawler主要用于从网络上抓取网页并为这些网页建立索引。

Searcher主要利用这些索引检索用户的查找关键词来产生查找结果。

两者之间的接口是索引,所以除去索引部分,两者之间的耦合度很低。

Crawler和Searcher两部分尽量分开的目的主要是为了使两部分可以分布式配置在硬件平台上,例如将Crawler和Searcher分别放在两个主机上,这样可以提升性能。

爬虫,Crawler:Crawler的重点在两个方面,Crawler的工作流程和涉及的数据文件的格式和含义。

数据文件主要包括三类,分别是web database,一系列的segment加上index,三者的物理文件分别存储在爬行结果目录下的db目录下webdb子文件夹内,segme nts文件夹和index文件夹。

Apache Nutch1.7 学习总结

Apache Nutch学习总结目录前言 (3)Nutch搭建过程[1] (13)1 准备工作 (13)2 开始部署 (13)2.1 安装linux系统 (13)2.2 安装jdk (13)2.3.配置nutch创建索引 (14)2.4安装tomcat (17)2.5配置nutch查询索引 (17)参考文献 (19)Nutch爬取内容解析[1] (20)1 Nutch的输出文件 (20)1.1 Crawldb (20)1.2 Linkdb (20)1.3 Segments (20)1.4 Indexes (22)1.5 Index (22)2 Nutch爬取内容解析 (23)2.1 nutch的所有命令[2] (23)2.2 nutch的页面转存命令 (29)2.3 nutch页面转存程序 (31)参考文献 (31)Nutch的爬取设置和配置文件 (32)1 nutch的爬取深度 (32)2 nutch的配置文件[2] (33)2.1 配置文件的优先级 (33)2.2 配置文件详解 (35)2.3 nutch抓取动态网页配置[3] (43)2.4 关于配置文件的一些细节问题[4][5] (44)参考文献 (46)后序内容 (47)前言学习使用nutch的时间加起来能有一个月了,在网上也搜集了不少的资料,但是比较零散,所以想把这一个月使用它的全部过程、原理的讲解和中间的注意事项总结一下。

主要汇总写网上已有的资料,方便查阅嘛。

Nutch在Windows下的搭建过程1 准备工作我是在Window7下搭建的Nutch,所需要的工具如下:(1)Cygwin安装(2)jdk-6u25-win-i586.bin(2)apache-nutch-1.2-bin.tar.gz2 安装Cygwin下载地址:/setup.exe(1)因为nutch自身的命令是要在linux环境下才能运行,所以先安装了cygwin,Cygwin 是一个在Windows下的模拟Linux系统程序。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Nutch 是一个开源Java 实现的搜索引擎。

它提供了我们运行自己的搜索引擎所需的全部工具。

包括全文搜索和Web爬虫。

Nutch使用方法简介:/pengpengfly/archive/2008/09/29/2994664.aspx nutch1.2 eclipse tomcat6.0 配置:/oliverwinner/blog/item/4be3f1370284b32f5ab5f565.htmlNutch 实战:介绍了开源搜索引擎Nutch 的基本信息,详细说明了在Eclispe 下运行Nutch 的步骤和需要注意的问题,还分析了部分源代码。

很好的文章Nutch 目录结构bin:用于命令行运行的文件;conf:Nutch的配置文件lib:一些运行所需要的jar文件;plugins:存放相应的插件;src:Nutch的所有源文件;webapps:web运行相关文件;nutch-0.9.war是Nutch所提供的基于Tomcat的应用程序包。

Nutch工作流程1. 将起始URL 集合注入到Nutch 系统之中。

2. 生成片段文件,其中包含了将要抓取的URL 地址。

3. 根据URL地址在互联网上抓取相应的内容。

4. 解析所抓取到的网页,并分析其中的文本和数据。

5. 根据新抓取的网页中的URL集合来更新起始URL集合,并再次进行抓取。

6. 同时,对抓取到的网页内容建立索引,生成索引文件存放在系统之中。

(1)准备需要的软件列表Cygwin (下载地址:/setup.exe)Jdk(1.4.2以上版本,下载地址/technetwork/java/javase/downloads/jdk-6u29-download-513648.html)Nutch(推荐使用0.9版本,下载地址/dyn/closer.cgi/lucene/nutch/)Tomcat(下载地址/)(2)安装软件1) Cygwin 打开安装程序Cygwin.exe后,在"Choose Installation Type"页选择"Install from Internet"(如果你已经把全部安装包下载到本地,就可以选择"Install from local directory"选项)。

然后点击"Next".然后选择安装目录,其他可保持默认选项,点击"Next".选择保存安装包的本地目录,点击"Next".选择下载连接的类型,点击Next。

然后通过服务器先下在需要安装的包列表,改为install比较合适,默认为default安装不全完成安装。

图文讲解2) 安装JDK,注意安装完成后需要在Windows的环境变量中加入JAVA_HOME=你的jdk的安装目录3) 安装Tomcat,下载安装版。

4)把Nutch解压到本地目录,例如D:/nutch。

启动Cygwin程序,Cygwin程序会启动一个模拟Unix/Linux的终端窗口,然后使用方式就和Unix的Shell一样了,Cygwin的根目录是/cygdriver,这个目录相当于Windows的“我的电脑”,然后进入Nutch的目录,例如:cd /cygdriver/d/nutch,然后运行bin/nutch命令,如果出现下面的Usage 信息,这样Nutch就安装完成了,非常简单。

注意cygwin路径的切换方法:命令:cd d:/nutch(3)使用NutchNutch 的爬虫有两种方式•爬行企业内部网(Intranet crawling)。

针对少数网站进行,用crawl 命令。

•爬行整个互联网。

使用低层的inject, generate, fetch 和updatedb 命令,具有更强的可控制性。

1) 添加需要爬行的内部网地址信息。

新建一个目录,写入一些网址信息,例如我们需要爬行csdn的内部网。

mkdir urlsecho / >urls/csdn 后面有斜线2) 然后修改conf目录下的crawl-urlfilter.txt文件,这个文件中的正则表达式定义了那些文件可以被Nutch爬行,那些不可以被爬行。

其中以“+”号开头的表示属于Nuch合法的Url连接,“-”号开头相反。

我们需要修改文件中的# accept hosts in +^http://([a-z0-9]*/.)*/为# accept hosts in +^http://([a-z0-9]*/.)*/或# accept hosts in +^http://([a-z0-9]*\.)*3)接下来我们需要配置conf/nutch-site.xml,这个需要填写相关的代理属性,应为Nutch也许要准受Robot协议,在爬行人家网站的时候,把相关的信息提交给被爬行的网站。

我们在这个文件中,需要在<configuration>和</configuration>之间,加入是个代理属性,例如属性<property><name></name><value>nutch-1.2</value><description></description></property>其中除了name字段需要准确添写外,其他value和descrption字段可或添写。

同样,还需要加入http.agent.description,http.agent.url和http.agent.email这三个属性。

例如1.<?xml version="1.0"?>2.<?xml-stylesheet type="text/xsl"href="configuration.xsl"?>3.<!-- Put site-specific property overrides in this file. -->4.<configuration>5.<property>6.<name></name>7.<value>nutch-1.2</value>8.<description>tjt</description>9.</property>10.<property>11.<name>http.robots.403.allow</name>12.<value>true</value>13.<description></description>14.</property>15.<property>16.<name>http.agent.description</name>17.<value>tjtnutchhoho</value>18.<description></description>19.</property>20.<property>21.<name>http.agent.url</name>22.<value></value>23.<description></description>24.</property>25.<property>26.<name>http.agent.email</name>27.<value>tangjiutao@</value>28.<description></description>29.</property>30.<property>31.<name>http.agent.version</name>32.<value>Nutch-1.2</value>33.<description></description>34.</property>35.<!-- file properties -->36.<property>37.<name>searcher.dir</name>38.<value>E:/nutch/csdn</value>39.<description></description>40.</property>41.</configuration>这里的设置,是因为nutch遵守了robots协议,在获取response时,把自己的相关信息提交给被爬行的网站,以供识别。

4)这样就完成了全部爬行所需要的配置,下面就可以用nutch的crawl命令来派性企业内部网了再nutch目录中输入:bin/nutch crawl urls -dir csdn -threads 4 -depth 2 -topN 30这样nutch就启动并且开始爬行任务了,由于是简单示例,所以以上这个命令很快就结束了,因为爬行的广度和深度都非常小,也就是说,示例只爬行了csdn网站的很小一部分网页。

下面就上面命令的参数进行说明:Crawl命令的使用说明为: crawl <url dir> [-dir index] [-threads num] [-depth num] [-topN num] 其中:urls是存放需要爬行网址的文件夹目录。

-dir选项是抓取的页面的存放目录。

-threads选项是启动的最大线程数。

-depth选项是能爬行的最大深度,也就是最多爬行到第几级的页面,也叫爬行深度。

-topN选项是在每层深度上,所能爬行的最多页面数,也称爬行广度。

完成爬行后,会在-dir选项所指定的目录中保存网页信息和搜索需要的索引。

********************************************************常见报错:(1)Exception in thread "main" java.io.IOException: Job failed!at org.apache.hadoop.mapred.JobClient.runJob(JobClient.java:1252)at org.apache.nutch.crawl.Injector.inject(Injector.java:217)at org.apache.nutch.crawl.Crawl.main(Crawl.java:124)请检查nutch-default.xml的plugin.folders是否修改为./src/plugin,默认为plugins,修改后启动正常(2)org.apache.nutch.plugin.PluginRuntimeException: ng.ClassNotFoundException:.urlnormalizer.basic.BasicURLNormalizer********************************************************PDF支持:默认情况下不支持对pdf文件的索引,要想对pdf文件也进行正确的索上,找到nutch-default.xml中的plugin.includes属性,添加上pdf,即为parse-(text|html|js|pdf)。