通过强化学习调整模糊逻辑控制器的时间差以控制倒立摆(IJISA-V4-N9-2)

强化学习在自动控制中的应用

强化学习在自动控制中的应用强化学习是近年来人工智能领域备受关注的一个重要研究方向。

与监督学习和无监督学习不同,强化学习以试错来训练智能体,通过对外部世界的反馈(奖励或惩罚)来调整其行为,逐步探索最优行动策略。

在自动控制中,强化学习也被广泛应用,可以用于控制器设计、动态系统建模、过程优化、机器人控制等领域。

一、强化学习与自动控制自动控制是一种控制系统在没有人类干预下,按照预先设定目标实现自我控制和优化的过程。

传统方法是将过程建模为数学模型,通过数学模型进行控制。

但是,当过程很复杂,或者难以建模时,传统方法的效果就会受到限制。

强化学习则是完全不同的一种方法。

它不需要过程模型,而是通过与环境的交互学习最佳策略。

因此,强化学习可以更好地应对复杂环境和未知过程。

强化学习的核心思想是将控制过程看作一系列动作和状态的序列。

智能体根据当前状态做出决策,采取行动,然后观察环境的反馈以更新策略。

智能体的目标是逐步探索环境,形成最优策略,使得长期(未来)获得最大回报。

二、强化学习在控制器设计中的应用控制器设计是自动控制的一个重要环节。

传统的控制器设计方法主要是基于经验,需要大量的试错。

使用强化学习可以让系统自行学习最佳调度策略,直接对控制器进行调度和优化。

例如,强化学习可以用于构建高效的PID控制器,可以在不需要数学模型的情况下,直接从在线数据中学习和优化控制器参数。

三、强化学习在动态系统建模中的应用动态系统建模是控制器设计的前置工作,是一个将实际过程转换为数学模型的过程。

传统方法需要大量的系统性能数据,以获取系统模型的各个参数。

然而,实际运行的系统往往由于各种随机因素而无法精确预测,这限制了建立准确的模型。

强化学习则不需要建立准确的模型,而是基于数据进行建模。

强化学习可以根据环境的变化,自动更新动态模型的参数,这使得模型更加准确和可靠。

四、强化学习在过程优化中的应用许多实际过程需要通过控制调整来达到最佳状态,比如生产过程控制、能耗优化等。

结合模糊控制的深度强化学习交通灯控制策略

结合模糊控制的深度强化学习交通灯控制策略传统的交通信号灯控制策略往往是基于时间间隔或车辆流量等经验规则进行设计的。

然而,这种设计方式无法适应现实道路交通的复杂性和多变性,导致交通拥堵和交通效率低下的问题。

为了解决这一问题,研究人员提出了基于深度强化学习的交通灯控制策略,以提高交通流量的流畅性和整体交通效率。

与此同时,模糊控制技术也被引入到交通灯控制中,以应对交通信号灯控制策略的模糊性和不确定性。

本文将结合模糊控制的深度强化学习交通灯控制策略进行综述。

1. 深度强化学习在交通灯控制中的应用深度强化学习是将深度学习和强化学习相结合的一种方法。

通过建立一个深度神经网络模型,结合强化学习的概念和算法,使得交通灯控制系统能够根据当前的交通状态来选择最优的交通灯状态。

深度强化学习在交通灯控制中的应用可以按照以下步骤进行:(1)建立环境模型:将交通路口及周围的道路和车辆等信息转化为输入特征,构建交通灯控制系统的环境模型;(2)定义交通灯控制策略:利用深度强化学习算法,定义交通灯控制策略的动作空间和状态空间;(3)训练深度强化学习模型:通过与环境交互和奖励机制,训练深度强化学习模型,使其能够根据当前状态选择最优的交通灯控制策略;(4)测试和优化:将训练好的深度强化学习模型用于实际交通灯控制场景中进行测试,并根据测试结果对模型进行优化。

2. 模糊控制在交通灯控制中的应用模糊控制是一种能够处理模糊信息和不确定性的控制方法。

在交通灯控制中,由于交通流量的变化和交通信号的多样性,交通灯控制策略往往是模糊的。

因此,模糊控制技术被引入到交通灯控制中,以应对这种模糊性和不确定性。

模糊控制在交通灯控制中的应用可以按照以下步骤进行:(1)建立模糊控制规则库:根据交通灯控制的经验规则和交通流量的变化规律,建立模糊控制规则库;(2)定义输入输出变量:将交通流量、道路拥堵等信息转化为模糊变量,并定义输出变量表示交通灯的状态;(3)进行模糊推理:根据当前的交通状态和模糊规则库,进行模糊推理,得到当前交通灯的控制策略;(4)优化和调整:根据实际的交通流量和交通效率等指标,对模糊控制规则库进行优化和调整,以提高交通灯控制的效果。

基于强化学习的动态智能调度策略研究

基于强化学习的动态智能调度策略研究动态智能调度策略在日益复杂的现代社会中起着重要的作用。

基于强化学习的动态智能调度策略研究是一个前沿领域,它利用强化学习算法来优化调度过程,以提高效率和性能。

本文将介绍基于强化学习的动态智能调度策略的研究现状、方法和发展前景。

一、研究现状目前,传统的调度策略主要基于静态模型,无法适应复杂多变的环境。

而基于强化学习的动态智能调度策略能够根据环境变化和任务需求调整策略,从而达到更好的调度效果。

强化学习是一种机器学习方法,它通过不断试错与奖惩机制来自主学习,进而选择出最优的决策策略。

在动态调度中,强化学习的优势在于能够学习和适应不断变化的环境,并根据实时反馈调整决策策略。

二、方法研究基于强化学习的动态智能调度策略的首要任务是建立合理的状态和行动空间。

状态可以包括任务的属性(如优先级、截止日期)和环境的因素(如网络状况、资源利用率)。

行动空间则对应调度的具体操作,比如选择执行任务的设备或调整任务的执行顺序。

在强化学习方法中,Q-learning是最常用的算法之一。

Q-learning通过在状态-行动空间中的每一个点上更新一组Q值来实现策略优化。

通过不断尝试和学习,Q-learning 能够找到在不同状态下选择合适行动的最优策略。

除了Q-learning,还有很多其他的强化学习算法,如Deep Q-Network(DQN)、Policy Gradient等,它们在不同的场景下有着各自的优势和适用性。

为了进一步提高调度效果,研究者们也尝试将深度学习方法与强化学习相结合,形成深度强化学习算法。

深度强化学习将神经网络应用于强化学习中,通过神经网络来近似Q值函数,使得系统能够更高效地学习和决策。

这种方法已经在许多领域取得了显著进展,如游戏领域的AlphaGo和自动驾驶。

三、发展前景基于强化学习的动态智能调度策略的研究前景非常广阔。

随着科技的不断发展,越来越多的领域需要实时智能调度策略,如物流调度、网络流量管理、车辆路径规划等。

基于模糊强化学习的双轮机器人姿态平衡控制

Vol. 43 No. 4April 2021第43卷第4期2021年4月文章编号:1001-506X(2021)04-1036-08系统工程与电子技术Systems Engineering and Electronics网址 :www. sys-ele. com基于模糊强化学习的双轮机器人姿态平衡控制闫 安1,陈 章,董朝阳】,何康辉1(1.北京航空航天大学航空科学与工程学院,北京100191;2.清华大学自动化系,北京100084)摘要:针对单轨双轮机器人在静止情况下存在的固有静态不稳定问题,提出一种基于模糊强化学习(简称为Fuzzy-Q)的控制方法。

首先,运用拉格朗日法建立带控制力矩陀螺的系统动力学模型。

然后,在此基础上设计表格型强化学习算法,实现机器人的稳定平衡控制。

最后,针对算法存在的控制精度不高和控制器输出离散等问题,采用模糊理论泛化动作空间,改善控制精度,并使控制输出连续。

仿真实验表明,相较于传统强化学习方法,所提方法 能够显著提高控制精度,且可以有效抑制外界干扰力矩对系统的影响,保证系统具有一定的抗干扰能力。

关键词:强化学习;模糊强化学习;模糊算法;控制力矩陀螺;单轨双轮机器人中图分类号:TP 242 文献标志码:A DOI : 10.12305/j. issn.1001-506X. 2021.04.21Attitude balance control of two-wheeled robot based onfuzzy reinforcement learningYAN An 1, CHEN Zhang 2」,DONG Chaoyang 1 , HE Kanghui 1(7.School of Aeronautic Science and Engineering , Beihang University , Beijing 100191 , China ;2.DeparLmenL of AuOmaion , Tsinghua University , Beijing 100084 , China )Abstract : In order to solve the inherent problem of static instability of monorail two-wheel robot underresting conditions , a control method of monorail two-wheel robot based on fuzzy reinforcement learning (Fuzzy-Q inshort ) is proposed. Firstly , the Lagrange method is used to establish the system dynamics model with control moment gyro. And then, on this basis, the tabular reinforcement learning algorithm is designed to realize thestable balance control of the robot. Finally , In order to solve the problems of low control accuracy and discretization of controller output, the fuzzy theory is used to generalize the action space , improve the controlaccuracy and make the control output continuous. The simulation results show that compared with thetraditional reinforcement learning methods ,the proposed Fuzzy-Q methodcansignificantlyimprovethecontrolaccuracy , effectively inhibit the influence of external interference torque on the system , and ensure that the system hasagreatant-nterferencecapablty.Keywords : reinforcement learning ; fuzzy reinforcement learning ; fuzzy algorithm ; control moment gyro ;monoraltwo-wheeledroboto 引言单轨双轮机器人因其高度的平稳性、较强的越障能力等性能在生活服务型机器人中表现岀其强大的优势,可以 广泛应用于军事、交通、安保、工业生产等领域。

强化学习算法中的策略改进方法详解

强化学习算法中的策略改进方法详解强化学习是一种通过与环境交互来学习最优行为的机器学习方法。

在强化学习中,智能体通过在环境中执行动作,观察环境的反馈并根据反馈来更新自己的策略。

策略是指智能体在特定状态下选择动作的概率分布。

强化学习的目标是找到一个最优策略,使得智能体在与环境的交互中能够获得最大的累积奖励。

在强化学习算法中,策略改进是一个重要的环节,它可以帮助智能体学习到更加优秀的策略。

在这篇文章中,我们将详细介绍强化学习算法中的策略改进方法。

价值迭代价值迭代是一种基于值函数的策略改进方法。

值函数是衡量状态或状态动作对的优劣的函数。

在价值迭代中,我们首先用一个任意的值函数来初始化策略,然后通过迭代的方式逐步更新值函数,最终得到最优值函数。

在得到最优值函数之后,我们可以根据值函数来改进策略,从而得到最优策略。

在价值迭代中,值函数的更新是通过贝尔曼方程来实现的。

贝尔曼方程是一种描述值函数之间关系的方程,通过不断地迭代求解贝尔曼方程,我们可以逐步地逼近最优值函数。

一旦得到最优值函数,我们就可以根据值函数来改进策略,从而得到最优策略。

策略梯度方法策略梯度方法是一种直接对策略进行优化的方法。

在策略梯度方法中,我们通过梯度上升的方式来更新策略参数,使得能够最大化期望累积奖励。

策略梯度方法的优势在于可以直接对策略进行优化,而不需要借助值函数。

在策略梯度方法中,我们首先定义一个可微的策略函数,然后通过对期望累积奖励的梯度来更新策略参数。

通过不断地迭代更新策略参数,我们可以逐步地逼近最优策略。

策略梯度方法的一个典型代表是深度强化学习中的深度确定性策略梯度(DDPG)算法。

探索-利用平衡在强化学习中,探索和利用是一个非常重要的问题。

在探索阶段,智能体需要尝试不同的动作,以便发现环境的特性和获得更多的奖励;而在利用阶段,智能体则需要根据已有的知识来选择最优的动作,以获得最大的奖励。

探索和利用之间的平衡是强化学习中的一个难点。

基于强化学习的智能调度算法研究

基于强化学习的智能调度算法研究随着现代社会的高速发展,越来越多的企业和机构开始借助现代技术来完成各种任务和工作。

然而在实际操作中,我们常常发现人工调度效率低下、难以把控的问题,尤其是在需要面对较大规模的调度场景时,人工调度效率越发差劲。

同时,自动化技术的快速发展,也要求我们需要更加智能化、高效化的技术和算法完成调度任务。

因此,基于强化学习的智能调度算法的研究就显得尤为重要。

强化学习是一种非常流行的机器学习方法,它的核心思想就是通过代理在试错中学习从而达到一种最优决策的策略。

也就是说,这种算法会自动寻找最佳动作,从而得到最优的结果。

这项技术涵盖了许多任务,其中调度算法正是其中的一项重要应用。

因为智能调度算法需要在复杂、动态的环境中实现最佳调度策略和决策,而强化学习的模式正好符合了这种性质。

在智能调度的涉及领域中,一些比较难以解决的问题被提出,这些问题多与大数据、高精度、快速反应相关。

例如,在公共交通领域中,考虑到行车时间、人流高峰,以及交通流量等因素,智能调度系统就可能遇到延迟、错误的问题。

物流领域中,又面临配送点的多样性、货物体积、重量等复杂的环境因素。

强化学习方法能够通过模拟复杂的调度场景,以及不断优化智能算法,使得这些问题得到较好的解决。

基于强化学习的智能调度算法的实现,通常使用深度神经网络作为学习模型。

它可以允许我们处理大量复杂数据,并且可以更好地处理多个事件、多个环境的复杂因素。

这种算法利用智能体(即代理)与环境进行互动,不断的调整自己的决策策略,从而获得最佳的结果。

在实际应用中,智能调度算法需要结合不同场景和场景下的具体需求进行实现。

例如,在智能公交调度系统中,可以通过开始学习路线、途径站点、运营时间等变量,来更好地对公交系统进行智能调度。

同样在物流领域,可以通过开始学习配送点、货物种类、交通路况、时间窗口等变量,来提高物流系统运作效率。

另外强化学习的一些技术也支持多智能体调度问题的求解,即可以通过协作或竞争的方式使整体系统性能更好。

基于神经网络的强化学习算法实现倒立摆控制

倒立摆控制 。99年 , n esn1 18 A dro L 又在 原有 的 A HC方法上 , 进行改进 , 现 了连续状 态空 间 的倒 立摆 控制 。99年 , . 实 19 K D y 运用 R F网络也成功解决 了倒立摆系统连续状态空 oa B 间问题 。 同时 , 作为 强化学 习的一种 ,Q—lann 算 法也被 erig 用 于控制倒立 摆。9 3年 ,e gJ 用 lou 19 Pn ok p表表示 Q值 的 方法 同样 实现了将 倒立 摆状 态离散 化后 的平衡 控制 。 后来 , A d r n 和蒋 国飞 , 沧浦 分别 在各 自的论 文 中将神 n es o 吴

解决倒立摆 系统连续状态空间的输入问题 , 还成功解决 了输 出连续动作空 间的问题。 将此方 法运用于连续 倒立摆系统 的平 衡控制 中, 经过基 于实际控制模型的 M t b a a 软件仿 真实验 , l 结果显示 了这个方法 的可行性 。 方法进一 步提高 了强化学 习 该 理论在实际控制系统 中的应用价值。 关键词 : 强化学 习 ; 神经网络 ; 激活函数 ; 泛化性能 ; 连续动作空 间

a t a i n f n to c i to u c i n,u i g n u a ewo ks g n r i ai n p ro ma c o s l e n to l e i p to o tn o s v sn e r n t r ’ e e a z t e f r n et o v o n y t n u fa c n i u u l l o h sa e s a e b t a s u p t a o tn o s a t n s a e tt p c u o o t u s a c n i u u c i p c ,wh c a e n p o e o b p l a l y Ma l b l o i h h s b e r v d t e a p i b e b ta c

强化学习在控制系统中的应用

强化学习在控制系统中的应用强化学习是一种基于试错的机器学习方法,通过不断与环境交互来学习最优的行为策略。

在控制系统中,强化学习被广泛应用于优化控制、自适应控制和智能控制等领域。

本文将重点讨论强化学习在控制系统中的应用,并介绍一些相关研究和实际案例。

一、强化学习在优化控制中的应用优化控制是指通过调节系统参数或输入信号来使系统性能达到最优的方法。

传统的优化方法通常需要准确建立数学模型,并且对于复杂系统往往难以找到解析解。

而强化学习可以通过与环境交互来实现模型无关的自动调节,因此在优化控制中具有广泛应用价值。

1.1 基于值函数的强化学习方法值函数是指将状态或状态-动作对映射为其长期累积奖励期望值的函数。

基于值函数的强化学习方法可以通过迭代更新值函数来找到最优策略。

例如,Q-learning算法就是一种基于值函数迭代的强化学习算法,它通过学习一个Q值表来实现最优策略的搜索。

在优化控制中,值函数可以被用来评估系统的性能,例如通过定义状态和动作的奖励函数来量化控制策略的优劣。

然后,强化学习算法可以通过与环境交互来更新值函数,并根据值函数选择最优动作。

这种方法在非线性系统和多目标优化中具有较好的适用性。

1.2 基于策略梯度的强化学习方法策略梯度是指通过直接优化策略参数来实现最优控制策略的方法。

与基于值函数的方法不同,基于策略梯度的强化学习不需要估计状态-动作对的价值函数,而是直接对参数进行更新。

在控制系统中,基于策略梯度的强化学习可以用于实现非线性和非确定性系统的最优控制。

例如,在机器人控制中,由于环境和任务复杂多变,并且存在不确定性因素,传统方法往往难以找到最佳解决方案。

而基于策略梯度的强化学习可以通过与环境交互来逐步优化策略参数,从而实现最优控制。

二、强化学习在自适应控制中的应用自适应控制是指系统能够根据环境和系统变化自动调整控制策略的方法。

传统的自适应控制方法通常需要准确建立系统模型,并且对于模型误差和参数变化敏感。

强化学习算法中的时间差分学习方法详解(九)

强化学习是一种人工智能领域的重要算法,它通过智能体与环境的交互来学习最优的决策策略。

而时间差分学习方法是强化学习算法中的一种重要方法,它通过估计价值函数来指导智能体的决策。

本文将详细介绍时间差分学习方法在强化学习中的应用和原理。

时间差分学习方法是一种基于动态规划的强化学习方法,它的核心思想是利用当前状态的价值函数估计来指导智能体的决策。

在时间差分学习方法中,智能体根据当前状态和动作的奖励来更新状态的价值函数估计。

这种方法可以有效地克服动态规划方法中需要完全环境模型的限制,使得智能体可以在不完全了解环境的情况下进行学习。

时间差分学习方法的核心是价值函数的估计和更新。

在强化学习中,价值函数通常用来衡量每个状态的好坏程度,从而指导智能体做出最优的决策。

时间差分学习方法通过不断地更新状态的价值函数估计来逐步优化智能体的决策策略。

时间差分学习方法的一个经典算法是Q学习算法。

Q学习算法通过不断地迭代更新状态-动作对的价值函数估计来寻找最优的决策策略。

具体来说,Q学习算法通过以下的更新规则来更新状态-动作对的价值函数估计:Q(s, a) = Q(s, a) + α * (r + γ * maxQ(s', a') - Q(s, a))其中,Q(s, a)表示状态s下执行动作a的价值函数估计,r表示执行动作a 后得到的即时奖励,α表示学习率,γ表示折扣因子,s'和a'表示执行动作a后转移到的下一个状态和下一个动作。

这个更新规则的核心思想是利用执行动作a后得到的即时奖励和下一个状态的最大价值函数估计来逐步优化状态-动作对的价值函数估计。

除了Q学习算法,时间差分学习方法还有许多其他的变种算法,比如Sarsa算法、Dyna算法等。

这些算法在更新规则和策略选择上有所不同,但它们的核心思想都是利用动态规划的方法来更新状态的价值函数估计,从而指导智能体的决策。

在实际应用中,时间差分学习方法在强化学习中有着广泛的应用。

使用强化学习进行机器人控制的教程

使用强化学习进行机器人控制的教程强化学习(Reinforcement Learning)是一种机器学习方法,经常被用来训练机器人进行自主控制。

在这篇文章中,我们将介绍如何使用强化学习进行机器人控制的教程。

1. 强化学习介绍强化学习是一种通过在环境中试错来学习最优策略的方法。

在强化学习中,一个智能体与环境进行交互,并通过试错来学习如何在某个环境中采取最优的行动。

智能体通过与环境交互获得的反馈信息,即奖励信号,来评估自己的行为,从而调整策略。

2. 强化学习的基本概念在强化学习中,有一些基本概念是必须了解的。

首先是状态(State),状态是描述智能体与环境交互的环境的一个快照。

其次是动作(Action),动作是智能体在某个状态下可以采取的行动。

接下来是奖励(Reward),奖励是智能体在某个状态下采取某个动作后所获得的反馈信息。

最后是策略(Policy),策略是一种确定智能体在某个状态下应该采取何种动作的规则。

3. 强化学习算法在强化学习中,有不同的算法可以用来训练智能体进行控制。

其中最经典的算法是Q-learning算法。

Q-learning算法利用一个Q表来记录智能体在不同状态下采取不同动作的Q值(即动作对应的预期回报)。

算法通过在环境中多次试错来更新Q表,使得智能体能够学习到最优策略。

其他常用的强化学习算法还包括Deep Q Network(DQN)、Policy Gradient等。

4. 强化学习应用于机器人控制将强化学习应用于机器人控制可以实现机器人的自主决策和智能操作。

在强化学习中,机器人的传感器数据可以作为输入的状态,而机器人的动作就是强化学习算法中的动作。

机器人在执行某一动作后,会根据环境的反馈获得奖励信号,通过调整机器人的动作选择,逐渐使机器人学会在不同环境下的最优行为。

5. 强化学习控制机器人的步骤首先,确定机器人控制的目标和环境。

例如,机器人的目标可能是在一个迷宫中找到目标位置,环境就是迷宫的布局和机器人的传感器数据。

利用强化学习进行智能体控制和优化

利用强化学习进行智能体控制和优化强化学习是一种机器学习方法,它通过智能体与环境的交互学习,以实现特定目标或最大化奖励。

在智能体控制和优化领域,强化学习已经被广泛应用,并取得了许多成功案例。

本文将介绍强化学习在智能体控制和优化中的应用,探讨其原理和算法,以及未来的发展趋势。

一、强化学习简介强化学习是一种从动作和环境的交互中学习的机器学习方法。

在强化学习中,智能体通过观察环境的状态,采取相应的动作,获得奖励或惩罚,以优化其行为策略。

强化学习的核心思想是通过试错和反馈来学习最优的行为策略,以达到特定的目标或最大化奖励。

强化学习的基本要素包括智能体、动作、环境状态和奖励。

智能体通过选择动作来影响环境,并观察环境的反馈状态和奖励。

根据这些反馈,智能体调整其行为策略,以获得更多的奖励或达到特定的目标。

强化学习的目标是找到最优的行为策略,使得智能体可以在环境中获得最大的奖励或实现特定的目标。

二、强化学习在智能体控制中的应用强化学习在智能体控制中的应用非常广泛,包括机器人控制、自动驾驶、电力系统控制等领域。

在机器人控制中,强化学习可以帮助机器人学习复杂的动作策略,以实现特定的任务,如导航、抓取物体等。

在自动驾驶领域,强化学习可以帮助无人驾驶汽车学习驾驶策略,以实现安全、高效的自动驾驶。

在电力系统控制中,强化学习可以帮助电力系统优化能源调度和供应策略,以实现节能和环保。

强化学习在智能体控制中的应用主要有两种方式:基于模型的强化学习和基于价值函数的强化学习。

基于模型的强化学习通过建立环境的动态模型,预测环境的状态和奖励,以进行决策和优化。

基于价值函数的强化学习通过建立价值函数,评估动作的价值,以进行决策和优化。

三、强化学习的原理和算法强化学习的核心原则是基于动作-反馈的交互学习,即智能体通过尝试不同的动作,观察环境的反馈,以调整其行为策略。

强化学习的关键问题是如何在动作和环境的交互中学习最优的行为策略。

为了解决这一问题,强化学习提出了许多优化算法,如价值迭代、策略梯度、Q学习等。

机器人控制中的强化学习方法教程

机器人控制中的强化学习方法教程强化学习是一种广泛应用于机器人控制领域的方法,它通过智能体与环境的交互学习,从而使得智能体能够以最优的方式执行任务。

本文将介绍强化学习方法在机器人控制中的应用,并讨论一些常用的强化学习算法。

1. 强化学习简介强化学习是一种通过智能体与环境的交互学习,以达到最大化预期奖励的方法。

在机器人控制中,智能体就是我们要控制的机器人,环境包括机器人所处的场景和其他物体。

通过与环境的交互,智能体通过尝试不同的动作来获得最大化的奖励。

2. 强化学习应用于机器人控制的挑战机器人控制涉及到复杂的状态空间和动作空间,而且通常存在延迟和不确定性。

强化学习方法需要克服这些挑战才能使机器人能够高效地执行任务。

3. 基本的强化学习元素强化学习包括四个基本的元素:状态(state)、动作(action)、奖励(reward)和策略(policy)。

状态是指机器人在特定时间点观测到的环境信息,动作是机器人在特定状态下选择的行为,奖励是环境对机器人的行为给予的反馈,策略是智能体在给定状态下选择动作的方法。

4. 常用的强化学习算法(1)Q-LearningQ-Learning是一种基于值函数的强化学习算法。

它通过迭代更新状态-动作对的值函数,以达到最大化总奖励的目标。

Q-Learning的核心思想是通过不断更新值函数来优化策略,以使智能体能够选择最优的动作。

(2)Deep Q-LearningDeep Q-Learning是将神经网络与Q-Learning相结合的强化学习方法。

它使用神经网络来近似值函数,以处理高维复杂的状态空间和动作空间。

Deep Q-Learning的优势在于可以处理连续动作空间和大规模状态空间。

(3)Policy GradientPolicy Gradient是一种直接优化策略的强化学习算法。

它通过迭代优化策略参数来使得智能体能够选择最优的动作。

Policy Gradient的优势在于可以处理连续动作空间和随机性更强的环境。

使用强化学习进行AI训练

使用强化学习进行AI训练引言:人工智能(Artificial Intelligence, AI)是近年来快速发展的热门领域之一。

强化学习(Reinforcement Learning)作为一种对智能系统进行训练和优化的算法,被广泛应用于AI领域。

本文将探讨使用强化学习进行AI训练的方法和技术,并分析其优势和应用场景。

一、强化学习概述强化学习是一种基于奖励和惩罚机制的学习算法,通过不断试错、反馈和优化的方式,使智能系统能够逐渐学会在特定环境中采取最佳行动。

与监督学习(Supervised Learning)和无监督学习(Unsupervised Learning)不同,强化学习的目标是让智能系统能够通过与环境交互来获得经验,并根据这些经验进行自主决策。

二、强化学习训练过程1. 环境建模在强化学习中,首先需要对所研究的问题建立一个合适的数学模型,并将其表示为马尔可夫决策过程(Markov Decision Process, MDP)。

MDP由状态集、行动集、奖励函数和状态转移概率组成,以提供动态决策制定的基础。

2. 探索与利用在训练过程中,智能系统需要在未知环境中探索,同时又要利用已有的经验进行最优决策。

这就需要平衡探索(Exploration)和利用(Exploitation)的关系。

常用的方法是采用ε-贪心策略,即以ε 的概率进行随机探索,以 1-ε 的概率选择已知效果最好的行动。

3. 奖励信号设计为了引导智能系统学习最优策略,需要设计合适的奖励信号。

奖励信号可以反映系统在特定状态下采取特定行动后的预期效果,以激励系统逐步优化。

合理的奖励信号设计是强化学习算法成功的重要关键之一。

4. 基于价值函数的学习强化学习通过建立和更新价值函数来评估不同状态-行动组合的价值。

常用的方法有Q-学习(Q-Learning)和SARSA算法,通过不断迭代和更新价值函数,使得智能系统能够在状态空间中获得最大的预期累积奖励。

强化学习在控制系统中的应用

强化学习在控制系统中的应用引言随着人工智能的快速发展和广泛应用,强化学习作为人工智能的一个重要分支,也受到了越来越多的关注。

强化学习是一种以试错学习为基础的学习方式,通过与环境的交互来提高智能体在特定任务上的性能。

在控制系统中,强化学习提供了一种全新的方法和思路,为控制器的设计和优化提供了更多的选择。

本文将介绍强化学习在控制系统中的应用,并探讨其在不同控制领域中的潜在价值。

第一章强化学习的基本原理及算法1.1 强化学习的基本原理强化学习是基于马尔可夫决策过程(MDP)的一种学习方式,主要包括环境、智能体和奖励函数三个基本要素。

智能体通过与环境的交互,通过试错学习来优化其策略,最大化累积奖励。

1.2 强化学习的主要算法强化学习的主要算法包括Q学习、SARSA、DDQN等。

Q学习是一种基于值函数的方法,通过更新策略价值函数Q值来优化策略。

SARSA是一种基于状态-动作价值函数的方法,通过更新状态-动作价值函数来优化策略。

DDQN是一种双重Q学习的方法,通过使用两个独立的Q网络来减少过估计误差。

第二章强化学习在控制系统中的应用2.1 机器人控制在机器人控制中,强化学习可以用于机器人的路径规划、动作精细调节等方面。

通过构建合适的环境和奖励函数,智能体可以学习到最优的路径规划策略,并根据不同的任务需求进行动作调整。

这种基于强化学习的机器人控制方法可以有效提高机器人的行动能力和适应性。

2.2 智能交通系统在智能交通系统中,强化学习可以用于交通信号控制、车辆路径选择等方面。

通过智能体与环境的交互,可以学习到最优的交通信号控制策略,减少交通拥堵和交通事故发生的概率。

同时,智能体还可以学习到最优的车辆路径选择策略,提高整体的交通效率和行驶安全性。

2.3 电力系统控制在电力系统控制中,强化学习可以用于电力负荷预测、电网频率调节等方面。

通过与电力系统的交互,智能体可以学习到最优的负荷预测策略,减少对燃煤等传统能源的依赖,并提高能源利用效率。

强化学习算法的调参技巧(十)

强化学习算法的调参技巧强化学习算法是一种机器学习的方法,它通过试错的方式,让计算机在环境中学习如何做出最优的决策。

在实际应用中,强化学习算法的性能往往受到超参数的影响。

因此,如何合理地调参成为了提高算法性能的关键。

本文将介绍一些强化学习算法的调参技巧,帮助读者更好地应用这一方法。

首先,对于强化学习算法的调参,一个重要的原则是“从简单开始”。

即在进行调参时,应该先从最基本的参数开始调整,逐步地逼近最优的参数组合。

这样做的好处是可以避免在参数空间中盲目搜索,陷入局部最优的情况。

其次,针对不同的强化学习算法,需要重点关注的参数也会有所不同。

以Q-learning算法为例,学习率和折扣因子是两个非常重要的参数。

学习率决定了在每一次迭代中,算法更新Q值的幅度。

如果学习率设置得太大,算法可能会收敛得太快,导致无法找到最优解;反之,如果学习率设置得太小,算法会收敛得过慢,耗费大量时间。

而折扣因子则决定了未来奖励的重要性,它的选择会影响到算法对长期回报的考虑程度。

这些参数的选择需要根据具体的问题和环境进行调整,没有一成不变的标准。

另外,为了更好地调参,还需要结合实际问题的特点和对算法的理解。

在调参的过程中,需要不断地观察算法的表现,并对不同参数组合下的性能进行对比。

这样可以帮助我们更好地理解参数对算法性能的影响,从而找到最优的参数组合。

此外,调参还可以借助一些工具和技巧来辅助。

比如,网格搜索(Grid Search)是一种常用的调参方法,它通过穷举搜索参数空间中的所有组合,找到最优的参数组合。

另外,随机搜索(Random Search)也是一种有效的调参方法,它通过随机选择参数的方式来搜索参数空间。

这些方法都可以帮助我们在参数空间中更快地找到最优解。

最后,需要强调的是,调参只是强化学习算法应用过程中的一部分。

在实际应用中,还需要考虑到数据质量、特征工程等问题。

因此,要想在实际问题中取得好的效果,需要综合考虑各个方面的因素。

强化学习算法的调参技巧(Ⅲ)

强化学习算法的调参技巧强化学习算法是一类机器学习算法,其目标是使智能体在与环境进行交互的过程中,通过学习逐步提高在某些任务上的性能。

在实际应用中,强化学习算法的效果往往取决于参数的选择和调优。

因此,本文将探讨强化学习算法的调参技巧。

一、理解强化学习算法的基本原理首先,要理解强化学习算法的基本原理。

强化学习是基于奖励的学习,智能体通过与环境交互,根据环境的反馈来调整自己的行为,使得在未来获得更多的奖励。

因此,理解奖励函数、价值函数、策略以及环境模型等概念对于调参至关重要。

二、选择合适的强化学习算法不同的问题适合不同的强化学习算法。

例如,对于连续动作空间的问题,可以选择深度确定性策略梯度算法(DDPG)或者优势行动者-评论家算法(A3C)。

而对于离散动作空间的问题,可以选择Q学习算法或者深度Q网络算法(DQN)。

因此,选择合适的算法对于调参非常关键。

三、调整学习率学习率是训练过程中非常重要的超参数,它决定了参数的更新速度。

如果学习率设置过大,可能导致参数更新过于剧烈,无法收敛;如果学习率设置过小,则训练速度会变得很慢。

因此,在调参过程中,需要不断尝试不同的学习率,找到最佳的学习率设置。

四、调整折扣因子折扣因子决定了未来奖励的重要性,一般取值范围在0到1之间。

如果折扣因子设置过小,意味着智能体更加关注即时奖励,而忽略了长期奖励;如果折扣因子设置过大,意味着智能体更加关注长期奖励,而忽略了即时奖励。

因此,在调参过程中,需要根据具体问题调整折扣因子。

五、调整探索率在强化学习算法中,探索率决定了智能体在探索和利用之间的平衡。

如果探索率设置过高,可能导致智能体长时间只进行探索而无法收敛;如果探索率设置过低,可能导致智能体陷入局部最优解。

因此,需要根据具体问题调整探索率,使智能体能够在探索和利用之间取得平衡。

六、调整记忆回放参数在一些深度强化学习算法中,记忆回放是一种重要的技术,它可以帮助智能体更好地学习经验。

使用强化学习进行AI训练

使用强化学习进行AI训练近年来,人工智能(Artificial Intelligence,AI)技术的快速发展,为人类生活带来了前所未有的变革。

而实现优秀的AI功能,离不开对其进行充分的训练。

强化学习(Reinforcement Learning)作为AI领域的一种重要技术方法,被广泛应用于AI训练过程中。

本文将探讨使用强化学习进行AI训练的方法和应用,并分析其优势和挑战。

一、强化学习概述强化学习是一种通过智能体与环境的交互学习的方法。

在强化学习中,智能体通过采取不同的动作来观察和感知环境,并根据环境的反馈(奖励或惩罚)来调整自己的策略以实现特定的目标。

这种学习方式类似于人类的学习过程,通过不断尝试并获得反馈来提高决策能力。

二、强化学习在AI训练中的应用1. 游戏领域强化学习在游戏领域的应用非常广泛。

代表性的例子是AlphaGo,使用了强化学习方法训练成为世界顶级围棋选手。

通过与自己不断对弈,AlphaGo能够从错误中学习,并逐渐熟练掌握围棋的技巧和策略。

2. 机器人控制强化学习在机器人控制中的应用,使得机器人能够通过与环境互动,学习到各种任务的解决方法。

例如,在自动驾驶领域,利用强化学习算法可以让汽车学会规避障碍物、按照交通规则行驶等。

3. 自然语言处理强化学习在自然语言处理中也有广泛的应用。

通过对话模型的训练,能够让机器人理解和生成人类语言,从而实现更自然流畅的对话交互。

例如,在智能助手中,强化学习可以使得机器人更好地理解用户的问题,并给出准确的回答。

三、强化学习训练的优势1. 无需人工标注的训练数据相比于监督学习等其他训练方法,强化学习不需要人工标注的训练数据。

通过与环境互动,智能体能够从环境中获取反馈信息,并根据反馈信息来更新自己的策略。

这种自主学习的方式可以减少训练数据的需求量,从而降低了训练的成本。

2. 适应复杂环境强化学习适用于复杂的环境和任务。

在复杂的环境中,很难通过一开始就给出正确的答案来进行训练。

强化学习理论_算法及应用

控制理论与应用 CON TROL THEORY AND APPLICA TIONS

文章编号 : 1000 - 8152 (2000) 05 - 0637 - 06

强化学习理论 、算法及应用 3

Vol . 17 ,No. 5 Oct . ,2000

张汝波 顾国昌 刘照德 王醒策

(哈尔滨工程大学计算机系·哈尔滨 ,150001)

摘要 : 强化学习 (reinforcement learning) 一词来自于行为心理学 , 这一理论把行为学习看成是反复试验的过程 , 从而把环境状态映射成相应的动作. 首先全面地介绍了强化学习理论的主要算法 , 即瞬时差分法 、Q 2学习算法及 自适应启发评价算法 ; 然后介绍了强化学习的应用情况 ; 最后讨论了强化学习目前所要研究的问题.

(Department of computer science , Harbin Engineering University·Harbin ,150001 , P. R. China) A bs t ract : The term , reinforcement learning ,comes from behavior psychology that takes behavior leaming as trial and er2 ror , by which the states of environment are mapped into corresponding actions . First , the main algorithms , temporal difference , Q2learning and adaptive heuristic critic ,are roundly introduced. Then ,the application of reinforcement leaming is presented. Fi2 nally ,some present research projects of reinforcement learning are discussed.

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Punitkumar Bhavsar System Modeling and Control Group, Department of Electronics and Computer Engineering, Indian Institute of

Technology Roorkee, INDIA mkndnfec@iitr.ernet.in

Sudeep Sharma System Modeling and Control Group, Department of Electronics and Computer Engineering, Indian Institute of

Technology Roorkee, INDIA punit_bhavsar@yahoo.co.in

Abstract—This paper presents a self-tuning method of fuzzy logic controllers. The consequence part of the fuzzy logic controller is self-tuned through the Qlearning algorithm of reinforcement learning. The off policy temporal difference algorithm is used for tuning which directly approximate the action value function which gives the maximum reward. In this way, the Qlearning algorithm is used for the continuous time environment. The approach considered is having the advantage of fuzzy logic controller in a way that it is robust under the environmental uncertainties and no expert knowledge is required to design the rule base of the fuzzy logic controller.

Technology Roorkee, INDIA rajkumar1chak@

M. J. Nigam System Modeling and Control Group, Department of Electronics and Computer Engineering, Indian Institute of

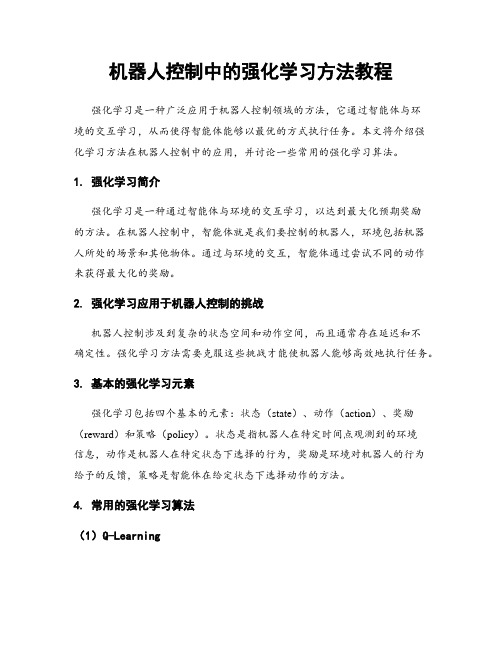

Let’s define [3] M: Cart Mass = 1.096 Kg m: Rod Mass = 0.1096 Kg b: Friction Coefficient of the Cart = 0.1 N/m/sec I: Rod Inertia = 0.0034 Kg*m*m l: Distance from the rod axis rotation center to the rod mass center=0.25m F: Force acting on the cart x: Cart position ф: Angle between the rod and the vertical direction ϴ: Angle between the rod and the vertically downward direction

Copyright © 2012 MECS

one dimension. The task is to balance the pole in the vertical direction by applying forces to the cart's base. The control performance of inverted pendulum can be measured directly by the angle of pendulum from the vertical, the displacement of cart and the transition time of the system. We can use inverted pendulum to test, verify and compare the effectiveness of controller or control theory when an innovative theory or method of control comes out [1], [2]. Therefore, the research for control techniques for inverted pendulum has important theoretic and practical meaning and it is widely concerned by scholars of control and the robotics branch.

In this paper, first the mathematical model of the linear inverted pendulum based on the detailed mechanical analysis of the system [3] is discussed, so as to have a brief idea of the dynamics of the inverted pendulum. Then, the Reinforcement learning algorithm is discussed followed by the MDP and then Q-learning algorithm is discussed. Then the tuning of consequence part of fuzzy logic controller is achieved based on temporal difference off policy control of Q-learning is developed. In this way the Q-learning can also work in the continuous time environment with the help of fuzzy logic controller. The control task is to determine the sequence of forces and magnitudes to apply to the cart in order to keep the pole vertically balanced. Hence results obtained are shown and are analyzed, which gives a satisfactory performance under the

I.J. Intelligent Systems and Applications, 2012, 9, 15-21 Published Online August 2012 in MECS (/) DOI: 10.5815/ijisa.2012.09.02

The equilibrium state is taken as;

̇

̇

P N

F

b

mc

̇

x ̈

Fig. 2 Cart and Rod Force Analysis

From the forces in the horizontal direction, we obtain:

̈

̇̈̇̈̇来自Analyze the force in the vertical direction, and then we have

A. Inverted Pendulum Structure

The structure of the inverted pendulum is as shown in the Fig. 1. After ignoring the air resistance and other frictions, 1-stage linear IP can be simplified as a system of cart and rod, as shown in Fig. 2.

Index Terms— Reinforcement Learning, Q-learning, Inverted Pendulum, Fuzzy logic control, Temporal Difference

I. Introduction

The cart-pole also known as inverted pendulum system, as depicted in Fig.1, is often used as an example of inherently unstable, non-linear, dynamic and multivariable system to demonstrate both classic and modern control techniques, and also the learning control techniques of neural networks using supervised learning methods or unsupervised methods. In this problem, a pole is attached to a cart that moves along

Temporal Difference based Tuning of Fuzzy Logic Controller through Reinforcement Learning to Control an Inverted Pendulum