一种启发式的局部随机特征选择算法

启发式算法实例

启发式算法实例在计算机科学领域,启发式算法是一种通过模拟自然界中某些现象或者基于经验的方法来解决问题的算法。

启发式算法不保证能够找到最优解,但通常能够在合理的时间内找到一个较好的解。

本文将介绍一种常用的启发式算法——模拟退火算法,并通过一个实例来展示其应用。

模拟退火算法(Simulated Annealing, SA)最早由Kirkpatrick等人在1983年提出,其灵感来源于固体退火的过程。

退火是一种将固体加热后缓慢冷却的过程,在这个过程中,固体内部的分子有足够的时间来重新排列以达到最低能量状态。

模拟退火算法则用来解决组合优化问题,尤其是那些在搜索空间非常大的问题。

模拟退火算法的基本思想是通过引入一个随机因素,允许算法在搜索空间中跳出局部最优解,从而更有可能找到全局最优解。

算法的过程如下:1. 初始化:随机生成一个初始解作为当前解,并设定初始温度和退火速率。

2. 迭代搜索:在每次迭代中,对当前解进行随机扰动,得到一个新解。

计算新解的目标函数值和当前解的目标函数值之间的差异。

3. 判断接受:根据目标函数差异和当前温度,决定是否接受新解。

如果新解的目标函数值更优,则直接接受;如果新解的目标函数值较差,则以一定概率接受,概率随温度的下降而降低。

4. 降温:通过退火速率降低当前温度。

5. 终止条件:重复上述步骤直到满足终止条件,例如达到最大迭代次数或者温度降低到某个阈值。

下面我们通过一个旅行商问题(Traveling Salesman Problem, TSP)的实例来演示模拟退火算法的应用。

假设有一位旅行商要拜访n个城市,他想找到一条最短的路径,使得每个城市都被访问且总行程最短。

这个问题可以用图论中的带权完全图来表示,其中每个城市是图中的一个节点,城市之间的距离是边的权重。

我们的目标是找到一条经过所有城市的路径,使得路径上的总权重最小。

使用模拟退火算法解决TSP问题的步骤如下:1. 初始化:随机生成一个初始解,即城市的访问顺序。

启发式算法详细讲解

启发式算法详细讲解

启发式算法(Heuristic Algorithm)也被称为启发算法或者近似算法,是一种通过启发式搜索的方式来解决问题的算法。

启发式算法与精确算法不同,它不保证最优解,但通常能够在合理的时间内找到较好的解。

启发式算法的基本思想是根据问题的特性和经验,使用一些启发式的规则或策略来指导搜索过程,以此来引导算法在搜索空间中找到可能更接近最优解的解。

具体来说,启发式算法通常包含以下步骤:

1. 初始解生成:通过某种方法生成一个初始解,可以是随机生成、基于经验的启发式规则生成等。

2. 邻域搜索:在当前解的周围搜索邻域解,通过一系列的局部搜索操作,如交换、插入、删除等,来生成新的解。

3. 评估函数:对新生成的解进行评估,评估函数用来衡量解的好坏程度,可以是目标函数值、代价函数值、质量评估值等。

4. 更新解:根据评估函数的结果,更新当前解为评估值更好的解。

5. 终止条件:根据预设的终止条件,判断是否终止搜索过程。

终止条件可以是找到满足要求的解或达到最大迭代次数等。

启发式算法的性能依赖于初始解的生成和邻域搜索操作的设计,以及评估函数的准确性。

在实际应用中,针对不同的问题,可以使用不同的启发式算法。

常见的启发式算法有贪婪算法、模拟退火算法、遗传算法、禁忌搜索等。

需要注意的是,启发式算法不能保证找到全局最优解,但可以在合理的时间内找到接近最优解的解。

启发式算法常常应用于那些NP难问题或解空间很大的问题中,可以在较短的时间内找到近似最优解,是一种非常实用的算法设计思想。

常见的随机算法、近似算法和启发式算法的案例

常见的随机算法、近似算法和启发式算法的案例常见的随机算法、近似算法和启发式算法的案例有:

随机算法:

1. 随机洗牌算法:用于打乱一组数据的顺序,常用于实现随机排列或游戏中的洗牌操作。

2. 蒙特卡洛算法:通过随机采样的方法,来估计一个问题的解或某个数值的概率分布,例如蒙特卡洛模拟的方法用于计算圆周率π的值。

近似算法:

1. 近似最近邻算法:快速搜索给定查询点最近邻的点,而不需要对所有数据点进行完全搜索,例如kd树算法。

2. 近似最小覆盖问题的算法:在给定一组区域的情况下,选择尽可能少的区域来覆盖所有点,例如贪心算法。

启发式算法:

1. 蚁群算法:模拟蚂蚁在寻找食物时的行为,通过信息素的释放和感知,来寻找全局最优解,常用于求解旅行商问题。

2. 遗传算法:基于生物进化理论,通过模拟自然选择、基因交叉、变异等操作,来搜索优化问题的解空间,例如用于解决旅行商问题或优化函数的最优解。

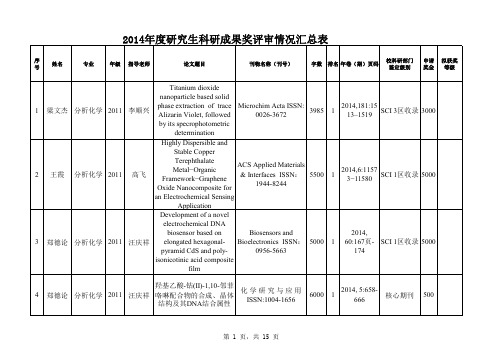

闽南师范大学2014年研究生奖励政策

Sets and Knowledge 3484 1 第129页-

Technology(0302-

138页

9743)

EI会议

500 三等奖

33 祝燕青 应用数学 2013

祝峰

A Variable Precision

The Scientific World

Covering-Based Rough Set Model Based on Functions

5000

an Electrochemical Sensing

Application

Development of a novel

electrochemical DNA

biosensor based on

Biosensors and

2014,

3 郑德论 分析化学 2011 汪庆祥 elongated hexagonal- Bioelectronics ISSN: 5000 1 60:167页- SCI 1区收录 5000

irradiation

Nonenzymatic hydrogen peroxide biosensor based

on four different morphologies of cuprous

oxide naaocrystals

Journal of materials research;ISSN:0884- 5233

pyramid CdS and poly-

0956-5663

174

isonicotinic acid composite

film

羟基乙酸-钴(II)-1,10-邻菲 化 学 研 究 与 应 用

2014, 5:658-

特征选择算法

特征选择算法1 综述(1)什么是特征选择特征选择 ( FeatureSelection )也称特征⼦集选择(Feature Subset Selection , FSS ) ,或属性选择( AttributeSelection ) ,是指从全部特征中选取⼀个特征⼦集,使构造出来的模型更好。

(2)为什么要做特征选择在机器学习的实际应⽤中,特征数量往往较多,其中可能存在不相关的特征,特征之间也可能存在相互依赖,容易导致如下的后果:Ø 特征个数越多,分析特征、训练模型所需的时间就越长。

Ø 特征个数越多,容易引起“维度灾难”,模型也会越复杂,其推⼴能⼒会下降。

特征选择能剔除不相关(irrelevant)或亢余(redundant)的特征,从⽽达到减少特征个数,提⾼模型精确度,减少运⾏时间的⽬的。

另⼀⽅⾯,选取出真正相关的特征简化了模型,使研究⼈员易于理解数据产⽣的过程。

2 特征选择过程2.1 特征选择的⼀般过程特征选择的⼀般过程可⽤图1表⽰。

⾸先从特征全集中产⽣出⼀个特征⼦集,然后⽤评价函数对该特征⼦集进⾏评价,评价的结果与停⽌准则进⾏⽐较,若评价结果⽐停⽌准则好就停⽌,否则就继续产⽣下⼀组特征⼦集,继续进⾏特征选择。

选出来的特征⼦集⼀般还要验证其有效性。

综上所述,特征选择过程⼀般包括产⽣过程,评价函数,停⽌准则,验证过程,这4个部分。

(1) 产⽣过程(Generation Procedure ) 产⽣过程是搜索特征⼦集的过程,负责为评价函数提供特征⼦集。

搜索特征⼦集的过程有多种,将在2.2⼩节展开介绍。

(2) 评价函数(Evaluation Function ) 评价函数是评价⼀个特征⼦集好坏程度的⼀个准则。

评价函数将在2.3⼩节展开介绍。

(3) 停⽌准则(Stopping Criterion ) 停⽌准则是与评价函数相关的,⼀般是⼀个阈值,当评价函数值达到这个阈值后就可停⽌搜索。

启发式算法

启发式算法的特点是能够在搜索过程中利用问题自身的特性信息,从而指导搜索朝 着更有希望的方向前进。

发展历程及现状

启发式算法的发展历程可以追溯到20世纪50年代,当时人 们开始尝试使用启发式方法来求解一些复杂的优化问题。

随着计算机技术的快速发展,启发式算法得到了广泛的应 用和研究,出现了许多不同类型的启发式算法,如模拟退 火算法、遗传算法、蚁群算法等。

目前,启发式算法已经成为解决复杂优化问题的重要工具 之一,在各个领域都得到了广泛的应用。

应用领域与前景

• 启发式算法的应用领域非常广泛,包括生产调度、交通运输、网络通信 、数据挖掘、生物信息学等。

01

模拟生物进化过程,通过选择、交叉、变异等操作寻找全局最

优解。

粒子群优化算法

02

模拟鸟群觅食行为,通过个体和群体的历史最优位置来更新粒

子的速度和位置。

蚁群算法

03

模拟蚂蚁觅食过程,通过信息素的积累和更新来寻找最优路径

。

混合启发式算法

遗传模拟退火算法

结合遗传算法和模拟退火算法的特点,既保持种群多样性又避免 陷入局部最优。

启发式算法

汇报人: 2024-02-06

目录

• 启发式算法概述 • 启发式算法分类 • 经典启发式算法介绍 • 启发式算法设计原则与技巧 • 实际应用案例分析 • 挑战、发展趋势及未来方向

01

启发式算法概述

定义与特点

启发式算法是一种基于直观或经验构造的算法,它能够在可接受的花费(指计算时 间、占用空间等)下给出待解决组合优化问题的一个可行解。

实际应用效果

[整理版]数学建模中用到的启发式算法

![[整理版]数学建模中用到的启发式算法](https://img.taocdn.com/s3/m/5b243971f4335a8102d276a20029bd64783e6273.png)

启发式搜索"启发"( heuristic)是关于发现和发明规则及方法的研究。

在状态空间搜索中, 启发式被定义成一系列规则, 它从状态空间中选择最有希望到达问题解的路径。

人工智能问题求解者在两种基本情况下运用启发式策略:1.一个问题由于在问题陈述和数据获取方面固有的模糊性可能使它没有一个确定的解。

医疗诊断即是一例。

所给出的一系列症状可能有多个原因; 医生运用启发搜索来选择最有可能的论断并依此产生治疗的计划。

视觉问题又是一例。

看到的景物经常是模糊的, 各个物体在其连接、范围和方向上可以有多个解释。

光所造成的幻觉加大了这些模糊性, 视觉系统可运用启发式策略选择一给定景象的最有可能解释。

2.一个问题可能有确定解, 但是求解过程中的计算机代价令人难以接受。

在很多问题(如国际象棋)中, 状态空间的增长特别快, 可能的状态数随着搜索的深度呈指数级增长、分解。

在这种情况下, 穷尽式搜索策略, 诸如深度优先或广度优先搜索,在一个给定的较实际的时空内很可能得不到最终的解。

启发式策略通过指导搜索向最有希望的方向前进降低了复杂性。

通过仔细考虑, 删除某些状态及其延伸, 启发式算法可以消除组合爆炸, 并得到令人能接受的解。

然而, 和发明创造的所有规则一样, 启发式策略也是极易出错的。

在解决问题过程中启发仅仅是下一步将要采取措施的一个猜想。

它常常根据经验和直觉来判断。

由于启发式搜索只有有限的信息,诸如当前Open表中状态的描述,要想预测进一步搜索过程中状态空间的具体的行为很难办到。

一个启发式搜索可能得到一个次最佳解, 也可能一无所获。

这是启发式搜索固有的局限性。

这种局限性不可能由所谓更好的启发式策略或更有效的搜索算法来消除。

启发式策略及算法设计一直是人工智能的核心问题。

博奕和定理证明是两个最古老的应用: 二者都需要启发式知识来剪枝以减少状态空间。

显然, 检查数学领域中每一步推理或棋盘上每一步可能的移动是不可行的。

pso算法python

pso算法pythonPSO算法(Particle Swarm Optimization,粒子群优化算法)是一种基于群体行为的启发式优化算法,由Kennedy和Eberhart于1995年提出。

PSO算法是一种基于群体智能的优化方法,其灵感来源于鸟群或鱼群等生物群体协同行动的行为。

PSO算法的基本思想是通过模拟群体中个体之间的协作和信息共享,来寻找全局最优解。

PSO算法模拟了鸟群中个体飞行时的行为,在搜索过程中通过个体之间的合作来寻找最优解。

PSO算法通过不断更新粒子的速度和位置来实现全局搜索,从而找到最优解。

PSO算法的特点包括易于实现、易于收敛、对初始值不敏感等。

因此,PSO算法在工程优化、神经网络训练、特征选择、模式识别等领域得到了广泛的应用。

PSO算法的基本原理PSO算法基于群体智能的原理,主要由粒子群的群体行为和信息传递两个基本部分组成。

粒子群的位置和速度分别代表了可能的解和搜索的方向,通过不断迭代更新粒子的位置和速度,最终找到最优解。

粒子群的基本行为是模拟了鸟群或鱼群等生物群体的行为。

在PSO 算法中,每个粒子都有自己的位置和速度,同时也有了个体的最优位置和全局最优位置。

粒子群中的每个粒子都通过不断的更新自己的位置和速度来模拟搜索过程,从而找到全局最优解。

粒子群的信息传递是通过个体和全局最优位置来实现的。

在搜索过程中,每个粒子都会根据自己的最优位置和全局最优位置来更新自己的速度和位置,从而实现信息的共享和传递。

通过不断更新粒子的速度和位置,PSO算法可以在搜索空间中找到全局最优解。

PSO算法的步骤PSO算法的基本步骤包括初始化粒子群、更新粒子速度和位置、评估适应度、更新个体和全局最优位置、判断停止条件等。

1.初始化粒子群PSO算法首先需要初始化一个粒子群,包括设定粒子的初始位置和速度、个体和全局最优位置等。

通常情况下,粒子的初始位置和速度是随机生成的,个体和全局最优位置可以初始化为无穷大。

常用特征选择方法

常用特征选择方法特征选择是机器学习和数据挖掘领域中的一个重要任务,它的目的是从原始特征中选择出最具有代表性和预测能力的特征,以提高模型的性能和可解释性。

常用的特征选择方法可以分为三大类:过滤式方法、包裹式方法和嵌入式方法。

过滤式方法是基于给定的评价准则对特征进行独立评估,然后根据评估结果进行特征选择。

常见的过滤式方法包括相关系数法、互信息法和方差选择法。

首先,相关系数法是基于特征和目标变量之间的相关关系进行特征选择。

它通过计算特征与目标变量之间的相关系数来评估特征的重要性,相关系数越大表示特征与目标变量之间的相关性越强,越有可能包含有价值的信息。

常用的相关系数包括皮尔逊相关系数和斯皮尔曼相关系数。

其次,互信息法是基于信息论的概念来评估特征与目标变量之间的信息量。

互信息法通过计算特征和目标变量之间的互信息来评估特征的重要性,互信息值越大表示特征包含的信息量越多,越有可能对目标变量的预测有帮助。

最后,方差选择法是一种简单但有效的特征选择方法。

它通过计算特征的方差来评估特征的重要性,方差越大表示特征的取值变化越大,越可能包含有价值的信息。

方差选择法适用于特征是数值型的情况。

除了过滤式方法,包裹式方法也是常用的特征选择方法。

包裹式方法是将特征选择看作为一个子集选择问题,通过在特征子集上训练和评估模型来选择最佳特征子集。

常见的包裹式方法包括递归特征消除法和遗传算法。

递归特征消除法是一种迭代的特征选择方法,它通过反复训练模型并消除最不重要的特征来选择最佳特征子集。

它的基本思想是从完整特征集合开始,首先训练一个模型,然后根据模型评估特征的重要性,再去掉最不重要的特征,然后重新训练模型,直到达到指定的特征数目或达到最佳性能为止。

遗传算法是一种启发式算法,它通过模拟生物进化的过程进行特征选择。

遗传算法的基本操作包括选择、交叉和变异,通过这些操作对特征子集进行优胜劣汰和优化调整,最终选择出最佳特征子集。

最后,嵌入式方法是将特征选择融入到模型训练的过程中,通过在模型训练过程中学习特征的权重或重要性来选择特征。

启发式方法举例

启发式方法举例

启发式方法是一种基于经验和直观的解决问题的方法,通常用于处理复杂的问题,尤其是那些难以用精确的数学模型描述的问题。

以下是一些启发式方法的例子:

1. 贪心算法:这是一种在每一步选择中都采取当前情况下最好或最优(即最有利)的选择,从而希望导致结果是最好或最优的算法。

例如,在找零钱时,如果目标是使硬币数量最少,贪心算法会尽量多地使用大面额的硬币。

2. 模拟退火算法:这是一种随机搜索算法,它结合了局部搜索和随机搜索。

它通过接受部分不好的解决方案,以避免陷入局部最优解。

3. 遗传算法:这是基于生物进化原理的一种优化算法。

在解决问题时,它通过不断地变异、交叉和选择来寻找最优解。

4. 蚂蚁算法:这是一种模拟蚂蚁寻找食物过程的优化算法。

蚂蚁会留下信息素,其他蚂蚁会根据信息素的浓度来寻找食物。

这种算法可以用于解决旅行商问题等。

5. 回溯法:这是一种通过尝试所有可能的解决方案来找到最优解的方法。

如果当前的解决方案不满足要求,它会回溯到上一步,尝试其他的解决方案。

这种方法通常用于解决组合优化问题。

6. 模糊逻辑:这是一种处理不确定性和模糊性的方法。

它使用模糊集合来表示不确定的信息,并使用模糊逻辑进行推理。

7. 启发式搜索:这种方法使用启发式函数来指导搜索的方向。

例如,A搜索算法使用一个启发式函数来估计从一个节点到目标节点的代价,从而决定搜索的优先级。

以上这些方法都是启发式方法的例子,它们在各种领域都有广泛的应用,如计算机科学、工程、经济学、商业等。

特征选择常用算法综述

2.2.2 启发式搜索

(1)序列前向选择( SFS , Sequential Forward Selection )

算法描述:特征子集X从空集开始,每次选择一个特征x加入特征子集X,使得特征函 数J( X)最优。简单说就是,每次都选择一个使得评价函数的取值达到最优的特征加入,其实就 是一种简单的贪心算法。

23 4 5678

搜索

posts 19, comments 255, trackbacks 0, articles 0 特征选择常用算法综述 Posted on 20110102 14:40 苍梧 阅读(36823) 评论(12) 编辑 收藏

1 综述

(1) 什么是特征选择 特征选择 ( Feature Selection )也称特征子集选择( Feature Subset Selection , FSS ) ,或属性选

<1>序列浮动前向选择( SFFS , Sequential Floating Forward Selection )

算法描述:从空集开始,每轮在未选择的特征中选择一个子集x,使加入子集x后 评价函数达到最优,然后在已选择的特征中选择子集z,使剔除子集z后评价函数达到最优。

<2>序列浮动后向选择( SFBS , Sequential Floating Backward Selection )

chrischeng

2. Re:那些优雅的数据结构 (1) : BloomFilter——大规 模数据处理利器

你好,请问一下表1D1 D2 D3 M11 2 3 1002 3 1 503 2 1 80表2d1 d2 d3 m1 flag2 3 1 60 U1 2 3100 D4 3 4 30 I 我......

人工智能开发中的特征选择方法介绍

人工智能开发中的特征选择方法介绍随着人工智能的迅速发展,数据在我们的生活中扮演着越来越重要的角色。

随之而来的是对于数据挖掘和机器学习技术的需求也越来越大。

而在这些技术中,特征选择方法的重要性日益突显。

本文将介绍一些常见的特征选择方法,帮助读者更好地理解和应用于人工智能开发中。

特征选择是指从所有可能的特征中选择出更加有用的特征,用来构建模型或者解决问题。

特征选择的目的是减少数据集的维度,并提高模型的性能。

下面将介绍几种常见的特征选择方法。

一、过滤式特征选择法过滤式特征选择法是一种简单快速的特征选择方法。

这种方法独立于任何具体的学习算法,它通过评估特征与类别之间的相关性来进行特征选择。

常见的过滤式特征选择方法有皮尔逊相关系数、互信息等。

皮尔逊相关系数是一种经典的统计量,用于衡量两个变量之间的线性相关性。

在特征选择中,我们可以计算每个特征与目标变量的皮尔逊相关系数,选择相关性高于某个阈值的特征。

互信息是用于衡量两个变量之间信息量的度量。

在特征选择中,我们可以计算每个特征与目标变量之间的互信息,选择互信息高于某个阈值的特征。

二、包裹式特征选择法包裹式特征选择法是一种比较耗时的特征选择方法,它直接采用评估模型在不同特征子集上的性能来进行特征选择。

这种方法与具体的学习算法密切相关,需要多次训练模型来选择最优特征子集。

常见的包裹式特征选择方法有递归特征消除、遗传算法等。

递归特征消除是一种基于模型评估的特征选择方法。

它通过计算每个特征的重要性,并不断剔除最不重要的特征,直到达到预定的特征数量。

遗传算法是一种启发式的优化算法,用于解决最优化问题。

在特征选择中,我们可以将每个特征视为一个个体,通过不断地进化和选择,找到最优的特征子集。

三、嵌入式特征选择法嵌入式特征选择法是一种将特征选择嵌入到学习算法中的方法。

这种方法不需要事先进行特征选择,而是将特征选择作为模型训练的一部分。

常见的嵌入式特征选择方法有L1正则化、决策树等。

人工智能开发技术的自动化特征选择

人工智能开发技术的自动化特征选择人工智能(Artificial Intelligence,AI)的飞速发展已经成为当今社会的热门话题。

在AI的众多关键技术中,自动化特征选择(Automated Feature Selection)被广泛应用于数据预处理和模型构建中,具有重要的意义和价值。

本文将探讨人工智能开发技术中自动化特征选择的主要内容及其优势。

自动化特征选择是指通过算法和模型来自动选择具有较高贡献度和关联性的特征,将不相关或冗余的特征排除在建模的过程中,从而提高模型的性能和可解释性。

自动化特征选择的核心是综合考虑特征的贡献度、关联度和唯一性。

通过合理的算法设计和模型定制,可以优化特征选择的过程,并提高人工智能模型的效果。

自动化特征选择具有以下优点。

首先,它可以减少特征维度,降低了模型的复杂性和计算成本。

在大规模数据集和复杂模型的情况下,特征数量往往是庞大的,这就需要耗费大量的计算资源和时间。

通过自动化特征选择,可以从原始特征集中提取出最有价值的特征,减少特征维度,从而减轻了计算负担。

其次,自动化特征选择可以提高模型的准确性和泛化能力。

特征选择能够过滤掉无关和冗余的特征,使模型更关注与目标任务密切相关的特征,提高模型的准确性。

此外,在特征选择的过程中,还可以发现特征之间的关联性,有助于发掘数据中的潜在模式和规律,进一步提高模型的泛化能力。

第三,自动化特征选择可以提高模型的可解释性。

人工智能模型往往是一个“黑箱”,难以被理解和解释。

通过特征选择,可以从原始特征中选择出对模型预测结果具有重要影响的特征,使得模型的输出更加可解释。

这对于模型的可解释性和应用场景的可接受性至关重要。

自动化特征选择的应用范围非常广泛。

在分类问题中,自动化特征选择可以用于选择最具判别性的特征,从而提高分类器的准确性。

在回归问题中,自动化特征选择可以用于选择最具相关性的特征,从而提高回归模型的拟合效果。

在聚类问题中,自动化特征选择可以用于选择最具代表性的特征,从而优化聚类结果。

大数据分析中的特征选择方法教程

大数据分析中的特征选择方法教程在大数据时代,数据量的爆炸性增长给我们带来了巨大的机遇和挑战。

为了从海量数据中挖掘出有价值的信息,大数据分析成为了一项非常重要的技术。

特征选择方法作为大数据分析的前处理步骤之一,能够帮助我们从众多的特征中选择出与目标变量有关的重要特征,从而提高数据分析和建模的效果。

本文将为您介绍几种常用的特征选择方法,并给出相应的实践示例。

一、过滤式特征选择过滤式特征选择是在特征选择与建模之前独立进行的,它通过计算特征与目标变量之间的相关性或者其他统计指标来评估特征的重要性。

常用的过滤式特征选择方法有:卡方检验、互信息和相关系数等。

1. 卡方检验卡方检验是一种统计方法,用于衡量两个分类变量之间的相关性。

在特征选择中,我们可以使用卡方检验衡量一个特征对目标变量的相关性。

具体来说,对于每个特征,我们可以计算特征与目标变量之间的卡方值,然后选择卡方值较大的特征作为重要特征。

2. 互信息互信息是一种衡量两个变量之间的相关性的度量方法。

在特征选择中,我们可以使用互信息来评估特征与目标变量之间的相关性。

与卡方检验不同的是,互信息可以捕捉到非线性关系。

具体来说,互信息的值越大,表示特征与目标变量之间的相关性越强。

3. 相关系数相关系数是一种衡量两个变量之间线性相关性的度量方法。

在特征选择中,我们可以使用相关系数来评估特征与目标变量之间的线性相关性。

具体来说,相关系数的绝对值越大,表示特征与目标变量之间的线性相关性越强。

二、包裹式特征选择包裹式特征选择是在特征选择与建模之间进行的,它通过将特征选择看作一个搜索问题,从特征子集中搜索出最佳的特征组合,达到提高模型性能的目的。

常用的包裹式特征选择方法有:递归特征消除和遗传算法等。

1. 递归特征消除递归特征消除是一种启发式的特征选择方法,它通过递归地构建模型和剔除次要特征来选择最佳特征子集。

具体来说,递归特征消除首先训练一个模型,然后根据特征的重要性进行排序,接下来从最不重要的特征开始逐步剔除,直到达到设定的特征数目或者达到最优性能。

数学建模中用到的启发式算法

数学建模中用到的启发式算法

启发式算法是一种通过显式的方法解决问题的技术,它常常被用在解决复杂的数学建模问题。

它的优点在于它可以快速地找到最优解,而无需进行一次详细的。

启发式算法的基本结构是通过一系列概率分布函数来生成候选解决方案,它们会根据先前的经验以及当前的模型来评估这些候选方案,并且选择最有可能的候选方案作为解决方案。

启发式算法在数学建模中的一个有用的应用是局部最优化。

局部最优化算法包括模拟退火(SA)、遗传算法(GA)和蚁群算法(ACO)。

这三种算法都是一种启发式算法,它们的目标是在一系列可能的候选解决方案中,找出一个尽可能接近最优解的解决方案。

模拟退火算法模拟了物理冷却过程,利用热量的传递作为一种方法,从而在空间中以一定的概率寻找最优解。

它的基本假设是,能量会沿着温度的降低而流向最低点。

尽管很多时候不能找到全局最优解,但它还是能够快速地找到一个良好的、可接受的最优解。

遗传算法是一种最优解的启发式算法,它模仿生物进化的过程,如遗传、变异和选择,并用它们来更新候选解决方案。

机器学习中的特征选择与数据预处理方法

机器学习中的特征选择与数据预处理方法机器学习是一种将人工智能引入实际应用的方法,但是这个过程中需要大量的数据和预处理,特征选择则是其中的重要一环。

在本篇文章中,我们将深入探讨机器学习中的特征选择和数据预处理方法。

一、特征选择的原理和意义特征选择是指从所有特征中挑选出最优特征,然后使用这些特征进行数据处理和建模。

其原理是通过对不同特征进行比较和分析,选出对结果影响最大的特征,以达到提高模型准确性的目的。

特征选择的意义也是非常重要的,首先从减少冗余特征的角度出发,可以加快模型运行速度,减少模型出错的概率。

另外,对于过多的特征,如果不进行特征选择很可能导致过拟合的问题,特征选择能够大大降低过拟合的风险,从而提高模型的泛化能力。

二、特征选择的常用方法特征选择是机器学习的一个重要环节,也是一个比较复杂的过程,常用的特征选择方法主要有以下几种:1、过滤式特征选择过滤式特征选择是最常用的特征选择方法之一,它是在训练模型之前,根据某些特定的标准对特征进行筛选,去掉一些对结果影响不大的特征,从而提高模型训练的效率和准确度。

常用的过滤式特征选择方法有如下几种:1)方差选择:对所有输入变量进行方差计算,如果方差较小则被认为对结果影响不大,可进行删除,以达到减少特征的目的。

2)相关系数选择:利用特定算法计算各特征之间的相关性,然后根据一定的标准进行选择。

3)互信息选择:互信息是指两个变量之间的相互信息量,可用于评价变量之间的独立性和相关性,再根据一定标准进行选择。

4)卡方检验:通过卡方检验计算变量之间的关联程度,然后根据一定的标准进行选择。

2、包裹式特征选择包裹式特征选择是一种较为复杂的特征选择方法,其原理是将特征选择嵌套在模型中,依靠模型的性能来评价特征的重要性,从而得到最终的特征组合。

常用的包裹式特征选择方法有如下几种:1)递归特征消除(RFE):RFE是一种特征选择方法,它依靠模型判断特征的重要性,并通过不断地迭代来选择特征。

机器学习中的参数优化的高级技巧介绍

机器学习中的参数优化的高级技巧介绍在机器学习中,参数优化是一个非常重要的任务。

通过优化参数,我们可以让模型更好地拟合数据,提高模型的性能。

传统的参数优化方法如网格搜索和随机搜索已经有了很多成熟的技巧,但在某些情况下,这些方法可能会受到一些限制,效果不尽人意。

因此,研究人员不断提出一些高级的参数优化技巧来解决这些问题。

一种常见的高级参数优化技巧是贝叶斯优化。

贝叶斯优化通过构建一个目标函数的统计模型,来推断出在哪些参数组合下模型的性能最好。

它首先选择一些初始参数组合,并在模型上进行评估。

然后,利用这些评估结果来更新模型的统计模型,并根据统计模型来选择下一组要评估的参数。

通过不断迭代这个过程,贝叶斯优化能够在较少的评估次数下找到最优的参数组合。

另一种高级参数优化技巧是遗传算法。

遗传算法是一种受到自然界进化过程启发的方法。

它通过模拟基因交叉和变异的过程,来生成新的参数组合,并根据目标函数的评估结果来选择下一代的参数组合。

遗传算法具有一定的随机性,在搜索空间较大或者存在多个局部最优解的情况下,表现良好。

同时,由于其并行化的特点,遗传算法在大规模参数优化问题上也有较好的表现。

除了贝叶斯优化和遗传算法,启发式算法也是一种常见的高级参数优化技巧。

启发式算法试图通过模拟一些智能体的行为,来搜索最优参数组合。

例如,模拟退火算法就是一种启发式算法,它以一定的概率接受较差的解,并逐渐降低这个概率,以便在搜索过程中跳出局部最优解。

遗传算法也可以被认为是一种启发式算法。

除了上述介绍的高级参数优化技巧,还有很多其他方法可以用来优化参数。

比如,粒子群优化算法、蚁群优化算法等。

这些方法都来源于不同的领域或者灵感,但它们的目标都是找到最优的参数组合。

在实际应用中,我们需要根据具体的问题和数据特征选择适合的参数优化方法。

不同方法有不同的优势和适用范围。

贝叶斯优化适用于参数空间连续且维度较高的情况,而遗传算法适用于参数空间离散或者维度较低的情况。

启发式搜索算法

启发式搜索算法

一、定义

启发式,又称为有启发性,是一种智能算法,它通过有效地给定的空

间来求解其中一特定问题,从而找到一个最优解。

启发式算法是以概率机

器学习的概念为基础,通过利用已有知识结合启发式函数来实现有效的。

二、分类

启发式可以分为两类:有限空间和无限空间。

有限空间算法包括深度

优先(DFS)、广度优先(BFS)等,这些算法通过有限次数的步骤状态空间,来尝试找出最佳解决方案。

而无限空间算法则是基于空间的随机加载,并根据不断变化的环境状况,来更新策略,以达到更优的最终解决方案。

三、基本原理

启发式算法的主要思想是在不知道结果的情况下,通过评估当前状态

来估计未来状态的最优解。

因此,启发式算法需要引入一种启发式函数,

即评价函数,来评估当前状态,以更有效地空间并找出最优解。

四、算法步骤

1.设置初始状态:设置初始状态,即的起点,以决定从哪里开始。

2.评估函数:定义一个评估函数,该函数可以比较当前状态与最终状

态之间的差距。

启发式算法

启发式算法简介启发式算法(Heuristic Algorithm)是一种通过寻找经验法则或启发式知识来解决复杂问题的算法。

启发式算法在面对NP-难问题时具有较高的效率和实用性,但不能保证获得最优解。

这种算法通常通过探索问题的解空间来找到近似最优解,是一种具有全局搜索特性的方法。

启发式算法的设计灵感来源于人类的思维方式。

通过运用特定的规则和策略,启发式算法可以快速找到问题的解,尽管该解不一定是最优解。

启发式算法的优势在于其高效性和实用性,特别适用于实际应用中的大规模、复杂问题的求解。

常见启发式算法1. 蚁群算法(Ant Colony Optimization,ACO)蚁群算法模拟了现实生活中蚂蚁寻找食物的行为,它通过蚂蚁在解空间中的移动来搜索最优解。

蚁群算法的关键是利用信息素的概念,即蚂蚁在探索过程中通过释放和感知信息素来进行交流。

信息素的释放和感知会影响蚂蚁的移动策略,从而实现解空间中的全局搜索。

2. 遗传算法(Genetic Algorithm,GA)遗传算法是一种模拟自然界中生物进化过程的优化算法。

它通过模拟遗传学中的基因、染色体和群体等概念,通过遗传、交叉和变异等操作来搜索最优解。

遗传算法通过选择和保留优良个体,逐代进行进化,最终得到接近最优解的结果。

3. 粒子群优化算法(Particle Swarm Optimization,PSO)粒子群优化算法模拟了鸟群或鱼群中个体之间的合作和协调行为。

在粒子群算法中,每个个体被称为粒子,每个粒子在解空间中通过自身的经验和邻居粒子的协作来搜索最优解。

粒子群算法通过粒子的位置和速度的调整逐步逼近最优解。

4. 模拟退火算法(Simulated Annealing,SA)模拟退火算法模拟了固体退火的过程,在搜索解空间中自适应地调整温度来避免陷入局部最优解。

在模拟退火算法中,初始温度较高时,算法具有较大的搜索范围,然后逐渐降低温度,减少搜索范围,最终收敛到全局最优解。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

puter Engineering and Applications,2016,52(2):170-174.

l 引 言 特征选择是 一种关键 的数据 预处 理步骤 ,在模式识

别 、机 器学习等领 域都有着十分广泛的应用 。 。其主要

和大 间隔两种方法 。其 中 ,基于 信息熵的特征选择方法 一 般 需要对数 据进行 离散化处理 ,易造 成信息 的丢失 。 因此 ,在文献 [6]中,Gilad.Bachrach等提 出了一种基 于大

间隔一般用来度量分界面与预测样本之 间的距离 ,

高 的优点 ,但是其计算过程较 为复杂繁琐 。过滤式是将 也 可 用 来 度 量 一 种 分 类 器 相 对 于 其 决 策 的 置 信 度 。 然

特征 选择作 为一个预处 理过程 ,简单易行 ,时 间复 杂度 而 ,大问隔只 考虑样本 之间 的相 似性 ,未兼顾特 征之 间

思想是从 一组 已知的特征 集中按照 某一准则选 择 区分 间隔 的特 征选择算法 。在 文献[7]中 ,Sun等人进一步证

性较好的特征子集 。特征选择算法一般可分 为过 滤式 、 明了 Relief是一种基于大 间隔 的特征选择方法 。

嵌入式 和封装式 [4-51三大 类 。封装式往 往具有 分类精 度

低 。嵌入式则 试图利用前两种模型的优点 ,在不 同的搜 的相关性 。因此 ,为 了充 分考虑样本间的相似性及特征

索 阶段采 用不 同的评 价准 则。随着数据 量和特征 维数 间的相关性 ,本文提 出了一种启发式的局部随机特征选

的不 断增长 ,过滤式模型更具有现实意义 。

择 算法 。首 先利 用 Relief算 法根 据重 要度对 特 征进行

目前基 于过滤式 的特征 选择算法 主要包括 信息 熵 排 序 ,进而 将得到 的特 征序 列划分为 若干 区段 。其 次 ,

基金项 目:国家自然科学基金(No.61303131,No.61379021);福建省自然科学基金(No.2013J01028);漳州市科技项 目(No.ZZ2013J04)。 作者简介 :刘景华 ,女 ,硕士研究生 ,研 究领域为特征选择 ,E—mail:zzliujinghua@163.corn。 收 稿 日期 :2014.01-20 修 回 日期 :2014.04—29 文 章 编 号 :1002—8331(2016)02—0170—05 CNKI网络 优 先 出版 :2014—05—29,http://www.cnki.net/kcms/doi/10.3778/j.issn.1002—8331.1401—0302.html

摘 要 :深入研 究大间隔从样本 间相似 性 、信 息熵从 特征 间相 关性 进行 特征选择 的特 点 ,提 出一种有 效地融合这 两 类方法的特征选择 算法。采用Relief算法得到 一个有效 的特征排序 ,进 而将其 划分为若 干区段 。设 置各区段 的采样 率 ,以对称 不确定性作为启发 因子获得每个局部 随机 子 空间的特征 子集 。将获得 的所有特征子 集作 为最终 的特征 选择 结果。实验 结果表 明该方法优 于一 些常用 的特征选择算 法。 关 键 词 :特 征 选择 ;大 间隔 ;对 称 不确 定性 ;局 部 随机 子 空 间 文 献 标 志 码 :A 中 图 分 类号 :TPI81 doi:10.3778/j.issn.1002.8331.1401—0302

Computer Engineering andApplications计算 机 工程 与应用

一 种 启 发 式 的局 部 随 机 特征 选 择 算 法

刘景 华 ,林 梦 雷 ,张 佳 ,林 耀进

LIU Jinghua,LIN Menglei,ZHANG Jia,LIN Yaoj in

闽南师范大学 计算机学 院 ,福建 漳州 363000 School of Computer Science,Minnan Normal University,Zhangzhou,Fujian 363000,China

Abstract:Tw o kinds of feature selection algorithm s are further studied,i.e.,the characteristic of large m argin is the sim i— larity between sam ples and the entropy is the correlation between features,an effective feature selection algorithm via fus— ing large m argin and inform ation entropy is proposed.The features are ranked by em ploying the algorithm of Relief,and the ranked feature list is partitioned into a few sections.Based on the heuristic factor of sym m etric uncertainty,the feature subset in each local random subspace is obtained by setting the sam pling rate of each section.The final feature subset is obtained by m erging all feature subsets.Experim ental results show that the proposed algorithm is superior to several f e a— ture selection algorithm s. K ey w ords:feature selection;large m argin;sym m etric uncertainty;local random subspace