Spark详细介绍文库

Spark介绍

背景介绍

起源于美国加州大学伯克利分校AMPLab的大数据计算平台 目前是Apache软件基金会的顶级项目 Spark是一个分布式计算框架,专注于分布式计算 目前版本是1.6.1 (2016.04.29)

应用企业

1、腾讯 场景:广告推荐、日志精准查询

2、阿里(淘宝)

推荐算法、机器学习、graphx 场景:基于度分布的中枢节点发现、基于最大连通图的社区发现、

Spark 执行过程 -- TaskSchedule、TaskSet

cluster mode 运行模式

运行模式包括:local、Yarn、Mesos、Standalone(Spark自带) 目前的使用情况

调试:local

生产:Yarn

一般使用yarn-client,driver在客户端,python spark不支持yarn cluster

sample

groupByKey reduceByKey union join

Sample a fraction fraction of the data, with or without replacement, using a given random number generator seed.

Spark SQL发展--Shark

1、其他Sql on Hadoop工具,表现突出的有:MapR的Drill、Cloudera的Impala、 Shark 2、Shark是Spark生态中的一个组件,它参考Hive架构,并修改了内存管理、物理 计划、执行三个模块,使得性能相较Hive有10-100倍的提升

System.out.println(accum.value());

注:一般是Integer或Long

Spark介绍

Spark介绍安装在集群上的spark版本:spark-1.6.3-bin-hadoop2.6.tgz scala版本:scala-2.10.4.tgz1、spark是什么Spark,是⼀种通⽤的⼤数据计算框架,正如传统⼤数据技术Hadoop的MapReduce、 Hive引擎,以及Storm流式实时计算引擎等。

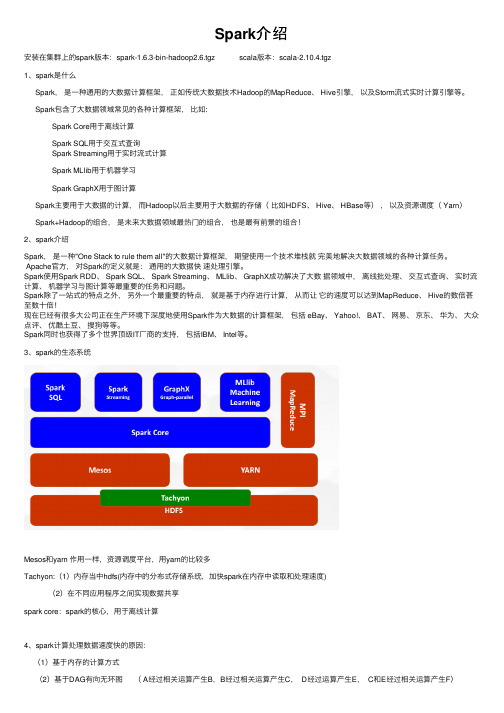

Spark包含了⼤数据领域常见的各种计算框架,⽐如:Spark Core⽤于离线计算Spark SQL⽤于交互式查询Spark Streaming⽤于实时流式计算Spark MLlib⽤于机器学习Spark GraphX⽤于图计算Spark主要⽤于⼤数据的计算,⽽Hadoop以后主要⽤于⼤数据的存储(⽐如HDFS、 Hive、 HBase等),以及资源调度( Yarn)Spark+Hadoop的组合,是未来⼤数据领域最热门的组合,也是最有前景的组合!2、spark介绍Spark,是⼀种"One Stack to rule them all"的⼤数据计算框架,期望使⽤⼀个技术堆栈就完美地解决⼤数据领域的各种计算任务。

Apache官⽅,对Spark的定义就是:通⽤的⼤数据快速处理引擎。

Spark使⽤Spark RDD、 Spark SQL、 Spark Streaming、 MLlib、 GraphX成功解决了⼤数据领域中,离线批处理、交互式查询、实时流计算、机器学习与图计算等最重要的任务和问题。

Spark除了⼀站式的特点之外,另外⼀个最重要的特点,就是基于内存进⾏计算,从⽽让它的速度可以达到MapReduce、 Hive的数倍甚⾄数⼗倍!现在已经有很多⼤公司正在⽣产环境下深度地使⽤Spark作为⼤数据的计算框架,包括 eBay、 Yahoo!、 BAT、⽹易、京东、华为、⼤众点评、优酷⼟⾖、搜狗等等。

Spark同时也获得了多个世界顶级IT⼚商的⽀持,包括IBM、 Intel等。

Spark大数据技术原理与实践

HDFS

HDFS

read iter. 1 write

Input

HDFS read

Input

DataSharinginSpark

太慢,冗余读写、序列化、磁盘IO

HDFS

HDFS

read iter. 2 write

.. .

query 1

result 1

query 2

result 2

query 3 .. .

result 3

10-100x快于网络和磁盘

iter. 1

iter. 2

.. .

Input

one-time processing

Input

Distributed memory

query 1 query 2 query 3

.. .

Spark 核心概念-- RDDs

7

• 弹性分布式数据集(ResilientDistributed Datasets)

重复使用。

– A distributed memory abstraction that letsprogrammers perform

in-memory computations on large clusters – 只读的,可分区的分布式数据集 – 只能直接通过操作符来创建和处理 – 支持容错处理

• R D D 操作:

据栈的基础组件;

• 做什么

– 数据处理( Data Processing): 可以用来快速处理数 据,兼具容错性和可扩展性。

– 迭代计算( Iterative Computation):支持迭代计算, 有效应对多步的数据处理逻辑。

– 数据挖掘( Data Mining):在海量数据基础上进行复 杂的挖掘分析,可支持各种数据挖掘和机器学习算法。

Spark详解

Spark详解⼀、spark简介Apache Spark是⼀个围绕速度、易⽤性和复杂分析构建的⼤数据处理框架。

Spark是⽤Scala程序设计语⾔编写⽽成,运⾏于Java虚拟机(JVM)环境之上。

⽬前⽀持如下程序设计语⾔编写Spark应⽤:Scala、Java、Python、Clojure、R。

1.1 重要概念RDD:(Resilient Distributed Dataset)叫做弹性分布式数据集,是Spark中最基本的数据抽象,它代表⼀个不可变、可分区、⾥⾯的元素可并⾏计算的集合。

算⼦:spark中⽤来操作RDD的函数,主要分为transformation和action两类算⼦。

transformation的特点就是lazy特性,只有当transformation之后,接着执⾏了⼀个action操作,那么所有的transformation才会执⾏driver:运⾏spark程序,初始化SparkContext,划分RDD并初始DAGScheduler、TaskScheduler、SparkUI,发送task到executorexecutor:运⾏tasktask:运⾏在executor上,每个core⼀个taskjob:通过action拆分,每个action算⼦会启动⼀个jobstage:通过宽窄依赖判断,如果存在宽依赖,会产⽣shuffle过程,划分两个stage1.2 spark架构Spark Core:包含Spark的基本功能;尤其是定义RDD的API、操作以及这两者上的动作。

其他Spark的库都是构建在RDD和Spark Core之上的Spark SQL:提供通过Apache Hive的SQL变体Hive查询语⾔(HiveQL)与Spark进⾏交互的API。

每个数据库表被当做⼀个RDD,Spark SQL查询被转换为Spark操作。

Spark Streaming:对实时数据流进⾏处理和控制。

spark 工作原理

spark 工作原理

Spark的工作原理主要包括以下几个方面:

1. 分布式计算:Spark将数据分成多个分区,并将其分布在不

同的计算节点上进行并行处理。

每个计算节点上都运行着Spark的执行引擎,并能够处理独立的任务。

这种分布式计算

的方式能够充分利用集群资源,提高计算效率。

2. 弹性分布式数据集(RDD):RDD是Spark的核心数据模型,它可以对数据进行分布式存储和处理。

RDD是不可变的,即不能直接修改其内容,但可以通过一系列的转换操作来生成新的RDD。

RDD可以被缓存在内存中,以提高计算性能。

3. 任务调度:Spark将用户的代码转化为一系列的任务,并将

这些任务以有向无环图(DAG)的形式进行调度执行。

Spark

的任务调度器可以根据数据的依赖关系来优化任务的执行顺序,并将多个相关的任务合并在一起执行,以减少任务调度的开销。

4. 内存计算:Spark将中间计算结果存储在内存中,以避免频

繁的磁盘IO操作,从而提高计算性能。

通过将数据缓存在内

存中,Spark能够快速地进行迭代计算和交互式查询等操作。

5. 容错性:Spark通过将数据划分成多个分区,并在集群中复

制多份数据来实现容错性。

当某个计算节点发生故障时,Spark可以自动将计算任务转移到其他节点上,并重新执行失

败的任务,以确保计算的完整性和准确性。

总而言之,Spark通过分布式计算、弹性分布式数据集、任务调度、内存计算和容错性等特性,提供了高性能和可靠的大数据处理能力。

它可以处理各种类型的计算任务,并且可以在大规模的集群上进行并行计算,以快速地处理海量的数据。

第2章Spark详细介绍

相关概念 1-1

• RDD是什么

– RDD全称为Resilient([rɪˈzɪljənt] 能复原的、有弹性的) Distributed([dɪ‘strɪbju:tɪd] 分布式) Datasets(数据集)。 – RDD是Spark最核心的模块和类,是Spark操纵数据的一个高度抽象,即Spark所操作的 数据集都是包装成RDD来进行操作的。

– Actions包括Collect、Reduce、Lookup和Save等操作。

• 另外各个处理节点之间的通信模型不再像Hadoop只有Shuffle一种模 式,用户可以命名、物化,控制中间结果的存储、分区等。

Spark四大组件 1

• Spark Streaming [ˈstri:mɪŋ] 。

• Spark Streaming是构建在Spark上的,基于微批量方式 的计算和处理,可以用于处理实时的流数据。 • 它支持高吞吐量、支持容错。 • 它使用DStream,简单来说就是一个弹性分布式数据集

– Executor:即真正执行作业的地方,一个集群一般包含多个Executor,每个 Executor接收Driver的命令Launch Task,一个Executor可以执行一到多个 Task。

相关概念 2-1

• DataFrame是什么

– DataFrame是一种以RDD为基础的分布式数据集,类似于传统数 据库中的二维表格。

相关概念 1-3

• RDD的核心组件 – Client:客户端进程,负责提交作业到Master。 – Master:Standalone模式中主控节点,负责接收Client提交的作业,管理 Worker,并命令Worker启动分配Driver的资源和启动Executor的资源。 – Worker:Standalone模式中slave节点上的守护进程,负责管理本节点的资 源,定期向Master 汇报心跳,接收Master的命令,启动Driver和Executor。 – Driver: 一个Spark作业运行时包括一个Driver进程,也是作业的主进程,负 责作业的解析、生成Stage并调度Task到Executor上。包括DAGScheduler, TaskScheduler。

Spark基本概念及入门

Spark基本概念及⼊门sparkspark背景什么是sparkSpark是⼀种快速、通⽤、可扩展的⼤数据分析引擎,2009年诞⽣于加州⼤学伯克利分校AMPLab,2010年开源,2013年6⽉成为Apache孵化项⽬,2014年2⽉成为Apache顶级项⽬。

⽬前,Spark⽣态系统已经发展成为⼀个包含多个⼦项⽬的集合,其中包含SparkSQL、Spark Streaming、GraphX、MLlib等⼦项⽬,Spark是基于内存计算的⼤数据并⾏计算框架。

Spark基于内存计算,提⾼了在⼤数据环境下数据处理的实时性,同时保证了⾼容错性和⾼可伸缩性,允许⽤户将Spark部署在⼤量廉价硬件之上,形成集群。

Spark与HadoopSpark是⼀个计算框架,⽽Hadoop中包含计算框架MapReduce和分布式⽂件系统HDFS,Hadoop更⼴泛地说还包括在其⽣态系统上的其他系统.为什么使⽤Spark?Hadoop的MapReduce计算模型存在问题:Hadoop的MapReduce的核⼼是Shuffle(洗牌).在整个Shuffle的过程中,⾄少产⽣6次I/O流.基于MapReduce计算引擎通常会将结果输出到次盘上,进⾏存储和容错.另外,当⼀些查询(如:hive)翻译到MapReduce任务是,往往会产⽣多个Stage,⽽这些Stage有依赖底层⽂件系统来存储每⼀个Stage的输出结果,⽽I/O的效率往往较低,从⽽影响MapReduce的运⾏速度.Spark的特点: 快, 易⽤, 通⽤,兼容性快:与Hadoop的MapReduce相⽐,Spark基于内存的运算要快100倍以上,基于硬盘的运算也要快10倍以上。

Spark实现了⾼效的DAG执⾏引擎,可以通过基于内存来⾼效处理数据流。

易⽤:Spark⽀持Java、Python和Scala的API,还⽀持超过80种⾼级算法,使⽤户可以快速构建不同的应⽤。

⽽且Spark⽀持交互式的Python和Scala的shell,可以⾮常⽅便地在这些shell中使⽤Spark集群来验证解决问题的⽅法。

Spark简介

Spark下载

1.

下载地址:/downloads.html,选择Pre-built for Hadoop 2.4 and later 这个包,点击直接下载,这会下载一个spark-1.2.0-bin-hadoop2.4.tgz的压缩包

2. 3.

搭建Spark不需要Hadoop,如果你有hadoop集群或者hdfs,你可以下载相应的版本。

2015

Spark简介

Spark是什么

Spark是一个快速且通用的集群计算平台。 集群计算

把一台电脑无法解决的问题,放到多台电脑组成的集群上进行解决,这就是集群计算。

Spark的特点

1.

Spark是快速的

很多任务能够秒级完成,对于一些特定的工作,Spark比Mapreduce快10-20倍。 Spark扩充了流行的Mapreduce计算模型,使Spark更高效地支持更多类型的计算,包括交互 式查询,和流处理。

1.

Spark是高度开放的

Spark提供了Python,Java,Scala,SQL的API和丰富的内置库。 同时,Spark和其它的大数据工具整合的很好。尤其,Spark能够运行在Hadoop集群上面, 能够访问Hadoop数据。

2.

Spark的组件

Spark包括多个紧密集成的组件。

Spark的组件

Spark基础知识详解

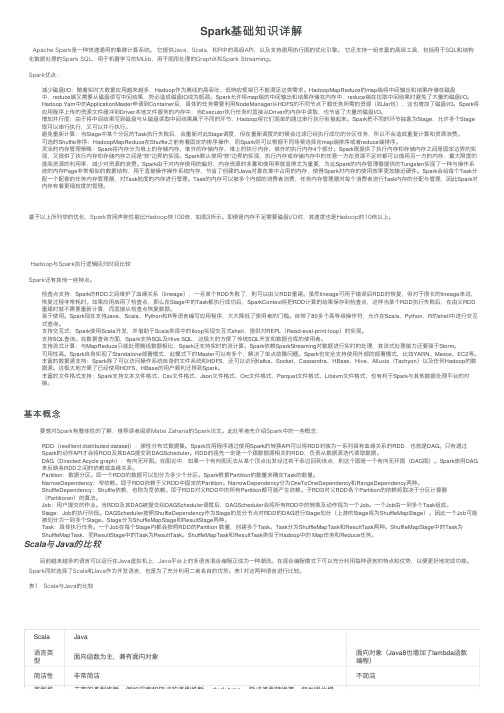

Spark基础知识详解Apache Spark是⼀种快速通⽤的集群计算系统。

它提供Java,Scala,和R中的⾼级API,以及⽀持通⽤执⾏图的优化引擎。

它还⽀持⼀组丰富的⾼级⼯具,包括⽤于SQL和结构化数据处理的Spark SQL,⽤于机器学习的MLlib,⽤于图形处理的GraphX和Spark Streaming。

Spark优点:减少磁盘I/O:随着实时⼤数据应⽤越来越多,Hadoop作为离线的⾼吞吐、低响应框架已不能满⾜这类需求。

HadoopMapReduce的map端将中间输出和结果存储在磁盘中,reduce端⼜需要从磁盘读写中间结果,势必造成磁盘IO成为瓶颈。

Spark允许将map端的中间输出和结果存储在内存中,reduce端在拉取中间结果时避免了⼤量的磁盘I/O。

Hadoop Yarn中的ApplicationMaster申请到Container后,具体的任务需要利⽤NodeManager从HDFS的不同节点下载任务所需的资源(如Jar包),这也增加了磁盘I/O。

Spark将应⽤程序上传的资源⽂件缓冲到Driver本地⽂件服务的内存中,当Executor执⾏任务时直接从Driver的内存中读取,也节省了⼤量的磁盘I/O。

增加并⾏度:由于将中间结果写到磁盘与从磁盘读取中间结果属于不同的环节,Hadoop将它们简单的通过串⾏执⾏衔接起来。

Spark把不同的环节抽象为Stage,允许多个Stage 既可以串⾏执⾏,⼜可以并⾏执⾏。

避免重新计算:当Stage中某个分区的Task执⾏失败后,会重新对此Stage调度,但在重新调度的时候会过滤已经执⾏成功的分区任务,所以不会造成重复计算和资源浪费。

可选的Shuffle排序:HadoopMapReduce在Shuffle之前有着固定的排序操作,⽽Spark则可以根据不同场景选择在map端排序或者reduce端排序。

灵活的内存管理策略:Spark将内存分为堆上的存储内存、堆外的存储内存、堆上的执⾏内存、堆外的执⾏内存4个部分。

spark的特点和应用原理

Spark的特点和应用原理特点•高速处理:Spark是一个快速、通用的集群计算系统,具备高速处理大规模数据的能力。

它通过将计算任务分解成多个小任务,并将其分布在集群中的多个节点上并行执行,从而实现了高速处理和大规模数据处理的能力。

•内存计算:Spark将数据加载到内存中进行计算,因此具备了快速的数据访问和处理能力。

相对于传统的磁盘计算,Spark内存计算的速度更快,可以在较短的时间内完成复杂的计算任务。

•多语言支持:Spark支持多种编程语言,包括Java、Scala、Python 和R等。

这使得开发人员可以使用自己熟悉的编程语言来开发和执行Spark 应用程序,提高了开发人员的工作效率。

•弹性扩展:Spark具备弹性扩展的能力,可以根据任务的需求动态地增加或减少计算资源。

这种弹性扩展的特性使得Spark能够适应不同规模的数据处理需求,并保持高性能。

•容错性:Spark具备容错性,即使在节点失败的情况下,仍能够完成任务的执行。

Spark通过将数据备份到多个节点并使用数据恢复机制来实现容错性,确保计算任务的可靠性。

应用原理Spark的应用原理主要包括以下几个方面:1.分布式计算模型:Spark使用分布式计算模型来进行计算。

它将计算任务拆分成多个小任务,并将其分发到集群中的多个节点上进行并行计算。

这种分布式计算模型可以提高计算效率和性能,并降低计算时间。

2.弹性数据集(RDD):Spark使用弹性数据集(Resilient Distributed Dataset,简称RDD)作为其核心数据结构。

RDD是一个可分区、可并行计算和可容错的数据集合,它可以在内存中进行高速计算。

RDD可以由外部数据集创建,并可以被转化和持久化以支持复杂的计算任务。

3.转换和动作操作:Spark提供了一系列的转换操作和动作操作来处理RDD。

转换操作用于将一个RDD转换为另一个RDD,而动作操作则从RDD 中获取计算结果。

转换操作和动作操作可以按照需要进行组合,构建出复杂的数据处理流程。

spark入门及实践

2010’NJUPT

纲要

1 Spark综述 2 核心技术 3 Spark架构 4 BDAS简介

5 Spark安装部署 6 Spark应用实例 7 Scala简介

2010’NJUPT

三、Spark体系架构

1 架构组成 Master Worker

2010’NJUPT

三、Spark体系架构

2 架构图

2010’NJUPT

二、Spark关键技术

宽依赖和窄依赖的样例。每一个方框表示一个 RDD,其内的阴影矩 形表示 RDD 的分区。

2010’NJUPT

二、Spark关键技术

4 RDD算子

RDD操作算子,RDD中的操作算子可以分为两类: Transformation(变换)算子 与 Action(行动)算子。

Transformation

Transformation操作是延迟计算的,也就是说从一个 RDD转换生成另一个RDD的转换操作不是立即执行的,而是 需要等到Action操作是才真正出发运算。

Action

Action算子会触发Spark提交作业,并将数据输出到 Spark系统。

2010’NJUPT

二、Spark关键技术

6 spark的容错机制

2010’NJUPT

二、Spark关键技术

检查点支持: 虽然 lineage 可用于错误后 RDD 的恢复,但对于很长的 lineage 的 RDD 来说 ,这样的恢复耗时较长。由此,可以考虑将某些 RDD 进行检查点操作 (Checkpoint)保存到稳定存储上。 Spark 当前提供了为 RDD 设置检查点操作的 API , 让用户自行决定需要为哪些 数据设置检查点操作。 由于 RDD 的只读特性使得比常用的共享内存更容易做 checkpoint.由于不需要 关心一致性的问题,RDD 的写出可在后台进行,而不需要程序暂停或进行分布 式快照

Spark大数据技术介绍

Spark大数据技术介绍大数据时代的到来给企业带来了前所未有的机遇和挑战。

数据量的急剧增加以及数据处理速度的要求,推动了大数据技术的发展。

在众多的大数据技术中,Spark作为一种快速、可扩展、通用的大数据处理框架,受到了广泛的关注和应用。

本文将介绍Spark大数据技术的特点、架构以及应用场景。

Spark是由加州大学伯克利分校AMPLab实验室开发的一种开源的大数据处理框架。

与传统的MapReduce相比,Spark具有更高的性能和更广泛的应用场景。

Spark支持在大规模集群上进行高效的数据处理,其基本理念是将数据存储在内存中,通过内存计算来加速数据处理过程,从而极大地提高了数据处理的速度。

Spark的核心模块是Spark Core,它提供了分布式任务调度、内存数据存储、容错机制和并行计算等基本功能。

Spark的另一个重要特点是其可扩展性。

Spark可以在数千台服务器上运行,而且可以方便地与其他大数据处理工具(如Hadoop和Hive)进行集成。

同时,Spark还提供了丰富的API,支持多种编程语言,包括Scala、Java、Python和R等。

Spark提供了丰富的高级库,用于解决各种大数据处理问题。

其中最著名的是Spark SQL、Spark Streaming、MLlib和GraphX。

Spark SQL是Spark提供的用于处理结构化数据的模块。

它支持将结构化数据导入Spark中,并以类似于SQL的方式进行查询和分析。

Spark SQL可以与其他的数据源进行集成,例如Hive、HBase、JSON和Parquet等。

通过Spark SQL,用户可以直接使用SQL语句来处理和分析大规模的结构化数据。

Spark Streaming是用于处理实时数据流的模块。

它能够将实时数据流分成一系列小批次进行处理,并将结果输出到外部系统中。

Spark Streaming可以集成多种数据源,例如Kafka、Flume和Twitter等。

spark入门及实践

区数。

▪ 每个数据分区的地址列表。

2010’NJUPT

二、Spark关键技术

RDD中的依赖关系 RDD之间的依赖关系可以分为两类: 窄依赖:每个父 RDD 的分区都至多被一个子 RDD 的分区使用; 窄依赖允许在单个集群节点上流水线式执行,这个节点可以计算所有父级分区。 在窄依赖中,节点失败后的恢复更加高效。因为只有丢失的父级分区需要重新计 算,并且这些丢失的父级分区可以并行地在不同节点上重新计算。 宽依赖:多个子 RDD 的分区依赖一个父 RDD 的分区。 宽依赖需要所有的父 RDD 数据可用并且数据已经通过类 MapReduce 的操作 shuffle 完成。 在宽依赖的继承关系中,单个失败的节点可能导致一个 RDD 的所有先祖 RDD 中 的一些分区丢失,导致计算的重新执行。

2010’NJUPT

纲要

1 Spark综述 2 核心技术 3 Spark架构 4 BDAS简介

5 Spark安装部署 6 Spark应用实例 7 函数式编程简介

2010’NJUPT

二、Spark关键技术

1 什么是RDD

RDD的全称是弹性分布式数据集(resilient distributed dataset)是Spark的核心数据模型,RDD是Spark中待处理 的数据的抽象,它是逻辑中的实体。 对于使用者来说,你得到的数据操作接口就是RDD,在对 RDD进行处理的时候不需要考虑底层的分布式集群,就像在 单机上一样即可,这也正是Spark的优势之一。

2010’NJUPT

二、Spark关键技术

2 RDD创建方式

▪ 从Hadoop文件系统输入(比如HDFS)创建。 ▪ 从父RDD转换得到新的RDD。 ▪ 将数组或者集合这样的数据结构并行化,转化成RDD。 ▪ 通过cache()函数将计算后的RDD缓存到内存中。

Spark技术及应用

tweets DStream hashTags DStream

batch @ t

batch @ t+1

batch @ t+2

flatMap

flatMap

flatMap

save

save

save

every batch saved to HDFS

RDD Objects

DAGScheduler

TaskScheduler

Worker

Cluster

manager

Threads

DAG

TaskSet

Task

Block

manager

rdd1.join(rdd2)

.groupBy(…)

.filter(…)

build operator DAG

split graph into stages of tasks

foreach

Write to database, update analytics UI, do whatever you want

第二十页,共二十八页。

20

Spark知识(zhī shi)分享

Spark 简介 Spark SQL 简介 Spark Streaming 简介 Spark应用(yìngyòng)场景

第二十一页,共二十八页。

场景1、架构简化(jiǎnhuà) – 混合式到单一架构

将Hadoop+Storm的架构,简化( jiǎnhuà)为Spark架构。实现一键式安装和配置,线程级别的任务监控和告警,降低

硬件集群、软件维护、任务监控和应用开发的难度。后续要做成统一的硬件、计算平台资源池,发展到云计算。

spark知识点总结

spark知识点总结Spark是一种分布式计算引擎,可以在大规模数据上进行高效的数据处理。

它提供了丰富的API,可以支持各种类型的应用程序,包括批处理、交互式查询、流处理和机器学习。

Spark还提供了很多工具和库,可以简化大规模数据处理的工作,同时也提供了很多优化特性,可以确保性能和可靠性。

Spark的核心概念Spark的核心概念包括Resilient Distributed Datasets (RDD)、作业和任务、分区、转换和行动。

这些概念是理解Spark编程模型的关键。

1. Resilient Distributed Datasets (RDD)RDD是Spark的核心数据结构,它代表一个可以在集群上并行操作的数据集合。

RDD可以从外部数据源创建,也可以通过其他RDD进行转换得到。

RDD具有容错性,并且可以在节点之间进行数据分区和并行处理。

2. 作业和任务在Spark中,作业是指由一系列的任务组成的计算单元。

每个任务都是在一个数据分区上并行执行的。

Spark会根据数据依赖关系和调度策略来合并任务,并在集群上执行。

这样可以确保作业能够高效地执行,并且可以减少数据传输和计算开销。

3. 分区分区是指将数据集合分割成多个独立的部分,这样可以在集群上进行并行处理。

Spark提供了很多内置的分区方法,同时也支持自定义分区策略。

正确的分区策略可以提高计算效率,减少数据传输和数据倾斜。

4. 转换和行动在Spark中,转换是指对RDD进行操作来生成新的RDD,例如map、filter、flatMap等。

行动是指对RDD执行计算来获取结果,例如reduce、collect、count等。

转换和行动是Spark编程的核心操作,它们可以用来构建复杂的数据处理流程。

Spark的核心特性除了上述核心概念外,Spark还具有以下几个核心特性:1. 内存计算Spark将数据存储在内存中,可以在多次计算之间重用数据,从而避免了传统的磁盘读写开销。

Spark介绍范文

Spark介绍范文Apache Spark是一种开源的大数据处理框架,最初由加州大学伯克利分校AMPLab团队开发,并于2024年发布。

它提供了高效的数据处理能力,可以在分布式环境中快速处理大规模的数据集。

Spark支持各种数据处理任务,包括批处理、流处理、机器学习和图计算等。

Spark的核心是一个分布式计算引擎,可以将任务划分为多个小任务,并在集群中的多个计算节点上并行执行。

这种并行计算的方式使得Spark具有非常高的性能和可伸缩性。

与传统的批处理框架相比,Spark的主要创新点之一是引入了弹性分布式数据集(Resilient Distributed Datasets,简称RDD)的概念。

RDD是一种抽象的数据结构,可以将数据集分为多个分区,并在内存中进行处理,从而实现极高的性能。

与其他的大数据处理框架相比,Spark具有以下几个特点:1. 高速计算:Spark利用内存计算以及基于RDD的分布式计算模型,可以比传统的批处理框架快上几倍甚至十几倍。

同时,Spark还提供了一系列优化技术,如广播变量、共享变量和累加器等,可以进一步提高计算性能。

2. 多种数据处理方式:Spark不仅支持批处理任务,还支持实时流处理任务。

其流处理模块称为Spark Streaming,可以以非常低的延迟处理实时数据,并将其与批处理任务无缝集成。

此外,Spark还提供了一系列用于机器学习和图计算的库,使得用户可以在同一个框架中完成不同类型的数据处理任务。

3. 易用性:Spark提供了丰富的开发API和高层次的抽象,使得用户可以以简单的方式编写并行计算任务。

Spark支持多种编程语言,如Java、Scala和Python,并提供了交互式的Shell环境,方便用户进行开发和调试。

4. 兼容性:Spark可以与其他大数据处理框架无缝集成,如Hadoop、Hive和HBase等。

用户可以利用Spark的计算引擎替代原有的MapReduce计算引擎,从而提升任务的执行效率。

spark简介

OUTLINE

• 2009年,Spark诞生于伯克利大学AMPLab,最开初属于伯克利大 学的研究性项目。它于2010年正式开源,并于2013年成为了 Aparch基金项目,并于2014年成为Aparch基金的顶级项目,整个 过程不到五年时间

OUTLINE

• Spark的特色在于它首先为大数据应用提供了一个统一的平台。从 数据处理层面看,模型可以分为批处理、交互式、流处理等多种 方式;而从大数据平台而言,已有成熟的Hadoop、CassandrLeabharlann 、 Mesos以及其他云的供应商。

OUTLINE

• 在ncisco召开的Spark Summit 2014大会上,参会的演 讲嘉宾分享了在音乐推荐(Spotify)、实时审计的数据分析 (Sharethrough)、流在高速率分析中的运用(Cassandra)、文 本分析(IBM)、客户智能实时推荐(Graphflow)等诸多在应用 层面的话题,这足以说明Spark的应用程度。

OUTLINE

• 简介 • 核心技术

• RDD • 资源调度 • 容错

• 系统应用

• 客户智能实时推荐(Graphflow) • 实时审计的数据分析(Sharethrough)

• 发展方向

谢谢!

Spark讲解课件

Spark通过提供丰富的Scala, Java,Python API及交互式 Shell来提高可用性。

Spark的适用场景:

Spark立足于内存计算,从而不再需要频繁的读写 HDFS,这使得Spark能更好的适用于:

(1) 迭代算法,包括大部分机器学习算法Machine Learning和比如PageRank的图形算法。

RDD(Resilient Distributed Dataset)

RDD是Spark的最基本抽象,是对分布式内存的抽象使用, 实现了以操作本地集合的方式来操作分布式数据集的抽象 实现。RDD是Spark最核心的东西,它表示已被分区,不 可变的并能够被并行操作的数据集合,不同的数据集格式 对应不同的RDD实现。RDD必须是可序列化的。RDD可 以cache到内存中,每次对RDD数据集的操作之后的结果, 都可以存放到内存中,下一个操作可以直接从内存中输入, 省去了MapReduce大量的磁盘IO操作。这对于迭代运算 比较常见的机器学习算法, 交互式数据挖掘来说,效率提 升比较大。

Shark(Hive SontreSapmairnkg):(Spark):Spark Shark基本上S就tre是a在miSngp是ark构的建在Spark上

Apache Spark组件图 Bagel(pregel on spa框rk架):基B础ag上el是提的供处和理H实iv时e一数样据的框架。其 基于Spark的轻的量H级ive的QL命基令本接原口理。是可将以S理tream数据分 Pregel(Pregel是Goo解gl为e鼎Sh鼎a有rk 名O成n小Sp的a时rk,间就片是段(几秒), 的图计算框架)的Hi实ve现O。n Had以oo类p,似两ba者tc地h批位处理的方式 是一样的来。处理小部分数据。