实验二 合著关系的数据挖掘

大数据分析师如何进行数据挖掘和关联分析

大数据分析师如何进行数据挖掘和关联分析一. 数据挖掘的概念和流程数据挖掘是通过运用统计分析、机器学习和模式识别等技术,从大量的数据中发现有用的模式、规律和知识。

数据挖掘的过程通常包括数据收集、数据预处理、特征选择、模型构建、模型评估和模型应用等步骤。

1. 数据收集数据挖掘的第一步是收集相关的数据。

数据可以来自各种来源,如数据库、文本文件、传感器、社交媒体等。

大数据分析师需要了解业务需求,确定需要收集的数据类型和来源,并采用合适的方法获取数据。

2. 数据预处理数据预处理是数据挖掘中非常重要的一步,它包括数据清洗、数据集成、数据转换和数据规约。

数据清洗是指去除数据中的噪声和异常值,确保数据的质量和准确性。

数据集成是将多个数据源的数据整合到一起,方便后续分析。

数据转换是对数据进行规范化和变换,以适应挖掘算法的需要。

数据规约是对数据进行简化和压缩,减少数据存储和计算的开销。

3. 特征选择特征选择是从大量的特征中选择出最具有代表性和区分性的特征。

通过特征选择可以减少数据维度,提高模型的训练和预测效率。

大数据分析师需要运用统计方法、信息论和机器学习等技术,对特征进行评估和选择。

4. 模型构建模型构建是数据挖掘的核心步骤,它根据业务需求选择合适的挖掘算法和模型。

常用的挖掘算法包括关联规则挖掘、分类和回归分析、聚类分析和时序分析等。

大数据分析师需要根据业务场景和数据特点选择合适的算法,并对模型进行建立和调优。

5. 模型评估模型评估是对挖掘模型进行性能评估和验证。

通过评估可以判断模型的准确性、稳定性和可信度。

评估方法包括交叉验证、混淆矩阵、ROC曲线等。

大数据分析师需要对模型进行评估,识别潜在的问题和改善的方向。

6. 模型应用模型应用是将挖掘模型应用到实际业务中,为决策提供支持和指导。

大数据分析师需要将挖掘结果进行解释和可视化,以便业务人员理解和接受,并根据反馈信息对模型进行迭代和优化。

二. 关联分析的方法和应用关联分析是一种常见的数据挖掘方法,它用于发现数据中的相关性和依赖关系。

数据挖掘实验报告结论(3篇)

第1篇一、实验概述本次数据挖掘实验以Apriori算法为核心,通过对GutenBerg和DBLP两个数据集进行关联规则挖掘,旨在探讨数据挖掘技术在知识发现中的应用。

实验过程中,我们遵循数据挖掘的一般流程,包括数据预处理、关联规则挖掘、结果分析和可视化等步骤。

二、实验结果分析1. 数据预处理在实验开始之前,我们对GutenBerg和DBLP数据集进行了预处理,包括数据清洗、数据集成和数据变换等。

通过对数据集的分析,我们发现了以下问题:(1)数据缺失:部分数据集存在缺失值,需要通过插补或删除缺失数据的方法进行处理。

(2)数据不一致:数据集中存在不同格式的数据,需要进行统一处理。

(3)数据噪声:数据集中存在一些异常值,需要通过滤波或聚类等方法进行处理。

2. 关联规则挖掘在数据预处理完成后,我们使用Apriori算法对数据集进行关联规则挖掘。

实验中,我们设置了不同的最小支持度和最小置信度阈值,以挖掘出不同粒度的关联规则。

以下是实验结果分析:(1)GutenBerg数据集在GutenBerg数据集中,我们以句子为篮子粒度,挖掘了林肯演讲集的关联规则。

通过分析挖掘结果,我们发现:- 单词“the”和“of”在句子中频繁出现,表明这两个词在林肯演讲中具有较高的出现频率。

- “and”和“to”等连接词也具有较高的出现频率,说明林肯演讲中句子结构较为复杂。

- 部分单词组合具有较高的置信度,如“war”和“soldier”,表明在林肯演讲中提到“war”时,很可能同时提到“soldier”。

(2)DBLP数据集在DBLP数据集中,我们以作者为单位,挖掘了作者之间的合作关系。

实验结果表明:- 部分作者之间存在较强的合作关系,如同一研究领域内的作者。

- 部分作者在多个研究领域均有合作关系,表明他们在不同领域具有一定的学术影响力。

3. 结果分析和可视化为了更好地展示实验结果,我们对挖掘出的关联规则进行了可视化处理。

通过可视化,我们可以直观地看出以下信息:(1)频繁项集的分布情况:通过柱状图展示频繁项集的分布情况,便于分析不同项集的出现频率。

数据挖掘概念与技术原书第2版第5章挖掘频繁模式、关联和相关

根据所挖掘的模式类型分类

◦ 频繁项集挖掘

从事务或关系数据集中挖掘频繁项集

◦ 序列模式挖掘

从序列数据集中搜索频繁子序列

◦ 结构模式挖掘

在结构化数据集中搜索频繁子结构

最简单的关联规则挖掘,即单维、单层、布尔关联规 则的挖掘。

Items Bought A,B,C A,C A,D B,E,F

Apriori算法由连接和剪枝两个步骤组成。 连接:为了找Lk,通过Lk-1与自己连接产生候选k-项 集的集合,该候选k项集记为Ck。

◦ Lk-1中的两个元素L1和L2可以执行连接操作 的条件 l1 l2 是

(l1[1] l2 [1]) (l1[2] l2 [2]) ... (l1[k 2] l2 [k 2]) (l1[k 1] l2 [k 1])

根据挖掘的模式的完全性分类:给定min_sup, 可以挖掘频繁项集的完全集,闭频繁项集和极大 频繁项集。也可以挖掘被约束的频繁项集(即满 足用户指定的一组约束的频繁项集)、近似的频 繁项集(只推导被挖掘的频繁项集的近似支持度 计数)、接近匹配的频繁项集(即与接近或几乎 匹配的项集的支持度计数符合的项集)、top-k 频繁项集 不同的应用对挖掘的模式的完全性有不同的要求, 我们主要研究挖掘频繁项集的完全集、闭频繁项 集和被约束的频繁项集

Ck是Lk的超集,即它的成员可能不是频繁的,但是所 有频繁的k-项集都在Ck中(为什么?)。因此可以通 过扫描数据库,通过计算每个k-项集的支持度来得到 Lk 。

◦ 为了减少计算量,可以使用Apriori性质,即如果一个k-项集 的(k-1)-子集不在Lk-1中,则该候选不可能是频繁的,可以 直接从Ck删除。

数据挖掘实验报告数据准备+关联规则挖掘+分类知识挖掘

数据挖掘实验报告数据准备+关联规则挖掘+分类知识挖掘数据挖掘实验报告班级学号姓名课程数据挖掘实验名称实验⼀:数据准备实验类型实验⽬的:(1)掌握利⽤⽂本编辑软件⽣成ARFF⽂件的⽅法;(2)掌握将EXCEL表格⽂件转换为ARFF⽂件的⽅法;(3)掌握数据的预处理⽅法。

实验要求:(1)将下列表格中的数据利⽤⽂本编辑软件⽣成ARFF⽂件:姓名出⽣⽇期性别婚否⼯资职业信⽤等级黄⼤伟1970.05.08 男3580 教师优秀李明1964.11.03 男是4850 公务员优秀张明明1975.03.12 ⼥是职员优秀覃明勇1981.07.11 男是2980 职员良好黄燕玲1986.05.08 ⼥否2560 ⼯⼈⼀般表中没有填上的数据为缺失数据。

请列出你编辑ARFF⽂件并在WEKA中打开该⽂件。

(2)将EXCEL表格⽂件“bankdata.xls”转换为ARFF⽂件的⽅法,并将它另存为ARFF⽂件“bankdata.arff”, 在WEKA中打开该⽂件,写出操作过程。

(3)数值属性的离散化:在WEKA中打开ARFF⽂件“bankdata.arff”,对属性“age”和“income”分别按等宽分箱和等深分箱进⾏离散化为三个箱。

给出分箱的结果。

实验结果:(1) @relation book1@attribute 姓名{黄⼤伟,'李明',张明明,覃明勇,黄燕玲}@attribute 出⽣⽇期{1970.05.08,1964.11.03,1975.03.12,1981.07.11,1986.05.08}@attribute 性别{男,⼥}@attribute 婚否{是,否}@attribute ⼯资numeric@data黄⼤伟,1970.05.08,男,?,3580李',1964.11.03,男,是,4850张明明,1975.03.12,⼥,是,?覃明勇,1981.07.11,男,是,2980黄燕玲,1986.05.08,⼥,否,2560(2)先把bankdata.xls转化为CSV⽂件格式得到bankdata.csv,再在WEKA中打开,再另存为ARFF格式,就可以得到bankdata.arff。

数据挖掘实验报告(参考)

时间序列的模型法和数据挖掘两种方法比较分析研究实验目的:通过实验能对时间序列的模型法和数据挖掘两种方法的原理和优缺点有更清楚的认识和比较.实验内容:选用1952-2006年的中国GDP,分别对之用自回归移动平均模型(ARIMA) 和时序模型的数据挖掘方法进行分析和预测,并对两种方法的趋势和预测结果进行比较并给出解释.实验数据:本文研究选用1952-2006年的中国GDP,其资料如下日期国内生产总值(亿元)日期国内生产总值(亿元) 2006-12-312094071997-12-3174772 2005-12-311830851996-12-312004-12-311365151995-12-312003-12-311994-12-312002-12-311993-12-312001-12-311992-12-312000-12-31894041991-12-311999-12-31820541990-12-311998-12-31795531989-12-311988-12-311969-12-311987-12-311968-12-311986-12-311967-12-311985-12-311966-12-311868 1984-12-3171711965-12-311983-12-311964-12-311454 1982-12-311963-12-311981-12-311962-12-311980-12-311961-12-311220 1979-12-311960-12-311457 1978-12-311959-12-311439 1977-12-311958-12-311307 1976-12-311957-12-311068 1975-12-311956-12-311028 1974-12-311955-12-31910 1973-12-311954-12-31859 1972-12-311953-12-31824 1971-12-311952-12-31679 1970-12-31表一国内生产总值(GDP)是指一个国家或地区所有常住单位在一定时期内生产活动的最终成果。

(完整word版)数据挖掘实验报告-关联规则挖掘(word文档良心出品)

数据发掘实验报告(二)关系规则发掘姓名:李圣杰班级:计算机1304学号: 1311610602一、实验目的1. 1. 掌握关系规则发掘的 Apriori 算法;2.将 Apriori 算法用详细的编程语言实现。

二、实验设施PC 一台,三、实验内容依据以下的Apriori算法进行编程:四、实验步骤1.编制程序。

2. 调试程序。

可采纳下边的数据库 D 作为原始数据调试程序,获得的候选 1 项集、 2 项集、 3 项集分别为C1、C2、 C3,获得的屡次 1 项集、 2 项集、 3 项集分别为L1、 L2、 L3。

代码#include <stdio.h>if(flag==1)#include<string.h>{#define D 4 //事务的个数b[x]=a[i][j];#define MinSupCount 2 // 最小事务支持x++;度数}else flag=1;void main()}{}char a[4][5]={{'A','C','D'},// 计算挑选出的元素的支持度计数{'B','C','E'},for(i=0;i<D;i++){'A','B','C','E'},{{'B','E'}for(j=0;a[i][j]!='\0';j++)};{char for(k=0;k<x;k++)b[20],d[100],t,b2[100][10],b21[100{][10];if(a[i][j]==b[k])int{i,j,k,x=0,flag=1,c[20]={0},x1=0,i1c[k]++;break;=0,j1,counter=0,c1[100]={0},flag1=}1,j2,u=0,c2[100]={0},n[20],v=1;}int count[100],temp;}}for(i=0;i<D;i++)//对选出的项集进行挑选,选出支持度{计数大于等于 2 的,而且保留到d[x1]数组for(j=0;a[i][j]!='\0';j++)中{for(k=0;k<x;k++)// 用来判断以前保留的能否{和 a[i][j]同样,不同样就保留,同样就不if(c[k]>=MinSupCount)保留{for(k=0;k<x;k++)d[x1]=b[k];{count[x1]=c[k];if(b[k]!=a[i][j]) ;x1++;else}{}flag=0;break;//对选出的项集中的元素进行排序}for(i=0;i<x1-1;i++)}{// 用来判断能否相等for(j=0;j<x1-i-1;j++){a[i][k+1]=t;if(d[j]>d[j+1])}{}}t=d[j];d[j]=d[j+1];d[j+1]=t;}//把L1中的每一个元素都放在temp=count[j];count[j]=count[j b2[i][0]中+1];count[j+1]=temp;j1=x1;}for(i=0;i<j1;i++)}{}b2[i][0]=d[i];//打印出 L1}printf("L1 elements are:\n");// 把 L1 中的元素进行组合,K=2 开始,for(i=0;i<x1;i++)表示 x1 个元素选K 个元素的组合{for(k=2;b2[0][0]!='\0';k++)printf("{%c}=%d{ //u是用来计数组合总数的\n",d[i],count[i]);u=0;v=1;//v是用来在进行输出各样组合的表记数v=1说明正在进行输出for(i=0;i<100;i++)}{c2[i]=0;}// 计算每一行的元素个数,而且保留到for(i=0;i<j1;i++)n[] 数组中{for(i=0;i<D;i++)for(i1=i+1;i1<j1;i1++){{for(j=0;a[i][j]!='\0';j++);for(j=0;j<k-2;j++)n[i]=j;{}if(b2[i][j]!=b2[i1][j])// 对 a[][]数组的每一前进行排序{for(i=0;i<D;i++){flag1=0;break;for(j=0;j<n[i]-1;j++)}{for(k=0;k<n[i]-j-1;k++)}{// 进行组合的部分if(a[i][k]>a[i][k+1])if(flag1==1&&b2[i][k-2]!=b2[i1][k- {2])t=a[i][k];{a[i][k]=a[i][k+1];for(j2=0;j2<k-1;j2++){}j1=0;temp=0;//这里的 temp是b21[u][j2]=b2[i][j2];用来分行}// 对 u 种状况进行选择,选出支持度计数大于 2 的 */b21[u][k-1]=b2[i1][k-2];for(i=0;i<u;i++)u++;{}if(c2[i]>=MinSupCount)flag1=1;{}if(v==1)}{counter=0;printf("L%dfor(i=0;i<D;i++) //a数组有elements are:\n",k);5 行元素v=0;{}for(i1=0;i1<u;i1++)//printf("{");代表 x1 个元素选K 个元素的全部组合总数for(j=0;j<k;j++){// 输出每种组合k 个元素for(j1=0;j1<k;j1++){//K代表一个组合中的元素个数{b2[j1][j]=b21[i][j];for(j=0;a[i][j]!='\0';j++)// 逐一比printf("%c,",b2[j1][j]);较每一行的元素}{j1++;printf("\b}");if(a[i][j]==b21[i1][j1])printf("=%d counter++;\n",c2[i]);}temp++;}}if(counter==k)}c2[i1]++; //把每种组合数记录在c2 数b2[j1][0]='\0';组中}counter=0;}}五、结果截图。

数据挖掘 实验报告

数据挖掘实验报告数据挖掘实验报告引言:数据挖掘是一门涉及从大量数据中提取有用信息的技术和方法。

在当今信息爆炸的时代,数据挖掘在各个领域中扮演着重要的角色。

本实验旨在通过应用数据挖掘技术,探索数据中的隐藏模式和规律,以提高决策和预测的准确性。

一、数据收集与预处理在数据挖掘的过程中,数据的质量和完整性对结果的影响至关重要。

在本次实验中,我们选择了某电商平台的销售数据作为研究对象。

通过与数据提供方合作,我们获得了一份包含订单信息、用户信息和商品信息的数据集。

在数据预处理阶段,我们对数据进行了清洗、去重和缺失值处理。

清洗数据的目的是去除噪声和异常值,以确保数据的准确性。

去重操作是为了避免重复数据对结果的干扰。

而缺失值处理则是填补或删除缺失的数据,以保证数据的完整性。

二、数据探索与可视化数据探索是数据挖掘的重要环节,通过对数据的分析和可视化,我们可以发现数据中的潜在关系和规律。

在本次实验中,我们使用了数据可视化工具来展示数据的分布、相关性和趋势。

首先,我们对销售数据进行了时间序列的可视化。

通过绘制折线图,我们可以观察到销售额随时间的变化趋势,从而判断销售业绩的季节性和趋势性。

其次,我们对用户的购买行为进行了可视化分析。

通过绘制柱状图和饼图,我们可以了解用户的购买偏好和消费习惯。

三、数据挖掘建模在数据挖掘建模阶段,我们选择了关联规则和聚类分析两种常用的数据挖掘技术。

关联规则分析用于发现数据集中的频繁项集和关联规则。

通过关联规则分析,我们可以了解到哪些商品经常被一起购买,从而为销售策略的制定提供参考。

在本次实验中,我们使用了Apriori算法来挖掘频繁项集和关联规则。

通过设置支持度和置信度的阈值,我们筛选出了一些有意义的关联规则,并对其进行了解释和分析。

聚类分析用于将数据集中的对象划分为不同的组,使得同一组内的对象相似度较高,而不同组之间的相似度较低。

在本次实验中,我们选择了K-means算法进行聚类分析。

通过调整聚类的簇数和距离度量方式,我们得到了一些具有实际意义的聚类结果,并对不同簇的特征进行了解读和解释。

数据挖掘实例实验报告(3篇)

第1篇一、实验背景随着大数据时代的到来,数据挖掘技术逐渐成为各个行业的重要工具。

数据挖掘是指从大量数据中提取有价值的信息和知识的过程。

本实验旨在通过数据挖掘技术,对某个具体领域的数据进行挖掘,分析数据中的规律和趋势,为相关决策提供支持。

二、实验目标1. 熟悉数据挖掘的基本流程,包括数据预处理、特征选择、模型选择、模型训练和模型评估等步骤。

2. 掌握常用的数据挖掘算法,如决策树、支持向量机、聚类、关联规则等。

3. 应用数据挖掘技术解决实际问题,提高数据分析和处理能力。

4. 实验结束后,提交一份完整的实验报告,包括实验过程、结果分析及总结。

三、实验环境1. 操作系统:Windows 102. 编程语言:Python3. 数据挖掘库:pandas、numpy、scikit-learn、matplotlib四、实验数据本实验选取了某电商平台用户购买行为数据作为实验数据。

数据包括用户ID、商品ID、购买时间、价格、商品类别、用户年龄、性别、职业等。

五、实验步骤1. 数据预处理(1)数据清洗:剔除缺失值、异常值等无效数据。

(2)数据转换:将分类变量转换为数值变量,如年龄、性别等。

(3)数据归一化:将不同特征的范围统一到相同的尺度,便于模型训练。

2. 特征选择(1)相关性分析:计算特征之间的相关系数,剔除冗余特征。

(2)信息增益:根据特征的信息增益选择特征。

3. 模型选择(1)决策树:采用CART决策树算法。

(2)支持向量机:采用线性核函数。

(3)聚类:采用K-Means算法。

(4)关联规则:采用Apriori算法。

4. 模型训练使用训练集对各个模型进行训练。

5. 模型评估使用测试集对各个模型进行评估,比较不同模型的性能。

六、实验结果与分析1. 数据预处理经过数据清洗,剔除缺失值和异常值后,剩余数据量为10000条。

2. 特征选择通过相关性分析和信息增益,选取以下特征:用户ID、商品ID、购买时间、价格、商品类别、用户年龄、性别、职业。

数据挖掘实验报告

数据挖掘实验报告市场购物篮分析经济管理学院企业管理专业1306122427 杨欢欢一、实验背景随着社会进入信息化时代,现代化的企业搜集了大量数据或高维数据,包括市场、客户、供货商、竞争对手以及未来趋势等重要信息,但是信息超载与无结构化,使得企业决策部门无法有效利用现存的信息,甚至使决策行为产生混乱与误用。

通过数据挖掘技术,可以从大量的数据中,挖掘出不同的信息与知识来支持决策,必能产生企业的竞争优势。

数据挖掘和知识发现是一个涉及多学科的研究领域。

数据库技术、人工智能、机器学习、统计学、粗糙集、模糊集、神经网络、模式识别、知识库系统、高性能计算、数据可视化等均与数据挖掘相关。

近年来,与数据库的知识发现研究领域已经成为热点,其中关联规则数据挖掘算法是数据挖掘中的一个很重要的课题,它是从背后发现数据中的关联或联系。

本实验主要处理描述超级市场购物篮内容(所购买的全部商品的集合)的虚构数据,以及购买者的相关个人数据。

目的是寻找购买相似产品并且购买相似产品的客户群特征。

二、实验目的1、掌握数据挖掘的基础知识,能够深刻理解并熟练运用GRI和C5.0规则,能够熟练运用SPSS Clementine11.1软件进行数据分析。

2、利用GRI和C5.0规则对商场客户交易数据进行分析,从中发现客户购买的商品之间的关联关系,并进一步归纳出购买相似商品的顾客群的特征。

3、理解并操作实验中数据挖掘的两个部分,一是关联规则建模和一个显示所购买商品关联关系的网络图;二是C5.0 规则归纳,显示购买建立的产品组合的顾客群具有的特征。

三、操作环境1、系统环境:Windows XP2、软件环境:SPSS Clementine11.13、软件简介:作为一个数据挖掘平台,Clementine结合商业技术可以快速建立预测性模型,进而应用到商业活动中,帮助人们改进决策过程。

强大的数据挖掘功能和显著的投资回报率使得Clementine 在业界久负盛誉。

数据挖掘关联规则实验报告

数据挖掘关联规则实验报告实验七关联规则1. 实验目标使用SSAS进行关联规则挖掘实验2. 实验要求(1)按“实验内容”完成操作,并记录实验步骤;(2)回答“问题讨论”中的思考题,并写出本次实验的心得体会;(3)完成实验报告。

3. 实验内容生成市场篮方案。

Adventure Works 的市场部希望改进公司的网站以促进越区销售。

在更新网站之前,需要根据客户的在线购物篮中已有的其他产品创建一个可预测客户购买需求的数据挖掘模型。

这些预测还有助于市场部将可能被集中购买的项统一放置在网站的一个位置上。

通过实验,创建关联规则模型,可预测可能出现在购物篮中的其他项或客户想要放入购物篮的项。

4. 实验步骤(1) 创建市场篮挖掘模型结构1.在Business Intelligence Development Studio 的解决方案资源管理器中,右键单击“挖掘结构”,再选择“新建挖掘结构”。

此时,系统将打开数据挖掘向导。

2.在“欢迎使用数据挖掘向导”页上,单击“下一步”。

3.在“选择定义方法”页上,确保已选中“从现有关系数据库或数据仓库”,再单击“下一步”。

4.在“选择数据挖掘技术”页的“您要使用何种数据挖掘技术?”下,选中“Microsoft 关联规则”,再单击“下一步”。

“选择数据源视图”页随即显示。

默认情况下,“可用数据源视图”下的Adventure Works DW 为选中状态。

5.单击“下一步”。

6.在“指定表类型”页上,选中vAssocSeqOrders表旁的“事例”复选框,选中vAssocSeqLineItems表旁边的“嵌套”复选框,再单击“下一步”(注意先在视图中建立两个表之间的关联)。

7.在“指定定型数据”页上,依次清除CustomerKey旁边的“键”复选框和LineNumber旁边的“键”和“输入”复选框。

8.选中Model列旁边的“键”和“可预测”复选框。

然后,系统也将自动选中“输入”复选框。

数据挖掘实验报告(两篇)2024

引言概述:数据挖掘是一项广泛应用于各个行业的技术,通过对大数据的处理和分析,可以发现隐藏在数据中的有价值信息。

本文是数据挖掘实验报告(二),将对具体的数据挖掘实验进行详细的阐述和分析。

本实验主要聚焦于数据预处理、特征选择、模型建立和评估等关键步骤,以增加对实验过程和结果的理解,提高实验的可靠性和准确性。

通过实验结果的分析和总结,可以帮助读者更好地理解数据挖掘的方法和技术,并为实际应用提供参考和指导。

正文内容:1. 数据预处理在进行数据挖掘之前,首先需要对原始数据进行预处理。

数据预处理的目的是清洗数据、处理缺失值和异常值等数据问题,以确保数据的质量和准确性。

在本实验中,我们采用了多种方法对数据进行预处理。

其中包括数据清洗、缺失值处理和异常值检测等。

具体的操作包括了数据去重、数据标准化、缺失值的填补和异常值的处理等。

2. 特征选择特征选择是数据挖掘的关键步骤之一,它的目的是从原始数据中选择出对问题解决有价值的特征。

在本实验中,我们通过使用相关性分析、方差选择和递归特征消除等方法,对原始数据进行特征选择。

通过分析特征与目标变量之间的关系,我们可以得出最有价值的特征,从而减少计算复杂度和提高模型准确性。

3. 模型建立模型建立是数据挖掘实验的核心步骤之一。

在本实验中,我们采用了多种模型进行建立,包括决策树、支持向量机、朴素贝叶斯等。

具体而言,我们使用了ID3决策树算法、支持向量机算法和朴素贝叶斯算法等进行建模,并通过交叉验证和网格搜索等方法选择最佳的模型参数。

4. 模型评估模型评估是对建立的模型进行准确性和可靠性评估的过程。

在本实验中,我们采用了多种评估指标进行模型评估,包括准确率、召回率、F1分数等。

通过对模型的评估,我们可以得出模型的准确性和可靠性,并进一步优化模型以达到更好的效果。

5. 结果分析与总结总结:本文是对数据挖掘实验进行详细阐述和分析的实验报告。

通过对数据预处理、特征选择、模型建立和评估等关键步骤的分析和总结,我们得出了对数据挖掘方法和技术的深入理解。

数据挖掘实验报告

数据挖掘实验报告一、实验背景数据挖掘作为一种从大量数据中发现未知、隐藏和有用信息的技术,正日益受到广泛关注。

在本次实验中,我们尝试运用数据挖掘方法对给定的数据集进行分析和挖掘,以期能够从中获取有益的知识和见解。

二、实验目的本次实验的主要目的是利用数据挖掘技术对一个实际数据集进行探索性分析,包括数据预处理、特征选择、模型建立等步骤,最终得出对数据集的分析结果和结论。

三、实验数据集本次实验使用的数据集为XXX数据集,包含了XXX个样本和XXX个特征。

数据集中涵盖了XXX方面的信息,包括但不限于XXX、XXX、XXX等。

四、实验步骤1. 数据预处理在数据挖掘过程中,数据预处理是至关重要的一步。

我们首先对原始数据进行清洗和处理,包括缺失值处理、异常值处理、数据转换等,以确保数据的准确性和可靠性。

2. 特征选择特征选择是指从所有特征中选择最具代表性和价值的特征,以提高模型的效果和准确性。

我们通过相关性分析、主成分分析等方法对特征进行筛选和优化,选取最具信息量的特征用于建模。

3. 模型建立在特征选择完成后,我们利用机器学习算法建立模型,对数据集进行训练和预测。

常用的模型包括决策树、支持向量机、神经网络等,我们根据实际情况选择合适的模型进行建模。

4. 模型评估建立模型后,我们需要对模型进行评估和验证,以确保模型的泛化能力和准确性。

我们采用交叉验证、ROC曲线、混淆矩阵等方法对模型进行评估,得出模型的性能指标和结果。

五、实验结果与分析经过一系列步骤的数据挖掘分析,我们得出了如下结论:XXX。

我们发现XXX,这表明XXX。

同时,我们还对模型的准确性和可靠性进行了评估,结果显示XXX,证明了我们建立的模型具有较好的预测能力和泛化能力。

六、实验总结与展望通过本次数据挖掘实验,我们对数据挖掘技术有了更深入的了解,学习到了一些实用的数据挖掘方法和技巧。

未来,我们将进一步探究数据挖掘领域的新技术和新方法,提高数据挖掘的应用能力和实践水平。

物理实验技术中如何利用实验数据进行数据挖掘

物理实验技术中如何利用实验数据进行数据挖掘在物理实验技术中,数据挖掘是一种重要的技术手段,它可以帮助科学家们从庞大的实验数据中发现隐藏在其中的规律和信息。

数据挖掘的目标是通过自动或半自动的方式,从大量数据中提取出有价值的信息。

在物理实验中,利用数据挖掘可以帮助我们更好地理解和解释实验结果,优化实验设计,甚至发现新的现象或规律。

首先,数据挖掘可以辅助我们更好地理解实验结果。

在物理实验中,我们通常会得到大量的数据,这些数据包含了实验过程中物理量的变化趋势和关联关系。

通过数据挖掘的技术,我们可以对这些数据进行分析和挖掘,从而找到其中的规律和模式。

例如,我们可以利用数据挖掘方法找到实验中物理量之间的关联关系,进一步探索物理规律的本质。

这样,数据挖掘不仅可以帮助我们更好地理解实验结果,还可以补充我们对物理现象的认识。

其次,数据挖掘还可以帮助我们优化实验设计。

在物理实验中,设计一个合理的实验方案非常重要。

通过数据挖掘的技术,我们可以对历史实验数据进行分析,找出影响实验结果的主要因素。

然后,我们可以利用这些因素的信息,优化实验设计,提高实验的效率和准确性。

例如,对于某一物理实验,我们可以通过数据挖掘方法找到影响实验结果的关键因素,并进一步确定这些因素的合理取值范围。

这样,我们就可以在不同条件下选择合适的实验方案,从而降低实验的成本和风险,提高实验的效果。

此外,数据挖掘还可以帮助我们发现新的现象或规律。

在物理实验中,我们通常会遇到一些预期之外的结果或现象,这可能是因为我们没有发现或考虑到某些潜在因素的原因。

通过数据挖掘的技术,我们可以将这些预期之外的数据纳入分析范围,尝试从中找到新的规律或现象。

例如,我们可以通过数据挖掘方法对实验数据进行聚类分析,找到不同实验条件下的相似性和差异性。

这样,我们就有机会发现一些之前不为人所知的现象或规律,进一步推动物理学的发展。

然而,要利用实验数据进行数据挖掘并不是一件容易的事情。

物理实验技术中的数据挖掘和模式识别技巧

物理实验技术中的数据挖掘和模式识别技巧在当今科技高速发展的时代,物理实验技术的进步日新月异。

数据的收集与处理成为物理实验的一个重要环节。

而数据挖掘和模式识别技巧的应用,则在这一环节中发挥着至关重要的作用。

本文将介绍物理实验技术中常见的数据挖掘和模式识别技巧。

首先,我们来谈谈数据挖掘在物理实验技术中的应用。

数据挖掘是指从大量数据中发现有价值、隐含的信息和模式的过程。

在物理实验中,大量的数据需要进行分析和挖掘,以期找到数据背后的规律和关联。

其中,聚类分析是一种常用的数据挖掘方法。

通过对一组数据进行聚类,可以将相似的数据点划分到同一类别中,从而揭示出数据的内在结构和特征。

聚类分析在物理实验中的应用十分广泛,例如对粒子实验结果的分析,通过聚类可以实现与理论模型的对比,从而验证理论的有效性。

除了聚类分析,关联规则挖掘也是物理实验中常用的数据挖掘技巧。

关联规则挖掘是通过寻找数据中的关联关系,从而发现事物之间的相互依赖和关联。

在物理实验中,通过挖掘数据之间的关联规则,可以发现某些物理量之间的相互影响,甚至可以找到新的物理定律。

例如,通过关联规则挖掘,科学家们发现了量子力学中的不确定性原理,这为后来的物理研究打下了重要基础。

接下来,我们来看看模式识别在物理实验技术中的应用。

模式识别是指通过对数据进行处理和分析,从中识别出特定模式和规律的技术。

物理实验中的数据往往呈现出某种模式,通过对这种模式的识别,可以更好地了解实验的结果和本质。

在粒子物理实验中,模式识别技巧被广泛应用于粒子轨迹的识别和重建。

通过对粒子轨迹进行分析和模式识别,可以准确地判断粒子的种类和动力学特征,进而深入研究物质的结构和性质。

此外,机器学习算法也是模式识别中的一项重要技术。

机器学习是通过对大量数据进行学习和训练,从而构建模型和算法,实现对新数据的预测和分类。

在物理实验中,机器学习算法可以帮助科学家们发现隐藏在数据中的特征和规律。

例如,在引力波探测领域,科学家们利用机器学习算法对引力波信号进行分类和识别,从而实现对宇宙中宏观现象的观测和研究。

数据库中的数据挖掘和关联分析方法研究

数据库中的数据挖掘和关联分析方法研究一、引言随着数据管理技术的飞速发展,数据库已经成为当今大型系统中最为重要和必要的组成部分之一。

然而,如何从庞大的数据库中找到有效的信息,却是数据库管理人员需要思考的问题。

数据挖掘和关联分析是最近几年来在数据库管理领域受到广泛研究的课题之一。

本文旨在探讨数据库中的数据挖掘和关联分析的方法,并提出其实际应用的价值。

二、数据挖掘方法1.分类分类是在数据分类模型中进行的一种学习方法,将不同的实例或观察变量所属的类进行有效划分,以便于构建分类器。

典型的分类方法包括朴素贝叶斯、决策树和支持向量机。

2.聚类聚类是一种无监督学习方法,旨在将众多自然存在的、并未预先标记的数据对象集合分成具有相似性质的不同组别。

聚类方法将所有对象分成两个或多个组别,这些组别被称为“聚类”。

聚类常用算法包括K-means、层次聚类和DBSCAN等。

3.异常检测异常检测是特定情况下的数据挖掘技术,主要用于识别非常规的、罕见的或是异常状态的数据模式。

常用异常检测方法包括基于统计方法的离散值方法、基于判别方法的集合距离方法和基于模型的变化检测方法等。

三、关联分析方法1.关联规则关联规则识别是关于大量项集的一类分析问题,旨在发现被归类的项集中的相互依存的关系。

具体而言,这个技术旨在识别数据空间中存在的事件之间的关系和随机性。

2.序列挖掘序列挖掘是关于带时间标记的数据的分析问题,用于挖掘顺序化的数据,例如在物流追踪数据中,识别物品的运动路径,从而帮助进行物流管理和优化。

四、数据挖掘和关联分析的应用数据挖掘和关联分析在现实生活中有着广泛的应用。

举几个例子:1.网站推荐系统。

基于用户行为和偏好的数据挖掘和关联分析技术,可以为用户提供更加精准的推荐服务。

2.商业智能分析。

企业可以利用数据挖掘和关联分析方法,快速发现销售状况、客户流失、市场趋势等关键信息,并制定更有效的业务策略。

3.医疗健康领域。

通过对大量医疗数据的分析,可以提高医疗领域的诊断和治疗效果,甚至可能通过挖掘关联规则预测某些疾病的发生几率。

数据挖掘实验报告

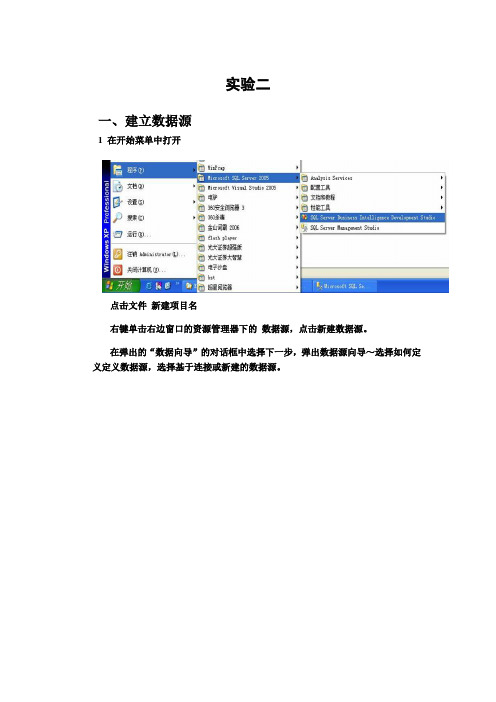

实验二

一、建立数据源

1 在开始菜单中打开

点击文件新建项目名

右键单击右边窗口的资源管理器下的数据源,点击新建数据源。

在弹出的“数据向导”的对话框中选择下一步,弹出数据源向导~选择如何定义定义数据源,选择基于连接或新建的数据源。

如果连接成功会显示如下页面

2·建立数据源视图

在解决方案资源数据管理器中选择~新建数据视图。

选择关系数据库201120181463的数据源,单击下一步。

单击下一步

3建立多维视图

点击下一步

选择一个度量值组表。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

实验二合著关系的数据挖掘

1.实验目的

(1)熟悉与了解数据挖掘的基本理论与方法;

(2)使用Apriori等算法进行频繁项集的挖掘;

(3)通过使用SQL Server进行原始数据的各项处理,理解和掌握数据挖掘(本实验为关联关系挖掘)的一般过程和方法,同时进行SQL Server的数据库语言以及数据挖掘的实操练习。

(4)对于数据挖掘处理大规模的数据,有初步的认知与了解。

2.实验内容

(1)导入数据到数据库中;

(2)在数据库中,对作者与文章的数据进行挖掘,找出同时出现3次及以上的合著组成频繁项集(包括两位作者以及三位作者合著的关系),并列出该频繁项集对应的记录的全部信息;

3. 实验条件

(1)操作系统:Windows 7

(2) SQL Server 2008或以上版本

(3) Excel 2003或以上版本

4. 数据来源及说明

本次实验的所有数据皆来源于,DBLP数据集,DBLP是计算机领域内对研究的成果以作者为核心的一个计算机类英文文献的集成数据库系统。

按年代列出了作者的科研成果。

包括国际期刊和会议等公开发表的论文。

截止目前,DBLP数据集收录的数据已达900万余条。

DBLP数据集中的数据,主要有作者、题目、文章来源、发表日期、文章类型等属性,但是为了便于同学们进行挖掘操作,故而对于原始数据进行了一定程度的预处理,本来这部分工作需要同学们自己完成的,不过请同学们一定不要忽视数据预处理的重要性。

具体挖掘数据的格式,如上图所示,其中,ID为唯一标示,title为文章的名称,title相同的多条记录,表示有多名作者,author为文章的作者,rank 为文章作者的排序,rank=1,说明该作者是第一作者。

因为,文章的作者不同于一般的组合,是有顺序的,所以,在挖掘的过程中,如果出现author1-author2,与author2-author1的次序出现在不同文章中,则认为两者为不同的合作模式。

5. 实验要求

(1)将excel中的原始数据导入到SQL Server中,进行数据挖掘等操作。

(2)挖掘到三位作者的合著关系为止(包括每位作者的写作次数,两位作

者合著的次数,以及三位作者合著的次数);

(3)按时、按照要求提交实验报告。

6. 实验报告

实验报告内容至少包括“2. 实验内容”所示的内容。

具体内容:

(1)列出挖掘结果,包括:合著关系结果(即频繁项集),并列出该频繁项集对应的记录的全部信息;需要通过数据库实现的步骤要有结果截

图,方法等需要有文字说明。

(2)挖掘方法、过程截图及数据库语言代码。

在实验报告中,要写明挖掘的具体方法步骤,需要数据库进行操作的步骤,需要包含代码,并且

附加每一步分析的过程截图。

(3)从L3频繁集中,任选一组合著关系,按照50%的置信度,挖掘强关联规则,写出计算过程及结果。

注明:本实验各步骤的支持度,都取3/数据总量。

7. 实验步骤

7.1 安装SQL Server 2008(略去)

7.2 将excel中的原始数据导入到SQL Server 2008中

本次实验的所有数据皆来源于,DBLP数据集,DBLP是计算机领域内对研究的成果以作者为核心的一个计算机类英文文献的集成数据库系统。

按年代列出了作者的科研成果。

包括国际期刊和会议等公开发表的论文。

截止目前,DBLP

数据集收录的数据已达900万余条。

(1)创建数据库:打开SQL Server Management Studio,进入操作界面后,右键“数据库”→“新建数据库”→“常规”→“数据库名称:”→

“确定”;

(2)将EXCEL数据导入到上述创建的数据库中:右键“数据库”→“任务”→“导入数据”→“数据源:EXCEL”→“路径”→“版本1997-2003”

→“下一步”;

(3)按照提示一步一步进行以下操作;

8. Apriori算法

(1)数据挖掘采用的是Apriori算法,该算法采用频繁项集性质的先验知识,使用一种称为逐层搜索的迭代方法,其中k项集用于搜素k+1项集。

步骤如下:(2)通过扫描数据库,累计每个项的计数,并收集满足最小支持度的项,找出频繁1项集的集合,该集合记为L1。

(3)利用L1找出频繁2项集的集合L2。

使用L2找出L3,如此下去,直到不能再找到频繁k项集。

9. 操作提示与建议

9.1 缩小样本数据规模

由于整个DBLP数据集的记录条数达900万条,所以即便是对数据集进行一次简单的遍历,也要进行900万次的运算,如果同时进行一些复杂的数据选择、匹配等操作的话,进行的运算次数极有可能成为几百万的N次方次运算,这对于普通的计算机来说,是无法承受,且费时费力的;因此,为了达成本次数据分析的目的,在保证数据有效性的前提下,对数据集进行适当的预处理,而减少数据总量,降低运算总时间,是必要且可行的。

这部分工作,已由助教完成,但是大家依旧需要正视这项工作的重要性。

9.2 挖掘方法

(1)对于挖掘合著关系来讲,主要使用到的数据属性是作者、题目,可选的挖掘思路是,在样本数据中,使用数据库语言,将所有作者出现的次数进行统计,并设定一定的阈值,以超过此阈值的为频繁出现的作者。

(2)以上一步挖掘的独立频繁作者为基础,进一步挖掘这些独立频繁的作者中,两个作者同时出现在一篇文章中的次数。

这其中,可能需要几步SQL 语言查询与操作才能实现。

如:需要以文章名称相同为查询条件等。

挖掘出两位作者的频繁项集之后,再以此为基础,挖掘三位合著的频繁项集,以此类推。

9.3 参考步骤(只供参考,期待不同甚至更好的方法)

(1)利用group by author having count(author)>1的方法,去除一篇文章只有一位作者的记录,并且将所查询结果存入表1中。

(2)以表1中的名单为索引,索引样本表,将作者相对应的全部信息输出来,存入到表2中。

(3)将表2中的数据,全部复制到表3中,使用操作语言实现。

(4)通过表2和表3的关联查询,实现作者与作者间的两两关联,将查询结果,存入到表4中,表4中的属性可包括:ID,title,author1(来源于表2),author2(来源于表3),rank1(来源于表2),rank2(来源于表3);查询条件包括:文章题目一样,但是作者不同,并且author1的rank要小于author2的rank。

(5)同样的方法,可以应用到三位作者合著频繁项集的挖掘之中,但是需要做改进以及更多条件的约束。

10. 参考书籍

Jiawei Han, Micheline Kamber, Jian Pei等著,范明,孟小峰译.数据挖掘概念与技术(原书第三版)[M].2012.。