提高mysql插入数据的速度

mysql实训报告总结800字

MySQL实训报告总结为期一个月的MySQL数据库实训结束了,这段时间的学习让我对MySQL有了更深入的了解。

在这次实训中,我不仅掌握了MySQL 的基本操作,还学会了如何进行数据库设计和优化。

现在,我将对这次实训进行总结。

一、实训内容在这次实训中,我们主要学习了MySQL的基本操作,包括创建数据库、表,插入、查询、更新和删除数据等。

此外,我们还学习了如何进行数据库设计和优化,例如使用索引、分区、缓存等技巧来提高数据库性能。

二、遇到的问题和解决方案在实训过程中,我遇到了一些问题,但通过自己的努力和同学的帮助,我成功地解决了它们。

以下是我遇到的一些问题和解决方案:1. 问题:在查询数据时,查询速度很慢。

解决方案:我发现是因为没有对查询字段建立索引导致的。

通过建立索引,我成功地提高了查询速度。

2. 问题:在插入大量数据时,插入速度很慢。

解决方案:我发现是因为没有对插入数据建立适当的索引和优化插入语句导致的。

通过优化插入语句和使用批量插入技巧,我成功地提高了插入速度。

3. 问题:在更新数据时,更新速度很慢。

解决方案:我发现是因为没有对更新字段建立索引导致的。

通过建立索引,我成功地提高了更新速度。

三、经验和教训通过这次实训,我学到了很多关于MySQL的知识和技能。

以下是我的一些经验和教训:1. 索引是提高数据库性能的重要手段,但过多的索引会导致数据插入和更新速度变慢。

因此,需要根据实际需求选择合适的索引策略。

2. 优化查询语句是提高数据库性能的关键,需要认真编写和优化查询语句。

3. 在进行数据库设计时,需要考虑数据的一致性和完整性,避免出现数据冗余和异常。

4. 在进行数据库操作时,需要注意操作的原子性和隔离性,保证数据的正确性和可靠性。

四、总结这次MySQL数据库实训让我收获颇丰。

通过实践操作,我不仅掌握了MySQL的基本操作和数据库设计技巧,还提高了自己的问题解决能力。

在未来的学习和工作中,我将继续深入学习数据库技术,不断提高自己的技能水平。

mysqlisnull函数_MySQL优化准则和技巧

mysqlisnull函数_MySQL优化准则和技巧MySQL是一种常用的关系型数据库管理系统,它广泛应用于各种Web应用程序和大型企业级系统。

为了提高MySQL数据库的性能和效率,我们可以通过一些优化准则和技巧来优化它的性能。

下面是一些MySQL优化准则和技巧,帮助您提高MySQL数据库的性能和效率。

1.使用合适的数据类型:选择合适的数据类型可以减少存储空间的占用和提高查询效率。

例如,对于存储整数的列,可以使用INT而不是VARCHAR,因为INT类型使用的存储空间更小。

2.创建适当的索引:索引可以加快查询的速度,特别是对于大型表来说。

在选择索引时,应该选择那些经常用于过滤和排序的列。

另外,避免创建过多的索引,因为过多的索引会增加写操作的负担。

3.避免使用SELECT*:尽量避免使用SELECT*语句,因为它会返回所有列的数据,包括不需要的列。

这会增加网络传输的开销和查询的执行时间。

最好只选择需要的列。

4.使用LIMIT分页:对于需要分页的查询,使用LIMIT语句可以提高查询的效率。

LIMIT语句可以限制查询结果的返回行数,减少数据库返回的数据量。

5.使用连接池:连接池可以提高数据库的连接效率。

连接池会维护一组已经建立的数据库连接,这样可以避免每次请求都重新建立连接的开销。

6.避免使用子查询:子查询可能会导致性能问题,特别是在处理大量数据时。

如果可能的话,尽量使用JOIN操作来代替子查询。

7.使用批量插入:当需要插入大量数据时,使用批量插入可以提高插入的效率。

批量插入可以减少与数据库的交互次数,从而提高插入的速度。

8.避免使用SELECTDISTINCT:SELECTDISTINCT语句可以去除查询结果中的重复行,但它会增加查询的开销。

如果不是必要的话,尽量避免使用SELECTDISTINCT。

9.避免在查询中使用函数:在查询中使用函数可以增加查询的开销。

如果可能的话,尽量避免在查询中使用函数。

数据库中大数据导入与导出的性能优化技巧

数据库中大数据导入与导出的性能优化技巧随着数据的快速增长和业务的发展,大数据的处理和分析已经变得越来越重要。

在数据库中,大数据的导入和导出操作是常见的任务。

然而,由于大数据量的特点,这些操作可能会变得非常耗时和低效。

因此,为了提高数据导入和导出的性能,我们需要一些优化技巧。

1. 使用合适的导入工具在数据库中,有许多工具和方法可以用于数据的导入和导出操作。

选择一个合适的工具是提高性能的第一步。

一些流行的导入工具包括MySQL的LOAD DATA INFILE语句、PostgreSQL的COPY命令以及Oracle的SQL*Loader工具等。

根据具体情况选择最合适的工具可以显著提高导入和导出的性能。

此外,使用并行导入工具也是一个提高性能的好方法。

并行导入工具可以同时使用多个线程或进程,从而加快导入和导出的速度。

可以使用类似于Oracle的并行导入工具如Data Pump或SQL Server的并行数据仓库负载运行器等工具,根据具体数据库产品选择合适的工具。

2. 批量插入和更新在大数据导入中,我们可以使用批量插入和更新操作来优化性能。

相比逐条插入或更新的方式,批量操作可以减少与数据库的交互次数,从而减少了网络开销和数据库锁定时间。

例如,在MySQL中,可以使用INSERT INTO ... VALUES、INSERTINTO ... SELECT或LOAD DATA INFILE等语句来实现批量插入;而在Oracle中,可以使用SQL*Loader或外部表等技术实现批量插入。

在批量插入和更新时,还可以考虑使用过程性操作。

这样可以把多个操作封装在一个事务中,提高整体的性能和数据的一致性。

例如,在PostgreSQL中,可以使用存储过程或触发器将多个操作包装在一个过程中,从而减少了事务的开销。

诸如此类,根据具体数据库产品的特性,选择合适的方法来进行批量操作。

3. 数据预处理和优化在进行大数据导入和导出操作之前,预处理和优化数据也是提高性能的关键步骤之一。

Mysql数据库写入数据速度优化

Mysql数据库写⼊数据速度优化

Mysql数据库写⼊数据速度优化

1)innodb_flush_log_at_trx_commit 默认值为1;设置为0,可以提⾼写⼊速度。

值为0:提升写⼊速度,但是安全⽅⾯较差,mysql服务器宕机可能会造成数据丢失。

值为1:每⼀次事务提交或者事务外的指令都需要把⽇志写⼊硬盘,此过程消耗时间较长;

值为2:是每次操作不写⼊硬盘,⽽是写⼊系统缓存,⽇志仍然会每秒刷新硬盘;

2)innodb_autoextend_increment默认值为8M,调整为128M ;

此配置项作⽤主要是当tablespace 空间已经满了后,需要MySQL系统需要⾃动扩展多少空间,每次tablespace 扩展都会让各个SQL 处于等待状态。

增加⾃动扩展Size可以减少tablespace⾃动扩展次数。

3)innodb_log_buffer_size默认值为1M,调整为16M ;

此配置项作⽤设定innodb 数据库引擎写⽇志缓存区;将此缓存段增⼤可以减少数据库写数据⽂件次数。

4)innodb_log_file_size默认值为 8M,调整为128M ;

此配置项作⽤设定innodb 数据库引擎UNDO⽇志的⼤⼩;从⽽减少数据库checkpoint操作。

5)bulk_insert_buffer_size默认值为8M,调整为100M;

作⽤于使⽤ MyISAM存储引擎,⽤来缓存批量插⼊数据的时候临时缓存写⼊数据。

innodb_flush_log_at_trx_commit、innodb_log_buffer_size和 innodb_log_file_size 需要谨慎调整;因为涉及MySQL本⾝的容灾处理。

mysql优化的几种方法

mysql优化的几种方法

1. 合理设计数据库结构:合理划分表和建立索引,将重要的字段和常用的查询条件作为索引,减少数据库查询的时间消耗。

2. 减少数据表的联接:尽量避免多表联接操作,可以通过使用冗余字段或者嵌套查询的方式来减少联接操作。

3. 使用合适的数据类型:选择合适的数据类型可以减少数据库存储空间,提高查询和更新的性能。

例如,使用整型代替字符串类型存储数字数据。

4. 避免全表扫描:尽量使用索引来查询数据,避免全表扫描的性能瓶颈。

如果有大量的数据需要查询,可以考虑分批次查询或者使用分页查询的方式。

5. 批量插入和更新:使用批量插入和更新的方式可以减少数据库的IO操作,提高数据写入的效率。

可以使用INSERT

INTO ... VALUES (...),或者使用LOAD DATA INFILE进行批量导入数据。

6. 优化查询语句:使用EXPLAIN语句分析查询语句的执行计划,找到慢查询的原因,然后通过修改查询语句或者调整索引来优化查询性能。

7. 使用缓存技术:可以使用缓存系统(如Redis、Memcached)来缓存查询结果,减少数据库的访问次数,提高系统的响应速度。

8. 避免使用SELECT *:尽量避免使用SELECT *查询所有字段,只选择需要的字段,避免传输和处理不必要的数据。

9. 分库分表:当数据量过大时,可以使用分库分表的方式来拆分数据,减少单个数据库的负载,提高数据库的扩展能力和性能。

10. 定期优化和维护:定期进行数据库优化和维护,包括备份

数据、清理无用数据、重新组织表等,保持数据库的健康状态,提高系统的稳定性和性能。

数据库快速参入百万数据的方法

数据库快速参入百万数据的方法如果您需要在数据库中快速插入大量数据,这通常涉及到的关键点是如何高效地将数据传输到数据库。

以下是一些方法可以帮助您在数据库中快速插入百万级别的数据:1. 批量插入:•批量插入大量数据时,每次插入的数据量越多,性能通常越好。

大多数数据库系统支持批量插入,而不是单条插入。

例如,在MySQL中,您可以使用的形式一次性插入多行数据。

禁用索引和约束:•在插入大量数据时,暂时禁用索引和约束可以提高性能。

完成插入后,您可以重建索引并应用约束。

在MySQL中,您可以使用来禁用索引,使用来禁用外键约束。

调整数据库配置:•根据您的数据库,调整相关的配置参数以获得更好的性能。

例如,调整缓存大小、I/O参数、连接池等。

分批插入:•如果数据量非常大,您可以考虑将数据分成较小的批次进行插入。

这样可以在不耗尽系统资源的情况下完成操作。

使用适当的文件格式:•如果您从文件中导入数据,使用CSV或JSON等格式可能比纯文本更有效,特别是当数据库支持这些格式的导入工具时。

并行处理:•如果您的系统支持并行处理,考虑同时从多个源或多个进程插入数据。

使用专业的ETL工具:•一些ETL(提取、转换、加载)工具专为快速加载大量数据而设计。

这些工具通常具有优化过的数据库接口和批量处理功能。

压缩数据:•在传输和存储之前压缩数据可以显著减少所需的时间和带宽。

考虑硬件和网络优化:* 确保您的服务器硬件足够强大,并且网络连接具有足够的带宽和稳定性。

对于远程数据库,考虑增加带宽或使用更稳定的数据传输协议。

2. 备份:* 在进行大量数据插入操作之前,请确保您有最近的备份。

这是一个好的做法,因为即使是最先进的系统也可能出现错误。

3. 使用专业服务:* 如果您处理的数据库非常大或非常复杂,您可能需要寻求专业的帮助或服务。

许多数据库提供商和服务商都提供这种服务。

4. 考虑数据库分片:•如果数据量非常大,可能需要考虑数据库分片。

分片是将数据分布在多个服务器上的方法,每个服务器都有其自己的数据库副本。

数据库优化:让数据访问更快速

数据库优化:让数据访问更快速数据库优化是指通过不同的方法和技术来提高数据库的性能和效率,使得数据的访问更加快速和高效。

随着数据量的增加和业务需求的变化,数据库优化已经成为了每个数据库管理员和开发人员需要关注的重要方面。

本文将深入探讨数据库优化的重要性、常见的优化方法以及一些实际的技巧和建议。

一、数据库优化的重要性1.1提高数据访问速度数据库优化的最主要的目的就是提高数据的访问速度。

一般来说,数据库中存储的数据量越大,访问数据所需的时间就会越长。

因此,通过优化数据库的结构和查询方式,可以有效地减少数据访问的时间,提高数据的读取和写入速度。

1.2提高系统的稳定性和可靠性数据库优化不仅可以提高数据的访问速度,还可以提高系统的稳定性和可靠性。

通过减少数据库的负载,优化数据库的性能和效率,可以减少系统出现故障的可能性,提高系统的稳定性和可靠性。

1.3降低系统的成本当一个系统的性能良好且稳定可靠的时候,就会降低系统运行的成本。

因为系统不会频繁出现问题,也不需要花费大量的人力物力来维护和修复。

因此,数据库优化可以降低系统的运行成本,提高系统的利润和竞争力。

1.4改善用户体验当用户访问一个网站或者使用一个应用程序的时候,他们最关心的就是数据访问的速度和效率。

如果数据库中的数据可以快速地被检索和展示给用户,那么就可以提高用户的体验,提升用户的满意度,从而增加用户的忠诚度和留存率。

二、数据库优化的常见方法2.1优化数据库的结构数据库的结构对于数据库的性能和效率具有重要的影响。

因此,通过优化数据库的结构和设计,可以进一步提高数据库的性能和效率。

2.1.1使用合适的数据类型在设计数据库表的时候,应该选择合适的数据类型来存储数据。

不同的数据类型有不同的存储空间和存储方式,选择合适的数据类型可以减少数据的存储空间,减少数据的读取时间,提高系统的性能。

2.1.2设计合理的索引索引是用来加快数据库查询速度的重要手段。

通过为数据库表中的列创建索引,可以减少数据的检索时间,提高查询效率。

MySQL批量插入和导出数据的高效方法

MySQL批量插入和导出数据的高效方法MySQL是目前最常用的开源关系型数据库管理系统之一,广泛应用于互联网、电子商务、金融等领域。

在实际开发中,经常需要进行大量数据的批量插入和导出,因此熟悉高效的批量插入和导出方法对于提升数据库操作的效率至关重要。

一、批量插入数据1. 使用INSERT INTO语句批量插入在MySQL中,最常见的插入数据的方式就是使用INSERT INTO语句。

要想实现批量插入,可以通过将多个待插入的数据值以逗号隔开,放在INSERT INTO语句的VALUES子句中。

例如,假设有一个名为users的表,有id、name和age三个字段,现在要批量插入1000条数据,可以使用以下语句:```sqlINSERT INTO users (name, age) VALUES('张三', 20),('李四', 25),...('王五', 30);```可以在一个INSERT INTO语句中一次性插入多条数据,避免了每次插入一条数据的开销,从而提高插入数据的效率。

2. 使用LOAD DATA INFILE语句批量插入除了使用INSERT INTO语句批量插入数据,还可以使用LOAD DATA INFILE语句。

这个语句可以一次性从一个文件中读取多行数据,并将其插入到MySQL表中。

首先,将待插入数据存储在一个纯文本文件中,每行数据的字段值以制表符或逗号等分隔符相隔。

然后,使用LOAD DATA INFILE语句将数据加载到表中。

例如,假设有一个名为data.txt的文件,其中的数据内容如下:```张三 20李四 25...王五 30```可以使用以下语句将数据导入到users表中:```sqlLOAD DATA INFILE '/path/to/data.txt' INTO TABLE users;```这种方式适用于需要导入大量数据的情况,相比使用INSERT INTO语句,可以显著提升插入数据的效率。

使用MySQL进行数据快速导入与导出的技巧

使用MySQL进行数据快速导入与导出的技巧一、背景介绍在现代信息时代,数据的快速处理和高效管理变得愈发重要。

作为最流行的开源关系型数据库管理系统之一,MySQL在各行各业的数据库管理中扮演着重要的角色。

本文将分享一些使用MySQL进行数据快速导入与导出的技巧,帮助读者更好地利用MySQL进行数据处理和管理。

二、数据导入技巧1. 使用LOAD DATA INFILE命令MySQL提供了LOAD DATA INFILE命令,可以快速将数据从外部文件导入到数据库中。

通过指定文件路径和格式,可以轻松导入大数据集。

使用该命令时,可以结合各种选项和控制字符,进行数据格式化和处理。

例如,可以指定字段分隔符、行分隔符、字符转义符等。

2. 使用多线程并行导入如果要导入大量数据,单线程的导入速度可能太低。

MySQL支持使用多线程并行导入数据,可以大大提高导入效率。

通过设置max_allowed_packet参数和concurrent_insert参数,可以同时使用多个线程进行数据导入。

同时,还可以使用LOAD DATA CONCURRENT LOCAL INFILE命令来实现并行导入。

3. 事务处理在数据导入过程中,为了保证数据的完整性和一致性,可以使用事务处理机制。

通过使用BEGIN和COMMIT语句,可以将一系列导入操作包裹在一个事务中,确保在出现错误或中断情况下能够回滚操作。

这样可以避免数据不一致和损坏。

三、数据导出技巧1. 使用SELECT INTO OUTFILE命令MySQL提供了SELECT INTO OUTFILE命令,可以将查询结果导出到外部文件中。

通过指定输出文件路径和格式,可以方便地将数据导出到CSV、TXT等格式。

同时,还可以使用多种选项和控制字符进行数据格式化。

2. 使用mysqldump命令mysqldump是MySQL提供的一个实用工具,可以高效地将整个数据库或特定表导出为SQL脚本。

如何在MySQL中优化大数据量插入操作

如何在MySQL中优化大数据量插入操作在现代信息时代,数据的重要性愈发凸显,尤其在数据库领域。

MySQL作为一种广泛使用的关系型数据库管理系统,具备了许多高效的数据插入操作优化技巧,本文将围绕如何在MySQL中优化大数据量插入操作展开论述。

一、选择合适的存储引擎MySQL提供了多种存储引擎,如InnoDB、MyISAM等。

对于大数据量插入操作,InnoDB是较为适合的选择。

InnoDB采用了行级锁,插入操作并发性较好,在处理大量并发插入时表现更佳。

而MyISAM则适合对静态数据的查询操作。

二、使用批量插入语句在进行大数据量插入操作时,使用批量插入语句能够显著提升性能。

MySQL提供了多种方式实现批量插入,如使用INSERT INTO ... VALUES (value1),(value2), ...,也可以使用LOAD DATA INFILE语句将数据文件直接导入数据库。

这样可以减少网络传输的开销,提高插入速度。

三、禁用索引在进行大数据量插入操作时,禁用索引可以大幅提高插入速度。

因为随着数据的增多,每次插入都会触发索引的更新操作,导致性能下降。

因此,在大规模插入数据之前,可以禁用相关索引,待插入操作完成后再重新建立索引。

注意,禁用索引可能会影响查询性能,因此需要在权衡之后进行操作。

四、分区表对于大数据量插入操作,使用分区表能够更好地管理和查询数据。

根据分区键进行数据分片存储,可以提高插入效率和查询性能。

例如按照时间进行分区,则可以方便地对某个时间段内的数据进行插入和查询操作。

此外,还可以通过分区表进行数据分离,将热点数据和冷数据分别存放在不同的分区表中,进一步优化性能。

五、调整MySQL参数通过调整MySQL的参数设置,可以优化大数据量插入操作的性能。

主要包括以下几个方面:1. 调整innodb_buffer_pool_size参数,将其设置为适当的值,以提高InnoDB的缓存击中率。

2. 增加innodb_log_file_size参数的大小,可以减小日志文件刷写的频率,提升插入性能。

如何优化MySQL的数据读取和写入性能

如何优化MySQL的数据读取和写入性能随着互联网的蓬勃发展,大数据时代已经来临。

数据库作为信息存储与检索的重要工具,在互联网应用中起着举足轻重的作用。

然而,随着数据量的增长,数据库的读取和写入性能成为了亟待解决的问题。

MySQL作为开源的关系型数据库管理系统,被广泛应用于各行各业。

如何优化MySQL的数据读取和写入性能,是我们需要解决的关键问题。

本文将结合实际案例,从不同角度探讨如何优化MySQL的数据读取和写入性能。

一、设计合理的数据库结构数据库结构是数据库性能的基础,良好的数据库设计能够提高查询效率和写入性能。

在设计数据库结构时,应该遵循以下原则:1.合理划分数据表: 将数据分散到不同的表中,以避免数据冗余和查询效率低下的问题。

经常一起查询的字段放在同一表中,避免频繁的表联接操作。

2.选择合适的字段类型: 设置适当的字段类型能够减少空间占用和提高查询效率。

例如,使用INT代替VARCHAR来存储数字类型的数据,使用ENUM代替VARCHAR来存储固定范围的取值。

3.建立合适的索引: 索引能够加快数据的检索速度,但过多的索引会增加写入数据的时间。

需要根据查询需求和数据量选择合适的索引类型和索引字段。

二、优化查询语句优化查询语句是提高MySQL读取性能的重要手段。

以下是一些优化查询语句的常用方法:1.避免使用SELECT *: SELECT * 会查询表中的所有字段,增加了数据传输和解析的开销。

应该明确指定需要的字段,避免不必要的查询。

2.使用JOIN操作: JOIN操作能够将多张表连接在一起,减少查询次数。

在使用JOIN操作时,应该根据实际情况选择合适的连接方式,避免使用过多的连接。

3.使用子查询: 子查询是一种嵌套查询的形式,能够简化查询逻辑和减少数据传输量。

使用子查询时,应该注意子查询的效率,避免过度嵌套和重复查询。

4.合理使用索引: 索引能够加快查询速度,但过多的索引会降低写入性能。

在使用索引时,需要根据具体情况选择合适的索引和索引字段。

MySQL中的数据导入导出速度优化方法

MySQL中的数据导入导出速度优化方法MySQL是一种广泛使用的开源关系型数据库管理系统,它提供了强大的数据存储和检索功能。

无论是在企业应用还是个人项目中,数据导入和导出都是开发人员经常需要处理的任务。

然而,对于数据库中大量数据的导入和导出操作,往往会遇到一些性能上的瓶颈,因此优化这些操作是非常有必要的。

一、数据导入优化1.使用LOAD DATA导入数据MySQL提供了LOAD DATA语句来导入数据,该语句比较高效,可以大大加快数据导入的速度。

使用LOAD DATA时,需要确保数据文件的格式与目标表的结构相匹配,这样可以避免在导入过程中的格式转换带来的性能损耗。

2.禁用索引在进行大量的数据导入操作时,可以考虑禁用索引。

索引的维护操作会降低数据导入的速度,因此禁用索引可以加快数据导入的过程。

导入完成之后,再重新启用索引。

3.批量提交MySQL默认是以事务的方式进行数据导入的,每次插入一条数据都会触发一次事务提交,这对于大批量数据的导入来说会造成很大的性能损耗。

可以通过批量提交的方式,一次性提交多条数据,从而减少事务提交的次数,提高导入速度。

4.使用多线程在导入大量数据时,可以考虑使用多线程的方式进行数据导入。

可以将待导入的数据分成多个文件,然后分别使用不同的线程来并发导入数据。

这样可以充分利用系统的多核资源,提高导入速度。

二、数据导出优化1.使用SELECT INTO OUTFILE导出数据MySQL提供了SELECT INTO OUTFILE语句来导出数据,该语句比较高效,可以大大加快数据导出的速度。

使用SELECT INTO OUTFILE时,可以使用不同的选项来控制导出的数据格式和文件存储位置。

2.使用压缩格式在导出大量数据时,可以考虑使用压缩格式,如gzip或者bzip2等。

压缩文件可以减小文件的体积,从而减少网络传输的时间和带宽的消耗。

3.使用LIMIT分批导出对于大量数据的导出操作,可以考虑使用LIMIT分批导出的方式。

如何优化MySQL中的数据导入和导出速度

如何优化MySQL中的数据导入和导出速度在数据库管理系统中,MySQL是最常用的一种开源关系型数据库管理系统。

由于其易于使用、性能优越等特点,使其成为众多企业和个人的首选数据库。

然而,在实际应用过程中,我们经常需要进行数据的导入和导出操作。

而随着数据量的增大和复杂性的提升,如何优化MySQL中的数据导入和导出速度成为一个亟需解决的问题。

本文将从多个方面介绍如何进行优化。

一、选择合适的导入导出工具在MySQL中,常见的导入导出工具有mysqldump、mysqlimport、LOADDATA等。

选择合适的工具对于提高导入导出速度至关重要。

以下是对几种常见工具的简要介绍:1. mysqldump:这是一种用于将整个MySQL数据库或其中一个或多个表导出为SQL脚本的工具。

它可以生成一个包含CREATE TABLE、INSERT、UPDATE和DELETE语句的文件。

但是,由于其生成的SQL脚本较大,导入时会增加大量的IO开销和锁定时间,因此不适合处理海量数据。

2. mysqlimport:这是一个用于导入数据的命令行工具。

它将数据从文件加载到MySQL表中。

相比mysqldump,mysqlimport更加高效,适用于处理大量数据。

3. LOAD DATA:这是MySQL提供的一种高效的数据导入方法。

它可以直接从文件中将数据加载到MySQL表中,绕过了SQL的解析和优化过程,具有较高的导入速度。

但是,LOAD DATA的缺点是不能导入非文本格式的数据,以及不能导入带有特定格式的数据。

在选择工具时,需要根据实际需求和数据量大小来进行评估和选择。

对于小规模的数据导入导出,mysqldump是一个不错的选择;对于大规模的数据导入导出,可以考虑使用mysqlimport或LOAD DATA来提高效率。

二、调整MySQL配置参数MySQL的配置参数对于数据导入导出的速度也有很大的影响。

以下是几个常见的配置参数。

如何在MySQL中进行数据导入和导出的速度优化

如何在MySQL中进行数据导入和导出的速度优化在MySQL中进行数据导入和导出是非常常见的操作,无论是备份数据、迁移数据还是与其他系统交互,都需要进行导入和导出。

然而,由于数据量庞大、服务器性能、网络带宽等因素的限制,导入和导出数据的速度可能会受到一定的影响。

本文将重点介绍如何在MySQL中进行数据导入和导出的速度优化。

一、选择合适的导入与导出工具在MySQL中进行数据导入和导出,可以使用多种工具和方法,如mysqldump、LOAD DATA INFILE、MySQL Workbench等。

对于较小规模的数据导入和导出操作,mysqldump是一个简单且方便的选择。

但是,对于大规模数据的导入和导出操作,mysqldump的速度可能会比较慢。

相比之下,LOAD DATA INFILE命令更适合处理大规模的数据导入和导出。

因此,根据具体需求选择合适的工具和方法是优化数据导入和导出速度的第一步。

二、适当调整MySQL服务器配置MySQL服务器的配置也会影响数据导入和导出的速度。

在进行大规模数据导入和导出操作之前,有一些配置参数可以进行调整,以优化服务器的性能。

1. max_allowed_packetmax_allowed_packet参数控制了一次性发送到服务器的最大数据包大小。

默认值为4MB,如果导入的数据包大于该值,会被分割成更小的包进行处理,从而影响导入速度。

如果遇到导入过程中速度过慢的情况,可以适当增加这个参数的值,例如设置为16MB或更大。

2. innodb_buffer_pool_sizeinnodb_buffer_pool_size参数指定了InnoDB存储引擎缓冲池的大小。

较大的缓冲池可以提高读取和写入数据的性能,从而加快导入和导出的速度。

根据服务器可用内存的大小,可以将该参数设置为合适的值,例如设置为物理内存大小的70%。

3. innodb_flush_log_at_trx_commitinnodb_flush_log_at_trx_commit参数控制了每次事务提交时,日志缓冲区的刷新策略。

MySQL批量插入数据的效率优化技巧

MySQL批量插入数据的效率优化技巧随着数据量的不断增长和业务的发展,数据库批量插入数据的效率就显得尤为重要。

MySQL作为广泛使用的开源关系型数据库,在处理大量数据插入时,也面临着一些性能瓶颈。

本文将介绍一些MySQL批量插入数据的效率优化技巧,帮助开发者提高数据插入的速度和效率。

1. 批量插入语句首先,了解并正确使用MySQL提供的批量插入语句是提高效率的基础。

常见的批量插入语句有INSERT INTO ... VALUES 和 INSERT INTO ... SELECT,它们可以在一次性插入多行数据。

相比逐条插入,批量插入语句显著提高了插入数据的速度。

2. 调整插入语句的大小单条INSERT语句的大小对插入性能也有一定影响。

较大的语句需要更多的网络传输和SQL解析时间。

可以通过调整INSERT语句的大小,减少传输和解析的开销,从而提高批量插入的效率。

可以尝试将单条插入语句的大小控制在一定的范围内,避免过大或过小。

3. 禁用或延迟索引在大批量插入数据时,索引的维护操作会导致插入性能下降。

可以在插入前禁用索引,插入完成后再重新启用索引,从而减少索引维护的开销。

也可以选择延迟索引的建立,在插入完成后再进行索引的创建,以提高插入数据的速度。

4. 使用LOAD DATA INFILEMySQL提供了LOAD DATA INFILE语句用于将数据从文件导入到表中。

相比使用INSERT语句,LOAD DATA INFILE在插入大量数据时更高效。

可以将数据以CSV格式存储,并通过LOAD DATA INFILE导入,将大幅提高插入的速度。

同时,可以通过调整LOAD DATA INFILE的参数来优化插入的性能。

5. 调整事务大小在批量插入数据时,数据库默认会使用事务机制保证数据的一致性。

但是大事务会导致锁等待时间增加,降低插入性能。

可以通过调整事务的大小,在插入过程中提交多个小事务,减少锁等待时间,提高数据插入的效率。

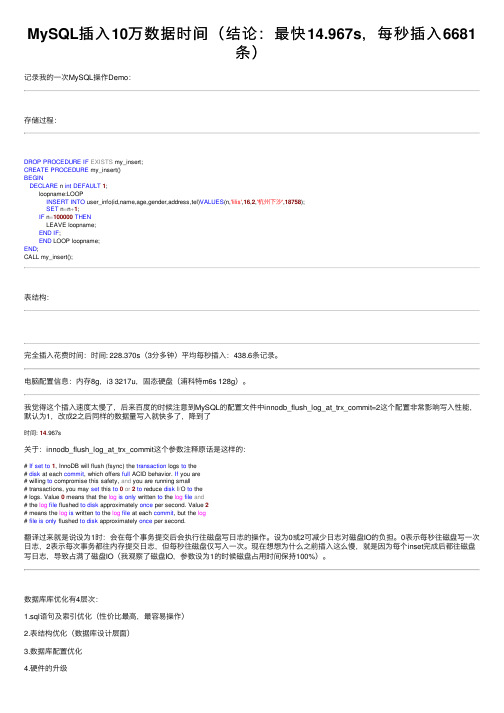

MySQL插入10万数据时间(结论:最快14.967s,每秒插入6681条)

MySQL插⼊10万数据时间(结论:最快14.967s,每秒插⼊6681条)记录我的⼀次MySQL操作Demo:存储过程:DROP PROCEDURE IF EXISTS my_insert;CREATE PROCEDURE my_insert()BEGINDECLARE n int DEFAULT1;loopname:LOOPINSERT INTO user_info(id,name,age,gender,address,tel)VALUES(n,'lilis',16,2,'杭州下沙',18758);SET n=n+1;IF n=100000THENLEAVE loopname;END IF;END LOOP loopname;END;CALL my_insert();表结构:完全插⼊花费时间:时间: 228.370s(3分多钟)平均每秒插⼊:438.6条记录。

电脑配置信息:内存8g,i3 3217u,固态硬盘(浦科特m6s 128g)。

我觉得这个插⼊速度太慢了,后来百度的时候注意到MySQL的配置⽂件中innodb_flush_log_at_trx_commit=2这个配置⾮常影响写⼊性能,默认为1,改成2之后同样的数据量写⼊就快多了,降到了时间: 14.967s关于:innodb_flush_log_at_trx_commit这个参数注释原话是这样的:# If set to1, InnoDB will flush (fsync) the transaction logs to the# disk at each commit, which offers full ACID behavior. If you are# willing to compromise this safety, and you are running small# transactions, you may set this to0or2to reduce disk I/O to the# logs. Value 0 means that the log is only written to the log file and# the log file flushed to disk approximately once per second. Value 2# means the log is written to the log file at each commit, but the log# file is only flushed to disk approximately once per second.翻译过来就是说设为1时:会在每个事务提交后会执⾏往磁盘写⽇志的操作。

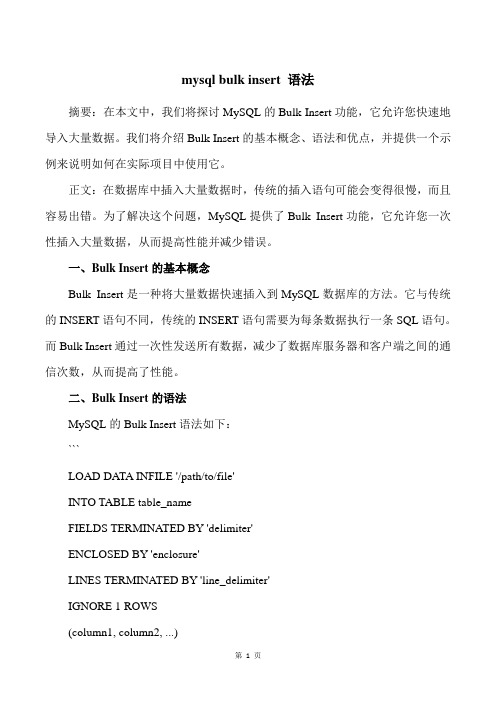

mysql bulk insert 语法

mysql bulk insert 语法摘要:在本文中,我们将探讨MySQL的Bulk Insert功能,它允许您快速地导入大量数据。

我们将介绍Bulk Insert的基本概念、语法和优点,并提供一个示例来说明如何在实际项目中使用它。

正文:在数据库中插入大量数据时,传统的插入语句可能会变得很慢,而且容易出错。

为了解决这个问题,MySQL提供了Bulk Insert功能,它允许您一次性插入大量数据,从而提高性能并减少错误。

一、Bulk Insert的基本概念Bulk Insert是一种将大量数据快速插入到MySQL数据库的方法。

它与传统的INSERT语句不同,传统的INSERT语句需要为每条数据执行一条SQL语句。

而Bulk Insert通过一次性发送所有数据,减少了数据库服务器和客户端之间的通信次数,从而提高了性能。

二、Bulk Insert的语法MySQL的Bulk Insert语法如下:```LOAD DATA INFILE '/path/to/file'INTO TABLE table_nameFIELDS TERMINATED BY 'delimiter'ENCLOSED BY 'enclosure'LINES TERMINATED BY 'line_delimiter'IGNORE 1 ROWS(column1, column2, ...)```参数说明:- '/path/to/file':指定要导入的数据文件的路径。

- table_name:指定要插入数据的表名。

- delimiter:指定字段之间的分隔符,如逗号、制表符等。

- enclosure:指定字段内部的括符,如单引号、双引号等。

- line_delimiter:指定行结束符,如换行符、回车符等。

- IGNORE 1 ROWS:指定在导入数据时忽略前1行。

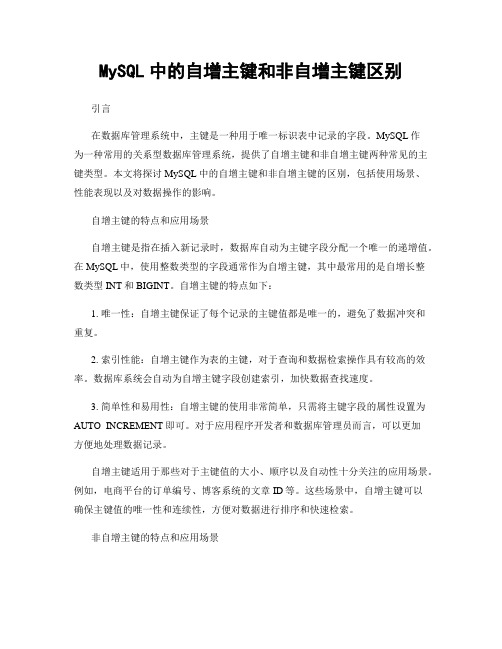

MySQL中的自增主键和非自增主键区别

MySQL中的自增主键和非自增主键区别引言在数据库管理系统中,主键是一种用于唯一标识表中记录的字段。

MySQL作为一种常用的关系型数据库管理系统,提供了自增主键和非自增主键两种常见的主键类型。

本文将探讨MySQL中的自增主键和非自增主键的区别,包括使用场景、性能表现以及对数据操作的影响。

自增主键的特点和应用场景自增主键是指在插入新记录时,数据库自动为主键字段分配一个唯一的递增值。

在MySQL中,使用整数类型的字段通常作为自增主键,其中最常用的是自增长整数类型INT和BIGINT。

自增主键的特点如下:1. 唯一性:自增主键保证了每个记录的主键值都是唯一的,避免了数据冲突和重复。

2. 索引性能:自增主键作为表的主键,对于查询和数据检索操作具有较高的效率。

数据库系统会自动为自增主键字段创建索引,加快数据查找速度。

3. 简单性和易用性:自增主键的使用非常简单,只需将主键字段的属性设置为AUTO_INCREMENT即可。

对于应用程序开发者和数据库管理员而言,可以更加方便地处理数据记录。

自增主键适用于那些对于主键值的大小、顺序以及自动性十分关注的应用场景。

例如,电商平台的订单编号、博客系统的文章ID等。

这些场景中,自增主键可以确保主键值的唯一性和连续性,方便对数据进行排序和快速检索。

非自增主键的特点和应用场景非自增主键是指在插入新记录时,由应用程序或数据库管理员手动提供主键值。

与自增主键相比,非自增主键的特点如下:1. 灵活性:非自增主键可以使用不同的数据类型,如整数、字符串等,在满足唯一性的前提下,可以根据实际需求自由选择主键值。

2. 控制性:由于非自增主键的主键值由用户或管理员指定,可以更加精确地控制主键值的范围和取值规则。

3. 外键关联:非自增主键可以方便地与其他表进行关联,建立外键关系。

这在数据库设计中是非常常见的需求,能够提高数据库的数据完整性和一致性。

非自增主键适用于那些对于主键值的特定要求和处理逻辑的应用场景。

mysql导入太慢解决方法

mysql导⼊太慢解决⽅法半调⼦数据科学家⼜要折腾数据,拿到数据⼀看,3.6G的zip⽂件,解压看看,卧槽12个G的sql⽂件。

好吧,⼜要折腾sql数据了。

第⼀件事,肯定是搭⼀个数据库,导⼊数据咯。

折腾过sql导⼊的亲们都知道,mysql默认的参数,导⼊的速度还是很慢的,特别是数据忒多的情况。

这次的数据,折腾完了之后,有1000W条那么多,不⽤猜也知道,慢的要死,所以需要对数据库做⼀些设置。

可以设置的地⽅有两个,第⼀个是innodb_flush_log_at_trx_commit。

官⽅⼿册对各个值解释如下:Controls the balance between strict ACID compliance for commit operations and higher performance that is possible when commit-related I/O operations are rearranged and done in batches. You can achieve better performance by changing the d The default value of 1 is required for full ACID compliance. With this value, the contents of the InnoDB log buffer are written out to the log file at each transaction commit and the log file is flushed to disk.With a value of 0, the contents of the InnoDB log buffer are written to the log file approximately once per second and the log file is flushed to disk. No writes from the log buffer to the log file are performed at transaction commit. Once-per-second With a value of 2, the contents of the InnoDB log buffer are written to the log file after each transaction commit and the log file is flushed to disk approximately once per second. Once-per-second flushing is not 100% guaranteed to happen every InnoDB log flushing frequency is controlled by innodb_flush_log_at_timeout, which allows you to set log flushing frequency to N seconds (where N is 1 ... 2700, with a default value of 1). However, any mysqld process crash can erase up to N sec DDL changes and other internal InnoDB activities flush the InnoDB log independent of the innodb_flush_log_at_trx_commit setting.InnoDB crash recovery works regardless of the innodb_flush_log_at_trx_commit setting. Transactions are either applied entirely or erased entirely.For durability and consistency in a replication setup that uses InnoDB with transactions:If binary logging is enabled, set sync_binlog=1.Always set innodb_flush_log_at_trx_commit=1.CautionMany operating systems and some disk hardware fool the flush-to-disk operation. They may tell mysqld that the flush has taken place, even though it has not. In this case, the durability of transactions is not guaranteed even with the setting 1, a 也就是1 默认值,最慢,每次事务提交都要写⼊log并刷新到磁盘上,这是最保险的⽅式0 最快,每隔1S将log刷新到磁盘,但是不保证。

MySQL中的批量插入和批量更新技巧

MySQL中的批量插入和批量更新技巧MySQL是目前广泛应用于Web开发和数据管理的关系型数据库管理系统。

在日常的数据库操作中,我们经常会遇到需要批量插入和批量更新大量数据的情况。

本文将探讨MySQL中的批量插入和批量更新技巧,并介绍一些优化方法,以提高数据库的性能和效率。

一、批量插入数据当需要向数据库中插入大量数据时,使用单条SQL语句逐条插入会导致性能下降,耗费大量的时间和资源。

而批量插入则可以大幅提升插入数据的效率。

下面我们将介绍几种常用的批量插入数据的方法。

1. 使用多个VALUES子句在MySQL中,可以使用INSERT INTO语句的多个VALUES子句一次性插入多条数据。

例如:```INSERT INTO table_name (column1, column2, column3) VALUES(value1, value2, value3),(value4, value5, value6),(value7, value8, value9);```这种方式可以一次性插入多条数据,减少了与数据库的通信次数,提高了插入数据的效率。

2. 使用INSERT INTO ... SELECT语句另一种常用的批量插入数据的方法是使用INSERT INTO ... SELECT语句。

该语句可以从另一个表中选择数据插入到目标表中。

例如:```INSERT INTO table_name (column1, column2, column3)SELECT column1, column2, column3FROM another_table;```使用该方法,可以将另一个表中的数据一次性插入到目标表中,提高插入数据的效率。

3. 使用LOAD DATA INFILE语句如果你有一个包含大量数据的文件,可以使用LOAD DATA INFILE语句将文件中的数据一次性导入到数据库中。

例如:```LOAD DATA INFILE 'data.txt' INTO TABLE table_name;```使用该方法,可以避免多次插入数据的开销,快速地将大量数据导入到数据库中。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

【转】提高mysql插入数据的速度。

2011-03-23 17:29转载自 jackbillow最终编辑dhbvsdhq在myisam engine下

1. 尽量使用insert into table_name values (...), (.....),(.....)这样形式插入数据,避免使用inset into table_name values (); inset into table_name values (); inset into table_name values ();

2 增加bulk_insert_buffer_size(默认8M)

3 如果是非空表,使用alter table table_name disable keys,然后load data infile,导入完数据在执行:

alter table table_name enable keys. 如果是空表,就不需要这个操作,因为myisam表在空表中导入数据时,是先导入数据然后建立indexs。

4 在插入数据时考虑使用:insert delayed....这样操作实际mysql把insert操作放到队列里面,进行相对集中的插入,速度更快。

5. 使用load data infile 比使用insert 操作快近20倍,尽量使用此操作。

在innodb engine下

1.导入数据之前执行set unique_checks=0来禁止对唯一索引的检查,数据导入完成之后再运行set unique_checks=1.

2. 导入数据之前执行set foreign_key_checks=0来禁止对外键的检查,数据导入完成之后再执行set foreign_key_checks=1.

3.导入数据之前执行set autocommit=0禁止自动事务的自动提交,数据导入完成之后,执行set autocommit=1 恢复自动提交操作。

使用innodb engine的表,物理存储都是按PK的顺序存的。

不能使用类似于myisam一样disable keys.

硬件上提高磁盘的I/0对插入速度很有好处(所以如果进行大数据量的导入导出工作,尽量在比较NB的硬件上进行,能缩减完成的时间,已经防止出现问题)。

另外一片资料

1、如果mysql的data数据很少,内存足够大,可以把data防止到内存盘中。

linux如下设置内存盘:

mount -t ramfs none /ram

默认使用内存一半

如果内存不够大,系统有多个硬盘,则把mysql应用程序和data目录分开到不同硬盘上。

2、mysql的表设置为myiasm,比同等条件下的innodb能快20倍以上

3、导入完成以后才创建数据库索引

4、导入完成以后根据需要转换为其他engine,比如innodb

5、多条数据插入一个表,可以使用多记录方式:

insert into tablename values(’xxx’,'xxx’),(’yyy’,'yyy’)…;

6、如果多个mysql执行导入,可以使用delayed

insert delayed into tablename values(’sss’,’ssss’);

7、大文件sql文件可以用split分成多份再导

8、同等条件下,redhat比ubuntu强很多(几乎肯定)

9 性能调整技巧(Performance tuning tips)

1. 如果 Unix top 或 Windows 任务管理器(Task Manager) 显示服务的 CPU 占用率小于70%,(shows that the CPU usage percentage with your workload is less than 70 %,)你的系统瓶颈可能在磁盘读写上。

或许你提交了大量的事务,或者是缓冲池(buffer pool)太小了。

将缓冲池设大点会有所帮助,但一定要注意不能大于物理内存的 80%。

2. 在一个事务中包含几个修改。

如果事务对数据库进行了修改,那么在这个事务提交时InnoDB 必须刷新日志到磁盘上。

因为硬盘的旋转速度通常至多为 167 转/秒,那么只要磁盘不欺骗操作系统,提交的事务数目限止也同样为 167 次/秒·用户。

3. 如果掉失最近的几个事务无所谓的话,可以在f 文件中将参数innodb_flush_log_at_trx_commit 设置为 0。

InnoDB 无论如何总是尝试一秒刷新(flush)一次日志,尽管刷新并不能得到保证。

4. 将日志文件(log files)设大一点,使日志文件的总和正好与缓冲池(buffer pool)一样大。

当 InnoDB 用光日志文件的空间时,它不得不在一个时间点上将缓冲池内修改过的内容写到磁盘上。

小的日志文件可能引起不必要的磁盘写操作。

但是大的日志文件的缺点就是在数据恢复时将占用较长的时间。

5. 同样 log buffer 尽量设大点,比如说 8 MB。

6. 如果要存储变长的字符串或字段可能会包含大量的 NULLs,请使用 VARCHAR 型字段代替CHAR 。

一个 CHAR(n) 字段总是使用 n bytes 来存储数据,即使这个字符串很短或是一个NULL 值。

较小的表更加适合缓冲池同时能够减少磁盘 I/O 。

7. (适合从 3.23.41 以上版本) 在某些版本的 Linux 和 Unixes 中,使用 Unix fsync 或其它类似的方法将文件刷新到磁盘是异常地慢的。

InnoDB 默认的方法就是 fsync 。

如果你对数据库系统的磁盘写性能不能感到满意,你可以尝试在f 中将innodb_flush_method 设置为 O_DSYNC,尽管 O_DSYNC 选项在多数的系统上看起来比较慢。

8. 在向 InnoDB 导入数据时,请确认 MySQL 没有打开 autocommit=1 。

否则每个插入语句都要将 log 刷新到磁盘。

在你的 SQL 导入文件的第一行加入

set autocommit=0;

并在最后一行加入

commit;

如果使用 mysqldump 选项–opt,你将会得到一个快速导入 InnoDB 表的转储(dump)文件,甚至可以不再使用上面所提的 set autocommit=0; … commit; 。

9. 小心 insert 集全的大回滚(roolback):在插入时 InnoDB 使用插入缓冲来减少磁盘I/O,但在相应的回滚中却没有使用这样的机制。

一个 disk-bound rollback 可能会花费相应插入时间的 30 倍。

如果发生一个失控的回滚,你可以查看第 6.1 章节的技巧来停止它。

10. 同样也要小心一个大的 disk-bound 的操作。

使用 Drop TABLE 或 TRUNCATE (从MySQL-4.0 以上) 来清空一个表,而不要使用 Delete FROM yourtable。

11. 如果需要插入大量记录行可以使用多行(multi-line)的 Insert 来减少客户端与服务器

端的通信开销:

Insert INTO yourtable VALUES (1, 2), (5, 5);

这个技巧对插入任何表均有效,而不仅仅是 InnoDB。

12. 如果在辅键上有 UNIQUE 约束,从 3.23.52 和 4.0.3 开始,可以通过在一个导入会话中将唯一键检查(uniqueness check)关闭来提高数据导入速度:

SET UNIQUE_CHECKS=0;

一个大的表导入这将减少大量的磁盘 I/O,因为这时 InnoDB 可能使用自身的插入缓冲来分批地记录辅助索引。

13. 如果在表中有一个子 FOREIGN KEY 约束,从 3.23.52 和 4.0.3 开始,可以通过在一个导入会话中将外键检查(foreign key check)关闭来提高数据导入速度:

SET FOREIGN_KEY_CHECKS=0;

对一个大的表导入这将减少大量的磁盘 I/O。