测试数据源

数据库应用程序设计第一次离线作业答案

《数据库应用技术》作业第六章6、系统DSN 用户DSN 文档DSN 系统DSN7、基于BDE的两层数据库应用程序、基于ADO的两层数据库应用程序、基于dbExpress 的两层数据库应用程序、基于InterBase的两层数据库应用程序8、三层开发结构的数据库应用程序方法主要有三种:基于DataSnap技术开发的多层结构数据库应用程序、基于Bussiness Broker Server技术开发的多层数据库应用程序和基于逻辑三层结构的数据库应用程序。

9、ODBC各部件及层次关系图10、1)打开ODBC数据源管理器:执行【开始】->【控制面板】命令,在控制面板窗口中双击【性能维护】图标,再双击【管理工具】图标,然后再双击【数据源(ODBC)】图标,将会展示【ODBC数据源管理器】对话框2)选择数据源类型并添加数据源:在【ODBC数据源管理器】对话框中单击【系统DSN】,再单“添加”按钮,出现【创建新数据源】对话框3)选择驱动数据源的驱动程序:在【创建新数据源】对话框中,选择【Microsoft Access Driver (*.mdb)】后单击【完成】按钮,出现【ODBC Microsoft Access安装】对话框4)设置数据源参数:在【数据源名】文本框中输入数据源名,在【说明】文本框中抒发说明信息。

单击【选择】按钮,出现【选择数据库】对话框。

在该对话框中选择对应的数据库名后单击【确定】按钮5)在【ODBC Microsoft Access安装】对话框中单击【确定】按钮,完成数据源的配置。

11、1)打开ODBC数据源管理器:执行【开始】->【控制面板】命令,在控制面板窗口中双击【性能维护】图标,再双击【管理工具】图标,然后再双击【数据源(ODBC)】图标,将会展示【ODBC数据源管理器】对话框2)选择数据源类型并添加数据源:在【ODBC数据源管理器】对话框中单击【系统DSN】,再单“添加”按钮,出现【创建新数据源】对话框3)选择驱动数据源的驱动程序:在【创建新数据源】对话框中,选择【SQL Server】后单击【完成】按钮,出现【创建到SQL Server的新数据源】对话框4)为数据源命名并选择SQL 服务器:在【创建到SQL Server的新数据源】对话框的【名称】文本框中输入数据源名,在【描述】文本框中输入数据源的描述,在【服务器列表框中选择或输入SQL服务器的名称。

测试ODBC连接

在软件操作中,经常出现连接不到服务器的情况

ODBC没有连接上就是导致连接不到服务器的原因之一。

在此是测试ODBC是否连接的详细步骤。

1、在控制面板中选择“管理工具”

注意:在XP系统中,在控制面版-----性能与维护-----管理工具

图示如下:

2、选择“数据源(ODBC)”

3、点击“添加”

4、选择SQL server

5、输入名称(任意)和服务器地址

(注意:填服务器地址的时候,若在客户端测试请输入服务器的ip地址)

6、选择“使用用户输入登陆ID和密码的SQL server验证

输入登陆ID和密码(一般口令为SA,密码为空)

7、点击下一步,直至完成即可

8、测试数据源

9、测试成功 >0<

注意:

1服务器地址的输入。

2用户ID和密码的输入。

若输入有误同样会出现测试失败的情况。

PB数据连接使用步骤

PB数据连接使用步骤步骤一:了解数据源在开始使用PB数据连接之前,首先需要了解要连接的两个数据源,包括数据源的类型、数据结构、数据存储方式等。

这些信息对于后续的数据连接设置和操作非常重要。

步骤二:安装和配置PB数据连接工具步骤三:设置数据连接在PB数据连接工具中,需要进行数据连接的设置。

首先,需要选择要连接的数据源类型,例如数据库、文件、Web服务等。

然后,根据具体的数据源类型,输入相应的连接信息,包括服务器地址、端口号、数据库名称、用户名、密码等。

通过设置这些连接信息,可以建立与数据源的连接。

步骤四:测试数据连接在设置数据连接后,可以进行数据连接的测试。

测试数据连接是为了确保输入的连接信息正确,并且可以成功连接到数据源。

通过测试数据连接,可以检查连接是否成功,以及连接是否稳定和可靠。

步骤五:添加数据源成功建立数据连接后,需要将数据源添加到PB数据连接工具中。

通过添加数据源,可以方便地管理和使用已连接的数据源。

在添加数据源时,需要提供数据源的名称和描述信息,并选择要添加的连接。

步骤六:设置数据传输方式在使用PB数据连接进行数据传输之前,需要设置数据传输方式。

数据传输方式包括增量传输和全量传输两种方式。

增量传输是指只传输数据源中发生变化的数据,而全量传输是指传输整个数据源中的全部数据。

通过设置数据传输方式,可以根据具体的需求选择合适的传输方式。

步骤七:执行数据传输设置完数据传输方式后,可以执行数据传输操作。

在数据传输过程中,PB数据连接工具会自动从一个数据源读取数据,并将数据传输到另一个数据源。

数据传输的速度和稳定性取决于数据源的类型和网络环境。

步骤八:监控和管理数据传输数据传输完成后,可以通过PB数据连接工具对传输结果进行监控和管理。

可以查看传输日志、统计传输结果、处理传输错误等。

通过监控和管理数据传输,可以及时发现并解决传输过程中的问题,确保数据的准确性和完整性。

步骤九:维护和优化数据连接数据连接是一个长期的过程,需要定期进行维护和优化。

大数据平台测试标准

大数据平台测试标准引言概述:随着大数据技术的快速发展,越来越多的企业和组织开始使用大数据平台来管理和分析海量数据。

然而,由于数据量的庞大和复杂性,大数据平台的测试变得愈发重要。

本文将介绍大数据平台测试的标准和方法,以确保其功能和性能的稳定和可靠。

一、功能测试1.1 数据采集功能测试- 确保数据采集模块能够正确地从各种数据源(如数据库、文件系统、传感器等)中获取数据。

- 验证数据采集的准确性和完整性,确保数据能够按照预期的方式被正确地读取和导入到大数据平台中。

- 测试数据采集模块的可扩展性和容错性,以确保在数据量增加或数据源变化时,系统能够正常工作。

1.2 数据存储功能测试- 检查数据存储模块是否能够正确地将数据存储到大数据平台中的分布式文件系统或数据库中。

- 验证数据存储的一致性和可靠性,确保数据在存储过程中不会丢失或损坏。

- 测试数据存储模块的性能和可扩展性,以确保在处理大规模数据时,系统能够高效地存储和检索数据。

1.3 数据处理功能测试- 验证数据处理模块能够正确地对数据进行清洗、转换和计算等操作。

- 检查数据处理的准确性和效率,确保数据能够按照预期的方式被处理和分析。

- 测试数据处理模块的可扩展性和容错性,以确保在处理大规模数据和复杂计算任务时,系统能够稳定运行。

二、性能测试2.1 数据采集性能测试- 测试数据采集模块的吞吐量和响应时间,以评估其在高负载情况下的性能表现。

- 检查数据采集模块的并发处理能力,以确保系统能够同时处理多个数据源的数据。

- 测试数据采集模块的可伸缩性,以评估其在数据量增加时的性能表现。

2.2 数据存储性能测试- 测试数据存储模块的读写性能,以评估其在大规模数据存储和检索时的性能表现。

- 检查数据存储模块的并发处理能力,以确保系统能够同时处理多个读写请求。

- 测试数据存储模块的可伸缩性,以评估其在数据量增加时的性能表现。

2.3 数据处理性能测试- 测试数据处理模块的处理速度和资源消耗情况,以评估其在大规模数据处理和复杂计算任务时的性能表现。

ODBC与数据源操作

9.单击“测试数据源”按钮,测试数据源 连接是否正确。如果DSN创建正确,则得 到图5-8所示的“SQL SERVER ODBC数 据源测试”的测试成功对话框。单击“确

定”按钮关闭测试结果对话框,最后单击 “确定”按钮,完成SQL SERVER 数据源 的建立工作,系统返回图7-1所示的 “ODBC数据源管理器”对话框,但“系统 DSN”的列表框中增加了一个名为 “NetShopSource”的数据源。

二、创建和配置ODBC数据源

在Windows NT/2000中,设定Web服务器使用 的数据源名称(DSN)时,必须建系统DSN,才 能确保所有的Web用户都可以使用该DSN连接到 指定得数据库。

下面以网上商店中所用的数据库NetShop为例, 建立ODBC数据源的步骤:

1.单击“开始/设置/控制面板”(或双击桌面 上“我的电脑”图标,并双击随之出现的“控制 面板”图标),出现“管理工具”图标。双击 “管理工具”图标,出现“管理工具”对话框。

数据源包含了用户安全性、数据库定位和

连接参数等与数据库进行连接的信息。也 就是说,DSN是一个代表ODBC连接的符 号,它隐藏了诸如数据库文件名、所在目 录、数据库驱动程序、用户ID、密码等细 节。所以,当建立连接时,不必考虑数据 库文件名或位置,只要给出它在ODBC中的 DSN即可。

DSN分为三种类型:用户DSN、系统DSN 和文件DSN。

在,则用选中一个数据源后单击“配置” 按钮,对该数据源进行重新设置。

3.单击“添加”按钮,将出现如图7-2所示的 “创建新数据源”对话框。因为本书中要连接的 数据库是由SQL Server创建的,故选择列表框中 的“SQL Server”,然后单击“完成”按钮。出 现图5-3所示的“建立新的数据源到SQL Server” 对话框第一页。

1.BW基础概念知识

1.基础问题集锦:关键值下的“累计值/非累计值”是什么意思?1) 累计值。

使用这一选项的关键值是一个自身存储数据的字段,在运行查询或报表时,系统会按照"集合"子窗口的设置将相应的值加总或平均,这也是最常见的设置。

2) 带非累计值更改的非累计值。

使用这一选项的关键值是一个非累计值,自身并不存储数据,但是它带有一个附加关键值,这一附加的关键值是存储数据的,表示的是非累计值的增量变化,非累计关键值的取值为附加关键值的累计结果。

3) 带流入和流出的非累计值。

使用这一选项非累计值带有两个附加关键值,分别表示非累计值的流入和流出的值,其取值为这两个附加关键值的累计结果。

做增量的时候,Tcode:LBWE下集中更新模式的区别是什么啊?Direct Delta:这就是一种V1模式,数据同步更新到增量队列,这种模式系统负荷很重,特别是对于业务量大的凭证,通过RSA7可以直接查看增量数据;Queued Delta:类似于V3的更新模式,与V3更新的区别在于,增量数据首先被收集到一个抽取队列中(V1模式),此时可以通过LBWQ查看增量数据,然后通过一步Job操作增量数据被送到增量队列中(V3模式),此时可以通过RSA7查看;Unserialized V3 Update:此模式与Queued Delta模式类似,唯一的区别是增量队列中的数据是无序的,而Queued Delta中的数据是排序的,这个对于采用覆盖模式的模型来说是最致命的,所以如果更新目标是DSO的话,还是不要采用这种模式,通过SM13可以查看增量数据。

什么是V3更新模式?V1同步更新模式,即凭证产生就更新增量,与业务数据同步更新;V2异步更新模式,就如同一个两步的操作一样,业务凭证产生以后,第一步更新业务数据源,第二步更新增量表,也就是说业务数据源和增量表是异步更新的;V3异步更新模式,也是两步操作,业务凭证产生以后首先更新业务数据源,然后再更新增量表,与V2的区别在于它的更新是通过后台事件来触发的,即定一个任务定时收集增量并更新至增量表。

大数据应用开发与数据管理规范

大数据应用开发与数据管理规范第一章引言 (2)1.1 大数据应用开发概述 (2)1.2 数据管理规范概述 (3)第二章大数据技术架构 (3)2.1 数据采集与存储 (3)2.1.1 数据来源 (4)2.1.2 数据采集方式 (4)2.1.3 数据存储策略 (4)2.2 数据处理与分析 (4)2.2.1 数据清洗 (4)2.2.2 数据转换 (5)2.2.3 数据计算与分析 (5)2.3 数据挖掘与可视化 (5)2.3.1 数据挖掘 (5)2.3.2 数据可视化 (5)第三章数据源管理 (5)3.1 数据源分类与评估 (6)3.2 数据源接入与维护 (6)3.3 数据源质量监控 (7)第四章数据质量管理 (7)4.1 数据质量评估 (7)4.2 数据清洗与转换 (8)4.3 数据质量监控与改进 (8)第五章数据仓库建设 (9)5.1 数据仓库设计 (9)5.2 数据仓库建模 (9)5.3 数据仓库管理与维护 (10)第六章数据集成与交换 (10)6.1 数据集成策略 (10)6.2 数据交换协议 (11)6.3 数据交换平台建设 (11)第七章数据安全与隐私保护 (12)7.1 数据安全策略 (12)7.2 数据加密与解密 (12)7.3 数据隐私保护 (13)第八章大数据开发工具与框架 (13)8.1 开发工具选型 (13)8.2 开发框架应用 (14)8.3 开发环境配置 (14)第九章大数据应用开发流程 (15)9.1 需求分析 (15)9.1.1 确定项目目标 (15)9.1.2 收集与整理需求 (15)9.1.3 需求文档撰写 (15)9.2 设计与实现 (15)9.2.1 系统架构设计 (15)9.2.2 数据库设计 (15)9.2.3 功能模块实现 (16)9.2.4 界面设计 (16)9.3 测试与部署 (16)9.3.1 单元测试 (16)9.3.2 集成测试 (16)9.3.3 系统测试 (16)9.3.4 部署与上线 (16)9.3.5 后期维护 (16)第十章数据分析与决策支持 (16)10.1 数据分析方法 (16)10.2 决策支持系统 (17)10.3 数据可视化 (17)第十一章大数据项目管理 (18)11.1 项目策划与管理 (18)11.1.1 项目目标确立 (18)11.1.2 资源整合 (18)11.1.3 进度控制 (19)11.2 项目风险管理 (19)11.2.1 风险识别 (19)11.2.2 风险评估 (19)11.2.3 风险应对 (19)11.3 项目评估与改进 (20)11.3.1 项目评估 (20)11.3.2 改进措施 (20)第十二章数据管理规范与标准 (20)12.1 数据管理规范制定 (20)12.2 数据管理标准实施 (21)12.3 数据管理培训与宣传 (22)第一章引言信息技术的飞速发展,大数据已经成为推动社会进步的重要力量。

TSTT产品可测试性需求格式范文

输出文档格式要求:在按照IPD模板内容执行IPD活动中,当输出文档时,请作者务必套用《IPD输出文档格式》,以保证文档格式的规范性。

Requirements for format of output documents: when you output documents while following IPD template to execute activities, Format of IPD Output Document must be followed to ensure that the format of documents are consistent and standardized.R&D-Template -Testability Requirements Guideline概念阶段确定可测试性需求指南-03.00.00活动号:TE-15Activity ID: TE-15Control Section文档控制Versio Date Change and reason ByProject Manager: __________________ Project: _________________项目经理: __________________ 项目: _________________Project Phase / Decision Checkpoint:项目阶段/决策检查点:XConcept概念Develop开发Launch发布Interim临时Plan 计划Qualify验证LifeCycle生命周期该模板仅作为确定可测性需求的指南,实际需求文档模板参照IPD《端到端产品包需求模板》。

1、概述 OVERVIEW目前可测性需求一般有以下几方面的考虑:1、面向产品的可测性需求,是为了提高产品的故障检测定位和隔离能力而考虑的可测性需求,直接影响产品问题故障检测定位和隔离的难易程度。

如何进行软件测试数据准备

如何进行软件测试数据准备软件测试是保障软件质量的一项重要工作,而数据准备是软件测试中不可或缺的一个环节。

正确的数据准备能够提高软件测试的效率和准确性,减少人为因素对测试结果的影响。

本文将探讨如何进行软件测试数据准备,包括数据源的选择、数据分类与整理、数据量的确定、数据质量的保证等方面。

一、数据源的选择在进行软件测试时,数据源的选择是至关重要的。

数据源应当与被测试软件的业务需求相符,以保证测试结果的准确性和全面性。

在选择数据源时,可以参考以下几个方面:1. 业务流程:根据被测试软件的业务流程,确定相关的数据源。

例如,如果被测试软件是一个电商平台,那么需要准备商品信息、订单信息、支付信息等数据。

2. 用户需求:根据用户的需求和使用场景,准备相应的测试数据。

例如,如果被测试软件是一款游戏,那么需要准备不同等级、不同属性的角色数据。

3. 手动输入:如果无法从现有数据源中获取满足要求的数据,可以手动输入测试数据。

二、数据分类与整理在确定了数据源后,需要对测试数据进行分类和整理。

数据分类可以根据业务流程、数据类型、数据来源等方面进行划分。

数据整理可以包括数据去重、数据格式化、数据清洗、数据关联等步骤。

1. 数据去重:在数据源中可能会存在重复数据,需要对重复数据进行去重处理,以保证测试数据的准确性和可靠性。

2. 数据格式化:不同的数据类型需要进行不同的格式化处理,例如日期、时间、金额等。

确保测试数据符合被测试软件的要求,避免因数据格式不正确而影响测试结果。

3. 数据清洗:在处理数据过程中,可能会存在数据错误、数据缺失、数据异常等问题。

需要对这些问题进行清洗处理,以保证测试数据的质量。

4. 数据关联:有些测试数据需要进行关联处理,例如订单信息需要关联用户信息、商品信息等。

需要确保关联关系正确,避免因数据关联不正确而影响测试结果。

三、确定数据量在进行软件测试数据准备时,需要确定合适的数据量。

数据量过小可能无法覆盖所有测试场景,数据量过大可能会造成测试效率低下。

公路桥梁健康监测结构化数据源分类与格式指南

公路桥梁健康监测结构化数据源分类与格式指南随着社会经济的不断发展,公路桥梁建设越来越成为城市基础设施建设的重要组成部分。

然而,随着桥梁使用年限的增长,桥梁的健康状况也日益引起人们的关注。

为了及时发现桥梁的疾病和隐患,采取有效的维护和保养措施,对桥梁健康监测结构化数据源的分类与格式指南具有重要意义。

本文将对公路桥梁健康监测结构化数据源进行分类和规范化,为相关工作提供指导。

一、公路桥梁健康监测结构化数据源分类1. 桥梁结构数据源桥梁结构数据源包括桥梁的基本结构参数、设计图纸、施工资料等信息。

这些数据源可以通过桥梁设计单位、施工单位等渠道获得,对于评估桥梁的结构健康状况具有重要的参考价值。

2. 桥梁荷载数据源桥梁荷载数据源是指桥梁承载车辆、行人等荷载的相关信息。

这些数据源可以通过交通管理部门、相关企业等途径获取,是评估桥梁承载能力的重要依据。

3. 桥梁材料检测数据源桥梁材料检测数据源包括桥梁材料的质量检测报告、材料强度测试数据等信息。

这些数据源可以通过材料检测机构、桥梁维护单位等渠道获取,对于评估桥梁的材料健康状况具有重要作用。

4. 桥梁监测数据源桥梁监测数据源是指利用传感器、监测设备等技术手段获取的桥梁结构变形、振动、应力等数据。

这些数据源可以通过监测设备提供商、监测单位等获得,是评估桥梁实际工作状态的重要依据。

二、公路桥梁健康监测结构化数据源格式指南1. 数据源命名规范为了方便管理和使用,对于不同类型的数据源需要制定清晰的命名规范。

桥梁结构数据源可以按照桥梁编号、部位、日期等进行命名;桥梁监测数据源可以按照监测点编号、监测参数、日期等进行命名。

2. 数据源格式规范不同类型的数据源可能具有不同的格式要求,桥梁结构数据源可以采用CAD图纸、PDF文档、Excel表格等格式;桥梁监测数据源可以采用文本文件、数据库格式、图表格式等。

对于每种类型的数据源,需要明确规定其所采用的格式要求。

3. 数据源存储标准数据源的存储标准包括存储介质、存储结构、备份策略等方面。

如何确保检测数据准确性

如何确保检测数据准确性引言概述:在现代社会中,数据的准确性对于各行各业都至关重要。

特殊是在科学研究、医疗诊断、金融分析等领域,准确的数据是做出正确决策和预测的基础。

因此,确保检测数据的准确性是一项至关重要的任务。

本文将介绍如何确保检测数据的准确性,从数据源的选择、检测方法的优化、质量控制、数据分析和验证等方面进行详细阐述。

一、选择可靠的数据源1.1 了解数据源的来源和采集方式选择可靠的数据源是确保数据准确性的第一步。

在选择数据源时,我们需要了解数据的来源以及采集方式。

数据源应来自可信赖的机构或者组织,采集方式应具备科学性和标准化,以确保数据的可靠性和一致性。

1.2 确保数据源的数据质量数据质量是确保数据准确性的关键因素之一。

我们需要评估数据源的数据质量,包括数据的完整性、一致性、准确性和时效性等方面。

如果数据源的数据质量不达标,我们需要考虑寻觅其他可靠的数据源或者采取数据清洗和修复等措施。

1.3 定期更新数据源数据源的更新频率对于数据准确性也有重要影响。

我们应确保数据源能够及时更新,以保证数据的时效性和准确性。

定期更新数据源可以匡助我们获取最新的数据,并及时修复和纠正可能存在的错误。

二、优化检测方法2.1 选择适当的检测方法针对不同的数据类型和检测目的,我们应选择适当的检测方法。

不同的检测方法有不同的适合范围和准确性,我们需要根据具体情况进行选择。

同时,我们也可以结合多种检测方法,以提高数据的准确性和可靠性。

2.2 设计合理的实验方案在进行数据检测时,我们需要设计合理的实验方案。

合理的实验方案可以减少误差和干扰因素的影响,提高数据的准确性。

我们需要考虑样本数量、实验环境、实验参数等因素,并进行充分的实验控制和重复实验,以获得可靠的数据结果。

2.3 使用先进的检测设备和技术现代科技的发展为数据检测提供了先进的设备和技术支持。

我们应选择先进的检测设备和技术,以提高数据的准确性和敏感性。

同时,我们也需要掌握和熟练运用这些设备和技术,以确保数据的准确性和可靠性。

数据迁移测试方案

数据迁移测试方案一、背景介绍在数据迁移过程中,为了确保数据的完整性、准确性和安全性,需要进行数据迁移测试。

数据迁移测试是指在数据迁移先后,通过摹拟真实环境,验证数据迁移过程中的各项功能和性能指标,以确保数据迁移的顺利进行。

二、测试目标1. 确保数据迁移过程中数据的完整性和准确性。

2. 验证数据迁移过程中的各项功能是否正常。

3. 确保数据迁移过程中的性能指标满足需求。

4. 验证数据迁移后系统的稳定性和可用性。

三、测试环境1. 数据源:摹拟真实环境中的数据源,包括数据库、文件系统等。

2. 目标环境:摹拟数据迁移后的目标环境,包括数据库、文件系统等。

3. 测试工具:根据具体情况选择合适的测试工具,如JMeter、LoadRunner等。

四、测试内容1. 数据完整性测试:验证数据迁移后目标环境中的数据是否与源环境中的数据彻底一致,包括数据的数量、结构和内容。

- 针对数据库,可以通过比对源数据库和目标数据库的表结构、数据记录等进行验证。

- 针对文件系统,可以通过比对源文件系统和目标文件系统中的文件数量、文件大小等进行验证。

2. 功能测试:验证数据迁移过程中的各项功能是否正常。

- 验证数据迁移的开始、暂停、继续和住手功能是否正常。

- 验证数据迁移过程中的错误处理机制是否正常,包括错误日志记录、错误信息提示等。

- 验证数据迁移过程中的日志记录功能是否正常,以便后续问题排查和分析。

3. 性能测试:验证数据迁移过程中的性能指标是否满足需求。

- 针对数据迁移的吞吐量,可以通过摹拟大量数据并设置合适的并发数,测试数据迁移的速度和稳定性。

- 针对数据迁移的延迟,可以通过摹拟高负载情况,测试数据迁移的响应时间和处理能力。

4. 系统稳定性和可用性测试:验证数据迁移后系统的稳定性和可用性。

- 验证数据迁移后系统的基本功能是否正常,包括数据的读写操作、数据的查询和分析等。

- 验证数据迁移后系统的负载能力,包括并发用户数、数据处理能力等。

pytest-excel模块的用法

pytest-excel模块的用法pytestexcel是一个基于pytest框架的插件,它提供了一种简洁有效的方式,用于在单元测试中读取和写入Excel文件。

该模块适用于Python开发人员,帮助他们在测试用例中方便地使用Excel作为数据源。

在本文中,我将给出一个详细的步骤,以指导读者使用pytestexcel模块。

文章将从安装所需的软件开始,然后介绍如何编写测试用例和使用pytestexcel模块来读取和写入Excel文件。

第一步:安装pytest和pytestexcel模块要使用pytestexcel模块,首先需要安装pytest和pytestexcel。

在命令行中使用以下命令来安装这两个模块:pip install pytestpip install pytest-excel安装完成后,可以通过运行以下命令来验证是否成功安装pytestexcel模块:pytest version如果显示了pytest的版本号,则说明模块安装成功。

第二步:创建Excel文件在开始编写测试用例之前,需要准备一个Excel文件作为数据源。

创建一个新的Excel文件,并使用合适的列标题来标识测试数据。

确保将测试数据保存在工作表的第一个工作表中。

例如,假设我们想测试一个计算器函数,我们可以在Excel文件中创建以下数据:A B C数字1 数字2 期望结果2 3 54 5 96 7 13保存Excel文件,并记住它的路径。

第三步:编写测试用例现在我们已经准备好Excel文件,可以开始编写测试用例了。

在您的Python项目中创建一个新的测试文件,并在文件中导入pytestexcel模块。

pythonimport pytestimport pytestexcel接下来,我们需要定义一个fixture函数,它将用于从Excel文件中获取和返回测试数据。

使用pytest的fixture装饰器将该函数标记为fixture,指定在测试运行之前运行的操作。

测试中的数据准备与数据清洗技巧

测试中的数据准备与数据清洗技巧数据是现代科技发展的核心基石,它们在各行各业中起着至关重要的作用。

在进行测试工作时,充分准备和清洗数据是确保测试结果准确可信的前提。

本文将介绍一些测试中的数据准备与数据清洗技巧,帮助读者提高测试效果。

一、数据准备技巧1. 确定测试目标:在进行数据准备之前,首先需要明确测试的目标。

明确测试目标有助于我们确定所需数据的类型和范围,以及测试数据的量级和质量要求。

2. 收集合适的数据源:选择合适的数据源是保证测试准确性的重要步骤。

数据源可以是真实业务数据、模拟数据、公共数据集等等,根据实际情况选择最适合的数据源。

3. 确定数据采集方式:数据采集方式根据数据源的不同而变化。

对于真实业务数据,可以通过接口、数据库、日志等方式进行采集;对于模拟数据,可以使用脚本、生成器等方式进行采集。

4. 验证数据的可用性:在采集到数据后,需要验证数据的可用性。

这包括检查数据的完整性、准确性和可靠性,确保数据符合测试需求,并排除可能存在的问题。

二、数据清洗技巧1. 去除重复数据:在数据清洗的过程中,首先需要去除重复数据。

重复数据可能会导致测试结果的偏差,因此需要对数据进行去重操作,确保每条数据的唯一性。

2. 处理缺失值:在数据中常常会存在一些缺失值,这些缺失值可能是由于系统故障、输入错误等原因导致的。

处理缺失值可以选择删除含缺失值的数据行,或者采用插值等方法进行填充。

3. 格式化数据:数据的格式化可以提高数据的可读性和可理解性。

格式化操作包括去除特殊字符、调整日期时间格式、统一数值单位等,使数据更易于处理和分析。

4. 删除异常值:异常值会对测试结果产生负面影响,因此在数据清洗的过程中需要识别和删除异常值。

异常值的识别可以使用统计方法、可视化分析等手段,将异常值排除在外。

5. 调整数据类型:对于不同的测试需求,经常需要对数据进行类型转换。

例如将字符串转换为数值型、日期时间格式调整等,使得数据满足测试要求。

atos 手册

atos 手册一、概述本手册旨在为使用atos工具的用户提供全面的指南和帮助。

atos是一款自动化测试工具,广泛应用于软件测试领域。

本手册提供了atos的基本概念、安装和配置、使用方法、常见问题及解决方法等方面的指导。

二、atos简介atos是一款功能强大的自动化测试工具,它能够根据测试用例自动执行测试任务,并生成测试报告。

atos支持多种测试框架和语言,如Java、Python、C++等,可以满足不同用户的需求。

使用atos工具可以帮助用户提高测试效率、减少人工干预、降低测试成本。

三、安装和配置atos的安装和配置相对简单,以下是基本的步骤:1. 下载atos安装包,根据系统要求进行安装。

2. 配置环境变量,确保系统能够正确识别atos工具。

3. 创建测试用例目录,用于存放测试用例和测试结果。

4. 选择并配置测试框架,如JUnit、Pytest等。

5. 配置测试数据源,如数据库、文件等,确保测试用例能够获取正确的数据。

6. 配置测试报告输出路径,以便将测试结果输出到指定的位置。

四、使用方法atos的使用方法相对简单,以下是基本的使用步骤:1. 编写测试用例,包括测试步骤、预期结果等。

可以使用文本编辑器或专门的测试管理工具进行编写。

2. 运行测试用例,只需打开atos工具并选择要运行的用例即可。

atos将自动执行测试脚本并生成测试报告。

3. 分析测试结果,查找问题并进行修复。

atos提供了一系列的工具和报告,帮助用户分析和解决测试问题。

4. 可选功能:atos还提供了许多可选的功能和扩展,如自定义脚本、多线程执行、云测试服务等,可以根据需要选择使用。

五、常见问题及解决方法以下是atos使用过程中常见的几个问题及解决方法:1. atos工具无法正常启动:请检查安装包是否完整,重新下载安装。

如果问题仍然存在,可以尝试重启电脑或检查系统环境变量配置是否正确。

2. 测试用例执行失败:请检查测试脚本是否正确编写,测试数据是否正确配置。

grafana 普罗米修斯查询正则匹配语句 -回复

grafana 普罗米修斯查询正则匹配语句-回复如何在Grafana中使用Prometheus查询语句进行正则匹配?在Grafana中使用Prometheus进行查询是一种常见的做法,因为Prometheus是一种功能强大的开源监控系统,可以用于收集、存储和查询时间序列数据。

在进行数据查询时,有时需要通过正则表达式来匹配特定的数据,以便更准确地获取所需的信息。

接下来,我们将一步一步地介绍如何在Grafana中使用Prometheus查询语句进行正则匹配。

首先,我们需要在Grafana中配置Prometheus数据源。

在Grafana的界面中,点击Configuration(配置)选项,然后选择Data Sources(数据源)。

在Data Sources页面中,点击Add Data Source(添加数据源)按钮,在Type(类型)下拉菜单中选择Prometheus,并填写相应的配置信息,例如URL和Access(访问)等。

配置完成后,点击Save & Test (保存并测试)按钮来测试数据源的连接是否成功。

接下来,我们将在Grafana仪表盘中创建一个面板,以便使用Prometheus 进行查询和展示数据。

在Grafana的主界面中,点击New Dashboard(新建仪表盘)按钮。

在新建的仪表盘页面中,点击Add New Panel(添加新面板)按钮,在Metrics(指标)选项卡中选择Prometheus作为数据源,并点击查询构建器图标以打开查询构建器。

在查询构建器中,我们可以输入Prometheus的查询语句来获取所需的数据。

为了进行正则匹配,我们将使用PromQL(Prometheus Query Language)中的正则表达式操作符。

PromQL支持使用=~操作符进行正则匹配,该操作符允许我们在查询时使用正则表达式来匹配指标名称或标签的值。

例如,假设我们有一个名为http_requests_total的指标,其中包含多个标签,如method(请求方法)和status(请求状态)。

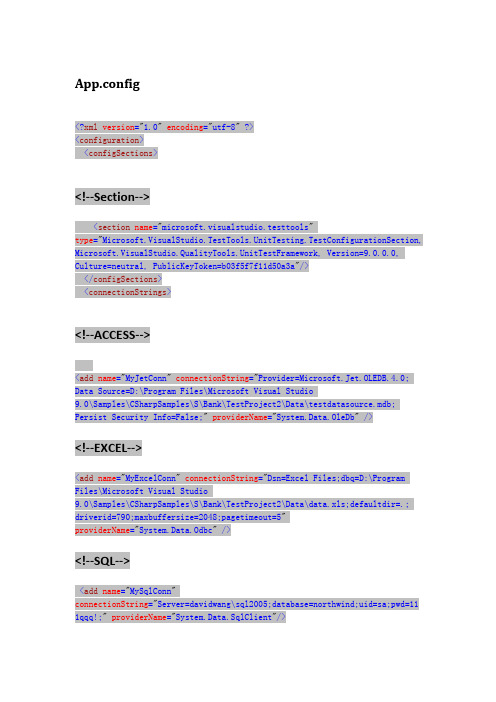

单元测试多种数据源的配置及测试代码

App.config<?xml version="1.0"encoding="utf-8" ?><configuration><configSections><!--Section--><section name="microsoft.visualstudio.testtools"type="Microsoft.VisualStudio.TestTools.UnitTesting.TestConfigurationSection, Microsoft.VisualStudio.QualityTools.UnitTestFramework, Version=9.0.0.0, Culture=neutral, PublicKeyToken=b03f5f7f11d50a3a"/></configSections><connectionStrings><!--ACCESS--><add name="MyJetConn"connectionString="Provider=Microsoft.Jet.OLEDB.4.0; Data Source=D:\Program Files\Microsoft Visual Studio9.0\Samples\CSharpSamples\S\Bank\TestProject2\Data\testdatasource.mdb; Persist Security Info=False;"providerName="System.Data.OleDb" /><!--EXCEL--><add name="MyExcelConn"connectionString="Dsn=Excel Files;dbq=D:\Program Files\Microsoft Visual Studio9.0\Samples\CSharpSamples\S\Bank\TestProject2\Data\data.xls;defaultdir=.; driverid=790;maxbuffersize=2048;pagetimeout=5"providerName="System.Data.Odbc" /><!--SQL--><add name="MySqlConn"connectionString="Server=davidwang\sql2005;database=northwind;uid=sa;pwd=11 1qqq!;"providerName="System.Data.SqlClient"/><!--XML--><add name="MyXMLConn"connectionString="|DataDirectory|\brief.xml" providerName="Microsoft.VisualStudio.TestTools.DataSource.XML"/></connectionStrings><microsoft.visualstudio.testtools><dataSources><add name="MyJetDataSource"connectionString="MyJetConn" dataTableName="MyDataTable"dataAccessMethod="Sequential"/><add name="MyExcelDataSource"connectionString="MyExcelConn" dataTableName="Sheet1$"dataAccessMethod="Sequential"/><add name="MySqlDataSource"connectionString="MySqlConn" dataTableName="Employees"dataAccessMethod="Sequential"/><add name="MyXMLDataSource"connectionString="MyXMLConn" dataTableName="Table1"dataAccessMethod="Sequential"/></dataSources></microsoft.visualstudio.testtools></configuration>报错单元测试适配器引发异常: “Microsoft.VisualStudio.TestTools.UnitTesting.TestConfiguration”的类型初始值设定项引发异常。

数据源(DataSource)是什么

数据源(DataSource)是什么数据源数据源,简单理解为数据源头,提供了应⽤程序所需要数据的位置。

数据源保证了应⽤程序与⽬标数据之间交互的规范和协议,它可以是数据库,⽂件系统等等。

其中数据源定义了位置信息,⽤户验证信息和交互时所需的⼀些特性的配置,同时它封装了如何建⽴与数据源的连接,向外暴露获取连接的接⼝。

应⽤程序连接数据库⽆需关注其底层是如何如何建⽴的,也就是说应⽤业务逻辑与连接数据库操作是松耦合的。

以下只讨论当数据源为数据库的情况,且为Java环境下JDBC规范下的如何建⽴与数据库的连接,其他情况类似。

DriverManagerJDBC(Java DataBase Connectivity, 简称JDBC)是Java中⽤于规范应⽤程序如何来访问数据库的应⽤程序接⼝(API),它提供了查询和更新数据库中数据的⽅法。

在基于Java的应⽤程序中,我们需要使⽤JDBC驱动程序与数据库进⾏交互,其中最重要的⼀步就是获取与数据库的连接。

在传统的JDBC时代,我们通常写⼀个通⽤的⽅法来封装与数据库的建⽴操作:` public Connection getConnection() throws SQLException {Connection conn = null;Properties connectionProps = new Properties();connectionProps.put("user", erName);connectionProps.put("password", this.password);//获取获取连接conn = DriverManager.getConnection("jdbc:" + this.dbms + "://" +this.serverName +":" + this.portNumber + "/",connectionProps);return conn;}`以上的代码对于早些的程序员是再熟悉不过了,我们利⽤驱动管理器为应⽤程序提供数据库连接,虽然使⽤形式简单,但有个很⼤的问题就是:程序员需要⾃⼰去写建⽴连接的操作,且该⽅法已经与我们的应⽤程序是紧耦合的,在后续需要更改数据库时,需要程序员⼿动修改这⾥。

报告中数据收集和处理过程中的质量控制

报告中数据收集和处理过程中的质量控制数据的质量控制对于报告的准确性和可信度至关重要。

在数据收集和处理过程中,需要采取一系列的质量控制措施,以确保数据的准确性、可靠性和一致性。

本文将从不同角度展开论述数据质量控制的重要性及相关措施。

一、数据收集过程中的质量控制1.数据源选择和验证:在数据收集之前,需要仔细选择数据源,确保其可靠性和准确性。

对数据源进行验证,比如检查数据源的来源、信誉度和数据生成过程等。

同时,进行数据的背景调查和核实,避免采用不真实或可疑的数据。

2.样本设计和抽样误差控制:样本的设计是数据收集的基础。

在样本设计过程中,需要考虑样本的代表性和随机性。

采用合适的抽样方法,并控制抽样误差,以减少样本偏差。

3.问卷设计和测试:问卷设计要考虑问题的准确性和清晰度,避免主观性和歧义。

在正式使用之前,进行问卷的预测试,以排除问题和改进问卷的可理解性和可操作性。

二、数据处理过程中的质量控制1.数据清洗和筛选:数据清洗是去除无效数据和异常值的过程。

需要对收集到的数据进行逻辑和实际性的检查,排除错误数据和异常情况。

同时,根据研究目的将数据进行筛选,只保留符合条件的数据。

2.数据标准化和匹配:数据标准化是将不同格式和单位的数据统一转换为可比较的形式。

数据匹配则是将不同数据源的数据进行对应和合并。

这两个过程可以提高数据的一致性和可比性,降低数据处理中的错误率。

3.数据分析和验证:在进行数据分析之前,需要对数据进行充分的验证。

比如,利用统计学方法检验数据的分布和相关性。

通过验证,可以排除数据处理过程中的错误和异常。

三、数据报告中的质量控制1.数据可视化和解释:在报告中,通过合适的图表和图形来展示数据。

数据可视化可以帮助读者更直观地理解和解释数据。

同时,在解释数据时,需要清晰地说明数据的来源、处理方法和限制条件等。

2.结果的一致性和可信度:在报告中,需要确保结果的一致性和可信度。

比如,通过重复实验或独立验证来验证结果的可靠性。

jmeter csvread函数

jmeter csvread函数JMeter是一个功能强大的负载测试工具,它可以用来模拟大量用户同时访问服务器,以测试服务器的性能和稳定性。

JMeter中的csvread函数是一种使用CSV文件作为测试数据源的方法。

在本文中,我们将介绍如何使用csvread函数,并给出一些相关的使用示例。

首先,让我们了解一下什么是CSV文件。

CSV是一种常用的电子表格文件格式,它使用逗号分隔不同的字段,并使用换行符分隔不同的行。

CSV文件可以用任何文本编辑器打开,并且只需将数据按照一定格式保存即可。

在JMeter中,通过使用csvread函数,我们可以将CSV文件作为测试数据源,将其中的数据读取到测试计划中。

csvread函数可以读取CSV文件的不同字段,并将它们保存到变量中,以供测试计划中的其他元素使用。

csvread函数的语法如下:```${__csvRead(fileName,variableName)}```其中,fileName是指CSV文件的路径,variableName是指要保存CSV文件数据的变量名。

例如,假设我们有一个名为data.csv的CSV文件,其中包含以下数据:```username,passworduser1,pass1user2,pass2user3,pass3```我们可以在测试计划中使用csvread函数读取该文件并将数据保存到变量中。

假设我们想将用户名保存到变量username中,密码保存到变量password中,我们可以使用以下方式调用csvread函数:```${__csvRead(data.csv,username)}${__csvRead(data.csv,password)}```在下面的示例中,我们将演示如何使用csvread函数来模拟多个用户登录一个网站的场景。

1. 首先,创建一个线程组来模拟用户登录场景。

设置线程数和循环次数等参数,以控制并发用户的数量和测试持续时间。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

请以文字为准,图片为参考

1.在能使用SMIS的电脑上进行操作,右键点击桌面小帽子(正式版)--属性--

查找目标,在弹出的文件夹中,找到文件名为StmsApp,类型为配置设置的文件,然后拷贝到船长电脑用记事本方式进行打开,会看到如下:

[STMSDATABASE]

DBMS = "MSS Microsoft SQL Server 6.x"

Database = "SMIS3"

ServerName = "********"

LogId = "sa"

AutoCommit = False

DBParm = "DBTextLimit='8192'"

UserId =

dbpass =

logpass = "*******"

OilManager = ""

Defaultlanguage=SIMPLECHINESE

UserName=system

Disabled=""

192.168.0.11

在上述中标记为黄色的是数据库名称,红色的是服务器IP,蓝色的是密码

2.测试数据源

方法是:

打开开始 运行输入odbcad32 如下图

点确定,跳出下面窗口。

然后切换到系统DSN标签页

点右侧添加,选择SQL SEVER,点击完成。

按下图输入服务器框内输入上述中的服务器IP

点下一步,弹出下面窗口

按上图进行操作,设置的都一样即可,登录ID(L)填小写sa, 密码就是上述蓝色字体的密码

输入好后,点客户端配置(T),弹出

将上图中,动态决定端口前打勾去掉,端口号输入1433 点确定退出此窗口,回到上面的窗口点下一步。

点下一步

点完成

点测试数据源

2.SMIS程序重装及配置文件替换

将smis程序重新安装后,在桌面会显示小帽子,右键点击桌面小帽子(正式版)

--属性--查找目标,在弹出的文件夹中将第一步拷贝回来的StmsApp,类型为配置设置的文件放入到刚打开的文件中,然后查看是否可以打开SMIS,完毕。