基于CycleGAN的图像风格迁移

基于GAN的图像风格迁移技术研究

基于GAN的图像风格迁移技术研究图像风格迁移技术是一种新兴的图像处理技术,它可以将一张图像的艺术风格应用到另一张图像上,从而创造出新的艺术品。

基于生成对抗网络(GAN)的图像风格迁移技术在近年来得到了广泛应用,其通过训练生成器来学习不同风格的图像特征,再将其应用到待处理的图像上实现风格转换。

本文将着重讨论基于GAN的图像风格迁移技术的原理、应用及其未来的发展方向。

一、基于GAN的图像风格迁移技术原理GAN是一种深度学习技术,它由两个神经网络组成,一个生成器和一个判别器。

生成器负责生成合成图像,判别器则负责判断图像的真实性。

在基于GAN的图像风格迁移技术中,生成器的目标是学习不同风格的图像特征,判别器的目标是将真实图像和合成图像分开。

为了训练生成器和判别器,我们需要定义一个损失函数,用于衡量两个神经网络的效果。

损失函数通常包括两个部分:生成器的误差和判别器的误差。

通过不断调整生成器和判别器的参数,我们可以让生成器生成更加逼真的合成图像,同时使判别器更加准确地判断图像的真实性。

基于GAN的图像风格迁移技术的核心在于训练生成器学习不同的图像风格。

我们可以使用不同的训练数据集,比如名画、电影场景或者自然景观等。

生成器可以通过学习风格的全局特征和局部细节来生成新的图像,从而实现图像风格的转换。

目前,基于GAN的图像风格迁移技术已经实现了很多令人惊叹的成果,比如将梵高的风格应用到自拍照片上、将日系动漫的风格应用到照片中等。

二、基于GAN的图像风格迁移技术应用基于GAN的图像风格迁移技术已经被应用到许多领域,比如艺术创作、影视特效、虚拟现实等。

在艺术创作方面,图像风格迁移技术可以帮助艺术家创造出更多的视觉表现形式,拓展艺术表达的空间。

在影视特效方面,图像风格迁移技术可以应用到场景的设计和渲染中,从而让电影或者游戏更加真实和惟妙惟肖。

在虚拟现实方面,图像风格迁移技术可以让虚拟世界更加真实,更符合我们的感知要求。

如何将CycleGAN用于风格迁移并探索其在游戏图形模型中的应用

如何将CycleGAN用于风格迁移并探索其在游戏图形模型中的应用用神经网络尝试在《堡垒之夜》中重现《绝地求生》的画面风格。

本文旨在了解如何将CycleGAN 用于风格迁移并探索其在游戏图形模型中的应用。

如果你是一名游戏玩家,肯定听说过如今最火的两款「吃鸡」游戏:《堡垒之夜》(Fortnite)和《绝地求生》。

这两个游戏很相似,都是100 名玩家降落在一个小岛上,然后淘汰至最后一人「吃鸡」。

作者之前比较喜欢《堡垒之夜》的游戏风格,但现在更喜欢《绝地求生》的写实画面。

于是他不禁开始思考,是否有可能创建一个图形模式,让我们选择喜欢的画面风格而不必依赖于开发者给我们提供的画面选择?如果有个图形模式能够将《绝地求生》的画风渲染至《堡垒之夜》呢?于是作者决定用深度学习来探索这一模式,然后发现了一种叫CycleGAN 的神经网络。

该网络非常擅长图像风格迁移。

在本文中,作者将介绍CycleGAN 的工作原理,然后训练它们将《堡垒之夜》可视化地转为《绝地求生》。

卡通风格的《堡垒之夜》(左)和写实风格的《绝地求生》(右)CycleGAN 是什么?CycleGAN 是一种用于跨域图像风格迁移的生成对抗网络,它能将图像从一个域迁移到另一个域,例如从《堡垒之夜》到《绝地求生》的迁移。

任务是以无监督方式执行的,即两个域的图像没有一一映射的关系。

Github 实现及其结果:https://github/junyanz/pytorch-CycleGAN-and-pix2pix该网络能够理解原始域图像中的对象,并对目标域图像中相同对象的外观做相应的变换。

该网络的算法实现经训练后,可以将马转化为斑马,将苹果转化为橙子,将照片转化为漂亮的油画等等。

如何实现?我们简单分析一下如何使用CycleGAN 将《堡垒之夜》和《绝地求生》分别作为输入域。

TensorFlow 2 深度学习实战 第6章 基于CycleGAN的图像风格转换

9

目录

1 2 3

目标分析 读取数据 数据预处理

10

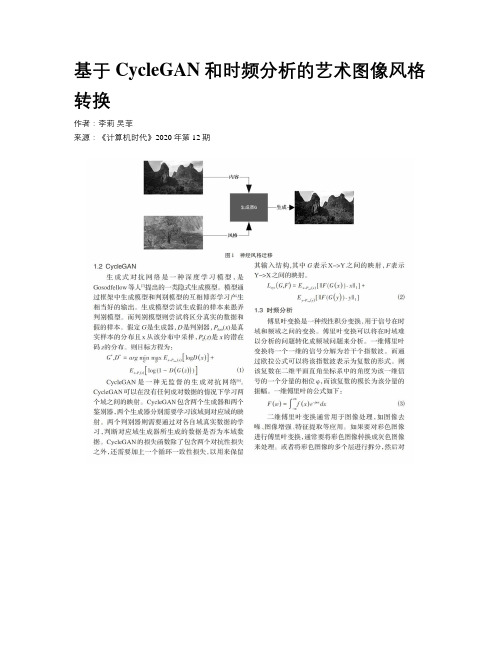

读取数据

➢ 本案例使用的数据是油画与现实风景图像数据集,该数据 集包含了4个子数据集。 • testA、trainA分别包含了400张油画图像。 • testB、trainB分别包含了400张现实风景图像。

➢ 读取图像数据,再将数据转换成TensorFlow框架所需要的 格式,即tensor数据格式。使用定义好的load函数展示一 张图像,输出结果如右图所示。

数据读取

数据预处理

随机抖动

图像数据

归一化处理图像 对图像做切片处理

建立迭代器

构建网络

构建生成器 构建判别器

训练网络

结果分析

定义损失函数 定义损失函数 定义损失函数 定义损失函数

结果分析

7

项目工程结构

➢ 本案例基于TensorFlow 2.2.0环境运行,并且需要安装tensorflow_examples库。 ➢ tensorflow_examples需要自行前往GiHub网站下载。 ➢ 在GiHub下载tensorflow.master包,解压后找到tensorflow_examples文件夹,将tensorflow_examples文件夹放

• 加载油画与现实风景图像数据集。 • 数据预处理,包括随机抖动、归一化处理、对所有图像做批处理并打乱和建立迭代器。 • 构建CycleGAN网络,即构建生成器与判别器。 • 训练网络,包括定义损失函数、定义优化器、定义图像生成函数和定义训练函数 • 对训练结果进行结果分析。

6

分析目标

案例的总体流程图如下图所示。

第6章 基于CycleGAN的图像 风格转换1

目录

基于生成对抗网络的图像艺术风格迁移

基于生成对抗网络的图像艺术风格迁移董伟;赵杰煜【摘要】提出了一种新颖的图像艺术风格化算法, 利用结构相似性指数和最小二乘生成对抗网络,搭建图像艺术风格化模型. 通过对模型生成器和判别器的对抗训练以及重建约束, 该模型可以生成一幅逼真的风格化作品. 根据在人脸肖像素描 sketch-photo 数据集和中国水墨画风格beihong-photo数据集实验表明, 与目前流行的DualGAN算法、CycleGAN算法、Pix2Pix算法和GAN算法相比, 本文提出的方法具有更好的风格化效果.%This paper proposes a novel neural style transfer algorithm. The Structural Similarity Index Measurement (SSIM) with the Least Squares Generate Adversarial Nets (LSGAN) is adopted to build a model for image repainting with neural styles. Through the adversarial training and reconstruction constraints, the model can generate a more realistic and reasonable stylized picture. Two groups of experiments are performed with CHUK sketch-photo dataset and a Chinese ink-painted style dataset (named beihong-photo which is constructed by the authors’ lab). Experimental results show that the presented method achieves a more acceptable state-of-art effect compared with those from the most popular algorithms, including DualGAN, CycleGAN, Pix2Pix and the classic GAN.【期刊名称】《宁波大学学报(理工版)》【年(卷),期】2019(032)005【总页数】6页(P30-35)【关键词】结构相似性指数;最小二乘生成对抗网络;图像艺术风格化;非真实感绘制【作者】董伟;赵杰煜【作者单位】宁波大学信息科学与工程学院, 浙江宁波 315211;宁波大学信息科学与工程学院, 浙江宁波 315211【正文语种】中文【中图分类】TP301.6随着大数据时代的来临与深度学习技术的兴起, 人工智能领域取得了快速发展, 使得研究者对人工智能的关注度以及社会大众对人工智能的憧憬得到空前提升[1-2]. 图像艺术风格化是近年来非真实感绘制领域的研究热点之一, 其主要考虑如何利用计算机模拟某种艺术风格绘制素描、水彩以及油画等[3]. 因此, 在海量图像数据下, 运用深度学习技术来实现图像艺术风格化具有重要意义.已有学者提出了一些图像艺术风格化算法和基于生成对抗网络的图像风格转换算法. 如Gatys等[4]首次运用深度学习来实现图像的艺术风格转换, 通过卷积神经网络中间层输出特征图的统计特性来对图像内容以及风格特征进行提取和量化, 虽然效果惊艳, 但每幅图像的渲染都要经过漫长的学习过程, 在多轮迭代计算中逐像素地施加纹理. 文献[5-6]在Gatys的基础上提出了一种实时图像艺术风格化算法, 通过预训练VGGNet提取图像的高维抽象特征用以构建损失函数, 同时使用图像转换网络来存储风格的纹理特征. 该算法实验效果良好, 但每次仅仅学习到单张图片的艺术风格. Isola等[7]提出了一种监督性风格转换框架Pix2Pix. 该算法要求训练样本配对, 即已知输入图像的风格化结果, 因此为了使生成器产生更逼真的结果,该算法引入范数来惩罚生成结果与真实结果之间的差异. 为了解决Pix2Pix训练数据需要配对的问题, Zhu等[8]提出了无监督风格转换框架CycleGAN, 引入循环一致性理论,使用两组生成器和判别器, 将源域中一幅图像依次经过源域到目标域的映射, 以及目标域到源域的映射后得到源图像的重建图像, 并使用范数约束重建图像与源图像越相近越好. Yi等[9]提出了基于对偶学习和范数的无监督图像风格转换DualGAN. 近期, 谢志峰等[10]提出了一种基于CycleGAN生成高低曝光图片, 并结合输入图像, 实现了HDR风格迁移. 林嘉骏等[11]提出了一种基于像素级GAN的灰度图像彩色化模型, 目标函数使用范数作为彩色化优化项. 上述基于GAN的图像风格转换算法都使用范数作为生成器损失函数的一部分, 但范数只是从像素角度去衡量图像之间的差异性, 并没有充分利用图像的结构信息.本文结合结构相似性指数(Structural Similarity Index Measurement, SSIM)[12]和最小二乘生成对抗网络(Least Squares Generate Adversarial Nets, LSGAN)[13], 提出一种在图像内容特征和风格特征保持平衡的图像艺术风格化算法, 使得在图像细节生成上有更出色的表现.2014年Goodfellow等[14]首次提出了生成对抗网络(Generative Adversarial Nets, GAN), 成为深度学习结合生成模型和判别模型的成功典范. GAN将一个对抗性判别器模型(判别器)巧妙地结合到一个生成模型(生成器)中, 生成器生成数据, 判别器判断该数据的真伪, 二者相互竞争, 相互促进, 生成器产生的结果愈来愈真, 达到以假乱真的程度; 判别器的能力也愈来愈强, 对于真假数据的判别越来越强. GAN 训练过程是一个全自动的非指导性学习过程, 几乎无需人工干预. 已有的研究表明[15-18], GAN在诸如图像生成、图像超分辨和半监督学习等各种任务中发挥着重要作用.GAN的基本思想是同时训练一个判别器和一个生成器, 判别器旨在区分真实样本和生成样本; 而生成器试图尽可能“欺骗”判别器, 使得判别器误认为生成样本为真实样本. 生成器与判别器均可以采用深度神经网络[19]. GAN的优化过程可以描述为一个“二元极小极大”问题, 目标函数为[12]:式中: 是随机噪声的分布; 是真实样本的分布; 表示计算期望值.对于生成器G, 目标是, 由于与目标无关, 因此仅需要最大化, 即生成器生成的结果需要成功“误导”判别器的输出结果. 对于判别器, 目标是, 因此需要最大化和最小化, 即判别器需要区分样本是真实样本还是生成样本.构建一个基于SSIM和LSGAN的残差网络进行图像艺术风格化学习. 网络的搭建借鉴了深度残差网络(ResNet)[20]和LSGAN. 其中生成器网络结构包含3个部分: 卷积层、残差块以及转置卷积层, 分别具有不同的卷积步长和模板数, 在对抗训练过程中完成对输入图像内容和目标图像风格特征的提取以及二者之间的融合过程. 判别器网络结构由卷积层构成, 在对抗训练过程中完成对生成样本和真实样本的区分.本研究的图像艺术风格化模型如图1所示, 由2组生成器和判别器构成. 在模型训练学习过程中, 人脸图像经过生成器生成具有素描绘制风格的人脸肖像, 判别器学习正确区分当前作品是否由生成器生成. 同时, 人脸素描图片经过生成器转换为对应现实状态下的人脸图像, 判别器学习正确区分当前图像是否由生成器转换过来. 本模型生成器的网络结构搭建借鉴了He等[20]提出的深度残差网络, 包括3个部分: 前部由3个卷积层构成; 中部由9个残差块构成; 尾部由2个转置卷积层和1个卷积层构成. 除第一层和最后一层卷积层使用了的卷积核, 滑动步长取1, 其余卷积层均采用的卷积核, 滑动步长取2. 生成器与生成器均采用相同的网络结构.图像艺术风格化模型的判别器网络结构是由5个卷积操作组成的深度卷积神经网络. 输入为生成器产生的生成样本和真实样本, 输出为判断结果. 判别器与判别器均采用相同的网络结构. 生成器和判别器的网络结构信息见表1. 由表1可知, 1~25层为生成器, 26~30层为判别器. 生成器除转置卷积操作外, 其余卷积操作之前均采用边缘镜像填充进行补零. 除生成器输出卷积层外, 其余所有卷积操作后都添加一个实例归一化层和ReLU激活函数层, 生成器输出层采用Tanh作为激活函数. 判别器除输出卷积层外, 其余卷积操作后均添加一个实例归一化层和LeakyReLU层. 在判别器中使用LeakyReLU作为激活函数, LeakyReLU是ReLU激活函数的改进版本.在确定模型的目标函数时, 借鉴文献[13]提出的最小二乘生成对抗网络的相关理论, 在生成器和判别器训练过程中生成器试图尽可能“欺骗”判别器, 使判别器误认生成样本为真实样本, 即学习最小化. 同时, 判别器通过不断地学习, 提升识别生成样本与真实样本的能力, 使其对生成样本的评分更低, 真实图评分更高, 即学习最小化和.生成器的损失函数为:判别器的损失函数为:同理, 生成器的损失函数为:同理, 判别器的损失函数为:为了进一步优化GAN的精度, 本文在LSGAN的损失函数的基础上, 在生成器的损失函数中添加重建损失函数作为损失函数的一部分. 为衡量生成器输入图像与其重建图像之间的差异程度, 引入SSIM来量化二者的相似性. 对输入图像与其重建图像的结构相似度定义为:则生成器重建损失函数项为:最终, 生成器的损失函数为:式中用于控制对抗损失项与重建损失项间的相对重要性.Step1 输入图片集X、图片集Y、生成器及其对应参数、判别器及其对应参数、生成器及其对应参数、判别器DX及其对应参数、权重系数、最大循环次数Nepoch、当前迭代次数t、开始减小学习率的回合数Noffset、生成器初始学习率和判别器初始学习率.Step2 随机初始化、、和.Step3 更新迭代次数.Step4 从集合X和Y中采样一张图像, 将其输入到对应的生成器得到相应的生成样本, 对真实样本以及生成样本分别打上1和0标签.Step5 将生成样本输入到对应的生成器, 得到图像的重建图像, 并计算各生成器重建损失.Step6 生成样本与真实样本分别输入判别器, 计算判别器目标函数, 最小化该目标函数, 同时根据误差, 采用误差反传和改进后Adam优化更新判别器的权值; 同理, 对判别器进行权值更新.Step7 对生成器进行优化, 同时最小化生成器目标函数, 同样采取误差反传与改进后的Adam优化更新生成器的权值; 同理, 对生成器进行优化并更新权值.Step8 判断当前迭代次数t与Noffset的大小关系, 然后更新学习率的值.Step9 循环计算Step3至Step 9, 直至达到最大循环次数.将本文提出的方法在2个不同艺术风格的数据集上进行实验, 通过与DualGAN算法[9]、CycleGAN算法[8]、Pix2Pix算法[7]和GAN算法[8]的对比, 验证本文算法的有效性, 并将该方法应用到具有中国特色的水墨画进行风格转换. 在水墨画风格转换实验中, 图片集X采用horse2zebra数据集中马的图片, 图片集Y采用从百度图片爬取的徐悲鸿所绘水墨画马的图片(图2). 利用Python的OpenCV库对爬取到的图片进行预处理, 将所有图片大小裁剪到像素128×128. 同时, 采用数据增强技术对图片集Y中的数据进行扩充. 实验环境为Intel Xeon Silver 4116 2.1GHz CPU, 128G内存, GPU为NVIDIA TITAN XP, 深度学习框架TensorFlow 1.8.0. 采用人脸素描风格数据集sketch-photo和中国水墨画风格数据集beihong-photo进行实验, 其中beihong-photo由宁波大学计算科学与技术研究所收集并创建. sketch-photo和beihong-photo的训练集和测试集包含的样本数量见表2. 本文提出方法基于TensorFlow深度学习框架实现, 使用GPU进行运算加速. 优化算法采用改进后Adam, 生成器初始学习率为0.0002, 判别器初始学习率为0.0001. 前100回合学习率不发生变化, 后100回合学习率开始线性衰减. 最大循环次数Nepoch为200, 重建损失函数项的比重λ为4.图3给出了5组实验在sketch-photo数据集的风格转换结果. 从图3可以发现, GAN算法和Pix2Pix算法生成的素描肖像比较模糊, 尤其在眼睛部位; DualGAN算法在输入图像色系偏暗情况下, 生成的素描肖像不太理想, 出现大片黑块; CycleGAN算法在输入图像佩戴眼镜情况下, 生成的素描肖像在眼镜部分发生了扭曲, 没有将眼镜与眉毛二者之间的细节信息很好地保存. 本文提出的算法能够很好地保留人脸五官细节信息, 同时可以保证生成的素描肖像轮廓不会扭曲.选取Kernel MMD(Maximum Mean Discrepancy, MMD)[21]、Wasserstein距离、FID(Fréchet Inception Distance, FID)[22]以及IS(Inception Score, IS)[23] 4种评价指标, 对本文算法与DualGAN算法、CycleGAN算法在sketch-photo数据集上进行定量评估, 评估结果见表3. Kernel MMD评估指标是在给定核函数下度量了真实分布与生成分布之间的差异; Wasserstein距离评估指标是通过计算Wasserstein距离来区分真实分布与生成分布的差异性; FID是将真实分布与生成分布建模为高斯随机变量, 并计算Fréchet距离来衡量真实分布与生成分布之间的差异性; MMD、Wasserstein距离以及FID指标分别从不同角度来衡量真实分布与生成样本之间的差异性, 值越小模型越好. 从表3可发现, 本文提出的方法能更好地拟合目标数据集的真实样本分布. IS评估指标是计算生成图像在Inception网络中产生的logit响应和边缘分布的KL散度来衡量GAN生成图片的质量以及多样性, 值越大模型越好. 从表3可发现, 本文算法与其他2种方法在该指标上差异不大, IS是评价现实图片与生成图片的区别, 而用在绘画风格上效果不明显.将本文提出方法应用到具有中国特色的水墨画风格转换中, 结果如图4所示. 从图4可发现, 本文算法可以学习到徐悲鸿先生的绘画风格, 尤其在马的鬃毛和马尾等部位的处理.本文结合结构相似性指数和最小二乘生成对抗网络, 提出一种在图像内容特征和风格特征保持平衡的图像艺术风格化算法. 实验结果表明, 在成功训练完一个GAN后, 利用生成器的强大生成能力, 可以获得高质量风格化作品. 下一步将对本模型进行改进, 使得模型能够学习到更加抽象的艺术绘制风格.【相关文献】[1] Lecun Y, Bengio Y, Hinton G. Deep learning[J]. Nature, 2015, 521(7553):436-444.[2] Bengio Y. Learning deep architectures for AI[J]. Foundations and Trends in Machine Learning, 2009, 2(1): 1-55.[3] 曹毅. 基于图像的水墨画绘制方法的研究[D]. 长春: 吉林大学, 2012.[4] Gatys L A, Ecker A S, Bethge M. Image style transfer using convolutional neural networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Communication Society, 2016:2414-2423.[5] Johnson J, Alahi A, Li F F. Perceptual losses for real-time style transfer and super-resolution[C]//European Conference on Computer Vision. Berlin: Springer, 2016:694-711.[6] Ulyanov D, Lebedev V, Vedaldi A, et al. Texture networks: Feed-forward synthesis of textures and stylized images [C]//Proceedings of 33rd International Conference on Machine Learning. New York: ACM, 2016:1349-1357.[7] Isola P, Zhu J Y, Zhou T, et al. Image-to-image translation with conditional adversarial networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Computer Society, 2017: 5967-5976.[8] Zhu J Y, Park T, Isola P, et al. Unpaired Image-to-image translation using cycle-consistent adversarial networks[C]// Proceedings of the IEEE International Conference on Computer Vision. New York: IEEE Computer Society, 2017:2242-2251.[9] Yi Z, Zhang H, Tan P, et al. DualGAN: Unsupervised dual learning for image-to-image translation[C]//IEEE International Conference on Computer Vision. New York: IEEE Computer Society, 2017:2868-2876.[10] 谢志峰, 叶冠桦, 闫淑萁, 等. 基于生成对抗网络的HDR图像风格迁移技术[J]. 上海大学学报(自然科学版), 2018, 24(4):524-534.[11] 林嘉骏, 诸葛晶晶, 张晴. 基于像素级生成对抗网络的复杂场景灰度图彩色化[J]. 计算机辅助设计与图形学学报, 2019, 31(3):439-446.[12] Wang Z, Bovik A C, Sheikh H R, et al. Image quality assessment: From error visibility to structural similarity [J]. IEEE Transactions on Image Processing, 2004, 13(4): 600-612. [13] Mao X, Li Q, Xie H, et al. Least squares generative adversarial networks[C]//IEEE International Conference on Computer Vision. New York: IEEE Computer Society, 2017:2813-2821.[14] Goodfellow I J, Pouget-Abadie J, Mirza M, et al. Generative adversarialnets[C]//Proceedings of the 28th International Conference on Neural Information Processing Systems.Massachusetts: MIT Press, 2014: 2672-2680.[15] Nguyen A, Clune J, Bengio Y, et al. Plug & play generative networks: Conditional iterative generation of images in latent space[C]//IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Computer Society, 2017:3510-3520.[16] Li C, Wand M. Precomputed real-time texture synthesis with markovian generative adversarial networks[C]// European Conference on Computer Vision. Berlin: Springer, 2016:702-716.[17] Ledig C, Theis L, Huszár F, et al. Photo-realistic single image super-resolution using a generative adversarial network[C]//IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Computer Society, 2017:105-114.[18] Zhang H, Xu T, Li H. StackGAN: Text to photo-realistic image synthesis with stacked generative adversarial networks[C]//IEEE International Conference on Computer Vision. New York: IEEE Computer Society, 2017:5908-5916.[19] 王坤峰, 苟超, 段艳杰, 等. 生成式对抗网络GAN的研究进展与展望[J]. 自动化学报, 2017,43(3):321-332.[20] He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]//IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Computer Society, 2016:770-778.[21] Gretton A, Fukumizu K H, Teo C, et al. A kernel method for the two-sample-problem[C]//Advances in Neural Information Processing Systems 19 Proceedings of the 2006 Conference. Massachusetts: MIT Press, 2007:1672- 1678.[22] Heusel M, Ramsauer H, Unterthiner T, et al. GANs trained by a two time-scale update rule converge to a local nash equilibrium[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems.Massachusetts: MIT Press, 2017: 6626-6637.[23] Salimans T, Goodfellow I J, Zaremba W, et al. Improved techniques for training GANs[C]//Proceedings of the 30th International Conference on Neural Information Processing Systems.Massachusetts: MIT Press, 2016: 2232-2242.。

基于改进CycleGAN的图像风格迁移

第27卷第8期 2019年8月

兴 Co旷旷wsQond彳?ig author, E-ma讥:nj

Abstract: Image style transfer exploits a specified style to modify given image content. An automate image style transfer based on a GeneratVeAdversarial Network (GAN) can reduce the workload and yield rich resuIts. In some cases, the pairdata_sets required by the classicalGAN weredifficul to obtain. To overcome the limitations of paired da_tasets by a traditional GAN and improve the efficiency of style transfer, this study proposedan image style ttransfer method based onan improved Cycleconsistent adversaial network (CycleGAN). In this study, the deep residual network adopted by the conventional network generator was replaced by the dense connection convolution network, and a novel loss function composed of the same mapping and perceptual losses was used to measure the style transfer loss. These improvements were shown to increase the network performance, overcome the networks limitations on paired samples, and improve the quality of images generated by style migration. In addition, the stability was further improvedand thenetwork convergence speed was accelerated. Experiments demonstrate that the peak signal-to-noise ratio of the image generated by the proposed method increase 6. 27% on average, where as the structural similarity index measure

基于m-cyclegan实现口罩图像风格迁移

生成对抗网络 渊GAN冤 是 CycleGAN 的基础袁 Cy鄄 cleGAN 网络较其他网络相比具有极高的稳定性和极快 的收敛速度等特点遥 基于 CycleGAN 的网络结构袁 在其 损失函数的基础上增加了面部损失项 Lfa袁 得到了改进后 的 M-CycleGAN袁 其降低了原本 CycleGAN 网络在进行 口罩图像迁移时的全局风险袁 增强了鲁棒性和泛化能力遥 2.1 CycleGAN 的回顾

1 概述 随着近年来人工智能领域的高速发展袁 深度学习被

广泛运用于各个领域袁 同时人工智能也逐渐在多个行业 的应用中开始起到了关键的作用遥 深度学习是学习样本 数据的内在规律和表示层次袁 通过建立多级神经网络的 方式袁 实现对输入信息进行分级表达遥 深度学的本质就 是经过建立尧 模仿人脑的分层构造袁 对外部输入的图 像尧 文本尧 声音等数据进行按层次的特征提取袁 从而达 到解释外部数据的效果遥 与传统学习构造比较袁 深度学 习主要是对结构的深度进行研究与探索袁 其神经网络通 常含有多个隐藏层袁 并且在深度学习中袁 对特征信息的 提取是研究内容的核心袁 神经网络通过对特征信息的按 层次转换达到了最后的分类和回归的目的遥

2020.03 131

基于CycleGAN_的服装图像混搭风格迁移

第31卷㊀第4期2023年7月现代纺织技术AdvancedTextileTechnologyVol.31ꎬNo.4Jul.2023DOI:10.19398∕j.att.202211024基于CycleGAN的服装图像混搭风格迁移王伟珍aꎬbꎬ张㊀功a(大连工业大学ꎬa.服装学院ꎻb.服装人因与智能设计研究中心ꎬ辽宁大连㊀116034)㊀㊀摘㊀要:为解决复杂背景下服装图像的风格迁移形式单一和局部细节失真问题ꎬ提出一种基于CycleGAN的服装图像混搭风格迁移的方法ꎬ用于实现服装款式和图案的多风格迁移ꎮ通过加入分割掩码ꎬ一方面ꎬ对特定区域的风格化形成空间约束ꎬ在判别器中加入谱归一化和引入背景优化损失保留了局部细节的真实度ꎬ实现服装风格款式的风格迁移ꎻ另一方面ꎬ提出图像融合的方式ꎬ将图案融入判别器输出的服装图像中ꎬ实现多风格迁移ꎮ最后ꎬ通过与CycleGAN和InstaGAN比较ꎬ依据生成图像的效果进行主观分析ꎬ使用图像质量评估指标IS和SSIM进行客观评估以验证该方法的有效性ꎮ关键词:混搭风格迁移ꎻ生成对抗网络ꎻ服装款式ꎻ服装图案ꎻ智能设计ꎻ服装设计中图分类号:TS941.26㊀㊀㊀文献标志码:A㊀㊀㊀文章编号:1009 ̄265X(2023)04 ̄0250 ̄09收稿日期:20221111㊀网络出版日期:20230221基金项目:教育部社科规划基金项目(21YJAZH088)ꎻ辽宁省教育厅高校基本科研重点攻关项目(LJKZZ20220069)ꎻ教育部产学协同育人项目(220404211305120)ꎻ辽宁省教育厅项目(1010152)ꎻ中国纺织工业联合会项目(2021BKJGLX321)作者简介:张功(1995 )ꎬ男ꎬ山东滕州人ꎬ硕士研究生ꎬ主要从事服装图像处理方面的研究ꎮ通信作者:王伟珍ꎬE ̄mail:wz ̄wang@foxmail.com㊀㊀应用计算机程序辅助服装设计师进行创作ꎬ已成为服装设计过程中不可或缺的技术手段ꎮ随着消费者对个性化需求的提高ꎬ服装设计师需要更短的时间设计出更加新颖的作品ꎮ此外由于深度学习[1]的兴起ꎬ人工智能与服装设计的融合变得尤为迫切ꎮ尽管人工智能相关技术在时尚领域研究的应用逐步深入ꎬ如服装分类㊁服装检测㊁服装推荐以及虚拟试穿等[2]ꎬ但是针对当前服装辅助智能设计的研究ꎬ服装图像的风格迁移仍然困囿于诸多技术问题ꎮ例如ꎬ服装图像只能完成单一形式(图案或者款式)的风格迁移ꎬ导致生成服装图像的多样性不足ꎬ设计师仍需要耗时耗力地对比不同款式和图案的搭配效果ꎻ生成的服装图像存在着边界伪影问题ꎬ降低了服装图像的质量[3 ̄5]ꎮ因此ꎬ如何利用现有技术在短时间内对服装图像添加多种风格ꎬ生成风格多样㊁效果真实的服装图像ꎬ给予设计师更多设计灵感ꎬ正是其中技术痛点之一ꎮ目前ꎬ风格迁移已成为解决上述技术痛点的着力点之一ꎮ服装风格迁移是将一张图像A的风格和另一张服装图像B的内容结合ꎬ生成同时具有图像A风格和图像B内容的服装图像Cꎮ一种比较前沿的SC ̄FashionG模型于2021年被提出ꎬ该模型将多种样式混合于给定的服装图像中ꎬ并把这种组合称为混搭风格(Mixandmatchstyle)[6]ꎮ在以往的研究中ꎬ人们提出许多方法[7 ̄9]实现风格迁移并将其应用于服装图像的生成ꎬ主要集中于基于图像迭代的神经风格迁移算法和基于模型迭代的生成对抗网络(GenerativeadversarialnetworksꎬGAN)模型ꎮ为解决不同风格对图像语义内容渲染困难的问题ꎬGatys等[10]提出了一种基于VGG(Visualgeometrygroup)的卷积神经网络结构ꎬ创新地将一种内容图像和风格图像结合在一起ꎮ此后ꎬ有学者使用该方法并结合图像分割实现服装局部风格迁移[11]ꎬ但是服装边界容易产生伪影ꎬ使生成的图像显得不自然ꎮLi等[12]提出一种基于WCT(Whiteningandcoloringtransform)的方法ꎮ通过白化原有风格并彩化新风格ꎬ有效的提高了图像生成的质量和艺术效果ꎬ并尝试了多风格迁移ꎬ但是应用于服装中只能改变图案纹理风格ꎬ无法改变款式ꎮ为了使生成数据分布尽可能的逼近真实数据分布ꎬGoodfellow等[13]提出GAN模型ꎮ由于在生成图像和应用在服装设计过程中展现出良好的效率和质量ꎬ很多研究者将注意力转移至GAN模型来实现服装风格迁移ꎮIsola等[14]通过向GAN引入约束条件ꎬ提出pix2pix来进行图像转换ꎬ该方法虽然生成图像的效果自然ꎬ但是需要成对的数据集训练ꎮ为了解决对数据集依赖的问题ꎬZhu等[15]提出CycleGAN在无配对数据集情况下实现了两域之间互相转换ꎬ但是生成的图像缺乏多样性ꎬ很难改变服装的形状ꎬ并且会改变内容域中的背景ꎮ为克服无监督学习中形状转换难以完成的风格迁移问题ꎬMo等[16]结合实例信息ꎬ引入了上下文保留损失ꎬ提出InstaGAN实现了服装款式的转换ꎬ但是在生成图像中局部细节会出现失真ꎬ如腿部皮肤显得不自然ꎮJiang等[6]提出将多种风格混搭在一个服装图像中ꎬ通过分割掩码改变服装中图案的结构ꎬ生成的服装图像颇为新颖ꎬ但是该方法也仅改变服装中图案并且没有人物背景作为参考ꎮ上述方法主要局限包括:单一风格迁移的研究(仅对图案或者服装款式进行风格迁移)ꎬ极大地限制了生成服装图像的多样性ꎻ在带有背景的服装图像中ꎬ容易产生图像局部细节失真的问题ꎮ为了克服上述两大缺陷ꎬ降低自动生成多风格服装图像的难度ꎬ本文基于CycleGAN的结构提出一种服装图像的混搭风格迁移方法ꎮ与以往生成单一风格形式的模型相比ꎬ有三点不同:首先本文提出混搭风格迁移ꎬ即关注于服装款式和服装图案的多风格迁移ꎻ其次ꎬ改进了CycleGAN网络结构用于多风格图像的生成ꎻ最后ꎬ加入了背景优化损失ꎬ结合引入的服装图像二值图ꎬ提升生成图像的质量ꎮ另外ꎬ通过使用图像评估指标IS(IceptionScore)[17]和SSIM(Structuralsimilarity)[18]对CycleGAN和InstaGAN进行比较ꎬ并结合生成的图像效果进行主客观分析ꎬ以验证本文方法的有效性ꎮ1㊀相关理论GAN和CycleGAN都是通过生成器和判别器互相博弈来生成图像ꎬ即通过建立生成器G和判别器D互相博弈来使双方进化ꎮ其两者关系如式(1):㊀minGmaxDLGAN(GꎬD)=Ex~Pdata(x)logD(x)[]+㊀㊀Ez~Pdata(z)log(1-D(G(z)))[](1)式中:z为生成器产生的噪声数据ꎬ服从Pdata(z)的先验分布ꎻx代表真实数据ꎬx服从真实样本分布Pdata(x)ꎮ当D(x)越大ꎬ判别器越能够准确识别出真实样本ꎻ当D(G(z))越小ꎬ则1-D(G(z))越大ꎬ判别器也能增强判别能力ꎬ若固定判别器ꎬ增强生成器生成能力ꎬ判别器会将假数据判别为真ꎬ即D(G(z))增大ꎬ所以有minGmaxDLGAN(GꎬD)ꎮ这种方法虽然能够生成较为逼真的图像ꎬ但是难以保证在风格迁移中生成图像的有效性ꎬ即无法限定生成图像的范围ꎬ保证图像的内容不发生变化ꎮ相较GAN模型ꎬCycleGAN有两大优势ꎬ一方面ꎬCycleGAN包含两个生成器(G和F)和两个判别器(Dx和Dy)ꎬ通过对偶学习[19]方法建立不同域之间的联系ꎬ因此CycleGAN的训练数据集不需要成对ꎻ另一方面ꎬ建立了循环一致性损失ꎬ如式(2):㊀Lcyc(GꎬF)=Ex~Pdata(x)F(G(x))-x)1[]+㊀㊀Ey~Pdata(y)G(F(y))-y1[](2)式中:F(G(x))为生成的重构图像ꎬ与x相似ꎬ下标1为L1范数ꎮF(G(x))重构了源域的图像减少与源域图像的差距ꎬ来弥补了使用GAN风格迁移过程中内容发生变化的缺陷ꎮ加入L1范数防止过拟合出现ꎮ因此ꎬCycleGAN的总损失函数为对抗性损失和循环一致性损失之和ꎬ如式(3):LossGAN=LGAN(GꎬDx)+LGAN(FꎬDy)+ωLcyc(GꎬF)(3)式中:ω为权值ꎬ用于调节该损失的重要性ꎮ2㊀本文方法为实现服装图像的混搭风格迁移ꎬ利用CycleGAN不需要成对训练数据集和风格迁移效果好的优势ꎬ本研究通过结合分割掩码改进CycleGAN网络结构和损失函数ꎬ完成服装图像中下装的几何变换ꎮ同时ꎬ为了将图案更好地融入服装局部ꎬ提出图案融合的方法ꎬ增强图像真实感而非艺术效果ꎬ对服装图像分割后获得的分割掩码与图案按照一定权值融合ꎮ2.1㊀网络结构本文的模型框架如图1所示ꎬHe等[20]提出的Resnet和林泓等[21]使用的PatchGAN分别作为生成器和判别器ꎮ其中ꎬ生成器和判别器各有两个ꎬ分别用GA2B㊁GB2A㊁DA和DB表示ꎮGA2B是将内容域A(长裤)中的风格生成具有风格域A中的风格(裙子)的服装图像ꎬ并使用DB判断GA2B生成图像的真假ꎬ若为真ꎬ则输出具有风格域A风格以及具有内容域A内容的图像(生成图像B)ꎮ同理ꎬGB2A是将风格域152第4期王伟珍等:基于CycleGAN的服装图像混搭风格迁移A(裙子)中的风格转换为内容域A(长裤)中的风格ꎬ并使用DA判断GB2A生成图像的真假ꎬ若为真ꎬ则输出具有内容域A的风格以及具有风格域A内容的服装图像(生成图像A)ꎮ同时ꎬ输入图像与重构图像通过训练会尽可能相似ꎬ体现CycleGAN中循环一致性ꎮ图1㊀本文模型总体框架Fig.1㊀Overviewofourmodel㊀㊀本文的Resnet生成器由下采样块㊁残差块和上采样块组成ꎬ如图2所示ꎮ在下采样块中ꎬ使用实例归一化(IN)在一个通道内作归一化ꎬ计算图像的H∗W的均值ꎬ保持了图像实例的独立性ꎬ加快了模型的收敛ꎮReLU作为激活函数ꎬ降低计算的复杂度ꎬ加快计算速度ꎮ同时ꎬ为了达到更好的训练效果ꎬResnet残差块设置了9层ꎬ保留了卷积层㊁实例归一化和激活层ꎮ此后ꎬ通过上采样块中逆卷积层减少通道数来扩大图像尺寸ꎬ用于生成目标(如裙装)图像ꎮ为了得到更好地生成效果ꎬ模型的PatchGAN判别器由5层卷积层组成ꎬ如图3所示ꎮ与CycleGAN不同的是ꎬ为了规范判别器参数ꎬ让其满足利普茨连续(1 ̄Lipschitzcontinuity)ꎬ卷积层本文在首尾卷积层中采用了谱归一化(SpectralNorm)[22]ꎮ此外ꎬ使用前3层卷积层提取特征后ꎬ后2层卷积层再进行分类ꎬ获得了较好的生成效果ꎮ图2㊀生成器的网络结构Fig.2㊀Networkstructureofthegenerator252 现代纺织技术第31卷图3㊀判别器的网络结构Fig.3㊀Networkstructureofthediscriminator2.2㊀损失函数的设计上述的损失函数虽然能够实现跨类别的图像翻译ꎬ尤其是纹理的风格迁移ꎬ但在几何变换和细节处理方面表现不佳ꎮ本研究更加关注图像转换过程中的上下文衔接ꎬ服装款式(即形状)的风格迁移效果和生成图像中人物背景的肢体的真实感ꎮ为此ꎬ加入了背景优化损失Lbackꎬ如式(4):Lback=ω2f(aꎬbᶄ)☉(x-yᶄ)1+ω3NðNn=1ð3c=1(G(x)-x)-(y-F(y))1(4)式中:x代表内容域图像ꎬa代表内容域掩码选中区域ꎬyᶄ代表内容域图像转换后的图像ꎬbᶄ代表内容域被转换后的掩码迭中区域ꎬω2和ω3分别作为调整内容保留和肤色显示的权重ꎬN代表转换区域内的像素数ꎬc为通道数ꎮ设实例为0ꎬ背景为1时ꎬ则f=aɣb为可转换状态ꎬ实现了实例的转换和背景的保留ꎮ由于边缘区域的细节要比中心区域复杂ꎬω2的权重值由中心向边缘逐渐增加ꎮ此外ꎬ为了弥补转换过程中转换区域形状纹理会发生的差异性变化ꎬ如长裤转换为短裤后ꎬ腿部存在仍然保留着部分长裤纹理的问题ꎮ本研究将生成器G生成的图像(如短裤风格图像)和内容域x(如长裤风格图像)的差异值与风格域(如短裤风格图像)和生成器F(如生成的长裤风格图像)的差异值作差ꎬ通过训练不断缩小差距ꎬ使人物腿部细节更加真实ꎮ其中ꎬω3为超参数ꎮ因此ꎬ本文所提方法的总损失为式(5):Ltotal=γ1LLSGAN+γ2Lcyc+γ3Lback(5)式中:γi(i=1~3)为超参数ꎮ尽管在风格迁移中ꎬ尤其是艺术领域ꎬ大部分使用神经网络来完成ꎬ并获得了较好的艺术风格图像ꎮ但是对于服装的图案纹理迁移ꎬ使用神经网络来完成并不理想或者说过于艺术ꎬ缺乏真实感ꎮ然而ꎬ本文提出一种图案融合方式ꎬ通过mask将服装与处理后的图案按一定比例进行融合ꎬ使图案纹理能够较好的在服装中展示ꎬ获得了较为新颖的服装图像ꎬ如式(6):Imer=(Iori-t1∗Iseg)+t2∗Ipat∗Imask(6)式中:Iori为原始的服装图像ꎬIseg为分割后所要融合的服装局部ꎬIpat为所要融合的图案ꎬImask为所要融合的服装局部的掩码ꎬt1为保留原始服装局部纹理的比例ꎬt2为融合图案纹理的比例ꎬ且t1+t2ʈ1ꎮ3㊀结果与分析3.1㊀数据集与实验细节本文所使用的数据集包含两部分:服装协同数据集[23](Clothingco ̄parsingdatasetꎬCCP)和自建数据集ꎮCCP共有2098张高分辨率时尚街头图像ꎬ所有图像带有图像级注释ꎬ里面有各种款式㊁配饰㊁服装和姿势ꎬ共有59个标签ꎮ自建数据集共有3000张图像ꎮ其中ꎬ长裤图像1000张ꎬ短裤图像1000张以及短裙图像1000张ꎮ增加自建数据集是对CCP的补充ꎬ增加训练数据为了更有针对性地完成服装款式的转换ꎬ获得更好的风格迁移效果ꎮ实验环境与模型训练:CUDA11.3ꎬcuDNN8ꎬUbuntu18.04系统ꎬPytorch1.10深度学习框架ꎬPython3.8程序语言ꎬNVIDIAGeForceRTX3090显存24GB的显卡ꎮ共训练了500轮ꎬ训练过程中损失的变化如图4所示ꎮ由于在训练200轮次后损失下降幅度减小甚至难以继续下降ꎬ因此ꎬ选择了200轮次的预训练模型进行测试ꎮ3.2㊀实验细节本文主要针对服装图像进行款式和图案纹理的风格迁移ꎮ在实验中ꎬ一方面将风格域A中的服装样式(短裤或者裙子)迁移至内容域的下装ꎬ并将风352第4期王伟珍等:基于CycleGAN的服装图像混搭风格迁移格域B的图案纹理迁移至内容域的上装ꎻ另一方面通过选择有人物背景的作为内容域ꎬ在风格迁移后ꎬ通过人物背景作为参考ꎬ可以更加直观展示风格迁移效果ꎬ如不同图案款式对不同人群搭配的适应性ꎮ如图5(a)所示ꎬ前两行展示的是将内容域中长裤的形状转换为与风格域A中短裤相似的样式ꎮ同理ꎬ后面两行图像是将长裤转换为裙子ꎬ并将风格域中的图案纹理分别融合在上装和下装中ꎮ不管是样式形状迁移还是图案纹理迁移ꎬ都获得了较好的生成效果ꎮ值得注意的是ꎬ转换所生成的裙子的色彩与风格域A无关ꎬ与输入的内容域有关ꎬ如内容域中服装色彩较深的往往转换为颜色较深的服装款式ꎮ风格域A所展示的图像仅仅只是一种样式(如裙子的样式)的代表ꎬ并非单个样式形状迁移ꎮ此外ꎬ在完成款式风格迁移后还可将对上装和下装同时进行图案的风格迁移ꎬ由图5(b)可见ꎬ将风格A㊁风格B和风格C的3种风格混搭在同一张服装图像中ꎬ生成了效果真实㊁新颖独特的服装图像ꎮ当然ꎬ这还需要根据不同图案来设置好式(6)中的参数ꎮ图4㊀训练过程中损失函数的变化情况Fig.4㊀Changesinthelossfunctionduringtraining图5㊀服装图像混搭风格迁移Fig.5㊀Demonstrationofmixandmatchstyletransferofclothingimages452 现代纺织技术第31卷3.3㊀多模型效果比较与评估为了验证本文方法在款式风格迁移的有效性ꎬ将本文基于CycleGAN所提的方法与CycleGAN和InstaGAN进行主客观的比较与分析ꎬ包括在相同数据集上不同方法生成的图像效果㊁图像生成指标IS和图像质量评估指标SSIMꎮa)主观比较与分析由图6所示ꎬ从测试效果角度来讲ꎬCycleGAN并没有改变服装的形状ꎬ而是对服装的色彩略有影响ꎬInstaGAN明显改变了服装的形状ꎬ但是处理其他服装图像尤其是浅色服装时ꎬ生成的图像中服装并不清晰ꎬ并且生成的人物肢体显得不自然(如第一行中生成人物的腿部皮肤不够接近肤色ꎬ第三行人物与背景拟合较差)ꎮ相比较之下ꎬ本文的模型生成的服装效果更好ꎬ更加自然ꎮb)客观评价指标分析衡量风格迁移过程中不同模型生成的质量是困难的ꎬ缺乏客观统一标准的评估[24]ꎬ尤其是设计美学方面ꎬ往往带有主观性ꎮ为了检验生成图像的质量和图像中的多样性ꎬ本文参考了图像生成的评价指标和其他计算机视觉方面的评价指标ꎬ选择了IS和SSIM分别对CycleGAN㊁InstaGAN和本文方法进行评估和对比ꎮ图6㊀服装款式风格迁移效果对比Fig.6㊀Comparisonoftheclothingstyletransfereffects㊀㊀IS是对生成图像的清晰度和多样性衡量ꎬ如式(7):IS(G)=exp(Ex~PgDKL(p(y|x)p(y)))(7)式中:对于p(y|x)log(p(y|x))ꎬ熵值越小表明数据分布越集中ꎬ则图像具有较好的清晰度ꎻ对于p(y)log(y)ꎬ熵值越大ꎬ表明图像种类越多ꎬ则生成的图像具有很好的多样性ꎮ因此ꎬIS分数为边缘分布p(y)和条件分布p(y|x)的KL散度的期望ꎬ即给定一个生成图像xꎬ类别信息y的不确定性的减少程度ꎮIS虽然一定程度能够衡量生成图像的清晰度和多样性ꎬ但是没有侧重点ꎮ为了评估的客观性ꎬ本文引入一种衡量两幅图像相似度的SSIM指标[25]ꎬ通过感知的模型ꎬ评价图像质量上更加贴近于人类视觉特性ꎮ如式(8):552 第4期王伟珍等:基于CycleGAN的服装图像混搭风格迁移SSIM(xꎬy)=(2uxuy+c1)(2σxy+c2)(u2x+u2y+c1)(σ2x+σ2y+c2)(8)式中:x代表风格图像ꎬy代表生成图像ꎮux是x的平均值ꎬσ2x是x的方差ꎬuy是y的平均值ꎬσ2y是y的方差ꎬσxy是x和y的协方差ꎬc1和c2是两个用于维持稳定的常数ꎬ避免出现除零的情况ꎮ因此ꎬSSIM越接近1ꎬ表明风格图像与生成图像越相近[26]ꎮ为了进行更为直观的对比分析ꎬ对IS和SSIM数据进行了归一化ꎮ如表1所示ꎬ本文模型的IS值和SSIM值都高于其他模型ꎬ表明了生成服装图像的真实感和多样性要优于其他模型ꎮ针对长裤向短裤的款式风格迁移ꎬ由IS值可知ꎬCycleGAN虽然难以改变服装款式ꎬ但是在生成图像清晰度上要比InstaGAN要好ꎬ而代表多样性的SSIM值偏低ꎻ针对长裤向短裙的款式风格迁移ꎬ虽然SSIM值远大于CycleGAN和InstaGANꎬ但是IS值却与CycleGAN相近ꎬ表明本文模型在生成图像多样性方面占优ꎬ在转换为裙子款式风格迁移后生成的图像清晰度还需要提高ꎮ表1㊀生成图像评估数据Tab.1㊀Evaluationdataofthegeneratedimages长裤ң短裤ISSSIM长裤ң裙子ISSSIMCycleGAN0.3200.1880.3460.129InstaGAN0.2670.3890.3030.357本文模型0.4030.4230.3510.514综上数据和视觉效果比较ꎬ与前文所述经典模型CycleGAN和InstaGAN不同的是ꎬ本文模型将服装款式和图案共同作用于服装图像中ꎬ克服服装图像风格迁移的单调性ꎬ形成了不同服装款式和图案的混搭ꎮ此外ꎬ本研究受比较前沿的混搭风格模型SC ̄FashionG启发ꎬ也通过加入分割掩码形成对服装局部的空间约束ꎬ并将多种风格作用于同一服装图像中ꎬ但又与该模型有显著差异:SC ̄FashionG模型使用了无背景的服装图像ꎬ而本研究使用的服装图像带有人物背景ꎻSC ̄FashionG模型使用分割掩码对服装内部纹理进行改变以实现服装图案的多样性ꎬ而本研究使用分割掩码作用于服装外部边缘来改变服装的款式和图案以增加生成图像的多样性ꎮ4㊀结㊀语本文提出一种混搭风格迁移的方法ꎬ解决了生成服装图像风格形式单一以及背景细节失真的问题ꎬ通过主观比较和客观评估分析ꎬ表明本文方法在多风格迁移任务中的有效性ꎮ其中ꎬ多风格主要包括了服装下装的款式风格和图案风格ꎮ一方面ꎬ针对服装款式的风格迁移ꎬ使用了图像分割掩码ꎬ引导和约束风格迁移对特定区域风格化ꎬ引入背景优化损失ꎬ用于保留背景和建立腿部肤色相似性ꎬ在判别器中加入谱归一化SN用于特性提取和分类任务中ꎬ优化背景细节纹理ꎻ另一方面ꎬ提出风格融合方式ꎬ按照权值使图案在服装中展示出来ꎮ最后ꎬ通过与CycleGAN和InstaGAN比较分析ꎬ本文采用的方法得到了较高的评价ꎮ在此次辅助智能设计的实践中ꎬ虽然获得了有效的结果ꎬ但也存在着一些不足ꎮ如对输入的内容图像分辨率要求较高ꎬ将长裤转换为裙子的成功率相对偏低ꎬ后期将继续提升模型的泛化能力ꎬ并注重生成过程中服装图像的情感元素[27]ꎬ以推进计算思维与设计思维的融合ꎮ参考文献:[1]LECUNYꎬBENGIOYꎬHINTONG.Deeplearning[J].Natureꎬ2015ꎬ521(7553):436 ̄444.[2]CHENGWHꎬSONGSJꎬCHENCYꎬetal.Fashionmeetscomputervision:Asurvey[J].ACMComputingSurveysꎬ2022ꎬ54(4):1 ̄41.[3]施倩ꎬ罗戎蕾.基于生成对抗网络的服装图像生成研究进展[J].现代纺织技术ꎬ2022ꎬ31(2):36 ̄46.SHIQianꎬLUORonglei.Researchprogressofclothingimagegenerationbasedongenerativeadversarialnetworks[J].AdvancedTextileTechnologyꎬ2022ꎬ31(2):36 ̄46.[4]CHENHꎬLEISꎬZHANGSGꎬetal.Man ̄algorithmcooperationintelligentdesignofclothingproductsinmultilinks[J].FibresandTextilesinEasternEuropeꎬ2022ꎬ30(1):59 ̄66.[5]赵梦如.人工智能在服装款式设计领域的应用进展[J].纺织导报ꎬ2021(12):74 ̄77.ZHAOMengru.Applicationprogressofartificialintelligenceinclothingstyledesign[J].ChinaTextileLeaderꎬ2021(12):74 ̄77.[6]JIANGSꎬLIJꎬFUY.Deeplearningforfashionstylegeneration[J].IEEETransactionsonNeuralNetworksandLearningSystemsꎬ2022ꎬ33(9):4538 ̄4550.[7]唐稔为ꎬ刘启和ꎬ谭浩.神经风格迁移模型综述[J].计算机工程与应用ꎬ2021ꎬ57(19):32 ̄43.TANGRenweiꎬLIUQiheꎬTANHao.Reviewofneuralstyletransfermodels[J].ComputerEngineeringand652 现代纺织技术第31卷Applicationsꎬ2021ꎬ57(19):32 ̄44.[8]JINGYCꎬYANGYZꎬFENGZLꎬetal.Neuralstyletransfer:Areview[J].IEEETransactionsonVisualizationandComputerGraphicsꎬ2020ꎬ26(11):3365 ̄3385. [9]MODꎬZOUXꎬWONGWK.Neuralstylist:Towardsonlinestylingservice[J].ExpertSystemswithApplicationsꎬ2022ꎬ203:117333.[10]GATYSLꎬECKERAꎬBETHGEM.Aneuralalgorithmofartisticstyle[J].JournalofVisionꎬ2016ꎬ16(12):356. [11]WANGHYꎬXIONGHTꎬCAIYY.ImagelocalizedstyletransfertodesignclothesbasedonCNNandinteractivesegmentation[J].ComputationalIntelligenceandNeuroscienceꎬ2020ꎬ2020:8894309.[12]LIYJꎬFANGCꎬYANGJMꎬetal.Universalstyletransferviafeaturetransforms[C]∕∕Proceedingsofthe31stInternationalConferenceonNeuralInformationProcessingSystems.LongBeachꎬCaliforniaꎬUSA.NewYork:ACMꎬ2017:385 ̄395.[13]GOODFELLOWIꎬPOUGET ̄ABADIEJꎬMIRZAMBꎬetal.Generativeadversarialnets[C]∕∕Proceedingsofthe27thInternationalConferenceonNeuralInformationProcessingSystems:Volume2.MontrealꎬCanada.NewYork:ACMꎬ2014:2672 ̄2680.[14]ISOLAPꎬZHUJYꎬZHOUTꎬetal.Image ̄to ̄imagetranslationwithconditionaladversarialnetworks[C]∕∕IEEEConferenceonComputerVisionandPatternRecognition(CVPR).HonoluluꎬHIꎬUSA.IEEEꎬ2017:5967 ̄5976.[15]ZHUJYꎬPARKTꎬISOLAPꎬetal.Unpairedimage ̄to ̄imagetranslationusingcycle ̄consistentadversarialnetworks[C]∕∕IEEEInternationalConferenceonComputerVision(ICCV).VeniceꎬItaly.IEEEꎬ2017:2242 ̄2251. [16]MOSꎬCHOMꎬSHINJ.InstaGAN:Instance ̄awareImage ̄to ̄ImageTranslation[J].ArXivꎬ2018:1812.10889.https:∕∕arxiv.org∕abs∕1812.10889.[17]SALIMANSTꎬGOODFELLOWIꎬZAREMBAWꎬetal.ImprovedtechniquesfortrainingGANs[C]∕∕Proceedingsofthe30thInternationalConferenceonNeuralInformationProcessingSystems.BarcelonaꎬSpain.NewYork:ACMꎬ2016:2234 ̄2242.[18]WANGZꎬBOVIKACꎬSHEIKHHRꎬetal.Imagequalityassessment:fromerrorvisibilitytostructuralsimilarity[J].IEEETransactionsonImageProcessing:aPublicationoftheIEEESignalProcessingSocietyꎬ2004ꎬ13(4):600 ̄612.[19]YIZꎬZHANGHꎬTANPꎬetal.DualGAN:Unsupervisedduallearningforimage ̄to ̄imagetranslation[C]∕∕ProceedingsoftheIEEEInternationalConferenceonComputerVision(ICCV).VeniceꎬItaly.IEEEꎬ2017:2868 ̄2876.[20]HEKMꎬZHANGXYꎬRENSQꎬetal.Deepresiduallearningforimagerecognition[C]∕∕IEEEConferenceonComputerVisionandPatternRecognition(CVPR).LasVegasꎬNVꎬUSA.IEEEꎬ2016:770 ̄778.[21]林泓ꎬ任硕ꎬ杨益ꎬ等.融合自注意力机制和相对鉴别的无监督图像翻译[J].自动化学报ꎬ2021ꎬ47(9):2226 ̄2237.LINHongꎬRENShuoꎬYANGYiꎬetal.Unsupervisedimage ̄to ̄imagetranslationwithself ̄attentionandrelativisticdiscriminatoradversarialnetworks[J].ACTAAutomaticaSinicaꎬ2021ꎬ47(9):2226 ̄2237. [22]GULRAJANIIꎬAHMEDFꎬARJOVSKYMꎬetal.Improvedtrainingofwassersteingans[J].ArXivꎬ2017:1704.00028.https:∕∕arxiv.org∕abs∕1704.00028. [23]LIANGXDꎬLINLꎬYANGWꎬetal.ClothesCo ̄parsingviajointimagesegmentationandlabelingwithapplicationtoclothingretrieval[J].IEEETransactionsonMultimediaꎬ2016ꎬ18(6):1175 ̄1186.[24]陈淮源ꎬ张广驰ꎬ陈高ꎬ等.基于深度学习的图像风格迁移研究进展[J].计算机工程与应用ꎬ2021ꎬ57(11):37 ̄45.CHENHuaiyuanꎬZHANGGuangchiꎬCHENGaoꎬetal.Researchprogressofimagestyletransferbasedondepthlearning[J].ComputerEngineeringandApplicationsꎬ2021ꎬ57(11):37 ̄45.[25]李敏ꎬ刘冰清ꎬ彭庆龙ꎬ等.基于CycleGAN算法的迷彩服装图案设计方法研究[J].丝绸ꎬ2022ꎬ59(8):100 ̄106.LIMinꎬLIUBingqingꎬPENGQinglongꎬetal.AcamouflagesuitpatterndesignbasedontheCycleGANalgorithm[J].JournalofSilkꎬ2022ꎬ59(8):100 ̄106. [26]曾宪华ꎬ陆宇喆ꎬ童世玥ꎬ等.结合马尔科夫场和格拉姆矩阵特征的写实类图像风格迁移[J].南京大学学报(自然科学)ꎬ2021ꎬ57(1):1 ̄9.ZENGXianhuaꎬLUYuzheꎬTONGShiyueꎬetal.PhotorealismstyletransfercombiningMRFs ̄basedandgram ̄basedfeatures[J].JournalofNanjingUniversity(NaturalScience)ꎬ2021ꎬ57(1):1 ̄9.[27]QUINONP.Engineeredemotions[J].Scienceꎬ2017ꎬ358(6364):729.752第4期王伟珍等:基于CycleGAN的服装图像混搭风格迁移852 现代纺织技术第31卷MixandmatchstyletransferfortheimagesofclotheswithCycleGANWANGWeizhenaꎬbꎬZHANGGonga(a.SchoolofFashionꎻb.ClothingHumanFactorsandIntelligentDesignResearchCenterꎬDalianPolytechnicUniversityꎬDalian116034ꎬChina)Abstract:WiththecontinuousintegrationofartificialintelligenceAI technologyandthefashionfield theuseofstyletransfertechnologytogeneratenewimageshasbecomeoneoftheresearchhotspotsofaidedintelligentclothingdesign.However theuseofcurrentstyletransfertechnologyintheprocessofaidedintelligentdesignstillhasgreatlimitations.Onlycompletingthetransferofasinglestylelimitsthediversityofgeneratedclothingimages andthedetaildistortionoftheclothingimagewiththecharacterbackgroundreducestheauthenticityofthegeneratedclothingimages.Aimingatsolvingtheproblemsoftheundiversifiedtransferformandlocaldetaildistortionofclothingimagestylesincomplicatedconditions amethodofclothingimagemixingandmatchingstyletransferwasproposedtorealizethemulti ̄styletransferofclothingstylesandpatterns.Duringtheexperiment wetookCycleGANasthebaselinemodel withtheadvantageofimprovingtheeffectofstyletransferwithoutrequiringpairwisetrainingandcyclicconsistencyloss usedResnetgeneratorandPatchGANdiscriminatorfortraining andintroducedthesegmentationmask.Ontheonehand spatialconstraintswereformedforthestylizationofspecificareas instancenormalizationwasaddedtothediscriminatortomaintaintheindependenceofimageinstances spectralnormalizationwasaddedtothefirstandlastlayersoftheconvolutionlayertoenhancetheclassificationabilityofthenetwork andbackgroundoptimizationlosswasaddedtooptimizethelocaldetailsofthegeneratedimages especiallytheboundaryartifacts whichjointlypromotedthegenerationeffectandrealizedthestyletransferofclothingstyles.Ontheotherhand themethodofimagefusionwasproposed.Accordingtothepatternfusionmappingrelationship thepatternwasintegratedintotheclothingimageoutputbythediscriminatortorealizethemulti ̄styletransferofclothingstylesandpatterns.Inordertoverifytheeffectivenessoftheabovemethodinthemulti ̄styletransferofclothingimages theclothingimagedesignsketchesgeneratedintheexperimentwerecomparedwiththedesignsketchesgeneratedbyCycleGANandInstaGANmodels.Bysubjectivelyanalyzingthestylediversityanddetaildifferencesofthedesignsketches theISandSSIMwereusedforquantitativeanalysis andthesubjectivevisualeffectandobjectivenumericalcomparisonbothshowedtheadvantagesofthisexperimentalmethodinthediversityandtheauthenticityofimagedetails.Themulti ̄styletransferofclothingstylesandpatternscanprovidedesignerswithcreativeinspirationandshortenthetimeperiodrequiredforeffectpresentation makingAImoresuitableforassistingclothingdesignbehavior.Insubsequentexperiments wewillexplorethetransferofmoretypesofclothingstyles soastoachieveadiversifiedandcontrollablestyletransfermethod.Inaddition emotionalelementsneededforperceptualdesignshouldbeaddedintheprocessofimagestyletransfer soastopromotetheintegrationofcomputationalthinkinganddesignthinkingoffuture ̄orienteddesignparadigm.Keywords:mixandmatchstyletransfer generativeadversarialnetwork clothingstyle clothingpattern intelligentdesign clothingdesign。

基于改进DeepLabv3+与CycleGAN的图像风格迁移研究司

图1CycleGan 迁移图Vol.40No.4Apr.2024赤峰学院学报(自然科学版)Journal of Chifeng University (Natural Science Edition)第40卷第4期2024年4月近年来,机器学习、深度学习等技术在许多领域都取得了突破性进展,尤其是深度学习的持续迭代,已具备了强大的感知、识别、理解人类话语的能力。

像GhatGPT 等最近在社会上成为一个令人兴奋的话题,甚至超越了人工智能和计算机科学领域。

风格转换是这方面的一项热门任务,旨在将参考图像的颜色和纹理等风格模式应用于给定的内容图像,同时保留内容的语义结构。

这种技术在许多领域中已得到应用,包括但不限于图像编辑,域适配,以及领域泛化等[1]。

在深度学习时代,2015年Gatys 等人[2]开创性地引入了以迭代的方式最小化VGG 特征空间中的内容和风格损失,利用Gram 矩阵实现对图像任意风格特征进行提取,产生了极佳的效果,但对于每种内容风格的在线优化计算开销很大。

为了缓解这个问题,Johnson 等人[3]建议优化前馈网络以实现风格转换,实现了实时的风格迁移,一旦被训练,网络可以实时地对任何输入内容图像进行风格转换,对于单个网络来说,在推断期间将任何样式的参考图像传送到内容图像都是可行的,它们被称为任意风格转换方法,已成为风格转换研究的主流。

2017年,Zhu 等人[4]继续提出一种无监督对抗网络Cycle⁃GAN,为实现双向的域转换,使用两对生成对抗网络,通过引入循环一致性损失使域之间的配对约束被消除,能更好地保留图像的内容属性。

2021年,Liu 等人[5]提出自适应注意力归一化AdaAttN(Adaptive Attention Normalization),在计算注意力权重时考虑到了浅层和深层的特征,以基于每点的方式使内容特征与风格特征的注意力加权均值和方差对齐,另外使用局部特征损失来帮助模型提升迁移质量。

基于生成对抗网络的图像风格迁移

基于生成对抗网络的图像风格迁移图像风格迁移是计算机视觉领域中一个备受关注的研究方向,它的目标是将一幅图像的风格迁移到另一幅图像上,从而生成具有新颖艺术风格的图片。

在过去几年中,基于生成对抗网络(GANs)的图像风格迁移方法取得了显著的进展。

GANs是一种由生成器和判别器组成的神经网络框架,通过对抗性训练来生成逼真的假样本。

本文将深入研究基于GANs的图像风格迁移方法,并探讨其在计算机视觉和艺术创作领域中的应用。

首先,我们将介绍传统图像风格迁移方法与基于GANs的方法之间存在的差异。

传统方法通常基于优化算法,通过最小化输入图片与目标图片之间特定特征之间差异来实现风格转换。

然而,这些方法往往需要大量计算资源和时间,并且结果可能不够逼真。

相比之下,基于GANs 的方法通过对抗性训练来学习输入图片与目标图片之间复杂而非线性关系,并且能够生成更加逼真和高质量的风格迁移结果。

接下来,我们将详细介绍基于GANs的图像风格迁移方法的基本原理和框架。

在这种方法中,生成器和判别器分别扮演着两个对抗性角色。

生成器负责将输入图片转换为目标风格,而判别器则负责判断生成图片与真实图片之间的差异。

通过对抗性训练,生成器和判别器不断优化自己的参数,以使得生成图片更加逼真,并且能够欺骗判别器。

然后,我们将介绍一些经典的基于GANs的图像风格迁移方法。

其中最著名且广泛使用的是CycleGAN和StarGAN。

CycleGAN通过引入循环一致性损失来实现单向图像转换,并且能够在没有配对训练数据的情况下进行风格迁移。

StarGAN则通过引入条件生成模块来实现多个不同风格之间的转换,并且能够在单个网络中学习多个目标域。

接着,我们将探讨基于GANs 的图像风格迁移方法在计算机视觉领域中的应用。

这些应用包括图像编辑、图像合成、目标识别等等。

通过将不同风格的图片转换为特定风格,我们可以实现图像编辑的目的,例如将一张普通照片转换为油画风格的图片。

基于深度生成模型的图像风格迁移算法研究

基于深度生成模型的图像风格迁移算法研究随着人工智能的快速发展,图像风格迁移成为计算机视觉领域一个备受瞩目的研究方向。

传统的图像风格迁移方法通常依赖于手工提取特征以及设计复杂的优化算法,这些方法存在着计算复杂度高、操作繁琐以及风格迁移效果不尽如人意等问题。

而基于深度生成模型的图像风格迁移算法则能够通过学习大量的图像数据,在保留内容信息的基础上,将输入图像的风格转换成指定的目标风格。

本篇文章将从深度生成模型的基本原理、常见的深度生成模型算法以及图像风格迁移算法的研究进展等方面进行探讨。

深度生成模型指的是一类能够对潜在变量进行建模的机器学习模型,主要包括生成对抗网络(GAN)和变分自编码器(VAE)。

这些模型基于神经网络结构,通过学习大量的训练样本,可以生成具有相同分布的样本。

其中,GAN模型由生成器和判别器两部分组成,生成器负责生成样本,而判别器则负责将生成的样本与真实样本区分开来。

GAN模型通过不断地迭代训练,使得生成器生成的样本与真实样本越来越接近,从而达到生成高质量样本的目的。

而VAE模型则利用潜在变量来表示样本的特征,并通过最大化观测样本与生成样本之间的似然性来训练模型。

这些深度生成模型的出现为图像风格迁移提供了理论基础和研究思路。

对于图像风格迁移任务来说,常见的深度生成模型算法有CycleGAN、StarGAN、MSG-Net等。

CycleGAN是一种无监督的图像风格迁移算法,它通过学习两个领域之间的映射关系,实现了风格的转换。

CycleGAN采用了循环一致性损失函数,用于保持输入图像和重构图像之间的一致性。

StarGAN则是一种多领域图像风格转换算法,它不仅可以实现单向的风格转换,还可以实现多个领域之间的任意转换。

MSG-Net是一种基于多尺度感知的图像风格迁移算法,它通过引入多尺度的风格特征来提高风格迁移的质量和速度。

除了这些经典的深度生成模型算法之外,还有一些研究者提出了一些改进的方法。

基于深度学习的图像风格迁移技术研究与实现

基于深度学习的图像风格迁移技术研究与实现近年来,随着深度学习技术的发展,图像风格迁移(Image Style Transfer)成为热门研究领域。

该技术可以将一幅图像的风格转移到另一幅图像上,创造出独特且艺术感强的图像。

在本文中,我们将探讨基于深度学习的图像风格迁移技术的研究与实现。

首先,我们将介绍图像风格迁移的背景与意义。

图像风格迁移技术使得用户可以通过改变图像的风格,创造出与众不同的艺术作品。

例如,将一幅写实主义的画作风格应用到一张风景照片上,可以得到一幅结合了写实与抽象风格的图像。

这种技术不仅能提供娱乐性的应用,还可以用于电影特效、游戏设计等领域。

接下来,我们将讨论基于深度学习的图像风格迁移技术的关键内容与方法。

首先我们将介绍深度学习的基本原理与概念,包括神经网络、卷积神经网络(CNN)和生成对抗网络(GAN)。

这些技术可以帮助我们提取图像的特征、理解图像的内容和风格,并生成新的具有艺术风格的图像。

然后,我们将讨论图像风格迁移的两种主要方法:基于优化的方法和基于神经网络的方法。

基于优化的方法通过定义损失函数,并以最小化损失函数的方式来实现图像风格迁移。

这种方法的代表是Gatys等人提出的Neural Style Transfer算法,它利用预训练的卷积神经网络提取图像的内容和风格特征,并通过最小化内容损失和风格损失来生成新的图像。

基于神经网络的方法则是利用生成对抗网络(GAN)来进行图像风格迁移。

GAN由生成器和判别器组成,生成器用于生成迁移后的图像,判别器用于判断生成的图像与目标风格是否一致。

这种方法的代表是CycleGAN,它可以实现不同风格之间的双向转换,而无需配对数据。

通过训练一个生成器来实现图像的风格迁移,可以得到更加自然、逼真的结果。

接着,我们将讨论图像风格迁移技术的应用与挑战。

图像风格迁移技术已经被广泛应用于各种领域,例如艺术创作、电影特效、游戏设计、虚拟现实等。

然而,该技术还面临着一些挑战,如图像内容与风格的平衡、图像细节的保留等。

如何利用生成式对抗网络进行风格迁移的实用技巧(Ⅰ)

生成式对抗网络(GAN)是一种深度学习模型,由两个独立的神经网络组成:生成器和判别器。

生成器负责生成与输入数据相似的新数据,而判别器则负责区分生成的数据和真实的数据。

通过不断的训练和竞争,生成器和判别器可以相互提升,最终生成高质量的假数据。

风格迁移是一种应用生成式对抗网络的常见技术,它可以将一种图像的风格应用到另一种图像上。

在本文中,我们将探讨如何利用生成式对抗网络进行风格迁移的实用技巧。

首先,对于风格迁移任务,选择合适的GAN架构非常重要。

目前最流行的GAN架构之一是CycleGAN,它专门用于无监督图像转换任务,包括风格迁移。

CycleGAN具有两个生成器和两个判别器,能够实现两个域之间的相互转换。

另一个常用的GAN架构是StarGAN,它可以实现多个域之间的图像转换,适用于更复杂的风格迁移任务。

选择合适的GAN架构可以为风格迁移任务奠定良好的基础。

其次,对于风格迁移任务,数据集的选择和准备也至关重要。

在训练生成式对抗网络时,我们需要大量的带标签数据来训练模型。

对于风格迁移任务,通常需要准备包含不同风格的图像数据集。

这些数据集可以是包含不同风格的自然图像,也可以是包含不同艺术风格的绘画作品。

通过精心挑选和准备数据集,可以提高生成式对抗网络在风格迁移任务中的表现。

另外,对于风格迁移任务,损失函数的设计和优化方法也是至关重要的。

在生成式对抗网络中,常用的损失函数包括对抗性损失、内容损失和风格损失。

对抗性损失用于促使生成器生成逼真的假数据,内容损失用于保持生成数据与输入数据的内容信息一致,而风格损失用于保持生成数据与输入数据的风格信息一致。

此外,优化方法也对生成式对抗网络的训练效果有重要影响。

常用的优化方法包括随机梯度下降(SGD)、Adam优化器等。

通过合适的损失函数设计和优化方法选择,可以提高生成式对抗网络在风格迁移任务中的性能。

此外,对于风格迁移任务,还可以通过迁移学习和增强学习等方法来进一步提高生成式对抗网络的性能。

基于CycleGAN和时频分析的艺术图像风格转换

基于CycleGAN和时频分析的艺术图像风格转换作者:李莉吴菲来源:《计算机时代》2020年第12期摘; 要:为了满足普通人群对艺术创作的需求,降低艺术创作的门槛极为重要,进行摄影作品的图像风格转换便是方法之一。

通过对特定风格的图像做傅里叶变换,得到频谱图,随后对频谱图进行预处理。

通过CycleGAN对频谱图进行图像风格迁移,再通过傅里叶逆变换将风格迁移后的频谱图转换为图片。

实验结果表明,该方法能够更快地收敛且具有更好的风格迁移能力。

关键词:风格迁移; 生成对抗网络; 图片处理; 表征学习中图分类号:TP-183; ; ; ; ; 文献标识码:A; ; ;文章编号:1006-8228(2020)12-41-06Abstract: In order to meet the needs of ordinary people for artistic creation, it is extremely important to lower the threshold of artistic creation. One of the methods is to transform the image style of photographic works. In this paper, the spectrogram is obtained by performing Fourier transform on the image of a specific style, and then the spectrogram is preprocessed. CycleGAN is used to transfer the image style, and then the style transferred spectrogram is converted into a picture by inverse Fourier transform. The experiment results show that this method can converge faster and has better style transfer capabilities.Key words: style transfer; Generative Adversarial Networks; image processing; representation learning0 引言近年來,计算机技术和计算机网络的发展,掀起了一股创新浪潮,这拓宽了人们获取文化遗产和文化输出的方式[1]。

基于生成对抗神经网络的图像风格快速迁移-毕业论文

---文档均为word文档,下载后可直接编辑使用亦可打印---摘要现今,无论是科研还是娱乐,人们对于图片和视频的处理需求越来越大,所以需要更多的处理图片和视频的应用,比如图像风格迁移。

对于图像风格迁移这个领域,人类很难快速学习到某种图片风格,而且利用人力在专门软件上处理图片是很耗时间的,所以人们需要可以自动化的快速的迁移方法。

本文主要是实现了一个可以对图像风格进行快速风格迁移的应用。

针对传统图像迁移方法迁移速度慢,复用性弱的缺点,这里使用了一种更新型的神经网络方法——循环一致性生成对抗网络(Cycle-Consistent Generative Adversarial Networks, CycleGAN)。

编写代码实现了CycleGAN 中的鉴别器和生成器之后,通过神经网络的迭代训练,可以训练出用来进行图像风格迁移的生成器。

利用这项技术,本文训练出了7个风格迁移生成器,分别有:梵高,莫奈,塞尚,浮世绘,齐白石,唐寅,山水画。

除了实现照片风格迁移,本文还实现了两个相似物体之间的风格互换。

一共3种:马与斑马互转,夏季与冬季互转,苹果与橘子互转。

关键词:图像风格迁移;快速迁移;CycleGAN;生成对抗网络;鉴别器;生成器AbstractNowadays, whether it is for scientific research or entertainment, people have an increasing demand for image and video processing, so more and more applications of image and video processing are needed, such as image style transfer. In the field of image style transfer, it is difficult for human beings to learn a certain image style quickly, and it takes time to process images on specialized software with human beings, so people need a fast method of migration that can be automated.This paper mainly realizes an application of fast style migration of image style. Image migration method for traditional migration speed slow, problem of weak reusability here USES a new type of neural network method more consistency - loop generated against network (Cycle - Consistent Generative Adversarial Networks, CycleGAN). After coding the discriminator and generator in CycleGAN, the generator for image style transfer can be trained through the iterative training of neural network. Using this technique, this paper has trained seven style transfer generators, namely: van gogh, monet, Cezanne, ukiyo-e, qi baishi, tang Yin, landscape painting. In addition to the transfer of photo styles, this paper also realizes the style exchange between two similar objects. There are three kinds: the horse turns with the zebra, the summer turns with the winter, the apple turns with the orange.Key words: Image style transfer; Rapid migration; CycleGAN; Generating antagonistic network; Discriminator; The generator目录第一章绪论1.1 研究背景想象一下,如果19世纪的荷兰画家梵高来到校园,画下一幅画。

人工智能教案TensorFlow基于CycleGAN的图像风格转换教案

第6章基于CycleGAN的图像风格转换教案课程名称:TensorFlow 2深度学习实战课程类别:必修适用专业:人工智能类相关专业总学时:64学时(其中理论36学时,实验28学时)总学分:4.0学分本章学时:10学时一、材料清单(1)《TensorFlow 2深度学习实战》教材。

(2)配套PPT。

(3)引导性提问。

(4)探究性问题。

(5)拓展性问题。

二、教学目标与基本要求1.教学目标本章主要实现了基于CycleGAN将现实风景图像的风格转换成油画风格的图像风格转换。

首先读取数据,对图像进行数据预处理;然后构建生成器与判别器;接下来训练CycleGAN网络,包括定义损失函数、定义优化器函数、定义图像生成函数和定义训练函数;最后对转换的结果进行分析。

2.素质目标(1)培养学生实事求是,科学严谨的学习精神。

(2)培养学生团结协作,共同进步的理念。

3.基本要求(1)了解图像风格转换的背景和目标。

(2)熟悉图像风格转换的步骤和流程。

(3)掌握常用的网络构建方法,用于构建CycleGAN网络。

(4)掌握常用的网络训练方法,如定义损失函数、定义优化器和定义训练函数等。

三、问题1.引导性提问引导性提问需要教师根据教材内容和学生实际水平,提出问题,启发引导学生去解决问题,提问,从而达到理解、掌握知识,发展各种能力和提高思想觉悟的目的。

(1)图像风格转换主要做些什么?(2)目前生活中有哪些地方应用了图像风格转换?2.探究性问题探究性问题需要教师深入钻研教材的基础上精心设计,提问的角度或者在引导性提问的基础上,从重点、难点问题切入,进行插入式提问。

或者是对引导式提问中尚未涉及但在课文中又是重要的问题加以设问。

(1)为什么要做数据扩充?(2)数据扩充有什么哪些方法?(3)批处理和迭代器有什么作用?3.拓展性问题拓展性问题需要教师深刻理解教材的意义,学生的学习动态后,根据学生学习层次,提出切实可行的关乎实际的可操作问题。

cyclegan的评价指标

cyclegan的评价指标CycleGAN是一种无监督的图像转换模型,常用以下评价指标进行定量评估:1. 结构相似性指数(SSIM):这是一种用于测量两幅图像相似度的指标,考虑了亮度、对比度和结构三个方面的差异。

对于生成的图像,可以将其与真实图像进行比较,计算SSIM指标,以评估生成图像的质量。

2. 峰值信噪比(PSNR):这也是一种常用的评价指标,用于衡量生成图像与真实图像之间的差异。

除此之外,还有许多其他评价指标可以用于评估CycleGAN 的性能,如Inception Score、Fréchet Inception Distance (FID)、KID (Kernel Inception Distance)等。

这些指标都是基于深度学习模型的特性来评估生成图像的质量。

同时,实验评价也是另一种评估CycleGAN性能的方法,通过在真实场景中进行实际应用来评价生成图像的质量。

这种评价方法的优点是结果客观可量化,但缺点是可能无法准确捕捉到人类感知的细节。

请注意,这些评价指标并非在所有情况下都适用,选择哪种评价指标取决于具体的应用场景和需求。

除了以上提到的评价指标,还有一些其他的评价指标也可以用于评估CycleGAN的性能,例如:3. 均方误差(MSE):这是一种常用的图像质量评价指标,通过计算生成图像与真实图像之间的均方误差来评估生成图像的质量。

4. 感知损失(Perceptual Loss):这种评价指标考虑了人类视觉系统的特性,通过比较生成图像与真实图像在高层特征上的差异来评估生成图像的质量。

5. 风格迁移损失(Style Loss):在CycleGAN中,风格迁移损失用于衡量生成图像与目标风格的相似度,通过比较生成图像与目标风格图像在风格特征上的差异来评估CycleGAN的性能。

这些评价指标可以帮助我们更客观地评估CycleGAN的性能,但需要注意的是,这些评价指标只是定量评估的指标,不能完全代替人类视觉系统的判断。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于CycleGAN的图像风格迁移作者:马赫张涛卢涵宇

来源:《电脑知识与技术》2020年第27期

摘要:随着深度学习的不断发展与应用,图像到图像的风格迁移成了计算机视觉领域的研究热点之一。

该文运用Cycle-GAN网络对图像进行风格迁移,能够在无匹配的源图像和风格图像的情况下进行。

使得CycleGAN网络中的生成器由编码器、转换器及解码器组成,能起到

保留原始图像特征和转换图像数据的作用。

该文尝试通过Inception与ResNet进行结合,并与原CycleGAN网络进行对比训练,结果表明,修改后的CycleGAN能够比CycleGAN训练后得到更加逼真的图像,具有更佳的视觉效果。

关键词:CycleGAN;图像风格迁移;转换器;ResNet模块;深度学习

中图分类号:TP183 文献标识码:A

文章编号:1009-3044(2020)27-0018-03

开放科学(资源服务)标识码(OSID):

随着计算机技术和人工智能技术的发展,深度学习应用越来越广,其中计算机图形学与深度学习的结合,产生了许多优秀的算法,并在后来的图像风格迁移、图像分割、自然语言生成等诸多领域得到广泛应用[1-4]。

随着GAN网络的应用也产生了一系列如难以收敛、训练不稳定、模型不可控等问题,促使了大量学者对该类问题的研究,如MARTIN等[5]针对GAN网络训练不稳定的问题,提出了WGAN(Wasserstein GAN),该方法使用Earth-Mover距离代替JS散度作为判别器D的目标函数,使得训练稳定性得到有效提升。

Zhu等[6]人为解决GAN网络的一些限制,提出了循环一致性对抗网络(CycleGAN)网络,该网络能够根据不成对的数据集训练出能够满足不同风格的图像的转换;随后,刘哲良等[7]针对采用CycleGAN网络进行图像风格迁移中,表现出泛化能力差等问题,提出了一种FCN-CycleGAN的图像风格迁移方法,结论证明该方的网络在稳定性法具有较好的表现能力。

杜振龙等[8]针对GAN网络进行图像风格迁移中收到数据集限制的问题,对CycleGAN进行了改进,通过利用DenseNet来代替Cycle-CAN网络中的ResNet,改进、收敛速度及对减少数据集的限制等方面都有很大进步。

本文运用CycleGAN网络对图像进行风格迁移,通过Incep-tion与ResNet进行结合,并与原CycleGAN网络进行对比训练,结果表明,修改后的CycleGAN得到更加逼真的图像,具有更佳的视觉效果。

1 图像风格转换

图像风格转换(又称作图像风格遷移)是深度学习领域内一中新兴的技术。

由于图像风格概念非常抽象,计算机对图像的处理过程中仅是一些像素点,不能像人类一样对不同风格进行分辨,所以人们期望通过对图像进行风格特征的提取来解决这一问题。

随着深度学习的发展,现已可以使用深度神经网络来学习图像里面的抽象风格特征。

Gatys等人开启了深度学习方法应用于图像风格迁移的先例,其论文中采用卷积神经网络对图像进行风格提取,虽然相对于传统非参方法来说能够对低层信息进行提取,但是对于高层的抽象特征而言并没有取得良好的效果。

直到CAN网络的引入,该类问题得到很大的改进,该类方法能够学习到大量样本之间的风格及其特征。

比如实际应用中将黑白图像转为对应的彩色图像、苹果与橘子之间的转换等问题,需要对大量样本进行训练提取其中的风格,然后完成不同图像风格的转换。

2 网络结构

CycleCAN模型是从GAN网络发展而来,其原理是基于对偶思想的图像风格转换,该方法不需要对成对的数据集进行训练,就能完成对风格的迁移。

2.1 GAN

GAN由两个相互竞争的神经网络组成:一个是神经网络是生成器网络( Generator,G),用于生成样本图像;另一个神经网络是判别器网络( Discriminator,D),用于区分真实样本和生成样本。

CAN网络其核心思想来源于博弈论的纳什均衡,该网络由生成器G和判别器D组成,其中G网络是通过将一个噪声矢量包装为与真实数据高度相似的样本,D网络是对输入的数据进行判断其来自真实样本还是通过G网络所生成的假数据;它们之间是一个动态的过程。

图1展示了其基本原理,图中X表示是真实图片的概率。

GAN网络的优化问题其实是一个极小一极大化问题,即先将生成器G进行固定,优化判别器D,使得D的判别准确率最大化;然后固定判别器D,优化生成器G,使得判别器准确率最小;当两者相等时,达到全局最优。

其目标函数如公式(1)所示:

2.2 Cycle GAN

CycleCAN使用两个生成器与两个判别器网络来实现对两个图片X与Y之间的相互映射,其原理图如图2所示。

本质上是两个镜像对称的GAN所构成的环形网络。

模型设计了两对生成网络和判别网络,通过训练后可以将不同的图像之间进行转换,但是在这个过程中要求循环的一致性,故而在其中设置了一个循环损失函数(Cyclic loss)。

CycleGAN模型有两个生成网络和两个判别网络,共4个生成损失函数。

上图中表示X通过映射G实现X中的图片x到Y中图片G(x)的映射关系,对应生成判别器为Dy,由于CycleGAN是基于对偶思想的原理,故而Y需要通过一个映射F实现Y中的图片y映射到X中的F(y)的映射关系,对应生成判别器为Dx;如果G(F(x))≈x和F(G (y))≈y则CycleGAN模型的转换过程就完成。

2.3 CycleGAN的改进

原CycleGAN生成器中采用残差网络,通过全卷积连接,由编码器、转换器和解码器组成。

残差网络在图像识别领域尤其是目标检测方面具有很大的优势,但是更大的优势需要在很深的网络结构中才能够展现,而传统的CycleGAN网络其生成器网络对于大小为256X256的图像采用的是9层的残差模块,并未有很深的网络。

本文尝试对CycleGAN网络进行改进,使用Inception模块来代替原来单一的ResNet模块,并进行组合保持了原来Cycle-CAN的层结构,其网络结构图如图3所示。

3 实验与结果分析

本文实验使用计算机配置为ADM2600X处理器,核心3.6GHz,一块GTX1660TI CPU、RAM 16GB,操作系统为Winl0,采用TensorFlowl.ll开源深度学习框架作为实验环境。

数据集采用Horse2zebra数据集,分为数据集A(马)和数据集B(斑马)。

本文在相同配置下,用本文提出的改进CycleGAN网络及原始CycleGAN网络中去,最终实现斑马与马之间的风格互换及网络性能之间的对比。

仅比较训练150000次后的生成结果,通过图4和图5可以看出,在15万次以后网络能够提供较好的风格迁移效果。

改进的CycleGAN从一定程度上得到更加逼真的图像。

4 结论

本文对原始CycleGAN网络结构进行了改进,在图像迁移中能够保留图像更多的图像细节,表明在对原有网络进行改进以后,能够提升对生成图像的质量。

结果证明本文所提出的改进型CycleGAN在风格迁移方面具有更好迁移效果,同时也为下一步继续完善改进本文所改进的网络具有指导作用。

参考文献:

[1]杨宏宇,王峰岩.基于深度卷积神经网络的气象雷达噪聲图像语义分割方法[J].电子与信息学报,2019,41(10):2373-2381.

[2]孙旭,李晓光,李嘉锋,等,基于深度学习的图像超分辨率复原研究进展[J].自动化学报,2017,43(5):697-709.

[3]刘勘,陈露.面向医疗分诊的深度神经网络学习[J].数据分析与知识发现,2019,3(6):99-108.

[4]彭鹏.基于CycleGAN的图像风格转换[D].成都:电子科技大学,2019.

[5] MARTINA, SOUMITH C,LON B.Wasserstein gan[R]. ArxivPreprint AIxiv:

1701.07875, 2017.

[6] Zhu J Y,Park T,lsola P,et al.Unpaired image-to-imagetranslation using cycle-consistent adversarial networks[C].IEEE International Conference on Computer Vision, 2017:2242-2251

[7]刘哲良,朱埔,袁梓洋.结合全卷积网络与CycleGAN的图像实例风格迁移[J].中国图象图形学报,2019,24(8):1283-1291.

[8]杜振龙,沈海洋,宋国美,等.基于改进CycleGAN的图像风格迁移[J].光学精密工程,2019,27(8):1836-1844.

【通联编辑:光文玲】

作者简介:马赫(2001-),男,山东日照人,山东科技大学遥感科学与技术专业学生;卢涵宇(1978-),男.河南周口人,副教授,博士后,主要研究方向为智能信息处理、3S技术应用。