机器学习第二章答案2

机器学习基础智慧树知到答案章节测试2023年太原理工大学

第一章测试1.样本是连续型数据且有标签,我们采用()进行机器学习。

A:嵌入算法B:聚类算法C:分类算法D:回归算法答案:D2.在机器学习中,样本常被分成()。

A:训练集B:其它选项都有C:测试集D:评估集答案:B3.机器学习算法需要显示编程,具备归纳、总结等自学习能力。

()A:错B:对答案:A4.机器学习和人工智能、深度学习是一个概念,都是指机器模仿人类推理、学习能力。

()A:错B:对答案:A5.特征工程非常重要,在采用机器学习算法前,首先需要利用特征工程确定样本属性。

()A:错B:对答案:B第二章测试1.K近邻算法认为距离越近的相似度越高。

()A:对B:错答案:A2.K近邻算法中数据可以不做归一化,因为是否归一化对结果影响不大。

()A:错B:对答案:A3.K近邻算法中采用不同的距离公式对于结果没有影响。

()A:错答案:A4.在上面图中,K=5,绿色样本的类别是()。

A:红色三角形B:蓝色正方形C:不能确定D:绿色圆形答案:B5.在K近邻算法中,K的选择是()?A:越大越好B:与样本有关C:其它都不正确D:越小越好答案:B第三章测试1.下列()中两个变量之间的关系是线性的。

A:猫的皮毛颜色和体重B:人的工作环境和健康状况C:重力和质量D:女儿的身高和父亲的体重答案:C2.下列说法不正确的是()。

A:线性回归模型也可以解决线性不可分的情况B:回归用于预测输入变量和输出变量之间的关系C:回归就是数据拟合D:回归分析就是研究两个事物的相关性答案:C3.从某大学随机选择8名女大学生,其身高x(cm)和体重y(kg)的回归方程是y=0.849x-85.712,则身高172cm的女大学生,预测体重为()。

A:60.316kgB:大于60.316kgC:小于60.316kgD:其它都不正确答案:Asso中采用的是L2正则化。

()A:错B:对答案:A5.线性回归中加入正则化可以降低过拟合。

()A:错答案:B第四章测试1.以下说法正确的是()。

机器学习知到章节答案智慧树2023年三亚学院

机器学习知到章节测试答案智慧树2023年最新三亚学院第一章测试1.下面哪句话是正确的()参考答案:增加模型的复杂度,总能减小训练样本误差2.评估模型之后,得出模型存在偏差,下列哪种方法可能解决这一问题()参考答案:向模型中增加更多的特征3.以垃圾微信识别为例,Tom Mitchell的机器学习的定义中,任务T是什么?()参考答案:T是识别4.如何在监督式学习中使用聚类算法()?参考答案:在应用监督式学习算法之前,可以将其类别ID作为特征空间中的一个额外的特征;首先,可以创建聚类,然后分别在不同的集群上应用监督式学习算法5.想要训练一个ML模型,样本数量有100万个,特征维度是5000,面对如此大数据,如何有效地训练模型()?参考答案:对训练集随机采样,在随机采样的数据上建立模型;使用PCA算法减少特征维度;尝试使用在线机器学习算法6.机器学习兴起于()。

参考答案:1990年;1980年7.监督学习包括是()。

参考答案:分类;回归8.机器学习可以对电子商务产品评价进行好评与差评分类。

()参考答案:对9.机器学习必备知识包括数学基础、心理学基础、算法设计基础、商业模式基础。

()参考答案:错10.机器学习是一门多学科交叉专业,涵盖____、____、近似理论知识和复杂算法知识,使用计算机作为工具并致力于真实实时的模拟人类学习方式,并将现有内容进行知识结构划分来有效提高学习效率。

参考答案:null第二章测试1.关于k-NN算法,以下哪个选项是正确的?参考答案:可用于分类和回归2.k-NN算法在测试时间而不是训练时间上进行了更多的计算。

参考答案:对3.假设算法是k最近邻算法,在下面的图像中,____将是k的最佳值。

参考答案:104.一个kNN分类器,该分类器在训练数据上获得100%的准确性。

而在客户端上部署此模型时,发现该模型根本不准确。

以下哪项可能出错了?注意:模型已成功部署,除了模型性能外,在客户端没有发现任何技术问题参考答案:可能是模型过拟合5.以下是针对k-NN算法给出的两条陈述,其中哪一条是真的?1、我们可以借助交叉验证来选择k的最优值2、欧氏距离对每个特征一视同仁参考答案:1和26.你给出了以下2条语句,发现在k-NN情况下哪个选项是正确的?1、如果k的值非常大,我们可以将其他类别的点包括到邻域中。

机器学习课后习题答案

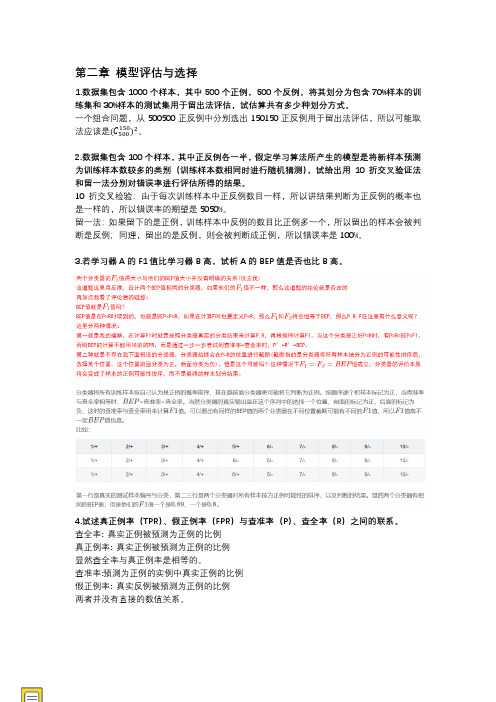

第二章 模型评估与选择1.数据集包含1000个样本,其中500个正例,500个反例,将其划分为包含70%样本的训练集和30%样本的测试集用于留出法评估,试估算共有多少种划分方式。

一个组合问题,从500500正反例中分别选出150150正反例用于留出法评估,所以可能取法应该是(C 500150)2。

2.数据集包含100个样本,其中正反例各一半,假定学习算法所产生的模型是将新样本预测为训练样本数较多的类别(训练样本数相同时进行随机猜测),试给出用10折交叉验证法和留一法分别对错误率进行评估所得的结果。

10折交叉检验:由于每次训练样本中正反例数目一样,所以讲结果判断为正反例的概率也是一样的,所以错误率的期望是5050%。

留一法:如果留下的是正例,训练样本中反例的数目比正例多一个,所以留出的样本会被判断是反例;同理,留出的是反例,则会被判断成正例,所以错误率是100%。

3.若学习器A 的F1值比学习器B 高,试析A 的BEP 值是否也比B 高。

4.试述真正例率(TPR )、假正例率(FPR )与查准率(P )、查全率(R )之间的联系。

查全率: 真实正例被预测为正例的比例真正例率: 真实正例被预测为正例的比例显然查全率与真正例率是相等的。

查准率:预测为正例的实例中真实正例的比例假正例率: 真实反例被预测为正例的比例两者并没有直接的数值关系。

第一章 绪论(略)机器学习(周志华)参考答案9.试述卡方检验过程。

第三章线性模型2.试证明,对于参数w,对率回归(logistics回归)的目标函数(式1)是非凸的,但其对数似然函数(式2)是凸的。

如果一个多元函数是凸的,那么它的Hessian矩阵是半正定的。

3.编程实现对率回归,并给出西瓜数据集3.0α上的结果/icefire_tyh/article/details/520688444.选择两个UCI数据集,比较10折交叉验证法和留一法所估计出的对率回归的错误率。

/icefire_tyh/article/details/520689005.编程实现线性判别分析,并给出西瓜数据集3.0α上的结果。

人工智能导论第二章答案

人工智能导论第二章答案1、单选题:下列关于智能说法错误的是()选项:A:细菌不具有智能B:任何生命都拥有智能C:从生命的角度看,智能是生命适应自然界的基本能力D:目前,人类智能是自然只能的最高层次答案: 【细菌不具有智能】2、判断题:目前,智能的定义已经明确,其定义为:智能是个体能够主动适应环境或针对问题,获取信息并提炼和运用知识,理解和认识世界事物,采取合理可行的(意向性)策略和行动,解决问题并达到目标的综合能力。

()选项:A:错B:对答案: 【错】3、判断题:传统人工智能领域将人工智能划分为强人工智能与弱人工智能两大类。

所谓强人工智能指的就是达到人类智能水平的技术或机器,否则都属于弱人工智能技术。

()选项:A:错B:对答案: 【对】4、判断题:人类历史上第一个人工神经元模型为MP模型,由赫布提出。

()选项:A:对B:错答案: 【错】5、单选题:下列关于数据说法错误的是()选项:A:数据可以分为模拟数据和数字数据两类B:数据就是描述事物的符号记录,是可定义为有意义的实体C:我们通常所说的数据即能够直接作为计算机输入的数据是模拟数据D:在当今社会,数据的本质是生产资料和资产答案: 【我们通常所说的数据即能够直接作为计算机输入的数据是模拟数据】6、多选题:下列关于大数据的说法中正确的有()选项:A:大数据具有多样、高速的特征B:“大数据”是需要新处理模式才能具有更强的决策力、洞察发现力和流程优化能力的海量、高增长率和多样化的信息资产C:大数据带来的思维变革中,更多是指更多的随机样本D:“大数据时代”已经来临答案: 【大数据具有多样、高速的特征;“大数据”是需要新处理模式才能具有更强的决策力、洞察发现力和流程优化能力的海量、高增长率和多样化的信息资产;“大数据时代”已经来临】7、判断题:大数据在政府公共服务、医疗服务、零售业、制造业、以及涉及个人位置服务等领域都将带来可观的价值。

()选项:A:对B:错答案: 【对】8、多选题:人工智能在各个方面都有广泛应用,其研究方向也众多,下面属于人工智能研究方向的有()选项:A:知识图谱B:模式识别C:语音识别D:机器学习答案: 【知识图谱;模式识别;语音识别;机器学习】9、判断题:机器人发展经历了程序控制机器人(第一代)、自适应机器人(第二代)、智能机器人(现代)三代发展历程。

智慧树机器学习(山东联盟)章节测验答案

解忧书店 JieYouBookshop第一章单元测试1【单选题】 (5分)对西瓜的成熟度进行预测得到结果为0.51,这属于()学习任务。

A.其余选项都不是B.聚类C.回归D.分类2【单选题】 (5分)在学习过程中,X表示数据集,Y是所有标记的集合,也称为()。

A.样本集合B.属性集合C.输出空间D.函数3【单选题】 (5分)机器学习算法在学习过程中可能获得多个不同的模型,在解决“什么样的模型更好”这一问题时遵循“若有多个假设与观察一致,则选最简单的那个”,即()原则。

A.奥卡姆剃刀B.没有免费的午餐C.迪米特法则D.里氏替换4【单选题】 (5分)机器学习是整个人工智能的核心,机器学习算法的特征之一就是()。

A.类别B.模型C.特征D.数据5【单选题】 (5分)模型的泛化能力是指A.适用于训练集样本的能力B.适用于测试集样本的能力C.适用于新样本的能力D.适用于验证集样本的能力6【多选题】 (5分)下列关于学习算法的说法正确的是A.在某些问题上表现好的学习算法,在另一些问题上却可能不尽人意B.学习算法自身的归纳偏好与问题是否相配通常并不起决定性的作用C.学习算法必须有某种偏好,才能产出它认为“正确”的模型D.要谈论算法的相对优劣,必须要针对具体的学习问题7【多选题】 (5分)获得假设(模型)空间时,从特殊到一般的过程属于A.泛化B.归纳C.特化D.演绎8【多选题】 (5分)机器学习可以应用在下列哪些领域()A.搜索引擎B.天气预报C.商业营销D.自动驾驶汽车9【多选题】 (5分)根据训练数据是否拥有标记信息,学习任务可以分为()。

A.分类B.聚类C.无监督D.回归E.半监督F.监督10【判断题】 (5分)演绎是从一般到特殊的"特化"过程,即从基础原理推演出具体状况A.对B.错11【判断题】 (5分)分类预测的是离散值A.错B.对12【判断题】 (5分)分类和回归是无监督学习A.对B.错13【判断题】 (5分)奥卡姆剃刀原则:即“若有多个假设与观察一致,选最简单的一个”。

机器学习课后习题答案(周志华)

第二章模型评估与选择1.数据集包含1000个样本,其中500个正例,500个反例,将其划分为包含70%样本的训练集和30%样本的测试集用于留出法评估,试估算共有多少种划分方式。

一个组合问题,从500500正反例中分别选出150150正反例用于留出法评估,所以可能取150)2。

法应该是(C5002.数据集包含100个样本,其中正反例各一半,假定学习算法所产生的模型是将新样本预测为训练样本数较多的类别(训练样本数相同时进行随机猜测),试给出用10折交叉验证法和留一法分别对错误率进行评估所得的结果。

10折交叉检验:由于每次训练样本中正反例数目一样,所以讲结果判断为正反例的概率也是一样的,所以错误率的期望是5050%。

留一法:如果留下的是正例,训练样本中反例的数目比正例多一个,所以留出的样本会被判断是反例;同理,留出的是反例,则会被判断成正例,所以错误率是100%。

3.若学习器A的F1值比学习器B高,试析A的BEP值是否也比B高。

4.试述真正例率(TPR)、假正例率(FPR)与查准率(P)、查全率(R)之间的联系。

查全率: 真实正例被预测为正例的比例真正例率: 真实正例被预测为正例的比例显然查全率与真正例率是相等的。

查准率:预测为正例的实例中真实正例的比例假正例率: 真实反例被预测为正例的比例两者并没有直接的数值关系。

9.试述卡方检验过程。

第三章线性模型2.试证明,对于参数w,对率回归(logistics回归)的目标函数(式1)是非凸的,但其对数似然函数(式2)是凸的。

如果一个多元函数是凸的,那么它的Hessian矩阵是半正定的。

3.编程实现对率回归,并给出西瓜数据集3.0α上的结果/icefire_tyh/article/details/520688444.选择两个UCI数据集,比较10折交叉验证法和留一法所估计出的对率回归的错误率。

/icefire_tyh/article/details/520689005.编程实现线性判别分析,并给出西瓜数据集3.0α上的结果。

智慧树答案机器学习理论与方法知到课后答案章节测试2022年

第一章1.机器学习是研究发现数据模型的算法并利用这些模型做出决策。

()答案:对2.机器学习通常要经过数据选择,模型训练,模型优化矫正等过程。

()答案:对3.决策树模型是一种典型的聚类模型。

()答案:错4.决策树是随机森林模型的子结构。

()答案:对5.以下哪种情况适合使用SVM算法()。

答案:单细胞分类6.关于机器学习的基本流程,下列顺序正确的是()。

答案:建模—评价—改进7.监督式学习根据输出形式可分为()。

答案:分类和回归8.机器学习根据学习方式可分为()。

答案:强化学习;半监督学习;监督学习;无监督学习9.朴素贝叶斯适合下列哪种场景分析()。

答案:情感分析;消费者细分10.机器学习根据模型性质可分为()。

答案:非线性模型;线性模型第二章1.若非零矩阵A满足A=O,则A+E与A-E均可逆()答案:对2.矩阵的特征值为()答案:-13.设P(A)=0.4,P(B)=0.7,事件A,B相互独立,则P(B-A)=()答案:0.424.已知离散型随机变量X可取值{-3,-1,0,2},且取这些值的概率依次为,则b的取值为2 ()答案:对5.若随机变量X服从N(5,4)的分布,若P(X>c)=P(X<c),则c=()答案:56.事件A,B,C至少有一个发生可以表示为。

()答案:对7.事件A与B互不相容,是指P(AB)=P(A)P(B) 。

( )答案:对8.下列关于矩阵的运算法则正确的是()。

答案:(AB)C=A(BC);(A+B)C=AC+BC;(At)t=A9.假设A和B都是同阶可逆矩阵,且A为对称矩阵,则下列等式成立的为()。

答案:(ABt)-1=A-1(B-1)t10.假设感染了新冠病毒的病人中感到身体发热的概率为0.88,病人感染新冠病毒的概率为0.001,病人发热的概率为0.02,则如果检测到一个病人发热,则判断他感染了新冠病毒的概率为()。

答案:0.044第三章1.机器学习模型都是从经验中Experience学习任务Task。

《模式识别与机器学习》习题和参考答案

(μ i , i ), i 1, 2 ,可得

r (x) ln p(x | w 1) ln p(x | w 2)

d

1

1

(x μ1 ) 1 (x μ1 ) ln 2 ln | |

2

2

2

d

1

1

(x μ 2 ) 1 (x μ 2 ) ln 2 ln | |

(2-15)可简化为

1

gi ( x) (x μi ) 1 (x μi ).

2

(2-17)

将上式展开,忽略与 i 无关的项 x 1x ,判别函数进一步简化为

1

gi (x) ( 1μi ) x μi 1μi .

2

(2-18)

此时判别函数是 x 的线性函数,决策面是一个超平面。当决策区域 Ri 与 R j 相邻时,

190%

(2-13)

最小风险贝叶斯决策会选择条件风险最小的类别,即 h( x) 1 。

3.

给出在两类类别先验概率相等情况下,类条件概率分布是相等对角协方差

矩阵的高斯分布的贝叶斯决策规则,并进行错误率分析。

答:

(1)首先给出决策面的表达式。根据类条件概率分布的高斯假设,可以

得到

p(x | w i )

2

2

2

1

1

1 ||

(x μ1 ) 1 (x μ1 ) (x μ 2 ) 1 (x μ 2 ) ln

2

2

2 ||

1

(μ 2 μ1 ) 1x (μ1 1μ1 μ 2 1μ 2 ).

2

(2-28)

机器学习智慧树知到课后章节答案2023年下同济大学

机器学习智慧树知到课后章节答案2023年下同济大学第一章测试1.回归和分类都是有监督学习问题。

()A:对 B:错答案:对2.输出变量为有限个离散变量的预测问题是回归问题;输出变量为连续变量的预测问题是分类问题。

()A:错 B:对答案:错3.关于“回归(Regression)”和“相关(Correlation)”,下列说法正确的是?注意:x 是自变量,y 是因变量。

()A:回归和相关在 x 和 y 之间都是互为对称的B:回归在 x 和 y 之间是对称的,相关在 x 和 y 之间是非对称的C:回归和相关在 x 和 y 之间都是非对称的D:回归在 x 和 y 之间是非对称的,相关在 x 和 y 之间是互为对称的答案:回归在 x 和 y 之间是非对称的,相关在 x 和 y 之间是互为对称的4.如果一个经过训练的机器学习模型在测试集上达到 100% 的准确率,这就意味着该模型将在另外一个新的测试集上也能得到 100% 的准确率。

()A:错 B:对答案:错5.机器学习学得的模型适用于新样本的能力,称为"泛化"能力,这是针对分类和回归等监督学习任务而言的,与聚类这样的无监督学习任务无关。

()A:错 B:对答案:错6.机器学习时,我们通常假设样本空间中的全体样本都服从某个未知"分布",并且我们获得的每个样本都是独立地从这个分布上采样获得的。

()A:对 B:错答案:对7.从归纳偏好一般性原则的角度看,"奥卡姆剃刀" (Occam's razor)准则与“大道至简”说的是相同的道理。

()A:错 B:对答案:对8.以下方法或系统属于"符号主义" (symbolism)学习技术的是()A:"概念学习系统"B:支持向量机C:"结构学习系统"D:"基于逻辑的归纳学习系统“答案:"概念学习系统";"结构学习系统";"基于逻辑的归纳学习系统“9.以下方法或技术属于统计学习范畴的是()A:核方法B:Hopfield神经网络C:支持向量机D:感知机答案:核方法;支持向量机10.归纳学习相当于"从样例中学习",即从训练样例中归纳出学习结果。

机器学习理论与方法知到章节答案智慧树2023年同济大学

机器学习理论与方法知到章节测试答案智慧树2023年最新同济大学第一章测试1.机器学习是研究发现数据模型的算法并利用这些模型做出决策。

()参考答案:对2.机器学习通常要经过数据选择,模型训练,模型优化矫正等过程。

()参考答案:对3.决策树模型是一种典型的聚类模型。

()参考答案:错4.决策树是随机森林模型的子结构。

()参考答案:对5.以下哪种情况适合使用SVM算法()。

参考答案:单细胞分类6.关于机器学习的基本流程,下列顺序正确的是()。

参考答案:建模—评价—改进7.监督式学习根据输出形式可分为()。

参考答案:分类和回归8.机器学习根据学习方式可分为()。

参考答案:监督学习;无监督学习;强化学习;半监督学习9.朴素贝叶斯适合下列哪种场景分析()。

参考答案:消费者细分;情感分析10.机器学习根据模型性质可分为()。

参考答案:非线性模型;线性模型第二章测试1.若非零矩阵A满足A=O,则A+E与A-E均可逆()参考答案:对2.矩阵的特征值为()参考答案:-13.设P(A)=0.4,P(B)=0.7,事件A,B相互独立,则P(B-A)=()参考答案:0.424.已知离散型随机变量X可取值{-3,-1,0,2},且取这些值的概率依次为,则b的取值为2 ()参考答案:对5.若随机变量X服从N(5,4)的分布,若P(X>c)=P(X<c),则c=()参考答案:56.事件A,B,C至少有一个发生可以表示为。

()参考答案:对7.事件A与B互不相容,是指P(AB)=P(A)P(B) 。

( )参考答案:对8.下列关于矩阵的运算法则正确的是()。

参考答案:(AB)C=A(BC);(A+B)C=AC+BC;(A t)t=A9.假设A和B都是同阶可逆矩阵,且A为对称矩阵,则下列等式成立的为()。

参考答案:(AB t)-1=A-1(B-1)t10.假设感染了新冠病毒的病人中感到身体发热的概率为0.88,病人感染新冠病毒的概率为0.001,病人发热的概率为0.02,则如果检测到一个病人发热,则判断他感染了新冠病毒的概率为()。

机器学习实战课后习题答案

机器学习实战课后习题答案机器学习实战课后习题答案机器学习是一门应用广泛的学科,通过训练算法和模型来使计算机能够从数据中学习并做出预测和决策。

在机器学习实战这门课程中,学生们学习了各种机器学习算法和技术,并通过实践来巩固所学的知识。

在课后习题中,学生们需要运用所学的知识来解决一系列的问题。

下面是一些常见的机器学习实战课后习题及其答案。

1. 什么是监督学习和无监督学习?举例说明。

监督学习是一种通过给定输入和输出的训练数据来训练模型的学习方法。

在监督学习中,模型通过学习输入和输出之间的关系来进行预测和分类。

例如,给定一组房屋的特征(如面积、卧室数量等)和对应的价格,我们可以通过监督学习来训练一个模型,以预测给定房屋特征时的价格。

无监督学习是一种通过给定输入数据而没有对应输出的训练数据来训练模型的学习方法。

在无监督学习中,模型通过学习数据之间的内在结构和关系来进行聚类和降维等任务。

例如,给定一组顾客的购物记录,我们可以通过无监督学习来将顾客分成不同的群组,以便进行个性化的市场营销。

2. 什么是过拟合和欠拟合?如何解决这些问题?过拟合是指模型在训练数据上表现很好,但在测试数据上表现较差的现象。

过拟合通常发生在模型过于复杂或训练数据过少的情况下。

为了解决过拟合问题,可以采取以下方法:- 增加训练数据量:通过增加训练数据量,可以减少模型对训练数据的过度拟合。

- 简化模型:可以通过减少模型的复杂度来降低过拟合的风险。

例如,可以减少模型的参数数量或使用正则化方法来约束模型的复杂度。

- 使用交叉验证:通过使用交叉验证来评估模型在不同数据集上的性能,可以更好地了解模型的泛化能力。

欠拟合是指模型在训练数据和测试数据上都表现较差的现象。

欠拟合通常发生在模型过于简单或训练数据过多的情况下。

为了解决欠拟合问题,可以采取以下方法:- 增加模型复杂度:可以增加模型的复杂度,使其可以更好地拟合训练数据。

- 增加特征数量:通过增加特征数量,可以提供更多的信息给模型,从而改善模型的性能。

机器学习技术及应用智慧树知到答案章节测试2023年

第一章测试1.下列属于机器学习中的监督学习算法有哪些()。

A:SVM B:ID3C:AdaBoost D:C4.5 答案:ABCD2.下列属于机器学习中的非监督学习算法有哪些()。

A:Sting B:K-meansC:Dbscan D:Birch 答案:ABCD3.下列属于机器学习中的半监督学习算法有哪些() A:基于距离的方法 B:基于流形学习的方法 C:基于差异的方法 D:基于类标签的方法答案:ABCD4.人工智能发展经历了哪几个发展阶段() A:推理期 B:知识期 C:表示期 D:学习期答案:ABD5.下列属于机器学习的应用领域有哪些() A:自然语言处理 B:人脸检测 C:计算机视觉 D:自动驾驶答案:ABCD第二章测试1.下列不属于机器学习开发语言是哪个?() A:R B:C++ C:汇编语言 D:Java 答案:C2.下列不属于机器学习的学习框架是哪个?() A:Keras B:Caffe C:RNND:TensorFlow 答案:C3.Numpy中创建全为0的矩阵使用() A:empty B:ones C:arange D:zeros 答案:D4.使用pandas时需要导入什么?() A:import matplotlib B:import numpy asnp C:import pandas as pd 答案:C5.下列说法正确的有() A:安装Scikit-learn库之前,不需要安装python、Numpy、Scipy和matplotlib等库。

B:Scikit-learn库是一个开源机器学习库,涵盖了几乎所有机器学习算法。

C:Scikit-learn内置了少量的数据集,其中数据集库datasets提供数据集。

D:Scikit-learn库不支持包括分类、回归、降维和聚类、模型选择及预处理等算法。

答案:B第三章测试1.在决策树中,用作分裂节点的信息增益说法不正确的是() A:较小不纯度的节点需要更多的信息来区分总体 B:信息增益可以使用熵得到 C:信息增益更加倾向于选择有较多取值的属性 D:ID3算法采用信息增益来选择特征答案:A2.下面明显属于回归问题的是() A:广告是否点击预测 B:西瓜好坏预测 C:房价估值预测 D:垃圾邮件识别答案:C3.梯度下降算法中学习率理解正确的是()A:学习率最好能设置可调的数值,先小后大 B:学习率最好设置很大的数值 C:学习率最好设置很小的数值 D:学习率最好能设置可调的数值,先大后小答案:D4.下列有关支持向量机(SVM)说法不正确的是() A:SVM的支持向量是少数的几个数据点向量 B:SVM对线性不可分的数据有较好的分类性能 C:SVM因为使用了核函数,因此它没有过拟合的风险 D:SVM使用核函数的过程实质是进行特征转换的过程答案:C5.K近邻算法的基本要素不包括() A:样本的大小 B:K值选择 C:距离度量 D:分类决策规则答案:A第四章测试1.下列属于机器学习中的非监督学习算法有哪些() A:Kmeans B:fisher判别C:PCA D:SVM 答案:AC2.从目的的角度来看,非监督学习的类别有哪些() A:降维 B:聚类 C:基于样本间相似性度量的方法 D:基于概率密度估计的方法答案:AB3.从实现方式的角度来看,非监督学习的类别有哪些() A:基于样本间相似性度量的方法 B:降维 C:基于概率密度估计的方法 D:聚类答案:AC4.下列哪些是非监督学习的应用场景() A:图像生成 B:用户细分 C:推荐系统D:异常发现答案:BCD5.对数据进行降维的原因有哪些() A:方便可视化处理 B:资源受限,不能处理高维数据 C:数据有冗余 D:能有效提升模型精度答案:ABC第五章测试1.卷积神经网络的缩写为() A:DNN B:ANN C:CNN D:BNN 答案:C2.人类历史上首次提出神经元模型是在哪一年() A:1946 B:1938 C:1949D:1943 答案:D3.深度学习概念是由下列哪位科学家提出的() A:威德罗 B:罗森勃拉特 C:霍夫 D:辛顿答案:D4.生物神经元不包含哪一部分() A:轴突 B:细胞体 C:树突 D:权重答案:D5.下列不属于常见反馈网络的是哪一个() A:感知机 B:BAM网络 C:Hopfield网络 D:Hamming网络答案:A第六章测试1.下列属于强化学习组成部分有哪些() A:行动 B:状态 C:智能体 D:环境答案:ABCD2.下列属于机器学习中的应改为强化学习算法有哪些() A:时间差分方法 B:值迭代算法 C:策略迭代算法 D:蒙特卡洛法答案:ABCD3.下列哪个是求解决策过程最优化的数学方法() A:动态规划方法 B:时间差分方法 C:策略迭代算法 D:蒙特卡洛法答案:AC4.采用时间差分法的强化学习可以分为哪几类() A:统计试验法 B:在线控制C:统计模拟法 D:离线控制答案:BD5.强化学习的主要特点有哪些() A:基于评估 B:交互性 C:单步 D:序列决策过程答案:ABD。

机器学习课后习题答案

机器学习课后习题答案一、回归问题1. 什么是回归问题?回归问题是指预测一个或多个连续值的问题。

在机器学习中,回归算法通过对已有的输入数据进行学习,建立一个数学模型,用于预测连续型输出变量的取值。

2. 回归问题有哪些常用的评价指标?常用的回归问题评价指标包括:•均方误差(Mean Squared Error,MSE):计算预测值与真实值之间的差异的均方值。

公式如下:MSE = (1/n) * Σ(y_pred - y_true)^2其中,y_pred是预测值,y_true是真实值,n是样本数量。

MSE越小,表示预测值与真实值的拟合程度越好。

•均方根误差(Root Mean Squared Error,RMSE):MSE的平方根。

公式如下:RMSE = √MSERMSE与MSE类似,用于评估预测值与真实值之间的差异,但RMSE更为直观。

•平均绝对误差(Mean Absolute Error,MAE):计算预测值与真实值之间的绝对差异的均值。

公式如下:MAE = (1/n) * Σ|y_pred - y_true|MAE越小,表示预测值与真实值的差异越小。

3. 请简要介绍线性回归算法的原理。

线性回归是一种基本的回归算法,它通过建立一个线性模型来描述自变量与因变量之间的关系。

线性回归的目标是找到最佳拟合直线来最小化预测值与真实值之间的误差。

线性回归算法的原理可以概括如下:1.假设自变量与因变量之间存在线性关系:y = β0 + β1*x1 + β2*x2 + ... + βn*xn + ε其中,y是因变量,x1, x2, …, xn是自变量,β0, β1, β2, …,βn是模型的参数,ε是误差项。

2.最小化误差:通过最小二乘法来确定最优的参数值,使预测值与真实值之间的误差最小化。

3.模型训练和预测:使用已知的训练数据集来训练模型,得到最优的参数值。

然后,可以使用该模型对新的输入数据进行预测。

4. 请简要介绍逻辑回归算法的原理。

2023年智慧树知道网课《机器学习》课后章节测试满分答案

2023年智慧树知道网课《机器学习》课后章节测试满分答案第一章简介1. 机器研究是一门研究如何使计算机模仿人类研究能力的学科。

2. 机器研究算法可以分为监督研究、无监督研究和强化研究三种类型。

3. 监督研究的目标是根据已经标记的数据来进行预测或分类。

4. 无监督研究的目标是从未标记的数据中发现模式或结构。

5. 强化研究是通过试错来研究,通过与环境进行交互来优化决策策略。

第二章监督研究2. 常用的监督研究算法有线性回归、逻辑回归和决策树等。

3. 线性回归用于建立输入特征与输出标签之间的线性关系。

4. 逻辑回归用于进行二分类或多分类任务。

5. 决策树是一种通过一系列特征判断来进行分类的算法。

第三章无监督研究1. 无监督研究是一种从未标记的数据中发现模式或结构的研究方法。

2. 常见的无监督研究算法有聚类和降维。

3. 聚类算法根据样本的相似性将其分为不同的类别。

4. 降维算法可以将高维数据映射到低维空间,减少数据的维度。

第四章强化研究1. 强化研究是一种通过与环境进行交互来研究的方法。

2. 在强化研究中,智能体通过观察环境的状态、采取行动和获得奖励来研究最优策略。

3. 常用的强化研究算法有Q-learning和深度强化研究等。

4. Q-learning是一种经典的强化研究算法,用于解决马尔可夫决策问题。

5. 深度强化研究结合了深度研究和强化研究的技术,可以在复杂环境中研究最优策略。

以上为《机器学习》课后章节测试满分答案,希望能对大家的学习有所帮助。

机器学习原理与实战课后习题答案

机器学习原理与实战课后习题答案第1章填空题答案(1)前期(2)无(3)无关相关不强(4)验证集(5)分布漂移(Distribution Drift)第1章选择题答案(1)D(2)C(3)A(4)C(5)B(6)A(7)B(8)C(9)A(10)D第2章填空题答案(1)决定分点、列出频率分布表、绘制频率分布直方图(2)concat、merge、join(3)散点图、热力图、Pearson相关系数、判定系数(4)集中趋势度量离散程度度量(5)数据分布与趋势探查、数据清洗、和、数据合并第2章选择题答案(1)D(2)D(3)B(4)B(5)D(6)D(7)D(8)A(9)B(10)C第3章填空题答案(1)特征变换(2)标准化、函数转换离散化(3)L1正则化、L2正则化(4)过滤式选择、包裹式选择、嵌入式选择、或、字典学习(5)离差标准化、标准差标准化、和、小数定标标准化第3章选择题答案(1)D(2)C(3)A(4)A(5)C(6)D(7)D(8)C(9)D(10)D第3章操作题# 第(1)题from sklearn.datasets import load_irisiris_data = load_iris()import numpy as npimport pandas as pdcol_names = iris_data['feature_names'] + ['target']data = pd.DataFrame(data= np.c_[iris_data['data'],iris_data['target']], columns=col_names)data.head()# 标准差标准化def StandarScale(data):x = np.array(data)[:,:-1]y = np.array(data)[:,-1:]x_scale = (x-x.mean(axis = 0))/(x.std(axis = 0))return pd.DataFrame(np.concatenate((x_scale,y),axis = 1),columns = data.columns)data_s_scale = StandarScale(data)print('标准差标准化之前的前5行数据为:')data.head()print('标准差标准化之后的前5行数据为:')data_s_scale.head()data_s_scale.to_csv('../tmp/data_s_scale.csv')# 第(2)题from sklearn.datasets import load_bostonboston_data = load_boston()import pandas as pdimport numpy as npcol_names = list(boston_data['feature_names'])+['target']data =pd.DataFrame(np.c_[boston_data['data'],boston_data['target']],columns = col_names)x = boston_data['data']y = boston_data['target']# 过滤式选择,选择5个变量 SelectKBest,既可以用于分类变量,也可以用于连续性变量。

机器学习第二章答案2

1.1. Give three computer applications for which machine learning approaches seem appropriate and three for which they seem inappropriate. Pick applications that are not already mentioned in this chapter, and include a one-sentence justification for each.Ans.Machine learning: Face recognition, handwritten recognition, credit card approval.Not machine learning: calculate payroll, execute a query to database, use WORD.2.1. Explain why the size of the hypothesis space in the EnjoySport learning task is 973. How would the number of possible instances and possible hypotheses increase with the addition of the attribute WaterCurrent, which can take on the values Light, Moderate, or Strong? More generally, how does the number of possible instances and hypotheses grow with the addition of a new attribute A that takes on k possible values?Ans.Since all occurrence of “φ” for an attribute of the hypothesis results in a hypothesis which does not accept any instance, all these hypotheses are equal to that one where attribute is “φ”. So the number of hypothesis is 4*3*3*3*3*3 +1 = 973.With the addition attribute Watercurrent, the number of instances = 3*2*2*2*2*2*3 = 288, the number of hypothesis = 4*3*3*3*3*3*4 +1 = 3889.Generally, the number of hypothesis = 4*3*3*3*3*3*(k+1)+1.2.3. Consider again the EnjoySport learning task and the hypothesis space H described in Section 2.2. Let us define a new hypothesis space H' that consists of all pairwise disjunctions of the hypotheses in H. For example, a typical hypothesis in H' is (?, Cold, High, ?, ?, ?) v (Sunny, ?, High, ?, ?, Same) Trace the CANDIDATE-ELIMINATATION algorithm for the hypothesis space H' given the sequence of training examples from Table 2.1 (i.e., show the sequence of S and G boundary sets.)Ans.S0= (φ,φ,φ,φ,φ,φ) v (φ,φ,φ,φ,φ,φ)G0 = (?, ?, ?, ?, ?, ?) v (?, ?, ?, ?, ?, ?)Example 1: <Sunny, Warm, Normal, Strong, Warm, Same, Yes>S1=(Sunny, Warm, Normal, Strong, Warm, Same)v (φ,φ,φ,φ,φ,φ)G1 = (?, ?, ?, ?, ?, ?) v (?, ?, ?, ?, ?, ?)Example 2: <Sunny, Warm, High, Strong, Warm, Same, Yes>S2= {(Sunny, Warm, Normal, Strong, Warm, Same)v (Sunny, Warm, High, Strong, Warm, Same),(Sunny, Warm, ?, Strong, Warm, Same) v (φ,φ,φ,φ,φ,φ)}G2 = (?, ?, ?, ?, ?, ?) v (?, ?, ?, ?, ?, ?)Example 3: <Rainy, Cold, High, Strong, Warm, Change, No>S3={(Sunny, Warm, Normal, Strong, Warm, Same)v (Sunny, Warm, High, Strong, Warm, Same),(Sunny, Warm, ?, Strong, Warm, Same) v (φ,φ,φ,φ,φ,φ)}G3 = {(Sunny, ?, ?, ?, ?, ?) v (?, Warm, ?, ?, ?, ?),(Sunny, ?, ?, ?, ?, ?) v (?, ?, ?, ?, ?, Same),(?, Warm, ?, ?, ?, ?) v (?, ?, ?, ?, ?, Same)}Example 4: <Sunny, Warm, High, Strong, Cool, Change, Yes>S4= {(Sunny, Warm, ?, Strong, ?, ?) v (Sunny, Warm, High, Strong, Warm, Same),(Sunny, Warm, Normal, Strong, Warm, Same) v (Sunny, Warm, High, Strong, ?, ?),(Sunny, Warm, ?, Strong, ?, ?)v (φ,φ,φ,φ,φ,φ),(Sunny, Warm, ?, Strong, Warm, Same)v (Sunny, Warm, High, Strong, Cool, Change)}G4 = {(Sunny, ?, ?, ?, ?, ?) v (?, Warm, ?, ?, ?, ?),(Sunny, ?, ?, ?, ?, ?) v (?, ?, ?, ?, ?, Same),(?, Warm, ?, ?, ?, ?) v (?, ?, ?, ?, ?, Same)}2.4. Consider the instance space consisting of integer points in the x, y plane and the set of hypotheses H consisting of rectangles. More precisely, hypotheses are of the form a ≤x ≤ b, c ≤ y≤d, where a, b, c, and d can be any integers.(a) Consider the version space with respect to the set of positive (+) and negative (-) training examples shown below. What is the S boundary of the version space in this case? Write out the hypotheses and draw them in on the diagram.(b) What is the G boundary of this version space? Write out the hypotheses and draw them in.(c) Suppose the learner may now suggest a new x, y instance and ask the trainer for its classification. Suggest a query guaranteed to reduce the size of the version space, regardless of how the trainer classifies it. Suggest one that will not.(d) Now assume you are a teacher, attempting to teach a particular target concept (e.g., 3 ≤ x ≤ 5,2 ≤ y ≤ 9). What is the smallest number of training examples you can provide so that the CANDIDATE-ELIMINATION algorithm will perfectly learn the target concept?Ans. (a) S= (4,6,3,5) (b) G=(3,8,2,7) (c) e.g., (7,6), (5,4) (d) 4 points: (3,2,+), (5,9,+),(2,1,-),(6,10,-)2.6. Complete the proof of the version space representation theorem (Theorem 2.1).Proof: Every member of VS H,D satisfies the right-hand side of expression.Let h be an arbitrary member of VS H,D, then h is consistent with all training examples in D. Assuming h does not satisfy the right-hand side of the expression, it means ¬(∃s∈S)∃(g∈G)(g ≥ h ≥ s) = ¬(∃s∈S)∃(g∈G) (g ≥ h) ∧ (h ≥ s). Hence, there does not exist g from G so that g is more general or equal to h or there does not exist s from S so that h is more general or equal to s.If the former holds, it leads to an inconsistence according to the definition of G. If the later holds, itleads to an inconsistence according to the definition of S. Therefore, h satisfies the right-hand side of the expression. (Notes: since we assume the expression is not fulfilled, this can be only be if S or G is empty, which can only be in the case of any inconsistent training examples, such as noise or the concept target is not member of H.)。

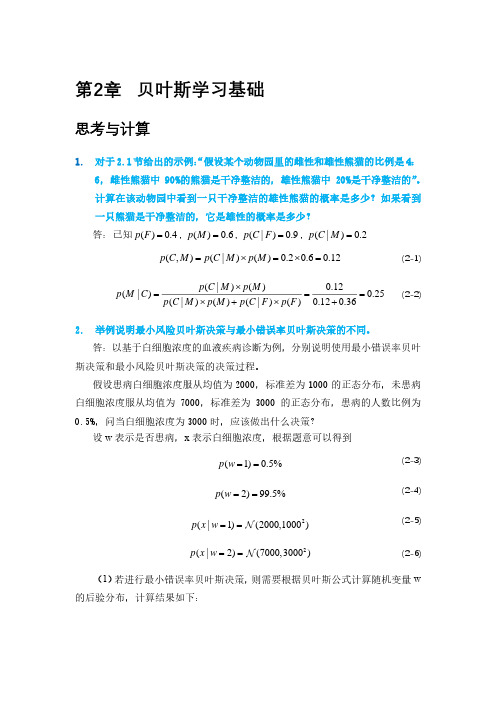

机器学习导论第2章

偏倚与方差

方差

偏倚

2.10 回归

• 数值输出写成输入的函数。假定数值输出 是输入的确定性函数与随机噪音的和:

• 其中 是未知函数,我们用定义在参数 上的估计 来近似它。如果

与估计无关, 可省略

等价于最小化

线性回归

关于w0求导 关于w1求导

可以解得

偏倚/方差 trade-off

• 由某个带噪声的 产生一组数据集 • 根据每个数据集形成一个估计 • 现实中 的估计为

2.7 模型的选择与泛化

• 实例学习布尔函数中,输入输出均为2元的。 • d个2元值有2d个写法,因此对于d个输入有 2d个样本实例,将有22d个可能的布尔函数。

2.7 模型的选择与泛化

• 学习一个样本的过程是去掉猜测出错的假 设。

– X1=0, x2=1 输出为0。 去掉了假设h5 h6 h7 h8 h 13 h14 h15. – 随着更多的实验样本,逐步去掉与训练数据不 一致的假设。

• 噪声来源?

– 记录输入属性可能不准确。 – 标记点可能有错。(指导噪声) – 可能存在我们没有考虑到的附加属性。这些属性可能 是隐藏的或潜在的,是不可以预测的。是一种随机成 分

• 当有噪声时,正负实例之间没有简单的边界。

– 利用复杂模型,更好地拟合数据,得到零误差。 – 保持模型的简单性并允许一定误差的存在。

– 现有一组汽车实例和一组被测人,展示汽车, 被测人对汽车标记:

• 正例:标记为家用汽车 • 负例:其他类型汽车

– 机器学习后预测未见过的汽车是否为家用 – 汽车特征包括 价格、发动机功率、座位数量、 车身颜色等。

2.1 由实例学习类

• 仅考虑价格(x1)和发动机功率(x2)

智慧树答案机器学习:模型与算法知到课后答案章节测试2022年

第一章1.sigmoid函数的值域为?()。

答案:(0,1)2.哪些属于监督学习重要元素?()。

答案:学习模型;标注数据;损失函数3.分析不同变量之间存在关系的研究叫回归分析。

()答案:对4.强可学习和弱可学习是等价的。

()答案:对5.下面的说法正确的是()。

答案:逻辑回归只能处理二分类问题第二章1.下面的说法正确的是()。

答案:K均值聚类算法实质上是最小化每个类簇的方差。

2.哪一项是皮尔逊相关系数的性质?()。

答案:X与Y协方差的绝对值小于等于13.下面的说法正确的有()。

答案:EM算法分为求取期望和期望最大化两个步骤。

;在K均值聚类算法中,欧式距离与方差量纲相同。

4.K均值聚类属于监督学习。

()答案:错5.特征人脸方法的本质是用称为“特征人脸”的特征向量按照线性组合形式表达每一张原始人脸图像。

()答案:对第三章1.下列哪一项不是运用半监督学习的原因()。

答案:为获得更高的机器学习性能2.在半监督学习中下列哪种说法是错误的()。

答案:“聚类假设的推广,对输出值没有限制”属于聚类假设的范畴。

3.半监督学习方法有:()。

答案:生成方法;基于图表的半监督学习;半监督SVM4.在有标记数据极少的情形下往往比其他方法性能更好是半监督学习生成式方法流程的优点。

()答案:对5.基于图表的半监督学习不用占有太大内存。

()答案:错第四章1.下列说法正确的是()。

答案:感知机网络只有输入层/输出层,无隐藏层。

2.一元变量所构成函数f在x处的梯度为()答案:;3.常用的池化操作有::()。

答案:最大池化;平均池化4.One-hot向量可以刻画词与词之间的相似性()答案:错5.前馈神经网络中存在反馈。

()答案:错第五章1.下列说法错误的是()。

答案:循环神经网络不能处理任意长度的序列2.下列说法正确的是()。

答案:如果一个完全连接的RNN有足够数量的sigmoid型隐藏神经元,它可以以任意的准确率去近似任何一个非线性动力系统个。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1.1. Give three computer applications for which machine learning approaches seem appropriate and three for which they seem inappropriate. Pick applications that are not already mentioned in this chapter, and include a one-sentence justification for each.Ans.Machine learning: Face recognition, handwritten recognition, credit card approval.Not machine learning: calculate payroll, execute a query to database, use WORD.2.1. Explain why the size of the hypothesis space in the EnjoySport learning task is 973. How would the number of possible instances and possible hypotheses increase with the addition of the attribute WaterCurrent, which can take on the values Light, Moderate, or Strong? More generally, how does the number of possible instances and hypotheses grow with the addition of a new attribute A that takes on k possible values?Ans.Since all occurrence of “φ” for an attribute of the hypothesis results in a hypothesis which does not accept any instance, all these hypotheses are equal to that one where attribute is “φ”. So the number of hypothesis is 4*3*3*3*3*3 +1 = 973.With the addition attribute Watercurrent, the number of instances = 3*2*2*2*2*2*3 = 288, the number of hypothesis = 4*3*3*3*3*3*4 +1 = 3889.Generally, the number of hypothesis = 4*3*3*3*3*3*(k+1)+1.2.3. Consider again the EnjoySport learning task and the hypothesis space H described in Section 2.2. Let us define a new hypothesis space H' that consists of all pairwise disjunctions of the hypotheses in H. For example, a typical hypothesis in H' is (?, Cold, High, ?, ?, ?) v (Sunny, ?, High, ?, ?, Same) Trace the CANDIDATE-ELIMINATATION algorithm for the hypothesis space H' given the sequence of training examples from Table 2.1 (i.e., show the sequence of S and G boundary sets.)Ans.S0= (φ,φ,φ,φ,φ,φ) v (φ,φ,φ,φ,φ,φ)G0 = (?, ?, ?, ?, ?, ?) v (?, ?, ?, ?, ?, ?)Example 1: <Sunny, Warm, Normal, Strong, Warm, Same, Yes>S1=(Sunny, Warm, Normal, Strong, Warm, Same)v (φ,φ,φ,φ,φ,φ)G1 = (?, ?, ?, ?, ?, ?) v (?, ?, ?, ?, ?, ?)Example 2: <Sunny, Warm, High, Strong, Warm, Same, Yes>S2= {(Sunny, Warm, Normal, Strong, Warm, Same)v (Sunny, Warm, High, Strong, Warm, Same),(Sunny, Warm, ?, Strong, Warm, Same) v (φ,φ,φ,φ,φ,φ)}G2 = (?, ?, ?, ?, ?, ?) v (?, ?, ?, ?, ?, ?)Example 3: <Rainy, Cold, High, Strong, Warm, Change, No>S3={(Sunny, Warm, Normal, Strong, Warm, Same)v (Sunny, Warm, High, Strong, Warm, Same),(Sunny, Warm, ?, Strong, Warm, Same) v (φ,φ,φ,φ,φ,φ)}G3 = {(Sunny, ?, ?, ?, ?, ?) v (?, Warm, ?, ?, ?, ?),(Sunny, ?, ?, ?, ?, ?) v (?, ?, ?, ?, ?, Same),(?, Warm, ?, ?, ?, ?) v (?, ?, ?, ?, ?, Same)}Example 4: <Sunny, Warm, High, Strong, Cool, Change, Yes>S4= {(Sunny, Warm, ?, Strong, ?, ?) v (Sunny, Warm, High, Strong, Warm, Same),(Sunny, Warm, Normal, Strong, Warm, Same) v (Sunny, Warm, High, Strong, ?, ?),(Sunny, Warm, ?, Strong, ?, ?)v (φ,φ,φ,φ,φ,φ),(Sunny, Warm, ?, Strong, Warm, Same)v (Sunny, Warm, High, Strong, Cool, Change)}G4 = {(Sunny, ?, ?, ?, ?, ?) v (?, Warm, ?, ?, ?, ?),(Sunny, ?, ?, ?, ?, ?) v (?, ?, ?, ?, ?, Same),(?, Warm, ?, ?, ?, ?) v (?, ?, ?, ?, ?, Same)}2.4. Consider the instance space consisting of integer points in the x, y plane and the set of hypotheses H consisting of rectangles. More precisely, hypotheses are of the form a ≤x ≤ b, c ≤ y≤d, where a, b, c, and d can be any integers.(a) Consider the version space with respect to the set of positive (+) and negative (-) training examples shown below. What is the S boundary of the version space in this case? Write out the hypotheses and draw them in on the diagram.(b) What is the G boundary of this version space? Write out the hypotheses and draw them in.(c) Suppose the learner may now suggest a new x, y instance and ask the trainer for its classification. Suggest a query guaranteed to reduce the size of the version space, regardless of how the trainer classifies it. Suggest one that will not.(d) Now assume you are a teacher, attempting to teach a particular target concept (e.g., 3 ≤ x ≤ 5,2 ≤ y ≤ 9). What is the smallest number of training examples you can provide so that the CANDIDATE-ELIMINATION algorithm will perfectly learn the target concept?Ans. (a) S= (4,6,3,5) (b) G=(3,8,2,7) (c) e.g., (7,6), (5,4) (d) 4 points: (3,2,+), (5,9,+),(2,1,-),(6,10,-)2.6. Complete the proof of the version space representation theorem (Theorem 2.1).Proof: Every member of VS H,D satisfies the right-hand side of expression.Let h be an arbitrary member of VS H,D, then h is consistent with all training examples in D. Assuming h does not satisfy the right-hand side of the expression, it means ¬(∃s∈S)∃(g∈G)(g ≥ h ≥ s) = ¬(∃s∈S)∃(g∈G) (g ≥ h) ∧ (h ≥ s). Hence, there does not exist g from G so that g is more general or equal to h or there does not exist s from S so that h is more general or equal to s.If the former holds, it leads to an inconsistence according to the definition of G. If the later holds, itleads to an inconsistence according to the definition of S. Therefore, h satisfies the right-hand side of the expression. (Notes: since we assume the expression is not fulfilled, this can be only be if S or G is empty, which can only be in the case of any inconsistent training examples, such as noise or the concept target is not member of H.)。