Basic_OpenStack_Grizzly_Install_Guide_20130619_pc_v1

openstack操作手册

以下是使用openstack的基本操作手册:

1. 安装openstack:根据您的系统和环境要求,遵循官方的安装指南进行安装。

2. 创建项目:使用命令行或管理界面创建一个新的项目。

项目将包含一组资源,包括计算、网络和存储资源。

3. 创建网络:在项目中创建一个新的网络。

网络是用于连接云中的虚拟机和其他资源的虚拟架构。

4. 创建虚拟机:使用命令行或管理界面在项目中创建一个新的虚拟机。

您需要指定所需的配置选项,例如操作系统、处理器、内存和存储。

5. 连接到虚拟机:使用SSH或其他远程桌面工具连接到虚拟机。

您需要提供虚拟机的IP地址和密码或密钥。

6. 配置和管理虚拟机:根据需要配置和管理虚拟机,例如安装软件、配置网络设置等。

7. 创建和管理云存储:使用命令行或管理界面在项目中创建一个新的云存储后端。

您可以定义存储的容量、访问级别和其他配置选项。

8. 创建和管理镜像:使用命令行或管理界面在项目中创建一个新的镜像。

镜像是虚拟机的完整快照,可用于创建新的虚拟机实例。

9. 管理和监控资源:使用命令行或管理界面监控和管理项目中的资源使用情况,例如CPU、内存和存储。

10. 删除项目和资源:根据需要删除项目和其中的资源,以释放云资源并降低成本。

以上是openstack的基本操作手册,根据您的具体需求,您可能需要进行其他高级配置和管理操作。

建议参考openstack的官方文档以获取更详细的信息和指导。

01 OpenStack多节点环境部署之Controller配置详解

CREATE DATABASE quantum;

GRANT ALL ON quantum.* TO 'quantumUser'@'%' IDENTIFIED BY 'quantumPass';

#Nova

CREATE DATABASE nova;

GRANT ALL ON nova.* TO 'novaUser'@'%' IDENTIFIED BY 'novaPass';

connection = mysql://keystoneUser:keystonePass@172.16.77.128/keystone

重启服务:service keystone restart

查看下数据库:

把结构同步到数据库中:keystone-manage db_sync

再次查看数据库:

下载脚本:

重启服务:service glance-api restart; service glance-registry restart

查看进程:ps -ef | grep glance

同步结构到库表:

查看同步是否成功:

上传cirros-0.3.0-x86_64-disk.img:

创建镜像:

查看镜像:

安装Quantum组件:apt-get install -y quantum-server

quantum_url=http://172.16.77.128:9696

quantum_auth_strategy=keystone

quantum_admin_tenant_name=service

quantum_admin_username=quantum

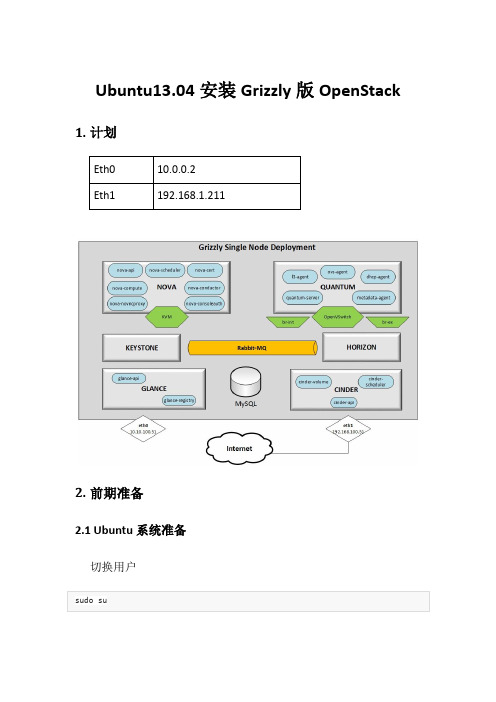

Ubuntu13.04安装Grizzly版本的OpenStack

Ubuntu13.04安装Grizzly版OpenStack 1.计划2.前期准备2.1 Ubuntu系统准备切换用户增加Grizzly源升级系统:2.2网络设置编辑/etc/network/interfaces设置好后重启网络:service networking restartUbuntu13.04桌面版不要用上面的命令重启网络,不然会卡死!可以用ifdown和ifup来启动和停止网卡2.3.安装MySQL &RabbitMQ安装MySQL:配置并重启MySQL:安装RabbitMQ:安装NTP:2.4.其他配置/etc/sysctl.conf3.Keystone安装并检查状态:建立数据库(蓝色标记的用户名和密码可改):修改/etc/keystone/keystone.conf中的数据库连接重启并同步数据库:用下面两个脚本去填充keystone数据库,也就是增加user,tenant,role和service以及service的endpoint修改keystone_basic.sh中的HOST_IP为自己的Eth0的IP,ADMIN_PASSWORD 和SERVICE_PASSWORD可改可不改:修改keystone_endpoints_basic.sh中的HOST_IP和EXT_HOST_IP,同时将连接keystone数据库的的用户名和密码进行修改:编辑文件creds引入环境变量中:sourcecreds或者可以直接加入root(cat creds>> /root/.bashrc)的环境变量,这样重启后就无需再次引入了查看创建的user同样有命令keystone tenant-list 和keystone role-list4.Glance安装并查看状态:建立glance数据库(用户名和密码可改):修改/etc/glance/glance-api-paste.ini和/etc/glance/glance-registry-paste.ini文件注:红色为必须要修改(核对)的地方,建议把提到的这几项都核对一下:编辑/etc/glance/glance-api.conf和/etc/glance/glance-registry.conf,修改数据库连接:并且在[paste_deploy]下加上flavor = keystone重启服务同步数据库:再次重启服务上传镜像测试glance的安装情况:查看镜像:5.Quantum5.1. OpenVSwitch安装OpenVSwitch建立网桥br-int和br-ex:5.2. Quantum-*安装quantum组件:创建quantum数据库(用户名和密码可修改):查看Quantum-*组件状态编辑/etc/quantum/api-paste.ini编辑OVS插件配置文件/etc/quantum/plugins/openvswitch/ovs_quantum_plugin.ini编辑/etc/quantum/metadata_agent.ini编辑/etc/quantum/quantum.conf重启quantum服务6.Nova6.1 KVM确保硬件支持虚拟化:安装kvm编辑/etc/libvirt/qemu.conf文件,使得cgroup_device_acl与下面相同:删除默认的网桥(也可以不删除,不会有影响)编辑/etc/libvirt/libvirtd.conf文件以便支持动态迁移:修改/etc/init/libvirt-bin.conf中的libvirtd_opts变量修改/etc/default/libvirt-bin中的libvirtd_opts变量重启libvirt服务使得修改生效6.2 Nova-*安装nova组件:查看各组件状态:建立Nova数据库修改/etc/nova/api-paste.ini文件::修改/etc/nova/nova.conf文件(最好是把原来的文件备份,然后新建和下面一样的文件):编辑/etc/nova/nova-compute.conf:同步数据库:重启nova-*服务检查nova-*各项服务是否工作正常(笑脸为正常)7.Cinder安装Cinder以及必须的软件包配置iscsi服务:重启所有服务:建立Cinder数据库修改/etc/cinder/api-paste.ini:编辑/etc/cinder/cinder.conf:同步数据库:创建cinder-volumes:为了重启后逻辑组cinder-volumes还在,可以在/etc/rc.local的exit 0之前加入重启cinder服务:查看是否正常:8.Horizon安装horizon如果不喜欢OpenStackubuntu的主题页面,可以去除改包:重启apache2 和memcached服务然后就可以从网页上访问192.168.1.210/horizon如果没有改,则默认的账号和密码是:admin:admin_pass.9.启动虚拟机为该租户admin创建一个内部网络(查看租户Id,命令为keystone tenant-list):创建子网:创建路由:把路由加入子网创建外部网络:*Note: $id_of_service_tenant 来自租户“service”,可用keystone tenant-list 查看获取;创建外网用子网192.168.1.x:关联外网和admin的路由:10.将内部外部网卡加入br-ex并清除外部网卡的IP ovs-vsctl add-port br-ex eth1ifconfig eth1 0ifconfigbr-ex 192.168.1.210 netmask 255.255.255.0route adddefaltgw 192.168.1.1上面的设置在重启电脑后配置就会无效,要想重启有效,就写入配置文件/etc/network/interfaces(这样修改后,启动后br-ex和eth1是满足要求了,但是启动的虚拟机又无法ping通,解决办法是:将上述命令写入脚本文件,然后再链接到rc2.d(ln–s XXX.sh /etc/rc2.d/S99XX)中,开机后执行脚本,这样就可以解决了)11.Windows镜像制作方法apt-get install virt-manager(下载虚拟机管理器)在桌面上的Applications-→System Tools -→Virtual Machine Manager 打开虚拟机管理器902b,94de下载驱动OpenStack只支持Virtio总线的磁盘,但是windows本身没有Virtio的相关驱动程序,所以首先需要先下载相关驱动程序,下载地址/pub/alt/virtio-win/latest/images/bin/。

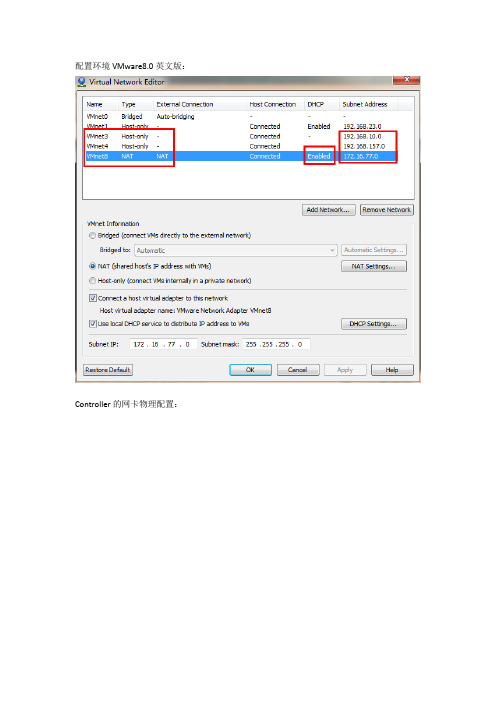

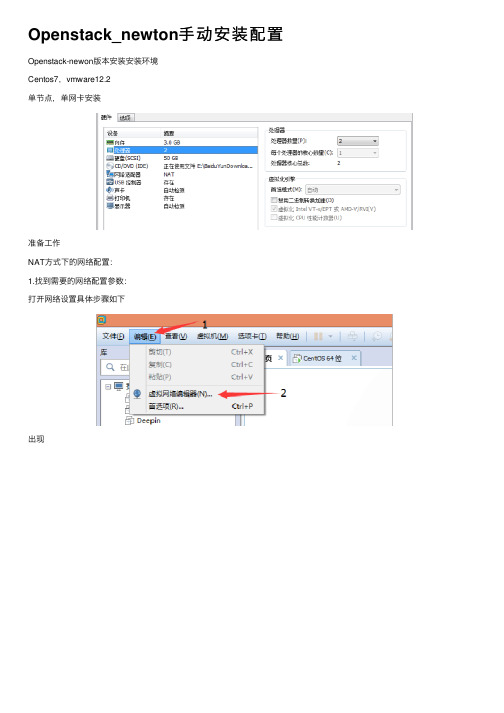

Openstack_newton手动安装配置

Openstack_newton⼿动安装配置Openstack-newon版本安装安装环境Centos7,vmware12.2单节点,单⽹卡安装准备⼯作NAT⽅式下的⽹络配置:1.找到需要的⽹络配置参数:打开⽹络设置具体步骤如下出现虚拟机创建双⽹卡选取NAT⽹络模式,详细⽹络配置见上图外⽹:内⽹:下⾯是本⼈的⽹络配置(此虚拟机图⽚与本⼈虚拟机不同)[root@localhost ~]# cat /etc/sysconfig/network-scripts/ifcfg-eno16777736 TYPE="Ethernet"BOOTPROTO=staticDEFROUTE="yes"IPV4_FAILURE_FATAL="no"IPV6INIT="yes"IPV6_AUTOCONF="yes"IPV6_DEFROUTE="yes"IPV6_FAILURE_FATAL="no"NAME="eno16777736"UUID="e52041f9-6cce-49f5-9f75-dced407765a4"DEVICE="eno16777736"ONBOOT="yes"IPADDR=192.168.174.222NETMASK=255.255.255.0GATEWAY=192.168.174.2PEERDNS="yes"DNS1=8.8.8.8IPV6_PEERDNS=yesIPV6_PEERROUTES=yes修改主机名:[root@localhost ~]# hostnamectl set-hostname controller --static –transient 修改hosts⽂件:[root@controller ~]# vi /etc/hosts192.168.174.222 controller安装NTP_SERVER[root@controller ~]# yum install chrony启动ntp:[root@controller ~]# systemctl enable chronyd.service[root@controller ~]# systemctl start chronyd.service检查ntp[root@controller ~]# chronyc sources效果如图:安装rdo源:[root@controller ~]# yum install centos-release-openstack-newton –y[root@controller ~]# yum install https:///doc/16d70a284a73f242336c1eb91a37f111f1850dfb.html /repos/rdo-release.rpm -y 进⾏升级:[root@controller ~]# yum upgrade安装openstack客户端:[root@controller ~]# yum install python-openstackclient–y[root@controller ~]# yum install openstack-selinux -y安装mysql数据库:[root@controller ~]# yum install mariadbmariadb-server python2-PyMySQL –y配置mysql/etc//doc/16d70a284a73f242336c1eb91a37f111f1850dfb.htmlf.d//doc/16d70a284a73f242336c1eb91a37f111f1850dfb.html f[root@controller ~]# vim /etc//doc/16d70a284a73f242336c1eb91a37f111f1850dfb.htmlf.d//doc/16d70a284a73f242336c1eb91a37f111f1850dfb.html f[mysqld]bind-address = 0.0.0.0default-storage-engine = innodbinnodb_file_per_tablemax_connections = 4096collation-server = utf8_general_cicharacter-set-server = utf8完成安装:Start the database service and configure it to start when the system boots: [root@controller ~]# systemctl enable mariadb.service[root@controller ~]# systemctl start mariadb.service设置mysql⽤户root登陆密码:root[root@controller ~]# mysql_secure_installation安装消息队列:Install the package[root@controller ~]# yum install rabbitmq-server –y启动:[root@controller ~]# systemctl enable rabbitmq-server.service[root@controller ~]# systemctl start rabbitmq-server.service创建⽤户Add the openstack user:[root@controller ~]# rabbitmqctladd_useropenstack RABBIT_PASS设置权限Permit configuration, write, and read access for the openstack user[root@controller ~]# rabbitmqctlset_permissionsopenstack ".*" ".*" ".*"安装memcached[root@controller ~]# yum install memcached python-memcached–y设置开机启动:[root@controller ~]# systemctl enable memcached.service[root@controller ~]# systemctl start memcached.service安装认证服务:keystone1.To create the database, complete the following actions:[root@controller ~]# mysql -u root -prootCreate the keystone database:MariaDB [(none)]> CREATE DATABASE keystone;Grant proper access to the keystone database:MariaDB [(none)]> G RANT ALL PRIVILEGES ON keystone.* TO 'keystone'@'localhost' \-> IDENTIFIED BY 'KEYSTONE_DBPASS';Query OK, 0 rows affected (0.00 sec)MariaDB [(none)]>GRANT ALL PRIVILEGES ON keystone.* TO 'keystone'@'%' \-> IDENTIFIED BY 'KEYSTONE_DBPASS';Query OK, 0 rows affected (0.00 sec)1.Run the following command to install the packages:2.dit the /etc/keystone/keystone.conf file and complete the following actions: In the [database] section, configure database access:Replace KEYSTONE_DBPASS with the password you chose for the database.In the [token] section, configure the Fernet token provider:3.pulate the Identity service database:同步数据库#su -s /bin/sh -c "keystone-manage db_sync" keystone4.nitialize Fernet key repositories:#keystone-manage fernet_setup --keystone-user keystone --keystone-groupReplace ADMIN_PASS with a suitable password for an administrative user。

openstack操作手册

openstack操作手册摘要:I.简介- Openstack 简介- 为什么使用Openstack- Openstack 的组成部分II.Openstack 安装与配置- 安装Openstack 的前提条件- 安装Openstack 的步骤- 配置OpenstackIII.Openstack 服务与组件- Openstack 服务的概述- 主要Openstack 组件的作用- Openstack 服务的实例IV.Openstack 命令行操作- 使用命令行操作Openstack- 常见命令介绍与示例- 高级命令与选项V.Openstack API 与自动化- Openstack API 概述- 使用Openstack API 进行自动化- 常见API 请求与响应VI.Openstack 与其他开源工具的集成- Openstack 与Keystone 集成- Openstack 与Glance 集成- Openstack 与Horizon 集成VII.常见问题与解决方案- 安装与配置问题- 操作与使用问题- 安全与稳定性问题正文:Openstack 是一个开源的云计算平台,用于部署私有云和公有云。

它提供了计算、存储和网络服务,并具有高度可扩展性和弹性。

Openstack 由几个主要组件组成,包括Nova、Glance、Keystone、Swift、Cinder、Neutron 等。

安装与配置Openstack 需要满足一些前提条件,例如安装Python、OpenSSL、Linux 内核等。

安装过程可以使用TripleO、Kolla、Packstack 等工具进行自动化部署。

在安装完成后,需要对Openstack 进行配置,包括设置数据库、消息队列、认证服务等方面的参数。

Openstack 提供了丰富的命令行工具,可以进行各种操作,例如创建项目、创建实例、挂载卷等。

常见的命令包括nova 命令、glance 命令、keystone 命令等。

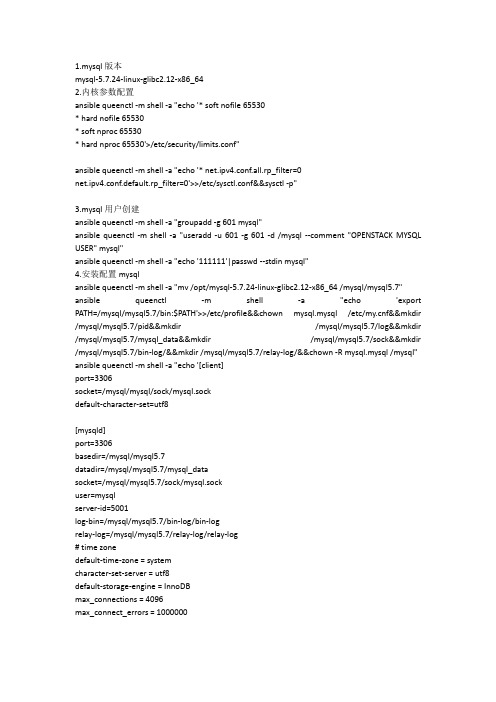

openstack-rocky安装手册

mysql-5.7.24-linux-glibc2.12-x86_642.内核参数配置ansible queenctl -m shell -a "echo '* soft nofile 65530* hard nofile 65530* soft nproc 65530* hard nproc 65530'>/etc/security/limits.conf"ansible queenctl -m shell -a "echo '* net.ipv4.conf.all.rp_filter=0net.ipv4.conf.default.rp_filter=0'>>/etc/sysctl.conf&&sysctl -p"3.mysql用户创建ansible queenctl -m shell -a "groupadd -g 601 mysql"ansible queenctl -m shell -a "useradd -u 601 -g 601 -d /mysql --comment "OPENSTACK MYSQL USER" mysql"ansible queenctl -m shell -a "echo '111111'|passwd --stdin mysql"4.安装配置mysqlansible queenctl -m shell -a "mv /opt/mysql-5.7.24-linux-glibc2.12-x86_64 /mysql/mysql5.7" ansible queenctl -m shell -a "echo 'export PATH=/mysql/mysql5.7/bin:$PATH'>>/etc/profile&&chown mysql.mysql /etc/f&&mkdir /mysql/mysql5.7/pid&&mkdir /mysql/mysql5.7/log&&mkdir /mysql/mysql5.7/mysql_data&&mkdir /mysql/mysql5.7/sock&&mkdir /mysql/mysql5.7/bin-log/&&mkdir /mysql/mysql5.7/relay-log/&&chown -R mysql.mysql /mysql" ansible queenctl -m shell -a "echo '[client]port=3306socket=/mysql/mysql/sock/mysql.sockdefault-character-set=utf8[mysqld]port=3306basedir=/mysql/mysql5.7datadir=/mysql/mysql5.7/mysql_datasocket=/mysql/mysql5.7/sock/mysql.sockuser=mysqlserver-id=5001log-bin=/mysql/mysql5.7/bin-log/bin-logrelay-log=/mysql/mysql5.7/relay-log/relay-log# time zonedefault-time-zone = systemcharacter-set-server = utf8default-storage-engine = InnoDBmax_connections = 4096max_connect_errors = 1000000log-error=/mysql/mysql5.7/log/mysqld.logpid-file=/mysql/mysql5.7/pid/mysqld.pid' > /etc/f"ansible queenctl -m shell -a "/mysql/mysql5.7/bin/mysqld --user=mysql --initialize-insecure"echo '#!/bin/shcd /mysql/mysql5.7./bin/mysqld_safe&'> /root/script/start_mysql.shecho '#!/bin/shcd /mysql/mysql5.7./bin/mysqladmin -uroot -p111111 shutdown'>./stop_mysql.shansible queenctl -m copy -a "src=/root/script/ dest=/mysql"ansible queenctl -m shell -a "chown -R mysql.mysql /mysql"ansible queenctl -m shell -a "su - mysql && sh /mysql/start_mysql.sh"ansible queenctl -m shell -a "/mysql/mysql5.7/bin/mysqladmin -u root password '111111'"mysql复制配置在ctl01数据库中配置:mysql -uroot -p'111111'grant replication slave on *.* to 'repl'@'%' identified by '111111';flush privileges;show master status;+----------------+----------+--------------+------------------+-------------------+| File | Position | Binlog_Do_DB | Binlog_Ignore_DB | Executed_Gtid_Set |+----------------+----------+--------------+------------------+-------------------+| bin-log.000002 | 1158 | | | |+----------------+----------+--------------+------------------+-------------------+在ctl02数据库中配置:change master to master_host='192.168.2.215', master_port=3306, master_user='repl', master_password='111111', master_log_file='bin-log.000039', master_log_pos=154;start slave;show slave status\G; ##验证复制配置是否成功。

openstack操作手册

openstack操作手册一、OpenStack简介与架构1.OpenStack概述OpenStack是一个开源的云计算平台,它提供了一整套解决方案,用于部署私有云和公有云。

OpenStack具有高度可扩展、弹性和易于管理的特点,广泛应用于全球各大企业及政府机构。

2.OpenStack核心组件OpenStack主要由以下几个核心组件组成:(1)Nova:计算服务组件,负责虚拟机实例的创建、启动、停止和删除等操作。

(2)Glance:镜像服务组件,用于管理虚拟机镜像的创建、存储和分发。

(3)Swift:对象存储服务组件,提供海量、高可用的对象存储服务。

(4)Keystone:认证服务组件,负责OpenStack整个系统的身份认证和权限管理。

二、OpenStack部署与运维1.部署流程OpenStack部署主要包括以下步骤:(1)准备环境:包括硬件、网络、操作系统等基础设施。

(2)安装OpenStack:根据官方文档,遵循相应的安装教程。

(3)配置OpenStack:配置各个组件之间的关系,如数据库、消息队列等。

(4)启动OpenStack:启动各个组件,并确保它们正常运行。

2.运维策略运维OpenStack时,需要注意以下几点:(1)监控:定期检查系统性能、资源使用情况,确保OpenStack稳定运行。

(2)备份:定期对关键数据进行备份,以防数据丢失或损坏。

(3)安全:确保OpenStack集群的安全性,采取必要的防火墙、加密等措施。

(4)升级:根据OpenStack版本更新计划,及时进行组件升级。

三、OpenStack常用操作教程1.创建与删除实例(1)登录OpenStack控制台,进入Nova组件。

(2)选择实例类型、镜像、存储等信息。

(3)确认配置无误后,创建实例。

(4)实例创建完成后,可以登录到虚拟机进行操作。

(5)若需要删除实例,请在Nova组件中进行操作。

2.配置网络与存储(1)进入Neutron组件,配置虚拟网络、子网和路由器。

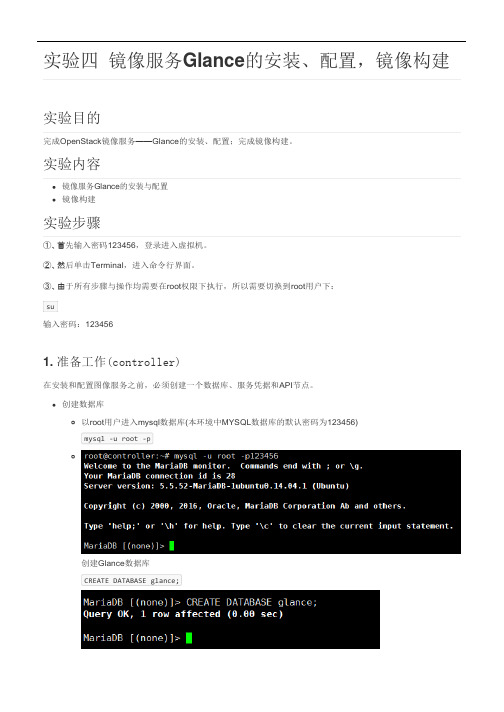

手动安装OpenStack 实验4:镜像服务Glance的安装、配置,镜像构建

实验四镜像服务Glance的安装、配置,镜像构建实验目的完成OpenStack镜像服务——Glance的安装、配置;完成镜像构建。

实验内容镜像服务Glance的安装与配置镜像构建实验步骤①、首先输入密码123456,登录进入虚拟机。

②、然后单击Terminal,进入命令行界面。

③、由于所有步骤与操作均需要在root权限下执行,所以需要切换到root用户下:su输入密码:1234561. 准备工作(controller)在安装和配置图像服务之前,必须创建一个数据库、服务凭据和API节点。

创建数据库以root用户进入mysql数据库(本环境中MYSQL数据库的默认密码为123456)mysql -u root -p创建Glance数据库CREATE DATABASE glance;GRANT ALL PRIVILEGES ON glance.* TO 'glance'@'localhost' IDENTIFIED BY'123456';GRANT ALL PRIVILEGES ON glance.* TO 'glance'@'%' IDENTIFIED BY '123456';quitopenstack user create --domain default --password-prompt glanceopenstack role add --project service --user glance adminopenstack service create --name glance --description "OpenStack Image" image授予Glance数据库访问权限,使得本地及远程都能访问(需要将123456替换成你自己的密码)退出数据库获得管理员凭据来访问仅管理员CLI命令执行.admin-openrc脚本创建服务凭据创建Glance用户(请记住你的输入的密码,建议还是123456)添加管理员角色到用户和服务项目(这条命令没有返回)创建Glance服务. admin-openrcopenstack endpoint create --region RegionOne image public http://controller:9292openstack endpoint create --region RegionOne image internal http://controller:9292openstack endpoint create --region RegionOne image admin http://controller:9292创建镜像服务的节点创建镜像服务API节点2. 安装和配置组件默认配置文件按分布变化。

OpenStack安装手册

OpenStack安装手册目录OpenStack安装手册 (1)一、安装环境 (4)1、示例架构 (4)2、网络 (4)3、安全 (5)4、主机网络配置 (5)5、NTP (7)6、安装OpenStack包 (9)7、安装数据库 (10)8、消息队列 (11)9、缓存令牌 (12)二、认证服务 (12)在控制节点上配置。

(13)1、前提条件 (13)配置Apache服务器 (15)3、创建一个域、项目、用户和角色 (16)4、验证操作 (17)1、前提条件 (20)2、安装并配置组件 (22)5、验证操作 (24)四、计算服务 (25)1、安装和配置控制节点 (25)∙安装并配置组件 (26)∙完成安装 (30)3、安装并配置计算节点 (30)∙安装并配置组件 (30)∙验证操作 (33)一、安装环境1、示例架构根据官方文档,本文架构采用一个控制节点和一个计算节点。

(The example architecture requires at least twonodes (hosts) to launch a basic virtual machine or instance. )控制节点运行认证服务、镜像服务、计算服务的管理部分、网络服务的管理部分、各种网络代理以及Dashboard,还包括一些基础服务如数据库、消息队列以及NTP。

计算节点上运行计算服务中管理实例的管理程序部分。

默认情况下,计算服务使用KVM。

还运行网络代理服务,用来连接实例和虚拟网络以及通过安全组给实例提供防火墙服务。

2、网络∙公有网络公有网络选项以尽可能简单的方式通过layer-2(网桥/交换机)服务以及VLAN网络的分割来部署OpenStack网络服务。

实际上,它将虚拟网络桥接到物理网络,并依靠物理网络基础设施提供layer-3服务(路由)。

另外,DHCP服务为实例提供IP地址。

∙私有网络私有网络选项扩展了公有网络选项,增加了layer-3(路由)服务,使用VXLAN类似的方式。

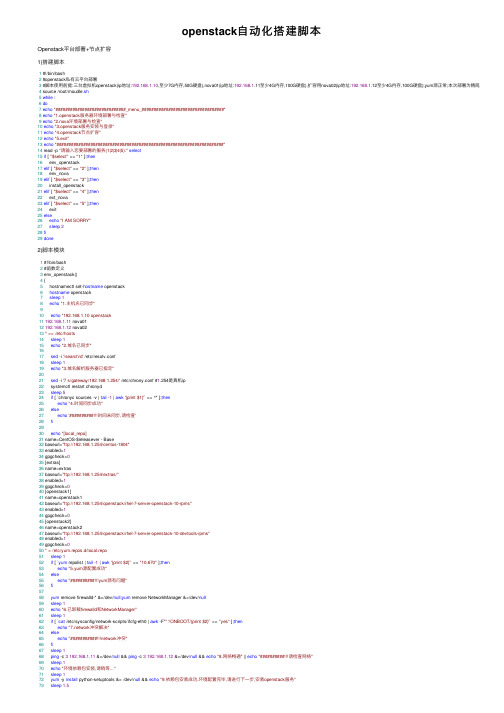

openstack自动化搭建脚本

openstack⾃动化搭建脚本Openstack平台部署+节点扩容1)搭建脚本1 #!/bin/bash2 #openstack私有云平台部署3 #脚本使⽤前提:三台虚拟机openstack(ip地址:192.168.1.10,⾄少7G内存,50G硬盘),nova01(ip地址:192.168.1.11⾄少4G内存,100G硬盘),扩容⽤nova02(ip地址:192.168.1.12⾄少4G内存,100G硬盘);yum源正常;本次部署为精简版安装4 source /root/moudle.sh5while :6do7echo"#############################_menu_##################################"8echo"1.openstack服务器环境部署与检查"9echo"2.nova环境部署与检查"10echo"3.openstack服务安装与登录"11echo"4.openstack节点扩容"12echo"5.exit"13echo"#####################################################################"14 read -p "请输⼊您要部署的服务(1|2|3|4|5):"select15if [ "$select" == "1" ];then16 env_openstack17elif [ "$select" == "2" ];then18 env_nova19elif [ "$select" == "3" ];then20 install_openstack21elif [ "$select" == "4" ];then22 ext_nova23elif [ "$select" == "5" ];then24 exit25else26echo"I AM SORRY"27sleep228fi29done2)脚本模块1 #!/bin/bash2 #函数定义3 env_openstack()4 {5 hostnamectl set-hostname openstack6hostname openstack7sleep18echo"1.主机名已同步"910echo"192.168.1.10 openstack11192.168.1.11 nova0112192.168.1.12 nova0213" >> /etc/hosts14sleep115echo"2.域名已同步"1617sed -i '/search/d' /etc/resolv.conf18sleep119echo"3.域名解析服务器已指定"2021sed -i '7 s/gateway/192.168.1.254/' /etc/chrony.conf #1.254是真机ip22 systemctl restart chronyd23sleep524if [ `chronyc sources -v | tail -1 | awk'{print $1}'` == ^* ];then25echo"4.时间同步成功"26else27echo'##########时间未同步,请检查'28fi2930echo"[local_repo]31 name=CentOS-$releasever - Base32 baseurl="ftp://192.168.1.254/centos-1804"33 enabled=134 gpgcheck=035 [extras]36 name=extras37 baseurl="ftp://192.168.1.254/extras/"38 enabled=139 gpgcheck=040 [openstack1]41 name=openstack142 baseurl="ftp://192.168.1.254/openstack/rhel-7-server-openstack-10-rpms"43 enabled=144 gpgcheck=045 [openstack2]46 name=openstack247 baseurl="ftp://192.168.1.254/openstack/rhel-7-server-openstack-10-devtools-rpms"48 enabled=149 gpgcheck=050" > /etc/yum.repos.d/local.repo51sleep152if [ `yum repolist | tail -1 | awk'{print $2}'` == "10,670" ];then53echo"5.yum源配置成功"54else55echo"##########yum源有问题"56fi5758yum remove firewalld-* &>/dev/null;yum remove NetworkManager &>/dev/null59sleep160echo"6.已卸载firewalld和NetworkManager"61sleep162if [ `cat /etc/sysconfig/network-scripts/ifcfg-eth0 | awk -F'"''/ONBOOT/{print $2}'` == "yes" ];then63echo"work冲突解决"64else65echo"###########network冲突"66fi67sleep168ping -c 3192.168.1.11 &>/dev/null && ping -c 3192.168.1.12 &>/dev/null && echo"8.⽹络畅通" || echo"##########请检查⽹络"69sleep170echo"环境依赖包安装,请稍等..."71sleep172yum -y install python-setuptools &> /dev/null && echo"9.依赖包安装成功,环境配置完毕,请进⾏下⼀步,安装openstack服务"73sleep1.574 }7576 env_nova()77 {78 read -p "请输⼊主机名尾号(01|02):" a79 hostnamectl set-hostname nova$a80hostname nova$a81sleep182echo"1.主机名已同步"8384echo"192.168.1.10 openstack85192.168.1.11 nova0186192.168.1.12 nova0287" >> /etc/hosts88sleep189echo"2.域名已同步"9091sed -i '/search/d' /etc/resolv.conf92sleep193echo"3.域名解析服务器已指定"9495sed -i '7 s/gateway/192.168.1.254/' /etc/chrony.conf #1.254是真机ip96 systemctl restart chronyd97sleep598if [ `chronyc sources -v | tail -1 | awk'{print $1}'` == "^*" ];then99echo"4.时间同步成功"100else101echo'##########时间未同步,请检查'102fi103104echo"[local_repo]105 name=CentOS-$releasever - Base106 baseurl="ftp://192.168.1.254/centos-1804"107 enabled=1108 gpgcheck=0109 [extras]110 name=extras111 baseurl="ftp://192.168.1.254/extras/"112 enabled=1113 gpgcheck=0114 [openstack1]115 name=openstack1116 baseurl="ftp://192.168.1.254/openstack/rhel-7-server-openstack-10-rpms"117 enabled=1118 gpgcheck=0119 [openstack2]120 name=openstack2121 baseurl="ftp://192.168.1.254/openstack/rhel-7-server-openstack-10-devtools-rpms"122 enabled=1123 gpgcheck=0124" > /etc/yum.repos.d/local.repo125sleep1126if [ `yum repolist | tail -1 | awk'{print $2}'` == "10,670" ];then127echo"5.yum源配置成功"128else129echo"##########yum源有问题"130fi131yum remove firewalld-* &>/dev/null;yum remove NetworkManager &>/dev/null132sleep1133echo"6.已卸载firewalld和NetworkManager"134sleep1135if [ `cat /etc/sysconfig/network-scripts/ifcfg-eth0 | awk -F'"''/ONBOOT/{print $2}'` == "yes" ];then136echo"work冲突解决"137else138echo"###########network冲突"139fi140sleep1141ping -c 3192.168.1.10 &>/dev/null && ping -c 3192.168.1.12 &>/dev/null && echo"8.⽹络畅通" || echo"##########请检查⽹络"142143echo"环境依赖包安装,请稍等..."144yum -y install python-setuptools qemu-kvm libvirt-daemon libvirt-daemon-driver-qemu libvirt-client &> /dev/null && echo"9.依赖包安装成功,环境配置完毕,请进⾏下⼀步" 145sleep1.5146 }147148 install_openstack()149 {150yum -y install openstack-packstack151 cd /root/152 packstack --gen-answer-file=answer.ini153sed -i '42 s/=y/=n/' answer.ini154sed -i '45 s/=y/=n/' answer.ini155sed -i '49 s/=y/=n/' answer.ini156sed -i '53 s/=y/=n/' answer.ini157sed -i '75 s/=/=192.168.1.254/' answer.ini158sed -i '98 s/1.10/1.11/' answer.ini159sed -i '102 s/1.10/1.10,192.168.1.11/' answer.ini160sed -i '333 s/=.*$/=a/' answer.ini161sed -i '840 s/=vx/=flat,vx/' answer.ini162sed -i '910 s/=/=physnet1:br-ex/' answer.ini163sed -i '921 s/=/=br-ex:eth0/' answer.ini164sed -i '1179 s/=y/=n/' answer.ini165echo"开始安装请耐⼼等待⼤约30min..."166 packstack --answer-file=answer.ini167sed -i '/WSGIProcessGroup apache/a WSGIApplicationGroup %{GLOBAL}' /etc/httpd/conf.d/15-horizon-vhost.conf168 apachectl graceful169echo"安装成功!欢迎使⽤,请访问以下⽹址http://192.168.1.10进⾏访问,账户密码为您的应答⽂件设置"170 }171172 ext_nova()173 {174 cd /root/175sed -i '98 s/1.11/1.11,192.168.1.12/' answer.ini176sed -i '102 s/1.11/1.11,192.168.1.12/' answer.ini177echo"开始安装请耐⼼等待⼤约30min..."178 packstack --answer-file=answer.ini179sed -i '/WSGIProcessGroup apache/a WSGIApplicationGroup %{GLOBAL}' /etc/httpd/conf.d/15-horizon-vhost.conf180 apachectl graceful181echo"扩容成功!欢迎使⽤,请访问以下⽹址http://192.168.1.10进⾏访问,账户密码>为您的应答⽂件设置"182 }。

openstack安装手册(半中文版)

翻译说明:由于名词和软件指令、脚本容易混淆,,导致无法与实际安装配置环境对应,本文会尽量不去翻译这些内容。

实际上,直接看原文,至少对照原文学习和操作,会避免很多因翻译产生的问题。

光头猪猪1.OpenStack基本安装简介如果你想利用Ubuntu 12.04 LTS (使用 Ubuntu Cloud Archive)来部署OpenStack Folsom平台用于开发测试,本文会为你提供帮助。

我们将完成一套三节点的安装,包括一个控制器、一个网络节点和一个计算节点。

当然,你也可以按你的需要安装尽可能多的计算节点。

对于希望安装测试基础平台的OpenStack初学者,本文会成为一个良好的开始。

Architecture一个标准的Quantum安装包括多达四个物理上分离的数据中心网络:• 管理网络。

用于OpenStack组件之间的内部通信。

在此网络上的IP地址应仅在数据中心内部可达。

• 数据网络。

用于所部署的云内部的虚拟机数据通信。

该网络的IP地址分配需求取决于使用中的Quan tum 插件。

• 外部网络。

用在某些部署方案中提供可访问Internet的虚拟机。

此网络上的IP地址应对Internet上的任何人都可达。

• API网络。

向租户公开所有OpenStack Api,包括Quantum API。

此网络上的IP地址应对Internet上的任何人都可达。

本网络可能和外部网络是同一个网络,因为你可以划分整个IP地址分配范围的一部分在外部网络建立一个Quantum子网。

必要条件您需要至少3台装好Ubuntu 12.04 (LTS)的计算机(虚拟或物理)。

表1.1结构和节点信息控制器节点简介控制器节点将提供:• Databases (with MySQL)• Queues (with RabbitMQ)• Keystone• Glance• Nova (without nova-compute)• Cinder• Quantum Server (with Open-vSwitch plugin)• Dashboard (with Horizon)公共服务操作系统1.使用此参数安装Ubuntu:• Time zone :UTC• Hostname :folsom-controller• Packages :OpenSSH-Server操作系统安装完成后,重新启动服务器。

openstack操作手册

openstack操作手册(最新版)目录一、OpenStack 概述二、OpenStack 组件介绍1.Glance2.Keystone3.Neutron4.Swift5.Nova三、OpenStack 的功能1.提供 REST API2.支持多种方式存储图像3.对实例执行 SN四、OpenStack 的配置与优化1.修改配置文件2.插件的使用五、OpenStack 的测试与实践1.Rally 压力测试2.Tempest 功能性测试正文OpenStack 是一个开源的云计算平台,旨在提供基础设施即服务(IaaS)和平台即服务(PaaS)功能。

它由多个组件组成,共同协作以实现计算、存储和网络资源的管理。

OpenStack 的主要组件包括:1.Glance:Glance 是一个用于管理 OpenStack 镜像的服务。

它能够上传、存储、查询和获取镜像的元数据和镜像本身。

Glance 还支持多种方式存储镜像,包括普通的文件系统、Swift、Amazon S3 等。

2.Keystone:Keystone 是 OpenStack 的身份认证服务,负责管理用户的凭据和访问控制。

它能够提供 REST API,让用户能够查询和获取镜像的元数据和镜像本身。

Keystone 的配置文件中,需要设置 authuri、pastedeploy 和 glancestore 等地方。

3.Neutron:Neutron 是 OpenStack 中负责提供网络服务的组件,基于软件定义网络的思想,实现了网络虚拟化下的资源管理,即:网络即服务。

Neutron 支持多种虚拟交换机,一般使用 Linux 桥接器、Open vSwitch 创建传统的 VLAN 网络,以及基于隧道技术的 Overlay 网络,如 VXLAN 和 GRE。

4.Swift:Swift 是 OpenStack 的对象存储服务,用于存储非结构化数据,如文本文件、图片等。

openstack操作手册

openstack操作手册一、介绍OpenStack是一种开源的云计算平台,通过将计算、存储和网络资源整合起来,提供一个灵活可扩展的云基础设施。

本操作手册将为您提供关于OpenStack的详细指南,帮助您了解和操作这一强大的云计算平台。

二、OpenStack的组件1. NovaNova是OpenStack的计算服务组件,它提供虚拟机管理和资源调度。

您可以使用Nova创建、启动、暂停、删除和迁移虚拟机实例,以满足不同的计算需求。

2. NeutronNeutron是OpenStack的网络服务组件,它提供虚拟网络的创建和管理。

您可以使用Neutron创建和管理虚拟网络、子网和路由器,以及配置虚拟机实例的网络连接。

3. CinderCinder是OpenStack的块存储服务组件,它允许用户创建和管理块设备,并将其挂载到虚拟机实例上。

您可以使用Cinder创建、删除、扩展和快照块设备,以满足存储需求。

4. SwiftSwift是OpenStack的对象存储服务组件,它提供了一个高可扩展的对象存储系统。

您可以使用Swift上传、下载、复制和删除对象,并进行对象的元数据管理。

5. KeystoneKeystone是OpenStack的身份认证服务组件,它提供了用户和角色的管理,以及身份认证和授权功能。

您可以使用Keystone创建用户、角色和项目,并为其分配相应的权限。

6. GlanceGlance是OpenStack的镜像服务组件,它允许用户上传、注册和管理虚拟机镜像。

您可以使用Glance创建、删除、共享和复制虚拟机镜像,并为虚拟机实例的启动提供基础镜像。

三、安装和配置OpenStack1. 硬件和软件要求在安装OpenStack之前,您需要确保服务器满足一定的硬件要求,并安装了支持的操作系统和相关软件。

2. 安装OpenStack组件您可以根据需要选择安装和配置OpenStack的各个组件,以满足特定的云计算需求。

自动化kolla-ansible部署centos7.9+openstack-train-超。。。

⾃动化kolla-ansible部署centos7.9+openstack-train-超。

⾃动化kolla-ansible部署centos7.9+openstack-train-超融合⾼可⽤架构欢迎加QQ群:1026880196 进⾏交流学习环境说明:1. 满⾜⼀台电脑⼀个⽹卡的环境进⾏模拟测试,由于配置较低,这⾥只涉及常规测试,不做更深⼊开展。

2.如果你是物理机,可以准备2个物理⽹卡,⼀个作为管理⽹接⼝,⼀个作为浮动⽹接⼝(实例上外⽹的需要,这⾥需要交换机⽀持dhcp功能,可以⾃动获取ip地址)。

3.根据环境需要注意⼀下参数修改:nova_compute_virt_type: "kvm"vim /etc/kolla/config/nova/nova-compute.conf[libvirt]inject_password=truecpu_mode=host-passthroughvirt_type = kvm1. PC台式电脑硬件配置2. 虚拟软件配置3. 节点信息 # 三台融合控制/计算/存储node1 CPU:4核内存:8GB 系统盘SSD 200GB*1数据盘SSD 300GB*1管理⽹:ens33 192.168.1.20/24浮动⽹:ens34 dhcp ( BOOTPROTO=dhcp )node2 CPU:4核内存:8GB 系统盘SSD 200GB*1数据盘SSD 300GB*1管理⽹:ens33 192.168.1.21/24浮动⽹:ens34 dhcp ( BOOTPROTO=dhcp )node3 CPU:4核内存:8GB 系统盘SSD 200GB*1数据盘SSD 300GB*1管理⽹:ens33 192.168.1.22/24浮动⽹:ens34 dhcp ( BOOTPROTO=dhcp )1. 系统版本CentOS-7-x86_64-Minimal-2009.iso(CentOS 7.9 64位)2. 语⾔英⽂=标准安装3. 分区/boot 1000M /swap 4096M 其余/5. ⽹卡信息6. 系统基本环境#注意每个节点都要执⾏1. 安装常⽤软件包yum install gcc vim wget net-tools ntpdate git -y2. 关闭防⽕墙systemctl stop firewalld.servicesystemctl disable firewalld.servicefirewall-cmd --state3. 关闭selinuxsed -i '/^SELINUX=.*/c SELINUX=disabled' /etc/selinux/configsed -i 's/^SELINUXTYPE=.*/SELINUXTYPE=disabled/g' /etc/selinux/configgrep --color=auto '^SELINUX' /etc/selinux/configsetenforce 04. 主机名:echo "192.168.1.20 node1192.168.1.21 node2192.168.1.22 node3">>/etc/hosts5. ssh免密验证#只在node1下操作,其它节点不执⾏ssh-keygenssh-copy-id root@node1ssh-copy-id root@node2ssh-copy-id root@node36. 修改sshsed -i 's/#ClientAliveInterval 0/ClientAliveInterval 60/g' /etc/ssh/sshd_configsed -i 's/#ClientAliveCountMax 3/ClientAliveCountMax 60/g' /etc/ssh/sshd_configsystemctl daemon-reload && systemctl restart sshd && systemctl status sshd9. 安装epel源yum makecacheyum install -y epel-release10. 使⽤清华pypi源11. 安装安装python-pipyum install python-pip -ypip install --upgrade "pip < 21.0"pip install pbr12. 升级系统软件包yum update -y13. 重启系统reboot7. 时间同步 #注意每个节点都要执⾏1. 安装chrony服务yum -y install chrony2. 配置chrony⽂件cp /etc/chrony.conf{,.bak}echo "server iburstserver iburstserver iburststratumweight 0driftfile /var/lib/chrony/driftrtcsyncmakestep 103bindcmdaddress 127.0.0.1bindcmdaddress ::1keyfile /etc/chrony.keyscommandkey 1generatecommandkeynoclientloglogchange 0.5logdir /var/log/chrony">/etc/chrony.conf3. 启动服务systemctl enable chronyd && systemctl restart chronyd && systemctl status chronyd4. chrony同步源chronyc sources -vntpdate hwclock -w5. 配置定时任务crontab -e0 */1 * * * ntpdate > /dev/null2>&1; /sbin/hwclock -w0 */1 * * * ntpdate > /dev/null2>&1; /sbin/hwclock -w8. 安装配置# node1下操作1. 安装依赖软件包yum install python2-devel libffi-devel openssl-devel libselinux-python -yyum remove docker docker-common docker-selinux docker-engine -yyum install yum-utils device-mapper-persistent-data lvm2 -y2. 安装ansibleyum install -y "ansible < 2.9.19"3. 配置ansible.cfg⽂件sed -i 's/#host_key_checking = False/host_key_checking = True/g' /etc/ansible/ansible.cfgsed -i 's/#pipelining = False/pipelining = True/g' /etc/ansible/ansible.cfgsed -i 's/#forks = 5/forks = 100/g' /etc/ansible/ansible.cfg4. 安装 kolla-ansiblepip install kolla-ansible==9.3.1 --ignore-installed PyYAML5. 安装docker-ceyum install docker-ce -y6. kolla-ansible配置⽂件到当前环境mkdir -p /etc/kollachown $USER:$USER /etc/kollacp -r /usr/share/kolla-ansible/etc_examples/kolla/* /etc/kollacp /usr/share/kolla-ansible/ansible/inventory/* .7. 修改docker配置⽂件配置国内阿⾥云地址,docker推送地址mkdir /etc/docker/cat >> /etc/docker/daemon.json << EOF{"registry-mirrors": ["https://","","https://"]}EOF8. 开启 Docker 的共享挂载功能mkdir -p /etc/systemd/system/docker.service.dcat >> /etc/systemd/system/docker.service.d/kolla.conf << EOF[Service]MountFlags=sharedEOF9. 设置docker服务启动systemctl daemon-reload && systemctl enable docker && systemctl restart docker&& systemctl status docker1. 配置清单vim /root/multinode修改如下:[control]node1node2node3[network]node1node2node3[compute]node1node2node3[storage]node1node2node3[monitoring]node1node2node3[deployment]node1node2node32. 配置globals.yml⽂件,开启需要的⽂件vim /etc/kolla/globals.yml修改如下:kolla_base_distro: "centos"kolla_install_type: "source"openstack_release: "train"node_custom_config: "/etc/kolla/config"kolla_internal_vip_address: "192.168.1.19"#docker_registry: ":4000"docker_namespace: "kolla"network_interface: "ens33"neutron_external_interface: "ens34"neutron_plugin_agent: "openvswitch"neutron_tenant_network_types: "vxlan,vlan,flat"keepalived_virtual_router_id: "56"openstack_logging_debug: "True"enable_ceph: "yes"enable_ceph_dashboard: "{{ enable_ceph | bool }}"enable_chrony: "yes"enable_cinder: "yes"enable_cinder_backup: "yes"enable_ceph_dashboard: "{{ enable_ceph | bool }}"enable_heat: "no"enable_neutron_dvr: "yes"enable_neutron_agent_ha: "yes"enable_neutron_provider_networks: "yes"enable_nova_ssh: "yes"glance_backend_ceph: "yes"cinder_backend_ceph: "{{ enable_ceph }}"cinder_backup_driver: "ceph"nova_backend_ceph: "{{ enable_ceph }}"nova_compute_virt_type: "qemu"nova_console: "novnc"3. ⽣成随机密码kolla-genpwd4. 修改界⾯登陆密码为123456sed -i 's/^keystone_admin_password.*/keystone_admin_password: 123456/' /etc/kolla/passwords.yml 5. 准备后端存储# node1-3都需要执⾏#格式化mkfs.ext4 /dev/sdb数据盘准备ceph的标签parted /dev/sdb -s -- mklabel gpt mkpart KOLLA_CEPH_OSD_BOOTSTRAP_BS_FOO1 1 -16. 设置nova配置⽂件mkdir /etc/kolla/configmkdir /etc/kolla/config/novacat >> /etc/kolla/config/nova/nova-compute.conf << EOF[libvirt]virt_type = qemucpu_mode = noneEOF7. 创建虚拟机界⾯禁⽌默认创建新卷.mkdir /etc/kolla/config/horizon/cat >> /etc/kolla/config/horizon/custom_local_settings << EOFLAUNCH_INSTANCE_DEFAULTS = {'create_volume': False,}EOF8. 创建ceph.confcat >> /etc/kolla/config/ceph.conf << EOF[global]osd pool default size = 3osd pool default min size = 2mon_clock_drift_allowed = 2osd_pool_default_pg_num = 8osd_pool_default_pgp_num = 8mon clock drift warn backoff = 30EOF1. 引导各节点依赖kolla-ansible -i ./multinode bootstrap-servers2. 检查ansible -i multinode all -m pingkolla-ansible -i ./multinode prechecks3. 部署kolla-ansible -i ./multinode deploy4. 部署完成后⽣成rc⽂件kolla-ansible -i ./multinode post-deploy5. 拷贝admin-openrc.sh⽂件cp /etc/kolla/admin-openrc.sh ./chmod +x admin-openrc.shsource admin-openrc.sh6. 安装openstack 包cd /etc/yum.repos.d/yum install centos-release-openstack-train -yyum makecache fastyum install python-openstackclient -ycd7. 编辑初始化脚本vim /usr/share/kolla-ansible/init-runonceEXT_NET_CIDR=EXT N ET C IDR:−′192.168.1.0/24′EXT N ET R ANGE={EXT_NET_RANGE:-'start=192.168.1.200,end=192.168.1.254'}EXT_NET_GATEWAY=${EXT_NET_GATEWAY:-'192.168.1.1'}8. 执⾏#这⾥需要执⾏pip install kolla-ansible==9.3.1 --ignore-installed PyYAML 不然报错依赖pip install kolla-ansible==9.3.1 --ignore-installed PyYAMLsh /usr/share/kolla-ansible/init-runonce11. 镜像上传#node1上执⾏1. 镜像下载mkdir /root/qcow2cd /root/qcow2#百度云盘链接:https:///s/1WK_VbWb-f9boOL2-QahIng提取码:2021#linux 默认22端⼝ root cloud5566@MM123#windows 默认56221端⼝ administrator cloud5566@MM123#其它镜像需要开通会员才能上传⼤于4G的⽂件...........2. 格式转换yum -y install qemu-imgqemu-img convert CentOS7.8_x86_64bit.qcow2 CentOS7.8_x86_64bit.raw3. 镜像上传source /root/admin-openrc.shopenstack image create "CentOS 7.8 64位" --file CentOS7.8_x86_64bit.raw --disk-format raw --container-format bare --property hw_qemu_guest_agent=yes --property os_type=linux --public 4. 查看镜像是否成功openstack image list12. 准备⼯作1. 安全组全部放⾏13. 创建实例测试13. 后端ceph存储状态查看docker exec -it ceph_mon ceph --versiondocker exec -it ceph_mon ceph -sdocker exec -it ceph_mon ceph -wdocker exec -it ceph_mon ceph dfdocker exec -it ceph_mon ceph osd treedocker exec -it ceph_mon ceph osd perf14. 卸载openstack集群环境1.卸载openstackkolla-ansible destroy -i /root/multinode --include-images --yes-i-really-really-mean-it2.所有节点重启系统reboot3.所有节点硬盘格式化dmsetup remove_allmkfs.ext4 /dev/sdb4.所有节点重新打ceph标签parted /dev/sdb -s -- mklabel gpt mkpart KOLLA_CEPH_OSD_BOOTSTRAP_BS_FOO1 1 -115. 如果集群设备意外关机,导致数据库集群挂掉。

centos openstack grizzly 安装配置

准备环境1、配置yum源CentOS6-Base-163.repo[base]name=CentOS-$releasever - Base - baseurl=/centos/$releasever/os/$basearch/#mirrorlist=/?release=$releasever&arch=$basearc h&repo=osgpgcheck=0gpgkey=/centos/RPM-GPG-KEY-CentOS-6#released updates[updates]name=CentOS-$releasever - Updates - baseurl=/centos/$releasever/updates/$basearch/#mirrorlist=/?release=$releasever&arch=$basearc h&repo=updatesgpgcheck=0gpgkey=/centos/RPM-GPG-KEY-CentOS-6#additional packages that may be useful[extras]name=CentOS-$releasever - Extras - baseurl=/centos/$releasever/extras/$basearch/#mirrorlist=/?release=$releasever&arch=$basearc h&repo=extrasgpgcheck=0gpgkey=/centos/RPM-GPG-KEY-CentOS-6#additional packages that extend functionality of existing packages[centosplus]name=CentOS-$releasever - Plus - baseurl=/centos/$releasever/centosplus/$basearch/ #mirrorlist=/?release=$releasever&arch=$basearc h&repo=centosplusgpgcheck=0enabled=0gpgkey=/centos/RPM-GPG-KEY-CentOS-6#contrib - packages by Centos Users[contrib]name=CentOS-$releasever - Contrib - baseurl=/centos/$releasever/contrib/$basearch/#mirrorlist=/?release=$releasever&arch=$basearc h&repo=contribgpgcheck=0enabled=0gpgkey=/centos/RPM-GPG-KEY-CentOS-6epel.repo [epel]name=Extra Packages for Enterprise Linux 6 - $basearchbaseurl=/epel/6/$basearch#mirrorlist=https:///metalink?repo=epel-6&arch= $basearchfailovermethod=priorityenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-EPEL-6[epel-debuginfo]name=Extra Packages for Enterprise Linux 6 - $basearch - Debugbaseurl=/epel/6/$basearch/debug#mirrorlist=https:///metalink?repo=epel-debug-6& arch=$basearchfailovermethod=priorityenabled=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-EPEL-6gpgcheck=0[epel-source]name=Extra Packages for Enterprise Linux 6 - $basearch - Sourcebaseurl=/epel/6/SRPMS#mirrorlist=https:///metalink?repo=epel-source-6& arch=$basearchfailovermethod=priorityenabled=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-EPEL-6gpgcheck=0openstack.repo [openstack]baseurl=/openstack/openstack-grizzly/epel-6gpgcheck=0安装前准备1、安装OpenStack Utilities #yum install -y openstack-utils dnsmasq-utils2、更新系统# yum update3、关闭iptables# service iptables stop# chkconfig iptables off4.关闭selinux# vi /etc/selinux/configSELINUX=disabled5、重启服务器# reboot6、安装qpid # yum install -y qpid-cpp-server# sed -i -e 's/auth=.*/auth=no/g' /etc/qpidd.conf# service qpidd start# chkconfig qpidd on部署KeyStone1、安装KeyStone # yum install -y openstack-keystone2、初始化数据库# openstack-db --init --service keystone--password PASSWORD如果没有安装mysql,会在这步安装,这里默认密码PASSWORD 3、生成Token,并设置环境变量# export SERVICE_TOKEN=$(openssl rand -hex 10)# export SERVICE_ENDPOINT=http://10.9.0.206:35357/v2.0# echo $SERVICE_TOKEN > /tmp/ks_admin_token71068df694f4c46201564、修改配置文件# openstack-config --set /etc/keystone/keystone.confDEFAULT admin_token $SERVICE_TOKEN# openstack-config --set /etc/keystone/keystone.confsigning token_format UUID5、启动keystone服务# service openstack-keystone start# chkconfig openstack-keystone on6、查看是否启动正常# ps -ef | grep -i keystone-allkeystone 2331 1 3 15:24 ? 00:00:00 /usr/bin/python /usr/bin/ke ystone-all --config-file /etc/keystone/keystone.confroot 2339 1902 0 15:24 pts/0 00:00:00 grep -i keystone-all# grep ERROR /var/log/keystone/keystone.log7、创建Keystone服务,并注册Endpoint# keystone service-create --name=keystone --type=identity--description="Keystone Identity Service"+-------------+----------------------------------+| Property | Value |+-------------+----------------------------------+| description | Keystone Identity Service || id | b987bd18f91a47709d1c191ca924f4db || name | keystone || type | identity |+-------------+----------------------------------+# keystone endpoint-create--service_id b987bd18f91a47709d1c191ca924f4db--publicurl 'http://10.9.0.206:5000/v2.0'--adminurl 'http://10.9.0.206:35357/v2.0'--internalurl 'http://10.9.0.206:5000/v2.0'+-------------+----------------------------------+| Property | Value |+-------------+----------------------------------+| adminurl | http://10.9.0.206:35357/v2.0 || id | a86e402ec8144c0ba560f9b917c65981 || internalurl | http://10.9.0.206:5000/v2.0 || publicurl | http://10.9.0.206:5000/v2.0 || region | regionOne || service_id | b987bd18f91a47709d1c191ca924f4db |+-------------+----------------------------------+其中service_id和上面创建service的返回ID对应8、创建admin用户a) 创建admin用户# keystone user-create --name admin --pass PASSWORD +----------+----------------------------------+| Property | Value |+----------+----------------------------------+| email | || id | 8179d4236cd147f2a9670df1616882a0 | | name | admin || tenantId | |+----------+----------------------------------+b)创建admin role# keystone role-create --name admin+----------+----------------------------------+| Property | Value |+----------+----------------------------------+| id | c44c1e8f4b8c4efa82beb83a847dd0ca | | name | admin |+----------+----------------------------------+c)创建admin tenant# keystone tenant-create --name admin+-------------+----------------------------------+| Property | Value |+-------------+----------------------------------+| enabled | True || id | 78b342b561ed4fb79ab764b828473f93 || name | admin |+-------------+----------------------------------+d)将admin用户加入到admin role中# keystone user-role-add --user-id 8179d4236cd147f2a9670df1616882a0 --role-id c44c1e8f4b8c4efa82beb83a847dd0ca--tenant-id 78b342b561ed4fb79ab764b828473f93e)设置admin的环境变量# vi keystonerc_adminexport OS_USERNAME=adminexport OS_TENANT_NAME=adminexport OS_PASSWORD=PASSWORDexport OS_AUTH_URL=http://10.9.0.205:35357/v2.0/export PS1='[u@h W(keystone_admin)]$ 'f)测试是否创建完成# unset SERVICE_TOKEN# unset SERVICE_ENDPOINT# source ~/keystonerc_admin# keystone user-list9、创建一个普通用户# keystone user-create --name tcommerce --pass PASSWORD +----------+----------------------------------+| Property | Value |+----------+----------------------------------+| email | || enabled | True || id | ad91d8062e5e48b185aa0e0847d4b860 || name | tcommerce || tenantId | |+----------+----------------------------------+# keystone role-create --name user+----------+----------------------------------+| Property | Value |+----------+----------------------------------+| id | c5689d23e5a04465831f5e39caff1099 || name | user |+----------+----------------------------------+# keystone tenant-create --name user+-------------+----------------------------------+| Property | Value |+-------------+----------------------------------+| description | || enabled | True || id | f380922e9d844b77b7c1cb742c7ca04b || name | user |+-------------+----------------------------------+keystone user-role-add --user-id ad91d8062e5e48b185aa0e0847d4b860 --role-id c5689d23e5a04465831f5e39caff1099--tenant-id f380922e9d844b77b7c1cb742c7ca04b#vim keystonerc_tcommerceexport OS_USERNAME=tcommerceexport OS_TENANT_NAME=userexport OS_PASSWORD=PASSWORDexport OS_AUTH_URL=http://10.9.0.206:5000/v2.0/export PS1='[u@h W(tcommerce)]$ '# source keystonerc_tcommerce# keystone user-listUnable to communicate with identity service: {"error": {"message": "You ar e not authorized to perform the requested action: admin_required", "code": 4 03, "title": "Not Authorized"}}. (HTTP 403)# keystone token-get+-----------+----------------------------------+| Property | Value |+-----------+----------------------------------+| expires | 2013-04-25T08:14:28Z || id | 1360775bf4504e84881689e6b9b4fff6 || tenant_id | f380922e9d844b77b7c1cb742c7ca04b || user_id | ad91d8062e5e48b185aa0e0847d4b860 |+-----------+----------------------------------+部署Glance1、安装glance# yum install -y openstack-glance2、设置环境变量# source ~/keystonerc_admin3、初始数据库# openstack-db --init --service glance--password PASSWORD4、修改配置文件# openstack-config --set /etc/glance/glance-api.confpaste_deploy flavor keystone# openstack-config --set /etc/glance/glance-api.confkeystone_authtoken admin_tenant_name admin# openstack-config --set /etc/glance/glance-api.confkeystone_authtoken admin_user admin# openstack-config --set /etc/glance/glance-api.confkeystone_authtoken admin_password PASSWORD# openstack-config --set /etc/glance/glance-registry.conf paste_deploy flavor keystone# openstack-config --set /etc/glance/glance-registry.conf keystone_authtoken admin_tenant_name admin# openstack-config --set /etc/glance/glance-registry.conf keystone_authtoken admin_user admin# openstack-config --set /etc/glance/glance-registry.conf keystone_authtoken admin_password PASSWORD5、启动服务# service openstack-glance-registry start# service openstack-glance-api start# chkconfig openstack-glance-registry on# chkconfig openstack-glance-api on6、创建服务和Endpoint# keystone service-create --name=glance --type=image --description="Gla nce Image Service"+-------------+----------------------------------+| Property | Value |+-------------+----------------------------------+| description | Glance Image Service || id | c5b9b64a19084d8fbf1230ab200e730b || name | glance || type | image |+-------------+----------------------------------+# keystone endpoint-create --service_id c5b9b64a19084d8fbf1230ab200e7 30b--publicurl http://10.9.0.206:9292--adminurl http://10.9.0.206:9292--internalurl http://10.9.0.206:9292+-------------+----------------------------------+| Property | Value |+-------------+----------------------------------+| adminurl | http://10.9.0.206:9292 || id | 611967c3b2224cba8632e8ebe98bef96 || internalurl | http://10.9.0.206:9292 || publicurl | http://10.9.0.206:9292 || region | regionOne || service_id | c5b9b64a19084d8fbf1230ab200e730b |+-------------+----------------------------------+7、测试是否安装成功# source ~/keystonerc_tcommerce# glance image-list9、上传镜像到Glancea)下载镜像# wget /images/2012-11-15/f17-x86_64-op enstack-sda.qcow2b)上传镜像glance image-create --name "fd"--is-public true--disk-format qcow2--container-format bare--file f17-x86_64-openstack-sda.qcow2+------------------+--------------------------------------+| Property | Value |+------------------+--------------------------------------+| checksum | 4255a68ec619c25d8e93ae00e514f42f | | container_format | bare || created_at | 2013-04-24T08:30:36 || deleted | False || deleted_at | None || disk_format | qcow2 || id | f1d57318-63f6-4670-a4c0-b97db6fab835 | | is_public | True || min_disk | 0 || min_ram | 0 || name | fd || owner | f380922e9d844b77b7c1cb742c7ca04b || protected | False || size | 5089761 || status | active || updated_at | 2013-04-24T08:30:36 |+------------------+--------------------------------------+c)查看镜像# glance image-list+--------------------------------------+----------+-------------+------------------+---------+--------+| ID | Name | Disk Format | Container Form at | Size | Status |+--------------------------------------+----------+-------------+------------------+---------+--------+| f1d57318-63f6-4670-a4c0-b97db6fab835 | fd | qcow2 | bare | 5089761 | active |+--------------------------------------+----------+-------------+------------------+---------+--------+部署Cinder1、安装Cinder # yum install -y openstack-cinder2、设置环境变量# source ~/keystonerc_admin3、初始化数据库# openstack-db --init --service cinder--password PASSWORD4、修改配置文件# openstack-config --set /etc/cinder/cinder.conf DEFAULT auth_strategy ke ystone# openstack-config --set /etc/cinder/cinder.confkeystone_authtoken admin_tenant_name admin# openstack-config --set /etc/cinder/cinder.confkeystone_authtoken admin_user admin# openstack-config --set /etc/cinder/cinder.confkeystone_authtoken admin_password PASSWORD5、修改tgt配置文件grep -q /etc/cinder/volumes /etc/tgt/targets.conf || sed -i '1iinclude /etc/c inder/volumes/*' /etc/tgt/targets.conf6、启动tgt #service tgtd start#chkconfig tgtd on6、创建cinder-volumes使用一个空闲独立的分区,这里这个分区为/dev/sdb1 # vgcreate cinder-volume s /dev/sdb1Volume group "cinder-volumes" successfully created# vgdisplay cinder-volumes--- Volume group ---VG Name cinder-volumesSystem IDFormat lvm2Metadata Areas 1Metadata Sequence No 1VG Access read/writeVG Status resizableMAX LV 0Cur LV 0Open LV 0Max PV 0Cur PV 1Act PV 1VG Size 1.90 TiBPE Size 4.00 MiBTotal PE 498073Alloc PE / Size 0 / 0Free PE / Size 498073 / 1.90 TiBVG UUID KpVXij-o9qC-WNOI-BKIw-1VSz-NUEa-2UsYTF7、启动服务# for srv in api scheduler volume ; dosudo service openstack-cinder-$srv start ;done# for srv in api scheduler volume ; dosudo chkconfig openstack-cinder-$srv on ;done8、检查是否有报错# grep -i ERROR /var/log/cinder/*# grep CRITICAL /var/log/cinder/*9、创建服务和endpoint# keystone service-create --name=cinder --type=volume --description="Ci nder Volume Service"+-------------+----------------------------------+| Property | Value |+-------------+----------------------------------+| description | Cinder Volume Service || id | 43f96e5b49464b809388daebbc5c1b2b || name | cinder || type | volume |+-------------+----------------------------------+# keystone endpoint-create --service_id 43f96e5b49464b809388daebbc5c1 b2b--publicurl "http://10.9.0.206:8776/v1/$(tenant_id)s"--adminurl "http://10.9.0.206:8776/v1/$(tenant_id)s"--internalurl "http://10.9.0.206:8776/v1/$(tenant_id)s"10、测试是否正常# source ~/keystonerc_username# cinder list部署Nova1、安装nova和cinderclient # yum install -y openstack-nova# yum install -y python-cinderclient2、初始化数据库# openstack-db --init --service nova--password PASSWORD3、修改配置文件# openstack-config --set /etc/nova/nova.conf DEFAULT auth_strategy keys tone# openstack-config --set /etc/nova/api-paste.inifilter:authtoken admin_token $(cat /tmp/ks_admin_token)4、卸载nova-network# rpm -e openstack-nova-network-2013.1-2.el6.noarch --nodeps这里面使用Quantum替代# service messagebus start# chkconfig messagebus on# service libvirtd start# chkconfig libvirtd on# openstack-config --set /etc/nova/nova.conf DEFAULTvolume_api_class nova.volume.cinder.API# openstack-config --set /etc/nova/nova.conf DEFAULTenabled_apis ec2,osapi_compute,metadata5、创建服务和Endpoint# keystone service-create --name=nova --type=compute --description="N ova Compute Service"+-------------+----------------------------------+| Property | Value |+-------------+----------------------------------+| description | Nova Compute Service || id | dff2746d4d7049fab6e1a96968f6a6ff || name | nova || type | compute |+-------------+----------------------------------+# keystone endpoint-create --service_id dff2746d4d7049fab6e1a96968f6a6f f--publicurl "http://10.9.0.206:8774/v1.1/$(tenant_id)s"--adminurl "http://10.9.0.206:8774/v1.1/$(tenant_id)s"--internalurl "http://10.9.0.206:8774/v1.1/$(tenant_id)s"+-------------+-------------------------------------------+| Property | Value |+-------------+-------------------------------------------+| adminurl | http://10.9.0.206:8774/v1.1/$(tenant_id)s || id | 21cd3644397e4affb79e22ef26a4acb8 || internalurl | http://10.9.0.206:8774/v1.1/$(tenant_id)s || publicurl | http://10.9.0.206:8774/v1.1/$(tenant_id)s || region | regionOne || service_id | dff2746d4d7049fab6e1a96968f6a6ff |+-------------+-------------------------------------------+更多阅读请移步openstack专题:/cloud-computing/open stack部署OpenStack Networking1、为OpenStack Networking配置Keystone# source ~/keystonerc_admin# keystone service-create --name openstack_network --type network --description 'OpenStack Networking Service'+-------------+----------------------------------+| Property | Value |+-------------+----------------------------------+| description | OpenStack Networking Service || id | 90d4cf4d89a143dabf5faf2de1f0de48 || name | openstack_network || type | network |+-------------+----------------------------------+# keystone endpoint-create --service-id 90d4cf4d89a143dabf5faf2de1f0de4 8--publicurl 'http://10.9.0.206:9696/'--adminurl 'http://10.9.0.206:9696/'--internalurl 'http://10.9.0.206:9696/'+-------------+----------------------------------+| Property | Value |+-------------+----------------------------------+| adminurl | http://10.9.0.206:9696/ || id | e6b17c6f8ff14455a755e4c9f6fc8ca6 || internalurl | http://10.9.0.206:9696/ || publicurl | http://10.9.0.206:9696/ || region | regionOne || service_id | 90d4cf4d89a143dabf5faf2de1f0de48 |+-------------+----------------------------------+2、安装quantum 和插件# yum install openstack-quantum# yum install openstack-quantum-openvswitch3、配置Openstack-Networking# openstack-config --set /etc/quantum/quantum.confDEFAULT rpc_backend mon.rpc.impl_qpid # openstack-config --set /etc/quantum/quantum.conf DEFAULT qpid_hostname 10.9.0.206# openstack-config --set /etc/quantum/quantum.conf keystone_authtoken admin_tenant_name admin# openstack-config --set /etc/quantum/quantum.conf keystone_authtoken admin_user admin# openstack-config --set /etc/quantum/quantum.conf keystone_authtoken admin_password PASSWORD# sudo sh -c 'echo 127.0.0.1 `hostname` >> /etc/hosts'# quantum-server-setup --plugin openvswitchQuantum plugin: openvswitchPlugin: openvswitch => Database: ovs_quantumPlease enter the password for the 'root' MySQL user:Verified connectivity to MySQL.Would you like to update the nova configuration files? (y/n):YConfiguration updates complete!# service quantum-server start# chkconfig quantum-server on4、修改nova.confnetwork_api_class = work.quantumv2.api.APIquantum_admin_username = adminquantum_admin_password = PASSWORDquantum_admin_auth_url = http://10.9.0.206:35357/v2.0/quantum_auth_strategy = keystonequantum_admin_tenant_name = adminquantum_url = http://10.9.0.206:9696/libvirt_vif_driver = nova.virt.libvirt.vif.LibvirtHybridOVSBridgeDriverlibvirt_use_virtio_for_bridges=True5、安装OpenStack Networking Agents# yum install -y openstack-quantum-openvswitch# quantum-node-setup --plugin openvswitchQuantum plugin: openvswitchPlease enter the Quantum hostname:10.9.0.206Would you like to update the nova configuration files? (y/n):y/usr/bin/openstack-config --set|--del config_file section [parameter] [value] Configuration updates complete!# service openvswitch start# chkconfig openvswitch on# service quantum-openvswitch-agent start# chkconfig quantum-openvswitch-agent on# chkconfig quantum-ovs-cleanup on6、安装OpenStack Networking DHCP Agent # quantum-dhcp-setup --plu gin openvswitchQuantum plugin: openvswitchPlease enter the Quantum hostname:10.9.0.206Configuration updates complete!# service quantum-dhcp-agent start# chkconfig quantum-dhcp-agent on7、安装OpenStack Networking L3 Agent# ovs-vsctl add-br br-int# ovs-vsctl add-br br-ex# ovs-vsctl add-port br-ex eth1# yum install -y openstack-quantum# quantum-l3-setup --plugin openvswitchQuantum plugin: openvswitchPlease enter the Quantum hostname:10.9.0.206Configuration updates complete!# quantum router-create router1+-----------------------+--------------------------------------+| Field | Value |+-----------------------+--------------------------------------+| admin_state_up | True || external_gateway_info | || id | e6216a61-0212-4b0c-8b1c-3911e9b97974 | | name | router1 || status | ACTIVE || tenant_id | 78b342b561ed4fb79ab764b828473f93 | +-----------------------+--------------------------------------+# vi /etc/quantum/l3_agent.inirouter_id = 3129097f-4d02-4610-b77a-47dc7a2904ea# service quantum-l3-agent start# chkconfig quantum-l3-agent on8、启动nova# service openstack-nova-api start# service openstack-nova-cert start# service openstack-nova-conductor start # service openstack-nova-objectstore start # service openstack-nova-scheduler start # service openstack-nova-compute start# chkconfig openstack-nova-api on# chkconfig openstack-nova-cert on# chkconfig openstack-nova-conductor on # chkconfig openstack-nova-objectstore on # chkconfig openstack-nova-scheduler on # chkconfig openstack-nova-compute on安装Horizonyum install -y openstack-dashboardyum install -y mod_ssl#keystone role-create --name Member+----------+----------------------------------+ | Property | Value | +----------+----------------------------------+| id | 60b56c45151841018131c14f98052a08 || name | Member |+----------+----------------------------------+#service httpd start#chkconfig httpd on连接https://10.9.0.206/dashboard/用户名:admin密码:PASSWORDConsole Accessyum install -y openstack-nova-novncproxyopenstack-config --set /etc/nova/nova.confDEFAULT novncproxy_host 0.0.0.0openstack-config --set /etc/nova/nova.confDEFAULT novncproxy_port 6080openstack-config --set /etc/nova/nova.confDEFAULT novncproxy_base_url http://10.9.0.206:6080/vnc_auto.html openstack-config --set /etc/nova/nova.confDEFAULT vnc_enabled trueopenstack-config --set /etc/nova/nova.confDEFAULT vncserver_listen 127.0.0.1openstack-config --set /etc/nova/nova.confDEFAULT vncserver_proxyclient_address 127.0.0.1service openstack-nova-novncproxy startservice openstack-nova-consoleauth startchkconfig openstack-nova-novncproxy onchkconfig openstack-nova-consoleauth onservice openstack-nova-compute restart使用OpenStack1、创建key# nova keypair-add oskey > oskey.priv# chmod 600 oskey.priv2、创建Instance# nova flavor-list+----+-----------+-----------+------+-----------+------+-------+-------------+-----------+-------------+| ID | Name | Memory_MB | Disk | Ephemeral | Swap | VCPUs | RXTX _Factor | Is_Public | extra_specs |+----+-----------+-----------+------+-----------+------+-------+-------------+-----------+-------------+| 1 | m1.tiny | 512 | 0 | 0 | | 1 | 1.0 | True | {} || 2 | m1.small | 2048 | 20 | 0 | | 1 | 1.0 | True | {} || 3 | m1.medium | 4096 | 40 | 0 | | 2 | 1.0 | Tru e | {} || 4 | rge | 8192 | 80 | 0 | | 4 | 1.0 | True | {} || 5 | m1.xlarge | 16384 | 160 | 0 | | 8 | 1.0 | True | {} |+----+-----------+-----------+------+-----------+------+-------+-------------+-----------+-------------+# nova image-list+--------------------------------------+------+--------+--------+| ID | Name | Status | Server |+--------------------------------------+------+--------+--------+| f1d57318-63f6-4670-a4c0-b97db6fab835 | fd | ACTIVE | |+--------------------------------------+------+--------+--------+# nova boot --flavor 2 --key_name oskey --image f1d57318-63f6-4670-a4 c0-b97db6fab835 fedoral+-------------------------------------+--------------------------------------+| Property | Value |+-------------------------------------+--------------------------------------+| OS-EXT-STS:task_state | scheduling || image | fd || OS-EXT-STS:vm_state | building ||O S-EX T-S RV-A T TR:i n s t a n c e_n a me|i n s t a n c e-00000006 || flavor | m1.small || id | 6169db0a-4e70-4fea-9bd3-80f33875215d | | security_groups | [{u'name': u'default'}] || user_id | 8179d4236cd147f2a9670df1616882a0 | | OS-DCF:diskConfig | MANUAL || accessIPv4 | || accessIPv6 | || progress | 0 || OS-EXT-STS:power_state | 0 || OS-EXT-AZ:availability_zone | None || config_drive | || status | BUILD || updated | 2013-04-25T05:01:05Z || hostId | || OS-EXT-SRV-ATTR:host | None || key_name | oskey || OS-EXT-SRV-ATTR:hypervisor_hostname | None|| name | fedoral || adminPass | eVUAeQ7H6CBm | | tenant_id | 78b342b561ed4fb79ab764b828473f93 || created | 2013-04-25T05:01:05Z || metadata | {} |+-------------------------------------+--------------------------------------+[root@iaas206 ~(keystone_admin)]# nova list+--------------------------------------+---------+--------+-------------------+ | ID | Name | Status | Networks |+--------------------------------------+---------+--------+-------------------+| 6169db0a-4e70-4fea-9bd3-80f33875215d | fedoral | ACTIVE | abc=192.16 8.100.1 |+--------------------------------------+---------+--------+-------------------+遇到问题及解决1、使用admin用户查看用户列表时报错# keystone user-listAuthorization Failed: Unable to communicate with identity service: {"error": {"message": "Unable to sign token.", "code": 500, "title": "Internal Server Error "}}. (HTTP 500)解决方法:# openstack-config --set /etc/keystone/keystone.confsigning token_format UUID2、qantum log出现下面错误Command: ['sudo', 'ovs-vsctl', '--timeout=2', 'list-ports', 'br-int']Exit code: 1Stdout: ''Stderr: 'sudo: no tty present and no askpass program specifiedn'2013-04-25 11:12:37 ERROR [quantum.agent.linux.ovs_lib] Unable to exe cute ['ovs-vsctl', '--timeout=2', 'list-ports', 'br-int']. Exception:解决方法:# visudo -f /etc/sudoers.d/quantum quantum ALL = (root) NOPASSWD: ALL。

OpenStack安装指南

11 添加遥测模块目录遥测模块 121安装和配置控制节点 122配置计算服务 125配置镜像服务 127配置块儿存储服务 127配置对象存储服务 128遥测安装的检测 129下一步 130遥测提供了一个监控和计量OpenStack的一个框架,这也被称为测云仪项目。

遥测模块遥测模块可以实现如下的功能:有效地调整与OpenStack服务相关的测量数据。

收集监控通知发送事件和计量数据的服务。

将收集到的数据发送到不同的数据存储块儿和消息队列中。

在收集中断定义规则的数据时创建警报。

这个遥测模块包含以下组件:计算代理(测云仪-代理-计算)运行在每个计算节点上,对这些节点的利用情况进行调查。

在将来可能有其他类型的代理,现在的重点是创建计算代理。

中心代理(测云仪中枢代理)运行在一个中枢管理服务器上,并对资源利用进行调查统计,这里的资源不把实例或计算节点绑定在一起。

多个代理可以开始规模服务水平。

通知代理(测云仪的通知代理)运行在一个中枢管理服务器上,从消息队列中得到消息,从而来构建事件和计量数据。

收集者(测云仪收集者)运行在一个中枢管理服务器上,分派收集遥测数据到数据仓储里面或者对外部消费者的数据不做修改。

报警评估(测云仪的报警评估)运行在一个或多个中枢管理服务器上决定那些火灾警报,这里的火灾警报是因为在一个滑动的时间窗口上跨越了一个阙值所做出的相关统计。

警报通知(测云仪警报通知)运行在一个或多个中枢管理服务器上并允许警报设置基于阈值评估样本的集合。

API服务器(测云仪的API)运行在一个或多个中央管理服务器上,并提供访问数据存储的数据。

这些服务通过使用OpenStack消息总线进行通信。

只有收集器和API 服务器访问数据存储。

安装和配置控制器节点本节描述了在控制器节点上如何安装和配置遥测模块、测云仪的代号。

这个遥测模块使用独立的代理从你环境的每一个OpenStack中收集测量值。

配置的先决条件在你安装和配置遥测模块之前,你必须先安装MongoDB,创建一个MongoDB数据库、服务凭证和API端点。

Openstack实验

开源云平台OpenStack实验主要内容实验目的✓理解OpenStack云平台用户、租户(项目)以及角色等基本概念,掌握对用户和租户的管理和设置方法,了解不同角色的权限区别实验要求✓实现对用户/租户的管理操作✓实现用户/租户/角色之间的关联操作✓实现对租户配额的设置创建项目✓在创建项目之前,查看目前系统的项目列表: keystone tenant-list✓创建项目,所使用的命令格式为:keystone tenant-create --name=<TENANT_NAME>如:keystone tenant-create --name=stu创建成功后显示该项目的信息列表。

✓创建项目后,查看目前OpenStack中的项目列表:keystone tenant-list查看和编辑项目配额✓列出指定项目的配额,所使用的命令为:nova-manage project quota <TENANT>如:nova-manage project quota stu✓为指定项目修改配额值,命令格式为:nova-manage project quota <TENANT > --key <KEY> --value<VALUE>如:nova-manage project quota stu --key cores --value 2//项目students的虚拟内核数设置为2创建用户✓在创建用户之前,查看目前系统的用户列表:keystone user-list✓创建用户,所使用的命令格式为:keystone user-create --name=<USER_NAME> --pass=<PASSWORD>如: keystone user-create --name=user1 --pass=mypassword创建成功后显示该用户的信息列表。

NetApp磁盘阵列安装手册

NetApp磁盘阵列安装手册目录目录 (1)一、磁盘阵列的系统安装 (2)1.1初始化磁盘阵列 (2)1.2输入license序列号 (8)1.3配置CIFS (9)1.4在机头中安装阵列操作系统 (11)二、磁盘阵列的SSL安全认证配置 (13)2.1通过浏览器来管理磁盘阵列 (13)2.2配置SSL安全认证 (15)三、磁盘阵列的空间配置和分配 (18)3.1在aggr0中添加新的磁盘 (18)3.2消除磁盘Aggregate的快照预留空间 (22)3.3缩小卷vol0的磁盘空间 (22)3.4创建新的Volume (27)3.5消除Volume的快照预留空间 (31)3.6在新建卷上的参数修改 (33)3.7在IBM主机上安装NetApp磁盘路径管理软件 (34)3.8创建LUN存储单元 (36)3.8.1开启FCP功能 (36)3.8.2创建一个Qtree (38)3.8.3创建一个Lun存储单元 (39)3.8.4在主机上使用LUN来存储数据 (44)一、磁盘阵列的系统安装1.1初始化磁盘阵列NetApp FAS3020C是NetApp产品中一款有双机头的磁盘阵列,需要先在每个机头中安装好操作系统,才能正常使用。

安装步骤如下:1,通过笔记本电脑或其它Windows平台PC机的串口,连接到机头上的串口上;2,通过超级终端,以默认值连接来进行操作;操作过程如下:CFE version 3.0.0 based on Broadcom CFE: 1.0.40Copyright (C) 2000,2001,2002,2003 Broadcom Corporation.Portions Copyright (c) 2002-2005 Network Appliance, Inc.CPU type 0xF29: 2800MHzTotal memory: 0x80000000 bytes (2048MB)CFE> bye输入bye 后,开始启动;CFE version 3.0.0 based on Broadcom CFE: 1.0.40Copyright (C) 2000,2001,2002,2003 Broadcom Corporation.Portions Copyright (c) 2002-2005 Network Appliance, Inc.CPU type 0xF29: 2800MHzTotal memory: 0x80000000 bytes (2048MB)Starting AUTOBOOT press any key to abort...Loading: 0x200000/24732624 0x19963d0/33360796 0x3966f70/1995456 Entry at 0x00200000 Starting program at 0x00200000Press CTRL-C for special boot menu提示按CTRL-C后弹出启动菜单;Special boot options menu will be available.Mon Mar 20 07:54:25 GMT [cf.nm.nicTransitionUp:info]: Interconnect link 0 is UPNetApp Release 7.0.3: Fri Dec 2 06:00:21 PST 2005Copyright (c) 1992-2005 Network Appliance, Inc.Starting boot on Mon Mar 20 07:54:14 GMT 2006(1) Normal boot.(2) Boot without /etc/rc.(3) Change password.(4) Initialize all disks.(4a) Same as option 4, but create a flexible root volume.(5) Maintenance mode boot.Selection (1-5)?4a这里选择4a,初始化所有的磁盘,并且创建一个root卷,此卷将用于操作系统的安装;Zero disks and install a new file system? y选择y,确认将所有的磁盘零化,并且安装新的文件系统;This will erase all the data on the disks, are you sure? Y选择y,确认将删除磁盘上的所有数据;Zeroing disks takes about 80 minutes. .................................................................................................................................................................... .................................................................................................................................................................... .................................................................................................................................................................... .................................................................................................................................................................... .................................................................................................................................................................... .................................................................................................................................................................... .................................................................................................................................................................... ..................................................................Mon Mar 20 09:15:30 GMT [raid.disk.zero.done:notice]: Disk 0a.23 Shelf ? Bay ? [NETAPP X276_S10K7288F10 NA01] S/N [3KR16HQC00007617E7VE] : disk zeroing complete...............Mon Mar 20 09:15:34 GMT [raid.disk.zero.done:notice]: Disk 0a.18 Shelf ? Bay ? [NETAPP X276_S10K7288F10 NA01] S/N [3KR18YGC000076187JGK] : disk zeroing complete ....................Mon Mar 20 09:15:40 GMT [raid.disk.zero.done:notice]: Disk 0a.20 Shelf ? Bay ? [NETAPP X276_S10K7288F10 NA01] S/N [3KR18MYR0000761769S1] : disk zeroing complete .............Mon Mar 20 09:15:43 GMT [raid.disk.zero.done:notice]: Disk 0a.22 Shelf ? Bay ? [NETAPP X276_S10K7288F10 NA01] S/N [3KR18QV900007617LZY3] : disk zeroing complete ..................Mon Mar 20 09:15:48 GMT [raid.disk.zero.done:notice]: Disk 0a.16 Shelf ? Bay ? [NETAPP X276_S10K7288F10 NA01] S/N [3KR18PE1000076187KXZ] : disk zeroing complete ...............Mon Mar 20 09:15:52 GMT [raid.disk.zero.done:notice]: Disk 0a.21 Shelf ? Bay ? [NETAPP X276_S10K7288F10 NA01] S/N [3KR17PT300007617M1P2] : disk zeroing complete .................................................................................................................................................................... ...............Mon Mar 20 09:16:42 GMT [raid.disk.zero.done:notice]: Disk 0a.17 Shelf ? Bay ? [NETAPP X276_S10K7288F10 NA01] S/N [3KR18Y6700007617695Y] : disk zeroing complete .................................................................................................................................................................... .............Mon Mar 20 09:18:44 GMT [raid.disk.zero.done:notice]: Disk 0a.19 Shelf ? Bay ? [NETAPP X276_S10K7288F10 NA01] S/N [3KR1911Z0000761769R8] : disk zeroing completeMon Mar 20 09:18:45 GMT [raid.vol.disk.add.done:notice]: Addition of Disk /aggr0/plex0/rg0/0a.18 Shelf 1 Bay 2 [NETAPP X276_S10K7288F10 NA01] S/N [3KR18YGC000076187JGK] to aggregate aggr0 has completed successfullyMon Mar 20 09:18:45 GMT [raid.vol.disk.add.done:notice]: Addition of Disk /aggr0/plex0/rg0/0a.17 Shelf 1 Bay 1 [NETAPP X276_S10K7288F10 NA01] S/N [3KR18Y6700007617695Y] to aggregate aggr0 has completed successfullyMon Mar 20 09:18:45 GMT [raid.vol.disk.add.done:notice]: Addition of Disk /aggr0/plex0/rg0/0a.16 Shelf 1 Bay 0 [NETAPP X276_S10K7288F10 NA01] S/N [3KR18PE1000076187KXZ] to aggregate aggr0 has completed successfullyMon Mar 20 09:18:45 GMT [wafl.vol.add:notice]: Aggregate aggr0 has been added to the system. Mon Mar 20 09:18:46 GMT [fmmbx_instanceWorke:info]: no mailbox instance on primary sideMon Mar 20 09:18:47 GMT [fmmbx_instanceWorke:info]: Disk 0a.18 is a primary mailbox disk Mon Mar 20 09:18:47 GMT [fmmbx_instanceWorke:info]: Disk 0a.17 is a primary mailbox disk Mon Mar 20 09:18:47 GMT [fmmbx_instanceWorke:info]: normal mailbox instance on primary side Mon Mar 20 09:18:47 GMT [fmmbx_instanceWorke:info]: Disk 0b.18 is a backup mailbox diskMon Mar 20 09:18:47 GMT [fmmbx_instanceWorke:info]: Disk 0b.17 is a backup mailbox diskMon Mar 20 09:18:47 GMT [fmmbx_instanceWorke:info]: normal mailbox instance on backup sideMon Mar 20 09:18:48 GMT [lun.metafile.dirCreateFailed:error]: Couldn't create vdisk metafile directory /vol/vol0/vdisk.DBG: Set filer.serialnum to: 1071155ifconfig e0a mediatype autoConfiguring onboard ethernet e0a.Contacting DHCP server.Ctrl-C to skip DHCP search ...Mon Mar 20 09:18:48 GMT [rc:info]: Contacting DHCP serverMon Mar 20 09:18:52 GMT [rc:info]: DHCP config failedConfiguring e0a using DHCP failed.NetApp Release 7.0.3: Fri Dec 2 06:00:21 PST 2005System ID: 010******* (); partner ID: <unknown> ()System Serial Number: 1071155 ()System Rev: E0slot 0: System BoardProcessors: 1Memory Size: 2048 MBslot 0: Dual 10/100/1000 Ethernet Controller VIe0a MAC Address: 00:a0:98:03:88:13 (auto-unknown-cfg_down)e0c MAC Address: 00:a0:98:03:88:10 (auto-unknown-cfg_down)e0d MAC Address: 00:a0:98:03:88:11 (auto-unknown-cfg_down) slot 0: FC Host Adapter 0a8 Disks: 2176.0GB1 shelf with ESH2slot 0: FC Host Adapter 0b8 Disks: 2176.0GB1 shelf with ESH2slot 0: Fibre Channel Target Host Adapter 0cslot 0: Fibre Channel Target Host Adapter 0dslot 0: SCSI Host Adapter 0eslot 0: NetApp ATA/IDE Adapter 0f (0x000001f0)0f.0 245MBslot 3: NVRAMMemory Size: 512 MBPlease enter the new hostname []: headb输入这个机头的主机名,这里举例为headb;Do you want to configure virtual network interfaces? [n]: y问是否要配置虚拟网卡,如果要创建的话,输入y;Number of virtual interfaces to configure? [0] 1输入要配置几块虚拟网卡,如配置1块虚拟网卡,就输入1;Name of virtual interface #1 []: vif1输入虚拟网卡的名称,这里举例为vif1;Is vif1 a single [s] or multi [m] virtual interface? [m] s选择虚拟网卡的类型是single还是multi,这里选择s;Number of links for vif1? [0] 2虚拟网卡所包含真实网卡的数量,如果用两块网卡绑定成一块虚拟网卡就输入2;Name of link #1 for vif1 []: e0a输入用于绑定的真实网卡的设备名,可以从阵列设备后面的网络接口上看到;Name of link #2 for vif1 []: e0b输入用于绑定的真实网卡的设备名,可以从阵列设备后面的网络接口上看到;Please enter the IP address for Network Interface vif1 []: 192.168.0.88输入虚拟网卡的IP地址;Please enter the netmask for Network Interface vif1 [255.255.255.0]:输入虚拟网卡的掩码,默认就直接回车;Should virtual interface vif1 take over a partner virtual interface during failover? [n]: y是否允许虚拟网卡在故障时切换到另一个机头上,输入y;The clustered failover software is not yet licensed. To enablenetwork failover, you should run the 'license' command forclustered failover.会提示说没有输入Clustered failover功能的license,需要输入才能实现网络切换功能;Please enter the partner virtual interface name to be taken over by vif1 []: vif1输入另一个机头上的会被切换过来的虚拟网卡的名字;Please enter media type for vif1 {100tx-fd, tp-fd, 100tx, tp, auto (10/100/1000)} [auto]:输入虚拟网卡的类型,一般是自适应,选默认auto;Please enter the IP address for Network Interface e0c []:输入网卡e0c的IP地址,不设置就直接回车;Should interface e0c take over a partner IP address during failover? [n]: n是否允许网卡e0c在故障时切换到另一个机头上,这里不配置就输入n;Please enter the IP address for Network Interface e0d []:输入网卡e0d的IP地址,不设置就直接回车;Should interface e0d take over a partner IP address during failover? [n]: n是否允许网卡e0d在故障时切换到另一个机头上,这里不配置就输入n;Would you like to continue setup through the web interface? [n]: n问是否通过web方式来进行继续的安装,输入n,不需要;Please enter the name or IP address of the default gateway:输入默认网关的名字和IP地址,无须输入就直接回车;The administration host is given root access to the filer's/etc files for system administration. To allow /etc root accessto all NFS clients enter RETURN below.Please enter the name or IP address of the administration host:输入超级管理主机的主机名或IP地址,没有就直接回车;Where is the filer located? []: nanjing问磁盘阵列设备的位置,可以随便写,比如南京,就输入nanjing;Do you want to run DNS resolver? [n]:是否配置DNS,输入n,不配置;Do you want to run NIS client? [n]:是否配置NIS,输入n,不配置;This system will send event messages and weekly reports to Network Appliance Technical Support. To disable this feature, enter "options autosupport.support.enable off" within 24 hours. Enabling Autosupport can significantly speed problem determination and resolution should a problem occur on your system. For further information on Autosupport, please see: /autosupport/ Press the return key to continue.提示说,阵列系统默认的自动发送事件日志和周报告功能是打开的,如果需要关闭,请输入options autosupport.support.enable off。

openstack实施手册

3.7RHEV、KVM虚拟化3.7.1 RHEV安装RHEV 虚拟环境由RHEV-H (虚拟服务器)和RHEV-M(管理平台)组成。

RHEV-H安装在裸机上。

RHEV-M安装在redhat linux6.3上,要求4G以上内存。

RHEV3.1版本开始,RHEV-M 安装在linux系统平台。

RHEV3.0版本,只支持windows平台。

1、安装RHEV-H2、安装RHEV-M管理端(1)rhev3.1目录下的内容上传到/root/目录下:(2)配置yum源#cd /etc/yum.repos.d#vi local.repo[rhev]name=Red Hat Enterprise Virtualizationbaseurl=file:///root/rhev3.1enabled=1gpgcheck=1gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release(3)安装RHEV-M# yum install rhevm rhevm-reports(4)配置RHEV-M# rhevm-setup在配置过程中,需要输入admin、数据等密码,建议的输入的密码全部相同。

(5)IE访问测试(6)配置报表# rhevm-reports-setup在登录界面选择“Reports Portal”,(默认用户为rhevm-admin,密码是安装时输入的密码)3、RHEV-M管理界面疑问2:RHEV-M、ESXi均无法继承到openstack,除非vmware和redhat开发api疑问3:Pureflex的FSM中不是内置了SCE功能吗,如果Pureflex算P团队的单,FSM 应该内置一个安装SCE云平台的虚拟机。

疑问4:KVM的正版授权。

3.7.2 KVM安装1、重新驱动虚拟机测试物理主机:32C+64GB虚拟机1:8C+32GB虚拟机2:8C+16GB虚拟机3:8C+16GB同时重启三台虚拟机,发现物理主机内存使用率100%后,使用部分swap分区。

单节点部署OpenStack(Queens版本、DevStack)

单节点部署OpenStack(Queens版本、DevStack)本⼈在本科毕业设计期间选择了基于OpenStack做⼀个项⽬,当初选题时过分低估了OpenStack学习的时间成本以及学习难度(说起来都是泪…着⼿搭建平台之前对linux、云计算、虚拟化都知之甚少),以⾄于整过过程下来踩了⽆数的坑,但整个过程亦收获颇丰,也重新燃起了对技术的热情。

在学习和实践期间通过阅读论坛博主CloudMan写的“每天5分钟玩转OpenStack”⼀书以及论坛中很多博主分享的⽂章获得了很⼤的帮助。

因此同样秉持着开源、共享的精神,在博客园也开通了⾃⼰的博客,将这段时间学习的过程、踩过的坑记录下来,⼀⽅⾯也算是对⾃⼰做过的⼯作做个总结,另⼀⽅⾯也期望能够在⼀定程度上给同是新⼿、同样遇到很多问题与⿇烦的同僚⼀个解决问题的思路和⽅法。

PS:本⽂叙述⽐较详尽,较适合⼩⽩,因为本⼈也是Newbie,还要向⼤佬们不断学习探索~操作系统的安装:我的OpenStack安装在了Ubuntu 16.04操作系统之下(Win10+Ubuntu 16.04双系统),先安装操作系统;操作系统安装上便遇到了⿇烦:在Ubuntu安装过程选择分区时,最开始根据⽹上的教程,划分了三个分区Swap、boot和/:Swap(交换分区)8G:类似于Windows的虚拟内存,物理内存空间不够时使⽤磁盘资源,通常设置为内存⼤⼩的⼆倍,但部署在普通笔记本上⼀般8G的容量⾜矣;/boot 200M:存放Linux内核⽂件、启动信息;/:剩下的磁盘空间挂载到/下即可,/为根⽬录(可以将其理解为只⼀个分区的Windows,即C盘)。

问题就出在/boot这个分区,它是由于以前BIOS只能认⼀个1024柱⾯的硬盘。

如果启动⽂件放在0-1023之外,BIOS就⽆法读取启动所需的⽂件,从⽽⽆法启动。

为了兼容这种BIOS,就需要在磁盘前端分出⼀个⼩分区专门来存储启动⽂件。

现在这个分区完全没有划分的必要,内核⽂件和启动信息会存储在/中相关的⼦⽬录下。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

北京交大思源科技有限公司OpenStack 基本安装文档北京交大思源科技有限公司 技术支持部庞超北京交大思源科技有限公司北京交大思源科技有限公司1. 介绍此文档适合有LINUX 操作系统基础和SHELL 脚本基础人员阅读。

此文档先后参考多份官方文档、大量度娘、大量google 后,解决各种奇怪的问题而写。

此安装文档将传承开源精神,并鼓励一些开发人员业余时间研究学习OpenStack 。

此文档帮忙一些人在Ubuntu 12.04.2 LTS (Long Term Support )安装OpenStack Grizzly (2013年4月4日发布)。

Note :The Grizzly version is available on the current Ubuntu development series, which is 13.04 (Raring Ringtail) and the most recent LTS (Long Term Support) version which is 12.04 (Precise Pangolin), via the Ubuntu Cloud Archive. At this time, there are not packages available for 12.10.北京交大思源科技有限公司2.体系结构2.1 云基础架构北京交大思源科技有限公司2.2 OpenStack 架构The Cloud Controller : this server provides all functionality of the cloud except actuallyhosting virtual machines or providing network services. See the "Compute Node" and "Network Controller" for details about those roles. This server will host the OpenStackImage Service, the OpenStack Block Storage Service, the OpenStack Identity Service, andthe OpenStack Dashboard. It will also run portions of the OpenStack Compute service such as the API server, the scheduler, conductor, console authenticator, and VNC service.Finally, it hosts the API endpoint for the OpenStack Network service.The Network Controller : this server provides the bulk of the OpenStack Networkservicessuch as DHCP, layer 2 switching, layer 3 routing, floating IPs (which this guide does notconfigure), and metadata connectivity.Compute Node : a Compute Node runs the OpenStack Compute service as well as the北京交大思源科技有限公司OpenStack Network service agent (in this case, the Open vSwitch plugin agent). This server also manages an OpenStack-compatible hypervisor such as KVM or Xen. This server will host the actual virtual machines (instances).Management network . Used for internal communication between OpenStackcomponents. The IP addresses on this network should be reachable only within the data center.• Data network . Used for VM data communication within the cloud deployment. The IP addressing requirements of this network depend on the OpenStack Networking plugin in use.• External network . Used to provide VMs with Internet access in some deployment scenarios. The IP addresses on this network should be reachable by anyone on the Internet.• API network . Exposes all OpenStack APIs, including the OpenStack Networking API, to tenants. The IP addresses on this network should be reachable by anyone on the Internet. This may be the same network as the external network, as it is possible tocreate a quantum subnet for the external network that uses IP allocation ranges to useonly less than the full range of IP addresses in an IP block.3. 需求3.1 硬件配置因之前接触过Vmware Exsi5.0虚拟化产品,后来就想在一台物理机安装Vmware Exsi5.0,然后再在Exsi 平台搭建OpenStack Grizzly 。

北京交大思源科技有限公司OpenStack Grizzly 可以安装在一台节点, 也可以安装在三台节点,为了防止单点故障建议使用三台服务器。

虚拟化平台:Exsi5.03.2 虚拟机配置4. EXSI4.1 KVM在 VMware ESXi 虚拟机上运行虚拟机,被称为多层虚拟或者嵌套虚拟机(Nested VMs )。

如果只有一台电脑想测试多节点 OpenStack 环境的话,使用 VMware ESXi 虚拟几个运行 KVM Hypervisor 的 OpenStack 计算节点是个不错的办法。

北京交大思源科技有限公司VMware ESXi 5.0 默认情况下不支持嵌套虚拟,所以在 VMware ESXi 虚拟机里安装完 KVM 以后会发现 KVM 虽然能装但不可用:# kvm-okINFO: Your CPU does not support KVM extensions KVM acceleration can NOT be used解决办法很简单:1、修改 VMware ESXi 的设置;2、修改对应虚拟机的设置。

登陆 VMware ESXi 控制台打开 VMware ESXi 5.0 的 SSH 服务(默认 SSH 服务是关闭的),然后用 ssh 登陆 VMware ESXi 后在 config 文件中最后加入 vhv.allow = “TRUE ” 一行:# vi /etc/vmware/config libdir = "/usr/lib/vmware"authd.proxy.vim = "vmware-hostd:hostd-vmdb" authd.proxy.nfc = "vmware-hostd:ha-nfc" authd.proxy.nfcssl = "vmware-hostd:ha-nfcssl" authd.proxy.vpxa-nfcssl = "vmware-vpxa:vpxa-nfcssl" authd.proxy.vpxa-nfc = "vmware-vpxa:vpxa-nfc" authd.fullpath = "/sbin/authd" authd.soapServer = "TRUE"vmauthd.server.alwaysProxy = "TRUE" vhv.allow = "TRUE"北京交大思源科技有限公司重启 VMware ESXi 后编辑虚拟机选项(需要先关闭虚拟机),打开 Edit virtual machine settings 对话框,在 options 页面的 General Options 选项里把 Guest Operating System 的类型换成 Other 里面的 VMware ESxi 5.x ,如图:最后启动虚拟机后再 kvm-ok 一下就可以看到 KVM 可以用了:# kvm-okINFO: /dev/kvm existsKVM acceleration can be used4.2 网络网络这块主要涉及OpenStack 内VMs 配置好了,上不了外网的问题。

解决方法:选中主机->配置->网络->vSwitch0->属性北京交大思源科技有限公司选中Management Network选中安全选项,将混杂模式修改为“接受”。

如果还是拒绝的话,很还可能导致OpenStack 的VMs 不能上外网。

北京交大思源科技有限公司5. Controller (控制节点)准备Databases (with MySQL )Queues (with RabbitMQ )(消息处理)北京交大思源科技有限公司Keystone (身份验证、服务规则和服务令牌的功能)Glance (镜像管理)Nova (without nova-compute )(虚拟机运行管理) Cinder (存储管理)Quantum-Server (with Open-vSwitch plugin )(网络管理) Dashboard (with Horizon )以上安装包都将安装在Controller 控制节点。