人工智能天气决策树源代码

id3算法对天气-打球关系的决策树

ID3算法是一种用于构建决策树的经典机器学习算法,它可以根据给定的数据集,自动构建出一个决策树模型,用于对未知数据进行分类。

在实际应用中,ID3算法被广泛应用于各种领域,包括天气预测和决策制定。

本文将以天气和是否适合打球这一主题为例,具体介绍ID3算法对于天气-打球关系的决策树。

1. 背景介绍天气对于人们的日常生活有着重要的影响,尤其是对于室外活动,比如打球。

在实际生活中,人们往往会根据当天的天气情况来决定是否适合进行打球活动。

而要根据天气来进行决策,就需要建立一个天气-打球的决策模型。

而ID3算法正是用来构建这样的决策模型的利器。

2. 数据采集为了构建天气-打球的决策树模型,首先需要收集一定量的天气相关数据和打球相关数据。

可以记录每天的天气情况(如晴天、阴天、下雨)、温度、湿度等天气指标,以及当天是否适合进行打球活动(是/否)。

通过收集大量的这样的数据,就可以构建出一个合适的数据集。

3. 分析数据在收集到足够的数据后,就可以开始分析这些数据,寻找天气与打球之间的关系。

ID3算法的核心思想是选择最佳的属性来进行划分,以便对数据进行分类。

在本例中,可以将天气指标(如晴天、阴天、下雨)作为属性,将打球活动(是/否)作为分类结果,然后根据ID3算法来选择最佳的属性进行数据划分,从而构建出决策树模型。

4. 构建决策树在进行数据分析后,就可以利用ID3算法来构建天气-打球的决策树。

ID3算法通过计算信息增益来确定最佳的属性,然后进行递归地对数据进行划分,直到构建出完整的决策树模型。

在这个过程中,ID3算法会根据不同的属性值来确定最佳的决策点,从而使得对于未知天气情况的打球决策变得更加准确。

5. 评估和优化构建出决策树模型后,还需要对模型进行评估和优化。

可以利用交叉验证等方法来检验模型的准确性,并根据验证结果对模型进行调整和优化。

这一步骤是非常重要的,可以帮助进一步提高决策树模型的预测能力。

6. 应用和推广构建出决策树模型后,可以将其应用到实际的天气预测和打球决策中。

id3决策树算法python程序

id3决策树算法python程序关于ID3决策树算法的Python程序。

第一步:了解ID3决策树算法ID3决策树算法是一种常用的机器学习算法,用于解决分类问题。

它基于信息论的概念,通过选择最佳的特征来构建决策树模型。

ID3算法的核心是计算信息增益,即通过选择最能区分不同类别的特征来构建决策树。

第二步:导入需要的Python库和数据集在编写ID3决策树算法的Python程序之前,我们需要导入一些必要的Python库和准备好相关的数据集。

在本例中,我们将使用pandas库来处理数据集,并使用sklearn库的train_test_split函数来将数据集拆分为训练集和测试集。

pythonimport pandas as pdfrom sklearn.model_selection import train_test_split# 读取数据集data = pd.read_csv('dataset.csv')# 将数据集拆分为特征和标签X = data.drop('Class', axis=1)y = data['Class']# 将数据集拆分为训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2) 第三步:实现ID3决策树算法的Python函数在此步骤中,我们将编写一个名为ID3DecisionTree的Python函数来实现ID3决策树算法。

该函数将递归地构建决策树,直到满足停止条件。

在每个递归步骤中,它将计算信息增益,并选择最佳特征作为当前节点的分裂依据。

pythonfrom math import log2from collections import Counterclass ID3DecisionTree:def __init__(self):self.tree = {}def calc_entropy(self, labels):label_counts = Counter(labels)entropy = 0for count in label_counts.values():p = count / len(labels)entropy -= p * log2(p)return entropydef calc_info_gain(self, data, labels, feature):feature_values = data[feature].unique()feature_entropy = 0for value in feature_values:subset_labels = labels[data[feature] == value]feature_entropy += len(subset_labels) / len(labels) * self.calc_entropy(subset_labels)return self.calc_entropy(labels) - feature_entropydef choose_best_feature(self, data, labels):best_info_gain = 0best_feature = Nonefor feature in data.columns:info_gain = self.calc_info_gain(data, labels, feature)if info_gain > best_info_gain:best_info_gain = info_gainbest_feature = featurereturn best_featuredef build_tree(self, data, labels):if len(set(labels)) == 1:return labels[0]elif len(data.columns) == 0:return Counter(labels).most_common(1)[0][0] else:best_feature = self.choose_best_feature(data, labels)sub_data = {}for value in data[best_feature].unique():subset = data[data[best_feature] == value].drop(best_feature, axis=1)sub_labels = labels[data[best_feature] == value]sub_data[value] = (subset, sub_labels)tree = {best_feature: {}}for value, (subset, sub_labels) in sub_data.items():tree[best_feature][value] = self.build_tree(subset, sub_labels)return treedef fit(self, data, labels):self.tree = self.build_tree(data, labels)def predict(self, data):predictions = []for _, row in data.iterrows():node = self.treewhile isinstance(node, dict):feature = list(node.keys())[0]value = row[feature]node = node[feature][value]predictions.append(node)return predictions第四步:使用ID3决策树模型进行训练和预测最后一步是使用我们实现的ID3DecisionTree类进行训练和预测。

id3算法代码

id3算法代码ID3算法简介ID3算法是一种常用的决策树算法,它通过对数据集的属性进行分析,选择最优属性作为节点,生成决策树模型。

ID3算法是基于信息熵的思想,通过计算每个属性对样本集合的信息增益来选择最优划分属性。

ID3算法步骤1. 计算数据集的熵首先需要计算数据集的熵,熵越大表示样本集合越混乱。

假设有n个类别,则数据集D的熵可以表示为:$$ Ent(D) = -\sum_{i=1}^{n}p_i\log_2p_i $$其中$p_i$表示第i个类别在数据集D中出现的概率。

2. 计算每个属性对样本集合的信息增益接下来需要计算每个属性对样本集合的信息增益。

假设有m个属性,则第j个属性$A_j$对数据集D的信息增益可以表示为:$$ Gain(D, A_j) = Ent(D) - \sum_{i=1}^{v}\frac{|D_i|}{|D|}Ent(D_i) $$其中$v$表示第j个属性可能取值的数量,$D_i$表示在第j个属性上取值为$i$时所包含的样本子集。

3. 选择最优划分属性从所有可用属性中选择最优划分属性作为当前节点。

选择最优划分属性的方法是计算所有属性的信息增益,选择信息增益最大的属性作为当前节点。

4. 递归生成决策树使用选择的最优划分属性将数据集划分成若干子集,对每个子集递归生成子树。

ID3算法代码实现下面是Python语言实现ID3算法的代码:```pythonimport mathimport pandas as pd# 计算熵def calc_entropy(data):n = len(data)label_counts = {}for row in data:label = row[-1]if label not in label_counts:label_counts[label] = 0label_counts[label] += 1entropy = 0.0for key in label_counts:prob = float(label_counts[key]) / n entropy -= prob * math.log(prob, 2) return entropy# 划分数据集def split_data(data, axis, value):sub_data = []for row in data:if row[axis] == value:sub_row = row[:axis]sub_row.extend(row[axis+1:])sub_data.append(sub_row)return sub_data# 计算信息增益def calc_info_gain(data, base_entropy, axis):values = set([row[axis] for row in data])new_entropy = 0.0for value in values:sub_data = split_data(data, axis, value)prob = len(sub_data) / float(len(data))new_entropy += prob * calc_entropy(sub_data) info_gain = base_entropy - new_entropyreturn info_gain# 选择最优划分属性def choose_best_feature(data):num_features = len(data[0]) - 1base_entropy = calc_entropy(data)best_info_gain = 0.0best_feature = -1for i in range(num_features):info_gain = calc_info_gain(data, base_entropy, i)if info_gain > best_info_gain:best_info_gain = info_gainbest_feature = ireturn best_feature# 多数表决函数,用于确定叶子节点的类别def majority_vote(class_list):class_count = {}for vote in class_list:if vote not in class_count:class_count[vote] = 0class_count[vote] += 1sorted_class_count = sorted(class_count.items(), key=lambda x:x[1], reverse=True)return sorted_class_count[0][0]# 创建决策树def create_tree(data, labels):class_list = [row[-1] for row in data]if class_list.count(class_list[0]) == len(class_list):return class_list[0]if len(data[0]) == 1:return majority_vote(class_list)best_feature_idx = choose_best_feature(data)best_feature_label = labels[best_feature_idx]tree_node = {best_feature_label: {}}del(labels[best_feature_idx])feature_values = [row[best_feature_idx] for row in data] unique_values = set(feature_values)for value in unique_values:sub_labels = labels[:]sub_data = split_data(data, best_feature_idx, value) tree_node[best_feature_label][value] =create_tree(sub_data, sub_labels)return tree_node# 预测函数def predict(tree, labels, data):first_str = list(tree.keys())[0]second_dict = tree[first_str]feat_index = labels.index(first_str)key = data[feat_index]value_of_feat = second_dict[key]if isinstance(value_of_feat, dict):class_label = predict(value_of_feat, labels, data) else:class_label = value_of_featreturn class_label# 测试函数def test():# 读取数据集df = pd.read_csv('iris.csv')data = df.values.tolist()# 划分训练集和测试集train_data = []test_data = []for i in range(len(data)):if i % 5 == 0:test_data.append(data[i])else:train_data.append(data[i])# 创建决策树labels = df.columns.tolist()[:-1]tree = create_tree(train_data, labels)# 测试决策树模型的准确率correct_count = 0for row in test_data:true_label = row[-1]pred_label = predict(tree, labels, row[:-1])if true_label == pred_label:correct_count += 1accuracy = float(correct_count) / len(test_data)if __name__ == '__main__':test()```代码解释以上代码实现了ID3算法的主要功能。

人工智能c语言源代码

人工智能c语言源代码人工智能是一个广泛的领域,涉及多种算法和技术。

在C语言中,可以实现一些基本的人工智能功能。

下面是一个简单的示例,展示了如何使用C语言编写一个简单的决策树算法:c.#include <stdio.h>。

// 定义决策树节点结构。

typedef struct DecisionTreeNode {。

char question;struct DecisionTreeNode yesNode;struct DecisionTreeNode noNode;} DecisionTreeNode;// 创建决策树节点。

DecisionTreeNode createNode(char question) {。

DecisionTreeNode node = (DecisionTreeNode)malloc(sizeof(DecisionTreeNode));node->question = question;node->yesNode = NULL;node->noNode = NULL;return node;}。

// 决策树算法。

void decisionTree() {。

DecisionTreeNode root = createNode("Is it a mammal?");root->yesNode = createNode("Does it have fur?");root->yesNode->yesNode = createNode("It's amammal!");root->yesNode->noNode = createNode("It's not a mammal!");root->noNode = createNode("Does it have feathers?");root->noNode->yesNode = createNode("It's a bird!");root->noNode->noNode = createNode("It's not abird!");printf("%s\n", root->question);char answer;scanf(" %c", &answer);DecisionTreeNode currentNode = root;while (currentNode != NULL) {。

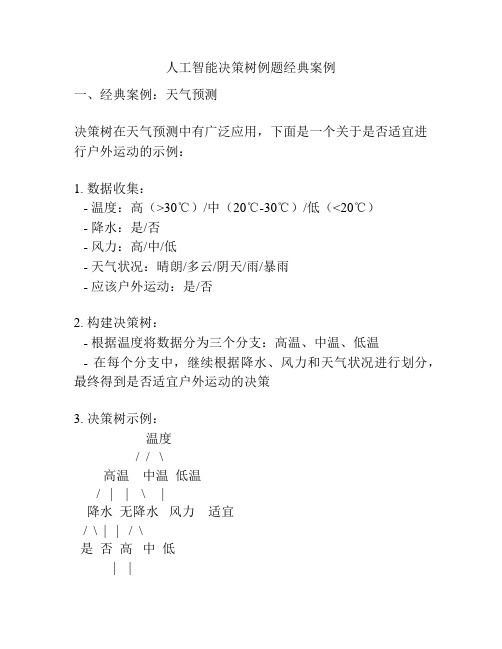

人工智能决策树例题经典案例

人工智能决策树例题经典案例一、经典案例:天气预测决策树在天气预测中有广泛应用,下面是一个关于是否适宜进行户外运动的示例:1. 数据收集:- 温度:高(>30℃)/中(20℃-30℃)/低(<20℃)- 降水:是/否- 风力:高/中/低- 天气状况:晴朗/多云/阴天/雨/暴雨- 应该户外运动:是/否2. 构建决策树:- 根据温度将数据分为三个分支:高温、中温、低温- 在每个分支中,继续根据降水、风力和天气状况进行划分,最终得到是否适宜户外运动的决策3. 决策树示例:温度/ / \高温中温低温/ | | \ |降水无降水风力适宜/ \ | | / \是否高中低| |不适宜适宜- 如果温度是高温且有降水,则不适宜户外运动- 如果温度是高温且无降水,则根据风力判断,如果风力是高,则不适宜户外运动,如果风力是中或低,则适宜户外运动 - 如果温度是中温,则不论降水和风力如何,都适宜户外运动- 如果温度是低温,则需要考虑风力,如果风力是高,则适宜户外运动,如果风力是中或低,则不适宜户外运动4. 参考内容:决策树的构建和应用:决策树通过对输入特征进行划分,构建了一棵树形结构,用于解决分类或回归问题。

构建决策树主要包括数据预处理、特征选择、划分策略和停止条件等步骤。

特征选择可以使用信息增益、基尼指数等算法,划分策略可以使用二叉划分或多叉划分,停止条件可以是叶子节点纯度达到一定阈值或达到预定的树深度。

决策树的应用包括数据分类、特征选择和预测等任务。

天气预测案例中的决策树:将天气预测问题转化为分类问题,通过构建决策树,可以得到识别是否适宜户外运动的规则。

决策树的决策路径可以用流程图或树状图表示,帮助理解和解释决策过程。

决策树的节点表示特征值,分支表示判断条件,叶子节点表示分类结果。

决策树的生成算法可以基于启发式规则或数学模型,如ID3、C4.5、CART等。

决策树的优缺点:决策树具有可解释性强、易于理解和实现、能处理非线性关系等优点。

机器学习经典算法详解及Python实现–决策树(Decision Tree) _ 数盟

人工智能

作者:Adan

℃

0评论

(一)认识决策树

1,决策树分类原理

决策树是通过一系列规则对数据进行分类的过程。它提供一种在什么条件下会得到什么值的类似 规则的方法。决策树分为分类树和回归树两种,分类树对离散变量做决策树,回归树对连续变量 做决策树。 近来的调查表明决策树也是最经常使用的数据挖掘算法,它的概念非常简单。决策树算法之所以 如此流行,一个很重要的原因就是使用者基本上不用了解机器学习算法,也不用深究它是如何工 作的。直观看上去,决策树分类器就像判断模块和终止块组成的流程图,终止块表示分类结 果(也就是树的叶子)。判断模块表示对一个特征取值的判断(该特征有几个值,判断模块就有 几个分支)。 如果不考虑效率等,那么样本所有特征的判断级联起来终会将某一个样本分到一个类终止块 上。实际上,样本所有特征中有一些特征在分类时起到决定性作用,决策树的构造过程就是找到 这些具有决定性作用的特征,根据其决定性程度来构造一个倒立的树–决定性作用最大的那个特 征作为根节点,然后递归找到各分支下子数据集中次大的决定性特征,直至子数据集中所有数据 都属于同一类。所以,构造决策树的过程本质上就是根据数据特征将数据集分类的递归过程,我 们需要解决的第一个问题就是,当前数据集上哪个特征在划分数据分类时起决定性作用。 为了找到决定性的特征、划分出最好的结果,我们必须评估数据集中蕴含的每个特征,寻找分类 数据集的最好特征。完成评估之后,原始数据集就被划分为几个数据子集。这些数据子集会分布 在第一个决策点的所有分支上。如果某个分支下的数据属于同一类型,则则该分支处理完成,称 为一个叶子节点,即确定了分类。如果数据子集内的数据不属于同一类型,则需要重复划分数据 子集的过程。如何划分数据子集的算法和划分原始数据集的方法相同,直到所有具有相同类型的 数据均在一个数据子集内(叶子节点)。如下图就是一个决策树实例(目标是两类–见或者不 见,每个样本有年龄、长相、收入、是否公务员四个特征):

机器学习决策树ID3算法的源代码

机器学习决策树ID3算法的源代码决策树算法(ID3)是一种机器学习算法,利用决策树的方式来学习和预测数据。

它是一种递归算法,可以根据现有的数据对分类功能进行估计。

ID3算法一般包括以下几个步骤:1、首先从所有的可能的特征中选择一个最好的分类特征,这个特征会从样本中提取出最有区分度的分类特征;2、接着把训练数据集按照这个特征的取值,划分成若干个小数据集;3、然后,从小数据集中,继续选择一个具有最大信息增益的特征作为子节点分裂依据;4、将节点分裂后,立即分类节点,叶子节点的样本类型应经过多数投票法,确定这个节点所属的分类;5、再把上述过程应用到每一个子节点上,一直迭代直到每一个节点只包含单一类别的样本;6、最后,根据决策树规则,得到一个分类模型,用于预测新的样本属于哪一类;下面是实现ID3算法的源代码:# -*- coding: utf-8 -*-import pandas as pdimport numpy as npfrom math import log2"""计算基尼不纯度parameters:dfData - 训练数据class_col - 分类的列returns:giniIndex - 基尼不纯度"""def giniIndex(dfData, class_col):giniIndex = 1class_count = dfData[class_col].value_counts( #计算每个类别出现的次数sum_count = dfData.shape[0] #数据的总条数for k in class_count:giniIndex -= (k / sum_count)**2 #基尼不纯度公式return giniIndex"""计算信息增益parameters:。

matlab决策树代码例子

matlab决策树代码例子当涉及到决策树的代码示例时,MATLAB提供了一个强大的工具箱,称为Statistics and Machine Learning Toolbox。

下面是一个使用MATLAB的决策树分类器的简单代码示例:matlab.% 导入数据。

load fisheriris.X = meas;Y = species;% 创建决策树模型。

tree = fitctree(X, Y);% 可视化决策树。

view(tree, 'Mode', 'Graph');% 预测新样本。

newX = [5 3.5 1.4 0.2; 6 3 4.5 1.5];predictedY = predict(tree, newX);disp(predictedY);这个示例中,我们首先导入了经典的鸢尾花数据集(fisheriris),其中包含了鸢尾花的测量数据(花萼长度、花萼宽度、花瓣长度和花瓣宽度)以及对应的鸢尾花种类。

然后,我们使用`fitctree`函数创建了一个决策树分类器模型,其中`X`是输入特征矩阵,`Y`是对应的目标变量。

接下来,我们使用`view`函数可视化生成的决策树模型,可以以图形方式展示决策树的结构。

最后,我们使用新的样本数据`newX`来预测其所属的鸢尾花种类,并使用`predict`函数进行预测。

这只是一个简单的决策树代码示例,你可以根据自己的需求进行更复杂的决策树模型构建和预测。

MATLAB的决策树工具箱提供了更多的选项和功能,例如控制树的最大深度、最小叶节点数等参数,以及交叉验证和剪枝等技术来优化模型。

决策树算法(1)含java源代码

决策树算法(1)含java源代码信息熵:变量的不确定性越⼤,熵越⼤。

熵可⽤下⾯的公式描述:-(p1*logp1+p2*logp2+...+pn*logpn)pi表⽰事件i发⽣的概率ID3:GAIN(A)=INFO(D)-INFO_A(D)节点A的信息增益为不加节点A时的信息量INFO(D)-加上A后的信息量INFO_A(D)算法步骤:1、树以代表训练样本的某个结点开始2、如果样本都在同⼀类,则将该节点设置为叶⼦,并使⽤该类标号3、否则,算法使⽤熵度量每个样本的分类结点,选择可以获得最⼤信息的节点4、所有的属性都是分类的,连续值必须离散化停⽌条件:该节点上所有的样本都属于⼀个类没有剩余的属性没有属性时,⽐如已经分到第三个属性,但是没有第四个属性,这时将样本分到最多的那类C4.5与ID3区别在于属性度量⽅式的不同优点:直观、便于理解、⼩规模数据有效缺点:处理连续变量不好类别较多时,错误增加⽐较快可规模性⼀般package dTree;import java.util.ArrayList;import java.util.HashMap;import java.util.Iterator;import java.util.List;import java.util.Map;import java.util.Set;public class dataClass {public static void main(String[] args) {double [][]exerciseData = {{1,1,0,0},{1,3,1,1},{3,2,1,1},{2,2,1,1},{3,2,1,1},{2,3,0,1},{2,1,0,0},{3,2,0,1},{2,1,0,1},{1,1,1,0}};//每⼀列表⽰⼀个属性值,最后⼀列表⽰决策层int[] index = gainResult(exerciseData);//输出的结果表⽰按照决策树规则所对应的属性参考顺序for(int i = 0;i<index.length;i++){System.out.print(" "+(index[i]+1));}}private static int[] gainResult(double[][] exerciseData) {int dataQuantity = exerciseData.length;int attributeQuantity = exerciseData[0].length-1;int []attribute = new int[attributeQuantity];int []newAttribute = new int [attributeQuantity];double [][]newExerciseData = exerciseData ;double [][]maxgainIndexData = new double[dataQuantity][attributeQuantity];for(int i = 0;i<attributeQuantity;i++){attribute[i] = MaxgainIndex(newExerciseData);for(int j = 0;j<maxgainIndexData.length;j++){maxgainIndexData[j][i] = newExerciseData[j][attribute[i]];}newExerciseData = NewData(newExerciseData,attribute[i]);}boolean flag =true;for(int i = 0;i<maxgainIndexData[0].length;i++){//寻找第i列所对应的exerciseDatafor(int k = 0;k<exerciseData[0].length-1;k++){flag = true;for(int j = 0;j<exerciseData.length;j++){if(maxgainIndexData[j][i]!=exerciseData[j][k]){flag = false;break;}}if(flag==true){newAttribute[i] = k;}}}return newAttribute;}//矩阵转置private static double[][] Transpose(double[][] exerciseData){int rows = exerciseData.length;int columns = exerciseData[0].length;double [][]newData = new double [columns][rows];for(int i = 0;i<columns;i++){for(int j= 0;j<rows;j++){newData[i][j] = exerciseData[j][i];}}return newData;}private static double[][] NewData(double[][] exerciseData,int maxIndex) {//删除exerciseData中maxindex列的数据,产⽣新数据double [][]newExerciseData = new double[exerciseData.length][];for(int i = 0;i<exerciseData.length;i++){newExerciseData[i] = new double[exerciseData[i].length-1];for(int j = 0;j<newExerciseData[i].length;j++){if(j>=maxIndex){newExerciseData[i][j] = exerciseData[i][j+1];}else{newExerciseData[i][j] = exerciseData[i][j];}}}return newExerciseData;}private static int MaxgainIndex(double[][] exerciseData) {//获取exerciseData最⼤增益率所对应的⼀列double []gainRatio = gainAll(exerciseData);double maxGain = gainRatio[0];//最⼤增益率int maxIndex = 0;//最⼤增益率所对应的索引值for(int i=1;i<gainRatio.length-1;i++){if(maxGain<gainRatio[i]){maxGain = gainRatio[i];maxIndex = i;}}return maxIndex;}public static double[] gainAll(double [][]Data){//得到Data中每⼀列的增益值int col = Data.length;//数据个数int vol = Data[0].length;//属性个数double [][]count = new double[vol][];double []info = new double[vol];double Lcount[][] = new double[vol][];//第i个属性的第j个分类的⽐率double Mcount[][] = new double[vol][];List <List<Map1>>listM = new ArrayList<List<Map1>>();List <List<Map1>>listM2 = new ArrayList<List<Map1>>();double []gain;//矩阵的属性统计for (int i = 0;i<vol;i++){//属性i的不重复的分类集(mapList加⼊了属性i以及对应的决策层的值)List<Map> mapList = new ArrayList<Map>();for(int j = 0;j<col;j++){Map y = new HashMap();y.put(Data[j][i],Data[j][vol-1]);if(!mapList.contains(y)){mapList.add(y);}}//属性i全部分类集(重复,listM2加⼊了i值以及决策层的值)List<Map> AllmapList = new ArrayList<Map>();for(int j = 0;j<col;j++){Map y = new HashMap();y.put(Data[j][i],Data[j][vol-1]);AllmapList.add(y);}count[i] = new double[mapList.size()];double sum = 0;double num = 0;List<Map1>LM = new ArrayList<Map1>();for(int j=0;j<mapList.size();j++){Iterator it =((Map)(mapList.get(j))).keySet().iterator(); num = (Double) it.next();for(int k = 0;k<AllmapList.size();k++){if(mapList.get(j).equals(AllmapList.get(k))){count[i][j] = count[i][j]+1;}}Map1 p = new Map1();p.setKey(count[i][j]);p.setValue(num);LM.add(p);}listM2.add(LM);}for( int k = 0;k<vol;k++){List <Double>list = new ArrayList<Double>();for(int i = 0;i<col;i++){if(!list.contains(Data[i][k])){list.add(Data[i][k]);}}Lcount[k] = new double[list.size()];Mcount[k] = new double[list.size()];for(int j = 0;j<col;j++){int index = list.indexOf(Data[j][k]);Lcount[k][index] = Lcount[k][index]+1;Mcount[k][index] = Mcount[k][index]+1;}double LastSum = 0;for(int i = 0;i<Lcount[k].length;i++){LastSum = LastSum+Lcount[k][i];}for(int j = 0;j<Lcount[k].length;j++){Lcount[k][j] = Lcount[k][j]/LastSum;}List<Map1> LM = new ArrayList<Map1>();for(int i = 0;i<Lcount[k].length;i++){Map1 p = new Map1();p.setKey(Mcount[k][i]);p.setValue(list.get(i));LM.add(p);}listM.add(LM);}gain = new double[listM2.size()];for(int i = 0; i<listM2.size()-1;i++){List listi = new ArrayList();listi = listM.get(i);double sum = 0;for(int j=0;j<listi.size();j++){Map1 p = (Map1) listi.get(j);double key = p.getKey();double value = p.getValue();for(int k = 0;k<listM2.get(i).size();k++){Map1 p1 = (Map1) listM2.get(i).get(k);if(p1.value==value){sum = sum+xlog2(p1.key/p.key);}//System.out.println(sum);}gain[i]+=sum*Lcount[i][j];sum = 0;}}for(int i = 0;i<Lcount[Lcount.length-1].length;i++){gain[listM2.size()-1] += -xlog2(Lcount[Lcount.length-1][i]); }for(int j = 0;j<gain.length-1;j++){gain[j] = gain[gain.length-1]+gain[j];}double[]Scount = new double [Lcount.length-1];for(int j= 0;j<Lcount.length-1;j++){double sum = 0;for(int k = 0;k<Lcount[j].length;k++){sum += xlog2(Lcount[j][k]);}Scount[j] = -sum;}for(int j= 0;j<Scount.length;j++){gain[j] = gain[j]/Scount[j];}return gain;}public static boolean contain(Map mapList,double key,double value){ if(value==Double.parseDouble(mapList.get(key).toString())){return true;}else{return false;}}public static double xlog2(double x){return x*(Math.log(x)/Math.log((double)2));}}。

决策树算法python代码

决策树算法python代码决策树是一种常见的机器学习算法,它可以用来做分类和回归问题。

决策树算法可以帮助我们从一组数据中找出有用的信息,并且可以把这些信息用来做出决策。

一般来说,决策树算法的基本思想是:从一组数据中提取最重要的特征,并根据这些特征来做出决策。

这些特征可以是数值型的,也可以是类别型的,也可以是组合型的。

下面我们来看一下决策树算法的python代码:## 一、导入库首先,我们需要导入相关的库,比如`numpy`,`pandas`,`sklearn`等。

```pythonimport numpy as npimport pandas as pdfrom sklearn.tree import DecisionTreeClassifier```## 二、准备数据然后,我们需要准备用于训练决策树的数据。

我们可以使用`pandas`库读取数据,并将其转换为`numpy`数组。

```python# 读取数据data = pd.read_csv('data.csv')# 将数据转换为numpy数组X = data.iloc[:,:-1].valuesy = data.iloc[:,-1].values```## 三、构建决策树接下来,我们就可以构建决策树了。

我们可以使用`sklearn`库中的`DecisionTreeClassifier`类来构建决策树。

```python# 创建决策树clf = DecisionTreeClassifier()# 训练决策树clf.fit(X,y)```## 四、预测结果最后,我们可以使用训练好的决策树来做预测。

```python# 预测结果y_pred = clf.predict(X)```## 五、评估模型最后,我们还可以使用`sklearn`库中的`accuracy_score`函数来评估模型的准确率。

```python# 评估模型from sklearn.metrics import accuracy_scoreprint(accuracy_score(y, y_pred))```以上就是决策树算法的python代码。

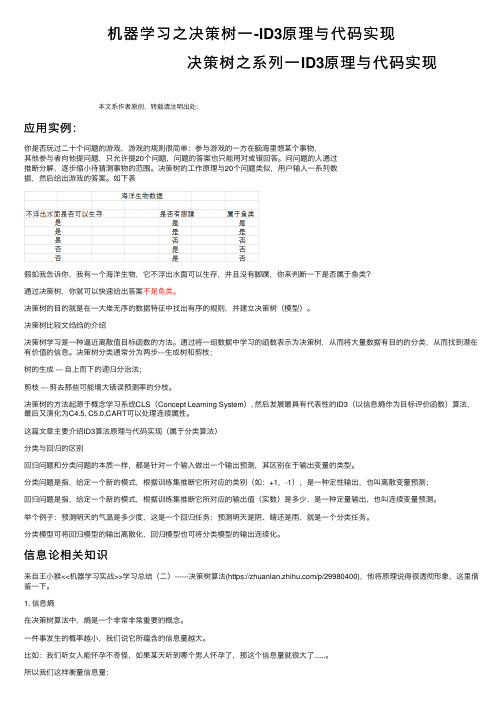

机器学习之决策树一-ID3原理与代码实现

机器学习之决策树⼀-ID3原理与代码实现决策树之系列⼀ID3原理与代码实现本⽂系作者原创,转载请注明出处:应⽤实例:你是否玩过⼆⼗个问题的游戏,游戏的规则很简单:参与游戏的⼀⽅在脑海⾥想某个事物,其他参与者向他提问题,只允许提20个问题,问题的答案也只能⽤对或错回答。

问问题的⼈通过推断分解,逐步缩⼩待猜测事物的范围。

决策树的⼯作原理与20个问题类似,⽤户输⼈⼀系列数据,然后给出游戏的答案。

如下表假如我告诉你,我有⼀个海洋⽣物,它不浮出⽔⾯可以⽣存,并且没有脚蹼,你来判断⼀下是否属于鱼类?通过决策树,你就可以快速给出答案不是鱼类。

决策树的⽬的就是在⼀⼤堆⽆序的数据特征中找出有序的规则,并建⽴决策树(模型)。

决策树⽐较⽂绉绉的介绍决策树学习是⼀种逼近离散值⽬标函数的⽅法。

通过将⼀组数据中学习的函数表⽰为决策树,从⽽将⼤量数据有⽬的的分类,从⽽找到潜在有价值的信息。

决策树分类通常分为两步---⽣成树和剪枝;树的⽣成 --- ⾃上⽽下的递归分治法;剪枝 --- 剪去那些可能增⼤错误预测率的分枝。

决策树的⽅法起源于概念学习系统CLS(Concept Learning System), 然后发展最具有代表性的ID3(以信息熵作为⽬标评价函数)算法,最后⼜演化为C4.5, C5.0,CART可以处理连续属性。

这篇⽂章主要介绍ID3算法原理与代码实现(属于分类算法)分类与回归的区别回归问题和分类问题的本质⼀样,都是针对⼀个输⼊做出⼀个输出预测,其区别在于输出变量的类型。

分类问题是指,给定⼀个新的模式,根据训练集推断它所对应的类别(如:+1,-1),是⼀种定性输出,也叫离散变量预测;回归问题是指,给定⼀个新的模式,根据训练集推断它所对应的输出值(实数)是多少,是⼀种定量输出,也叫连续变量预测。

举个例⼦:预测明天的⽓温是多少度,这是⼀个回归任务;预测明天是阴、晴还是⾬,就是⼀个分类任务。

分类模型可将回归模型的输出离散化,回归模型也可将分类模型的输出连续化。

tensorflow天气预测计算公式

一、介绍随着人工智能技术的发展和应用,越来越多的领域开始将这一技术运用到实际应用中。

其中,天气预测是一个非常重要的领域,对于农业、交通、航空等行业都有着重要的影响。

而TensorFlow作为一种流行的机器学习框架,也被广泛应用于天气预测中。

本文将介绍TensorFlow在天气预测中的计算公式。

二、天气预测的重要性天气预测对于社会的各个领域都有着重要的影响。

在农业领域,天气预测可以帮助农民做出种植决策,避免因天气变化而导致的收成损失。

在交通和航空领域,天气预测可以帮助交通运输公司和航空公司优化航线和行车计划,减少不必要的延误和事故。

三、TensorFlow在天气预测中的应用TensorFlow是一个基于数据流图的开源软件库,主要用于机器学习和深度学习应用程序。

在天气预测中,TensorFlow可以帮助我们通过历史气象数据和其他相关数据来建立模型,并进行天气预测。

在TensorFlow中,天气预测的计算公式主要包括以下几个步骤:1. 数据收集和预处理天气预测的第一步是收集和预处理数据。

这些数据可以包括历史气象数据、地理位置数据、气象预报数据等。

通过TensorFlow提供的数据处理工具,我们可以将这些数据进行清洗、归一化等预处理操作,以便后续的模型训练和预测。

2. 模型选择和训练在数据预处理之后,我们需要选择合适的模型来进行天气预测。

TensorFlow提供了丰富的机器学习和深度学习模型,包括线性回归、决策树、神经网络等。

根据实际情况和需求,我们可以选择合适的模型,并通过TensorFlow来进行模型的训练和优化,以提高预测的准确度和稳定性。

3. 模型评估和预测模型训练完成之后,我们需要通过一定的评估指标来评估模型的性能。

这些评估指标可以包括均方误差、相关系数等。

在TensorFlow中,我们可以通过内置的评估函数来对模型进行评估。

通过训练好的模型,我们可以进行天气预测,并得到未来一段时间内的天气情况预测结果。

人工智能天气决策树源代码

昆明理工大学信息工程与自动化学院学生实验报告( 2011 — 2012 学年第 1 学期)课程名称:人工智能开课实验室:信自楼计算机机房444 2011 年12月 16 日专业班级0 学号200 姓名成绩实验名称天气决策树指导教师教师评语该同学是否了解实验原理: A.了解□ B.基本了解□ C.不了解□该同学的实验能力: A.强□ B.中等□ C.差□该同学的实验是否达到要求: A.达到□ B.基本达到□ C.未达到□实验报告是否规范: A.规范□ B.基本规范□ C.不规范□实验过程是否详细记录: A.详细□ B.一般□ C.没有□教师签名:2011 年12 月日一、上机目的及内容1.上机内容根据下列给定的14个数据,运用Information Gain构造一个天气决策树。

例子编号属性分类天况温度湿度风况1 晴热大无N2 晴热大有N3 多云热大无P4 雨中大无P5 雨冷正常无P6 雨冷正常有N7 多云冷正常有P8 晴中大无N9 晴冷正常无P10 雨中正常无P11 晴中正常有P12 多云中大有P13 多云热正常无P14 雨中大有N2.上机目的(1)学习用Information Gain构造决策树的方法;(2)在给定的例子上,构造出正确的决策树;(3)理解并掌握构造决策树的技术要点。

二、实验原理及基本技术路线图(方框原理图或程序流程图)(1)设计并实现程序,构造出正确的决策树;(2)对所设计的算法采用大O符号进行时间复杂性和空间复杂性分析;主函数流程图:Attributevalue.cpp流程图Basefun流程图:Datapiont.cpp流程图:Dataset主要流程图:三、所用仪器、材料(设备名称、型号、规格等或使用软件)1台PC及VISUAL C++6.0软件四、实验方法、步骤(或:程序代码或操作过程)工程源代码:Main.cpp:#include <fstream>#include <iostream>#include <list>#include <sstream>#include <string>#include <vector>#include "AttributeValue.h"#include "DataPoint.h"#include "DataSet.h"DataPoint processLine(std::string const& sLine){std::istringstream isLine(sLine, std::istringstream::in);std::vector<AttributeValue> attributes;// TODO: need to handle beginning and ending empty spaces.while( isLine.good() ){std::string rawfield;isLine >> rawfield;attributes.push_back( AttributeValue( rawfield ) );}AttributeValue v = attributes.back();attributes.pop_back();bool type = v.GetType();return DataPoint(attributes, type);}void main(){std::ifstream ifs("in.txt", std::ifstream::in);DataSet initDataset;while( ifs.good() ){// TODO: need to handle empty lines.std::string sLine;std::getline(ifs, sLine);initDataset.addDataPoint( processLine(sLine) );}std::list<DataSet> processQ;std::vector<DataSet> finishedDataSet;processQ.push_back(initDataset);while ( processQ.size() > 0 ){std::vector<DataSet> splittedDataSets;DataSet dataset = processQ.front();dataset.splitDataSet(splittedDataSets);processQ.pop_front();for (int i=0; i<splittedDataSets.size(); ++i){float prob = splittedDataSets[i].getPositiveProb();if (prob == 0.0 || prob == 1.0){finishedDataSet.push_back(splittedDataSets[i]);}else{processQ.push_back(splittedDataSets[i]);}}}std::cout << "The dicision tree is:" << std::endl;for (int i = 0; i < finishedDataSet.size(); ++i){finishedDataSet[i].display();}}Attributevalue.cpp:#include "AttributeValue.h"#include "base.h"AttributeValue::AttributeValue(std::string const& instring): m_value(instring){}bool AttributeValue::GetType(){if (m_value == "P"){return true;}else if (m_value == "N"){return false;}else{throw DataErrException();}}Basefun.cpp:#include <math.h>float log2 (float x){return 1.0 / log10(2) * log10(x);}float calEntropy(float prob){float sum=0;if (prob == 0 || prob == 1){return 0;}sum -= prob * log2(prob);sum -= (1 - prob) * log2 ( 1 - prob );return sum;}Datapiont.cpp:#include <iostream>#include "DataPoint.h"DataPoint::DataPoint(std::vector<AttributeValue> const& attributes, bool type) : m_type(type){for (int i=0; i<attributes.size(); ++i){m_attributes.push_back( attributes[i] );}}void DataPoint::display(){for (int i=0; i<m_attributes.size(); ++i){std::cout << "\t" << m_attributes[i].getValue();}if (true == m_type){std::cout << "\tP";}else{std::cout << "\tN";}std::cout << std::endl;}Dataset.cpp:#include <iostream>#include <map>#include "base.h"#include "DataSet.h"void SplitAttributeValue::display(){std::cout << "\tSplit attribute ID(" << m_attributeIndex << ")\t";std::cout << "Split attribute value(" << m_v.getValue() << ")" << std::endl; }void DataSet::addDataPoint(DataPoint const& datapoint){m_data.push_back(datapoint);}float DataSet::getPositiveProb(){float nPositive = 0;for(int i=0; i<m_data.size(); ++i){if ( m_data[i].isPositive() ){nPositive++;}}return nPositive / m_data.size();}struct Stat{int nPos;int nNeg;int id;};void DataSet::splitDataSet(std::vector<DataSet>& splittedSets){// find all available splitting attributesint nAttributes = m_data[0].getNAttributes();int i, j;std::vector<bool> splittingAttributeBV;splittingAttributeBV.resize(nAttributes);for (i=0; i<nAttributes; ++i){splittingAttributeBV[i] = true;}for (i=0; i<m_splitAttributes.size(); ++i){splittingAttributeBV[ m_splitAttributes[i].getAttributeIndex() ] = false;}std::vector<int> splittingAttributeIds;for (i=0; i<nAttributes; ++i){if (true == splittingAttributeBV[i]){splittingAttributeIds.push_back(i);}}typedef std::map<AttributeValue, Stat, AttributeValueCmp> AttributeValueStat;typedef std::map<AttributeValue, Stat, AttributeValueCmp>::iterator AttributeValueStat_iterator;typedef std::map<AttributeValue, Stat, AttributeValueCmp>::const_iterator AttributeValueStat_const_iterator;// go through data once, and collect needed statistics to calculate entropystd::vector< AttributeValueStat > splittingStats;splittingStats.resize( splittingAttributeIds.size() );for (i=0; i<m_data.size(); ++i){for (j=0; j<splittingAttributeIds.size(); ++j){AttributeValue const& v = m_data[i].getAttribute(splittingAttributeIds[j]);AttributeValueStat_iterator it = splittingStats[j].find(v);if ( splittingStats[j].end() == it ){Stat stat;if ( m_data[i].isPositive() ){stat.nPos = 1;stat.nNeg = 0;stat.id = 0;}else{stat.nPos = 0;stat.nNeg = 1;stat.id = 0;}splittingStats[j].insert(std::pair<AttributeValue, Stat>(v, stat));}else{if ( m_data[i].isPositive() ){it->second.nPos++;}else{it->second.nNeg++;}}}}// display collected statisticsfor (j=0; j<splittingAttributeIds.size(); ++j){std::cout << "Attribute(" << splittingAttributeIds[j] << "):" << std::endl;std::cout << "\tValue \t nPos \t nNeg" << std::endl;for (AttributeValueStat_const_iterator it = splittingStats[j].begin();it != splittingStats[j].end(); ++it)std::cout << "\t" << it->first.getValue() << " \t " << it->second.nPos << " \t " << it->second.nNeg << std::endl;}}// find splitting attributefloat minEntropy = 0.0;int splitAttributeId = -1;for (j=0; j<splittingStats.size(); ++j){int n = m_data.size();float entropy = 0.0;for (AttributeValueStat_iterator it = splittingStats[j].begin();it != splittingStats[j].end(); ++it){int nSamples = it->second.nPos + it->second.nNeg;float p = it->second.nPos;p /= nSamples;entropy += calEntropy(p) * nSamples / n;}if (entropy < minEntropy || -1 == splitAttributeId){minEntropy = entropy;splitAttributeId = j;}}std::cout << "Split at attribute(" << splittingAttributeIds[splitAttributeId] << ")" << std::endl << std::endl;// splitint attrId = splittingAttributeIds[splitAttributeId];AttributeValueStat const& attVStat = splittingStats[splitAttributeId];splittedSets.clear();int k = 0;for (AttributeValueStat_iterator it = splittingStats[splitAttributeId].begin();it != splittingStats[splitAttributeId].end(); ++it){it->second.id = k++;}splittedSets.resize( k);for (i=0; i<k; ++i){for (j=0; j<m_splitAttributes.size(); ++j)splittedSets[i].m_splitAttributes.push_back( m_splitAttributes[j] );}}for (AttributeValueStat_iterator itt = splittingStats[splitAttributeId].begin();itt != splittingStats[splitAttributeId].end(); ++itt) {splittedSets[itt->second.id].m_splitAttributes.push_back(SplitAttributeValue(itt ->first, attrId));}for (i=0; i<m_data.size(); ++i){AttributeValue const& v = m_data[i].getAttribute(attrId);AttributeValueStat_const_iterator it = attVStat.find(v);if ( attVStat.end() != it ){splittedSets[it->second.id].addDataPoint(m_data[i]);}else{throw DataErrException();}}}void DataSet::display(){int i;std::cout << "Dataset(" << this << ")" << std::endl;for (i=0; i<m_splitAttributes.size(); ++i){m_splitAttributes[i].display();}std::cout << "Data:" << std::endl;for (i=0; i<m_data.size(); ++i){m_data[i].display();}std::cout << std::endl;}五、实验过程原始记录( 测试数据、图表、计算等)六、实验结果、分析和结论(误差分析与数据处理、成果总结等。

机器学习决策树_ID3算法的源代码

机器学习决策树ID3算法的源代码(VC6.0)#include<iostream.h>#include<fst ream.h>#include<string.h>#include<stdlib.h>#include<math.h>#include<iomanip.h>#define N 500 //N定义为给定训练数据的估计个数#define M 6 //M定义为候选属性的个数#define c 2 //定义c=2个不同类#define s_max 5 //定义s_max为每个候选属性所划分的含有最大的子集数int av[M]={3,3,2,3,4,2};int s[N][M+2],a[N][M+2]; //数组s[j]用来记录第i个训练样本的第j个属性值int path_a[N][M+1],path_b[N][M+1]; //用path_a[N][M+1],path_b[N][M+1]记录每一片叶子的路径int count_list=M; //count_list用于记录候选属性个数int count=-1; //用count+1记录训练样本数int attribute_t est_list1[M];int leaves=1;//用数组ss[k][j]表示第k个候选属性划分的子集S j中类Ci的样本数,数组的具体大小可根据给定训练数据调整int ss[M][c][s_max];//第k个候选属性划分的子集Sj中样本属于类Ci的概率double p[M][c][s_max];//count_s[j]用来记录第i个候选属性的第j个子集中样本个数int count_s[M][s_max];//分别定义E[M],Gain[M]表示熵和熵的期望压缩double E[M];double Gain[M];//变量max_Gain用来存储最大的信息增益double max_Gain;int Trip=-1; //用Trip记录每一个叶子递归次数int most;void main(void){int i,j=-1,k,t emp,l,count_t est,t rue_class=0,count_train;char trainname[256],t estname[256];int t est[N][8];cout<<"请输入训练集文件名:";cin>>trainname;ifstream trainfile;trainfile.open(trainname,ios::in|ios::nocreat e);if(!trainfile){cout<<"无法使用训练集,请重试!"<<'\n';exit(1);}//读取训练集while(t rainfile>>temp){j=j+1;k=j%(M+2);if(k==0||j==0) count+=1;//count为训练集的第几个,k代表室第几个属性switch(k){case 0:s[count][0]=temp;break;case 1:s[count][1]=temp;break;case 2:s[count][2]=temp;break;case 3:s[count][3]=temp;break;case 4:s[count][4]=temp;break;case 5:s[count][5]=temp;break;case 6:s[count][6]=temp;break;case 7:s[count][7]=temp;break;}}trainfile.close();//输出训练集for(i=0;i<=count;i++){if(i%2==0) cout<<'\n';for(j=0;j<M+2;j++)cout<<setw(4)<<s[j];}//most记录训练集中哪类样本数比较多,以用于确定递归终止时不确定的类别for(i=0,j=0,k=0;i<=count;i++){if(s[0]==0) j+=1;else k+=1;}if(j>k) most=0;else most=1;//count_train记录训练集的样本数count_t rain=count+1;//训练的属性for(i=0;i<M;i++)attribut e_test_list1=i+1;//首次调用递归函数,即是生成根结点的分支Generat e_decision_tree(s,count+1,attribut e_test_list1,count_list,0,0);cout<<'\n'<<"叶子结点的个数为:"<<leaves<<'\n'; cout<<"请输入测试集文件名:";cin>>t estname;ifstream testfile;testfile.open(testname,ios::in|ios::nocreat e);if(!t estfile){cout<<"无法使用训练集,请重试!"<<'\n';exit(1);}count_t est=0;j=-1;//读取测试集数据while(t estfile>>temp){j=j+1;k=j%(M+2);if(k==0) count_test+=1;switch(k){case 0:test[count_test][7]=temp;break;case 1:test[count_test][1]=temp;break;case 2:test[count_test][2]=temp;break;case 3:test[count_test][3]=temp;break;case 4:test[count_test][4]=temp;break;case 5:test[count_test][5]=temp;break;case 6:test[count_test][6]=temp;break;}}testfile.close();for(i=1;i<=count_test;i++)test[0]=0; //以确保评估分类准确率cout<<"count_test="<<count_test<<'\n';cout<<"count_train="<<count_t rain<<'\n';//用测试集来评估分类准确率for(i=1;i<=count_test;i++){l=0;for(j=1;j<=leaves;j++)if(t est[path_b[j][1]]==path_a[j][1]&&test[path_b[j][2]]==path_a[j][2]&&t est[path_b[j][3] ]==path_a[j][3]&&t est[path_b[j][4]]==path_a[j][4]&&test[path_b[j][5]]==path_a[j][5]&&t est[path _b[j][6]]==path_a[j][6]){l=1;if(test[7]==path_a[j][0]) true_class+=1;break;}if(t est[7]==most && l==0) true_class+=1;}cout<<"测试集与训练集的比例为:"<<float(count_train)/count_test<<'\n';cout<<"分类准确率为:"<<float(true_class)/count_test<<'\n';}void Gener ate_decis ion_tree(int b[][M+2],int bn,int attribute_te s t_lis t[],int s n,int ai,int aj){//定义数组a记录目前待分的训练样本集,定义数组b记录目前要分结点中所含的训练样本集//s am e_clas s用来记数,判别s amples是否都属于同一个类Trip+=1;//用Trip记录每一个叶子递归次数path_a[leav es][Trip]=ai;//用p ath_a[N][M+1],path_b[N][M+1]记录每一片叶子的路径path_b[leaves][Trip]=aj;int s ame_class,i,j,k,l,ll,lll;if(bn==0){//待分结点的样本集为空时,加上一个树叶,标记为训练集中最普通的类//记录路径与前一路径相同的部分for(i=1;i<Trip;i++)if(path_a[leaves][i]==0){p ath_a[leaves][i]=path_a[l eaves-1][i];p ath_b[leaves][i]=path_b[leaves-1][i];}c out<<'\n'<<"I F ";for(i=1;i<=Trip;i++)if(i==1) c out<<"a["<<p ath_b[leaves][i]<<"]="<<p ath_a[leaves][i];els e cout<<"^a["<<path_b[leaves][i]<<"]="<<path_a[leaves][i];c out<<" THEN class="<<mos t;path_a[leaves][0]=m os t;//修改树的深度if(path_a[leaves][Trip]==av[p ath_b[leaves][Trip]-1])for(i=Trip;i>1;i--)if(path_a[leaves][i]==av[path_b[leaves][i]-1]) Trip-=1;els ebreak;Trip-=1;leaves+=1;}els e{s ame_clas s=1;for(i=0;i<bn-1;i++)if(b[i][0]==b[i+1][0])s ame_clas s+=1;if(s ame_class==bn){//待分样本集属于同一类时以该类标记//记录路径与前一路径相同的部分for(i=1;i<Trip;i++)if(path_a[leaves][i]==0){p ath_a[leaves][i]=path_a[l eaves-1][i];p ath_b[leaves][i]=path_b[leaves-1][i];}c out<<'\n'<<"I F ";for(i=1;i<=Trip;i++)if(i==1)cout<<"a["<<path_b[leaves][i]<<"]="<<path_a[leav es][i];els ecout<<"^a["<<path_b[leaves][i]<<"]="<<path_a[l eaves][i];c out<<" THEN class="<<b[0][0];path_a[leaves][0]=b[0][0];//修改树的深度if(path_a[leaves][Trip]==av[p ath_b[leaves][Trip]-1])for(i=Trip;i>1;i--)if(path_a[leaves][i]==av[path_b[leaves][i]-1])Trip-=1;els ebreak;Trip-=1;leaves+=1;//未分类的样本集减少for(i=0,l=-1;i<=c ount;i++){for(j=0,lll=0;j<bn;j++)if(s[i][M+1]==b[j][M+1])lll++;if(lll==0){l+=1;for(ll=0;ll<M+2;ll++)a[l][ll]=s[i][ll];}}for(i=0,k=-1;i<l;i++){k++;for(ll=0;ll<M+2;ll++)s[k][ll]=a[i][ll];}c ount=count-bn;}els e{if(s n==0){//候选属性集为空时,标记为训练集中最普通的类//记录路径与前一路径相同的部分for(i=1;i<Trip;i++)if(path_a[leaves][i]==0){p ath_a[leaves][i]=path_a[l eaves-1][i];p ath_b[leaves][i]=path_b[leaves-1][i];}c out<<'\n'<<"I F ";for(i=1;i<=Trip;i++)if(i==1) c out<<"a["<<p ath_b[leaves][i]<<"]="<<p ath_a[leaves][i];els e cout<<"^a["<<path_b[leaves][i]<<"]="<<path_a[leaves][i];//判断类别for(i=0,ll=0,lll=0;i<bn;i++){if(b[i][0]==0) ll+=1;els e lll+=1;}if(ll>lll) {cout<<" THEN clas s=0";path_a[leav es][0]=0;}els e{cout<<" THEN clas s=1";path_a[leav es][0]=1;}//修改树的深度if(path_a[leaves][Trip]==av[p ath_b[leaves][Trip]-1])for(i=Trip;i>1;i--)if(path_a[leaves][i]==av[path_b[leaves][i]-1]) Trip-=1;els ebreak;Trip-=1;leaves+=1;//未分类的样本集减少for(i=0,l=-1;i<=c ount;i++){for(j=0,lll=0;j<bn;j++)if(s[i][M+1]==b[j][M+1]) lll++;if(lll==0){l+=1;for(ll=0;ll<M+2;ll++)a[l][ll]=s[i][ll];}}for(i=0,k=-1;i<l;i++){k++;for(ll=0;ll<M+2;ll++)s[k][ll]=a[i][ll];}c ount=count-bn;}els e//待分结点的样本集不为空时{//定义c ount_Pos itive记录属于正例的样本数int count_Pos itive=0;//p1,p2分别定义为正负例的比例double p1,p2;double Entropy_Es; //Entropy_Es表示熵for(i=0;i<=c ount;i++)if(s[i][0]==1)c ount_Pos itive+=1;p1=d ouble(count_Pos itive)/(count+1);p2=1-p1;Entropy_Es=-p1*log10(p1)/log10(2)-p2*log10(p2)/log10(2);cout<<p1<<'\t'<<p2<<'\t'<<Entropy_Es<<'\n';//初始化for(i=0;i<s n;i++)//当前的属性包含的个数for(j=0;j<c;j++)//类别for(k=0;k<av[i];k++)//以当前属性分成的小类(每个属性包含的种类数)s s[attribute_te s t_lis t[i]-1][j][k]=0;//用数组s s[k][i][j]表示第k个候选属性划分的子集Sj中类Ci的样本数,数组的具体大小可根据给定训练数据调整 for(i=0;i<s n;i++)for(j=0;j<av[i];j++)c ount_s[attribute_test_lis t[i]-1][j]=0;//初始化某个属性的某个具体值的全部个数for(i=0;i<count+1;i++)for(j=1;j<=s n;j++)if(s[i][0]==0){//找出每个属性具体某个值属于反例的个数s s[attribute_test_lis t[j-1]-1][0][s[i][j]-1]+=1;c ount_s[attribute_test_list[j-1]-1][s[i][j]-1]+=1;}els e{s s[attribute_te s t_lis t[j-1]-1][1][s[i][j]-1]+=1;count_s[attribute_te s t_lis t[j-1]-1][s[i][j]-1]+=1;}//计算分别以各个候选属性划分样本后,各个子集Sj中的样本属于类Ci的概率for(i=0;i<s n;i++)for(j=0;j<c;j++)for(k=0;k<av[i];k++)if(count_s[attribute_test_lis t[i]-1][k]!=0)p[attribute_test_lis t[i]-1][j][k]=double(s s[attribute_test_lis t[i]-1][j][k])/count_s[attribute_te s t_list[i]-1][k];for(i=0;i<s n;i++)E[attribute_test_lis t[i]-1]=0.0;//计算熵for(i=0;i<s n;i++)for(j=0;j<av[attribute_tes t_list[i]-1];j++){//if语句处理0*l og10(0)=0if(p[attribute_test_lis t[i]-1][0][j]==0||p[attribute_tes t_list[i]-1][1][j]==0) {p[attribute_tes t_list[i]-1][0][j]=1;p[attribute_tes t_list[i]-1][1][j]=1;}E[attribute_test_lis t[i]-1]+=(s s[attribute_test_lis t[i]-1][0][j]+ss[attribute_test_lis t[i]-1][1][j])*(-(p[ attribute_test_lis t[i]-1][0][j]*log10(p[attribute_tes t_list[i]-1][0][j])/log10(2)+p[attribute_tes t_list[i]-1][1][j]*log10 (p[attribute_tes t_list[i]-1][1][j])/log10(2)))/(c ount+1);}//计算熵的信息增益for(i=0;i<s n;i++)Gain[attribute_tes t_list[i]-1]=Entropy_Es-E[attribute_te s t_lis t[i]-1];//找出信息增益的最大值,用j记录哪个候选属性的信息增益最大m ax_Gain=Gain[0];j=attribute_tes t_lis t[0]-1;for(i=0;i<s n;i++)//找出最大的信息增益if(max_Gain<Gain[attribute_tes t_list[i]-1]) {m ax_Gain=Gain[attribute_tes t_lis t[i]-1];j=attribute_te s t_lis t[i]-1;}//利用得到的具有最大信息增益的属性来划分待分的样本集b[bn][8]int temp[s_max];int b1[N][M+2];int temp1=-1;int temp_b[s_max][N][M+2];for(i=1;i<=av[j];i++){temp[i]=-1;for(k=0;k<bn;k++)//样本的个数if(b[k][j+1]==i){temp[i]+=1;for(l=0;l<M+2;l++)temp_b[i][t emp[i]][l]=b[k][l];}}//对于每一个分支使用递归函数重复生成树for(i=1;i<=av[j];i++){for(k=0;k<=temp[i];k++)for(l=0;l<M+2;l++)b1[k][l]=t emp_b[i][k][l];if(i==1){for(ll=0,l=0;ll<s n;ll++)if(attribute_tes t_list[ll]-1!=j) attribute_te s t_lis t[l++]=attribute_tes t_lis t[ll]; Gener ate_d ecision_tree(b1,k,attribute_te s t_lis t,l,i,j+1);s n-=1;}els e{Gener ate_decis ion_tree(b1,k,attribute_tes t_lis t,s n,i,j+1);if(i==av[j]) attribute_test_list[s n]=j+1;}}}}}}。

人工智能实验报告天气决策树解读

人工智能实验报告天气决策树解读

天气决策树是人工智能领域中一种常见的分类与决策技术,它利用决策树(decision tree)的思想结构,将气象数据的空间空间构建为一个分层结构,按照一定的标准来衡量这些数据,最终将气象状况确定为特定的天气状况。

它是一种基于规则的机器学习方法,用于从海量历史气象数据中学习到特定地区的天气预报规律,以便预测该地区的未来天气情况。

天气决策树的基本原理是构建一棵树,按照特定的决策规则来对气象数据进行分类,以最终把气象状况确定为特定的天气状况。

其具体过程如下:

1.数据采集:根据给定的特定地区,搜集这个地区过去一段时间内的气象数据,包括温度、湿度、风速、降水量等多个要素。

2.建立决策树:以一定的规则来建立决策树,将特定地区的所有气象数据按照一定的分类标准构建分层结构。

每一层决策节点都以特定的条件分割数据,最终将气象状况确定为特定天气状况。

3.学习与评估:建立完决策树后,按照一定的标准对决策树估分类的准确率进行评估,例如按照日平均温、降水量、湿度、气温最高和最低等特征,以及每个节点预测气象状况的准确度等,来评估决策树的准确性。

决策树算法代码

决策树算法代码

简单来说,决策树算法是一种基于特征的方法,能够从训练数据中按照某种规则构建出决策树,用于预测未知数据。

它是非参数研究算法,不需要设定任何参数,只需要使用训练数据和特征,就可以构建出一个决策树。

决策树算法的基本思想是将数据集分解为更小的子集,每个子集都可以用一个决策来表示。

决策树算法通过不断地将数据集分解,最终形成一个“决策树”,用于预测未知数据。

决策树算法的基本步骤如下:

1. 从训练集中选择一个最优特征;

2. 根据最优特征的不同值,将训练集分成多个子集;

3. 对每一个子集,如果子集中的所有实例属于同一类,则该子集为“叶子结点”;否则,选择一个新的最优特征,重复1-2步;

4. 重复1-3步,直到所有子集都属于同一类,形成一棵决策树;

5. 利用决策树预测未知数据。

决策树算法具有许多优点,如容易理解、可视化和实现简单等。

决策树算法也有一些缺点,如容易过拟合、对异常数据敏感等。

总之,决策树算法是一种非常有用的机器研究算法,它可以用来解决分类和回归问题,它的优点和缺点都要注意,在使用时要谨慎,以达到最佳的效果。

决策树的python实现方法

决策树的python实现方法

决策树说白了就好像是if-else结构一样,它的结果就是你要生成这个一个可以从根开始不断判断选择到叶子节点的树,但是这里的if-else必然不会是让我们认为去设置的,我们要做的是提供一种方法,计算机可以根据这种方法得到我们所需要的决策树。

这个方法的重点就在于如何从这么多的特征中选择出有价值的,并且按照最好的顺序由根到叶选择。

完成了这个我们也就可以递归构造一个决策树了

划分数据集的最大原则是将无序的数据变得更加有序。

既然这又牵涉到信息的有序无序问题,自然要想到信息熵了。

这里我们计算用的也是信息熵。

数据需要满足的要求:

①数据必须是由列表元素组成的列表,而且所有的列白哦元素都要具有相同的数据长度

②数据的最后一列或者每个实例的最后一个元素应是当前实例的类别标签。

id3决策树算法代码

id3决策树算法代码ID3决策树算法是一种常用的机器学习算法,它可以根据给定的训练数据集构建决策树模型,用于分类和预测任务。

下面我们将详细介绍ID3决策树算法的实现过程。

决策树是一种树结构模型,它由节点和有向边组成。

在决策树中,每个内部节点表示一个特征或属性,每条边表示一个特征取值,叶节点表示一个类别。

决策树的构建过程是一个递归的过程,通过选择最优的特征来划分数据集,使得每个子节点上的样本尽可能属于同一类别。

在ID3算法中,选择最优的特征是通过计算信息增益来实现的。

信息增益表示在特征F的条件下,样本集D的不确定性减少的程度。

具体计算公式如下:信息增益(Gain) = Entropy(D) - ∑(|Dv|/|D|) * Entropy(Dv)其中,Entropy(D)表示样本集D的信息熵,Entropy(Dv)表示在特征F的取值为v时,样本集Dv的信息熵,|Dv|表示样本集Dv的样本个数,|D|表示样本集D的样本个数。

信息熵表示样本集的不确定性,熵越大表示样本集的不确定性越高。

ID3算法的实现步骤如下:1. 若样本集D中的所有样本属于同一类别C,则将该节点标记为C,并返回。

2. 若特征集A为空集,或者样本集D中的所有样本在特征集A上取值相同,则将该节点标记为D中样本数最多的类别,并返回。

3. 计算特征集A中每个特征的信息增益,选择信息增益最大的特征F。

4. 将节点标记为特征F,并根据特征F的取值将样本集D划分为多个子集Dv。

5. 对于每个子集Dv,递归调用ID3算法,构建子节点。

6. 返回决策树模型。

ID3算法的实现过程比较简单,但也存在一些问题。

首先,ID3算法倾向于选择具有较多取值的特征,导致决策树过于复杂。

其次,ID3算法不能处理连续型特征,需要将其离散化。

此外,ID3算法容易产生过拟合问题,可以通过剪枝来解决。

为了避免决策树过于复杂,可以使用剪枝技术对决策树进行优化。

剪枝分为预剪枝和后剪枝两种方式。

决策树算法编程

决策树算法编程决策树算法是一种常用的机器学习算法,它通过构建一棵树来解决分类和回归问题。

决策树算法具有易于理解、可解释性强的特点,因此在实际应用中被广泛使用。

本文将介绍决策树算法的基本原理,并以编程的方式实现一个简单的决策树模型。

一、决策树算法的原理决策树算法的基本思想是通过对数据集进行递归划分,构建一棵树来表示数据的分类或回归关系。

决策树的每个内部节点表示一个属性,每个叶节点表示一个类别或一个回归值。

决策树的构建过程可以分为三个步骤:特征选择、划分准则和停止条件。

特征选择是指从当前节点的属性集合中选择一个最优的属性作为划分属性。

常用的特征选择准则有信息增益、信息增益比、基尼系数等。

信息增益是指在划分属性前后,数据集的信息熵的差值。

信息增益比是信息增益除以划分属性的固有信息。

基尼系数是指数据集中一个随机选中的样本被错误分类的概率。

划分准则是指根据特征选择得到的划分属性将数据集划分成若干个子集。

划分准则的选择与特征选择密切相关,常用的划分准则有ID3、C4.5、CART等。

ID3算法使用信息增益作为划分准则,C4.5算法使用信息增益比作为划分准则,CART算法使用基尼系数作为划分准则。

停止条件是指决策树的构建过程何时停止。

常用的停止条件有:节点中的样本个数小于某个阈值、节点中的样本属于同一类别、节点中的样本属性值相同等。

二、决策树算法的编程实现下面以Python编程语言为例,介绍决策树算法的编程实现。

首先,我们需要定义一个节点类,用来表示决策树的节点。

```pythonclass Node:def __init__(self, attr=None, value=None, label=None, children=None):self.attr = attr # 节点划分属性self.value = value # 节点划分属性的取值bel = label # 叶节点的类别或回归值self.children = children # 子节点```然后,我们可以定义一个决策树类,用来表示整棵决策树。

gee用决策树分类代码

gee用决策树分类代码决策树是一种常用的机器学习算法,用于分类和回归问题。

它通过构建一棵树状结构,根据特征进行分割,最终将数据划分为不同的类别。

在本文中,我们将以Gee为例,介绍如何使用决策树算法进行分类。

我们需要了解决策树的基本原理。

决策树是由节点和边组成的树状结构,每个节点代表一个特征或属性,边代表特征的取值。

根节点表示整个数据集,通过判断特征的取值将数据集划分为不同的子集。

每个子集又可以看作一个新的数据集,然后继续划分,直到达到停止条件,例如达到叶子节点或者数据集的纯度满足一定的条件。

在使用决策树算法进行分类之前,我们需要准备一个训练集。

训练集包含多个样本,每个样本都有多个特征和一个标签。

特征是用来描述样本的属性,标签是我们想要预测的结果。

接下来,我们需要选择一个合适的指标来评估每个特征的重要性。

常用的指标有信息增益、基尼系数等。

这些指标用于衡量特征对分类结果的贡献程度,我们选择贡献程度最大的特征作为当前节点的划分特征。

在选择了划分特征之后,我们将数据集划分为多个子集,每个子集都包含了一个特定取值的样本。

然后,我们对每个子集递归地进行上述步骤,直到满足停止条件。

接下来,我们可以使用训练好的决策树对新样本进行分类。

从根节点开始,根据特征的取值选择相应的子节点,直到达到叶子节点。

叶子节点的类别即为预测结果。

决策树算法具有直观、易解释等优点,但也存在一些缺点。

例如,容易过拟合、对噪声敏感等。

为了减小过拟合的风险,我们可以采用剪枝等方法。

决策树是一种常用的分类算法,通过构建树状结构,根据特征进行划分,最终将数据划分为不同的类别。

通过选择合适的指标和停止条件,我们可以构建出一个准确、可解释的分类模型。

希望本文对你理解决策树算法有所帮助。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

昆明理工大学信息工程与自动化学院学生实验报告(2011 —2012 学年第 1 学期)课程名称:人工智能开课实验室:信自楼计算机机房4442011 年12月16 日专业班级0 学号200 姓名成绩实验名称天气决策树指导教师教师评语该同学是否了解实验原理: A.了解□ B.基本了解□ C.不了解□该同学的实验能力: A.强□ B.中等□ C.差□该同学的实验是否达到要求: A.达到□ B.基本达到□ C.未达到□实验报告是否规范: A.规范□ B.基本规范□ C.不规范□实验过程是否详细记录: A.详细□ B.一般□ C.没有□教师签名:2011 年12 月日一、上机目的及内容1.上机内容根据下列给定的14个数据,运用Information Gain构造一个天气决策树。

例子编号属性分类天况温度湿度风况1 晴热大无N2 晴热大有N3 多云热大无P4 雨中大无P5 雨冷正常无P6 雨冷正常有N7 多云冷正常有P8 晴中大无N9 晴冷正常无P10 雨中正常无P11 晴中正常有P12 多云中大有P13 多云热正常无P14 雨中大有N2.上机目的(1)学习用Information Gain构造决策树的方法;(2)在给定的例子上,构造出正确的决策树;(3)理解并掌握构造决策树的技术要点。

二、实验原理及基本技术路线图(方框原理图或程序流程图)(1)设计并实现程序,构造出正确的决策树;(2)对所设计的算法采用大O符号进行时间复杂性和空间复杂性分析;主函数流程图:Attributevalue.cpp流程图Basefun流程图:Datapiont.cpp流程图:Dataset主要流程图:三、所用仪器、材料(设备名称、型号、规格等或使用软件)1台PC及VISUAL C++6.0软件四、实验方法、步骤(或:程序代码或操作过程)工程源代码:Main.cpp:#include <fstream>#include <iostream>#include <list>#include <sstream>#include <string>#include <vector>#include "AttributeValue.h"#include "DataPoint.h"#include "DataSet.h"DataPoint processLine(std::string const& sLine){std::istringstream isLine(sLine, std::istringstream::in);std::vector<AttributeValue> attributes;// TODO: need to handle beginning and ending empty spaces.while( isLine.good() ){std::string rawfield;isLine >> rawfield;attributes.push_back( AttributeValue( rawfield ) );}AttributeValue v = attributes.back();attributes.pop_back();bool type = v.GetType();return DataPoint(attributes, type);}void main(){std::ifstream ifs("in.txt", std::ifstream::in);DataSet initDataset;while( ifs.good() ){// TODO: need to handle empty lines.std::string sLine;std::getline(ifs, sLine);initDataset.addDataPoint( processLine(sLine) );}std::list<DataSet> processQ;std::vector<DataSet> finishedDataSet;processQ.push_back(initDataset);while ( processQ.size() > 0 ){std::vector<DataSet> splittedDataSets;DataSet dataset = processQ.front();dataset.splitDataSet(splittedDataSets);processQ.pop_front();for (int i=0; i<splittedDataSets.size(); ++i){float prob = splittedDataSets[i].getPositiveProb();if (prob == 0.0 || prob == 1.0){finishedDataSet.push_back(splittedDataSets[i]);}else{processQ.push_back(splittedDataSets[i]);}}std::cout << "The dicision tree is:" << std::endl;for (int i = 0; i < finishedDataSet.size(); ++i){finishedDataSet[i].display();}}Attributevalue.cpp:#include "AttributeValue.h"#include "base.h"AttributeValue::AttributeValue(std::string const& instring) : m_value(instring){}bool AttributeValue::GetType(){if (m_value == "P"){return true;else if (m_value == "N"){return false;}else{throw DataErrException();}}Basefun.cpp:#include <math.h>float log2 (float x){return 1.0 / log10(2) * log10(x); }float calEntropy(float prob){float sum=0;if (prob == 0 || prob == 1)return 0;}sum -= prob * log2(prob);sum -= (1 - prob) * log2 ( 1 - prob );return sum;}Datapiont.cpp:#include <iostream>#include "DataPoint.h"DataPoint::DataPoint(std::vector<AttributeValue> const& attributes, bool type) : m_type(type){for (int i=0; i<attributes.size(); ++i){m_attributes.push_back( attributes[i] );}}void DataPoint::display(){for (int i=0; i<m_attributes.size(); ++i){std::cout << "\t" << m_attributes[i].getValue();}if (true == m_type){std::cout << "\tP";}else{std::cout << "\tN";}std::cout << std::endl;}Dataset.cpp:#include <iostream>#include <map>#include "base.h"#include "DataSet.h"void SplitAttributeValue::display(){std::cout << "\tSplit attribute ID(" << m_attributeIndex << ")\t";std::cout << "Split attribute value(" << m_v.getValue() << ")" << std::endl; }void DataSet::addDataPoint(DataPoint const& datapoint){m_data.push_back(datapoint);}float DataSet::getPositiveProb(){float nPositive = 0;for(int i=0; i<m_data.size(); ++i){if ( m_data[i].isPositive() ){nPositive++;}}return nPositive / m_data.size();}struct Stat{int nPos;int nNeg;int id;};void DataSet::splitDataSet(std::vector<DataSet>& splittedSets) {// find all available splitting attributesint nAttributes = m_data[0].getNAttributes();int i, j;std::vector<bool> splittingAttributeBV;splittingAttributeBV.resize(nAttributes);for (i=0; i<nAttributes; ++i){splittingAttributeBV[i] = true;}for (i=0; i<m_splitAttributes.size(); ++i){splittingAttributeBV[ m_splitAttributes[i].getAttributeIndex() ] = false;}std::vector<int> splittingAttributeIds;for (i=0; i<nAttributes; ++i){if (true == splittingAttributeBV[i]){splittingAttributeIds.push_back(i);}}typedef std::map<AttributeValue, Stat, AttributeValueCmp> AttributeValueStat;typedef std::map<AttributeValue, Stat, AttributeValueCmp>::iterator AttributeValueStat_iterator;typedef std::map<AttributeValue, Stat, AttributeValueCmp>::const_iterator AttributeValueStat_const_iterator;// go through data once, and collect needed statistics to calculate entropy std::vector< AttributeValueStat > splittingStats;splittingStats.resize( splittingAttributeIds.size() );for (i=0; i<m_data.size(); ++i){for (j=0; j<splittingAttributeIds.size(); ++j){AttributeValue const& v = m_data[i].getAttribute(splittingAttributeIds[j]);AttributeValueStat_iterator it = splittingStats[j].find(v);if ( splittingStats[j].end() == it ){Stat stat;if ( m_data[i].isPositive() ){stat.nPos = 1;stat.nNeg = 0;stat.id = 0;}else{stat.nPos = 0;stat.nNeg = 1;stat.id = 0;}splittingStats[j].insert(std::pair<AttributeValue, Stat>(v, stat));}else{if ( m_data[i].isPositive() ){it->second.nPos++;}else{it->second.nNeg++;}}}}// display collected statisticsfor (j=0; j<splittingAttributeIds.size(); ++j){std::cout << "Attribute(" << splittingAttributeIds[j] << "):" << std::endl;std::cout << "\tValue \t nPos \t nNeg" << std::endl;for (AttributeValueStat_const_iterator it = splittingStats[j].begin();it != splittingStats[j].end(); ++it){std::cout << "\t" << it->first.getValue() << " \t " << it->second.nPos << " \t " << it->second.nNeg << std::endl;}}// find splitting attributefloat minEntropy = 0.0;int splitAttributeId = -1;for (j=0; j<splittingStats.size(); ++j){int n = m_data.size();float entropy = 0.0;for (AttributeValueStat_iterator it = splittingStats[j].begin();it != splittingStats[j].end(); ++it){int nSamples = it->second.nPos + it->second.nNeg;float p = it->second.nPos;p /= nSamples;entropy += calEntropy(p) * nSamples / n;}if (entropy < minEntropy || -1 == splitAttributeId){minEntropy = entropy;splitAttributeId = j;}}std::cout << "Split at attribute(" << splittingAttributeIds[splitAttributeId] << ")" << std::endl << std::endl;// splitint attrId = splittingAttributeIds[splitAttributeId];AttributeValueStat const& attVStat = splittingStats[splitAttributeId];splittedSets.clear();int k = 0;for (AttributeValueStat_iterator it = splittingStats[splitAttributeId].begin();it != splittingStats[splitAttributeId].end(); ++it){it->second.id = k++;}splittedSets.resize( k);for (i=0; i<k; ++i){for (j=0; j<m_splitAttributes.size(); ++j){splittedSets[i].m_splitAttributes.push_back( m_splitAttributes[j] );}}for (AttributeValueStat_iterator itt = splittingStats[splitAttributeId].begin();itt != splittingStats[splitAttributeId].end(); ++itt){splittedSets[itt->second.id].m_splitAttributes.push_back(SplitAttributeValue(itt->first, attrId));}for (i=0; i<m_data.size(); ++i){AttributeValue const& v = m_data[i].getAttribute(attrId);AttributeValueStat_const_iterator it = attVStat.find(v);if ( attVStat.end() != it ){splittedSets[it->second.id].addDataPoint(m_data[i]);}else{throw DataErrException();}}}void DataSet::display(){int i;std::cout << "Dataset(" << this << ")" << std::endl;for (i=0; i<m_splitAttributes.size(); ++i){m_splitAttributes[i].display();}std::cout << "Data:" << std::endl;for (i=0; i<m_data.size(); ++i){m_data[i].display();}std::cout << std::endl;}五、实验过程原始记录( 测试数据、图表、计算等)六、实验结果、分析和结论(误差分析与数据处理、成果总结等。