全国软考-一个决策树算法案例分析

决策树例题分析

• 建设小工厂投资280万元,如销路好,3年后扩建,扩建需要投资400万元, 可使用7年,每年赢利190万元。不扩建则每年赢利80万元。如销路不好则 每年赢利60万元。

• 试用决策树法选出合理的决策方案。 经过市场调查,市场销路好的概率为 0.7,销路不好的概率为0.3。

5

• 计算完毕后,开始对决策树进行剪枝,在每个决策结点删去除 了最高期望值以外的其他所有分枝,最后步步推进到第一个决 策结点,这时就找到了问题的最佳方案

• 方案的舍弃叫做修枝,被舍弃的方案用“≠”的记号来表示,最 后的决策点留下一条树枝,即为最优方案。

6

• A1、A2两方案投资分别为450万和240万,经营年限为5年,销 路好的概率为0.7,销路差的概率为0.3,A1方案销路好、差年 损益值分别为300万和负60万;A2方案分别为120万和30万。

1

例:设某茶厂计划创建精制茶厂,开始有两个方案,方案一是建年加工能力 为800担的小厂,方案二是建年加工能力为2000担的大厂。两个厂的使用期 均为10年,大厂投资25万元,小厂投资10万元。产品销路没有问题,原料来 源有两种可能(两种自然状态):一种为800担,另一种为2000担。两个方案每 年损益及两种自然状态的概率估计值见下表

自然状态

原料800担 原料2000担

概率 建大厂(投资25万元) 建小厂(投资10万元)

0.8

13.5

0.2

25.5

15.0 15.0

2

补充: 风险型决策方法——决策树方法

• 风险决策问题的直观表示方法的图示法。因为图的形状像树,所以被称为决 策树。

软考中项高项常见计算题详解

选择题:一、决策树分析EMV2011年下半年例题1:某公司希望举办一个展销会以扩大市场;选择北京、天津、上海、深圳作为候选会址..获利情况除了会址关系外;还与天气有关..天气可分为晴、多云、多雨三种..通过天气预报;估计三种天气情况可能发生的概率为0.25、0.50、0.25;其收益单位:人民币万元情况见下表..使用决策树进行决策的结果为61..61A.北京B.天津C.上海D.深圳答案:B解析:北京的期望货币值为 4.5×0.25+4.4×0.5+1×0.25=3.575 天津 5×0.25+4×0.5+1.6×0.25=3.65上海 6×0.25+3×0.5+1.3×0.25=3.325深圳 5.5×0.25+3.9×0.5+0.9×0.25=3.55 例题2 2008上某电子商务公司要从A地向B地的用户发送一批价值90000元的货物..从A地到B地有水、陆两条路线..走陆路时比较安全;其运输成本为10000元;走水路时一般情况下的运输成本只要7000元;不过一旦遇到暴风雨天气;则会造成相当于这批货物总价值的10%的损失..根据历年情况;这期间出现暴风雨天气的概率为1/4;那么该电子商务公司_70..A.应选择走水路B.应选择走陆路C.难以选择路线D.可以随机选择路线答案: A..陆路10000水路7000×3/4+7000+90000×10%×1/4=9250例题3二、盈亏平衡点盈亏平衡点Break Even Point;简称BEP又称零利润点、保本点、盈亏临界点、损益分歧点、收益转折点..通常是指全部销售收入等于全部成本时销售收入线与总成本线的交点的产量..以盈亏平衡点的界限;当销售收入高于盈亏平衡点时企业盈利;反之;企业就亏损..盈亏平衡点可以用销售量来表示;即亏平衡点的销售量;也可以用销售额来表示;即盈亏平衡点的销售额..按实物单位计算:盈亏平衡点=固定成本/单位产品销售收入-单位产品变动成本按金额计算:盈亏平衡点=固定成本/1-变动成本/销售收入=固定成本/贡献毛率例题1:例题2:2011年上半年三、三点估算法计算PERT估算期望值Te=P+4M+O÷6标准差δ=P-O÷6例1:公司的某项目即将开始;项目经理估计该项目10天即可完成;如果出现问题耽搁了也不会超过20天完成;最快6天即可完成..根据项目历时估计中的三点估算法;你认为该项目的历时为37该项目历时的估算标准差为38 ..37A.10天 B.11天 C.12天 D.13天38A.2.1天 B.2.2天 C.2.3天 D.2.4天解答: 37B T=6+4x10+20/6=1138C σ=20-6/6=2.3例2:A任务持续时间悲观估计为36天;最大可能估计为21天;乐观估计6天..那么A行为在16到26天之间完成的概率有多大%解答:1求出σ .. σ = 36-6/ 6 = 5T = 6 + 21*4 + 36/6 = 212 由σ可知 21+5=26 21-5=16; 因此16—26天落在±1 σ分布内..3 由1 σ的概率P为68.26可得答案为 B. 68.26%注意:必须记住三个数字是±1σ 68.3%±2σ 95.5%±3σ 99.7%四、合同计算成本加成本百分比合同=实际成本*1+费用百分比成本加固定费合同=实际成本+目标成本*费用百分比成本加奖励合同=实际成本+目标利润=目标成本*费用百分比+目标成本-实际成本*风险分摊比例固定总价加奖励费合同:计算值=实际成本+目标利润=目标成本*费用百分比+目标成本-实际成本*风险分摊比例当计算值<最高限价时;固定总价加奖励费合同=计算值;当计算值>最高限价时;固定总价加奖励费合同=最高限价;例题1:五、沟通渠道沟通渠道communication channels类似于联系所有参与者的电话线数目..沟通渠道= N N – 1 / 2这里;N 是指参与沟通者的人数..例题1:项目团队原来有6个成员;现在新增加2个成员;沟通渠道增加了多少A、6条B、12条C、13条D、26条原来 6×6-1/2=15 现在8×8-1/2=282011年下半年六、人力资源计算经常和进度合在一起考答案:A B某工程包括A、B、C、D、E、F、G、H八个作业;各个作业的紧前作业、所需时间和所需人数如下表所示假设每个人均能承担各个作业:作业 A B C D E F G H 紧前作业—— A B C C D;E G 所需时间周 2 1 1 1 2 1 2 1 所需人数8 4 5 4 4 3 7 8 该工程的工期应为57周..按此工期;整个工程至少需要58人..57A. 8 B. 9 C. 10 D. 1158A. 8 B. 9 C. 10 D. 11答案:A B七、风险2011年上半年八、工程题例题1答案:B答案:B C答案:D答案:C B答案:B答案:C载重量限 24 吨的某架货运飞机执行将一批金属原料运往某地的任务..待运输60A. 11 B. 10 C. 9 D. 8答案:B答:A C9X+4Y≤3604 X+5 Y≤2003 X+10 Y≤300Max0.7X+1.2YX≥0;Y≥0两两组合建立三个方程组..解代入第三个方程看是否成立..并求出对应的利润;即可..2011年真题上半年2011年下半年大题计算花了多少AC 实际成本ACWP =实际工作量×实际单价测量时间点项目已完成工作的实际的货币价值;即实际花了多少..通过项目执行过程中绘制的AC的S 曲线可得到..全部工作预算的总成本是多少BAC 完工预算即项目预算的总成本;在成本预算中已得到..还需要多少预算能才能完成所有的工作ETC 完工尚需估算预计在以后不会再发生相似的偏差时:ETC=BAC-EV当前偏差可代表未来的趋势时:ETC=BAC-EV/CPI考虑了截止目前的资源绩效和生产率的估算..现在预期完工时总成本将是多少EAC 完工估算EAC=AC+ETC①EAC=AC+BAC-EV②EAC=AC+BAC-EV/CPI③成本偏差多少CV 成本偏差CV=EV-AC +有利-不利成本执行的趋势如何CPI 成本执行指数CPI=EV/AC >1 有利<1 不利进度偏差多少 SV 进度偏差SV=EV-PV +有利-不利进度执行趋势如何SPI 进度绩效指数SPI=EV/PV >1 有利<1 不利①过去的实施情况表明原来所作的估算彻底过时了;或由于条件变化;原来的估算已不再合适②目前的偏差被视为一种特例;并且项目团队认为将来不会发生类似的偏差情况③目前的偏差视为将来偏差的典型形式例题1解答:求出SPI = 18000+45000+30000/ 100000= 93% 选 C例题2:下表为同时开展的4个项目在某个时刻的计划值PV、实际成本AC和挣值EV;该时刻成本超出最多的项目和进度最为落后的项目分别是 ..A.项目1;项目1B.项目3;项目2C.项目4;项目4D.项目2;项目4答案:选择C..例题3:某公司正在进行中的项目;当前的PV=2200元、EV=2000元、AC=2500元;当前项目的SV和项目状态是1;该项目的CPI和成本绩效是2..1A.-300元;项目提前完成 B.+200元;项目提前完成C.+8000元;项目按时完成D.-200元;项目比原计划滞后2;实际成本与计划的一致实际成本比计划成本要低实际成本超出了计划成本实际成本超出了计划成本答案:1D;2C..2011年上半年中级案例试题二15 分阅读以下说明;请回答问题 1 至问题3;将解答或相应的编号填入答题纸的对应栏内..某大楼布线工程基本情况为:一层到四层;必须在低层完成后才能进行高层布线..每层工作量完全相同..项目经理根据现有人员和工作任务;预计每层需要一天完成..项目经理编制了该项目的布线进度计划;并在3 月18 号工作时间结束后对工作完成情况进行了绩效评估;如下表所示:问题 15 分请计算 2011 年3 月18 日时对应的PV、EV、AC、CPI 和SPI..问题 24 分(1)根据当前绩效;在下图中划出AC 和EV 曲线..2 分2分析当前的绩效;并指出绩效改进的具体措施..2 分问题 36 分1如果在2011 年3 月18 日绩效评估后;找到了影响绩效的原因;并纠正了项目偏差;请计算ETC 和EAC;并预测此种情况下的完工日期..3 分2如果在2011 年3 月18 日绩效评估后;未进行原因分析和采取相关措施;仍按目前状态开展工作;请计算ETC 和EAC;并预测此种情况下的完工日期..3 分参考答案分析:问题 1PV= 20000;EV=10000; AC=8000;CPI=EV/AC=10000/8000=125%;SPI=EV/PV=50% 问题212目前的绩效:成本节省;进度滞后..具体的措施:增加工作人员;赶工;必要时调整计划或基准问题 31ETC=30000;EAC=38000..预测的完工日期:3 月21 日..2ETC=24000;EAC=32000..预测的完工日期:3 月24 日..二、进度画图;计算6参数;关键线路;工期;费用..例题2迟多少天..解:1D、E、G都已经推迟..首先求出D、E、G的最早完成时间;进而可以求出这三项工作各推迟了多少天..D的TEF =12;E的TEF=10;G的TEF=9;故三个工作分别推迟:D为3天;E为5天;G为4天..推迟天数=检查时点的工时数-活动最早完成时间+每个活动的工时-已完成工作工时2根据ADM图;计算最早、最晚时间;总时差;找出关键路径;计算项目工期关键路径: 1-3-4-5-6-7-9-10-11总工期:41天3由于工作D在关键路径上;因此D工作推迟3天;项目工期也会推迟3天;E活动不在关键路径上;总时差为19天;大于目前耽误的5天;因此不会对项目工期造成威胁;活动G不在关键路径上;总时差为11天;大于目前耽误的4天;因此不会对项目工期造成威胁;项目进度-选择题答案:B D答案:D答:BD三、投资分析(1)投资收益率ROI建成投产后;在运营正常年获得的净收益与项目总投资之比..2投资回收期Payback Period项目从投产年算起;用每年的净收益将初始投资全部收回的时间..静态投资回收期Pt计算公式:Pt = 累计净现金流量开始出现正值的年份数 - 1 +上年累计净现金流量的绝对值 / 当年净现金流量动态投资回收期动态投资回收期 T 计算公式:动态投资回收期年= 累计净现金流量现值开始出现正值年份数 - 1+上年累计净现金流量现值的绝对值 / 当年净现金流量现值例题1:红星集团目前正在考虑投资建设客户关系管理CRM系统..经过初步分析;CRM项目预计投资约2000万元;其中包括设备采购、软件开发、流程优化、人员培训等内容..整个项目的前期准备工作约一年的时间..第二年进入运营阶段;预计当年运营成本为1000万元;CRM系统所带来的收益约为1200万元..从第三年开始;年运营成本下降为800万元;第三年收益为1500万元;第四年收益为1800万元;第五年收益为2000万元..问题 1 假设系统的使用寿命为五年;企业确定的贴现率为12%;根据上述数据;分析红星集团在想CRM项目的生命期内的现金流量情况;并将有关数据添入表1问题2根据表1红星集团现金流量表中的数据;计算CRM项目的动态投资回收期;静态投资回收期;NPV;动态投资收益率问题3该项目动态投资回收期和静态投资回收期是否一致如果不一致;为什么解:问题1 假设系统的使用寿命为五年;企业确定的贴现率为12%;根据上述数据;分析红星集团在想CRM项目的生命期内的现金流量情况;并将有关数据添入表1问题2动态回收期:488.64 4.714348.5684tP=+=≈年个月静态回收期:t -1001P=(5-1)+=4+=4.083=41120012年年个月NPV=195.4动态投资收益率 = 1 / 动态投资回收期 = 1 / 4.7143 = 0.2121问题 3 动态投资回收期考虑了货币的时间价值;进行了折现计算;因而数值将变小;故一个方案的动态投资回收期通常小于静态投资回收期..解: C B。

决策树例题经典案例

决策树例题经典案例决策树是一种常用的机器学习算法,它可以用于解决分类和回归问题。

在这篇文档中,我们将探讨一个经典的决策树例题,并详细介绍如何使用决策树算法来解决这个问题。

首先,让我们来看看这个经典案例的背景。

假设我们是一个电商平台,我们希望根据用户的购买历史和个人信息,来预测用户是否会购买一款新的产品。

为了解决这个问题,我们将使用决策树算法来构建一个模型,用于预测用户购买的结果。

接下来,我们需要收集数据来训练决策树模型。

针对这个问题,我们可以收集一些用户的购买历史数据和个人信息数据,比如用户的性别、年龄、收入水平,以及之前购买的产品的种类和数量等。

在收集到足够的数据后,我们可以开始构建决策树模型了。

首先,我们需要将数据分成训练集和测试集,通常我们将数据的70%用于训练,30%用于测试。

然后,我们可以使用训练集的数据来构建决策树模型。

在构建决策树模型之前,我们需要选择一个合适的划分准则来衡量每个特征的重要性。

在这个例子中,我们可以使用基尼指数作为划分准则。

基尼指数用于度量一个数据集的不纯度,越小表示数据越纯。

接下来,我们需要选择一个最佳的特征来作为根节点。

在这个例子中,我们可以选择购买历史中最常购买的产品作为根节点。

然后,我们根据该特征的取值将数据划分成若干个子集,每个子集对应一个分支节点。

在每个分支节点中,我们需要继续选择一个最佳的特征来作为子节点。

在选择特征的过程中,我们可以使用递归的方法,不断地将数据划分为更小的子集,直到满足某个停止条件。

在构建决策树的过程中,我们需要注意一些问题。

首先,我们需要处理缺失值。

在训练集中,有些用户可能没有提供某些特征的值,我们可以使用一些方法来填补这些缺失值,比如使用平均值或中位数。

其次,我们需要处理特征的取值类型。

有些特征是离散型的,有些是连续型的。

对于离散型的特征,我们可以直接将其作为树的分支节点,而对于连续型的特征,我们需要使用一些方法将其转化为离散型的特征,比如使用二分法来分割特征的取值范围。

决策树例题分析

决策树例题分析决策树是一种常见的机器学习算法,它通过树形结构对数据进行分类和预测。

本文将基于一个例题,详细分析决策树的构建和应用过程。

例题描述:某公司想要根据客户的特征来判断他们是否会购买某个产品。

为了实现这个目标,公司收集了以下一些数据:客户的年龄、年收入和婚姻状况,以及他们最终购买与否的情况。

现要用这些数据建立一个决策树模型来预测客户是否会购买产品。

数据集准备:首先,我们需要对数据集进行准备和清洗。

将数据集划分为训练集和测试集,其中训练集用于建立决策树模型,测试集用于评估模型的性能。

然后,对于缺失值或异常值,可以根据具体情况进行处理,例如使用均值填充或删除异常样本。

特征选择:在决策树算法中,需要选择最佳的特征来构建决策树。

一个好的特征应该能够很好地区分不同类别的样本。

在本例中,我们可以使用信息增益或基尼系数作为特征选择的标准。

根据特征选择的结果,选择最佳的特征作为根节点。

决策树构建:在选择了根节点特征后,我们需要对数据集进行划分,并递归地构建决策树。

在每个节点上,根据选择的分裂特征和划分标准,将数据集分为更小的子集。

直到满足终止条件,例如节点中只包含同一类别的样本或达到了预定深度。

在构建过程中,可以使用剪枝技术来防止过拟合。

决策树预测:构建完决策树模型后,就可以用它来进行预测了。

对于一个新的样本,从根节点开始,根据节点的特征判断样本应该往哪个分支走,直到到达叶节点。

叶节点对应的类别就是预测的结果。

可以使用预测准确率、精确率、召回率等指标来评估模型的性能。

模型评估和优化:在预测的过程中,我们可以使用测试集来评估模型的性能。

根据评估结果,可以选择调整模型参数或选择其他特征,并再次训练模型。

一般来说,更好的特征和更合适的模型参数可以提高决策树的性能。

总结:决策树是一种常见而强大的分类和预测算法。

通过选择最佳特征、构建决策树和预测样本,可以实现对数据集的分类和预测。

在实际应用中,需要根据不同问题的特点选择合适的特征和模型参数,以达到更好的性能。

决策树例题经典案例

决策树例题经典案例决策树是一种常用的机器学习算法,它能够通过构建一棵树来对数据进行分类或者回归预测。

决策树通过对每个样本的特征进行划分,从而逐步构建树结构,最终得到一棵用于分类或者回归的决策树。

下面我们来看一个经典的决策树例题。

假设我们有一个数据集,包含了一些二分类问题的样本,每个样本有两个特征,特征1表示是否有房产(是/否),特征2表示是否有工作(是/否)。

我们的目标是通过这两个特征来预测样本的类别(是/否)。

我们可以根据这个问题构建一个决策树。

首先,我们需要选择一个特征来进行划分。

通常我们选择的划分特征是能够最大程度地将样本分开的特征。

在这个例子中,我们可以选择特征1作为划分特征。

然后,我们将特征1的取值分别为“是”和“否”的样本分成两个子集。

对于特征1取值为“是”的样本,我们可以看到它们的类别都为“是”,所以我们可以将其划分为一个叶子节点,并且将类别设为“是”。

对于特征1取值为“否”的样本,我们需要选择另一个特征来划分。

同样地,我们选择特征2作为划分特征。

对于特征2取值为“是”的样本,我们可以看到它们的类别有一部分为“是”,一部分为“否”,所以我们还需要继续划分。

我们选择特征1作为再次划分的特征。

对于特征2取值为“否”的样本,我们可以看到它们的类别都为“否”,所以我们可以将其划分为一个叶子节点,并且将类别设为“否”。

对于特征2取值为“是”,特征1取值为“否”的样本,我们可以看到它们的类别全部为“否”,所以我们可以将其划分为一个叶子节点,并且将类别设为“否”。

最后,我们得到的决策树如下:特征1是|--- 类别:是特征1否|--- 特征2是| |--- 类别:是||--- 特征2否|--- 类别:否通过这个决策树,我们可以根据样本的特征值来进行预测。

例如,对于一个样本,特征1为“是”,特征2为“否”,按照决策树的规则,我们可以预测该样本的类别为“否”。

决策树是一种直观、易于解释的机器学习算法,它能够根据数据集的特征进行分类或者预测,对于解决一些简单的二分类问题非常有效。

决策树计算方法例题讲解

决策树计算方法例题讲解决策树是一种常用的机器学习算法,用于分类和回归问题。

它通过构建一棵树形结构来进行决策,每个内部节点表示一个特征,每个叶子节点表示一个类别或一个数值。

下面我将通过一个具体的例题来详细讲解决策树的计算方法。

假设我们有一个数据集,其中包含了一些水果的特征(颜色、形状、纹理)以及对应的标签(是否为橙子)。

我们希望通过这些特征来构建一个决策树模型,能够根据水果的特征预测其是否为橙子。

首先,我们需要将数据集划分为训练集和测试集。

训练集用于构建决策树模型,测试集用于评估模型的性能。

1.特征选择在构建决策树之前,我们需要选择一个特征作为根节点。

常用的特征选择方法有信息增益、信息增益比、基尼指数等。

这里我们使用信息增益来选择特征。

信息增益衡量了在给定特征条件下,类别的不确定性减少的程度。

具体计算信息增益的步骤如下:-计算整个数据集的熵(entropy):-首先,统计每个类别的样本数量。

-然后,计算每个类别的概率,并求和。

-最后,根据概率计算整个数据集的熵。

-对于每个特征,计算其对应的信息增益:-首先,针对该特征的每个取值,将数据集划分为不同的子集。

-然后,计算每个子集的熵和权重,并求和。

-最后,用整个数据集的熵减去子集的熵和权重的乘积,得到信息增益。

选择具有最大信息增益的特征作为根节点。

2.构建决策树选择完根节点后,我们需要递归地构建决策树。

具体步骤如下:-对于每个内部节点,选择一个最佳的特征作为其子节点。

-将数据集根据该特征的不同取值划分为多个子集。

-对于每个子集,如果所有样本都属于同一类别,则将该子集设为叶子节点,并标记为该类别。

-否则,继续递归地构建决策树,直到满足停止条件(如达到预定深度或无法继续划分)。

3.决策树的剪枝构建完决策树后,我们需要进行剪枝操作,以避免过拟合现象。

剪枝可以通过预剪枝和后剪枝来实现。

-预剪枝:在构建决策树的过程中,在划分子集之前,先进行验证集的测试,如果测试结果不好,则停止划分,将当前节点设为叶子节点。

决策树例题分析及解答

最后比较决策点1的情况: 由于点③(719万元)与点②(680万元)相比,点③的期望利润值较大,因此取点③而舍点②。这样,相比之下,建设大工厂的方案不是最优方案,合理的策略应采用前3年建小工厂,如销路好,后7年进行扩建的方案。

*

决策树法的一般程序是: (1)画出决策树图形 决策树指的是某个决策问题未来发展情况的可能性和可能结果所做的估计,在图纸上的描绘决策树 (2)计算效益期望值 两个行动方案的效益期望值计算过程: 行动方案A1(建大厂)的效益期望值: 13.5×0.8×10+25.5×0.2×10-25=134万元 行动方案A2(建小厂)的效益期望值: 15×0.8×10+15×0.2×10-10=140万元 (3)将效益期望值填入决策树图 首先在每个结果点后面填上相应的效益期望值;其次在每个方案节点上填上相应的期望值,最后将期望值的角色分支删减掉。只留下期望值最大的决策分支,并将此数值填入决策点上面,至此决策方案也就相应选出

01

A1的净收益值=[300×0.7+(-60)×0.3] ×5-450=510万 A2的净收益值=(120×0.7+30×0.3)×5-240=225万 选择:因为A1大于A2,所以选择A1方案。 剪枝:在A2方案枝上打杠,表明舍弃。

02

”

*

例 题

为了适应市场的需要,某地提出了扩大电视机生产的两个方案。一个方案是建设大工厂,第二个方案是建设小工厂。

例: 某农业企业有耕地面积33.333公顷,可供灌水量6300立方米,在生产忙季可供工作日2800个,用于种植玉米、棉花和花生三种作物。预计三种作物每公顷在用水忙季用工日数、灌水量和利润见表,在完成16.5万公斤玉米生产任务的前提下,如何安排三种作物的种植面积,以获得最大的利润。

决策树算法分析范文

决策树算法分析范文决策树(Decision Tree)是一种基于树状结构的机器学习算法,用于解决分类和回归问题。

它是一个自顶向下的递归分割数据集的过程,每个决策点都是基于一些特征的条件判断,根据判断结果将数据分配到其子节点中。

1.简单直观:决策树的分类结果可以直接通过树状结构进行解释和理解,易于人类理解和使用。

决策树还可以通过可视化的方式展示,直观地展示决策规则。

2.非参数化算法:决策树算法不对数据分布做出任何假设,没有参数需要调节。

因此,决策树算法在处理非线性数据和无法满足线性假设的数据上表现良好。

3.天然的特征选择:决策树算法可以自动选择划分特征,通过对特征的比较选择最优的划分点,从而减少了特征工程的工作。

此外,决策树还可以通过计算特征的重要性,提供关于数据集中特征重要性的有用信息。

4.容易处理缺失值:决策树算法可以有效地处理缺失值。

当在决策过程中遇到缺失值时,可以选择忽略该特征,或者将缺失值分配到合适的子节点中。

5.可处理大型数据集:决策树算法具有良好的扩展性,可以有效地处理大规模的数据集,而且可以通过并行化的方式来加速训练过程。

1.容易过拟合:决策树容易过拟合训练数据,特别是在处理包含大量特征的复杂问题时。

为了避免过拟合,可以采用剪枝操作对决策树进行剪枝,或者使用集成学习方法如随机森林、梯度提升树等。

2.不稳定性:决策树算法对数据的微小变化非常敏感,数据的微小变化可能导致完全不同的树结构。

为了提高决策树的稳定性,可以使用集成学习方法来减少这种不稳定性,如随机森林。

3.忽略特征间的相关性:决策树算法通常假设特征之间是独立的,而忽略了特征之间的相关性。

这可能会导致决策树在处理包含高度相关特征的数据时性能下降。

决策树算法的应用非常广泛,包括金融风控、医疗诊断、工业质量控制等领域。

它在解决分类和回归问题上表现出高效且高度可解释的特点,对于数据集具有非线性特征分布和复杂关系的问题有着良好的效果。

同时,决策树算法的可视化特点也使其成为了教育领域理解和学习机器学习概念的重要工具。

【信息系统项目管理】一个决策树算法案例分析

s1, P(S1 ) 0.8 s2 , P(S2 ) 0.2

800 700

1400 500 2000 -900

首先计算出各个状态结点的期望值,从中选取一个最大期望值, 往回找对应的方案,为最佳方案,如上图,④点最大 ,选d3方 案为最佳方案。

可见,方案d3建大楼为最佳方案。

为了较形象直观地作出决策,也可应用决策树方式进行分析,决策树

决策结点用□表示,由它生出方案枝;各方案枝分别生出状态结点,用○ 表示,由状态结点引出各种状态分枝,分枝末梢绘上相应的益损值。对本

d

1

d

1

2

d

3

780 2

1220 3

1420 4

s1, P(S1 ) 0.8 s2 , P(S2 ) 0.2

d2

2000-1400=600

700-500=200

d3

2000-2000=0 700-(-900)=1600

再分别对各方案,从不同自然状态的后悔值中取一最大者,

d1 →1200

d2 →600万←Min

d3 →1600

5

然d2为后最从各佳方方案案。的最大后悔值中选取一最小者,为600万,则它对应的方案

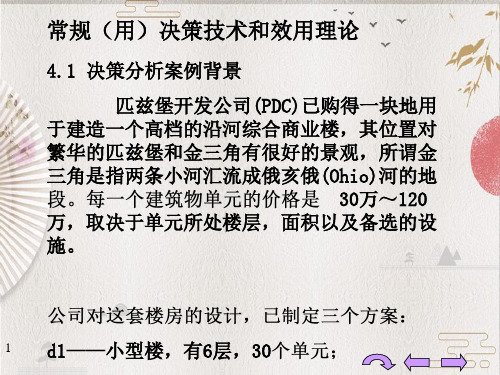

常规(用)决策技术和效用理论

4.1 决策分析案例背景 匹兹堡开发公司(PDC)已购得一块地用

于建造一个高档的沿河综合商业楼,其位置对 繁华的匹兹堡和金三角有很好的景观,所谓金 三角是指两条小河汇流成俄亥俄(Ohio)河的地

30万~120 万,取决于单元所处楼层,面积以及备选的设 施。

1 d1——小型楼,有6层,30

二、风险决策方法(自然状态出现的概率已知) 既然各种可能的自然状态出现的概率已经通过调研获得,则可以

一个决策树算法案例分析

一个决策树算法案例分析决策树是一种用于解决分类和回归问题的机器学习算法。

它通过对数据集进行递归的二分操作,构建一棵树形结构来进行决策。

在本文中,我将介绍一个决策树算法的案例分析。

案例背景:假设我们是一家互联网公司的人力资源部门,负责筛选和招聘候选人。

我们希望通过构建一个决策树模型来预测一些候选人是否适合我们公司的工作岗位。

数据集:我们收集了一些候选人的个人信息和面试表现数据,如年龄、性别、教育程度、工作经验、英语水平和面试结果(是否被录取)。

数据集样本量为1000。

决策树的构建:根据数据集,我们可以得出这样的决策树模型:首先,我们选择一个特征来划分数据集。

我们可以选择基于工作经验来进行划分。

然后,我们对每个节点进行评估,计算每个特征的信息增益或者信息熵。

信息增益或信息熵表示了在一些特征条件下,对于分类结果的不确定性减少的程度。

我们选择具有最大信息增益或最小信息熵的特征作为当前节点的划分特征。

接下来,我们将数据集划分为若干个子集,每个子集包含具有相同特征值的样本。

对于每个子集,我们递归地构建决策树。

如果子集中的样本全部属于同一类别,则停止划分,将当前节点标记为叶子节点,并将该类别作为预测结果。

如果子集为空,则停止划分,将当前节点标记为叶子节点,并将父节点中最常见的类别作为预测结果。

最后,我们得到了一棵完整的决策树模型。

模型评估:为了评估决策树的性能,我们需要对模型进行训练和测试。

我们可以将数据集按照一定比例划分为训练集和测试集。

通过使用训练集,我们可以从根节点开始递归地构建决策树。

然后,使用测试集对模型进行评估。

我们可以使用准确率、召回率、F1分数等指标来评估模型的性能。

模型优化:在构建决策树时,我们可以使用一些优化方法来提高模型的性能。

例如,剪枝是一种常用的优化方法。

剪枝可以去除一些无关的特征,从而简化决策树的结构,并减少过拟合的风险。

另外,我们还可以使用集成学习的方法来进一步提高模型的性能。

集成学习通过同时训练多个决策树,并将其组合成一个更强大的模型。

个决策树算法案例分析

个决策树算法案例分析决策树算法是一种常用的机器学习算法,可以用于分类和回归问题。

在这个案例分析中,我将以一个电商网站的用户行为数据为例,详细介绍决策树算法的应用过程。

首先,我们需要了解数据集的特征和目标变量。

假设我们的数据集包含以下特征:用户的年龄、性别、浏览器类型、操作系统、浏览时间、购买意愿等。

目标变量是用户是否会购买商品,即购买意愿的分类。

接下来,我们需要对数据进行预处理。

首先,我们要处理缺失值。

如果一些特征的值缺失,我们可以选择删除这些样本,或者用平均值、中位数或众数来填充缺失值。

其次,我们要处理类别型数据。

将类别型特征转化为数值型特征,通常可以使用独热编码等方法。

接下来,我们可以开始构建决策树模型。

我们可以使用信息增益或基尼系数等指标来选择最佳的特征来划分数据。

一般来说,我们会选择那些能够提供最大分类能力的特征作为划分节点。

使用递归的方式,我们可以构建一个完整的决策树。

在构建决策树时,我们要注意避免过拟合。

为了避免决策树过于复杂,我们可以引入剪枝操作。

剪枝操作可以通过限制树的深度、节点的最小样本数等来控制树的复杂度。

构建好决策树后,我们可以使用测试数据进行预测。

预测过程非常简单,只需要将测试样本沿着决策树的分支进行判断,直到达到叶节点,然后根据叶节点的分类来进行预测。

最后,我们需要对模型进行评估。

常用的评估指标包括准确率、召回率、F1值等。

我们可以使用交叉验证或留出集的方法来对模型进行评估,以确保模型的泛化能力。

在这个案例中,决策树算法可以用于预测用户的购买意愿。

通过分析用户的年龄、性别、浏览器类型、操作系统、浏览时间等特征,我们可以根据决策树模型来预测用户是否会购买商品。

这个预测结果可以帮助网站进行个性化推荐、优化页面设计等工作,提升用户体验和销售额。

总结起来,决策树算法是一种简单而有效的机器学习算法,在各行各业都有广泛的应用。

通过选择合适的特征和合理的划分节点,我们可以构建一个高效的决策树模型,用于预测和分类任务。

决策树算法例题经典

决策树算法例题经典决策树是一种常用的机器学习算法,用于处理分类和回归问题。

它通过对数据集进行划分,构建一个树状模型来进行决策。

在这篇文章中,我将介绍一个经典的决策树算法的例子,并详细解释其原理和实现方法。

假设我们有一个数据集,里面包含了一些患有乳腺癌的病人的信息。

每个病人的信息都有一些特征,比如年龄、乳房厚度、肿块大小等。

我们的任务是根据这些特征预测病人是否患有乳腺癌。

首先,我们需要选择一个合适的划分准则来构建决策树。

常用的划分准则有信息增益、信息增益比、基尼指数等。

在本例中,我们选择使用信息增益作为划分准则。

接下来,我们需要计算每个特征的信息增益。

信息增益是根据特征划分前后的熵变化来衡量的。

熵是一个用于度量系统无序程度的指标,越大表示越无序,越小表示越有序。

在本例中,我们可以通过计算患有乳腺癌和未患有乳腺癌的病人的比例来计算熵。

然后,我们选取信息增益最大的特征作为当前节点的划分特征。

这样可以使得划分后的子集的熵最小化,从而提高分类的准确性。

接着,我们递归地对每个子集进行上述操作,直到满足停止条件。

停止条件可以是子集中只有一类样本或没有更多的特征可供选择划分。

在实现决策树算法时,我们需要解决一些问题。

首先,如何选择划分特征。

上述例子中我们选择了信息增益最大的特征作为划分特征,但也可以选择其他准则。

其次,如何处理缺失值。

在实际应用中,数据集中可能会有一些缺失值,我们需要考虑如何处理这些缺失值。

最后,如何处理连续型特征。

决策树算法本质上是一个离散型算法,对于连续型特征,我们需要进行离散化处理。

决策树算法是一种简单但有效的机器学习算法,可以用于处理分类和回归问题。

它具有可解释性好、易于理解和实现等优点,在实际应用中得到了广泛的应用。

然而,决策树算法也存在一些限制,比如容易过拟合、适应性较差等。

为了提高决策树算法的性能,可以使用集成学习方法,如随机森林、梯度提升树等。

总之,决策树算法是一种经典的机器学习算法,本文介绍了它的原理和实现方法,并给出了一个实际应用的例子。

全国软考-一个决策树算法案例分析

备选方案

小型楼d1 中型楼d 2 大型楼d 3

3

自然状 态 高的市场接受程度S1 800万 1400万 2000万 低的市场接受程度S2 700万 500万 -900万

其中i——表示方案,j——表示状态。比如:V32=-900万,表示大型楼方案 d3在低 的市场接受S2时,楼房不能正常销售,估计可能带来亏损900万。

高接受S1,P(S1)=0.8 低接受S2,P(S2)=0.2

有兴趣买楼,即支持者I1

P(I1|S1)=0.90 P(I1|S2)=0.25

无兴趣买楼,不支持者I2

P(I2|S1)=0.10 P(I2|S2)=0.75

11

这个似然函数的意义是:在真正高接受者中核查为有兴趣(即支持建 楼)买楼的概率为0.9,而不支持的为0.1;在真正低接受者中,核查为不支 持的概率为0.75,反而支持的为0.25。这些补充信息是在明确了高、低接 受者的条件下,进一步调查核实的信息,由此统计出的条件概率。 有 了先验概率和似然函数,可以运用贝叶斯全概率公式,计算出后验概率 P(S|I):

8 百万 7

中型d2

2 支持的,I1 P(I1)=0.77 1 支持的,I2 P(I2)=0.77 3

大型d3 中型d2 小型d1 大型d3

5

6

高接受S1,P(S1|I1)=0.935 14 低接受S2,P(S2|I1)=0.065 5 高接受S1,P(S1|I1)=0.935 20 低接受S2,P(S2|I1)=0.065 -9

1000 2000

d3可得 最大EV 的P区间 d1可得 最大 EV的P 区间 d2可得 最大 EV的P 区间

1500

EV(d3)

EV(d2) EV(d1)

决策树例题分析

7

决策过程如下:画图,即绘制决策树

• A1的净收益值=[300×0.7+(-60)×0.3] ×5-450=510 万

• A2的净收益值=(120×0.7+30×0.3)×5-240=225万 • 选择:因为A1大于A2,所以选择A1方案。 • 剪枝:在A2方案枝上打杠,表明舍弃。

8

例题

• 为了适应市场的需要,某地提出了扩大电视机生产的 两个方案。一个方案是建设大工厂,第二个方案是建 设小工厂。

9

680万元 2

建大厂

销路好(0.7) 销路差(0.3)

200万元 -40万元

1 719万元

扩建 5 销路好(1.0)

建小厂

930万元

销路好(0.7) 4 不扩建

930万元

6 销路好(1.0)

3

560万元

719万元

销路差(0.3)

前3年,第一次决策

后7年,第二次决策

190万元

80万元 60万元

10

1

例:设某茶厂计划创建精制茶厂,开始有两个方案,方案 一是建年加工能力为800担的小厂,方案二是建年加工能 力为2000担的大厂。两个厂的使用期均为10年,大厂投 资25万元,小厂投资10万元。产品销路没有问题,原料来 源有两种可能(两种自然状态):一种为800担,另一种为 2000担。两个方案每年损益及两种自然状态的概率估计值 见下表

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

备选方案

小型楼d1 中型楼d 2 大型楼d 3

3

自然状 态 高的市场接受程度S1 800万 1400万 2000万 低的市场接受程度S2 700万 500万 -900万

其中i——表示方案,j——表示状态。比如:V32=-900万,表示大型楼方案 d3在低 的市场接受S2时,楼房不能正常销售,估计可能带来亏损900万。

各方案dj的益损期望值为:

EV (d i ) P( S j ) * Vij

j 1 n

益损期望值为最大者对应的方案,可选为最佳方案。 对本问题而言,若已知:P(S1)=0.8,P(S2)=0.2,则 有: EV(d1)=0.8×800+0.2×700=780万 EV(d2)=0.8×1400+0.2×500=1220万 EV(d3)=0.8×2000+0.2×(-900)=1420万

没有兴趣(支持)买楼者I2的有关概率计算表

自然状态Si s1 先验概率P(Si) 0.8 条件概率P(I1|Si) 0.1 联合概率P(I1∩s1) 0.08 后验概率P(Si|I1) 0.348

s2

12

0.2

0.75

0.15Biblioteka 0.652根据上列概率计算表,可以画出如下决策树:

小型d1

高接受S1,P(S1|I1)=0.935 4 低接受S2,P(S2|I1)=0.065

4

2 小中取大法或保守法

对各方案,先从不同状态的Vij中取一最小值者,得: 最小值d1→700←Max·Min d2→500 d3→-900 再从不同方案的最小值中取一最大值,如700万,所对应的方案——小型楼方 案d1为决策的最佳方案。 3等概率法 该方法认为,不同自然状态出现的概率彼此相等。在等概率原则下,则可分 别先将各不同方案的所有自然状态的益损值求和,得: d1→800+700=1500万

1

常规(用)决策技术和效用理论

4.1 决策分析案例背景

匹兹堡开发公司(PDC)已购得一块地用于建造一个高档的沿河 综合商业楼,其位置对繁华的匹兹堡和金三角有很好的景观,所 谓金三角是指两条小河汇流成俄亥俄(Ohio)河的地段。每一个建 筑物单元的价格是30万~120万,取决于单元所处楼层,面积 以及备选的设施。 公司对这套楼房的设计,已制定三个方案: d1——小型楼,有6层,30个单元; d2——中型楼,有12层,60个单元; d3——大型楼,有18层,90个单元。 决策问题是要从这三个方案中选择其中之一,并提出决策分析的 书面报告,包括分析计算书,建议,以及风险提示。

高接受S1,P(S1)=0.8 低接受S2,P(S2)=0.2

有兴趣买楼,即支持者I1

P(I1|S1)=0.90 P(I1|S2)=0.25

无兴趣买楼,不支持者I2

P(I2|S1)=0.10 P(I2|S2)=0.75

11

这个似然函数的意义是:在真正高接受者中核查为有兴趣(即支持建 楼)买楼的概率为0.9,而不支持的为0.1;在真正低接受者中,核查为不支 持的概率为0.75,反而支持的为0.25。这些补充信息是在明确了高、低接 受者的条件下,进一步调查核实的信息,由此统计出的条件概率。 有 了先验概率和似然函数,可以运用贝叶斯全概率公式,计算出后验概率 P(S|I):

8 百万 7

中型d2

2 支持的,I1 P(I1)=0.77 1 支持的,I2 P(I2)=0.77 3

大型d3 中型d2 小型d1 大型d3

5

6

高接受S1,P(S1|I1)=0.935 14 低接受S2,P(S2|I1)=0.065 5 高接受S1,P(S1|I1)=0.935 20 低接受S2,P(S2|I1)=0.065 -9

d2→1400+500=1900万←Max

d3→2000-900=1100万 再从各方案的合计和值中取一最大值,如1900万,所对应方案d2的最佳方案。 5

4 最小后悔值原则的方法 该方法相似于保守方法,取悲观态度。首先从益损矩阵中求后悔值,即机 会损失值Rij: Rij= V*j-Vij (j=1,2,…,n) (i=1,2,…,m) 式中V*j——对状态Sj而言的最佳决策的益损值; Vij——状态Sj、方案di相应的益损值。 由此,可得后悔值Rij矩阵为: s1 d1 d2 d3 最大的后悔值

4.2 常用决策分析方法

按照问题面临的自然状态出现的概率无法知道,抑或可以通过调研统计得 到,常用决策方法划分为不确定性决策方法与风险决策方法。 一、不确定性决策方法(自然状态出现的概率不知道) 其常用方法有: 1大中取大法或乐观法

对各方案先从不同状态的Vij中取一最大值者,得:

最大值 小型楼d1→800万 中型楼d2→1400万 大型楼d3→2000万←Max· Max 再从不同方案的最大值中取一最大值,为2000万,所对应的方案——大型楼 方案d3为决策的最佳方案。

1000 2000

d3可得 最大EV 的P区间 d1可得 最大 EV的P 区间 d2可得 最大 EV的P 区间

1500

EV(d3)

EV(d2) EV(d1)

500

0

0.2

-500

0.4

0.6

0.8

1.0

-1000

10

§4.5 贝叶斯决策方法

前述两种自然状态出现的概率P(S1)=0.8,P(S2)=0.2,只是一种比较粗 糙地调研而获得的自然状态的概率分布,也即是一种所谓先验概率。如果 我们能够再深挖一些新信息,用以修正先验概率,最终获得一种所谓后验 概率,用来进行决策,则决策的效果更好、更科学。 一般讲,补充信息是可以通过对自然状态样本信息设计的实验方法来 取得,包括原始资料的采样、产品检验、市场调研等等。比如:通过天气 预报的验证信息,来修正天气状态的先验概率;通过产品检验的正确与否 的信息,来修正产品的正、废品先验概率。对PDC问题来讲,可以通过市 场调查,调查有多少比率的人有兴趣买楼,记为I1,有多少比率的人没有 兴趣买楼,记为I2,则可以获得四个条件概率,记为:P(I1|S1),P(I2|S1), P(I1|S2),P(I2|S2),它们也叫做似然函数。 对PDC问题,经过调查,获得了下表的似然函数。 自然状态

建中型楼。

14

§4.5 效用与风险分析(Utility and Risk Analysis)

以前所述的决策分析方法是按照最好的货币期望值选择方案,但在决策 分析中除了要考虑方案的货币益损因素以外,还要考虑风险程度,包括决策 人对待风险的态度这一主观偏好因素。因而,往往单从货币益损期望值选择 的方案,不一定是最佳方案。本节将介绍决策分析中的期望效用。 所谓效用是一种特定结果的总价值的相对尺度,它反映决策者面对诸如 利润、损失和风险等因素集合的态度。

800 700

d2

d3

1220 3 1420 4

1400

500 2000

-900

首先计算出各个状态结点的期望值,从中选取一个最大期望值, 往回找对应的方案,为最佳方案,如上图,④点最大 ,选d3方案 为最佳方案。

8

§4.4 灵敏度分析

灵敏度分析是将自然状态出现的概率加以改变,来考察这一改变对决策 方案选取将带来什么样的影响。比如:高的接受程度S1的概率降到0.2, 低的接受S2的概率升为0.8,即P(S1)=0.2,P(S2)=0.8,则有: EV(d1)=0.2×800+0.8×700=720万 EV(d2)=0.2×1400+0.8×500=680万 EV(d1)=0.2×2000+0.8×(-900)=-320万 可见,小楼方案d1为最佳,大楼方案为最差的。 如果问题只涉及两种自然状态,则可以按以下方式求出各方案的临界 的自然状态概率: 设自然状态S1的概率P(S1)=P,则自然状态S2的概率P(S2)=1-P。按本问 题的益损矩阵,可算得: EV(d1)=P×800+(1-P)×700=100P+700 EV(d2)=900P+500 EV(d3)=2900P-900

d1 →1200万 d2 →600万←Min d3 →1600万

6

s2 700-700=0 700-500=200 700-(-900)=1600

2000-800=1200 2000-1400=600 2000-2000=0

再分别对各方案,从不同自然状态的后悔值中取一最大者,得到:

然后从各方案的最大后悔值中选取一最小者,为600万,则它对应的方案 d2为最佳方案。

可见,方案d3建大楼为最佳方案。

7

为了较形象直观地作出决策,也可应用决策树方式进行分析,决策树 由结点和树枝构成: 决策结点用□表示,由它生出方案枝;各方案枝分别生出状态结点,用○ 表示,由状态结点引出各种状态分枝,分枝末梢绘上相应的益损值。对本 问题有:

780

2 d1 1

s1 , P( S1 ) 0.8 s 2 , P( S 2 ) 0.2 s1 , P( S1 ) 0.8 s 2 , P( S 2 ) 0.2 s1 , P( S1 ) 0.8 s 2 , P( S 2 ) 0.2

P( S i | I K ) P( S i ) P( I K | S i )

P( S ) P( I

i 1 i

n

K

| Si )

I=1,2,…..n, k=1,2,…,m

按以上数据,可算得其后验概率为:

有兴趣(支持)买楼者I1的有关概率计算表