摄像头采集的图像代码

双目视觉 opencv 代码

双目视觉 opencv 代码双目视觉是指利用两个摄像头来获取场景的深度信息。

在OpenCV中,可以使用双目视觉进行立体视觉的处理。

下面我将从多个角度介绍如何使用OpenCV来实现双目视觉的代码。

1. 初始化摄像头:首先,你需要初始化两个摄像头,可以使用OpenCV的VideoCapture类来实现。

你可以通过以下代码来初始化两个摄像头:cv::VideoCapture cap1(0); // 打开第一个摄像头。

cv::VideoCapture cap2(1); // 打开第二个摄像头。

2. 获取图像:接下来,你需要从两个摄像头中获取图像。

你可以使用以下代码来获取图像:cv::Mat frame1, frame2;cap1 >> frame1; // 从第一个摄像头获取图像。

cap2 >> frame2; // 从第二个摄像头获取图像。

3. 立体校正:在进行立体视觉处理之前,通常需要进行立体校正,以确保两个摄像头的图像对齐。

你可以使用OpenCV中的stereoRectify和initUndistortRectifyMap函数来实现立体校正。

4. 视差计算:一旦完成立体校正,你可以使用OpenCV中的StereoBM或StereoSGBM类来计算图像的视差。

这些类实现了不同的立体匹配算法,可以帮助你计算出图像中不同像素的视差值。

5. 三维重构:最后,你可以使用视差图和立体校正参数来进行三维重构,从而获取场景的深度信息。

你可以使用reprojectImageTo3D函数来实现三维重构。

以上是使用OpenCV实现双目视觉的基本步骤和代码示例。

当然,双目视觉涉及到的内容非常广泛,包括摄像头标定、深度图像的可视化等等,还有很多细节需要考虑。

希望以上内容能够帮助你入门双目视觉的代码实现。

摄像头编码方式

摄像头编码方式在如今网络普及的时代,越来越多的摄像头被应用在各种场合中。

而一个好的视频监控系统不仅要求摄像头本身画面的清晰度,更需要考虑数据的传输和存储问题。

其中编码方式就显得尤为关键。

在摄像头传输数据过程中,首先需要将图像以数字信号的形式进行采样和量化,即编码。

编码方式的不同会影响画面质量、数据大小和传输速度,因此在选择摄像头和监控系统时需要根据实际情况进行选择。

常见的编码方式有MJPEG、H.264、H.265等,下面将分别介绍它们的特点。

MJPEG(Motion JPEG)MJPEG是一种基于JPEG格式的视频编码方式,它采用每帧图像单独压缩的方式,画质相对较好,适用于在带宽充足的局域网中传输。

但是,由于每帧图像单独压缩,因此数据大小会比较大,传输速度相对较慢。

对于需要实时监控的场合来说,MJPEG不是很理想的选择。

但是,对于需要高画质图像或需要识别细节的应用场合来说,MJPEG则是一个较好的选择。

H.264H.264是目前应用最为广泛的视频编码标准之一。

它采用先预测再压缩的方式,即通过预测下一帧图像的内容来减少数据的冗余度,从而降低数据的大小。

同时,它还支持多速率编码,可以根据不同带宽和画质要求进行选择。

因此,H.264适用于带宽较低的互联网环境中传输数据。

在实时视频监控场景中,H.264具有较高的压缩比和传输速度,而且能够在保证画质的前提下保证数据的大小。

因此,大多数监控设备和应用都采用了H.264编码方式。

H.265H.265是近年来新推出的一种视频编码标准,它在H.264的基础上进行了优化。

同样采用先预测再压缩的方式,H.265可以在保证画质的同时,将数据大小进一步降低。

因此,H.265相对H.264来说,可以在同样带宽下使用更高的画质,或者在同样画质下使用更低的数据大小。

它适用于带宽较低的3G/4G网络、网络流媒体等应用场合。

目前H.265的应用还比较少,主要原因在于它需要更高的算力和带宽,而且相对H.264来说兼容性较差。

大华工业相机图像采集Python代码实现

⼤华⼯业相机图像采集Python代码实现 1#!/usr/bin/env python2# coding: utf-83'''4Created on 2017-10-2556@author:7'''89from ImageConvert import *10from MVSDK import *11import time12import numpy13import gc14from PIL import Image15from queue import Queue16# from Helper import MessageBox171819class Camera:2021def__init__(self):2223 self.g_cameraStatusUserInfo = b"statusInfo"24 self.g_Image_Grabbing_Timer = 10 # unit : s25 self.g_isStop = 026 self.connectCallBackFuncEx = connectCallBackEx(self.deviceLinkNotify)27 self.frameCallbackFuncEx = callbackFuncEx(self.onGetFrameEx)28 self.dev = None29 self.qimage = Queue(maxsize=0)30 erInfo = b"test"31# self.messagebox = MessageBox()3233def onGetFrameEx(self, frame, userInfo):34""" 取流回调函数Ex """35if (self.g_isStop == 1):36return3738 nRet = frame.contents.valid(frame)39if (nRet != 0):40print("frame is invalid!")41# 释放驱动图像缓存资源42 frame.contents.release(frame)43return4445print("BlockId = {}".format(str(frame.contents.getBlockId(frame))))4647#此处客户应⽤程序应将图像拷贝出使⽤48# 给转码所需的参数赋值49 imageParams = IMGCNV_SOpenParam()50 imageParams.dataSize = frame.contents.getImageSize(frame)51 imageParams.height = frame.contents.getImageHeight(frame)52 imageParams.width = frame.contents.getImageWidth(frame)53 imageParams.paddingX = frame.contents.getImagePaddingX(frame)54 imageParams.paddingY = frame.contents.getImagePaddingY(frame)55 imageParams.pixelForamt = frame.contents.getImagePixelFormat(frame)5657# 将裸数据图像拷出58 imageBuff = frame.contents.getImage(frame)59 userBuff = c_buffer(b'\0', imageParams.dataSize)60 memmove(userBuff, c_char_p(imageBuff), imageParams.dataSize)6162# 释放驱动图像缓存资源63 frame.contents.release(frame)6465# 如果图像格式是 Mono8 直接使⽤66if imageParams.pixelForamt == EPixelType.gvspPixelMono8:67 grayByteArray = bytearray(userBuff)68 cvImage = numpy.array(grayByteArray).reshape(imageParams.height, imageParams.width)69else:70# 转码 => BGR2471 rgbSize = c_int()72 rgbBuff = c_buffer(b'\0', imageParams.height * imageParams.width * 3)7374 nRet = IMGCNV_ConvertToBGR24(cast(userBuff, c_void_p), \75 byref(imageParams), \76 cast(rgbBuff, c_void_p), \77 byref(rgbSize))7879 colorByteArray = bytearray(rgbBuff)8182 img = Image.fromarray(cvImage)83 self.qimage.put(img)84 gc.collect()8586def deviceLinkNotify(self, connectArg, linkInfo):87""" 相机连接状态回调函数 """88if ( EVType.offLine == connectArg.contents.m_event ):89print("camera has off line, userInfo [%s]" %(c_char_p(linkInfo).value))90elif ( EVType.onLine == connectArg.contents.m_event ):91print("camera has on line, userInfo [%s]" %(c_char_p(linkInfo).value))9293def subscribeCameraStatus(self, camera):94""" 注册相机连接状态回调注册上下线通知"""95 eventSubscribe = pointer(GENICAM_EventSubscribe())96 eventSubscribeInfo = GENICAM_EventSubscribeInfo()97 eventSubscribeInfo.pCamera = pointer(camera)98 nRet = GENICAM_createEventSubscribe(byref(eventSubscribeInfo), byref(eventSubscribe))99if ( nRet != 0):100print("create eventSubscribe fail!")101return -1102103 nRet = eventSubscribe.contents.subscribeConnectArgsEx(eventSubscribe, self.connectCallBackFuncEx, self.g_cameraStatusUserInfo) 104if ( nRet != 0 ):105print("subscribeConnectArgsEx fail!")106# 释放相关资源107 eventSubscribe.contents.release(eventSubscribe)108return -1109110# 不再使⽤时,需释放相关资源111 eventSubscribe.contents.release(eventSubscribe)112return 0113114def unsubscribeCameraStatus(self, camera):115"""反注册相机连接状态回调反注册上下线通知"""116 eventSubscribe = pointer(GENICAM_EventSubscribe())117 eventSubscribeInfo = GENICAM_EventSubscribeInfo()118 eventSubscribeInfo.pCamera = pointer(camera)119 nRet = GENICAM_createEventSubscribe(byref(eventSubscribeInfo), byref(eventSubscribe))120if ( nRet != 0):121print("create eventSubscribe fail!")122return -1123124 nRet = eventSubscribe.contents.unsubscribeConnectArgsEx(eventSubscribe, self.connectCallBackFuncEx, self.g_cameraStatusUserInfo) 125if ( nRet != 0 ):126print("unsubscribeConnectArgsEx fail!")127# 释放相关资源128 eventSubscribe.contents.release(eventSubscribe)129return -1130131# 不再使⽤时,需释放相关资源132 eventSubscribe.contents.release(eventSubscribe)133return 0134135def setSoftTriggerConf(self):136"""设置软触发"""137if self.dev is None:138print("camera is None!")139return -1140141# 创建control节点142 acqCtrlInfo = GENICAM_AcquisitionControlInfo()143 acqCtrlInfo.pCamera = pointer(self.dev)144 acqCtrl = pointer(GENICAM_AcquisitionControl())145 nRet = GENICAM_createAcquisitionControl(pointer(acqCtrlInfo), byref(acqCtrl))146if ( nRet != 0 ):147print("create AcquisitionControl fail!")148return -1149150# 设置触发源为软触发151 trigSourceEnumNode = acqCtrl.contents.triggerSource(acqCtrl)152 nRet = trigSourceEnumNode.setValueBySymbol(byref(trigSourceEnumNode), b"Software")153if ( nRet != 0 ):154print("set TriggerSource value [Software] fail!")155# 释放相关资源156 trigSourceEnumNode.release(byref(trigSourceEnumNode))157 acqCtrl.contents.release(acqCtrl)158return -1159160# 需要释放Node资源161 trigSourceEnumNode.release(byref(trigSourceEnumNode))162163# 设置触发⽅式165 nRet = trigSelectorEnumNode.setValueBySymbol(byref(trigSelectorEnumNode), b"FrameStart")166if ( nRet != 0 ):167print("set TriggerSelector value [FrameStart] fail!")168# 释放相关资源169 trigSelectorEnumNode.release(byref(trigSelectorEnumNode))170 acqCtrl.contents.release(acqCtrl)171return -1172173# 需要释放Node资源174 trigSelectorEnumNode.release(byref(trigSelectorEnumNode))175176# 打开触发模式177 trigModeEnumNode = acqCtrl.contents.triggerMode(acqCtrl)178 nRet = trigModeEnumNode.setValueBySymbol(byref(trigModeEnumNode), b"On")179if ( nRet != 0 ):180print("set TriggerMode value [On] fail!")181# 释放相关资源182 trigModeEnumNode.release(byref(trigModeEnumNode))183 acqCtrl.contents.release(acqCtrl)184return -1185186# 需要释放相关资源187 trigModeEnumNode.release(byref(trigModeEnumNode))188 acqCtrl.contents.release(acqCtrl)189return 0190191def grabContinue(self):192"""⾃由拉流"""193if self.dev is None:194print("camera is None!")195return -1196197# 创建流对象198 streamSourceInfo = GENICAM_StreamSourceInfo()199 streamSourceInfo.channelId = 0200 streamSourceInfo.pCamera = pointer(self.dev)201202 streamSource = pointer(GENICAM_StreamSource())203 nRet = GENICAM_createStreamSource(pointer(streamSourceInfo), byref(streamSource))204if (nRet != 0):205print("create StreamSource fail!")206return -1207208# 通⽤属性设置:设置触发模式为off --根据属性类型,直接构造属性节点。

python海康相机拍照控制实例

python海康相机拍照控制实例海康相机是一种高性能的相机设备,它具有拍照控制的功能,可以通过编程语言Python来实现这一功能。

在本文中,我将为您介绍如何使用Python控制海康相机进行拍照。

我们需要安装海康相机的Python SDK,这个SDK提供了与相机通信的接口和方法。

可以通过在终端中运行以下命令来安装SDK:```pip install hikvisionapi```安装完成后,我们可以开始编写Python代码来实现控制相机拍照的功能。

我们需要导入相应的库:```pythonfrom hikvisionapi import Client```然后,我们需要创建一个客户端实例来连接相机:```pythonclient = Client('ip地址', '用户名', '密码')```在这里,我们需要将ip地址、用户名和密码替换为实际的相机信息。

通过这个客户端实例,我们可以与相机进行通信。

接下来,我们可以使用以下代码来控制相机进行拍照:```pythonclient.capture_picture('保存路径')```在这里,我们需要将保存路径替换为希望保存照片的路径。

通过这个方法,相机会拍摄一张照片并保存到指定的路径中。

我们需要关闭客户端连接:```pythonclient.close()```通过这个方法,我们可以断开与相机的连接。

以上就是使用Python控制海康相机进行拍照的实例。

通过安装SDK,创建客户端实例,调用拍照方法,并关闭连接,我们可以很方便地实现对相机的控制。

这为我们在编程中应用相机拍照功能提供了很大的便利。

希望本文对您有所帮助!。

android摄像头拍照编程

android摄像头拍照编程以下是测试通过的一个android摄像头拍照编程例子,步骤如下:1.编写拍照类CameraActivitypublic class CameraActivity extends Activity {private CameraView cv;// 准备一个相机对象private Camera mCamera = null;// 准备一个Bitmap对象private Bitmap mBitmap = null;// 准备一个保存图片的PictureCallback对象public Camera.PictureCallback pictureCallback = newCamera.PictureCallback() {public void onPictureTaken(byte[] data, Camera camera) {Log.i("yao", "onPictureTaken");Toast.makeText(getApplicationContext(), "正在保存……",Toast.LENGTH_LONG).show();// 用BitmapFactory.decodeByteArray()方法可以把相机传回的裸数据转换成Bitmap对象mBitmap= BitmapFactory.decodeByteArray(data, 0, data.length);// 接下来的工作就是把Bitmap保存成一个存储卡中的文件File file = new File("/mnt/sdcard/pics/"+ new DateFormat().format("yyyyMMdd_hhmmss",Calendar.getInstance(Locale.CHINA)) + ".jpg");try {file.createNewFile();BufferedOutputStream os = new BufferedOutputStream(new FileOutputStream(file));press(pressFormat.PNG, 100, os);os.flush();os.close();Toast.makeText(getApplicationContext(), "图片保存完毕,在存储卡的pics目录",Toast.LENGTH_LONG).show();} catch (IOException e) {e.printStackTrace();}}};// Activity的创建方法@Overridepublic void onCreate(Bundle savedInstanceState) {super.onCreate(savedInstanceState);// 窗口去掉标题requestWindowFeature(Window.FEATURE_NO_TITLE);// 窗口设置为全屏getWindow().setFlags(youtParams.FLAG_FULLSCREEN, youtParams.FLAG_FULLSCREEN);// 设置窗口为半透明getWindow().setFormat(PixelFormat.TRANSLUCENT);// 提供一个框架布局FrameLayout fl = new FrameLayout(this);// 创建一个照相预览用的SurfaceView子类,并放在帧布局的底层cv = new CameraView(this);fl.addView(cv);// 创建一个文本框添加在帧布局中,我们可以看到,文字自动出现在了SurfaceView的前面,由此你可以在预览窗口做出各种特殊效果TextView tv = new TextView(this);tv.setText("请按\"相机\"按钮拍摄");fl.addView(tv);// 设置Activity的根内容视图setContentView(fl);}// 相机按键按下的事件处理方法public boolean onKeyDown(int keyCode, KeyEvent event) {Log.i("yao", "MainActivity.onKeyDown");if (keyCode == KeyEvent.KEYCODE_CAMERA) {if (mCamera != null) {Log.i("yao", "mCamera.takePicture");// 当按下相机按钮时,执行相机对象的takePicture()方法,该方法有三个回调对象做入参,不需要的时候可以设nullmCamera.takePicture(null, null, pictureCallback);}}return cv.onKeyDown(keyCode, event);}class CameraView extends SurfaceView implements SurfaceHolder.Callback {private SurfaceHolder holder = null;// 构造函数public CameraView(Context context) {super(context);Log.i("yao", "CameraView");// 操作surface的holderholder = this.getHolder();// 创建SurfaceHolder.Callback对象holder.addCallback(this);// 设置Push缓冲类型,说明surface数据由其他来源提供,而不是用自己的Canvas来绘图,在这里是由摄像头来提供数据holder.setType(SurfaceHolder.SURFACE_TYPE_PUSH_BUFFERS);}@Overridepublic void surfaceDestroyed(SurfaceHolder holder) {// 停止预览mCamera.stopPreview();// 释放相机资源并置空mCamera.release();mCamera = null;}@Overridepublic void surfaceCreated(SurfaceHolder holder) {// 当预览视图创建的时候开启相机mCamera = Camera.open();try {// 设置预览mCamera.setPreviewDisplay(holder);} catch (IOException e) {// 释放相机资源并置空mCamera.release();mCamera = null;}}// 当surface视图数据发生变化时,处理预览信息@Overridepublic void surfaceChanged(SurfaceHolder holder, int format, int width,int height) {// 获得相机参数对象Camera.Parameters parameters = mCamera.getParameters();// 设置格式parameters.setPictureFormat(PixelFormat.JPEG);// 设置预览大小,这里我的测试机是Milsstone所以设置的是854x480parameters.setPreviewSize(854, 480);// 设置自动对焦parameters.setFocusMode("auto");// 设置图片保存时的分辨率大小parameters.setPictureSize(2592, 1456);// 给相机对象设置刚才设定的参数mCamera.setParameters(parameters);// 开始预览mCamera.startPreview();}}@Overridepublic boolean onCreateOptionsMenu(Menu menu) {this.getMenuInflater().inflate(R.menu.camera_menu, menu);return super.onCreateOptionsMenu(menu);}@Overridepublic boolean onOptionsItemSelected(MenuItem item) {if (item.getItemId() == R.id.takePhotoItem) {if (mCamera != null) {Log.i("yao", "mCamera.takePicture");// 当按下相机按钮时,执行相机对象的takePicture()方法,该方法有三个回调对象做入参,不需要的时候可以设nullmCamera.takePicture(null, null, pictureCallback);}} else if (item.getItemId() == R.id.queryPhotoItem) {Intent intent = new Intent(this, BrowserPhotoActivity.class);this.startActivity(intent);} else if (item.getItemId() == R.id.stopPhotoItem) {// 停止预览mCamera.stopPreview();// 释放相机资源并置空mCamera.release();mCamera = null;}return super.onOptionsItemSelected(item);}}2.编写相应的菜单文件res/menu/camera_menu.xml当用户单击menu按钮时,会弹出操作菜单,有拍照、停止预览、浏览相片等功能<?xml version="1.0"encoding="utf-8"?><menu xmlns:android="/apk/res/android">android:id="@+id/takePhotoItem"android:title="拍照"></item><itemandroid:id="@+id/stopPhotoItem"android:title="停止预览"></item><itemandroid:id="@+id/queryPhotoItem"android:title="浏览相片"></item></menu>3.编写浏览相片的布局文件res/layout/browserphoto.xml<?xml version="1.0"encoding="utf-8"?><LinearLayout xmlns:android="/apk/res/android"android:layout_width="match_parent"android:layout_height="match_parent"android:orientation="vertical"><GridViewandroid:id="@+id/photoGridView"android:layout_width="match_parent"android:layout_height="wrap_content"android:numColumns="3"></GridView></LinearLayout>4.编写浏览相片类BrowserPhotoActivity.javapublic class BrowserPhotoActivity extends Activity implements OnItemClickListener{private GridView photoGridView;private String picBaseDir = "/mnt/sdcard/pics/";private String[] pics; //存放所有图片文件public void onCreate(Bundle savedInstanceState) {super.onCreate(savedInstanceState);this.setContentView(yout.browserphoto);loadView();}private void loadView(){photoGridView = (GridView)this.findViewById(R.id.photoGridView);File file = new File(picBaseDir);pics = file.list();photoGridView.setAdapter(new ImageAdapter());photoGridView.setOnItemClickListener(this);}class ImageAdapter extends BaseAdapter{@Overridepublic int getCount() {// TODO Auto-generated method stubreturn pics.length;}@Overridepublic Object getItem(int position) {// TODO Auto-generated method stubreturn null;}@Overridepublic long getItemId(int position) {// TODO Auto-generated method stubreturn 0;}@Overridepublic View getView(int position, View convertView, ViewGroup parent) {String filePath = picBaseDir+pics[position];Bitmap bitmap = BitmapFactory.decodeFile(filePath);bitmap = ImageUtil.zoomBitmap(bitmap, bitmap.getWidth()/2, bitmap.getHeight()/2);ImageView imageView = new ImageView(BrowserPhotoActivity.this);imageView.setImageBitmap(bitmap);imageView.setLayoutParams(newyoutParams(80,60));return imageView;}}@Overridepublic void onItemClick(AdapterView<?> parent, View view, int position, long id) {// TODO Auto-generated method stubAlertDialog.Builder dialog = new AlertDialog.Builder(this);dialog.setTitle("查看图片");View dialogView =LayoutInflater.from(this).inflate(yout.photodialog, null);String filePath = picBaseDir+pics[position];Bitmap bitmap = BitmapFactory.decodeFile(filePath);bitmap = ImageUtil.zoomBitmap(bitmap,bitmap.getWidth()*2,bitmap.getHeight()*2);ImageView imageView =(ImageView)dialogView.findViewById(R.id.photoImageView);imageView.setImageBitmap(bitmap);dialog.setView(dialogView);dialog.setPositiveButton("返回", null);dialog.show();}}5.编写浏览单张相片对话框布局文件res/layout/photodialog.xml<?xml version="1.0"encoding="utf-8"?><LinearLayout xmlns:android="/apk/res/android"android:layout_width="match_parent"android:layout_height="match_parent"android:orientation="vertical"><ImageViewandroid:id="@+id/photoImageView"android:layout_width="wrap_content"android:layout_height="wrap_content"android:src="@drawable/bg"/></LinearLayout>。

Java实现海康摄像头抓拍图像Windows、Linux

Java实现海康摄像头抓拍图像Windows、Linux先抱怨⼀下,打死都想不到,海康的摄像头SDK居然是⼀个Java类,还有必须的两个jar包(jna.jar,examples.jar)。

⿁能想得到会这么命名。

下⾯开始吧。

Windows1. 把从官⽹下载的SDK(和当前系统对应)解压,把库⽂件整个拷贝到某个⽬录(我是D:\hik\libs),然后把D:\hik\libs和D:\hik\libs\HCNetSDKCom加⼊到系统环境变量path中。

可以尝试从代码中把这两个⽂件夹加⼊path,我没有试成功。

2. 项⽬引⼊jna.jar和examples.jar这两个jar包。

注意:⼀定要⽤官⽹SDK⾥⾯的,千万不要⽤其他版本的jna。

3. 从ClientDemo中把HCNetSDK.java拷贝到⾃⼰的项⽬中(这就是神奇的SDK)。

4. 开始主体,Java代码:public class CameraManager {private static Logger logger = LoggerFactory.getLogger(CameraManager.class);private static HCNetSDK sdk = HCNetSDK.INSTANCE;private static NativeLong userId = new NativeLong(-1);//⽤户登录ID,值为0,1,2...private static NativeLong startChan = new NativeLong(-1); // start channel numberprivate void login(String ip, short port, String username, String pwd){//sdk初始化if (!_DVR_Init()){logger.error("海康SDK初始化失败!" + _DVR_GetLastError());}//注册设备NET_DVR_DEVICEINFO_V30 deviceInfo = new NET_DVR_DEVICEINFO_V30();//登录userId = _DVR_Login_V30(ip, port, username, pwd, deviceInfo);if (userId.intValue() < 0){logger.error("摄像头⽤户登录失败!Err:" + _DVR_GetLastError());}startChan.setValue(deviceInfo.byStartChan);}public boolean takePic(String ip, short port, String username, String pwd) {if (userId.intValue() < 0 || startChan.intValue() < 0) {("执⾏海康摄像机登录,ip[{}],port[{}],username[{}].",ip,port,username);login(ip,port,username,pwd);}("准备拍照,userId:[{}],startChan:[{}]",userId.intValue(),startChan.intValue());//拍照NET_DVR_JPEGPARA strJpeg = new NET_DVR_JPEGPARA();strJpeg.wPicQuality = 1; //图像参数strJpeg.wPicSize = 2;String filePath = "E:\\123q.jpg";boolean b = _DVR_CaptureJPEGPicture(userId, startChan, strJpeg, filePath);//尝试⽤NET_DVR_CaptureJPEGPicture_NEW⽅法,但不是报43就是JDK崩溃.... if(!b){//单帧数据捕获图⽚System.out.println("抓拍失败!" + " err: " + _DVR_GetLastError());}else{System.out.println("抓拍成功");}return b;}public void logout(){_DVR_Logout(userId);_DVR_Cleanup();}}5. 完成。

人脸识别算法代码

人脸识别算法的实现涉及多个步骤,包括图像采集、预处理、特征提取和匹配等。

这里,我将给出一个使用Python和OpenCV库进行人脸识别的简单示例。

这个示例将使用Haar Cascade分类器进行人脸检测和识别。

首先,你需要安装必要的库:```bashpip install opencv-pythonpip install numpy```然后,你可以使用以下代码进行人脸识别:```pythonimport cv2# 加载Haar Cascade分类器face_cascade = cv2.CascadeClassifier(cv2.data.haarcascades + 'haarcascade_frontalface_default.xml')# 打开摄像头cap = cv2.VideoCapture(0)while True:# 从摄像头读取一帧图像ret, img = cap.read()if not ret:break# 将图像转换为灰度图像gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)# 使用Haar Cascade分类器检测人脸faces = face_cascade.detectMultiScale(gray, 1.3, 5)# 在检测到的人脸周围画矩形框for (x, y, w, h) in faces:cv2.rectangle(img, (x, y), (x+w, y+h), (255, 0, 0), 2)# 显示图像cv2.imshow('img', img)if cv2.waitKey(1) & 0xFF == ord('q'):break# 释放摄像头并关闭所有窗口cap.release()cv2.destroyAllWindows()```这个代码将打开你的摄像头,并在检测到的人脸周围画矩形框。

摄像头采集的图像代码

for (var x:Number = _array.length-1; x>=0; x--) {

for (var y:Number = _array[x].length-1; y>=0; y--) {

var _BMP:BitmapData = new BitmapData(160, 120, true, 0xfff000);

var cam_func:Function = function () {

_BMP.draw(_video);

photo_mc.attachBitmap(_BMP, 3, "always", true);

if (success) {

name_array = [];

name_array = _asp.split("|");

addItem_func(name_array);

setTimeout(function () {

in_txt.text = "";

show_txt.text = "";

_video.attachVideo(_cam);

//==========收集图像数据并显示========

var photo_mc:MovieClip = this.createEmptyMovieClip("photo_mc", 2);

photo_mc._x = 200;

photo_mc._y = 10;

var showbmp_lvoadVars = new LoadVars();

iOS实现摄像头实时采集图像

iOS实现摄像头实时采集图像本⽂实例为⼤家分享了iOS实现摄像头实时采集图像的具体代码,供⼤家参考,具体内容如下新接到⼀个实时获取摄像头当前照⽚的需求,在设定的时间内需要保持摄像头处在开启状态并可以实时回调到当前的图⽚数据信息;此次结合 AVCaptureDevice、AVCaptureSession、AVCaptureVideoPreviewLayer 将其与 UIView、UIImageView 和 UIImage 相结合;具体实现 code 如下:#import <UIKit/UIKit.h>#import <CoreVideo/CoreVideo.h>#import <CoreMedia/CoreMedia.h>#import <AVFoundation/AVFoundation.h>NS_ASSUME_NONNULL_BEGIN@interface YHCameraView : UIView <AVCaptureVideoDataOutputSampleBufferDelegate>@property (nonatomic, weak) UIImageView *cameraImageView;@property (strong, nonatomic) AVCaptureDevice* device;@property (strong, nonatomic) AVCaptureSession* captureSession;@property (strong, nonatomic) AVCaptureVideoPreviewLayer* previewLayer;@property (strong, nonatomic) UIImage* cameraImage;@endNS_ASSUME_NONNULL_END#import "YHCameraView.h"@implementation YHCameraView- (instancetype)initWithFrame:(CGRect)frame {if (self = [super initWithFrame:frame]) {self.backgroundColor = [UIColor lightGrayColor];[self createUI];}return self;}/*// Only override drawRect: if you perform custom drawing.// An empty implementation adversely affects performance during animation.- (void)drawRect:(CGRect)rect {// Drawing code}*/- (void)createUI {NSArray* devices = [AVCaptureDevice devicesWithMediaType:AVMediaTypeVideo];for(AVCaptureDevice *device in devices){if([device position] == AVCaptureDevicePositionFront) // 前置摄像头self.device = device;}AVCaptureDeviceInput* input = [AVCaptureDeviceInput deviceInputWithDevice:self.device error:nil];AVCaptureVideoDataOutput* output = [[AVCaptureVideoDataOutput alloc] init];output.alwaysDiscardsLateVideoFrames = YES;dispatch_queue_t queue;queue = dispatch_queue_create("cameraQueue", NULL);[output setSampleBufferDelegate:self queue:queue];NSString* key = (NSString *) kCVPixelBufferPixelFormatTypeKey;NSNumber* value = [NSNumber numberWithUnsignedInt:kCVPixelFormatType_32BGRA];NSDictionary* videoSettings = [NSDictionary dictionaryWithObject:value forKey:key];[output setVideoSettings:videoSettings];self.captureSession = [[AVCaptureSession alloc] init];[self.captureSession addInput:input];[self.captureSession addOutput:output];[self.captureSession setSessionPreset:AVCaptureSessionPresetPhoto];self.previewLayer = [AVCaptureVideoPreviewLayer layerWithSession:self.captureSession];self.previewLayer.videoGravity = AVLayerVideoGravityResizeAspectFill;// CHECK FOR YOUR APPNSInteger screenWidth = self.frame.size.width;NSInteger screenHeitht = self.frame.size.height;self.previewLayer.frame = self.bounds;self.previewLayer.orientation = AVCaptureVideoOrientationPortrait;// CHECK FOR YOUR APP// [yer insertSublayer:self.previewLayer atIndex:0]; // Comment-out to hide preview layer[self.captureSession startRunning];}- (void)captureOutput:(AVCaptureOutput *)captureOutput didOutputSampleBuffer:(CMSampleBufferRef)sampleBuffer fromConnection:(AVCaptureConnection *)connection{CVImageBufferRef imageBuffer = CMSampleBufferGetImageBuffer(sampleBuffer);CVPixelBufferLockBaseAddress(imageBuffer, 0);uint8_t *baseAddress = (uint8_t *)CVPixelBufferGetBaseAddress(imageBuffer);size_t bytesPerRow = CVPixelBufferGetBytesPerRow(imageBuffer);size_t width = CVPixelBufferGetWidth(imageBuffer);size_t height = CVPixelBufferGetHeight(imageBuffer);CGColorSpaceRef colorSpace = CGColorSpaceCreateDeviceRGB();CGContextRef newContext = CGBitmapContextCreate(baseAddress, width, height, 8, bytesPerRow, colorSpace, kCGBitmapByteOrder32Little | kCGImageAlphaPremultipliedFirst); CGImageRef newImage = CGBitmapContextCreateImage(newContext);CGContextRelease(newContext);CGColorSpaceRelease(colorSpace);self.cameraImage = [UIImage imageWithCGImage:newImage scale:1.0f orientation:UIImageOrientationLeftMirrored]; // UIImageOrientationDownMirroredself.cameraImageView.image = [UIImage imageWithCGImage:newImage scale:1.0f orientation:UIImageOrientationLeftMirrored];CGImageRelease(newImage);CVPixelBufferUnlockBaseAddress(imageBuffer, 0);}@end将其实例化后在需要的时候直接获取其 cameraView 的 cameraImage 即可;#pragma mark - 快照采集/// 快照采集- (YHCameraView *)cameraView {if (!_cameraView) {YHCameraView *view = [[YHCameraView alloc] init];view.frame = CGRectMake(1, 1, 1, 1);view.cameraImageView.image = view.cameraImage;_cameraView = view;}return _cameraView;}NSString *strImg = [YHCameraManager imageBase64EncodedWithImage:self.cameraView.cameraImageAndImageType:@"JPEG"]; // 获取照⽚信息/**图⽚转 Base64@param img 原图⽚@param type 图⽚类型(PNG 或 JPEG)@return 处理结果*/+ (NSString *)imageBase64EncodedWithImage:(UIImage *)img AndImageType:(NSString *)type {NSString *callBack = nil;if ([img isKindOfClass:[UIImage class]]) {NSData *data = [NSData data];if ([type isEqualToString:@"PNG"]) {data = UIImagePNGRepresentation(img);} else {data = UIImageJPEGRepresentation(img, 1.0f);}NSString *encodedImgStr = [data base64EncodedStringWithOptions:NSDataBase64Encoding64CharacterLineLength];NSLog(@"YHCameraManager\nencodedImgStr: %@", encodedImgStr);return encodedImgStr;} else {return callBack;}}以上就是本⽂的全部内容,希望对⼤家的学习有所帮助,也希望⼤家多多⽀持。

数字图像处理~图像编码

Eb = -log2(0.3) = 1.737

Ec = -log2(0.2) = 2.322

总信息量也即表达整个字符串需要的位数为:

E = Ea * 5 + Eb * 3 + Ec * 2 = 14.855 位

举例说明:

如果用二进制等长编码,需要多少位?

数据压缩技术的理论基础是信息论。

2.信息量和信息熵

A

B

数据压缩的基本途径

数据压缩的理论极限

信息论中信源编码理论解决的主要问题:

信息量等于数据量与冗余量之差

I = D - du

数据是用来记录和传送信息的,或者说数据

是信息的载体。

数据所携带的信息。

信息量与数据量的关系:

du—冗余量

I— 信息量

D— 数据量

叁

实时传输:在10M带宽网上实时传输的话,需要压缩到原来数据量的?

肆

存储: 1张CD可存640M,如果不进行压缩,1张CD则仅可以存放?秒的数据

伍

可见,单纯依靠增加存储器容量和改善信道带宽无法满足需求,必须进行压缩

1 图像编码概述

数字化后的图像信息数据量非常大,图像压缩利用图像数据存在冗余信息,去掉这些冗余信息后可以有效压缩图像。

01.

02.

03.

04.

问题:

把某地区天气预报的内容看作一个信源,它有6种可能的天气:晴天(概率为0.30)、阴天(概率为0.20)、多云(概率为0.15)、雨天(概率为0.13)、大雾(概率为0.12)和下雪(概率为0.10),如何用霍夫曼编码对其进行编码?平均码长分别是多少?

哈夫曼编码

30

10

通过摄像头设备采集一帧数据的例子程序(完整版)

#include <stdio.h>#include <stdlib.h>#include <string.h>#include <assert.h>#include <getopt.h>#include <fcntl.h>#include <unistd.h>#include <errno.h>#include <malloc.h>#include <sys/stat.h>#include <sys/types.h>#include <sys/time.h>#include <sys/mman.h>#include <sys/ioctl.h>#include <asm/types.h>#include <linux/videodev2.h>#define VIDEO_WIDTH 640 #define VIDEO_HEIGHT 480 #define BUFFER_COUNT 4#define CLEAR(x) memset (&(x), 0, sizeof (x))struct buffer {void * start; //记录缓冲帧地址size_t length; //一帧的大小};//pic process---------------------------------------------------------------------------------------------------------#pragma pack(1)typedef struct BITMAPFILEHEADER{unsigned short bfType;//位图文件的类型,unsigned long bfSize;//位图文件的大小,以字节为单位unsigned short bfReserved1;//位图文件保留字,必须为0unsigned short bfReserved2;//同上unsigned long bfOffBits;//位图阵列的起始位置,以相对于位图文件或者说是头的偏移量表示,以字节为单位} BITMAPFILEHEADER;#pragma pack()typedef struct BITMAPINFOHEADER{//位图信息头类型的数据结构,用于说明位图的尺寸unsigned long biSize;//位图信息头的长度,以字节为单位unsigned long biWidth;//位图的宽度,以像素为单位unsigned long biHeight;//位图的高度,以像素为单位unsigned short biPlanes;//目标设备的级别,必须为1unsigned short biBitCount;//每个像素所需的位数,必须是1(单色),4(16色),8(256色)或24(2^24色)之一unsigned long biCompression;//位图的压缩类型,必须是0-不压缩,1-BI_RLE8压缩类型或2-BI_RLE4压缩类型之一unsigned long biSizeImage;//位图大小,以字节为单位unsigned long biXPelsPerMeter;//位图目标设备水平分辨率,以每米像素数为单位unsigned long biYPelsPerMeter;//位图目标设备垂直分辨率,以每米像素数为单位unsigned long biClrUsed;//位图实际使用的颜色表中的颜色变址数unsigned long biClrImportant;//位图显示过程中被认为重要颜色的变址数} BITMAPINFOHEADER;void create_bmp_header(struct BITMAPFILEHEADER * bfh,struct BITMAPINFOHEADER * bih){bfh->bfType = (unsigned short)0x4D42;bfh->bfSize = (unsigned long)(14 + 40 + VIDEO_WIDTH * VIDEO_HEIGHT*3);bfh->bfReserved1 = 0;bfh->bfReserved2 = 0;bfh->bfOffBits = (unsigned long)(14 + 40);bih->biBitCount = 24;bih->biWidth = VIDEO_WIDTH;bih->biHeight = VIDEO_HEIGHT;bih->biSizeImage = VIDEO_WIDTH * VIDEO_HEIGHT * 3;bih->biClrImportant = 0;bih->biClrUsed = 0;bih->biCompression = 0;bih->biPlanes = 1;bih->biSize = 40;//sizeof(bih);bih->biXPelsPerMeter = 0x00000ec4;bih->biYPelsPerMeter = 0x00000ec4;printf("----create bmp header successfully !----\n");}void store_bmp(FILE * fd,char * file_name,unsigned char * newBuf,int bmp_len,struct BITMAPFILEHEADER * bfh,struct BITMAPINFOHEADER * bih){fd = fopen(file_name, "wb");if (fd < 0) {printf("open frame data file failed\n");return;}fwrite(bfh,sizeof(*bfh),1,fd);fwrite(bih,sizeof(*bih),1,fd);fwrite(newBuf, 1, bmp_len, fd);fclose(fd);printf("----store bmp successfuylly ,bmp name is : %s----\n", file_name);return;}/** YUYV 转RGB 算法*/void yuyv2rgb(unsigned int index, struct buffer * buffers,unsigned char * newBuf){unsigned char YUYV[4],RGB[6];int j,k,i;unsigned int location = 0;unsigned char * starter;starter = (unsigned char *)buffers[index].start; /* starter 代表当前数据帧在用户空间的首地址*/ j=0;for(i=0;i < buffers[index].length;i+=4){YUYV[0]=starter[i];//Y0YUYV[1]=starter[i+1];//UYUYV[2]=starter[i+2];//Y1YUYV[3]=starter[i+3];//Vif(YUYV[0]<1){RGB[0]=0;RGB[1]=0;RGB[2]=0;}else{RGB[0]=YUYV[0]+1.772*(YUYV[1]-128);//bRGB[1]=YUYV[0]-0.34413*(YUYV[1]-128)-0.71414*(YUYV[3]-128);//gRGB[2]=YUYV[0]+1.402*(YUYV[3]-128);//r}if(YUYV[2]<0){RGB[3]=0;RGB[4]=0;RGB[5]=0;}else{RGB[3]=YUYV[2]+1.772*(YUYV[1]-128);//bRGB[4]=YUYV[2]-0.34413*(YUYV[1]-128)-0.71414*(YUYV[3]-128);//gRGB[5]=YUYV[2]+1.402*(YUYV[3]-128);//r}for(k=0;k<6;k++){if(RGB[k]<0)RGB[k]=0;if(RGB[k]>255)RGB[k]=255;}//请记住:扫描行在位图文件中是反向存储的!if(j%(VIDEO_WIDTH*3)==0){//定位存储位置location=(VIDEO_HEIGHT-j/(VIDEO_WIDTH*3))*(VIDEO_WIDTH*3);}bcopy(RGB,newBuf+location+(j%(VIDEO_WIDTH*3)),sizeof(RGB));j+=6;}printf("---- yuyv 2 rgb CHANGE DONE ! ----");return;}/**去噪算法*/void move_noise(unsigned char * newBuf){//双滤波器int i,j,k,temp[3],temp1[3];unsigned char BGR[13*3];unsigned int sq,sq1,loc,loc1;int h=VIDEO_HEIGHT,w=VIDEO_WIDTH;for(i=2;i<h-2;i++){for(j=2;j<w-2;j++){memcpy(BGR,newBuf+(i-1)*w*3+3*(j-1),9);memcpy(BGR+9,newBuf+i*w*3+3*(j-1),9);memcpy(BGR+18,newBuf+(i+1)*w*3+3*(j-1),9);memcpy(BGR+27,newBuf+(i-2)*w*3+3*j,3);memcpy(BGR+30,newBuf+(i+2)*w*3+3*j,3);memcpy(BGR+33,newBuf+i*w*3+3*(j-2),3);memcpy(BGR+36,newBuf+i*w*3+3*(j+2),3);memset(temp,0,4*3);for(k=0;k<9;k++){temp[0]+=BGR[k*3];temp[1]+=BGR[k*3+1];temp[2]+=BGR[k*3+2];}temp1[0]=temp[0];temp1[1]=temp[1];temp1[2]=temp[2];for(k=9;k<13;k++){temp1[0]+=BGR[k*3];temp1[1]+=BGR[k*3+1];temp1[2]+=BGR[k*3+2];}for(k=0;k<3;k++){temp[k]/=9;temp1[k]/=13;}sq=0xffffffff;loc=0;sq1=0xffffffff;loc1=0;unsigned int a;for(k=0;k<9;k++){a=abs(temp[0]-BGR[k*3])+abs(temp[1]-BGR[k*3+1])+abs(temp[2]-BGR[k*3+2]);if(a<sq){sq=a;loc=k;}}for(k=0;k<13;k++){a=abs(temp1[0]-BGR[k*3])+abs(temp1[1]-BGR[k*3+1])+abs(temp1[2]-BGR[k*3+2]);if(a<sq1){sq1=a;loc1=k;}}newBuf[i*w*3+3*j]=(unsigned char)((BGR[3*loc]+BGR[3*loc1])/2);newBuf[i*w*3+3*j+1]=(unsigned char)((BGR[3*loc+1]+BGR[3*loc1+1])/2);newBuf[i*w*3+3*j+2]=(unsigned char)((BGR[3*loc+2]+BGR[3*loc1+2])/2);/*还是有些许的噪点temp[0]=(BGR[3*loc]+BGR[3*loc1])/2;temp[1]=(BGR[3*loc+1]+BGR[3*loc1+1])/2;temp[2]=(BGR[3*loc+2]+BGR[3*loc1+2])/2;sq=abs(temp[0]-BGR[loc*3])+abs(temp[1]-BGR[loc*3+1])+abs(temp[2]-BGR[loc*3+2]);sq1=abs(temp[0]-BGR[loc1*3])+abs(temp[1]-BGR[loc1*3+1])+abs(temp[2]-BGR[loc1*3+2]);if(sq1<sq) loc=loc1;newBuf[i*w*3+3*j]=BGR[3*loc];newBuf[i*w*3+3*j+1]=BGR[3*loc+1];newBuf[i*w*3+3*j+2]=BGR[3*loc+2];*/}}printf("----move noise successfully---- !\n");return;}//end of pic process---------------------------------------------------------------------------------------------------//v4l2 -------------------------------------------------------------------------------------------------------/*查询设备能力,v4l2 规定这一步是必须(暂时这里不指定特别的功能)*/ void do_cap(int fd,struct v4l2_capability * cap ){if( ioctl(fd,VIDIOC_QUERYCAP,cap) != -1 ){printf(" 1: step1:device capbility checed succssfully\n");return;}exit(EXIT_FAILURE);}/*规定设备帧捕获格式的信息*/void init_fmt(struct v4l2_format * fmt){CLEAR(*fmt);fmt->type = V4L2_BUF_TYPE_VIDEO_CAPTURE;fmt->fmt.pix.width = VIDEO_WIDTH;fmt->fmt.pix.height = VIDEO_HEIGHT;fmt->fmt.pix.pixelformat = V4L2_PIX_FMT_YUYV;fmt->fmt.pix.field = V4L2_FIELD_INTERLACED;return;}/*设置设备帧捕获格式*/void do_set_fmt(int fd,struct v4l2_format * fmt){if(ioctl(fd,VIDIOC_S_FMT,fmt) != -1){printf(" 2: Set devic format succssfully\n");return;}exit(EXIT_FAILURE);}/*初始化缓冲帧请求表单*/void init_req(struct v4l2_requestbuffers * req){;CLEAR(*req);req->count = BUFFER_COUNT;req->type = V4L2_BUF_TYPE_VIDEO_CAPTURE; req->memory = V4L2_MEMORY_MMAP;}/**发送命令申请缓冲帧*/void do_reqBuf(int fd,struct v4l2_requestbuffers * req ){if(ioctl(fd,VIDIOC_REQBUFS,req) != -1){printf(" 3: request buffers successfully \n");return;}exit(EXIT_FAILURE);}/**获得驱动开辟的缓冲区的物理地址,并将此地址映射到用户空间可用的虚拟地址*/void process_bufferAddr(int fd,int num, struct buffer * buffers){int i;for (i = 0; i < num; ++i){struct v4l2_buffer buf;CLEAR (buf);buf.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;buf.memory = V4L2_MEMORY_MMAP;buf.index = i; //记录当前帧是buffers中的第及帧if (-1 == ioctl (fd, VIDIOC_QUERYBUF, &buf)){ //获得缓冲帧的物理地址printf ("VIDIOC_QUERYBUF error\n");exit(EXIT_FAILURE);}buffers[i].length = buf.length;buffers[i].start = //将内存中缓冲帧的物理地址映射为用户空间地址mmap (NULL,buf.length,PROT_READ | PROT_WRITE ,MAP_SHARED,fd, buf.m.offset);if (MAP_FAILED == buffers[i].start){printf ("mmap failed\n");exit(EXIT_FAILURE);}}//end of forprintf(" 4: address processed successfully! \n");return;}/**操作内存中已开辟好空间的缓冲帧入队列,准备记录数据信息*/void in_queue(int fd, int num){int i;for(i = 0; i < num; ++i){struct v4l2_buffer buf; //工作数据帧,用户填好index和type字段后,传给驱动,驱动根据这些信息去处理内存中实际存在的数据帧CLEAR(buf);buf.index = i;buf.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;buf.memory = V4L2_MEMORY_MMAP;if(-1 == ioctl(fd, VIDIOC_QBUF,&buf)){printf("VIDIOC_QBUF error !\n");exit(EXIT_FAILURE);}}printf(" 5: in queue successfully !\n");return;}/**开始采集数据*/void do_capture(int fd){enum v4l2_buf_type type = V4L2_BUF_TYPE_VIDEO_CAPTURE;if( -1 == ioctl(fd,VIDIOC_STREAMON,&type)){printf("VIDIOC_STREAMON error ! \n");exit(EXIT_FAILURE);}printf(" 6: do capture successfully !\n");return;}/**将数据帧存储为jpg图片*/void save_asJpg(__u32 index, struct buffer * buffers){/*采集到的图片相关的变量*/FILE * pic_fd; //图片文件描述符unsigned long pic_length; //文件大小char * pic_fileName = "test.jpg"; //图像文件名pic_fd = fopen(pic_fileName,"wb");fwrite(buffers[index].start, buffers[index].length, 1,pic_fd);fclose(pic_fd); /*关闭文件*/printf("---- save pic as jpg successfully !----\n");return;}void save_asBmp(unsigned int index, struct buffer * buffers){FILE * bmp_fd; /*新创建的bmp文件的文件描述副*/char * bmp_name = "testBMP.bmp";unsigned char * bmpBuf; /*为了处理jpg 转bmp ,需要在内存中开辟一段工作空间*/ int bmp_len; /*bmp 图片大小*/struct BITMAPFILEHEADER bfh; /*bmp 文件结构体*/struct BITMAPINFOHEADER bih;bmp_len = buffers[index].length*3/2;bmpBuf = calloc((unsigned int)bmp_len,sizeof(unsigned char));if(!bmpBuf){printf("cannot assign the memory for bmp!\n");exit(EXIT_FAILURE);}yuyv2rgb(index,buffers,bmpBuf); /*将buffers[index]代表的jpg格式的数据转换成bmp格式*/move_noise(bmpBuf);create_bmp_header(&bfh,&bih);store_bmp(bmp_fd,bmp_name,bmpBuf,bmp_len,&bfh,&bih);}/** 将一帧放入数据缓冲队列*/int put_oneFrame_inQue(int camera_fd,struct v4l2_buffer * buf){ioctl(camera_fd,VIDIOC_QBUF,buf);return buf->index;}/**此函数由monitor_queue 函数调用,用来从设备文件中读取视频数据*/int read_frame (int camera_fd,struct buffer * buffers){struct v4l2_buffer buf;unsigned int i;CLEAR (buf);buf.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;buf.memory = V4L2_MEMORY_MMAP;ioctl (camera_fd, VIDIOC_DQBUF, &buf); /*从数据缓冲队列中取出数据帧*///assert (buf.index < num);save_asJpg(buf.index,buffers); /* 将读取到的帧存为jpg格式的图片*/ save_asBmp(buf.index,buffers);put_oneFrame_inQue(camera_fd,&buf); /*重新把帧插入队列*/printf(" 7: read frame successfully !\n");return 1;}/**监听数据队列数据帧的状态,状态发生改变(说明采集到了数据),则调用read_frame函数返回数据帧*/void monitor_queue(int fd,struct buffer * buffers){while (1){fd_set fds; //为select函数设置监听文件集,即:fds文件集合中的所有文件的状态将会被监听struct timeval tv; //设置等待超时时间int ret;FD_ZERO (&fds);FD_SET (fd, &fds);/* Timeout. */_sec = 2;_usec = 0;ret = select (fd + 1, &fds, NULL, NULL, &tv);//监听出错if (-1 == ret) {if (EINTR == errno)continue;printf ("select err\n");}//等待超时if (0 == ret) {fprintf (stderr, "select timeout\n");exit (EXIT_FAILURE);}//当ret != -1 && != 0时,则ret的值表示状态改变的文件个数if (read_frame (fd,buffers))break;}printf(" 8: do capture successfully !\n");return;}/**将mmap映射的地址空间还原*/void release_mmap_buffer(int num,struct buffer * buffers){int i;for (i = 0; i < num; ++i){if (-1 == munmap (buffers[i].start, buffers[i].length)){printf ("munmap error !\n");exit(EXIT_FAILURE);}}printf(" 9: mmap buffer released successfuly !\n");return;}/*初始化程序的上下s,然后开始视频采s*/void init_context(){/*摄像头设备相关变量*/char * camera_fileName = "/dev/video0"; // linux下摄像头设备的文件名int camera_fd = -1; // 摄像头的文件描述符/*视频采集相关变量*/struct v4l2_capability cap; //查询设备的能力struct v4l2_format fmt; //设置设备当前驱动的帧捕获格式enum v4l2_buf_type type; //定义设备的采集方式struct v4l2_requestbuffers req;struct buffer * buffers; //向系统内存申请缓冲区,用于在内存中保存数据帧信息/** 图片采集处理相关变量*/unsigned char * bmp_picBuf;int bmp_len;/*启动采集工作*///以阻塞方式打开一个设备文件camera_fd = open(camera_fileName,O_RDWR,0);//1、v4l2 规定此步必须有do_cap(camera_fd,&cap);//2、设置设备捕获数据格式init_fmt(&fmt);do_set_fmt(camera_fd,&fmt);//3、申请缓冲区init_req(&req);do_reqBuf(camera_fd,&req);//4、获得缓冲帧地址,并且将其映射到用户空间buffers = calloc (req.count, sizeof (*buffers)); //系统为为应用程序分配缓冲区,并清零process_bufferAddr(camera_fd,req.count,buffers); //处理地址问题,函数返回后,buffers中即可获得缓冲帧的虚拟地址(应用程序可操作)//5、通知驱动把内存中的数据帧入队,准备记录数据信息in_queue(camera_fd,req.count);//6、通知驱动开始视频采集do_capture(camera_fd);//7、监听数据队列,并从队列中取出数据帧monitor_queue(camera_fd,buffers);//8、图片处理//9、清场/* 解除地址映射*/release_mmap_buffer(req.count,buffers);/* 关闭设备文件*/close(camera_fd);/* 关闭图像文件*/}void main(){init_context();}---------------------作者:向浅来源:CSDN原文:https:///chance_yin/article/details/8947138 版权声明:本文为博主原创文章,转载请附上博文链接!。

摄像头图像采集程序与分析

打开摄像头:case IDM_OPENCAMERA:if(capDriverConnect(hwndCap, 0)==TRUE){capDriverGetCaps(hwndCap , &CapDriver ,sizeof (CAPDRIVERCAPS) );if (CapDriver.fHasOverlay)capOverlay(hwndCap ,TRUE);else{capPreviewRate(hwndCap ,66) ;capPreview(hwndCap, TRUE) ;}}else {MessageBox(hwndCap,"打开摄像头错误!\n 确定摄像头是否已连接","错误",MB_OK);}break;//采集,捕捉摄像头单帧图像case IDM_CAPTUREIMG:capGrabFrame( hwndCap);break;//保存摄像头采集的图片case IDM_CAPIMGSA VE:MenuOpenDlg(hwnd,"视频采集保存对话框","save");capFileSaveDIB(hwndCap,TempName);break;//VideoCapture.cpp#include <windows.h>#include <stdio.h>#include <commdlg.h>#include <vfw.h>#include "VideoCapture.h"#include "resource.h"char TempName[256];HWND hwndCap;HWND hwndSetCapStutas;CAPDRIVERCAPS CapDriver;CAPSTATUS CapStat;2 / 17int WINAPI WinMain(HINSTANCE hInstance,HINSTANCE hPrevInstance,LPSTR lpCmdLine,int nShowCmd){if(DialogBox(hInstance,(LPCSTR)IDD_DIALOG1,NULL,DlgProc)==-1) MessageBox(NULL,"对话框建立错误!","错误",MB_OK);return 0;}BOOL CALLBACK DlgProc(HWND hdlg,UINT message,WPARAM wParam,LPARAMlParam){RECT rect;switch(message){case WM_INITDIALOG:GetWindowRect(hdlg,&rect);hwndCap =capCreateCaptureWindow(" 人脸录入" ,WS_CHILD|WS_VISIBLE,30,20,320,240,hdlg ,0);return FALSE;case WM_COMMAND :switch (LOWORD (wParam)){case IDOK :if(capDriverConnect(hwndCap, 0)==TRUE){capDriverGetCaps(hwndCap , &CapDriver ,sizeof (CAPDRIVERCAPS) );if (CapDriver.fHasOverlay)capOverlay(hwndCap ,TRUE);else{capPreviewRate (hwndCap ,66) ;capPreview(hwndCap, TRUE) ;}}elseMessageBox(hdlg,"采集图像错误","提示",MB_OK);return 0;break;case IDC_BUTTON1: 3 / 17if(CapDriver.fHasDlgVideoSource)capDlgVideoSource(hwndCap);break;case IDC_BUTTON2:MessageBox(hdlg,"作者:Steward\n地址:云南大学信息学院","关于作者",MB_OK);break;case IDC_BUTTON3:capGrabFrame( hwndCap);break;case IDC_BUTTON4:MenuOpenDlg(hdlg,"视频采集保存对话框");capFileSaveDIB(hwndCap,TempName);break;case IDCANCEL :capCaptureStop(hwndCap);capDriverDisconnect (hwndCap);EndDialog (hdlg, 0) ;return TRUE ;}break ;}return FALSE ;}void MenuOpenDlg(HWND hWnd,char *str1){OPENFILENAME OpenTemp;DWORD Errval,error;char buf[5];char Errstr[50]="GetOpenFileName returned Error #";char szTemp[] = "BMP 文件(*.bmp;*.BMP)\0*.bmp\0所有文件(*.*)\0*.*\0";OpenTemp.lStructSize = sizeof( OPENFILENAME );OpenTemp.hwndOwner = hWnd;OpenTemp.hInstance = 0;OpenTemp.lpstrFilter = (LPSTR)szTemp;OpenTemp.lpstrCustomFilter = NULL;OpenTemp.nMaxCustFilter = 0;OpenTemp.nFilterIndex = 1;OpenTemp.lpstrFile = (LPSTR)TempName;OpenTemp.nMaxFile = sizeof( TempName );OpenTemp.lpstrFileTitle = NULL;OpenTemp.nMaxFileTitle = 0; 4 / 17OpenTemp.lpstrInitialDir = NULL;OpenTemp.lpstrTitle=str1;OpenTemp.Flags = OFN_FILEMUSTEXIST |OFN_HIDEREADONLY | OFN_PATHMUSTEXIST;OpenTemp.nFileOffset = 0;OpenTemp.nFileExtension = 0;OpenTemp.lpstrDefExt = "*";OpenTemp.lCustData = 0L;OpenTemp.lpfnHook = NULL;OpenTemp.lpTemplateName = NULL;error=0;if (GetSaveFileName( &OpenTemp ) != TRUE)error=1;if (error==1) {Errval=CommDlgExtendedError();if (Errval!=0) {sprintf(buf,"%ld",Errval);strcat(Errstr,buf);MessageBox(hWnd,Errstr,"WARNING",MB_OK|MB_ICONSTOP);}}InvalidateRect( hWnd, NULL, TRUE );}//资源文件// Dialog//IDD_DIALOG1 DIALOG DISCARDABLE 0, 0, 203, 201STYLE DS_MODALFRAME | WS_POPUP | WS_CAPTION | WS_SYSMENU CAPTION "视频采集"FONT 10, "System"BEGINDEFPUSHBUTTON "打开",IDOK,31,143,39,14PUSHBUTTON "退出",IDCANCEL,140,169,37,15PUSHBUTTON "设置",IDC_BUTTON1,140,142,38,14PUSHBUTTON "帮助",IDC_BUTTON2,84,170,38,14PUSHBUTTON "捕捉图像",IDC_BUTTON3,85,142,38,15PUSHBUTTON "保存图像",IDC_BUTTON4,32,170,37,14END// DESIGNINFO 5 / 17GUIDELINES DESIGNINFO DISCARDABLEBEGINIDD_DIALOG1, DIALOGBEGINLEFTMARGIN, 7RIGHTMARGIN, 196TOPMARGIN, 7BOTTOMMARGIN, 194ENDEND实现原理用A VICAP.DLL实现图像采集,首先要用函数capCreateCaptureWindowA 创建一个视频采集窗口,然后向视频采集窗口发送相应的消息,实现视频设备的连接、回调函数设置、预览比例和速率设置、预览和叠加模式的设置、图像文件设置等操作。

C#调用摄像头实现拍照功能的示例代码

C#调⽤摄像头实现拍照功能的⽰例代码前⾔⽼师要求我们学⽣做⼀套拍照⾝份验证系统,经过长时间的学习,有了这篇⽂章,希望能帮到读者们。

正⽂⾸先介绍本⽂的主⾓:AForge创建⼀个C#项⽬,引⽤必备的⼏个DLLAForge.dllAForge.Controls.dllAForge.Imaging.dllAForge.Math.dllAForge.Video.DirectShow.dllAForge.Video.dll这些DLL读者们可以在⽂末下载我附带的Demon引⽤必要的命名空间using AForge.Controls;using AForge.Video;using AForge.Video.DirectShow;⾄此,便可以开始编写代码了。

⾸先遍历操作系统上的摄像头控件:public static bool GetDevices(){try{//枚举所有视频输⼊设备videoDevices = new FilterInfoCollection(FilterCategory.VideoInputDevice);if (videoDevices.Count != 0){Console.WriteLine("已找到视频设备.");return true;}return false;}catch (Exception ex){Console.WriteLine("error:没有找到视频设备!具体原因:" + ex.Message);return false;}}找到控件后就可以初始化摄像头:private static void CameraConn(){videoSource = new VideoCaptureDevice(videoDevices[selectedDeviceIndex].MonikerString);vid.VideoSource = videoSource;vid.Start();}但是这⾥为⽌,都只是摄像拍摄,如果需要拍照,则需要通过eventArgs.Frame.Clone()截取视频中的某⼀帧图像这⾥就需要通过事件来处理:public static void GrabBitmap(){if (videoSource == null){return;}videoSource.NewFrame += new NewFrameEventHandler(videoSource_NewFrame); //新建事件}static void videoSource_NewFrame(object sender, NewFrameEventArgs eventArgs){Bitmap bmp = (Bitmap)eventArgs.Frame.Clone(); //Clone摄像头中的⼀帧bmp.Save(path, ImageFormat.Png);videoSource.NewFrame -= new NewFrameEventHandler(videoSource_NewFrame); //如果这⾥不写这个,⼀会⼉会不停的拍照,}代码中的path变量就是图⽚保存的位置,读者们可以⾃⾏设置路径。

网络摄像头工作原理

网络摄像头工作原理网络摄像头是现代科技的产物,广泛应用于监控、视频通话、远程教育等领域。

它利用网络传输技术,将图像和音频信息数字化后传输至远程接收端。

本文将介绍网络摄像头的工作原理,从图像采集、编码传输、远程接收等方面逐步阐述。

一、图像采集网络摄像头的第一步是图像采集。

它通过感光器件(通常是CCD 或CMOS)将光学信号转换为电信号。

感光器件将光线转化为电子信号后,经过模拟-数字转换器(ADC)将其转化为数字信号。

摄像头的分辨率取决于感光器件的像素数量,像素数量越多,图像细节就越清晰。

二、图像编码在图像采集之后,网络摄像头需要对图像进行编码。

编码的目的是将大量的图像数据压缩为较小的数据流,以便于网络传输。

常用的编码方式包括JPEG、MJPEG和H.264等。

JPEG编码是一种无损压缩技术,适合静态图像的传输。

而MJPEG和H.264编码则更适用于动态图像的传输,其中H.264编码在保证图像质量的同时,能够更好地压缩数据量。

三、网络传输经过编码后的图像数据将通过网络传输到远程接收端。

网络摄像头通常有两种传输方式:有线传输和无线传输。

有线传输通过网线将图像数据传输到路由器或交换机,然后再传输到远程接收端。

无线传输则通过WiFi或蓝牙等无线技术将图像数据传送至接收端。

无论是有线传输还是无线传输,网络传输的稳定性和数据传输速度都是关键因素。

四、远程接收当图像数据传输到远程接收端后,接收端将对其进行解码和显示。

解码器将编码后的图像数据还原成原始的图像序列,然后通过显示设备(如电脑、手机或电视)将图像进行显示。

接收端也可以将图像保存或录制下来,以便后续查看或分析。

网络摄像头工作原理的核心就是图像采集、图像编码和网络传输。

通过这一过程,我们可以实现远程监控、视频通话等功能。

同时,随着科技的不断进步,网络摄像头的性能也在不断提升,图像质量更加清晰,网络传输速度更加稳定,为用户带来更好的体验。

网络摄像头的工作原理在实际应用中发挥着重要作用。

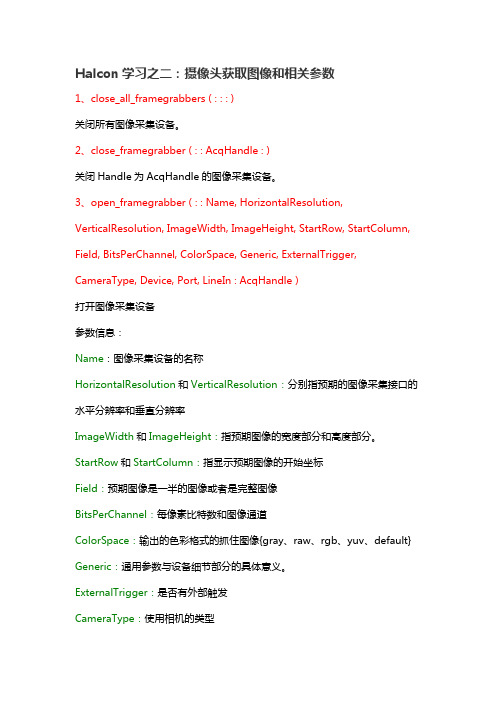

Halcon学习之二:摄像头获取图像和相关参数

Halcon学习之二:摄像头获取图像和相关参数1、close_all_framegrabbers ( : : : )关闭所有图像采集设备。

2、close_framegrabber ( : : AcqHandle : )关闭Handle为AcqHandle的图像采集设备。

3、open_framegrabber ( : : Name, HorizontalResolution, VerticalResolution, ImageWidth, ImageHeight, StartRow, StartColumn, Field, BitsPerChannel, ColorSpace, Generic, ExternalTrigger, CameraType, Device, Port, LineIn : AcqHandle )打开图像采集设备参数信息:Name:图像采集设备的名称HorizontalResolution和VerticalResolution:分别指预期的图像采集接口的水平分辨率和垂直分辨率ImageWidth和ImageHeight:指预期图像的宽度部分和高度部分。

StartRow和StartColumn:指显示预期图像的开始坐标Field:预期图像是一半的图像或者是完整图像BitsPerChannel:每像素比特数和图像通道ColorSpace:输出的色彩格式的抓住图像{gray、raw、rgb、yuv、default} Generic:通用参数与设备细节部分的具体意义。

ExternalTrigger:是否有外部触发CameraType:使用相机的类型Device:图像获取设别连接到的设备Port:图像获取设别连接到的端口LineIn :相机输入的多路转接器AcqHandle:图像获取设备的Handle4、grab_image ( : Image : AcqHandle : )获取AcqHandle的图像采集设备的Image。

matlab调用摄像头的代码

matlab调用摄像头的代码

在MATLAB中调用摄像头可以使用MATLAB自带的Image Acquisition Toolbox。

首先,确保你已经安装了这个工具箱。

接下来,你可以按照以下步骤进行操作:

步骤1,创建视频输入对象。

你可以使用以下代码创建一个视频输入对象:

matlab.

vid = videoinput('winvideo', 1, 'RGB24_640x480');

其中,'winvideo'是指定使用Windows平台的视频输入适配器,1是指定摄像头的设备ID,'RGB24_640x480'是指定视频格式和分辨率。

步骤2,预览视频。

使用以下代码可以预览摄像头捕获的视频:

matlab.

preview(vid);

步骤3,捕获图像。

你可以使用以下代码从摄像头捕获图像:

matlab.

img = getsnapshot(vid);

步骤4,显示图像。

最后,你可以使用以下代码来显示捕获的图像:

matlab.

imshow(img);

需要注意的是,在使用完摄像头后,记得释放摄像头资源,可

以使用以下代码来完成释放操作:

matlab.

delete(vid);

以上就是在MATLAB中调用摄像头的基本代码。

当然,根据具体的需求,你还可以对图像进行处理、保存视频等操作。

希望这些信息能够帮助到你。

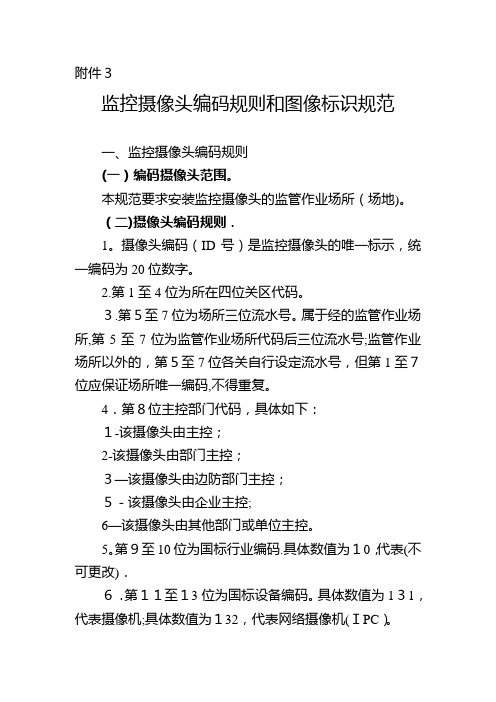

监控摄像头编码规则和图像标识样板

附件3监控摄像头编码规则和图像标识规范一、监控摄像头编码规则(一)编码摄像头范围。

本规范要求安装监控摄像头的监管作业场所(场地)。

(二)摄像头编码规则.1。

摄像头编码(ID号)是监控摄像头的唯一标示,统一编码为20位数字。

2.第1至4位为所在四位关区代码。

3.第5至7位为场所三位流水号。

属于经的监管作业场所,第5至7位为监管作业场所代码后三位流水号;监管作业场所以外的,第5至7位各关自行设定流水号,但第1至7位应保证场所唯一编码,不得重复。

4.第8位主控部门代码,具体如下:1-该摄像头由主控;2-该摄像头由部门主控;3—该摄像头由边防部门主控;5-该摄像头由企业主控;6—该摄像头由其他部门或单位主控。

5。

第9至10位为国标行业编码.具体数值为10,代表(不可更改).6.第11至13位为国标设备编码。

具体数值为131,代表摄像机;具体数值为132,代表网络摄像机(IPC)。

7.第14至15位为监控摄像头场所分类代码,详见下(1)陆路边境口岸的摄像头,无论是否在口岸限定区域设置有监管作业场所,摄像头编码的第14至15位均应为“10-陆路边境口岸"。

(2)未包含在监管作业场所内的水运口岸泊位等作业区域的摄像头,相应摄像头编码的第14至15位为“19——水运码头泊位”.(3)边民互市类监管作业场摄像头,相应摄像头编码的第14至15位为“14—-边民互市类”。

(4)摄像头编码的第14-15位应严格谨慎使用“其他"(代码为18、41)。

8.第16至17位为摄像头位置代码(摄像头监控的范围),具体如下:01—监控范围为办公场所出入口02-监控范围为地磅或磅秤03—监控范围为查验场地、查验平台或快件、邮件、旅检查验区04—监控范围为货物、快件、邮件分拣线(机检线)或旅检先期机检线05—储罐06-监控范围为大型集装箱检查设备H986,快件、邮件、旅检X光机或CT机等机检设备07-监控范围为执法办案场所08-监控范围为卡口09-监控范围为码头泊位10-监控范围为辐射探测设备11—监控范围为仓库12—监控范围为围网13—监控范围为旅检通道14—监控范围为旅检申报区15—监控范围为搜身房、X光机检查房等旅检人身检查区16-监控范围为旅检暂不予放行物品存放区域17-监控范围为口岸免税店18-监控范围为旅检作业区前的缓冲区、航空旅客行李提取区19—监控范围为办理ATA单证册、客带货、离境退税等业务的区域20—监控范围为上述所列的位置以外的地方.21—监控范围为卫生处理场所 .ﻩ22—监控范围为堆场.9。

C#摄像头实现拍照功能的简单代码示例

C#摄像头实现拍照功能的简单代码⽰例C#摄像头实现拍照功能的简单代码⽰例using System;using System.Runtime.InteropServices;using System.Drawing;using System.Drawing.Imaging;namespace Video{////// ⼀个C#摄像头控制类///public class VideoWork{private const int WM_USER = 0x400;private const int WS_CHILD = 0x40000000;private const int WS_VISIBLE = 0x10000000;private const int WM_CAP_START = WM_USER;private const int WM_CAP_STOP = WM_CAP_START + 68;private const int WM_CAP_DRIVER_CONNECT = WM_CAP_START + 10;private const int WM_CAP_DRIVER_DISCONNECT = WM_CAP_START + 11;private const int WM_CAP_SAVEDIB = WM_CAP_START + 25;private const int WM_CAP_GRAB_FRAME = WM_CAP_START + 60;private const int WM_CAP_SEQUENCE = WM_CAP_START + 62;private const int WM_CAP_FILE_SET_CAPTURE_FILEA = WM_CAP_START + 20;private const int WM_CAP_SEQUENCE_NOFILE =WM_CAP_START+ 63;private const int WM_CAP_SET_OVERLAY =WM_CAP_START+ 51;private const int WM_CAP_SET_PREVIEW =WM_CAP_START+ 50;private const int WM_CAP_SET_CALLBACK_VIDEOSTREAM = WM_CAP_START +6;private const int WM_CAP_SET_CALLBACK_ERROR=WM_CAP_START +2;private const int WM_CAP_SET_CALLBACK_STATUSA= WM_CAP_START +3;private const int WM_CAP_SET_CALLBACK_FRAME= WM_CAP_START +5;private const int WM_CAP_SET_SCALE=WM_CAP_START+ 53;private const int WM_CAP_SET_PREVIEWRATE=WM_CAP_START+ 52;private IntPtr hWndC;private bool bWorkStart = false;private IntPtr mControlPtr;private int mWidth;private int mHeight;private int mLeft;private int mTop;////// 初始化显⽰图像////// 控件的句柄/// 开始显⽰的左边距/// 开始显⽰的上边距/// 要显⽰的宽度/// 要显⽰的长度public VideoWork(IntPtr handle, int left, int top, int width,int height){mControlPtr = handle;mWidth = width;mHeight = height;mLeft = left;mTop = top;}[DllImport("avicap32.dll")]private static extern IntPtr capCreateCaptureWindowA(byte[] lpszWindowName, int dwStyle, int x, int y, int nWidth, int nHeight, IntPtr hWndParent, int nID);[DllImport("avicap32.dll")]private static extern int capGetVideoFormat(IntPtr hWnd, IntPtr psVideoFormat, int wSize );[DllImport("User32.dll")]private static extern bool SendMessage(IntPtr hWnd, int wMsg, int wParam, long lParam);////// 开始显⽰图像///public void Start(){if (bWorkStart)return;bWorkStart = true;byte[] lpszName = new byte[100];hWndC = capCreateCaptureWindowA(lpszName,WS_CHILD|WS_VISIBLE ,mLeft,mTop,mWidth,mHeight,mControlPtr,0);if (hWndC.ToInt32() != 0){{SendMessage(hWndC, WM_CAP_SET_CALLBACK_VIDEOSTREAM, 0, 0);SendMessage(hWndC, WM_CAP_SET_CALLBACK_ERROR, 0, 0);SendMessage(hWndC, WM_CAP_SET_CALLBACK_STATUSA, 0, 0);SendMessage(hWndC, WM_CAP_DRIVER_CONNECT, 0, 0);SendMessage(hWndC, WM_CAP_SET_SCALE, 1, 0);SendMessage(hWndC, WM_CAP_SET_PREVIEWRATE, 66, 0);SendMessage(hWndC, WM_CAP_SET_OVERLAY, 1, 0);SendMessage(hWndC, WM_CAP_SET_PREVIEW, 1, 0);//Global.log.Write("SendMessage");}return;}////// 停⽌显⽰///public void Stop(){SendMessage(hWndC, WM_CAP_DRIVER_DISCONNECT, 0, 0);bWorkStart = false;}////// 抓图////// 要保存bmp⽂件的路径public void GrabImage(string path){IntPtr hBmp = Marshal.StringToHGlobalAnsi(path);SendMessage(hWndC,WM_CAP_SAVEDIB,0,hBmp.ToInt64());}}}这是⼀个控制摄像头进⾏拍照的类,我每次使⽤GrabImage抓图都是225K的⼀张照⽚,我想请问如何才能让我抓到的图⽚⼩⼀些,我想控制在70K左右。

摄像头代码实例解析

1、版本更新说明版本:更新日期:版本:更新日期:库说明: 加入噪点检测函数HqDLNoiseCalibration加入位置调节函数HqDLSizeCalibration 版本:更新日期:库说明: 加入控制电机HqDLAutoFocus及光源函数HqDLLedControl版本:更新日期:库说明: 加入avi录影HqDLCaptureToAvi及自动调焦功能HqDLSetDoAF注:提供的开发包的所有操作都是针对24比特BMP图像。

2、返回值类型说明ResSuccess 0x0000 // 返回成功ResNullHandleErr 0x0001 // 无效句柄ResNullPointerErr 0x0002 // 指针为空ResFileOpenErr 0x0003 // 文件打开失败ResNoDeviceErr 0x0004 // 没有设备连接ResInvalidParameterErr 0x0005 // 无效的参数ResOutOfMemoryErr 0x0006 // 内存溢出ResNoPreviewRunningErr 0x0007 // 预览没有开启ResOSVersionErr 0x0008 // 操作系统版本错误ResUsbNotAvailableErr 0x0009 // 设备无效ResNotSupportedErr 0x000a // 设备不支持此功能ResNoSerialString 0x000b // 读取不到序列号ResVerificationErr 0x000c // 效验失败ResTimeoutErr 0x000d // 超时ResScaleModeErr 0x000f // 缩放错误ResUnknownErr 0x00ff // 未知错误ResDisplayWndExist 0x0011 // 应该关闭预览窗口ResAllocated 0x0012 // 内存已经分配ResAllocateFail 0x0013 // 内存分配失败ResReadError 0x0014 // USB读取失败ResWriteError 0x0015 // USB命令发出失败ResUsbOpen 0x0016 // USB端口已经打开ResCreateStreamErr 0x0017 // 创建avi流失败ResSetStreamFormatErr 0x0018 // 设置AVI流格式失败3、HqDLInitialize函数: HQDL_API HqDLInitialize(IN LPCTSTR pFilterName,OUT int *pIndex,IN CapInfoStruct *pCapInfo,OUT HANDLE *hCamera);功能: 初始化设备,返回摄像头句柄,用于其它函数的调用参数: pIndex 返回摄像头索引pFilterName 保留pCapInfo 初始化摄像头参数hCamera 返回给调用者的设备句柄说明: 必须要给pCapInfo->Buffer分配足够的内存空间,一般要分配比最大的采集空间要大一些,推荐用MAXWIDTH*MAXHEIGHT+512,用于传递采集数据说明: 此函数要先于所有的API函数,并且每一次调用,都要有HqDLUninitialize相对应。

C#调用AForge实现摄像头录像的示例代码

C#调⽤AForge实现摄像头录像的⽰例代码1:⾸先下载也可以下载输出为MP4需要⽤到ffmpeg相关的⽂件,我打包的库已经带了,去官⽹找的库可以在这个⽬录找到:2:添加这些引⽤:3:两个全局变量://⽤来操作摄像头private VideoCaptureDevice Camera = null;//⽤来把每⼀帧图像编码到视频⽂件private VideoFileWriter VideoOutPut = new VideoFileWriter();开始代码://获取摄像头列表var devs = new FilterInfoCollection(FilterCategory.VideoInputDevice);//实例化设备控制类(我选了第1个)Camera = new VideoCaptureDevice(devs[0].MonikerString);//配置录像参数(宽,⾼,帧率,⽐特率等参数)VideoCapabilities这个属性会返回摄像头⽀持哪些配置,从这⾥⾯选⼀个赋值接即可,我选了第1个Camera.VideoResolution = Camera.VideoCapabilities[0];//设置回调,aforge会不断从这个回调推出图像数据Camera.NewFrame += Camera_NewFrame;//打开摄像头Camera.Start();//打开录像⽂件(如果没有则创建,如果有也会清空),这⾥还有关于VideoOutPut.Open("E:/VIDEO.MP4", Camera.VideoResolution.FrameSize.Width, Camera.VideoResolution.FrameSize.Height, Camera.VideoResolution.AverageFrameRate, VideoCodec.MPEG4, Camera.VideoResolution.BitCount);给AForge输出图像数据的回调⽅法://图像缓存private Bitmap bmp = new Bitmap(1, 1);//摄像头输出回调private void Camera_NewFrame(object sender, NewFrameEventArgs eventArgs){//写到⽂件VideoOutPut.WriteVideoFrame(eventArgs.Frame);lock (bmp){//释放上⼀个缓存bmp.Dispose();//保存⼀份缓存bmp = eventArgs.Frame.Clone() as Bitmap;}}结束代码://停摄像头Camera.Stop();//关闭录像⽂件,如果忘了不关闭,将会得到⼀个损坏的⽂件,⽆法播放VideoOutPut.Close();4:修改App.config,兼容net2.0的⼀些东西:<?xml version="1.0" encoding="utf-8"?><configuration><startup useLegacyV2RuntimeActivationPolicy="true"><supportedRuntime version="v4.0" sku=".NETFramework,Version=v4.5"/></startup><supportedRuntime version="v2.0.50727"/></configuration>不然会这样:以上就是本⽂的全部内容,希望对⼤家的学习有所帮助,也希望⼤家多多⽀持。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

bmp_array.push(bmpy_array+"|");

}

bmp_ = in_txt.text;

bmp_lv.bmp_data = bmp_array;

show_txt.text = "正在发送数据,请稍等......";

bmp_lv.sendAndLoad("asp/bmp.asp?id="+Math.random(), bmp_lv, "post");

for (var d:Number = temp_array.length-2; d>=0; d--) {

var temp2_array:Array = new Array();

temp2_array = temp_array[d].split(",");

out_array.push(temp2_array);

} else {

show_txt.text = "请选中要删除的图片。";

setTimeout(function () {

show_txt.text = "";

}, 3000);

}

};

delete_btn.onRelease = delete_func;

//==============进入管理=====================

delete_btn.enabled = false;

this.onKeyDown = function() {

if (Key.getCode() == 13 && in_txt.text == "ING") {

delete_btn.enabled = true;

}

};

in_txt.onSetFocus = function() {

eCodepage = true;

import flash.display.BitmapData;

//============摄像头初始化=============

var _cam:Camera = Camera.get();

_cam.setMode(160, 120, 12, true);

}, 1000);

}

};

var nameshow_func:Function = function () {

name_lv.load("asp/showname.asp?id="+Math.random());

};

nameshow_func();

//===============图像查询===================

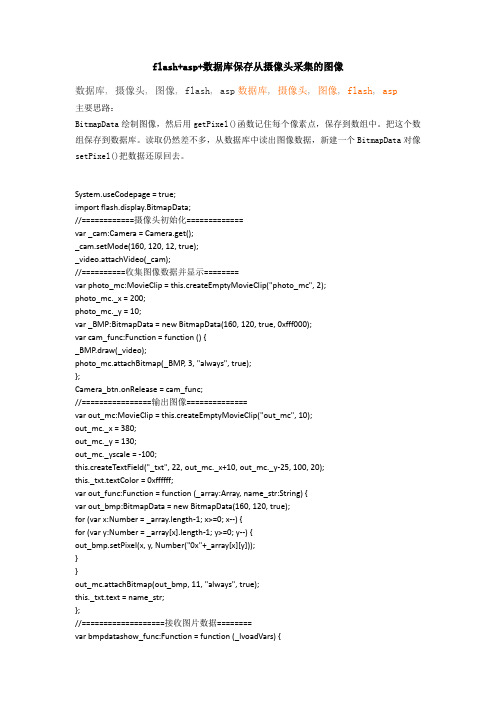

flash+asp+数据库保存从摄像头采集的图像

数据库,摄像头,图像,flash,asp数据库,摄像头,图像,flash,asp

主要思路:

BitmapData绘制图像,然后用getPixel()函数记住每个像素点,保存到数组中。把这个数组保存到数据库。读取仍然差不多,从数据库中读出图像数据,新建一个BitmapData对像setPixel()把数据还原回去。

_video.attachVideo(_cam);

//==========收集图像数据并显示========

var photo_mc:MovieClip = this.createEmptyMovieClip("photo_mc", 2);

photo_mc._x = 200;

photo_mc._y = 10;

var _BMP:BitmapData = new BitmapData(160, 120, true, 0xfff000);

var cam_func:Function = function () {

_BMP.draw(_video);

photo_mc.attachBitmap(_BMP, 3, "always", true);

name_list.addItem((d+1)+":"+_array[d]);

}

};

name_list.addEventListener("change", this);

this.change = function(evt) {

//trace(evt.target.selectedIndex);

select_func(name_array[evt.target.selectedIndex]);

}

out_func(out_array, __asp);

};

//============发送图像数据并接收========

var bmp_lvoadVars = new LoadVars();

bmp_lv.onLoad = function(success:Boolean):Void {

}

};

//=============列表添加=========

var addItem_func:Function = function (_array:Array) {

name_list.removeAll();

for (var d:Number = 0; d<_array.length-1; d++) {

var bmpdatashow_func:Function = function (_lvoadVars) {

var out_array:Array = new Array();

var temp_array:Array = new Array();

temp_array = _lv.data_asp.split("|");

}

};

var select_func:Function = function (name_str:String) {

showbmp_ = name_str;

showbmp_lv.sendAndLoad("asp/selectbmp.asp?id="+Math.random(), showbmp_lv, "post");

var out_bmp:BitmapData = new BitmapData(160, 120, true);

for (var x:Number = _array.length-1; x>=0; x--) {

for (var y:Number = _array[x].length-1; y>=0; y--) {

var showbmp_lvoadVars = new LoadVars();

showbmp_lv.onLoad = function(success) {

if (success) {

bmpdatashow_func(this);

show_txt.text = "数据接收成功!";

nameshow_func();

show_txt.text = "正在接收数据,请稍等......";

};

select_btn.onRelease = function() {

select_func(in_txt.text);

};

//============删除===================

var delete_lvoadVars = new LoadVars();

};

Camera_btn.onRelease = cam_func;

//================输出图像==============

var out_mc:MovieClip = this.createEmptyMovieClip("out_mc", 10);

out_mc._x = 380;

out_mc._y = 130;

out_mc._yscale = -100;

this.createTextField("_txt", 22, out_mc._x+10, out_mc._y-25, 100, 20);

this._txt.textColor = 0xffffff;

var out_func:Function = function (_array:Array, name_str:String) {

for (var x:Number = 159; x>=0; x--) {

var bmpy_array:Array = new Array();

for (var y:Number = 119; y>=0; y--) {

bmpy_array.push(_BMP.getPixel(x, y).toString(16));

};

//===============名字显示================

var name_lvoadVars = new LoadVars();

var name_array:Array = new Array();

name_lv.onLoad = function(success) {

trace(success);

if (success) {

name_array = [];

name_array = _asp.split("|");

addItem_func(name_array);

setTimeout(function () {

in_txt.text = "";

show_txt.text = "";

Key.addListener(this._parent);