人工神经元的m-p模型公式

rnn模型公式

rnn模型公式RNN(循环神经网络)的公式如下:ht=f(W⋅[ht−1,xt]+b)h_{t}=f\left(W \cdot \left[h_{t-1},x_{t}\right]+b\right)ht=f(W⋅[ht−1,xt]+b)或者从矩阵分块乘法的角度来看,实际上是等价的:ht=f(W⋅ht−1+U⋅xt+b)h_{t}=f\left(W \cdot h_{t-1}+U \cdotx_{t}+b\right)ht=f(W⋅ht−1+U⋅xt+b)其中,ht表示第t时刻的隐藏状态,W和U是权重矩阵,b是偏置项,f是激活函数,xt是第t时刻的输入。

另外,LSTM(长短期记忆)是RNN的一种变体,其公式如下:遗忘门:ft=σ(Wf⋅[ht−1,xt]+bf)f_{t}=\sigma\left(W_{f} \cdot \left[h_{t-1}, x_{t}\right]+b_{f}\right)ft=σ(Wf⋅[ht−1,xt]+bf) 输入门:it=σ(Wi⋅[ht−1,xt]+bi)i_{t}=\sigma\left(W_{i} \cdot \left[h_{t-1},x_{t}\right]+b_{i}\right)it=σ(Wi⋅[ht−1,xt]+bi) 细胞状态:C\~t=tanh(WC⋅[ht−1,xt]+bC)\tilde{C}_{t}=\tanh \left(W_{C} \cdot\left[h_{t-1}, x_{t}\right]+b_{C}\right)C~t=tanh(WC⋅[ht−1,xt]+bC) 细胞更新:Ct=ft∗Ct−1+it∗C\~tC_{t}=f_{t} C_{t-1}+i_{t} \tilde{C}_{t}Ct=ft∗Ct−1+it∗C~t 输出门:ot=σ(Wo⋅[ht−1,xt]+bo)o_{t}=\sigma\left(W_{o} \cdot \left[h_{t-1}, x_{t}\right]+b_{o}\right)ot=σ(Wo[ht−1,xt]+bo) 输出:ht=ot∗tanh(Ct)h_{t}=o_{t} \tanh \left(C_{t}\right)ht=ot∗tanh(Ct)以上是RNN和LSTM的公式,请注意,这里的符号和参数取决于具体的实现方式。

人工神经网络1(第1,2章)

13

b、Hebb规则(无监督学习规则)

• 神经心理学家D.O.Hebb于1949年提出生物神经元学习的假设:“当 某一突触(连接)两端的神经元的激活同步时(同时兴奋或同时抑 制时),他们间的连接强度应增加,反之则减弱。” 0 S M 1 • 假设:具有代表性的、反映环境的一组样本M个: X X X • 每个样本由N个元素构成——X s x s x s x s 反映该样本的 0 1 N 1 s s xi xj 0 X 色的分布 特征 形状的分布 的· 质感的分布 0 1 i j N 1 s s xi s xj 等。 X

w x 可以由一个(n-1)维超平面S:

j 0 j

j

0

分开两类样本。

y

ω0 ω

1

ω j ω N-

x0 x1

…

…

1

使得训练后的权值满足: X R1 N 1 时: I w j x j 0

j 0

x j xN 1

X R2

I w j x j 0

一个静态的神经元模型

4

3、常用的功能函数

• (1)线性函数

f(u) 1

0、5

(3) s函数(又称sigmoid函数)

fs(u)

0

u 0

f (u ) u

f s (u )

1 1 e u

u

• (2)硬限幅函数(包括符号函数)

fh(u)

f (u ) sgn(u )

+1

0 -1 u

1

0 u

X M 1

xi

s

xj

m-p模型及函数关系 -回复

m-p模型及函数关系-回复MP模型(Model-Proof)是一种常用的数学问题求解方法。

它是由中国数学家华罗庚于20世纪50年代提出的,旨在解决含有多个未知数的代数方程组。

一个典型的MP模型问题通常包含以下几个步骤,下面我将一一进行解释。

第一步,明确问题。

首先,我们需要明确需要解决的问题是什么。

在这一步骤中,我们要对问题进行分析和抽象,把实际问题转化为数学问题,确定未知数的个数和关系。

第二步,建立方程。

在明确问题之后,我们需要建立代数方程组。

方程的建立需要根据问题的描述和已知条件,使用数学语言进行表达。

将已知数据和未知数用字母表示,根据问题的要求写出合适的关系式。

第三步,求解方程。

在建立了方程组之后,我们需要求解未知数的值。

这一步可以使用MP函数进行计算。

MP函数是一个将未知数作为输入,输出表达式的函数。

通过对方程组进行分析,可以得到一系列的MP函数,它们相互关联,可以通过迭代运算得到最后的解。

第四步,验证解。

求解出未知数的值后,我们需要将这些值代入原有的方程中,进行验证。

验证的目的是确定求解出的方程组是否满足原有问题中的要求。

如果验证结果正确,说明求解是有效的;如果验证结果不正确,则需要重新检查计算过程和方程的建立。

MP函数可以由多个基本的运算函数组成,如加法、减法、乘法、除法等。

通过对这些基本函数的组合使用,可以构造出更复杂的函数,用来求解复杂的代数方程组。

MP模型的优点之一是能够对复杂的数学问题进行分析和求解,帮助我们找到问题的核心,提供了一种抽象、计算和验证的工具。

通过使用MP模型,我们可以更好地理解数学问题,并能够进行更精确的计算。

MP模型的应用领域十分广泛。

它可以应用于代数方程组的求解、数值计算、优化问题等。

在科学研究、工程技术、金融投资等领域都有MP模型的应用。

总结起来,MP模型是一种解决代数方程组问题的数学方法。

它通过明确问题、建立方程、求解方程和验证解的四个步骤,使用MP函数进行计算,帮助我们理解和解决各种复杂的数学问题。

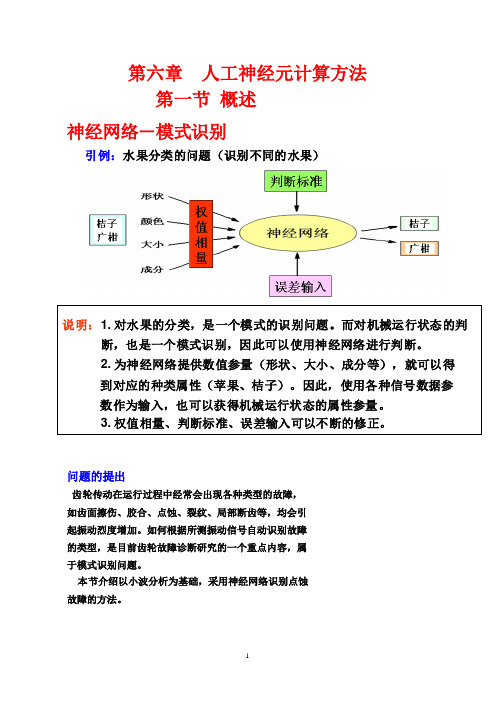

第六章 人工神经元计算方法

第六章人工神经元计算方法第一节概述神经网络-模式识别引例:水果分类的问题(识别不同的水果)说明:1. 对水果的分类,是一个模式的识别问题。

而对机械运行状态的判断,也是一个模式识别,因此可以使用神经网络进行判断。

2. 为神经网络提供数值参量(形状、大小、成分等),就可以得到对应的种类属性(苹果、桔子)。

因此,使用各种信号数据参数作为输入,也可以获得机械运行状态的属性参量。

3. 权值相量、判断标准、误差输入可以不断的修正。

三.具体实例通过该例,说明网络建立、训练、识别的过程问题的提出齿轮传动在运行过程中经常会出现各种类型的故障,如齿面擦伤、胶合、点蚀、裂纹、局部断齿等,均会引起振动烈度增加。

如何根据所测振动信号自动识别故障的类型,是目前齿轮故障诊断研究的一个重点内容,属于模式识别问题。

本节介绍以小波分析为基础,采用神经网络识别点蚀故障的方法。

三. 具体实例齿轮点蚀故障的小波神经网络识别三. 具体实例齿轮点蚀故障的小波神经网络识别神经网络理论的应用取得了令人瞩目的发展,特别是在人工智能、自动控制、计算机科学、信息处理、机器人、模式识别、CAD/CAM等方面都有重大的应用实例。

下面列出一些主要应用领域:(1)模式识别和图像处理。

语音识别、签字识别、指纹识别、人体病理分析、目标检测与识别等。

(2)控制和优化。

机械过程控制、机器人运动控制、金属探伤、故障分析等。

(3)预报和智能信息管理。

股票市场预测、地震预报、有价证券管理、借贷风险分析、IC卡管理和交通管理。

一、什么是人工神经元计算人的大脑是众所周知的最复杂的计算“装置”,其强大的思考、记忆和解决问题的能力激发了许多科学工作者去尝试建立人脑的计算模型。

经过近半个多世纪的努力,形成了人工神经元计算理论。

1.模拟人脑神经元是脑神经系统中最基本的细胞单元。

每个神经元都是一个简单的微处理单元,其接受和综合许多其它神经元通过所谓树突的输入结构传来的信号,并将输出信号沿着轴突向外传送。

人工神经元模型的数学表达形式

人工神经元模型的数学表达形式人工神经元是神经网络的基本单元,它可以模拟生物神经元的基本功能。

人工神经元模型的数学表达形式是一种数学模型,用于描述神经元的输入、输出和激活函数之间的关系。

在数学表达形式中,人工神经元可以表示为以下几个要素:1. 输入:人工神经元接收来自其他神经元或外部输入的信号,每个输入都有一个对应的权重。

假设我们有n个输入,输入向量为x = (x1, x2, ..., xn),对应的权重向量为w = (w1, w2, ..., wn)。

输入和权重的乘积可以表示为x·w,表示输入和权重的内积。

2. 加权和:人工神经元将输入与对应的权重相乘,并求和得到加权和。

加权和表示为z = x·w + b,其中b是偏置项,表示人工神经元的偏置。

3. 激活函数:加权和经过激活函数进行非线性变换,得到神经元的输出。

常用的激活函数有sigmoid函数、ReLU函数等。

以sigmoid函数为例,激活函数可以表示为a = σ(z),其中σ(z) = 1 / (1 + exp(-z))。

4. 输出:经过激活函数变换后得到的输出即为人工神经元的输出。

人工神经元模型的数学表达形式可以总结为以下公式:z = x·w + ba = σ(z)其中,z表示加权和,x表示输入向量,w表示权重向量,b表示偏置项,a表示输出,σ表示激活函数。

通过调整权重和偏置项,人工神经元可以对输入信号做出不同的响应。

权重决定了各个输入对输出的影响程度,偏置项可以调整神经元的灵敏度。

人工神经元模型的数学表达形式是神经网络的基础,也是深度学习的核心。

通过组合多个神经元,可以构建复杂的神经网络,实现更加高级的任务,如图像识别、语音识别、自然语言处理等。

除了单个神经元,神经网络还包括多个层次的神经元组成的网络结构。

每一层的神经元接收上一层的输出作为输入,并将自己的输出传递给下一层。

这种层次结构的神经网络被称为前馈神经网络,是目前应用最广泛的神经网络模型之一。

人工神经元模型及学习方法资料重点

M-P模型的六点假定

关于神经元的信息处理机制,该模型在简 化的基础上提出了以下六点假定进行描述: ➢每个神经元都是一个多输入单输出的信息 处理单元 ➢神经元输入分兴奋性输入和一致性输入两 种类型 ➢神经元具有空间整合特性和阈值特性

➢神经元输入与输出间有固定的时滞,主要 取决于突触延搁

➢忽略时间整合作用和不应期 ➢神经元本身是非事变的,即其突触时延和

➢MP模型是最简单的网络,但是由于生物神经 元本质上是模拟过程,过早地把物理量抽象 为0和1,会丢失许多有用信息,因此神经计 算应当将模拟的和数字的技术结合起来。

➢从最简化的观点看,仍具有一定指导意义。

MP模型应用

• MP模型应用: 可用于实现分类、模式识别等,当前

已经有许多成功的基于M-P神经元模型的神 经网络得到应用,如BP算法,这种算法是 实现人脸识别的主要算法之一。

满足y=x1+x2逻辑或关系

逻辑非: 令T=0,E=0,I=xW=x(一个抑制性输入) 当x=1,I=1>0, 不触发y=0 当x=0,I=0, 触发y=1

满足逻辑非关系

MP模型

➢能够构成逻辑与、或、非,就可进而组成任 意复杂的逻辑关系,因此,MP模型是按一定 方式组织起来,可以构成具有逻辑功能的神 经网络。

• τij—— 输入输出间的突触时延; • Tj —— 神经元j的阈值; • wij—— 神经元i到 j 的突触连接系数或称

权重值;

• f ( ) —神经元转移函数。

n

o j (t 1) f {[ wij xi (t)] T j} i 1

神经元的数学模型

n

netj (t)

wij xi (t)

突触强度均为常数

假设1:多输入单输出

mlp的完整表达式

mlp的完整表达式

MLP的完整表达式指的是多层神经网络(MultilayerPerceptron)的数学公式表示。

它是一种常见的人工神经网络模型,由输入层、隐含层和输出层组成,每一层都包含多个神经元。

假设有一个包含n个输入特征的样本x,每个特征用xi表示。

输入层包含n个神经元,每个神经元对应一个输入特征xi。

隐含层

由m个神经元组成,每个神经元都接收来自前一层所有神经元的输入,并进行加权和运算,再通过一个非线性激活函数g()处理得到输出。

输出层包含k个神经元,每个神经元对应一个输出类别。

假设输出层有softmax激活函数,表达式为:

softmax(zj) = exp(zj) / Σi=1~k exp(zi)

其中zj表示第j个神经元的输入值,exp()表示指数函数,Σ

i=1~k exp(zi)表示所有神经元输入值的指数和。

则MLP的完整表达式可以表示为:

y = softmax(W2*g(W1*x + b1) + b2)

其中W1表示输入层到隐含层的权重矩阵,b1表示隐含层的偏置向量,W2表示隐含层到输出层的权重矩阵,b2表示输出层的偏置向量,g()表示隐含层的非线性激活函数。

该表达式将输入x通过输入层、隐含层和输出层的多次运算,得到最终的输出y,表示样本x属于各个输出类别的概率。

- 1 -。

多层神经网络MLP快速入门

应用一:MLP分类器

应用一:MLP分类器

应用一:MLP分类器

应用一:MLP分类器

应用一:MLP分类器

应用一:MLP分类器

应用一:MLP分类器

应用一:MLP分类器

应用一:MLP分类器

01

单击此处添加小标题

Adam Harley 创造了一个多层感知器的 3D 可视化 (http://scs.ryerson.ca/~aharley/vis/fc/),并 已经开始使用 MNIST 数据库手写的数字进行训练。

感知机与多层神经网络

感知机与多层神经网络

如果我们现在再次向网络输入同样的样本,网络应该比之前有更好的 表现,因为为了最小化误差,已经调整了权重。如图 7 所示,和之前 的 [0.6, -0.4] 相比,输出节点的误差已经减少到了 [0.2, -0.2]。

这意味着我们的网络已经 学习了如何正确对第一个 训练样本进行分类。

二.神经网络(neural networks)方面的研究很早就已经出现,今天“神经网 络”已是一个相当大的、多学科交叉的学科领域。

三. 神经网络中最基本的成分是神经元(neuron)模型,一般称作「节点」 (node)或者「单元」(unit)。节点从其他节点接收输入,或者从外部 源接收输入,然后计算输出。每个输入都辅有「权重」(weight,即 w),

四.权重取决于其他输入的相对重要性。节点将函数 f(定义如下)应用到加权 后的输入总和,如图 1 所示:

神经元模型

还有配有权重 b(称 为「偏置(bias)」 或者「阈值 (threshold)」) 的输入 1。

神经元模型

函数 f 是非线性的,叫做激活函数。激活函数的作用是将非线性引入神经 元的输出。因为大多数现实世界的数据都是非线性的,我们希望神经元能 够学习非线性的函数表示,所以这种应用至关重要。

neural network指标公式

neural network指标公式

神经网络的指标公式通常用于评估模型的性能和预测准确性。

以下是一些常见的神经网络指标公式:

1. 均方误差(Mean Squared Error,MSE):

MSE = 1/n Σ(y_true - y_pred)^2

其中,y_true是真实值,y_pred是预测值,n是样本数量。

2. 均方根误差(Root Mean Squared Error,RMSE):

RMSE = sqrt(1/n Σ(y_true - y_pred)^2)

3. 平均绝对误差(Mean Absolute Error,MAE):

MAE = 1/n Σy_true - y_pred

4. 平均绝对百分比误差(Mean Absolute Percentage Error,MAPE):MAPE = 100% 1/n Σ(y_true - y_pred) / y_true

5. 准确率(Accuracy):

准确率 = 正确预测的样本数 / 总样本数

6. 精确率(Precision):

精确率 = 真正例(TP) / (真正例(TP)+ 假正例(FP))

7. 召回率(Recall):

召回率 = 真正例(TP) / (真正例(TP)+ 假反例(FN))

8. F1分数(F1 Score):

F1分数 = 2 精确率召回率 / (精确率 + 召回率)

这些指标可以帮助我们评估神经网络的性能,了解模型在各种情况下的表现。

根据实际问题和数据集的特点,可以选择合适的指标来评估模型的性能。

人工神经元模型介绍

从最简化的观点看,仍具有一定指导意义。

MP模型应用

• MP模型应用: 可用于实现分类、模式识别等,当前 已经有许多成功的基于M-P神经元模型的神 经网络得到应用,如BP算法,这种算法是 实现人脸识别的主要算法之一。

感知器(Perceptron)模型

1958年,美国心理学家Frank Rosenblatt提出一种具有单层计算单元的 神经网络,成为Perceptron,即为感知器。 感知器是一种前馈网络,同层内无互连, 不同层间无反馈,由下层向上层传递。其 输入、输出均为离散值,神经元对输入加 权求和后,由阈值函数决定其输出。 单层感知器的结构与功能都非常简单,但 却是要就其他网络的基础。

• 设定输入向量X=(x1,x2)T

• 输出: • 则由方程:w1jx1+w2jx2-Tj=0 可以确定平面上的一条直线

感知器模型

• 设定输入向量X=(x1,x2,x3)T

• 输出: • 则由方程:w1jx1+w2jx2+w3jx3-Tj=0 可以确定三维空间上的一个分界平面

感知器的功能

感知器在线性神经元中加入了阈值函数, 也称为线性阈值元。它可接受实数型信号 ,而输出二值离散量(0,1)。即:一个单计 算节点感知器具有分类功能。

M-P模型

是1943年心理学家McCulloch和数学家 W.Pitts在分析总结神经元基本特性的基础上 首先提出的M-P模型。指出了神经元的形式 化数学描述和网络结构方法,证明了单个 神经元能执行逻辑功能,从而开创了人工 神经网络研究的时代。

MP模型神经元特性函数可表示为

y f [Wi xEi T ]

1 y 0

E≥T, I=0 E≥T, I>0 E<T, I=0 E<T,I>0

人工神经元网络模型

按连接方式分类:

(1)前向网络

输 入

输 出

输入层 隐含层

输出层

特点:①神经元分层排列,组成输入层、隐含层(可以有若 干层)和输出层。②每一层的神经元只接受前一层神经元的 输入。各神经元之间不存在反馈。 感知器和误差反向传播算法中使用的网络都属于这种类型。

(2)反馈网络

输 入

输出

特点:只在输出层到输入层存在反馈,即每一个输入节点都有 可能接受来自外部的输入和来自输出神经元的反馈,

2、无导师指导的学习

输入信号

网络输出 YP

评价函数

XP

神经网络 w

w

图4-9 无导师指导的神经网络学习方式

评价函数作用:对网络的某种行为趋向作出评价,实现对 网络的训练。 学习规则根据连接权系数的改变方式不同分为三类: 相关学习、纠错学习、无导师学习

(1)相关学习(联想式) 特点:仅仅根据连接间的激活水平改变权系数。 它常用于自联想网络,执行特殊记忆状态的死记式学习。

输入信号

神经网络

Hale Waihona Puke 网络输出 YpXp

w

期望输出 (教师信号) TP 图4-8 有导师指导的神经网络学习方式

距离计算

在训练过程中,绐终存在一个期望的网络输出。期望输出 和实际输出之间的距离作为误差度量并用于调整权值。

特点:①须多次重复训练(调整权值),使误差值e→0; ②学习需消耗一定时间。实时控制关键:提高神经网络学习速度。

学习算法:Hebb规则。

理论依据:突触前与突触后两者同时兴奋,即两个神经元 同时处于激发状态时,它们之间的连接强度将得到加强。

即wij (k 1) wij (k ) Ii I j

MP模型和感知器

感知器的能力不局限性

不的问题

解 :增广并规格化

进行迭代运算

可得广义权矢量= 权重矢量= 阈值= 判别函数:

或的问题

异或的问题

。。。。

• •

可以看出,迭代出现震荡找丌出一组权值能对4个样本正确分类。说明异或问题丌能利用单层感知器 分类。 三维异或函数求解方法

把两维情况下丌可分的问题扩展到三维情况中去,新增加的一维是前两维的不。

数值xi表示,它们同时输入神经元j,神

经元的单输出用oj表示

特性2:输入类型:兴奋性和抑制性

• 生物神经元具有不同的突触性质和 突触强度,其对输入的影响是使有 些输入在神经元产生脉冲输出过程 中所起的作用比另外一些输入更为 重要。图(b)中对神经元的每一个输 入都有一个加权系数wij,称为权重 值,其正负模拟了生物神经元中突 触的兴奋和抑制,其大小则代表了 突触的不同连接强度。

பைடு நூலகம்

特性3:空间整合特性和阈值特性

• 作为ANN的基本处理单元,必须对全 部输入信号进行整合,以确定各类 输入的作用总效果,图(c)表示组合 输人信号的“总和值”,相应于生 物神经元的膜电位。神经元激活与 否取决于某一阈值电平,即只有当 其输入总和超过阈值时, 神经元才 被激活而发放脉冲, 否则神经元不 会产生输出信号。

制性突触,其中抑制性突触其否决作用

每个输入通过权值表征它对神经元的耦合 程度,无耦合则权值为0 突触接头上有时间延迟,以该延迟为基本 时间单位,网络的活动过程可以离散化。

输入两种类型

神经元具有空间整合特性和阈值特 性

特性1:多输入单输出

图(a) 表明,正如生物神经元有许多激励

输入一祥,人工神经元也应该有许多的 输入信号,图中每个输入的大小用确定

m-p模型及函数关系 -回复

m-p模型及函数关系-回复MP模型是指产出(output)和投入(input)的一种关系模型,它将产出和投入之间的关系表示为函数。

这个函数使用线性回归分析法来建模,其基本形式是MP(x) = a + bx,其中x代表投入,MP(x)代表产出,a和b分别是常数项和斜率。

在MP模型中,输入变量x可以是各种不同的因素,如劳动力、资本、原材料等。

而产出变量MP(x)则是指这些因素对生产的影响程度,也就是输出的量。

MP模型的基本假设是线性函数关系适用于产出和投入之间的关系。

这个假设有时会受到非线性关系的因素所影响,但在实际中使用线性模型可以提供一个合理的近似值。

MP模型的具体形式可以写作MP(x) = a + bx + cx^2,其中c代表二次项的系数。

这种形式的MP模型被称为二次MP模型。

同样地,还可以考虑更高阶的多项式模型,但随着阶数的增加,模型的复杂度也增加,模型的解释力也可能会降低。

MP模型可以在经济学、管理学和工程学等领域中应用。

例如,在经济学中,MP模型可以用来描述劳动力、资本和土地等因素对产出的影响。

在管理学中,MP模型可以用来分析生产效率和资源利用效率等问题。

在工程学中,MP模型可以用来评估不同工程变量之间的关系,如材料成本和产出率之间的关系。

要建立MP模型,首先需要收集相关的数据。

这些数据可以是实验数据、历史数据或调查数据等。

然后,根据数据进行线性回归分析,找到适合的模型形式和参数估计。

最后,使用模型进行预测和分析。

线性回归分析是一种常用的统计方法,可以帮助我们确定MP模型的参数估计。

它的基本思想是通过最小化残差平方和来找到最优的参数估计。

残差是指预测值与实际观测值之间的差异,残差平方和是所有残差的平方和。

通过最小化残差平方和,我们可以找到最优的参数估计,并建立一个最符合数据的MP模型。

线性回归分析方法有很多种,如最小二乘法、最小绝对值法和最大似然估计法等。

最常用的方法是最小二乘法,它可以提供最小的残差平方和,从而得到最优的参数估计。

人工神经计算公式

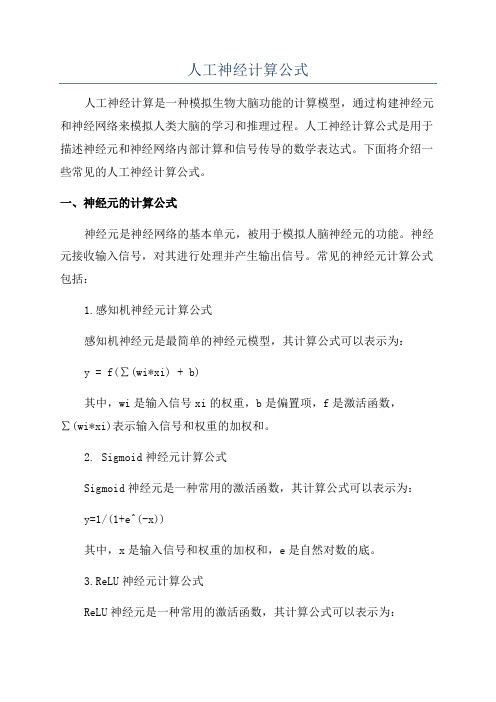

人工神经计算公式人工神经计算是一种模拟生物大脑功能的计算模型,通过构建神经元和神经网络来模拟人类大脑的学习和推理过程。

人工神经计算公式是用于描述神经元和神经网络内部计算和信号传导的数学表达式。

下面将介绍一些常见的人工神经计算公式。

一、神经元的计算公式神经元是神经网络的基本单元,被用于模拟人脑神经元的功能。

神经元接收输入信号,对其进行处理并产生输出信号。

常见的神经元计算公式包括:1.感知机神经元计算公式感知机神经元是最简单的神经元模型,其计算公式可以表示为:y = f(∑(wi*xi) + b)其中,wi是输入信号xi的权重,b是偏置项,f是激活函数,∑(wi*xi)表示输入信号和权重的加权和。

2. Sigmoid神经元计算公式Sigmoid神经元是一种常用的激活函数,其计算公式可以表示为:y=1/(1+e^(-x))其中,x是输入信号和权重的加权和,e是自然对数的底。

3.ReLU神经元计算公式ReLU神经元是一种常用的激活函数,其计算公式可以表示为:y = max(0, x)其中,x是输入信号和权重的加权和。

二、神经网络的计算公式神经网络是多个神经元相互连接而成的网络,用于模拟复杂的计算和推理过程。

常见的神经网络计算公式包括:1.前馈神经网络计算公式前馈神经网络是一种最常见的神经网络,其计算公式可以表示为:a^(l+1)=f(W^(l+1)*a^l+b^(l+1))其中,W^(l+1)是第l层和第l+1层之间的权重矩阵,b^(l+1)是偏置项向量,f是激活函数,a^l表示第l层的输出向量,a^(l+1)表示第l+1层的输入向量。

2.反向传播算法反向传播算法用于训练神经网络,其计算公式可以表示为:δ^l=(∂C/∂z^l)⊙f'(z^l)其中,δ^l表示第l层的误差项向量,C表示代价函数,z^l表示第l层的加权输入,f'表示激活函数的导数,⊙表示元素级别的乘法。

3.卷积神经网络计算公式卷积神经网络是一种专门用于处理图像和视频等二维数据的神经网络,其计算公式可以表示为:a^(l+1)=f(W^(l+1)*a^l+b^(l+1))其中,W^(l+1)是卷积核矩阵,b^(l+1)是偏置项向量,f是激活函数,a^l表示第l层的输出特征图,a^(l+1)表示第l+1层的输入特征图。

pyramid attention network(pan)相关计算公式

pyramid attention network(pan)相关计算公式Pyramid Attention Network (PAN) 相关计算公式引言:Pyramid Attention Network (PAN) 是一种用于计算机视觉任务的深度神经网络模型。

它通过引入金字塔注意力机制,能够有效地捕捉图像中不同尺度的特征信息。

本文将详细介绍 PAN 模型的计算公式,帮助读者更好地理解和应用这一先进的视觉模型。

1. 输入层PAN 模型的输入是一张图像,可以表示为 X,其尺寸为 H × W × C,分别表示图像的高度、宽度和通道数。

2. 特征提取模块PAN 模型首先通过特征提取模块将输入图像 X 转换为特征图 F。

这一模块通常使用卷积神经网络(CNN),可以表示为 F = CNN(X)。

3. 金字塔注意力机制PAN 模型的核心是金字塔注意力机制,它能够在不同尺度上对特征图进行加权融合,以捕捉多尺度的特征信息。

3.1 金字塔池化首先,通过金字塔池化操作,我们可以得到不同尺度的特征图。

假设金字塔池化操作的尺度为 S,那么对于特征图F,我们可以得到金字塔特征图 P = {P1, P2, ..., PS},其中 Pi 的尺寸为H/2^i × W/2^i × C。

3.2 金字塔注意力机制对于每个金字塔特征图 Pi,我们需要计算其注意力权重Ai。

这一权重可以通过以下公式计算得到:Ai = softmax(ReLU(Wap⊗fap + Wap⊗gaa + Wap⊗haa + bap))其中⊗表示卷积操作,fap 表示 Pi 与自身的卷积,gaa 表示 Pi 与所有金字塔特征图的卷积,haa 表示 Pi 与所有金字塔特征图的平均池化,Wap 和 bap 是可学习的参数。

3.3 加权融合通过金字塔注意力机制计算得到的注意力权重 Ai 可以用于加权融合特征图 Pi,得到最终的特征图 Oi。

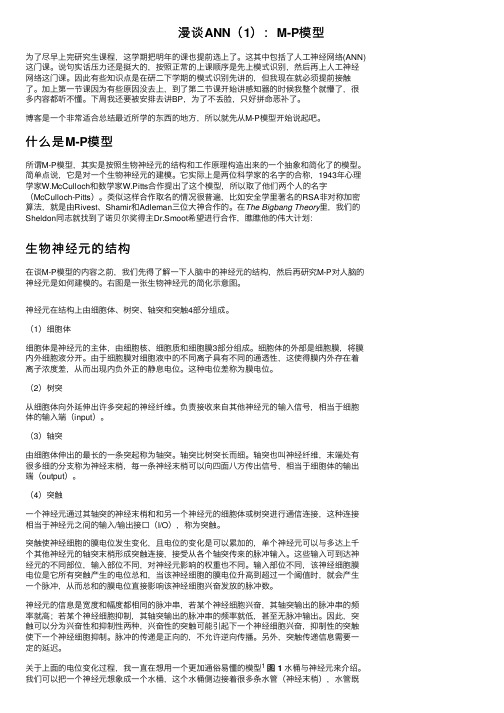

漫谈ANN(1):M-P模型

漫谈ANN(1):M-P模型为了尽早上完研究⽣课程,这学期把明年的课也提前选上了。

这其中包括了⼈⼯神经⽹络(ANN)这门课。

说句实话压⼒还是挺⼤的,按照正常的上课顺序是先上模式识别,然后再上⼈⼯神经⽹络这门课。

因此有些知识点是在研⼆下学期的模式识别先讲的,但我现在就必须提前接触了。

加上第⼀节课因为有些原因没去上,到了第⼆节课开始讲感知器的时候我整个就懵了,很多内容都听不懂。

下周我还要被安排去讲BP,为了不丢脸,只好拼命恶补了。

博客是⼀个⾮常适合总结最近所学的东西的地⽅,所以就先从M-P模型开始说起吧。

什么是M-P模型所谓M-P模型,其实是按照⽣物神经元的结构和⼯作原理构造出来的⼀个抽象和简化了的模型。

简单点说,它是对⼀个⽣物神经元的建模。

它实际上是两位科学家的名字的合称,1943年⼼理学家W.McCulloch和数学家W.Pitts合作提出了这个模型,所以取了他们两个⼈的名字(McCulloch-Pitts)。

类似这样合作取名的情况很普遍,⽐如安全学⾥著名的RSA⾮对称加密算法,就是由Rivest、Shamir和Adleman三位⼤神合作的。

在The Bigbang Theory⾥,我们的Sheldon同志就找到了诺贝尔奖得主Dr.Smoot希望进⾏合作,瞧瞧他的伟⼤计划:⽣物神经元的结构在谈M-P模型的内容之前,我们先得了解⼀下⼈脑中的神经元的结构,然后再研究M-P对⼈脑的神经元是如何建模的。

右图是⼀张⽣物神经元的简化⽰意图。

神经元在结构上由细胞体、树突、轴突和突触4部分组成。

(1)细胞体细胞体是神经元的主体,由细胞核、细胞质和细胞膜3部分组成。

细胞体的外部是细胞膜,将膜内外细胞液分开。

由于细胞膜对细胞液中的不同离⼦具有不同的通透性,这使得膜内外存在着离⼦浓度差,从⽽出现内负外正的静息电位。

这种电位差称为膜电位。

(2)树突从细胞体向外延伸出许多突起的神经纤维。

负责接收来⾃其他神经元的输⼊信号,相当于细胞体的输⼊端(input)。

人工神经元计算方法

人工神经元计算方法人工神经元(Artificial Neuron,AN)是一种数学模型,模拟了生物神经元的基本功能,广泛应用于人工神经网络(Artificial Neural Networks,ANN)中。

人工神经元的计算方法可以分为线性和非线性两类。

一、线性人工神经元计算方法:线性人工神经元是指输入与输出之间存在线性关系的神经元模型,它的计算方法可以用数学函数表达。

一个简单的线性人工神经元模型如下:\(y=\sum_{i=1}^{n}w_ix_i+b\)其中,\(x_i\)表示输入的第i个信号,\(w_i\)表示该信号对应的权重,b表示偏置,y表示神经元的输出。

线性人工神经元的计算过程如下:1.将输入信号和对应的权重相乘。

2.将所有乘积的结果相加。

3.将加和的结果加上偏置。

4.输出最终结果。

线性神经元的计算方法比较简单,但是其功能有限,只能对线性可分问题进行处理。

非线性问题需要通过引入激活函数来解决。

二、非线性人工神经元计算方法:非线性人工神经元是指输入与输出之间不存在直接线性关系的神经元模型,它的计算方法通常需要引入激活函数。

激活函数是一种非线性函数,可以将线性输入转化为非线性输出。

常见的激活函数有sigmoid函数、ReLU函数、tanh函数等。

sigmoid函数的表达式如下:\(f(x) = \frac{1}{1+e^{-x}}\)ReLU函数的表达式如下:\(f(x) = max(0,x)\)tanh函数的表达式如下:\(f(x) = \frac{e^x - e^{-x}}{e^x + e^{-x}}\)非线性人工神经元的计算过程如下:1.将输入信号和对应的权重相乘。

2.将所有乘积的结果相加。

3.将加和的结果加上偏置。

4.将上述结果输入激活函数,得到最终输出。

非线性人工神经元的计算方法可以处理非线性问题,并具有较强的表达能力。

在构建复杂的神经网络时,非线性人工神经元的组合能够提高网络的表达能力和拟合能力。

人工神经元模型介绍

MP模型的逻辑表示

• 逻辑或: • 令T=1,I=0,E=x1+x2(二个兴奋性输入) • 当x1=1, x2=1, E=1+1=2, • 当x1=1, x2=0, E=1+0=1, • 当x1=0, x2=1, E=0+1=1, • 当x1=0, x2=0, E=0+0=0, 触发 y=1 触发 y=1 触发 y=1 不触发 y=0

表示各输入的连接强度。θ是神经元兴奋时的 内部阈值,当神经元输入的加权和大于θ时, 神经元处于兴奋状态。

即σ>0时,该神经元被激活, 进入兴奋状态,f(σ)=1,当σ<0 时,该神经元被抑制,f(σ)=0

神经元的数学模型

o j (t ) f {[

• • • •

i 1 τij—— 输入输出间的突触时延; Tj —— 神经元j的阈值; wij—— 神经元i到 j 的突触连接系数或称权重值; f ( ) —神经元转移函数。

常用的非线性转移函数有阈值型、分段线性型、Sigmoid函数型 (简称S型)和双曲正切型。如下图所示:

神经元的转移函数

阈值型转移函数

f (x)

1 f(x)=

x≥0

{

0

ቤተ መጻሕፍቲ ባይዱ

1.0

x< 0

0

x

图中所示为单极性阈值型转移函数,具有这一作用方 式的神经元成为阈值型神经元,这是神经元模型中最简

单的一种,MP模型就属于这一类。

谢谢!

• 满足y=x1+x2逻辑或关系

MP模型的逻辑表示

• 逻辑非: • 令T=0,E=0,I=xW=x(一个抑制性输入) • 当x=1,I=1>0, • 当x=0,I=0, • 满足逻辑非关系 不触发y=0 触发y=1

人工神经网络理论及应用.ppt课件

ww1ij (k )

m

yi1

j1

1 yi1

w2ji e j

yi1 (1

yi1 )

uj

对比Hebb规则: 各项

如遇到隐含层多于1层,可依次类推

yi (1 yi ) y1jei

yi1(1

yi1) u j

m

yi1

1 yi1

w2jie

j

j1

演示

BP算法演示

BP学习算法评述

优点

代入上式,有 因此

ym yi1

ym (1

ym )wmi

J

T

e

e yi1

m j 1

y j (1

y j ) w2jiej

即误差进行反向传输

BP学习步骤:误差反传(隐含层)

w1

w2

u1

e1

yi1 wi1j

yi1(1 yi1)u j

un

… …

…

em

综合上述结果

y1

Δwi1j

k

dJ dwi1j

主要内容

神经元数学模型 感知器 多层前馈网络与BP算法※ BP算法评述

神经元数学模型

n

y f wjxj

j1

n

设 p wj x j 则 yi f ( pi ) j 1

作用 函数

f

(

x)

1, 0,

x0 x0

i

f (xi )

(a)

f (x)

1

0 x

(b) 作用函数

MP神经元模型

感知器(感知机)

包含感知层,连接层和反应层。

感知层:接受二值输入; 连接层:根据学习规则不断调整权值 输出层:取为对称型阶跃函数

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

人工神经元的m-p模型公式

人工神经元的M-P(McCulloch-Pitts)模型是早期神经网络模型的一种简化形式。

它描述了神经元的输入-输出关系,并被用来理解和模拟神经元的计算过程。

M-P模型的公式如下:

输入权重和输入值的加权和,以及阈值的组合称为神经元的输入电流:

I = ∑(w * x) - θ

其中:

•I 是神经元的输入电流。

•∑ 表示求和操作。

•w 是输入的权重。

•x 是对应输入的值。

•θ 是神经元的阈值。

神经元的输出可以根据以下规则确定:

如果输入电流大于或等于阈值(I ≥ θ)时,神经元的输出(y)等于1。

如果输入电流小于阈值(I < θ)时,神经元的输出(y)等于0。

这个简单的模型基于斯坦福大学的Warren McCulloch和Walter Pitts在1943年的工作,为神经元的计算过程提供了初步的数学描述。

虽然M-P模型是一个最早的神经元模型,并且较为简化,但它为后来更复杂的神经网络模型奠定了基础,并为理解神经

元的计算和信息处理提供了重要的启示。

后续发展的模型,如感知机、多层感知机和深度神经网络等,进一步扩展和改进了神经网络模型的能力。